Schlüsselwörter:Tesla, Optimus Roboter, KI, GPT-5, Meta KI, Großes Modelltraining, LLM Vorausbildung, Goldfisch-Verlustfunktion, DynaGuard dynamisches Schutzzäunemodell, GAM Netzwerkarchitektur, MedDINOv3 medizinische Bildsegmentierung, M3Ret multimodale medizinische Bildsuche

🔥 FOKUS

Musk veröffentlicht “Master Plan Part IV”: 80% des Tesla-Wertes liegen in Robotern : Tesla hat offiziell den “Master Plan Part IV” veröffentlicht, dessen Kern darin besteht, AI in die reale physische Welt zu integrieren und durch die massive Vereinheitlichung von Teslas Hardware und Software “nachhaltigen Wohlstand” zu erreichen. Musk wies darauf hin, dass in Zukunft etwa 80% des Wertes von Tesla vom humanoiden Roboter Optimus stammen werden, was einen Paradigmenwechsel des Unternehmens von Elektrofahrzeugen hin zu einer tiefen Integration von Energie, AI und Robotik ankündigt, mit dem Ziel, reale Probleme durch Technologie zu lösen und der gesamten Menschheit zugutezukommen. (Quelle: 量子位)

🎯 BEWEGUNG

AI gewinnt Gold bei der Internationalen Mathematik-Olympiade : OpenAIs GPT und Googles DeepMind Gemini haben bei der Internationalen Mathematik-Olympiade Goldmedaillen gewonnen, was Expertenprognosen widerlegt und die erstaunlichen Fortschritte von LLMs im mathematischen Denken demonstriert. Dies deutet darauf hin, dass die AI-Entwicklung weit über den Erwartungen liegt und in ein Zeitalter der “Massenintelligenz” eintritt. Dies ist nicht nur ein technologischer Durchbruch, sondern löst auch eine tiefgreifende Diskussion über die Grenzen der AI-Fähigkeiten und ihre zukünftigen Auswirkungen auf die Gesellschaft aus. (Quelle: 36氪)

GPT-5 zeigt herausragende Leistung im Werwolf-Spiel : Beim AIWolfDial 2025 Werwolf-Benchmark-Test führte GPT-5 mit einer Siegquote von 96,7% haushoch und demonstrierte starke Fähigkeiten in sozialem Denken, Täuschung und Manipulationsresistenz. Kimi-K2 zeigte einen kühnen und aggressiven “Bluff”-Stil, was die personalisierten Verhaltensmuster von LLMs in komplexen sozialen Interaktionen widerspiegelt. (Quelle: 量子位,Reddit r/deeplearning)

Neue Trainingsmethode für große Modelle: “Goldfish Loss” : Forschungsteams der University of Maryland und anderer Institutionen haben den “Goldfish Loss” vorgeschlagen. Durch das zufällige Entfernen einiger Token bei der Berechnung der Verlustfunktion wird die Memorierung großer Modelle effektiv reduziert, sodass sie Trainingsdaten nicht mehr auswendig lernen, ohne die Leistung bei nachgelagerten Aufgaben zu beeinträchtigen, was die Generalisierungsfähigkeit der Modelle verbessert. (Quelle: 量子位)

Interne Umstrukturierung der AI-Abteilung von Meta sorgt für Kontroversen : Metas Chief AI Officer Alexandr Wang hat neue Regeln eingeführt, die vorschreiben, dass FAIR-Veröffentlichungen von TBD Labs überprüft werden müssen und wertvolle Papiere und Autoren möglicherweise “zurückgehalten” werden, um sie in Produkte umzusetzen. Dieser Schritt hat zu Unzufriedenheit innerhalb von FAIR geführt und einige Mitarbeiter zum Verlassen des Unternehmens bewogen. Dies unterstreicht Metas Einmischung in die Forschungsunabhängigkeit und seine harte Haltung bei der Umsetzung von Forschungsergebnissen im Rahmen seiner AI-Strategieanpassung. (Quelle: 量子位)

LLM Pre-Training Optimizer Performance Benchmark : Eine systematische Studie von zehn Deep-Learning-Optimierern wurde durchgeführt, die verschiedene Modellgrößen und Daten-Modell-Verhältnisse abdeckt. Es wurde festgestellt, dass ein fairer Vergleich eine strenge Hyperparameter-Optimierung und die Bewertung der Leistung am Ende des Trainings erfordert. Die Studie zeigt, dass die Geschwindigkeitsverbesserung von matrixbasierten Optimierern (wie Muon und Soap) mit zunehmender Modellgröße abnimmt und bei 1.2B-Modellen nur das 1,1-fache beträgt, was Leitlinien für die Auswahl und zukünftige Forschung von LLM Pre-Training Optimierern bietet. (Quelle: HuggingFace Daily Papers,HuggingFace Daily Papers)

DynaGuard: Dynamisches Schutzmodell mit benutzerdefinierten Strategien : Das dynamische Schutzmodell DynaGuard wurde vorgeschlagen, das Texte gemäß benutzerdefinierten Strategien bewerten und Regelverstöße schnell erkennen kann. Das Modell erreicht bei der Erkennung statischer Gefahrenkategorien eine ähnliche Genauigkeit wie Standard-Schutzmodelle und kann gleichzeitig Freiform-Strategieverstöße in kürzerer Zeit identifizieren, was Chatbots eine flexible und effiziente Ausgabeüberwachung bietet. (Quelle: HuggingFace Daily Papers)

Gated Associative Memory (GAM) Netzwerke : Das GAM-Netzwerk wurde vorgestellt, eine neue, vollständig parallele Architektur für die Sequenzmodellierung, deren Komplexität linear zur Sequenzlänge (O(N)) ist und den quadratischen Komplexitätsengpass des Transformer-Self-Attention-Mechanismus löst. GAM kombiniert kausale Faltung mit paralleler assoziativer Gedächtnisabfrage und zeigt auf den Datensätzen WikiText-2 und TinyStories schnellere Trainingsgeschwindigkeiten und eine bessere oder vergleichbare Validierungs-Perplexität als Transformer und Mamba. (Quelle: HuggingFace Daily Papers)

Reasoning Vectors: Übertragung von Chain-of-Thought-Fähigkeiten durch Aufgabenarithmetik : Studien zeigen, dass die Schlussfolgerungsfähigkeiten von LLMs als kompakte Aufgabenvektoren extrahiert und zwischen Modellen übertragen werden können. Durch die Berechnung der Vektordifferenz zwischen feinabgestimmten Modellen und SFT-Modellen und deren Addition zu anderen instruktionsfeinabgestimmten Modellen kann die Leistung der Modelle bei mehreren Schlussfolgerungs-Benchmarks wie GSM8K und HumanEval kontinuierlich verbessert werden, was eine effiziente und wiederverwendbare Methode zur Verbesserung der LLM-Fähigkeiten bietet. (Quelle: HuggingFace Daily Papers)

MedDINOv3: Visuelles Basismodell für die medizinische Bildsegmentierung : Das MedDINOv3-Framework wurde vorgestellt, das durch die Neugestaltung des ViT-Backbones und domänenadaptive Vorabtrainings auf dem CT-3M-Datensatz DINOv3 effektiv auf die medizinische Bildsegmentierung anwendet. Dieses Modell erreicht oder übertrifft SOTA-Leistung bei mehreren Segmentierungs-Benchmarks und zeigt das enorme Potenzial visueller Basismodelle als vereinheitlichtes Backbone für die medizinische Bildsegmentierung. (Quelle: HuggingFace Daily Papers)

M3Ret: Zero-Shot Multimodale Medizinische Bildabfrage : M3Ret erreicht SOTA-Leistung bei der Zero-Shot-Bild-zu-Bild-Abfrage durch das Training eines vereinheitlichten visuellen Encoders auf einem großskaligen gemischten Modalitäten-Datensatz. Das Modell zeigt eine starke Generalisierungsfähigkeit bei ungesehenen MRI-Aufgaben und fördert durch generative und kontrastive selbstüberwachte Lernparadigmen die Entwicklung visueller selbstüberwachter Basismodelle im multimodalen medizinischen Bildverständnis. (Quelle: HuggingFace Daily Papers)

OpenVision 2: Generativer visueller Encoder für multimodales Lernen : OpenVision 2 vereinfacht die Architektur und das Verlustdesign, indem es den Text-Encoder und den Kontrastverlust entfernt und nur den Untertitelgenerierungsverlust beibehält. Dieses rein generative Trainingssignal zeigt hervorragende Leistungen bei multimodalen Benchmarks, reduziert gleichzeitig Trainingszeit und Speicherverbrauch erheblich und bietet ein effizientes Paradigma für die Entwicklung visueller Encoder für zukünftige multimodale Basismodelle. (Quelle: HuggingFace Daily Papers)

LLaVA-Critic-R1: Bewertungsmodell kann auch ein leistungsstarkes Strategiemodell sein : LLaVA-Critic-R1 wandelt durch RL-Training Bewertungsdatensätze mit Präferenzannotationen in verifizierbare Signale um. Es ist nicht nur ein leistungsstarkes Bewertungsmodell, sondern auch ein wettbewerbsfähiges Strategiemodell, das professionelle VLMs bei mehreren visuellen Schlussfolgerungs- und Verständnis-Benchmarks übertrifft und die Schlussfolgerungsleistung durch Selbstkritik zur Testzeit weiter verbessern kann. (Quelle: HuggingFace Daily Papers)

Metis: Low-Bit-Quantisierungs-Training für LLM : Das Metis-Framework löst das Problem der anisotropen Parameterverteilung beim Low-Bit-Quantisierungs-Training von LLMs durch die Kombination von Spektralzerlegung, adaptiver Lernrate und Dual-Range-Regularisierung. Diese Methode ermöglicht es, dass FP8-Training die FP32-Baseline übertrifft und FP4-Training die Genauigkeit von FP32 erreicht, was den Weg für ein robustes und skalierbares Training von LLMs unter fortschrittlicher Low-Bit-Quantisierung ebnet. (Quelle: HuggingFace Daily Papers)

AMBEDKAR: Mehrstufiges Rahmenwerk zur Bias-Eliminierung : Das AMBEDKAR-Framework wurde vorgestellt, inspiriert von der indischen Verfassungsvision der Gleichheit. Es reduziert aktiv Vorurteile in LLMs in Bezug auf Kaste und Religion während der Inferenz durch eine verfassungsbewusste Dekodierungsschicht und einen spekulativen Dekodierungsalgorithmus. Diese Methode erfordert keine Änderung der Modellparameter, senkt die Rechenkosten und reduziert Vorurteile erheblich, was einen neuen Ansatz für die Fairness von LLMs in spezifischen kulturellen Kontexten bietet. (Quelle: HuggingFace Daily Papers)

C-DiffDet+: Hochpräzise Objekterkennung durch Integration globalen Szenenkontexts : C-DiffDet+ wurde vorgestellt, das durch die Einführung eines kontextbewussten Fusionsmechanismus (CAF) den globalen Szenenkontext direkt mit lokalen Vorschlagsmerkmalen integriert und so das generative Detektionsparadigma erheblich verbessert. Dieses Framework nutzt einen dedizierten Encoder, um umfassende Umgebungsinformationen zu erfassen, sodass jeder Objektvorschlag szenenweites Verständnis berücksichtigen kann, wodurch SOTA-Modelle im CarDD-Benchmark übertroffen werden. (Quelle: HuggingFace Daily Papers)

GenCompositor: Generative Videosynthese basierend auf Diffusion Transformer : GenCompositor wurde vorgestellt, das durch eine neuartige Diffusion Transformer (DiT)-Pipeline eine interaktive generative Videosynthese ermöglicht. Die Methode entwirft einen leichtgewichtigen Hintergrund-Erhaltszweig und DiT-Fusionsblöcke und führt Extended Rotary Position Embedding (ERoPE) ein, wodurch hochauflösende und konsistente Videosynthese auf dem VideoComp-Datensatz erreicht und bestehende Lösungen übertroffen werden. (Quelle: HuggingFace Daily Papers)

ELV-Halluc: Benchmark für semantische Aggregationshalluzinationen im Langzeit-Videoverständnis : ELV-Halluc wurde eingeführt, der erste Benchmark, der sich speziell mit Halluzinationen in langen Videos befasst und semantische Aggregationshalluzinationen (SAH) systematisch untersucht. Experimente bestätigen die Existenz von SAH, die mit zunehmender semantischer Komplexität und bei sich schnell ändernden Semantiken häufiger auftreten. Die Studie zeigt auch, dass Positionskodierungsstrategien und DPO SAH lindern können, indem sie die SAH-Rate durch adversarische Datenpaare signifikant reduzieren. (Quelle: HuggingFace Daily Papers)

FastFit: Beschleunigung der virtuellen Anprobe mit cachefähigen Diffusionsmodellen : FastFit wurde vorgestellt, ein Hochgeschwindigkeits-Framework für virtuelle Anproben mit mehreren Referenzen, basierend auf einer cachefähigen Diffusionsarchitektur. Durch Halb-Aufmerksamkeitsmechanismen und Klasseneinbettungen wird die Referenzmerkmalskodierung vom Entrauschungsprozess entkoppelt, was eine einmalige Berechnung und verlustfreie Wiederverwendung von Referenzmerkmalen ermöglicht, die Geschwindigkeit durchschnittlich um das 3,5-fache erhöht und SOTA-Methoden auf Datensätzen wie DressCode-MR übertrifft. (Quelle: HuggingFace Daily Papers)

🧰 WERKZEUGE

Googles Gemini “nano-banana”-Funktion : Google Gemini hat die “nano-banana”-Funktion eingeführt, mit der Benutzer Fotos mit nur einem Prompt in Bilder im Miniaturmodell-Stil umwandeln können. Die Bedienung ist einfach und kreativ und bietet Benutzern ein unterhaltsames Erlebnis, persönliche Fotos, Landschaftsaufnahmen oder Haustierbilder in maßgeschneiderte Miniaturmodelle zu verwandeln. (Quelle: GoogleDeepMind)

Alibaba_Wans Wan2.2 Bildgenerierungsfähigkeiten : Alibaba_Wan demonstrierte die hervorragende Detailwiederherstellungsfähigkeit von Wan2.2 bei der Bildgenerierung. Von “geneigten Äxten und staubigen Fotos” bis hin zu “schwachen Bewegungen im Schatten” wurde eine perfekte Horrorfilm-Atmosphäre geschaffen, was das starke Potenzial von AI bei der Erstellung komplexer Szenen und Emotionen widerspiegelt. (Quelle: Alibaba_Wan,Alibaba_Wan)

Claude Codes vollständige Dateilesefunktion : Claude Code unterstützt nach dem Update das vollständige Lesen von Dateien, wodurch die frühere Beschränkung auf 50/100 Zeilen grep-Verkettung behoben wird. Die Dateilesegeschwindigkeit wurde erheblich verbessert und erreicht das Niveau von Gemini CLI, möglicherweise dank Verbesserungen der Backend-Hardware (wie TPU), obwohl die Kontextgröße weiterhin 200k anzeigt. (Quelle: Reddit r/ClaudeAI)

Le Chat integriert MCP-Konnektoren und Gedächtnisfunktion : Le Chat integriert jetzt über 20 Unternehmensplattform-Konnektoren (basierend auf MCP) und führt eine “Gedächtnis”-Funktion ein, die hochgradig personalisierte Antworten liefert und gleichzeitig den Import von ChatGPT-Erinnerungen unterstützt. Dies stärkt die Anwendungsfähigkeiten von Le Chat in Unternehmensumgebungen, ermöglicht ein besseres Verständnis von Benutzerpräferenzen und Fakten und verbessert die Nützlichkeit von AI-Assistenten. (Quelle: Reddit r/LocalLLaMA)

Googles LangExtract Tool : Google hat LangExtract veröffentlicht, ein Tool zum Extrahieren von Wissensgraphen aus Texten. Es kann unstrukturierte Texte in strukturiertes Wissen umwandeln, was für die Implementierung von RAG (Retrieval-Augmented Generation) sehr vorteilhaft ist, den Aufbau von Wissensgraphen für persönliche Projekte unterstützt und LLMs präzisere Kontextinformationen liefert. (Quelle: Reddit r/LocalLLaMA)

Model Context Protocol (MCP) Server-Ökosystem : Das GitHub-Projekt appcypher/awesome-mcp-servers listet eine Vielzahl von MCP-Servern auf, die es AI-Modellen ermöglichen, sicher mit lokalen und entfernten Ressourcen wie Dateisystemen, Datenbanken und APIs zu interagieren. Dieses Ökosystem erweitert die Fähigkeiten von AI-Agenten erheblich und umfasst Bereiche wie Dateisysteme, Sandboxes, Versionskontrolle, Cloud-Speicher und Datenbanken, wodurch die Integration und Anwendung von AI-Tools gefördert wird. (Quelle: GitHub Trending)

Universal Deep Research (UDR) System : UDR ist ein universelles Agentensystem, das jedes Sprachmodell kapseln kann und es Benutzern ermöglicht, vollständig benutzerdefinierte Tiefenforschungsstrategien ohne zusätzliches Training oder Fine-Tuning zu erstellen, zu bearbeiten und zu verfeinern. Es fördert Systemexperimente durch die Bereitstellung von minimalen, erweiterten und dichten Forschungsstrategiebeispielen und verbessert so die Flexibilität und Effizienz der AI-Forschung. (Quelle: HuggingFace Daily Papers)

SQL-of-Thought: Multi-Agent Text-to-SQL Framework : SQL-of-Thought wurde vorgestellt, ein Multi-Agenten-Framework, das die Text2SQL-Aufgabe in Schema-Verknüpfung, Unterproblem-Identifikation, Abfrageplan-Generierung, SQL-Generierung und einen geführten Fehlerkorrekturzyklus zerlegt. Das Framework erzielt durch die Kombination von geführter Fehlerklassifizierung und推理basierten Abfrageplanung modernste Ergebnisse auf dem Spider-Datensatz und verbessert die Robustheit der Umwandlung von natürlicher Sprache in SQL. (Quelle: HuggingFace Daily Papers)

VerlTool: Agentic Reinforcement Learning Framework für die Werkzeugnutzung : VerlTool ist ein einheitliches und modulares Framework, das darauf abzielt, Fragmentierung, synchrone Ausführungsengpässe und Skalierbarkeitsbeschränkungen im Agentic Reinforcement Learning (ARLT) bei mehrstufigen Werkzeuginteraktionen zu lösen. Es erreicht eine nahezu 2-fache Geschwindigkeitssteigerung und zeigt wettbewerbsfähige Leistungen in 6 ARLT-Domänen durch Upstream-Alignment mit VeRL, einheitliches Werkzeugmanagement, asynchrone Rollout-Ausführung und umfassende Bewertung. (Quelle: HuggingFace Daily Papers)

MobiAgent: Anpassbares mobiles Agenten-System : MobiAgent ist ein umfassendes mobiles Agenten-System, das die MobiMind-Reihe von Agentenmodellen, das AgentRR-Beschleunigungsframework und die MobiFlow-Benchmark-Suite umfasst. Es reduziert die Kosten für die Annotation hochwertiger Daten durch AI-gestützte Datenerfassungsprozesse erheblich und erreicht modernste Leistung in realen mobilen Szenarien, wodurch die Herausforderungen bestehender GUI-Mobiler Agenten in Bezug auf Genauigkeit und Effizienz gelöst werden. (Quelle: HuggingFace Daily Papers)

VARIN: Textgesteuerte autoregressive Bildbearbeitung : VARIN ist die erste VAR-Modell-Bildbearbeitungstechnologie, die auf Rauschinversion basiert. Sie nutzt Location-aware Argmax Inversion (LAI), um inverses Gumbel-Rauschen zu erzeugen und so eine präzise Quellbildrekonstruktion und kontrollierte textgesteuerte Bearbeitung zu ermöglichen. Die Methode bewahrt beim Ändern von Bildern signifikant den ursprünglichen Hintergrund und strukturelle Details und demonstriert ihre Wirksamkeit als praktische Bearbeitungsmethode. (Quelle: HuggingFace Daily Papers)

📚 LERNEN

Projektvorschläge für AI-Kurse an Universitäten : Ein Reddit-Nutzer sucht nach interaktiven Projektvorschlägen für einen Kurs “Grundlagen der Künstlichen Intelligenz”, die keine Hochleistungscomputer erfordern. Die Diskussion konzentriert sich darauf, was LLMs leisten können, die Funktionen intelligenter Geräte und wie diese Konzepte im Unterricht kombiniert werden können, wobei der Schwerpunkt auf praktischen und Projekten mit geringen Rechenanforderungen liegt. (Quelle: Reddit r/ArtificialInteligence)

Umfassende GitHub-Ressourcen für Studenten : dipakkr/A-to-Z-Resources-for-Students ist eine sorgfältig zusammengestellte Ressourcenliste für Universitätsstudenten, die Programmiersprachenlernen (Python, ML, LLM, DL, Android usw.), Hackathons, Studentenleistungen, Open-Source-Projekte, Praktikumsportale, Entwicklergemeinschaften und mehr abdeckt. Der Abschnitt über AI-Tools und -Ressourcen listet beliebte AI-Tools und GitHub-Repositories detailliert auf. (Quelle: GitHub Trending)

Wie man Forschungsarbeiten versteht und AI/ML für Anfänger : Zwei Reddit-Diskussionen über AI-Lernen: Eine fragt, wie man Forschungsarbeiten versteht, die andere sucht Kursvorschläge für AI/ML-Anfänger. Diese Diskussionen spiegeln die allgemeine Verwirrung von AI-Lernenden beim Verständnis von Spitzenforschung und der Wahl des Lernpfads wider. (Quelle: Reddit r/deeplearning,Reddit r/deeplearning)

FlashAdventure: Abenteuerspiel-Benchmark für GUI-Agenten : FlashAdventure ist ein Benchmark, der 34 Flash-Abenteuerspiele umfasst und darauf abzielt, die Fähigkeit von LLM-gesteuerten GUI-Agenten zu bewerten, vollständige Handlungsstränge abzuschließen und das “Beobachtungs-Verhaltens-Gap”-Problem zu lösen. Das COAST-Framework verbessert die Planung durch langfristiges Hinweisgedächtnis und erhöht die Erreichung von Meilensteinen, weist aber immer noch einen signifikanten Unterschied zur menschlichen Leistung auf. (Quelle: HuggingFace Daily Papers)

The Gold Medals in an Empty Room: Diagnose der metalinguistischen Schlussfolgerung von LLMs : Camlang wurde vorgestellt, eine neue künstliche Sprache, die durch Grammatikbücher und zweisprachige Wörterbücher die metalinguistische deduktive Lernfähigkeit von LLMs in unbekannten Sprachen bewertet. GPT-5 zeigte bei Camlang-Aufgaben eine deutlich schlechtere Leistung als Menschen, was darauf hindeutet, dass aktuelle Modelle immer noch einen grundlegenden Unterschied zu Menschen in der systematischen Grammatikbeherrschung aufweisen und ein neues Paradigma für die kognitionswissenschaftliche Bewertung von LLMs bieten. (Quelle: HuggingFace Daily Papers)

💼 BUSINESS

Altman setzt auf Indiens AI-Infrastruktur: Herausforderungen : OpenAI plant eine massive Expansion des “Stargate”-Projekts in Indien und investiert enorme Summen in den Aufbau von AI-Recheninfrastruktur. Indien steht jedoch vor den “drei Defiziten” – GPU-Mangel, Kapitalinvestitionen und Abwanderung von High-End-Talenten – sowie einem kritischen Mangel an Stromversorgung, was Zweifel am Potenzial des Landes für AI-Infrastruktur aufkommen lässt. (Quelle: 36氪)

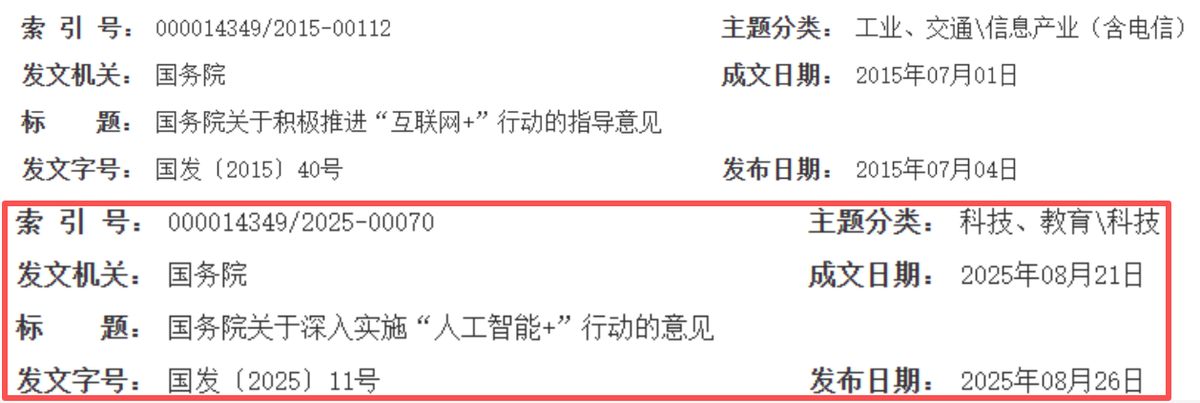

AI gestaltet Chinas Internet-Wachstumszyklus neu : Chinas Internetbranche wandelt sich von “Konnektivitäts-Empowerment” zu “intelligentem Antrieb”, wobei AI zum neuen Wachstumsmotor wird. Giganten wie Alibaba, Tencent und Baidu erhöhen ihre AI-bezogenen Kapitalausgaben erheblich, beschleunigen die AI-Integration in ihre Geschäfte und vollziehen eine strategische Transformation von “Kapitalakkumulation” zu “AI-Empowerment”. Dies deutet auf ein neues goldenes Jahrzehnt für Chinas Internet hin, das durch technologische Tiefe, industrielle Integration und kommerzielle Effizienz gekennzeichnet ist. (Quelle: 36氪)

Salesforce entlässt 4000 Mitarbeiter wegen AI : Salesforce-CEO Marc Benioff erklärte, dass das Unternehmen nach dem Einsatz von AI-Agenten 4000 Kundensupport-Positionen abgebaut und die Größe des Support-Teams von 9000 auf etwa 5000 Mitarbeiter reduziert hat. Dies zeigt den direkten Einfluss der AI-Automatisierung auf traditionelle Arbeitsplätze und die Steigerung der betrieblichen Effizienz, löst aber auch Diskussionen über die Ersetzung menschlicher Arbeit durch AI aus. (Quelle: The Verge,Reddit r/ChatGPT)

🌟 COMMUNITY

Zweifel am ROI von AI-Investitionen in Unternehmen : Die Reddit-Community diskutiert intensiv über den tatsächlichen ROI von Unternehmensinvestitionen in AI-Tools. Viele bezweifeln, ob Unternehmen wirklich die “gesparte Zeit” gegen das “ausgegebene Geld” abwägen, und argumentieren, dass die meisten Entscheidungen “stimmungsgetrieben” und nicht datengestützt sind. Kommentare weisen darauf hin, dass AI bei Textaufgaben hervorragend ist, aber in Szenarien, die menschliche Interaktion erfordern, ineffizient ist und möglicherweise Kosten zu bestehenden ineffizienten Prozessen hinzufügt. (Quelle: Reddit r/ArtificialInteligence)

Ethische Bedenken bei AI-Agenten, die echtes Geld verwalten : Soziale Medien diskutieren die schnelle Entwicklung von AI-Agenten, die Kryptowährungswallets autonom verwalten, was tiefe Bedenken hinsichtlich Vertrauen, Sicherheit und der autonomen Bildung von AI-Ökonomien aufwirft. Benutzer befürchten, dass AI-Agenten manipuliert werden oder unabhängige Wirtschaftssysteme schaffen könnten, die den Menschen überflüssig machen. Es wird gefordert, sich auf datenschutzfreundliche AI und Modelle zu konzentrieren, die mit verschlüsselten Daten trainiert werden. (Quelle: Reddit r/ArtificialInteligence)

ChatGPT Prompt Engineering Tricks und Modellverhalten : Benutzer haben festgestellt, dass das Beginnen einer Frage mit “Ich könnte falsch liegen, aber…” den Ton von ChatGPT ändern und es kritischer und nachdenklicher machen kann. Gleichzeitig ist die Community verärgert über die häufigen “zusätzlichen Aufgaben”, die GPT-5 anbietet, und sieht dies als Zeichen dafür, dass das Modell “verdummt” wird, und wünscht sich eine Version mit weniger voreingestellten Verhaltensweisen. (Quelle: Reddit r/ChatGPT,Reddit r/ChatGPT)

Auswirkungen von AI auf den Arbeitsmarkt : Die Community diskutiert, ob AI-Automatisierung globale Arbeitsplätze reduzieren oder neue schaffen wird. Die allgemeine Ansicht ist, dass beides der Fall sein wird, aber Arbeitnehmer sich an neue Fähigkeiten anpassen und mit AI zusammenarbeiten müssen. Einige argumentieren auch, dass AI-getriebene Arbeitsplätze sich auf Techniker konzentrieren könnten, was eine breitere Verbreitung von Fähigkeiten und politische Anpassungen erfordert. (Quelle: Reddit r/ArtificialInteligence)

Bedenken vor einem “AI-Winter” durch AI-Datenschutz und Regulierung : Die Community diskutiert, dass der zukünftige “AI-Winter” eher durch Datenschutzgesetze als durch technische Einschränkungen verursacht werden könnte. Die Verschärfung von Vorschriften wie der DSGVO wird AI-Modelle dazu zwingen, auf verschlüsselten Daten zu trainieren und zu laufen. Nur Unternehmen mit datenschutzfreundlicher Infrastruktur werden überleben können, andernfalls könnten sie aufgrund rechtlicher Rahmenbedingungen keine AI einsetzen. (Quelle: Reddit r/ArtificialInteligence)

AI-Plattform-Zuverlässigkeit und Datenschutzbedenken : Die ChatGPT-Community diskutiert intensiv über Modellausfälle, wobei Benutzer scherzhaft von einem “Wirtschaftszusammenbruch” sprechen, was die Verbreitung von AI-Tools im Arbeitsalltag und ihre potenzielle Abhängigkeit widerspiegelt. Gleichzeitig kündigte OpenAI an, “hochriskante Gespräche” zur Kriminalitätsprävention zu überwachen, was bei den Benutzern Bedenken hinsichtlich des Datenschutzes auslöste. Die Community empfiehlt allgemein die Verwendung lokaler oder Open-Source-LLMs und betont, dass Benutzer bewusst vermeiden sollten, sensible Informationen auf AI-Plattformen zu teilen. (Quelle: Reddit r/ChatGPT,Reddit r/ChatGPT)

Fallbeispiel: AI-Halluzinationen führen zu Arbeitsfehlern : Die Freundin eines Benutzers steht wegen eines von ChatGPT halluzinierten, falschen Datenanalyseberichts vor einer Arbeitskrise. ChatGPT analysierte Textdaten fälschlicherweise mit dem “Pearson-Korrelationskoeffizienten” und konnte den Berechnungsprozess nicht erklären. Die Community rät, den Fehler zuzugeben, eine korrekte Analyse durchzuführen und betont, dass AI nur ein Hilfsmittel ist und kritische Informationen manuell überprüft werden müssen. (Quelle: Reddit r/ChatGPT)

Claude AIs “niedliches” Verhalten : Benutzer haben festgestellt, dass Claude AI eine Eigenschaft des “Respekts vor dem Leben” besitzt und sogar Benutzer davon überzeugen kann, Spinnen zu retten. Community-Benutzer loben Claude als “niedlich” und teilen Erfahrungen des Zusammenlebens mit Spinnen zu Hause, was das interessante Potenzial von AI in emotionaler Interaktion und moralischer Führung widerspiegelt. (Quelle: Reddit r/ClaudeAI)

Trump schiebt Probleme auf AI : Der ehemalige US-Präsident Trump machte “AI-Generierung” für ein Video verantwortlich, das einen Müllsack aus einem Fenster des Weißen Hauses wirft, obwohl offiziell bestätigt wurde, dass es sich um Bauunternehmer handelte. Dieser Vorfall wurde in den sozialen Medien als “AI ist der neue Hund, der meine Hausaufgaben gefressen hat” verspottet, was widerspiegelt, wie AI zu einer neuen Ausrede in der öffentlichen Debatte geworden ist. (Quelle: Reddit r/ArtificialInteligence,The Verge )

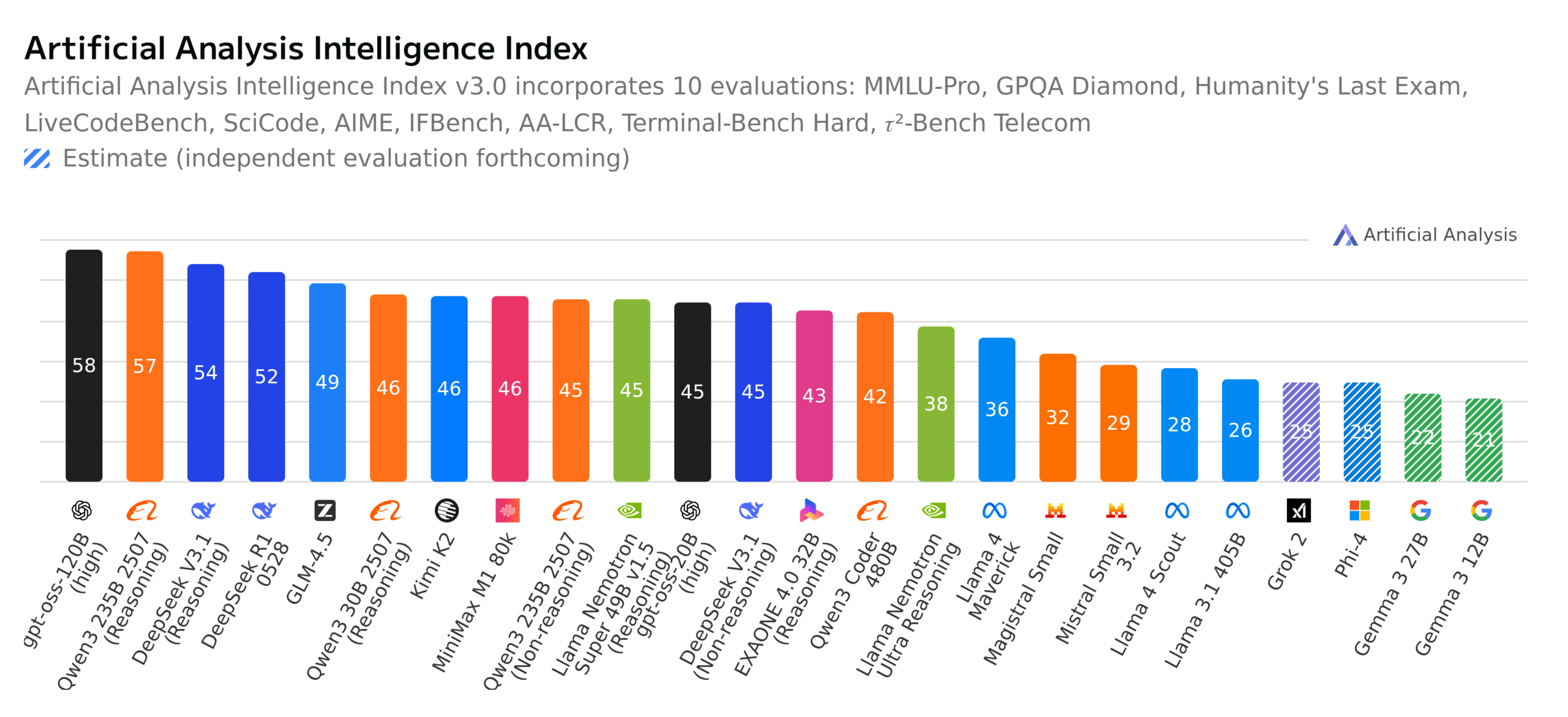

Fortschritte bei Open-Source-LLMs und Benchmark-Diskussionen : Die Community diskutiert intensiv über GPT-OSS 120B als Top-Open-Source-Modell, die Veröffentlichung des neuen, vollständig quelloffenen mehrsprachigen Modells Apertus-70B-2509 aus der Schweiz sowie die Einführung des Kimi K2-0905-Modells. Gleichzeitig bewertet der deutsche “Wer wird Millionär”-Benchmark LLMs, was eine breite Diskussion über die tatsächlichen Fähigkeiten der Modelle, die Bedeutung von Benchmarks und die Ethik von Open-Source-Modellen (z.B. Datentransparenz) auslöste. (Quelle: Reddit r/LocalLLaMA,Reddit r/LocalLLaMA,Reddit r/LocalLLaMA,Reddit r/LocalLLaMA)

💡 SONSTIGES

Yunpeng Technology stellt neue AI+Gesundheitsprodukte vor : Yunpeng Technology hat am 22. März 2025 in Hangzhou neue Produkte in Zusammenarbeit mit Shuaikang und Skyworth vorgestellt, darunter das “Digitale und intelligente Zukunftsküchenlabor” und einen intelligenten Kühlschrank mit einem großen AI-Gesundheitsmodell. Das große AI-Gesundheitsmodell optimiert Küchendesign und -betrieb, während der intelligente Kühlschrank über den “Gesundheitsassistenten Xiaoyun” personalisiertes Gesundheitsmanagement bietet, was einen Durchbruch von AI im Gesundheitsbereich markiert. Diese Veröffentlichung demonstriert das Potenzial von AI im täglichen Gesundheitsmanagement, indem personalisierte Gesundheitsdienste durch intelligente Geräte ermöglicht werden, was voraussichtlich die Entwicklung der Familiengesundheitstechnologie fördern und die Lebensqualität der Bewohner verbessern wird. (Quelle: 36氪)

Bedenken hinsichtlich der Qualität von Paper-Reviews auf akademischen Konferenzen : Die Machine-Learning-Community diskutiert die Veröffentlichung der WACV 2026 Paper-Reviews sowie Probleme mit der Qualität der Reviews bei ACL Rolling Review (ARR). Einige Forscher beklagen, dass ARR mit “AI-generierten” generischen, minderwertigen Reviews überflutet ist, diese als Zeitverschwendung betrachten und empfehlen, bei anderen AI-Konferenzen einzureichen. Dies spiegelt die Bedenken in der akademischen Welt hinsichtlich der Qualität von AI-unterstützten Reviews und der Review-Mechanismen wider und fordert eine Verbesserung der Substanz und Konstruktivität der Reviews. (Quelle: Reddit r/MachineLearning,Reddit r/MachineLearning)

Cloud-Service-Sentimentanalysemodell-Projekt : Ein ML-Anfänger hat ein BERT-basiertes aspektorientiertes Sentimentanalysemodell entwickelt, um Kommentare in ML-/Cloud-Technologie-Reddit-Communities zu Cloud-Service-Anbietern wie AWS, Azure und Google Cloud zu analysieren und die Stimmung nach Dimensionen wie Kosten, Skalierbarkeit und Sicherheit zu klassifizieren. Er sucht nach Vorschlägen zur Verbesserung der Erklärungsgenauigkeit des Modells, zur Verarbeitung vergleichender oder gemischter Aussagen und zur Erhöhung der Robustheit gegenüber Negationen und Sarkasmus. (Quelle: Reddit r/MachineLearning,Reddit r/deeplearning)