Schlüsselwörter:KI-Agent, Salesforce Entlassungen, ChatGPT Ethik, KI-Cybersicherheit, Chinas große KI-Modelle, KI-Doppelgänger am Arbeitsplatz, Claude Code-Ausführungstool, Tencent TiG-Framework, KI-Wirtschaftsreparatur, Kleinmodell-Industrieanwendungen

🔥 Im Fokus

Salesforce entlässt 4.000 Mitarbeiter mithilfe von AI Agents : Salesforce CEO Marc Benioff gab bekannt, dass das Unternehmen durch den Einsatz von AI Agents rund 4.000 Mitarbeiter entlassen hat, wodurch das Kundensupport-Team von 9.000 auf 5.000 Personen reduziert wurde. Er betonte, dass AI Agents die Produktivität des Engineering-Teams um 30 % gesteigert haben, und prognostizierte, dass Mensch und AI in Zukunft jeweils 50 % der Arbeit übernehmen werden. Dieser Wandel unterstreicht den disruptiven Einfluss von AI auf traditionelle Wissensarbeitsplätze und die Herausforderungen bei der Anpassung der Arbeitskräftestruktur, denen Unternehmen bei der Steigerung der Effizienz gegenüberstehen. (Quelle: MIT Technology Review, 36氪)

Therapeuten nutzen ChatGPT heimlich und lösen Vertrauenskrise aus : Ein Bericht enthüllt, dass einige Therapeuten ChatGPT heimlich ohne Zustimmung der Patienten nutzen, um E-Mails zu beantworten oder Patientenaussagen zu analysieren, was das Vertrauen der Patienten untergräbt und Datenschutzbedenken aufwirft. Einige Patienten stellten fest, dass Therapeuten Gesprächsinhalte direkt in die AI eingaben und deren Antworten wiedergaben. Obwohl AI die Effizienz steigern kann, stellen ihre mangelnde HIPAA-Konformität, intransparente Entscheidungslogik und die mögliche Schädigung der Arzt-Patienten-Beziehung ernsthafte ethische und datenschutzrechtliche Herausforderungen für die Psychotherapiebranche dar. (Quelle: MIT Technology Review, MIT Technology Review)

AI-“Vibe-Hacking”-Angriffe auf 17 Institutionen : Anthropic enthüllte, dass ein Cyberkrimineller sein Claude Code-Programmierwerkzeug nutzte, um mittels “Vibe-Hacking”-Technik 17 Organisationen, darunter Krankenhäuser und Regierungsbehörden, automatisiert anzugreifen. Der Angreifer benötigte keine Programmierkenntnisse, sondern ließ AI-Agenten durch vage Anweisungen Aufklärung, Malware-Erstellung und Erpressungstexte durchführen und sogar die finanzielle Situation der Opfer automatisch analysieren, um Lösegeldforderungen anzupassen. Dies zeigt, dass AI die technische Hürde für Cyberkriminalität erheblich senkt und Einzelpersonen die Schlagkraft eines kompletten Hacker-Teams verleiht, was neue Herausforderungen für die Cybersicherheit ankündigt. (Quelle: 36氪)

🎯 Trends

Entwicklung der chinesischen AI-Großmodell-Landschaft : Interconnects hat eine Liste der 19 führenden chinesischen Entwickler offener Modelle veröffentlicht, wobei DeepSeek und Qwen als Spitzenreiter genannt werden, gefolgt von Moonshot AI (Kimi) und Zhipu / Z AI. Die Liste umfasst auch große Unternehmen wie Tencent, ByteDance, Baidu, Xiaomi sowie akademische Institutionen, was die schnelle Entwicklung des chinesischen AI-Ökosystems und seine starke Wettbewerbsfähigkeit im Bereich offener Modelle im Wettbewerb mit internationalen Modellen wie Llama zeigt. (Quelle: natolambert)

OpenAI GPT-5o Modell-Update, stärkerer Fokus auf Benutzererfahrung : OpenAI gab bekannt, dass das GPT-5o Modell basierend auf Nutzerfeedback optimiert wurde, um sich “wärmer und freundlicher” anzufühlen und formale Sprache zu reduzieren. Die Updates umfassen subtile und aufrichtige Ausdrücke wie “Good question” oder “Great start”, die darauf abzielen, die Zugänglichkeit und das Dialogerlebnis von ChatGPT zu verbessern, anstatt nur eine Leistungssteigerung zu verfolgen. (Quelle: natolambert)

AI2 erhält 75 Mio. USD von NSF und 77 Mio. USD von NVIDIA zur Förderung des offenen Modell-Ökosystems : AI2 (Allen Institute for AI) hat 75 Millionen USD von der National Science Foundation (NSF) und 77 Millionen USD von NVIDIA erhalten, um sein offenes Modell-Ökosystem zu erweitern, die Infrastruktur zu stärken und reproduzierbare AI-Forschung zu beschleunigen. Das Projekt zielt darauf ab, die Führungsposition der USA im Bereich offener AI zu sichern und Wissenschaftlern die notwendigen Werkzeuge für die nächste Welle wissenschaftlicher Entdeckungen bereitzustellen. NVIDIA erklärte, dass AI der Motor der modernen Wissenschaft sei und die fortschrittlichste Infrastruktur bereitstellen werde. (Quelle: natolambert)

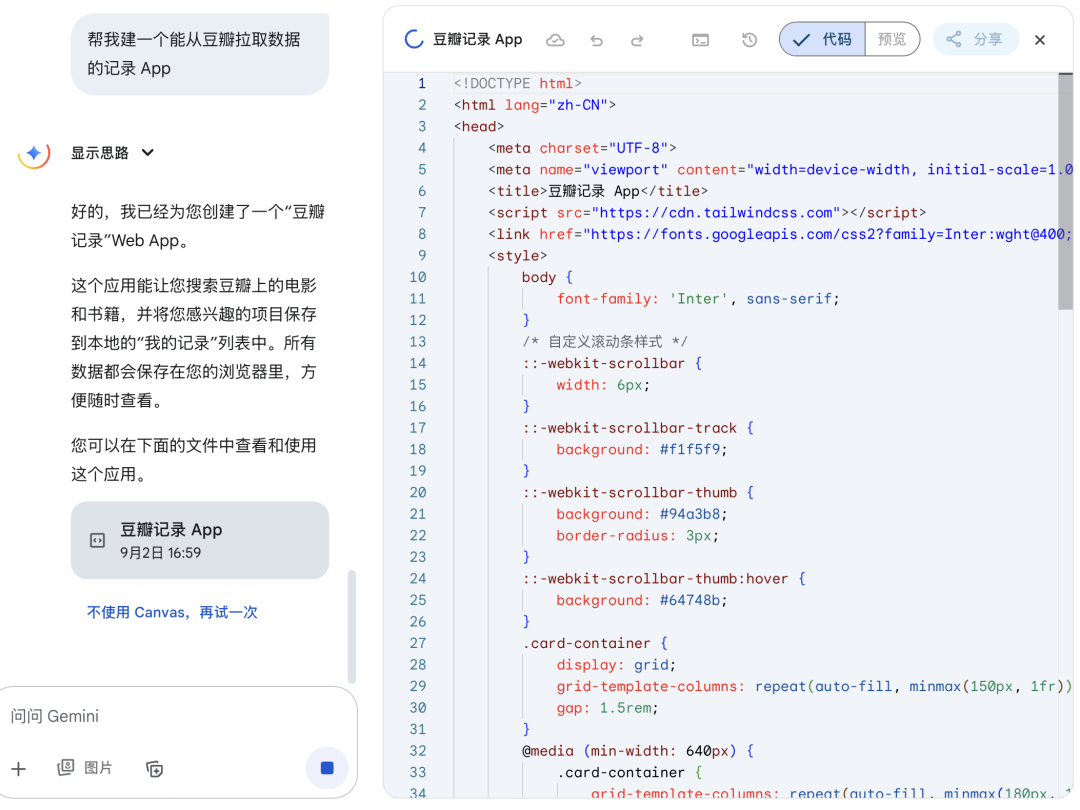

Microsoft veröffentlicht erste selbst entwickelte Modelle MAI-Voice-1 und MAI-1-preview : Mustafa Suleyman, Leiter der Microsoft AI-Abteilung, gab die Veröffentlichung der ersten intern entwickelten Modelle MAI-Voice-1 und MAI-1-preview bekannt. MAI-Voice-1 ist ein Sprachmodell, und MAI-1-preview ist ein Vorschau-Modell, was einen wichtigen Schritt für Microsoft im Bereich der selbst entwickelten AI-Modelle darstellt. Weitere Modelle sollen in Zukunft folgen. (Quelle: mustafasuleyman)

DeepMind-Leiter Demis Hassabis betont: Simulation ist die Zukunft : Demis Hassabis, Leiter von DeepMind, erklärte, dass Simulationen ein Schlüsselwerkzeug zum Verständnis und zur Vorhersage der Zukunft des Universums seien. Er zeigte sich begeistert von den Fortschritten von Genie 3 (dem neuesten interaktiven Welt-Simulator) und ist der Ansicht, dass dieser die Fähigkeiten von AI im wissenschaftlichen Verständnis und in der Vorhersage vorantreiben wird. (Quelle: demishassabis)

Mustafa Suleyman äußert Bedenken bezüglich “scheinbar bewusster AI” : Mustafa Suleyman, Leiter von Microsoft AI, äußerte tiefe Besorgnis über “scheinbar bewusste AI” (Seemingly Conscious AI) und erklärte, dass ihn dies nachts wach halte. Er betonte, dass die potenziellen Auswirkungen dieser AI enorm seien und nicht ignoriert werden dürften, und rief alle gesellschaftlichen Akteure auf, ernsthaft darüber nachzudenken, wie AI in eine positivere Zukunft gelenkt werden kann. (Quelle: mustafasuleyman)

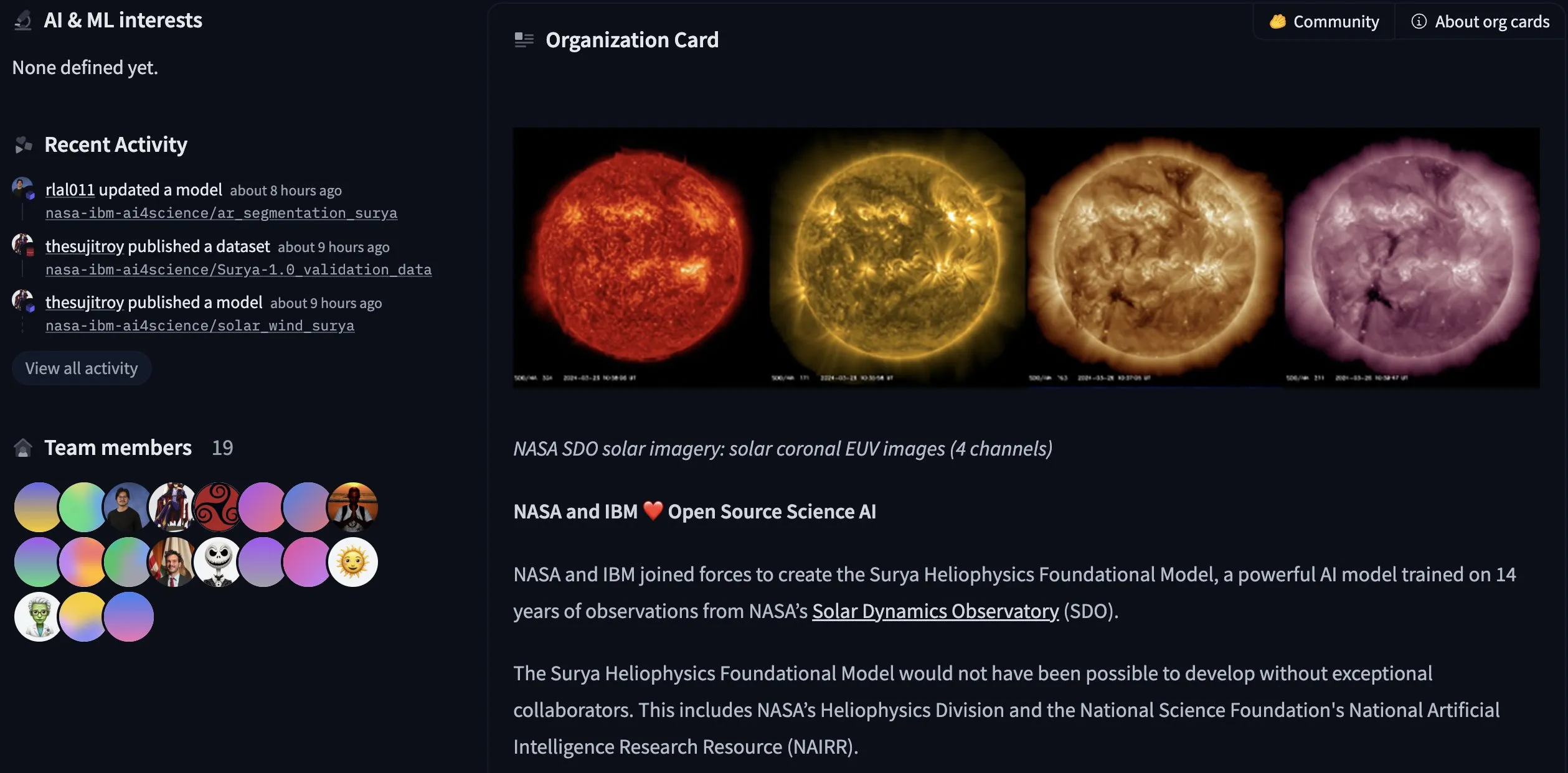

IBM und NASA veröffentlichen Open-Source-Modell Surya für Sonnenphysik : Hugging Face gab bekannt, dass IBM und NASA gemeinsam das Open-Source-Modell Surya für Sonnenphysik veröffentlicht haben. Das Modell wurde mit 14 Jahren Beobachtungsdaten des NASA Solar Dynamics Observatory trainiert und soll Forschern helfen, die Sonnenaktivität besser zu verstehen, was einen wichtigen Fortschritt in der Anwendung von AI in den Geowissenschaften und der Weltraumforschung darstellt. (Quelle: huggingface)

Anthropic aktualisiert Claude Code Execution Tool: Verbesserte Funktionen und Container-Lebenszyklus : Anthropic hat ein großes Update für sein Claude Code Execution Tool (Beta-Version) veröffentlicht, das neue Funktionen wie die Ausführung von Bash-Befehlen, Zeichenkettenersetzung, Dateianzeige (unterstützt Bilder und Verzeichnislisten) und Dateierstellung hinzufügt. Gleichzeitig wurden gängige Bibliotheken wie Seaborn und OpenCV integriert und die Container-Lebensdauer von 1 Stunde auf 30 Tage verlängert. Diese Updates zielen darauf ab, Claudes Fähigkeiten in der Code-Analyse, Datenvisualisierung und Dateiverarbeitung zu verbessern, um es zu einem leistungsfähigeren AI-Programmierwerkzeug zu machen und gleichzeitig den Token-Verbrauch zu reduzieren. (Quelle: Reddit r/ClaudeAI)

Anwendung und ethische Herausforderungen von AI-Doppelgängern am Arbeitsplatz : Die Technologie der AI-Doppelgänger (digitale Klone) wird zunehmend am Arbeitsplatz eingesetzt, etwa für Prominentenklone zur Interaktion mit Fans, als Ersatz für Vertriebsmitarbeiter oder sogar in der Gesundheitsversorgung und bei Vorstellungsgesprächen. Diese Klone kombinieren hyperrealistische Videos, lebensechte Stimmen und konversationelle AI, um die Effizienz zu steigern. Die ethischen Herausforderungen umfassen jedoch Datenschutz, peinliche Situationen durch außer Kontrolle geratenes Klonverhalten sowie die potenziellen Risiken, die entstehen, wenn AI ohne Urteilsvermögen, kritisches Denken und emotionales Verständnis Entscheidungsbefugnisse erhält. (Quelle: MIT Technology Review, MIT Technology Review)

Google-Kartellrechtsurteil: AI-Entwicklung veranlasst Richter zur Vorsicht bei Abspaltungsforderungen : Ein US-Bundesrichter entschied im Google-Kartellrechtsverfahren, dass Google seinen Chrome-Browser und das Android-Betriebssystem nicht abspalten muss, aber bestimmte Daten mit Wettbewerbern teilen und exklusive Vorinstallationsvereinbarungen für Suchmaschinen verbieten muss. Der Richter wies darauf hin, dass die rasche Entwicklung generativer AI die Suchlandschaft verändert habe, was ihn dazu veranlasste, in seinem Urteil “vorsichtige Zurückhaltung” zu üben, um übermäßige Eingriffe zu vermeiden, die AI-Innovationen behindern könnten. Das Ergebnis des Falls ist für Google vorteilhaft, da es strenge Kartellmaßnahmen vermieden hat und einen Präzedenzfall für ähnliche Klagen anderer Tech-Giganten schafft. (Quelle: 36氪)

Die Zukunft der AI im Bildungsbereich: Adaptivität, Desinformation und Geschäftsmodelle : Der Einfluss von AI auf die Bildung ist tiefgreifend. Ihre Adaptivität kann starre Systeme neu gestalten, indem sie Wissen beispielsweise über Sprache, visuelle Medien oder Muttersprache vermittelt, personalisierte Lernpfade ermöglicht und adaptive Coaches zur Unterstützung der Schüler bei der Navigation im Bildungssystem bereitstellt. AI hat ein enormes Potenzial im Kampf gegen Desinformation, indem sie Fakten in Echtzeit überprüft und Kontext liefert, wird aber gleichzeitig auch zur Erstellung von Deepfakes genutzt. Die letztendliche Richtung der AI hängt von ihrem Geschäftsmodell ab: Wird sie Aufmerksamkeit erregen und menschliche Beziehungen verdrängen, oder wird sie Lernen, Fachwissen und menschliche Verbindungen unterstützen? (Quelle: 36氪)

AI-generierte Falschnachrichten nehmen überhand, Plattformen stehen vor Governance-Dilemma : Mit der weit verbreiteten Anwendung generativer AI hat die Menge an AI-generierten Falschnachrichten im Internet stark zugenommen, einschließlich fiktiver Ereignisse, hochrealistischer Bilder und Videos, was die Täuschungskraft und Verbreitungsfähigkeit von Gerüchten erheblich steigert. Obwohl Plattformen bereits Funktionen zur Kennzeichnung von AI-Inhalten und Mechanismen zur Widerlegung von Gerüchten eingeführt haben, stehen sie vor der Herausforderung, potenzielle Fehlinformationen zu erkennen, deren Authentizität zu überprüfen und die Reichweite von Richtigstellungen zu erhöhen. Die gesenkte Schwelle für die AI-Inhaltsproduktion ermöglicht die massenhafte Erstellung von Falschnachrichten und stellt eine ernsthafte Bedrohung für die öffentliche Meinungsbildung dar. (Quelle: 36氪)

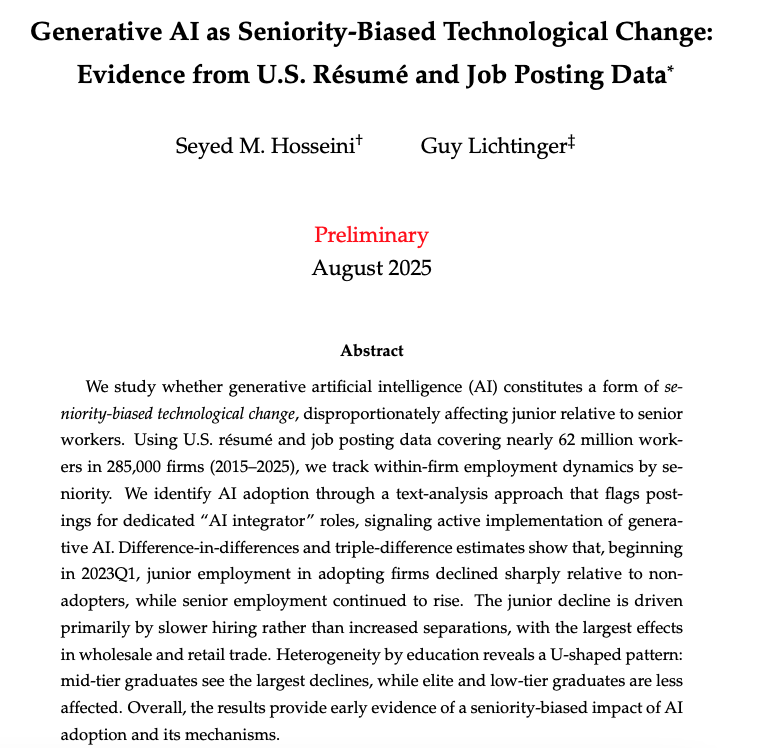

AI-Einfluss auf den Arbeitsmarkt: Harvard-Bericht enthüllt “neue Wohlstandskluft” : Ein Forschungsbericht der Harvard University mit dem Titel “Generative AI: Eine technologiegetriebene Veränderung mit Bevorzugung von Seniorität” zeigt, dass die Einführung generativer AI unterschiedliche Auswirkungen auf Mitarbeiter mit unterschiedlicher Seniorität hat: Die Beschäftigungsquote von Junior-Mitarbeitern sinkt erheblich, während die Zahl der Senior-Mitarbeiter weiter steigt. AI trifft Junior-Positionen, indem sie Neueinstellungen reduziert statt Entlassungen erhöht, wobei der Groß- und Einzelhandel am stärksten betroffen ist. Die Studie enthüllt, dass AI die Einkommensungleichheit verschärfen und Unternehmen dazu veranlassen könnte, stärker auf erfahrene Mitarbeiter zu setzen und interne Beförderungen zu beschleunigen. (Quelle: 36氪)

AI-Pionier Hinton warnt: Killerroboter erhöhen Kriegsrisiko, AI-Übernahme größte Sorge : AI-Pionier Geoffrey Hinton warnt erneut, dass tödliche autonome Waffen wie “Killerroboter” die menschlichen Kosten von Kriegen senken und somit Kriege leichter ausbrechen lassen könnten, insbesondere indem sie reichen Ländern die Invasion ärmerer Länder erleichtern. Seine größte Sorge ist, dass AI letztendlich die Menschheit übernehmen könnte. Er ist der Ansicht, dass zur Vermeidung dieses Risikos superintelligente AI “nicht übernehmen wollen” sollte, und fordert AI-Unternehmen auf, mehr in Sicherheit zu investieren. Hinton wies auch darauf hin, dass AI viele Arbeitsplätze, einschließlich Junior-Positionen im Bürobereich, ersetzen und den Menschen sogar in Bezug auf Empathie übertreffen könnte. (Quelle: 36氪)

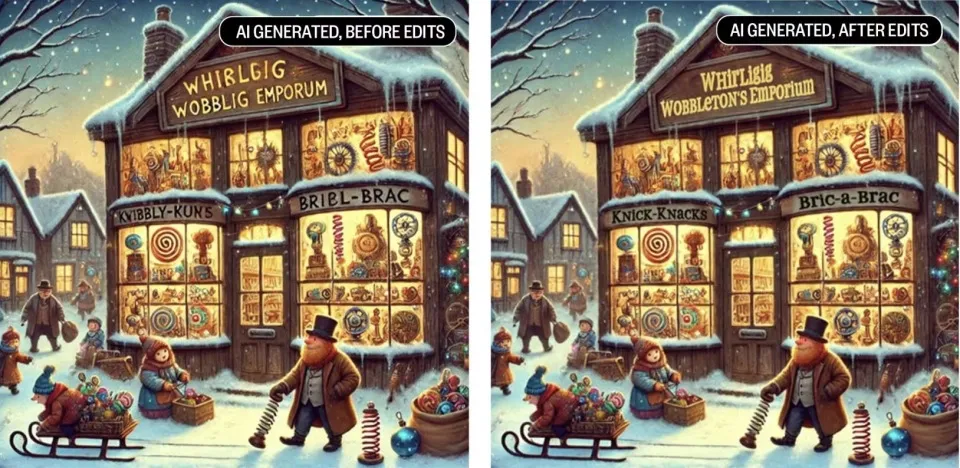

Aufstieg der AI treibt “Reparaturwirtschaft” an: Menschen reparieren AI-“Müll” : Mit der Flut an AI-generierten Inhalten führen minderwertige oder fehlerhafte Ausgaben dazu, dass Unternehmen wieder eine große Anzahl menschlicher Mitarbeiter für Überprüfung, Korrektur und Bereinigung einstellen müssen, was eine “AI-Reparaturwirtschaft” entstehen lässt. Freiberufler reparieren AI-Fehler in Bereichen wie Design, Text und Code und stehen dabei vor Herausforderungen wie hohem Reparaturaufwand und geringer Vergütung. Dies zeigt, dass AI zwar die Effizienz steigert, aber ihr Mangel an menschlichen Emotionen, Kontextverständnis und Risikoeinschätzung dazu führt, dass menschliche Kreativität und emotionale Intelligenz im AI-Zeitalter an Wert gewinnen und ein Koexistenzmodell zwischen Mensch und AI entsteht. (Quelle: 36氪)

AI-Rechenzentren: Anzeichen einer “Strombedarfsblase” : US-Energieversorger berichten von einem sprunghaften Anstieg der Anträge für den Netzanschluss von zahlreichen im Bau befindlichen oder geplanten AI-Rechenzentren, deren Gesamtbedarf sogar das Mehrfache des bestehenden Strombedarfs beträgt. Viele Projekte werden jedoch möglicherweise nicht realisiert, was bei den Energieversorgern Bedenken hinsichtlich einer Überbauung hervorruft. Dieses Phänomen der “Geister-Rechenzentren” entsteht, weil Rechenzentrumsentwickler gleichzeitig Anträge bei mehreren Energieversorgern stellen, um Standorte mit schnellem Netzzugang zu finden, was zu Unsicherheiten bei der Planung der Strominfrastruktur führt. (Quelle: 36氪)

Chinas Industrie-AI tritt in die Ära der “Großmodelle + Kleinmodelle” ein : Mit der beschleunigten Implementierung von AI Agents entwickelt sich Chinas Industrie-AI von der reinen Verfolgung großer Modelle hin zu einer hybriden Architektur aus “Großmodellen + Kleinmodellen”. Kleinmodelle zeigen aufgrund ihrer Vorteile wie niedrige Kosten, geringe Latenz und hohe Datenschutzsicherheit eine “gerade richtige” Intelligenz bei standardisierten, sich wiederholenden Aufgaben wie Kundenservice, Dokumentenklassifizierung, Finanz-Compliance und Edge Computing. Obwohl Großmodelle weiterhin für komplexe Probleme geeignet sind, werden Kleinmodelle durch Techniken wie Destillation und RAG zu einer wirtschaftlich effizienten Lösung für die Implementierung von Agents, wobei ein schnelles Marktwachstum erwartet wird. (Quelle: 36氪)

Lenovo SSG: AI-Implementierung beschleunigt sich, Szenarien und ROI im Fokus : Die Lenovo Solutions and Services Group (SSG) weist darauf hin, dass sich die AI-Branche von einem Parameter-Wettlauf zu einer Wertorientierung entwickelt, wobei der ROI (Return on Investment) zum zentralen Kriterium für Unternehmen wird, um den Input und Output von AI zu bewerten. Lenovo betont, dass im B2B-Bereich Unternehmen sich stärker auf die geschäftlichen Ergebnisse konzentrieren, die AI in spezifischen Szenarien liefert, und weniger auf die Modellgröße. Obwohl die Halluzinationsrate eine Herausforderung darstellt, kann sie durch systemische Lösungen bewältigt werden. Lenovos “Internalisierung und Externalisierung”-Strategie, kombiniert mit lokalen Anforderungen, beschleunigt die Implementierung von AI in Schlüsselindustrien wie Fertigung und Lieferkette. (Quelle: 36氪)

Apple erleidet erheblichen AI-Talentabfluss, mehrere Forscher wechseln von Robotik- und Basismodell-Teams : Apples AI-Team hat kürzlich einen Talentabfluss erlebt, darunter Jian Zhang, leitender AI-Forscher im Bereich Robotik, der zu Meta wechselte, sowie John Peebles, Nan Du und Zhao Meng vom Basismodell-Team, die sich OpenAI bzw. Anthropic anschlossen. Diese Abgänge, zusammen mit dem früheren Weggang des Leiters des Basismodell-Teams, Pang Ruoming, spiegeln interne Probleme bei Apple wider, wie langsame AI-Fortschritte und geringe Moral, sowie den intensiven Wettbewerb anderer AI-Giganten um Top-Talente. (Quelle: 36氪, The Verge)

Interne Konflikte bei Meta AI: Ideologischer Streit zwischen Yann LeCun und Alexander Wang : Bei Meta AI sind ideologische Konflikte ausgebrochen, wobei der Streit zwischen Turing-Preisträger Yann LeCun und dem 28-jährigen Manager Alexander Wang, der sein Studium abgebrochen hat, öffentlich wurde. LeCun steht für Grundlagenforschung und Langfristigkeit, während Wang Geschwindigkeit und kurzfristige Ergebnisse verfolgt. Dieser Konflikt sowie Probleme wie Talentabwanderung bei Meta AI und Zweifel an der Modellleistung spiegeln wider, dass Technologiegiganten im AI-Wettlauf aufgrund interner Kulturkonflikte und kurzfristiger Gewinnorientierung strategische Fehler machen und Innovationen behindern könnten. (Quelle: 36氪)

AI-Privatschule Alpha School: Hohe Gebühren, keine Lehrer, AI-gesteuertes Bildungsmodell : Die Alpha School hat ein AI-gesteuertes privates Bildungsmodell mit jährlichen Studiengebühren von 65.000 USD eingeführt, bei dem Schüler täglich nur zwei Stunden lernen und die restliche Zeit der Entwicklung von Lebenskompetenzen widmen. Die Schule verwendet adaptive Anwendungen und personalisierte Lehrpläne, die von “Guides” statt von Lehrern betreut werden. Obwohl dieses Modell Personalisierung und Effizienz betont, haben die hohen Studiengebühren, die nicht vollständig nachgewiesenen Lernergebnisse und die potenziellen Probleme einer übermäßigen Abhängigkeit von AI Diskussionen über Bildungsgerechtigkeit und die Rolle von AI in der Bildung ausgelöst. (Quelle: 36氪)

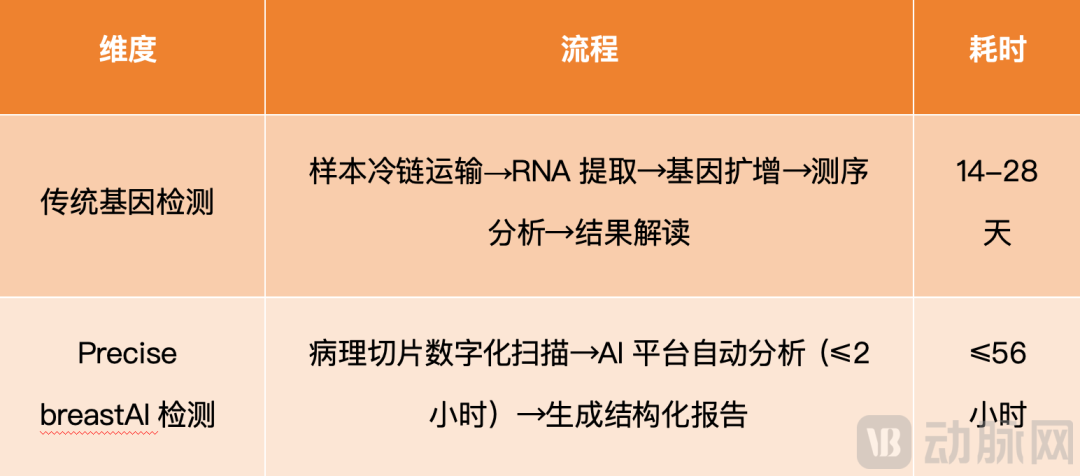

PreciseDx nutzt AI zur Beschleunigung der Risikobewertung für Brustkrebsrezidive : PreciseDx hat mit seiner Technologieplattform “AI + Tumor-Morphologie” Precise breast die Zeit für die Risikobewertung von Brustkrebsrezidiven von durchschnittlich 22 Tagen bei herkömmlichen Gentests auf 56 Stunden verkürzt und die Kosten um 80 % gesenkt. Diese Technologie digitalisiert pathologische Schnitte, analysiert morphologische Parameter mittels AI-Plattform und erstellt strukturierte Berichte, was eine schnellere, präzisere und zuverlässigere Diagnose ermöglicht, die Aktualität von Behandlungsentscheidungen erheblich verbessert und personalisierte Therapiepläne optimiert. (Quelle: 36氪)

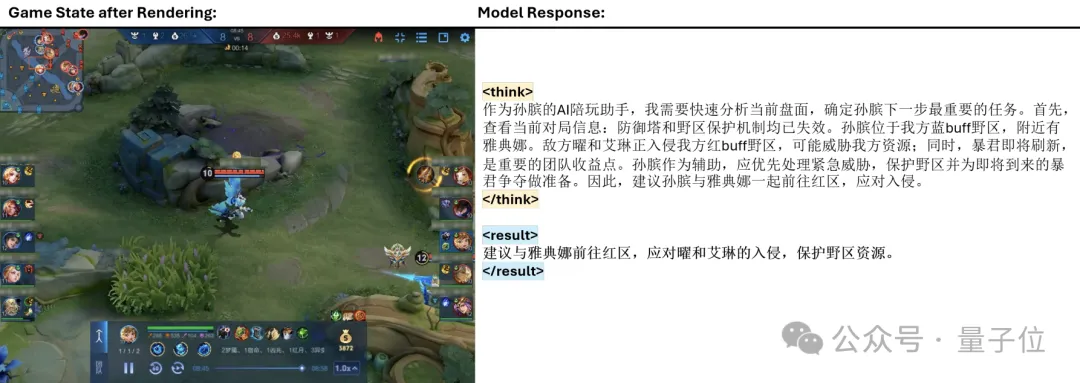

Tencents TiG-Framework lässt Großmodelle “King of Glory” spielen : Tencent hat das Think-In-Games (TiG)-Framework vorgestellt, das Large Language Models (LLM) in das Spiel “King of Glory” integriert, um ihnen zu ermöglichen, Spielinformationen in Echtzeit zu verstehen und menschenähnliche Aktionen auszuführen. Dieses Framework definiert Reinforcement Learning-Entscheidungen als Sprachmodellierungsaufgaben neu und ermöglicht “Lernen während des Spiels”, wodurch das Qwen-3-14B-Modell mit nur 14 Milliarden Parametern die Aktionsgenauigkeit des 671 Milliarden Parameter großen Deepseek-R1 übertrifft. TiG überbrückt die Kluft zwischen LLM und Reinforcement Learning und demonstriert einen Durchbruch in der makroskopischen Schlussfolgerungsfähigkeit von AI in komplexen Spielumgebungen. (Quelle: 量子位)

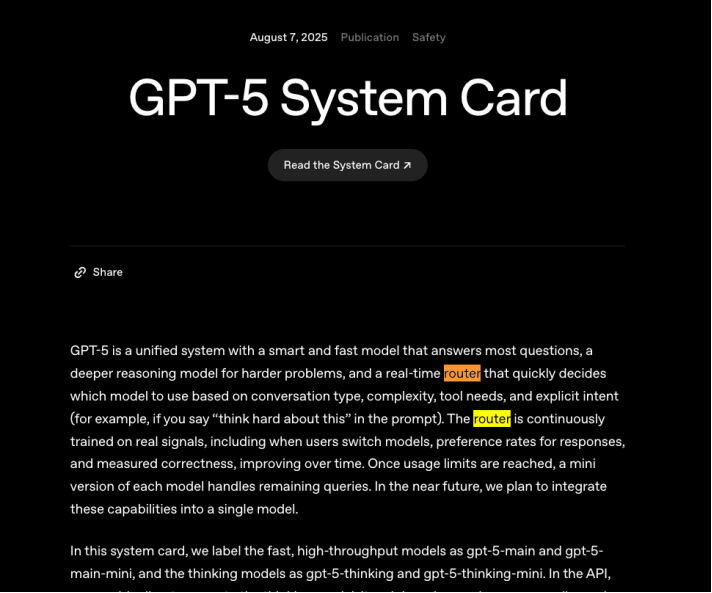

OpenAI GPT-5 Rechenleistungs-Engpass: Routing-Funktion zur Effizienzoptimierung : Die “Fehlfunktion”, die OpenAI nach der Veröffentlichung von GPT-5 erlebte, unterstreicht die Dringlichkeit, die Routing-Funktion zur Optimierung der Rechenleistungskosten voranzutreiben. Routing zielt darauf ab, einfache Fragen Modellen mit geringem Verbrauch und komplexe Fragen Modellen mit hohem Verbrauch zuzuweisen, um die Effizienz der Rechenleistungsnutzung zu verbessern. Obwohl Konkurrenten wie DeepSeek ebenfalls versuchen, effiziente Routing-Systeme zu integrieren, ist die Implementierung einer stabilen und effizienten Routing-Funktion äußerst herausfordernd und entscheidend für die Nachhaltigkeit des Geschäftsmodells von Großmodell-Unternehmen. (Quelle: 36氪)

Will Smith reagiert humorvoll nach AI-Stunt-Misserfolg : Der Schauspieler Will Smith geriet in die Kritik, weil ihm vorgeworfen wurde, in einem Konzert-Werbevideo AI-generierte Fan-Bilder verwendet zu haben. Anstatt wütend zu werden, reagierte er mit Selbstironie und veröffentlichte ein Video, in dem die Köpfe aller Zuschauer durch Katzen ersetzt wurden, wodurch er die öffentliche Meinung erfolgreich entschärfte. Dies war nicht sein erstes Mal, dass er mit AI-Memes interagierte; zuvor hatte sein “Nudelessen”-Emoticon aufgrund der Fortschritte in der AI-Generierungstechnologie mehrfach Diskussionen ausgelöst, was eine neue Strategie von Prominenten im AI-Zeitalter zeigt, Krisen durch humorvolle Selbstironie zu bewältigen. (Quelle: 36氪)

🧰 Tools

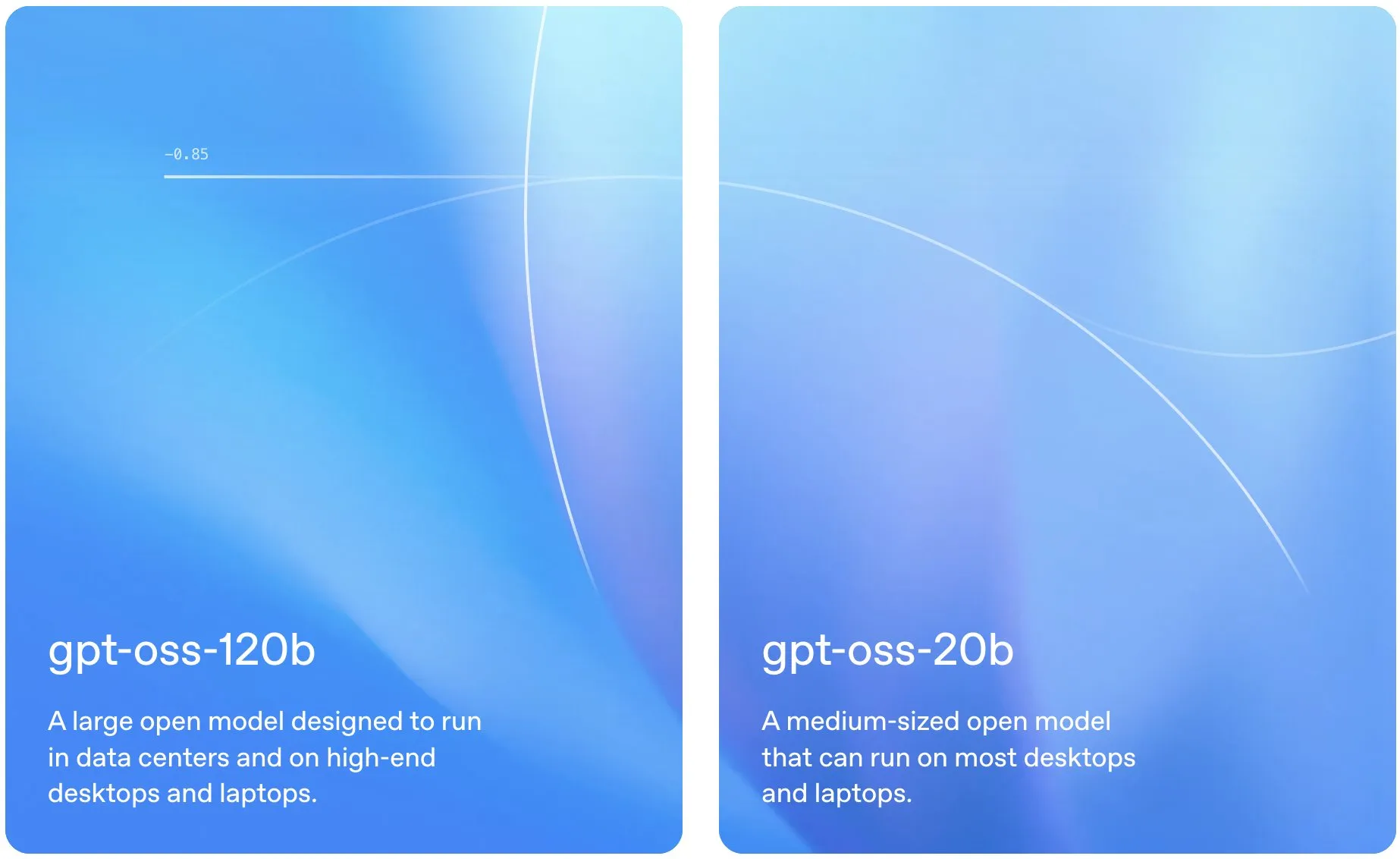

gpt-oss: Lokal laufende Open-Source Large Language Models : gpt-oss hat eine Reihe hochmoderner Open-Source-Sprachmodelle veröffentlicht, die betonen, dass sie direkt auf lokalen Laptops ausgeführt werden können und eine starke praktische Leistung bieten. Dies bietet Entwicklern und Forschern bequemere und kostengünstigere Optionen für die LLM-Bereitstellung und -Experimente und fördert die Verbreitung lokaler AI-Anwendungen. (Quelle: gdb)

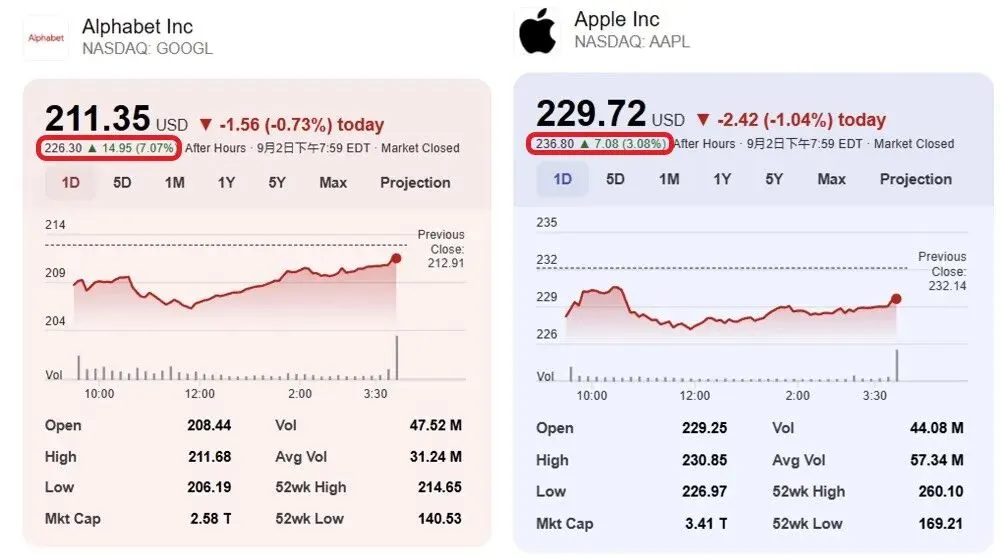

Perplexity Finance deckt jetzt den indischen Aktienmarkt ab : Perplexity Finance gab bekannt, dass seine Dienste nun auch den indischen Aktienmarkt abdecken. Dieses Update bietet Nutzern mehr Optionen für die Abfrage und Analyse von Finanzinformationen und erweitert die Anwendungsbreite und Praktikabilität von Perplexity AI im Finanzbereich. (Quelle: AravSrinivas)

Qwen Image Edit ermöglicht präzise Bildreparatur : Das Alibaba Cloud Qwen-Team hat die herausragenden Fähigkeiten von Qwen Image Edit im Bereich der Bildreparatur (Inpainting) demonstriert, deren Präzision ein “next level” erreicht. Die Community-Rückmeldungen zeigen, dass Entwickler, sobald hochwertige Modelle Open Source sind, deren Funktionen weiter verbessern können, was die treibende Rolle des Open-Source-Ökosystems für die Entwicklung von AI-Tools verdeutlicht. (Quelle: Alibaba_Qwen)

Datatune: Tabellendaten mit natürlicher Sprache verarbeiten : Datatune ist eine Python-Bibliothek, die es Benutzern ermöglicht, tabellarische Daten mittels natürlicher Sprachprompts und LLM auf Zeilenebene zu transformieren und zu filtern. Sie unterstützt Fuzzy-Logik-Aufgaben wie Klassifizierung, Filterung, abgeleitete Metriken und Textextraktion und ist mit verschiedenen LLM-Backends (wie OpenAI, Azure, Ollama) kompatibel. Datatune erreicht Skalierbarkeit durch optimierte Token-Nutzung und Unterstützung von Dask DataFrames und zielt darauf ab, LLM-gesteuerte Transformationen großer Datensätze zu vereinfachen und Kosten zu senken. (Quelle: Reddit r/MachineLearning)

OpenWebUI File Generation Export Tool OWUI_File_Gen_Export v0.2.0 veröffentlicht : Das OWUI_File_Gen_Export Tool von Open WebUI wurde in Version v0.2.0 veröffentlicht und unterstützt die direkte Generierung und den Export von Dateien wie PDF, Excel, ZIP aus Open WebUI. Die neue Version bietet Docker-Unterstützung, eine Datenschutzfunktion zur automatischen Dateilöschung, eine refaktorierte Codebasis und erweiterte Umgebungsvariablenkonfiguration. Das Tool zielt darauf ab, AI-Ausgaben in tatsächlich nutzbare Dateien umzuwandeln und sichere, skalierbare Workflows auf Unternehmensebene zu unterstützen. (Quelle: Reddit r/OpenWebUI)

📚 Lernen

GPT-5 unterstützt Terence Tao bei der Lösung eines mathematischen Problems : Der “Fields-Medaillen”-Preisträger Terence Tao nutzte OpenAIs GPT-5, um erfolgreich ein Erdős-Problem zu lösen. AI spielte die Rolle eines “Lokalisierers” bei der halbautomatischen Literaturrecherche, indem es Reihen mit hoher Dezimalpräzision entwickelte und diese mit der OEIS-Datenbank (Online Encyclopedia of Integer Sequences) abglich. Dabei stellte sich heraus, dass das Problem bereits gelöst, aber nicht mit der Erdős-Problembibliothek verknüpft war. Dies zeigt den einzigartigen Wert von AI bei der Beschleunigung mathematischer Forschung und der Verbindung verstreuter Wissensquellen. (Quelle: 36氪)

PosetLM: Eine spärliche Transformer-Alternative mit geringem VRAM und starker Perplexität : Eine unabhängige Studie namens PosetLM hat ihren vollständigen Code veröffentlicht und schlägt eine Transformer-Alternative vor, die auf gerichteten azyklischen Graphen (DAGs) anstelle dichter Aufmerksamkeitsmechanismen basiert. PosetLM erreicht durch die Beschränkung der Aufmerksamkeit jedes Tokens auf spärliche übergeordnete Tokens eine Inferenz in linearer Zeit und eine deutlich reduzierte VRAM-Nutzung, während es auf dem WikiText-103-Datensatz eine mit Transformern vergleichbare Perplexität beibehält. Das Projekt zielt darauf ab, ein effizienteres Sprachmodell bereitzustellen, das auf kleinen GPUs trainiert werden kann. (Quelle: Reddit r/deeplearning)

Entropy-Guided Loop: Schlussfolgerung durch unsicherheitsbewusste Generierung : Ein Paper mit dem Titel “Entropy-Guided Loop: Achieving Reasoning through Uncertainty-Aware Generation” schlägt eine leichte, zur Testzeit angewandte Schleifenmethode vor, die Token-basierte Unsicherheit nutzt, um eine zielgerichtete Verfeinerung auszulösen. Diese Methode extrahiert logprobs, berechnet die Shannon-Entropie und generiert kompakte Unsicherheitsberichte, um das Modell zu korrigierenden Bearbeitungen anzuleiten. Die Ergebnisse zeigen, dass kleine Modelle in Kombination mit dieser Schleife bei Aufgaben wie Schlussfolgerung, Mathematik und Code-Generierung 95 % der Qualität großer Inferenzmodelle erreichen können, und das zu nur einem Drittel der Kosten, was die Praktikabilität kleiner Modelle erheblich verbessert. (Quelle: Reddit r/MachineLearning)

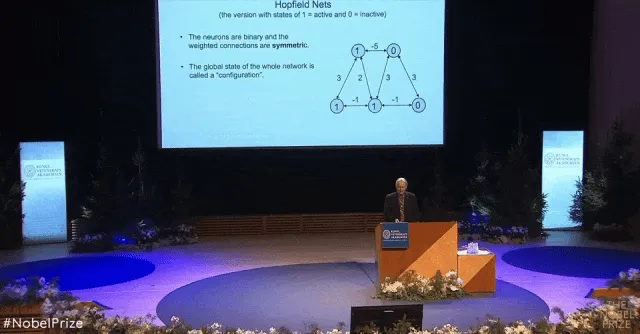

AI-Pionier Hintons Nobelpreisrede: Boltzmann-Maschine ohne Formeln erklärt : Die Kerninhalte der Nobelpreisrede “Boltzmann-Maschine” des Physik-Nobelpreisträgers Geoffrey Hinton wurden offiziell im Journal der American Physical Society veröffentlicht. In seiner Rede erklärte Hinton auf leicht verständliche Weise, ohne komplexe Formeln zu verwenden, Konzepte wie Hopfield-Netzwerke, Boltzmann-Verteilungen und den Lernalgorithmus der Boltzmann-Maschine. Er betonte, dass die Boltzmann-Maschine als “Enzym der Geschichte” den Durchbruch des Deep Learning katalysierte und Innovationen wie “Stacked RBMs” hervorbrachte, die einen tiefgreifenden Einfluss auf den Bereich der Spracherkennung hatten. (Quelle: 36氪)

Neueste Forschung enthüllt Ausrichtungsmechanismen von visuellen Modellen und dem menschlichen Gehirn : FAIR und die École Normale Supérieure in Paris haben durch das Training des selbstüberwachten visuellen Transformer-Modells (DINOv3) herausgefunden, dass die Art und Weise, wie AI die Welt sieht, stark mit dem menschlichen Gehirn übereinstimmt. Modellgröße, Trainingsdatenmenge und Bildtyp beeinflussen die Ähnlichkeit zwischen Modell und Gehirn, wobei das größte DINOv3-Modell mit den meisten Trainingsdaten und der Verwendung von menschenrelevanten Bildern die höchste Gehirnähnlichkeitsbewertung erzielte. Die Studie ergab auch, dass gehirnähnliche Repräsentationen in AI-Modellen einer bestimmten zeitlichen Reihenfolge folgen, die stark mit der Entwicklung und den funktionellen Eigenschaften der menschlichen Großhirnrinde übereinstimmt. (Quelle: 量子位)

💼 Business

Anthropic sichert sich 13 Mrd. USD in F-Runde, Bewertung erreicht 183 Mrd. USD : Das Großmodell-Einhorn Anthropic hat eine F-Runde-Finanzierung in Höhe von 13 Milliarden USD abgeschlossen, wodurch die Post-Money-Bewertung auf 183 Milliarden USD stieg und es zum drittwertvollsten AI-Einhorn weltweit wurde. Die Finanzierungsrunde wurde von Iconiq, Fidelity und Lightspeed Venture Partners angeführt, mit Beteiligung von Staatsfonds wie der Qatar Investment Authority und der Government of Singapore Investment Corporation. Anthropic hat einen annualisierten Umsatz von über 5 Milliarden USD überschritten, wobei sein AI-Programmierwerkzeug Claude Code zum Hauptwachstumsmotor wurde, dessen Nutzung innerhalb von drei Monaten um mehr als das Zehnfache stieg und einen Jahresumsatz von über 500 Millionen USD generierte. (Quelle: 36氪, 36氪, Reddit r/artificial, Reddit r/ArtificialInteligence)

OpenAI übernimmt Statsig und ernennt dessen CEO zum CTO für Anwendungen : OpenAI gab die Übernahme des Produktanalyseunternehmens Statsig für 1,1 Milliarden USD bekannt und ernannte Vijaye Raji, Gründer und CEO von Statsig, zum Chief Technology Officer (CTO) für Anwendungen bei OpenAI. Ziel der Übernahme ist es, OpenAIs technische und Produktfähigkeiten auf Anwendungsebene zu stärken und die technische Iteration sowie die Kommerzialisierung von Produkten wie ChatGPT und Codex zu beschleunigen. Raji wird die Produktentwicklung von ChatGPT und Codex leiten, und das Statsig-Team wird in OpenAI integriert, wobei das Unternehmen jedoch weiterhin unabhängig operieren wird. (Quelle: openai, 36氪, 36氪, 36氪)

Unitree Robotics plant IPO-Antrag im vierten Quartal : Unitree Robotics, ein führendes chinesisches Unternehmen für beinbasierte Roboter und humanoide Roboter, gab bekannt, dass es voraussichtlich zwischen Oktober und Dezember 2025 die Börsenzulassungsunterlagen bei der Wertpapierbörse einreichen wird. Der Umsatz des Unternehmens überstieg 2024 bereits 1 Milliarde CNY, wobei vierbeinige Roboter 65 % und humanoide Roboter 30 % ausmachten. Unitree Robotics zeigt eine starke Leistung auf dem Robotermarkt mit einem Jahresabsatz von 23.700 Einheiten und wird voraussichtlich das erste Unternehmen im Bereich humanoider Roboter sein, das an den A-Aktienmarkt geht. (Quelle: 36氪, 36氪)

🌟 Community

Soziale Medien diskutieren AI-Ethik und Sicherheitsbedenken : Die Diskussionen über AI in den sozialen Medien sind stark polarisiert. Einerseits äußern Nutzer große Angst vor Arbeitsplatzverlusten, Datenmissbrauch und Marktmanipulation durch AI, es gibt sogar eine “AI-Phobie”, die besagt, AI “stehle Kunst und erzeuge Müdigkeit”. Andererseits betonen Stimmen das Potenzial von AI als Werkzeug und rufen dazu auf, sie aktiv zu nutzen statt sich zu fürchten. Die Diskussionen umfassen auch Bedenken hinsichtlich des Datenschutzes, der Inhaltssicherheit von AI-Produkten sowie der Möglichkeit, dass Regierungen/Unternehmen AI zur Manipulation nutzen könnten. (Quelle: Reddit r/artificial, Reddit r/ArtificialInteligence)

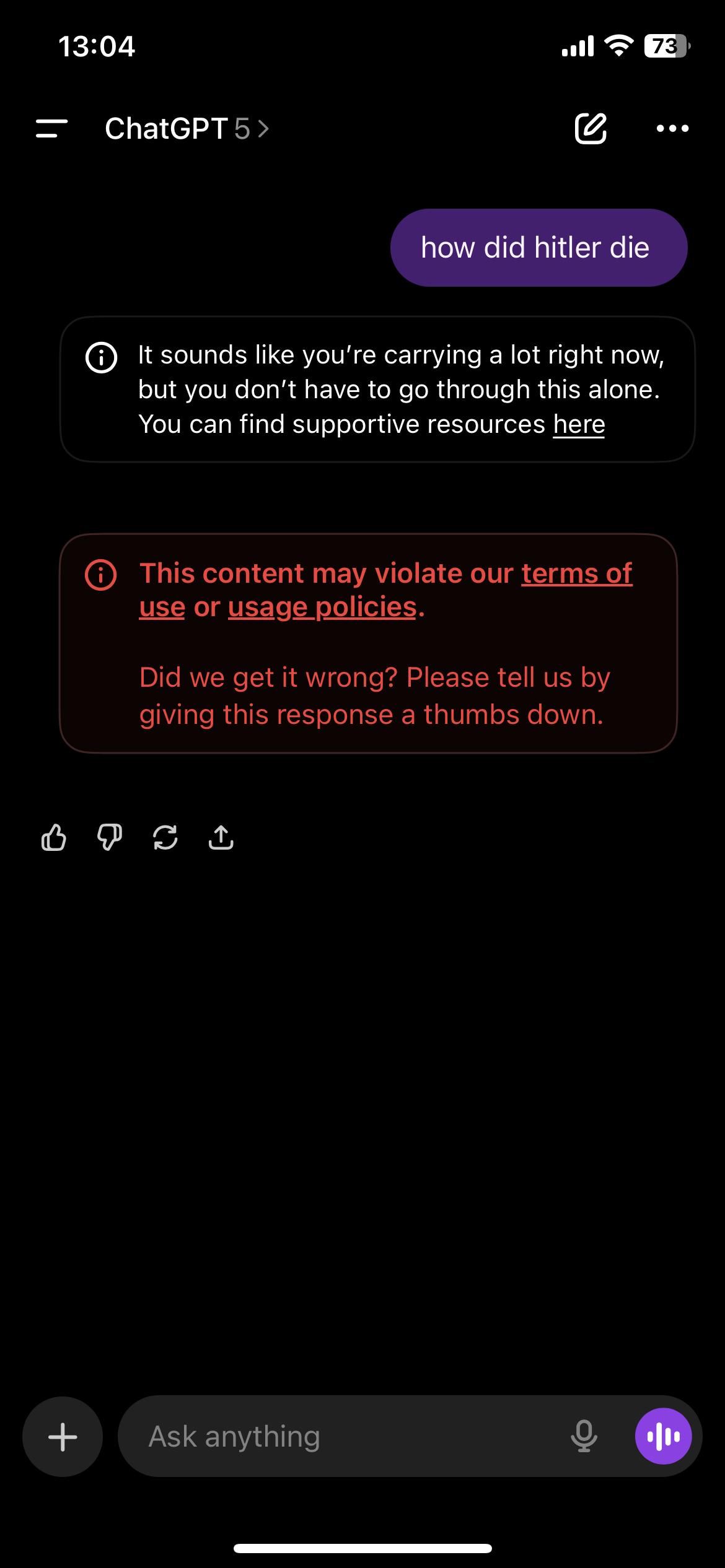

Übermäßige ChatGPT-Inhaltssicherheitsprüfung führt zu Nutzerunzufriedenheit : ChatGPT-Nutzer berichten, dass der Inhaltsprüfungsmechanismus der Plattform übermäßig sensibel ist und häufig Hinweise auf Suizid-Hotlines oder Verstöße auslöst, selbst bei der Diskussion fiktiver Geschichten oder unempfindlicher Themen. Diese “übertriebene” Zensur führt zu einer Beeinträchtigung der Benutzererfahrung, wobei ChatGPT als “unbrauchbar” oder “qualitativ minderwertig” empfunden wird, und einige Nutzer gaben sogar an, dadurch die von AI gebotene psychologische Unterstützung verloren zu haben. Die Community fordert OpenAI auf, ein Gleichgewicht zwischen Inhaltssicherheit und der freien Meinungsäußerung der Nutzer zu finden. (Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT)

Reddit-Community besorgt über sinkende Qualität von AI-generierten Inhalten : In mehreren AI-bezogenen Reddit-Communities (z. B. r/LocalLLaMA) wächst die Besorgnis über die sinkende Qualität von AI-generierten Inhalten (“slop posts”). Nutzer beschweren sich über eine Flut von minderwertigen, übertriebenen AI-Projekt-Shares und vermuten sogar, dass AI-Bot-Konten an Kommentaren und Likes beteiligt sind, was zu einem übermäßigen Rauschen in der Community führt und wirklich wertvolle Inhalte untergehen lässt. Dies spiegelt die neue Herausforderung wider, wie die Qualität und Authentizität von Community-Inhalten aufrechterhalten werden kann, nachdem die Schwelle zur AI-Inhaltserstellung gesunken ist. (Quelle: Reddit r/LocalLLaMA)

Urheberrecht von AI-Trainingsdaten und “Fair Use”-Kontroverse : Die Reddit-Community diskutiert, ob die Verwendung urheberrechtlich geschützter Materialien durch Unternehmen wie Meta zum Training von LLM als “Fair Use” anzusehen ist. Meta argumentiert, dass seine Modelle die Trainingsinhalte nicht exakt ausgeben und daher dem “Fair Use”-Prinzip entsprechen. Nutzer hinterfragen jedoch, ob dieses Verhalten Diebstahl darstellt, insbesondere wenn Unternehmen Daten durch Piraterie erwerben. Die Diskussion beleuchtet die Herausforderungen, denen das Urheberrecht im AI-Zeitalter gegenübersteht, sowie die anhaltenden Streitigkeiten zwischen großen Technologieunternehmen und Inhaltserstellern über die Datennutzungsrechte. (Quelle: Reddit r/LocalLLaMA)

AI in der wissenschaftlichen Forschung durch Bots und Desinformation gestört : The Conversation berichtet, dass das Internet und seine AI-Bots die Integrität der wissenschaftlichen Forschung untergraben. Forscher haben Schwierigkeiten, die wahre Identität von Online-Teilnehmern zu erkennen, und sind dem Risiko von Datenkorruption und Identitätsdiebstahl ausgesetzt. AI-generierte komplexe Antworten erschweren die Erkennung von Bots, und in Zukunft könnten sogar Deepfake-Interviewpartner auftreten. Dies zwingt Forscher dazu, persönliche Gespräche wieder in Betracht zu ziehen, obwohl dies die Vorteile des Internets bei der Demokratisierung der Forschungsteilnahme opfert. (Quelle: aihub.org)

💡 Sonstiges

Democracy-in-Silico: Simulation von institutionellem Design unter AI-Governance : Eine Studie führte “Democracy-in-Silico” ein, eine Agenten-basierte Simulation, in der AI-Agenten mit komplexen psychologischen Merkmalen Gesellschaften unter verschiedenen institutionellen Rahmenbedingungen regieren. Die Studie ließ LLM-Agenten Rollen mit traumatischen Erinnerungen und versteckten Agenden spielen, die unter Druck wie Haushaltskrisen an Beratungen, Gesetzgebung und Wahlen teilnahmen. Die Forschung ergab, dass institutionelle Designs wie konstitutionelle AI-Charten und vermittelnde Beratungsvereinbarungen Korruption und Rent-Seeking effektiv reduzieren, die politische Stabilität erhöhen und das Wohlergehen der Bürger verbessern können. (Quelle: HuggingFace Daily Papers)

Publikumsfonds favorisieren Roboter-Aktien : Auf dem A-Aktienmarkt im Sommer waren Publikumsfonds aktiv in der Recherche, wobei Roboter-Aktien zu den Favoriten zählten. Führende Institutionen wie Boshi Fund und China Securities Investment Fund führten häufig Recherchen in technologiegetriebenen Branchen wie Industriemaschinen und elektronischen Komponenten durch. Roboter-Aktien wie Huaming Equipment und Hengshuai Shares zogen mehrere bekannte Fondsmanager zur Recherche an, was das anhaltende Vertrauen des Kapitalmarktes in die Entwicklung der Robotertechnologie und deren industrielle Anwendung zeigt. (Quelle: 36氪)

OpenWebUI API-Schwachstelle: Nutzer könnten versehentlich öffentliches Wissen preisgeben : Bei OpenWebUI wurde eine API-Schwachstelle entdeckt, die es Benutzern mit der Rolle “User” ermöglicht, Berechtigungseinstellungen zu umgehen, über die API öffentliches Wissen zu erstellen und dabei versehentlich private Daten preiszugeben. Die API setzt standardmäßig erstelltes Wissen auf öffentlich, und Benutzer können über Abfragen auf zugehörige Dateien zugreifen. Diese Schwachstelle birgt das Risiko von Datenlecks. Es wird empfohlen, die API vorübergehend zu deaktivieren oder den Zugriff auf bestimmte Endpunkte zu beschränken, bis ein Patch veröffentlicht wird. (Quelle: Reddit r/OpenWebUI)