Schlüsselwörter:xAI, Meituans Open-Source-Großmodell, Andrew Ng, Meta, humanoider Roboter, Longcat-Flash-Chat, parallele Agenten, Scale AI Datenqualität, HITTER Tischtennisroboter, DeepSeek-V3

🔥 Fokus

Diebstahl der xAI-Codebasis: Elon Musk bestätigte, dass die gesamte Codebasis von xAI von dem ehemaligen Mitarbeiter Xuechen Li gestohlen wurde, der zu OpenAI gewechselt ist. xAI hat Klage eingereicht und wirft ihm die Verletzung von Vertraulichkeitsvereinbarungen und den Diebstahl von Geschäftsgeheimnissen vor. Es wurde auch bekannt gegeben, dass der Mitarbeiter vor seinem Ausscheiden fast 7 Millionen US-Dollar in bar abgehoben hat. Dies hat eine breite Diskussion über den Wettbewerb um AI-Talente und Geschäftsgeheimnisse ausgelöst. (Quelle: 量子位, TheRundownAI)

Meituan veröffentlicht Open-Source-LLM Longcat-Flash-Chat: Meituan hat sein erstes Open-Source-LLM, Longcat-Flash-Chat (560B MoE), veröffentlicht. Es übertrifft DeepSeek-V3.1 und Qwen3 MoE-2507 in den Bereichen Agent Tool Calling, Instruction Following und Programmierfähigkeiten und liegt auf dem Niveau von Claude4 Sonnet. Das Modell verwendet eine “Zero-Compute Expert” und Shortcut-connected MoE-Architektur, was den Trainings- und Inferenzdurchsatz erheblich verbessert. Meituan hat detaillierte Trainingsinformationen veröffentlicht, was seine tiefgreifenden Fähigkeiten im AI-Bereich unterstreicht. (Quelle: 量子位, ZhihuFrontier, karminski3)

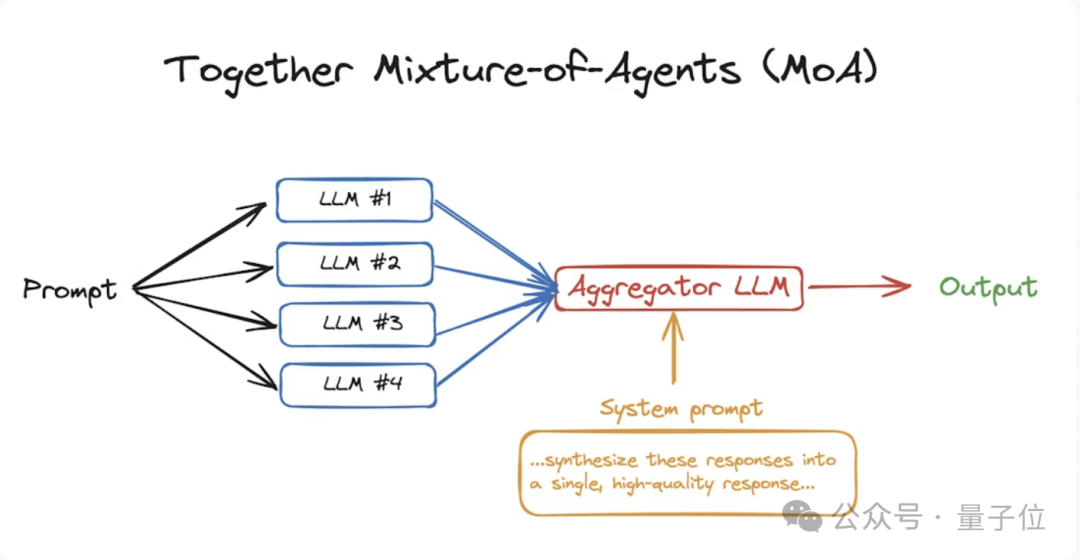

Andrew Ng betont Parallel Agents: Andrew Ng weist in seinem neuesten Brief darauf hin, dass Parallel Agents eine neue Richtung zur Steigerung der AI-Fähigkeiten darstellen. Sie ermöglichen es, durch die Zusammenarbeit mehrerer Agents schnell detaillierte Forschungsberichte zu erstellen, Programmieraufgaben zu beschleunigen oder parallele asynchrone Steuerung zu realisieren. Er ist der Ansicht, dass mit sinkenden Token-Kosten für Large Language Models Parallel Agents zu einem wichtigen Trend in der zukünftigen AI-Entwicklung werden, und verweist auf Forschungsbeispiele wie Code Monkeys und Together Mixture Of Agents (MoA). (Quelle: 量子位, DeepLearningAI)

Spannungen in der Partnerschaft zwischen Meta und Scale AI: Nach Metas 14,3 Milliarden US-Dollar Investition in Scale AI zeigen sich Risse in der Zusammenarbeit. Ruben Mayer, ein ehemaliger Scale AI-Manager, verließ Meta nach weniger als zwei Monaten. Interne Meta-Forscher äußerten ebenfalls Zweifel an der Datenqualität von Scale AI und wechselten zu anderen Datenbeschriftungsunternehmen. Gleichzeitig gibt es interne Reibereien zwischen alten und neuen Teams sowie Talentabwanderung bei Meta. Das Unternehmen erwägt zudem, Google- oder OpenAI-Modelle in seine eigenen Anwendungen zu integrieren, was auf eine schwankende AI-Strategie hindeutet. (Quelle: 36氪, TheRundownAI)

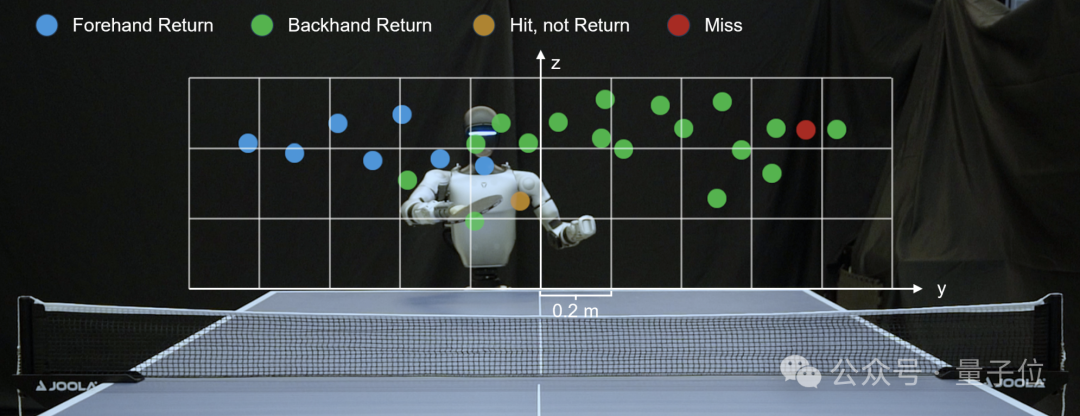

Humanoid-Roboter-Tischtennis-Meister HITTER: Das Team von Su Zhi, einem Studenten der Yao-Klasse der Tsinghua-Universität, veröffentlichte das Paper “HITTER”, das einen hierarchischen Rahmen vorschlägt, der Modellplanung und Reinforcement Learning kombiniert. Dies ermöglicht es einem Humanoid-Roboter, Tischtennis stabil und kontinuierlich mit einer Reaktionszeit im Subsekundenbereich zu spielen, wobei bis zu 106 Schläge ausgetauscht werden können. Der Roboter verwandelt die Handfläche eines Unitree G1 in einen Schläger, verwendet OptiTrack-Kameras zur Ballverfolgung und wird unter Berücksichtigung menschlicher Bewegungsreferenzen trainiert. Dies demonstriert seine herausragende Fähigkeit zur Interaktion mit sich schnell bewegenden Objekten in einer dynamischen Umgebung. (Quelle: 量子位)

🎯 Trends

DeepSeek-V3.1 Modell-Update und erhöhte Transparenz: DeepSeek hat ein V3.1 Modell-Update veröffentlicht, das Preisanpassungen, Verbesserungen der Modellarchitektur (V3.1 Base basiert auf kontinuierlichem Pre-Training von V3 und erweitert den langen Kontext) sowie verbesserte Tool- und Agent-Fähigkeiten (verbesserte Leistung bei SWE/Terminal-Bench, höhere Effizienz bei mehrstufiger Inferenz) umfasst. Gleichzeitig, als Reaktion auf die “Maßnahmen zur Kennzeichnung von AI-generierten synthetischen Inhalten”, verpflichtet sich DeepSeek, alle AI-generierten Inhalte explizit zu kennzeichnen und die Trainingsdetails der V3/R1-Modelle offenzulegen. Dabei werden Daten-Governance-Prozesse und das Opt-out-Recht der Nutzer betont, um Halluzinationen und Missbrauchsrisiken zu begegnen. (Quelle: deepseek_ai, 36氪)

Google Pixel 10 Serie: Dedizierter Speicher für AI-Funktionen: Google hat in der Pixel 10 Serie 3,5 GB RAM speziell für AI-Funktionen reserviert, die nur von der TPU des Tensor G5 aufgerufen werden können. Dieser Schritt zielt darauf ab, die On-Device-AI-Erfahrung zu optimieren und mögliche Verzögerungen bei parallelem Multitasking zu beheben, da 7B-Modelle und 4-Bit-quantisierte AI-Modelle 3,5 GB bis 4 GB RAM benötigen. Dieses Design könnte jedoch die tatsächliche Lebensdauer des Telefons verkürzen, und für Benutzer, die keine On-Device-AI verwenden, reduziert sich der tatsächlich verfügbare Speicher, was eine Debatte über “gemeinschaftlich genutzten” Speicher auslöst. (Quelle: 36氪)

Tesla integriert Doubao und DeepSeek LLMs in den chinesischen Markt: Die aktualisierte offizielle Website von Tesla China zeigt, dass das neue Model Y L mit ByteDances Doubao LLM und dem DeepSeek-Modell ausgestattet sein wird, die beide über Volcanic Engine integriert werden. Das Doubao-Modell ist für Sprachbefehle und die Abfrage des Benutzerhandbuchs zuständig, während DeepSeek AI-Sprach-Chat-Dienste anbietet. Dieser Schritt wird als “dringende Nachhilfe” von Tesla angesehen, um die unzureichende Implementierung von AI-Funktionen auf dem chinesischen Markt zu kompensieren, und spiegelt auch den allgemeinen Bedarf von Automobilherstellern an der Aufrüstung von AI-Funktionen in intelligenten Cockpits wider. (Quelle: 36氪)

Rückblick auf den chinesischen Open-Source-LLM-Markt im August: Eine Zhihu-Kolumne fasst die aktive Entwicklung des chinesischen Open-Source-LLM-Marktes im August 2025 zusammen, darunter Modelle wie XBai-o4, Tencent Hunyuan Small Models, Alibaba Qwen-Image, Xiaomi MiDashengLM-7B, Xiaohongshu dots.vlm1, OpenBMB MiniCPM-V-4, die Text-, Bild-, Audio-, Multimodal- und Agent-Modelle umfassen. DeepSeek-V3.1 hat sich im Bereich Coding verbessert, zeigt aber eine etwas schwächere allgemeine Textfähigkeit. Insgesamt zeigt sich ein intensiver Wettbewerb im chinesischen AI-Ökosystem, mit einer kontinuierlichen Bereicherung der Modelltypen und -funktionen. (Quelle: ZhihuFrontier, ostrisai)

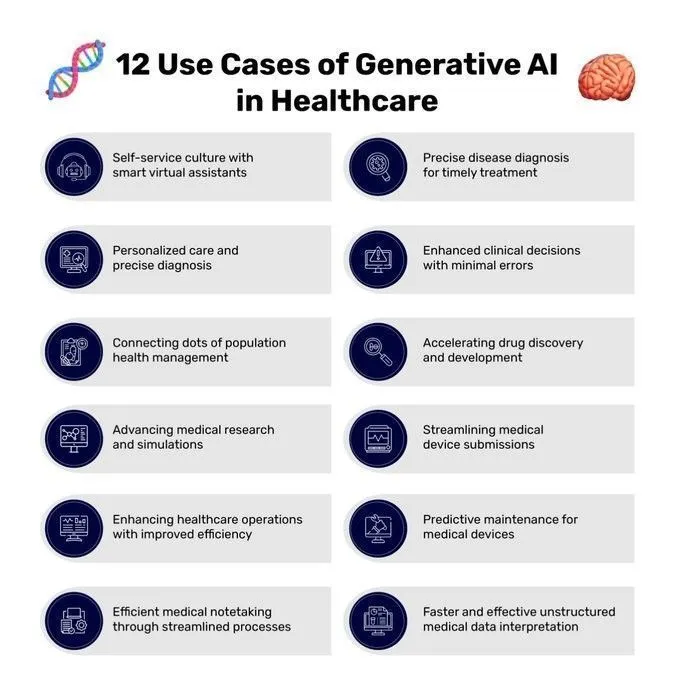

Anwendungen von Generative AI im Gesundheitswesen: Generative AI zeigt ein breites Anwendungspotenzial im Gesundheitswesen, einschließlich Krankheitsdiagnose, Medikamentenentwicklung, personalisierten Behandlungsplänen und intelligentem Gesundheitsmanagement. Durch die Analyse großer Datenmengen kann AI Ärzten helfen, präzisere Diagnosen zu stellen, medizinische Prozesse zu optimieren und Patienten maßgeschneiderte Gesundheitsdienste anzubieten. (Quelle: Ronald_vanLoon, Ronald_vanLoon, ClementDelangue)

TinyML-Implementierung auf Edge-Geräten: TinyML verändert die Art und Weise, wie AI auf eingeschränkter Hardware läuft, und ermöglicht Echtzeit-Vorhersagen, geringe Latenz, hohe Energieeffizienz und Datenschutz. Eine erfolgreiche Implementierung erfordert die Einhaltung bewährter Praktiken, darunter die Verwendung leichter Modellarchitekturen, die Optimierung der Speichernutzung (z. B. statische Speicherzuweisung, Quantisierung), die Reduzierung des Stromverbrauchs (Energiesparmodi, ereignisgesteuerte Inferenz) und Tests auf der Zielhardware. Diese Praktiken sind entscheidend für die Realisierung von AI-Funktionen auf Edge-Geräten wie Mikrocontrollern und IoT-Sensoren. (Quelle: Reddit r/deeplearning)

AI-Begleitroboter lindern Einsamkeit bei alleinlebenden Senioren: Das von dem koreanischen Startup Hyodol entwickelte AI-Spielzeug wird in großem Umfang an alleinlebende Senioren verteilt und bietet 24-Stunden-Begleitung, Gesundheitsüberwachung (z. B. Medikamentenerinnerungen, Aktivitätserkennung) und Notfallalarmfunktionen. Die Puppe verfügt über ein integriertes ChatGPT-Dialogsystem, das mit den Senioren kommunizieren und ihren emotionalen Zustand bewerten kann. Obwohl dies die Einsamkeit und den Pflegedruck lindert, wirft es auch ethische und Sicherheitsfragen auf, wie Datenschutzverletzungen, übermäßige Abhängigkeit und Auswirkungen auf Demenzpatienten. (Quelle: 量子位)

Diskussion über GPT-5s Agent-Leistung und AGI-Fortschritte: Es gibt die Ansicht, dass GPT-5 seine Agent-Leistung verbessert hat, aber es gibt Kontroversen darüber, ob dies die Nähe zu AGI signalisiert. Einige glauben, dass Skalierungsgesetze nicht universell anwendbar sind, und stehen Sam Altmans Aussagen über AGI skeptisch gegenüber, indem sie darauf hinweisen, dass LLMs bei grundlegenden Aufgaben wie Mathematik immer noch Mängel aufweisen. Google DeepMind hat im August auch eine Reihe von AI-Updates veröffentlicht, darunter Nano Banana, Gemini und Veo. Modelle wie NousResearch Hermes 4 70B und GPT-OSS 120B zeigten ebenfalls hervorragende Leistungen bei Agent-Aufgaben und Coding-Tests. (Quelle: gfodor, Teknium1, nickfrosst, Reddit r/ArtificialInteligence, _philschmid, stablequan, Reddit r/LocalLLaMA)

🧰 Tools

Fooocus Bildgenerierungssoftware-Update: Fooocus ist eine Offline-, Open-Source-Bildgenerierungssoftware, die auf Stable Diffusion XL basiert und sich auf die Vereinfachung der Benutzererfahrung konzentriert, indem sie nur die Prompts in den Mittelpunkt stellt. Das Projekt befindet sich derzeit in einer Limited Long-Term Support (LTS)-Phase, in der nur Bugfixes durchgeführt werden und es keine Pläne gibt, auf neue Modellarchitekturen wie Flux zu migrieren. Es unterstützt hochwertige Text-zu-Bild-Generierung, Bildbearbeitung (Inpaint/Outpaint), Image Prompting, verschiedene Stile und erweiterte Parameteranpassungen und bietet gute Unterstützung für geringen GPU-Speicher (4GB Nvidia). (Quelle: lllyasviel/Fooocus – GitHub Trending)

Resemble AI veröffentlicht Open-Source-TTS-Modell Chatterbox: Resemble AI hat das produktionsreife Open-Source-TTS-Modell Chatterbox unter MIT-Lizenz veröffentlicht. Das Modell zeichnet sich durch Zero-Shot-TTS aus, basiert auf einem 0.5B Llama-Backbone, unterstützt eine einzigartige Steuerung der emotionalen Übertreibung und wurde mit 500.000 Stunden Daten trainiert, wobei die Ausgabe mit einem PerTh-Wasserzeichen versehen ist. Chatterbox übertrifft in Side-by-Side-Bewertungen kontinuierlich Closed-Source-Systeme wie ElevenLabs und eignet sich für verschiedene Anwendungsbereiche wie Memes, Videos, Spiele und AI Agents. (Quelle: resemble-ai/chatterbox – GitHub Trending)

Anwendung und Vergleich von Claude Code in der Softwareentwicklung: Claude Code wird von Entwicklern weithin in der Softwareentwicklung eingesetzt und zeigt sich besonders leistungsfähig beim Aufbau von AI Agents und der Automatisierung von Entwicklungsprozessen, z. B. bei der Erstellung virtueller Team-Agents wie Product Owner, Test-Autoren, Ingenieure und Code-Validatoren. Seine CLI-Tools und die Möglichkeit zur feingranularen Anpassung werden gelobt. Einige Benutzer berichten jedoch, dass die Codequalität von Claude Code in letzter Zeit nachgelassen hat. Im Vergleich zu GPT-5 High könnte GPT-5 bei der Bewältigung komplexer Probleme stärker sein, aber seine CLI-Erfahrung und der Grad der Anpassung sind nicht so gut wie bei Claude Code. (Quelle: op7418, omarsar0, amasad, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

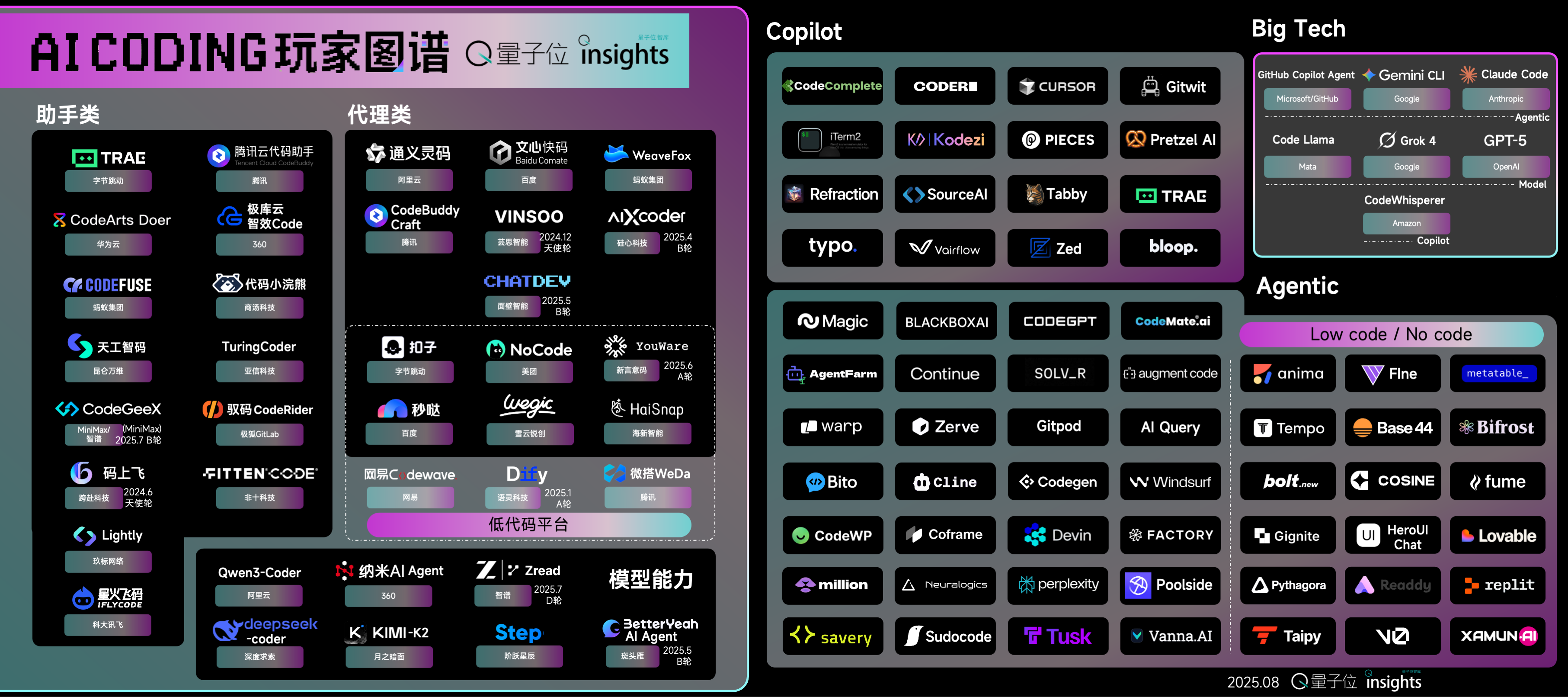

AI Coding Player Landscape und Entwicklungstrends: Ein Bericht des Qbitai Think Tanks analysiert die AI Coding-Marktlandschaft und weist auf eine Zunahme von Agent-Produkten und Low-Code-Plattformen hin. Auch Assistentenprodukte beginnen, Agent-Funktionen zu testen. Grundlagenmodellhersteller wie Anthropic Claude, Google Gemini und OpenAI GPT verbessern alle ihre Coding-Fähigkeiten und setzen neue SOTA-Standards. Die Breite der AI-Intervention im Coding reicht von der Code-Vervollständigung bis zum “Start to PR”, aber die meisten Produkte sind immer noch “Einwegprodukte”. Zukünftig müssen sie über Gedächtnis- und Kontextwiederverwendungsfähigkeiten verfügen und in den gesamten Entwicklungszyklus integriert werden. (Quelle: 量子位)

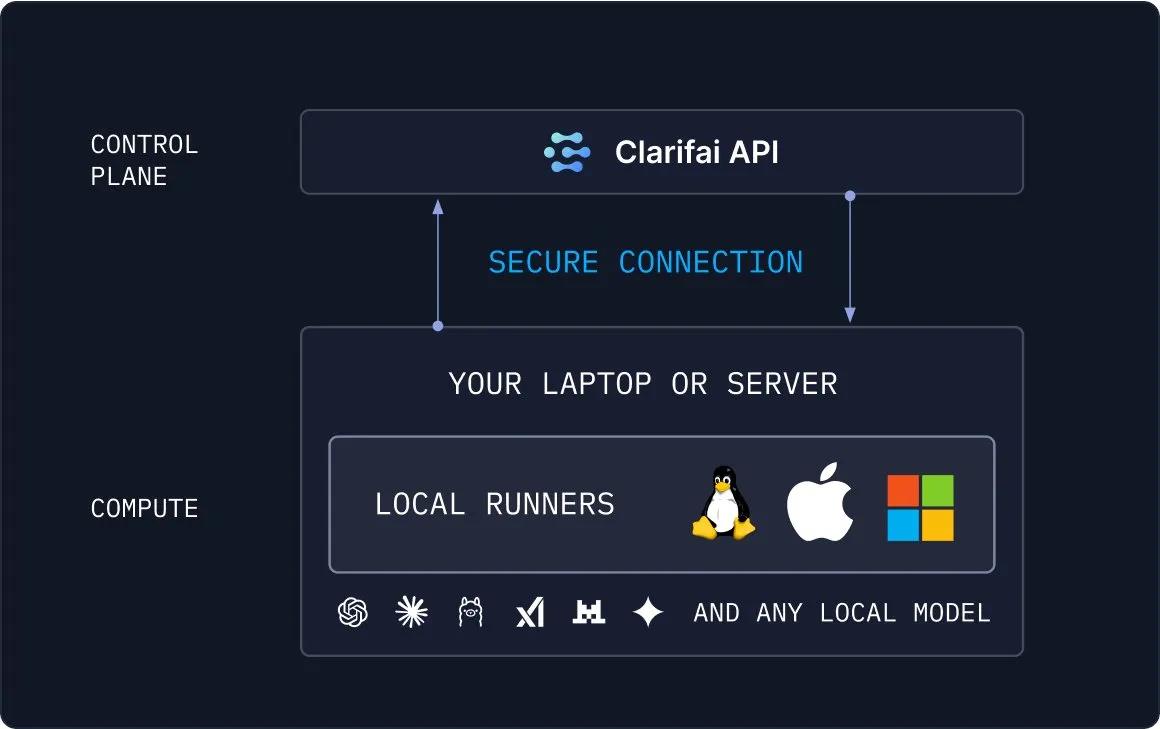

MLOps- und RAG-Tools vereinfachen die AI-Entwicklung: Clarifai hat das Local Runners-Tool eingeführt, das es Benutzern ermöglicht, Modelle lokal auszuführen und sich mit der Cloud zu verbinden, wodurch MLOps-Prozesse vereinfacht werden. Gleichzeitig bietet die Weaviate Vektordatenbank einen schnellen Weg, RAG auf PDF-Dokumenten ohne Coding zu erstellen, indem Inhalte über die Unstructured-Bibliothek extrahiert werden, um semantische Suche und Q&A zu ermöglichen. Diese Tools senken gemeinsam die Einstiegshürden für die AI-Entwicklung und erhöhen die Effizienz. (Quelle: TheTuringPost, bobvanluijt, tonywu_71)

Kreative Anwendungen des Kling AI Videogenerierungs-Tools: Kling AI 2.1 Pro demonstriert sein starkes kreatives Potenzial in der Videogenerierung, einschließlich der Erstellung von Kampfszenen durch die Kombination von Nano Banana und Kling 2.1, der Nutzung der Start-End-Frame-Funktion zur Generierung flüssiger 10-Sekunden-Szenenübergänge und der Umwandlung nicht zusammenhängender Bilder in animierte Geschichten mittels Prompts. Benutzer haben es auch verwendet, um AI-Werbespots für Coca-Cola und Werwolf-Transformationseffekte zu erstellen, was die Flexibilität und Ausdruckskraft von AI bei der Erstellung visueller Inhalte unterstreicht. (Quelle: Kling_ai, Kling_ai, Kling_ai, Kling_ai, Kling_ai, fabianstelzer)

Fallstudien zur AI-gestützten Entwicklung vertikaler Anwendungen: AI-Technologien werden zur Entwicklung intelligenter Anwendungen in verschiedenen vertikalen Bereichen eingesetzt. Zum Beispiel hat ein Entwickler mit Claude AI den Portfolio-Tracker Monerry erstellt und damit ein einjähriges Prokrastinationsproblem überwunden; ein anderer Entwickler nutzte Claude Code, um die AI-Nachhilfeplattform BrainRush speziell für ADHD-Studenten zu entwickeln; und jemand anderes hat mit AI ein Beziehungsdiagramm für den Fußballspieler Zlatan erstellt. Diese Fälle zeigen das Potenzial von AI, Effizienz zu steigern und Innovationen in Bereichen wie Finanzen, Bildung und Datenvisualisierung zu realisieren. (Quelle: Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

📚 Lernen

Empfehlung für ein Einführungsbuch zur Topologischen Datenanalyse: Frank Nielsen empfiehlt ein prägnantes Einführungsbuch zur Topologischen Datenanalyse (TDA), das Homologie- und Morse-Theorie behandelt und eine hervorragende Ressource für Leser bietet, die TDA verstehen möchten. (Quelle: jpt401)

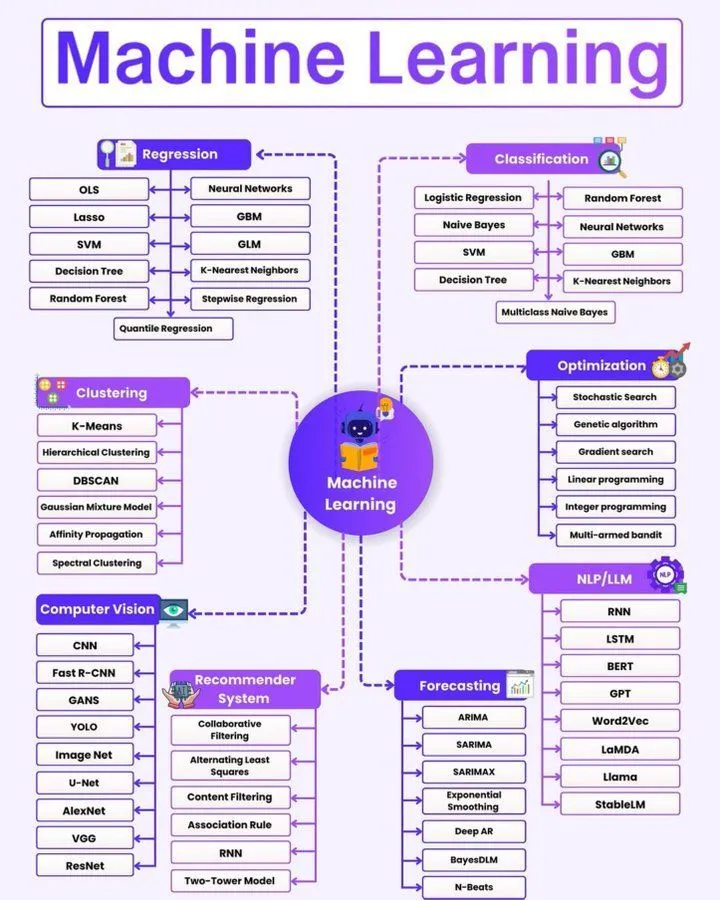

Roadmap für Machine Learning: Python_Dv hat eine Roadmap für Machine Learning geteilt, die Lernenden, die in den AI-Bereich einsteigen möchten, eine systematische Anleitung bietet. Diese Roadmap deckt Schlüsseltechnologiebereiche wie Künstliche Intelligenz, Machine Learning und Deep Learning ab. (Quelle: Ronald_vanLoon)

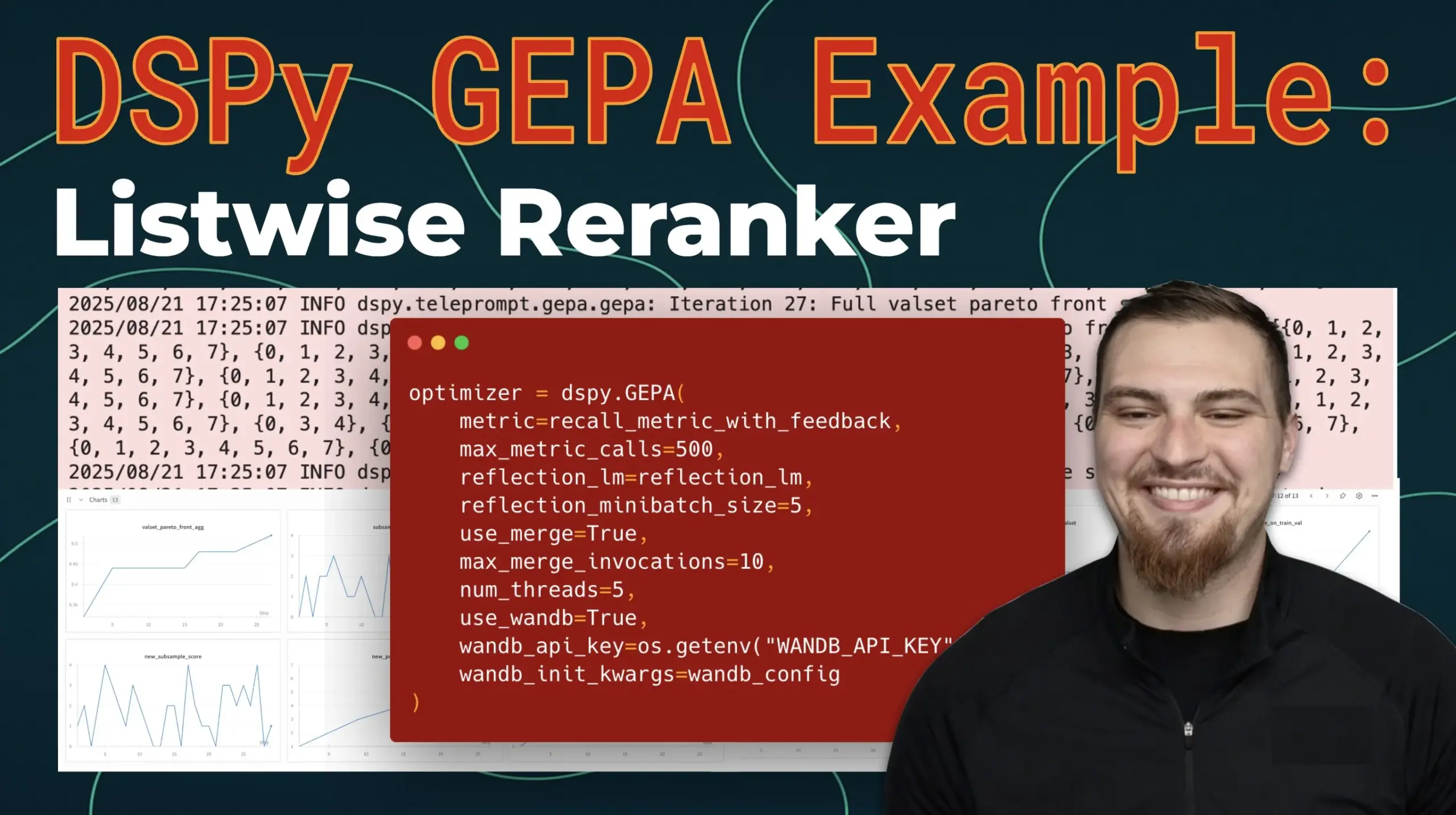

GEPA-optimierter Reranker in DSPy 3.0: Connor Shorten teilte seine Erfahrungen mit der Optimierung eines Listwise Rerankers in DSPy 3.0 mithilfe von GEPA (Gradient-Enhanced Prompting for Agents) und gab Anleitungen zur Überwachung von GEPA-Optimierungsläufen. Dies bietet praktische technische Details und Lernressourcen für die Retrieval-Optimierung in LLM-Anwendungen. (Quelle: stanfordnlp)

AI-Kompetenz: Videos und Artikelserie: TuringPost hat eine Serie von Videos und Artikeln zur AI-Kompetenz für Familien veröffentlicht, die untersucht, wie unsere Gespräche über AI-Intelligenz die Wahrnehmung von AI durch junge Menschen und deren Art der Nutzung oder Mitgestaltung beeinflussen. Die Serie zielt darauf ab, Aktivitäten und Beispiele bereitzustellen, um Familien zu helfen, AI besser zu verstehen. (Quelle: TheTuringPost)

Graph Machine Learning Benchmarks und Grundlagenmodellforschung: Das Yandex Research Team hat zwei Papers zum Graph Machine Learning veröffentlicht: den GraphLand-Benchmark (enthält 14 industrielle Datensätze für die Knotenattributvorhersage, die zeitliche Verteilungsverschiebungen und induktive Vorhersageeinstellungen abdecken) und das G2T-FM-Framework (das tabellarische Grundlagenmodelle in Graph-Grundlagenmodelle umwandelt, indem es die ursprünglichen Merkmale durch Nachbarschaftsmerkmalsaggregation und strukturelle Kodierung erweitert). G2T-FM übertrifft traditionelle GNNs und bestehende Graph-Grundlagenmodelle auf GraphLand und anderen Datensätzen. (Quelle: Reddit r/MachineLearning)

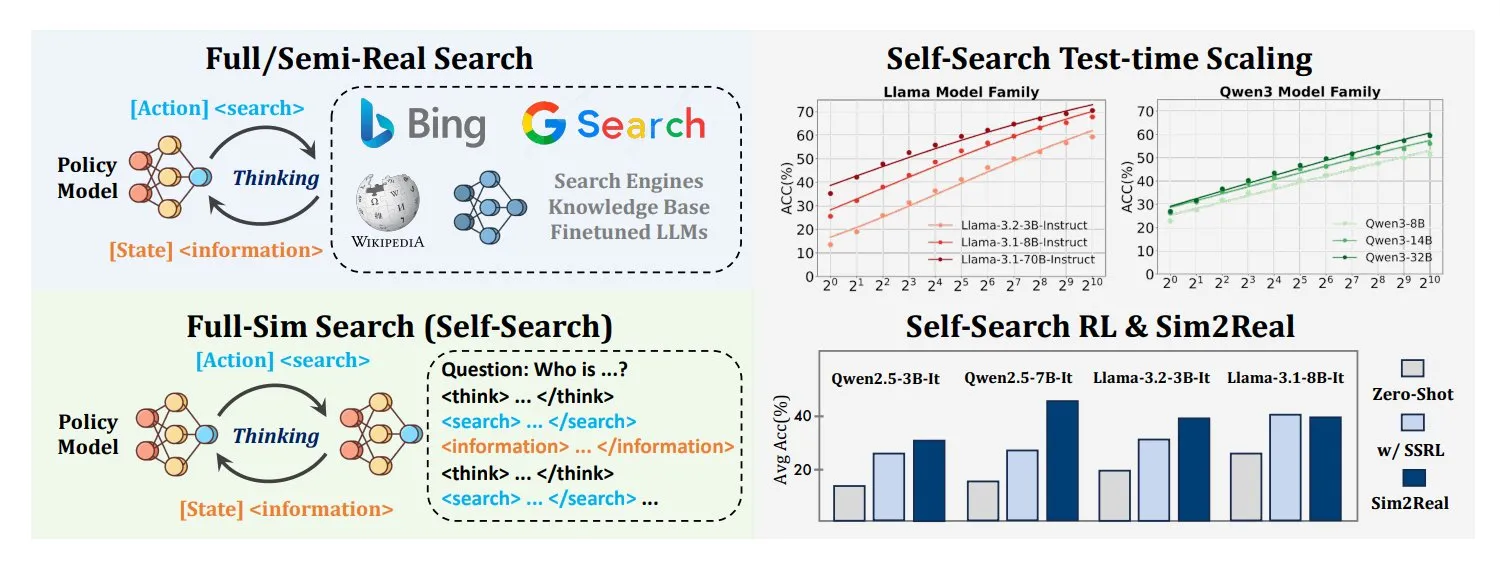

Self-Search Reinforcement Learning (SSRL) zum Trainieren der internen Wissenssuche von LLMs: Ein Forschungsteam der Tsinghua-Universität hat Self-Search Reinforcement Learning (SSRL) vorgeschlagen, das LLMs trainiert, ihr internes Wissen für Suchaufgaben zu nutzen. Diese Methode zeigt, dass LLMs als integrierte Web-Simulatoren fungieren können, wodurch die Abhängigkeit von externen Suchmaschinen reduziert und die Sucheffizienz und Unabhängigkeit erhöht werden. (Quelle: TheTuringPost)

DeepLearning.AI Kurs: Schnelles Prototyping von GenAI-Anwendungen mit Streamlit: Andrew Ng und Chanin Nantasenamat diskutieren, wie Generative AI das Denken von Entwicklern neu gestaltet, weg von übermäßiger Planung hin zu schnellem Prototyping und frühem Feedback. DeepLearning.AI hat den Kurs “Schnelles Prototyping von GenAI-Anwendungen mit Streamlit” gestartet, der Entwicklern helfen soll, Ideen schneller zu testen, mit realen Daten zu entwickeln und GenAI-Anwendungen iterativ bereitzustellen. (Quelle: DeepLearningAI)

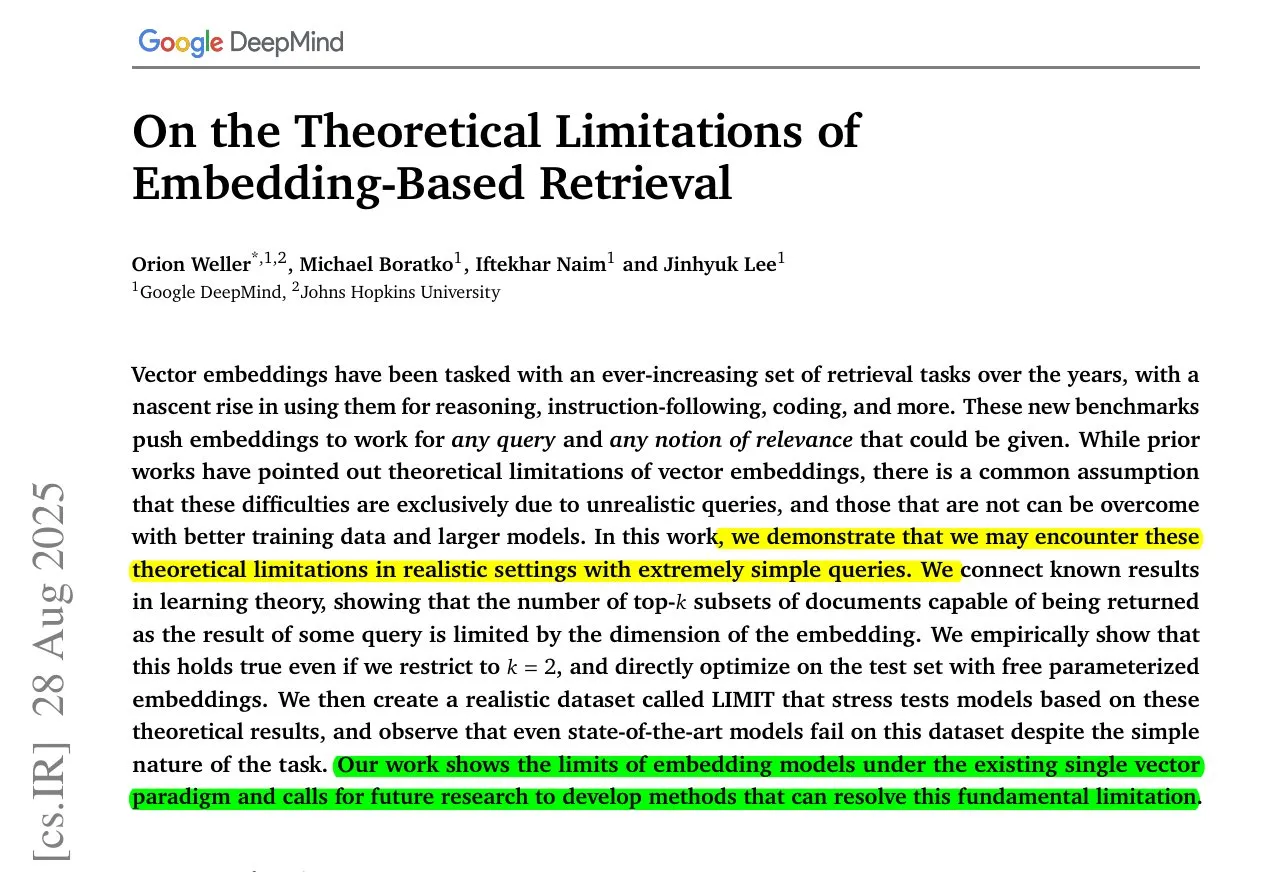

Studie zu den Limitationen von LLM-Embeddings: Eine Studie von Google DeepMind zeigt, dass selbst die besten Embeddings nicht alle möglichen Query-Dokument-Kombinationen darstellen können, was bedeutet, dass bestimmte Antworten mathematisch nicht wiederherstellbar sind. Es gibt eine harte Obergrenze für die Anzahl der Paare, die ein Embedding-Modell erfassen kann, begrenzt durch die Dimensionen. Überschreitet man diese Grenze, bricht die Recall-Rate zusammen. Dies deutet darauf hin, dass in großen Indizes eine hybride Einrichtung erforderlich ist, die dichte Vektoren, sparse Methoden oder Multivektor-Modelle kombiniert, und Embeddings als nützliche Werkzeuge und nicht als universelle Lösungen betrachtet werden sollten. (Quelle: jpt401)

AI hilft zu verstehen, wie das Gehirn die Welt wahrnimmt: Forschung von Meta AI und ENS_ULM zeigt, dass AI helfen kann zu verstehen, wie das Gehirn lernt, die Welt wahrzunehmen. Diese Studie untersucht die strategischen Denkfähigkeiten von AI durch die Analyse der Inferenzpfade von LLMs in Strategiespielen und bietet neue Perspektiven für die Schnittstellenforschung zwischen Neurowissenschaften und AI. (Quelle: menhguin, TimDarcet)

AI/ML Karriereentwicklung und Lernressourcen: Die Community diskutierte Karrierewege im AI/ML-Bereich, einschließlich der Frage, wie man mangelnde Programmierkenntnisse durch Projekte und Open-Source-Beiträge ausgleichen kann, die Suche nach geeigneten Cloud-Service-Plattformen für die LLM-Forschung (z. B. mit A100 GPUs) und Organisationen, die GPU-Ressourcen für bedürftige Forscher bereitstellen. Diese Ressourcen und Ratschläge sollen Lernenden und Praktikern helfen, ihre Karriere besser zu planen, die notwendigen Rechenressourcen zu erhalten und Lernherausforderungen zu bewältigen. (Quelle: algo_diver, Reddit r/deeplearning, Reddit r/deeplearning, Reddit r/deeplearning, Reddit r/MachineLearning)

💼 Business

A16Z-Partner über zwei Wege für AI-Startups: Die A16Z-Partner Joe Schmidt und Angela Strange stellen die Metaphern “Ölquelle” und “Pipeline” für AI-Startups vor. “Ölquelle” bezieht sich auf die Vertiefung in spezifische Szenarien, die Beherrschung von Kerndaten und den Neuaufbau oder die Erstellung von Aufzeichnungssystemen von Grund auf. “Pipeline” bedeutet die Verbindung fragmentierter Systeme und Prozesse, die Automatisierung menschlicher Entscheidungen und die abteilungsübergreifende Zusammenarbeit. Beide ergänzen sich, und Gründer müssen eine klare Wahl treffen und diese konsequent umsetzen, um skalierbare und widerstandsfähige Unternehmen aufzubauen. (Quelle: 36氪)

Dells Rechenzentrumsgeschäft übertrifft PC-Geschäft: Mit dem Aufschwung der AI hat Dells Rechenzentrumsgeschäft erstmals sein traditionelles PC-Geschäft übertroffen. Dies signalisiert den enormen Schub der AI-Welle für die Nachfrage nach Hardware-Infrastruktur und spiegelt die strategische Verlagerung des Schwerpunkts der Technologiebranche hin zu AI-bezogenen Dienstleistungen und Hardware wider. (Quelle: Reddit r/artificial)

Auswirkungen von AI auf Wirtschaft und Arbeitsmarkt: Ökonomen könnten die Auswirkungen von AI auf den Arbeitsmarkt erheblich unterschätzt haben. AI wird nicht nur repetitive Aufgaben ersetzen, sondern auch die Art der Arbeit verändern und von den Mitarbeitern die Anpassung an neue Fähigkeiten verlangen. Gleichzeitig treiben AI-Anwendungen im Geschäftsbereich, wie die Kommerzialisierung von Generative AI, Unternehmen dazu an, AI zur Steigerung von Effizienz und Innovation zu nutzen. (Quelle: Ronald_vanLoon, Ronald_vanLoon)

🌟 Community

Vorsicht vor übermäßiger AI-Abhängigkeit und unabhängigem Denken: In den sozialen Medien wird der Wert von AI als Lernpartner heiß diskutiert, es wird aber auch davor gewarnt, sich zu sehr auf AI zu verlassen, und die Bedeutung von unabhängigem Denken sowie dem eigenhändigen Schreiben/Programmieren betont. Der Artikel “Wird AI menschliches Denken ersetzen? Warum wir immer noch selbst schreiben und programmieren sollten” wird empfohlen und ruft dazu auf, das Denken neu zu lernen und die eigenen Fähigkeiten zu verfeinern. (Quelle: dotey, Reddit r/artificial)

Positive Auswirkungen von AI auf die persönliche psychische Gesundheit und soziale Interaktion: Ein Reddit-Nutzer teilte die positiven Auswirkungen von ChatGPT auf sein Leben, das ihm half, Ängste zu überwinden, die Begeisterung für Fitness und Reisen wiederzuentdecken und soziale Fähigkeiten zu verbessern. AI fungierte als “vertrauenswürdiger Freund”, der Ermutigung und Herausforderungen bot, seinen Lebensweg veränderte und die weit verbreitete Ansicht widerlegte, dass AI zu Isolation führt, indem es das Potenzial von AI für psychologische Unterstützung und persönliches Wachstum hervorhebt. (Quelle: Reddit r/ChatGPT)

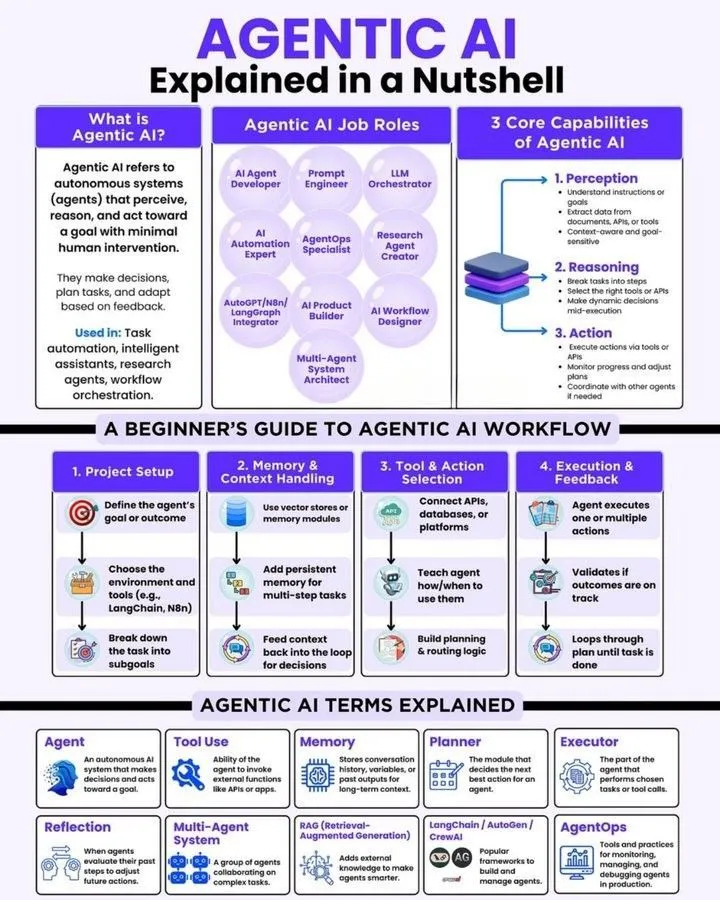

Die wahre Funktionsweise und Herausforderungen von AI Agents: Die Community diskutiert den Unterschied zwischen AI Agents und traditionellen LLM+Tools und betont, dass echte AI Agents in der Lage sind, Workflows autonom zu gestalten, anstatt nur Tool-erweiterte Systeme zu sein. Das ReAct-Framework wird als entscheidend angesehen, da es Gedächtnis, APIs und Multi-Agent-Kollaboration umfasst. Entwickler stehen vor Herausforderungen in der Planungs- und Ausführungsphase und sind an Erfahrungen mit der erfolgreichen Bereitstellung autonomer Agents in Produktionsumgebungen interessiert. (Quelle: Reddit r/deeplearning, omarsar0, Ronald_vanLoon)

AI-Akzeptanz und Herausforderungen in Unternehmen: Unternehmen stehen bei der internen Einführung von AI-Tools vor der Herausforderung der Mitarbeiterakzeptanz, da viele immer noch zu alten, manuellen Gewohnheiten neigen. Der Schlüssel zum Erfolg liegt in der Entwicklung guter Tools, die echte Probleme lösen, sowie in effektiver Schulung und Unterstützung, um den Widerstand der Mitarbeiter gegen neue Technologien und die Lernkurve zu überwinden. (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

LLM-Inhaltsattribution und Benutzerarchivierungsmethoden: Die Community diskutiert die Frage der Inhaltsattribution von LLM-generierten Inhalten und schlägt ein “LLM Content Archiving Protocol” vor, das Benutzern empfiehlt, eine dauerhafte Aufzeichnung der Zusammenarbeit mit LLMs über externe Markdown-Dateien zu führen. Diese Methode zielt darauf ab, die Kontrolle der Benutzer über gemeinsam erstelltes geistiges Eigentum zu gewährleisten, die Kontrolle durch Dritte zu vermeiden und Verzögerungsprobleme bei langen Dialogen durch manuelles Aktualisieren der Archivdateien zu lösen. (Quelle: Reddit r/ArtificialInteligence)

Die Zukunft von UI/UX im AI-Zeitalter: Mit der zunehmenden Intelligenz von AI Agents könnten sich die Benutzeroberflächen mobiler Anwendungen von traditionellen Schaltflächen und Menüs hin zu AI-gesteuerten Chat-Schnittstellen entwickeln. Benutzer könnten komplexe Aufgaben über Sprach- oder Textbefehle erledigen, anstatt durch mehrere Klicks. Es gibt jedoch auch die Ansicht, dass Sprachinteraktionen nicht sehr effizient sind und traditionelle UIs und AI-Chat-Schnittstellen koexistieren werden, anstatt sich vollständig zu ersetzen. (Quelle: Reddit r/ArtificialInteligence)

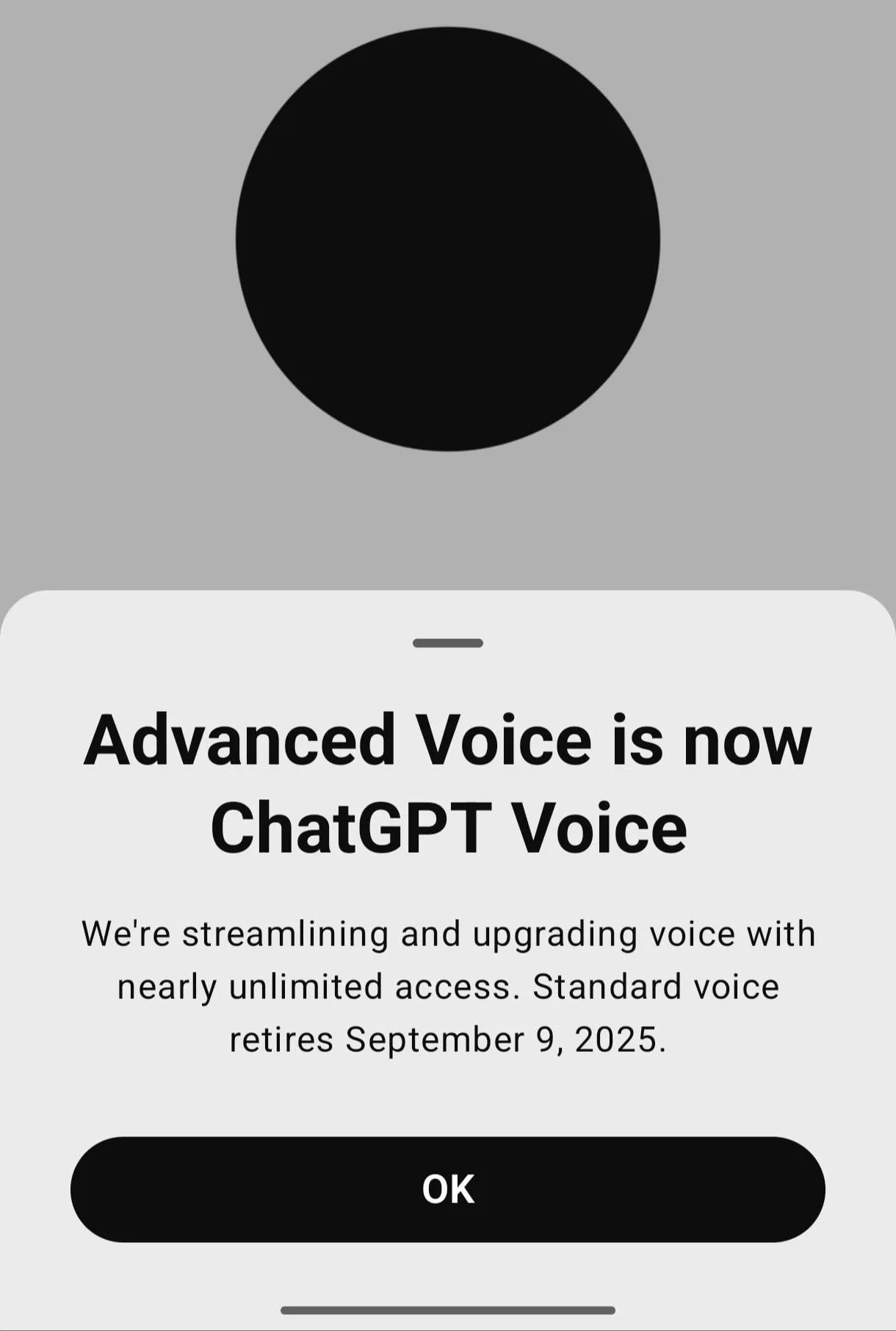

Benutzerfeedback zum ChatGPT-Sprachmodus: Der “Advanced Voice”-Modus von ChatGPT hat bei Benutzern Unmut ausgelöst, da die Stimme als “trocken” und “langweilig” empfunden wird und es an der “ruhigen, bodenständigen” und emotionalen Unterstützung des Standard-Sprachmodus mangelt. Viele Benutzer fordern OpenAI auf, die Option für den Standard-Sprachmodus beizubehalten, insbesondere da der “positive” Ton der Advanced Voice bei der Behandlung persönlicher Emotionen und sensibler Themen unpassend ist. (Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT)

AI-Ethik, Datenschutz und gesellschaftliche Auswirkungen: In den sozialen Medien werden ethische Fragen der AI breit diskutiert, darunter die Illusion der Personifizierung von Chatbots, AI und Datenschutz, Werbung sowie intime Beziehungen. Benutzer befürchten, dass AI missbraucht werden könnte, was zu Entscheidungslähmung führt, und stellen Fragen zur Sicherheit persönlicher Daten und zum Datenschutz von AI-Modellen (wie Hermes 4). Gleichzeitig haben Fragen, ob AI Bewusstsein besitzt und welche Auswirkungen AI auf die menschliche Identität und den Arbeitsplatz hat, tiefgreifende philosophische Diskussionen ausgelöst. (Quelle: MIT Technology Review, Ronald_vanLoon, The Verge, ben_burtenshaw, clefourrier, Reddit r/ArtificialInteligence, Reddit r/artificial, kylebrussell, Ronald_vanLoon, Reddit r/ArtificialInteligence, Reddit r/LocalLLaMA)

💡 Sonstiges

Entwicklung der Robotik: Von Humanoiden zur intelligenten Wahrnehmung: Der Bereich der Robotik setzt seine Innovationen fort, darunter der Vulcan-Roboter mit menschenähnlichen Seh-, Tast- und Navigationsfähigkeiten sowie das Skild Brain, ein Robotergehirn, das mit dem Jetson Thor Supercomputer gekoppelt ist. Das chinesische Unternehmen Spirit AI hat ebenfalls die neue Generation des Humanoid-Roboters Moz1 mit Rädern vorgestellt. Diese Fortschritte fördern die Wahrnehmungs-, Bewegungs- und autonomen Operationsfähigkeiten von Robotern. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

AI revolutioniert das Game Design: AI verändert den Bereich des Game Designs grundlegend und eröffnet durch Technologien wie Generative AI und Reinforcement Learning neue Möglichkeiten für die Spieleentwicklung. AI kann nicht nur die Erstellung von Spielinhalten unterstützen, sondern auch das Spielerlebnis optimieren und sogar Innovationen in den Spielmechaniken vorantreiben, was auf eine intelligentere und personalisiertere Zukunft der Spiele hindeutet. (Quelle: togelius)

Kreative Fähigkeiten des AI-Bearbeitungstools Higgsfield_ai: Higgsfield_ai wird als “AI-Bearbeitungstool mit Seele” beschrieben und demonstriert seine starken Fähigkeiten in der Inhaltserstellung und kreativen Bearbeitung. Dieses Tool nutzt AI-Technologie, um Benutzern die Erstellung künstlerischerer und personalisierterer visueller Inhalte zu ermöglichen und fördert so die Entwicklung der Kreativbranche. (Quelle: Ronald_vanLoon)