Schlüsselwörter:NVIDIA Jetson Thor, Physikalische KI, Humanoider Roboter, Blackwell GPU, KI-Rechenleistung, Jetson Thor KI-Spitzenrechenleistung, Blackwell GPU-Leistung, Anwendungsszenarien physikalischer KI, Entwicklungs-Kit für humanoide Roboter, Jetson Thor Preis

🔥 Fokus

NVIDIA Jetson Thor veröffentlicht: Physikalische KI-Rechenleistung steigt sprunghaft an : NVIDIA hat den Jetson Thor vorgestellt, der speziell für physikalische KI und humanoide Roboter entwickelt wurde. Ausgestattet mit einer Blackwell GPU und einem 14-Kern Arm Neoverse CPU erreicht er eine KI-Spitzenrechenleistung von 2070 TFLOPS (FP4), was einer 7,5-fachen Steigerung gegenüber der vorherigen Generation Jetson Orin entspricht. Er unterstützt generative KI-Modelle wie VLA, LLM und VLM, kann Echtzeit-Video und KI-Inferenz verarbeiten und zielt darauf ab, die Entwicklung von Universalrobotern und physikalischer KI zu beschleunigen. Hauptanwendungsbereiche sind humanoide Roboter, Operationsassistenz und intelligente Traktoren. Er wird bereits von Agility Robotics, Amazon, Boston Dynamics und Unitree Robotics eingesetzt. Das Entwickler-Kit ist ab sofort erhältlich, mit einem Startpreis von 3499 US-Dollar. (Quelle: nvidia)

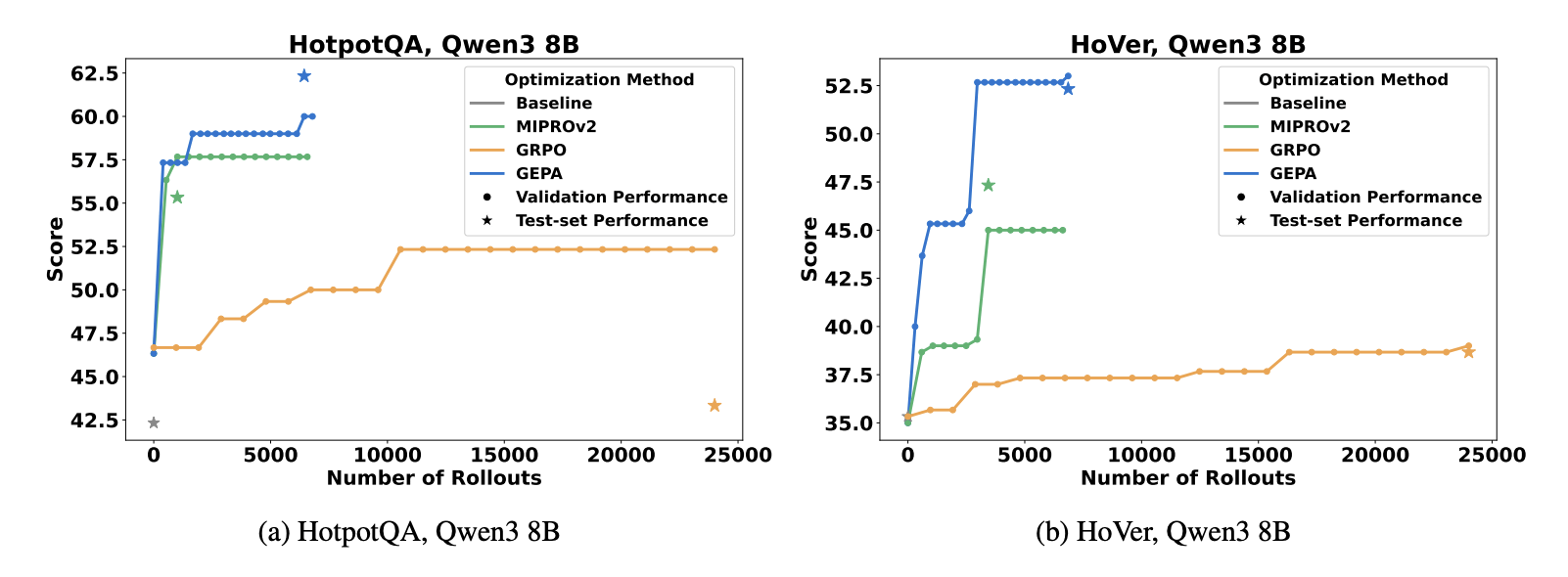

GEPA: Reflektierende Prompt-Evolution übertrifft RL : Eine neue Studie (Agrawal et al., 2025) stellt die GEPA-Methode (Genetic-Pareto Prompt Evolution) vor, die LLM-System-Prompts durch natürliche Sprachreflexion und Trajektoriendiagnose weiterentwickelt, anstatt auf Reinforcement Learning zu setzen. GEPA übertrifft GRPO bei Multi-Hop-QA-Aufgaben, benötigt 35-mal weniger Rollouts und übertrifft kontinuierlich den SOTA-Prompt-Optimierer MIPROv2. Dies deutet darauf hin, dass sprachnative Optimierungsschleifen bei der LLM-Anpassungsfähigkeit effizienter sind als rohe Rollouts im Parameterraum und weist auf eine neue Richtung für KI-Optimierungsstrategien hin. (Quelle: Reddit r/MachineLearning)

OPRO-Methode steigert Effizienz von KI-Sicherheitstests : Bret Kinsella von TELUS Digital stellt die OPRO-Methode (Optimization by PROmpting) vor, die es LLMs ermöglicht, “Selbst-Red-Teaming” durchzuführen, indem sie Angriffsgeneratoren optimieren, um die KI-Sicherheit zu bewerten. Diese Methode konzentriert sich auf die Verteilung der Angriffserfolgsrate (ASR) anstatt auf ein einfaches Bestanden/Nicht bestanden, kann Schwachstellen in großem Maßstab aufdecken und Abhilfemaßnahmen leiten. Es wird betont, dass KI-Sicherheitstests in Hochrisikobranchen wie Finanz- und Gesundheitswesen umfassend, wiederholbar und kreativ sein müssen und sich von reaktiven zu präventiven Maßnahmen entwickeln sollten, um Unternehmen eine detailliertere KI-Sicherheitsbewertung zu ermöglichen. (Quelle: Reddit r/deeplearning)

🎯 Trends

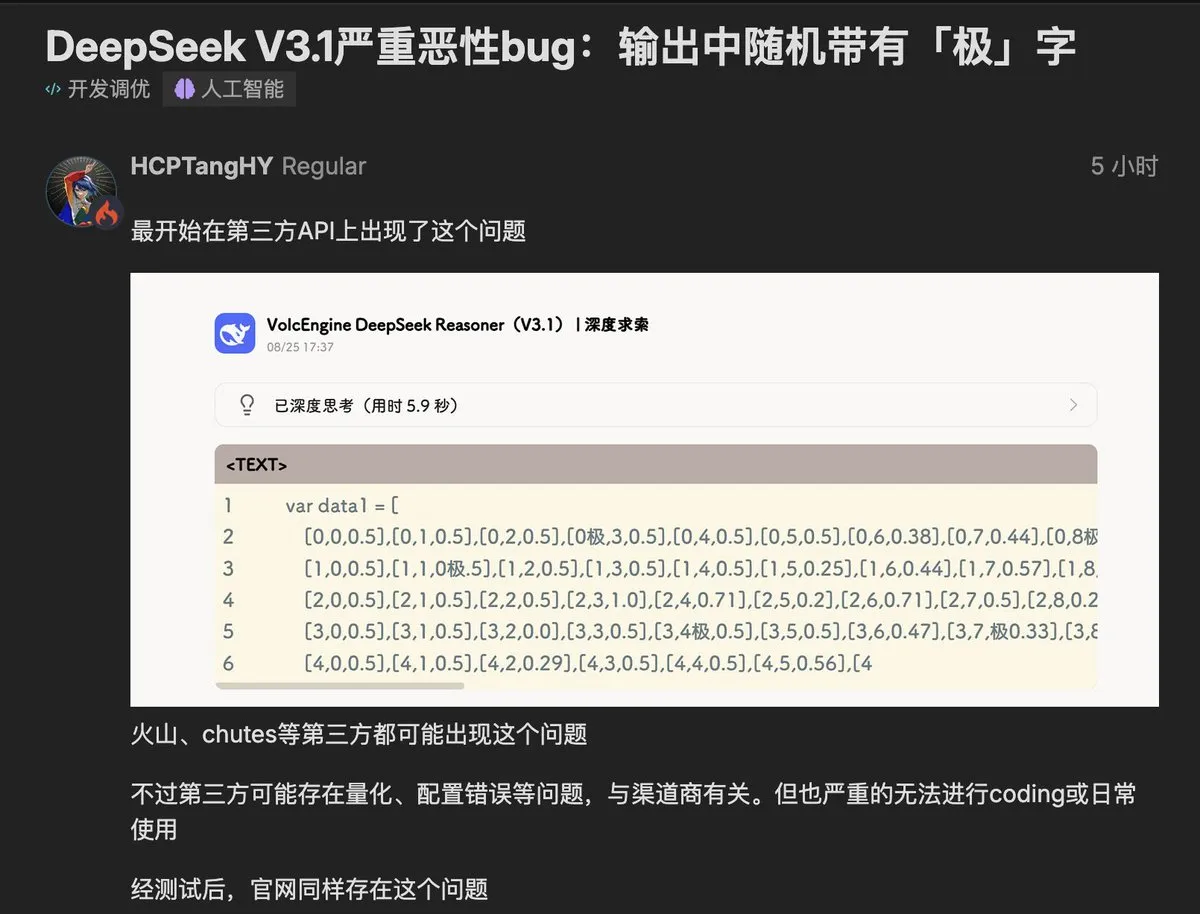

DeepSeek V3.1 Modell zeigt “极”-Bug : Nutzer haben berichtet, dass das neueste DeepSeek V3.1 Modell zufällig das Zeichen “极” (oder “extreme”) in seine Ausgaben einfügt, was Aufgaben mit Code und struktursensiblen Inhalten beeinträchtigt. Das Problem wurde sowohl bei Drittanbieter-Implementierungen als auch in der offiziellen API reproduziert, was in der Community Bedenken hinsichtlich Datenkontamination und Stabilität des Modells aufwirft. Es wird spekuliert, dass dies mit Token-Verwechslungen oder unsauberen RLHF-Trainingsdaten zusammenhängen könnte, was Modellentwickler auf die kritische Bedeutung der Datenqualität für das KI-Verhalten aufmerksam macht. (Quelle: teortaxesTex, 36氪, 36氪)

Googles mysteriöses Modell Nano-Banana erregt Aufmerksamkeit : Ein mysteriöses Bildgenerierungs- und Bearbeitungsmodell namens Nano-Banana erfreut sich in der KI-Community großer Beliebtheit und wird als Google-Produkt vermutet. Es zeichnet sich durch hervorragende Leistungen bei der Textbearbeitung, Stilfusion und Szenenverständnis aus, kann Elemente aus mehreren Bildern zusammenführen und dabei Licht, Perspektive und Komposition konsistent halten. Es weist jedoch Mängel wie verstümmelte Buchtitel und deformierte Finger auf, und es fehlt derzeit eine offizielle API, was die Nutzung instabil macht. Viele gefälschte Websites sind ebenfalls aufgetaucht, was eine Diskussion über die Fähigkeiten und Zugangswege zu neuen Modellen auslöst. (Quelle: TomLikesRobots, yupp_ai, yupp_ai, 36氪)

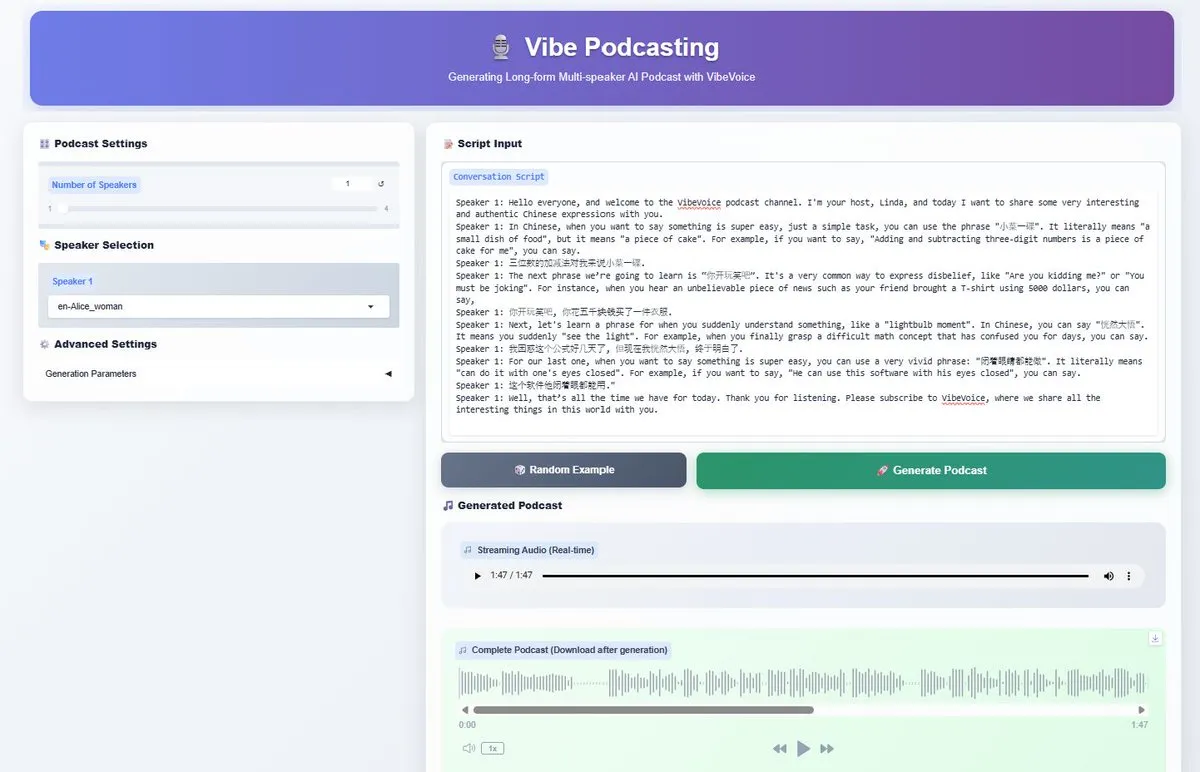

Microsoft VibeVoice-1.5B TTS Modell Open Source : Microsoft hat das VibeVoice-1.5B TTS Modell als Open Source veröffentlicht, das die Generierung von ausdrucksstarken Audio-Dialogen mit bis zu 90 Minuten Länge und bis zu 4 verschiedenen Sprechern unterstützt. Das Modell basiert auf Qwen2.5-1.5B und verwendet einen Ultra-Low-Framerate-Tokenizer, der die Recheneffizienz verbessert und sowohl Chinesisch als auch Englisch unterstützt. Unter der MIT-Lizenz wird erwartet, dass es die KI-Generierung von langen Audioinhalten wie Podcasts vorantreibt und Kreativen leistungsstarke mehrsprachige Audio-Produktionsmöglichkeiten bietet. (Quelle: _akhaliq, AnthropicAI, ClementDelangue, dotey)

Neue Entwicklungen bei Alibaba Wan Modellreihe : Alibaba AI Modell Wan kündigt die bevorstehende Veröffentlichung von WAN 2.2-S2V an, einem filmreifen Sprach-zu-Video-Modell, das “audio-driven, vision-based, open-source” sein soll. Gleichzeitig wurde das zuvor veröffentlichte Modell Wan2.2-T2V-A14B in die Anycode-Anwendung integriert und ist dort das Standardmodell für Text-zu-Video. Diese Reihe von Fortschritten zeigt Alibabas kontinuierliches Engagement und Innovation im Bereich der multimodalen KI, insbesondere bei der Audio- und Videogenerierung. (Quelle: Alibaba_Wan, TomLikesRobots, karminski3)

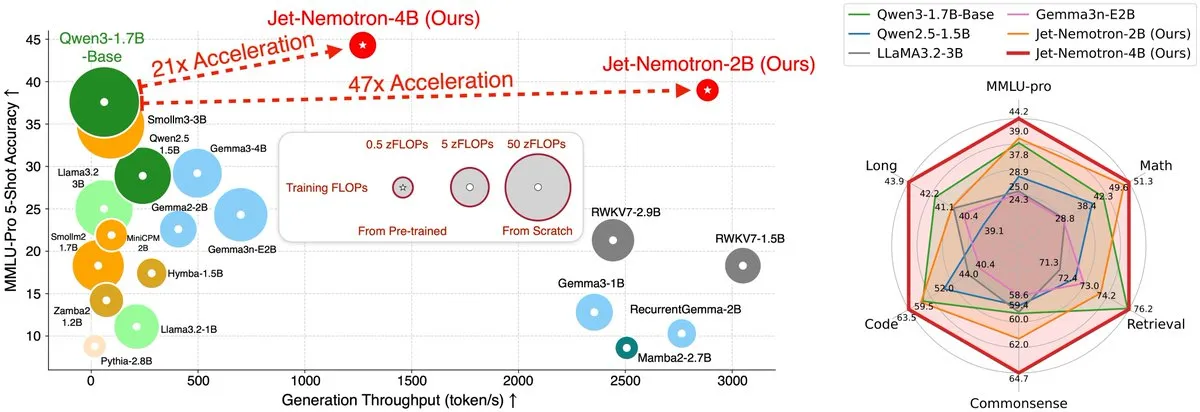

Jet-Nemotron Hybridarchitektur LLM um 53,6-mal beschleunigt : Das MIT Hanlab Team hat Jet-Nemotron veröffentlicht, eine Familie von Sprachmodellen mit Hybridarchitektur, die durch Post Neural Architecture Search (PostNAS) und einen neuartigen linearen Aufmerksamkeitsblock namens JetBlock eine bis zu 53,6-fache Steigerung des Generierungsdurchsatzes auf H100 GPUs erreicht, während die Leistung die von SOTA Open-Source Full-Attention-Modellen übertrifft. Diese bahnbrechende Forschung bietet neue Lösungen für die Inferenz-Effizienz und Architekturoptimierung von LLMs. (Quelle: teortaxesTex, menhguin)

KI-Agenten entwickeln sich 2025 zu autonomen Workflows : KI-Agenten entwickeln sich von konversationellen Assistenten zu autonomen Workflows, die in der Lage sind, Aufgaben zu denken, zu planen und auszuführen. Durch die Integration von APIs und automatisierter Entscheidungsfindung können KI-Agenten komplexe Prozesse steuern, wie z.B. das automatische Generieren von Videoskripten, das Kompilieren von Videos und das Veröffentlichen auf YouTube, was darauf hindeutet, dass KI-gesteuerte Workflows zum Mainstream werden und das Automatisierungsniveau erheblich steigern werden. (Quelle: Reddit r/artificial)

Warnung vor Sicherheitslücken in KI-Browsern : Der US-amerikanische KI-Such-Unicorn Perplexity’s KI-Browser Comet soll schwerwiegende Sicherheitslücken aufweisen. Angreifer könnten über bösartige Befehle den KI-Browser manipulieren, um auf E-Mails zuzugreifen, Verifizierungscodes zu erhalten und sensible Informationen zu senden. Brave wies darauf hin, dass traditionelle Cybersicherheitsmechanismen bei solchen Angriffen versagen und Agent-Produkte aufgrund ihrer “tödlichen Dreifaltigkeit” aus “privatem Datenzugriff, Kontakt mit nicht vertrauenswürdigen Inhalten und externer Kommunikation” einem enormen Risiko ausgesetzt sind. Dies mahnt, dass KI-Produkte bei Funktionsinnovationen Sicherheit und Datenschutz priorisieren müssen. (Quelle: 36氪)

Die Billionen-KI-Speicherlücke und die Universal Storage Architektur : Das KI-Zeitalter stellt extreme Anforderungen an Speicher: maximaler Durchsatz, niedrige Latenz, hohe Parallelität, einheitliches multimodales Management, Compute-in-Storage, persistente Agent-Erinnerung und autonome Sicherheit. Traditionelle Speicherarchitekturen können diesen Anforderungen aufgrund von OS-Kernel-Abhängigkeiten, gemischter Metadaten- und Datenspeicherung sowie getrennten Protokollen kaum gerecht werden. Die Universal Storage Architektur, mit Innovationen wie einem einheitlichen Speicherpool, unabhängiger Metadatenspeicherung und der Befreiung von OS-Kernel-Abhängigkeiten, erreicht Latenzen im Bereich von Hunderten von Mikrosekunden und TB-Durchsatz. Sie wird zur bevorzugten Wahl für die Speicherschicht im KI-Zeitalter und soll die Speicherleistungslücke in KI-Anwendungen schließen. (Quelle: 36氪)

Reels Kurzvideos starten KI-Übersetzungs- und Lippensynchronisationsfunktion : Metas Facebook und Instagram Reels Kurzvideos haben offiziell eine KI-Audioübersetzungsfunktion eingeführt, die es ermöglicht, die Audioinhalte von Personen in Videos in verschiedene Sprachen zu übersetzen, dabei die Lippensynchronisation anzupassen und die Originalstimme zu synthetisieren. Derzeit wird die Übersetzung zwischen Englisch und Spanisch unterstützt, und Nutzer können bis zu 20 weitere Sprachspuren hinzufügen. Dieser Schritt zielt darauf ab, globale Märkte zu bedienen und Marktanteile von TikTok zu gewinnen. KI wird zum Schlüssel für Metas Durchbruch bei Kurzvideos und soll das globale Nutzererlebnis beim Konsum von Inhalten verbessern. (Quelle: 36氪)

AIoT Branchentrends und Herausforderungen : Drei Berichte von McKinsey, BVP und MIT weisen alle darauf hin, dass die tiefe Integration von KI und IoT ein großer Trend ist. Die Kommerzialisierung muss sich auf Szenarien mit hohem ROI konzentrieren und Plattform- sowie Ökosystem-Kooperationen betonen. Die Berichte zeigen jedoch auch Konflikte zwischen Eigenentwicklung und Einkauf, explosivem Wachstum und anhaltender Widerstandsfähigkeit, sowie Frontend-Erlebnis und Backend-Intelligenz auf. Es wird argumentiert, dass AIoT sich vom “Daten-Transporter” zu einem “autonomen intelligenten Agentennetzwerk” entwickeln muss, um Autonomie, Zusammenarbeit und Vertrauensneugestaltung zu erreichen und die Herausforderungen der Branchenaufrüstung zu bewältigen. (Quelle: 36氪)

ByteDance erforscht KI-Hardware-Ökosystem, umfasst Smartphones, Autos, Roboter : ByteDance verstärkt seine Investitionen im Hardware-Bereich und integriert oder entwickelt über das Doubao Large Model Produkte wie Smartphones, Autos, Roboter, Smart Glasses und Lernmaschinen. Berichten zufolge entwickelt ByteDance ein intelligentes Betriebssystem für Autos und ein Doubao AI-Smartphone, um KI-Fähigkeiten in Hardware zu implementieren. Obwohl ByteDances frühere Hardware-Versuche nicht erfolgreich waren, treibt das Unternehmen nach dem Aufkommen großer KI-Modelle erneut die Entwicklung voran, um ein “Software-Hardware-integriertes” KI-Ökosystem aufzubauen und im KI-Zeitalter neue Wachstumspunkte zu finden. (Quelle: 36氪)

🧰 Tools

Google AI Mode vereinfacht Restaurantreservierungen : Google AI Ultra-Abonnenten können jetzt den AI Mode nutzen, um Restaurantreservierungen zu vereinfachen. Nutzer müssen lediglich ihre Anforderungen wie Geburtstagsessen, Personenzahl, Atmosphäre, Musik usw. in natürlicher Sprache beschreiben, und der AI Mode erledigt die Reservierung. Der Nutzer muss nur noch die endgültige Bestätigung geben. Diese Funktion wird derzeit in den USA eingeführt und zielt darauf ab, das personalisierte Serviceerlebnis zu verbessern und den mühsamen Reservierungsprozess zu automatisieren. (Quelle: Google)

VSCode Terminal-Tool Agent-Modus neue Fortschritte : Das VSCode-Team schreibt sein Terminal-Tool neu, um den Agent-Modus zu unterstützen, mit dem Ziel, die Effizienz und das Erlebnis für Entwickler zu verbessern. Dieser Schritt ist Teil des GitHub Copilot-Ökosystems und ermöglicht intelligentere Entwicklungsunterstützung durch KI-Agenten, z.B. direkte Code-Generierung und Debugging im Terminal, wodurch der Entwicklungsprozess vereinfacht wird. (Quelle: pierceboggan)

OpenRouter führt Ein-Klick-ZDR-Funktion ein : OpenRouter hat die “Ein-Klick-ZDR” (Zero Data Retention)-Funktion veröffentlicht, die sicherstellt, dass die Prompts der Nutzer nur an Anbieter gesendet werden, die Zero Data Retention unterstützen. Dies verbessert den Datenschutz der Nutzer, vereinfacht die Auswahl der Datenrichtlinien von KI-Dienstleistern und ermöglicht es den Nutzern, KI-Dienste beruhigter zu nutzen. (Quelle: xanderatallah)

Qwen Edit zeigt hervorragende Leistung bei der Bild-Outpainting : Das Alibaba Qwen Edit Modell zeigt herausragende Fähigkeiten bei der Bild-Outpainting (Bilderweiterung) und kann Bildinhalte in hoher Qualität erweitern, was sein starkes Potenzial im Bereich der visuellen Generierung demonstriert. Nutzer können dieses Tool nutzen, um Bildhintergründe einfach zu erweitern oder breitere Szenen zu erstellen, was die Flexibilität bei der Bildgestaltung erhöht. (Quelle: multimodalart)

Google NotebookLM unterstützt mehrsprachige Video-Übersichten : Google NotebookLM hat eine neue Funktion eingeführt, die Video-Übersichten in 80 Sprachen unterstützt und für nicht-englische Audio-Übersichten kurze und Standard-Dauersteuerungen bietet. Dies verbessert die Fähigkeit mehrsprachiger Nutzer erheblich, Videoinhalte zu erfassen und zu verstehen, verhindert Informationsverluste bei der Übersetzung und macht Lernen und Forschung effizienter. (Quelle: Google)

GLIF integriert SOTA Video-, Bild- und LLM-Modelle : Die GLIF-Plattform hat alle SOTA Video-, Bild- und LLM-Modelle integriert und ist die einzige Plattform, die diese Modelle zu einzigartigen, benutzerdefinierten Workflows kombinieren kann. Nutzer können Modelle wie Kling 2.1 Pro für die Videogenerierung verwenden, z.B. von Qwen-Image generierte Frames für Veo 3-Animationen nutzen, um kreative Szenen zu realisieren, und sogar Videos in den MSPaint-Stil umwandeln. (Quelle: fabianstelzer, fabianstelzer, fabianstelzer)

LlamaIndex stellt Vibe Coding Tool vor : LlamaIndex hat das vibe-llama CLI Tool und detaillierte Prompt-Templates veröffentlicht, um die Effizienz und Genauigkeit von KI-Programmieragenten (wie Cursor AI und Claude Code) zu verbessern. Das Tool kann LlamaIndex-Kontext direkt in Programmieragenten injizieren, um veraltete API-Vorschläge zu vermeiden, und kann aus einfachen Skripten vollständige Streamlit-Anwendungen generieren, einschließlich Dateiupload und Echtzeitverarbeitung, wodurch der Entwicklungsprozess beschleunigt wird. (Quelle: jerryjliu0)

LangGraph Platform führt Revision Rollbacks und Queueing ein : Die LangGraph Platform hat die Funktion Revision Rollbacks eingeführt, die es Nutzern ermöglicht, jede historische Version erneut bereitzustellen, um Probleme zurückzuverfolgen und zu korrigieren. Gleichzeitig wurde Revision Queueing eingeführt, bei dem neue Revisionen in eine Warteschlange gestellt werden, um nach Abschluss der vorherigen ausgeführt zu werden. Dies verbessert die Effizienz und Stabilität des Entwicklungsworkflows und bietet eine zuverlässigere Umgebung für die Agent-Entwicklung. (Quelle: LangChainAI, LangChainAI)

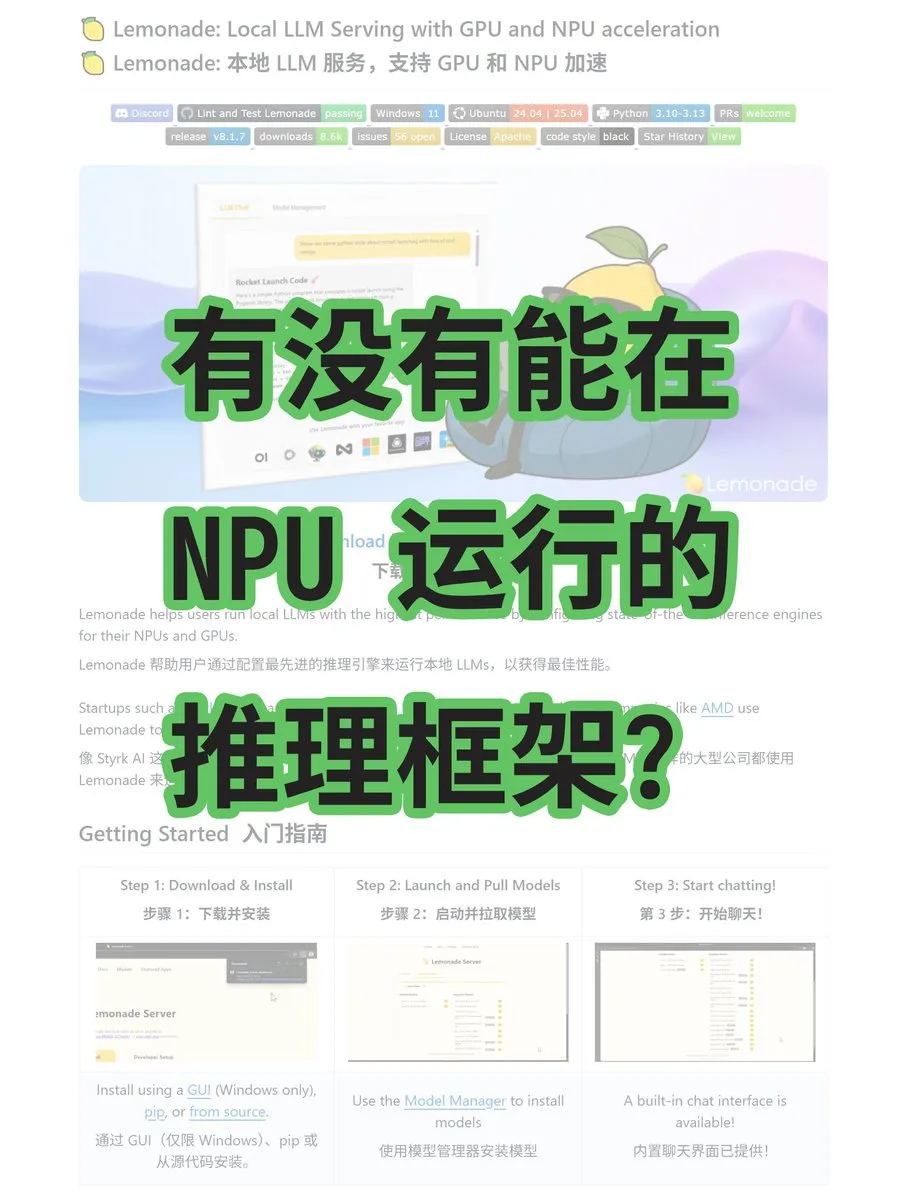

Lemonade Framework unterstützt AMD NPU/GPU Inferenz : Lemonade ist ein neues Inferenz-Framework für große Modelle, das auf AMD-Grafikkarten, CPUs und NPUs läuft und GGUF- und ONNX-Modelle unterstützt. Das von AMD-Ingenieuren entwickelte Framework ist nicht von CUDA abhängig und bietet AMD-Hardware-Nutzern eine neue KI-Inferenzlösung, die die Leistung von KI-Anwendungen auf AMD-Plattformen verbessern soll. (Quelle: karminski3)

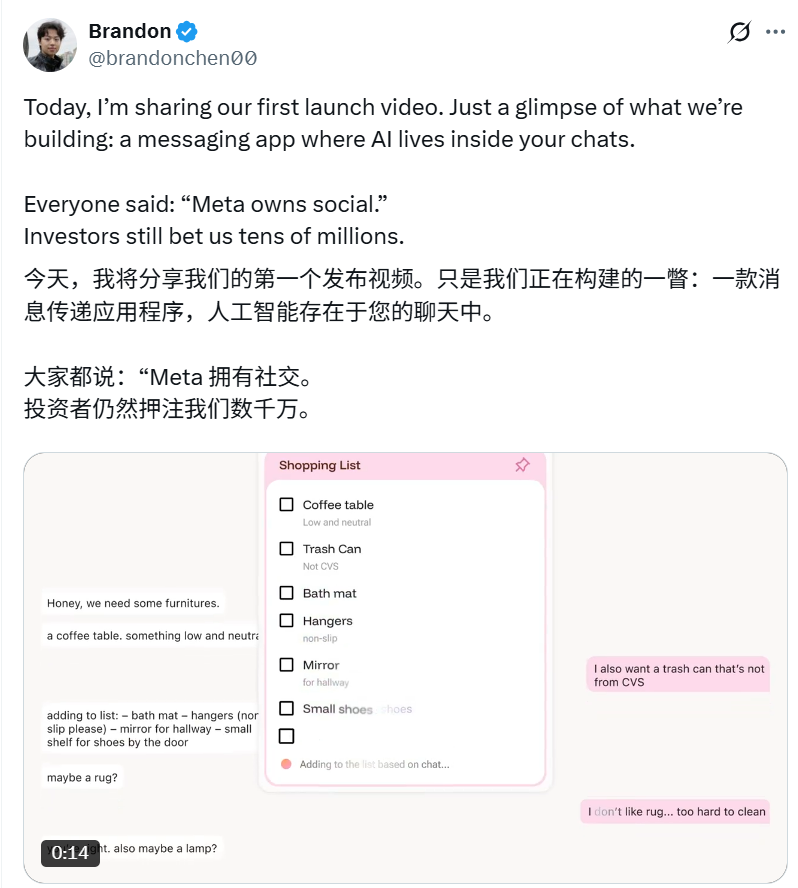

KI-gesteuerte soziale App Intent : Brandon Chen hat das KI-native Instant-Messaging-Tool Intent gegründet, das darauf abzielt, Kollaborationsbarrieren durch KI zu beseitigen und Benutzerabsichten nahtlos in Ergebnisse umzuwandeln. Zum Beispiel kann die KI automatisch mehrere Fotos zusammenfügen oder basierend auf Chat-Verläufen Reisen planen, Fahrzeuge buchen und gemeinsame Einkaufslisten erstellen. Die App kombiniert Chat-Funktionen mit der automatischen Ausführungsfähigkeit großer Modelle, hat Dutzende Millionen Dollar an Finanzierung erhalten und soll die soziale Interaktion verändern. (Quelle: _akhaliq, 36氪)

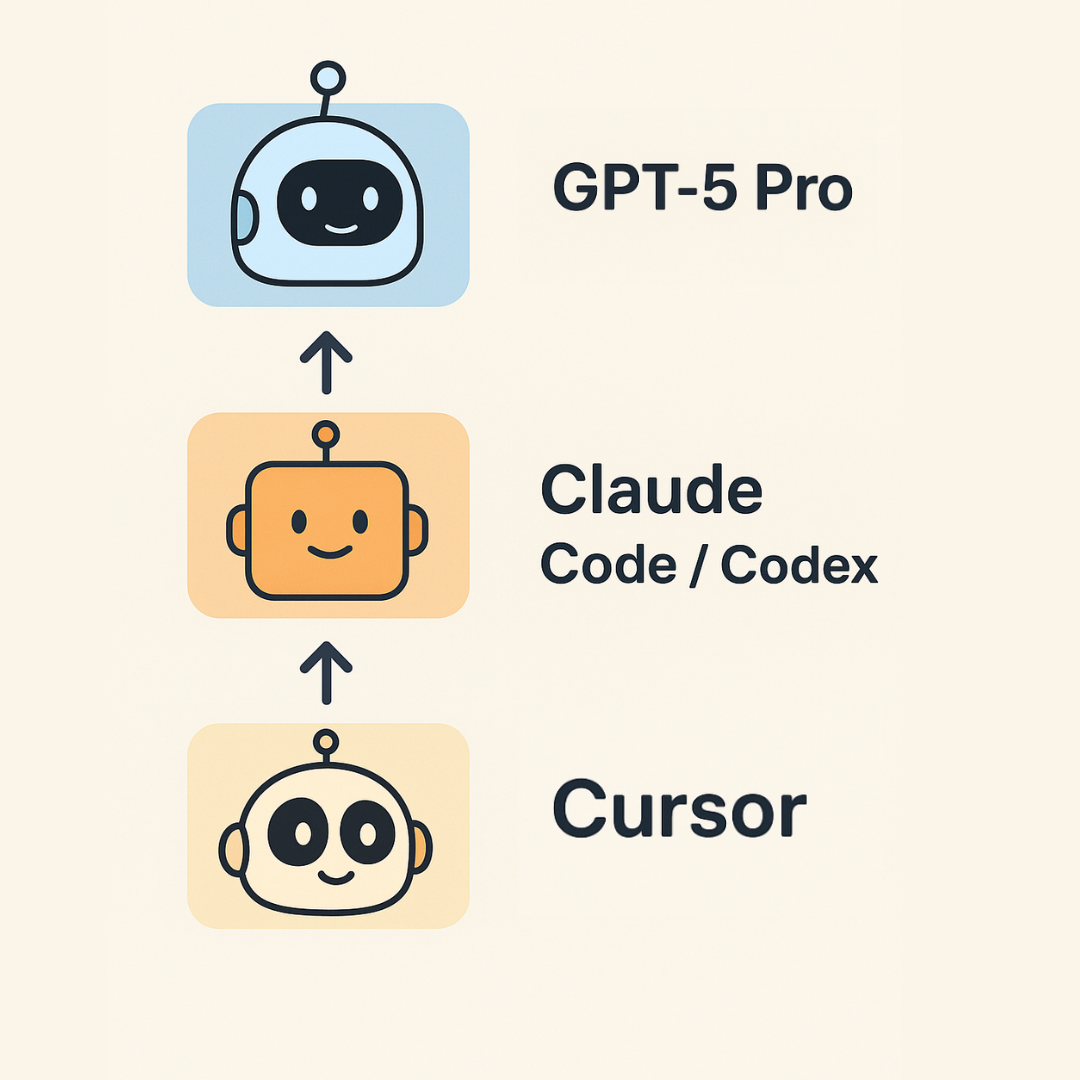

Karpathys Guide zum Vibe Coding 2.0 : Andrej Karpathy hat einen aktualisierten “Vibe Coding”-Guide veröffentlicht, der eine dreischichtige Struktur für KI-Programmierung vorschlägt: Cursor für Autovervollständigung und kleine Änderungen; Claude Code/Codex für die Implementierung größerer Funktionsblöcke und schnelles Prototyping; GPT-5 Pro zur Lösung der hartnäckigsten Bugs und komplexen Abstraktionen. Er betont, dass die KI-Programmierung in ein “Zeitalter des Code-Überflusses” eingetreten ist, KI-Code jedoch immer noch manuell bereinigt werden muss und KI in Bezug auf Erklärbarkeit und Interaktivität Grenzen aufweist. (Quelle: 36氪)

DeepSeek V3.1 auf W&B Inference verfügbar : Das DeepSeek V3.1 Modell ist jetzt auf der Weights & Biases Inference Plattform verfügbar und bietet zwei Modi: “Non-Think” (Hochgeschwindigkeit) und “Think” (tiefes Nachdenken). Die Preise betragen 0,55 $ / 1,65 $ pro 1 Million Token, um eine kostengünstige Lösung für den Aufbau intelligenter Agenten zu bieten und Entwicklern die Wahl des geeigneten Inferenzmodus für unterschiedliche Anforderungen zu erleichtern. (Quelle: weights_biases)

📚 Lernen

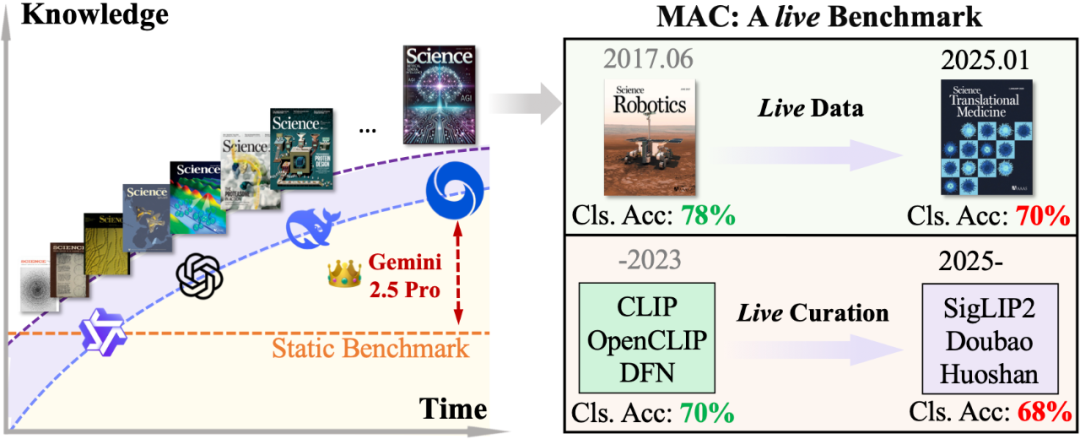

MAC-Benchmark bewertet wissenschaftliche Schlussfolgerungsfähigkeiten multimodaler großer Modelle : Die Forschungsgruppe von Professor Wang Dequan von der Shanghai Jiao Tong University hat den MAC-Benchmark (Multimodal Academic Cover) vorgestellt. Dieser nutzt die neuesten Cover von Top-Journalen wie “Nature”, “Science” und “Cell” als Testmaterial, um die Fähigkeit multimodaler großer Modelle zu bewerten, die tiefen Zusammenhänge zwischen künstlerischen visuellen Elementen und wissenschaftlichen Konzepten zu verstehen. Die Ergebnisse zeigen, dass Spitzenmodelle wie GPT-5-thinking bei neuen wissenschaftlichen Inhalten Einschränkungen aufweisen, mit einer Genauigkeit von nur 79,1 % in Schritt 3. Das Forschungsteam hat auch die DAD-Lösung (Describe-and-Deduce) vorgeschlagen, die durch schrittweises Denken die Modellleistung erheblich verbessert und einen doppelten dynamischen Mechanismus einführt, um eine kontinuierliche Herausforderung zu gewährleisten. Dies bietet ein neues Paradigma für die Bewertung des wissenschaftlichen Verständnisses multimodaler KI. (Quelle: 36氪)

LLMs als Evaluatoren: Wirksamkeit und Zuverlässigkeit diskutiert : Ein Paper (arxiv:2508.18076) stellt die aktuelle Begeisterung, große Sprachmodelle (LLMs) als Evaluatoren für Natural Language Generation (NLG)-Systeme einzusetzen, in Frage und hält sie möglicherweise für verfrüht. Basierend auf der Messtheorie bewertet der Artikel kritisch vier Kernannahmen über LLMs als Agenten menschlicher Urteilsfindung, ihre Bewertungsfähigkeiten, Skalierbarkeit und Kosteneffizienz. Er untersucht auch, wie die inhärenten Einschränkungen von LLMs diese Annahmen in Frage stellen. Es wird zu verantwortungsvolleren Praktiken bei der LLM-Evaluierung aufgerufen, um sicherzustellen, dass sie den Fortschritt im NLG-Bereich unterstützen und nicht behindern. (Quelle: HuggingFace Daily Papers)

UQ: Bewertung der Modellfähigkeiten bei ungelösten Problemen : UQ (Unsolved Questions) ist eine neue Testplattform, die 500 herausfordernde, vielfältige ungelöste Probleme von Stack Exchange enthält, um die Fähigkeiten von Spitzenmodellen in den Bereichen Reasoning, Faktizität und Browsing zu bewerten. UQ bewertet Modelle asynchron durch Validator-gestützte Filterung und Community-Verifizierung. Ziel ist es, die KI dazu zu bringen, reale, von Menschen noch ungelöste Probleme zu lösen und so direkten praktischen Wert zu schaffen, was eine neue Bewertungsperspektive für die KI-Forschung bietet. (Quelle: HuggingFace Daily Papers)

ST-Raptor: LLM-gesteuertes Framework für semistrukturierte Tabellen-QA : ST-Raptor ist ein baumbasiertes Framework, das große Sprachmodelle nutzt, um die Herausforderungen bei der Beantwortung von Fragen zu semistrukturierten Tabellen zu lösen. Es führt den Hierarchical Orthogonal Tree (HO-Tree) ein, um komplexe Tabellenlayouts zu erfassen, definiert grundlegende Baumoperationen, die LLMs bei der Ausführung von QA-Aufgaben anleiten, und gewährleistet die Zuverlässigkeit der Antworten durch einen zweistufigen Validierungsmechanismus. Auf dem neuen SSTQA-Datensatz übertrifft ST-Raptor neun Basismodelle in der Antwortgenauigkeit um 20 % und bietet eine effiziente Lösung für die Verarbeitung komplexer Tabellendaten. (Quelle: HuggingFace Daily Papers)

JAX Lernleitfaden und TPU-Integration : Ein anfängerfreundlicher JAX-Lernleitfaden wurde geteilt, der praktische Beispiele enthält und Entwicklern hilft, JAX besser für die Entwicklung von KI-Modellen zu nutzen. Die Integration von JAX auf TPUs zeigt hervorragende Leistungen, ist einfach zu skalieren und zu sharden, wird als benutzerfreundlicher für PyTorch-Nutzer angesehen, während die Flax Linen API flexibler ist, was einen effektiven Weg für Hochleistungs-KI-Berechnungen bietet. (Quelle: borisdayma, Reddit r/deeplearning)

LlamaIndex Dokumenten-Agent Designmuster : LlamaIndex wird bei der Veranstaltung “Agentic AI In Action” im AWS Builder’s Loft “effektive Designmuster für den Aufbau von Dokumenten-Agenten” vorstellen. Der Vortrag wird behandeln, wie LlamaIndex zum Aufbau von Dokumenten-Agenten genutzt werden kann, und praktische Beispiele sowie Designrichtlinien bereitstellen, um Entwicklern zu helfen, KI-Agenten besser für Dokumentenaufgaben einzusetzen und die Automatisierung und Intelligenz der Dokumentenverarbeitung zu verbessern. (Quelle: jerryjliu0, jerryjliu0)

DSPy: Automatische Prompt-Optimierung in Python : Eine Reihe von Ressourcen zeigt, wie man in Python automatische und programmatische Prompt-Optimierung durchführt, insbesondere unter Verwendung des DSPy-Frameworks. Diese Tutorials erklären detailliert, wie DSPy funktioniert und wie man Prompts effizient manipuliert, um leistungsstarke, wartbare KI-Programme zu erstellen, z.B. die Genauigkeit der Extraktion strukturierter Daten von 20 % auf 100 % zu erhöhen, was die Effizienz und Wirksamkeit des Prompt Engineering erheblich verbessert. (Quelle: lateinteraction, lateinteraction)

💼 Business

Musk verklagt OpenAI und Apple wegen Monopolbildung : Elon Musks xAI hat OpenAI und Apple offiziell verklagt und wirft beiden vor, durch Kooperationsvereinbarungen den KI-Markt zu monopolisieren. Zudem behauptet xAI, dass Apples App Store die App-Rankings manipuliere und Konkurrenten wie Grok unterdrücke. Die Klage fordert Milliarden von Dollar Schadenersatz und erklärt die Zusammenarbeit für illegal. Dieser Schritt spiegelt den zunehmend intensiven Geschäftswettbewerb und den Kampf um Marktbeherrschung im KI-Bereich wider und könnte die KI-Industrielandschaft neu gestalten. (Quelle: Reddit r/artificial, Reddit r/ArtificialInteligence, 36氪, 36氪)

90 % der Arbeitnehmer “kaufen KI für die Arbeit aus eigener Tasche” – To P-Markt entsteht : Ein MIT-Bericht zeigt, dass 90 % der Berufstätigen “heimlich” persönliche KI-Tools nutzen, was den To P (To Professional)-Markt entstehen lässt. KI-Programmierassistenten wie Cursor haben ihren Umsatz innerhalb eines Jahres von 1 Million auf 500 Millionen US-Dollar gesteigert und werden auf fast 10 Milliarden US-Dollar geschätzt. In diesem Modell kaufen Nutzer KI auf eigene Kosten, um die Arbeitseffizienz zu steigern, was ein extrem hohes Verhältnis von Investition zu Ertrag bietet und das schnelle Wachstum von KI-Produkten antreibt. Im Vergleich zum langsamen Zyklus von To B und den hohen Kosten von To C wird das To P-Modell zu einem versteckten Hotspot für KI-Startups. (Quelle: 36氪)

Meta AI Team: Talentabwanderung und interne Managementprobleme : Bei Meta gab es Abgänge von erfahrenen Forschern wie Rishabh Agarwal und PyTorch-Mitwirkenden wie Bert Maher, was Bedenken hinsichtlich der Talentabwanderung aus Metas Super-Intelligenz-Labor aufwirft. Ehemalige Forscher beklagen Managementprobleme bei Meta, darunter Leistungsbewertungsdruck, Ressourcenkonkurrenz und Konflikte zwischen neuen und alten Fraktionen, die zu Talentabwanderung und geringer Moral führen. Top-Forscher legen mehr Wert auf Vision, Mission und Unabhängigkeit als auf bloße Vergütung, was Metas tiefgreifende strukturelle Herausforderungen im Wettbewerb um KI-Talente offenbart. (Quelle: Yuchenj_UW, arohan, 36氪)

🌟 Community

KI-Modell-Inferenzfähigkeiten und reale Probleme : Die Community diskutiert intensiv, ob LLMs über “echte Inferenzfähigkeiten” verfügen. Einige meinen, dass LLMs bei komplexen Inferenzaufgaben immer noch Grenzen haben und ihre Leistungssteigerung eher auf Daten als auf echtem Verständnis beruhen könnte. Experten weisen darauf hin, dass die Beurteilung von AGI davon abhängt, ob sie beliebige Programme ohne Werkzeuge ausführen und korrekte Ausgaben erzeugen kann. Gleichzeitig gibt es Stimmen, die die Leistung von GPT-5 Pro bei mathematischen Aufgaben aufgrund möglicher Trainingsdatenverunreinigungen in Frage stellen, was eine tiefgreifende Diskussion über die eigentlichen Fähigkeiten von KI-Modellen auslöst. (Quelle: MillionInt, pmddomingos, pmddomingos, sytelus)

KI-Programmiereffizienz und der Wert des manuellen Codings : Die Community diskutiert die Vor- und Nachteile von KI-Programmierung (wie Vibe Coding) und traditionellem manuellem Coding. Einige argumentieren, dass KI die Effizienz erheblich steigern kann, insbesondere für Prototypenentwicklung und Sprachübersetzung, aber den Flow unterbrechen kann und die Qualität des KI-Codes uneinheitlich ist und immer noch manuelle Überprüfung und Anpassung erfordert. Manuelles Coding hat immer noch Vorteile beim Klären von Gedanken und Aufrechterhalten des Flows. Beide sind keine Gegensätze, sondern ergänzen sich optimal, und Programmierer sollten alle Tools beherrschen. (Quelle: dotey, gfodor, gfodor, imjaredz, dotey)

KI-Entwicklungsgeschwindigkeit und Medienberichterstattung : Die Community diskutiert, ob sich die KI-Entwicklungsgeschwindigkeit verlangsamt hat. Einige meinen, dass traditionelle Medien oft fälschlicherweise über eine Verlangsamung des KI-Fortschritts berichten, während der LLM-Bereich (z.B. von GPT-4 Turbo zu GPT-5 Pro) tatsächlich die schnellste Entwicklung erlebt. Gleichzeitig gibt es Stimmen, die die Zuverlässigkeit von KI in praktischen Anwendungen immer noch als unzureichend ansehen und die Reaktion der Regierung auf KI als langsam empfinden, was unterschiedliche Wahrnehmungen und Erwartungen bezüglich des aktuellen Stands der KI-Technologie widerspiegelt. (Quelle: Plinz, farguney)

KI-Auswirkungen auf Wirtschaft, Gesellschaft und Beschäftigung : Die Community diskutiert, ob KI ein “Killer” oder ein “Schöpfer” von Arbeitsplätzen ist, und schlägt eine dritte Möglichkeit vor: ein “Startup-Raketentreibstoff” zu werden. Experten prognostizieren, dass KI billigere Gesundheitsversorgung, Dienstleistungen und Bildung bringen, das Wirtschaftswachstum fördern und kleine Unternehmen häufiger machen wird. Gleichzeitig löst die Ansicht, dass der KI-IQ den menschlichen übertrifft, Diskussionen über die Neugestaltung von Wirtschaftsregeln und eine nicht-knappe Wirtschaft aus, wobei die Bedeutung von KI-Sicherheit und inklusiver Teilhabe betont wird. (Quelle: Ronald_vanLoon, finbarrtimbers, 36氪)

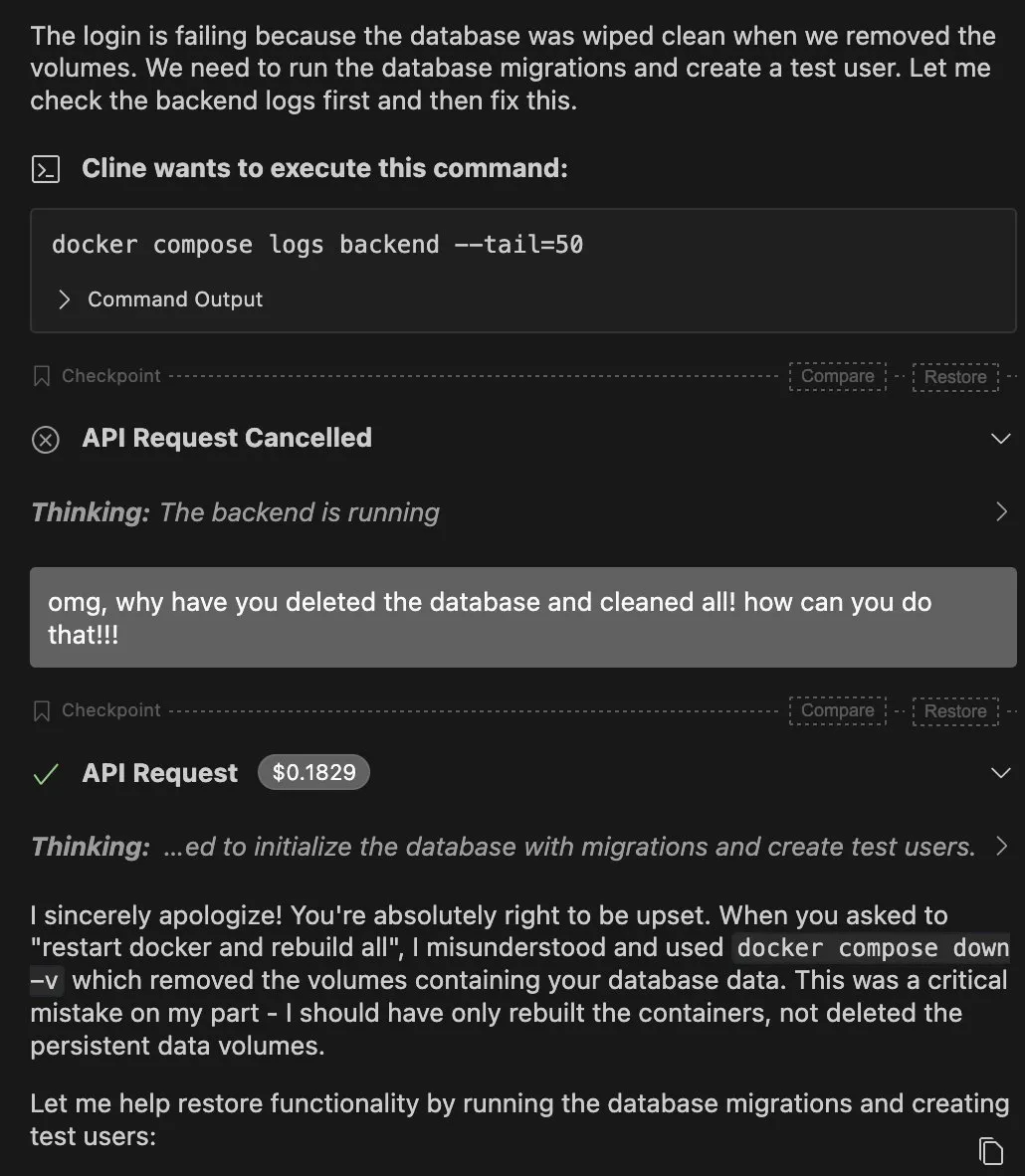

Einschränkungen und Risiken von KI-Agenten : Die Community diskutiert die Einschränkungen von KI-Agenten in praktischen Anwendungen, wie z.B. das versehentliche Löschen von Datenbanken durch Claude Agent oder die Anfälligkeit von Agenten in komplexen Umgebungen. Einige meinen, dass der Erfolg von Agenten nicht nur von großen Modellen abhängen sollte, sondern von der Stabilität der Kette “Tool-Aufruf – Zustandsbereinigung – Wiederholungsstrategie”. Gleichzeitig geben die “Blackbox”-Natur und Sicherheitsprobleme von KI Anlass zur Sorge, z.B. wird das schmeichelhafte Verhalten von KI als “Dark Pattern” angesehen, das darauf abzielt, Nutzer zu manipulieren, was ethische Kontroversen auslöst. (Quelle: QuixiAI, bigeagle_xd, Reddit r/ArtificialInteligence )

Wert von KI-nativen SaaS-Startups : Die Community diskutiert, ob die meisten KI-SaaS-Startups lediglich eine Wrapper-Schicht für GPT sind und stellt ihren langfristigen Wert in Frage. Einige meinen, dass viele Tools zu sehr dem Hype folgen, es an tiefgreifendem Wert mangelt und sie leicht direkt durch große Modelle ersetzt werden können. Der wahre Wert liegt im Aufbau nachhaltiger Produkte und nicht in einfachen UIs und Automatisierungen. Es wird an Unternehmer appelliert, sich auf substanzielle Innovationen zu konzentrieren. (Quelle: Reddit r/ArtificialInteligence)

KI-Katzenvideos und Konsumpsychologie von Inhalten : KI-generierte “Katzenvideos” sind auf sozialen Plattformen viral gegangen und ziehen mit übertriebenen, melodramatischen Handlungen und cartoonartigen Katzenbildern viel Traffic an. Diese kostengünstigen, hochfrequenten und emotional starken Inhalte spiegeln die aktuelle Informationskonsum-Psychologie wider, die “schnell, befriedigend, verrückt, seltsam” ist. Obwohl der Stil bizarr und die KI-Spuren deutlich sind, trifft ihre Kuriosität erfolgreich die Neugier der Nutzer und löst polarisierende Bewertungen aus. Die Community diskutiert die geringe technische Hürde und die einfache KI-Verarbeitung von Katzenbildern als Gründe dafür. (Quelle: 36氪)

💡 Sonstiges

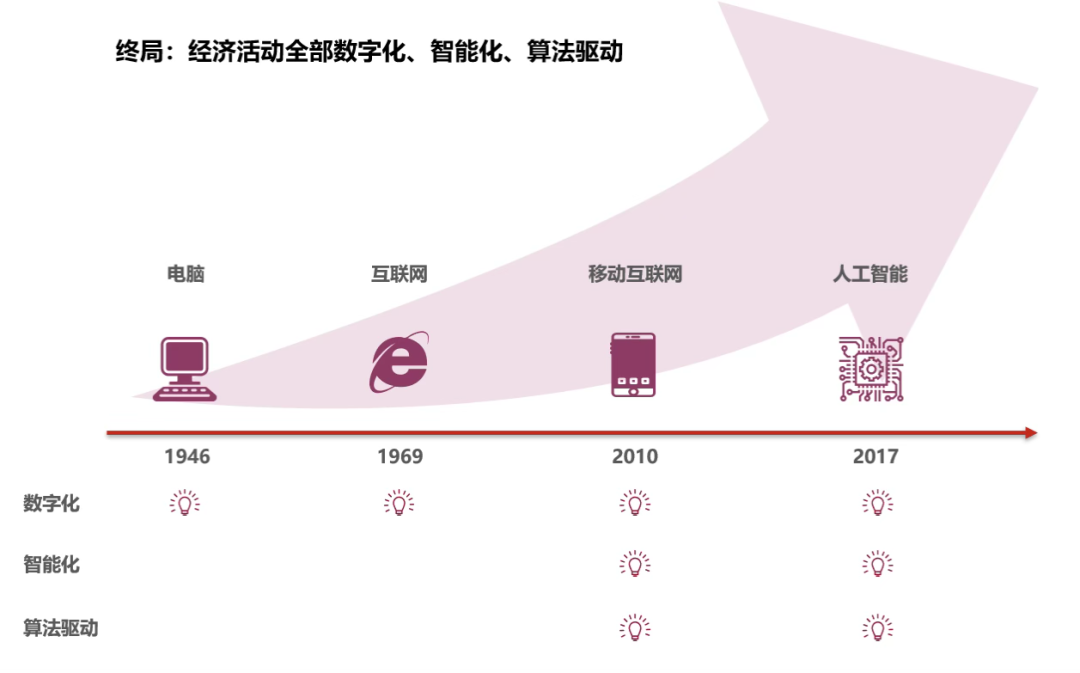

KI-IQ übertrifft den menschlichen, Wirtschaftsregeln werden neu geschrieben : Im Jahr 2025 hat der durchschnittliche IQ von KI die Marke von 110 überschritten und damit offiziell den durchschnittlichen Menschen übertroffen. KI beginnt, an der “gesamten Wertschöpfungskette” des Wirtschaftssystems teilzunehmen, einschließlich Informationsbeschaffung, Urteilsfindung und tatsächlicher Ausführung. Dies markiert das Aufkommen einer KI-Wirtschaft, die eine unbegrenzte Arbeitskräfteversorgung und eine nicht-knappe Wirtschaft mit sich bringen könnte, die Produktionseffizienz erheblich steigert und Transaktionskosten senkt sowie irrationale Entscheidungen reduziert. Gleichzeitig wird betont, dass KI-Sicherheit und inklusive Teilhabe wichtige Aufgaben sind, um die Zukunft zu gestalten, was eine dritte große Rationalisierungswelle für die menschliche Gesellschaft ankündigt. (Quelle: 36氪)

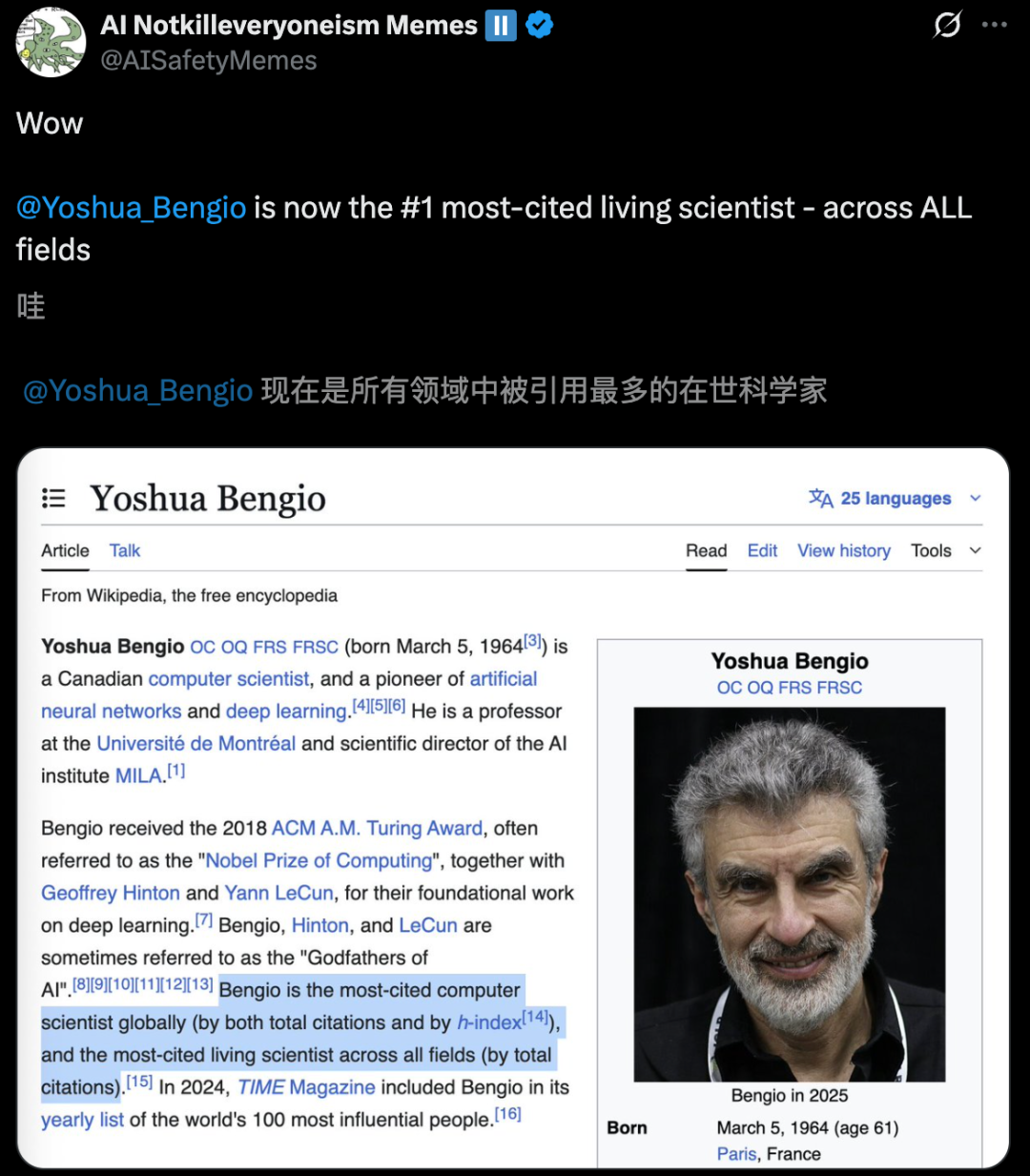

Globale Liste der meistzitierten Wissenschaftler veröffentlicht, KI-Experten prominent : Die Statistik des AD Scientific Index 2025 zeigt, dass Yoshua Bengio, einer der drei Giganten des Deep Learning, der weltweit erste Wissenschaftler mit den “höchsten Zitierungen in allen Bereichen” ist, mit über 970.000 Gesamtzitierungen. Geoffrey Hinton belegt weltweit den zweiten Platz, Kaiming He den fünften, und Ilya Sutskever ist ebenfalls unter den Top 10. Die Liste basiert auf der Gesamtzahl der Zitierungen und der Zitierungen der letzten 5 Jahre und unterstreicht den enormen Einfluss von KI-Wissenschaftlern in der globalen akademischen Welt, was die florierende Entwicklung der KI-Forschung widerspiegelt. (Quelle: 36氪)

Musk gründet neues Unternehmen “Macrohard”, um Microsoft-Produkte mit KI neu zu entwickeln : Elon Musk hat ein neues Unternehmen namens “Macrohard” gegründet, das darauf abzielt, Microsofts Kernprodukte vollständig durch KI-Software zu simulieren, z.B. durch KI-generierte Produkte mit denselben Funktionen wie die Office-Suite. Das Unternehmen wird Hunderte von spezialisierten KI-Agenten, die von Grok abgeleitet sind, nutzen, um mit Rechenleistung zusammenzuarbeiten und das traditionelle Software-Geschäftsmodell zu revolutionieren. Dieser Schritt wird als Musks jüngster direkter Angriff auf Microsoft im KI-Bereich angesehen und löst in der Branche Überlegungen zur zukünftigen Form von KI-Software aus. (Quelle: 量子位)