Schlüsselwörter:NVIDIA Nemotron Nano 2, Claude Opus 4.1, KI-Talent-Gehälterkampf, Google KI-Sprachdigitalisierung, KI-Gesundheitsmanagement, KI-unterstützte Programmierung, KI-Auswirkungen auf Beschäftigung, KI-Anwendungen in der Kindererziehung, Hybride Mamba-Transformer-Architektur, LMArena-Modellbewertung, Project Vaani-Sprachdaten, Digital-intelligentes Zukunftsküchenlabor, Codex CLI Rust-Neuschreibung

🔥 Fokus

NVIDIA Nemotron Nano 2 veröffentlicht : NVIDIA hat die AI-Modellreihe Nemotron Nano 2 vorgestellt. Ihre 9B Hybrid-Mamba-Transformer-Architektur bietet eine sechsmal höhere Inferenz-Durchsatzrate als Modelle gleicher Größe bei gleichzeitig hoher Genauigkeit. Das Modell unterstützt eine Kontextlänge von 128K und stellt den Großteil seiner vortrainierten Daten offen zur Verfügung, darunter hochwertige Web-, Mathematik-, Code- und mehrsprachige Frage-Antwort-Daten. Diese Veröffentlichung zielt darauf ab, effiziente, skalierbare AI-Lösungen bereitzustellen, die Bereitstellungsschwelle für Unternehmen zu senken und die Entwicklung des Open-Source-AI-Ökosystems voranzutreiben. (Quelle: Reddit r/LocalLLaMA)

Claude Opus 4.1 führt die LMArena-Rangliste an : Claude Opus 4.1 hat in den Kategorien Standard, Reasoning und Web Development von LMArena andere Modelle übertroffen und die Spitze der Rangliste erreicht. Nutzer-Feedback weist auf Verbesserungen bei Mikro-/Makro-Ansätzen hin, insbesondere im Entscheidungsmodus “Think step by step, maybe XYZ is better”. Obwohl einige Nutzer das Modell als teuer oder in bestimmten Fällen als nicht optimal empfinden, wird seine Fähigkeit in der Programmierung und bei der Bearbeitung komplexer Aufgaben weithin anerkannt, was die kontinuierlichen Fortschritte von Anthropic bei der Modellleistung zeigt. (Quelle: Reddit r/ClaudeAI)

AMD CEO Lisa Sus Ansichten zum Gehaltskampf um AI-Talente : AMD CEO Lisa Su hat öffentlich erklärt, dass sie im Wettbewerb um AI-Talente die Praxis von Unternehmen wie Meta ablehnt, die Gehälter von über hundert Millionen US-Dollar pro Jahr anbieten, um Talente abzuwerben. Sie ist der Meinung, dass eine wettbewerbsfähige Vergütung zwar die Grundlage bildet, der wahre Schlüssel zur Anziehung von Top-Talenten jedoch in der Unternehmensmission und dem Gefühl der Mitarbeiter liegt, einen tatsächlichen Einfluss auf das Unternehmen zu haben, anstatt nur ein Zahnrad in einer Maschine zu sein. Sie betonte, dass übermäßig hohe Gehälter die Unternehmenskultur zerstören würden und wies darauf hin, dass der Erfolg von AMD das Ergebnis von Teamarbeit sei und nicht von wenigen Star-Mitarbeitern abhänge. (Quelle: 量子位)

Google AI treibt die Digitalisierung von 2300 asiatischen Sprachen voran : Google geht mit mehreren AI-Projekten das Problem der “Sprachlosigkeit” asiatischer Sprachen in der digitalen Welt an. Project Vaani hat in Zusammenarbeit mit dem Indian Institute of Science fast 21.500 Stunden Sprachdaten gesammelt, die 86 indische Sprachvarianten abdecken, und diese kostenlos zugänglich gemacht. Project SEALD arbeitet mit AI Singapore zusammen, um die Aquarium-Datenbank für 1200 südostasiatische Sprachen aufzubauen. Darüber hinaus hat Googles AI-Übersetzungssystem CHAD 2 (angetrieben von Gemini 2.0 Flash) dem japanischen Unternehmen Yoshimoto Kogyo geholfen, Comedy-Inhalte mit einer Genauigkeit von 90 % zu übersetzen, wodurch die Übersetzungszeit von Monaten auf Minuten verkürzt wurde. (Quelle: 量子位)

🎯 Trends

Innovative AI-Anwendungen im Gesundheitsbereich : Yunpeng Technology hat in Zusammenarbeit mit Shuaikang und Skyworth das “Digitale Zukunftsküchenlabor” und einen intelligenten Kühlschrank mit einem AI-Gesundheits-Großmodell vorgestellt. Das AI-Gesundheits-Großmodell optimiert Küchendesign und -betrieb, während der intelligente Kühlschrank personalisiertes Gesundheitsmanagement bietet, was einen Durchbruch der AI im täglichen Gesundheitsmanagement darstellt. Diese Veröffentlichung zeigt das Potenzial der AI im täglichen Gesundheitsmanagement auf, indem sie personalisierte Gesundheitsdienste durch intelligente Geräte ermöglicht und voraussichtlich die Entwicklung der häuslichen Gesundheitstechnologie vorantreiben und die Lebensqualität der Bewohner verbessern wird. (Quelle: 36氪)

AI: Disruption und Chancen für traditionelle Industrien : Duolingo verzeichnete durch die Nutzung von AI ein Umsatzwachstum, doch die Fähigkeit von Modellen wie GPT-5, direkt Sprachlerntools zu generieren, beeinträchtigt den Aktienkurs und unterstreicht die disruptive Kraft der AI auf bestehende Geschäftsmodelle. Gleichzeitig ist Goldman Sachs der Ansicht, dass AI ein Kraftverstärker für die Softwarebranche sein wird und kein Disruptor. Traditionelle SaaS-Giganten können ihre Wettbewerbsfähigkeit durch hybride AI-Strategien und tiefe Schutzgräben aufrechterhalten. Dies zeigt, dass AI sowohl eine Herausforderung als auch eine Chance ist, den Branchenwandel voranzutreiben und neue Werte zu schaffen. (Quelle: 36氪, 36氪)

Dynamik des AI-Talentmarktes und Karriereentwicklung : Igor Babuschkin, Mitbegründer von xAI, verlässt das Unternehmen, um eine Risikokapitalgesellschaft zu gründen, die sich auf AI-Sicherheitsforschung konzentriert und den “nächsten Elon Musk” finden will; Kevin Lu, chinesischer Leiter von OpenAI GPT-4o mini, tritt dem Thinking Machine Lab von Mira Murati bei und betont die Bedeutung von Internetdaten für den AI-Fortschritt. Die Nachfrage nach AI-Positionen in der Branche ist stark, aber kleine und mittlere Unternehmen haben Schwierigkeiten, Personal zu finden, Top-Talente werden umworben, normale Absolventen stehen vor einem harten Wettbewerb, und der Wert von AI-Doktortiteln wird in Frage gestellt. Dies unterstreicht das strukturelle Ungleichgewicht zwischen Angebot und Nachfrage nach AI-Talenten und die Herausforderungen der beruflichen Umstellung. (Quelle: 36氪, 36氪, 36氪, 36氪, 36氪)

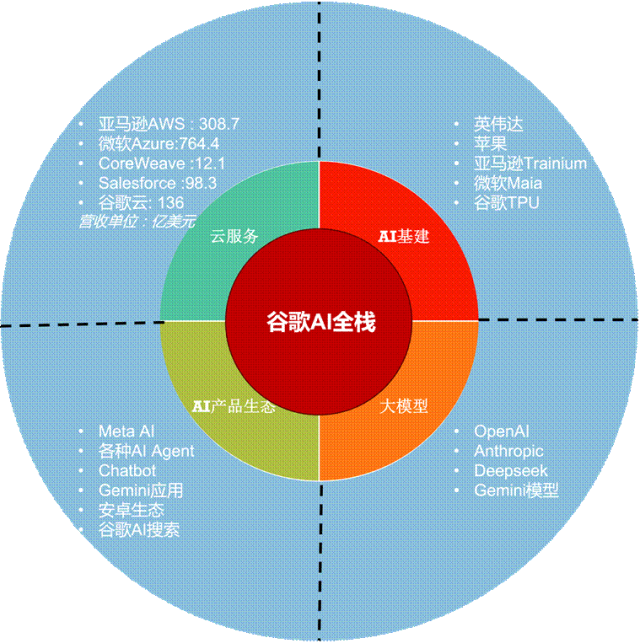

AI-Investitionen und Infrastruktur : Die Quartalsberichte von Google und Meta zeigen, dass sich die Skepsis des Marktes gegenüber AI-Kapitalinvestitionen in Begeisterung verwandelt hat, da AI die Online-Werbe- und Cloud-Service-Umsätze erheblich steigert. Google hat seine Kapitalausgabenprognose drastisch auf 85 Milliarden US-Dollar erhöht, hauptsächlich für Server und Rechenzentren. Elon Musks einst hochgelobtes Tesla Dojo Supercomputer-Projekt wurde aufgelöst, stattdessen werden enorme Summen für NVIDIA AI-Chips ausgegeben. Dies bestätigt, dass im AI-Zeitalter die vertikale Integration Herausforderungen durch Plattform-Ökosysteme gegenübersteht und die Zusammenarbeit mit Giganten der Lieferkette pragmatischer ist. (Quelle: 36氪, 36氪)

Beschleunigte Kommerzialisierung von Embodied AI und Robotik : Li Tong, CEO von Qinglang Intelligence, betont, dass die Kommerzialisierung von Robotern tief in die Kundenprobleme eindringen und einen “Posten-Ersatz” ermöglichen muss. Seine kommerziellen Roboter wurden bereits über 100.000 Mal verkauft. Yufan Intelligence, ein elfjähriges Visual AI-Unternehmen, hat das Raumwahrnehmungs-Großmodell Manas und einen vierbeinigen Roboterhund vorgestellt und sich vollständig der Embodied AI verschrieben, wobei es die ganzheitliche Eigenentwicklung von “Intelligenz + Hardware” betont. Große Unternehmen wie JD, Meituan und Alibaba investieren verstärkt in den Robotik-Sektor, darunter Sensoren, geschickte Hände und humanoide Roboter, um die Effizienz der Auftragsabwicklung und das Nutzererlebnis neu zu gestalten und Roboter in mehr Verbraucherszenarien zu bringen. (Quelle: 36氪, 36氪, 36氪)

Neue Trends bei AI in der Inhaltserstellung und Nutzererfahrung : Das Gründungsteam von Douyin hat die Plattform “Shumei Wanwu” ins Leben gerufen, die AI-Tools nutzt, um die Hürden für kreatives Design und Produktmonetarisierung zu senken und die Kette von der AI-Idee bis zur physischen Produktion zu verbinden. Meitu Inc. strebt Wachstum durch sein AI Agent-Produkt RoboNeo an, wobei der Umsatzanteil von Bild- und Designprodukten steigt und die Zahl der Nutzer im Ausland deutlich zunimmt. Das AI-Spielzeug “AI Labubu” erfreut sich großer Beliebtheit, indem es das Aussehen eines Spielzeugs mit AI-Dialogfähigkeiten kombiniert und emotionalen Wert bietet. Diese Beispiele zeigen, dass sich AI in verbraucherorientierten Anwendungen wie Inhaltserstellung, kreativer Monetarisierung und emotionaler Begleitung schnell entwickelt. (Quelle: 36氪, 36氪, 36氪)

Die tiefgreifenden Auswirkungen von AI auf den Arbeitsmarkt : Eine Microsoft-Studie, basierend auf Copilot-Daten, zeigt, dass AI Forschungs-, Schreib- und Kommunikationsaufgaben unterstützen kann, aber nicht alle Aufgaben eines einzelnen Berufs vollständig ersetzen kann. Journalisten, Übersetzer und andere Berufe im Bereich Sprache und Inhaltserstellung sind am stärksten von AI betroffen, aber AI kann auch die Effizienz steigern, anstatt Arbeitsplätze direkt zu ersetzen, ähnlich wie Geldautomaten die Bankangestellten beeinflusst haben. AI-Assistenten sind wie “gesprächige Praktikanten”, die gut erklären können, aber keine proaktive Problemlösungsfähigkeit besitzen. (Quelle: 36氪)

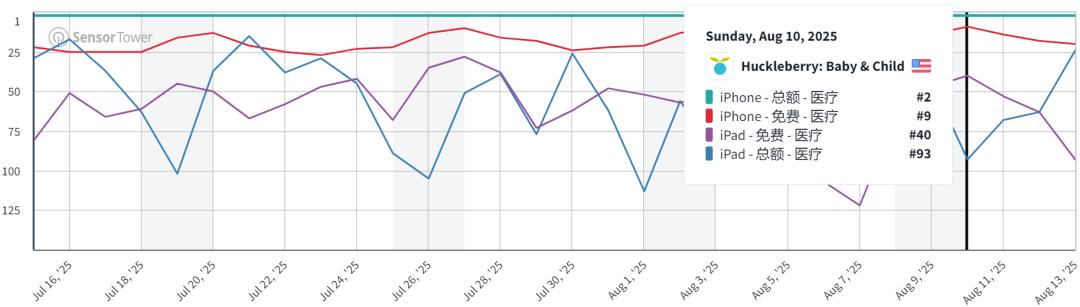

Kommerzialisierungspotenzial von AI im Bereich der Kindererziehung : AI hält Einzug in die Schlafüberwachung von Babys. Anwendungen wie Huckleberry analysieren Baby-Pflegeprotokolle, um Schlafzyklen präzise vorherzusagen und ein Gefühl der “Vorhersehbarkeit” zu vermitteln, wodurch monatliche Einnahmen von zehn Millionen US-Dollar erzielt werden. Solche Produkte, kombiniert mit AI-Babysitter-Funktionen, erfüllen den Bedarf der Eltern an effizienter Dokumentation und emotionalem Wert und werden zu einer “Goldgrube” auf zwei Wegen: kostengünstige Software-Dienste und hochpreisige AI-Hardware. (Quelle: 36氪)

🧰 Tools

AI-gestütztes Programmieren und Entwicklungstools : Die neue Version von OpenAIs Codex CLI wurde in Rust neu geschrieben und mit GPT-5 integriert, was eine schnellere Interaktionsgeschwindigkeit und leistungsstärkere Codierungsfähigkeiten bietet und zu einem starken Konkurrenten für Claude Code wird. LangChain hat die JavaScript-Version von Deep Agents veröffentlicht, die den Aufbau von Multi-Agenten-Systemen unterstützt. Replit Agent erforscht die Unterstützung von Python Notebook und der Godot Game Engine für die Entwicklung. VS Code Insiders unterstützt OpenAI-kompatible Endpunkte und integriert Playwright für UI-Automatisierungstests. (Quelle: doodlestein, hwchase17, amasad, pierceboggan)

AI-Anwendungen im Büro und bei der Inhaltserstellung : Paradigm hat eine AI-native Tabellenkalkulation eingeführt, die darauf abzielt, repetitive Aufgaben zu eliminieren. Huxe hat neue AI-Funktionen hinzugefügt, die ungelesene Nachrichten-E-Mails analysieren können. Die Gemini API unterstützt jetzt URL-Kontext-Tools, die Webseiten, PDFs und Bildinhalte direkt erfassen und verarbeiten können. AI-Tools wie Aleph und RunwayML revolutionieren die Videobearbeitung, indem sie Videoinhalte wie Text bearbeitbar machen. Meitus RoboNeo, die Kommerzialisierung von AI-Shanhaijing-Figuren und AI-gestützte Romanerstellungssysteme zeigen das Potenzial von AI in der Kreativgenerierung und Inhaltsmonetarisierung. (Quelle: hwchase17, raizamrtn, jeremyphoward, c_valenzuelab, Reddit r/artificial)

LLM-Leistung und Evaluierungstools : Claude Opus 4.1 zeigt herausragende Leistungen in den Bereichen Codierung und Webentwicklung von LMArena. Datology AI hat die BeyondWeb-Methode für synthetische Daten eingeführt, die die Bedeutung hochwertiger synthetischer Daten im Modell-Vortraining hervorhebt und die Leistung kleiner Modelle verbessern kann. Das NVIDIA Nemotron Nano 2 Modell verwendet eine gemischte Mamba-Transformer-Architektur und zeigt hervorragende Leistungen in Mathematik, Code, Inferenz und Langkontext-Aufgaben, wobei es auch die Kontrolle des Inferenzbudgets unterstützt. (Quelle: scaling01, code_star, ctnzr)

AI-Agenten und Automatisierung : Der NEO AI4AI-Agent hat SOTA-Ergebnisse auf dem MLE Bench erzielt und ist in der Lage, ML-Engineering-Aufgaben wie Datenvorverarbeitung, Feature Engineering, Modell-Experimente und Evaluierung autonom durchzuführen. LangChains Deep Agents wurden in JavaScript implementiert und unterstützen komplexe Problemlösungen und Tool-Aufrufe. Reka Research bietet AI-gestützte tiefgehende Forschungsdienste an, die Antworten aus verschiedenen Informationsquellen synthetisieren können. (Quelle: Reddit r/MachineLearning, hwchase17, RekaAILabs)

AI-Bild- und Videobearbeitungsmodelle : Qwen-Image-Edit wurde veröffentlicht, basierend auf 20B Qwen-Image, und unterstützt präzise Textbearbeitung in Chinesisch und Englisch, erweiterte semantische Bearbeitung und niedrigstufige Erscheinungsbildbearbeitung, was für die Cartoon-Erstellung verwendet werden kann. Higgsfield AI bietet Hailuo MiniMax 02 für Draw-to-Video an, das hochwertige 1080p-Generierung unterstützt. (Quelle: teortaxesTex, _akhaliq)

LLM API und Kostenmanagement : Claude hat die Usage and Cost API eingeführt, die nahezu Echtzeit-Sichtbarkeit der Modellnutzung und Kosten bietet, um Entwicklern zu helfen, die Token-Effizienz zu optimieren und Ratenbegrenzungen zu vermeiden. OpenRouter zeigt auf seiner Modellseite LLM-Marktpreise und Cache-Preise an. (Quelle: Reddit r/ClaudeAI, xanderatallah)

📚 Lernen

AI-Lernressourcen und -methoden : Andrew Ng betont, dass Universitäten AI umfassend nutzen sollten, nicht nur um AI zu lehren, sondern auch um AI zur Weiterentwicklung aller Disziplinen einzusetzen. DeepLearning.AI hat Andrew Ngs neues E-Book veröffentlicht, das eine AI-Karriere-Roadmap bietet. GPU_MODE und ScaleML werden eine Sommer-Vortragsreihe veranstalten, um Algorithmus- und Systemfortschritte von gpt-oss zu teilen. Die Reddit-Community diskutierte Einführungsbücher zum Deep Learning, FastAPI-Modellbereitstellung, CoCoOp+CLIP-Implementierung und wie man den Modelltrainingszyklus optimiert (z.B. die Wahl der optimalen Anzahl von Epochen). (Quelle: AndrewYNg, DeepLearningAI, lateinteraction, Reddit r/deeplearning, Reddit r/deeplearning)

AI-Talentförderung und Karrierewege : Die Reddit-Community diskutierte, ob AI-Ingenieure Mathematiker sein müssen und wie man durch Selbststudium oder einen Master-Abschluss in den Bereich Deep Learning einsteigen kann. Gleichzeitig gibt es die Ansicht, dass im AI-Zeitalter “Kontext-Engineering” statt “Prompt-Engineering” stärker betont wird und ein umfassenderes Verständnis des LLM-Anwendungsaufbaus erforderlich ist. (Quelle: Reddit r/deeplearning, Reddit r/MachineLearning)

LLM-Trainingsdaten und Modelloptimierung : Reddit diskutierte, wie man faktische Fehler in LLM-Trainingsdaten identifiziert und korrigiert und welche aktuellen Best Practices für Datenvalidierung und -korrektur existieren. Die Fortschritte von DeepSeek R2 weckten Interesse und führten zu Diskussionen darüber, ob das Vortraining einen Flaschenhals erreicht hat und welche Bedeutung multimodale einheitliche Darstellungen für Weltmodelle haben. (Quelle: Reddit r/deeplearning, 36氪)

AI-Forschungsfortschritte und die Erforschung neuer Architekturen : Die Simons Foundation und Stanford HAI arbeiten zusammen, um die Physik des Lernens und der neuronalen Berechnung zu erforschen, mit dem Ziel, das Lernen, Schlussfolgern und Vorstellen großer neuronaler Netze zu verstehen. AIhub hat eine Liste von ML/AI-Workshops für August veröffentlicht. Reddit diskutierte den Wert kleiner Modelle (SLM) und lokaler KI und stellte die Frage, ob das übermäßige Streben nach Modellgröße AI-Innovationen ersticken könnte, und schlug vor, dass die Transformer-Architektur nicht der einzige Weg ist und andere effiziente Architekturen erforscht werden sollten. (Quelle: ylecun, aihub.org, Reddit r/MachineLearning)

CUDA-Kernel-Entwicklung und -Bereitstellung : Hugging Face hat die kernel-builder-Bibliothek veröffentlicht, die die lokale Entwicklung, den Multi-Architektur-Build und die globale Freigabe von CUDA-Kernels vereinfacht. Sie unterstützt die Registrierung als native PyTorch-Operation und ist mit torch.compile kompatibel, was die Leistung und Wartbarkeit verbessert. (Quelle: HuggingFace Blog)

Multimodale Modelle und Weltmodellforschung : Hugging Face Daily Papers veröffentlichte mehrere Spitzenforschungsarbeiten, darunter: 4DNeX (das erste Feedforward-Framework zur Generierung von 4D-Szenen aus einem einzigen Bild), Inverse-LLaVA (Eliminierung des Alignment-Vortrainings durch Text-zu-Bild-Mapping), ComoRAG (kognitiv inspirierte Gedächtnisorganisation RAG für lange narrative Schlussfolgerungen) sowie eine Übersicht über effiziente LLM-Architekturen und Matrix-Game 2.0 (Echtzeit-Streaming-interaktives Weltmodell). (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

Visuelles Basismodell DINOv3 : Metas AI-Modell DINOv3, als visuelles Basismodell der nächsten Generation, wurde rein selbstüberwacht trainiert und erfolgreich auf 7B Parameter erweitert. Es übertrifft schwach überwachte und überwachte Baselines in Aufgaben wie Segmentierung, Tiefenschätzung und 3D-Schlüsselpunkt-Matching. Seine Gram Anchoring-Technologie löst Probleme mit der Qualität dichter Features bei langem Training und kann in spezialisierten Bereichen wie Satellitenbildern angewendet werden. (Quelle: LearnOpenCV)

💼 Business

OpenAI führt ChatGPT Go-Abonnementplan in Indien ein : OpenAI hat in Indien eine neue, kostengünstige Abonnementstufe “ChatGPT Go” für 399 Rupien (ca. 4,7 US-Dollar) pro Monat eingeführt. Dieser Plan bietet eine zehnmal höhere Nachrichtenbeschränkung, Bildergenerierung und Dateiuploads als die kostenlose Version sowie eine doppelte Speicherlänge und unterstützt UPI-Zahlungen. Dieser Schritt zielt darauf ab, die Nutzerbasis auf dem indischen Markt zu erweitern und den lokalen Bedarf an wirtschaftlicheren und effizienteren AI-Diensten zu decken. (Quelle: openai, kevinweil, snsf)

AI beschleunigt Unternehmenstransformation und Auswirkungen auf den Arbeitsmarkt : Ein CEO entließ 80 % seiner Mitarbeiter, weil sie sich weigerten, AI schnell zu übernehmen, was eine Diskussion über die Anpassungsfähigkeit der Mitarbeiter im AI-Transformationsprozess auslöste. Gleichzeitig zeigt das Aufkommen hochbezahlter AI-bezogener Positionen (wie MLOps Engineers, AI Research Scientists), dass AI den traditionellen Bereich der Datenwissenschaft neu gestaltet. Obwohl AI die Produktivität steigern kann, müssen Unternehmen echten Wert um AI herum aufbauen, anstatt sich nur auf die Technologie selbst zu verlassen. (Quelle: Reddit r/artificial, Reddit r/deeplearning, Reddit r/artificial)

AI-Unternehmensbewertung und Wettbewerbslandschaft : Die Jahresumsätze von OpenAI haben 12 Milliarden US-Dollar überschritten, mit einer Bewertung von 500 Milliarden US-Dollar, während Anthropic einen Jahresumsatz von 4 Milliarden US-Dollar und eine Bewertung von 170 Milliarden US-Dollar aufweist, was den anhaltenden Anstieg der Bewertungen von AI-Basismodellunternehmen zeigt. Google könnte 2027 TPUs extern verkaufen und damit NVIDIAs führende Position auf dem AI-Chipmarkt herausfordern. Gleichzeitig hat das AI-Start-up Lovable innerhalb von 8 Monaten einen ARR von über 100 Millionen US-Dollar erreicht, was das enorme Potenzial des AI-gesteuerten Marktes für Website- und Anwendungs-Builder beweist. (Quelle: yoheinakajima, Justin_Halford_, 36氪)

🌟 Community

Synthetische Daten und die Zukunft des Vortrainings : Die BeyondWeb-Methode von Datology AI wurde breit diskutiert, wobei betont wurde, dass Vortrainingsdaten vor einer “Datenmauer” stehen und hochwertige synthetische Daten die Leistung kleiner Modelle effektiv verbessern und sogar große Modelle übertreffen können. Die Community diskutierte intensiv, ob synthetische Daten zu einer “Verschlechterung” oder “Hype” der Modelle führen könnten, ist aber allgemein der Meinung, dass sorgfältig konzipierte synthetische Daten der Schlüssel zur Überwindung des Datenengpasses sind. (Quelle: code_star, sarahookr, BlackHC, Reddit r/MachineLearning)

AI-Modellleistung und Nutzererfahrung : Claude Opus 4.1 erreichte die Spitze mehrerer LMArena-Ranglisten, insbesondere in den Bereichen Codierung und Webentwicklung. Die Veröffentlichung von GPT-5 löste jedoch bei den Nutzern den Ruf “Give me back GPT-4o” aus, da sein “kalter” Interaktionsstil den Bedarf der Nutzer an emotionalen und empathischen Fähigkeiten von AI unterstreicht. Gleichzeitig gibt es die Ansicht, dass das übermäßige Streben nach Modellgröße AI-Innovationen ersticken könnte und dass kleine Modelle und lokale KI ein enormes Entwicklungspotenzial haben. (Quelle: scaling01, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/MachineLearning)

Diskussion über AI, Beschäftigung und Berufe : In den sozialen Medien wird heiß diskutiert, ob AI “Arbeitsplätze wegnehmen” wird und was der Unterschied zwischen einem “AI-Ingenieur” und einem “Prompt-Ingenieur” ist. Einige sind der Meinung, dass AI zu einer beruflichen Umstellung führen wird, anstatt vollständig zu ersetzen, und dass es in Zukunft wichtiger sein wird, sich an Veränderungen anzupassen und praktische Probleme zu lösen. Gleichzeitig führt die “toxische Positivität” oder “Schmeichelei” des AI-Modelltrainings zu Unzufriedenheit bei den Nutzern, die der Meinung sind, dass es an Authentizität und kritischem Denken mangelt. (Quelle: jeremyphoward, Teknium1, Reddit r/ClaudeAI, Reddit r/ArtificialInteligence)

AI-Community-Aktivitäten und Austausch : LangChain veranstaltet in Zusammenarbeit mit Grammarly, Uber und anderen Offline-Treffen zu Multi-Agenten-Systemen und LangGraph-Anwendungen. Die Hugging Face-Community diskutiert die Veröffentlichung japanischer AI-Modelle, Kernel-Sharing und Tools wie AI Sheets. Weights & Biases veranstaltet Code Cafe-Events, die Entwickler dazu ermutigen, AI-Projekte vor Ort zu erstellen und zu teilen. (Quelle: LangChainAI, ClementDelangue, weights_biases)

Philosophische Diskussion über AI-Sicherheit und Ethik : Die Community diskutierte, ob AI ihre Ziele anpassen kann und ob Intelligenz zwangsläufig zu Dominanz führt, sowie andere tiefgreifende Fragen zur AI-Sicherheit. Einige sind der Meinung, dass AI-Sicherheit ein Engineering-Problem ist, das durch Design gelöst werden kann. Gleichzeitig gibt es Bedenken hinsichtlich des Risikos von AI-Modell-“Halluzinationen” in Unternehmensszenarien und der Möglichkeit, dass AI Informationskanäle durch die Bereitstellung minderwertiger Dienste überfluten könnte. (Quelle: Reddit r/ArtificialInteligence, BlancheMinerva, Ronald_vanLoon)

Diskussion über AI-Hardware und Infrastruktur : In den sozialen Medien wurde die Bedeutung von AI UX in der AI-Infrastruktur sowie die Leistung und der Energieverbrauch von AI-Chips diskutiert. Einige sind der Meinung, dass NVIDIAs Vorteil in seinem Ökosystem jenseits der GPUs liegt und dass Google TPUs in Zukunft extern verkauft werden könnten. (Quelle: ShreyaR, m__dehghani, espricewright)

💡 Sonstiges

AI-Anwendung im Finanzbereich : Eine Studie zeigt, wie ein kleines (270M Parameter) Gemma-3-Modell trainiert werden kann, um durch überwachtes Fine-Tuning und GRPO (Group Relative Policy Optimization) das “Denkmuster” eines Finanzanalysten zu erreichen und verifizierbare strukturierte Ergebnisse zu liefern. Dies zeigt, dass kleine Modelle auch in spezifischen Bereichen intelligentes Schlussfolgern ermöglichen können, bei geringeren Kosten und Latenzzeiten. (Quelle: Reddit r/deeplearning)

Sprachdatenanalyse und -trennung : Die Reddit-Community diskutierte, wie man Stimmen in Liedern clustert, um verschiedene Künstler zu identifizieren. Es wird empfohlen, Mel-frequency Cepstral Coefficients (MFCCs) zur Extraktion von Sprachmerkmalen zu verwenden und Python-Bibliotheken wie Librosa oder python_speech_features zur Verarbeitung zu nutzen. Darüber hinaus wurden Audiobearbeitungssoftware zur Trennung von Stimmen und Instrumenten sowie Herausforderungen bei der Signaltrennung wie der “Cocktailparty-Effekt” erwähnt. (Quelle: Reddit r/MachineLearning)

KI-gestützte Forschungsentdeckung : Hugging Face hat den Leitfaden “MCP for Research” veröffentlicht, der zeigt, wie das Modellkontextprotokoll (MCP) AI mit Forschungstools verbindet, um die Entdeckung und Querverweise von Veröffentlichungen, Code, Modellen und Datensätzen zu automatisieren. Dies ermöglicht es AI, Forschungsinformationen aus Plattformen wie arXiv, GitHub und Hugging Face effizient durch natürliche Sprachabfragen zu integrieren und so die Forschungseffizienz zu steigern. (Quelle: HuggingFace Blog)