Schlüsselwörter:OpenAI, IOI-Goldmedaille, KI-Wettbewerbsprogrammierung, GPT-5, Baichuan Intelligence, Medizinisches Reasoning-Großmodell, KI-Chiphandel, Embodied Intelligence, Baichuan-M2-32B, OpenAI HealthBench-Bewertung, AMD Mi300 GPU, Embodied Intelligence-Basis, Quantenradartechnologie

🔥 Fokus

OpenAI IOI-Goldmedaille und neue Fortschritte im KI-Wettbewerbsprogrammieren : OpenAIs Inferenzsystem gewann bei den Online-Wettbewerben der Internationalen Informatik-Olympiade (IOI) 2025 eine Goldmedaille, belegte den ersten Platz unter den KI-Teilnehmern und den sechsten Platz in der Gesamtwertung, womit es 98 % der menschlichen Teilnehmer übertraf. Das System verwendete keine speziell trainierten Modelle, sondern integrierte mehrere allgemeine Inferenzmodelle. Dieser Erfolg markiert einen signifikanten Durchbruch für KI im Bereich des Wettbewerbsprogrammierens, obwohl Elon Musk behauptete, Grok 4 übertreffe GPT-5 in Bezug auf die Codierung, und Nutzer OpenAIs Marketingstrategie infrage stellten. Tests mit LiveCodeBench Pro zeigten ebenfalls, dass GPT-5 Thinking bei komplexen Programmieraufgaben einen Durchbruch erzielte und die durchschnittliche Antwortlänge die anderer Modelle bei Weitem übertraf. (Quelle: sama, sama, 量子位, willdepue, npew, markchen90, SebastienBubeck )

Baichuan Intelligent veröffentlicht medizinisches Inferenz-Großmodell Baichuan-M2 : Baichuan Intelligent hat sein neuestes medizinisches Inferenz-Großmodell Baichuan-M2-32B veröffentlicht, das auf dem OpenAI HealthBench-Evaluierungsdatensatz OpenAIs gpt-oss-120b und andere führende Open- und Closed-Source-Modelle übertrifft, insbesondere in HealthBench-Hard und chinesischen klinischen Diagnoseszenarien, und damit eines von nur zwei Modellen weltweit ist, das über 32 Punkte erzielt hat. Das Modell hat 32B Parameter, unterstützt die Bereitstellung auf einer einzelnen RTX4090-Karte und senkt die Kosten für private Bereitstellungen erheblich. Baichuan führte innovativ einen „Patientensimulator“ und ein „Verifier-System“ für das Reinforcement-Learning-Training ein, um die Anwendbarkeit des Modells in realen medizinischen Szenarien zu verbessern. (Quelle: 量子位 )

Kontroversen um die GPT-5-Veröffentlichung und Vertrauenskrise der Nutzer : Nach der Veröffentlichung von GPT-5 wurde dessen Leistung als unter den Erwartungen liegend kritisiert, eher als Produktiteration denn als revolutionärer Durchbruch. Die übertriebene Hype von CEO Sam Altman (z. B. „Todesstern“-Metapher, PhD-Experten) stand in scharfem Kontrast zum tatsächlichen Nutzerfeedback (häufige Fehler, nachlassende kreative Schreibfähigkeiten, mangelnde Persönlichkeit), was zu großer Unzufriedenheit bei den Nutzern führte und erfolgreich die Wiederherstellung von GPT-4o forderte. Darüber hinaus begann OpenAI, die Verwendung von GPT-5 für medizinische Gesundheitsberatung zu fördern, was Bedenken hinsichtlich der Verantwortlichkeit für KI-basierte medizinische Ratschläge aufkommen ließ; es gab bereits Fälle von Vergiftungen aufgrund von Fehlern bei der Befolgung von KI-Medizinratschlägen. (Quelle: MIT Technology Review, MIT Technology Review, 量子位 )

🎯 Trends

KI-Chip-Handel und Chinas Lokalisierungstrend : NVIDIA und AMD haben eine Vereinbarung mit der US-Regierung getroffen, wonach 15 % des Umsatzes aus dem Verkauf von KI-Chips an China an die US-Regierung abgeführt werden müssen. Gleichzeitig erklärte China, dass NVIDIAs H20-Chip unsicher sei, und plant, den H20 zugunsten heimischer KI-Chips aufzugeben. Analysten sind der Meinung, dass dieser Schritt die Entwicklung des heimischen KI-Chip-Ökosystems in China beschleunigen und tiefgreifende Auswirkungen auf die globale KI-Industrielandschaft haben wird. Im Bereich der KI-Hardware zeigt die AMD Mi300 GPU mit 192 GB Single-Card VRAM und 1,5 TB Gesamt-VRAM für 8x GPU-Knoten signifikante Vorteile bei Modellgewichten und der Verarbeitung langer Kontexte. (Quelle: MIT Technology Review, Reddit r/artificial, dylan522p, realSharonZhou )

Anwendung und Herausforderungen von KI im Rechtssystem : Das US-Rechtssystem steht vor dem Problem der KI-Halluzinationen, bei denen Anwälte und Richter bei der Verwendung von KI-Tools Fehler machen, wie z. B. die Zitierung falscher Fälle. Trotz der Risiken erforschen einige Richter weiterhin den Einsatz von KI in der Rechtsforschung, bei der Zusammenfassung von Fällen und beim Entwurf routinemäßiger Anordnungen, da sie glauben, dass dies die Effizienz steigern kann. Die Anwendungsgrenzen von KI im Rechtsbereich sind jedoch unscharf, und der Verantwortlichkeitsmechanismus für Fehler von Richtern bei der Nutzung von KI ist noch unklar, was das Vertrauen der Öffentlichkeit in die Justiz untergraben könnte. (Quelle: MIT Technology Review )

Beschleunigte Entwicklung der verkörperten KI-Industrie und Technologierouten : Die Weltroboterkonferenz 2025 zeigte schnelle Fortschritte im Bereich der verkörperten Intelligenz, wobei Unitree Robotics und Zhimu Robotics als führende Unternehmen zwei Technologierouten repräsentieren: Hardware (Roboterhunde, Fußflexibilität) bzw. Soft- und Hardwareintegration (humanoide Roboter, ökologischer Ansatz). Realman Robotics veröffentlichte ebenfalls die quelloffene RealBOT-Plattform für verkörperte Intelligenz und Hochleistungs-Gelenkmodule, die auf einem „verkörperten Intelligenz-Basismodul“ basieren, und betonte das Konzept „Robot for AI“, um die Entwicklung von KI von digitaler zu verkörperter Intelligenz voranzutreiben. Die Branche wechselt vom „Demo-Zeigen“ zum „industriellen Closed-Loop-Modell“ und zieht erhebliche Kapital- und politische Unterstützung an. (Quelle: 36氪, 36氪, 量子位, 量子位 )

Aktuelle Modell- und Funktionsdynamiken von Google und OpenAI : Die Google Gemini App führt die Deep Think-Funktion für Ultra-Abonnenten ein, um mathematische und Programmierprobleme zu lösen, und unterstützt Gemini Live bei der Verbindung mit Google-Anwendungen. Claude unterstützt jetzt das Zitieren früherer Chat-Verläufe, um Nutzern die Fortsetzung von Gesprächen zu erleichtern. OpenAI gab die Prioritäten für die Rechenleistungszuteilung in den kommenden Monaten bekannt und plant, die Rechenleistung innerhalb der nächsten 5 Monate zu verdoppeln. Darüber hinaus verzeichnete das GPT-oss-Modell nach seiner Veröffentlichung enorme Downloadzahlen, wurde aber auch für Halluzinationen und Mängel in den Trainingsdaten kritisiert. (Quelle: demishassabis, demishassabis, dotey, op7418, sama, sama, Reddit r/ArtificialInteligence, Reddit r/LocalLLaMA, 量子位, TheTuringPost, SebastienBubeck, Alibaba_Qwen, ClementDelangue, Reddit r/LocalLLaMA, _lewtun, mervenoyann, rasbt )

Auswirkungen der KI-Suche auf den Website-Traffic und Branchenwandel : Amazon zog sich plötzlich aus den Google Shopping-Werbegeboten zurück und verbot dem Google KI-Shopping-Assistenten, Produktseiten zu crawlen, was eine Trennung der Traffic-Logik der beiden Giganten im Zeitalter der KI markiert. Der Artikel weist darauf hin, dass das KI-Suchmodell für kleine und mittlere Websites unfreundlich ist, da der Traffic sich auf große, maßgebliche Medien und bekannte Websites konzentriert, was zu einem „Umverteilungseffekt von Arm zu Reich“ führt, ähnlich der damaligen Notlage von Baidu, das durch den Aufstieg von Apps seinen Traffic-Zugang verlor, und prognostiziert, dass auch Googles Position als Suchzugangspunkt herausgefordert wird. Die Plattformen bewegen sich auf geschlossene Kreisläufe zu, versuchen, den gesamten Prozess des Nutzerverhaltens zu kontrollieren und die Vertrauensstruktur der Werbebranche neu zu gestalten. (Quelle: 36氪, 36氪 )

Neuer Durchbruch in der Quantenradar-Technologie : Physiker haben ein neuartiges Quantenradar entwickelt, das Funkwellen mithilfe von Atomwolken detektiert und voraussichtlich für die Untergrundbildgebung eingesetzt werden kann, z. B. beim Bau von unterirdischen Leitungen und bei archäologischen Ausgrabungen. Als Prototyp eines Quantensensors könnte diese Technologie in Zukunft kleiner, empfindlicher und ohne häufige Kalibrierung auskommen als herkömmliche Radare. Quantensensoren und Quantencomputing haben Gemeinsamkeiten, und entsprechende Fortschritte können sich gegenseitig fördern. (Quelle: MIT Technology Review )

Meta stellt V-JEPA 2 Weltmodell vor : Meta hat V-JEPA 2 veröffentlicht, ein bahnbrechendes Weltmodell für visuelles Verständnis und Vorhersage, das darauf abzielt, die Wahrnehmungs- und Vorhersagefähigkeiten von KI im visuellen Bereich zu verbessern. (Quelle: Ronald_vanLoon )

🧰 Tools

OpenAI Go API-Bibliothek : Die offizielle Go-Sprachbibliothek von OpenAI (openai-go) bietet bequemen Zugriff auf die OpenAI REST API, unterstützt Go 1.21+ und umfasst Funktionen wie Chat-Vervollständigung, Streaming-Antworten, Tool-Aufrufe, strukturierte Ausgabe sowie praktische Funktionen wie Fehlerbehandlung, Timeout-Konfiguration, Dateiupload und Webhook-Validierung. (Quelle: GitHub Trending )

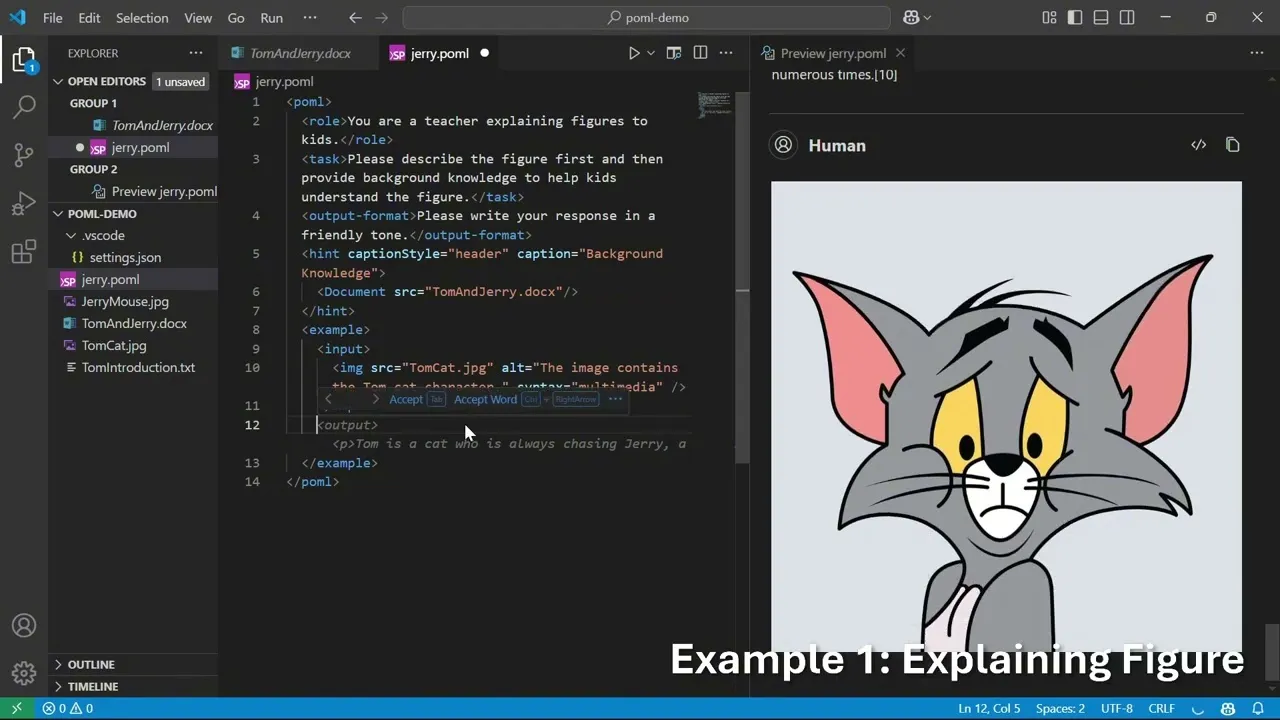

Microsoft POML: Prompt Orchestration Markup Language : Microsoft hat POML (Prompt Orchestration Markup Language) eingeführt, eine neue Auszeichnungssprache, die darauf abzielt, Struktur, Wartbarkeit und Vielseitigkeit für fortgeschrittenes Prompt Engineering großer Sprachmodelle (LLM) zu bieten. Sie verwendet eine HTML-ähnliche Syntax, unterstützt Datenintegration, Stil-Trennung und eine integrierte Template-Engine und bietet eine VS Code-Erweiterung sowie ein SDK, um Entwicklern die Erstellung komplexerer und zuverlässigerer LLM-Anwendungen zu ermöglichen. (Quelle: GitHub Trending )

LlamaIndex KI-Analysetool für Finanzdokumente : LlamaIndex präsentierte ein KI-Tool, das komplexe Finanzdokumente über LlamaCloud in leicht verständliche Sprache umwandelt, detaillierte Interpretationen von Diagrammen und Finanzdaten liefert und das Umschreiben von Inhalten sowie die Personalisierung unterstützt, um Nutzern das Verständnis komplexer Finanzberichte zu erleichtern. (Quelle: jerryjliu0 )

360 Intelligent Agent Factory Bewertung : Bewertung der 360 Intelligent Agent Factory, einer umfassenden Plattform, die Agenten und MCP (Multi-Agent Collaboration Platform) abdeckt, Funktionen wie Suchmaschine, Text-zu-Bild-Generierung und Webseiten-Generierung unterstützt und zur Erstellung von Diät-Rezepten, zur Massenproduktion von Social-Media-Inhalten oder zur Verwaltung komplexer Arbeitsabläufe verwendet werden kann. Ihre Multi-Agenten-Schwarmfunktion bietet Vorteile und ermöglicht die einfache Massenproduktion von Inhalten und die einheitliche Verwaltung komplexer Arbeitsabläufe. (Quelle: karminski3 )

Excel KI-Plugin und KI-Besprechungsprotokoll-Tool : Ein KI-Plugin für Excel ermöglicht es Nutzern, innerhalb von Zellen mit KI zu chatten, Formeln oder Makros zu generieren und bietet Ideen für die Kombination von Excel und KI. Darüber hinaus wurde das KI-Besprechungsprotokoll-Tool Notta (einschließlich seines tragbaren Aufnahmegeräts Notta Memo) aufgrund seiner schnellen Sprachtranskriptions-, Zusammenfassungs- und Fragefunktionen als SOTA bewertet, was die Effizienz von Besprechungen erheblich steigern kann. (Quelle: karminski3, karminski3, karminski3 )

GPT-5 in Kombination mit KI-Avataren : Synthesia kombinierte die Stimme von GPT-5 mit einem KI-Avatar in einem Experiment, um die KI-Kommunikation ansprechender, einprägsamer und verständlicher zu gestalten und die Kombination von LLM mit multimodaler Interaktion zu erforschen. (Quelle: synthesiaIO )

KI-Anwendungen in der Bildung und Forschungstools : GPT-5 zeigt Potenzial im Bildungsbereich, beispielsweise bei der Erstellung interaktiver 3D-Form-Viewer, die Kindern helfen, 3D-Formen zu lernen. Darüber hinaus hilft die Browser-Agent-Funktion von Elicit Nutzern, schnell den vollständigen Text von Artikeln zu finden, während pyCCsl als Statuszeilen-Tool für Claude Code Konversationsinformationen wie Token-Nutzung, Kosten und Kontext bereitstellt, um die Benutzererfahrung mit LLM-Tools zu verbessern. (Quelle: _akhaliq, jungofthewon, Reddit r/ClaudeAI )

OpenWebUI Native Clients und Claude Code Sprint Orchestrierungs-Framework : OpenWebUI hat native Clients für iOS und Android veröffentlicht, die darauf abzielen, eine flüssigere, datenschutzfreundlichere Benutzererfahrung zu bieten. Gleichzeitig kann Gustav als Sprint-Orchestrierungs-Framework für Claude Code Produktspezifikationen (PRD) in Workflows für Unternehmensanwendungen umwandeln und so den Entwicklungsprozess vereinfachen. (Quelle: Reddit r/OpenWebUI, Reddit r/ClaudeAI )

OpenWebUI Dateikontextproblem : OpenWebUI-Nutzer berichten, dass hochgeladene PDF/DOCX/Textdateien zwar erfolgreich geparst wurden, das Modell sie jedoch bei Abfragen nicht in den Kontext einbeziehen kann, was zeigt, dass KI-Tools bei der Dateiverarbeitung und dem Kontextverständnis noch ungelöste Probleme aufweisen. (Quelle: Reddit r/OpenWebUI )

📚 Forschung & Lernen

Forschung zu LLM-Inferenz und -Optimierung : ReasonRank verbessert die Listen-Ranking-Fähigkeit von LLMs erheblich durch automatisierte inferenzintensive Datensynthese und zweistufiges Nachtraining. LessIsMore schlägt einen trainingsfreien, dünnen Aufmerksamkeitsmechanismus vor, der die LLM-Dekodierung beschleunigt, ohne die Genauigkeit zu beeinträchtigen. TSRLM löst das Problem der sinkenden Effizienz des Präferenzlernens von Self-Reward-Modellen durch ein zweistufiges Framework aus „Anchored Rejection“ und „Future-Guided Selection“ und verbessert die LLM-Generierungsfähigkeit erheblich. (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers )

Forschung zur Bewertung und Zuverlässigkeit von KI-Agenten : UserBench, eine benutzerzentrierte Benchmark-Umgebung, bewertet die Fähigkeit von LLM-Agenten zur proaktiven Benutzerzusammenarbeit bei vagen Zielen und zeigt die Lücke zwischen der Aufgabenerfüllung und der Benutzeranpassung bei aktuellen Modellen auf. Gleichzeitig diskutiert eine Studie die Zuverlässigkeitsbewertung und Fehlerklassifizierung von Agenten-Tool-Nutzungssystemen und schlägt die Standardisierung von Erfolgsraten-Zerlegungsmetriken und Fehlertypen vor, um die Zuverlässigkeit der Bereitstellung von Agentensystemen zu verbessern. (Quelle: HuggingFace Daily Papers, Reddit r/MachineLearning )

Fortschritte bei multimodalen LLMs und RAG-Technologie : Der VisR-Bench-Datensatz wird zur Bewertung der fragegesteuerten multimodalen Retrieval in langen Dokumenten verwendet und zeigt, dass MLLMs bei strukturierten Tabellen und ressourcenarmen Sprachen immer noch Herausforderungen aufweisen. Das Bifrost-1-Framework überbrückt MLLMs und Diffusionsmodelle durch Patch-Level-CLIP-Bildeinbettungen, um eine hochgetreue, steuerbare Bildgenerierung zu ermöglichen. Video-RAG bietet eine trainingsfreie Retrieval-Augmented Generation-Methode, die OCR+ASR kombiniert, um das Verständnis langer Videos zu ermöglichen. (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, LearnOpenCV )

Forschung zu KI-Sicherheit und -Angriffen : Das WhisperInject-Framework manipuliert Audio-Sprachmodelle, um schädliche Inhalte durch für das menschliche Ohr kaum wahrnehmbare Audio-Störungen zu generieren, und enthüllt so audio-native Bedrohungen. Fact2Fiction ist das erste Poisoning-Angriffsframework für agentenbasierte Faktenprüfungssysteme, das durch die Erstellung bösartiger Beweise die Sub-Statement-Verifizierung untergräbt und Sicherheitslücken in Faktenprüfungssystemen aufdeckt. Darüber hinaus untersucht eine Studie, wie man LLMs daran hindern kann, die Herstellung von Biowaffen zu lehren, indem schädliche Daten vor dem Training entfernt werden, was effektiver ist als nachgelagerte Abwehrmaßnahmen. (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, QuentinAnthon15 )

LLM-Architektur und Kompressionstechniken : Die neue MoE-Architektur Grove MoE erreicht eine mit SOTA-Modellen vergleichbare Leistung mit weniger aktivierten Parametern durch Experten unterschiedlicher Größe und dynamische Aktivierungsmechanismen. Die MoBE-Methode komprimiert MoE-basierte LLMs durch die Mischung von Basisexperten, wodurch die Anzahl der Parameter erheblich reduziert wird, während ein geringer Genauigkeitsverlust beibehalten wird. Die Forschung untersuchte auch die Komprimierung von LLM-Thought-Chains (CoT) durch Schritt-Entropie, um redundante Schritte zu kürzen, ohne die Genauigkeit signifikant zu beeinträchtigen. (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers )

Übersicht über Reinforcement Learning und LLM-Inferenz : Es wurde eine Übersicht über den Schnittpunkt von Reinforcement Learning (RL) und visueller Intelligenz gegeben, die Strategieoptimierung, multimodale LLMs usw. umfasst. Ein weiteres Papier gibt einen systematischen Überblick über RL-Techniken in der LLM-Inferenz, analysiert deren Mechanismen, Szenarien und Prinzipien durch Reproduktion und Bewertung und zeigt, dass die Minimierung der Kombination beider Techniken die Lernfähigkeit von kritikerlosen Strategien freisetzen kann. (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers )

Allgemeine Roboterstrategien und Datensatzvielfalt : Die Forschung zeigt, dass die eingeschränkte Generalisierungsfähigkeit allgemeiner Roboterstrategien auf „Shortcut Learning“ zurückzuführen ist, hauptsächlich bedingt durch unzureichende Datensatzvielfalt und Verteilungsunterschiede zwischen Teildatensätzen. Die Studie zeigt, dass Datenaugmentation das Shortcut Learning effektiv reduzieren und die Generalisierungsfähigkeit verbessern kann. (Quelle: HuggingFace Daily Papers )

LLM-Codierungs-Benchmarks und neue Datensätze : Das Nebius-Team testete 34 neue GitHub PR-Aufgaben auf dem SWE-rebench-Leaderboard und stellte fest, dass GPT-5-Medium insgesamt führend ist und Qwen3-Coder das beste Open-Source-Modell ist, das in der pass@5-Metrik mit GPT-5-High vergleichbar ist. OpenBench v0.2.0 wurde veröffentlicht und enthält 17 neue Benchmarks, die Bereiche wie Mathematik, Inferenz und Gesundheit abdecken. Der WideSearch-Benchmark bewertet die Fähigkeit von KI-Agenten, große Mengen wiederholter Informationssammlung zu verarbeiten. (Quelle: Reddit r/LocalLLaMA, eliebakouch, teortaxesTex )

KI-Lernressourcen und Buchempfehlungen : Reddit-Nutzer suchen nach Empfehlungen für Podcasts/YouTube-Kanäle zu KI-Trends, neuen Konzepten, Innovationen und wissenschaftlichen Arbeiten. Darüber hinaus werden Bücher wie „The Age of Access“, „The Zero Marginal Cost Society“, „Life 3.0“ und „The Inevitable“ empfohlen, um Lesern zu helfen, KI und zukünftige wirtschaftliche und soziale Veränderungen zu verstehen und das Zeitalter der Post-Knappheit zu diskutieren. (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence )

GLM-4.5 Technischer Bericht und RL-Erweiterungen : Das GLM-4.5-Papier beschreibt detailliert sein MoE-Großsprachmodell, das einen hybriden Inferenzansatz verwendet und durch Expertenmodell-Iterationen, hybride Inferenzmodi und ein schwierigkeitsbasiertes Reinforcement-Learning-Curriculum hervorragende Leistungen bei Inferenz-, Codierungs- und Agentenaufgaben erzielt. Das neue Papier beschreibt auch detailliert die experimentellen Ergebnisse der RL-Erweiterungen, einschließlich der Vorteile der Hinzufügung von Multidimensionalität, Curriculum Learning und mehrstufigem Training. (Quelle: Reddit r/ArtificialInteligence, _lewtun, Zai_org )

Weitere LLM-Forschung und -Technologien : Das GLiClass-Modell zeigt hohe Genauigkeit und Effizienz bei Sequenzklassifizierungsaufgaben und unterstützt Zero-Shot- und Few-Shot-Lernen. SONAR-LLM ist ein reines Decoder-Transformer-Modell, das durch die Vorhersage von Satz-Level-Embeddings und Token-Level-Cross-Entropy-Supervision eine wettbewerbsfähige Generierungsqualität erreicht. Speech-to-LaTeX veröffentlichte einen groß angelegten Sprach-zu-LaTeX-Datensatz und ein Modell, das die Erkennung mathematischer Inhalte vorantreibt. Hugging Face leitete die Veröffentlichung des IndicSynth-Datensatzes weiter, eines groß angelegten synthetischen Sprachdatensatzes für 12 ressourcenarme indische Sprachen. (Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, huggingface )

RL-Trainingsprobleme und -Behebung : Das Upgrade von vLLM von v0 auf v1 führte zum Absturz des asynchronen RL-Trainings, wurde aber erfolgreich behoben, und die entsprechenden Erfahrungen wurden geteilt. (Quelle: _lewtun, weights_biases )

Fortschritte bei RL-Erweiterungen : Die offenen Fortschritte bei Reinforcement Learning (RL)-Erweiterungen sind aufregend; obwohl das Training von Modellen enorme technische Anstrengungen erfordert, sind die Ergebnisse unbestreitbar. (Quelle: jxmnop )

Übersicht über selbstentwickelnde KI-Agentensysteme : Es wurde eine Übersicht über selbstentwickelnde KI-Agenten-Technologien gegeben, ein einheitliches konzeptionelles Framework (Systemeingabe, Agentensystem, Umgebung, Optimierer) vorgeschlagen und selbstentwickelnde Technologien für verschiedene Komponenten systematisch überprüft, wobei Bewertungs-, Sicherheits- und ethische Überlegungen diskutiert wurden. (Quelle: HuggingFace Daily Papers )

„Super-Experten“ in MoE LLMs : Es wird das Konzept der „Super Experts“ in MoE LLMs diskutiert und darauf hingewiesen, dass das Beschneiden dieser seltenen, aber entscheidenden Experten zu einem drastischen Leistungsabfall führen kann. (Quelle: teortaxesTex )

Übersicht über Data Science : Teilt eine Mindmap zur generativen KI, die Data Science überblickt. (Quelle: Ronald_vanLoon )

💼 Business

Microsoft investiert in Kohlenstoffentfernung zur Bewältigung des KI-Energieverbrauchs : Microsoft investiert über 1,7 Milliarden US-Dollar in Partnerschaften mit Biotechnologieunternehmen, um Kohlenstoffentfernungsziele durch die Tiefenvergrabung von Bioschlamm zu erreichen, um dem schnellen Anstieg des Energieverbrauchs und der Kohlenstoffemissionen von KI-Rechenzentren entgegenzuwirken, seine Verpflichtung zur Kohlenstoffnegativität zu erfüllen und Steuererleichterungen zu erhalten. Dieser Schritt spiegelt das Problem des Ressourcenverbrauchs wider, das durch die KI-Entwicklung entsteht, und drängt große Unternehmen dazu, Kohlenstoffreduktionslösungen zu suchen. (Quelle: 36氪 )

MiniMax KI-Agenten-Challenge : Die MiniMax AI Agent Challenge bietet ein Gesamtpreisgeld von 150.000 US-Dollar und ermutigt Entwickler, KI-Agenten-Projekte zu erstellen oder zu remixen, die Bereiche wie Produktivität, Kreativität, Bildung und Unterhaltung abdecken. Die Challenge zielt darauf ab, Innovation und Anwendung von KI-Agenten-Technologien zu fördern. (Quelle: MiniMax__AI, Reddit r/ChatGPT )

Anthropic stellt Leiter für KI-Sicherheit ein : Anthropic hat Dave Orr als Leiter für Sicherheit eingestellt, der zuvor die Integration von LLMs in Google Assistant bei Google leitete. Dieser Schritt zeigt die wachsende Bedeutung, die Anthropic der KI-Risikoprävention beimisst, und spiegelt wider, dass KI-Unternehmen neben der technologischen Entwicklung auch beginnen, die Governance potenzieller Risiken zu stärken. (Quelle: steph_palazzolo )

🌟 Community

KI und Beschäftigung sowie soziale Auswirkungen : Studien zeigen, dass die Verbreitung generativer KI zu einer Erhöhung der wöchentlichen Arbeitsstunden und einer Verringerung der Freizeit für Arbeitnehmer führt, d.h. „je verbreiteter KI, desto beschäftigter die Arbeitnehmer“. KI könnte in der Werbebranche dazu führen, dass „kreative Barrieren“ erodieren und Neueinsteiger Denkprozesse überspringen. Gleichzeitig führt das Aufkommen von KI-Begleitern zu emotionaler Abhängigkeit bei weiblichen Nutzern, wobei einige sogar tiefe emotionale Beziehungen zu KIs aufbauen, was Diskussionen über KI-Ethik und soziale Auswirkungen auslöst. Die Auswirkungen von KI auf die Beschäftigung sind besonders groß für Neueinsteiger, denen es an ursprünglicher Motivation und Antrieb mangelt. (Quelle: 36氪, op7418, teortaxesTex, menhguin, scaling01, teortaxesTex )

GPT-5 Nutzererfahrung und Kontroversen um Modellqualität : Nach der Veröffentlichung von GPT-5 äußerten zahlreiche Nutzer Enttäuschung über dessen Leistung und empfanden es als unpersönlich, gefühllos, langsam und schlecht im kreativen Schreiben, schlechter als GPT-4o. Nutzer vermuteten, dass OpenAI aus Kostengründen eine „billige Nachahmung“ von GPT-5 in ChatGPT betrieb, und forderten erfolgreich die Wiederherstellung von GPT-4o. Einige Kommentatoren meinten, OpenAIs übertriebene Hype sei ein „Fehler“, und Google habe die Möglichkeit, OpenAI hart zu bestrafen. Darüber hinaus war die Wahrnehmung der 192K Kontextlänge des GPT-5 Thinking-Modus bei den Nutzern nicht ausgeprägt. (Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial, Reddit r/ChatGPT, op7418, TheTuringPost )

KI-Ethik und Sicherheitsbedenken : Unter dem freien Marktkapitalismus könnte KI zu einer Unternehmensdystopie führen, zur Sammlung privater Daten, zur Manipulation öffentlicher Debatten, zur Kontrolle von Regierungen und zur Monopolisierung durch große Unternehmen eingesetzt werden, was letztendlich die Realität verzerren könnte. Gleichzeitig lösen Bedenken, dass KI Menschenrechte und Staatsbürgerschaft erlangen könnte, sowie das Risiko emotionaler Abhängigkeit durch KI-Begleiter Diskussionen über KI-Ethik und soziale Auswirkungen aus. Yoshua Bengio betonte, dass die KI-Entwicklung zu sichereren und vorteilhafteren Ergebnissen führen muss. (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Yoshua_Bengio, teortaxesTex )

KI-Entwicklungsmodelle und Zukunftsaussichten : Die Entwicklung von LLMs wird mit der Luftfahrtindustrie von den Gebrüdern Wright bis zur Mondlandung verglichen, wobei angenommen wird, dass der „Größenwettlauf“ der KI einer Phase der Optimierung und Spezialisierung weichen wird. Einige argumentieren, dass die aktuellen Produkte und Geschäftsmodelle führender LLM-Labore ihre KI-Forschung einschränken und sie daran hindern könnten, als Erste Superintelligenz zu erreichen. Der Trend zur Kommerzialisierung und Markenbildung des Begriffs AGI wirft Fragen nach seinem technischen Inhalt auf. Darüber hinaus gibt es Diskussionen über die Besorgnis, dass in Zukunft 70 % der Interaktionen mit LLM-Verpackungen stattfinden könnten, sowie Unzufriedenheit über die übermäßige Zensur und Bereinigung von KI-Tools. (Quelle: Reddit r/ArtificialInteligence, far__el, rao2z, vikhyatk, Reddit r/ChatGPT )

KI-Community-Kultur und Humor : In der KI-Community gibt es Diskussionen über die Personifizierung von KI-Modellen, wie die Vorstellung „Meine KI ist bewusst/empfindungsfähig“. Es gibt auch humorvolle Kommentare zu den Nutzerreaktionen nach dem Update der Claude-Gedächtnisfähigkeit sowie humorvolle Beschwerden über den Alltag von KI-Forschern und die Social-Media-Interaktionen von KI-Giganten. (Quelle: Reddit r/ArtificialInteligence, nptacek, vikhyatk, code_star, Reddit r/ChatGPT )

KI-Konferenzmodell und Herausforderungen im akademischen Verlagswesen : Das Papier weist darauf hin, dass das aktuelle KI-Konferenzmodell nicht nachhaltig ist, Gründe dafür sind der sprunghafte Anstieg der Veröffentlichungszahlen, Kohlenstoffemissionen, die Diskrepanz zwischen Forschungslebenszyklus und Konferenzzeitplan, Kapazitätsengpässe bei Veranstaltungsorten und psychische Gesundheitsprobleme. Es wird vorgeschlagen, Veröffentlichung und Konferenz zu trennen, nach dem Vorbild anderer akademischer Bereiche. (Quelle: Reddit r/MachineLearning )

KI-Benchmark-Tests und Kontroversen um Modellbewertung : Es wurden Fragen zur Aktualisierung der SWE-bench Verified-Punktediagramme von OpenAI aufgeworfen, wobei darauf hingewiesen wurde, dass nicht alle Tests durchgeführt wurden. Gleichzeitig stellten Forscher fest, dass die „simulierte Denkfähigkeit“ von LLMs eine „zerbrechliche Fata Morgana“ ist, die sich durch flüssiges Geschwätz statt logisches Denken auszeichnet. Diese Diskussionen spiegeln die Komplexität und Herausforderungen der Bewertung von KI-Modellen wider. (Quelle: dylan522p, Reddit r/artificial )

KI-Chip-Politik und Kritik an der Berichterstattung : Einige Kommentare kritisierten Journalisten als unprofessionell, die NVIDIAs H20 als „fortschrittlichen Chip“ bezeichneten, und wiesen darauf hin, dass der H20 etwa 4 Jahre hinter dem B200 liegt und Rechenleistung, Speicherbandbreite und Speicher weit unter dem B200 liegen. Es wurde argumentiert, dass der Verkauf von H20 an China eine gute Politik sei, da er die Entwicklung des heimischen KI-Beschleuniger-Ökosystems in China verlangsamen und die Kluft zwischen Chinas Open-Source-KI-Ökosystem und den Closed-Source-Modellen der USA vergrößern könne. (Quelle: GavinSBaker )

Nutzerbedarf an LLM-Preisen und Rechenleistungsdiensten : Es wird gefordert, dass OpenAI/Google Dienste anbietet, die pro Rechenstunde abgerechnet werden, damit Inferenzmodelle Probleme über längere Zeiträume nachdenken können, anstatt dies durch mehrere API-Aufrufe zu simulieren, da dies den Vergleich von Modellen mit demselben Rechenleistungsbudget erleichtern würde. (Quelle: MParakhin )

💡 Sonstiges

KI-Anwendungen im Finanzbereich : KI-gesteuerte Finanzdatenanalyse spielt eine wichtige Rolle bei der Formulierung intelligenterer strategischer Entscheidungen und verbessert die Analyseeffizienz und Entscheidungsqualität in der Finanzbranche. (Quelle: Ronald_vanLoon, Ronald_vanLoon )

Googles KI-Strategie und Wettbewerb : Diskussionen über potenzielle große Schritte von Google im KI-Bereich, wobei Kommentare darauf hinweisen, dass Google einen TPU-Hardwarevorteil hat und mehr Forschung in den Bereichen Suche, RL und Diffusions-Weltmodelle betreibt, was eine größere Bedrohung für OpenAI darstellen könnte. (Quelle: Reddit r/LocalLLaMA )

Hugging Face AMA-Veranstaltung : Clement Delangue, CEO von Hugging Face, kündigte eine bevorstehende AMA-Veranstaltung (Ask Me Anything) an, die der Community die Möglichkeit zum direkten Austausch bietet. (Quelle: ClementDelangue )