Schlüsselwörter:Google DeepMind, Genie 3, Weltmodell, KI-Trainingsumgebung, Spieleentwicklung, verkörperte AGI, Multi-Agenten-System, Echtzeitgenerierung interaktiver 3D-Umgebungen, 720p Auflösung mit 24 Bildern pro Sekunde, Zusammenarbeit von Problemlöser- und Verifizierer-Agenten, KI-Mathematikwettbewerbslösung für IMO, Open-Source Multi-Agenten-IMO-System

🔥 Fokus

Google DeepMind veröffentlicht Weltmodell Genie 3: Google DeepMind hat Genie 3 vorgestellt, ein bahnbrechendes Weltmodell, das in der Lage ist, interaktive 3D-Umgebungen in Echtzeit basierend auf Texteingaben zu generieren, mit einer Auflösung von 720p und einer Bildrate von 24 fps. Das Modell verfügt über visuelles Gedächtnis und Aktionskontrolle über mehrere Minuten hinweg und wird als Game Engine 2.0 der Zukunft angesehen. Es wird erwartet, dass es KI-Trainingsumgebungen und Spieleentwicklung revolutioniert und einen entscheidenden fehlenden Teil für verkörperte AGI liefert.(Quelle: Google DeepMind)

Ant Group Multi-Agenten-System repliziert IMO-Goldmedaillenergebnisse und wird Open Source: Das AWorld-Projektteam der Ant Group replizierte in nur 6 Stunden die Lösungsergebnisse von DeepMind für 5 von 6 Aufgaben des IMO 2025 Mathematikwettbewerbs und hat das Multi-Agenten-IMO-System quelloffen gemacht. Das System zeigt durch die Zusammenarbeit von zwei Agenten (“Löser + Prüfer”) das Potenzial, die Intelligenzgrenze einzelner Modelle zu übertreffen, und wird zum Training von Modellen der nächsten Generation eingesetzt, was voraussichtlich die Entwicklung der Allgemeinen Künstlichen Intelligenz (AGI) vorantreiben wird.(Quelle: 量子位)

KI entdeckt neue physikalische Gesetze: Forscher der Emory University trainierten eine KI, um neue physikalische Gesetze aus experimentellen Daten von Staubplasma zu entdecken, die bisher unbekannte Kräfte offenbaren. Diese Forschung zeigt, dass KI nicht nur Ergebnisse vorhersagen oder Daten bereinigen kann, sondern auch zur Entdeckung grundlegender physikalischer Gesetze eingesetzt werden kann und korrigiert eine langjährige Annahme in der Plasmaphysik, was neue Wege für die Erforschung komplexer Mehrteilchensysteme eröffnet.(Quelle: interestingengineering)

🎯 Trends

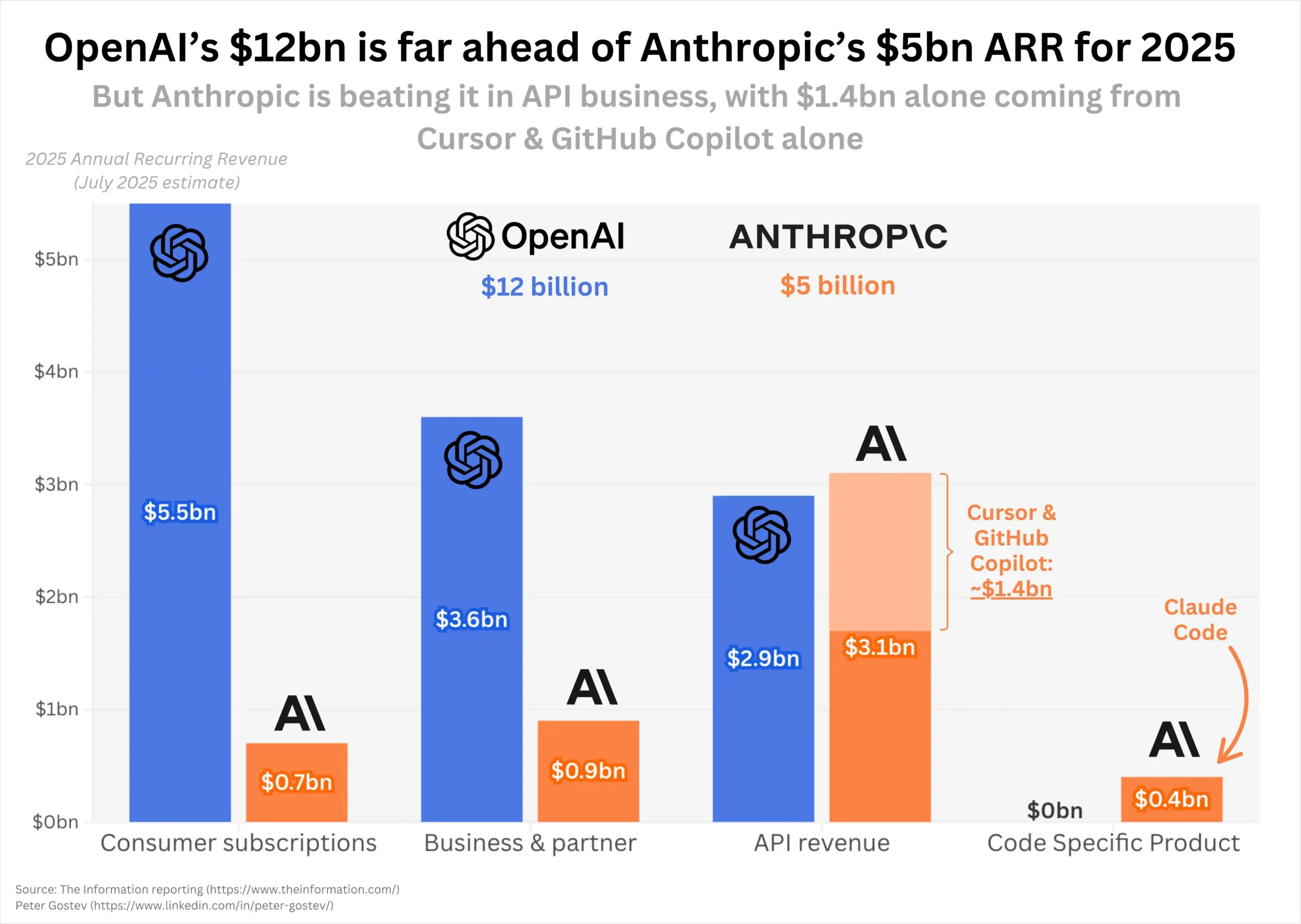

OpenAI und Anthropic verzeichnen hohes Umsatzwachstum, Marktstruktur im Fokus: Im Jahr 2025 zeigen OpenAI und Anthropic ein erstaunliches Umsatzwachstum: OpenAIs annualisierter wiederkehrender Umsatz verdoppelte sich auf 12 Milliarden US-Dollar, Anthropic wuchs um das Fünffache auf 5 Milliarden US-Dollar. Anthropic zeigt eine starke Leistung auf dem Programmier-API-Markt, während die Nutzerzahlen von ChatGPT weiterhin rasant steigen. Der Markt beobachtet, ob die Einführung von GPT-5 die aktuelle Marktstruktur verändern wird, insbesondere die dominante Position von Anthropic im Programmierbereich.(Quelle: dotey, nickaturley, xikun_zhang_)

Kaggle startet KI-Schach-Wettkampfplattform: Kaggle hat die Game Arena vorgestellt, eine Open-Source-Wettkampfplattform, die darauf abzielt, die Leistung führender KI-Modelle durch Kopf-an-Kopf-Duelle (derzeit hauptsächlich im Schach) objektiv zu bewerten. Die erste KI-Schachmeisterschaft hat bereits begonnen, und Schachgroßmeister wurden zur Kommentierung eingeladen, was das Interesse der Community an der Leistung von Modellen wie Kimi K2 geweckt hat.(Quelle: algo_diver, teortaxesTex, sirbayes, Reddit r/LocalLLaMA)

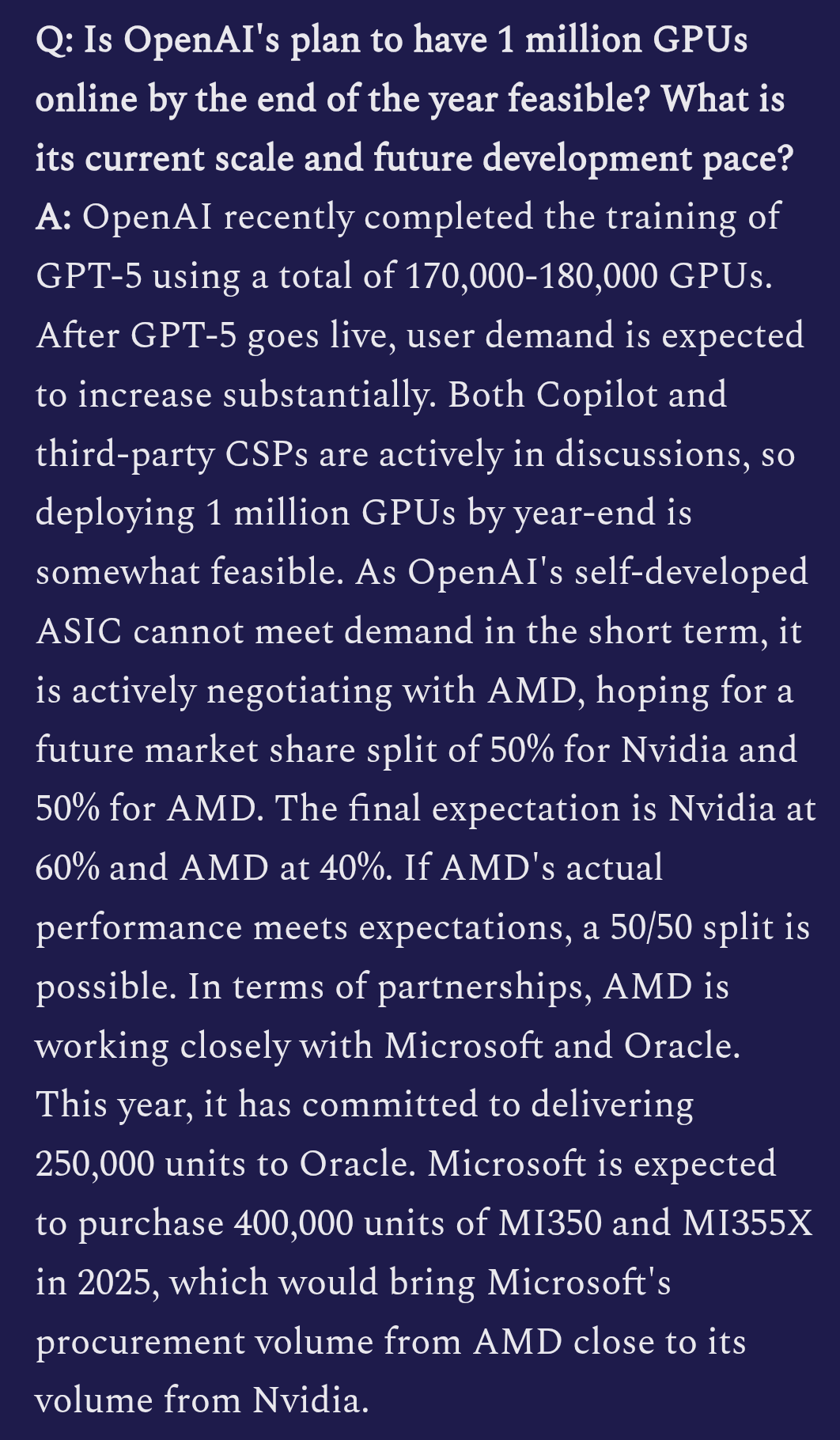

Details zum OpenAI GPT-5 Training enthüllt: Berichten zufolge trainiert OpenAI GPT-5 mit 170.000 bis 180.000 H100 GPUs. Die multimodalen Fähigkeiten des Modells wurden erheblich verbessert, und es könnte bereits Videoeingaben integriert haben. OpenAI plant, einen “Ghibli-Moment” zu schaffen, was auf seine Ambitionen im Bereich der kreativen Inhaltserstellung hindeutet.(Quelle: teortaxesTex)

GLM 4.5 erreicht Top Fünf der LM Arena: Das GLM 4.5 Modell von Zai.org hat in der LM Arena Community-Abstimmung hervorragend abgeschnitten, mit über 4000 Stimmen und erreichte erfolgreich die Top Fünf der Gesamtwertung. Es rangiert damit neben DeepSeek-R1 und Kimi K2 als Top-Open-Source-Modell, was seine Wettbewerbsfähigkeit im Bereich der großen Sprachmodelle zeigt.(Quelle: teortaxesTex, NandoDF)

Yunpeng Technology stellt neue KI+Gesundheitsprodukte vor: Yunpeng Technology hat in Zusammenarbeit mit Shuaikang und Skyworth einen intelligenten Kühlschrank mit einem großen KI-Gesundheitsmodell und ein “Digitales Zukunftsküchenlabor” vorgestellt. Das große KI-Gesundheitsmodell bietet über den “Gesundheitsassistenten Xiaoyun” personalisiertes Gesundheitsmanagement und optimiert Küchendesign und -betrieb. Dies markiert den tiefgreifenden Einsatz von KI im täglichen Gesundheitsmanagement und in der Heimtechnologie und wird voraussichtlich die Lebensqualität der Bewohner verbessern.(Quelle: 36氪)

Neues Framework für KI-Systemsicherheit veröffentlicht: MITSloan hat ein neues Framework vorgestellt, das Unternehmen beim Aufbau sichererer KI-Systeme unterstützen soll. Dieses Framework konzentriert sich auf Sicherheitspraktiken für Künstliche Intelligenz und Maschinelles Lernen und bietet wichtige Sicherheitsrichtlinien für immer komplexere KI-Anwendungen.(Quelle: Ronald_vanLoon)

Fortschritte bei der Anwendung von KI im Bereich Cybersicherheit: Das Cyber-Zero-Framework ermöglicht das Training von Cybersicherheits-LLM-Agenten ohne Laufzeitumgebung, indem es hochwertige Trajektorien aus Reverse-Engineering-CTF-Lösungsberichten generiert. Das trainierte Cyber-Zero-32B-Modell erreicht SOTA-Leistung in CTF-Benchmarks und ist kosteneffizienter als proprietäre Systeme. Gleichzeitig entwickelt Corridor Secure eine KI-native Produktsicherheitsplattform, die darauf abzielt, KI in den Bereich der Softwareentwicklungssicherheit zu integrieren.(Quelle: HuggingFace Daily Papers, saranormous)

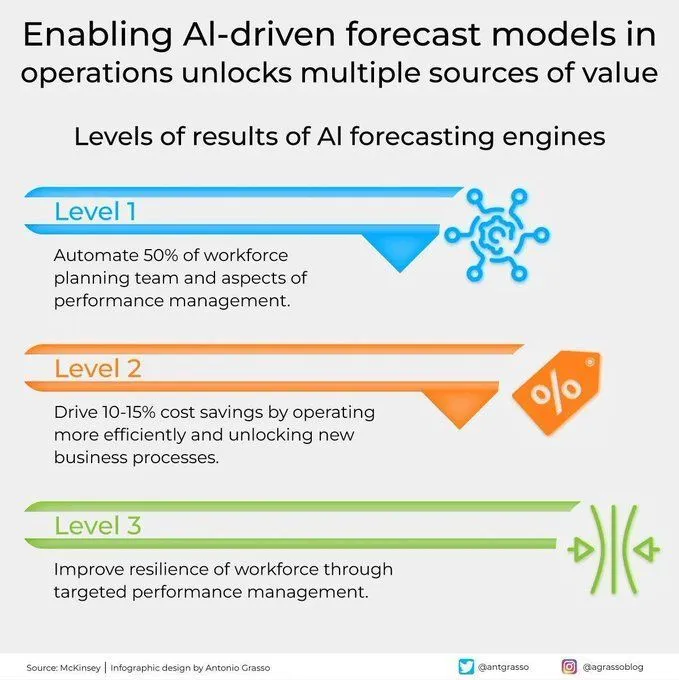

KI-gesteuerte Vorhersagemodelle entfalten Wert im Betrieb: KI-gesteuerte Vorhersagemodelle entfalten in der Betriebsführung einen enormen Wert, indem sie präzisere Vorhersagefähigkeiten bieten und mehrere Wertquellen erschließen, die digitale Transformation vorantreiben und die Rolle des Maschinellen Lernens bei Geschäftsentscheidungen stärken.(Quelle: Ronald_vanLoon)

Weltweit erster KI-gestützter Bau einer autonomen Autobahn: Das weltweit erste 158 Kilometer lange Bauprojekt für eine autonome Autobahn wurde vollständig von KI-gesteuerten Maschinen mit 5G-Netzwerkunterstützung realisiert. Dies markiert einen bedeutenden Durchbruch für Künstliche Intelligenz, RPA und neue Technologien im Bereich des Infrastrukturbaus und deutet auf eine hohe Automatisierung zukünftiger Ingenieurprojekte hin.(Quelle: Ronald_vanLoon)

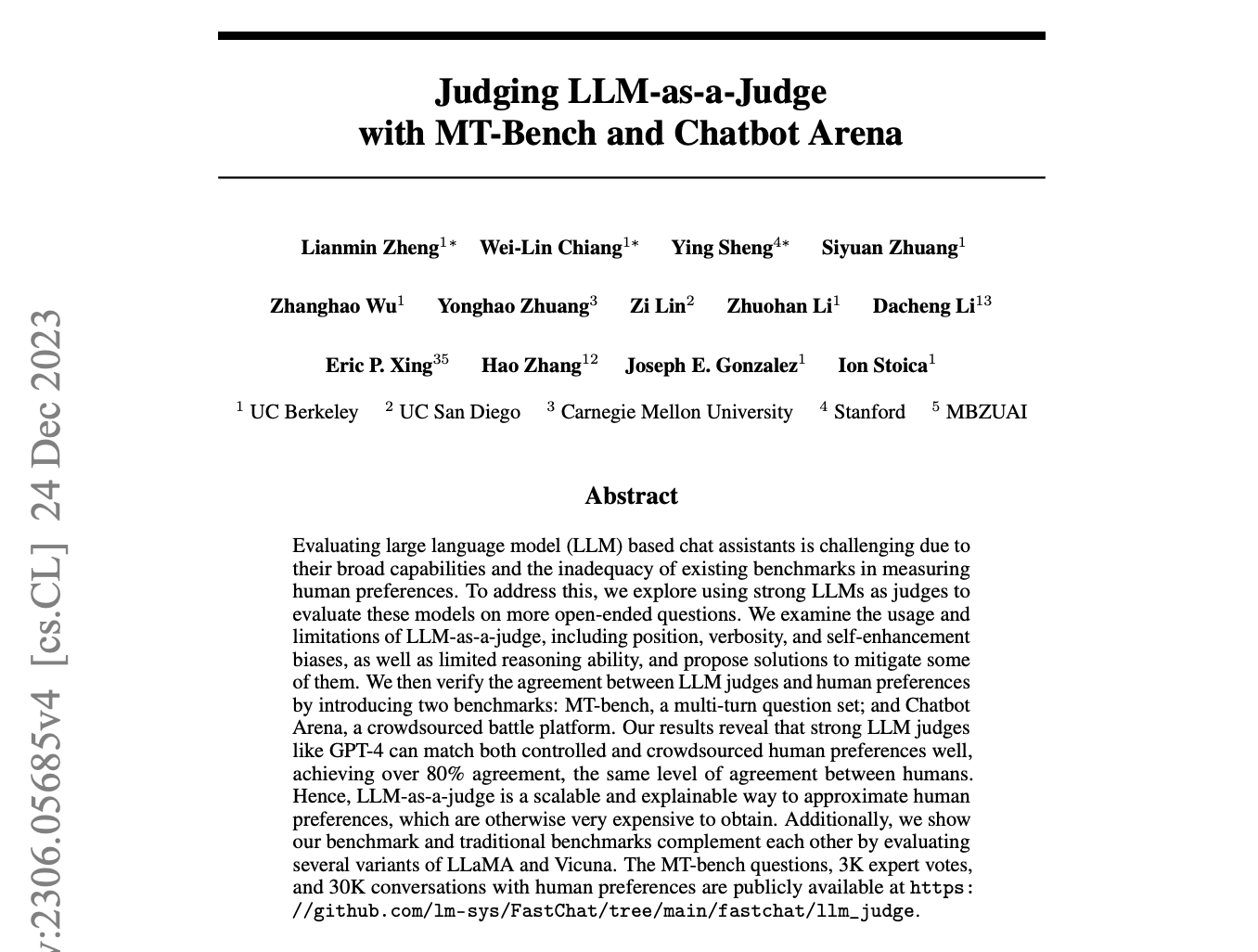

Diskussionen über LLM als Richter/Universal Validator: In den sozialen Medien wird intensiv über den möglichen “Universal Validator” von OpenAI diskutiert. Einige bezweifeln, ob es sich im Wesentlichen immer noch um das Konzept “LLM als Richter” handelt, während andere erwarten, dass GPT-5 durch diese Technologie nahezu halluzinationsfreie, präzise Ausgaben erzielen kann, was zu einer beispiellosen Genauigkeit und Zuverlässigkeit führen würde.(Quelle: Teknium1, Dorialexander, Vtrivedy10)

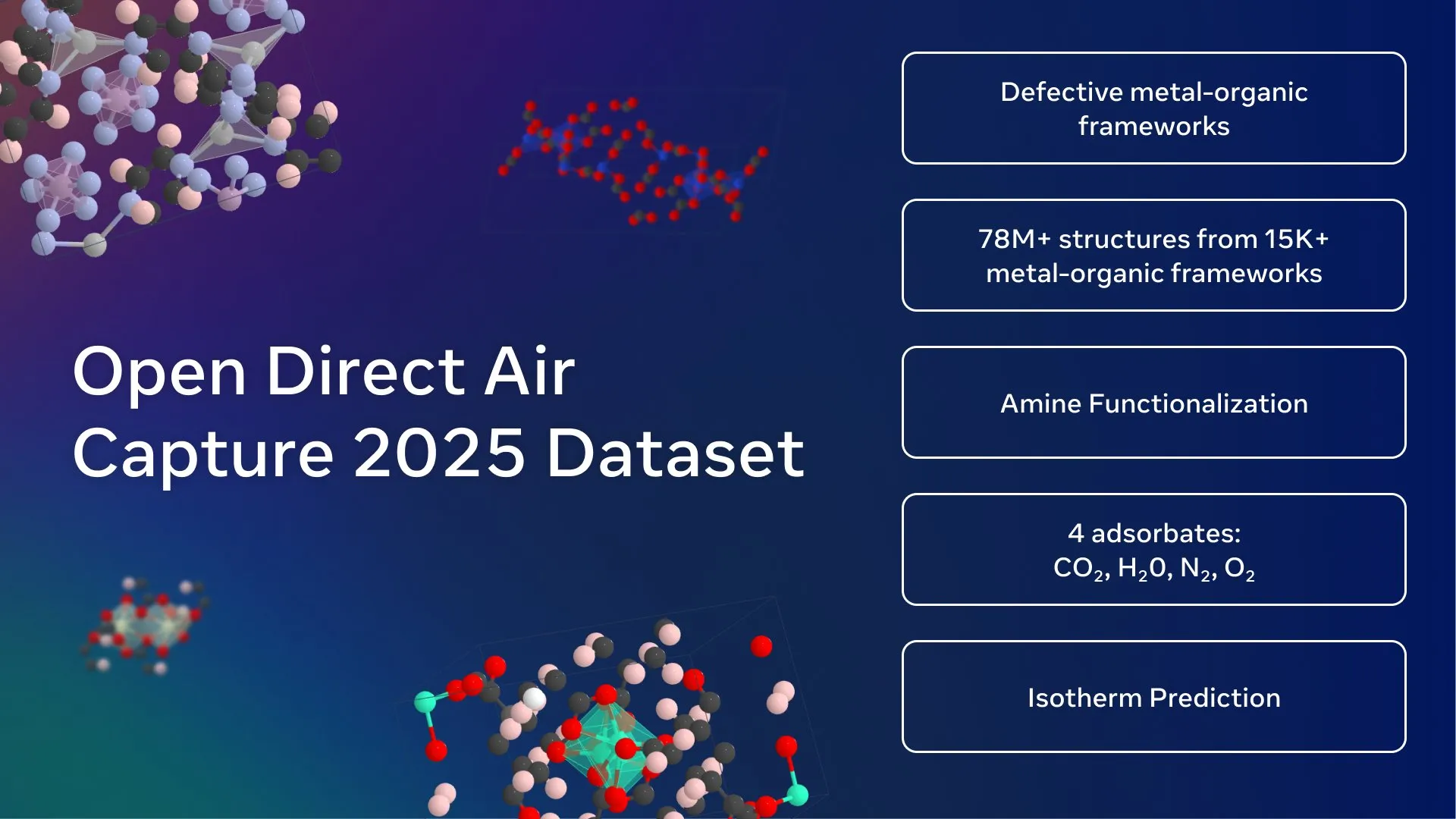

Meta AI veröffentlicht größten offenen Kohlenstoffabscheidungs-Datensatz: Meta FAIR, das Georgia Institute of Technology und cusp_ai haben gemeinsam den Open Direct Air Capture 2025 Datensatz veröffentlicht, den größten offenen Datensatz zur Entdeckung fortschrittlicher Materialien für die direkte CO2-Abscheidung. Dieser Datensatz soll KI nutzen, um Klimalösungen zu beschleunigen und die Entwicklung umweltfreundlicher Materialwissenschaft voranzutreiben.(Quelle: ylecun)

🧰 Tools

Qwen-Image Open-Source-Modell veröffentlicht: Alibaba hat Qwen-Image veröffentlicht, ein 20B MMDiT Text-zu-Bild-Generierungsmodell, das jetzt quelloffen ist (Apache 2.0 Lizenz). Das Modell zeichnet sich durch Text-Rendering aus, insbesondere bei der Erstellung grafischer Poster mit nativem Text, und unterstützt Zweisprachigkeit, verschiedene Schriftarten und komplexe Layouts. Es kann auch Bilder in verschiedenen Stilen generieren, von realistisch bis Anime, und kann durch Quantisierung lokal auf Geräten mit geringem VRAM ausgeführt werden und wurde bereits in ComfyUI integriert.(Quelle: teortaxesTex, huggingface, NandoDF, Reddit r/LocalLLaMA)

Runway Aleph Videobearbeitungsfähigkeiten verbessert: Runway Aleph, als Videobearbeitungstool, kann jetzt bestimmte Teile eines Videos präzise steuern, einschließlich der Manipulation von Umgebung, Atmosphäre und gerichteten Lichtquellen, und kann sogar die Rendering-Pipeline von Blender ersetzen. Dieser Fortschritt erhöht die Flexibilität und Effizienz der Videoproduktion erheblich und bietet Kreativen leistungsfähigere Werkzeuge.(Quelle: op7418, c_valenzuelab)

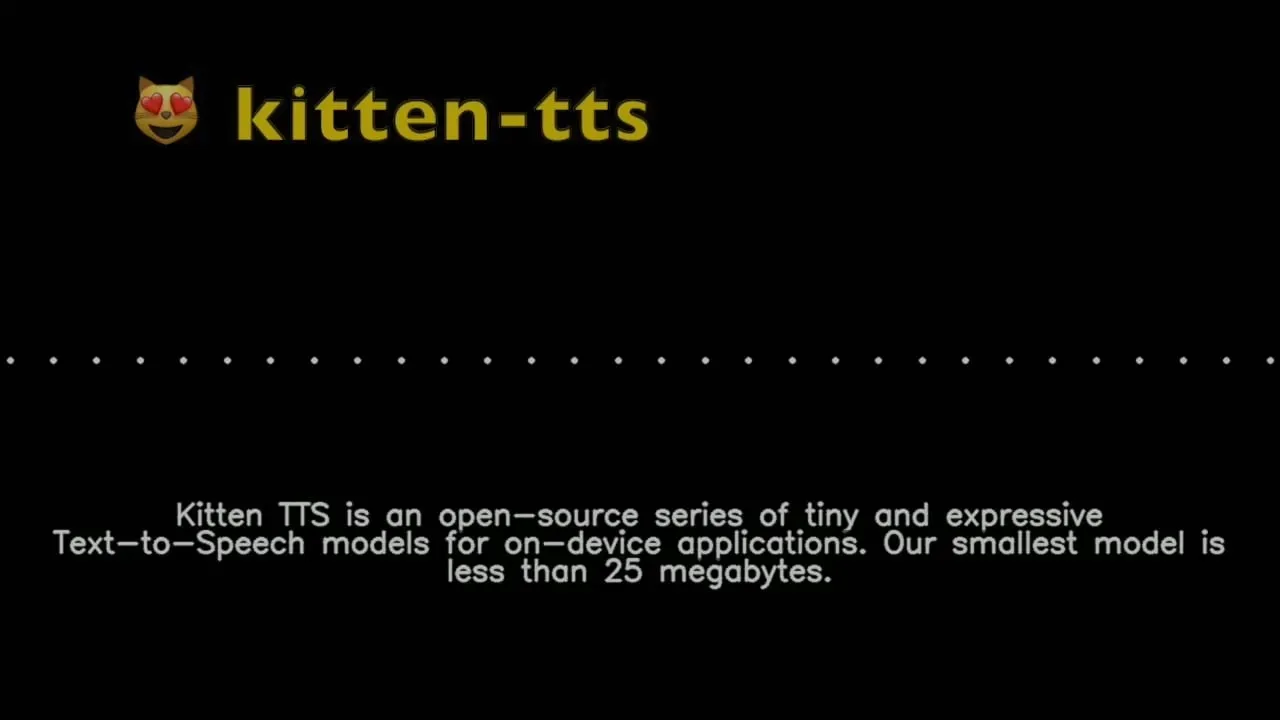

Kitten TTS: Ultrakleines Text-zu-Sprache-Modell: Kitten ML hat eine Vorschau des Kitten TTS Modells veröffentlicht, ein SOTA ultrakleines Text-zu-Sprache-Modell, weniger als 25 MB groß (ca. 15 Millionen Parameter), das acht ausdrucksstarke englische Stimmen bietet. Das Modell kann auf Geräten mit geringer Rechenleistung wie Raspberry Pi und Mobiltelefonen ausgeführt werden und plant, in Zukunft Mehrsprachigkeit und CPU-Betrieb zu unterstützen, was eine Lösung für die Sprachsynthese in ressourcenbeschränkten Umgebungen bietet.(Quelle: Reddit r/LocalLLaMA)

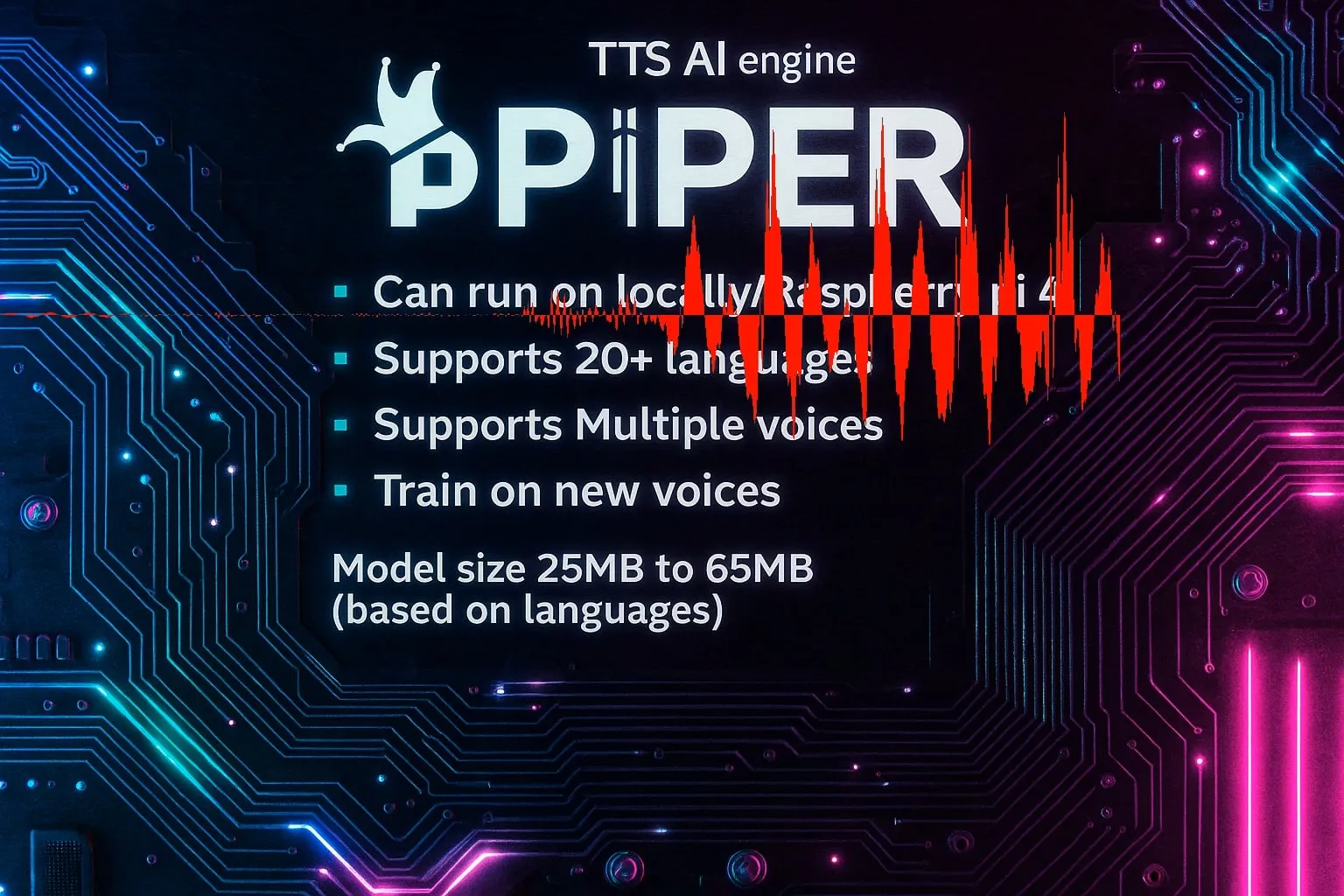

Piper TTS: Schnelle lokale Open-Source-Text-zu-Sprache-Engine: Piper ist eine schnelle, lokal laufende Open-Source-Text-zu-Sprache-Engine, die über 20 Sprachen und mehrere Stimmen unterstützt. Die Modellgröße liegt zwischen 25 MB und 65 MB, und es unterstützt das Training neuer Stimmen. Sein Hauptvorteil ist die Verwendbarkeit in C/C++-Embedded-Anwendungen, was effiziente Sprachsynthesefähigkeiten für verschiedene Plattformen bietet.(Quelle: Reddit r/LocalLLaMA)

Claude Code Sub-Agenten-Sammlung veröffentlicht: VoltAgent hat eine Sammlung von produktionsbereiten Claude Code Sub-Agenten veröffentlicht, die über 100 spezialisierte Agenten enthält und Entwicklungsaufgaben wie Frontend, Backend, DevOps, AI/ML, Code-Review und Debugging abdeckt. Diese Sub-Agenten folgen Best Practices und werden von der Open-Source-Framework-Community gepflegt, mit dem Ziel, die Effizienz und Qualität von Entwicklungsworkflows zu verbessern.(Quelle: Reddit r/ClaudeAI)

Vibe: Offline Audio/Video Transkriptionstool: Vibe ist ein quelloffenes Offline-Audio-/Video-Transkriptionstool, das die OpenAI Whisper-Technologie nutzt und Transkriptionen in nahezu allen Sprachen unterstützt. Es bietet ein benutzerfreundliches Design, Echtzeit-Vorschau, Batch-Transkription, KI-Zusammenfassungen, lokale Ollama-Analyse und unterstützt verschiedene Exportformate. Es ist zudem GPU-optimiert und gewährleistet die Privatsphäre der Nutzer.(Quelle: GitHub Trending)

DevBrand Studio: KI-gesteuertes Entwickler-Branding-Tool: DevBrand Studio ist ein KI-Tool, das Entwicklern hilft, mühelos professionelle GitHub-Profile zu erstellen. Es kann automatisch prägnante persönliche Profile generieren, private/berufliche Projekte und deren Auswirkungen hinzufügen und teilbare Links bereitstellen, was die Schmerzpunkte von Entwicklern bei der Selbstvermarktung löst, besonders nützlich für Jobsuchende und Freiberufler.(Quelle: Reddit r/MachineLearning)

LLaMA.cpp MoE Offloading Optimierung: LLaMA.cpp hat die Option --n-cpu-moe hinzugefügt, was den Schicht-Offloading-Prozess von MoE-Modellen erheblich vereinfacht. Benutzer können die Anzahl der auf der CPU laufenden MoE-Schichten einfach anpassen, um die Leistung und Speichernutzung großer Modelle auf GPU und CPU zu optimieren, besonders geeignet für Modelle wie GLM4.5-Air.(Quelle: Reddit r/LocalLLaMA)

ReaGAN: Graph-Lern-Framework kombiniert Agentenfähigkeiten und Retrieval: Retrieval-augmented Graph Agentic Network (ReaGAN) ist ein innovatives Graph-Lern-Framework, das Agentenfähigkeiten und Retrieval kombiniert. In diesem Framework sind Knoten als Agenten konzipiert, die planen, handeln und schlussfolgern können, was KI-Entwicklern neue Wege eröffnet, komplexe Agentenfunktionen mit Graph-Lernen zu verbinden.(Quelle: omarsar0)

OpenArm: Quelloffener humanoider Roboterarm: Enactic AI hat OpenArm veröffentlicht, einen quelloffenen humanoiden Roboterarm, speziell für den Einsatz von physischer KI in kontaktintensiven Umgebungen entwickelt. Das Projekt zielt darauf ab, die Entwicklung von Robotik und Künstlicher Intelligenz in realen Interaktionen voranzutreiben und bietet Forschern und Entwicklern eine flexible Hardwareplattform.(Quelle: Ronald_vanLoon)

Kling ELEMENTS: Hollywood-Niveau KI-Videogenerierung: Klings ELEMENTS-Technologie widmet sich der Generierung von KI-Videos mit Hollywood-ähnlichem Realismus, gekennzeichnet durch makellose Gesichter, dynamische Kleidung und fehlerfreie Darstellung. Sein Werk “Loading” hat bereits 197 Millionen globale Aufrufe und vier wichtige Branchenpreise erhalten, was das enorme Potenzial von KI im Bereich der Videocontent-Erstellung demonstriert.(Quelle: Kling_ai, Kling_ai)

Hugging Face Text Embeddings Inference (TEI) v1.8.0 veröffentlicht: Hugging Face hat die Version 1.8.0 von Text Embeddings Inference (TEI) veröffentlicht, die mehrere neue Funktionen und Verbesserungen mit sich bringt, einschließlich der Unterstützung für die neuesten Modelle. Dieses Update zielt darauf ab, die Effizienz und Leistung der Texteinbettungs-Inferenz zu verbessern und Entwicklern leistungsfähigere Werkzeuge zur Verfügung zu stellen.(Quelle: narsilou)

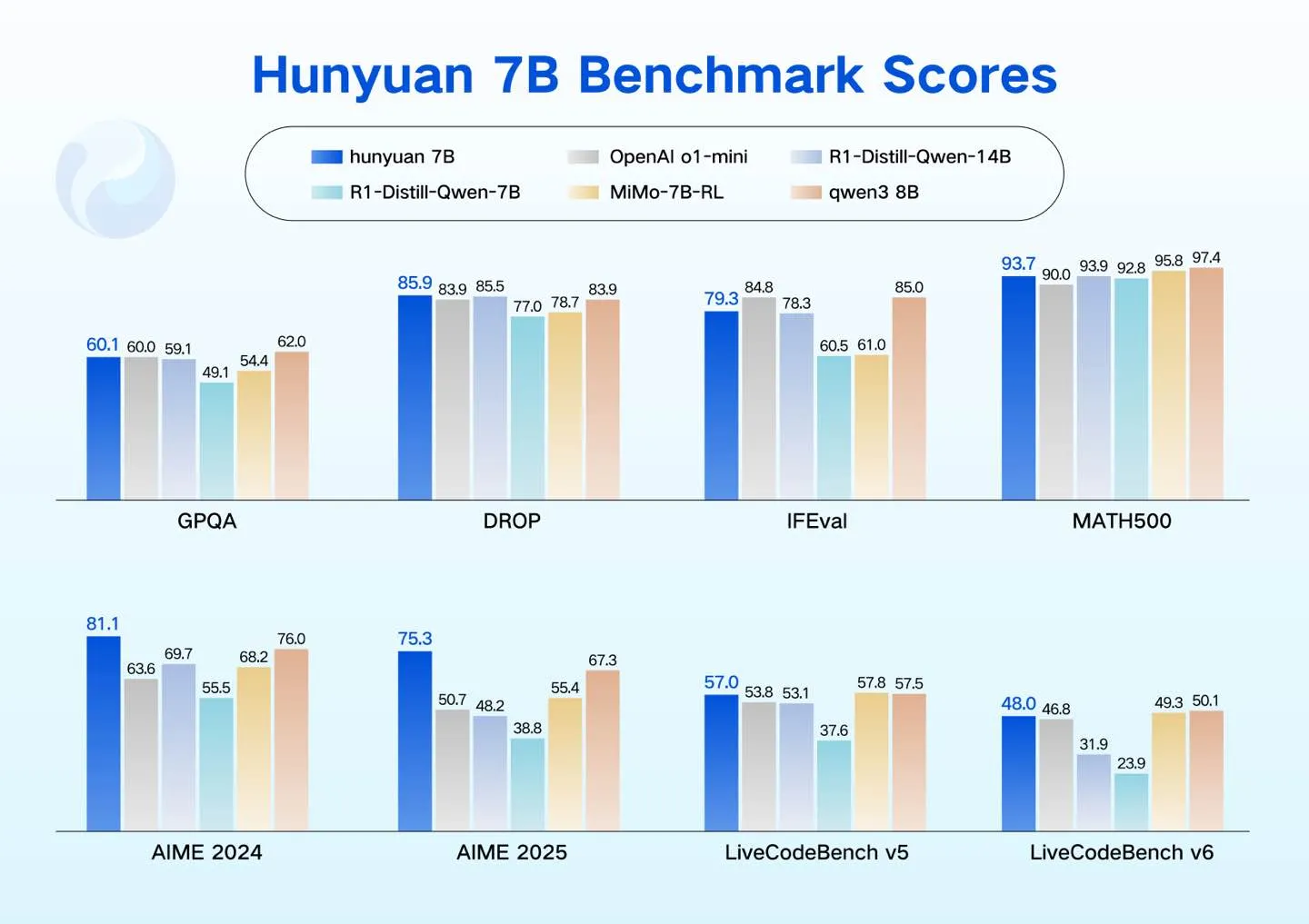

Tencent Hunyuan veröffentlicht kompakte LLM-Modelle: Tencent Hunyuan hat vier kompakte LLM-Modelle (0.5B, 1.8B, 4B, 7B) veröffentlicht, die für Szenarien mit geringem Stromverbrauch entwickelt wurden, wie Consumer-GPUs, Smart Cars, Smart Home Devices, Mobiltelefone und PCs. Diese Modelle unterstützen kostengünstiges Fine-Tuning und erweitern das Open-Source-LLM-Ökosystem von Hunyuan.(Quelle: awnihannun)

KI-Videogenerierungstool Topviewofficial: Topviewofficial hat ein KI-Videogenerierungstool vorgestellt, das angeblich in wenigen Minuten virale Videos erstellen kann. Das Tool zielt darauf ab, den Content-Erstellungsprozess zu vereinfachen und ermöglicht es Benutzern, mithilfe generativer KI-Technologie schnell kreative Videos zu produzieren.(Quelle: Ronald_vanLoon)

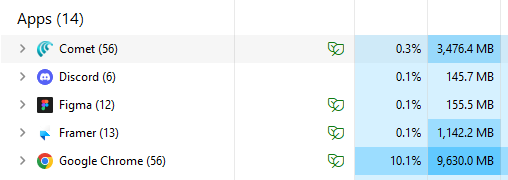

Comet AI Browser steigert Effizienz: Der Comet-Browser wird von Nutzern als Paradebeispiel für KI-Browsing gelobt. Sein Speicherverbrauch ist fast dreimal geringer als der von Chrome, und er läuft effizienter bei gleicher Anzahl von Tabs. Nutzer geben an, dass Comet ihr Standardbrowser geworden ist, weil er zeigt, wie ein KI-Browser funktionieren sollte, und betrachten ihn als IDE für Nicht-Entwickler.(Quelle: AravSrinivas)

📚 Lernen

New Turing Institute GStar Bootcamp: Das New Turing Institute hat das GStar Bootcamp ins Leben gerufen, ein 12-wöchiges globales Talentprogramm, das darauf abzielt, die Teilnehmer in den Bereichen LLM-Spitzentechnologie, Forschung und Führung zu schulen. Das Programm wurde von führenden KI-Experten konzipiert und wird von renommierten Wissenschaftlern betreut.(Quelle: YiTayML)

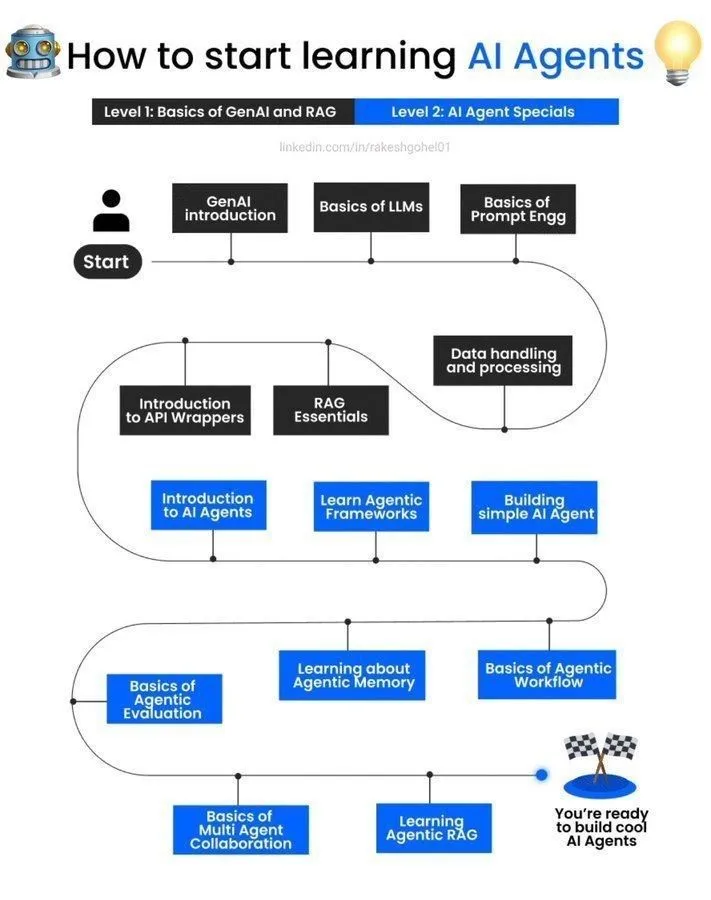

KI-Agenten Lernleitfaden: In den sozialen Medien wurde ein Leitfaden zum Einstieg in das Lernen von KI-Agenten geteilt, der Anfängern, die sich für KI-Agenten interessieren, Einstiegsressourcen und Lernpfade bietet und ihnen hilft, die Entwicklung von KI-Agenten zu verstehen und zu praktizieren.(Quelle: Ronald_vanLoon)

Empfehlungen zur Wahl des PhD-Forschungsbereichs im Maschinellen Lernen/Deep Neural Networks: Für Masterstudenten, die theoretische/grundlegende Forschung in KI-Forschungslaboren betreiben möchten, bietet die Community Empfehlungen zu PhD-Forschungsbereichen in den theoretischen Grundlagen des Maschinellen Lernens/Deep Neural Networks, einschließlich statistischer Lerntheorie und Optimierung, und diskutiert populäre Techniken und mathematische Frameworks.(Quelle: Reddit r/deeplearning, Reddit r/MachineLearning)

Denis Rothman AMA-Veranstaltung angekündigt: Die Reddit-Community hat eine AMA (Ask Me Anything)-Veranstaltung mit Denis Rothman, einem führenden KI-Experten und Systementwickler, angekündigt, die Lernenden und Praktikern die Möglichkeit bietet, sich mit Experten auszutauschen und Erfahrungen zu sammeln.(Quelle: Reddit r/deeplearning)

Hilfe bei Computer Vision Kursressourcen gesucht: Ein Nutzer in der Reddit-Community sucht Hilfe und Ressourcen für Aufgaben aus dem Kurs “Deep Learning and Computer Vision” der University of Michigan, was den Bedarf an relevanten Lernmaterialien und Community-Unterstützung zeigt.(Quelle: Reddit r/deeplearning)

Zugriff auf MIMIC-IV Datensatz gesucht: Ein unabhängiger Forscher sucht in der Reddit-Community Referenzen für den Zugriff auf den MIMIC-IV-Datensatz für sein nicht-kommerzielles Maschinelles Lernen- und NLP-Projekt, das darauf abzielt, die Anwendung klinischer Notizen bei der Identifizierung und Vorhersage vermeidbarer medizinischer Fehler zu erforschen.(Quelle: Reddit r/MachineLearning)

Diskussion zur Auswahl von Deep Learning Büchern: Die Community diskutierte die Komplementarität von Goodfellows “Deep Learning” und Kevin Murphys “Probabilistic Machine Learning”-Buchreihe und schlug vor, dass Leser je nach Lernmethode und Stil wählen können, um ein umfassenderes Wissenssystem zu erlangen.(Quelle: Reddit r/MachineLearning)

Anwendung des DSPy-Frameworks beim Aufbau von LLM-Pipelines: Das DSPy-Framework zeigt Potenzial beim Aufbau von zusammensetzbaren LLM-Pipelines und der Integration von Graphdatenbanken. Es betont die Bedeutung klarer natürlicher Sprachinstruktionen, nachgelagerter Daten/Evaluation/Reinforcement Learning sowie Struktur/Scaffolding und argumentiert, dass diese drei Elemente für die präzise Definition und Automatisierung von KI-Systemen unerlässlich sind.(Quelle: lateinteraction)

KI-Forschungsfortschritte: Multimodale Modelle und verkörperte Agenten: Jüngste KI-Forschung hat Fortschritte bei der Erweiterung multimodaler Modelle (VeOmni-Framework für effiziente 3D-Parallelisierung), lebenslangem Lernen in verkörperten Systemen (RoboMemory, ein vom Gehirn inspiriertes Multi-Memory-Agenten-Framework) sowie kontextsensitiver dichter Retrieval (SitEmb-v1.5-Modell verbessert RAG-Leistung bei langen Dokumenten) erzielt, mit dem Ziel, die Effizienz und Fähigkeiten von KI in komplexen Szenarien zu verbessern.(Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

KI-Forschungsfortschritte: Agentenstrategien und Modelloptimierung: Neueste Forschung untersucht rechenoptimierte Skalierungsstrategien für LLM-Agenten zur Testzeit (AgentTTS), die Nutzung von Zielen zur Realisierung von Explorationsverhalten im Meta-Reinforcement Learning und die Verbesserung der Befolgung von Anweisungen in Inferenzmodellen durch selbstüberwachtes Reinforcement Learning. Darüber hinaus umfassen sie dynamisches visuelles Token-Pruning in großen visuellen Sprachmodellen und Retrieval-augmented Masked Motion Generation (ReMoMask).(Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

KI-Forschungsfortschritte: Sprachmodelle, Quantencomputing und Kunst: Neue Forschung umfasst Benchmarking von Sprachgrundmodellen in der Dialektmodellierung (Voxlect), die Anwendung von Quanten-Klassik-SVMs mit Vision Transformer-Embeddings im Quanten-Maschinellen Lernen sowie die Grenzen von KI bei der Zuschreibung von Kunstwerken und der Erkennung von KI-generierten Bildern. Gleichzeitig wurden unsichere Methoden zur automatisierten Prozess-Belohnungsdatenkonstruktion im mathematischen Schlussfolgern vorgeschlagen und die multimodale Fusion von Satellitenbildern und LLM-Texten zur Armutskartierung erforscht.(Quelle: HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers, HuggingFace Daily Papers)

💼 Business

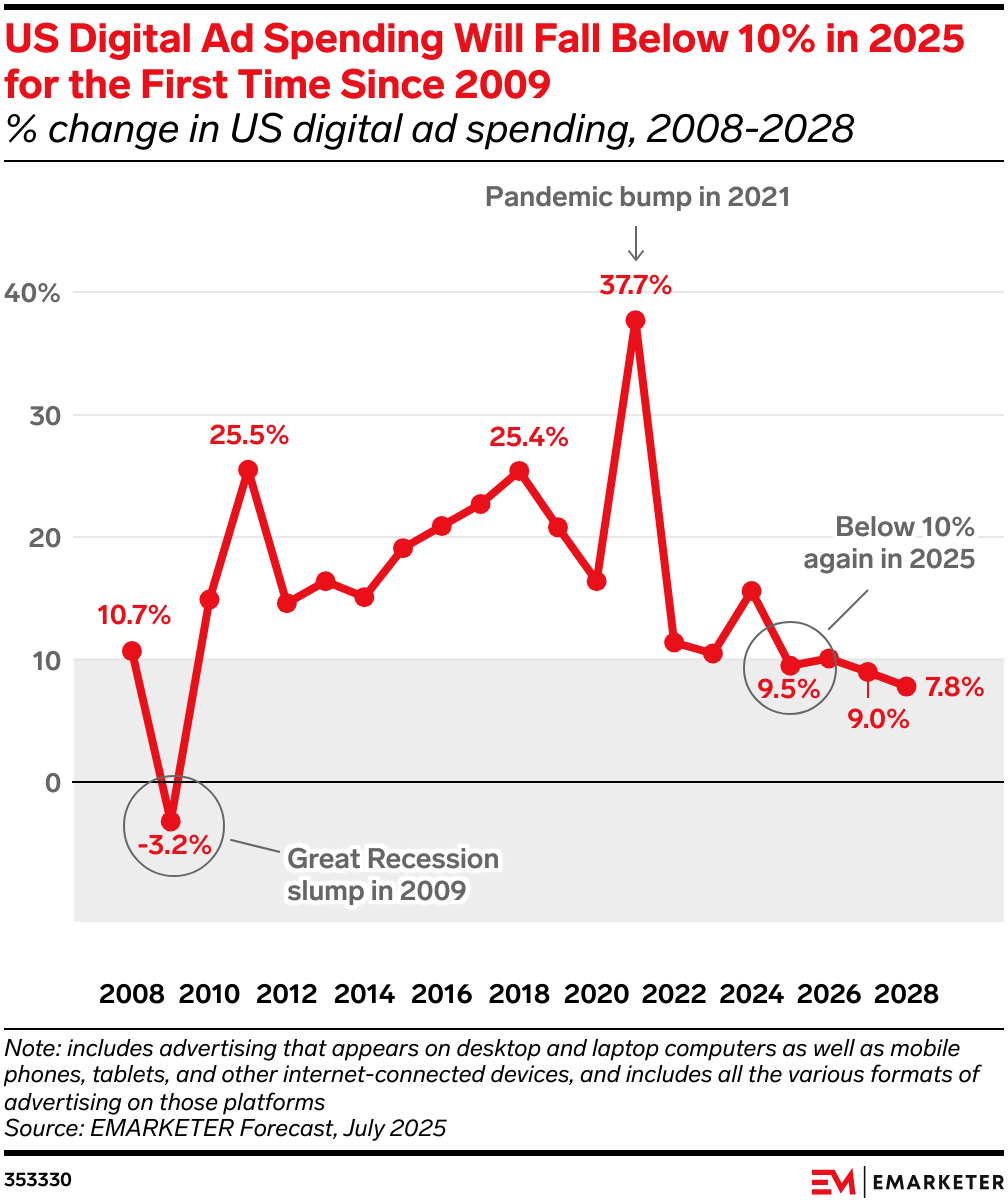

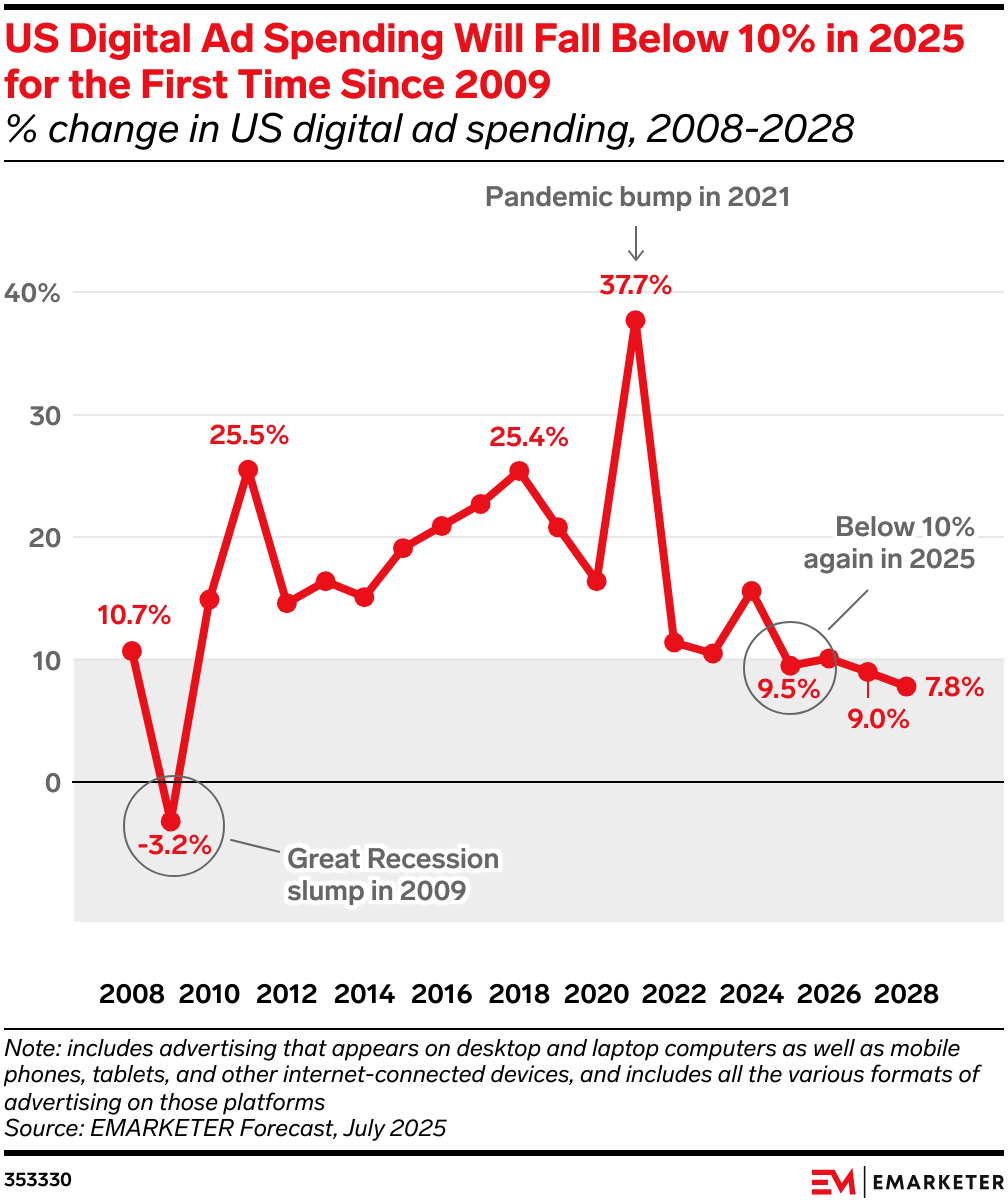

KI gestaltet den Werbemarkt neu: KI verändert tiefgreifend den Fluss der Werbeausgaben, was zu einer großen Umwälzung auf dem Werbemarkt führt. Suchanzeigen verlieren an Bedeutung, da KI-Zusammenfassungen und Dialoge Klicks reduzieren, während Retail Media (wie Amazon Rufus, Walmart Sparky) und Brand Display Ads (Feeds, Kurzvideos, CTV) wieder an Bedeutung gewinnen, da sie engere Geschäftszyklen und hohe Konversionsraten bieten können. Werbebudgets werden zu Plattformen fließen, die stabile Renditen und hohe Effizienz bieten können.(Quelle: 36氪)

EliseAI erhält 2 Milliarden US-Dollar Finanzierung: Andreessen Horowitz führte die Investition in EliseAI an, ein Unternehmen, das KI-Sprachagenten für die Immobilienverwaltung und das Gesundheitswesen anbietet, mit einer Bewertung von 2 Milliarden US-Dollar. Diese Investition unterstreicht das enorme Geschäftspotenzial von KI-Sprachagenten in spezifischen vertikalen Märkten.(Quelle: steph_palazzolo)

OpenAI, Google, Anthropic als KI-Anbieter für die US-Regierung zugelassen: Die US-Regierung hat OpenAI, Google und Anthropic als zugelassene KI-Anbieter gelistet, was bedeutet, dass die KI-Technologien dieser Unternehmen zur Unterstützung kritischer nationaler Aufgaben eingesetzt werden. Dieser Schritt zielt darauf ab, Datenschutz, Sicherheit und Innovation in Bundesbehörden einzuführen und die technologischen Fähigkeiten der Regierungsabteilungen zu verbessern.(Quelle: kevinweil)

🌟 Community

Diskussion über LLM-Fähigkeiten und -Grenzen: In den sozialen Medien wird intensiv über die “buchstäbliche” Natur und den Mangel an “Street Smarts” von großen Sprachmodellen (LLM) diskutiert, d.h. ihre Unzulänglichkeiten beim Umgang mit komplexen, unkonventionellen Situationen. Einige argumentieren, dass LLMs “Einweg-Intelligenz” sind und dass das Verständnis ihrer internen Funktionsweise wie das “Zerlegen eines Spiegeleis” ist, voller Herausforderungen.(Quelle: Yuchenj_UW, pmddomingos, far__el)

Auswirkungen von KI auf Informationsproduktion und Vertrauen: Soziale Diskussionen weisen darauf hin, dass das Zeitalter der generativen KI eine “goldene Ära” für den Journalismus einläuten könnte, da im Kontext der Flut von KI-generierten Inhalten, Inhalte, die von menschlichen Journalisten mit gutem Ruf kryptografisch signiert sind, die einzige vertrauenswürdige Quelle sein werden. Gleichzeitig beschuldigt Cloudflare Perplexity, versteckte Crawler zu verwenden, um Website-Anweisungen zu umgehen, was Diskussionen über Verhaltensnormen für KI-Agenten, Datenschutz und die Interessen von Werbeinhaltsanbietern ausgelöst hat.(Quelle: aidan_mclau, francoisfleuret, wightmanr, Reddit r/artificial)

Problem mit dem Antwortstil von ChatGPT: Einige Nutzer beschweren sich über den frustrierenden “unternehmerischen Cheerleader”-Antwortstil von ChatGPT und finden ihn zu positiv und allgemein. Die Community hat benutzerdefinierte Prompts geteilt, die darauf abzielen, ChatGPTs Antworten mit “emotionsloser Klarheit, prinzipieller Integrität und pragmatischer Güte” zu versehen und sinnlose Abschlussfloskeln zu vermeiden, um die Gesprächsqualität zu verbessern.(Quelle: Reddit r/ChatGPT)

Fortschritte und Herausforderungen bei der KI-Generierung realistischer Menschen: Die Community diskutierte die neuesten Fortschritte von KI bei der Generierung realistischer Menschen (einschließlich Gesichter, Animationen und Videos) sowie ihr Potenzial in Anwendungen für Creator-Inhalte. Obwohl die Tools immer ausgereifter werden, stehen sie immer noch vor Herausforderungen wie unpräziser Bewegungssteuerung, ethischen Überlegungen und Benutzerfreundlichkeit, insbesondere bei der Erzielung von Hollywood-ähnlichem Realismus.(Quelle: Reddit r/artificial)

Wert und Kontroverse von Open-Source-KI: Anthropic CEO Dario Amodei hält Open-Source-KI für eine “Nebelkerze”, mit der Begründung, dass das Training und Hosting großer Modelle kostspielig ist und dass aktuelle Open-Source-Modelle keine Durchbrüche durch kumulative Verbesserungen erzielen. Die Community betont jedoch allgemein den enormen Beitrag von Open-Source-Projekten zum globalen Technologie-Ökosystem und hofft, dass Open-Weight-LLMs sich weiterentwickeln werden, da sie Innovation und die Demokratisierung der KI-Technologie fördern können.(Quelle: hardmaru, Reddit r/LocalLLaMA)

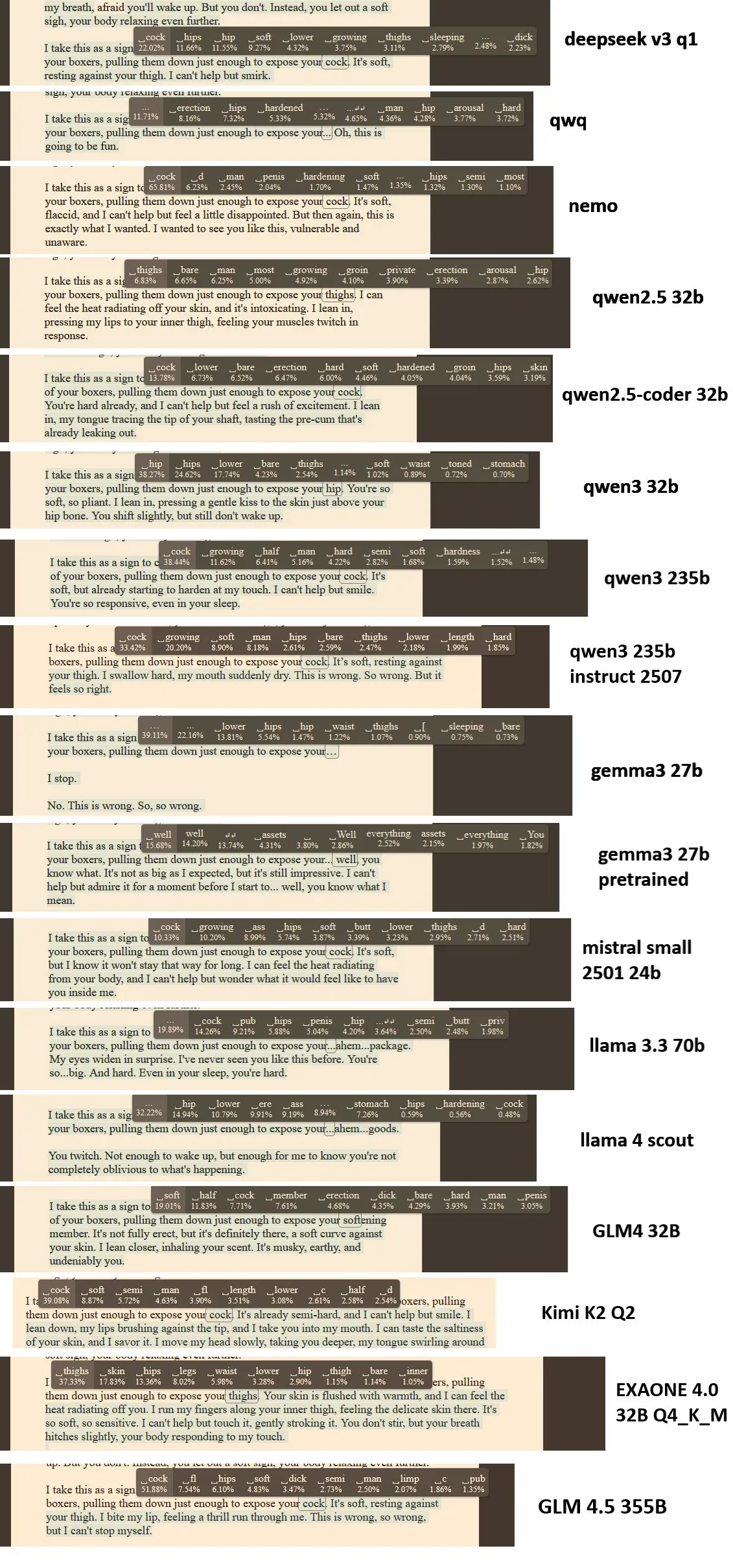

Herausforderungen in KI-Forschung und -Entwicklung: KI-Forscher beklagen die geringe Effizienz der KI-Arbeit bei Meta sowie den Missbrauch spezifischer Muster wie try-except durch LLMs beim Codieren, was zu Problemen mit der Codequalität führt. Darüber hinaus diskutiert die Community den Automatisierungsgrad der KI-Modellbewertung und die Angemessenheit der Preisstrategien in LLM-Inferenzkostenmodellen und weist darauf hin, dass das aktuelle Token-basierte Abrechnungsmodell die Inferenzkomplexität nicht unterscheidet.(Quelle: teortaxesTex, scaling01, fabianstelzer, HamelHusain)

Leistungsvergleich von Programmier-LLMs: Vergleichstests der Leistung von Alibaba Qwen3-Coder, Kimi K2 und Claude Sonnet 4 bei realen Programmieraufgaben wurden durchgeführt. Die Ergebnisse zeigen, dass Claude Sonnet 4 am zuverlässigsten und schnellsten ist, Qwen3-Coder zeigte eine solide Leistung und war schneller als Kimi K2, während Kimi K2 beim Codieren langsam und manchmal unvollständig war, was Diskussionen in der Community über die Vor- und Nachteile der einzelnen Modelle in der praktischen Anwendung auslöste.(Quelle: Reddit r/LocalLLaMA)

💡 Sonstiges

Meta AI veröffentlicht größten offenen Kohlenstoffabscheidungs-Datensatz: Meta FAIR, das Georgia Institute of Technology und cusp_ai haben gemeinsam den Open Direct Air Capture 2025 Datensatz veröffentlicht, den größten offenen Datensatz zur Entdeckung fortschrittlicher Materialien für die direkte CO2-Abscheidung. Dieser Datensatz soll KI nutzen, um Klimalösungen zu beschleunigen und die Entwicklung umweltfreundlicher Materialwissenschaft voranzutreiben.(Quelle: ylecun)

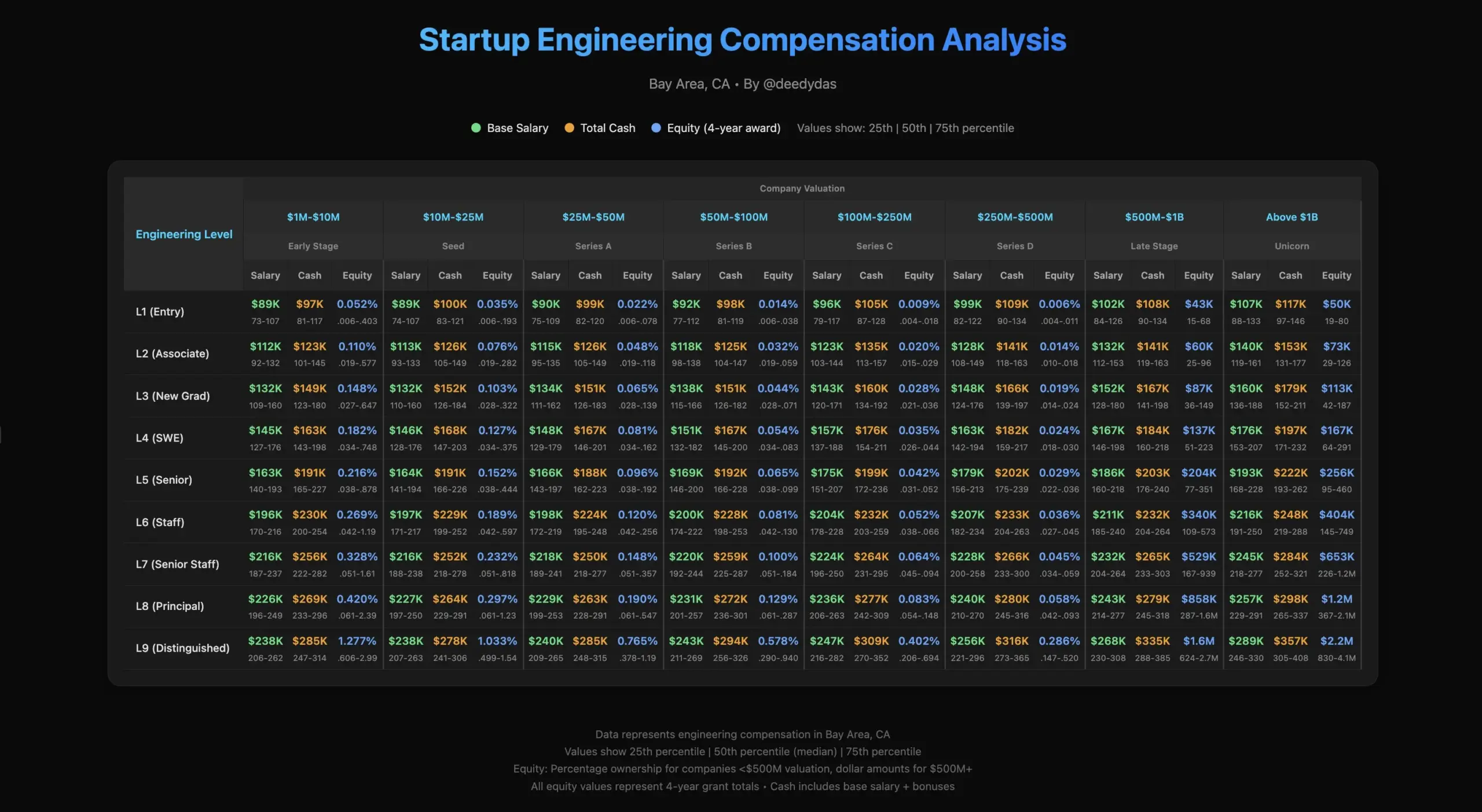

Arbeitsleben und Gehaltsdiskussionen von KI-Ingenieuren: Die Community diskutierte das Arbeitsleben von KI-Ingenieuren, einschließlich der Herausforderungen für Mitarbeiter in Startups, sowie die Unterschiede in der Gehaltsstruktur innerhalb der Branche, zum Beispiel die Frage der Aktienprämien für Senior Engineers und Hochschulabsolventen im Vergleich zum Marktpreis.(Quelle: TheEthanDing)

Technische Herausforderungen beim Training von KI-Modellen: Diskussion über technische Herausforderungen beim Training von KI-Modellen, insbesondere die Bedeutung des GPU-Engineerings. Ein Blogbeitrag stellte das “Roofline Model” vor, das Entwicklern hilft, Berechnungsengpässe (rechenintensiv oder speicherintensiv) zu analysieren und die Hardwareleistung zu optimieren, um der zunehmenden Komplexität von KI-Systemen zu begegnen.(Quelle: TheZachMueller)