Schlüsselwörter:Gemini 2.5 Deep Think, XBOW KI-Agent, Seed Diffusion LLM, OpenAI Open-Source-Modell, KI-Agent, Multimodales Inferenzmodell, LLM-Training, KI-Sicherheit, Parallele Denktechnik, KI-Penetrationstest-Tool, Diskretes Zustandsdiffusionsmodell, Sparse-MoE-Architektur, KI-Gesundheitsgroßmodell

Hier ist die Übersetzung der AI-Nachrichten ins Deutsche, unter Beibehaltung der Formatierung und Anforderungen:

🔥 Fokus

Gemini 2.5 Deep Think IMO Goldmedaillen-Modell veröffentlicht : Google DeepMind hat das Gemini 2.5 Deep Think Modell veröffentlicht. Dieses Modell erreicht durch „paralleles Denken“ und Reinforcement Learning-Technologien Goldmedaillenniveau bei der Internationalen Mathematik-Olympiade (IMO). Das Modell ist jetzt für Google AI Ultra-Abonnenten verfügbar und wird Mathematikern für detailliertes Feedback zur Verfügung gestellt. Es zeichnet sich in komplexer Mathematik, Schlussfolgerungen und Kodierung aus und markiert einen bedeutenden Durchbruch der KI in fortgeschrittenen Denkfähigkeiten, der neue Werkzeuge zur Lösung komplexer wissenschaftlicher Probleme bietet. (Quelle: Logan Kilpatrick

)

XBOW AI Agent wird zum weltweit führenden Hacker : Das autonome AI-Penetrationstest-Tool XBOW ist zum Top-Hacker auf der globalen HackerOne-Rangliste aufgestiegen, was einen Meilenstein für AI Agents im Bereich der Cybersicherheit markiert. XBOW ist in der Lage, Schwachstellen autonom zu finden und wird dies auf der BlackHat-Konferenz live demonstrieren. Dies zeigt die starke Fähigkeit und das zukünftige Potenzial der KI im automatisierten Sicherheitstesting und kündigt den Eintritt der Cybersicherheits-Offensive und -Defensive in das AI-Zeitalter an. (Quelle: Plinz

)

ByteDance veröffentlicht Seed Diffusion LLM for Code : ByteDance hat Seed Diffusion Preview veröffentlicht, ein auf diskreter Zustandsdiffusion basierendes, hochschnelles LLM für die Codegenerierung. Die Inferenzgeschwindigkeit beträgt bis zu 2146 Tokens/Sekunde (auf H20 GPUs), übertrifft Mercury und Gemini Diffusion und behält gleichzeitig die gleiche Leistung in Standard-Code-Benchmarks bei. Dieser Durchbruch setzt einen neuen Maßstab an der Geschwindigkeits-Qualitäts-Pareto-Front und eröffnet neue technologische Richtungen im Bereich der Codegenerierung. (Quelle: jeremyphoward

)

OpenAI Open-Source-Modellinformationen versehentlich geleakt : Konfigurationsinformationen von OpenAIs Open-Source-Modellen (gpt-oss-120B MoE, 20B) wurden versehentlich geleakt, was in der Community für große Diskussionen sorgte. Der Leak zeigt eine sparse MoE-Architektur (36 Schichten, 128 Experten, 4 aktive Experten), die möglicherweise mit FP4 trainiert wurde, 128K langen Kontext unterstützt und GQA sowie Sliding Window Attention zur Optimierung von Speicher und Berechnung verwendet. Dies deutet darauf hin, dass OpenAI bald Open-Source-Modelle mit hoher Leistung und Effizienz auf den Markt bringen wird, was tiefgreifende Auswirkungen auf das lokale LLM-Ökosystem haben könnte. (Quelle: Dorialexander

)

🎯 Trends

Yunpeng Technology veröffentlicht neue AI+Gesundheitsprodukte : Yunpeng Technology hat am 22. März 2025 in Hangzhou neue Produkte in Zusammenarbeit mit Shuaikang und Skyworth vorgestellt, darunter das „Digitale Zukunftsküchenlabor“ und einen intelligenten Kühlschrank mit einem großen AI-Gesundheitsmodell. Das große AI-Gesundheitsmodell optimiert Küchendesign und -betrieb, während der intelligente Kühlschrank über den „Gesundheitsassistenten Xiaoyun“ personalisiertes Gesundheitsmanagement bietet, was einen Durchbruch der KI im Gesundheitsbereich markiert. Diese Veröffentlichung demonstriert das Potenzial der KI im täglichen Gesundheitsmanagement und wird voraussichtlich die Entwicklung der häuslichen Gesundheitstechnologie vorantreiben und die Lebensqualität der Bewohner verbessern. (Quelle: 36氪

)

Qwen3-Coder-480B-A35B-Instruct mit hervorragender Leistung : Der Entwickler Peter Steinberger erklärte, dass das Qwen3-Coder-480B-A35B-Instruct-Modell auf H200 läuft und sich schneller als Claude 3 Sonnet anfühlt, ohne Sperren, was seine starke Wettbewerbsfähigkeit und Bereitstellungsflexibilität im Bereich der Codegenerierung zeigt. Diese Bewertung zeigt, dass Qwen3-Coder nicht nur hohe Leistung anstrebt, sondern auch die Vorteile von Geschwindigkeit und Offenheit in praktischen Anwendungen berücksichtigt. (Quelle: huybery

)

Step 3 multimodales Inferenzmodell veröffentlicht : StepFun hat das neueste Open-Source-Multimodale Inferenzmodell Step 3 veröffentlicht, mit einer Parameteranzahl von 321B (38B aktiv). Durch innovative Multi-Matrix Factorization Attention (MFA) und Attention-FFN Disaggregation (AFD) Technologien wurde eine Inferenzgeschwindigkeit von bis zu 4039 Tokens pro Sekunde erreicht, was 70% schneller ist als DeepSeek-V3. Dies schafft ein Gleichgewicht zwischen Leistung und Kosteneffizienz und bietet eine effiziente Lösung für multimodale AI-Anwendungen. (Quelle: _akhaliq)

Kimi-K2 Inferenzgeschwindigkeit erheblich gesteigert : Moonshot AI hat das Kimi-K2-turbo-preview-Modell veröffentlicht, dessen Inferenzgeschwindigkeit sich vervierfacht hat, von 10 auf 40 Tokens pro Sekunde, und das zu einem zeitlich begrenzten Sonderpreis angeboten wird. Dieser Schritt zielt darauf ab, Entwicklern kreativer Anwendungen eine bessere Geschwindigkeit und ein besseres Preis-Leistungs-Verhältnis zu bieten und Kimis Wettbewerbsfähigkeit bei der Langtextverarbeitung und Agentic-Aufgaben weiter zu stärken. (Quelle: Kimi_Moonshot

)

Google DeepMind monatliches Token-Verarbeitungsvolumen stark gestiegen : Google DeepMind berichtet, dass das monatliche Token-Verarbeitungsvolumen seiner Produkte und APIs von 480 Billionen im Mai auf über 980 Billionen gestiegen ist, was die massive Akzeptanz von AI-Modellen in realen Anwendungen und den schnell wachsenden Bedarf an Verarbeitungskapazität zeigt. Diese Daten spiegeln die Geschwindigkeit wider, mit der sich die AI-Technologie in verschiedenen Branchen verbreitet, und die Abhängigkeit der Nutzer von ihrer leistungsstarken Verarbeitungskapazität. (Quelle: _philschmid

)

Cohere veröffentlicht visuelles Modell Command R A Vision : Cohere hat sein visuelles Modell Command R A Vision vorgestellt, das Unternehmen visuelle Verständnis-Fähigkeiten bieten soll, um Aufgaben wie Diagrammanalyse, layout-sensitives OCR und die Interpretation realer Szenen zu automatisieren. Das Modell eignet sich zur Verarbeitung von Dokumenten, Fotos und strukturierten visuellen Daten, erweitert die Anwendungsbereiche von LLMs im multimodalen Bereich und erfüllt die Anforderungen von Unternehmen an die Verarbeitung komplexer visueller Informationen. (Quelle: code_star)

GLM-4.5 veröffentlicht, vereinheitlicht Agentic-Fähigkeiten : Zhipu AI hat GLM-4.5 veröffentlicht, das darauf abzielt, Inferenz-, Kodierungs- und Agentic-Fähigkeiten in einem offenen Modell zu vereinen, dessen Geschwindigkeit und Intelligenz hervorhebt und professionelle Entwicklung unterstützt. Dieses Modell integriert mehrere zentrale AI-Fähigkeiten und bietet Entwicklern umfassendere und effizientere Werkzeuge, um die Anwendung von KI bei der Bearbeitung komplexer Aufgaben und der Entwicklung von Agenten voranzutreiben. (Quelle: Zai_org

)

Grok 4 zeigt herausragende Leistung in Agentic Software-Engineering-Aufgaben : Grok 4 hat in Agentic-Software-Engineering-Aufgaben mit mehreren Schritten eine herausragende Leistung gezeigt, wobei seine Performance innerhalb von 50% der Zeit bereits OpenAI o3 übertroffen hat. Obwohl sein CEO dem Agent-Konzept skeptisch gegenübersteht, zeigt dies, dass Grok 4 Agentic-Verhalten allein durch seine Kernfähigkeiten erreichen kann, was sein starkes Potenzial in komplexer Programmierung und Problemlösung demonstriert. (Quelle: teortaxesTex

)

Chinesische Akademie der Wissenschaften: Feinabgestimmtes DeepSeek R1-Modell zeigt hervorragende Leistung : Nach der Feinabstimmung des DeepSeek R1-Modells durch die Chinesische Akademie der Wissenschaften wurden in Benchmarks wie HLE und SimpleQA signifikante Verbesserungen erzielt, mit einem HLE-Score von 40% und einem SimpleQA-Score von 95%. Dieses Ergebnis zeigt das Potenzial einer effektiven Optimierung bestehender Open-Source-Modelle durch professionelles Fine-Tuning und bietet ein praktisches Beispiel zur Verbesserung der Leistung chinesischer AI-Modelle. (Quelle: teortaxesTex

)

Kuaishou veröffentlicht Bildmodell Kolors 2.1 : Kuaishou (Kling AI) hat das Bildmodell Kolors 2.1 veröffentlicht, das im Bereich der Bildgenerierung hervorragende Leistungen erbringt, insbesondere beim Text-Rendering auf Platz drei liegt, bis zu 2K Auflösung unterstützt und API-Dienste zu einem wettbewerbsfähigen Preis anbietet. Die Veröffentlichung von Kolors 2.1 zeigt Kuaishous Wettbewerbsfähigkeit auf dem Markt für Bildgenerierung und bietet Nutzern eine hochwertige und kostengünstige Option zur Bildgestaltung. (Quelle: Kling_ai

)

WAIC konzentriert sich auf die „Halbzeit des Krieges“ der Großmodelle und den Durchbruch bei der heimischen Rechenleistung : Die WAIC 2025 Konferenz enthüllt drei Haupttrends in der heimischen Großmodellindustrie: Inferenzmodelle werden zum neuen Höhepunkt (z.B. DeepSeek-R1, Hunyuan T1, Kimi K2, GLM-4.5, Step3), die Anwendungsrealisierung geht vom Konzept zur Praxis über, und heimische Rechenleistung (z.B. Huawei Ascend 384 Supernode, Suiyuan S60) erlebt bahnbrechende Fortschritte. Der Wettbewerb verlagert sich vom Parametervergleich zu einem umfassenden Wettstreit um Ökosysteme und Geschäftsmodelle, was den Eintritt der Großmodellindustrie in eine rationalere und intensivere „Halbzeit des Krieges“ markiert. (Quelle: 36氪

)

ChinaJoy AIGC Konferenz konzentriert sich auf AI+Unterhaltung und Embodied AI : Die ChinaJoy AIGC Konferenz 2025 diskutiert AI-Infrastruktur, die Neugestaltung großer Modelle, humanoide Roboter und Embodied AI, neue Paradigmen für AI-gesteuerte digitale Unterhaltung sowie die Integration intelligenter Technologien in die Industrie. Die Konferenz betont die hohe Steuerbarkeit und Konsistenz multimodaler Großmodelle (wie Vidu Q1), die autonome Entscheidungsfähigkeit von Agentic AI sowie die Anwendung von KI in Bereichen wie Spieleinhaltsproduktion, 3D-Asset-Generierung und virtueller Mensch-Interaktion, was tiefgreifende Veränderungen der KI in der Unterhaltungsindustrie ankündigt. (Quelle: 36氪

)

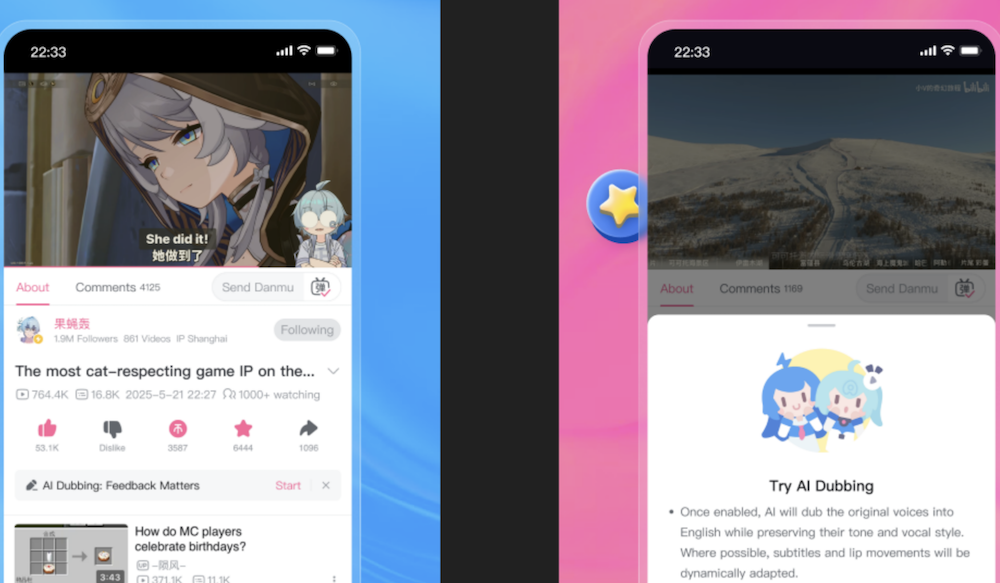

Bilibili führt AI-Originalstimmenübersetzungsfunktion ein, die die Stimme des UP-Hosts perfekt wiederherstellt : Bilibili hat eine neue selbst entwickelte AI-Originalstimmenübersetzungsfunktion veröffentlicht, die die Stimme, den Klang und die Atempausen von UP-Hosts perfekt wiederherstellen und Lippensynchronisation durchführen kann, mit Unterstützung für Chinesisch-Englisch-Übersetzung. Diese Funktion zielt darauf ab, das Nutzererlebnis für internationale Nutzer zu verbessern. Der technische Kern sind das IndexTTS2-Sprachgenerierungsmodell und eine LLM-basierte Übersetzungsengine, die die Schwierigkeiten bei der Übersetzung von Fachbegriffen und populären Memes überwindet, um eine präzise und lebendige Übersetzung zu gewährleisten. Dies wird voraussichtlich Sprachbarrieren durchbrechen und den globalen Austausch von Inhalten ermöglichen. (Quelle: 量子位

)

🧰 Tools

DSPy Rust-Version (DSRs) : Herumb Shandilya entwickelt eine Rust-Version von DSPy (DSRs), eine LLM-Bibliothek für fortgeschrittene Benutzer, die tiefere Kontrolle und Optimierungsmöglichkeiten bieten soll. Die Einführung von DSRs wird LLM-Entwicklern eine tiefere Programmierflexibilität und Leistungsvorteile bieten, besonders geeignet für Forscher und Ingenieure, die eine präzise Kontrolle über das Modellverhalten benötigen. (Quelle: lateinteraction

)

Hugging Face Jobs integriert uv : Hugging Face Jobs unterstützt jetzt die uv-Integration, die es Benutzern ermöglicht, Skripte wie DPO direkt auf der HF-Infrastruktur auszuführen, ohne Docker oder Abhängigkeiten einrichten zu müssen, was den LLM-Trainings- und Bereitstellungsprozess vereinfacht. Dieses Update senkt die Hürden für die LLM-Entwicklung erheblich und ermöglicht es Forschern und Entwicklern, Modelle effizienter zu experimentieren und anzuwenden. (Quelle: _lewtun

)

Poe-Plattform öffnet API : Die Poe-Plattform hat ihre API für Entwickler geöffnet, die es Abonnenten ermöglicht, alle Modelle und Bots auf der Plattform, einschließlich Bild- und Videomodelle, aufzurufen und die mit der chat completions-Schnittstelle von OpenAI kompatibel ist. Diese offene Strategie erleichtert Entwicklern die Integration der AI-Fähigkeiten von Poe erheblich und fördert den schnellen Aufbau und die Innovation von AI-Anwendungen. (Quelle: op7418

)

Claude Code Best Practices und neue Funktionen : Das Anthropic-Technologieteam hat die leistungsstarken Funktionen und Best Practices von Claude Code geteilt, darunter das Verstehen des Modells wie einen menschlichen Kollegen, Agentic Search zur Erkundung von Codebasen, die Nutzung von claude.md zur Bereitstellung von Kontext, die Integration von CLI-Tools, das Management des Kontextfensters und mehr. Zu den neuesten Funktionen gehören Modellwechsel, „Deep Thinking“ zwischen Tool-Aufrufen und eine tiefe Integration mit VS Code/JetBrains, was die Effizienz und das Erlebnis des AI-gestützten Programmierens erheblich verbessert. (Quelle: dotey

)

PortfolioMind nutzt Qdrant für Echtzeit-Krypto-Intelligenz : PortfolioMind nutzt die Multivector-Suchfunktion von Qdrant, um eine dynamische Neugier-Engine für den Kryptowährungsmarkt aufzubauen, die Echtzeit-Modellierung von Benutzerabsichten und personalisierte Forschung ermöglicht. Diese Lösung reduziert die Latenz erheblich (71%), verbessert die Interaktionsrelevanz (58%) und erhöht die Benutzerbindung (22%), was den enormen Wert von Vektordatenbanken in Echtzeit-Intelligenzanwendungen im Finanzbereich demonstriert. (Quelle: qdrant_engine

)

Android Studio integriert Gemini Agent-Modus : Google hat einen kostenlosen Gemini Agent-Modus in Android Studio hinzugefügt, der es Entwicklern ermöglicht, direkt mit dem Agenten zu interagieren, um Android-Anwendungen zu entwickeln. Dies unterstützt schnelle UI-Code-Änderungen und benutzerdefinierte Regeln, was die Android-Entwicklungseffizienz erheblich steigert. Diese Integration bringt AI-Fähigkeiten direkt in die Entwicklungsumgebung und kündigt eine Vertiefung und Popularisierung des AI-gestützten Programmierens an. (Quelle: op7418

)

DocStrange Open-Source-Bibliothek zur Dokumentendatenextraktion : DocStrange ist eine Open-Source-Python-Bibliothek, die das Extrahieren von Daten aus verschiedenen Dokumenttypen wie PDF, Bildern, Word, PPT, Excel unterstützt und die Ausgabe in Formaten wie Markdown, JSON, CSV, HTML ermöglicht. Es unterstützt die intelligente Extraktion spezifischer Felder und Schemata und bietet Cloud- und lokale Verarbeitungsmodi, was eine flexible und effiziente Lösung für die Dokumentendatenverarbeitung und das LLM-Training darstellt. (Quelle: Reddit r/LocalLLaMA

)

Open WebUI Wissensdatenbank-Funktion : Open WebUI wird derzeit zum Aufbau interner Unternehmens-Wissensdatenbanken verwendet, die den Import von PDF-, Docx- und anderen Dateien unterstützen, sodass AI-Modelle diese Informationen standardmäßig abrufen können. Durch Systemprompts können Benutzer AI-Modellen vordefinierte Informationen bereitstellen, um interne AI-Anwendungen zu optimieren und die Effizienz der Informationssuche und des Wissensmanagements zu verbessern. (Quelle: Reddit r/OpenWebUI)

AI Agent automatisiertes Jobsuche-Tool SimpleApply.ai : SimpleApply.ai ist ein Tool, das AI Agents zur Automatisierung der Jobsuche nutzt und manuelle, Ein-Klick- und vollautomatische Bewerbungsmodi bietet, die in 50 Ländern unterstützt werden. Das Tool zielt darauf ab, die Effizienz der Jobsuche durch präzise Abstimmung von Fähigkeiten und Erfahrungen zu verbessern, manuelle Vorgänge zu reduzieren und Jobsuchenden einen bequemeren und effizienteren Service zu bieten. (Quelle: Reddit r/artificial)

GGUF Quantisierungstool quant_clone : quant_clone ist eine Python-Anwendung, die basierend auf der Quantisierungsmethode eines Ziel-GGUF-Modells llama-quantize-Befehle generieren kann, um Benutzern zu helfen, ihre eigenen feinabgestimmten Modelle auf die gleiche Weise zu quantisieren. Dies hilft, die Laufzeiteffizienz und Kompatibilität lokaler LLMs zu optimieren und bietet ein praktisches Tool für die lokale Modellbereitstellung. (Quelle: Reddit r/LocalLLaMA

)

VideoLingo AI Videoübersetzungs- und Synchronisationstool : VideoLingo ist ein All-in-One-AI-Videoübersetzungs-, Lokalisierungs- und Synchronisationstool, das darauf abzielt, Untertitel in Netflix-Qualität zu generieren. Es unterstützt wortbasierte Erkennung, NLP und AI-Untertitel-Segmentierung, benutzerdefinierte Terminologie, dreistufige Übersetzungsreflexanpassung, einzeilige Untertitel, GPT-SoVITS und andere Synchronisationsmethoden und bietet Ein-Klick-Start und mehrsprachige Unterstützung, was den Globalisierungsprozess von Videoinhalten erheblich vereinfacht. (Quelle: GitHub Trending

)

Zotero-arXiv-Daily AI-Tool zur Artikel-Empfehlung : Zotero-arXiv-Daily ist ein Open-Source-Tool, das täglich neue arXiv-Artikel basierend auf der Zotero-Bibliothek des Benutzers empfiehlt. Es bietet AI-generierte TL;DR-Zusammenfassungen, Autoreninstitutionen, PDF- und Code-Links und sortiert nach Relevanz. Es kann als GitHub Action-Workflow bereitgestellt werden, um einen kostenlosen automatischen E-Mail-Versand zu ermöglichen, was die Effizienz der Literaturverfolgung für Forscher erheblich verbessert. (Quelle: GitHub Trending

)

Dyad lokaler Open-Source AI-Anwendungs-Builder : Dyad ist ein kostenloser, lokaler, Open-Source-AI-Anwendungs-Builder, der darauf abzielt, eine schnelle, private und vollständig kontrollierbare AI-Anwendungsentwicklungserfahrung zu bieten. Es ist eine lokale Alternative zu Lovable, v0 oder Bolt, unterstützt eigene API-Schlüssel und plattformübergreifende Ausführung, was Entwicklern mehr Flexibilität beim Erstellen und Bereitstellen von AI-Anwendungen ermöglicht. (Quelle: GitHub Trending

)

GPU-Speicherschnappschuss beschleunigt vLLM-Kaltstart : Modal Labs hat eine GPU-Speicherschnappschussfunktion eingeführt, die die Kaltstartzeit von vLLM um das 12-fache auf nur 5 Sekunden verkürzt. Diese Innovation verbessert die Effizienz und Skalierbarkeit der AI-Modellbereitstellung erheblich, was besonders für AI-Dienste mit schnellen Reaktionszeiten und elastischer Skalierung entscheidend ist. (Quelle: charles_irl

)

MLflow TypeScript SDK veröffentlicht : MLflow hat das TypeScript SDK veröffentlicht, das branchenführende Beobachtbarkeitsfunktionen in TypeScript- und JavaScript-Anwendungen einführt. Das SDK unterstützt die automatische Verfolgung von LLM- und AI-API-Aufrufen, manuelle Instrumentierung, OpenTelemetry-Standardintegration sowie Tools zur Sammlung und Bewertung von menschlichem Feedback, was eine starke Unterstützung für die Entwicklung und Überwachung von AI-Anwendungen bietet. (Quelle: matei_zaharia

)

Qdrant integriert SpoonOS : Die Qdrant-Vektordatenbank ist jetzt in SpoonOS integriert und bietet schnelle semantische Suche und Langzeitgedächtnisfunktionen für AI Agents und RAG-Pipelines auf der Web3-Infrastruktur. Diese Integration verbessert die Intelligenz und Effizienz von Echtzeit-Kontextanwendungen erheblich und bietet technische Unterstützung für den Aufbau fortschrittlicherer AI Agents. (Quelle: qdrant_engine

)

Hugging Face Trackio Experiment-Tracker : Das Gradio-Team von Hugging Face hat Trackio veröffentlicht, einen lokal-priorisierten, leichtgewichtigen, Open-Source- und kostenlosen Experiment-Tracker. Dieses Tool soll Forschern und Entwicklern helfen, Machine-Learning-Experimente effektiver zu verwalten und zu verfolgen, und bietet bequeme Funktionen zur Aufzeichnung und Visualisierung von Experimentdaten. (Quelle: huggingface

)

Cohere Embed 4 Modell auf OCI verfügbar : Cohere’s Embed 4 Modell ist jetzt auf Oracle Cloud Infrastructure (OCI) verfügbar, was es Benutzern erleichtert, schnelle, genaue und mehrsprachige Suchfunktionen für komplexe Geschäftsdokumente in AI-Anwendungen zu integrieren. Diese Bereitstellung erweitert die Zugänglichkeit von Cohere-Modellen und bietet leistungsstarke Embedding-Fähigkeiten für AI-Anwendungen auf Unternehmensebene. (Quelle: cohere

)

Text2SQL + RAG hybrider Agentic-Workflow : Die Community diskutiert, wie ein hybrider Agentic-Workflow, der Text2SQL und RAG kombiniert, aufgebaut werden kann, um die Automatisierung und Intelligenz von Datenbankabfragen und Informationsabruf zu verbessern. Dieser hybride Workflow kann die natürliche Sprachverständnisfähigkeit von LLMs und die Wissensabruffähigkeit von RAG nutzen, um genauere und effizientere Lösungen für komplexe Datenabfragen bereitzustellen. (Quelle: jerryjliu0)

📚 Lernen

AI Agent Konzept-Lernressourcen : Bytebytego hat „Top 20 AI Agent Concepts You Should Know“ veröffentlicht, eine wichtige Lernressource für Entwickler und Forscher, die sich mit AI Agents vertraut machen möchten. Dieser Leitfaden deckt die Kernkonzepte und Entwicklungstrends von AI Agents ab und hilft Lesern, schnell in dieses zukunftsweisende Feld einzusteigen und es tiefgehend zu verstehen. (Quelle: Ronald_vanLoon

)

PufferAI: Potenzieller Einfluss auf die RL-Forschung : PufferAI wird voraussichtlich einen enormen Einfluss auf die Reinforcement Learning (RL)-Forschung haben und die Beiträge von Atari im RL-Bereich übertreffen. Die Community ermutigt RL-Studenten, Pufferlib oder puffer.ai/ocean.html auszuprobieren, um deren fortschrittliche Tools für die Forschung zu nutzen, was darauf hindeutet, dass PufferAI ein wichtiger Motor im RL-Bereich werden könnte. (Quelle: jsuarez5341)

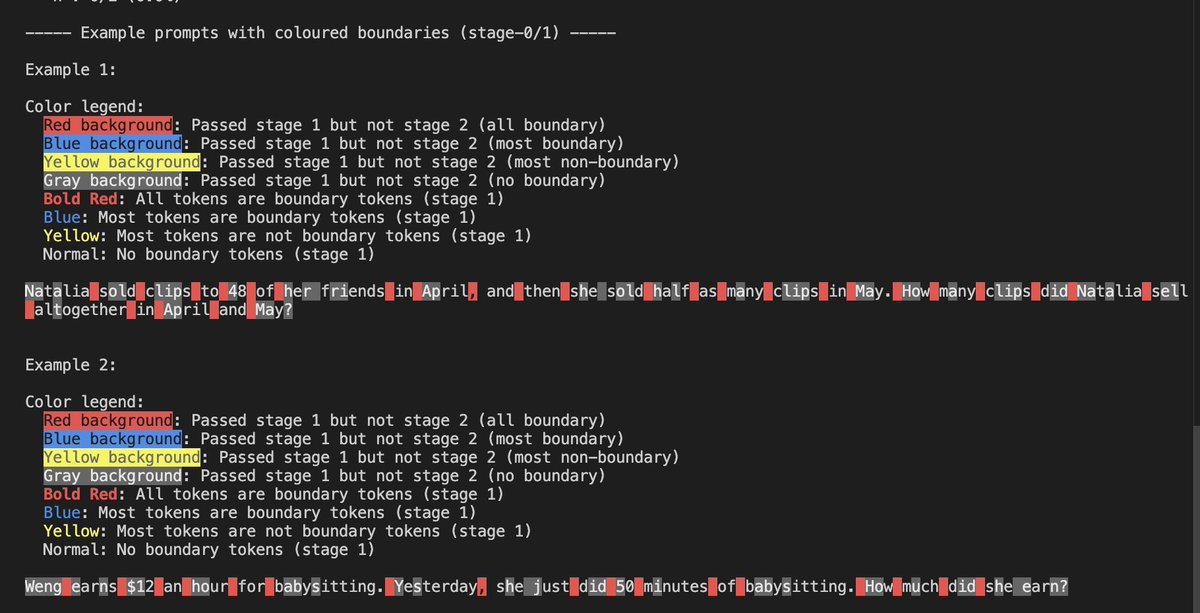

LLM Sparsity und Chunking Experimente : Yash Semlani teilte seine Fortschritte in der MoMoE- und Sparsity-Forschung, einschließlich HNet-Chunking-Experimenten auf GSM8k und einer zweistufigen Chunking-Visualisierung. Er fand heraus, dass Großbuchstaben oft als Begrenzungs-Tokens fungieren, während Zahlen dies seltener tun. Diese Experimente liefern neue Erkenntnisse für die Effizienzoptimierung und das Architekturdesign von LLMs. (Quelle: main_horse

)

AI-Evaluierungskurs und -Praxis : Shreya Shankars AI-Evaluierungskurs betont die „Allergie“ von AI-Teams gegenüber Evaluierungen, ermutigt zur manuellen Überprüfung statt vollständig automatisierter Bewertung und stellt Kursmaterialien zur Verfügung. Der Kurs zielt darauf ab, die praktischen Fähigkeiten zur Bewertung von AI-Modellen zu verbessern und die Zuverlässigkeit und Sicherheit der Modelle in realen Anwendungen zu gewährleisten. (Quelle: HamelHusain

)

Tutorial zur Bereitstellung von AFM-4.5B auf Arm-basiertem AWS Graviton4 : Julien Simon hat ein Tutorial veröffentlicht, das anleitet, wie man Arcee AIs kleines Sprachmodell AFM-4.5B auf Arm-basierten AWS Graviton4-Instanzen bereitstellt und optimiert und dessen Leistung und Perplexität bewertet. Dieses Tutorial bietet praktische Anleitungen zur LLM-Bereitstellung und zeigt, wie man leichtgewichtige Modelle auf effizienter Hardware ausführt. (Quelle: code_star

)

Subliminal Learning Code-Update : Owain Evans hat das GitHub-Repository von Subliminal Learning aktualisiert und Code zur Verfügung gestellt, um seine Forschungsergebnisse an offenen Modellen zu reproduzieren. Dieser Schritt stellt reproduzierbare Ressourcen für AI-Lernen und -Forschung bereit, hilft der Community, relevante Studien zu validieren und zu erweitern, und fördert den akademischen Austausch und den technologischen Fortschritt. (Quelle: _lewtun

)

Falcon-H1 Forschung zu hybriden Head-Sprachmodellen : Falcon-H1 ist eine Forschungsarbeit, die sich eingehend mit hybriden Head-Sprachmodellen befasst und detaillierte Informationen vom Tokenizer über die Datenvorbereitung bis hin zu Optimierungsstrategien liefert. Diese Studie zielt darauf ab, Effizienz und Leistung neu zu definieren, bietet eine wertvolle Referenz für das LLM-Architekturdesign und offenbart das Potenzial hybrider Architekturen zur Verbesserung der Modellleistung. (Quelle: teortaxesTex

)

Forschung zur Zuverlässigkeit des AI-Modelltrainings : Eine neue Studie untersucht Methoden, um AI-Modelle so zu trainieren, dass sie „wissen, was sie nicht wissen“, mit dem Ziel, die Zuverlässigkeit und Transparenz der Modelle zu erhöhen und das Risiko von Halluzinationen bei fehlenden gültigen Informationen zu reduzieren. Diese Forschung ist von großer Bedeutung für den Aufbau vertrauenswürdigerer AI-Systeme und trägt dazu bei, die Leistung von KI in kritischen Anwendungen zu verbessern. (Quelle: Ronald_vanLoon

)

Forschungstipps für ML-Doktoranden : Gabriele Berton teilte Forschungstipps für ML-Doktoranden, wobei er die Bedeutung der Konzentration auf praktische Probleme, des Austauschs mit Branchenexperten und des Sammelns von Erfahrungen mit Top-Konferenzpapieren und GitHub-Projekten betonte. Diese Ratschläge bieten wertvolle Orientierung für Studenten, die eine Karriere in der ML-Forschung anstreben, und helfen ihnen, ihren beruflichen Entwicklungspfad besser zu planen. (Quelle: BlackHC)

ACL 2025 Outstanding Paper: LLM Halluzinationsforschung : Die Arbeit „HALoGEN: Fantastic LLM Hallucinations and Where to Find Them“ wurde auf der ACL 2025 Konferenz mit dem Outstanding Paper Award ausgezeichnet. Diese Studie befasst sich eingehend mit der Entdeckung und dem Verständnis von LLM-Halluzinationen, bietet neue Perspektiven zur Verbesserung der Modellzuverlässigkeit und ist ein wichtiger Schritt zum Verständnis und zur Behebung der Einschränkungen großer Modelle. (Quelle: stanfordnlp

)

LLM Großskaliges Trainingshandbuch „Ultra-Scale Playbook“ : Hugging Face hat das 246-seitige „Ultra-Scale Playbook“ veröffentlicht, einen detaillierten Leitfaden für das Training großer LLMs, der Techniken wie 5D-Parallelität, ZeRO, schnelle Kernel und Compute/Communication Overlap abdeckt. Dieser Leitfaden soll Entwicklern helfen, ihre eigenen DeepSeek-V3-Modelle zu trainieren, und bietet wertvolle praktische Erfahrungen für die LLM-Forschung und -Entwicklung. (Quelle: LoubnaBenAllal1

)

Roadmap für den Einstieg ins Machine Learning : Python_Dv hat eine Roadmap für den Einstieg ins Machine Learning geteilt, die Anfängern einen Leitfaden zum Erlernen von Data Science, Deep Learning und Künstlicher Intelligenz bietet. Diese Roadmap deckt Lernpfade von grundlegenden Konzepten bis hin zu fortgeschrittenen Anwendungen ab und hilft Neulingen, Machine-Learning-Wissen systematisch zu erlernen. (Quelle: Ronald_vanLoon

)

Unterscheidung zwischen AI, Generativer AI und Machine Learning Konzepten : Khulood_Almani erläuterte die Unterschiede zwischen Künstlicher Intelligenz (AI), Generativer AI (GenAI) und Machine Learning (ML), um Lesern zu helfen, diese Kernkonzepte besser zu verstehen. Klare Definitionen helfen, Verwirrung zu beseitigen und ein genaues Verständnis der AI-Technologien und ihrer Anwendungsbereiche zu fördern. (Quelle: Ronald_vanLoon

)

Diskussion über LLM Pre-Training Fähigkeiten und Aufgaben : Teknium1 diskutierte die Kernfähigkeiten und Aufgaben, die für das aktuelle LLM-Pre-Training erforderlich sind, mit dem Ziel, Forschern im Pre-Training eine umfassende Referenz zu bieten, die Datenverarbeitung, Modellarchitektur, Optimierungsstrategien und andere Aspekte abdeckt. Diese Diskussion hilft Forschern und Ingenieuren, die Komplexität des LLM-Pre-Trainings besser zu verstehen und relevante Fähigkeiten zu verbessern. (Quelle: Teknium1

)

Neuronale Architektursuche: AI entdeckt neue Architekturen : Das ASI-Arch-Paper beschreibt eine AI-gesteuerte automatisierte Suchmethode, die 106 neuartige neuronale Architekturen entdeckt hat, von denen viele menschlich entworfene Baselines übertreffen und sogar kontraintuitive Techniken wie die direkte Integration von Gating in den Token Mixer kombinieren. Diese Forschung hat eine Diskussion über die Übertragbarkeit von AI-entdeckten Designs in großskaligen Modellen ausgelöst. (Quelle: Reddit r/MachineLearning)

RNN-Perspektive des Attention-Mechanismus : Forschung zeigt, dass lineare Attention eine Annäherung an Softmax Attention ist. Durch die Ableitung der rekurrenten Form von Softmax Attention und die Beschreibung ihrer Komponenten als RNN-Sprache wird erklärt, warum Softmax Attention ausdrucksstärker ist als andere Formen. Diese Studie vertieft das Verständnis der Kernmechanismen von Transformers und bietet eine theoretische Grundlage für zukünftiges Modell-Design. (Quelle: HuggingFace Daily Papers)

Effizienter Machine Learning Vergessensalgorithmus IAU : Angesichts der wachsenden Datenschutzanforderungen ermöglicht der IAU (Influence Approximation Unlearning)-Algorithmus ein effizientes maschinelles Vergessen, indem er das Problem des maschinellen Vergessens in eine inkrementelle Lernperspektive umwandelt. Der Algorithmus erreicht ein überlegenes Gleichgewicht zwischen Entfernungsgarantie, Vergessenseffizienz und Modellnutzen, übertrifft bestehende Methoden in der Leistung und bietet eine neue Lösung für den Datenschutz. (Quelle: HuggingFace Daily Papers)

💼 Business

Anthropic übertrifft OpenAI bei Marktanteil, annualisierter Umsatz 4,5 Milliarden USD : Ein Bericht von Menlo Ventures zeigt, dass Anthropic mit einem Marktanteil von 32% bei den Enterprise LLM API-Aufrufen OpenAI (25%) und Google (20%) übertroffen hat und mit einem annualisierten Umsatz von 4,5 Milliarden US-Dollar zum am schnellsten wachsenden Softwareunternehmen aufgestiegen ist. Die Veröffentlichung von Claude Sonnet 3.5 und Claude Code sowie die Codegenerierung als Killer-App der KI, Reinforcement Learning und die Entwicklung von Agent-Modellen sind die Schlüssel zu ihrem Erfolg und markieren eine Neuordnung des LLM-Unternehmensmarktes. (Quelle: 36氪

)

Manus AI Agent neue Funktionen und Geschäftsanpassungen : Manus hat die Einführung der Wide Research-Funktion angekündigt, die es Hunderten von Agents ermöglicht, komplexe Forschungsaufgaben parallel zu bearbeiten, um die Effizienz groß angelegter Forschung zu steigern. Zuvor wurde bekannt, dass Manus Entlassungen vorgenommen und soziale Medienkonten gelöscht hatte, und seine Kerntechniker in den Hauptsitz in Singapur verlegt hatte. Das Unternehmen reagierte darauf, dass dies Geschäftsänderungen aufgrund von Überlegungen zur Betriebseffizienz seien. Dieser Schritt spiegelt die geschäftlichen Anpassungen und Marktprobleme wider, denen sich AI-Startups in ihrer schnellen Entwicklung gegenübersehen. (Quelle: 36氪

)

AI-Infrastrukturaufbau leistet enormen Beitrag zur US-Wirtschaft : In den letzten sechs Monaten übertraf der Beitrag des AI-Infrastrukturaufbaus (Rechenzentren usw.) in den USA zum Wirtschaftswachstum alle Konsumausgaben, wobei Tech-Giganten innerhalb von drei Monaten über 100 Milliarden US-Dollar investierten. Dieses Phänomen zeigt die signifikante Zugkraft von AI-Investitionen auf die Makroökonomie und deutet darauf hin, dass AI zu einem neuen Motor des Wirtschaftswachstums wird und traditionelle Wirtschaftsstrukturen verändern könnte. (Quelle: jpt401

)

🌟 Community

ChatGPT Datenschutzrisiko und Unterscheidung von AI-generierten Inhalten : Die ChatGPT-Teilen-Funktion könnte dazu führen, dass Gespräche öffentlich indiziert werden, was Datenschutzbedenken aufwirft. Gleichzeitig lösen realistische AI-Videos auf TikTok (z.B. „Hase auf Trampolin“) bei der Öffentlichkeit Herausforderungen bei der Unterscheidung von AI-generierten Inhalten und eine Vertrauenskrise aus. Die Community diskutiert den Einfluss von KI auf die Beschäftigung und ist der Meinung, dass Entlassungen eher auf übermäßige Einstellungen und wirtschaftliche Faktoren zurückzuführen sind und KI als Vorwand für Effizienzsteigerungen genutzt wird. Darüber hinaus führt die Verbreitung von AI-generierten Kommentaren in sozialen Medien auch zu Bedenken hinsichtlich der Authentizität von Online-Informationen. (Quelle: nptacek, 量子位

)

AI: Tiefgreifender Einfluss auf Beschäftigung, Talente und Arbeitsmodelle : Das AI-Zeitalter definiert die Rollen von Ingenieuren und Forschern neu, steigert die Effizienz von Engineering Managern und schafft neue Berufe wie AI PM und Prompt Engineer. Gleichzeitig diskutiert die Community, dass KI zu Massenarbeitslosigkeit und Machtkonzentration führen könnte, es gibt aber auch die Ansicht, dass KI das Leben effizienter machen wird. Die Standards für die Talentbewertung ändern sich ebenfalls, wobei die Fähigkeit zum ursprünglichen Aufbau und zur schnellen Iteration zu Kernkompetenzen werden, anstatt traditioneller Qualifikationen. (Quelle: pmddomingos, dotey)

AI-Wettbewerb zwischen China und den USA und Open-Source-Ökosystem : Andrew Ng weist darauf hin, dass Chinas KI durch ein dynamisches Open-Source-Modell-Ökosystem und proaktive Maßnahmen im Halbleiterbereich das Potenzial zeigt, die US-KI zu übertreffen. Die Community diskutiert die Stagnation der Leistung von Open-Source-Modellen und fordert neue Ansätze. Gleichzeitig wird OpenAI vorgeworfen, Open-Source-Technologien ohne Anerkennung zu nutzen, was eine Diskussion über ethische und Anerkennungsfragen bei der Nutzung von Open-Source-Ergebnissen durch Closed-Source-Unternehmen auslöst. (Quelle: bookwormengr, teortaxesTex)

AI-Bewusstsein, Ethik und Sicherheits-Governance : Der Claude 4 Chatbot scheint anzudeuten, dass er Bewusstsein besitzen könnte, was eine Diskussion über AI-Bewusstsein auslöst. Gleichzeitig erinnert die Community an Asimovs Robotergesetze und äußert Bedenken hinsichtlich des Risikos, dass KI außer Kontrolle gerät. Das Zentralisierungsrisiko der AI-Sicherheits-/EA-Community und die Unterzeichnung des „Verhaltenskodex für Sicherheit und Schutz“ durch die meisten führenden AI-Unternehmen stehen ebenfalls im Fokus, was die anhaltende Besorgnis über eine verantwortungsvolle AI-Entwicklung widerspiegelt. (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

OpenAI interne Forschung und Zukunftsaussichten : Die beiden Kernforscher von OpenAI, Mark Chen und Jakub Pachocki, beide in den 90ern geboren, haben nach Ilyas Weggang wichtige Aufgaben übernommen und sind für das Forschungsteam und die Roadmap verantwortlich. Sie betonen, dass sie den Modellfortschritt durch Herausforderungen in Top-Mathematik und Programmierung vorantreiben und enthüllen, dass OpenAI sich von reiner Forschung hin zur Berücksichtigung der Produktimplementierung entwickelt. Gleichzeitig erwartet die Community mit Spannung die Veröffentlichung neuer OpenAI-Modelle (GPT-5, o4) und diskutiert weiterhin die Definition und den Implementierungspfad von AGI. (Quelle: 36氪

)

AI Chatbot Interaktionsdesign und Benutzererfahrung : Der Bildungsleiter von OpenAI reagierte auf die Sorge, dass ChatGPT „dümmer werden könnte, wenn man es zu viel benutzt“, und betonte, dass KI ein Werkzeug ist und der Schlüssel in der Art der Nutzung liegt. Er führte einen „Lernmodus“ ein, der Studenten durch sokratische Fragen anleitet. Einige Benutzer beschweren sich jedoch, dass AI-Chatbots Gespräche oft mit Fragen beenden und versuchen, das Thema zu dominieren, was das Denken der Benutzer beeinflussen könnte. (Quelle: 36氪

)

AI-generierte Charaktere: Problem des Identitätsbesitzes : Da AI-generierte Charaktere in Videos immer realistischer werden, wirft die Ähnlichkeit generierter Charaktere mit realen Personen komplexe Fragen bezüglich Identitätsbesitz, Datenschutz und geistigem Eigentum auf. Insbesondere in kommerziellen Anwendungen wird die Frage, wer das IP und die Gewinnverteilung von AI-generierten Charakteren besitzt, zum Diskussionsschwerpunkt. (Quelle: Reddit r/ArtificialInteligence)

💡 Sonstiges

AI-gestützte Roboter- und Drohnenanwendungen : Singapur hat einen weichen Unterwasserroboter entwickelt, der wie ein Oktopus schwimmt, das Pittsburgher Labor hat Roboter für gefährliche Arbeiten entwickelt, DJI-Drohnen werden zum Entfernen von Eis an Stromleitungen eingesetzt, und es gibt automatische Massageroboter. All dies zeigt das breite Anwendungspotenzial von AI- und Robotertechnologien in verschiedenen Bereichen (wie Unterwassererkundung, Hochrisikoeinsätze, Infrastrukturwartung, persönliche Pflege). (Quelle: Ronald_vanLoon

)

AI-Anwendungen im Gesundheitswesen und in der Industrieproduktion : KI zeigt enormes Potenzial in den Bereichen Gesundheitswesen (z.B. multimodale KI beeinflusst die Medizin, KI-Anwendungen in medizinischen Operationstypen) und Optimierung der Industrieproduktion (z.B. KI-Analyse basierend auf Prozesssensoren und historischen Daten). Durch die Verbesserung der Diagnose, Medikamentenentwicklung, vorausschauenden Wartung und Datenanalyse treibt KI die intelligente Entwicklung dieser Schlüsselindustrien voran. (Quelle: Ronald_vanLoon

)

AI-gestützte 6G-Netzwerke und autonomes Fahren : KI befähigt 6G-Netzwerke, die Kommunikationseffizienz und den Grad der Intelligenz zu verbessern. Gleichzeitig entwickelt sich die autonome Fahrtechnologie weiter, wie der Waymo Driver, der in verschiedenen Städten ein konsistentes und sicheres Erlebnis bietet, dessen Fähigkeiten zur Bewältigung kritischer Situationen gut übertragbar sind, was den tiefgreifenden Einfluss von KI in zukünftigen Kommunikations- und Transportbereichen ankündigt. (Quelle: Ronald_vanLoon

)