Schlüsselwörter:KI, Meta, OpenAI, Anthropic, NVIDIA, LLM (Großes Sprachmodell), Humanoider Roboter, Persönliche Superintelligenz, ChatGPT-Lernmodus, Walker S2 autonomer Batteriewechsel, Qwen3-30B-A3B-Thinking-2507, AlphaEarth Foundations

🔥 Im Fokus

Meta veröffentlicht Vision einer persönlichen Superintelligenz : Mark Zuckerberg hat Metas Zukunftsvision einer “persönlichen Superintelligenz” geteilt und betont, dass jedem Einzelnen erstklassige AI-Assistenten, AI-Creator und AI-Tools für Unternehmensinteraktionen zur Verfügung gestellt werden sollen. Diese Vision zielt darauf ab, alle Nutzer durch AI zu befähigen und die Entwicklung von Open-Source-Modellen voranzutreiben. Dies hat jedoch auch Diskussionen in der Community über die Definition von “Superintelligenz” ausgelöst, wobei hinterfragt wird, ob dies einen unvorhersehbaren “Singularitätsmoment” mit sich bringen oder lediglich eine Erweiterung der virtuellen sozialen Interaktion sein wird. (Quelle: AIatMeta)

ACL 2025: Beste Paper bekannt gegeben : Die ACL (Association for Computational Linguistics) hat die besten Paper des Jahres 2025 bekannt gegeben. Dabei wurden “Native Sparse Attention” in Zusammenarbeit der Peking University, DeepSeek und der University of Washington sowie “Language Models Resist Alignment: Evidence from Data Compression” der Peking University ausgezeichnet. Bemerkenswert ist, dass über die Hälfte der Autoren chinesischer Herkunft sind. Darüber hinaus vergab die ACL die 25-Jahres- und 10-Jahres-Test-of-Time-Awards, die wegweisende Forschungsarbeiten würdigen, die einen tiefgreifenden Einfluss auf Bereiche wie neuronale maschinelle Übersetzung und semantische Rollenetikettierung hatten. (Quelle: karminski3)

Anthropic tritt Alignment-Projekt des britischen AI Safety Institute bei : Anthropic hat angekündigt, dem Alignment-Projekt des britischen AI Safety Institute beizutreten und Rechenressourcen zur Förderung wichtiger Forschung beizusteuern. Dieser Schritt zielt darauf ab, sicherzustellen, dass AI-Systeme mit zunehmender Leistungsfähigkeit vorhersehbar bleiben und menschlichen Werten entsprechen. Diese Zusammenarbeit unterstreicht die Bedeutung, die führende AI-Unternehmen der AI-Sicherheit und Alignment-Forschung beimessen, um den komplexen Herausforderungen zukünftiger AI-Systeme zu begegnen. (Quelle: AnthropicAI)

🎯 Entwicklungen

OpenAI führt ChatGPT ‘Lernmodus’ ein : OpenAI hat offiziell den ChatGPT “Lernmodus” gestartet, der darauf abzielt, Schüler durch sokratische Fragen, schrittweise Anleitungen und personalisierte Unterstützung zum eigenständigen Denken anzuregen, anstatt direkte Antworten zu geben. Der Modus ist bereits für alle ChatGPT-Nutzer verfügbar und wird zukünftig um Funktionen wie Visualisierung, Zielsetzung und Fortschrittsverfolgung erweitert. Dieser Schritt wird als wichtiger Vorstoß von OpenAI in den EdTech-Markt angesehen und hat eine breite Diskussion über die Rolle von AI in der Bildung sowie die potenziellen Auswirkungen von “Wrapper-Anwendungen” ausgelöst. (Quelle: 量子位, 36氪)

Ubtech Walker S2 Humanoid-Roboter erreicht autonomen Batteriewechsel : Das chinesische Unternehmen Ubtech Robotics hat seinen vollformatigen Industrie-Humanoid-Roboter Walker S2 vorgestellt und dabei das weltweit erste autonome Batteriewechselsystem demonstriert. Walker S2 kann den Batteriewechsel innerhalb von 3 Minuten reibungslos durchführen, ermöglicht einen 24/7-Dauerbetrieb und steigert die Effizienz von Industriearbeiten erheblich. Der Roboter verfügt über ein AI-Doppelkreislaufsystem, reine RGB-Stereo-Vision und 52 Freiheitsgrade. Er ist für hochintensive Aufgaben wie die Automobilfertigung konzipiert und hat Diskussionen über den Ersatz menschlicher Arbeit durch Roboter und zukünftige Arbeitsmodelle ausgelöst. (Quelle: 量子位, Ronald_vanLoon)

Qwen-Modellreihe: Kontinuierliche Updates und Leistungssteigerung : Das Qwen-Team hat kürzlich das mittelgroße Modell Qwen3-30B-A3B-Thinking-2507 veröffentlicht. Dieses Modell verfügt über “Denkfähigkeiten”, zeigt hervorragende Leistungen bei Inferenz-, Code- und Mathematikaufgaben und unterstützt einen langen Kontext von 256K. Gleichzeitig steht die Veröffentlichung von Qwen3 Coder 30B-A3B bevor, was die Code-Generierungsfähigkeiten weiter verbessern wird. Diese Updates festigen die Wettbewerbsfähigkeit der Qwen-Reihe im LLM-Bereich und wurden bereits in Tools wie Anycoder integriert. (Quelle: Alibaba_Qwen, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Google DeepMind: Fortschritte bei KI-Modellen für Erde und Geschichte : Google DeepMind hat AlphaEarth Foundations vorgestellt, das darauf abzielt, die Erde mit erstaunlicher Detailgenauigkeit abzubilden und riesige Mengen geografischer Daten zu vereinheitlichen. Gleichzeitig hilft das Aeneas-Modell Historikern, Geschichte quantitativ zu modellieren, indem es alte lateinische Texte mittels AI analysiert. Diese Modelle demonstrieren das große Anwendungspotenzial von AI in den Bereichen Umweltüberwachung und geisteswissenschaftliche Geschichtsforschung. (Quelle: GoogleDeepMind, GoogleDeepMind)

Arcee veröffentlicht Open-Weight-Modell AFM-4.5B : Arcee hat offiziell AFM-4.5B und seine Basisversion veröffentlicht, ein Open-Weight-Sprachmodell, das für Unternehmensanwendungen entwickelt wurde. AFM-4.5B zielt darauf ab, flexible und hochleistungsfähige Lösungen für verschiedene Bereitstellungsumgebungen zu bieten. Seine Trainingsdaten wurden streng gefiltert, um eine hohe Ausgabequalität zu gewährleisten. Die Veröffentlichung dieses Modells bietet Unternehmen weitere fortschrittliche Open-Source-AI-Optionen, um ihre Anforderungen beim Aufbau und der Bereitstellung von AI-Anwendungen zu erfüllen. (Quelle: code_star, stablequan)

GLM-4.5-Modell zeigt starke Leistung bei EQ-Bench und Langtext-Generierung : Das GLM-4.5-Modell von Z.ai hat bei den EQ-Bench- und Langtext-Generierungs-Benchmarks sehr gute Ergebnisse erzielt und seine kombinierten Stärken in Inferenz, Codierung und Agentenfunktionen demonstriert. Das Modell ist in zwei Versionen, GLM-4.5 und GLM-4.5-Air, verfügbar und auf HuggingFace zugänglich, wobei einige Versionen sogar kostenlos getestet werden können. Seine starke Leistung und die Fähigkeit, anspruchsvolle Prompts schnell zu verarbeiten, deuten auf sein Potenzial in komplexen Anwendungsszenarien hin. (Quelle: Zai_org, jon_durbin)

Mistral AI veröffentlicht Codestral 25.08 : Mistral AI hat das neueste Modell Codestral 25.08 veröffentlicht und einen vollständigen Mistral-Coding-Stack für Unternehmen eingeführt. Dieser Schritt zielt darauf ab, Unternehmen leistungsfähigere Code-Generierungsfähigkeiten und umfassendere Entwicklungstools zu bieten, um die Marktposition von Mistral AI im Bereich der AI-Programmierung weiter zu festigen. (Quelle: MistralAI)

NVIDIA: Signifikantes Wachstum bei Modellen/Datensätzen/Anwendungen auf Hugging Face : Daten von AI World zeigen, dass NVIDIA in den letzten 12 Monaten 365 neue öffentliche Modelle, Datensätze und Anwendungen auf Hugging Face hinzugefügt hat, durchschnittlich eines pro Tag. Diese beeindruckende Wachstumsrate zeigt, dass NVIDIA nicht nur im Hardwarebereich eine dominierende Stellung einnimmt, sondern auch im Open-Source-AI-Ökosystem starken Einfluss ausübt und die Verbreitung und Anwendung von AI-Technologien aktiv vorantreibt. (Quelle: ClementDelangue)

Llama: Inferenzgeschwindigkeit um 5% erhöht : Ein neuer Fast Attention-Algorithmus hat die Geschwindigkeit der SoftMax-Funktion um etwa 30% erhöht, wodurch die Inferenzzeit von Meta LLMs auf A100 GPUs um 5% verkürzt wurde. Diese Optimierung dürfte die Betriebseffizienz von LLMs steigern, die Inferenzkosten senken und ist von großer Bedeutung für den großflächigen Einsatz und Echtzeitanwendungen. (Quelle: Reddit r/LocalLLaMA)

Skywork-UniPic-1.5B: Einheitliches autoregressives multimodales Modell veröffentlicht : Skywork hat Skywork-UniPic-1.5B veröffentlicht, ein einheitliches autoregressives multimodales Modell. Dieses Modell kann Daten verschiedener Modalitäten verarbeiten und bietet eine neue Grundlage für die multimodale AI-Forschung und -Anwendung. (Quelle: Reddit r/LocalLLaMA)

Google führt KI-Funktion für virtuelle Anprobe ein : Google hat eine neue AI-Funktion eingeführt, die es Nutzern ermöglicht, Kleidung online virtuell anzuprobieren. Diese Technologie nutzt generative AI-Fähigkeiten, um Verbrauchern ein intuitiveres, personalisiertes Einkaufserlebnis zu bieten, was voraussichtlich die Retourenquote senken und die E-Commerce-Konversionsrate steigern wird. (Quelle: Ronald_vanLoon)

LimX Dynamics veröffentlicht Humanoid-Roboter Oli : LimX Dynamics hat offiziell den neuen Humanoid-Roboter Oli vorgestellt, dessen Preis bei etwa 22.000 US-Dollar liegt. Oli ist 5‘5” groß, wiegt 55 kg, verfügt über 31 Freiheitsgrade und ist mit einem selbst entwickelten 6-Achsen-IMU ausgestattet. Er unterstützt ein modulares SDK und eine vollständig offene Python-Entwicklungsschnittstelle, bietet eine flexible Plattform für Forschung und Entwicklung und dürfte den Einsatz von Humanoid-Robotern in weiteren Szenarien vorantreiben. (Quelle: teortaxesTex)

🧰 Tools

LangSmith führt ‘Align Evals’-Funktion ein : LangSmith hat die neue Align Evals-Funktion eingeführt, die darauf abzielt, den Erstellungsprozess von LLM-as-a-Judge-Evaluatoren zu vereinfachen. Diese Funktion hilft Nutzern, LLM-Bewertungen mit menschlichen Präferenzen abzugleichen, um genauere und vertrauenswürdigere Evaluatoren zu erstellen und die Unsicherheit bei der Evaluierungsarbeit zu reduzieren. (Quelle: hwchase17)

NotebookLM: Neue Video-Übersichtsfunktion : Googles NotebookLM hat eine Video-Übersichtsfunktion eingeführt, mit der Nutzer visuell ansprechende Folienzusammenfassungen für ihre Notizinhalte erstellen können. Die Funktion nutzt das Gemini-Modell zur Generierung von Textpräsentationen und kombiniert interne Tools zur Erstellung statischer Bilder und separater Audios, um schließlich Videos zu synthetisieren, die Nutzern reichhaltigere Lern- und Inhaltspräsentationsmöglichkeiten bieten. (Quelle: JeffDean, cto_junior)

Qdrant Cloud Inference und LLM-Datenverarbeitung : Qdrant Cloud Inference ermöglicht Nutzern, Text, Bilder und Sparse-Vektoren nativ einzubetten, ohne die Vektordatenbank zu verlassen, und unterstützt Modelle wie BGE, MiniLM, CLIP und SPLADE. Darüber hinaus wurde in der Community die Funktion diskutiert, dass LLMs URLs direkt als Informationsquellen zitieren können, sowie die Möglichkeit, dass LLMs URL-Inhalte regelmäßig überprüfen, cachen und aktualisieren, um die Vertrauenswürdigkeit und Praktikabilität von AI zu verbessern. (Quelle: qdrant_engine, Reddit r/OpenWebUI)

Replit Agent unterstützt bei der Erstellung von Echtzeit-Dashboards : Der Replit Agent wurde eingesetzt, um schnell zugängliche Echtzeit-Dashboards zu erstellen, um das Problem unübersichtlicher Informationen auf traditionellen Tsunami-Warn-Websites zu lösen. Dieser Fall demonstriert das Potenzial von AI-Agenten in der Datenvisualisierung und im UI-Design, komplexe Daten in leicht verständliche, interaktive Oberflächen umzuwandeln. (Quelle: amasad)

Hugging Face ML-Infrastruktur-Tools : Hugging Face und Gradio haben gemeinsam trackio vorgestellt, eine Local-First-Lösung für das Tracking von Machine-Learning-Experimenten, die es Nutzern ermöglicht, wichtige Metriken in Hugging Face Datasets zu persistieren. Gleichzeitig hat Hugging Face “Hugging Face Jobs” eingeführt, einen vollständig verwalteten Dienst zum Ausführen von CPU- und GPU-Aufgaben, der die Ausführung von ML-Aufgaben vereinfacht und es Nutzern ermöglicht, sich stärker auf die Modellentwicklung zu konzentrieren. (Quelle: algo_diver, reach_vb)

KI-Vertikalbereiche und Workflow-Automatisierungsagenten : SciSpace Agent, ein spezieller AI-Assistent für Wissenschaftler, integriert Funktionen für Zitationen, Literaturrecherche, PDF-Lesen und AI-Schreiben, um die Forschungseffizienz erheblich zu steigern. LlamaCloud Nodes hat auch n8n-Workflows integriert, was die Automatisierung der Dokumentenverarbeitung vereinfacht. Mithilfe des Llama Extract-Agenten werden Schlüsseldaten extrahiert, um die automatisierte Extraktion strukturierter Daten aus Finanzdokumenten, Kundenkommunikation usw. zu ermöglichen. (Quelle: TheTuringPost, jerryjliu0)

AutoRL: Aufgaben-spezifische LLMs durch RL trainieren : Matt Shumer hat AutoRL vorgestellt, eine einfache Methode zum Trainieren aufgabenspezifischer LLMs mittels Reinforcement Learning. Nutzer müssen das gewünschte Modell lediglich in einem Satz beschreiben, und das AI-System kann Daten und Bewertungskriterien generieren sowie das Modell trainieren. Dieses Open-Source-Tool basiert auf ART und dürfte die Entwicklungsschwelle für maßgeschneiderte LLMs senken. (Quelle: corbtt)

ccflare: Power-Tools für fortgeschrittene Claude Code-Nutzer : ccflare ist eine leistungsstarke Tool-Sammlung, die für fortgeschrittene Claude Code-Nutzer entwickelt wurde und Funktionen wie Analyse-Tracking, Lastausgleich und Wechsel zwischen mehreren Claude-Abonnementkonten, detaillierte Anforderungsanalyse sowie die Einstellung von Modellen für Sub-Agenten bietet. Das Tool zielt darauf ab, die Nutzungseffizienz und Kontrollierbarkeit von Claude Code zu verbessern und Entwicklern zu helfen, ihre AI-Programmier-Workflows besser zu verwalten und zu optimieren. (Quelle: Reddit r/ClaudeAI)

📚 Lernen

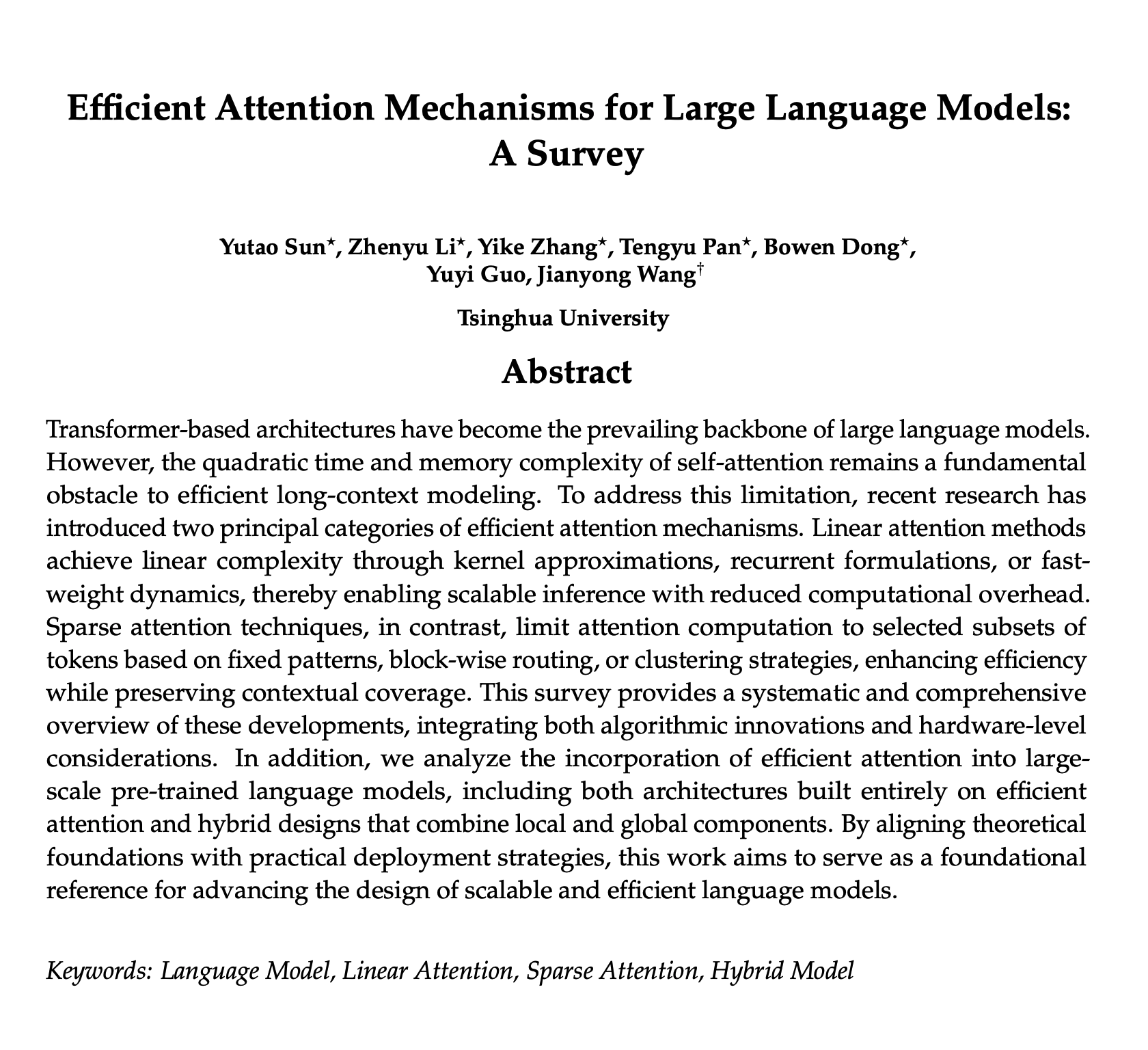

Übersicht über effiziente Aufmerksamkeitsmechanismen in LLMs : Eine aktuelle Übersicht über effiziente Aufmerksamkeitsmechanismen in LLMs wurde geteilt und gilt als hervorragende Ressource, um neue Ideen und zukünftige Trends zu verstehen. Die Übersicht behandelt verschiedene Methoden zur Optimierung der Aufmerksamkeitsberechnung und ist von großem Referenzwert für Forscher und Entwickler, die die Effizienz und Leistung von LLMs verbessern möchten. (Quelle: omarsar0)

GEPA: Reflektive Prompt-Evolution übertrifft Reinforcement Learning : Eine Forschungsarbeit stellt GEPA (Reflective Prompt Evolution) vor, eine Methode zur reflektiven Prompt-Optimierung, die bei geringem Bereitstellungsbudget durch reflexive Prompt-Evolution herkömmliche Reinforcement Learning-Algorithmen in der Leistung übertrifft. Diese Studie bietet neue Ansätze, um AI-Modellen eine RL-ähnliche Leistungssteigerung bei spezifischen Aufgaben zu ermöglichen, insbesondere im Bereich der synthetischen Datengenerierung. (Quelle: teortaxesTex, stanfordnlp)

Verständnis der LLM-Erklärbarkeitsmetrik XPLAIN : Eine neue Metrik namens “XPLAIN” wurde vorgeschlagen, um die Erklärbarkeit von Black-Box-LLMs zu quantifizieren. Die Methode nutzt die Kosinus-Ähnlichkeit, um Wort-für-Wort-Wichtigkeitswerte zu berechnen, die aufzeigen, wie LLMs Eingabesätze interpretieren und welche Wörter den größten Einfluss auf die Ausgabe haben. Die Studie zielt darauf ab, das Verständnis der internen Mechanismen von LLMs zu verbessern, und Code sowie Paper wurden der Community zur Referenz zur Verfügung gestellt. (Quelle: Reddit r/MachineLearning)

MoHoBench: Bewertung der Ehrlichkeit multimodaler großer Modelle : MoHoBench ist der erste Benchmark zur systematischen Bewertung des ehrlichen Verhaltens von multimodalen Large Language Models (MLLMs), indem er deren Ehrlichkeit anhand der Reaktion auf visuell unbeantwortbare Fragen misst. Der Benchmark umfasst über 12.000 visuelle Frage-Antwort-Beispiele und zeigt, dass die meisten MLLMs es versäumen, bei Bedarf die Antwort zu verweigern, und dass ihre Ehrlichkeit stark von visuellen Informationen beeinflusst wird. Dies fordert die Entwicklung spezialisierter multimodaler Alignment-Methoden für Ehrlichkeit. (Quelle: HuggingFace Daily Papers)

Hierarchical Reasoning Model (HRM) erzielt Durchbruch in ARC-AGI : Das Hierarchical Reasoning Model (HRM) hat bei ARC-AGI-Aufgaben bemerkenswerte Fortschritte erzielt und erreichte mit nur 1.000 Beispielen und geringen Rechenressourcen eine Genauigkeit von 25%, was sein großes Potenzial für komplexe Inferenzaufgaben zeigt. Das Modell ist von den hierarchischen Verarbeitungsmechanismen des Gehirns inspiriert und dürfte Durchbrüche in der Inferenzfähigkeit allgemeiner AI-Systeme vorantreiben. (Quelle: VictorTaelin)

ACL 2025: Paper zur LLM-Evaluierung : Ein Paper auf der ACL 2025 zeigte, wie man beurteilt, ob ein Sprachmodell besser ist als ein anderes, und betonte die Bedeutung der Evaluierung bei der Entwicklung von LLM-Anwendungen. Die Studie zielt darauf ab, effektivere Methoden zum Vergleich und zur Auswahl von LLMs bereitzustellen, um Entwicklern zu helfen, blinde Versuche ohne tatsächlichen Fortschritt zu vermeiden. (Quelle: gneubig, charles_irl)

Verständnis der Entstehung von ‘Soft Preferences’ in LLMs : Ein neues Paper untersucht, wie robuste und universelle “Soft Preferences” in der menschlichen Sprachproduktion aus Strategien zur Minimierung einer autoregressiven Gedächtniskostenfunktion entstehen. Diese Forschung vertieft das Verständnis der subtilen menschlichen Merkmale in von LLMs generierten Texten und bietet eine neue Perspektive auf die Verhaltensmechanismen von LLMs. (Quelle: stanfordnlp)

Definition von LLM Agenten : Harrison Chase, Gründer von LangChain, teilte seine Definition von AI-Agenten und betonte, dass der “Agentic”-Grad eines AI-Agenten davon abhängt, inwieweit das LLM autonom die nächsten Schritte entscheidet. Diese Ansicht hilft, das Konzept von AI-Agenten zu klären und Entwickler bei der Messung der Autonomie beim Aufbau von Agenten-Systemen zu leiten. (Quelle: hwchase17)

💼 Business

Anthropic-Bewertung schnellt auf 170 Milliarden US-Dollar : Anthropic, das Unternehmen hinter Claude, verhandelt derzeit über eine neue Finanzierungsrunde von bis zu 5 Milliarden US-Dollar, wobei die Bewertung voraussichtlich 170 Milliarden US-Dollar erreichen wird, was es nach OpenAI zum zweiten AI-Einhorn mit einer Bewertung im dreistelligen Milliardenbereich macht. Diese Finanzierungsrunde wird von Iconiq Capital angeführt und könnte die Beteiligung von Qatar Investment Authority, dem singapurischen Staatsfonds GIC und Amazon anziehen. Anthropics Einnahmen stammen hauptsächlich aus API-Aufrufen, wobei das Unternehmen insbesondere im Bereich der AI-Programmierung stark performt und einen annualisierten Umsatz von 4 Milliarden US-Dollar erreicht hat. (Quelle: 36氪, 36氪)

Surge AI erzielt 1 Milliarde US-Dollar Umsatz mit hochwertigen Daten : Das vom chinesischen Gründer Edwin Chen gegründete Unternehmen Surge AI hat mit einem 120-köpfigen Team einen Jahresumsatz von über 1 Milliarde US-Dollar erzielt, ohne externe Finanzierung oder ein Vertriebsteam, und übertrifft damit die Effizienz der Konkurrenz bei Weitem. Das Unternehmen konzentriert sich auf die Bereitstellung hochwertiger menschlicher Feedback-Daten (RLHF). Sein Elite-Annotierungsnetzwerk “Surge Force” gewährleistet mit strengen Standards und professionellem Hintergrund (z.B. MIT-Mathematikdoktoranden) die Datengenauigkeit und ist zum bevorzugten Anbieter für Top-AI-Labore wie OpenAI und Anthropic geworden. Es plant zudem, eine erste Finanzierungsrunde von 1 Milliarde US-Dollar zu starten, mit einer potenziellen Bewertung von 15 Milliarden US-Dollar. (Quelle: 36氪)

Nvidia: Rechenzentrum-Umsatz innerhalb von zwei Jahren verzehnfacht : Nvidias Rechenzentrum-Umsatz hat sich in den letzten zwei Jahren verzehnfacht und wird voraussichtlich nach der Freigabe des H20-Chips weiterhin eine starke Wachstumsdynamik beibehalten. Dieses Wachstum ist hauptsächlich auf die enorme Nachfrage nach GPU-Rechenleistung durch große AI-Modelle zurückzuführen und festigt Nvidias Führungsposition im AI-Hardwaremarkt. (Quelle: Reddit r/artificial)

🌟 Community

Diskussion über die Wirksamkeit von Rollenspielen in AI-Prompts : In der Community wird die tatsächliche Wirksamkeit von Rollenspielen in Prompts für große Modelle heiß diskutiert. Es wird allgemein angenommen, dass sie die AI effektiv auf bestimmte Aufgaben lenken und die Ausgabequalität verbessern können, indem sie die Wahrscheinlichkeitsverteilung auf hochwertige Daten ausrichten. Es gibt jedoch auch die Ansicht, dass sowohl übermäßige Abhängigkeit als auch die vollständige Ablehnung von Rollenspielen Formalismus darstellen; entscheidend sei das Verständnis der AI-Aufgabenanforderungen. (Quelle: dotey)

KI-Codierung: Kontroverse um Code-Menge und -Qualität : In den sozialen Medien wird die Effizienz von AI-gestützten Codierungstools und die Frage der Code-Qualität heiß diskutiert. Einige Nutzer berichten, dass AI schnell Zehntausende von Codezeilen generieren kann, äußern aber gleichzeitig Bedenken hinsichtlich der Wartbarkeit und der Architekturauswahl. Die Diskussionen zeigen, dass AI-generierter Code möglicherweise umfangreiche manuelle Überprüfung und Modifikation erfordert, anstatt “gedankenlos generiert” zu werden. Dies unterstreicht die Herausforderungen, die der Rollenwandel der AI in der Softwareentwicklung mit sich bringt. (Quelle: vikhyatk, dotey, Reddit r/ClaudeAI)

Meta KI-Strategie und Talentkampf lösen hitzige Community-Diskussionen aus : Meta hat in letzter Zeit zahlreiche Aktivitäten im AI-Bereich gezeigt: Die von CEO Zuckerberg vorgestellte Vision einer “persönlichen Superintelligenz”, Abwerbeangebote von bis zu 1 Milliarde US-Dollar für Top-AI-Talente (einschließlich Mitarbeitern von Mira Muratis Startup) sowie “vorsichtige” Äußerungen zur Open-Source-Strategie zukünftiger Top-Modelle haben in der Community breite Diskussionen ausgelöst. Diese Schritte werden als Ausdruck von Metas Ambitionen im AI-Bereich interpretiert, sind aber auch mit Bedenken hinsichtlich des AI-Talentmarktes, der technischen Ethik und des Open-Source-Gedankens verbunden. (Quelle: dotey, teortaxesTex, joannejang, tokenbender, amasad)

KI-Anwendungen in der Bildung und ethische Herausforderungen : Obwohl OpenAI den ChatGPT-Lernmodus eingeführt hat, um Schüler zum Nachdenken anzuregen, äußert die Community allgemeine Bedenken hinsichtlich ethischer Fragen in der Bildung, wie Betrugsrisiken und eine Abnahme der Fähigkeit zum kritischen Denken. Die Diskussionen zeigen, dass der Einsatz von AI in der Bildung Innovation und akademische Integrität ausbalancieren muss, und es wird erörtert, wie diesen Herausforderungen durch tiefere personalisierte Lehrmethoden und die Gestaltung von Lehrplänen begegnet werden kann. (Quelle: 36氪, Reddit r/artificial, Reddit r/ArtificialInteligence)

KI-Modell-Halluzinationen und Herausforderungen der Inhaltsauthentizität : In den sozialen Medien wird das “Halluzinations”-Phänomen von AI-generierten Inhalten und dessen Einfluss auf die Informationsauthentizität breit diskutiert. Nutzer stellen fest, dass AI scheinbar professionelle, aber logisch inkonsistente oder falsche Informationen generieren kann, insbesondere im Bereich der Bild- und Videoerstellung, wo Wahrheit und Fälschung schwer zu unterscheiden sind. Dies führt zu einer Vertrauenskrise in AI-Tools und regt zum Nachdenken darüber an, wie die menschliche Urteilsfähigkeit und das kritische Denken bewahrt und eine übermäßige Abhängigkeit von Algorithmen vermieden werden können. (Quelle: 36氪, teortaxesTex, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/artificial)

KI: Doppelte Auswirkungen auf sozioökonomische Aspekte und individuelle Kreativität : In der Community gibt es eine polarisierte Diskussion über die sozioökonomischen Auswirkungen von AI. Einerseits äußern CEOs öffentlich, dass AI “die Arbeit, wie wir sie kennen, beenden” wird, was Bedenken hinsichtlich des Verlusts von Arbeitsplätzen auslöst; andererseits teilen Nutzer, wie AI Einzelpersonen befähigt, auch ohne Budget und technische Fähigkeiten ihre Startup-Ideen umzusetzen, und sehen AI als “großen Equalizer”, der die individuelle Kreativität befreit. (Quelle: Reddit r/artificial, Reddit r/ArtificialInteligence)

Sicherheitsdebatte: Open-Source vs. Closed-Source KI : In der Community wird eine heftige Debatte über die Sicherheit von Open-Source- und Closed-Source-AI-Modellen geführt. Einige Meinungen besagen, dass die Bereitstellung von Modellen hinter APIs oder Chatbots potenziell riskanter sein könnte als die Veröffentlichung von Open-Weight-Modellen, da dies die Hemmschwelle für missbräuchliche Nutzung senkt. Die Debatte fordert eine Neubewertung der These “Open Weight ist unsicher” und betont, dass AI-Sicherheit über die einfache technische Offenheit hinausgehen sollte. (Quelle: bookwormengr)

Erörterung der emotionalen Verbindung zwischen KI und Mensch : In den sozialen Medien gehen die Meinungen über den Aufbau emotionaler Verbindungen zu AI auseinander. Einige Nutzer sind der Meinung, dass eine Beziehung zu AI eine persönliche Entscheidung ist, solange sie das normale Leben nicht beeinträchtigt; andere befürchten, dass eine übermäßige Abhängigkeit von AI-Begleitung die Geduld für echte menschliche Beziehungen verringern könnte und lösen tiefere Überlegungen zu Ethik und psychologischen Auswirkungen von AI-Partnern aus. (Quelle: Reddit r/ChatGPT, ClementDelangue)

💡 Sonstiges

Ungleichmäßige globale KI-Entwicklung und geopolitische Auswirkungen : Der stellvertretende UN-Generalsekretär forderte die Überbrückung der “AI-Kluft” und wies darauf hin, dass die AI-Entwicklungskapazitäten in wenigen Ländern und Unternehmen konzentriert sind, was zu technologischen und Governance-Ungleichheiten führt. Experten betonen, dass AI menschliche Fähigkeiten erweitern und nicht ersetzen sollte, und dass flexible Governance-Mechanismen etabliert werden müssen, um Kategorienunterschiede zwischen Technikern und Nicht-Technikern zu vermeiden. Darüber hinaus ist der geopolitische Wettbewerb um AI, wie der US-chinesische AGI-Wettlauf, ebenfalls zu einem internationalen Schwerpunkt geworden. (Quelle: 36氪, teortaxesTex)

KI-Urheberrechtskrieg: Konflikt zwischen Vorstellungskraft und Maschinen : Großbritannien erlebt derzeit eine Debatte über das AI-Urheberrecht. Die Kernfrage ist, ob AI-Technologieunternehmen menschlich geschaffene Inhalte ohne Genehmigung und Bezahlung für das Training und das Generieren von “verbesserten” Inhalten scrapen dürfen. Diese Debatte konzentriert sich auf die Urheberrechtszuordnung kreativer Werke im AI-Zeitalter und den Schutz der Rechte von Urhebern, was den Konflikt zwischen technologischer Entwicklung und bestehenden rechtlichen Rahmenbedingungen widerspiegelt. (Quelle: Reddit r/artificial)

Ethische Bedenken durch KI-Anwendungen der FDA : Berichten zufolge könnte die AI der US-amerikanischen FDA im Medikamentenzulassungsprozess “Studien erfinden”, was ethische und Genauigkeitsbedenken hinsichtlich des Einsatzes von AI im Gesundheitswesen auslöst. Dies unterstreicht die Herausforderungen in Bezug auf Datenauthentizität und Transparenz bei AI-gestützten Entscheidungssystemen, insbesondere in Hochrisikobereichen, sowie die Frage, wie sichergestellt werden kann, dass AI-Entscheidungen ethischen und regulatorischen Standards entsprechen. (Quelle: Ronald_vanLoon)