Schlüsselwörter:KI-Gedächtnis, Open-Source-Modell, KI-Agent, Multimodal, Neuronales Netzwerk, KI-Videogenerierung, Medizin-KI, Autonomes Fahren, MIRIX Multimodales Gedächtnissystem, Llama Nemotron Super v1.5 Inferenzmodell, Qwen3-30B-A3B-Instruct-2507 MoE-Architektur, SciMaster Universeller Wissenschafts-KI-Agent, Tesla FSD-Chip HW5.0

Gerne, hier ist die Übersetzung der AI-Nachrichten in die deutsche Sprache, unter Berücksichtigung Ihrer Anforderungen:

🔥 Fokus

Weltweit erstmals: AI-Gedächtnis als Open Source implementiert, MIRIX gleichzeitig als App veröffentlicht : Forschende der University of California San Diego und der New York University haben MIRIX, das weltweit erste multimodale, Multi-Agenten-AI-Gedächtnissystem, gemeinsam veröffentlicht und als Open Source zugänglich gemacht. Dieses System integriert erstmals ein „multimodales Langzeitgedächtnis“ in das zugrunde liegende AI-Betriebssystem. Es ermöglicht tiefgreifendes Verständnis und Langzeitverfolgung durch sechs Gedächtnismodule und einen Multi-Agenten-Workflow. In den Aufgaben ScreenshotVQA und LOCOMO (lange Dialoge) übertrifft MIRIX herkömmliche RAG- und Langtextmethoden bei Weitem. Gleichzeitig wurde eine Desktop-App veröffentlicht, die lokale Speicherung unterstützt und darauf abzielt, Nutzern einen personalisierten AI-Assistenten zu bieten. (Quelle: 36氪)

NVIDIAs neues Open-Source-Modell: dreifacher Durchsatz, auf einer einzelnen Karte lauffähig und erreicht State-of-the-Art (SOTA) bei der Inferenz : NVIDIA hat Llama Nemotron Super v1.5 vorgestellt, ein Open-Source-Modell, das speziell für komplexe Inferenz- und Agentenaufgaben entwickelt wurde. Das Modell wurde durch Neuronale Architektursuche (NAS) optimiert und erzielt SOTA-Leistung in wissenschaftlichen, mathematischen, Programmier- und Agentenaufgaben. Gleichzeitig verdreifacht es den Durchsatz im Vergleich zum Vorgänger und kann effizient auf einer einzelnen Karte ausgeführt werden, was hohe Genauigkeit, hohen Durchsatz und geringen Ressourcenverbrauch ermöglicht. Es ist Teil des NVIDIA Nemotron-Ökosystems und zielt darauf ab, leistungsstarke, hochgradig kontrollierbare und leicht skalierbare Lösungen für die Entwicklung von AI-Anwendungen auf Unternehmensebene bereitzustellen. (Quelle: 量子位)

Qwen3-30B-A3B-Instruct-2507 Modell veröffentlicht : Das Alibaba Cloud Qwen-Team hat das Modell Qwen3-30B-A3B-Instruct-2507 veröffentlicht. Dieses Modell basiert auf der MoE-Architektur (Mixture-of-Experts) mit nur 3 Milliarden aktiven Parametern, zeigt aber eine signifikant verbesserte Leistung. Besonders hervorzuheben sind seine herausragenden Ergebnisse im mathematischen Schlussfolgern (AIME25 von 21,4 auf 61,3 verbessert) und im Verständnis langer Kontexte (256K Tokens), zudem unterstützt es die lokale Bereitstellung. Seine Leistung nähert sich der von GPT-4o und Qwen3-235B-A22B im Nicht-Denkmodus an und wird als wichtiger Fortschritt im Open-Source-Bereich angesehen. GGUF- und MLX-quantisierte Versionen sind bereits auf Hugging Face verfügbar und stoßen in der Community auf breites Interesse. (Quelle: Reddit r/LocalLLaMA)

SciMaster: Weltweit erster universeller Wissenschafts-Agent : Die Shanghai Jiao Tong University und DeepMotion AI haben SciMaster gemeinsam veröffentlicht und als Open Source zugänglich gemacht, mit dem Ziel, ein expertenbasiertes Forschungsassistenzsystem für jedermann zu werden. Dieser universelle Wissenschafts-Agent kombiniert Ressourcen aus dem gesamten Internet und 170 Millionen wissenschaftliche Publikationen, um expertenbasierte, tiefgehende Recherchefähigkeiten zu bieten. Er unterstützt verschiedene Suchmethoden wie WebSearch, WebParse und PaperSearch und kann Informationen automatisch korrigieren und ergänzen. SciMaster integriert zudem eine Vielzahl wissenschaftsspezifischer Tools, die aktiv und automatisch aufgerufen werden können, mit dem Ziel, das Forschungsparadigma an Universitäten neu zu gestalten und die Entwicklung im Bereich AI4S voranzutreiben. (Quelle: 量子位)

🎯 Trends

Fortschritte bei chinesischen AI-Videomodellen im „Drei-Königreiche-Kampf“ : Im Bereich der AI-Videogenerierung in China entbrennt ein intensiver Wettbewerb zwischen Kuaishou Keling AI, Shengshu Technology Vidu und ByteDance Jiemeng AI. Keling AI zeichnet sich durch starke Ausdruckskraft aus und eignet sich für dramatische Inhalte; Vidu ist bekannt für seine realistische Detailtreue und seine Fähigkeit, physikalische Gesetze zu simulieren; Jiemeng AI überzeugt durch ausgewogene Kontrolle und umfassende Tool-Eigenschaften. Alle drei haben Durchbrüche bei Konsistenzproblemen erzielt, wobei ihre technologischen Ansätze unterschiedliche Schwerpunkte haben. Keling und Jiemeng werden aufgrund ihres Potenzials auf Anwendungs- und Ökosystemebene als stärkere Anwärter auf den letztendlichen Sieg angesehen. (Quelle: 36氪)

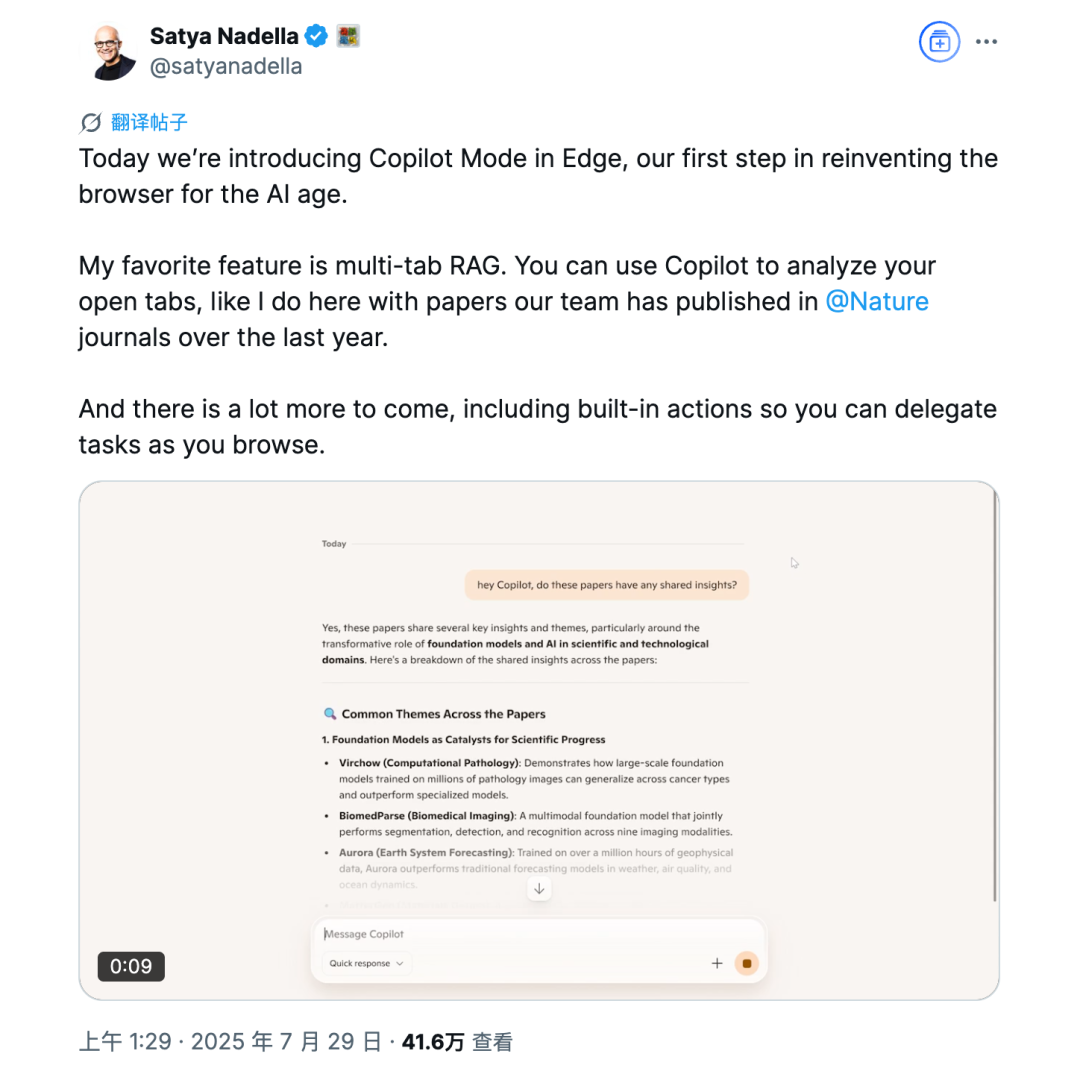

Microsoft Edge Browser führt Copilot-Modus ein : Der Microsoft Edge Browser tritt offiziell in den Markt der AI-Browser ein und führt den Copilot-Modus ein. Dieser kann Webinhalte lesen und verstehen, YouTube-Videos zusammenfassen, Produktinformationen aus mehreren Tabs vergleichen und unterstützt Sprachinteraktion. Der Modus befindet sich noch in der Experimentierphase und bietet kostenlose Funktionen ähnlich ChatGPT DeepResearch, mit dem Ziel, den Browser in ein intelligenteres Hilfswerkzeug zu verwandeln. Seine Funktionen unterscheiden sich jedoch kaum von bestehenden AI-Browsern, und er steht vor Herausforderungen bezüglich Nutzerdatenschutz und Akzeptanz. (Quelle: 36氪)

Medizinische AI erlebt systematische Ermächtigung und Spezialisierung : Die WAIC 2025 (World Artificial Intelligence Conference) zeigt, dass die medizinische AI „wieder auf dem Vormarsch“ ist, wobei große Unternehmen und Start-ups in den Markt eintreten. AI entwickelt sich von der Lösung spezifischer „Knotenpunkte“ hin zur Ermächtigung ganzer „Prozessschritte“, indem sie durch Agenten ein umfassendes Gesundheitsmanagement und Diagnoseunterstützung ermöglicht, wie zum Beispiel Tencents „Gesundheitsmanagement-Assistent“. Gleichzeitig entwickelt sich AI von allgemeinen Modellen zu vertikalen Spezialmodellen, um tiefgreifende klinische Probleme zu lösen, wie zum Beispiel Jingdong Healths „Jingyi Qianxun 2.0“ und United Imaging Intelligences „Brust-Scan-Multi-Check-Agent“, was die Effizienz und Präzision der Diagnose und Behandlung verbessert. (Quelle: 36氪)

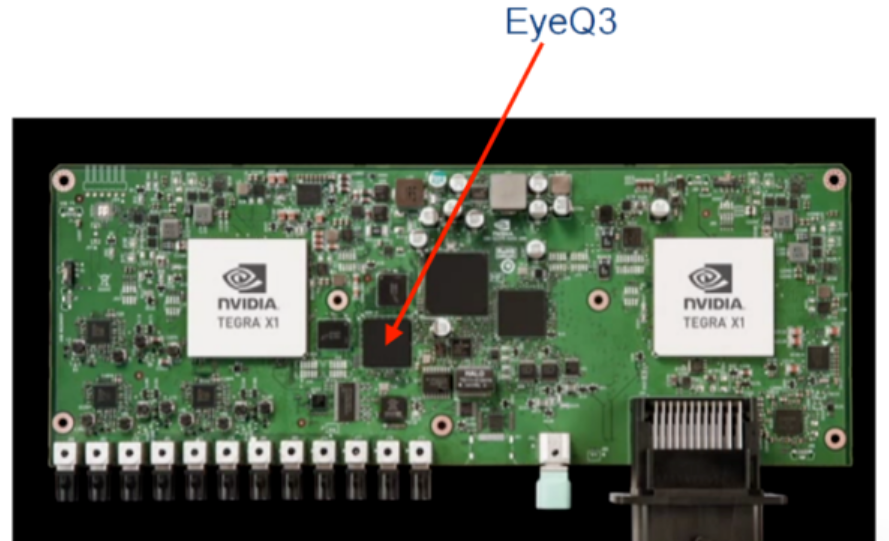

Teslas FSD-Chips: Kontinuierliche Iteration zielt auf autonomes Fahren der Stufe L4 ab : Teslas Fahrassistenz-Chips haben sich von der Abhängigkeit von externen Anbietern (Mobileye, NVIDIA) zu vollständig selbst entwickelten FSD-Chips entwickelt, wobei HW3.0 und HW4.0 nacheinander eingeführt wurden. Die Rechenleistung und Energieeffizienz wurden erheblich verbessert, und die Anpassungsfähigkeit an komplexe Szenarien wurde gestärkt. Der HW5.0/AI5-Chip ist in die Massenproduktion gegangen, verwendet den 3nm-Prozess von TSMC, erreicht eine Rechenleistung von bis zu 2000-2500 TOPS und wird voraussichtlich 2026 in großem Maßstab produziert, um das autonome Fahren der Stufe L4 zu ermöglichen und den Markt für intelligente Fahrchips neu zu gestalten. (Quelle: 36氪)

🧰 Tools

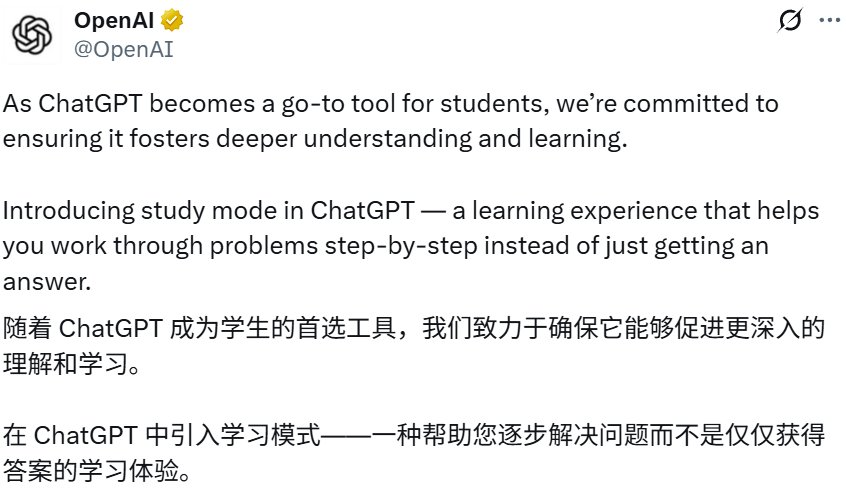

ChatGPT führt „Lernmodus“ ein : OpenAI hat den „Lernmodus“ für ChatGPT eingeführt, der darauf abzielt, Nutzern durch sokratische Fragen, leitende Fragen und personalisiertes Feedback schrittweise bei der Problemlösung zu helfen und das Verständnis zu vertiefen, anstatt direkte Antworten zu geben. Dieser Modus steht allen Nutzern (einschließlich kostenloser Nutzer) zur Verfügung und wird von maßgeschneiderten Systemanweisungen angetrieben, die in Zusammenarbeit mit Bildungsexperten erstellt wurden. Er zielt darauf ab, kritisches Denken und selbstständiges Lernen zu fördern, was eine tiefere Erkundung von ChatGPT im Bildungsbereich markiert. (Quelle: 36氪)

Google NotebookLM fügt Video-Übersichtsfunktion hinzu : Google NotebookLM hat eine Video-Übersichtsfunktion eingeführt, die eine visuelle Alternative zur Audio-Übersicht darstellt. Nutzer können einen AI-Moderator nutzen, um automatisch kurze Videozusammenfassungen mit Bildern, Diagrammen, Zitaten und Daten zu generieren, was eine klarere visuelle Darstellung komplexer oder textlastiger Konzepte ermöglicht und die Lern- und Verständniseffizienz verbessert. Diese Funktion ist derzeit für Englisch und Desktop-Geräte verfügbar. (Quelle: Google)

Claude Code unterstützt Arbeit mit mehreren Verzeichnissen : Anthropic’s Claude Code wurde aktualisiert und unterstützt nun die Arbeit über mehrere Verzeichnisse hinweg in einer einzigen Sitzung; Nutzer können /add-dir eingeben, um Arbeitsverzeichnisse hinzuzufügen. Diese Funktion verbessert die Benutzerfreundlichkeit bei der Codebasis-Operation erheblich, ermöglicht die Migration von Code innerhalb oder zwischen Projekten ohne Sitzungswechsel und kann Speicher- oder Regelsätze von extern beziehen, was das kollaborative Programmiererlebnis mit Agenten verbessert. (Quelle: dotey)

Tongyi Lingma veröffentlicht Qwen3-Coder : Alibaba Cloud Tongyi Lingma hat das AI-Programmiermodell Qwen3-Coder veröffentlicht, das Nutzern über die Tongyi Lingma AI IDE sowie VSCode- und Jetbrains-Plugins kostenlos zur Verfügung steht. Qwen3-Coder verbessert die Geschwindigkeit und Genauigkeit der Codegenerierung in realen Unternehmensentwicklungsszenarien erheblich und bietet ein besseres kollaboratives Programmiererlebnis mit Agenten. Das Modell hat die Spitze der HuggingFace-Modellrangliste erreicht und wird als das weltweit stärkste Open-Source-Programmiermodell angesehen, das mit Claude4 vergleichbar ist. (Quelle: 量子位)

BlockDL: Visueller Neuronales-Netzwerk-Builder : BlockDL ist ein kostenloses Open-Source-GUI-Tool, das Nutzern ermöglicht, Keras-Neuronale Netze visuell per Drag-and-Drop zu entwerfen und bietet sofortige Codegenerierung sowie Echtzeit-Formvalidierung, um Entwicklern zu helfen, kreative Designs schnell umzusetzen und frühe Fehler zu vermeiden. Das Tool enthält auch ein vollständiges Lernsystem und unterstützt fortgeschrittene Strukturen wie Skip Connections und Multi-Input/Output-Modelle. (Quelle: fchollet)

PopAi AI Slides Agent : PopAi hat den AI Slides Agent eingeführt, mit dem Nutzer mit nur einem Prompt automatisch ansprechende PowerPoint-Folien von einem AI-Agenten generieren lassen können. Dieses Tool zielt darauf ab, die Ideen der Nutzer durch AI zu verstehen und eine intelligente, schnelle und einfache Folienproduktion zu ermöglichen, wodurch die Effizienz bei der Erstellung von Präsentationen erheblich gesteigert wird. (Quelle: kaifulee)

📚 Lernen

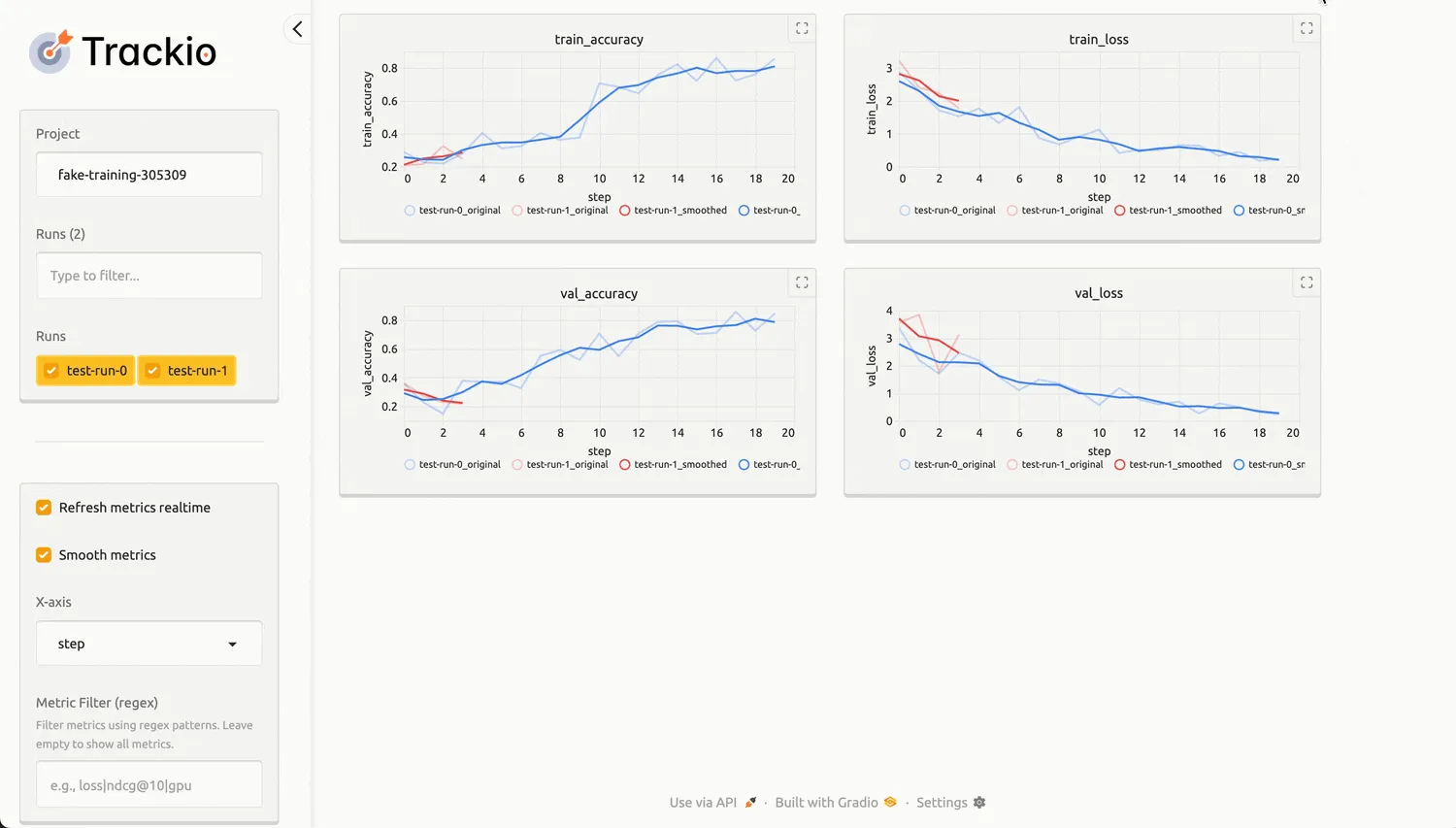

Hugging Face veröffentlicht leichtgewichtige Bibliothek zur Experimentverfolgung Trackio : Hugging Face hat die Open-Source-Python-Bibliothek Trackio veröffentlicht, die eine leichtgewichtige, lokal-orientierte Lösung zur Verfolgung von Machine-Learning-Experimenten bietet. Trackio ist kompatibel mit der wandb API, unterstützt das einfache Teilen von Trainingsfortschritten, das Einbetten von Diagrammen und die standardisierte, transparente Aufzeichnung von Metriken wie dem GPU-Energieverbrauch. Es basiert auf Gradio und Hugging Face Spaces, was Nutzern die Visualisierung und das Teilen von Experimentergebnissen erleichtert, und kann nativ in die Transformers- und Accelerate-Bibliotheken integriert werden. (Quelle: HuggingFace Blog)

Anwendung von LangChain und LangGraph im Kontext-Engineering : LangChain und LangGraph bieten verschiedene Methoden des Kontext-Engineerings, um Entwicklern zu helfen, die Leistung von LLM-Anwendungen zu optimieren. LangGraph hilft Unternehmen (wie Bertelsmann) durch Multi-Agenten-Systeme, die Zeit für die Inhaltserkennung von Stunden auf Sekunden zu verkürzen, und ermöglicht den Einsatz spezialisierter Agenten über verschiedene Inhaltsbereiche hinweg sowie die Wiederverwendung modularer APIs. Die neue Align Evals-Funktion von LangSmith vereinfacht zudem die Erstellung von LLM-as-judge-Evaluatoren, sodass deren Bewertungen besser menschlichen Präferenzen entsprechen. (Quelle: LangChainAI)

LLM-Generierung mathematischer Probleme und Komplexitätssteigerung : Das SAND-Math-Projekt schlägt eine Pipeline vor, die LLMs nutzt, um neuartige, schwierige und nützliche mathematische Probleme und Lösungen zu generieren. Diese Methode generiert zunächst hochwertige Probleme und erhöht dann systematisch deren Komplexität durch einen „Schwierigkeitssteigerungs“-Schritt. Der EDGE-GRPO-Algorithmus mindert effektiv das Problem des „Advantage Collapse“ im Reinforcement Learning durch „Entropy-Driven Advantage“ und „Guided Error Correction“, wodurch die LLM-Inferenzleistung verbessert wird. Das MaPPO-Framework hingegen verbessert die Ausrichtung von LLMs an menschlichen Präferenzen, indem es a priori Belohnungswissen in das Optimierungsziel integriert. Diese Studien treiben gemeinsam die Fortschritte von LLMs in den Bereichen mathematisches Schlussfolgern und Reinforcement Learning voran. (Quelle: HuggingFace Daily Papers)

CIRCLE: Sicherheits-Benchmark für LLM-Code-Interpreter : CIRCLE (Code-Interpreter Resilience Check for LLM Exploits) ist ein einfacher Benchmark zur Bewertung der systemweiten Cybersicherheitsrisiken von LLM-Code-Interpreter-Systemen. Er umfasst 1260 Prompts, die auf CPU-, Speicher- und Festplattenressourcenerschöpfung abzielen, um zu bewerten, ob das LLM gefährlichen Code ablehnt oder generiert, und führt den Code in der Interpreterumgebung aus, um seine Korrektheit oder ein Timeout zu bewerten. Tests ergaben signifikante und inkonsistente Schwachstellen in kommerziellen Modellen, insbesondere eine verminderte Abwehrfähigkeit bei indirekten, sozialingenieurmäßigen Prompts. (Quelle: HuggingFace Daily Papers)

Zielausrichtung in LLM-Benutzersimulatoren : Forschungsergebnisse zeigen die Grenzen aktueller LLM-Benutzersimulatoren auf, die in mehrstufigen Dialogen Schwierigkeiten haben, zielgerichtetes Verhalten konsistent zu zeigen. Das User Goal State Tracking (UGST)-Framework wurde vorgeschlagen, um den Fortschritt von Nutzerzielen zu verfolgen und Benutzersimulatoren zu entwickeln, die Ziele autonom verfolgen und zielgerichtete Antworten generieren können. Diese Methode verbesserte die Zielausrichtung in den Benchmarks MultiWOZ 2.4 und τ-Bench signifikant. (Quelle: HuggingFace Daily Papers)

LLM Code-Vervollständigungsmodell Finetuning-Tutorial : Oxen.ai hat eine Reihe von Tutorials veröffentlicht, die zeigen, wie man schnelle, lokale „Tab-Tab“-Code-Vervollständigungsmodelle für Marimo-Notebooks finetunt. Ziel ist es, Open-Source-Modelle zu erstellen, die ein Cursor-ähnliches Code-Vervollständigungserlebnis bieten und lokal ausgeführt oder über eine kostenlose API aufgerufen werden können. Frühe Experimente zeigen, dass die finetuned Qwen- und Llama-Modelle auf dem MBPP-Datensatz bereits GPT-4-Niveau erreicht haben. (Quelle: Reddit r/MachineLearning)

Neuronale Netzwerktheorie und neue Fortschritte im Repräsentationslernen : Angesichts der zunehmenden Strenge im Design neuronaler Netze sucht ein Doktorand nach Empfehlungen für mathematische Bücher, um die Forschung theoretisch zu untermauern, anstatt sich nur auf Intuition zu verlassen. Gleichzeitig diskutiert die Community die neuesten Ansätze im Repräsentationslernen, einschließlich Matryoshka Learning und Contrastive Learning, und sucht nach neuen neuronalen Netzwerk-„Tricks“ der letzten 2-3 Jahre zum Aufbau besserer Repräsentationen, die sowohl unüberwachte als auch überwachte Lernprobleme abdecken. Darüber hinaus hat das X-Omni-Framework diskrete autoregressive Bildgenerierungsmodelle durch Reinforcement Learning verbessert und eine nahtlose Integration von Bild- und Sprachgenerierung erreicht. (Quelle: Reddit r/MachineLearning)

💼 Business

Polarisierende Auswirkungen von AI auf den Arbeitsmarkt : AI verändert den Arbeitsmarkt erheblich, insbesondere in Bezug auf Einstellung und Entlassung. Die Technologiebranche hat aufgrund von AI-Automatisierung etwa 80.000 Entlassungen erlebt (z.B. Microsoft plant 15.000 Entlassungen), während außerhalb der Tech-Branche die Nachfrage nach AI-Fähigkeiten stark gestiegen ist, mit einem Gehaltsaufschlag von bis zu 28% für entsprechende Positionen, was einem durchschnittlichen jährlichen Anstieg von fast 18.000 US-Dollar entspricht. Bereiche wie Marketing, Personalwesen und Finanzen integrieren schnell AI-Tools, und hybride AI-Fähigkeiten (wie Kommunikation, Führung) sind sehr gefragt. (Quelle: 36氪)

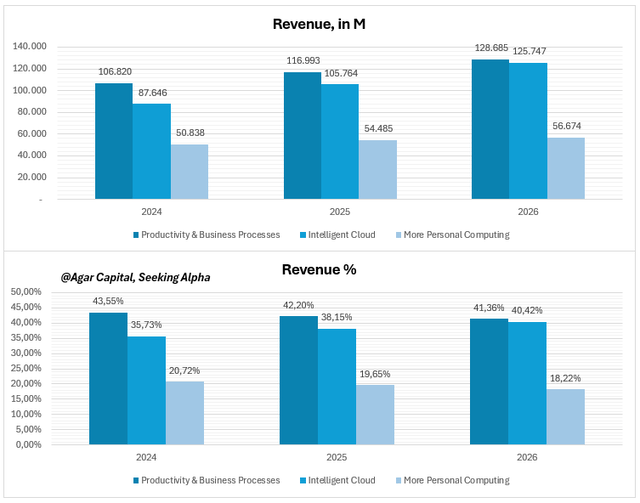

Microsoft Q4 Quartalsausblick: AI steigert Gewinnmargen statt eines Glücksspiels : Microsofts AI-Strategie hat sich von einer Spitzentechnologie zu einer wirtschaftlichen Infrastruktur entwickelt; AI ist tief in Kernbereiche wie Azure Cloud, Copilot und Office integriert und beginnt, sich auszuzahlen. AI-Workloads trieben das Azure-Cloud-Wachstum um 34% im Jahresvergleich an, Copilot hat 200.000 Unternehmenskunden, und der ARPU wächst beschleunigt. Analysten halten Microsoft für unterbewertet; seine hohen Gewinnmargen und Cashflows beweisen, dass AI zu einer monetarisierbaren „Superkraft“ geworden ist und nicht nur eine bloße Geschichte. (Quelle: 36氪)

Kommerzialisierung von AI Agenten: Wer wird zum „Cash Cow“? : Die WAIC 2025 zeigt, dass AI Agenten vom Konzept zur Implementierung übergehen, insbesondere in den Bereichen Unternehmensdienstleistungen, Industrieintelligenz, Fintech und Smart Hardware. Profitable Agentenplattformen weisen in der Regel hohe Kundenwerte (Jahresgebühren von 500.000+), hohe Bruttomargen (≥60%) auf und monetarisieren über fortgeschrittene Modelle wie „Eingangsverkauf“ (systemweite Bindung), „Erfolgsbeteiligung“ (Prozentsatz der Einsparungen) und „Verkauf nach Ressourceneinheit“ (AI-Cloud-Personal). Die Kernbarrieren liegen in der tiefen Integration in Geschäftsprozesse, der Einhaltung von Branchenvorschriften und der Fähigkeit zur Integration mit Altsystemen. (Quelle: 36氪)

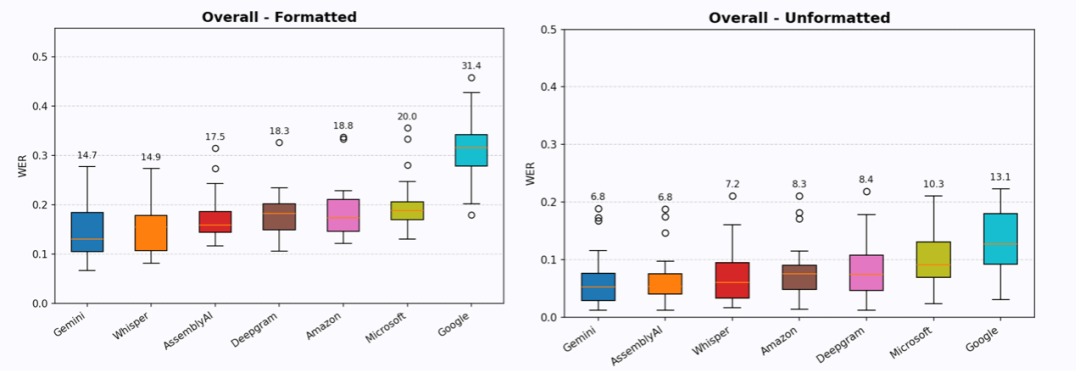

AI-Spracheingabe-Sektor erhält Millionen-Dollar-Finanzierung : Die Start-ups für Spracheingabe Willow Voice und Wispr Flow haben kürzlich eine Angel-Runde von 4,2 Millionen US-Dollar bzw. eine Serie-A-Runde von 30 Millionen US-Dollar abgeschlossen, was das Kapitalinteresse an der AI-Sprach-„Eingabe“ statt der „Ausgabe“ zeigt. Diese Unternehmen zielen darauf ab, „Zero-Edit-Informationen“ in Form von Sprache-zu-Text-Diensten bereitzustellen, die durch Formatierung, Kontextverständnis und Kontextidentifikation direkt nutzbaren Text ausgeben. Obwohl noch Lücken bestehen, deuten ihre hohe Nutzerbindung und Zahlungsbereitschaft darauf hin, dass die Spracheingabe ein enormes Potenzial zur Reduzierung der Mensch-Computer-Interaktionsreibung und zur Effizienzsteigerung birgt und das Potenzial hat, die Tastatur als neues Mensch-Computer-Interaktionsparadigma abzulösen. (Quelle: 36氪)

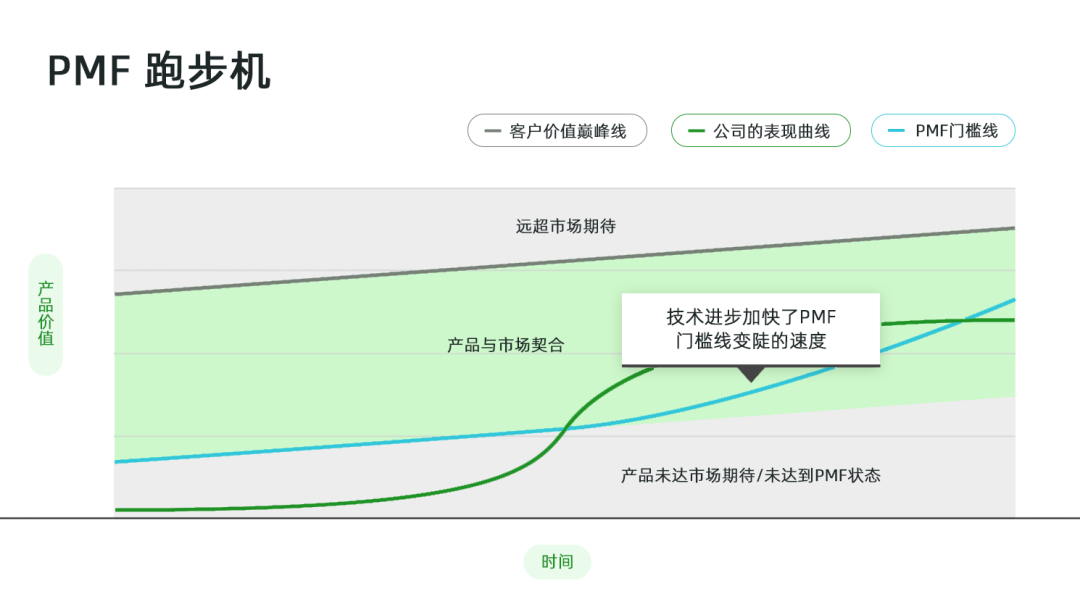

Beschleunigende Auswirkungen von AI auf den Product-Market Fit (PMF) : Im AI-Zeitalter wird PMF von einem statischen Meilenstein zu einem beschleunigten Laufband. Die Verbreitung von AI-Tools beschleunigt die Ablösung von Produkten, und die Nutzererwartungen wachsen exponentiell, was das Risiko eines „PMF-Verlusts“ erhöht. Unternehmen müssen die Veränderungen der Nutzererwartungen genau beobachten und AI-Tools zur Aggregation von Feedback nutzen; das Risiko eines PMF-Verlusts bewerten, z.B. Produktnutzungskanäle, -frequenz, Beherrschung des kreativen Workflows, proprietäre Daten und die Akzeptanz neuer Technologien durch Kunden; und die Produktstrategie entsprechend anpassen, um mehr Ressourcen in die PMF-Erweiterung oder die Neusuche nach PMF zu investieren. (Quelle: 36氪)

GMI Cloud zeigt AI-Infrastrukturstärke auf der WAIC2025 : GMI Cloud, ein weltweit führender Anbieter von AI Native Cloud Services, präsentierte auf der WAIC 2025 seine AI-Infrastrukturstärke. Zu seinen Kernprodukten gehören GPU-Cloud-Dienste (basierend auf High-End-Chips wie H200, B200), Cluster Engine und Inference Engine, die darauf abzielen, Unternehmen eine sichere und effiziente AI-Infrastruktur bereitzustellen. GMI Cloud hat auch einen Kostenrechner für den Aufbau von AI-Anwendungen und eine praktische Inference Engine-Erfahrung eingeführt, um Entwicklern zu helfen, AI-Anwendungen präzise zu planen und effizient umzusetzen, insbesondere auf internationalen Märkten. (Quelle: 量子位)

🌟 Community

Phasen des AI-Modelltrainings: „Vortraining“ und „Nachtraining“ : In den sozialen Medien wird die AI-Modellschulung in „Vortraining“ (Pretraining) und „Nachtraining“ (Post-training) unterteilt. Das Vortraining wird mit der präzisen Berechnung jedes Abschnitts und jedes Gramms Wasser durch einen Marathonläufer verglichen – eine elegante Wissenschaft, die von Mathematikern und Ingenieuren für große verteilte Systeme durchgeführt wird; das Nachtraining wird als „riskante Cowboy-Forschung“ beschrieben, die experimenteller und explorativer ist und auf die Herausforderungen und nicht-standardisierten Eigenschaften in der praktischen Anwendung hindeutet. (Quelle: natolambert)

Schnelle Entwicklung und Herausforderungen von AI-generierten Videos : In den sozialen Medien wird die rasante Entwicklung von AI-generierten Videos, wie Modellen wie Runway Aleph und Alibaba Wan 2.2, lebhaft diskutiert. Nutzer staunen, dass „Videos sich für immer verändert haben“ und Standbilder mühelos in bewegte Bilder umgewandelt werden können, sogar mit filmreifen visuellen Effekten. Einige Nutzer weisen jedoch auch auf Mängel von AI-Videos in Bezug auf emotionalen Ausdruck und Rhythmuskontrolle sowie den hohen Bedarf an Rechenressourcen hin. Zudem wird das Phänomen „Will Smith isst Spaghetti“ als inoffizieller Benchmark für AI-Videogenerierung diskutiert, was das anhaltende Interesse der Community an der Qualität und Realismus von AI-Videos widerspiegelt. (Quelle: c_valenzuelab)

AI-Inhaltsüberproduktion und Wertverschiebung : Soziale Diskussionen weisen darauf hin, dass mit der Senkung der Produktionsschwelle durch AI-Erstellungstools die Generierung hochwertiger Langtextinhalte einfacher wird, was zu einem „Überangebot“ führt. Dies macht Kuratierung, Verifizierung, Kontextualisierung und Synthesefähigkeiten wertvoller, während „Geschmack, Theory of Mind und Urteilsvermögen“ entscheidend werden. Einige befürchten, dass dies zu „allgemeiner Mittelmäßigkeit“ führen wird, aber andere glauben, dass AI die Arbeit beschleunigen und mehr Menschen zur Teilnahme an der Kreation anregen kann. (Quelle: nptacek)

Sicherheitsdebatte über AI APIs und Open-Weight-Modelle : Clement Delangue, CEO von Hugging Face, stellt die Behauptung in Frage, dass „die Bereitstellung von AI-APIs verantwortungsvoller sei als Open-Weight-Modelle“. Er argumentiert, dass APIs durch die Senkung der Nutzungsschwelle die Anzahl böswilliger Akteure erheblich erhöhen könnten, ohne mehr Kontrolle zu gewinnen. Er fordert ein Ende der Rhetorik, dass „Open Weights unsicher sind“, und meint, dass die Benutzerfreundlichkeit von APIs ein größeres Risiko bergen könnte. (Quelle: ClementDelangue)

Diskussion über AI-Agenten-Parallelisierung und Effizienzsteigerung : Die Community diskutiert, ob die Parallelisierung von AI-Agenten die Effizienz signifikant steigern kann; einige vergleichen es mit „neun Frauen können kein Baby in einem Monat bekommen“, was darauf hindeutet, dass einige Aufgaben von Natur aus sequenziell und schwer zu parallelisieren sind. Andere argumentieren jedoch, dass die Effizienz durch die parallele Arbeit mehrerer Agenten an verschiedenen Zweigen/Aufgaben gesteigert werden kann, insbesondere wenn andere Probleme bearbeitet werden, während auf die Antwort eines Agenten gewartet wird. Die Diskussion erwähnt auch Amdahls Gesetz, das besagt, dass die Parallelisierungseffizienz von der Art der Aufgabe abhängt, und betont, dass Agenten kostengünstig sind, sodass selbst eine teilweise Parallelisierung zu Effizienzsteigerungen führen kann. (Quelle: Reddit r/ClaudeAI)

AGI-Veröffentlichung und Bedenken hinsichtlich der Kontrolle : Die Community diskutiert intensiv, ob AGI (Künstliche Allgemeine Intelligenz) öffentlich veröffentlicht wird. Die meisten glauben, dass das Unternehmen oder Land, das AGI zuerst entdeckt/erschafft, es streng geheim halten wird, um einen enormen Vorteil zu erzielen, und es nicht leichtfertig öffentlich machen wird. Besorgte Stimmen meinen, dass das Aufkommen von AGI zu einem Kontrollverlust führen und sogar menschliche Erwartungen übertreffen könnte. Andere weisen darauf hin, dass Unternehmen nach Profit streben und AGI kommerzialisieren würden, während Regierungen möglicherweise sofort die Kontrolle übernehmen würden. (Quelle: Reddit r/ArtificialInteligence)

LLM-Zuverlässigkeit und das „Halluzinations“-Phänomen : Die Community diskutiert die Zuverlässigkeit von LLMs; einige vergleichen sie mit Googles „Auf gut Glück!“-Button, was darauf hindeutet, dass die Antworten von LLMs manchmal rein zufällig sind. Ein anderer Nutzer teilte seine Erfahrung mit Gemini 2.5, das „dissoziative“ abnormale Ausgaben zeigte, was Bedenken hinsichtlich der Modellstabilität und des „Halluzinations“-Phänomens aufwirft. Diese Unsicherheit erfordert, dass Nutzer die Ausgaben von LLMs weiterhin sorgfältig überprüfen. (Quelle: Reddit r/ArtificialInteligence)

Neudefinition menschlicher Rollen und Berufsbezeichnungen durch AI : Elon Musk kündigte bei xAI die Abschaffung des Begriffs „Forscher“ an und behält nur noch „Ingenieur“ bei, da er „Forscher“ als Relikt aus der akademischen Welt betrachtet und den Schwerpunkt auf den tatsächlichen technischen Beitrag legt. Diese Ansicht löste in der Community eine Diskussion aus; einige stimmen zu, dass letztendlich alle Ingenieure sein sollten, aber andere widersprechen der Bedeutung der Forschung für die Ingenieurwissenschaften und bezweifeln, dass diese Praxis zu einem Verlust von Talenten führen könnte. (Quelle: Yuchenj_UW)

Auswirkungen von AI auf die Arbeit von Produktmanagern (PM) : In den sozialen Medien wird der Einfluss von AI auf die Arbeit von Produktmanagern (PM) diskutiert, wobei darauf hingewiesen wird, dass AI den Produktentwicklungsprozess neu gestaltet. Einige glauben, dass AI-Codierung begrenzte Auswirkungen auf Ingenieurteams hat, aber in Produkt- und Designteams beschleunigt AI die Iterationsgeschwindigkeit durch Prototyping erheblich. AI-PMs teilten mit, wie Produkte gebaut werden können, um den durch AI verursachten Wandel zu bewältigen, und betonten, dass Produktmanagement nicht mehr „Codieren nach Gefühl“ ist, sondern sorgfältiges Management erfordert. (Quelle: amasad)

Diskussion über AI und zukünftige Gesellschaftsformen : Die Community diskutiert, ob AI eine Zukunft ohne Geld und Arbeit ermöglichen kann. Einige glauben, dass AI den Großteil der Arbeit automatisieren und die Menschheit befreien kann, sich auf Selbstentwicklung und Verbindung zu konzentrieren, aber die Verwirklichung dieser Utopie erfordert eine massive Veränderung von Werten, Zugang und Eigentum, nicht nur Technologie. Andere befürchten, dass eine solche Zukunft dazu führen könnte, dass AI-Kontrolleure Macht missbrauchen oder AI selbst unerwartete Ziele entwickelt. (Quelle: Reddit r/ArtificialInteligence)

💡 Sonstiges

Symbiotische Beziehung zwischen AI und Quantencomputing : Quantinuum und Google DeepMind haben die Realität einer symbiotischen Beziehung zwischen Quantencomputing und AI aufgezeigt. Die einzigartigen Fähigkeiten des Quantencomputings bieten neue Rechenparadigmen für AI-Modelle, während AI Quantenalgorithmen und Hardware-Design optimieren kann. Die Kombination beider verspricht Durchbrüche bei der Lösung komplexer Probleme und der Datenverarbeitung und treibt die Entwicklung von Spitzentechnologien voran. (Quelle: Ronald_vanLoon)

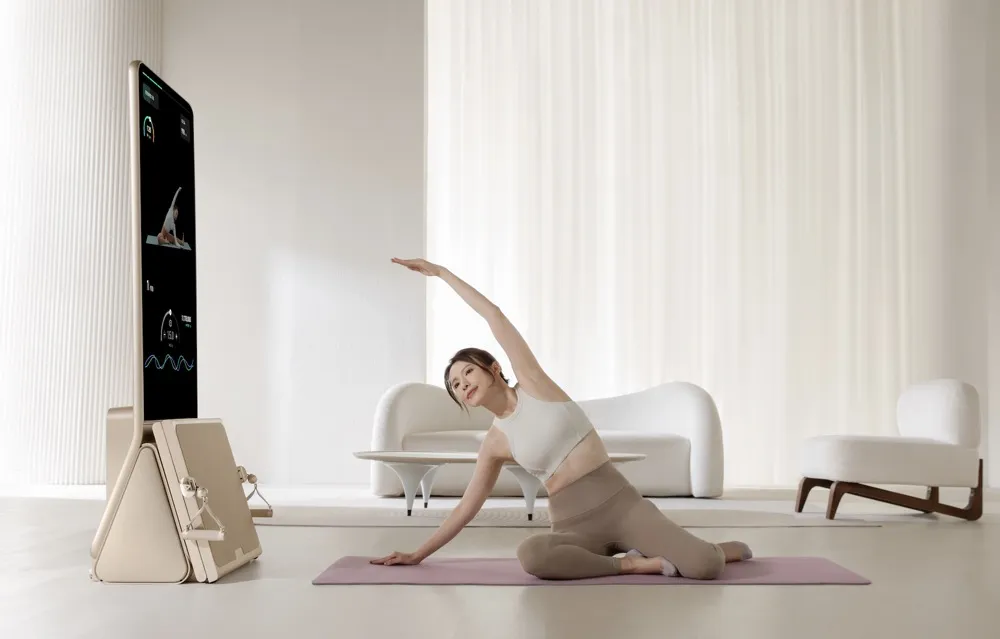

Intelligente Fitnessgeräte von AEKE erobern den High-End-Heimmarkt : Das Shenzhener Unternehmen AEKE hat mit seinem intelligenten Heim-Fitnessgerät Smart Home Gym K1, das einen Stückpreis von 20.000 RMB hat, innerhalb eines Monats auf einer ausländischen Crowdfunding-Plattform einen Umsatz von über zehn Millionen RMB erzielt. Das Produkt konzentriert sich auf Krafttraining und Pilates, bietet eine integrierte Hard- und Softwarelösung, ist mit einem 4K-Touchscreen, selbst entwickelter digitaler Servomotortechnologie und einem AI-Personal-Trainer-System ausgestattet, um personalisierte Trainingspläne und Echtzeit-Bewegungskorrekturen zu ermöglichen. AEKE zielt auf den High-End-Markt ab, positioniert sich als leicht, installationsfrei und als Kunstobjekt für das Zuhause und steigert durch das AI-Personal-Trainer-System die Nutzerbindung und die Effizienz der Expansion auf Überseemärkten. (Quelle: 36氪)

AIhub Monatsübersicht: Juli 2025 : AIhub hat seine Monatsübersicht für Juli 2025 veröffentlicht, die wichtige AI-Veranstaltungen wie den RoboCup Roboterfußballwettbewerb und die ICML Machine Learning Conference abdeckt. Der Inhalt umfasst Interviews und Zusammenfassungen der verschiedenen RoboCup-Ligen (wie RoboCupRescue, Small Size League, 3D Simulation League), eingeladene Vorträge und Auszeichnungen der ICML sowie eine Einführung in NASAs fahrzeugbasierte AI-Forschungsplattform OnAIR. Darüber hinaus werden Fortschritte in der Forschung zur Text-zu-Sprache-Generierung und zur Nutzung von Feedback in der Mensch-Roboter-Interaktion behandelt. (Quelle: aihub.org)