Schlüsselwörter:OpenAI, schlussfolgernde LLM, Internationale Mathematik-Olympiade, KI-Trainingsdatensatz, persönlicher Datenschutz, ChatGPT-Agent, politische Neutralität von KI-Modellen, Kimi K2, IMO-Goldmedaillenniveau, DataComp CommonPool-Datensatz, LLM-Agentenintelligenz, Weißes Haus KI-Verordnung, MoE-Architektur

🔥 Fokus

OpenAIs experimentelles Reasoning-LLM gewinnt Goldmedaille bei der Internationalen Mathematikolympiade: OpenAIs neuestes experimentelles Reasoning-LLM erreichte bei der Internationalen Mathematikolympiade (IMO) 2025 ein Goldmedaillen-Niveau und löste 5 von 6 Aufgaben. Das Modell arbeitete unter den gleichen Regeln wie die menschlichen Teilnehmer, einschließlich eines Zeitlimits von 4,5 Stunden pro Aufgabe, und verwendete keine Hilfsmittel. Die Beweise wurden in natürlicher Sprache ausgegeben. Dies markiert einen bedeutenden Durchbruch für KI im Bereich des mathematischen Denkens und deutet auf das Potenzial von KI für wissenschaftliche Entdeckungen hin. (Quellen: gdb, scaling01, dmdohan, SebastienBubeck, markchen90, npew, MillionInt, cloneofsimo, bookwormengr, tokenbender)

KI-Trainingsdatensatz CommonPool enthält Millionen personenbezogener Daten: Studien haben ergeben, dass der große Open-Source-KI-Trainingsdatensatz DataComp CommonPool Millionen von Bildern von Pässen, Kreditkarten, Geburtsurkunden und anderen Dokumenten mit personenbezogenen Daten enthält. Forscher überprüften 0,1 % der Daten von CommonPool und fanden Tausende von Bildern mit identifizierbaren persönlichen Informationen. Sie schätzen, dass der gesamte Datensatz Hunderte von Millionen solcher Bilder enthält. Dies wirft Bedenken hinsichtlich des Datenschutzes beim KI-Training auf und fordert die Machine-Learning-Community dazu auf, wahlloses Web Scraping zu überdenken. (Quelle: MIT Technology Review)

🎯 Entwicklungen

OpenAI stellt persönlichen Assistenten ChatGPT Agent vor: OpenAI hat den persönlichen Assistenten ChatGPT Agent vorgestellt, der Aufgaben im Auftrag des Benutzers erledigen kann, indem er einen eigenen “virtuellen Computer” erstellt. Dies ist ein wichtiger Schritt für die Agentenintelligenz von LLMs, aber die Funktion befindet sich noch in einem frühen Stadium und die Erledigung von Aufgaben kann einige Zeit dauern. (Quellen: MIT Technology Review, The Verge, Wired)

Das Weiße Haus bereitet eine Durchführungsverordnung vor, die “politisch neutrale und unvoreingenommene” KI-Modelle fordert: Das Weiße Haus bereitet eine Durchführungsverordnung vor, die von KI-Modellen “politische Neutralität und Unvoreingenommenheit” verlangt. Die Einhaltung dieser Verordnung wird über die Berechtigung für Bundesaufträge entscheiden, was für alle KI-Labore eine große Sache ist. Die Durchführungsverordnung wird voraussichtlich nächste Woche veröffentlicht. (Quellen: WSJ, MIT Technology Review, natolambert)

Kimi K2: Agentenintelligenzmodell mit Werkzeugnutzung: Kimi K2, veröffentlicht von Kimi_Moonshot, ist ein Agentenintelligenzmodell mit Werkzeugnutzung. Es zeichnet sich durch Werkzeugnutzung, Mathematik, Programmierung und mehrstufige Aufgaben aus und ist derzeit das führende Open-Source-Modell in der Arena, insgesamt auf Platz fünf. Kimi K2 verwendet eine DeepSeek-V3-ähnliche Mixture-of-Experts (MoE)-Architektur im großen Maßstab mit 1 Billion Gesamtparametern und 32 Milliarden aktiven Parametern. (Quelle: TheTuringPost)

🧰 Werkzeuge

GitHub MCP-Server verbindet KI-Tools mit der GitHub-Plattform: Der GitHub MCP-Server ermöglicht KI-Tools die direkte Verbindung mit der GitHub-Plattform, sodass KI-Agenten, Assistenten und Chatbots Repositories und Codedateien lesen, Issues und Pull Requests verwalten, Code analysieren und Workflows automatisieren können – alles durch Interaktion in natürlicher Sprache. (Quelle: GitHub Trending)

ik_llama.cpp: llama.cpp Fork mit besserer CPU-Leistung: ik_llama.cpp ist ein Fork von llama.cpp mit besserer CPU- und gemischter GPU/CPU-Leistung, neuen SOTA-Quantisierungstypen, erstklassiger Bitnet-Unterstützung, verbesserter DeepSeek-Leistung durch MLA, FlashMLA, fusionierte MoE-Operationen und Tensor-Overwriting sowie zeilenverschachteltem Quantisierungs-Packing für gemischte GPU/CPU-Inferenz. (Quelle: GitHub Trending)

📚 Lernen

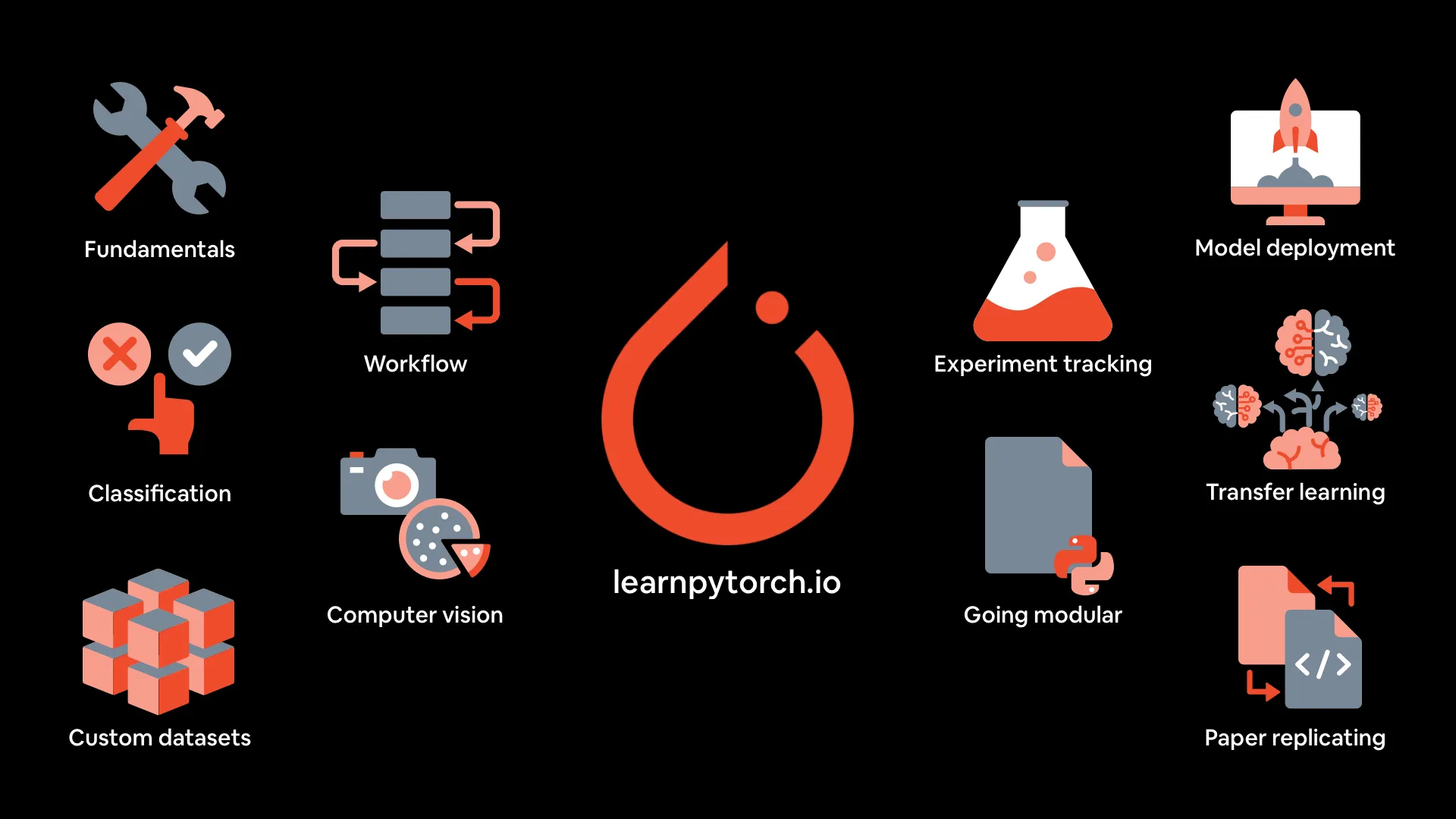

PyTorch Deep Learning Kursmaterialien: mrdbourke/pytorch-deep-learning bietet Materialien für den Kurs “PyTorch Deep Learning von Grund auf neu lernen”, einschließlich einer Online-Buchversion, Videos der ersten fünf Abschnitte auf YouTube, Übungen und zusätzlichen Kursen. Der Kurs konzentriert sich auf Code-Praxis und Experimente und behandelt PyTorch-Grundlagen, Workflows, neuronale Netzklassifizierung, Computer Vision, benutzerdefinierte Datensätze, Transferlernen, Experimentverfolgung und Modellbereitstellung. (Quelle: GitHub Trending)

MIT Press bietet drei Bücher über Algorithmen und maschinelles Lernen kostenlos an: MIT Press bietet drei Bücher über Algorithmentheorie und Kernalgorithmen des maschinellen Lernens kostenlos an: Algorithmen für die Optimierung, Algorithmen für Entscheidungen und Algorithmen für die Verifizierung. Diese Bücher eignen sich hervorragend für ein tieferes Verständnis von Algorithmen und maschinellem Lernen. (Quellen: TheTuringPost, TheTuringPost)

Energiebasierte Transformer sind skalierbare Lerner und Denker: Ein Artikel erörtert energiebasierte Transformer (EBTs), eine neue Art energiebasierter Modelle (EBMs), die durch das Lernen, die Kompatibilität zwischen Eingaben und Kandidatenvorhersagen explizit zu überprüfen, und die Neudefinition des Vorhersageproblems als Optimierung in Bezug auf diesen Verifizierer das “Denken” allein aus dem unüberwachten Lernen ermöglichen. (Quelle: )

🌟 Community

Erfahrungswerte zum Context Engineering für LLMs: Das ManusAI-Team teilt seine Erfahrungen mit dem Context Engineering für KI-Agenten und hebt die Bedeutung von KV-Caching, Dateisystemen, Fehlerverfolgung usw. im Agentendesign hervor. (Quellen: dotey, AymericRoucher, vllm_project)

Kimi K2 vs. Gemini in der Praxis: ClementDelangue und jeremyphoward retweeteten pashs Tweet, der darauf hinweist, dass Kimi K2 in der Praxis Gemini übertrifft, und lieferten zugehörige Diagrammdaten. (Quellen: ClementDelangue, jeremyphoward)

OpenAIs IMO-Goldmedaille überraschend: Das Ergebnis von OpenAIs LLM, eine Goldmedaille bei der IMO zu gewinnen, überraschte viele und löste breite Diskussionen in der Community aus. (Quellen: kylebrussell, VictorTaelin)

💼 Geschäft

Anthropic beschränkt die Nutzung von Claude Code: Anthropic hat die Nutzung von Claude Code eingeschränkt, ohne die Benutzer zu informieren, was zu Beschwerden und Bedenken hinsichtlich geschlossener Produkte führte. (Quellen: jeremyphoward, HamelHusain)

Meta weigert sich, das europäische KI-Abkommen zu unterzeichnen: Meta weigert sich, das europäische KI-Abkommen zu unterzeichnen, und behauptet, es sei zu interventionistisch und würde die KI-Entwicklung behindern. (Quellen: Reddit r/artificial, Reddit r/ArtificialInteligence)

💡 Sonstiges

Wie man ein LLM auf seinem Laptop ausführt: MIT Technology Review veröffentlichte einen Leitfaden zur Ausführung von Large Language Models (LLMs) auf Laptops und bietet Schritte und Empfehlungen für Benutzer, die Wert auf Datenschutz legen, sich der Kontrolle großer LLM-Unternehmen entziehen möchten oder gerne Neues ausprobieren. (Quellen: MIT Technology Review, MIT Technology Review)

Eine kurze Geschichte der “Drei-Eltern-Babys”: MIT Technology Review blickt auf die Geschichte der “Drei-Eltern-Babys” zurück und erläutert die verschiedenen Ansätze, Kontroversen und die neuesten Entwicklungen dieser Technologie, einschließlich der Geburt von acht Babys im Rahmen einer Studie in Großbritannien. (Quellen: MIT Technology Review, MIT Technology Review)

Wie man vom ersten Tag an Wert aus KI-Agenten schöpft: Dieser Artikel untersucht, wie Unternehmen Wert aus KI-Agenten schöpfen können, und empfiehlt Unternehmen, eine iterative Haltung einzunehmen, mit “Low-Hanging Fruits” und inkrementellen Anwendungsfällen zu beginnen und Interoperabilität zu priorisieren, um sich auf zukünftige Multi-Agenten-Systeme vorzubereiten. (Quelle: MIT Technology Review)