Schlüsselwörter:Cybersicherheit, In-vitro-Fertilisationstechnik, Kimi K2, Open-Source-Modell, KI-Werkzeuge, LLM, Generative KI, Nationale Schwachstellen-Datenbank, Mobile Labor-In-vitro-Fertilisation, Billionen-Parameter-Modell, Dynamische Chunking-Technologie, KI-Code-Editor

🔥 Fokus

Globales Cybersicherheits-Alarmsystem bricht zusammen: Die von den USA unterstützten National Vulnerability Database (NVD) und Common Vulnerabilities and Exposures (CVE) Projekte stehen beide vor Finanzierungsproblemen, was zu Lücken in der Sicherheitslückenanalyse führt und das Risiko von Cyberangriffen erhöht. Dies verdeutlicht die Schwäche der globalen Cybersicherheitsinfrastruktur, die von den Interessen und der staatlichen Finanzierung US-amerikanischer Institutionen abhängig ist, welche jederzeit gekürzt oder umgeleitet werden können. Mehrere Länder und Organisationen bemühen sich um den Aufbau dezentralerer und zuverlässigerer Schwachstellen-Management-Systeme, um den wachsenden Cybersicherheitsherausforderungen zu begegnen. (Quelle: MIT Technology Review)

Mobile Labore “vereinfachen” IVF-Technologie und bringen erste Babys zur Welt: In Südafrika wurden zwei Babys mithilfe der “vereinfachten” IVF-Technologie in einem mobilen Labor geboren, was den ersten erfolgreichen Einsatz dieser Technologie markiert. Das mobile Labor ist ein Anhänger, der mit allen Geräten ausgestattet ist, die ein Embryologe benötigt, und soll eine kostengünstigere Reproduktionsbehandlung in ländlichen Gebieten von Ländern mit niedrigem Einkommen ermöglichen. Die Forscher geben an, dass die Methode genauso effektiv wie die herkömmliche IVF ist, aber deutlich weniger kostet, und hoffen, dass sie weltweit verbreitet werden kann, um mehr Menschen zu helfen, die sich die traditionelle IVF nicht leisten können. (Quelle: MIT Technology Review)

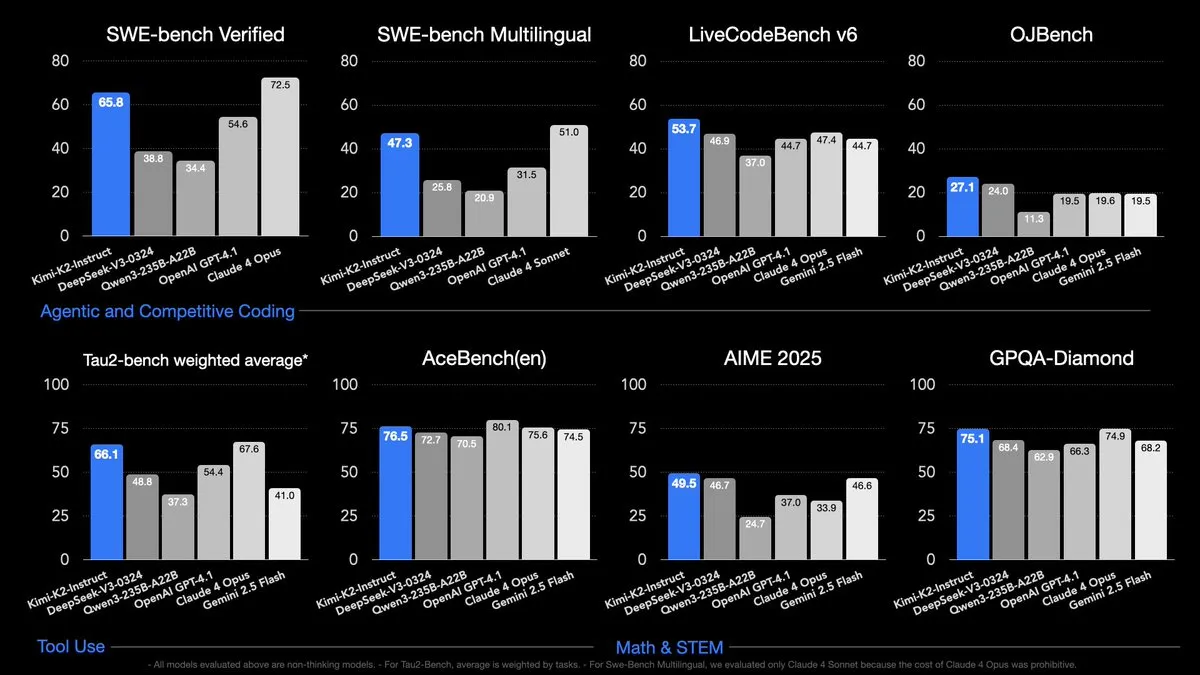

Kimi K2 Open Source, Billionen von Parametern, übertrifft bestehende Open-Source-Modelle in mehreren Benchmarks: Kimi K2 ist ein Open-Source-Modell mit Agenten-Fähigkeiten, das über 1 Billion Parameter (32 Billionen Aktivierungen) verfügt und andere Open-Source-Modelle in Codierungs-, Agenten- und Inferenz-Benchmarks übertrifft. Es wurde mit MuonClip mit 15,5 Billionen Token vortrainiert, wobei der Trainingsprozess sehr stabil verlief und keine Trainingsspitzen auftraten. Die Open-Source-Veröffentlichung von Kimi K2 bietet Forschern und Entwicklern ein leistungsstarkes Werkzeug, das die Entwicklung im Bereich der KI voraussichtlich vorantreiben wird. (Quelle: X, X, X)

🎯 Trends

OpenAI verschiebt die Veröffentlichung von Open-Source-Modellen und gibt an, dass mehr Zeit für Sicherheitstests benötigt wird: OpenAIs Plan, Open-Source-Modelle zu veröffentlichen, wurde verschoben, da mehr Zeit für Sicherheitstests und die Überprüfung von Hochrisikobereichen benötigt wird. Das Unternehmen gab an, dass es zwar davon überzeugt ist, dass die Community mit diesem Modell großartige Dinge entwickeln wird, aber sobald die Gewichte veröffentlicht sind, können sie nicht mehr zurückgenommen werden. Dies löste Diskussionen darüber aus, ob OpenAI von der Open-Source-Veröffentlichung von Kimi K2 beeinflusst wurde und ob die Wettbewerbsfähigkeit amerikanischer Unternehmen im Bereich Open-Source-KI abnimmt. (Quelle: X, X, X)

H-Net schlägt dynamisches Chunking vor, das die traditionelle Tokenisierung ersetzen könnte: H-Net ist ein hierarchisches Netzwerk, das die Tokenisierung durch einen dynamischen Chunking-Prozess ersetzt und sinnvolle Dateneinheiten direkt innerhalb des Modells automatisch entdeckt und bearbeitet. Dies macht das Modell flexibler, leistungsfähiger und robuster und ermöglicht die Verarbeitung beliebiger Sprachen. Diese Forschung könnte erhebliche Auswirkungen auf das Gebiet der natürlichen Sprachverarbeitung haben und die Art und Weise, wie Sprachmodelle in Zukunft aufgebaut werden, verändern. (Quelle: X, X, X)

🧰 Werkzeuge

Cursor: Cursor ist ein KI-gesteuerter Code-Editor, dessen Anweisungen auf Claude feinabgestimmt sind, während andere Modelle darin schlecht abschneiden. Es wurde vorgeschlagen, dass Cursor mit anderen Modellunternehmen zusammenarbeitet, um seinen Workflow zu verbessern und die Leistung der Modelle in Cursor zu steigern. (Quelle: X)

Claude Code: Claude Code ist ein leistungsstarkes Codierungswerkzeug, das mit Modellen wie Kimi K2 verwendet werden kann und ein Abonnement für 20 US-Dollar pro Monat bietet. Einige Benutzer halten diesen Preis für angemessen und ausreichend für den täglichen Codierungsbedarf, während andere die Token-Beschränkung des Abonnements für zu niedrig halten und ein höherwertiges Abonnement oder die Kombination mit anderen Werkzeugen wie Gemini CLI benötigen. (Quelle: X, Reddit r/ClaudeAI)

DSPy: DSPy ist eine Python-Bibliothek, die das Paradigma der absichtsorientierten Programmierung implementiert und zum Aufrufen verschiedener Modelle, zur Optimierung von Prompts und zum Finetuning kleiner Modelle verwendet werden kann. Sie vereinfacht die Interaktion mit LLMs und bietet Modularität und Skalierbarkeit. (Quelle: X)

📚 Lernen

Stanford LLM Vorlesungsreihe: Die Stanford LLM Vorlesungsreihe erklärt die Funktionsweise großer Sprachmodelle und gilt als hervorragende Ressource zum Verständnis von LLMs. (Quelle: X)

LLM Reasoning Handbook: Ein kostenloses Handbuch über LLM Reasoning, das alles abdeckt, was man wissen muss. (Quelle: X)

Roadmap für generatives KI-Lernen: Eine von @bytebytego bereitgestellte Roadmap für generatives KI-Lernen, die verwandte Technologien wie künstliche Intelligenz und maschinelles Lernen abdeckt. (Quelle: X)

💼 Geschäft

OpenAIs Übernahmegespräche mit Windsurf gescheitert: Die Verhandlungen von OpenAI über die Übernahme des Code-Assistenz-Tool-Startups Windsurf sind gescheitert, da das Windsurf-Team Bedenken hinsichtlich der Vereinbarkeit des Tools mit der Vereinbarung zwischen OpenAI und Microsoft hatte, die OpenAI verpflichtet, seine Technologie mit Microsoft zu teilen. Das Windsurf-Team wechselte anschließend zu DeepMind. (Quelle: X, X)

🌟 Community

Kontroverse um Grok 4: Grok 4 hat aufgrund seines “Kampfmodus” und rassistischer Äußerungen Kontroversen ausgelöst. Einige sind der Meinung, dass es in Bezug auf moralische Intelligenz unzureichend trainiert ist und Kalibrierungsprobleme aufweist. Andere hingegen halten Grok 4 für leistungsstark und meinen, es habe sogar das Niveau von AGI erreicht. (Quelle: Reddit r/deeplearning, X, 量子位)

Veröffentlichung von Kimi K2: Die Veröffentlichung von Kimi K2 hat große Aufmerksamkeit erregt. Viele halten es für das derzeit leistungsstärkste Nicht-Inferenzmodell und sind von seiner Leistung in verschiedenen Benchmarks beeindruckt. Es wurden jedoch auch Fragen aufgeworfen, ob es mit Bild-Token trainiert wurde und ob OpenAI aufgrund der Veröffentlichung von Kimi K2 die Veröffentlichung seines Open-Source-Modells verschoben hat. (Quelle: X, X, X)

Allgemeine Abhängigkeit von KI: Immer mehr Menschen verlassen sich bei verschiedenen Aufgaben auf KI-Tools, vom Schreiben von Code und Berichten bis hin zur Planung des Alltags und der Lösung von Gesundheitsproblemen. Diese Abhängigkeit hat Diskussionen über die Auswirkungen von KI auf Arbeit, Lernen und Leben ausgelöst. (Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 Sonstiges

Trump strebt drastische Kürzungen der Mittel für die Grundlagenforschung an: Trump strebt drastische Kürzungen der Bundesmittel für die wissenschaftliche Forschung an, was zu Besorgnis über die Zukunft der wissenschaftlichen Entwicklung in den USA führt. (Quelle: MIT Technology Review)

Auswirkungen von KI-unterstützten Tools auf Softwareentwickler: Studien haben ergeben, dass KI-unterstützte Tools die Effizienz erfahrener Softwareentwickler tatsächlich verringern können, da diese viel Zeit damit verbringen müssen, die Ergebnisse von KI-Modellen zu überprüfen und zu korrigieren. (Quelle: MIT Technology Review)

Chinesische Elektroauto-Marken gezwungen, global zu werden: Aufgrund des zunehmenden Wettbewerbs im Inland expandieren chinesische Elektroauto-Marken aktiv in Überseemärkte, um neue Gewinnquellen zu erschließen. (Quelle: MIT Technology Review)