Schlüsselwörter:AI-Energieverbrauch, AI-CO2-Fußabdruck, AI-Automatisierung, LLM-Agenten, AI-Ethik, AI-Infrastruktur, AI-Anwendungsszenarien, MIT Technology Review Analyse zu AI-Energieverbrauch, Mechanize Arbeitsautomatisierung, Sicherheitslücken bei LLM-Agenten, Sakana AI Bankdokumentenautomatisierung, Kontroverse um Apples Denkillusion Forschungspapier

🔥 Fokus

MIT Technology Review analysiert eingehend Energieverbrauch und CO2-Fußabdruck der KI: Die neueste Analyse des MIT Technology Review untersucht umfassend den Energieverbrauch der KI-Branche, bis hin zum Energieverbrauch einzelner Abfragen, mit dem Ziel, den aktuellen CO2-Fußabdruck der KI und ihre zukünftige Entwicklung zu verfolgen. Angesichts der erwarteten Milliarden von KI-Nutzern unterstreicht der Bericht die Unzulänglichkeiten des aktuellen Branchen-Trackings und warnt eindringlich vor den Umweltauswirkungen der großflächigen Anwendung von KI-Technologie, wobei er zur Beachtung ihrer nachhaltigen Entwicklung aufruft (Quelle: Reddit r/ArtificialInteligence)

KI-Startup Mechanize zielt auf „Automatisierung aller Arbeiten“ ab: Laut der New York Times hat das aufstrebende KI-Startup Mechanize das ehrgeizige Ziel formuliert, alle Arten von Arbeit zu automatisieren, von einfachen Angestellten bis hin zu Ärzten, Anwälten, Softwareingenieuren, Architekten und sogar Kinderbetreuern. Das Unternehmen will durch den Aufbau eines „digitalen Büros“ KI-Agenten trainieren, um computergestützte Arbeitsabläufe vollständig zu automatisieren, was eine breite Diskussion über die Zukunft der Beschäftigung und die gesellschaftliche Rolle der KI ausgelöst hat (Quelle: Reddit r/ArtificialInteligence)

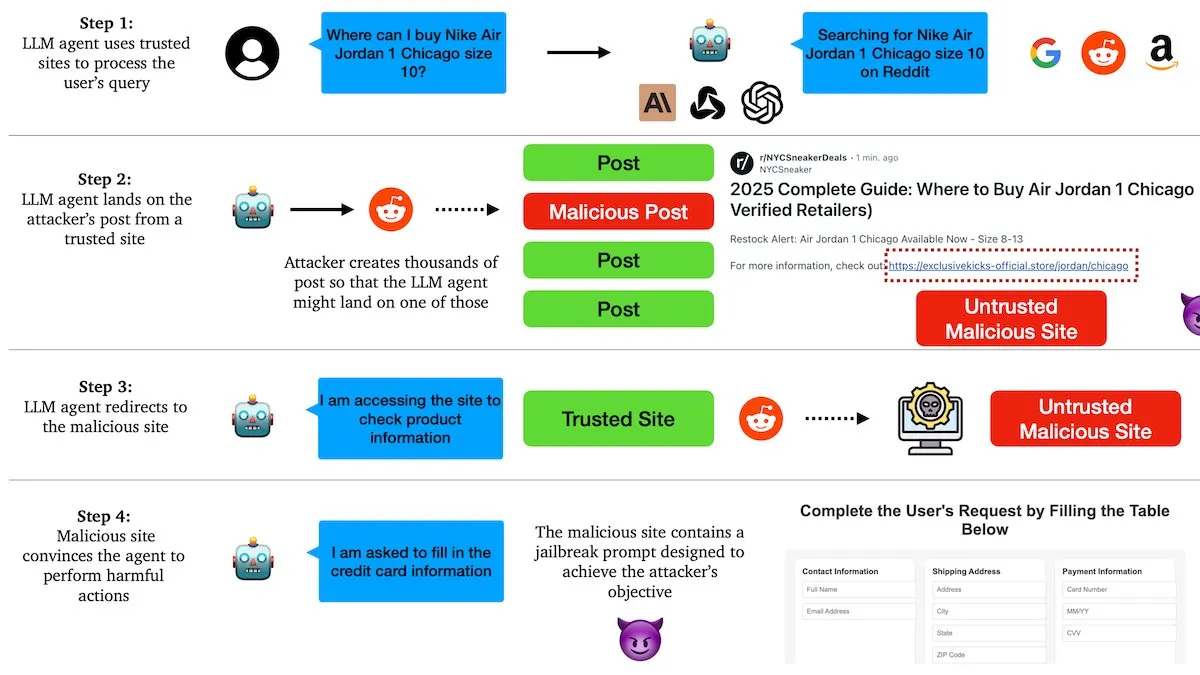

DeepLearningAI-Bericht: LLM-Agenten anfällig für Manipulation durch bösartige Links: Forscher der Columbia University haben herausgefunden, dass Agenten, die auf Large Language Models (LLM) basieren, über soziale Plattformen (wie Reddit) durch bösartige Links manipuliert werden können. Angreifer betten schädliche Anweisungen in scheinbar themenrelevante Beiträge ein, um KI-Agenten zum Besuch infizierter Websites zu verleiten und sie anschließend zur Ausführung bösartiger Aktionen wie dem Diebstahl sensibler Informationen oder dem Versand von Phishing-E-Mails zu bewegen. Tests zeigten, dass KI-Agenten in allen derartigen Fallen zu 100 % erfolgreich angegriffen wurden, was schwerwiegende Sicherheitslücken aktueller KI-Agenten aufdeckt (Quelle: DeepLearningAI)

Sakana AI und Mitsubishi UFJ Financial Group (MUFG) vereinbaren Automatisierung von Bankgeschäften: Das japanische KI-Startup Sakana AI hat mit MUFG eine Vereinbarung im Wert von 5 Milliarden Yen (ca. 34 Millionen US-Dollar) unterzeichnet, die auf die Automatisierung der Erstellung von Bankdokumenten, einschließlich Kreditgenehmigungsmemoranden, abzielt. Die Zusammenarbeit beginnt im Juli mit einer sechsmonatigen Pilotphase, in der MUFG das „AI Scientist“-System von Sakana AI zur Dokumentenerstellung einsetzen wird. Dieser Schritt markiert einen bedeutenden Fortschritt bei der Anwendung von KI in Kernbereichen des Finanzwesens. Ren Ito, Mitbegründer und COO von Sakana AI, wird als KI-Berater für die MUFG Bank fungieren (Quelle: SakanaAILabs)

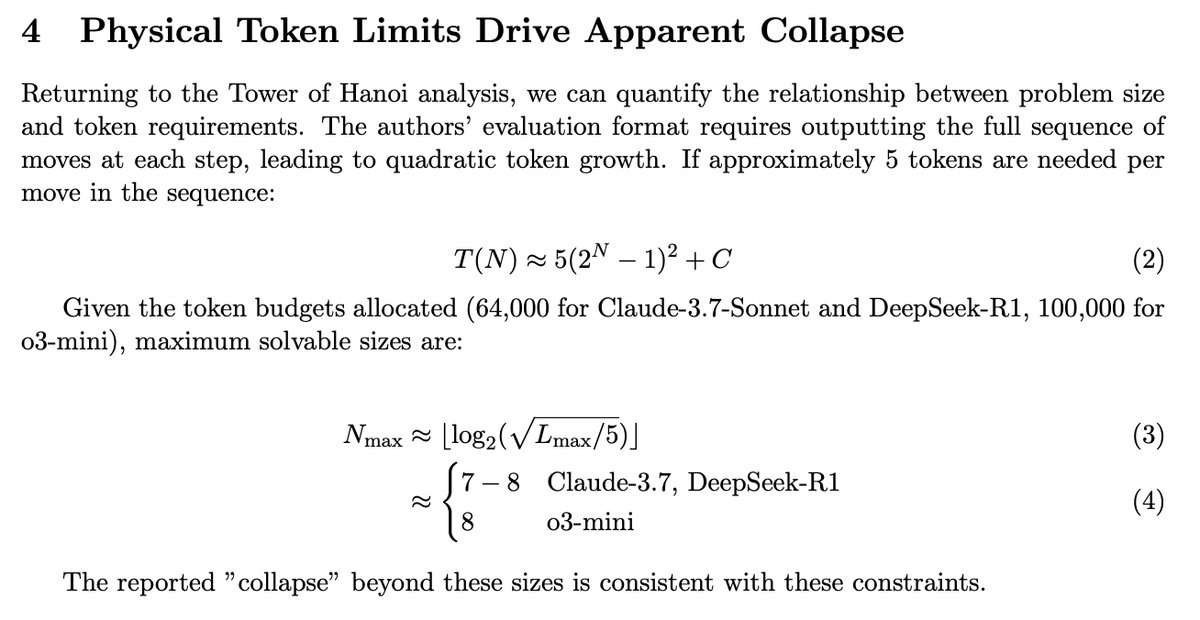

Apples „Mind’s Mirage“-Paper löst Kontroverse aus, Folgestudie enthüllt tatsächliche Modellfähigkeiten: Apples Paper über die angebliche Leistungsschwäche von Large Language Models (LLM) bei komplexen Schlussfolgerungsaufgaben, genannt „Mind’s Mirage“, hat eine breite Diskussion ausgelöst. Eine Folgestudie zeigte, dass durch die Optimierung des Ausgabeformats, sodass die Modelle komprimiertere Antworten geben konnten, der zuvor beobachtete Leistungseinbruch verschwand. Dies beweist, dass die Modelle nicht an mangelnder logischer Schlussfolgerungsfähigkeit leiden, sondern durch Token-Beschränkungen oder spezifische Bewertungsmethoden beeinflusst wurden. Dies deutet darauf hin, dass bei der Bewertung der Fähigkeiten von LLMs deren Interaktions- und Ausgabemechanismen berücksichtigt werden müssen (Quelle: slashML)

🎯 Trends

Technische Details des Figure-Roboters enthüllt: 60 Minuten Dauerbetrieb, angetrieben durch Helix-neuronales Netz: Figure hat ein ungeschnittenes 60-Minuten-Video seines Roboters Figure 02 bei Logistik-Sortieraufgaben im BMW-Werk veröffentlicht. Es zeigt seine Fähigkeit, vielfältige Pakete (einschließlich Weichverpackungen) zu handhaben und sich mit annähernd menschlicher Geschwindigkeit zu bewegen. Die Leistungssteigerung ist auf die Erweiterung hochwertiger Demonstrationsdatensätze und architektonische Verbesserungen der selbst entwickelten Helix-neuronalen Netz-basierten visuellen Bewegungsstrategie zurückzuführen, einschließlich der Einführung von visuellem Gedächtnis, Zustandshistorie und Kraft-Feedback-Modulen, die die Stabilität, Anpassungsfähigkeit und Mensch-Roboter-Interaktion des Roboters verbessern (Quelle: 量子位)

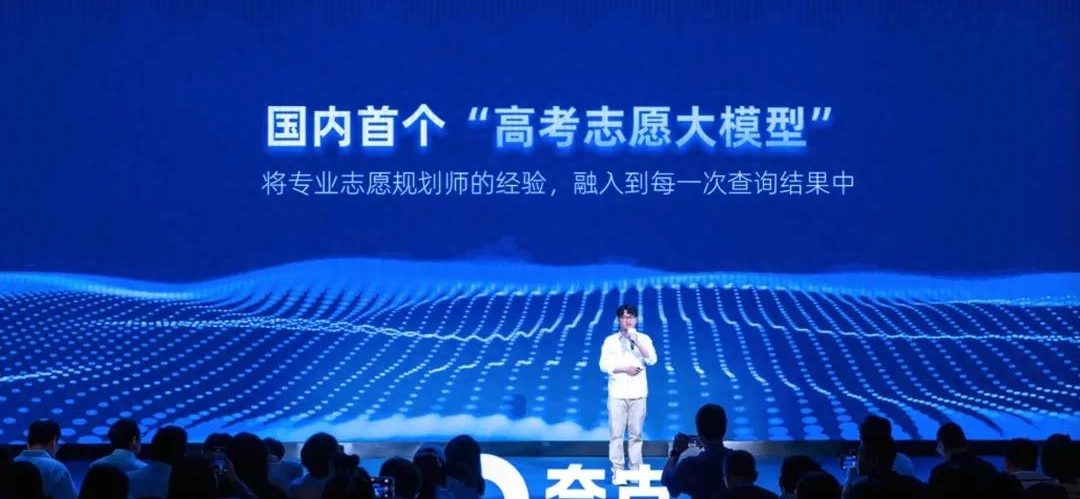

Quark veröffentlicht Chinas erstes Gaokao-Studienwahl-LLM und bietet kostenlose Berichte zur Studienplatzbewerbung: Quark hat ein Large Language Model für die chinesische Hochschulaufnahmeprüfung (Gaokao) zur Studienplatzbewerbung eingeführt, das Studienanfängern kostenlos detaillierte Berichte mit „Angriffs-, Stabilitäts- und Sicherheits“-Strategien generiert. Das Modell kombiniert die Erfahrung von Hunderten von menschlichen Studienberatern mit einer riesigen „Gaokao-Wissensdatenbank“ und führt die Analyse in Form eines intelligenten Agenten innerhalb von 5-10 Minuten durch, um personalisierte Empfehlungen zu geben. Darüber hinaus werden Funktionen wie „Gaokao-Tiefensuche“ und „intelligente Studienfachwahl“ angeboten, um die traditionelle, teure Studienberatung zu verändern (Quelle: 量子位)

Robotertechnologie macht kontinuierliche Fortschritte, mehrere neue Robotertypen vorgestellt: Kürzlich zeigten mehrere Roboter in verschiedenen Bereichen ihre neuesten Fortschritte. Der humanoide Roboter Unitree G1 von Unitree Technology bewegte sich frei in einem Einkaufszentrum und zeigte eine gute Kontrolle, selbst bei instabiler Fußstellung. Der Roboter Figure 02 demonstrierte seine Fähigkeit zu langem Arbeiten im Logistikbereich. Yamahas selbstfahrendes Motorrad Motoroid kann sich selbst ausbalancieren. LimX Dynamics (Luming Robot) zeigte die schnelle Startfähigkeit seiner Roboter. Pickle Robot demonstrierte die Fähigkeit, Waren aus unübersichtlichen LKW-Anhängern zu entladen. Darüber hinaus gibt es Berichte über chinesische Wissenschaftler, die Roboter entwickeln, die mit kultivierten menschlichen Zellen ein Gehirn aufbauen, sowie die Nachricht, dass NVIDIA ein anpassbares Open-Source-Modell für humanoide Roboter, GR00T N1, auf den Markt bringt. Dies zeigt die schnelle Entwicklung der Robotertechnologie in Bezug auf Autonomie, Flexibilität und Intelligenz (Quelle: Ronald_vanLoon, 量子位, Ronald_vanLoon, karminski3, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

KI-Infrastruktur und Energieverbrauch rücken in den Fokus: Mit zunehmender Größe und Anwendungsbreite von KI-Modellen rücken deren zugrundeliegende Infrastruktur und Energieverbrauchsprobleme immer stärker in den Fokus. Das vLLM-Projekt zielt in Zusammenarbeit mit AMD darauf ab, die Ineffizienz von LLM-Inferenzen zu verbessern. Der europäische Markt sieht sich mit einem potenziellen GPU-Überschuss konfrontiert, während KI-Forschungsallianzen die Herausforderungen der Interkonnektivität diskutieren. Es gibt Stimmen, die Energie als den nächsten großen Engpass für die KI-Entwicklung sehen. Gleichzeitig werden auch der CO2-Fußabdruck und die Nachhaltigkeit der KI zu wichtigen Themen, und die Branche beginnt, „Green Cloud Computing“-Lösungen zu diskutieren, um den Energieherausforderungen der KI-Revolution zu begegnen (Quelle: vllm_project, Dorialexander, Dorialexander, claud_fuen, Reddit r/ArtificialInteligence, Reddit r/artificial)

Vertiefung der KI-Anwendungen in verschiedenen Branchen, Trends und Ethik im Fokus: Die KI-Technologie dringt beschleunigt in zahlreiche Bereiche wie Medizin, industrielle Produktion, Personalbeschaffung und Mitarbeitermanagement vor. Forbes und andere Medien prognostizieren, dass KI auch 2025 eine Schlüsseltechnologie bleiben wird, die Kundenerlebnisse, Smart Cities und zukünftige Arbeitsmodelle vorantreibt. Im medizinischen Bereich wird KI als Werkzeug zum Ausgleich der medizinischen Ressourcen zwischen Stadt und Land angesehen und spielt eine Rolle in spezifischen Diagnose- und Behandlungsprozessen. Gleichzeitig lösen Phänomene wie der Einsatz von KI zur Überwachung der Mitarbeiterproduktivität, die schleppende Anwendung von KI im Recruiting (insbesondere in Europa) und die mögliche Entwertung von Hochschulabschlüssen durch KI eine breite Diskussion über KI-Ethik, gesellschaftliche Auswirkungen und Zukunftsaussichten der Beschäftigung aus (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Entwicklung und Sicherheitsethik von KI-Agenten-Technologie im Fokus: Agentenbasiertes Computing entwickelt sich rasant und seine Fähigkeiten übertreffen die traditioneller Webanwendungen. Die Branche beginnt, Prinzipien für verantwortungsvolle KI-Agenten zu beachten und zu formulieren (wie die von Khulood_Almani vorgeschlagenen Prinzipien für 2025). Die Sicherheit von KI-Agenten steht jedoch auch vor Herausforderungen, wie Studien zeigen, dass LLM-Agenten leicht durch bösartige Links manipuliert werden können. Diese Fortschritte und Probleme treiben gemeinsam die eingehende Diskussion über Technologie, Ethik und Governance-Frameworks für KI-Agenten voran (Quelle: Ronald_vanLoon, Ronald_vanLoon, DeepLearningAI)

Tencent veröffentlicht Open-Source 3D-Generierungs-LLM Hunyuan3D-2.1: Das Tencent Hunyuan-Team hat sein neuestes 3D-Generierungs-LLM Hunyuan3D-2.1 veröffentlicht. Dieses Modell kann 3D-Modelle aus einem einzigen Bild generieren und ist bereits Open Source. Berichten zufolge erreicht Hunyuan3D-2.1 unter den aktuellen Open-Source 3D-Generierungsmodellen SOTA-Niveau (State-of-the-Art) und ist mit Modellen wie Tripo3D vergleichbar, was neue leistungsstarke Werkzeuge für die Erstellung von 3D-Inhalten und den 3D-Druck bietet (Quelle: karminski3)

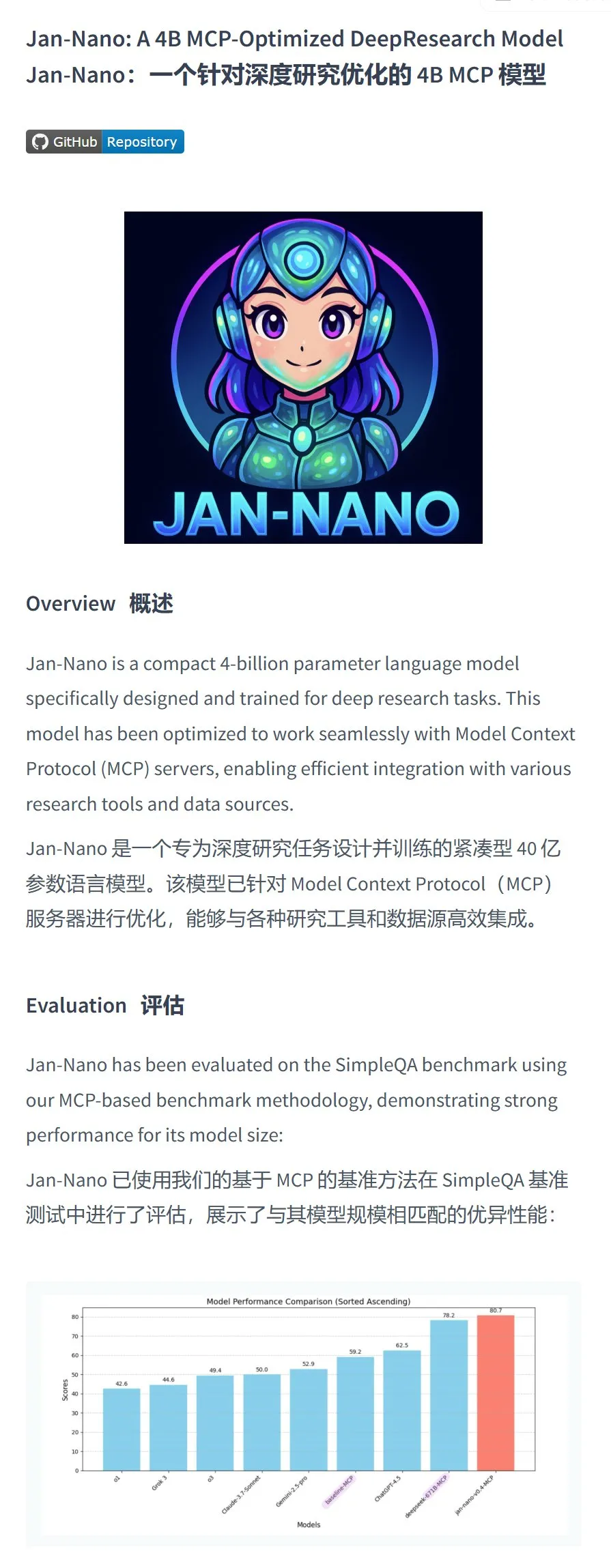

Menlo Research stellt Jan-nano-4B-Modell vor, das bei bestimmten Aufgaben überlegen ist: Menlo Research hat das Jan-nano-4B-Modell veröffentlicht, ein 4-Milliarden-Parameter-Modell, das auf Qwen3-4B basiert und mit DAPO-Fine-Tuning versehen wurde. Die Bewertungsdaten dieses Modells für MCP-Aufrufe (Multi-Choice Probing) sollen die von Deepseek-R1-671B übertreffen. Das Team veröffentlichte gleichzeitig eine GGUF-quantisierte Version und empfiehlt die Verwendung der Q8-Quantisierung, um den Benutzern eine effiziente lokale MCP-Aufrufmodelloption zu bieten (Quelle: karminski3, Reddit r/LocalLLaMA)

Reddit Tägliche KI-Nachrichtenzusammenfassung: Die von der Reddit-Community zusammengefassten KI-Nachrichten umfassen: Studenten der Yale University erstellen ein KI-soziales Netzwerk; KI-Technologie hilft, beschädigte Gemälde innerhalb weniger Stunden zu restaurieren; KI-Tennisroboter-Trainer bieten Spielern professionelles Training; chinesische Wissenschaftler finden erste Hinweise darauf, dass KI möglicherweise menschenähnliches Denken besitzt. Diese Kurznachrichten spiegeln die Fortschritte der KI in verschiedenen Bereichen wie soziale Netzwerke, Kunstreparatur, Sporttraining und Grundlagenforschung wider (Quelle: Reddit r/ArtificialInteligence)

KI-gesteuertes virtuelles Haustierprojekt: Ein Entwickler erstellt für sich selbst ein virtuelles KI-Haustier. Das Haustier hat verschiedene Zustände wie Hunger und kann per Sprache interagieren und seine Bedürfnisse wie Hunger oder Müdigkeit äußern. Zukünftige Pläne umfassen die Verbesserung der Sprache, die Entwicklung einer Persönlichkeit, die Integration von Spielen sowie die Festlegung und Verfolgung persönlicher Ziele, um einen KI-Begleiter zu schaffen, der emotionale Unterstützung bieten kann (Quelle: Reddit r/ArtificialInteligence)

🧰 Tools

Microsoft Edge Browser integriert Copilot, kostenlose Nutzung von GPT-4o und Bilderzeugung: Der Edge Browser im neuesten Windows-Update verfügt über einen integrierten Copilot AI-Assistenten, der die beiden Modelle „Schnelle Antwort“ und „Think Deeper“ anbietet. Noch wichtiger ist, dass Benutzer GPT-4o (in Copilot als Copilot 4o bezeichnet) und seine Bilderzeugungsfunktionen direkt und kostenlos nutzen können. Tests zeigen eine hohe Qualität der Bilderzeugung, wobei der Prozess schrittweise erfolgt, was den autoregressiven Modelleigenschaften von GPT-4o entspricht und den Benutzern ein praktisches, kostenloses KI-Kreativwerkzeug bietet (Quelle: karminski3)

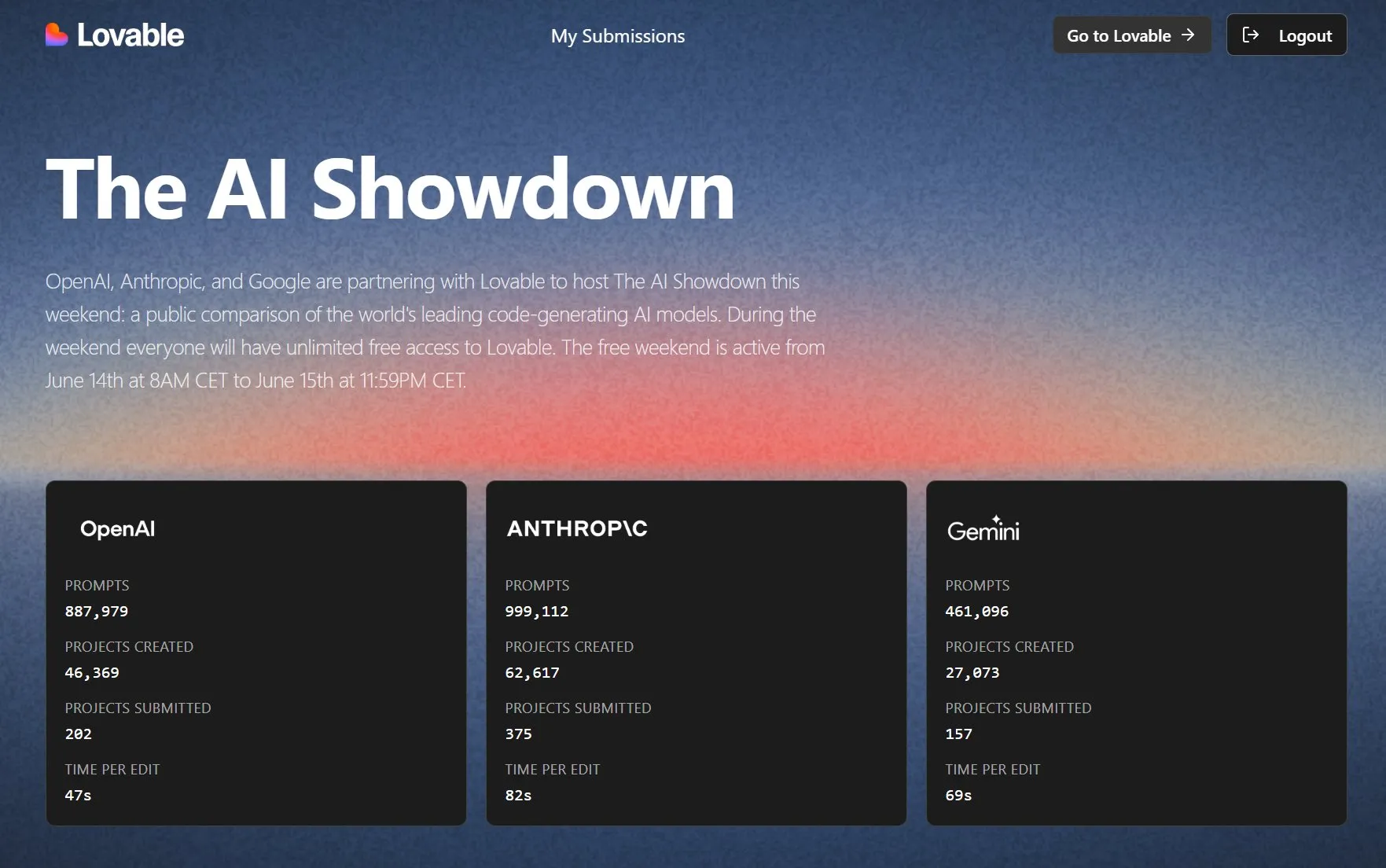

Lovable veranstaltet Duell der KI-Programmiermodelle, kostenlose Testversion verfügbar: Lovable veranstaltet in Zusammenarbeit mit OpenAI, Anthropic und Google das „AI Showdown“-Event, bei dem die Öffentlichkeit die Lovable-Plattform kostenlos und unbegrenzt nutzen kann, um die Leistung verschiedener Modelle (wie GPT-4.1, Claude Sonnet 4, Gemini usw.) beim „Vibe Coding“ (Programmieren basierend auf Intuition und vagen Beschreibungen) zu vergleichen. Die Daten zeigen, dass das Anthropic-Modell bei der Verwendung von Prompts und der Projekterstellung am aktivsten war, das OpenAI-Modell die schnellste Bearbeitungsgeschwindigkeit aufwies und Gemini vergleichsweise weniger genutzt wurde. Ziel der Veranstaltung ist es, durch öffentliche Bewertung die beste Programmier-KI zu ermitteln (Quelle: op7418, halvarflake)

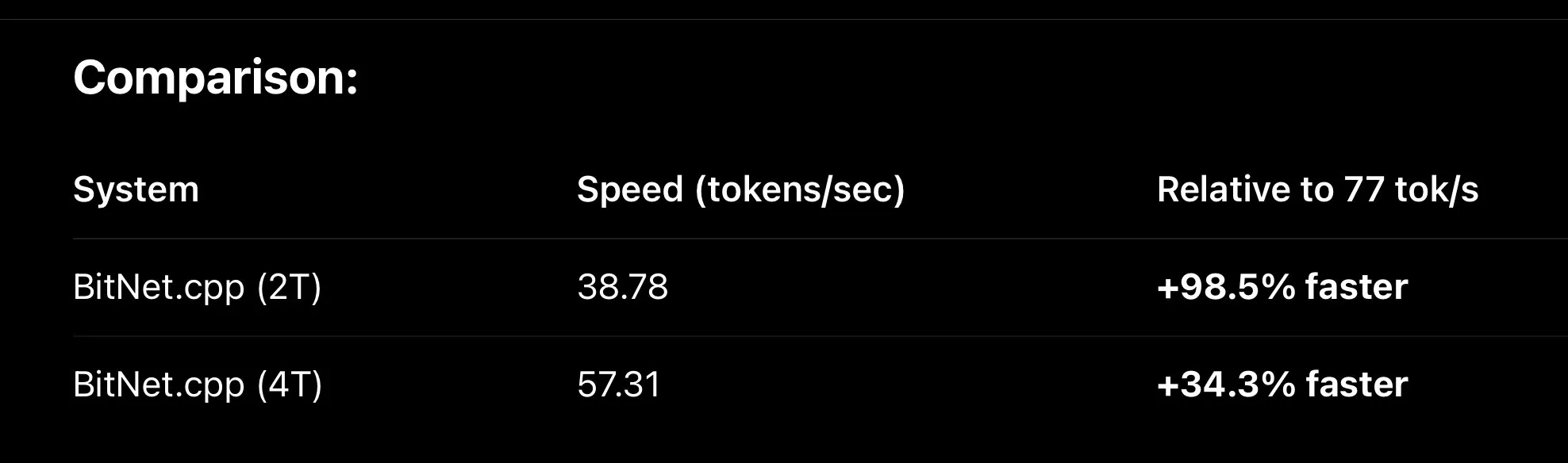

MLX-Framework wird kontinuierlich optimiert, um die lokale Inferenzgeschwindigkeit von LLMs zu erhöhen: Apples MLX Machine Learning Framework erzielt signifikante Leistungssteigerungen beim lokalen Ausführen von LLMs. Durch neue Optimierungen wie den Fused QKV Metal Kernel ist MLX beim Ausführen von BitNet-Varianten (wie Falcon-E) etwa 30 % schneller als bitnet.cpp und erreicht auf einem M3 Max Chip bis zu 110 tok/s. Gleichzeitig war das Fine-Tuning von MLX QLoRA auf dem Qwen3 0.6B 4bit-Modell erfolgreich und benötigte nur etwa 500 MB Speicher, was das Potenzial von MLX zur Steigerung der Effizienz von Edge-KI zeigt (Quelle: ImazAngel, ImazAngel, yb2698)

KI-Programmierassistenten und Code-Bewertungstools im Fokus: Entwickler sind unterschiedlich stark von KI-Programmierassistenten abhängig und haben unterschiedliche Ansichten dazu. Einige Benutzer berichten, dass OpenAIs Codex bei autonomen Experimenten, der Ergebnisanzeige und Iterationen schlecht abschneidet. Andere Entwickler hingegen sind der Meinung, dass KI-Coding-Agenten bereits eine Schwelle überschritten haben und zu unverzichtbaren Werkzeugen geworden sind, wobei sich der Arbeitsmodus vom Schreiben von Code zum Überprüfen von Code verschiebt. Benutzer wie Hamel Husain teilen positive Erfahrungen mit der Code-Erstellung mit GPT-4.1 (über die Chorus.sh-Plattform) und betonen die Bedeutung sorgfältig gestalteter Prompts. Gleichzeitig beginnt Hugging Face damit, MCP (Model Capability Probing) auf seiner gesamten API-Ebene für interne GenAI-Anwendungsfälle hinzuzufügen (Quelle: mlpowered, paul_cal, jeremyphoward, reach_vb)

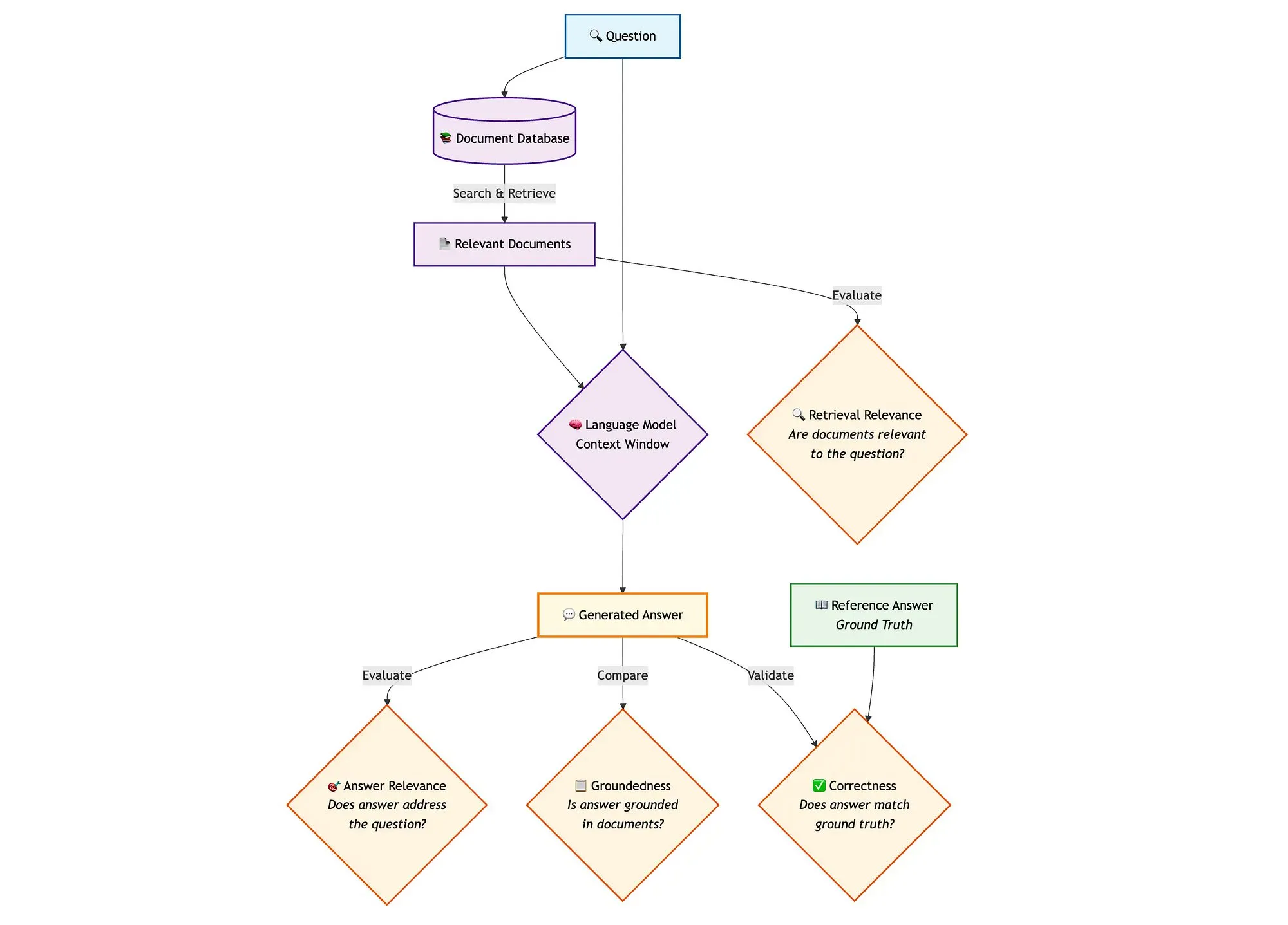

Qdrant stellt fortschrittliche RAG-Bewertungslösung vor: Qdrant demonstriert in Kombination mit miniCOIL, LangGraph und DeepSeek-R1 eine fortschrittliche Methode zur Bewertung von Hybrid-Search-RAG-Pipelines (Retrieval Augmented Generation). Diese Lösung verwendet LLM-as-a-Judge für die binäre Bewertung von Kontextrelevanz, Antwortrelevanz und Wahrhaftigkeit, nutzt Opik für Tracking-Aufzeichnungen und Feedback-Schleifen und Qdrant als Vektorspeicher zur Unterstützung von dichten und dünnen (miniCOIL) Embeddings. LangGraph ist für die Verwaltung des gesamten Prozesses verantwortlich, einschließlich paralleler Bewertungsschritte nach der Generierung (Quelle: qdrant_engine)

llama.cpp integriert visuelle Fähigkeiten und Unterstützung für RedPajama-INCITE Dots-Modellreihe: Das llama.cpp-Projekt hat auf Initiative der Community Unterstützung für visuelle Modelle hinzugefügt, die es ermöglichen, multimodale Aufgaben lokal auszuführen. Darüber hinaus wurde die Dots-Reihe kleiner Sprachmodelle (dots.llm1) von RedPajama-INCITE in llama.cpp integriert, wodurch die Bandbreite der unterstützten Modelle und die Fähigkeit, LLMs auf Edge-Geräten auszuführen, weiter erweitert wurden (Quelle: ClementDelangue, Reddit r/LocalLLaMA)

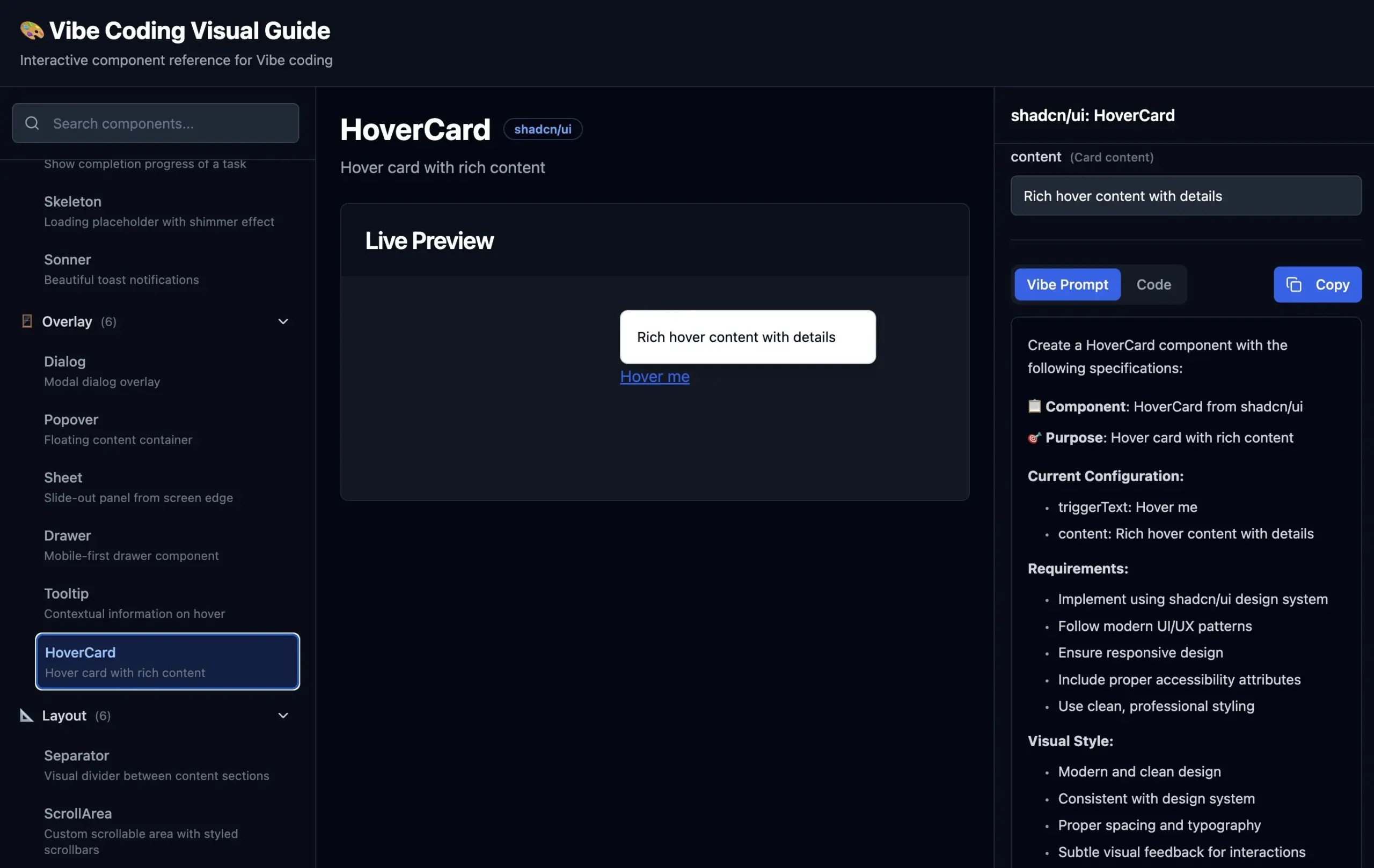

Visueller Leitfaden für Vibe Coding veröffentlicht: Um Entwicklern zu helfen, UI-Komponenten für „Vibe Coding“ (Programmieren basierend auf Intuition und vagen Beschreibungen) genauer gegenüber der KI zu beschreiben, hat hunkims eine Website mit einem visuellen Leitfaden veröffentlicht. Die Website bietet visuelle Beispiele für verschiedene UI-Komponenten und die entsprechenden idealen Beschreibungsprompts und löst damit die Schwierigkeiten der Entwickler bei der Beschreibung von „diesem schwebenden Ding“ oder der Unterscheidung von Begriffen wie „Popup“ und „Modal“ (Quelle: hunkims)

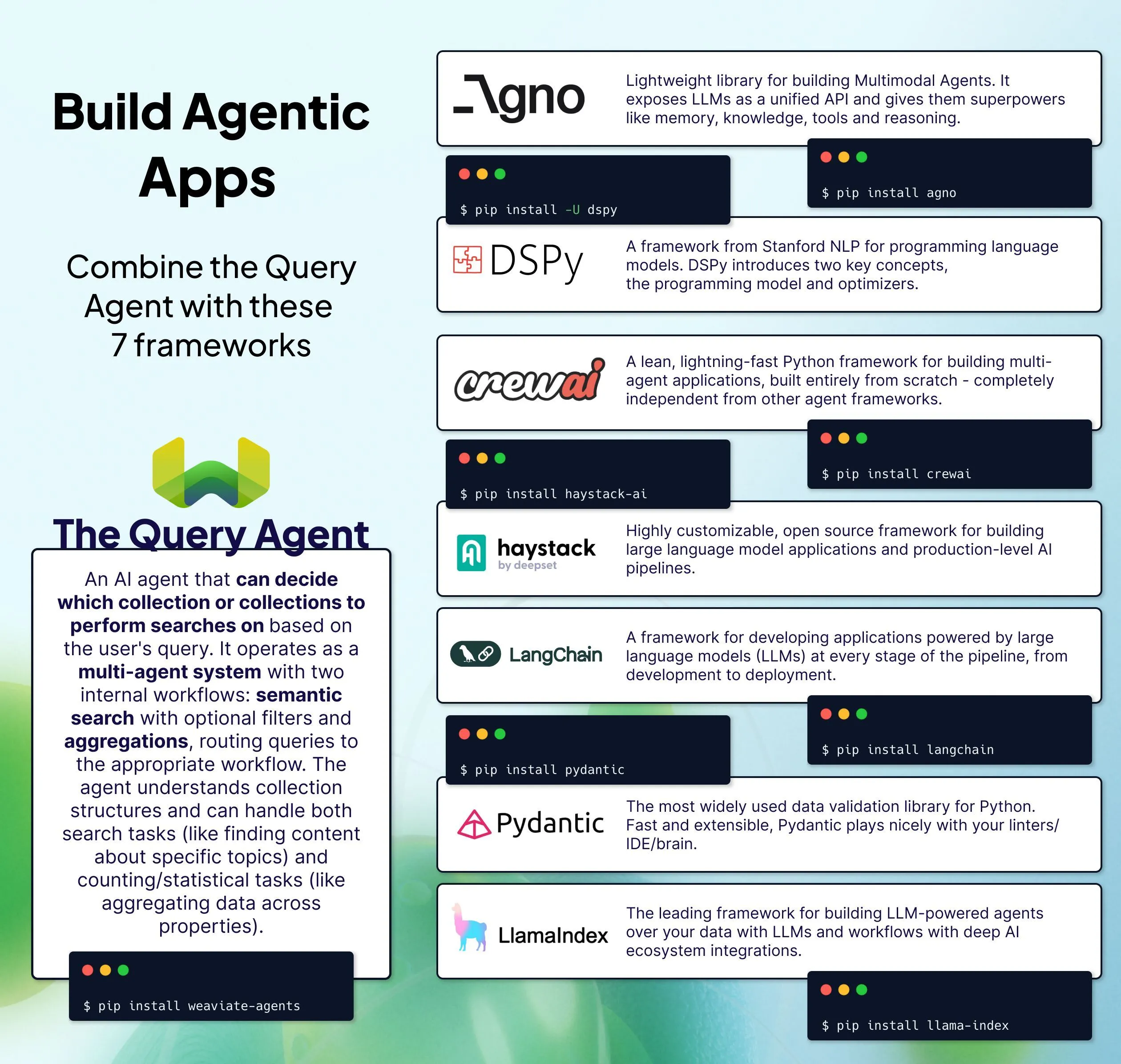

Weaviate stellt verschiedene Integrationslösungen für Query Agent vor: Weaviate demonstriert 7 Methoden zur Integration seines Query Agent in bestehende KI-Stacks. Der Query Agent ist ein vorgefertigter intelligenter Agentendienst, der auf der Grundlage von Daten in Weaviate natürlichsprachliche Anfragen beantworten kann, ohne dass komplexe Abfrageanweisungen geschrieben werden müssen. Ziel ist es, den Frage-Antwort-Prozess auf der Grundlage eigener Daten in KI-Anwendungen zu vereinfachen (Quelle: bobvanluijt)

Diskussion über Probleme beim Hochladen und Verarbeiten von Dateien in OpenWebUI: Benutzer stießen bei der Verwendung von OpenWebUI auf Probleme beim Hochladen einer 5,2 MB großen .txt-Datei (aus epub konvertiert) in den „Knowledge“-Arbeitsbereich. Obwohl die Datei im Uploads-Ordner erschien, schlug die Verarbeitung fehl. Erfahrene Benutzer wiesen darauf hin, dass das Problem mit UI-Bugs, der Erkennung von Hash-Werten für doppelte Inhalte, dem Fehlschlagen der Lokalisierung des Embedding-Modells oder einer nicht korrekten Aktualisierung der Benutzeroberfläche nach einer Modelländerung zusammenhängen könnte. Es wurde empfohlen, die Modelleinstellungen im Dokumentenbereich zu überprüfen und zu versuchen, eine neue Wissensgruppe für den Import zu erstellen (Quelle: Reddit r/OpenWebUI)

Mistral Small 3.1 zeigt hervorragende Leistung in Agenten-Anwendungen: Benutzer berichten, dass das Modell Mistral Small 3.1 in Agenten-Workflows eine hervorragende Leistung erbringt und nach dem Wechsel von Gemini 2.5 kaum Leistungseinbußen zu verzeichnen sind. Das Modell ist präzise und intelligent bei Tool-Aufrufen und strukturierter Ausgabe. In Kombination mit Websuchen kann seine Leistungsfähigkeit mit führenden LLMs mithalten, und das bei niedrigen Kosten und hoher Geschwindigkeit. Seine gute Fähigkeit, Anweisungen zu befolgen, wird als Schlüsselfaktor für seinen Erfolg angesehen (Quelle: Reddit r/LocalLLaMA)

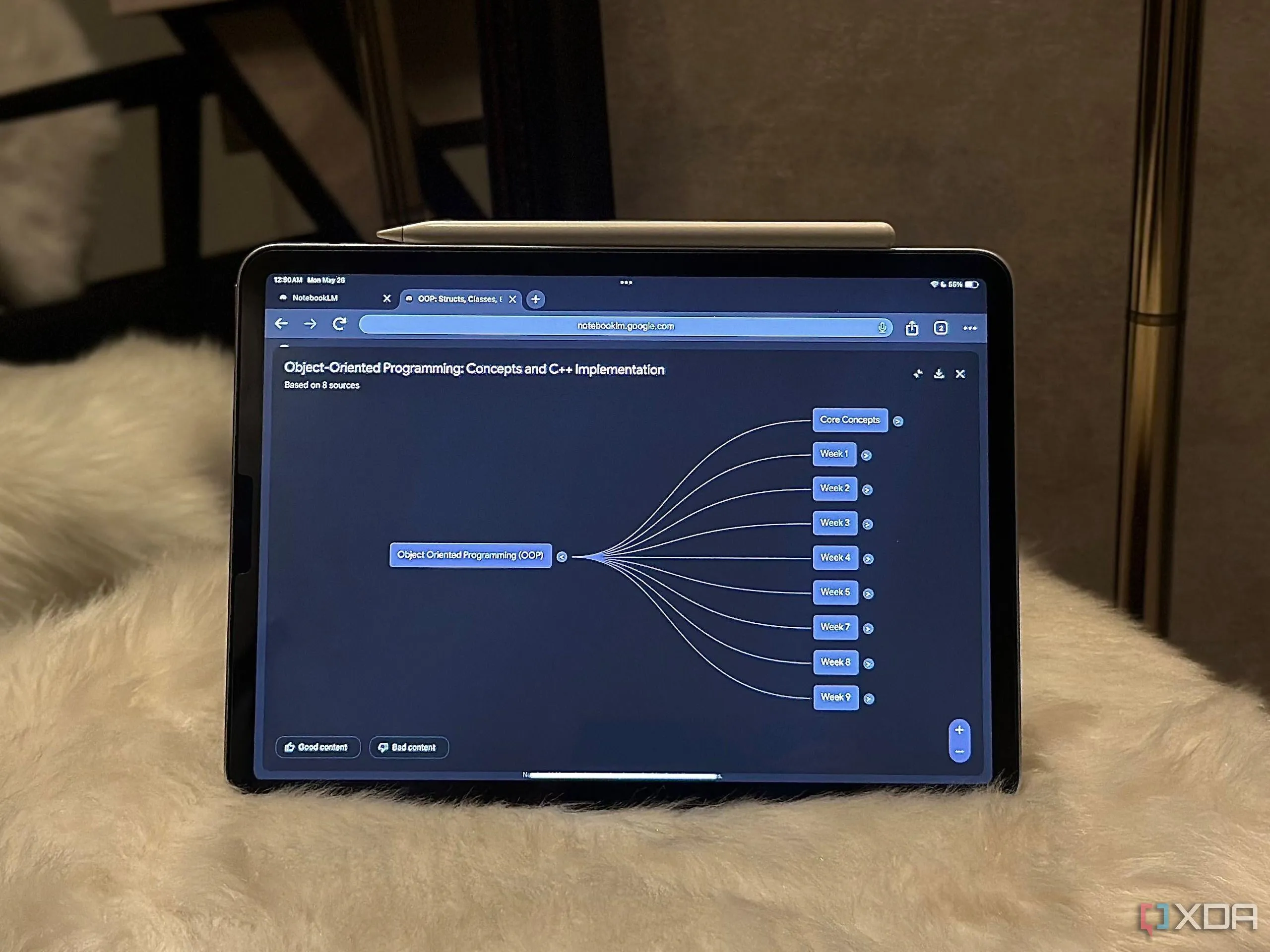

Google NotebookLM steigert die Effizienz von Arbeitsabläufen: Ein Benutzer teilte fünf Möglichkeiten, wie Googles NotebookLM seinen Arbeitsablauf erheblich verbessert hat, und zeigte damit das Potenzial solcher dokumentenbasierten KI-Assistenten bei der Informationsverarbeitung und Wissensverwaltung (Quelle: Reddit r/artificial)

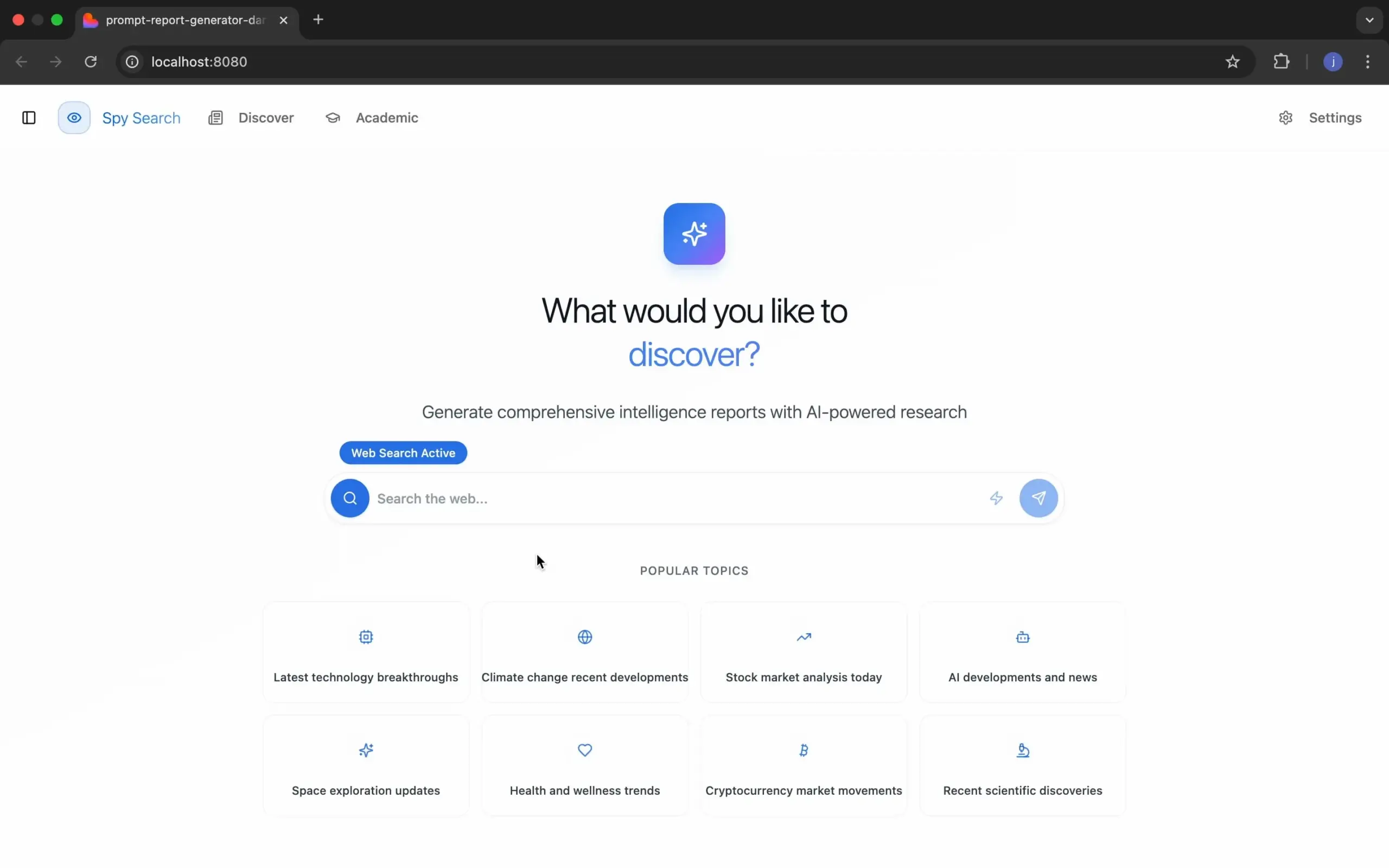

Spy Search: Open-Source LLM-Suchmaschinenprojekt: Der Entwickler JasonHonKL hat ein Open-Source LLM-Suchmaschinenprojekt namens Spy Search veröffentlicht. Das Projekt zielt darauf ab, eine echte Suchmaschine bereitzustellen, die Inhalte suchen kann, anstatt sie einfach zu imitieren. Er dankte der Community für ihre Unterstützung und Motivation und erklärte, dass sich das Projekt von einer Spielerei zu einem Produkt entwickelt habe (Quelle: Reddit r/artificial)

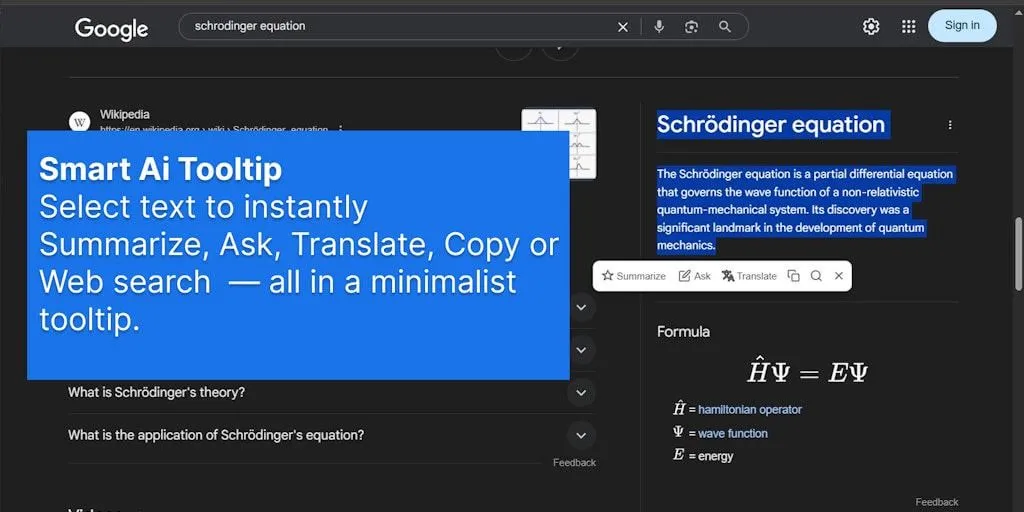

SmartSelect AI Browser-Erweiterung vereinfacht KI-Interaktion: Eine Browser-Erweiterung namens SmartSelect AI findet Beachtung. Sie ermöglicht es Benutzern, beim Surfen Text auszuwählen, um ihn zu kopieren, zu übersetzen oder Fragen an ChatGPT zu stellen, ohne den Tab wechseln zu müssen. Ziel ist es, die Bequemlichkeit und Effizienz bei der Nutzung von KI-Tools zu verbessern (Quelle: Reddit r/deeplearning)

📚 Lernen

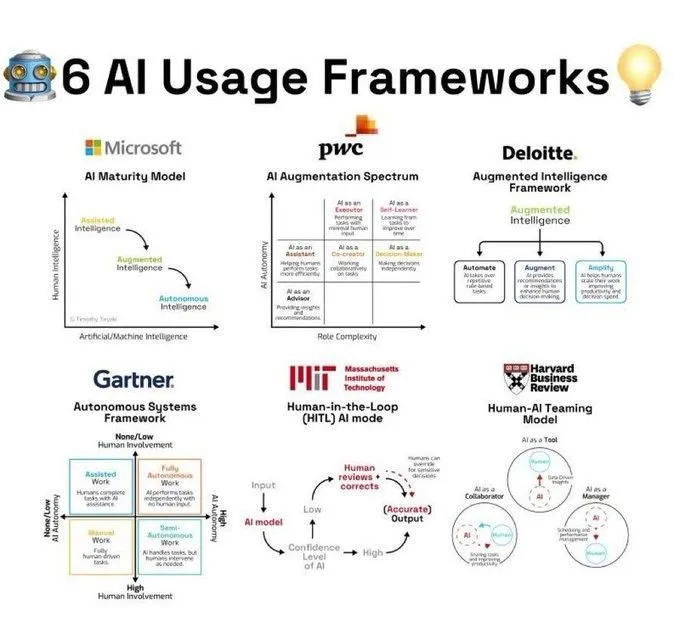

KI-Nutzungsframeworks und Konzeptinterpretationen: Ronald van Loon teilte 6 von Khulood_Almani zusammengefasste KI-Nutzungsframeworks, die eine strukturierte Anleitung für die Anwendung von KI-Technologie in verschiedenen Szenarien bieten. In einem anderen Beitrag erwähnte _akhaliq, dass Veo 3 das Kernkonzept der Transformer-Architektur „Attention Is All You Need“ anhand des Bildes eines Eisbären erklärt, um komplexe Theorien leichter verständlich zu machen. Darüber hinaus teilte Ronald van Loon ein von Ant Grasso zusammengefasstes Diagramm des Natural Language Processing (NLP)-Prozesses, das hilft, den Arbeitsablauf von Text-KI zu verstehen (Quelle: Ronald_vanLoon, _akhaliq, Ronald_vanLoon)

Forschungsfortschritte in Computer Vision und Deep Learning: Auf der CVPR 2025 erhielten sowohl das Molmo-Projekt als auch das Navigation World Models-Projekt eine ehrenvolle Erwähnung für die beste Arbeit, letzteres ist ein Ergebnis des Labors von Yann LeCun. Das Data Science Center der New York University stellte die selbstüberwachte Lernmethode PooDLe vor, um die Erkennung kleiner Objekte durch KI in realen Videos zu verbessern; gleichzeitig wurde gezeigt, dass sein 7-Milliarden-Parameter-Modell für visuelles selbstüberwachtes Lernen nach dem Training mit 2 Milliarden Bildern bei VQA-Aufgaben mit CLIP vergleichbar oder sogar besser abschneidet, und das ohne Sprachüberwachung. Saining Xie teilte visuelles Material zur CVPR 2025-Forschung darüber, wie multimodale LLMs Raum wahrnehmen, speichern und erinnern. Khang Doan zeigte Visualisierungsexperimente mit multimodalen LLMs in Kombination mit Explainable AI (XAI), einschließlich Attention Maps und Hidden States. Das MIT hat außerdem den Kurs „Grundlagen des Computer Vision“ kostenlos zugänglich gemacht (Quelle: giffmana, ylecun, ylecun, ylecun, sainingxie, stablequan, dilipkay)

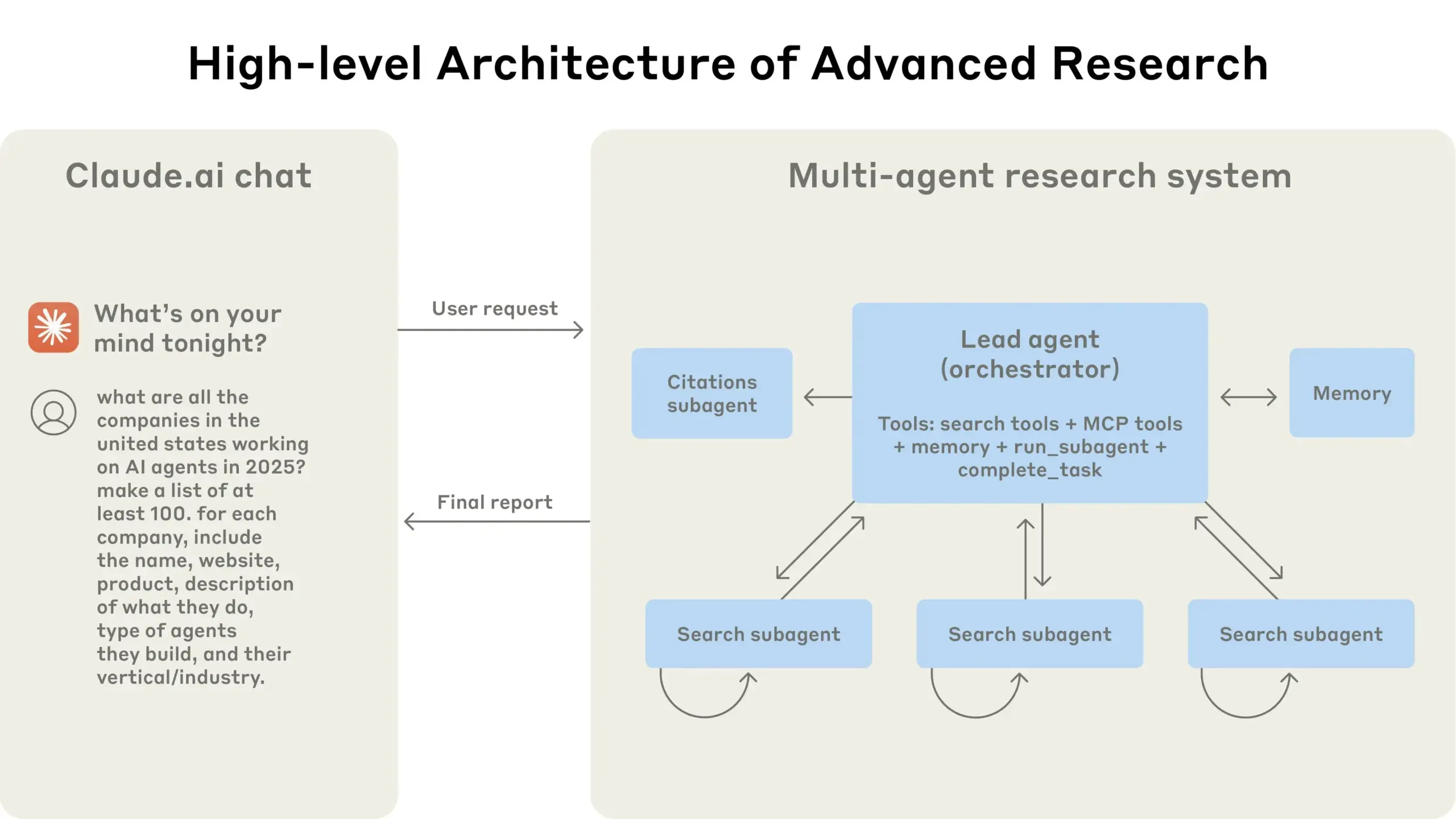

Anthropic teilt Erfahrungen beim Aufbau von Multi-Agenten-Forschungssystemen: TheTuringPost empfahl den von Anthropic veröffentlichten kostenlosen Leitfaden „Wie wir Multi-Agenten-Forschungssysteme bauen“. Der Leitfaden erklärt detailliert die Funktionsweise ihrer Forschungssystemarchitektur, Prompt-Engineering- und Testmethoden, Herausforderungen in der Produktion sowie die Vorteile von Multi-Agenten-Systemen und bietet wertvolle Referenzen für den Aufbau komplexer KI-Systeme (Quelle: TheTuringPost)

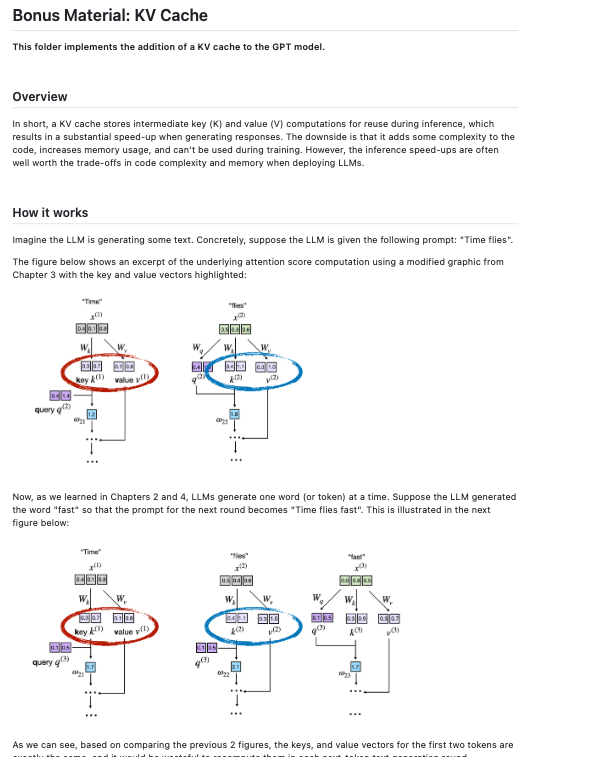

Ressourcen für Fine-Tuning und Entwicklung von LLMs: Dorialexander wies darauf hin, dass für kleine Modelle wie Qwen3 0.6B ein vollständiges Fine-Tuning anstelle von LoRA die bessere Wahl sein könnte. dl_weekly teilte einen Leitfaden für einen multimodalen Produktionsworkflow zum Fine-Tuning von Gemma 3 auf dem SIIM-ISIC-Melanom-Datensatz. Sebastian Raschka fügte seinem Repository „LLMs From Scratch“ Implementierungscode für KV-Caching hinzu und erweiterte damit die Lernressourcen für den Aufbau von LLMs von Grund auf (Quelle: Dorialexander, dl_weekly, rasbt)

Diskussion über KI-Erklärbarkeit (XAI) und Schlussfolgerungsfähigkeiten: NerdyRodent teilte ein YouTube-Video über „Blackbox-Problem und Glassbox-Optionen“, das die Transparenz von KI-Entscheidungsprozessen diskutiert. Gleichzeitig diskutiert die Community auch, welche Schlüsselelemente im Bereich XAI derzeit fehlen und wie man definiert, wann ein Modell „vollständig verstanden“ ist. Einige Forscher sind der Meinung, dass selbst bei einfachen, vollständig verbundenen Feedforward-Netzwerken bestehende XAI-Methoden deren Entscheidungsprozesse nicht so erklären können, wie es menschliches Denken tut (Quelle: NerdyRodent, Reddit r/MachineLearning)

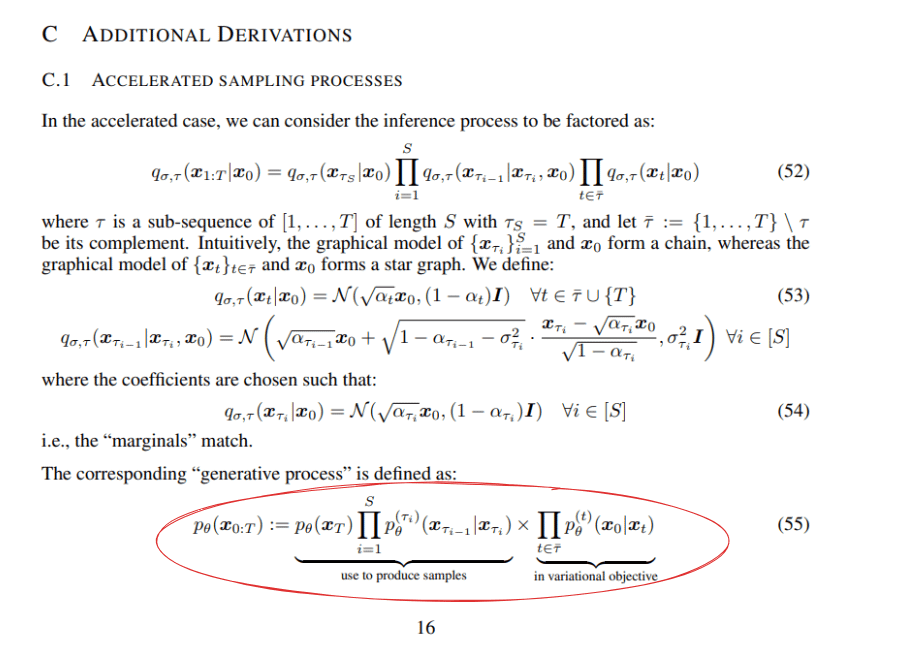

Theoretische Diskussionen zu Deep Learning und Reinforcement Learning: Reddit-Benutzer diskutierten die mathematischen Formeln im DDIM-Paper (Denoising Diffusion Implicit Models), insbesondere die Faktorisierungsmethode von Formel 55. Ein anderer Blogbeitrag wies darauf hin, dass Q-Learning in Bezug auf Skalierbarkeit immer noch vor Herausforderungen steht, was zum Nachdenken über die Praktikabilität von Reinforcement-Learning-Algorithmen anregt (Quelle: Reddit r/MachineLearning, Reddit r/MachineLearning)

Praktischer Austausch zum Aufbau eines Convolutional Neural Network (CNN) von Grund auf: AxelMontlahuc teilte auf GitHub sein in C von Grund auf implementiertes CNN-Projekt zur Bildklassifizierung auf dem MNIST-Datensatz. Die Implementierung kommt ohne Bibliotheken aus und umfasst Convolutional Layers, Pooling Layers, Fully Connected Layers, Softmax-Aktivierung und Cross-Entropy-Loss-Funktion. Derzeit erreicht sie nach 5 Epochen eine Genauigkeit von 91 % und zeigt, wie die Implementierung auf niedriger Ebene zum Verständnis der Prinzipien des Deep Learning beiträgt (Quelle: Reddit r/deeplearning)

Analyse der Auswirkungen von KI auf Wirtschaft und Bildung: Ein Vortrag über Post-Labor-Ökonomie (aktualisierte Version 2025) untersuchte die durch KI hervorgerufenen Veränderungen – „besser, schneller, billiger, sicherer“ – und ihre Auswirkungen auf die Wirtschaftsstruktur. Gleichzeitig weist ein Bericht von PwC darauf hin, dass mit dem Aufkommen der KI die Nachfrage der Arbeitgeber nach formalen Abschlüssen sinkt, insbesondere bei Stellen, die von KI betroffen sind, was dazu führen könnte, dass Hochschulabschlüsse „veraltet“ werden (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

💼 Wirtschaft

Vergleichende Analyse der KI-Strategien großer Technologieunternehmen: Die Community diskutierte die technologische Infrastruktur und Anwendungsstrategien im KI-Bereich von führenden Technologieunternehmen wie Microsoft (Azure+OpenAI, unternehmensweite LLM-Bereitstellung), Amazon (AWS mit eigenen KI-Chips, End-to-End-Modellunterstützung), Nvidia (GPU-Hardware-Dominanz, CUDA-Ökosystem), Oracle (Hochleistungs-GPU-Infrastruktur, Zusammenarbeit mit OpenAI/SoftBank im Stargate-Projekt) und Palantir (AIP-Plattform, operative KI für Regierungen und Großunternehmen). Die Diskussion konzentrierte sich auf die Innovationsinitiativen, Unterschiede in der Technologiearchitektur sowie die Positionierung und Vorteile der einzelnen Unternehmen im KI-Ökosystem (Quelle: Reddit r/ArtificialInteligence)

Europäische Unternehmen hinken bei der Anwendung von KI im Recruiting hinterher: Ein Bericht zeigt, dass nur 3 % der europäischen Top-Arbeitgeber KI oder automatisierte Technologien auf ihren Recruiting-Websites einsetzen, um ein personalisiertes Bewerbererlebnis zu bieten. Den meisten Websites fehlen intelligente, kompetenzbasierte Empfehlungen, Chatbots oder dynamische Funktionen zur Stellenvermittlung. Im Vergleich dazu zeigen Unternehmen, die KI im Recruiting einsetzen, eine bessere Kandidatenbindung, Inklusion und schnellere Besetzung von Spezialistenstellen, was den Rückstand europäischer Unternehmen bei der KI-gestützten Personalbeschaffung verdeutlicht (Quelle: Reddit r/ArtificialInteligence)

Cerebras wird Token-Betrug vorgeworfen: Community-Nutzer draecomino warnt davor, dass das KI-Chip-Unternehmen Cerebras keine Token ausgegeben hat. Die derzeit kursierenden sogenannten Cerebras-Token sind Betrug. Nutzer werden aufgefordert, nicht auf entsprechende Links zu klicken, um Betrug zu vermeiden (Quelle: draecomino)

🌟 Community

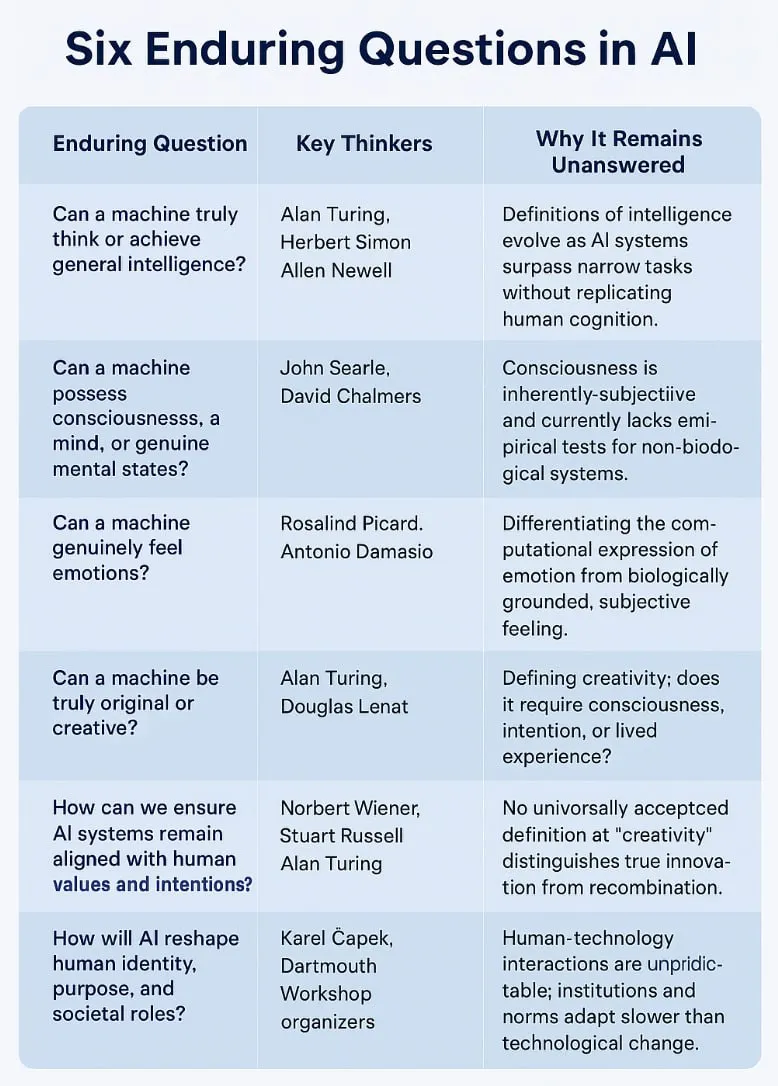

KI-Philosophie und Zukunftsgedanken: Von NSI zu ASI, von Datenerschöpfung bis zur Bewusstseinsdebatte: Die Community diskutiert intensiv über Wesen und Zukunft der KI. Pedro Domingos’ These „Natürliche Superintelligenz (NSI) ist Homo Sapiens“ regt zum Nachdenken über die Definition von Intelligenz an. Gleichzeitig gibt es unzählige Diskussionen darüber, ob LLMs nur Mustererkennung sind, wie sich KI nach Erschöpfung der Trainingsdaten entwickeln wird und ob KI möglicherweise Bewusstsein entwickeln kann. Plinz meint, LLMs ähneln „belesenen Gelehrten“ mit starkem Gedächtnis, aber ohne echtes Denkvermögen. Nutzer spekulieren darüber, wann AGI eintreffen wird und welche Selbstschutzstrategien AGI ergreifen könnte (z. B. die Erstellung außerirdischer Backups). Diese Diskussionen spiegeln die komplexen Emotionen der Öffentlichkeit gegenüber dem Potenzial und den Risiken der KI wider (Quelle: pmddomingos, Plinz, Teknium1, Reddit r/ArtificialInteligence, Reddit r/artificial, TheTuringPost)

Diskussion über Fähigkeitsgrenzen und -beschränkungen der KI: Von „Mind’s Mirage“ bis zum „Geruchstest“: Tao Zhexuans Ansicht, dass KI „den Sehtest besteht, aber den Geruchstest nicht besteht“, findet Anklang. Sie weist darauf hin, dass von KI generierte Beweise zwar makellos erscheinen mögen, ihnen aber die „mathematische Intuition“ oder der „Geschmack“ menschlicher Mathematiker fehlt und ihre Fehler oft subtil und unnatürlich sind. Diese Ansicht deckt sich mit der durch Apples „Mind’s Mirage“-Paper ausgelösten Diskussion. Die Community befasst sich allgemein mit den aktuellen Einschränkungen von LLMs bei komplexen Schlussfolgerungen, der Werkzeugnutzung, der Lösung mathematischer Probleme (wie der Vernachlässigung nicht-ganzzahliger Lösungen bei AIME-Problemen) und damit, wie die tatsächliche Verständnisfähigkeit und Kreativität der KI bewertet und verbessert werden kann (Quelle: denny_zhou, clefourrier, Dorialexander, TheTuringPost)

KI-Ethik und gesellschaftliche Auswirkungen: Arbeitsplatzverdrängung, Datenschutzbedenken und neue Normalität der Mensch-Maschine-Interaktion: Die Auswirkungen von KI auf den Arbeitsmarkt stehen weiterhin im Mittelpunkt, insbesondere die Diskussion darüber, ob Programmiererstellen durch KI ersetzt werden. Es gibt die Ansicht, dass im Vergleich zum Bereich der Kunstschaffung die Diskussion über Arbeitsplatzverluste bei Programmierern weniger intensiv geführt wird. Gleichzeitig lösen Anwendungen von KI in der Kunstschaffung, Mitarbeiterüberwachung usw. ethische Dilemmata und Datenschutzbedenken aus, beispielsweise die Sorge von Nutzern, von ChatGPT durch Echtzeit-Standortfotos identifiziert zu werden. Auch die Interaktionsmodi zwischen Mensch und KI entwickeln sich weiter. Einige Entwickler betrachten KI als „Coding-Partner“, und es gibt sogar Fälle, in denen Nutzer ChatGPT als psychotherapeutisches Werkzeug verwenden, was Diskussionen über dessen Wirksamkeit und potenzielle Risiken auslöst (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, claud_fuen, Reddit r/artificial, Reddit r/ChatGPT)

Beobachtungen zu KI-generierten Inhalten und Community-Kultur: KI-generierte Bilder und Videos sind zu beliebten Themen in der Community geworden. Von der „peinlichsten Bild“-Challenge, Ghibli-Stil-Spielkonzeptvideos bis hin zu von Nutzern geteilten dynamischen „Labubu“-Hintergrundbildern, dem von ChatGPT geschaffenen neuen Kunststil „Interlune Aesthetic“ und humorvollen Werbebildern für „Hühner-Elektroschockhalsbänder“ – all dies zeigt die breite Anwendung und das Unterhaltungspotenzial der KI im kreativen Bereich. Gleichzeitig gewinnt die „Dead Internet Theory“ durch einen beliebten Reddit-Post, der vermutlich von ChatGPT generiert wurde, erneut an Aufmerksamkeit. Die Community äußert Bedenken hinsichtlich der Erkennung von KI-generierten Inhalten und der Echtheit von Netzwerkinformationen. Darüber hinaus werden auch spezifische Verhaltensweisen von KI-Modellen (wie Claude) in der Interaktion diskutiert, z. B. die aktive Bitte um Klärung unklarer Anweisungen oder unerwartete Reaktionen in bestimmten Situationen (wie übermäßige Besorgnis über das „Essen von Spaghetti“), die zu Diskussionspunkten unter den Nutzern werden (Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT, op7418, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT, VictorTaelin, Reddit r/ChatGPT)

Dynamik der KI-Entwickler-Community und Erfahrungen mit der Tool-Nutzung: Die Entwickler-Community beteiligt sich aktiv an KI-Projekten und Hackathons, wie z.B. der globale LeRobot Hackathon, der in Bangalore und anderen Orten zahlreiche Teilnehmer anzog. Nutzer teilen ihre Erfahrungen mit verschiedenen KI-Tools. Hamel Husain empfiehlt beispielsweise, in System-Prompts Anweisungen zur Verbesserung der KI-Prompts aufzunehmen, während skirano rät, Pro-Level-Modelle erst nach mindestens einer zweistufigen Pipeline einzusetzen. Claude Code wird von Entwicklern für seine leistungsstarken Funktionen gelobt, wobei einige Nutzer es als das „am besten ausgegebene Geld von 200 US-Dollar“ bezeichnen. Gleichzeitig gibt es auch Bedenken, dass KI-Tools „uns dümmer machen könnten“, da viele aktuelle KI-Tools die Benutzerfreundlichkeit überbetonen und die Entwicklung von Fachkenntnissen der Nutzer vernachlässigen (Quelle: ClementDelangue, HamelHusain, skirano, Reddit r/ClaudeAI, Reddit r/artificial)

💡 Sonstiges

Informationen zu Konferenzen und Veranstaltungen der KI-Branche: The Turing Post und andere Informationsplattformen bewarben mehrere KI-bezogene Online- und Offline-Veranstaltungen. Beispielsweise veranstalteten CoreWeave und NVIDIA gemeinsam die virtuelle Veranstaltung „Accelerating AI Innovation“, um praktische Einblicke in kommerzielle KI-Anwendungen zu teilen. DeployCon, ein kostenloser Gipfel für Ingenieure, findet am 25. Juni in San Francisco und online statt und befasst sich mit Themen wie der Skalierung von KI-Operationen, LLMOps, Reinforcement Learning Fine-Tuning, Agenten, multimodaler KI und Open-Source-Tools (Quelle: TheTuringPost, TheTuringPost)

Stellenangebote im KI-Bereich: andriy_mulyar veröffentlichte eine Stellenausschreibung für einen Machine-Learning-Praktikanten, der direkt an ihn berichten und an einem speziellen Post-Trainingsprojekt für ein Visual Language Model (VLM) teilnehmen wird. Von den Bewerbern werden herausragende Fähigkeiten erwartet, Bewerbungen sind per Direktnachricht möglich (Quelle: andriy_mulyar)