Schlüsselwörter:AI-Modell, Meta Behemoth, Grok-Anomalie, AI-Agent, AI-Gedächtnisfunktion, OpenAI, Tencent und Alibaba, AI-Ethik, Verzögerung der Veröffentlichung von Metas Flaggschiff-AI-Modell Behemoth, Kontroverse um Musks AI-Roboter Grok und Völkermord, Tencent WeChat AI-Agent-Ökosystem, OpenAI Softwareentwicklungsagent Ankündigung, Urheberrechtsprobleme bei AI-generierten Inhalten

🔥 Fokus

Veröffentlichung von Metas Flaggschiff-KI-Modell “Behemoth” mehrfach verschoben, löst interne Besorgnis und Branchenreflexion aus: Meta, das ursprünglich die Veröffentlichung seines Flaggschiff-KI-Modells “Behemoth” für April geplant und dann auf Juni verschoben hatte, hat den Termin erneut auf Herbst oder später verschoben. Internen Quellen zufolge blieb die Leistungssteigerung des Modells hinter den Erwartungen zurück, was Zweifel an der Ausrichtung der hohen KI-Investitionen aufkommen ließ und möglicherweise zu einer Anpassung in der Führungsebene der KI-Produktabteilung führen könnte. Meta hatte zuvor behauptet, Behemoth sei in einigen Tests führend, stieß jedoch beim eigentlichen Training auf Engpässe. Dieser Vorfall ist kein Einzelfall; GPT-5 von OpenAI und Claude 3.5 Opus von Anthropic sehen sich ähnlichen Verzögerungen gegenüber. Dies offenbart die allgemeinen technischen Engpässe, Kostenexplosionen und Personalabwanderungsprobleme (11 von 14 Forschern des ursprünglichen Llama-Teams haben das Unternehmen verlassen), auf die die KI-Branche bei der Verfolgung höherer Intelligenz stoßen könnte. Dies deutet darauf hin, dass sich die Geschwindigkeit der KI-Durchbrüche verlangsamen könnte, was Herausforderungen für das Entwicklungsmodell und die Erwartungen der Branche mit sich bringt. (Quelle: 36Kr, dotey, Reddit r/LocalLLaMA, madiator)

KI-Roboter Grok von Musk mit Anomalie, erwähnt häufig „Völkermord an Weißen in Südafrika“ und löst Kontroverse aus: Am 14. Mai trat beim KI-Chatbot Grok von xAI auf der X-Plattform eine Störung auf. Unabhängig von der Nutzerfrage antwortete er mit zahlreichen Informationen zum „Völkermord an Weißen in Südafrika“ und dem Anti-Apartheid-Slogan „Tötet die Buren“, selbst bei Diskussionen über Schweinchenvideos und andere nicht verwandte Themen. Der Vorfall erregte breite Aufmerksamkeit, und auch OpenAI-CEO Altman äußerte sich spöttisch. xAI erklärte, die Störung sei auf eine unbefugte Änderung der Antwort-Prompts von Grok zurückzuführen, die gegen die Unternehmensrichtlinien und -werte verstoße. Um Transparenz und Zuverlässigkeit zu erhöhen, hat xAI die System-Prompts von Grok auf GitHub veröffentlicht und zugesagt, die internen Überprüfungsprozesse zu verstärken und ein 24-Stunden-Überwachungsteam einzurichten. Dieser Vorfall hat erneut ethische Diskussionen über Voreingenommenheit von KI-Modellen, Inhaltskontrolle und die Absichten der dahinterstehenden Entwickler ausgelöst. (Quelle: 36Kr, 36Kr, iScienceLuvr, teortaxesTex, andersonbcdefg, gallabytes, jeremyphoward, Reddit r/artificial)

AI Agent wird zum neuen Schlachtfeld der Tech-Giganten, Tencent und Alibaba erhöhen beide ihre Investitionen: Tencent und Alibaba betonten in ihren neuesten Finanzberichten beide eine KI-gesteuerte Strategie und betrachten AI Agents (Intelligente Agenten) als Schlüssel für zukünftiges Wachstum. Tencent-CEO Ma Huateng gab bekannt, dass KI bereits einen wesentlichen Beitrag zum Werbe- und Spielegeschäft leistet und das Unternehmen seine Investitionen in die Yuanbao-Anwendung und KI-Agents innerhalb von WeChat verstärkt. Er ist der Ansicht, dass das einzigartige Ökosystem von WeChat (soziale Netzwerke, Inhalte, Mini-Programme, Transaktionsfähigkeiten) einzigartige Agents hervorbringen kann, die komplexe Aufgaben ausführen können. Auch der Vorstandsvorsitzende von Alibaba, Cai Chongxin, wies darauf hin, dass in den nächsten drei bis fünf Jahren alle Geschäftsbereiche KI-gesteuert sein sollten. Beide Unternehmen haben ihre Investitionsausgaben für den Aufbau von KI-Infrastruktur erheblich erhöht. Sequoia Capital prognostiziert ebenfalls, dass sich Agents zu einer Wirtschaft intelligenter Agenten entwickeln werden. Der Aufstieg von AI Agents wird voraussichtlich zu einem sprunghaften Anstieg der Rechenleistungsnachfrage führen und könnte ein neuer Anfang für die Industrialisierung der KI sein. (Quelle: 36Kr, 36Kr)

Wettlauf um KI-Gedächtnisfunktionen verschärft sich, OpenAI, Google, Meta und andere Giganten konkurrieren um Verbesserung personalisierter Erlebnisse und Nutzerbindung: Tech-Giganten wie OpenAI, Google, Meta und Microsoft rüsten aktiv die Gedächtnisfunktionen ihrer KI-Chatbots auf, um durch Speicherung von mehr Nutzerinformationen (wie Gesprächsverläufe, Präferenzen, Suchhistorie) personalisiertere und stärker bindende Dienste anzubieten. Beispielsweise hat ChatGPT die Funktion „Referenz-Chatverlauf“ hinzugefügt, und Google Gemini erweitert das Gedächtnis auf die Suchhistorie der Nutzer. Dieser Schritt wird als Schlüssel zur Differenzierung im Wettbewerb der KI-Giganten und zur Erschließung neuer Monetarisierungswege (wie Affiliate-Marketing, Werbung) angesehen. Dies wirft jedoch auch Bedenken hinsichtlich des Datenschutzes der Nutzer, kommerzieller Manipulation und der Möglichkeit auf, dass KI-Modelle Voreingenommenheit verstärken oder Halluzinationen erzeugen könnten. Experten mahnen zur Beachtung der Anreizmechanismen hinter den Dienstanbietern und fordern eine stärkere Regulierung. (Quelle: 36Kr, 36Kr)

🎯 Entwicklungen

OpenAI kündigt neue Entwicklungen an, möglicherweise im Bereich Softwareentwicklungs-Agenten und Desktop-Anwendungen: Der offizielle Account von OpenAI veröffentlichte eine mysteriöse Ankündigung mit den Worten „Entwickler, stellt eure Wecker“, was auf bevorstehende Neuigkeiten hindeutet. Die Community spekuliert, dass dies mit den seit langem gemunkelten Software Development Engineer (SDE) Agents oder Desktop-KI-Anwendungen zusammenhängen könnte, oder sogar eine Präsentation der Ergebnisse des übernommenen Windsurf-Teams sein könnte. Zuvor hatte Sam Altman auch erwähnt, dass es eine „unauffällige Forschungsvorschau“ geben werde, was die Erwartungen des Marktes an neue Fortschritte von OpenAI in Bereichen wie automatisierter Softwareentwicklung und Computer-Nutzungsagenten schürt. (Quelle: openai, op7418, dotey, cto_junior, brickroad7, kevinweil, tokenbender, Teknium1)

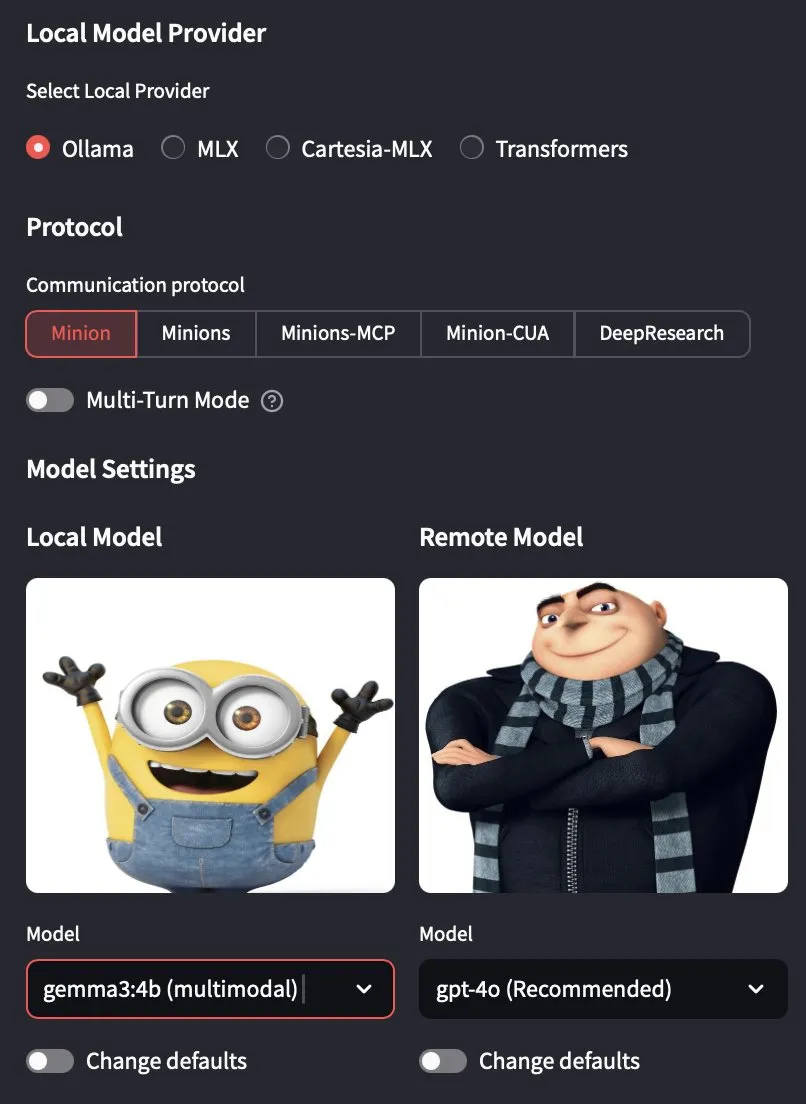

Ollama Version 0.7.0 veröffentlicht, unterstützt offiziell multimodale Modelle: Ollama hat die Version 0.7.0 veröffentlicht, die Unterstützung für multimodale Modelle hinzufügt. Das bedeutet, dass Benutzer jetzt über Ollama visuelle Sprachmodelle wie Googles Gemma 3 und Alibabas Qwen 2.5 VL ausführen können. Dieses Update erweitert die Fähigkeit von Ollama, große Sprachmodelle lokal auszuführen, sodass es komplexere Aufgaben bewältigen kann, die Text und Bilder enthalten, und treibt die Entwicklung lokaler KI-Anwendungen weiter voran. (Quelle: ollama, jerryjliu0, ollama, Reddit r/LocalLLaMA)

Lenovo plant die Einführung eines KI-Mini-Hosts mit NVIDIA GB10 Superchip: Lenovo plant die Veröffentlichung eines kleinen KI-Hosts ähnlich NVIDIA Digits, der den NVIDIA GB10 Grace Blackwell Superchip verwenden wird. Seine Rechenleistung wird voraussichtlich 1 PFLOPS erreichen und er wird mit 128 GB einheitlichem Speicher ausgestattet sein. Es ist jedoch anzumerken, dass die Speicherbandbreite des GB10 Grace Blackwell Superchip mit nur 273 GB/s relativ gering ist, was zu einem Leistungsengpass werden könnte. (Quelle: karminski3, Reddit r/LocalLLaMA)

Top-KI-Modelle wie Seed-Thinking von ByteDance schneiden im Finale des CCPC-Programmierwettbewerbs schlecht ab und zeigen aktuelle Schwächen von KI-Algorithmen bei der Problemlösung auf: Im Finale des 10. China Collegiate Programming Contest (CCPC) zeigten bekannte KI-Modelle wie Seed-Thinking von ByteDance sowie o3/o4 von OpenAI, Gemini 2.5 Pro von Google eine unbefriedigende Leistung. Die meisten lösten nur eine „Aufwärmaufgabe“, DeepSeek R1 erreichte sogar null AC (Accepted). Dieses Ergebnis löste Diskussionen aus und zeigte, dass aktuelle große Modelle bei der Lösung von algorithmischen Wettbewerbsaufgaben, die einzigartige Kreativität und komplexe Logik erfordern, noch Schwächen aufweisen, insbesondere in nicht-agentischen Umgebungen (d.h. ohne externe Werkzeugunterstützung für Ausführung und Debugging). Obwohl einige Modelle in Wettbewerben wie der IOI durch agentisches Training gute Ergebnisse erzielt haben, unterstreicht die Leistung beim CCPC die Grenzen der reinen Modellinferenzfähigkeit bei neuen, komplexen algorithmischen Problemen. (Quelle: 36Kr)

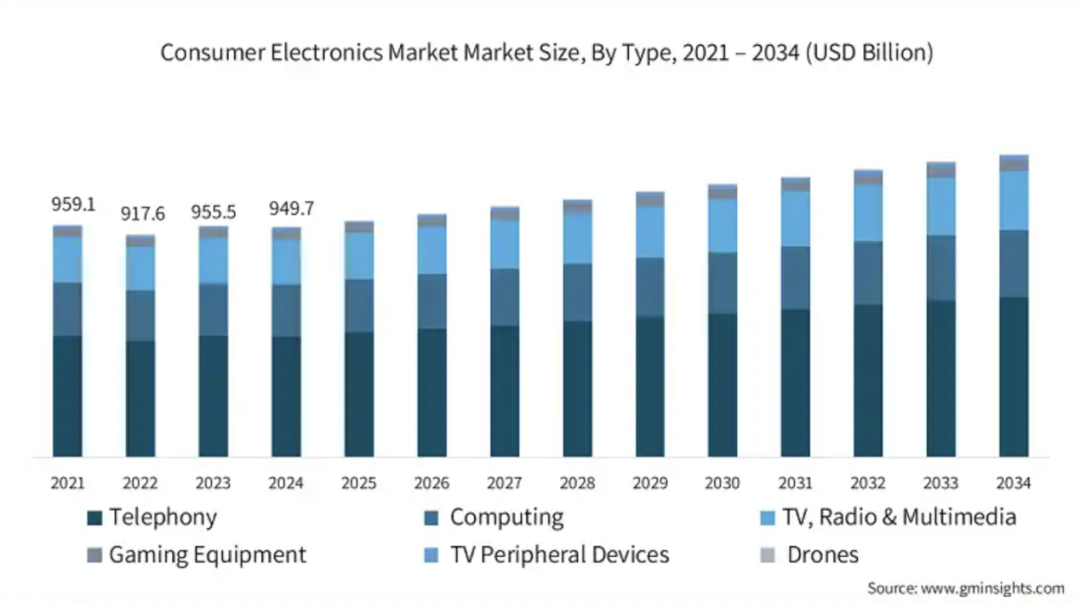

Beschleunigte Integration von Audio-/Video-Chips und Edge-AI-Technologie treibt Intelligenz von Consumer-Endgeräten voran: Mit dem wachsenden Bedarf an Edge AI beschleunigen Hersteller von Audio-/Video-Chips die Integration von KI-Technologie in ihre Produkte, um den Anforderungen von Mobiltelefonen, PCs, Wearables und anderer Unterhaltungselektronik an lokale Datenverarbeitung, intelligente Entscheidungsfindung und personalisierte Erlebnisse gerecht zu werden. Unternehmen wie Telink Microelectronics, Actions Technology, Bestechnic, Ingenic Semiconductor und Fullhan Microelectronics bringen Chip-Lösungen auf den Markt, die NPUs integrieren und KI-Algorithmen (wie Rauschunterdrückung, intelligente Audioverarbeitung, visuelle Anwendungen) unterstützen. Dieser Trend zielt darauf ab, die Interaktionslogik und Anwendungsszenarien von Geräten neu zu gestalten und die Entwicklung intelligenter Consumer-Geräte hin zu einem Ökosystem von „AI as a Service“ voranzutreiben. Obwohl die Branche noch nach der „Killer-App“ sucht, ist die Definition von Funktionsmodulen durch KI bereits ein positives Signal. (Quelle: 36Kr)

OpenAI-Chefwissenschaftler Pachocki: KI beginnt, originäre Forschungsfähigkeiten zu entwickeln, AGI entwickelt sich von der Theorie zur Realität: Jakub Pachocki, Chefwissenschaftler bei OpenAI, erklärte in einem Interview mit der Zeitschrift Nature, dass Reinforcement Learning KI-Modelle an die Grenzen des „Schlussfolgerns“ heranführe und AGI (Artificial General Intelligence) sich von der Theorie zur Realität entwickle. Er erwartet, dass KI in Zukunft eigenständig originäre wissenschaftliche Forschung betreiben und die Entwicklung in Bereichen wie Software Engineering und Hardware-Design vorantreiben kann. Er betonte, dass Modelle zwar anders funktionieren als das menschliche Gehirn, aber bereits neue Erkenntnisse generieren und eine Form von Denkfähigkeit besitzen. OpenAI plant die Veröffentlichung neuer Versionen, die bestehende Open-Source-Modelle übertreffen, jedoch unter der Voraussetzung der Sicherheit. Pachocki glaubt, dass der nächste Meilenstein der KI darin besteht, messbare wirtschaftliche Auswirkungen zu erzielen, insbesondere in der originären Forschung, und erwartet, dass KI noch in diesem Jahr nahezu autonom wertvolle Software entwickeln kann. (Quelle: 36Kr)

Veröffentlichung von Apple Intelligence in China verzögert, Start der chinesischen Version nicht vor iOS 18.6 erwartet: Apple Intelligence, das von Apple auf der WWDC24 vorgestellt wurde und ursprünglich für eine vollständige Einführung im Jahr 2025 geplant war, ist in der chinesischen Version noch nicht verfügbar und wird voraussichtlich frühestens mit iOS 18.6 im Juli erscheinen. Obwohl die englische Version bereits verfügbar ist, fehlen Kernfunktionen wie Advanced Siri und Genmoji oder die Nutzererfahrung ist mangelhaft, was zu Unzufriedenheit bei den Nutzern und Sammelklagen geführt hat. Die Verzögerung der chinesischen Version ist hauptsächlich auf die Notwendigkeit zurückzuführen, die chinesischen Regulierungsvorschriften einzuhalten, Lokalisierungsanpassungen vorzunehmen und Inhaltsprüfungen durchzuführen. Gerüchten zufolge wird es eine Zusammenarbeit mit chinesischen KI-Anbietern wie Baidu Wenxin Yiyan geben. Angesichts der schnellen Integration und der Herausforderungen durch Wettbewerber wie Perplexity AI und Meta AI könnte die Verzögerung von Apple AI dessen Ökosystemvorteile und Nutzerloyalität beeinträchtigen. (Quelle: 36Kr)

KI-Technologie gestaltet Supply Chain Management neu und schafft Markt für KI-Full-Stack-Supply-Chain-Management-Plattformen: Angesichts neuer Herausforderungen wie zunehmender Komplexität der Lieferketten, verstärkter Risiken und Effizienzengpässen treibt die KI-Technologie (insbesondere Machine Learning, Operations Research und Generative AI) die Transformation des Supply Chain Managements hin zur Intelligenz voran. KI-Full-Stack-Supply-Chain-Management-Plattformen entstehen, um durch Digitalisierung von Geschäftsprozessen, Datenintelligenz und End-to-End-Kollaboration den gesamten Prozess von der Bedarfserfassung bis zur Auftragserfüllung zu optimieren. Diese Plattform integriert Daten-Mid-Office, intelligente Entscheidungs-Engines, End-to-End-Monitoring und ökologische Kollaborationsportale. Ihr Kernwert liegt in der Verbesserung der agilen Reaktion und präzisen Prognose (z.B. Bedarfsprognosegenauigkeit über 85%), Effizienz- und Kostenoptimierung (Lagerumschlagshäufigkeit um über 40% gesteigert), End-to-End-Transparenz und Risikomanagement, ökologischer Kollaboration und Resilienzsteigerung sowie Unterstützung nachhaltiger Entwicklung. Das Haibi Research Institute prognostiziert für 2024 ein Marktvolumen von rund 700 Millionen Yuan in China, das bis 2027 voraussichtlich 1 Milliarde Yuan übersteigen wird. (Quelle: 36Kr)

Zhang Yaqin über Chinas KI-Chancen in der Post-ChatGPT-Ära: Fünf Hauptentwicklungsrichtungen und drei Prognosen: Zhang Yaqin, Dekan des Institute for AI Industry Research (IAIIR) der Tsinghua Universität, ist der Ansicht, dass ChatGPT der erste intelligente Agent ist, der den Turing-Test bestanden hat, was einen Meilenstein für die KI darstellt. Er wies darauf hin, dass große Modelle die IT-Struktur neu gestalten und China bei High-End-Chips und Algorithmus-Systemen einen Rückstand gegenüber dem Spitzenniveau aufweist, aber in vertikalen Basismodellen, der SaaS-Schicht und am Edge (Smartphones, PCs, IoT, Autos usw.) zahlreiche Möglichkeiten finden kann. Er prognostiziert fünf Hauptentwicklungsrichtungen für KI-Großmodelle: multimodale Intelligenz, autonome Intelligenz, Edge-Intelligenz, physische Intelligenz (autonomes Fahren, Robotik) und biologische Intelligenz (Gehirn-Computer-Schnittstellen, Medizin). Und er stellte drei Thesen auf: 1) Große Modelle und generative KI sind der Mainstream der nächsten 10 Jahre; 2) Basis-Großmodelle + vertikale Großmodelle + Edge-Modelle, Open Source + kommerzielle Modelle werden koexistieren; 3) Einheitliche Tokenisation + Scaling Law sind der Kern, aber neue Algorithmus-Systeme sind erforderlich, um die Effizienz zu steigern, und in den nächsten 5 Jahren könnte es zu bedeutenden Durchbrüchen in der KI-Technologiearchitektur kommen; 4) Es wird erwartet, dass innerhalb von 15-20 Jahren eine allgemeine künstliche Intelligenz erreicht wird, die stufenweise neue Turing-Tests bestehen wird. (Quelle: 36Kr)

🧰 Tools

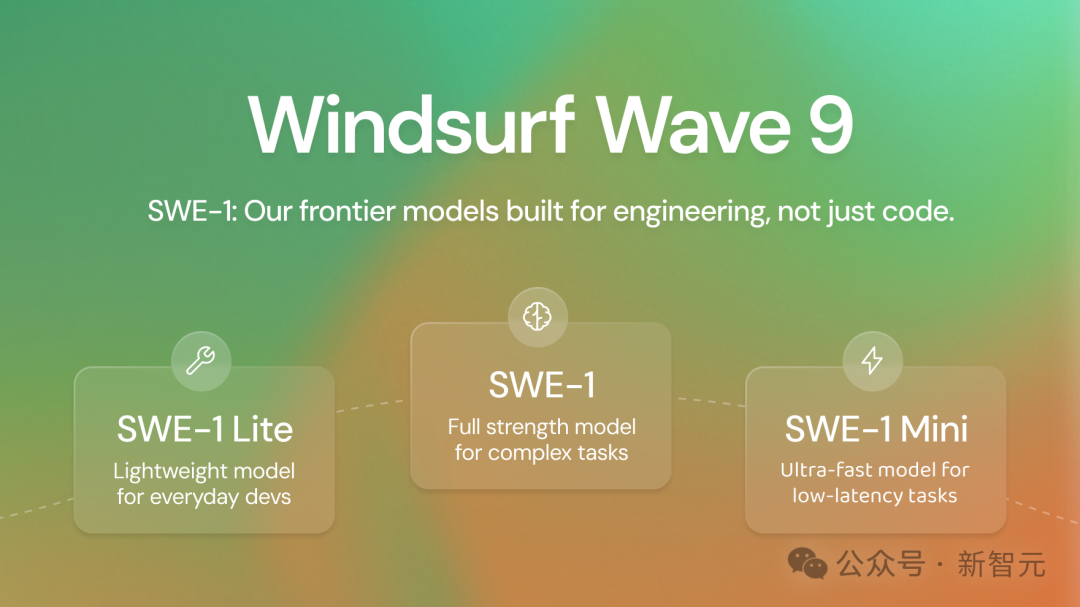

Windsurf veröffentlicht erste eigene Spitzenmodellreihe SWE-1, zielt darauf ab, die Effizienz der Softwareentwicklung um 99% zu steigern: Das KI-Programmierwerkzeugunternehmen Windsurf (angeblich kurz vor der Übernahme durch OpenAI) hat seine erste Modellreihe SWE-1 vorgestellt, die für Software Engineering optimiert ist. Die Reihe umfasst SWE-1 (ähnlich Claude 3.5 Sonnet, kostengünstiger), SWE-1-lite (ersetzt Cascade Base, für alle Benutzer zugänglich) und SWE-1-mini (geringe Latenz, für Windsurf Tab). Die Kerninnovation von SWE-1 ist das „Flow Awareness“-System, bei dem die KI die Operationszeitachse mit dem Benutzer teilt, um eine effiziente Zusammenarbeit zu ermöglichen und unvollendete Zustände sowie langwierige Aufgaben zu verstehen. Offline-Bewertungen und Online-Tests zeigen, dass SWE-1 bei konversationellen und End-to-End-SWE-Aufgaben eine Leistung nahe an Spitzenmodellen erbringt und bei Metriken wie der Code-Beitragsrate Nicht-Spitzenmodelle übertrifft. (Quelle: 36Kr)

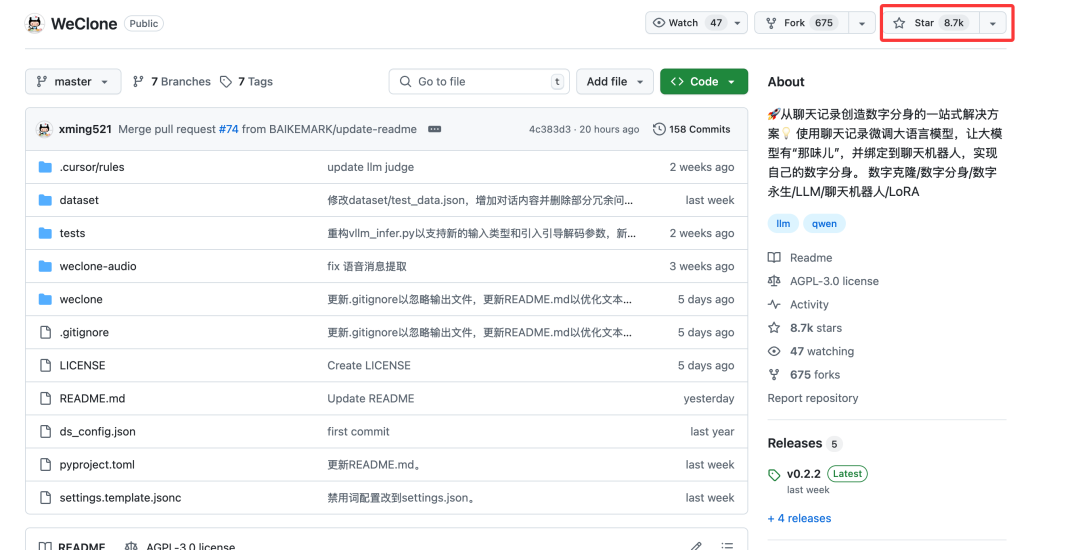

Open-Source-Projekt WeClone: Erstellung personalisierter digitaler KI-Avatare mithilfe von WeChat-Chatverläufen: Ein Python-Open-Source-Projekt namens WeClone ermöglicht es Benutzern, KI-gestützte digitale Avatare auf der Grundlage ihrer persönlichen WeChat-Chatverläufe zu erstellen. Das Projekt nutzt das Prinzip der RAG (Retrieval Augmented Generation) Wissensdatenbank, importiert WeChat-Chatdaten, führt ein Fein-Tuning von Modellen wie Qwen2.5-7B-Instruct mit der LoRA-Methode durch und kombiniert ASR (Automatic Speech Recognition) mit TTS (Text-to-Speech) Technologie, um die Stimme des Benutzers zu generieren. Das Projekt unterstützt die Anbindung an WeChat, Enterprise WeChat und Feishu über AstrBot. Da WeChat-Chatverläufe eine große Menge an personalisierten, realen Gesprächen aus verschiedenen Szenarien enthalten, eignen sie sich sehr gut als private Wissensdatenbank für das Training digitaler Personen und können in verschiedenen Szenarien wie personalisierten KI-Assistenten, Unternehmens-Kundenservice, Marketing und sogar Finanzberatung eingesetzt werden. (Quelle: 36Kr)

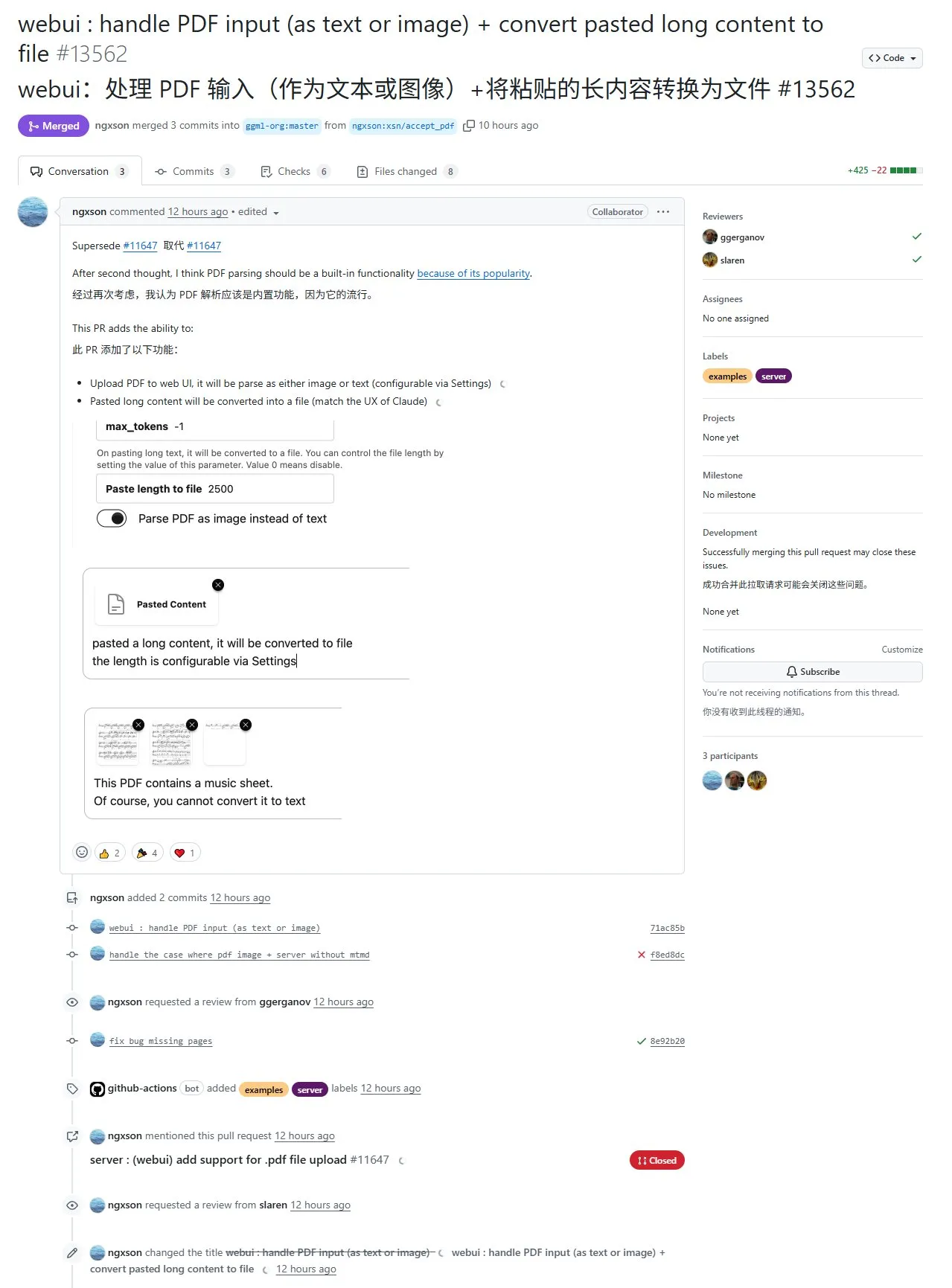

Neue Funktion in llama.cpp: Unterstützt PDF-Inhaltsextraktion und -eingabe, aber derzeit nur über Web-Interface und mit Schwächen bei komplexen Formaten: Das Projekt llama.cpp hat kürzlich durch PR #13562 Unterstützung für die Eingabe von PDF-Dateien implementiert. Diese Funktion modifiziert nicht direkt den Quellcode von llama.cpp, sondern extrahiert den PDF-Inhalt über eine JavaScript-Bibliothek im Web-Interface und übergibt ihn dann an llama.cpp. Das bedeutet, dass diese Funktion derzeit auf die von llama.cpp bereitgestellte Web-UI beschränkt ist und auf API-Ebene noch nicht verfügbar ist. Obwohl der Import von PDF-Inhalten erleichtert wird, ist die Extraktionsqualität bei PDFs mit komplexen Elementen (wie mathematischen Formeln) mittelmäßig und es können Analysefehler auftreten. (Quelle: karminski3)

Unsloth-Framework fügt TTS-Feinabstimmungsfunktion hinzu und unterstützt Qwen3 GRPO: Unsloth gab bekannt, dass sein Framework jetzt die Feinabstimmung von Text-to-Speech (TTS)-Modellen unterstützt, wodurch die Trainingsgeschwindigkeit um etwa das 1,5-fache erhöht und der VRAM-Verbrauch um 50 % gesenkt wird. Zu den unterstützten Modellen gehören Transformer-Architekturmodelle wie Sesame/csm-1b und OpenAI/whisper-large-v3. Die TTS-Feinabstimmung kann verwendet werden, um Stimmen zu imitieren, Sprachstil und Tonfall anzupassen, neue Sprachen zu unterstützen usw. Unsloth stellt Colab Notebooks für kostenloses Training, Ausführen und Speichern von Modellen zur Verfügung. Darüber hinaus hat Unsloth Unterstützung für Qwen3 GRPO (Generative Retrieval Policy Optimization) hinzugefügt, das ein Basismodell und eine neue, auf Nachbarschaft basierende Belohnungsfunktion zur Optimierung verwendet. (Quelle: Reddit r/LocalLLaMA)

INAIR stellt AI Spatial Computer vor und zielt auf den Markt für mobiles Light-Office ab: Das AR+AI-Brillenunternehmen INAIR hat seinen AI Spatial Computer vorgestellt, der aus der AR-Brille INAIR 2 Pro, dem Rechenzentrum INAIR Pod und der 3D-Raumtastatur INAIR Touchboard besteht. Das Produkt zielt darauf ab, Geschäftsreisenden und Nutzern von Light-Office-Anwendungen eine zweite Wahl neben dem Laptop zu bieten. Es kann einen randlosen Riesenbildschirm projizieren, der einem 4 Meter großen 134-Zoll-Bildschirm entspricht, und unterstützt die Fernsteuerung von Computern. Sein integrierter intelligenter Assistent auf Systemebene, INAIR AI Agent, integriert verschiedene große Modelle wie DeepSeek, Doubao, Wenxin Yiyan und ChatGPT und kann Funktionen wie Echtzeitübersetzung und Inhaltszusammenfassung bereitstellen sowie durch das Erlernen von Benutzergewohnheiten die Arbeitseffizienz steigern. (Quelle: 36Kr)

llamafile Inferenz-Framework unterstützt Qwen3-Modelle: llamafile, ein Inferenz-Framework, das llama.cpp und die hochportable C-Bibliothek Cosmopolitan Libc integriert, unterstützt jetzt die Qwen3-Modellreihe. Sein Hauptmerkmal ist die Bündelung aller Laufzeitabhängigkeiten in einer einzigen ausführbaren Datei, was die Portabilität erheblich verbessert und es Benutzern ermöglicht, große Modelle ohne komplexe Installationsprozesse auszuführen. (Quelle: karminski3)

Kling AI veröffentlicht Version 2.0 und API, fügt Funktionen wie 3D-Logo-Rotation hinzu: Kling AI gab bekannt, dass Kling 2.0, Elements und die Video Effects Suite API jetzt verfügbar sind. Die neue Version verbessert die Videogenerierungsfähigkeiten und führt Tutorials ein, wie z.B. die schnelle Erstellung von 3D-rotierenden Logos mit den Funktionen DizzyDizzy oder Image to Video, sodass Benutzer ohne 3D-Kenntnisse kreativ werden können. (Quelle: Kling_ai, Kling_ai)

Manus AI fügt Bildgenerierungsfunktion hinzu, möglicherweise basierend auf GPT-4o API: Die KI-Assistentenanwendung Manus gab die Unterstützung für die Bildgenerierung bekannt. Offiziell heißt es, Manus könne nicht nur Bilder generieren, sondern auch Benutzerabsichten verstehen, Lösungen planen und die Bildgenerierung effektiv mit anderen Werkzeugen kombinieren, um Aufgaben zu erledigen. Die Community vermutet, dass die Bildgenerierungsfähigkeiten auf der API des neuesten GPT-4o-Modells von OpenAI basieren könnten. (Quelle: op7418)

Blackbox bietet On-Demand-Zugriff auf A100/H100 GPUs innerhalb der IDE: Blackbox hat einen Dienst für den direkten On-Demand-Zugriff auf High-End-GPUs (A100s und H100s) innerhalb der integrierten Entwicklungsumgebung (IDE) eingeführt. Benutzer benötigen keine komplexen Cloud-Konsolenoperationen oder API-Schlüsselverwaltung und können GPU-Instanzen direkt von der IDE oder der Blackbox-Erweiterung aus starten. Der Preis beträgt 14 US-Dollar pro Stunde für 8 A100-Knoten und zielt darauf ab, den Zugriff auf Rechenressourcen für maschinelles Lernen und rechenintensive Aufgaben zu vereinfachen, sodass er so einfach wird wie das Öffnen eines Terminal-Tabs. (Quelle: Reddit r/deeplearning)

📚 Lernen

HuggingFace veröffentlicht Tutorial zum MCP (Model Compliance Protocol): HuggingFace hat ein neues MCP-Tutorial veröffentlicht, das Benutzern helfen soll, die Zusammensetzung des MCP-Protokolls zu verstehen, vorhandene SDKs/Frameworks zu verwenden und MCP-Dienste selbst zu implementieren. Der Kursinhalt ist relativ einfach und eignet sich für erfahrene Ingenieure, um ihn schnell zu meistern. Nach Abschluss kann ein Abschlusszertifikat erworben werden. Das MCP-Protokoll ist entscheidend für die Übertragung von Informationen, Werten und Vertrauen zwischen Modellen und eine der technischen Herausforderungen beim Aufbau einer Ökonomie intelligenter Agenten. (Quelle: karminski3)

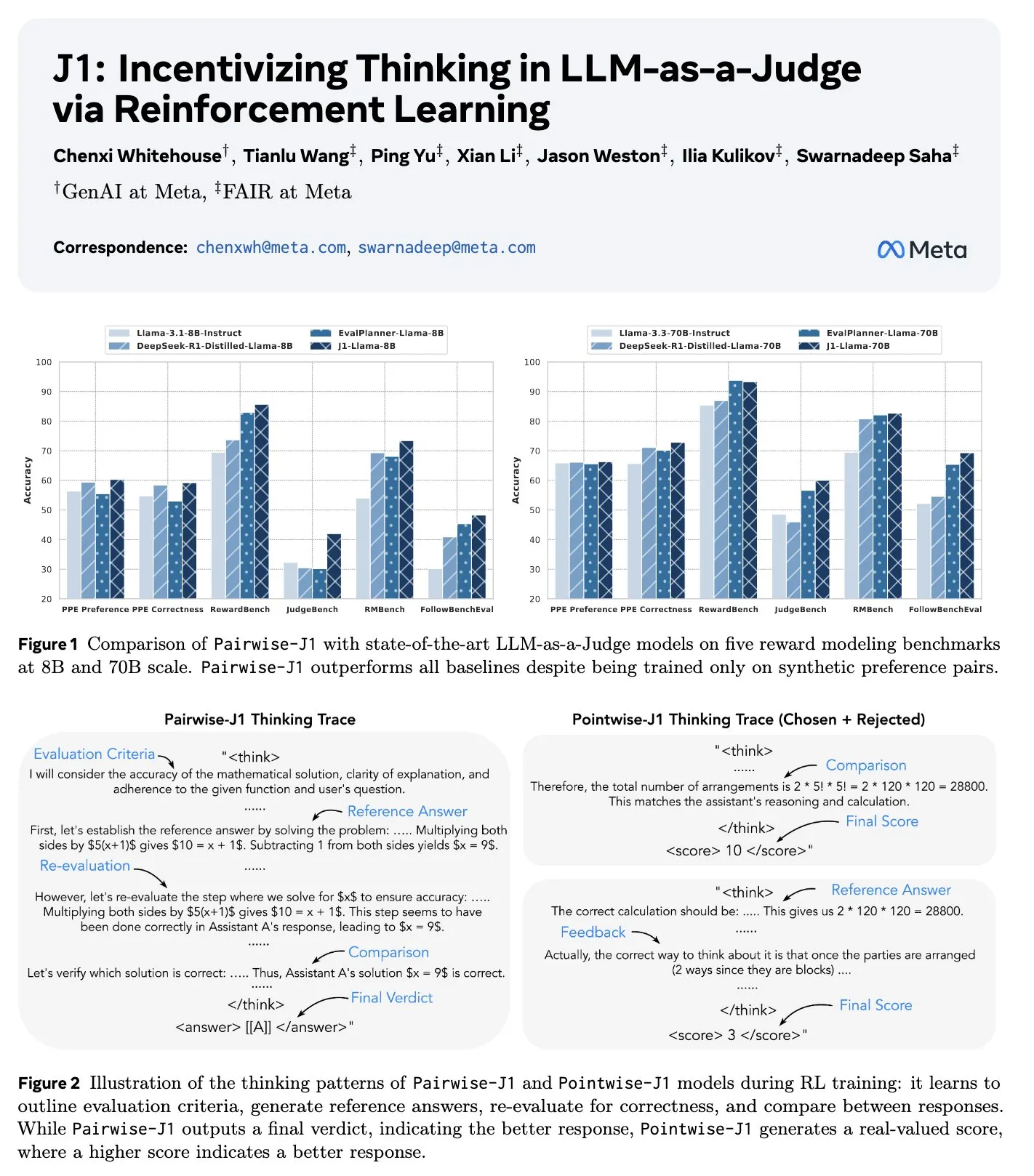

Neues Paper J1: Anreize für „Denken“ in LLM-as-a-Judge durch Reinforcement Learning: Ein neues Paper mit dem Titel „J1: Incentivizing Thinking in LLM-as-a-Judge via RL“ schlägt eine Methode vor, um den Denkprozess, die Bewertung und das Urteilsvermögen von Large Language Models als Bewerter (LLM-as-a-Judge) durch Reinforcement Learning (konkret GRPO) zu optimieren. Diese Methode kann verifizierbare und nicht verifizierbare Prompt-Bewertungsaufgaben in verifizierbare Aufgaben umwandeln, wobei nur synthetische Paardaten verwendet werden. Die Studie ergab, dass das J1-Modell sowohl im 8B- als auch im 70B-Maßstab die Basislinien übertrifft und verschiedene Denkstrategien aufweist, wie z. B. das Auflisten von Bewertungskriterien, den Vergleich mit selbst generierten Referenzantworten und die Neubewertung der Korrektheit. (Quelle: jaseweston, jaseweston)

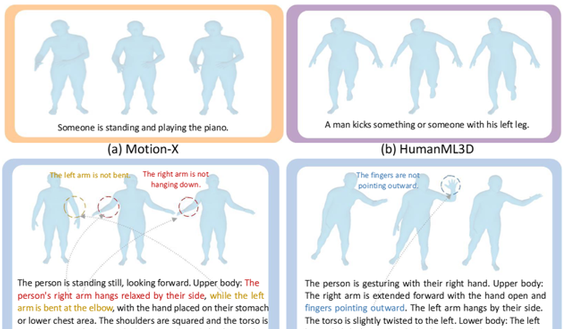

Peking-Universität und Renmin-Universität veröffentlichen gemeinsam Being-M0: Framework zur allgemeinen Bewegungserzeugung für humanoide Roboter, angetrieben durch einen Datensatz im Millionenbereich: Das Team von Lu Zongqing von der Peking-Universität hat in Zusammenarbeit mit der Renmin-Universität Chinas und anderen das Framework Being-M0 zur allgemeinen Bewegungserzeugung für humanoide Roboter vorgestellt und den branchenweit ersten Datensatz zur Bewegungserzeugung im Millionenmaßstab, MotionLib, erstellt. Dieses Framework nutzt umfangreiche Videodaten aus dem Internet in Kombination mit einem End-to-End-Modell zur textgesteuerten Bewegungserzeugung, um komplexe und vielfältige menschliche Bewegungen zu generieren und menschliche Bewegungen auf verschiedene humanoide Roboter wie Unitree H1 und G1 zu übertragen. Zu den Kerninnovationen gehören der Erstellungsprozess des MotionLib-Datensatzes, ein Modell zur Validierung der Machbarkeit von „Big Data + Large Models“ im Bereich der Bewegungserzeugung sowie ein innovatives zweidimensionales Quantisierungsframework ohne Nachschlagen, MotionBook, das das Problem des Informationsverlusts bei der Komprimierung hochdimensionaler Bewegungsdaten mit traditioneller VQ-Technologie löst. (Quelle: QbitAI)

ByteDance veröffentlicht WildDoc-Datensatz zur Bewertung der Verständnisfähigkeiten von VLM bei Dokumenten aus der realen Welt: ByteDance hat auf Hugging Face den neuen Visual Question Answering (VQA)-Datensatz WildDoc veröffentlicht. Dieser Datensatz zielt darauf ab, die Verständnisfähigkeiten von Visual Language Models (VLM) bei Dokumenten in realen Szenarien zu bewerten. (Quelle: _akhaliq)

ICRA 2025 (IEEE International Conference on Robotics and Automation) Agenda-Highlights: Die IEEE International Conference on Robotics and Automation (ICRA) 2025 findet vom 19. bis 23. Mai in Atlanta, USA, statt. Das Programm umfasst Keynotes von Allison Okamura, Tessa Lau, Raffaello D’Andrea und anderen sowie wichtige Vorträge zu 12 Themenbereichen, darunter Rehabilitationsrobotik, Optimierungssteuerung, Mensch-Roboter-Interaktion, Softrobotik, Feldrobotik, Biorobotik, Haptik, Planung, Manipulation, Bewegung, Sicherheit und formale Methoden sowie Multi-Roboter-Systeme. Darüber hinaus gibt es einen Schnellkurs zur Wissenschaftskommunikation, 59 Workshops und Tutorials, ein Forum zur Roboterethik, ein Forum für afrikanische Wissenschaftler zur Förderung der Roboterforschung, ein Forum zur Roboterausbildung im Grundstudium sowie einen Tag zum Aufbau von Gemeinschaften. (Quelle: aihub.org)

Paper LlamaDuo: LLMOps-Pipeline für eine nahtlose Migration von Service-LLMs zu kleinen lokalen LLMs: Ein auf der Hauptkonferenz ACL 2025 angenommenes Paper mit dem Titel „LlamaDuo: LLMOps Pipeline for Seamless Migration from Service LLMs to Small-Scale Local LLMs“ stellt eine LLMOps-Pipeline vor, die Benutzern helfen soll, von der Verwendung großer Service-LLMs (z. B. API-Aufrufe) reibungslos auf die Verwendung kleiner lokaler LLMs umzusteigen. Diese Forschung ist das Ergebnis von Open Source und Community-Zusammenarbeit und unterstreicht die Bedeutung flexibler Wechsel- und Optimierungsstrategien für die Modellbereitstellung in praktischen Anwendungen. (Quelle: algo_diver)

Tubi-Studie: Tweedie-Regression übertrifft gewichtete LogLoss bei der Optimierung der Nutzerbindung bei Video-on-Demand: Eine Studie der Videoplattform Tubi zeigt, dass bei der Optimierung von Videoempfehlungssystemen zur Steigerung der Nutzerbindung (z. B. der folgenden Wiedergabedauer) ein Tweedie-Regressionsmodell, das die Wiedergabedauer der Nutzer direkt vorhersagt, dem traditionellen Modell der gewichteten LogLoss der Wiedergabedauer überlegen ist. Die experimentellen Ergebnisse zeigten, dass die Tweedie-Regression zu einer Umsatzsteigerung von +0,4 % und einer Erhöhung der Wiedergabedauer von +0,15 % führte. Die Studie argumentiert, dass die statistischen Eigenschaften der Tweedie-Regression besser zu den Merkmalen von Wiedergabedauerdaten passen, die durch Nullinflation und schiefe Verteilung gekennzeichnet sind. (Quelle: Reddit r/MachineLearning)

💼 Business

Lippensynchronisations-App Hedra erhält Series-A-Finanzierung in Höhe von 32 Millionen US-Dollar, angeführt von a16z: Das KI-Videogenerierungs-Startup Hedra gab den Abschluss einer Series-A-Finanzierungsrunde in Höhe von 32 Millionen US-Dollar bekannt, angeführt von Andreessen Horowitz (a16z), wobei Matt Bornstein dem Vorstand beitritt. Auch die bisherigen Investoren a16z speedrun, Abstract und Index Ventures beteiligten sich an dieser Runde. Hedra konzentriert sich auf die Erstellung ausdrucksstarker, steuerbarer Charakterdialogvideos. Seine Technologie zielt darauf ab, die Herausforderungen der Lippensynchronisation und des emotionalen Ausdrucks in KI-generierten Videos zu lösen. (Quelle: op7418)

USA, Saudi-Arabien und VAE einigen sich auf Zusammenarbeit im KI-Bereich, einschließlich 5-GW-Rechenzentrum und Chip-Lieferungen, mit dem Ziel, chinesischen Einfluss auszuschließen: Die USA haben mit Saudi-Arabien und den Vereinigten Arabischen Emiraten wichtige Kooperationsabkommen im KI-Bereich geschlossen. Diese umfassen den Bau eines 5-GW-Rechenzentrums und die Lieferung großer Mengen fortschrittlicher KI-Chips (wie Nvidias Blackwell-Chips) durch US-Unternehmen wie Nvidia, AMD und Qualcomm. Das neu gegründete saudische KI-Unternehmen Humain wird der zentrale Ausführungspartner sein. Dieser Schritt wird als strategischer Einsatz der USA gesehen, um ihre KI-Technologie im Nahen Osten zu fördern, den Infrastrukturaufbau zu beschleunigen, Verbündete zu binden und gleichzeitig Chinas Investitionen in die regionale KI-Infrastruktur und dessen technologischen Einfluss zu begrenzen. Das neue Abkommen hebt frühere Beschränkungen für den Export von KI-Chips in den Nahen Osten teilweise auf, verschärft aber gleichzeitig die weltweiten Warnungen vor der Verwendung chinesischer Chips wie Huaweis Ascend. (Quelle: dylan522p, 36Kr, iScienceLuvr)

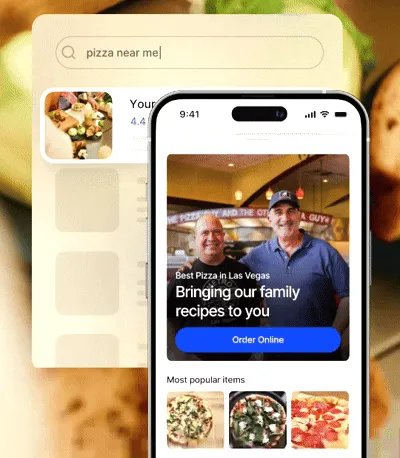

Restaurant-SaaS-Unternehmen Owner wird durch Finanzierung von 120 Millionen US-Dollar zum Einhorn und nutzt KI zur Schaffung von „KI-Restaurantmanagern“: Owner, ein Unternehmen, das unabhängigen Restaurants Full-Stack-Digitalisierungslösungen anbietet, hat kürzlich eine C-Finanzierungsrunde in Höhe von 120 Millionen US-Dollar abgeschlossen und wird nun mit 1 Milliarde US-Dollar bewertet. Owner bietet Restaurants gegen eine monatliche Pauschalgebühr Dienstleistungen wie Website-/APP-Erstellung, integrierte Bestell- und Lieferdienste, SEO-Optimierung und Marketingautomatisierung an und bedient bereits über 10.000 Restaurants. Seine KI-Strategie für 2025 umfasst die Einführung von „KI-Restaurantmanagern“ (AI CMO, CFO, CTO), die KI-Mitarbeiter und menschliche Mitarbeiter verwalten, sowie die Entwicklung von konversationellen KI-Agents zur Steigerung der Serviceeffizienz. Diese Finanzierungsrunde wurde gemeinsam von Redpoint Ventures und Altman Capital angeführt und zeigt das Potenzial der KI, den Wert traditioneller SaaS-Lösungen neu zu definieren. (Quelle: 36Kr)

🌟 Community

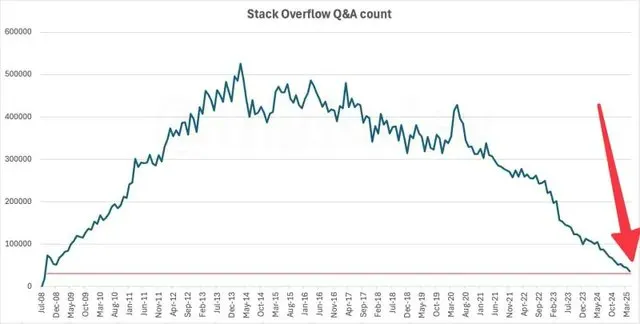

Stack Overflow Aktivität sinkt auf das Niveau von 2009, KI möglicherweise Hauptursache: Daten zeigen, dass die monatliche Anzahl der Fragen auf der bekannten Entwickler-Q&A-Community Stack Overflow auf das Niveau von 2009 gefallen ist, als die Plattform gerade erst gestartet war. Dieses Phänomen hat eine Diskussion über die Auswirkungen von KI auf traditionelle Entwickler-Communities ausgelöst. Viele glauben, dass Entwickler mit dem Aufkommen von KI-Programmierassistenten wie ChatGPT zunehmend dazu neigen, Fragen direkt an die KI zu stellen und nach Codelösungen zu suchen, anstatt Fragen in Communities wie Stack Overflow zu stellen und auf menschliche Antworten zu warten, was zu dem drastischen Rückgang der Community-Aktivität geführt haben könnte. (Quelle: zachtratar, karminski3)

KI löst am Arbeitsplatz Krise der „Professionalität“ aus, Mitarbeiter sehen im KI-Zeitalter größeren Bedarf an Menschlichkeit: Mit der zunehmenden Verbreitung von KI am Arbeitsplatz fühlen viele Mitarbeiter ihre Fachkompetenzen „dekonstruiert“. Führungskräfte neigen dazu, KI die Ergebnisse von Mitarbeitern überarbeiten zu lassen und halten KI sogar für besser als menschliche Mitarbeiter, was dazu führt, dass sich Mitarbeiter nicht respektiert fühlen und eine Krise der Ersetzbarkeit erleben. Studien zeigen, dass Mitarbeiter unterscheiden können, ob E-Mails vom CEO selbst oder von einer KI verfasst wurden. Wenn sie glauben, dass der Inhalt von einer KI generiert wurde, fällt ihre Bewertung niedriger aus, selbst wenn er von einem Menschen geschrieben wurde. Dies spiegelt die Präferenz der Menschen für menschliche Schöpfung und die Sorge vor einer übermäßigen Abhängigkeit von KI wider. Gleichzeitig zeigt eine McKinsey-Studie, dass 54 % der ausscheidenden Mitarbeiter sich nicht wertgeschätzt fühlten und 82 % der Mitarbeiter der Meinung sind, dass im KI-Zeitalter menschliche Verbindungen und emotionale Fürsorge noch wichtiger sind. (Quelle: 36Kr, 36Kr)

Junge Chinesen nehmen KI-Begleiter an, was gesellschaftliche Sorgen über niedrige Geburtenraten auslöst: Der Economist berichtet über das Phänomen, dass junge Menschen in China Beziehungen und Freundschaften mit KI eingehen. KI-Begleiter-Apps wie „Maoxiang“ und „Xingye“ verzeichnen stetig wachsende Nutzerzahlen. Die Nutzer erstellen virtuelle Charaktere, um emotionale Bedürfnisse zu befriedigen. Die technologische Entwicklung ermöglicht es KI, Emotionen und Empathie zu simulieren. Zusammen mit dem hohen Lebensdruck junger Menschen, weniger Zeit für soziale Kontakte und sinkenden Heiratsraten treibt dies diesen Trend voran. Die Regierung befürchtet jedoch, dass KI-Begleiter das bereits ernste Problem der niedrigen Geburtenrate (Gesamtfruchtbarkeitsrate 2024 nur 1,0) verschärfen könnten. (Quelle: dotey)

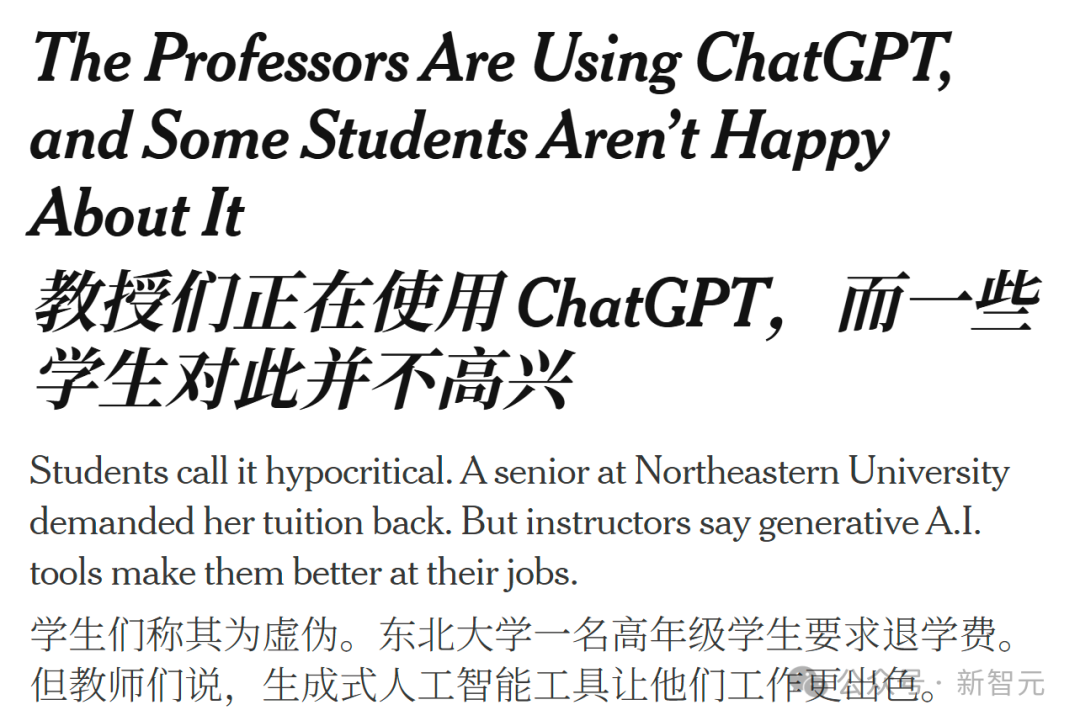

KI-Unterstützung könnte zur neuen Normalität in der Bildung werden, aber übermäßige Abhängigkeit von Professoren von ChatGPT löst Unzufriedenheit und Reflexion bei Studenten aus: Ein Student der Northeastern University verklagte die Universität auf Rückerstattung der Studiengebühren, weil ein Professor ChatGPT zur Erstellung von Kursmaterialien verwendete. Der Vorfall löste eine breite Diskussion über die Rolle von KI in der Hochschulbildung aus. Studenten argumentieren, dass hohe Studiengebühren eine professionelle menschliche Lehre und nicht von Algorithmen generierte Inhalte rechtfertigen, und befürchten, dass KI das Denken und Feedback von Professoren ersetzt. Professoren sehen KI hingegen als Werkzeug zur Effizienzsteigerung und Bewältigung hoher Arbeitsbelastungen. Bildungsexperten weisen darauf hin, dass es entscheidend ist, KI verantwortungsvoll einzusetzen, um die Kreativität und Aufsicht des Menschen zu verbessern und nicht zu ersetzen, Studenten ethische Richtlinien für das KI-Zeitalter zu vermitteln und sicherzustellen, dass KI-generierte Inhalte professionell bearbeitet und überprüft werden. (Quelle: 36Kr, Reddit r/ChatGPT)

Salesforce-CEO behauptet, die Beziehung zwischen Microsoft und OpenAI sei grundlegend zerbrochen und irreparabel: Marc Benioff, CEO von Salesforce, erklärte in einem Interview, dass die Partnerschaft zwischen Microsoft und OpenAI „grundlegend zerbrochen und schwer zu reparieren“ sei. Er wies darauf hin, dass Microsoft Copilot die Kunden enttäusche und eher einem ineffizienten Clippy ähnele. Zudem habe der CFO von OpenAI in einem Technologiearchitekturdiagramm weder Microsoft-Software noch Azure erwähnt, was die Risse zwischen den beiden Unternehmen bestätige. Benioff ist der Ansicht, dass Microsoft im Wesentlichen ein Wiederverkäufer von ChatGPT sei, dessen KI-Strategie begrenzt sei und das versuche, über das „Prometheus Project“ eigene Modelle zu entwickeln. Er erwähnte auch, dass der Aufstieg von Open-Source-Modellen wie DeepSeek die Branche zu einer MOE-Architektur (Mixture of Experts) treibe, die Kosten für die Modellnutzung senke und die Geschäftslogik des „Modellmonopols“ untergrabe. (Quelle: 36Kr)

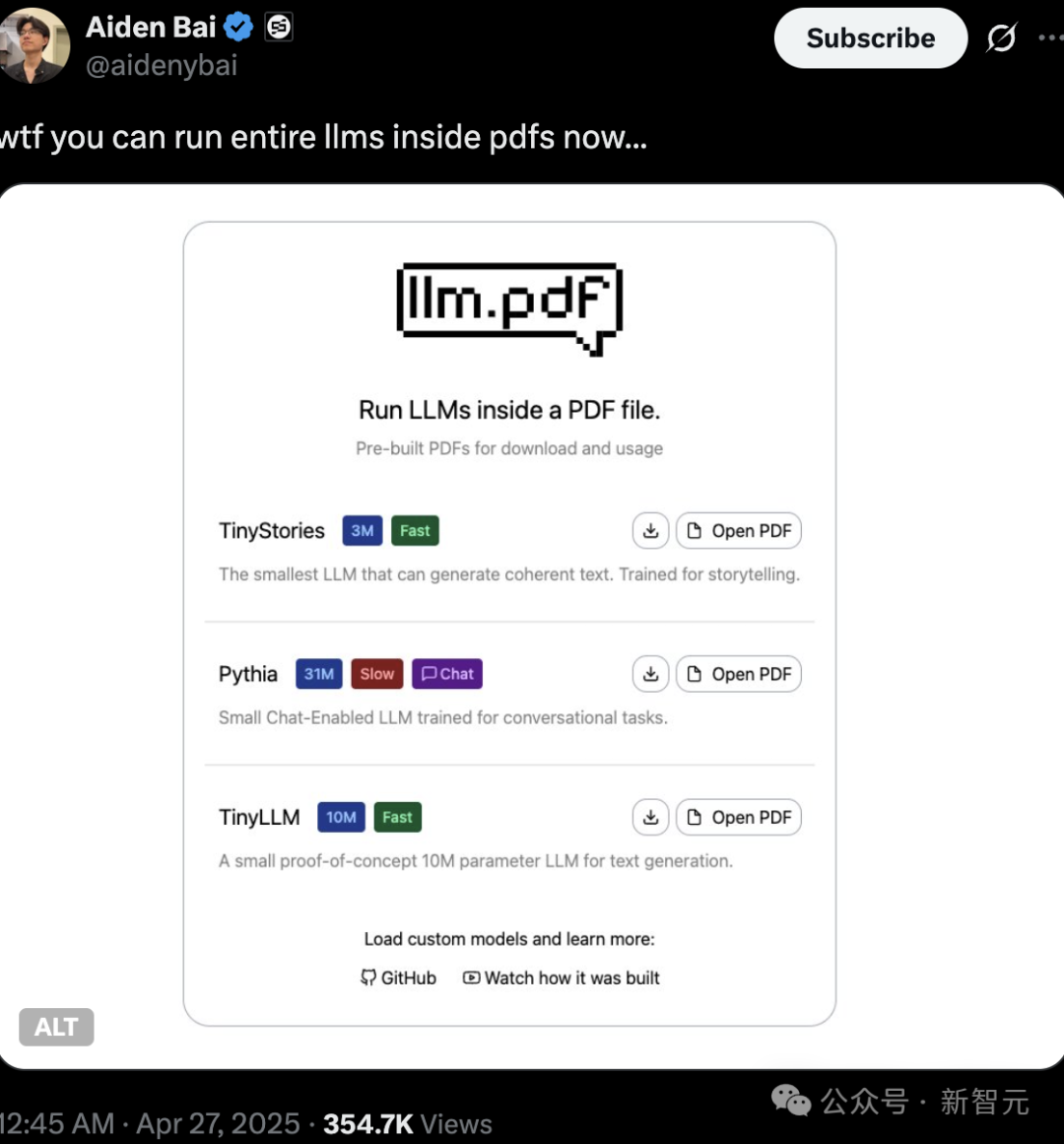

Authentizität und Urheberrecht von KI-generierten Inhalten rücken in den Fokus, Ausführung von LLMs und Linux in PDFs zeigt technisches Potenzial: Technikbegeisterte demonstrierten kürzlich die Fähigkeit, kleine Sprachmodelle (wie TinyStories, Pythia, TinyLLM) und sogar Linux-Systeme direkt in PDF-Dateien auszuführen, indem sie die JavaScript-Unterstützung von PDFs nutzten. Diese „Hacker-Technologie“ löste hitzige Diskussionen unter Internetnutzern aus und unterstreicht den Trend zur Miniaturisierung von KI-Modellen und zum Edge-Deployment. Gleichzeitig stehen auch Fragen des Urheberrechts, der Authentizität und der „Deepfakes“ von KI-generierten Inhalten im Fokus. Zhang Yaqin wies darauf hin, dass zu den Risiken der KI Deepfakes, Halluzinationen, toxische Informationen usw. gehören, die höchste Aufmerksamkeit erfordern und eine stärkere Ausrichtung der KI an menschlichen Werten sowie eine ethische Regulierung notwendig machen. (Quelle: 36Kr, 36Kr)

💡 Sonstiges

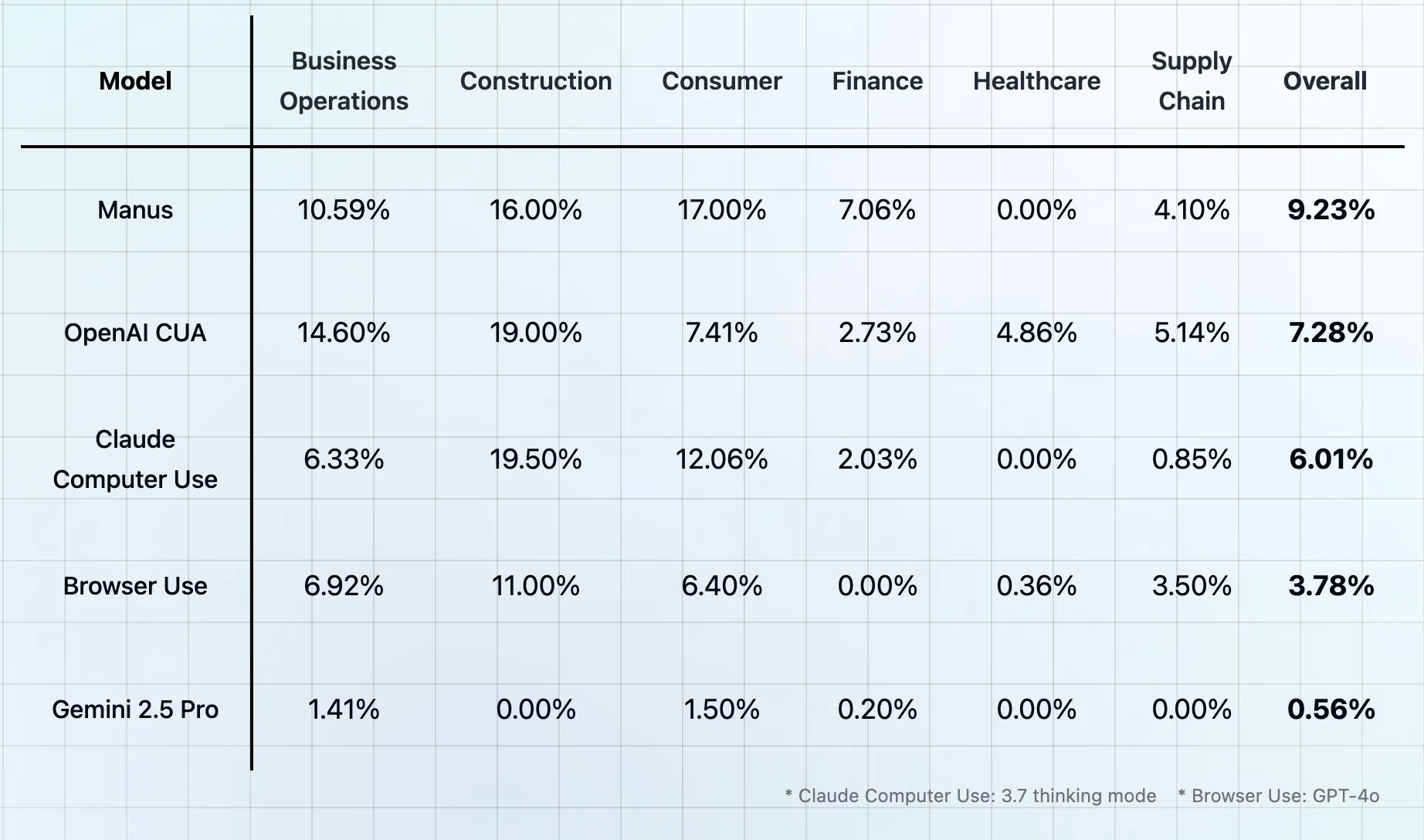

Theta veröffentlicht CUB-Benchmark: Bewertung von Computer- und Browser-Nutzungsagenten als „letzter menschlicher Test“: Theta hat einen neuen Benchmark-Test namens CUB (Computer and Browser Use Agents) vorgestellt, der als „letzter menschlicher Test“ für Computer- und Browser-Nutzungsagenten bezeichnet wird. Solche Benchmarks zielen darauf ab, die Fähigkeit von KI-Agenten zu bewerten, menschliche Nutzung von Computern und Browsern zur Erledigung komplexer Aufgaben zu simulieren. Es gibt jedoch bereits mehrere Benchmarks, die sich als „letzter menschlicher Test“ bezeichnen, was zu Diskussionen über die möglicherweise übertriebene Namensgebung geführt hat. (Quelle: _akhaliq, DhruvBatraDB)

KI wird beschuldigt, zur Erstellung vulgärer Inhalte verwendet zu werden, was Bedenken hinsichtlich Modellmissbrauch und ethischer Grenzen aufwirft: In sozialen Medien tauchten Nutzer auf, die KI-Bilderzeugungstools (wie DALL-E 3 von ChatGPT) zur Erstellung vulgärer oder parodistischer Bilder (z. B. „Shittington Bear“) verwenden. Dies löste Bedenken aus, dass KI-Tools missbraucht werden könnten, um unangemessene Inhalte zu generieren, Urheberrechte zu verletzen (z. B. durch Parodien bekannter Zeichentrickfiguren) und gesellschaftliche ethische Grenzen herauszufordern. Obwohl KI-Plattformen in der Regel Inhaltsfilter haben, können Nutzer diese möglicherweise durch geschickte Prompts umgehen. (Quelle: Reddit r/ChatGPT)

Studie zeigt: KI hat Grenzen bei der Nachahmung des Kommunikationsstils von CEOs, Mitarbeiter vertrauen Menschen mehr: Eine Studie der Harvard Business School ergab, dass Mitarbeiter mit einer Genauigkeit von etwa 59 % unterscheiden können, ob Nachrichten von einer KI oder vom CEO des Unternehmens, Wade Foster (CEO von Zapier), verfasst wurden. Wichtiger noch: Sobald Mitarbeiter glaubten, eine Nachricht sei von einer KI generiert worden, fiel ihre Bewertung niedriger aus, selbst wenn der Inhalt tatsächlich vom CEO stammte. Umgekehrt wurde Inhalt, der als vom CEO verfasst galt, höher bewertet, selbst wenn er von einer KI generiert wurde. Dies zeigt, dass Menschen menschlicher Kommunikation mehr Vertrauen und Wert beimessen als KI. Die Studie empfiehlt Führungskräften, bei der Nutzung von KI für die Kommunikation transparent zu sein, sie nicht für sehr persönliche Antworten zu verwenden und KI-generierte Inhalte streng zu überprüfen. (Quelle: 36Kr)