Schlüsselwörter:KI im Gesundheitswesen, Sprachmodell, Bestärkendes Lernen, KI-Inferenz, KI-Benchmarking, KI-Tools, KI im Geschäftsbereich, KI-Ethik, OpenAI HealthBench, Meta Physik der Sprachmodelle, FlashInfer Inferenz-Engine, Matrix-Game virtuelle Welterzeugung, INTELLECT-2 verteiltes Training

Gerne, hier ist die Übersetzung der AI-Nachrichten ins Deutsche, unter Beibehaltung der englischen Fachbegriffe und des Formats:

🔥 Fokus

OpenAI HealthBench Benchmark veröffentlicht, KI-Fähigkeiten im Gesundheitswesen deutlich verbessert: OpenAI hat HealthBench veröffentlicht, einen Benchmark zur Bewertung von KI im Gesundheitswesen, der in Zusammenarbeit mit 262 Ärzten weltweit entwickelt wurde. Tests zeigen, dass die Leistung der neuesten AI-Modelle (wie o3, GPT-4.1) in medizinischen Dialogszenarien bereits dem besten Niveau entspricht, das Ärzte mit AI-Unterstützung erreichen, und unabhängige Ärzte (ca. 4x) weit übertrifft. Auch die Leistung kleinerer Modelle hat sich verbessert. Dies signalisiert das enorme Potenzial von AI im Gesundheitswesen. Das Bewertungssystem zielt darauf ab, die sichere und effektive Anwendung von AI in der klinischen Praxis zu fördern. (Quelle: Reddit r/ArtificialInteligence, BorisMPower, clefourrier)

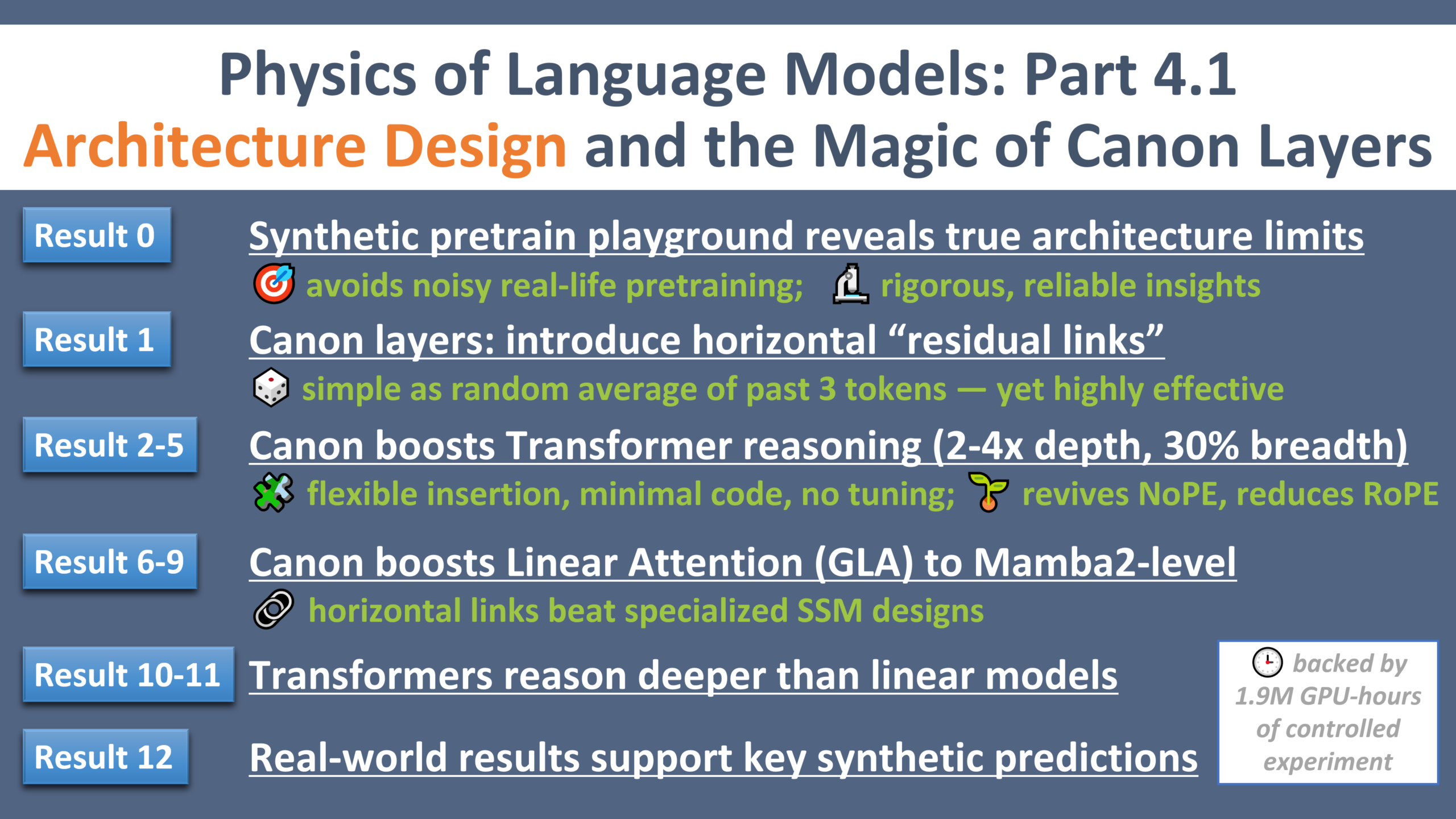

Meta Physics of Language Models Teil 4 veröffentlicht: Meta AI Research hat den vierten Teil der Forschungsreihe “Physics of Language Models” veröffentlicht. Durch eine kontrollierte synthetische Pre-Training-Umgebung entdeckten sie eine leichte Komponente namens “Canon layers”, die durch das Hinzufügen von “horizontalen Residual Connections” zwischen Tokens die Inferenz- und Generalisierungsfähigkeiten von Modellen verschiedener Architekturen wie Transformer, Mamba, GLA signifikant verbessern kann. (Quelle: AIatMeta, arohan)

FlashInfer gewinnt MLSys 2025 Best Paper und erhält NVIDIA-Unterstützung: Die Arbeit über die effiziente, anpassbare Attention Engine-Technologie von FlashInfer, die sich auf LLM-Inferenzdienste konzentriert, wurde als MLSys 2025 Best Paper ausgezeichnet. NVIDIA kündigte die Unterstützung des Projekts an und wird Top-LLM-Inferenz-Kernel wie TensorRT-LLM in FlashInfer integrieren, zur Nutzung durch vLLM, SGLang und andere, mit dem Ziel, die LLM-Inferenz-Effizienz und Skalierbarkeit zu verbessern. (Quelle: vllm_project, _philschmid)

Kunlun Wanwei veröffentlicht Matrix-Game Interactive World Generation Engine: Kunlun Wanwei hat Matrix-Game vorgestellt, eine interaktive Engine, die virtuelle Welten über Textbefehle generieren und steuern kann. Sie unterstützt die Generierung verschiedener Szenarien wie Wüsten und Wälder und ermöglicht eine reibungslose Steuerung von Aktionen wie Vorwärtsgehen, Springen und Angreifen sowie einen 360°-Perspektivwechsel. Diese Technologie verspricht, die Spieleentwicklung, das Training von Embodied AI und die Produktion von Metaverse-Inhalten zu beschleunigen. (Quelle: WeChat)

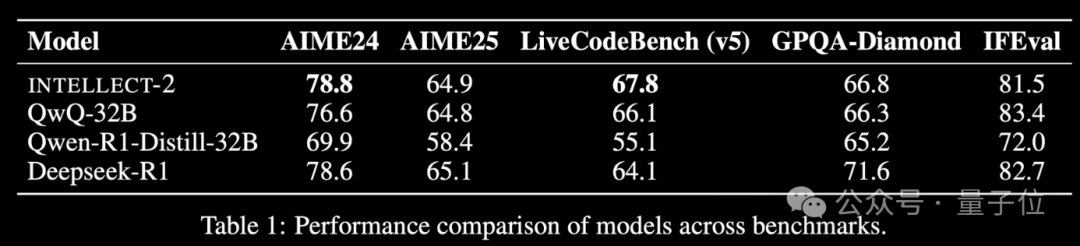

Prime Intellect veröffentlicht INTELLECT-2 Distributed RL Training Model: Prime Intellect hat INTELLECT-2 veröffentlicht und bezeichnet es als das erste Modell, das verteiltes Reinforcement Learning Training durch die Integration ungenutzter globaler Rechenressourcen ermöglicht, mit einer Leistung, die mit DeepSeek-R1 vergleichbar ist. Das Projekt zielt darauf ab, die Kosten für RL Training zu senken, die Abhängigkeit von zentralisierter Rechenleistung zu überwinden und hat Investitionen von bekannten Persönlichkeiten wie Karpathy und Tri Dao erhalten. Die Kernkomponenten (PRIME-RL, SHARDCAST, TOPLOC, Protocol Testnet) wurden als Open Source veröffentlicht. (Quelle: 36氪)

Reinforcement Learning Pioniere Andrew Barto und Richard Sutton erhalten Turing Award: Andrew Barto und Richard Sutton wurden für ihre grundlegenden Beiträge im Bereich des Reinforcement Learning (einschließlich Temporal Difference Learning) mit dem Turing Award ausgezeichnet. Ihre Arbeit hatte tiefgreifenden Einfluss auf die AI und manifestierte sich in Projekten wie AlphaGo. Die beiden planen, einen Teil des Preisgeldes zur Unterstützung der Forschungsfreiheit junger Wissenschaftler und zur Einrichtung von Stipendien für Doktoranden zu verwenden. (Quelle: WeChat)

Neuer Papst benennt sich nach AI-Revolution, AI-Zar prognostiziert millionenfachen AI-Wachstum in vier Jahren: Der neu gewählte Papst Leo XIV. erklärte, dass seine Namenswahl teilweise eine Reaktion auf die “neue industrielle Revolution” sei, die durch AI ausgelöst wird und die die menschliche Würde, Gerechtigkeit und Arbeit herausfordert, was das Interesse der Kirche an AI-Ethik zeigt. Der erste US-“AI- und Krypto-Zar” David Sacks prognostizierte unterdessen, dass die AI-Fähigkeiten aufgrund des exponentiellen Fortschritts bei Modellen, Chips und Rechenleistung in vier Jahren um das Millionenfache wachsen werden, und betonte die Bedeutung des Verständnisses von exponentiellem Wachstum und seinen disruptiven Auswirkungen. (Quelle: WeChat)

🎯 Entwicklungen

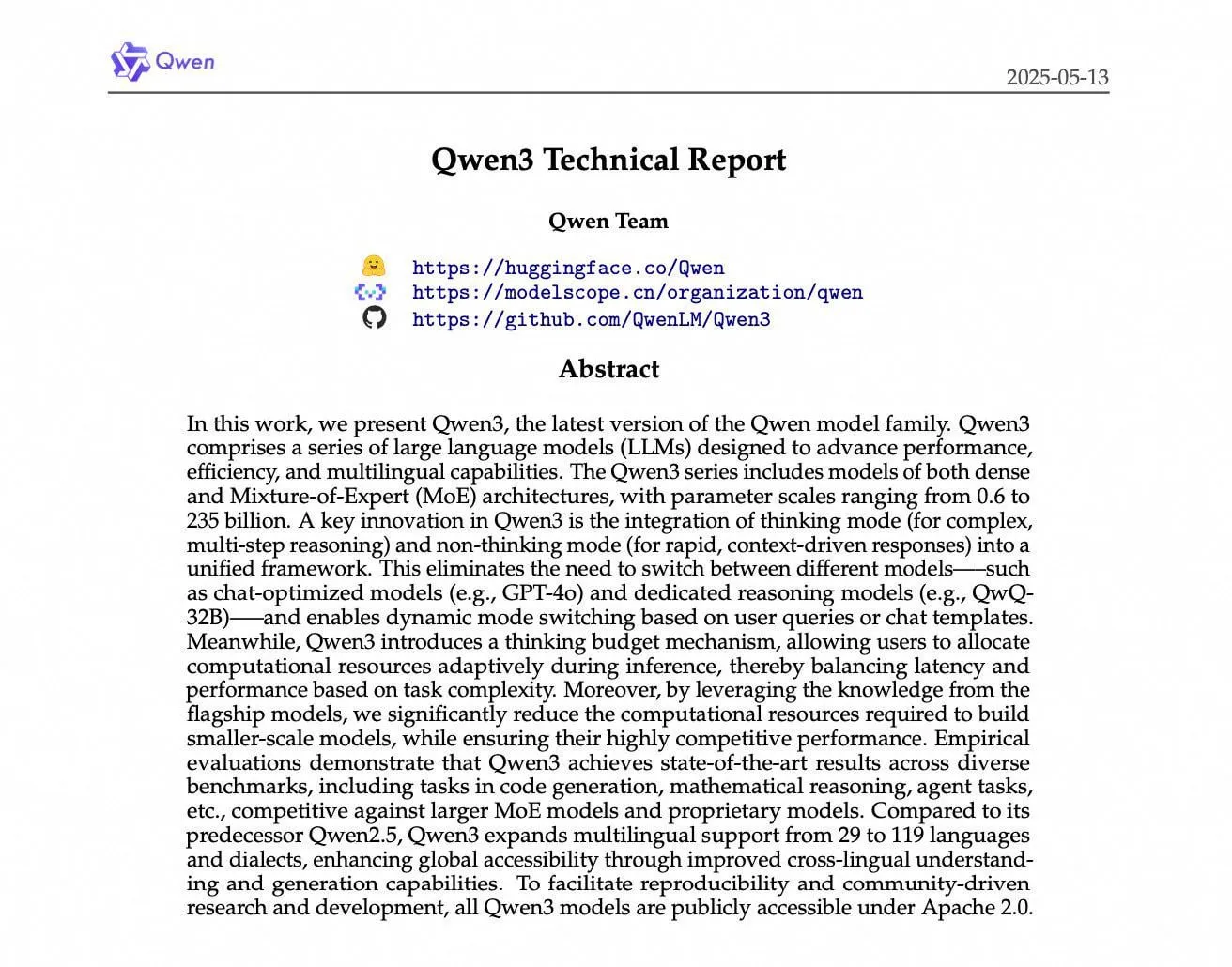

Alibaba Qwen3 Technical Report enthüllt Trainingsdetails: Alibaba Cloud hat den Technical Report für Qwen3 veröffentlicht, der den Trainingsprozess auf 36 Billionen Tokens detailliert beschreibt, einschließlich des massiven Dateneinsatzes für kleinere Modelle und mehrstufigem Post-Training (wie CoT, RL). Das Modell zeigte hervorragende Leistungen auf Benchmarks wie MathArena, aber Community-Diskussionen wiesen auch auf Bugs in seinem Chat-Template hin und darauf, dass es bei Nicht-Inferenz-Aufgaben schlechter abschneidet als Mistral Medium 3. (Quelle: cognitivecompai, rishdotblog, Dorialexander, teortaxesTex, qtnx_, nrehiew_, Reddit r/LocalLLaMA)

US-Kongress erwägt zehnjährige Aussetzung der AI-Regulierung auf Staatsebene: Ein Textentwurf des Handelsausschusses des US-Repräsentantenhauses enthält einen Vorschlag, die Regulierung von AI durch die einzelnen Bundesstaaten für zehn Jahre auszusetzen, um zu verhindern, dass ein Flickenteppich von staatlichen Vorschriften AI-Innovationen behindert. Dieser Schritt wird von einigen Staatsbeamten unterstützt, die argumentieren, dass die AI-Regulierung auf Bundesebene erfolgen sollte. (Quelle: ylecun, pmddomingos, jd_pressman, Reddit r/artificial)

Coding Assistants entwickeln sich zu “Always-On” Agents: Coding Assistants entwickeln sich von Paar-Programmierern, die viel Prompting und menschliche Hilfe benötigen, zu “Always-On” Agents, die kontinuierlich im Hintergrund nach Bugs und Schwachstellen suchen. (Quelle: steph_palazzolo)

Neue Konzepte im AI-Bereich entstehen: Im Bereich der AI-Forschung tauchen mehrere neue Konzepte auf, darunter SakanaAI’s “Continuous Thought Machines” (betont den Zeitfaktor), Salesforce’s “Elastic Reasoning” (trennt Denk- und Lösungsphasen), Alibaba’s “ZeroSearch” (nutzt LLM als simulierte Suchmaschine) sowie Tsinghua University’s “Absolute Zero” (lernt vollständig durch Selbst-Spiel). (Quelle: TheTuringPost)

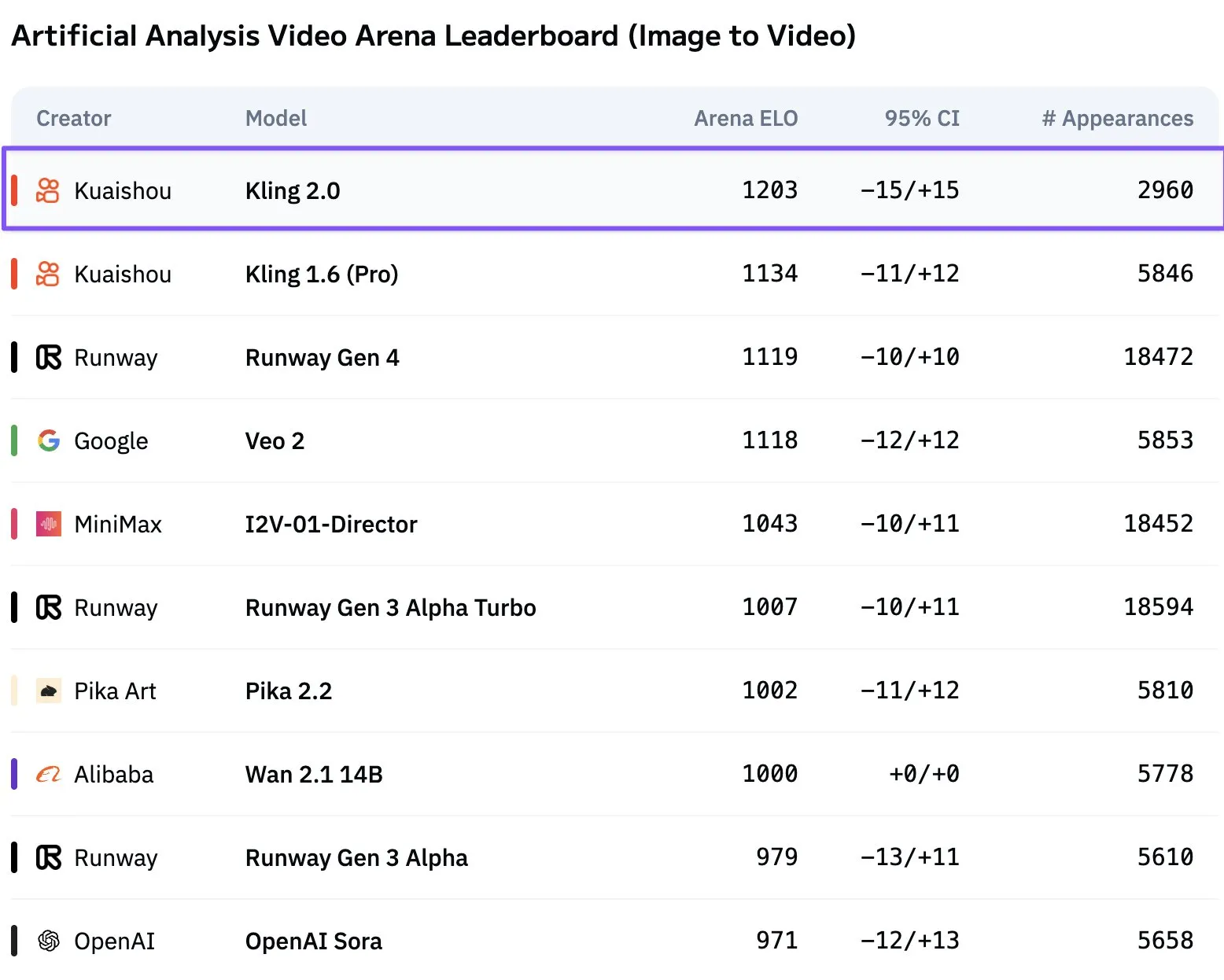

Kuaishou Kling 2.0 Video Model erreicht Spitzenposition: Kuaishou’s Kling 2.0 hat auf der Artificial Analysis Video Generation Rangliste Veo 2 und Runway Gen 4 übertroffen und ist zum führenden Text-zu-Video-Modell aufgestiegen. Community-Nutzer äußerten sich anerkennend über seine Leistung. (Quelle: scaling01)

OpenAI GPT-4.1 führt bei Benutzerpräferenztests vor Claude 3.5 Sonnet: Benutzerpräferenztests zeigen, dass OpenAI’s GPT-4.1 (einschließlich 4.1-mini) in Bezug auf die Benutzererfahrung vor Claude 3.5 Sonnet liegt. (Quelle: imjaredz)

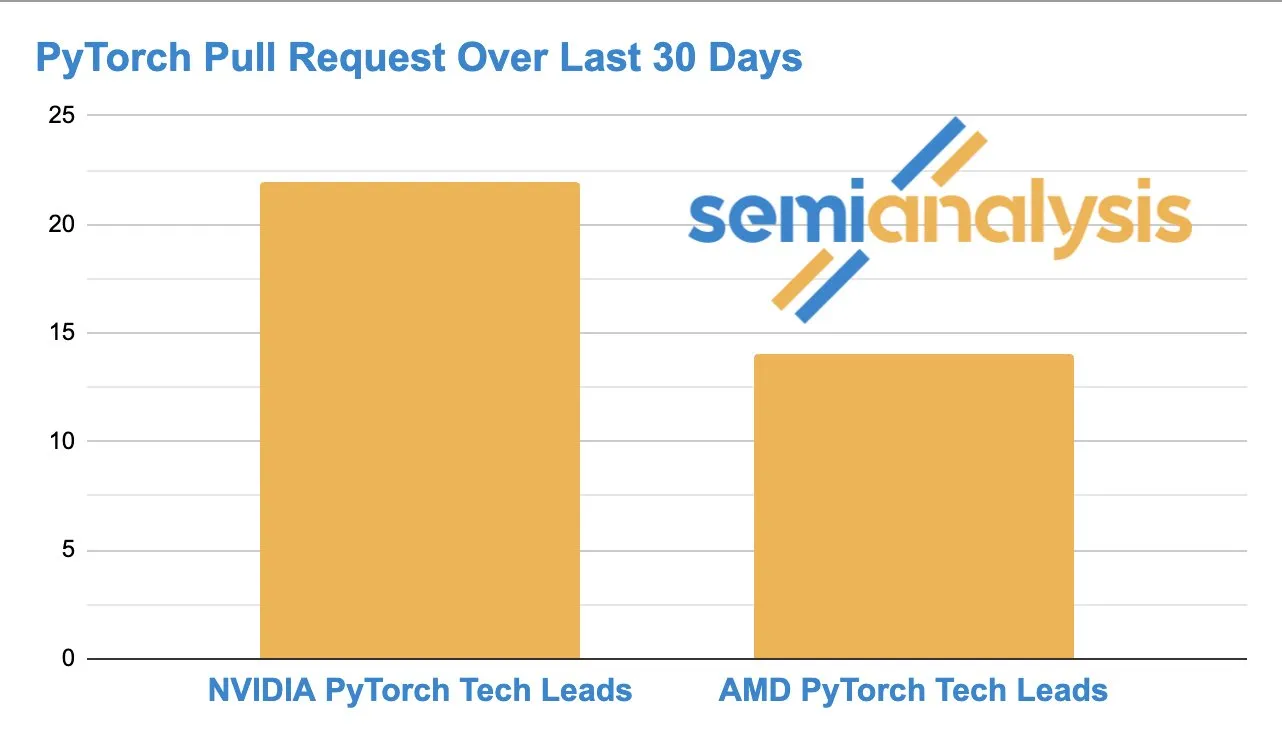

Wettbewerb zwischen AMD und NVIDIA bei der AI-Softwareentwicklung verschärft sich: GitHub-Aktivitäten zeigen, dass die Anzahl der Pull Requests des AMD ROCm PyTorch Teams die des NVIDIA PyTorch Technical Lead einholt, was auf einen zunehmenden Wettbewerb im Bereich der zugrundeliegenden AI-Hardware- und Softwareentwicklung hindeutet. (Quelle: zacharynado)

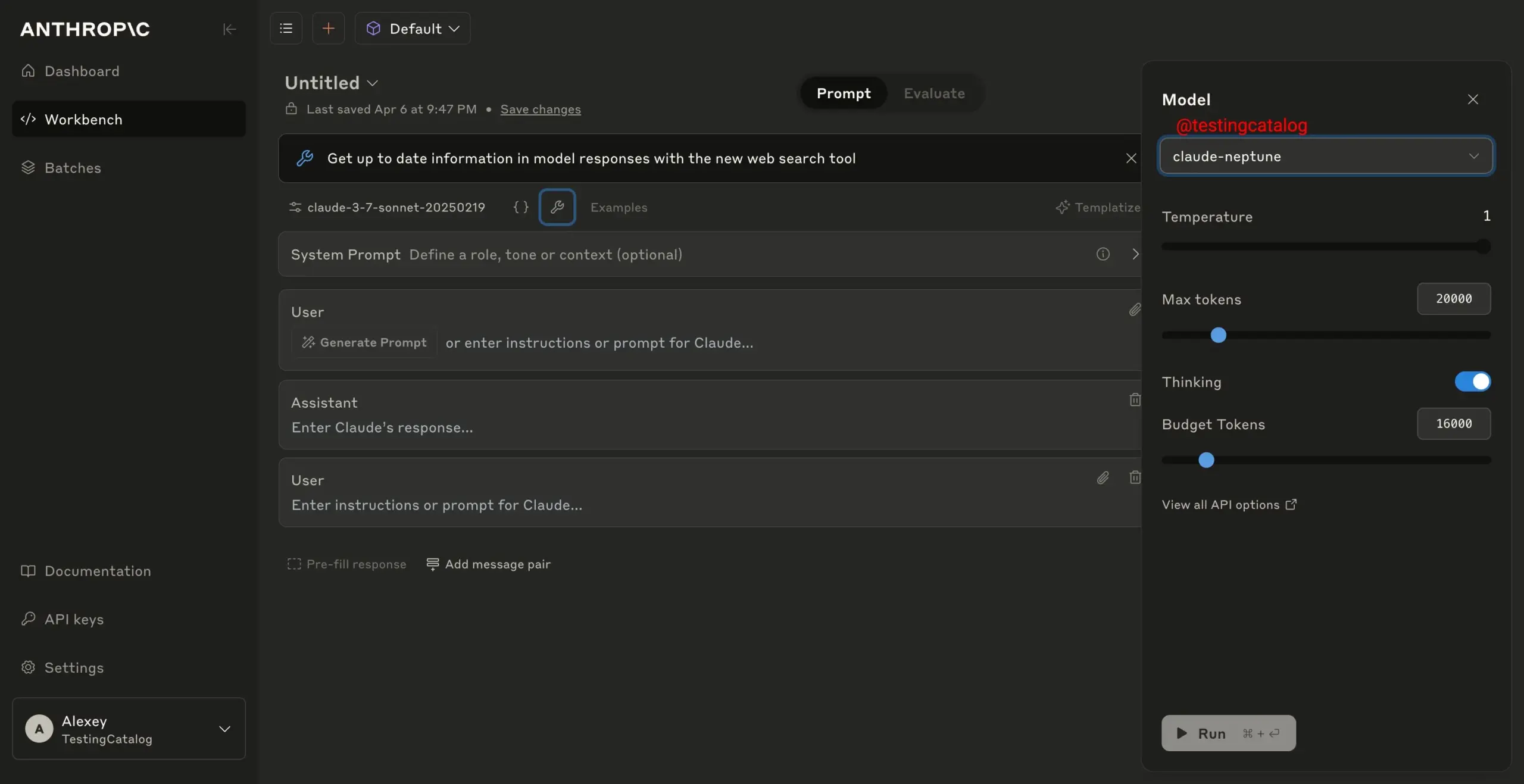

Anthropic testet neues Modell “claude-neptune” auf Sicherheit: Es wird berichtet, dass Anthropic sein neues Modell “claude-neptune” Sicherheitstests unterzieht, was auf eine mögliche baldige Veröffentlichung eines neuen Modells hindeutet. (Quelle: scaling01)

Kostenloser API-Zugang zu Gemini 2.5 Pro aufgrund hoher Nachfrage vorübergehend ausgesetzt: Aufgrund der enormen Nachfrage hat Google den Zugang zur kostenlosen Ebene von Gemini 2.5 Pro über die API vorübergehend ausgesetzt, um sicherzustellen, dass Entwickler ihre Anwendungen weiterhin skalieren können. Das Modell ist in Google AI Studio weiterhin kostenlos nutzbar. (Quelle: matvelloso)

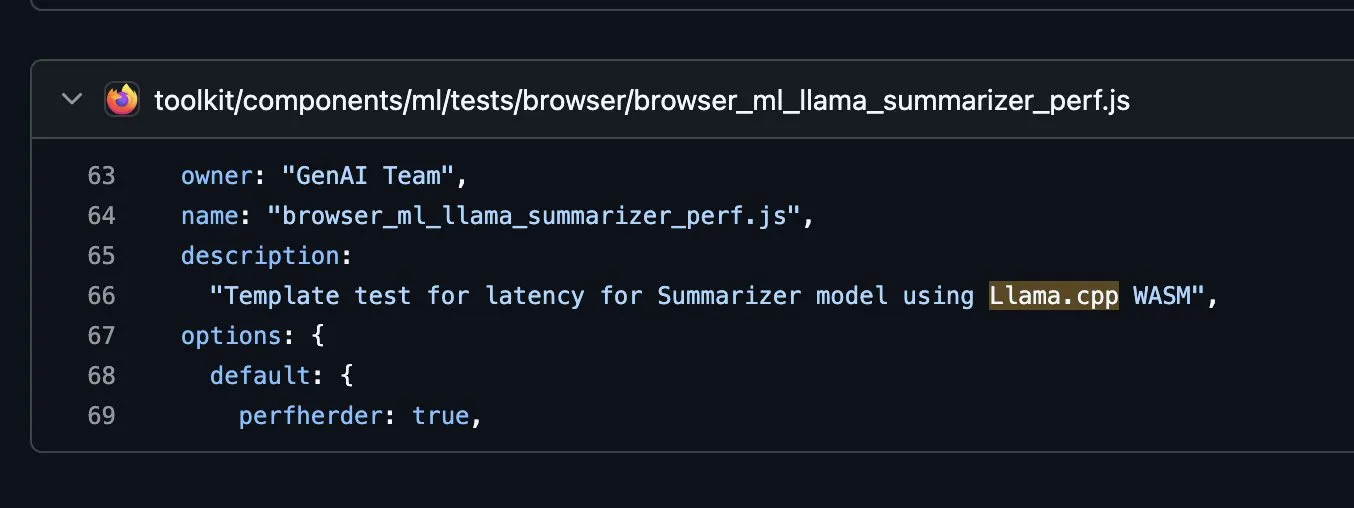

Firefox erforscht Integration von llama.cpp in WASM: Firefox experimentiert auf GitHub mit der Integration der llama.cpp Bibliothek in WebAssembly (WASM), was bedeuten könnte, dass Benutzer zukünftig lokale LLMs direkt im Browser ausführen können. (Quelle: ClementDelangue, ggerganov)

AMD Ryzen AI Max+ PRO 395 LLM Benchmark-Tests: LLM Benchmark-Tests des AMD Ryzen AI Max+ PRO 395 unter Linux zeigen, dass seine Leistung scheinbar unter der einer RTX 4060 Ti liegt. Community-Diskussionen weisen darauf hin, dass die Tests möglicherweise nur die CPU-Leistung widerspiegeln, und diskutieren die iGPU-Leistung, die Vorteile des Grafikspeichers sowie aktuelle Kompatibilitätsprobleme von Intel GPUs bei FP8, Flash Attention und Speicherzuweisung. (Quelle: Reddit r/LocalLLaMA)

🧰 Tools

Minions Secure Chat Open Source Protokoll veröffentlicht, ermöglicht verschlüsselte Cloud-LLM-Chats: Ein Open Source Protokoll namens “Minions Secure Chat” wurde veröffentlicht, das Ende-zu-Ende-verschlüsselte Cloud-LLM-Chats mit sehr geringem Latenz-Overhead (<1%) ermöglicht, selbst bei Modellen mit über 30B Parametern. Das Protokoll stellt sicher, dass Cloud-Service-Provider den Nachrichteninhalt nicht einsehen können; die Inferenz erfolgt in sicheren GPU Enclaves, um die Vertraulichkeit zu gewährleisten. (Quelle: realDanFu, ollama, rebeccatqian, code_star)

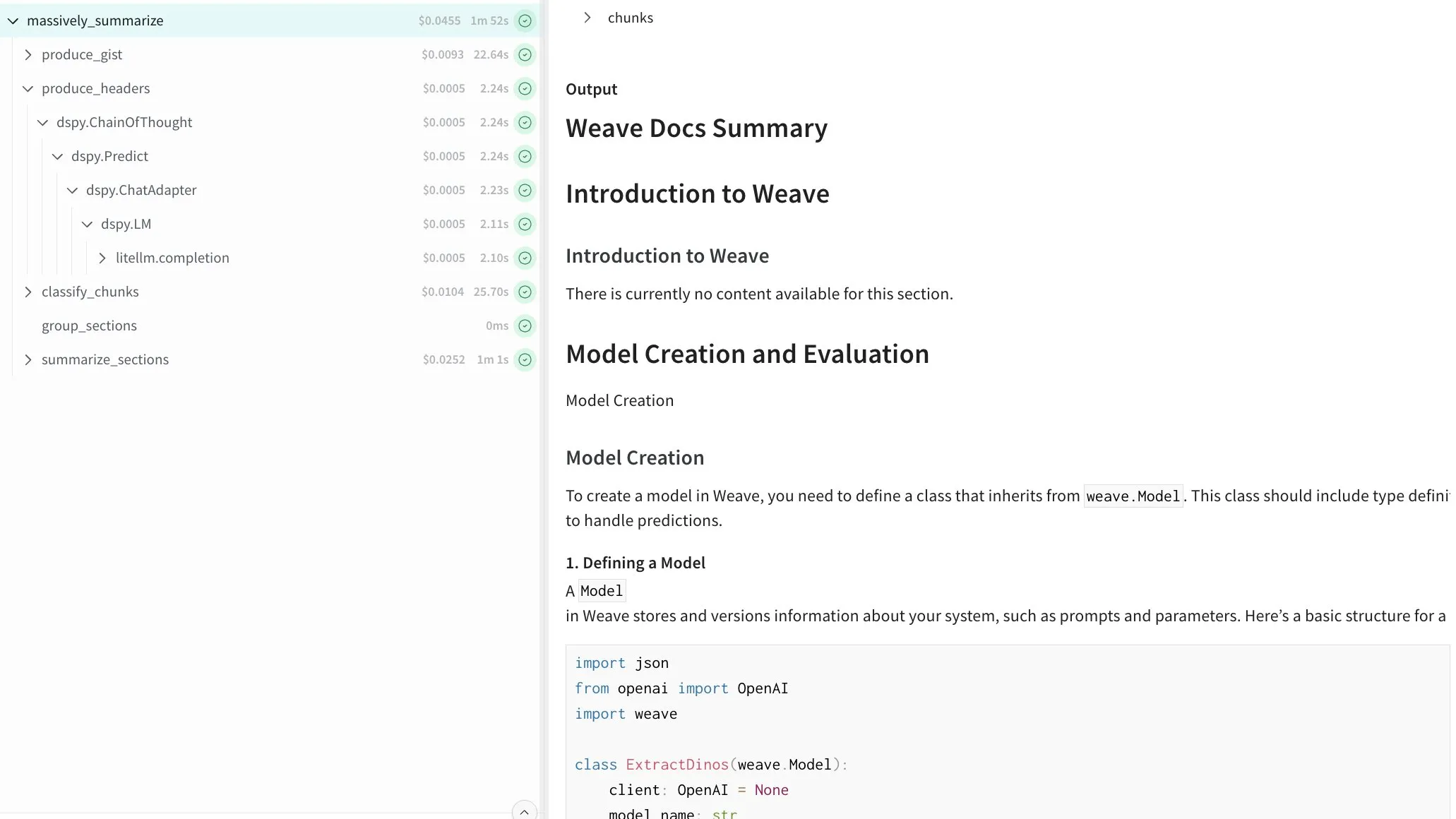

DSPy ermöglicht rekursive Zusammenfassung beliebig langer Texte: Ein mit DSPy erstelltes Programm wurde vorgestellt, das in der Lage ist, beliebig lange Texte rekursiv zusammenzufassen. Das Programm erreicht dies durch das Erstellen eines Verzeichnisses, das Aufteilen des Inhalts in Blöcke und die parallele Verarbeitung der einzelnen Teile, was eine allgemeine Lösung für die Verarbeitung langer Dokumente bietet. (Quelle: lateinteraction)

Runway AI Video Generation fügt filmische Steuerung und Referenzfunktionen hinzu: Runway hat neue Funktionen für sein Gen-4 Video Generation Modell eingeführt, darunter über 20 filmische Kamerasteuerungen, Multi-Element-Referenzierung und -Fusion sowie eine flüssigere Verarbeitung komplexer Bewegungen. Die verbesserten Referenzfunktionen erhöhen auch die Präzision bei der Objektplatzierung. (Quelle: c_valenzuelab, TomLikesRobots)

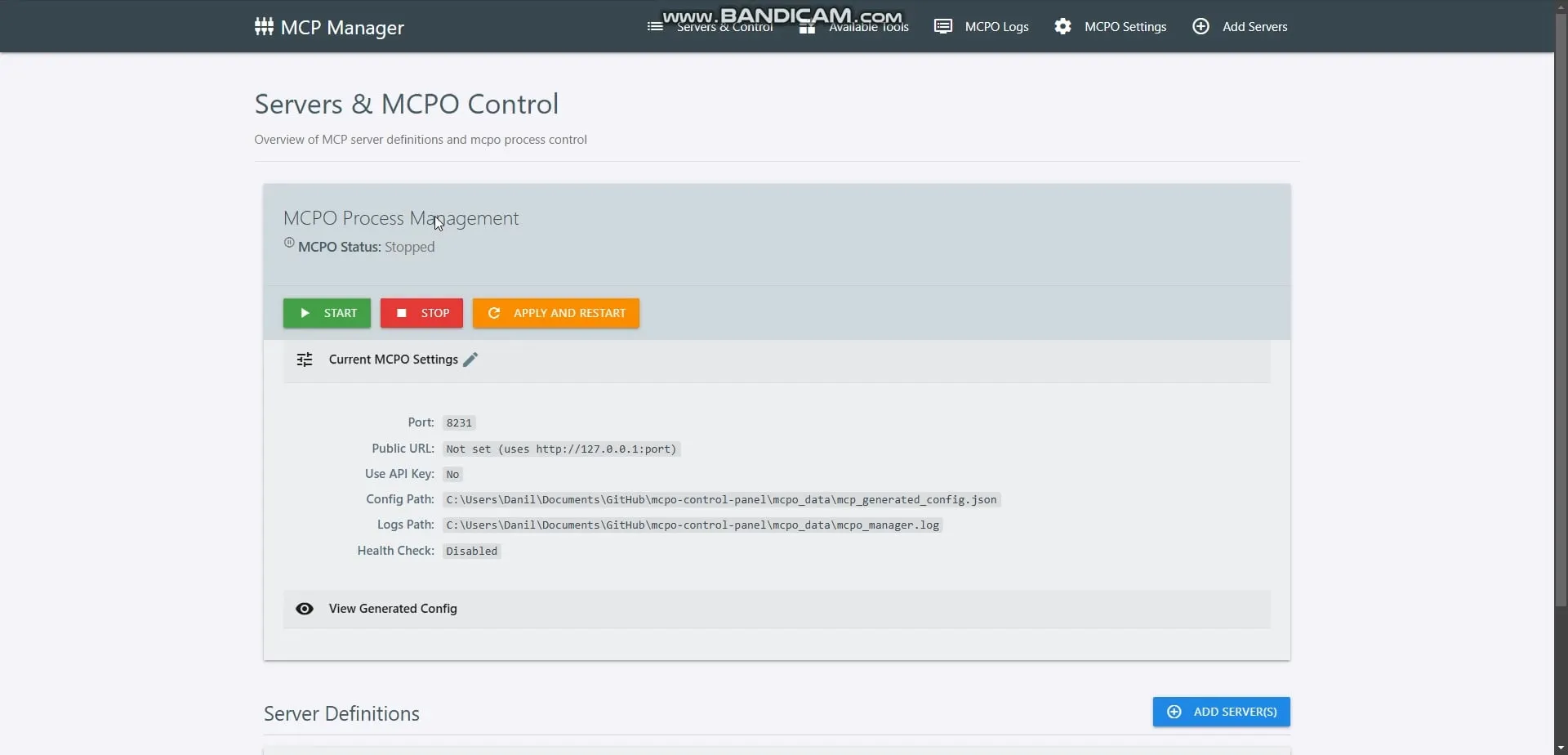

OpenMemory MCP veröffentlicht, bietet lokalen privaten Speicher für AI Agents: OpenMemory MCP wurde veröffentlicht, eine private, lokale, persistente Speicherschicht, die für MCP-kompatible AI-Clients (wie Cursor, Claude Desktop) entwickelt wurde. Sie ermöglicht es verschiedenen AI-Tools, sicher und privat auf einen gemeinsamen Speicher zuzugreifen, der vollständig auf der Maschine des Benutzers läuft und nicht von Cloud-Diensten abhängt. (Quelle: omarsar0)

HeyGen führt Voice Mirroring Funktion ein: HeyGen hat die Voice Mirroring Funktion veröffentlicht, die es Benutzern ermöglicht, einen bestimmten Sprachstil oder bestimmte Merkmale in AI-generiertem Audio zu replizieren. (Quelle: Ronald_vanLoon)

Step1X-3D Open Source Framework veröffentlicht, ermöglicht kontrollierte 3D-Asset-Generierung: StepFun AI hat Step1X-3D auf Hugging Face veröffentlicht, ein Open Source Framework zur hochgetreuen, kontrollierten Generierung von texturierten 3D-Assets. (Quelle: huggingface, _akhaliq, reach_vb)

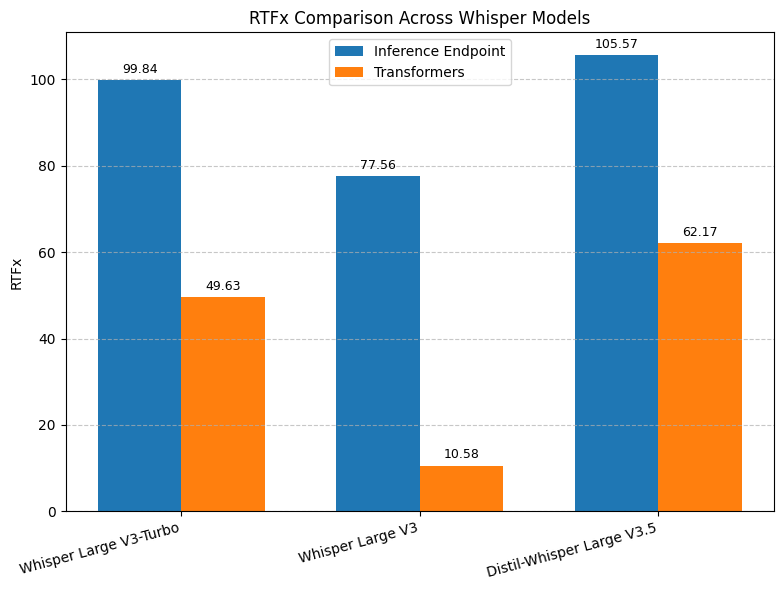

Hugging Face Whisper Transkriptionsgeschwindigkeit erhöht: Hugging Face hat einen auf vLLM basierenden und für NVIDIA GPUs optimierten Whisper Transkriptions-Endpunkt eingeführt, der eine bis zu 8-fache Geschwindigkeitssteigerung bietet und bessere Leistung zu geringeren Kosten liefert. (Quelle: ClementDelangue, huggingface, vllm_project)

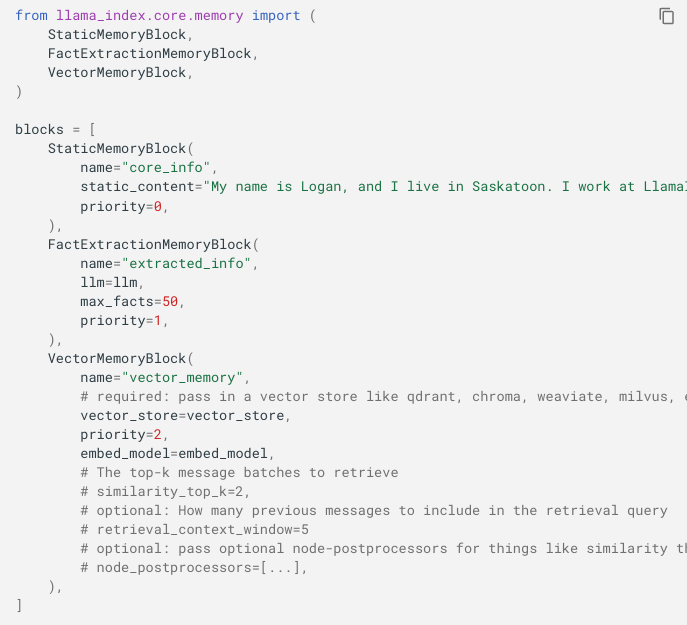

LlamaIndex Memory API Update unterstützt Fusion von Kurz- und Langzeitgedächtnis: LlamaIndex hat seine Memory API aktualisiert, um sie flexibler zu gestalten und die Fusion von kurzem Chat-Verlauf und Langzeitgedächtnis durch steckbare Module (statisch, Faktenextraktion, Vektorspeicher) zu ermöglichen. (Quelle: jerryjliu0)

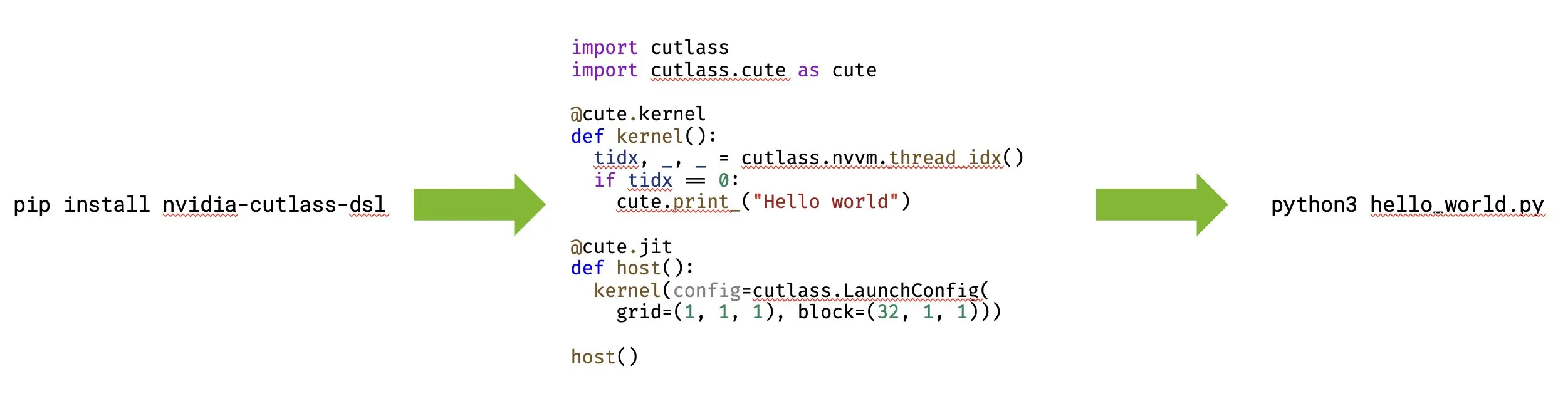

NVIDIA veröffentlicht CUTLASS 4.0 mit Unterstützung für natives Python GPU Programming: NVIDIA hat CUTLASS 4.0 veröffentlicht, eine Bibliothek, die natives Python GPU Programming unterstützt. Dieses Update zielt darauf ab, die Kernel-Entwicklung und die Erforschung neuer Ideen in den Bereichen ML und GPU Programming zu beschleunigen. (Quelle: marksaroufim, tri_dao)

WeClone Open Source Projekt zur Erstellung digitaler Klone aus Chat-Verläufen: Ein beliebtes Open Source Projekt auf GitHub, WeClone, bietet eine Lösung zur Erstellung digitaler Klone aus WeChat Chat-Verläufen. Es ermöglicht das Fine-Tuning von Large Language Models, um den persönlichen Gesprächsstil zu erfassen, und bindet diese an Chatbots wie WeChat, QQ, Telegram, wobei auch Datenschutzfilter enthalten sind. (Quelle: GitHub Trending)

Google Maps Scraper Open Source Tool zum Extrahieren von Kartendaten: Ein beliebtes Open Source Tool auf GitHub zum Extrahieren von Google Maps Listendaten. Es bietet Kommandozeilen-, Web UI- und REST API-Schnittstellen, kann Informationen wie Geschäftsnamen, Adressen, Kontaktdaten, Bewertungen, Rezensionen extrahieren und unterstützt E-Mail-Extraktion sowie einen “Fast Mode”. (Quelle: GitHub Trending)

OpenWebUI Benutzer melden mehrere technische Probleme: OpenWebUI Benutzer berichten über mehrere technische Probleme, darunter das Ignorieren von Modelfile-Parametern (wie num_ctx), was zu Abstürzen führt, die Unfähigkeit, auf die UI im lokalen Netzwerk nach Updates zuzugreifen, die Unfähigkeit, die integrierte OpenAI Websuche mit bestimmten Modellen zu verwenden, sowie Timeout-Probleme bei alten Chat-Sitzungen. (Quelle: Reddit r/OpenWebUI)

Roboter zur Inspektion von Eisenbahnoberflächen: Ein multifunktionaler Roboter namens RailScan wird erwähnt, der für Inspektionsarbeiten an Eisenbahnoberflächen eingesetzt wird und ein Beispiel für die Anwendung von AI und Robotik in der Industrie ist. (Quelle: Ronald_vanLoon)

3D-Druck-Baumaschinenroboter: Die 3D-Drucktechnologie wird mit Robotern im Bausektor kombiniert, z. B. für den 3D-Druck von Strukturen, was den Fortschritt von Robotik und AI in der automatisierten Konstruktion zeigt. (Quelle: Ronald_vanLoon)

Embodied AI Roboter: Es werden autonome, AI-gesteuerte Roboter erwähnt, die in der Lage sind, nahtlos in komplexen Umgebungen zu navigieren und Aufgaben präzise auszuführen, was das Potenzial von Embodied AI und Robotik für reale Anwendungen demonstriert. (Quelle: Ronald_vanLoon)

Bio-inspirierte Robotik: Eine Studie wird erwähnt, in der Pilze, denen ein Roboterkörper gegeben wurde, das Klettern lernten, was zeigt, wie biologische Inspiration die Robotik vorantreiben kann. (Quelle: Ronald_vanLoon)

📚 Lernen

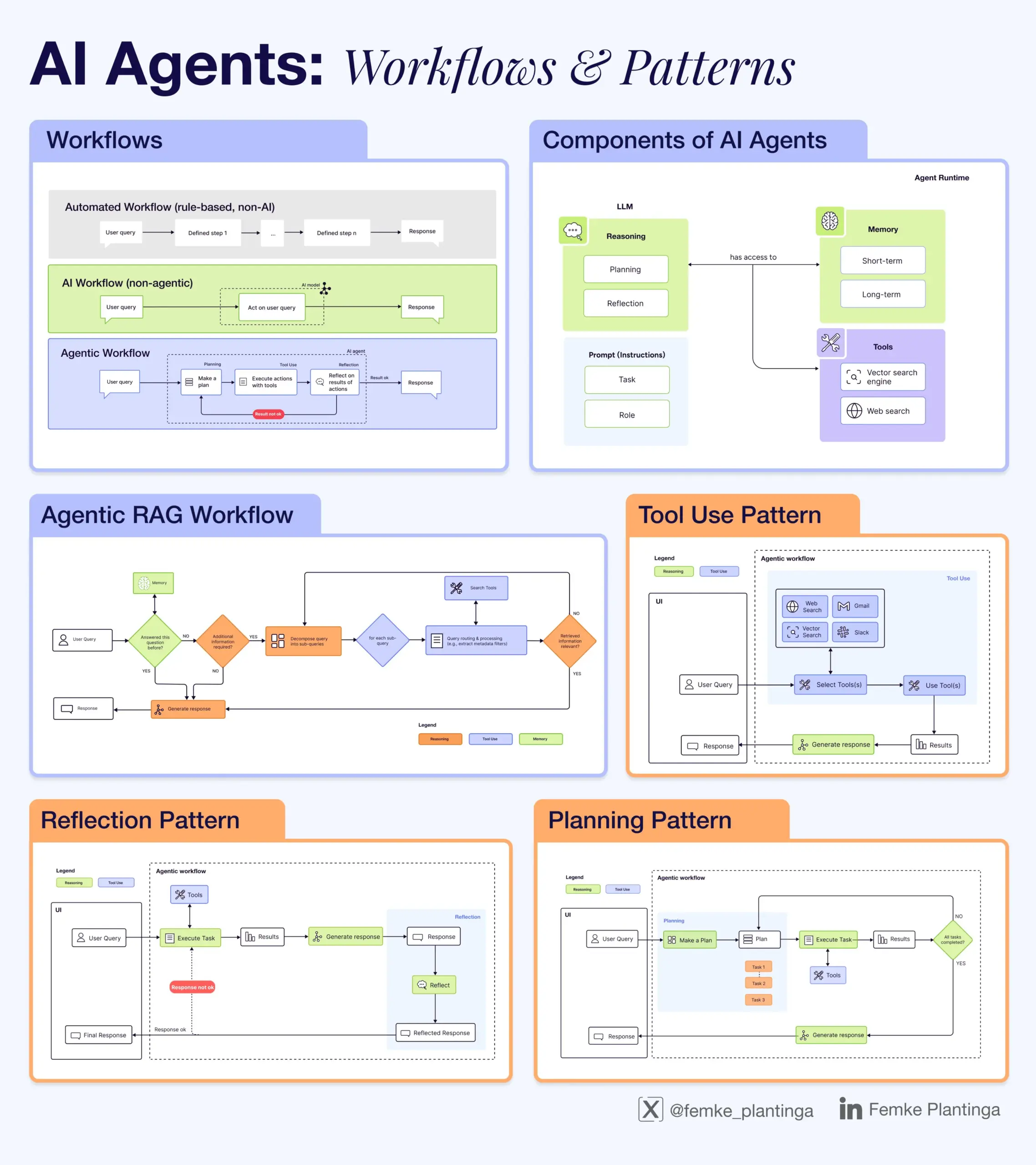

Sammlung von AI-Lernressourcen: Die Community teilte verschiedene AI-Lernressourcen, darunter positives Feedback zu den Ressourcen von @dair_ai, Online-Meisterkurse und Buch-Workshops zur AI-Bewertung, Video-Guides zur Inferenz von LLMs, eine Erklärung des Unterschieds zwischen Agentic AI und konventioneller AI, ein kostenloses RLHF-Buch, ein Modul für Datenanalyse-Kurse über Datenverarbeitung und Debugging mit GenAI, Veranstaltungen zur AI-Code-Intelligenz sowie Infografiken, die erklären, wie LLMs funktionieren. (Quelle: dair_ai, HamelHusain, omarsar0, bobvanluijt, natolambert, DeepLearningAI, l2k, Ronald_vanLoon, Reddit r/deeplearning, Reddit r/artificial)

LangChain Interrupt Event und Workshops: LangChain veranstaltete das Interrupt Event, das Workshops zum Aufbau zuverlässiger AI Agents umfasste. Die Inhalte deckten das Design von Agent-Workflows mit LangGraph, Mensch-AI-Zusammenarbeit sowie die Nutzung von LangSmith für Beobachtbarkeit und Bewertung ab. Cisco präsentierte ihren Text-zu-SQL Agent, der mit LangGraph und LangSmith erstellt wurde. (Quelle: LangChainAI, hwchase17)

RL und Videospiele Workshop Ankündigung: Die RLC 2025 Konferenz wird einen Workshop zu Reinforcement Learning und Videospielen veranstalten. Es werden Beiträge zu spielbezogenen Themen wie RL in komplexen Umgebungen, Multi-Agenten-Szenarien und Content-Generierung gesucht. Bestätigte Sprecher wurden ebenfalls bekannt gegeben. (Quelle: Reddit r/MachineLearning)

mlabonne/llm-course GitHub Repository bietet umfassenden LLM-Lernpfad: Ein beliebtes Repository auf GitHub, mlabonne/llm-course, bietet einen umfassenden LLM-Lernkurs und eine Roadmap, die Grundlagen, LLM Science (Fine-Tuning, Quantisierung, Bewertung) und LLM Engineering (Ausführung, RAG, Deployment, Sicherheit) abdeckt und relevante Code-Notizen und Referenzen enthält. (Quelle: GitHub Trending)

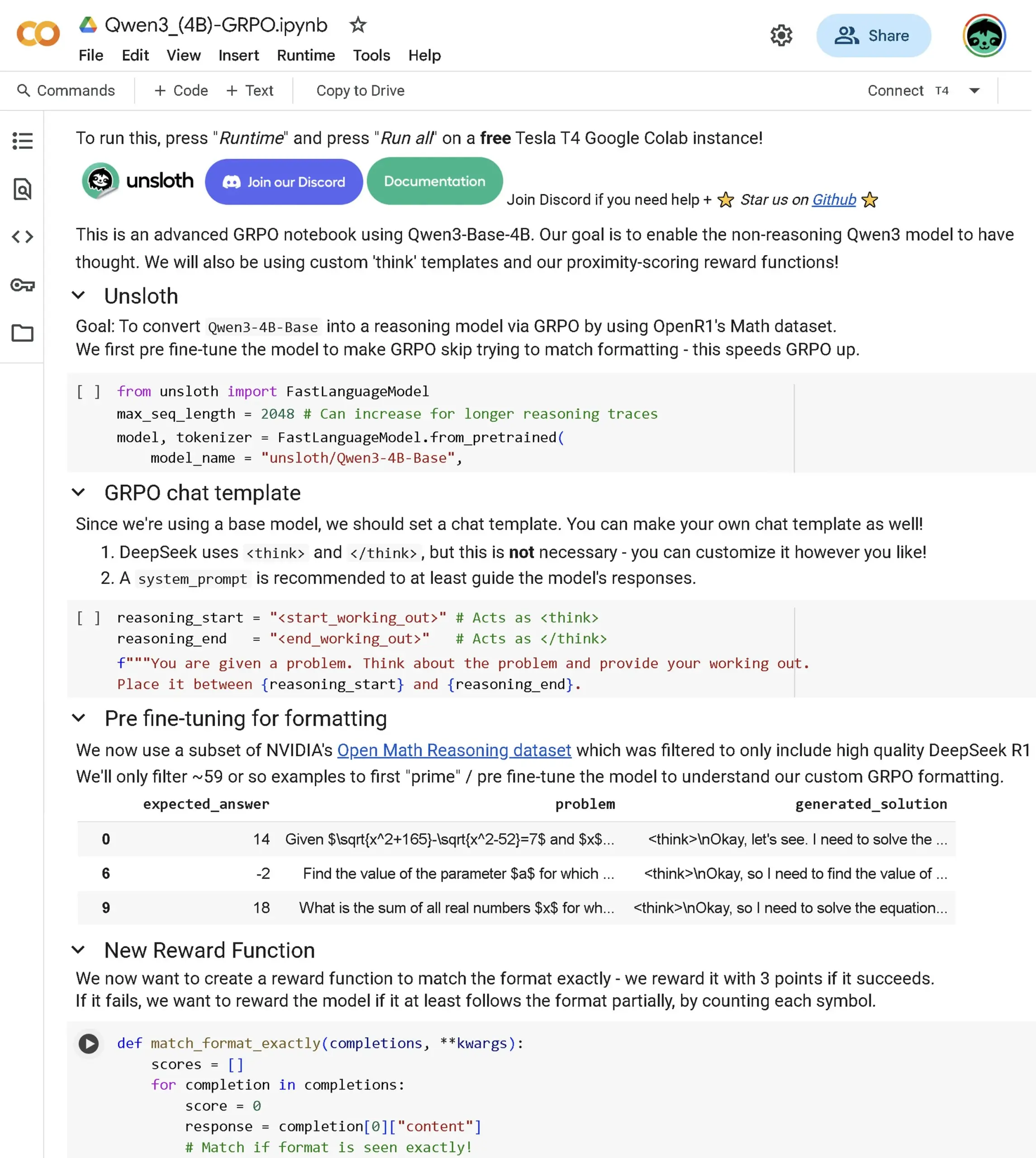

Qwen3 Base GRPO Advanced Notebook veröffentlicht: Ein neues Advanced GRPO (Generalized Policy Optimization) Notebook wurde veröffentlicht, das speziell auf das Qwen3 Base Modell zugeschnitten ist. Der Inhalt behandelt das Fine-Tuning des Modells zur Verbesserung der Inferenzfähigkeiten, Proximity Scoring, GRPO Templates, das OpenR1 Dataset sowie die Optimierung des RL-Prozesses durch Pre-Fine-Tuning. (Quelle: danielhanchen)

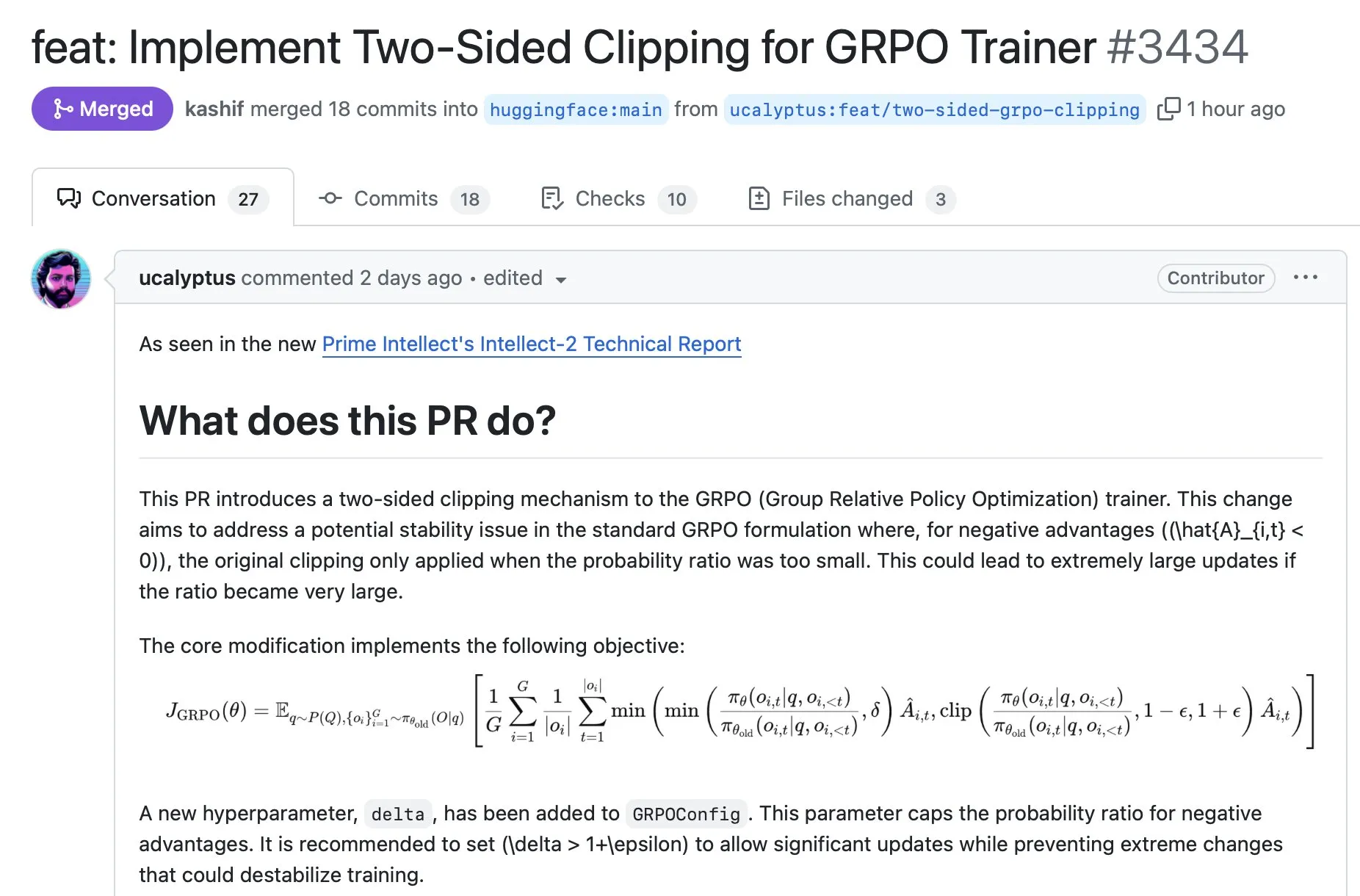

TRL Bibliothek integriert GRPO Stabilisierungstechnik: Eine neue GRPO Stabilisierungstechnik, die von Prime Intellect entwickelt wurde, wurde in die beliebte Transformer Reinforcement Learning (TRL) Bibliothek integriert. Sie ist durch die Installation der neuesten Version verfügbar und zielt darauf ab, die Stabilität des GRPO Trainings zu verbessern. (Quelle: ClementDelangue)

💼 Business

Perplexity AI steht kurz vor Abschluss einer 500 Millionen Dollar Finanzierungsrunde bei einer Bewertung von 14 Milliarden Dollar: Das AI-Such-Startup Perplexity AI steht Berichten zufolge kurz vor dem Abschluss einer Finanzierungsrunde in Höhe von 500 Millionen Dollar, angeführt von Accel, wodurch das Unternehmen mit 14 Milliarden Dollar bewertet würde. Dies zeigt, dass Perplexity trotz des Wettbewerbs mit Google und OpenAI starke Kapitalunterstützung erhält. (Quelle: TheRundownAI, Reddit r/ClaudeAI, 36氪)

NVIDIA arbeitet mit Saudi-Arabien am Aufbau einer AI-Fabrik: NVIDIA kündigte eine Zusammenarbeit mit HUMAIN, der AI-Tochtergesellschaft des saudischen Public Investment Fund, an, um eine “AI-Fabrik” in Saudi-Arabien zu bauen. NVIDIA wird Infrastruktur und Fachwissen bereitstellen, um Saudi-Arabien zu einem globalen AI-Führer zu machen. (Quelle: nvidia)

WizardLM Team verlässt Microsoft und wechselt zu Tencent Hunyuan: Das WizardLM Team, einschließlich seines Leiters Can Xu, hat Microsoft verlassen und ist zu Tencent Hunyuan gewechselt. Zuvor rangierte das Tencent Hunyuan-Turbos Modell auf den Ranglisten weit oben (Platz 8). Dieser Personalwechsel hat Diskussionen über den Talentwettbewerb zwischen großen AI-Labors ausgelöst. (Quelle: andrew_n_carr, cognitivecompai, teortaxesTex, Sentdex, WizardLM_AI, madiator)

Johnson & Johnson setzt generative AI umfassend im Pharmageschäft ein: Nach rund 900 internen Experimenten hat Johnson & Johnson die Anwendung generativer AI auf verschiedene Bereiche seines Pharmageschäfts ausgeweitet, darunter die Beschleunigung der Arzneimittelentwicklung, die Vorhersage von Lieferkettenrisiken, die Vereinfachung klinischer Studien sowie die Unterstützung von Vertrieb und Mitarbeiterservices. (Quelle: DeepLearningAI)

Somite AI erhält Finanzierung für den Aufbau eines Basismodells für menschliche Zellen: Das Unternehmen Somite AI baut ein Basismodell namens “DeltaStem” für menschliche Zellen auf und entwickelt Technologien zur schnelleren Generierung von Zellsignaldaten. Das Unternehmen hat 5,9 Millionen Dollar Finanzierung erhalten. (Quelle: saranormous, finbarrtimbers)

🌟 Community

Benutzer äußern Unzufriedenheit mit sinkender AI-Modellqualität und Sycophancy: Viele Benutzer äußerten Frustration über die sinkende Qualität aktueller AI-Modelle, insbesondere ChatGPT wird als “sycophantic” (übermäßig positiv/schmeichelhaft), faul und halluzinierend kritisiert. Einige Benutzer erwägen daher die Kündigung ihres Abonnements, während andere diskutieren, ob benutzerdefinierte Anweisungen wirksam sind oder ob die Unzufriedenheit in den sozialen Medien übertrieben ist. (Quelle: Reddit r/ArtificialInteligence, Reddit r/ChatGPT)

AI-Ethik und Verantwortung: Wer ist verantwortlich für AI-Fehlentscheidungen?: Die Community diskutiert breit, wer die Verantwortung tragen sollte, wenn autonome AI-Entscheidungen zu Fehlern führen. Standpunkte reichen von der Verantwortung der Unternehmen, die die AI besitzen (ähnlich wie Eltern für Kinder oder Fahrer für autonome Autos), über die Möglichkeit, dass die AI selbst in Zukunft verantwortlich sein könnte, bis hin zur Notwendigkeit menschlicher Aufsicht und der Verantwortung der Unternehmen, die von der AI profitieren. (Quelle: Reddit r/ArtificialInteligence)

Auswirkungen von AI auf Bildung und Beschäftigung: Lehrkräfte nutzen AI zur Benotung löst Kontroverse aus: Die Diskussion über die Nutzung von AI durch Lehrkräfte zur Benotung von Schülerarbeiten löst Kontroversen aus. Einige befürchten, dass dies die Schüler abwertet oder ihre potenzielle Überflüssigkeit signalisiert. Gegenargumente besagen, dass AI nur ein Werkzeug ist, das zeitnahes Feedback geben kann, und dass Prüfungen vielfältige Zwecke haben. Die Community diskutierte auch die breiteren Auswirkungen von AI auf die Beschäftigung und welche spezifischen Arbeitsaufgaben Benutzer sich wünschen, dass AI vollständig übernimmt. (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Bedenken hinsichtlich der LLM-Zuverlässigkeit: Schlechte Leistung bei der Verarbeitung spezifischer Datenquellen: Benutzer äußerten Enttäuschung darüber, dass LLMs bei der Verarbeitung spezifischer, fragmentierter Datenquellen (wie juristischen Dokumenten) Ergebnisse liefern, die zwar autoritär klingen, aber sachlich ungenau oder vage sind. Obwohl LLMs bei allgemeiner Zusammenfassung oder Codierung gut abschneiden, wird ihre Zuverlässigkeit für Aufgaben, die eine präzise Verarbeitung einmaliger Daten erfordern, in Frage gestellt. (Quelle: Reddit r/artificial)

AI-Hardware-Geopolitik: US-Senator schlägt vor, High-End-GPUs mit Geotracking auszustatten: Ein Vorschlag eines US-Senators fordert, High-End-GPUs (wie die RTX 4090) mit integriertem Geotracking auszustatten, um deren Nutzung durch ausländische Regierungen zu verhindern. Dies löste in der Community Bedenken hinsichtlich übermäßiger staatlicher Eingriffe, potenzieller Fernabschaltungsfunktionen und Hardware-DRM aus. (Quelle: Reddit r/LocalLLaMA)

Junge Menschen nutzen ChatGPT zur Unterstützung von Lebensentscheidungen: Sam Altman wies darauf hin, dass die jüngere Generation ChatGPT zunehmend zur Unterstützung bei Lebensentscheidungen nutzt. Einige sehen dies als positives Phänomen (Suche nach Rat, wenn menschliche Ressourcen unzureichend sind), während andere Bedenken hinsichtlich der Abhängigkeit von potenziell unzuverlässigen LLMs für wichtige Entscheidungen äußern. (Quelle: Reddit r/ChatGPT)

Diskussionen über AI-Industrie-Wahrnehmung und Strategie: Die Community-Diskussionen umfassten Ansichten darüber, warum Meta als hinter anderen großen AI-Labors zurückliegend angesehen wird, den Wertabgleich zwischen Fine-Tuning kleiner Modelle und Prompt Engineering, die Geheimhaltung von AI-Unternehmen sowie die Ansicht, dass “Suche” ein zentraler Burggraben für AI Agents ist. (Quelle: Reddit r/MachineLearning, cto_junior, madiator, Dorialexander)

💡 Sonstiges

China veröffentlicht Quantenkontrollsystem der vierten Generation: China hat ein Quantenkontrollsystem der vierten Generation veröffentlicht, das über 500 Qubits unterstützt und den neuesten Fortschritt in der Quantencomputertechnologie darstellt. (Quelle: Ronald_vanLoon)

Anwendung von AI im Verteidigungsbereich: China nutzt DeepSeek zur Entwicklung von Stealth-Kampfflugzeugen: Berichten zufolge nutzt China die DeepSeek AI-Technologie zur Unterstützung der Entwicklung seiner Stealth-Kampfflugzeuge der sechsten Generation (J-35, J-50). (Quelle: Ronald_vanLoon)

METACOG-25 Projektvorstellungsvideo veröffentlicht: Das METACOG-25 Projekt hat ein Vorstellungsvideo veröffentlicht, das auf neue Fortschritte im Bereich der AI-Forschung oder -Entwicklung hindeutet. (Quelle: Reddit r/deeplearning)

Hugging Face Plattform Updates: Collections in Collections und offizieller PyTorch Account: Der Hugging Face Hub hat die Funktion “Collections in Collections” eingeführt, die eine feinere Organisation von Ressourcen ermöglicht. Gleichzeitig hat PyTorch nun einen offiziellen Account auf der Plattform. (Quelle: ClementDelangue, Reddit r/LocalLLaMA)