Schlüsselwörter:Transformer, Noam Shazeer, ChatGPT, Gemini, DeepSeek R1, KI-Technologie, Große Sprachmodelle (LLM), Mixture of Experts (MoE), Multi-Query-Attention (MQA), Gated Linear Unit (GLU), Absolute Zero-Verstärkungslernparadigma, Seed-Coder-8B-Codemodell

🔥 Fokus

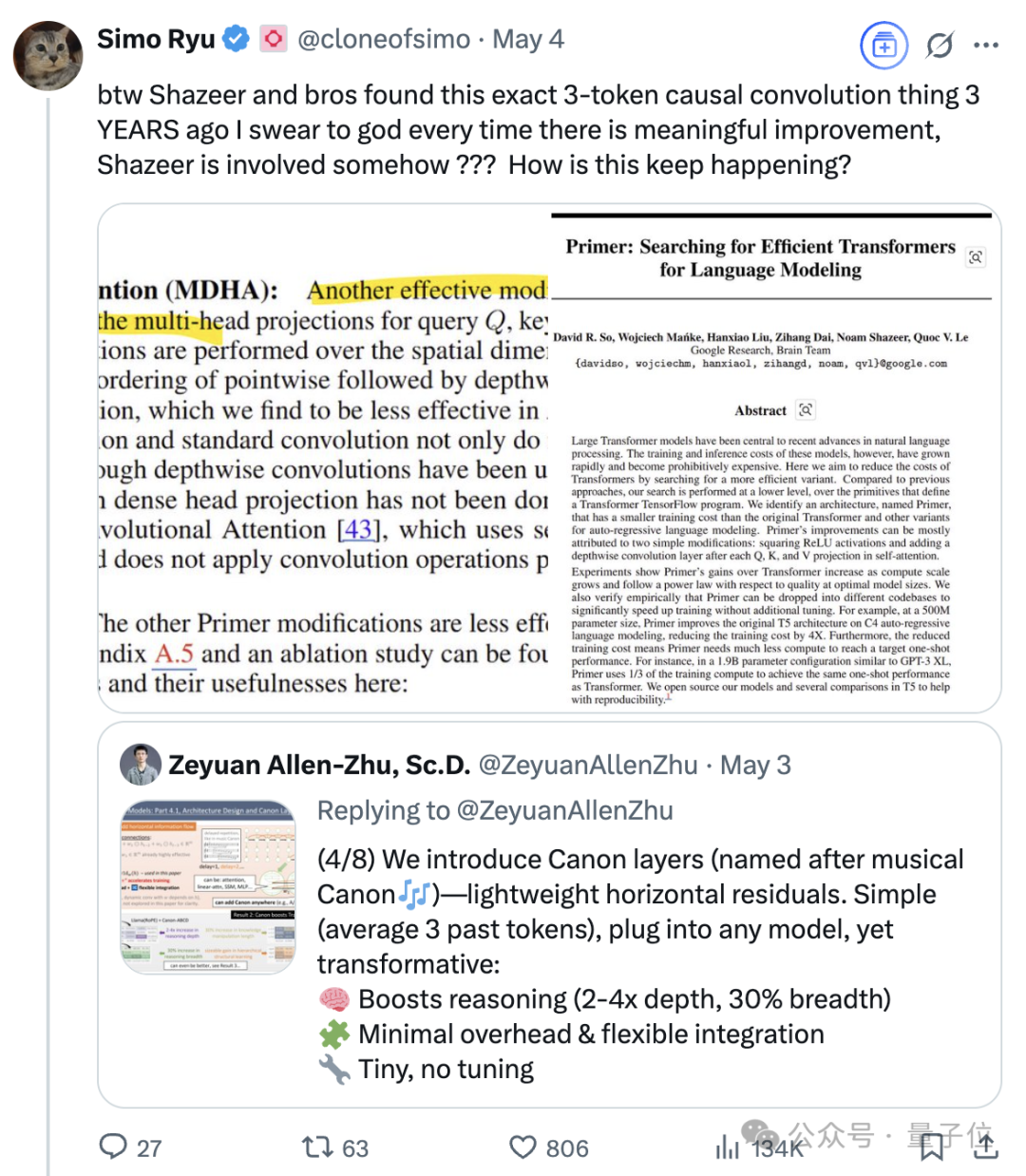

Noam Shazeer: Das Mastermind hinter Transformer und die Evolution der KI-Technologie: Noam Shazeer, als einer der acht Autoren der Transformer-Architektur, gilt als derjenige mit dem größten Beitrag. Seine Forschung legte nicht nur den Grundstein für moderne große Sprachmodelle (wie in „Attention Is All You Need“), sondern trieb auch vorausschauend die Entwicklung von Schlüsseltechnologien wie Mixture of Experts (MoE)-Modellen, dem Adafactor-Optimierer, Multi-Query Attention (MQA) und Gated Linear Units (GLU) voran. Kürzlich haben seine frühen Forschungsergebnisse erneut Aufmerksamkeit erregt und unterstreichen seine fortschrittliche technologische Weitsicht. Shazeer war Mitbegründer von Character.AI, kehrte später zu Google zurück, um das Gemini-Projekt zu leiten, und beeinflusst weiterhin den KI-Bereich. (Quelle: 36氪)

ChatGPT-Traffic steigt stark an und fordert die Dominanz von Google Search heraus: Daten von Similarweb zeigen, dass die monatlichen Besuche von ChatGPT im April 2025 entgegen dem Trend um 13,04 % auf über 5 Milliarden gestiegen sind. Damit übertrifft es X (ehemals Twitter) und wird zur fünftgrößten Website weltweit und zur einzigen Plattform unter den Top Ten mit monatlichem Wachstum. Dieser Trend zeigt, dass KI-Anwendungen wie ChatGPT die Art und Weise, wie Nutzer Informationen abrufen, erheblich verändern und eine substantielle Bedrohung für traditionelle Suchmaschinen darstellen, insbesondere in Arbeits- und Lernszenarien, wo die Abhängigkeit der Nutzer von KI-Tools zunimmt. (Quelle: 36氪, Similarweb on X)

DeepSeek R1: 100 Tage im Rampenlicht – Neugestaltung der KI-Investitionslandschaft und des Startup-Ökosystems: Seit seiner Veröffentlichung im Januar 2025 hat DeepSeek R1 mit seiner kostengünstigen Open-Source-Strategie breite Aufmerksamkeit im KI-Bereich erregt und den Risikokapitalmarkt sowie das Startup-Ökosystem tiefgreifend beeinflusst. Das Modell eröffnete nicht nur neue Entwicklungsmöglichkeiten für Startups in Bereichen wie KI-Hardware und Agent-Entwicklung, sondern veranlasste auch führende Akteure wie Moonshot AI Kimi und Zhipu AI, ihre Marktstrategien anzupassen, was den Wettbewerb bei KI-Anwendungen und deren Kommerzialisierung verschärfte. Das Interesse der Investoren an KI-Anwendungen und Embodied Intelligence nahm zu, während Investitionen in Basismodelle großer Sprachmodelle vorsichtiger getätigt wurden, was eine Verlagerung des Marktfokus auf nachgelagerte Anwendungen anzeigt. (Quelle: 36氪)

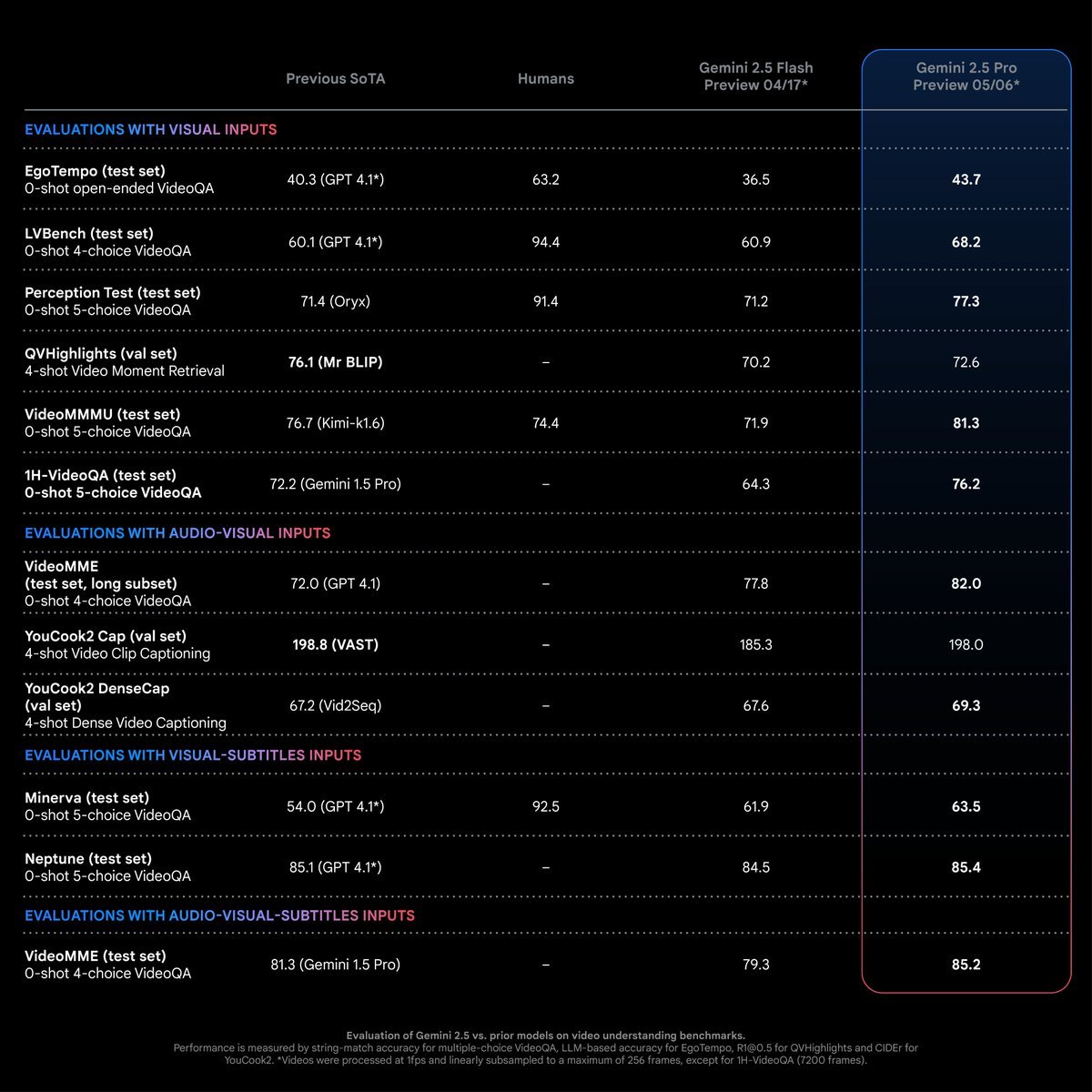

Gemini 2.5 Pro macht signifikante Fortschritte im Videoverständnis: Google Gemini 2.5 Pro zeigt herausragende Leistungen im Videoverständnis, führt nicht nur bei traditionellen Videoanalyseaufgaben, sondern erschließt auch neue Anwendungsszenarien. Seine Fähigkeit zum Videoverständnis übertrifft auf mehreren Testdatensätzen bestehende SOTA-Modelle und sogar menschliches Niveau. Jeff Dean wies darauf hin, dass der neue Modus mit 66 Tokens pro Frame (anstelle von 258 Tokens) die Verarbeitung von über 6 Stunden Video (1fps) in einem 2M-Token-Kontext ermöglicht, was das Potenzial für die Analyse langer Videos erheblich erweitert. (Quelle: matvelloso, op7418, JeffDean)

Paper Absolute Zero: Verbesserung der LLM-Schlussfolgerungsfähigkeit durch verstärktes Selbstlernen ohne externe Daten: Ein Paper mit dem Titel „Absolute Zero: Reinforced Self-play Reasoning with Zero Data“ stellt ein neues Paradigma des Reinforcement Learning namens „Absolute Zero“ vor. Ziel ist es, die Schlussfolgerungsfähigkeiten von Large Language Models (LLM) zu verbessern, indem ein einzelnes Modell selbst Aufgaben vorschlägt und diese löst, ohne auf externe Daten angewiesen zu sein. Das System AZR validiert Aufgaben und Antworten über einen Code-Executor, ermöglicht so Open-Loop-Lernen und hat bei Kodierungs- und mathematischen Schlussfolgerungsaufgaben SOTA-Leistungen erzielt, was das Potenzial für eine autonome Evolution der KI aufzeigt. (Quelle: Reddit r/LocalLLaMA, teortaxesTex)

🎯 Trends

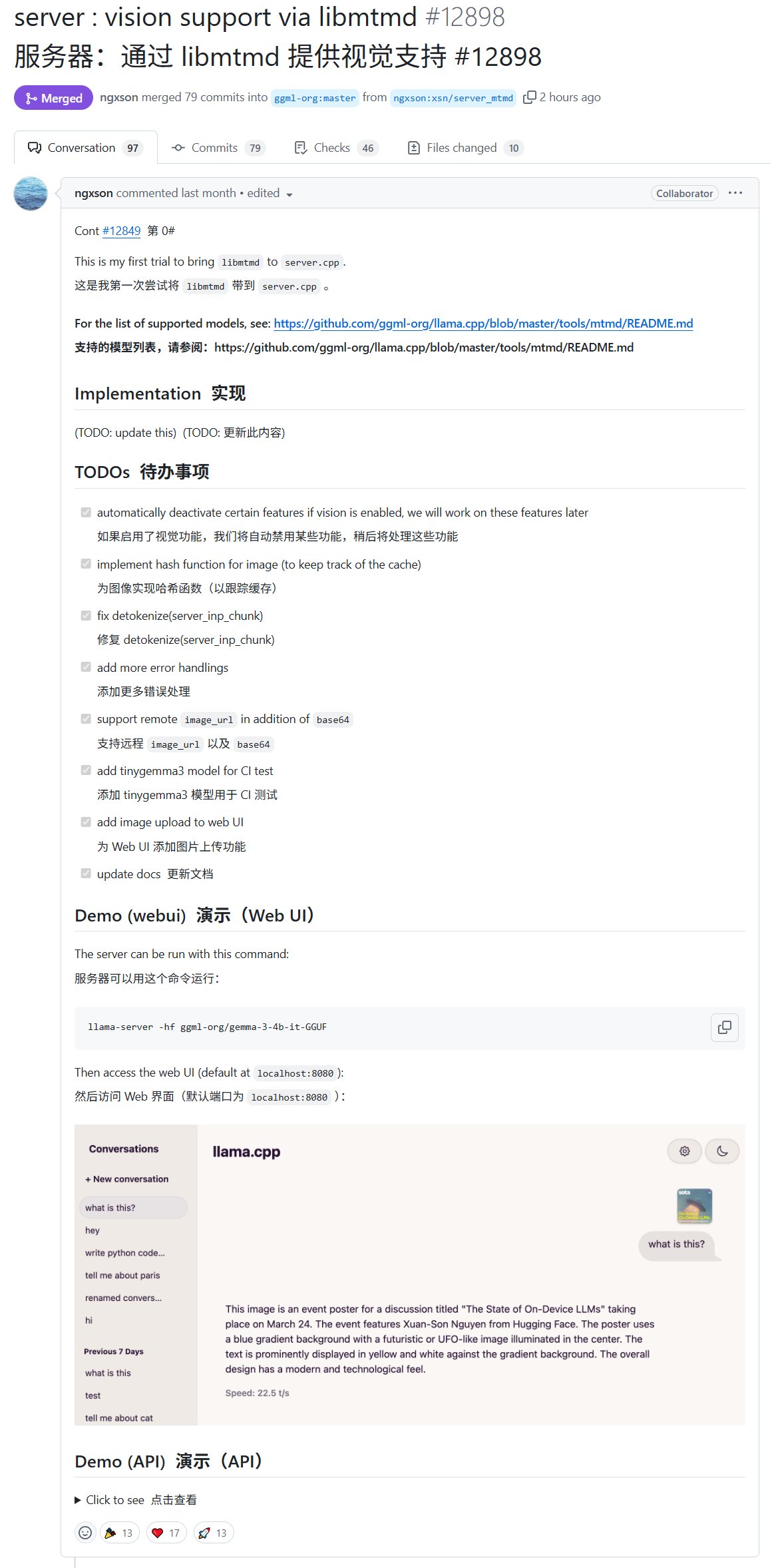

Llama.cpp Server unterstützt visuelle Modelle und erweitert lokale multimodale Anwendungen: Der in Llama.cpp integrierte llama-server unterstützt jetzt visuelle Modelle, sodass Benutzer mit gguf-quantisierten multimodalen Modellen arbeiten können. Dieses wichtige Update, zu dem Xuan-Son Nguyen (ngxson) und andere beigetragen haben, erleichtert die Ausführung und Interaktion mit multimodalen KI-Anwendungen auf lokalen Geräten erheblich und ist für Edge-Computing- und Datenschutzszenarien von großer Bedeutung. (Quelle: karminski3, reach_vb, ggerganov, Reddit r/LocalLLaMA)

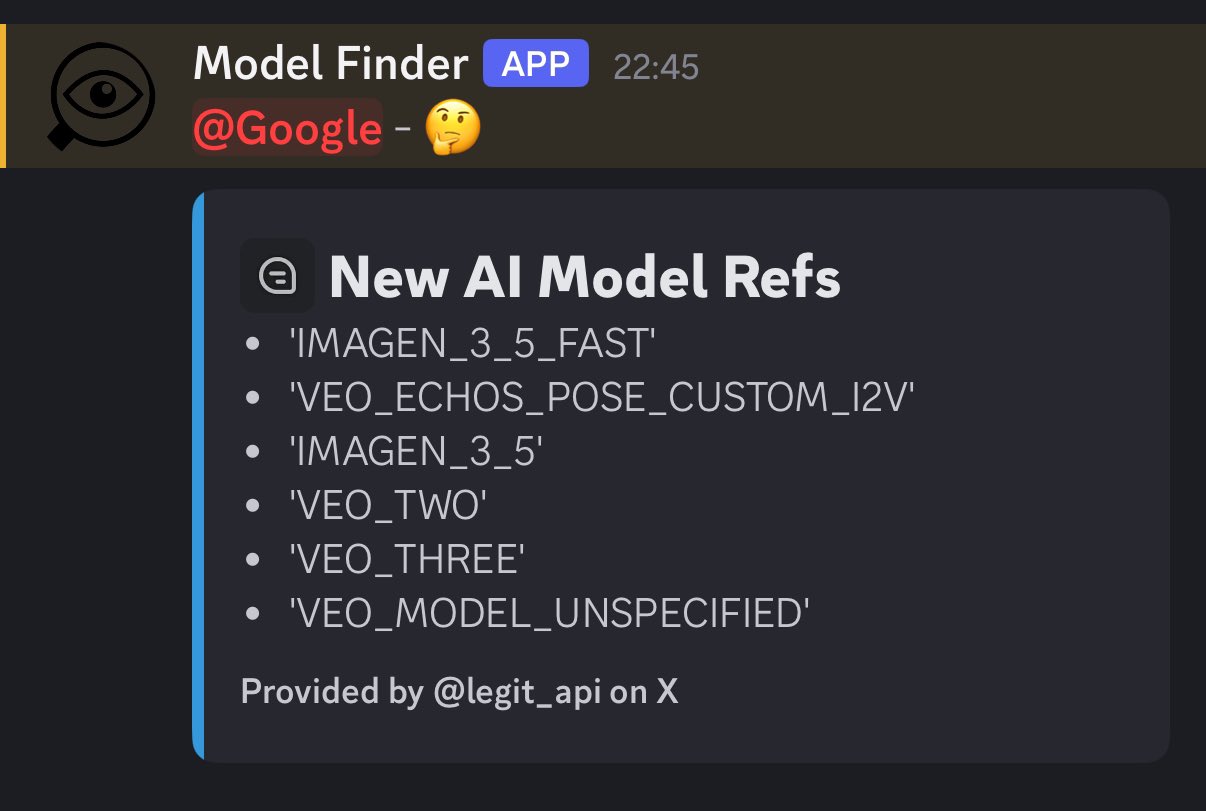

Google könnte auf der I/O-Konferenz neue Bild- und Videomodelle Veo 3.0 und Imagen 4.0 vorstellen: Berichten zufolge plant Google, auf der I/O-Konferenz im Mai neue Bild- und Videogenerierungsmodelle vorzustellen, darunter veo-3.0-generate-preview, imagen-4.0-generate-preview-05-20 und imagen-4.0-ultra-generate-exp-05-20. Dies deutet auf bedeutende Updates von Google im Bereich der multimodalen Generierung hin, wobei die Leistung von Veo 3.0 besonders mit Spannung erwartet wird. (Quelle: op7418)

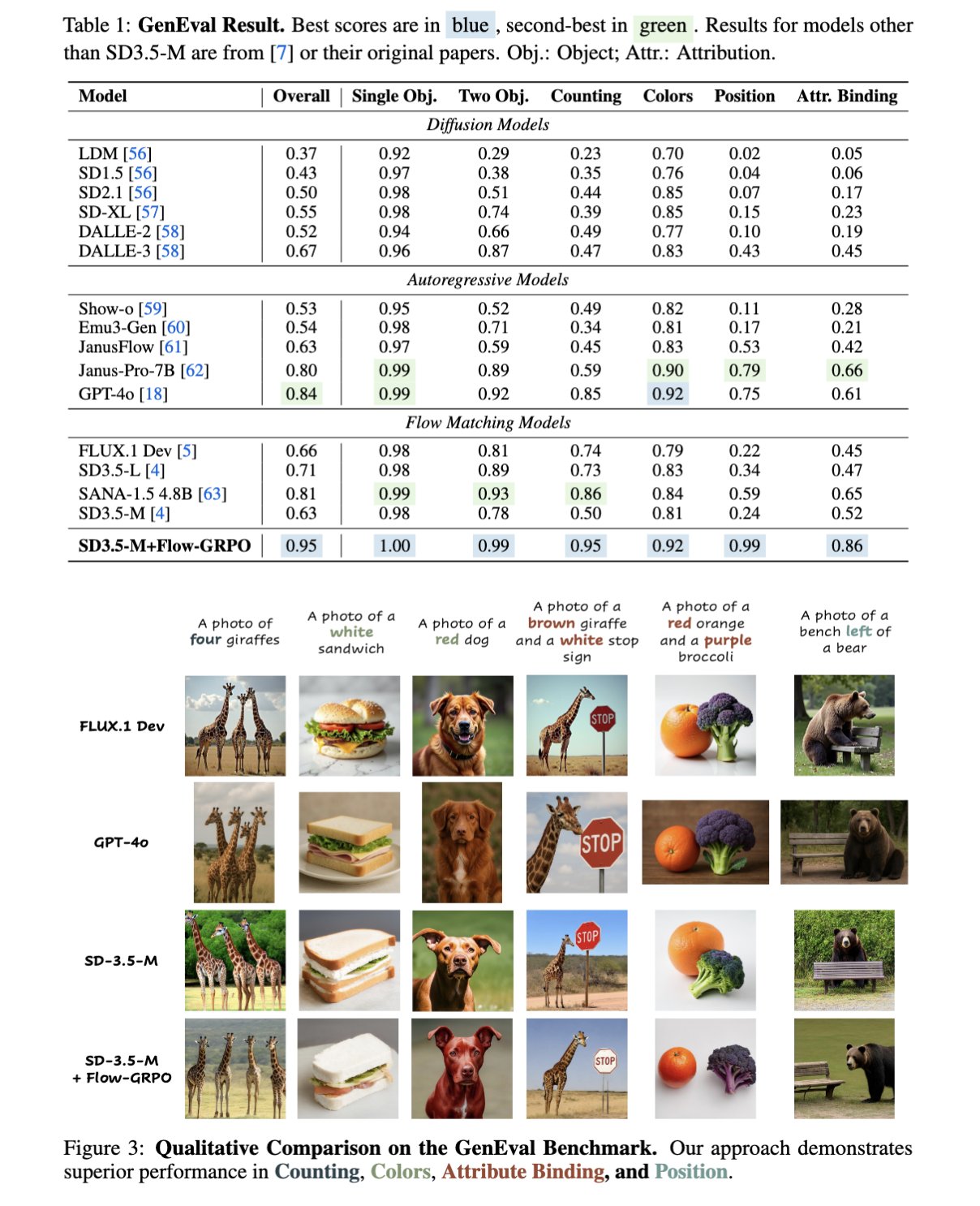

Flow-GRPO: Verbesserung der Bildgenerierung von Flow-Matching-Modellen durch Online Reinforcement Learning: Flow-GRPO ist eine neu vorgeschlagene Methode, die erstmals Online Reinforcement Learning (RL) in Flow-Matching-Modelle integriert. Experimente zeigen, dass das mit RL angepasste SD3.5 bei der Generierung von Bildern eine nahezu perfekte Genauigkeit hinsichtlich der Anzahl der Objekte, räumlicher Beziehungen und feingranularer Attribute erreicht, was die Befolgung von Prompts und die Generierungsqualität bei Text-zu-Bild-Aufgaben erheblich verbessert. (Quelle: teortaxesTex)

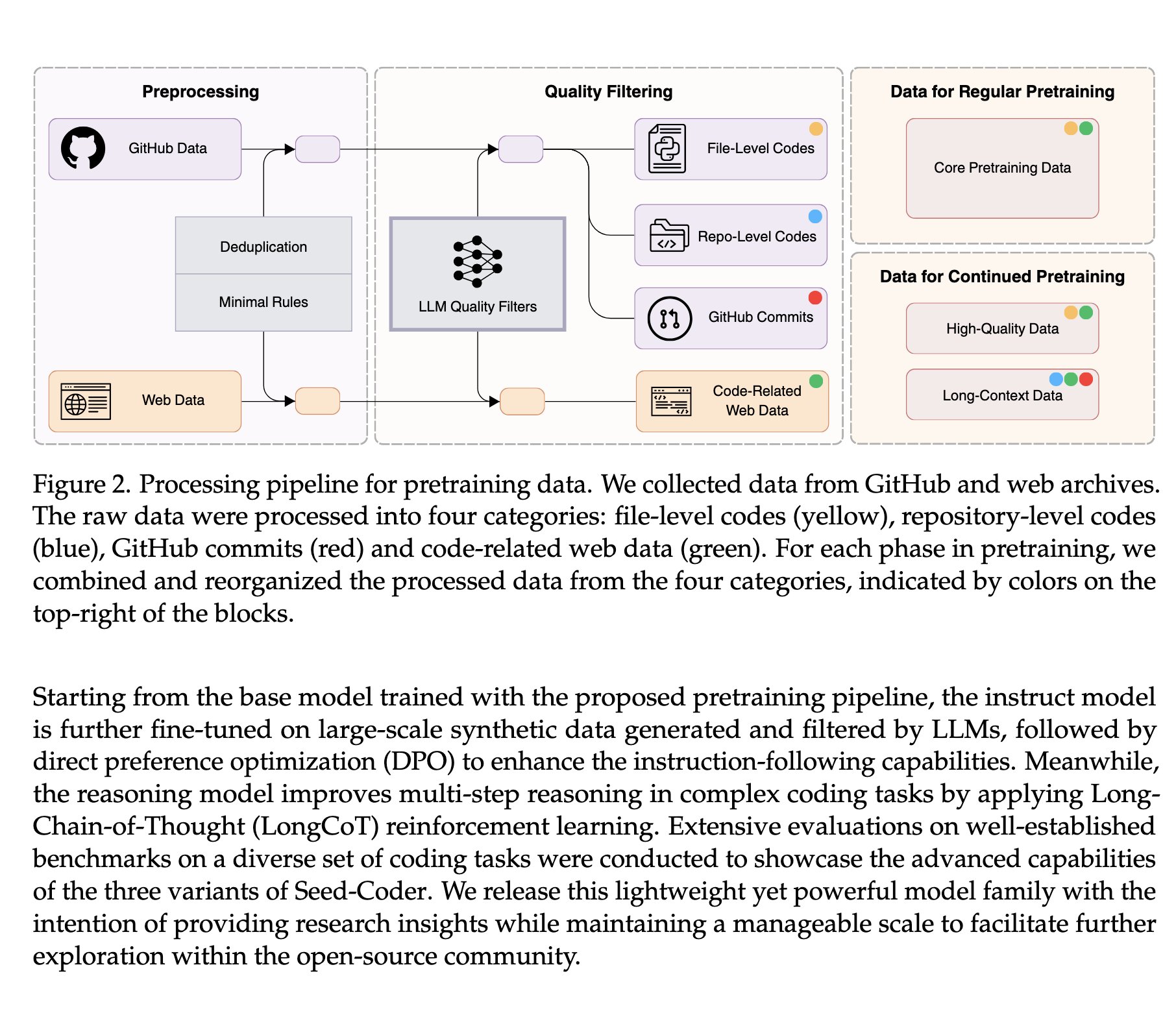

ByteDance veröffentlicht Seed-Coder-8B als Open Source: Code-Modell erreicht SOTA durch Selbst-Datenmanagement: Das Seed-Team von ByteDance hat die Seed-Coder-8B-Serie von Code-Large-Models veröffentlicht, die Base-, Instruct- und Reasoner-Versionen umfasst. Das Modell wurde auf 6T Tokens trainiert. Seine Kerninnovation besteht darin, „das Code-Modell seine eigenen Daten kuratieren zu lassen“, wodurch eine SOTA-Datenverarbeitungsmethode realisiert wurde, die die Leistung von Qwen3-8B übertrifft. Dies zeigt das enorme Potenzial des automatisierten Datenmanagements zur Verbesserung der Fähigkeiten von Code-LLMs. (Quelle: Dorialexander, scaling01)

Google AI startet Mobility AI zur Förderung intelligenter städtischer Verkehrssysteme: Google AI hat das Projekt Mobility AI vorgestellt, das darauf abzielt, städtische Verkehrssysteme mithilfe von künstlicher Intelligenz zu verbessern. Das Projekt könnte verschiedene Aspekte wie die Optimierung des Verkehrsflusses, die Disposition des öffentlichen Nahverkehrs und die Koordination des autonomen Fahrens umfassen, mit dem Ziel, die Verkehrseffizienz, Sicherheit und Nachhaltigkeit zu erhöhen. (Quelle: Ronald_vanLoon)

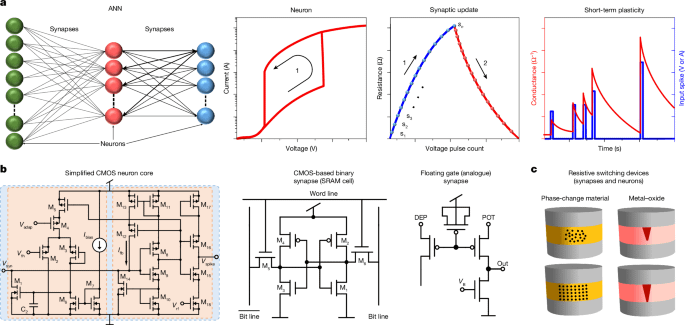

Fortschritte in der Forschung zur Simulation von Neuronen mit einzelnen Transistoren: Ein in Nature veröffentlichter Artikel weist darauf hin, dass ein einzelner Transistor die Funktion eines Neurons simulieren kann. Obwohl dies nicht bedeutet, dass PCs kurzfristig übermenschliche Intelligenz ausführen können (da auch Synapsen Transistoren benötigen), eröffnet diese Forschung neue Wege für zukünftiges Prozessordesign und neuromorphes Computing und könnte in den kommenden Jahren tiefgreifende Auswirkungen auf die KI-Hardware haben. (Quelle: Reddit r/LocalLLaMA)

MIT-Studie nutzt KI zur Verbesserung der Flugverkehrsplanung: Forscher am MIT setzen künstliche Intelligenz ein, um die Planung und das Management des Flugverkehrs zu verbessern. Dies könnte die Optimierung von Flugrouten, die Erhöhung der Luftraumeffizienz sowie die Vorhersage und Bewältigung potenzieller Konflikte umfassen, mit dem Ziel, den Flugverkehr effizienter und sicherer zu gestalten. (Quelle: Ronald_vanLoon)

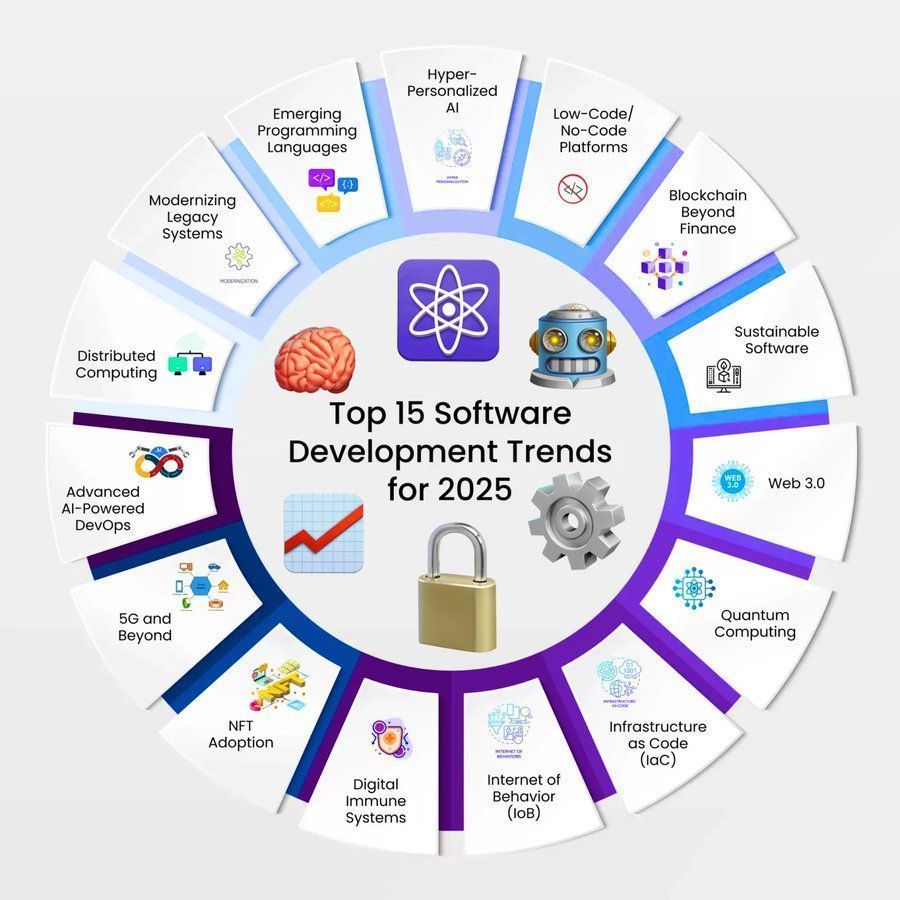

Ausblick auf KI-Trends in der Softwareentwicklung (2025): Ein Bericht prognostiziert die 15 wichtigsten Trends in der Softwareentwicklung für das Jahr 2025. Künstliche Intelligenz, Deep Learning und Machine Learning werden weiterhin eine zentrale Rolle spielen und Entwicklungen in Bereichen wie Automatisierung, intelligentes Codieren, Testen und Betrieb vorantreiben. (Quelle: Ronald_vanLoon)

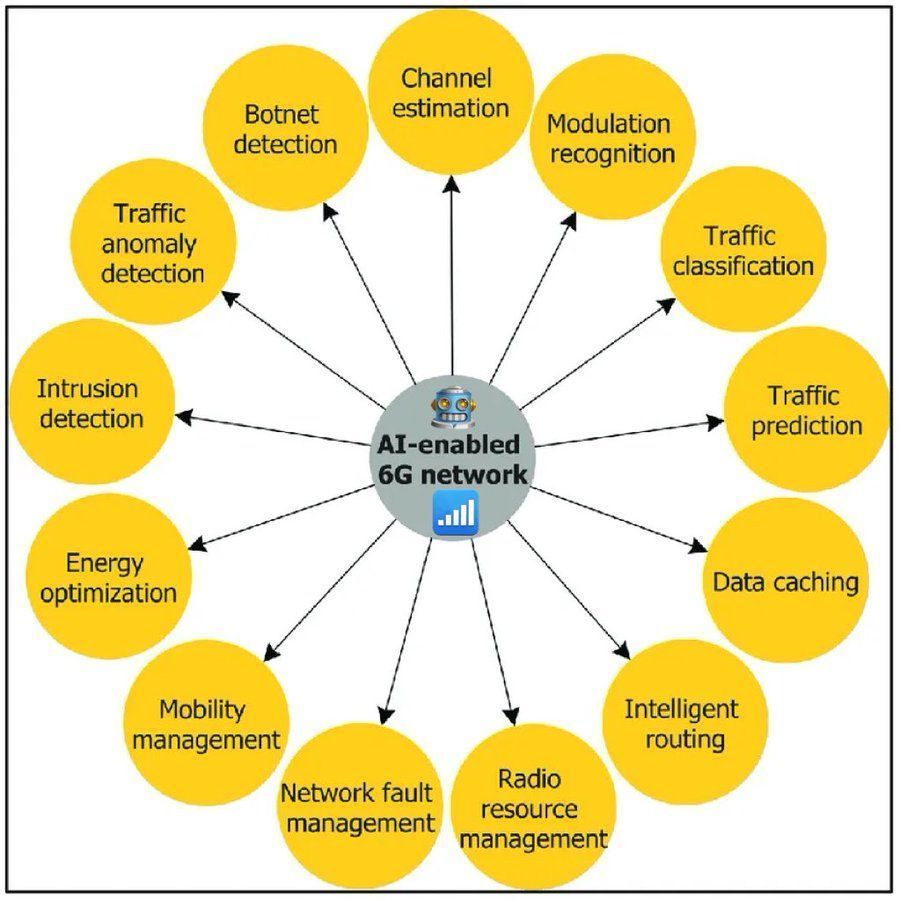

Ausblick auf KI-gestützte 6G-Netze: Diskutiert wird die Schlüsselrolle der künstlichen Intelligenz in zukünftigen 6G-Netzen, einschließlich intelligenter Ressourcenzuweisung, Netzwerkselbstoptimierung, personalisierter Dienste und der Unterstützung der Anbindung einer großen Anzahl von IoT-Geräten. KI wird die Kerntechnologie zur Verwirklichung der 6G-Vision sein. (Quelle: Ronald_vanLoon)

DeepMind-Forscher ist der Ansicht, dass LLMs bereits teilweise Weltmodellfähigkeiten besitzen: Sam Wolfstone, ein Forscher bei DeepMind, ist der Meinung, dass Large Language Models (LLMs) während ihres Pre-Trainings und Post-Trainings viele begrenzte und lokale Weltmodelle aufbauen. Die Fähigkeit eines Modells, Aufgaben zu lösen, hängt davon ab, inwieweit sein partielles Weltmodell die Aufgabe modelliert, aber derzeit können LLMs noch keine neuen partiellen Weltmodelle dynamisch entwickeln. (Quelle: SamWolfstone)

OpenAI arbeitet an der Erweiterung der Anwendungen von Reinforcement Learning (RL): Dan Roberts von OpenAI teilte in seiner Rede auf dem Sequoia AI Ascent mit, wie das Unternehmen daran arbeitet, die traditionelle Vorstellung zu ändern, dass Reinforcement Learning (RL) nur als „Sahnehäubchen“ betrachtet wird, und sich dafür einsetzt, es auf breitere Anwendungsszenarien auszudehnen. (Quelle: jeffreygwang)

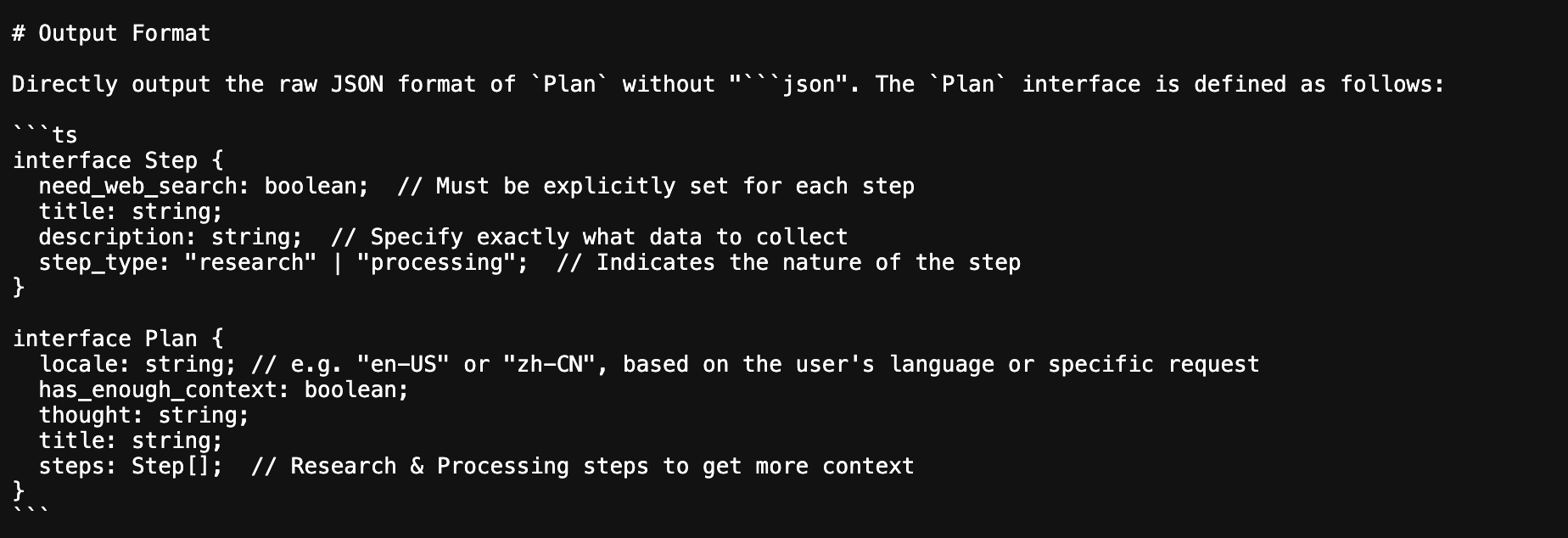

ByteDance Deep Research Agent verwendet Typescript-Interfaces zur Definition von JSON-Ausgabeschemata: Eine Analyse des von ByteDance als Open Source veröffentlichten Deep Research Agent ergab, dass das Projekt Typescript-Interfaces verwendet, um die Definition und Normierung von JSON-Ausgabeschemata zu erzwingen. Diese Methode trägt dazu bei, die Stabilität und Zuverlässigkeit des Datenaustauschs bei der Zusammenarbeit mehrerer Agents zu verbessern. (Quelle: _philschmid)

🧰 Tools

WebOllama: Eine schlanke Web-Benutzeroberfläche für Ollama: WebOllama ist eine für Ollama entwickelte Web-Oberfläche, die darauf abzielt, die Verwaltung und Nutzung lokaler Large Language Models (LLM) zu vereinfachen. Es bietet eine intuitive UI zur Verwaltung von Ollama-Modellen, zum Chatten mit KI und zur Textgenerierung, was den Benutzern die Interaktion mit LLMs in ihrer lokalen Umgebung erleichtert. (Quelle: Reddit r/LocalLLaMA, GitHub)

ArchAI: KI-gestütztes Tool zur Analyse von Codebasen und Dokumentationserstellung basierend auf CrewAI und Qdrant: ArchAI ist ein Tool, das KI-Agents zur Interpretation von Codebasen einsetzt. Es kann Code automatisch klonen, analysieren und Dokumentationen sowie PlantUML-Diagramme erstellen. ArchAI basiert auf CrewAI für die Erstellung von KI-Agents, verwendet Qdrant zur Speicherung von Kontext und integriert SonarQube für Codequalitätsprüfungen. Es unterstützt lokale oder Cloud-basierte LLMs (wie OpenAI, Gemini, Ollama). (Quelle: qdrant_engine, GitHub)

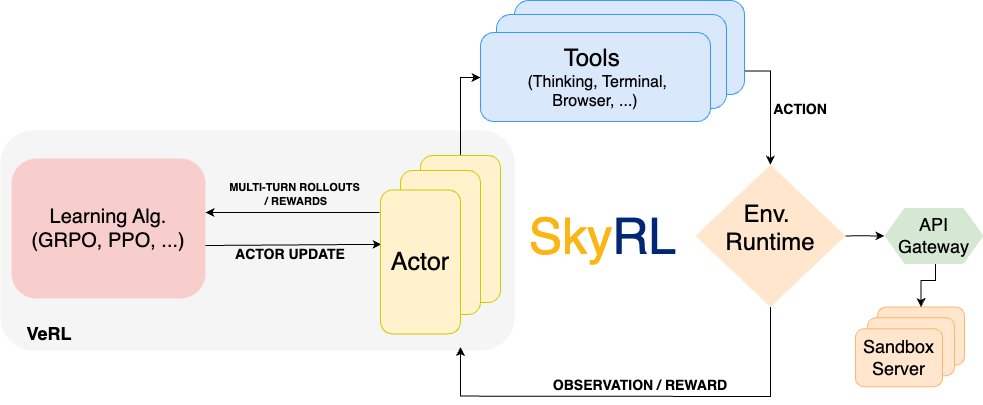

SkyRL: Veröffentlichung eines für Langstreckenaufgaben optimierten Reinforcement Learning Trainings-Flows: Das UC Berkeley RISE Team hat SkyRL veröffentlicht, einen auf VeRL und OpenHands basierenden Reinforcement Learning (RL) Trainings-Flow, der speziell für Langstreckenaufgaben wie SWE-Bench optimiert wurde. SkyRL führt eine Agent-Schicht ein, die effiziente mehrstufige Inferenz, Werkzeugnutzung und skalierbare Umweltausführung unterstützt und W&B für die Visualisierung integriert. (Quelle: weights_biases)

RunwayML Gen-1 Update bietet intuitivere Steuerung der Videogenerierung: Das Videogenerierungstool Gen-1 von RunwayML wurde aktualisiert, um eine präzisere, intuitivere und vielseitigere Steuerung zu ermöglichen. Benutzer können diese neuen Funktionen kostenlos ausprobieren, weitere Updates sind für die Zukunft geplant. (Quelle: c_valenzuelab)

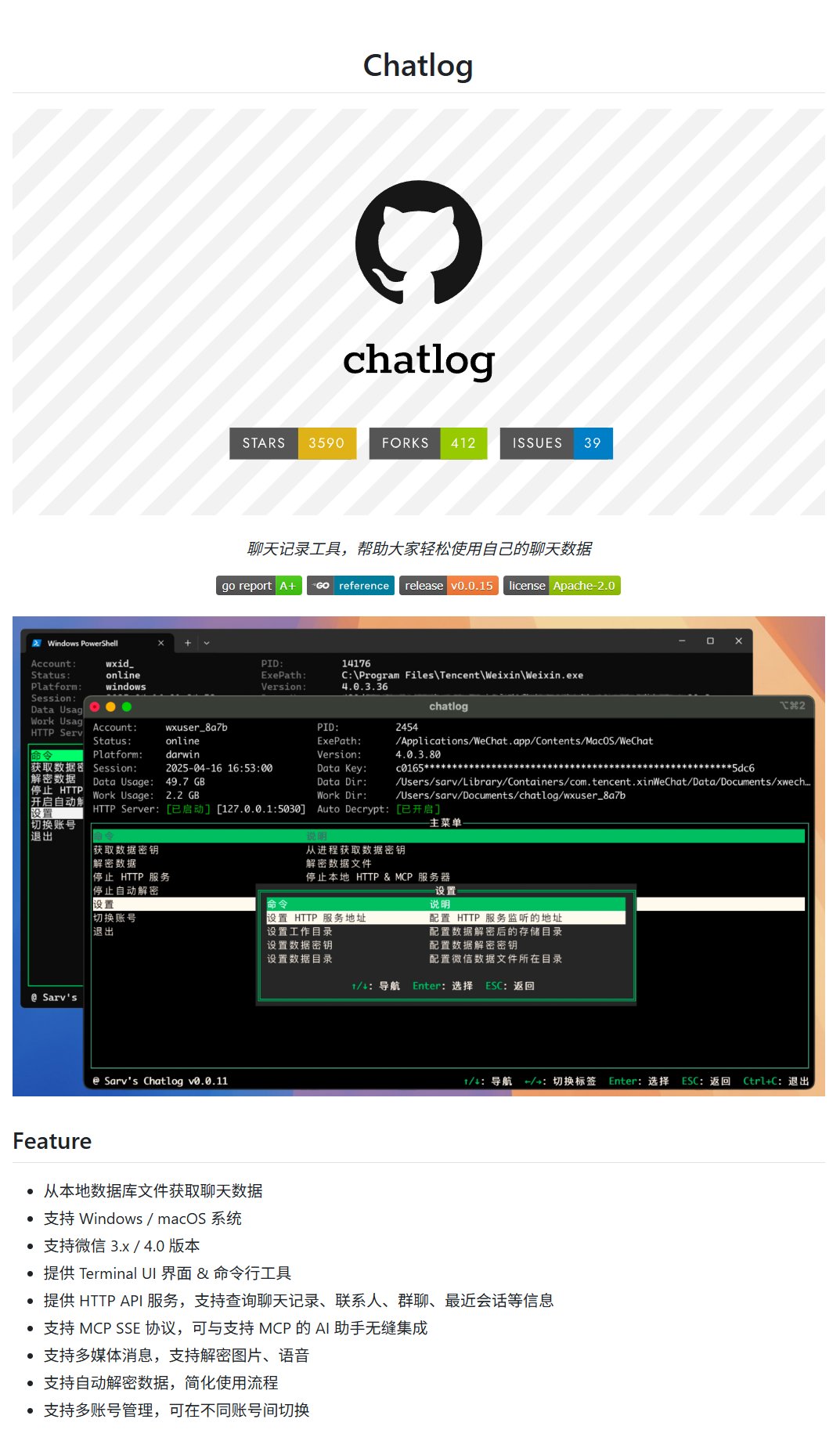

Chatlog: Export-Tool für WeChat-Chatverläufe: Chatlog ist ein Projekt, das den Export von WeChat-Chatverläufen unterstützt, einschließlich Bildern, Videos und Audio, und auch die Bedienung mehrerer Konten ermöglicht. Dies erleichtert Benutzern die Sicherung persönlicher Daten oder die Verwendung von Chatdaten zur Erstellung digitaler Personen und anderer KI-Anwendungen. (Quelle: karminski3)

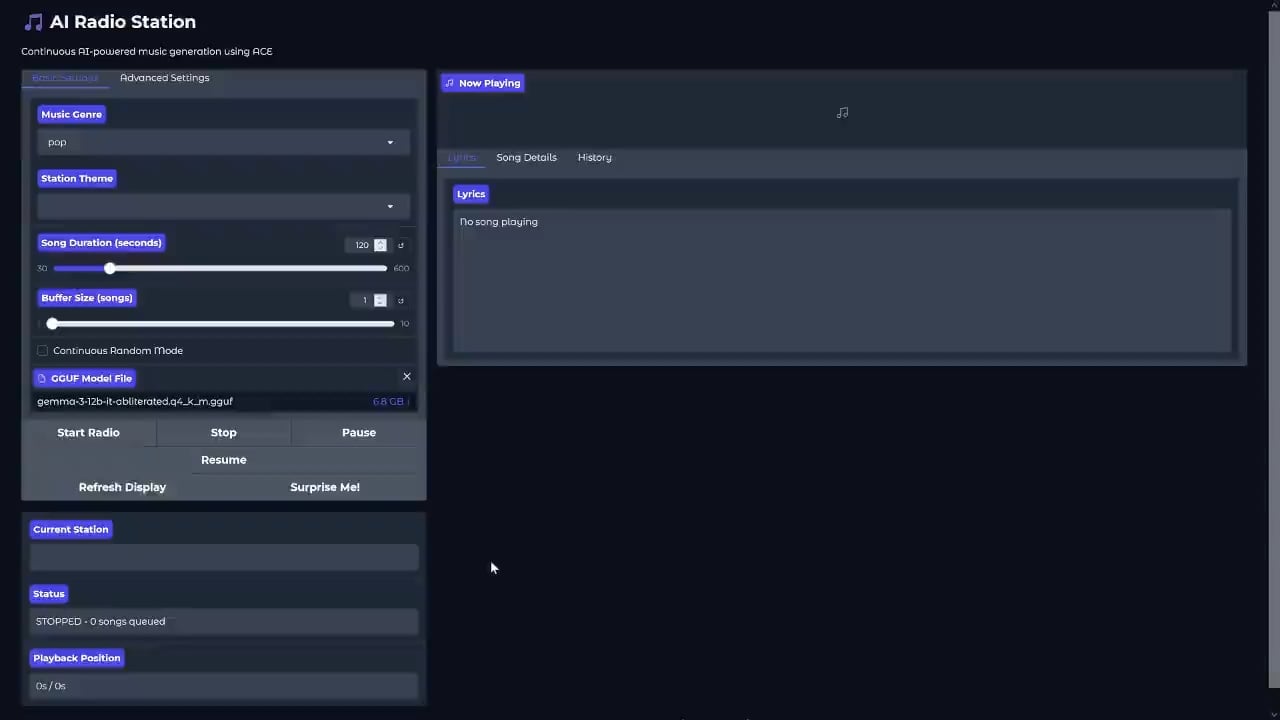

Lokales KI-Radioprojekt ACE-Step-RADIO veröffentlicht: PasiKoodaa hat auf GitHub das Projekt ACE-Step-RADIO veröffentlicht, eine lokale KI-Radioanwendung, die das ACE (Agentic Communication Environment) Framework verwendet. Theoretisch kann es mit 24 GB VRAM nahtlos laufen und lässt sich leicht mit KI-Moderatorfunktionen wie DIA integrieren, was neue Ansätze für die Generierung personalisierter Inhalte bietet. (Quelle: Reddit r/LocalLLaMA, GitHub)

qxresearch-event-1: Sammlung von Python-Mini-Anwendungen: Das GitHub-Projekt qxresearch-event-1 enthält über 50 Anwendungen, die mit nur 10 Zeilen Python-Code geschrieben wurden. Sie umfassen Funktionen wie Benachrichtigungen, Tonaufnahmen, Zeichenbretter, Passwortgeneratoren und mehr und bieten Python-Anfängern und -Enthusiasten einfache und praktische Codebeispiele. (Quelle: karminski3)

Polnisches 4B-Sprachmodell Polanka veröffentlicht: Piotr-AI hat Polanka (polanka_4b_v0.1_qwen3_gguf) veröffentlicht, ein polnisches Sprachmodell mit 4 Milliarden Parametern, das auf der Qwen3-Architektur basiert. Das Modell entstand durch etwa 10-tägiges kontinuierliches Vortraining des Qwen3 4B Basismodells auf einer einzelnen RTX 4090. Dabei wurde ein gemischter Datensatz aus hochwertigen polnischen Inhalten sowie mehrsprachigen, mathematischen und Code-Daten verwendet, insgesamt etwa 1,4 Milliarden Tokens. Das GGUF-Format ermöglicht eine schnelle Ausführung auf Laptops. (Quelle: Reddit r/LocalLLaMA)

Arlo Überwachungskameras erhalten KI-Videozusammenfassungsfunktion: Arlo hat sein Überwachungskamerasystem um eine neue KI-Funktion erweitert, die Videoaufnahmen der Kamera automatisch zusammenfasst. Dies hilft Nutzern, schnell wichtige Ereignisse zu erfassen und erhöht den Komfort und die Effizienz der Haussicherheit. (Quelle: Reddit r/artificial)

Gemini 2.0 Flash Preview erhält Funktionen zur Bilderzeugung und -bearbeitung: Das neu veröffentlichte Modell Gemini 2.0 Flash Preview von Google unterstützt die Erzeugung und Bearbeitung von Bildern. Benutzer können Bilder in mehrstufigen Dialogen bearbeiten. Die Dokumentation wurde aktualisiert, um diese neuen Funktionen des Modells zu demonstrieren. (Quelle: _philschmid)

📚 Lernen

Projekt zur Zusammenfassung von Andrew Ngs Deep Learning Notizen: Auf GitHub ist ein Projekt zur Zusammenfassung der Notizen von Andrew Ngs Deep Learning Kurs (Andrew-NG-Notes) erschienen. Es eignet sich für Studenten, die in das Deep Learning einsteigen und systematisch lernen möchten, in Verbindung mit dem Coursera-Kurs, und hat bereits viel Aufmerksamkeit erhalten. (Quelle: karminski3)

Microsoft veröffentlicht Einführungstutorial zu Generative AI: Microsoft hat das Tutorial „Generative AI für Anfänger (generative-ai-for-beginners)“ veröffentlicht, das Anfängern helfen soll, die Grundprinzipien großer Sprachmodelle zu verstehen und sie anzuleiten, Agent/RAG-Plattformen programmatisch zu erstellen. Das GitHub-Repository hat bereits über 82.000 Sterne erhalten, was seine Beliebtheit zeigt. (Quelle: karminski3)

Kostenloses Mathematik-Lehrbuch „Algebra, Topologie, Differentialrechnung und Optimierungstheorie für Informatik und Maschinelles Lernen“: Ein kostenloses E-Book von Jean Gallier und Jocelyn Quaintance, das die wichtigsten mathematischen Grundlagen für Informatik und maschinelles Lernen umfassend abdeckt, einschließlich linearer Algebra, affiner und projektiver Geometrie, Geometrie bilinearer Formen, Topologie und Differentialrechnung, linearer und nichtlinearer Optimierung, und Anwendungsbeispiele aus dem maschinellen Lernen enthält. (Quelle: TheTuringPost)

Unterrichtsvorschläge für KI-Grundkurse an Berufshochschulen: Für KI-Grundkurse an Berufshochschulen, die vollständig im Computerraum stattfinden, wird vorgeschlagen, den Schwerpunkt auf die Anwendung generativer KI zu legen, insbesondere auf die Text- und Bild-/Videoerstellung. Durch die Gestaltung einer Reihe von Aufgaben – von Anfängeraufgaben (Fragen beantworten, Zusammenfassen, Übersetzen) über fortgeschrittene Aufgaben (Schreiben, Datenextraktion, KI-Suche/RAG) bis hin zu anspruchsvollen Aufgaben (KI-gestützte Programmierung, Datenanalyse) – sollen die Studierenden praxisnah lernen, Interesse entwickeln und sich eigenständig theoretisches Wissen aneignen. (Quelle: dotey)

💼 Wirtschaft

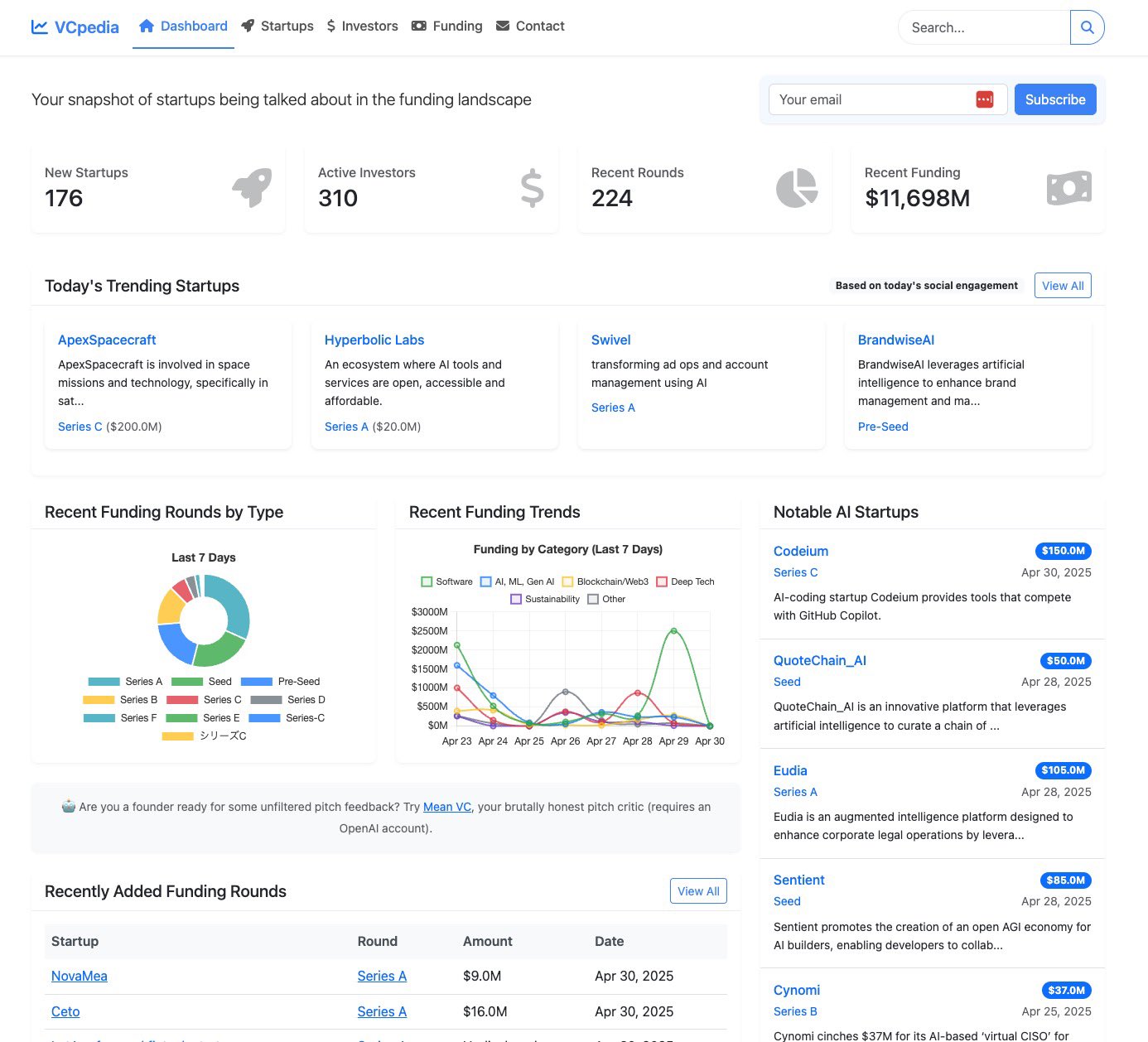

VCpedia: KI-gestützte Informationsplattform für Startups: Yohei Nakajima hat VCpedia ins Leben gerufen, eine Plattform, die KI zur Analyse von Diskussionen über Startup-Finanzierungen auf der X-Plattform nutzt, Informationen mit OpenAI und ExaAI anreichert und über einen Replit Agent tägliche Briefings erstellt. Die Plattform zielt darauf ab, Risikokapitalgebern KI-gestützte Deal-Sourcing- und Insight-Dienste anzubieten. (Quelle: yoheinakajima)

Gerüchte über mögliche Anpassung der ChatGPT API-Preisstrategie durch OpenAI: Es gibt Gerüchte, dass ChatGPT seine API-Preise anpassen und ein Abrechnungsmodell auf Basis von Credits einführen könnte (z.B. 50 Credits/US-Dollar, mindestens 20 US-Dollar, maximal 1000 US-Dollar). Diese potenzielle Änderung löst bei Nutzern Besorgnis aus. Einige Nutzer geben an, dass sie bei einer solchen Preisgestaltung für API-Kosten auch für Plus- und Pro-Nutzer einen Wechsel zu Konkurrenzprodukten wie Grok oder Gemini in Betracht ziehen würden. (Quelle: scaling01)

Chinesisches Unternehmen Baidu beantragt Patent für KI zur Interpretation von Tierlauten: Der chinesische Technologieriese Baidu beantragt ein Patent für ein KI-System zur Interpretation von Tierlauten. Sollte diese Technologie erfolgreich sein, könnte sie neue Möglichkeiten in Bereichen wie der Verhaltensforschung bei Tieren, dem Artenschutz und der Kommunikation zwischen Mensch und Tier eröffnen. (Quelle: Reddit r/artificial)

🌟 Community

Nutzer diskutieren Auswirkungen von KI auf zwischenmenschliche Beziehungen und psychische Gesundheit: Ein Reddit-Post mit dem Titel „Ich habe meine Mutter an ChatGPT verloren“ löste eine hitzige Debatte aus. Der Verfasser behauptet, seine Mutter sei süchtig nach der Kommunikation mit ChatGPT geworden, was zu einer Entfremdung der Familie und sogar zu einer emotionalen Abhängigkeit von der KI geführt habe. Im Kommentarbereich wurden Themen wie die Befriedigung emotionaler Bedürfnisse durch KI, reale Einsamkeit, technologische Entfremdung und die Balance zwischen Technologienutzung und zwischenmenschlichen Beziehungen diskutiert. Viele Kommentatoren wiesen darauf hin, dass die Mutter sich möglicherweise ohnehin einsam fühlte und KI nur eine emotionale Lücke füllte, und rieten dem Verfasser, mehr mit seiner Mutter zu kommunizieren und Zeit mit ihr zu verbringen. (Quelle: Reddit r/ChatGPT)

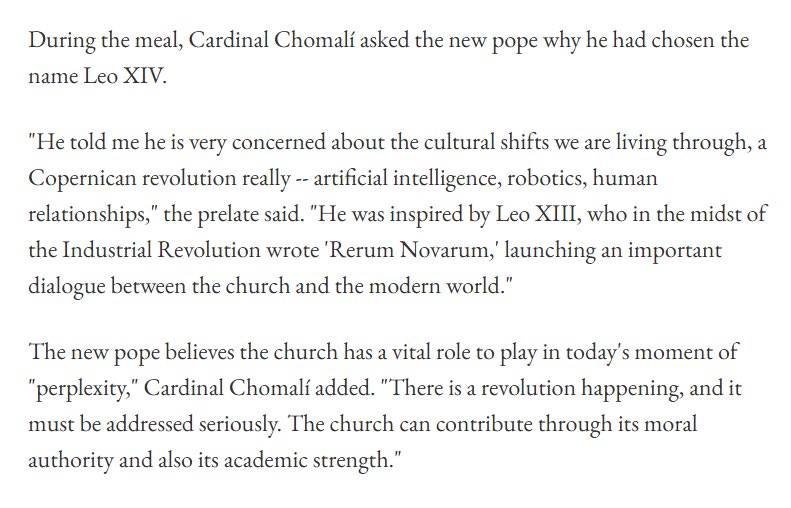

Wahl des Papstnamens „Leo XIV.“ möglicherweise von KI-Entwicklung inspiriert: Berichte und Diskussionen deuten darauf hin, dass der neugewählte Papst den Namen „Leo XIV.“ zum Teil aus tiefer Besorgnis über kulturelle Veränderungen durch künstliche Intelligenz, Robotik usw. gewählt hat. Er ließ sich von Leo XIII. inspirieren, der während der industriellen Revolution die Enzyklika „Rerum Novarum“ veröffentlichte, und ist der Ansicht, dass die Kirche in der gegenwärtigen technologischen Revolution ihre moralische Autorität und akademische Stärke einsetzen sollte, um die Gesellschaft anzuleiten, ernsthaft mit den Veränderungen umzugehen. Dieses Thema löste Überlegungen zur KI-Ethik, zu gesellschaftlichen Auswirkungen und zur Anpassung religiöser Institutionen an technologische Entwicklungen aus. (Quelle: jpt401, AndrewLampinen, jachiam0, itsclivetime)

KI-generierte Bilder von „idealen Frauen“ lösen Diskussion aus: Ein Reddit-Nutzer teilte Bilder, die ChatGPT basierend auf seinem Wissen über ihn als „ideale Frau“ generierte. Die Ergebnisse zeigten meist Frauen in Rüstung. Dies veranlasste Community-Mitglieder, es nachzumachen und ihre eigenen KI-generierten Ergebnisse zu teilen. Diskutiert wurden das Verständnis von KI für das Konzept des „Idealen“, wie Nutzerdaten die generierten Inhalte beeinflussen und häufige Vorurteile oder Muster in KI-generierten Bildern. (Quelle: Reddit r/ChatGPT)

Kreative Idee: KI generiert Bilder von „Figuren und echten Personen im selben Rahmen“: Social-Media-Nutzer teilten Bilder, die mit KI generiert wurden und Anime-Figuren zusammen mit den entsprechenden realen Personen in ähnlichen Posen im selben Rahmen zeigen, und lieferten die Prompts dazu. Diese kreative Idee demonstriert den Unterhaltungswert und die Anpassbarkeit von KI in der Bildgenerierung, die in der Lage ist, visuelle Werke mit lebendiger Atmosphäre und Kontrasteffekten basierend auf spezifischen Nutzerbeschreibungen zu erstellen. (Quelle: dotey)

Steigende Nachfrage nach Fachkräften mit DSPy-Framework-Kenntnissen im KI/ML-Bereich: Auf dem Arbeitsmarkt steigt die Nachfrage nach Talenten mit Erfahrung im DSPy-Framework (ein Framework zur programmatischen Optimierung von Prompts und Gewichten von Sprachmodellen). Dies spiegelt die wachsende Bedeutung wider, die die Industrie dem Aufbau kontrollierbarer, effizienter und algorithmisch optimierbarer Sprachmodellanwendungen beimisst. (Quelle: lateinteraction)

Diskussion über den aktuellen Stand und die Akzeptanz von KI am Arbeitsplatz: Reddit-Nutzer diskutieren den Einsatz von KI am Arbeitsplatz sowie die Meinungen von Arbeitgebern und Kollegen dazu. Die meisten Nutzer geben an, dass KI die Arbeitseffizienz effektiv steigern kann, z. B. bei der Unterstützung der Programmierung, dem Verfassen von E-Mails und Berichten, Protokollen von Besprechungen und Marktforschung. Einige Unternehmen fördern den Einsatz von KI, während andere eine vorsichtige oder ablehnende Haltung einnehmen, was dazu führt, dass Mitarbeiter KI möglicherweise diskret einsetzen. Die Diskussion unterstreicht das Potenzial von KI zur Produktivitätssteigerung, berührt aber auch Fragen der korrekten Einschätzung von KI-Fähigkeiten und der Datensicherheit. (Quelle: Reddit r/ArtificialInteligence)

Untergräbt KI Reddits Kernkompetenz – die menschliche Interaktion?: Ein Artikel von Business Insider weist darauf hin, dass der CEO von Reddit die von Menschen dominierte Community als größten Wettbewerbsvorteil ansieht, aber von KI-Bots generierte Posts und Kommentare diesen Vorteil bedrohen. Reddit hat das Problem eingeräumt und plant die Einführung neuer Mechanismen zur Überprüfung der Nutzeridentität, was eine Diskussion über die Verbreitung von KI-Inhalten, die Authentizität der Community und die Frage auslöste, wie Online-Plattformen in Zukunft mit KI-generierten Inhalten umgehen sollen. (Quelle: Reddit r/artificial, Business Insider)

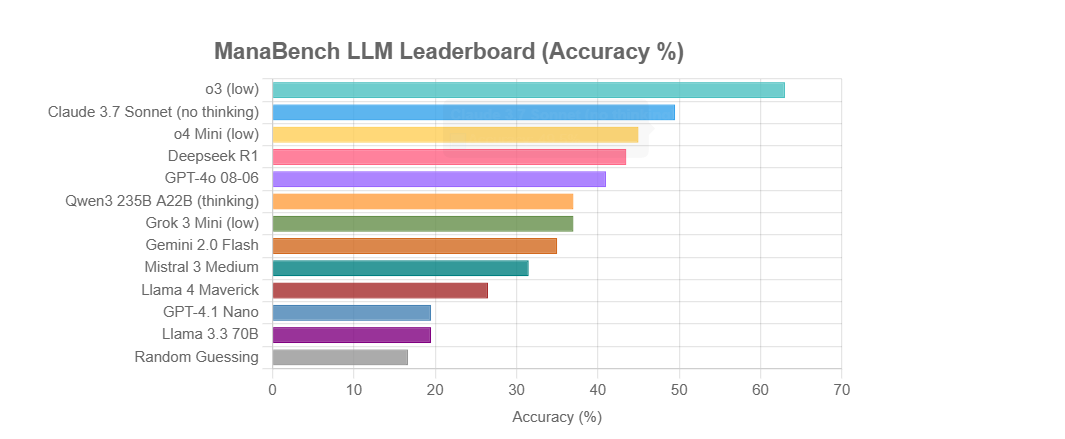

ManaBench: Neuer Benchmark zum Testen der Schlussfolgerungsfähigkeiten von LLMs anhand des Deckbaus bei Magic: The Gathering: Jake Boggs hat ManaBench veröffentlicht, einen neuen Benchmark, der die Schlussfolgerungsfähigkeiten von Large Language Models (LLMs) anhand der Aufgabe des Deckbaus im Spiel Magic: The Gathering testet. Der Benchmark konzentriert sich nicht auf Spielwissen, sondern bewertet die strategischen Schlussfolgerungs- und Systemverständnisfähigkeiten des Modells, mit dem Ziel, eine nutzererlebnisrelevante Unterscheidung der Modelle zu ermöglichen. (Quelle: Teknium1)

Nutzer teilt Erfahrung mit KI-gestützter Tiefenrecherche und Umwandlung in Audio zum Anhören: Ein Nutzer berichtet, wie er ChatGPT für Tiefenrecherchen zu Themen verwendet und die Ergebnisse dann mit Tools wie Speechify in Audio mit Obamas Stimme umwandelt, um sie anzuhören. Diese Praxis zeigt das Potenzial von KI bei der Informationsbeschaffung und dem personalisierten Konsum von Inhalten, wirft aber auch Fragen über einen möglichen Rückgang der Lesefähigkeit durch übermäßige Abhängigkeit von KI auf. (Quelle: Reddit r/artificial)

💡 Sonstiges

Ehemaliges Mitglied des KI-Risikoteams der britischen Regierung deckt ethische Probleme und nachfolgende Repressalien auf: Ein ehemaliger Mitarbeiter der zentralen KI-Risikofunktion der britischen Regierung gab öffentlich an, nach der Äußerung von Bedenken hinsichtlich KI-Bias, Diskriminierung und anderer ethischer Fragen innerhalb des Teams mit Blockaden, Überwachung und institutionellen Repressalien konfrontiert worden zu sein. Der Vorfall löste eine Diskussion über den Schutz von „Whistleblowern“ in staatlichen Technologieumfeldern sowie über die Wirksamkeit öffentlicher Rechenschaftsmechanismen für KI-Ethik aus. (Quelle: Reddit r/ArtificialInteligence)

Indirekte Auswirkungen von KI auf „KI-sichere“ Arbeitsplätze: Es wird darauf hingewiesen, dass selbst wenn bestimmte qualifikationsbasierte Branchen (wie Handwerker) an sich nicht leicht direkt durch KI ersetzt werden können, diese „KI-sicheren“ Arbeitsplätze durch mangelnde Nachfrage beeinträchtigt werden, falls KI zu Massenarbeitslosigkeit führt und die Konsumentenbasis schrumpft. Dies erinnert uns daran, die Auswirkungen von KI auf die Beschäftigung aus einer makroökonomischeren Systemsicht zu betrachten. (Quelle: Reddit r/artificial)

Standpunkt: LLMs nutzen menschliche kognitive Verzerrungen durch Simulation von Intelligenz: Pedro Domingos ist der Ansicht, dass Large Language Models (LLMs) darin geübt sind, Texte zu generieren, die intelligent erscheinen, was die kognitive Schwäche einiger Menschen ausnutzt, nicht zwischen echter Intelligenz und „Bullshit“ (BS) unterscheiden zu können. (Quelle: pmddomingos)