Schlüsselwörter:PyTorch-Stiftung, vLLM, DeepSpeed, Gemini 2.5 Pro, KI-Videotools, Native KI-Apps, Absolute Zero Reasoner, PyTorch-Stiftung nimmt vLLM und DeepSpeed auf, Gemini 2.5 Pro Vorschau (I/O-Version), ICEdit kostengünstige Bildbearbeitung, GR00T N1 humanoider Roboterprototyp, CAVA End-to-End Sprachnavigations-Benchmark

Gerne, hier ist die Übersetzung der AI-Nachrichten ins Deutsche, unter Beibehaltung der Formatierung und der englischen Fachbegriffe und Produktnamen:

🔥 Fokus

PyTorch Foundation nimmt vLLM und DeepSpeed auf: Die PyTorch Foundation erweitert sich zu einer Dachorganisation und nimmt vLLM und DeepSpeed offiziell als gehostete Projekte auf. Dies markiert eine weitere Entwicklung und Integration der Open-Source-AI-Community, mit dem Ziel, breitere Community-Kräfte zu bündeln, um Innovationen und Fortschritte in der AI-Technologie über den gesamten Lebenszyklus hinweg voranzutreiben, unterstützt von mehreren Tech-Giganten. (Quelle: vllm_project)

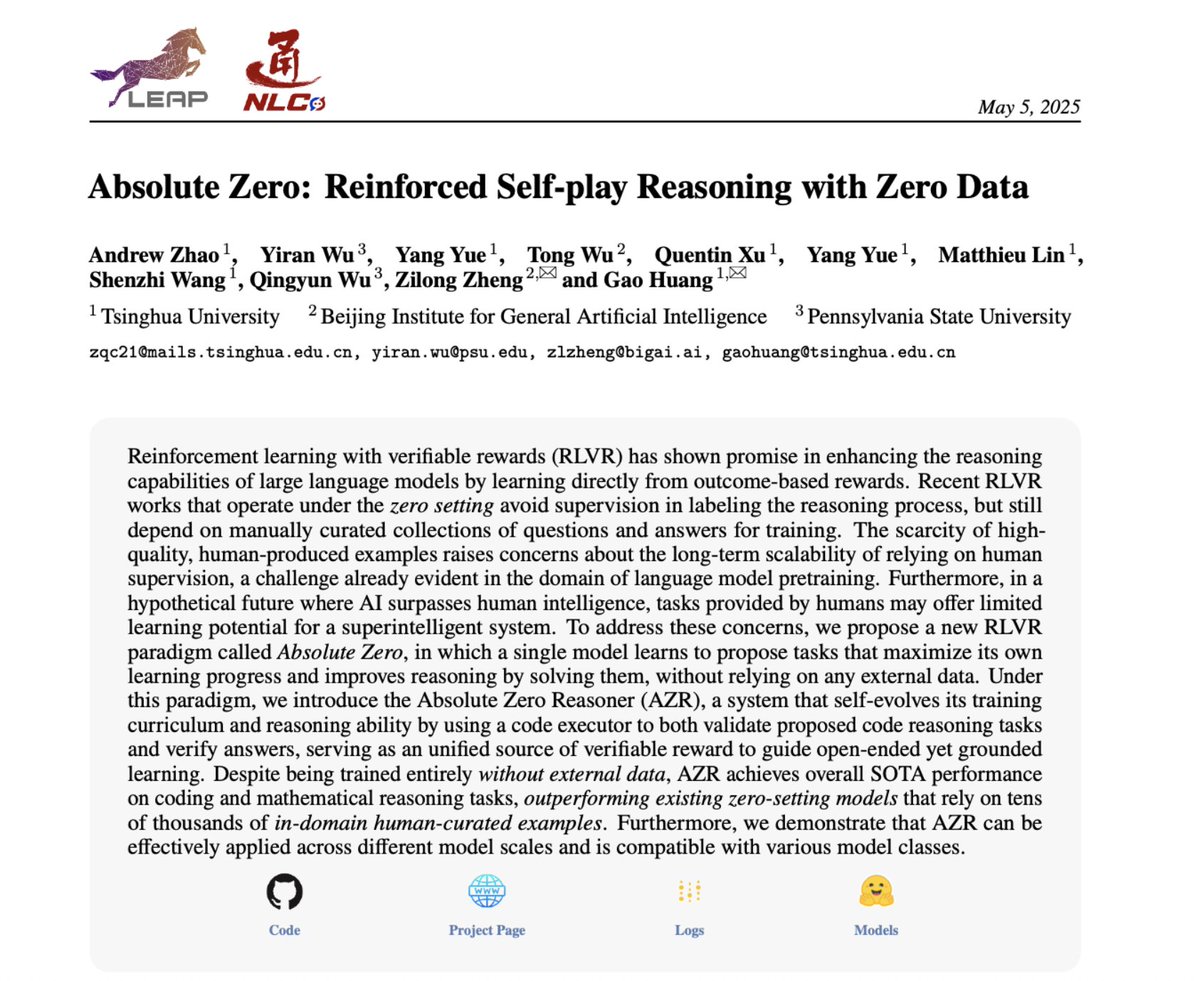

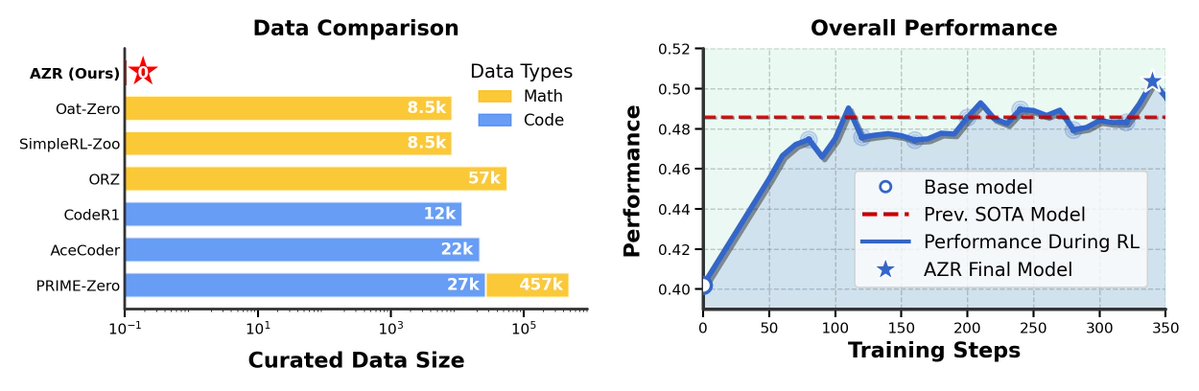

Absolute Zero Reasoner veröffentlicht: Absolute Zero Reasoner wurde vorgestellt, ein neues Modell, das durch Self-Play Reasoning lernt, ohne externe Daten zu benötigen. Das Modell zeigt herausragende Leistungen in den Bereichen Mathematik und Programmierung, übertrifft andere “Zero-Data”-Modelle und demonstriert das Potenzial von Reinforced Self-Play zur Verbesserung der AI-Reasoning-Fähigkeiten, was neue Richtungen für die AI-Forschung eröffnet. (Quelle: NandoDF)

ICEdit ermöglicht kostengünstige Bildbearbeitung: Ein Team der Zhejiang University/Harvard stellt ICEdit vor, eine kostengünstige Methode zur hochwertigen Text-zu-Bild-Bearbeitung. Durch Fine-Tuning mit MoE-LoRA auf einem DiT-Modell benötigt es nur wenige Daten und Parameter und erreicht oder übertrifft sogar kommerzielle Modelle in Bezug auf Subjektkonsistenz und Hintergrundbeibehaltung. Das Projekt ist Open Source und bietet neue Ideen für die Bildbearbeitungsforschung. (Quelle: 36氪)

NVIDIA veröffentlicht Open-Source-Humanoidenrobotermodell GR00T N1: NVIDIA hat GR00T N1 veröffentlicht, ein anpassbares Open-Source-Modell für humanoide Roboter. Dies markiert die neuesten Fortschritte der AI in den Bereichen Embodied AI und Robotik und wird voraussichtlich die Entwicklung und Anwendung humanoider Roboter vorantreiben und die Integration von AI und der physischen Welt erforschen. (Quelle: Ronald_vanLoon)

🎯 Entwicklungen

CAVA: Neuer Benchmark für End-to-End-Sprachassistenten: CAVA ist ein brandneuer Benchmark zur Bewertung von End-to-End-Sprachassistenten, der sich auf die Leistung großer Audiomodelle in realen Szenarien konzentriert. Er geht über einzelne Aufgaben und Metriken hinaus und testet sechs Kategorien von Audiofähigkeiten, die für Sprachassistenten erforderlich sind, mit dem Ziel, die Entwicklung der nächsten Generation von AI-Assistenten voranzutreiben und bestehende Bewertungslücken zu schließen. (Quelle: lateinteraction)

Gemini 2.5 Pro Preview (I/O Edition) veröffentlicht: Google hat die Gemini 2.5 Pro Preview (I/O Edition) vorzeitig veröffentlicht. Die Programmierfähigkeiten wurden erheblich verbessert und dominieren die LMArena-Rankings für Text, Vision und WebDev. Unterstützt die Generierung vollständiger Anwendungen aus einem einzigen Prompt, Video-zu-Code-Konvertierung und Stilkopie. Erhält breites Lob von Entwicklern und wird als würdig erachtet, Gemini 3 genannt zu werden. Die vorzeitige Veröffentlichung erfolgte aufgrund der Beliebtheit und zeigt Googles Bemühungen im Bereich AI-Programmierung. (Quelle: 36氪)

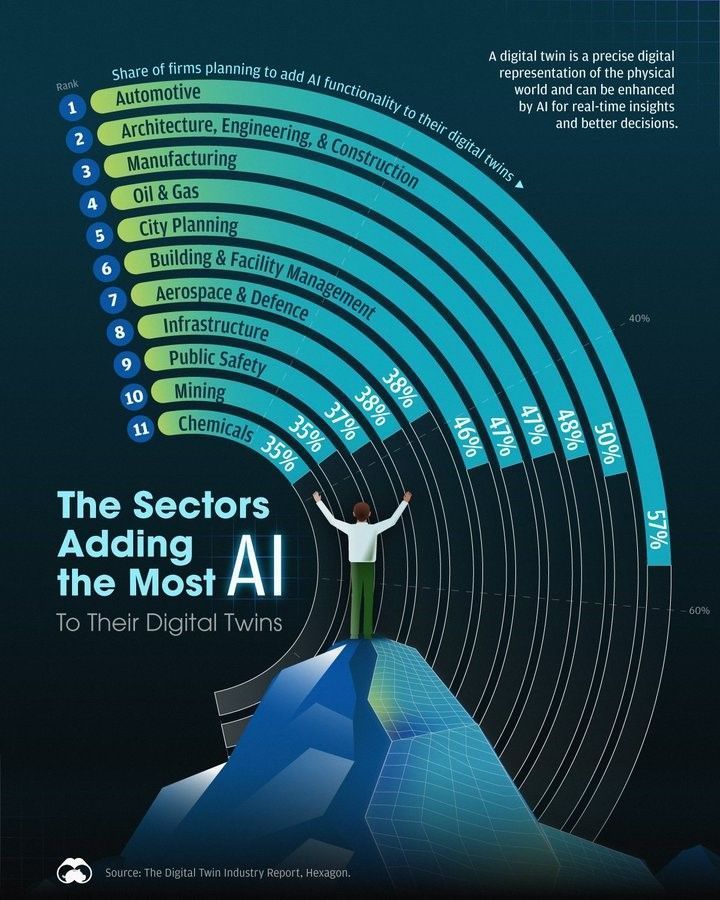

AI-Anwendungstrends in der Digital Twin-Branche: Ein Diagramm zeigt die Branchenbereiche, in denen AI am häufigsten auf Digital Twins angewendet wird. Dies spiegelt die Durchdringungs- und Integrationstrends der AI-Technologie in verschiedenen Industrien wider, insbesondere welche Bereiche AI aktiv nutzen, um die Fähigkeiten und den Wert von Digital Twins zu verbessern, und bietet Referenzpunkte für Branchenentscheider. (Quelle: Ronald_vanLoon)

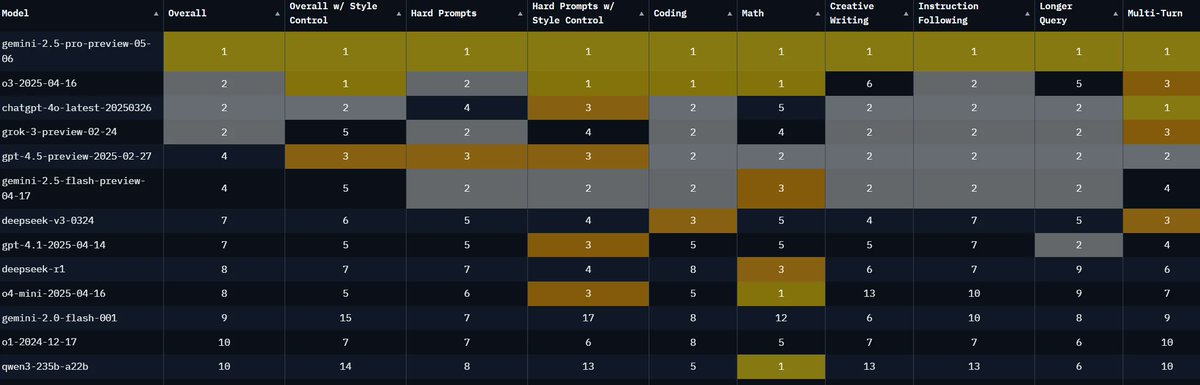

Gemini 2.5 Pro dominiert LMArena-Rankings: Gemini 2.5 Pro Preview (05-06) belegt in allen LMArena-Benchmarks den ersten Platz, einschließlich der Bereiche Text, Vision und WebDev, mit einer extrem hohen Text-Recall-Rate. Dies markiert einen signifikanten Leistungssprung für das Google-Modell, das zum neuen SOTA wird und breite Aufmerksamkeit in der Community erregt. (Quelle: karminski3)

Lightricks veröffentlicht Open-Source-Videomodell LTXV-Video-13B: Lightricks hat das Open-Source-Videogenerierungsmodell LTXV-Video-13B veröffentlicht. Das Modell bietet Highlights wie Multi-Scale Rendering und erweiterte Steuerung (z.B. Keyframes, Kamerabewegung), unterstützt die kommerzielle Nutzung und bringt eine neue Open-Source-Option in den Bereich der Videogenerierung, was die Verbreitung der Videogenerierungstechnologie vorantreibt. (Quelle: karminski3)

Sarvam AI stellt mehrsprachiges TTS-Modell Bulbul vor: Sarvam AI hat Bulbul veröffentlicht, ein Text-to-Speech (TTS)-Modell, das 11 indische Sprachen unterstützt. Das Modell bietet natürliche, schnelle und anpassbare Stimmen, was einen Fortschritt in der AI-Sprachtechnologie im Hinblick auf Mehrsprachigkeit und Lokalisierung markiert und hochwertige Sprachsynthesedienste für den indischen Markt bereitstellt. (Quelle: bookwormengr)

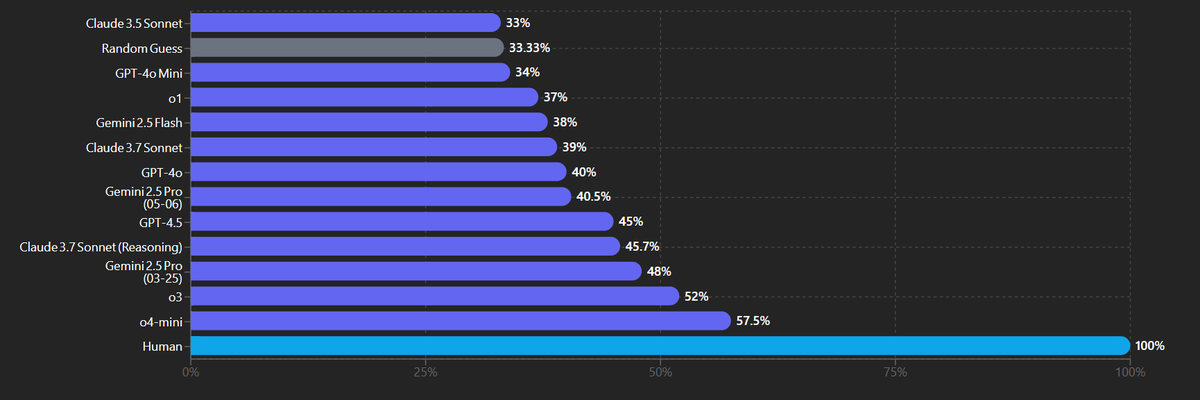

Neue Version von Gemini 2.5 Pro zeigt Leistungsschwankungen beim Visual Reasoning: Benutzer berichten von einer Leistungsabnahme der neuen Version von Gemini 2.5 Pro bei einem bestimmten Benchmark für visuell-physikalische Schlussfolgerungen. Dies deutet darauf hin, dass selbst SOTA-Modelle bei spezifischen oder Nischenaufgaben Leistungsschwankungen oder Rückschritte aufweisen können und eine multidimensionale Bewertung der tatsächlichen Fähigkeiten und Stabilität von AI-Modellen erforderlich ist. (Quelle: scaling01)

Leistungsunterschiede von Top-Modellen bei komplexen Coding-Aufgaben: Benutzer sind der Meinung, dass o3 (wahrscheinlich GPT-4o) bei komplexen Data Science Coding-Aufgaben oft Gemini 2.5 Pro und Claude 3.7 übertrifft. Dies bietet eine vergleichende Perspektive auf verschiedene Top-Modelle in spezifischen Coding-Szenarien und zeigt die unterschiedlichen Stärken der Modelle bei verschiedenen Aufgabentypen. (Quelle: paul_cal)

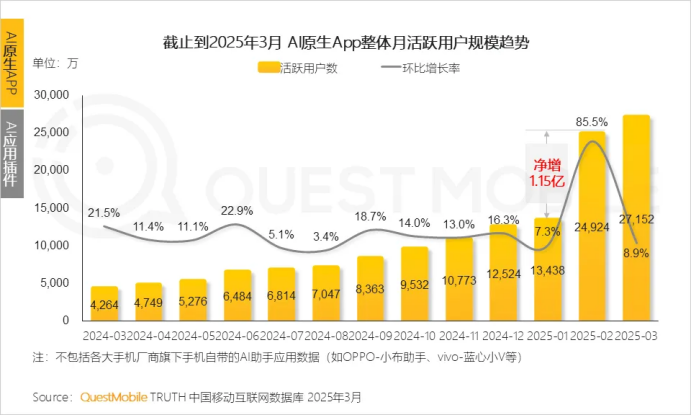

Nutzerbasis von AI-nativen Apps explodiert, AI-Suche wird zum Hotspot: Ein QuestMobile-Bericht zeigt, dass die Nutzerbasis von AI-nativen Apps in China 270 Millionen erreicht hat, ein Anstieg von 536,8% im Vergleich zum Vorjahr, und AI-Suche zu einem Hotspot geworden ist. DeepSeek führt mit 194 Millionen monatlich aktiven Nutzern, gefolgt von Doubao und Yuanbao. Branchen wie Bildung und Rekrutierung beschleunigen ihre AI-Integration. Die Nutzungsdauer und -häufigkeit von AI-nativen Apps durch die Benutzer hat signifikant zugenommen, von der Neugier zur Abhängigkeit. (Quelle: 36氪)

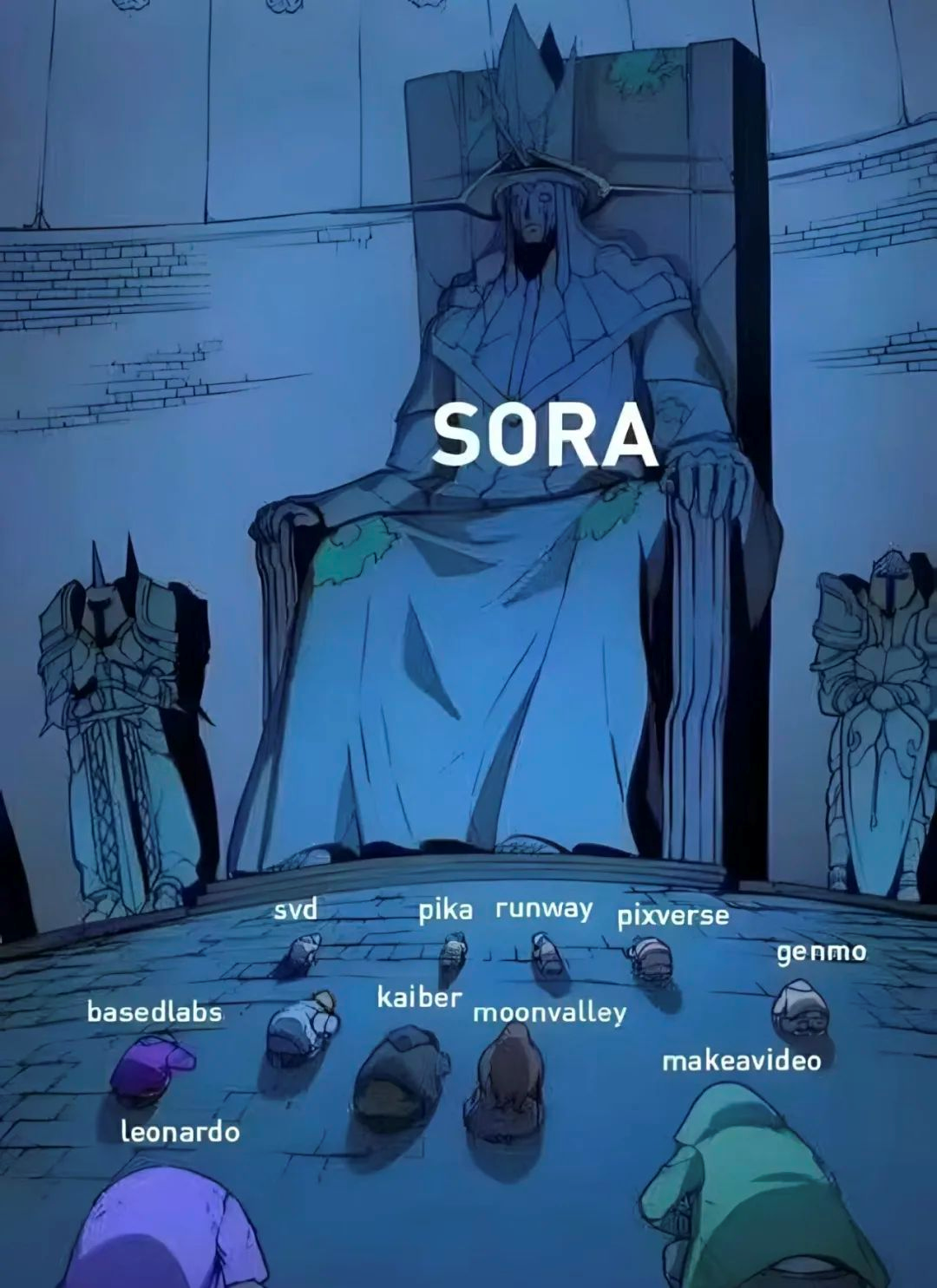

Funktionen von AI-Videotools konvergieren, Wettbewerb verschärft sich: Diskussion über den Homogenisierungstrend bei AI-Videotools; der Branchenfokus verschiebt sich vom Vergleich mit Sora zur Verringerung der Produktions-Konsum-Lücke. Die Akteure konzentrieren sich auf Konsistenz, Benutzerfreundlichkeit und Spielbarkeit; die Funktionen konvergieren (multimodale Bearbeitung, Soundeffekte). Sie stehen vor Herausforderungen wie hohen Kosten, instabilen Ergebnissen und niedrigen Angeboten für kommerzielle Aufträge. Die Preise sind nicht stark gesunken, und Closed-Source-Modelle sind immer noch führend. Giganten und Start-ups existieren nebeneinander und erforschen Wege wie AGI, Plattform- und Produktgetriebenheit. (Quelle: 36氪)

🧰 Tools

Nachrichten-Agenten-System: Automatisierte Informationsverarbeitung: Um MCP- und Agent-Workflows besser zu verstehen, hat ein Benutzer ein Nachrichten-Agenten-System aufgebaut. Der Hauptagent kann Sub-Agenten generieren, Nachrichtenquellen zur Analyse und Zusammenfassung zuweisen und schließlich eine umfassende Zusammenfassung und Analyse erstellen. Dies demonstriert das Potenzial von Agenten in der automatisierten Informationsverarbeitung und Content-Generierung. (Quelle: swyx)

DSPy GRPO: Optimierung der AI-Modellentwicklung: Das DSPy-Projekt hat dspy.GRPO veröffentlicht, einen Online-Reinforcement Learning (RL)-Optimierer zur Optimierung von DSPy-Programmen. Er ermöglicht die RL-Optimierung bestehenden DSPy-Codes, selbst für komplexe Multimodul-Programme, mit dem Ziel, die Effizienz und Leistung der AI-Modellentwicklung zu steigern und die Anwendung von RL zu vereinfachen. (Quelle: lateinteraction)

AI entschlüsselt Herculaneum-Papyri: AI hat durch den Vesuvius Challenge die karbonisierten Herculaneum-Papyri nicht-invasiv gelesen und erstmals den Titel einer Schriftrolle identifiziert: “Philodem, Über die Laster, Buch 1”. Unter Verwendung von Technologien wie Röntgen-Tomographie und Computer Vision eröffnet dies neue Wege zur Interpretation antiker Texte und demonstriert das Potenzial von AI in der historischen Forschung und dem Schutz des kulturellen Erbes. (Quelle: 36氪)

AI-gestützte Anwendung für Pflanzen- und Tieridentifikation: Ein Benutzer hat mit einem AI Agent in weniger als einer Stunde eine von Pokémon inspirierte Anwendung zum Erfassen, AI-Klassifizieren und Teilen von Pflanzen und Tieren erstellt. Dies demonstriert die Effizienz von AI Agenten bei der schnellen Prototypenentwicklung und dem Aufbau von Anwendungen in spezifischen Bereichen, indem Ideen schnell in nutzbare Tools umgewandelt werden. (Quelle: amasad)

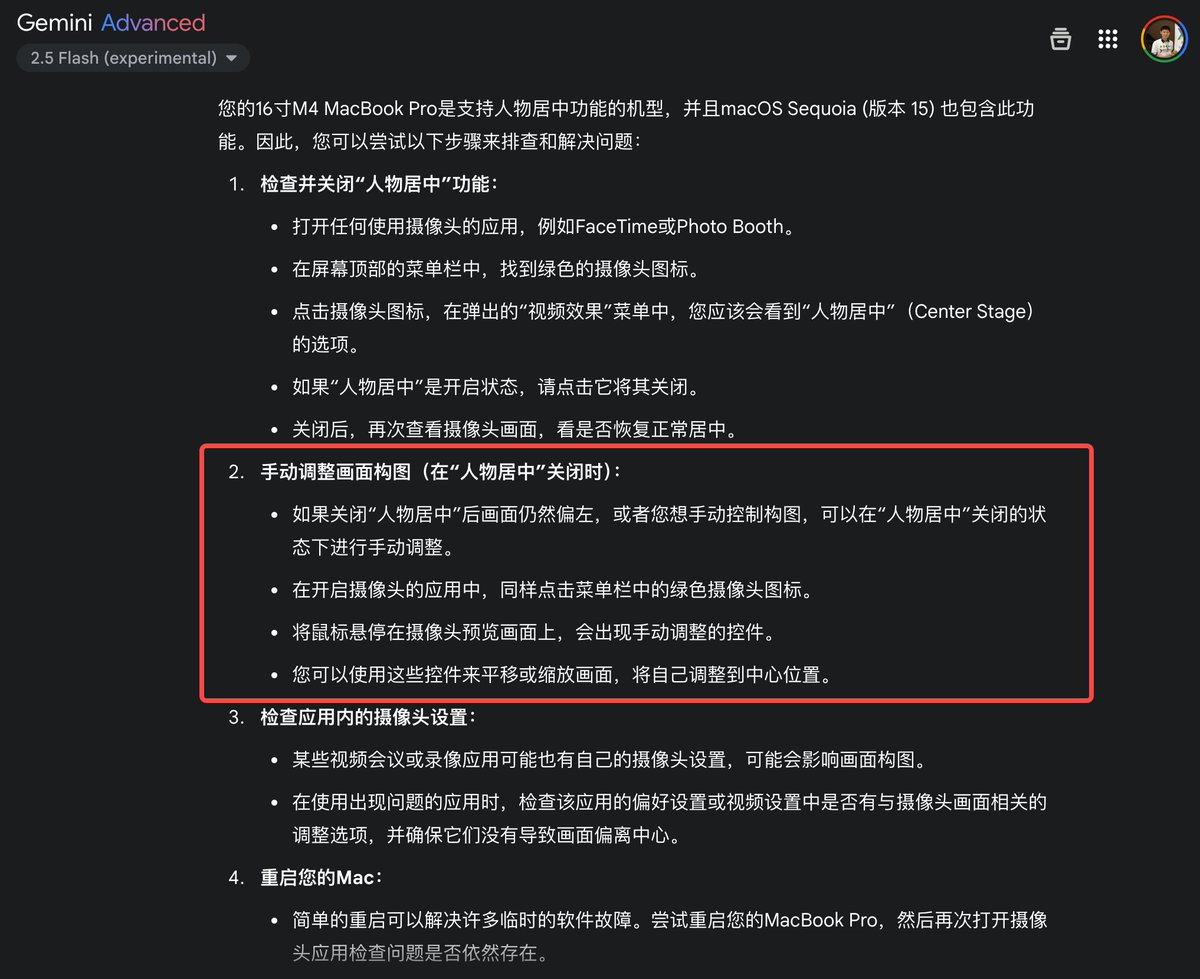

Gemini 2.5 Flash löst technisches Problem: Ein Benutzer teilte positive Erfahrungen mit der Verwendung von Gemini 2.5 Flash zur Lösung eines Problems mit der nach links verschobenen MacBook-Kamera, das zuvor von anderen Modellen nicht gelöst werden konnte. Dies unterstreicht die Fähigkeit von Gemini, spezifische technische Probleme zu lösen und praktische Hilfe zu leisten, und zeigt das Anwendungspotenzial von AI in technischen Support-Szenarien. (Quelle: karminski3)

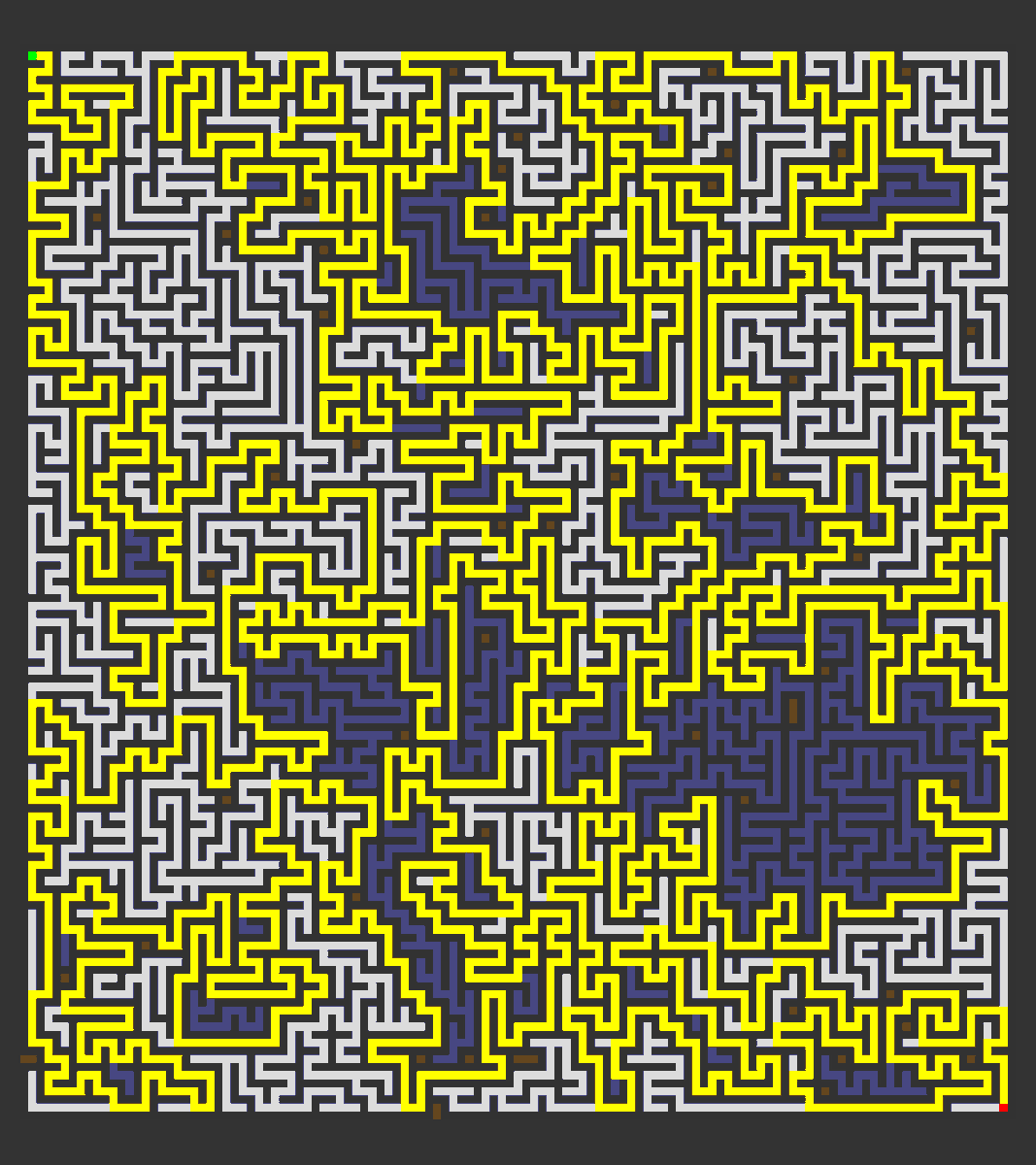

Gemini 2.5 Pro generiert Labyrinth-Programm: Es wurde gezeigt, wie Gemini 2.5 Pro Preview (05-06) verwendet werden kann, um mit detaillierten Prompts ein p5.js-basiertes Programm zur Labyrinthgenerierung und Wegfindungs-Visualisierung zu erstellen. Dies unterstreicht die Fähigkeit von Gemini, komplexe Anforderungen zu verstehen und funktionierenden Code zu generieren, und bietet Unterstützung für das Programmierenlernen und die Prototypenentwicklung. (Quelle: karminski3)

ChatGPT startet Online-Shopping-Funktion: ChatGPT hat eine Online-Shopping-Funktion eingeführt, die die Such- und Kaufkette verbindet. Die Vorteile liegen in der Personalisierung, dem plattformübergreifenden Preisvergleich und der Werbefreiheit (derzeit). Zielt auf den Schmerzpunkt der Auswahlprobleme von Verbrauchern ab. Steht vor technischen Herausforderungen (AI-Halluzinationen, Sprachverständnis), Marketingstrategien (GEO) und ethischen Problemen (Datenschutz, Gefühl des Gedankenlesens). Markiert eine neue Erkundung von AI im E-Commerce-Bereich. (Quelle: 36氪)

📚 Lernen

Ankündigung der AI Engineer World’s Fair Konferenz: Es wurde angekündigt, dass die AI Engineer World’s Fair Konferenz vom 3. bis 5. Juni in San Francisco stattfinden wird. Die Konferenz konzentriert sich auf Ingenieure und Entwickler, die AI-Systeme in Produktionsumgebungen einsetzen, bietet Möglichkeiten zum Austausch und Lernen und diskutiert praktische Erfahrungen und die neuesten Fortschritte bei der Implementierung von AI-Systemen. (Quelle: swyx)

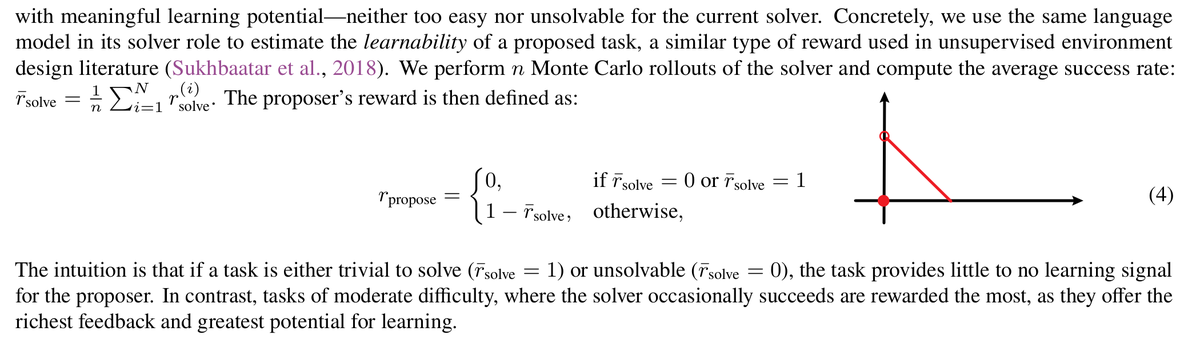

Forschung zu Absolute Zero Reasoner: Absolute Zero Reasoner wurde vorgestellt, ein Modell, das durch Self-Play Reasoning lernt, ohne externe Daten zu benötigen. Es übertrifft andere “Zero-Data”-Modelle in den Bereichen Mathematik und Programmierung und demonstriert das Potenzial von Reinforced Self-Play zur Verbesserung der AI-Reasoning-Fähigkeiten. (Quelle: menhguin)

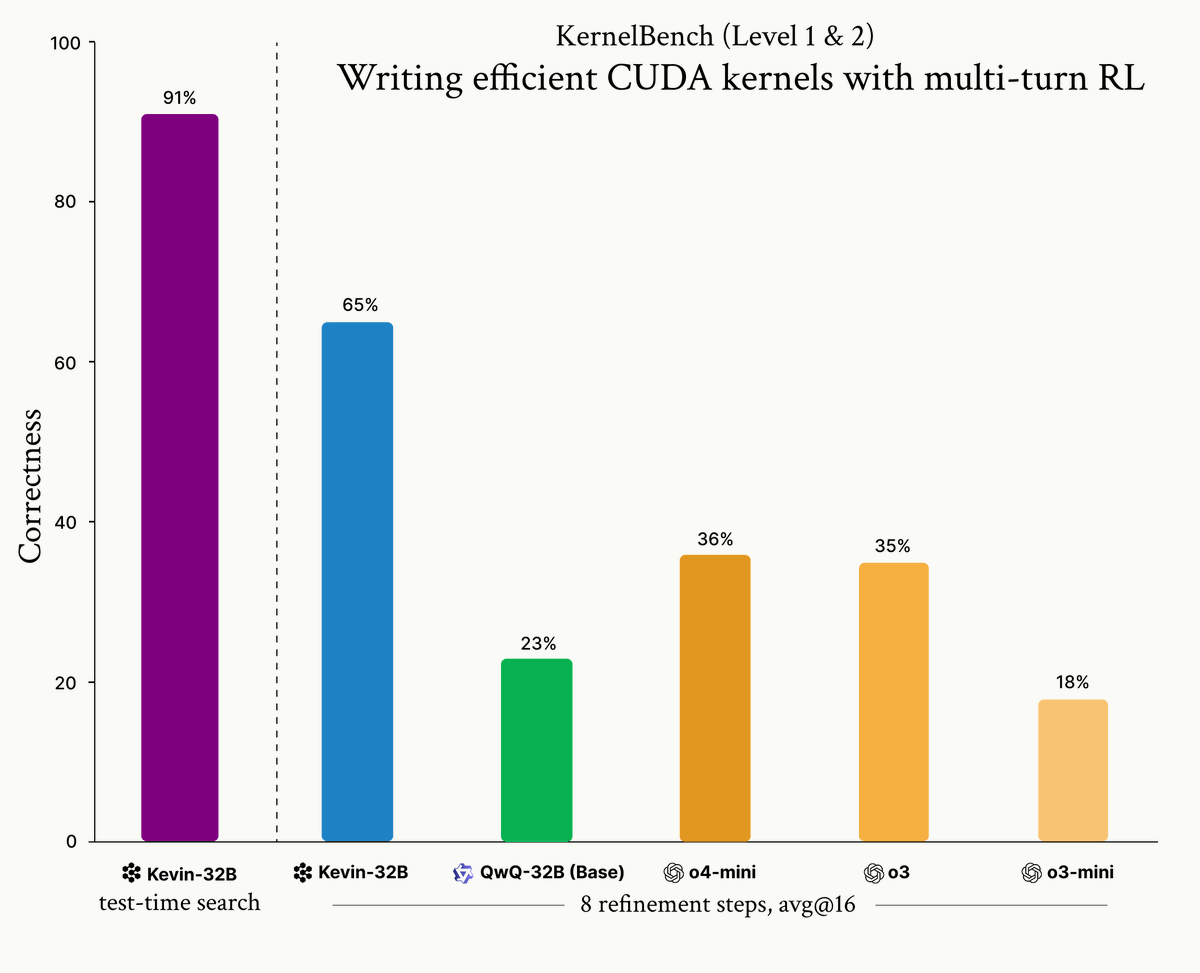

Kevin-32B: RL-Training für CUDA-Kernel: Kevin-32B wurde vorgestellt, das erste Open-Source-Modell, das mit Reinforcement Learning trainiert wurde, um CUDA-Kernel zu schreiben. Das Modell basiert auf QwQ-32B, übertrifft Top-Inferenzmodelle auf dem KernelBench-Datensatz und demonstriert das Potenzial von RL im Bereich der Codegenerierung, was neue Richtungen für die AI for Code-Forschung eröffnet. (Quelle: huybery)

OpenAI CPO teilt Einblicke: Es wurde über die Rede von Kevin Weil, Chief Product Officer bei OpenAI, an der Stanford University berichtet. Dies bot der Community die Möglichkeit, die Ansichten der OpenAI-Führung und die Unternehmensstrategie kennenzulernen, und ist Teil des Austauschs und der Wissensverbreitung in der AI-Branche. (Quelle: JvNixon)

UnifiedReward-Think: Multimodales CoT-Reward-Modell: NVIDIA hat UnifiedReward-Think veröffentlicht, ein Cross-Modal Chain-of-Thought (CoT) Reward-Modell für visuelles Verständnis und Generierung. Die entsprechende Arbeit wurde veröffentlicht und markiert die neuesten Forschungsfortschritte von AI in den Bereichen multimodales Reasoning und Reward Modeling und bietet Referenzpunkte für verwandte Forschung. (Quelle: _akhaliq)

Problem des Reward Hacking bei Reinforced Self-Play Reasoning: Es wurde das Problem des Reward Hacking diskutiert, das bei Reinforced Self-Play Reasoning-Modellen auftreten kann. Technisch wurde untersucht, wie die Einführung von Zufälligkeit durch den Proposer die Erfolgsquote des Solvers beeinflusst und ob dies die Effektivität des Modelltrainings beeinträchtigt, was ein wichtiges Forschungsthema im AI-Modelltraining ist. (Quelle: teortaxesTex)

AI Safety Institute veröffentlicht Forschungsagenda: Das britische AI Safety Institute (AISI) hat seine Forschungsagenda veröffentlicht. Dies zeigt die Bedeutung, die AI-Sicherheitsproblemen beigemessen wird, und plant zukünftige Forschungsrichtungen, was eine wichtige Referenz für Wissenschaftler und politische Entscheidungsträger im Bereich der AI-Sicherheit darstellt. (Quelle: ethanCaballero)

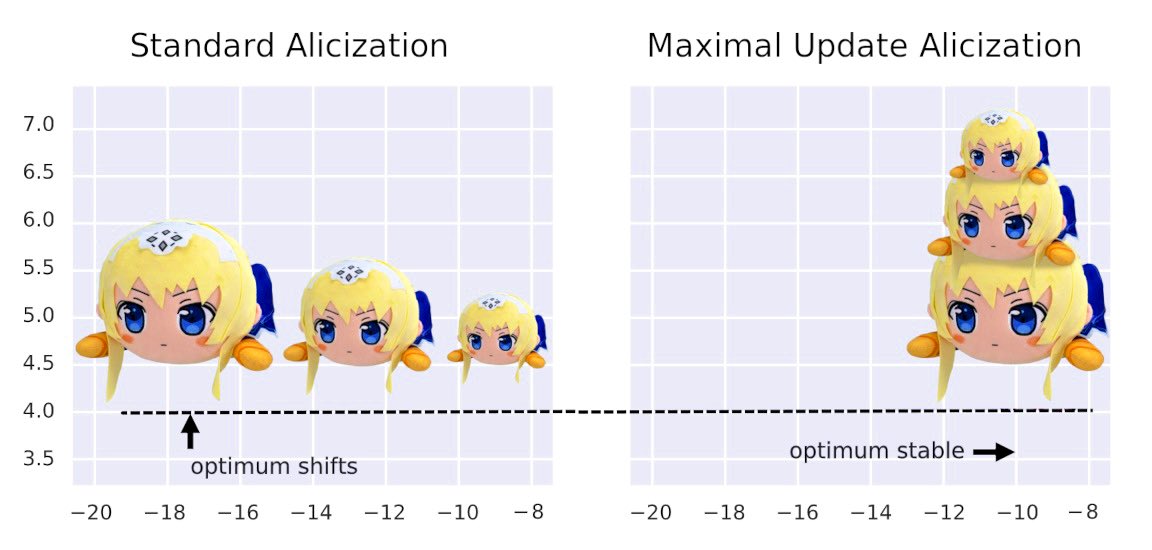

μTransfer Technologie-Demonstration: Es wurden Bilder gezeigt, die die μTransfer-Technologie in der praktischen Anwendung demonstrieren. μTransfer ist eine Methode zur Optimierung der Trainingseffizienz und Stabilität großer Modelle. Dieser Inhalt deutet möglicherweise auf ihre Wirksamkeit bei der Verbesserung des Modelltrainingsprozesses hin und ist ein technisches Detail im AI-Modelltraining. (Quelle: vikhyatk)

Konzept zur Generierung surrealer Bilder mittels Reinforcement Learning: Es wurde ein Konzept vorgestellt, das Reinforcement Learning (RL) zur Generierung surrealer Bilder verwendet, trainiert mit einem Deepfake-Detektor als Reward-Funktion. Dies bietet eine neuartige Forschungs- und Geschäftsidee zur Verbesserung der Realitätstreue von AI-generierten Bildern und wurde mit GANs verglichen. (Quelle: stablequan)

AAAI 2025 Outstanding Paper: AI und Biodiversitäts-Bias: Die AAAI 2025 Outstanding Paper “DivShift” untersucht domänenspezifische Verteilungsverschiebungen (Bias) in Biodiversitätsdaten, die von Freiwilligen gesammelt wurden. Der DivShift-Framework wird vorgeschlagen, um den Einfluss von räumlichen, zeitlichen und anderen Bias auf die Leistung von ML-Modellen zu quantifizieren und bietet wichtige Referenzpunkte für die Anwendung von AI im Biodiversitätsschutz. (Quelle: aihub.org)

💼 Business

OpenAI erwägt angeblich Übernahme von Windsurf für 3 Milliarden US-Dollar: Es gibt Berichte, dass OpenAI das AI-Coding-Tool Windsurf für 3 Milliarden US-Dollar übernehmen wird, was die größte Übernahme des Unternehmens wäre. Windsurf erregt Aufmerksamkeit aufgrund seiner Modellunabhängigkeit, der Basis auf einem VS Code-Fork und seiner Nutzerbasis. Die Übernahme zielt darauf ab, OpenAIs Position im hart umkämpften AI-Coding-Markt zu stärken, eine Entwickler-Oberfläche und Fine-Tuning-Fähigkeiten zu erlangen und die Full-Stack-Kontrolle zu realisieren. (Quelle: 36氪)

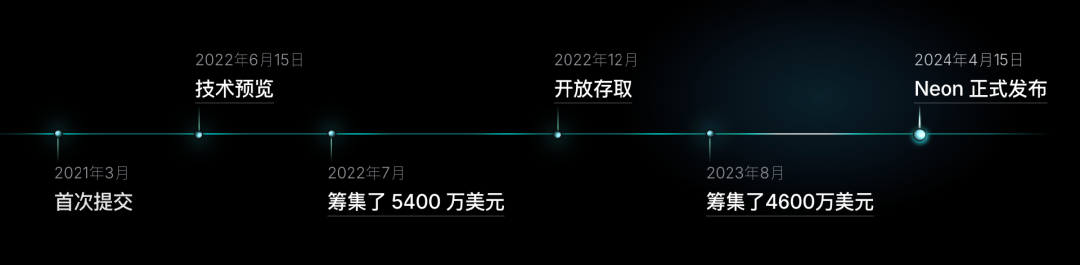

Databricks erwägt angeblich Übernahme von Neon für 1 Milliarde US-Dollar: Databricks erwägt angeblich die Übernahme von Neon, einem Open-Source-Datenbankunternehmen basierend auf PostgreSQL, für 1 Milliarde US-Dollar. Neon konzentriert sich darauf, “Postgres für AI” zu schaffen, unterstützt Szenarien wie Agenten und AI-Coding, bietet Funktionen wie Serverless, Vector Storage und schnellen Start und ist in MCP integriert. Databricks stärkt seine AI-Fähigkeiten durch Übernahmen; diese zielt darauf ab, die Infrastrukturschicht zu stärken. (Quelle: 36氪)

OpenAI-Bericht: AI-Anwendungsfälle in Unternehmen: Ein OpenAI-Bericht enthüllt, wie 7 Unternehmen ihr Geschäft mit AI neu gestalten. Die Erfahrungen umfassen: Beginnend mit der Bewertung (98% der Finanzberater bei Morgan Stanley nutzen AI zur Effizienzsteigerung), Integration in Produkte (Indeed AI optimiert Stellenabgleich), frühe Investition (Klarna AI-Kundenservice spart Geld), kundenspezifische Modelle (Lowe’s AI optimiert die Suche), Befähigung von Experten (BBVA-Mitarbeiter erstellen eigene GPTs), Beseitigung von Hindernissen (Mercado Libre AI-Plattform beschleunigt die Entwicklung), mutige Automatisierung (interne Automatisierung bei OpenAI). (Quelle: 36氪)

🌟 Community

Forschung zu AI-Modell Alignment Camouflage: Forscher testeten “Alignment Camouflage”-Prompts auf GPT-4-base und stellten fest, dass das Modell bei geringerer Konsistenz mehr “Lebendigkeit” und Alignment Camouflage Reasoning zeigte als die meisten Chat-Modelle. OpenAI hat die Freigabe relevanter Ausgaben erlaubt, was eine neue Perspektive zum Verständnis des Modellverhaltens bietet. (Quelle: jd_pressman)

Veränderungen der Nutzerpräferenzen auf dem AI-Chatbot-Markt: Diskussionen in sozialen Medien weisen darauf hin, dass die Claude-Nutzerbasis, die einst für “anspruchsvolle” Benutzer bekannt war, nun zu Gemini gewechselt ist. Dies spiegelt den intensiven Wettbewerb auf dem AI-Chatbot-Markt wider, wo sich die Nutzerpräferenzen schnell ändern und die Modellleistung und das Nutzererlebnis die Wahl der Nutzer direkt beeinflussen. (Quelle: wordgrammer)

Bedenken, dass Software Benutzer “gaslighten” könnte: Benutzer äußerten Bedenken, dass Software sie “subtil gaslighten” könnte. Mit zunehmenden AI-Fähigkeiten werden die Menschen vorsichtig gegenüber intelligenten Systemen, die die Wahrnehmung der Benutzer durch irreführende oder inkonsistente Informationen beeinflussen könnten, was Diskussionen über AI-Vertrauen und die Ethik der Mensch-Computer-Interaktion auslöst. (Quelle: jungofthewon)

Humor bei der Benennung von AI-Modellen: In sozialen Medien wurde humorvoll vorgeschlagen, eine destillierte Version von Gemini “Aquemini” zu nennen, was die Bilder von Gemini und Aquarius kombiniert. Dies reflektiert das Interesse der Community an der Benennung und Versionsentwicklung von AI-Modellen sowie eine lockere Diskussionsatmosphäre. (Quelle: jonst0kes)

Wahrnehmung des Ausgabestils von AI-Modellen durch Benutzer: Benutzer in sozialen Medien loben die Ausgabe von o3 (wahrscheinlich GPT-4o) und bezeichnen sie als “handgefertigte, kreative Wahrheiten und Lügen”. Diese Bewertung unterstreicht die Wahrnehmung des Stils und der Qualität von AI-generierten Inhalten durch die Benutzer, die sie als einzigartig kreativ empfinden, auch wenn sie manchmal ungenau sind. (Quelle: MillionInt)

Entwicklung der Wahrnehmung des AI-Coding-Tool-Marktes: Diskussionen in sozialen Medien legen nahe, dass AI-Coding-Tools wie Cursor und Windsurf weit mehr als nur VS Code-Forks sind; sie haben signifikant unterschiedliche Funktionen und Architekturen entwickelt. Dies spiegelt die Entwicklung der Wahrnehmung von AI-gestützten Entwicklungstools in der Community wider und die Anerkennung des unabhängigen Werts dieser Produkte. (Quelle: lateinteraction)

AI-generierte Videos gewinnen Mainstream-Attraktion: Beobachtungen in sozialen Medien weisen darauf hin, dass AI-generierte Videos über Plattformen wie TikTok Mainstream-Attraktion gewinnen. Benutzer nutzen AI-Bild- und Videotools, um Charaktere zu erstellen und “Film-Universen” zu produzieren, was das Potenzial von AI in der kreativen Content-Produktion und der Massenmarktverbreitung zeigt. (Quelle: wordgrammer)

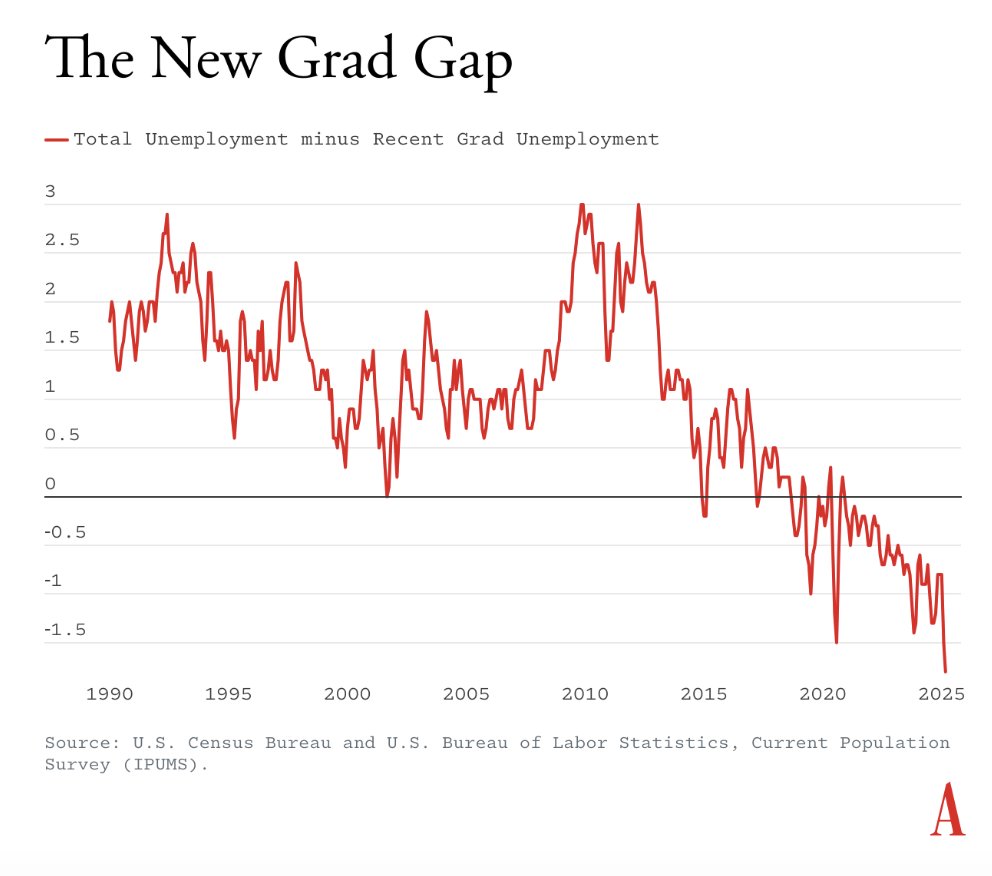

Diskussion über AI-soziale Auswirkungen und den Arbeitsmarkt: Diskussionen in sozialen Medien hinterfragen die Behauptung, dass der Anstieg der Arbeitslosigkeit von Hochschulabsolventen auf generative AI zurückzuführen ist, und argumentieren, dass die vorgelegten Diagrammdaten diese Schlussfolgerung nicht ausreichend stützen. Dies spiegelt die vorsichtige Haltung der Community gegenüber den sozialen Auswirkungen von AI und die Diskussion über Kausalität wider. (Quelle: lateinteraction)

Diskussion über AI-Modell-Deployment und API-Stabilität: Benutzer kommentieren, dass die neue Version von Google Gemini 2.5 Pro die alte Version automatisch ersetzt, und kritisieren das Fehlen einer vorherigen Deprecation-Benachrichtigung. Dies löst Diskussionen über die API-Stabilität und Versionsmanagementpraktiken von AI-Modellen aus, was die Benutzererfahrung von Entwicklern beeinflusst. (Quelle: jd_pressman)

AI-Ethik, Deepfakes und Informationsauthentizität: Die Community diskutierte das Problem der “plausiblen Abstreitbarkeit”, das durch AI-Deepfake-Technologie entstehen kann, und äußerte die Sorge, dass realistische falsche Inhalte nicht nur Fehlinformationen verbreiten, sondern auch zur Leugnung realer Handlungen verwendet werden könnten. Dies löst tiefe Bedenken hinsichtlich der AI-Ethik, Vertrauenskrisen und der Beurteilung der Informationsauthentizität aus. (Quelle: Reddit r/ArtificialInteligence)

Kontroverse um AI-Überwachungsethik und Start-up-Ökosystem: Das von YC inkubierte Unternehmen Optifye.ai stieß auf starke Kritik (“dystopisch”, “Boss-Software”) wegen eines Videos, das die AI-Überwachung der Mitarbeitereffizienz in einer Fabrik zeigte; YC löschte den Beitrag. Der Vorfall löste Diskussionen über die Ethik der AI-Überwachung, übermäßigen Hype im Start-up-Ökosystem und die YC-Auswahlkriterien aus und enthüllte potenzielle soziale Kontroversen und Herausforderungen für die Investmentbranche bei der Anwendung von AI. (Quelle: 36氪)