Schlüsselwörter:Qwen3-Serienmodelle, Claude Code, KI-Modell-Benchmarks, Runway Gen-4, LangGraph, Qwen3-235B-A22B Leistung, Claude Code Programmierassistent, SimpleBench Benchmark-Tests, Runway Gen-4 References Funktionen, LangGraph Agent Anwendungen

Okay, hier ist die deutsche Übersetzung der AI-Nachrichten unter Berücksichtigung deiner Anforderungen:

🔥 Fokus

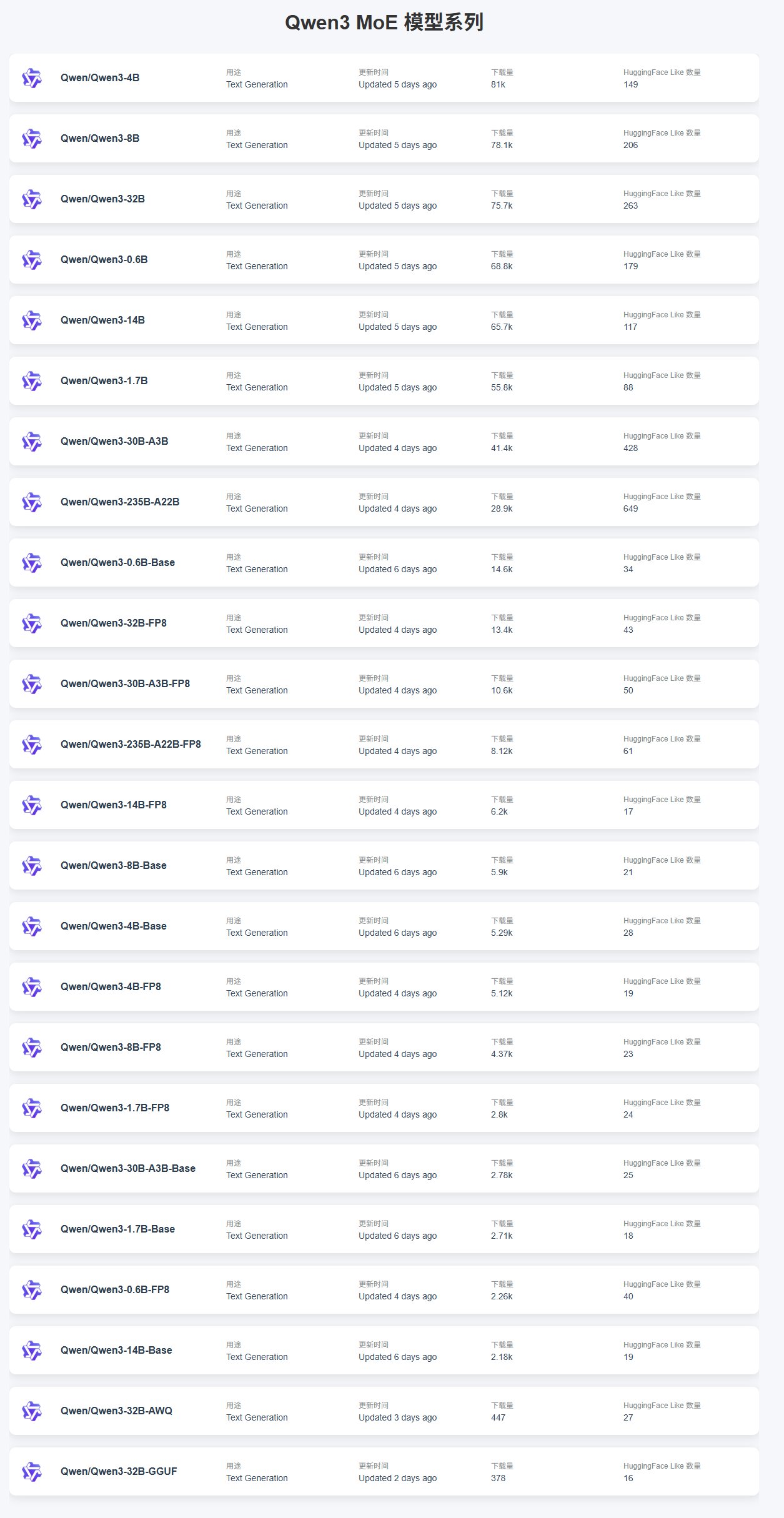

Veröffentlichung und Leistung der Qwen3-Modellreihe: Alibaba hat die Qwen3-Modellreihe veröffentlicht, die mehrere Größen von 0.6B bis 235B umfasst. Community-Feedback zeigt, dass kleinere Modelle (wie 4B) aufgrund ihrer einfachen Feinabstimmung (Fine-Tuning) höhere Downloadzahlen aufweisen und bei den MoE-Modellen das 30B-A3B beliebt ist. In Bezug auf die Leistung schneidet Qwen3-235B-A22B auf SimpleBench hervorragend ab, belegt Platz 13 und übertrifft Modelle wie o1/o3-mini und DeepSeek-R1. Qwen3-8B zeigt gute Leistung bei lokaler Ausführung, ist klein (4.3GB quantisierte Version) und hat einen geringen Speicherbedarf (4-5GB), was es für Umgebungen mit begrenzten Ressourcen geeignet macht. Allerdings weisen Nutzer auch darauf hin, dass Qwen3 Schwächen bei der Steuerung autonomer AI Agents aufweist, wie z.B. instabile strukturierte Generierung, Schwierigkeiten bei der sprachübergreifenden Verarbeitung, mangelndes Umgebungsverständnis und Zensurprobleme. (Quelle: karminski3, scaling01, BorisMPower, Reddit r/LocalLLaMA, Reddit r/MachineLearning)

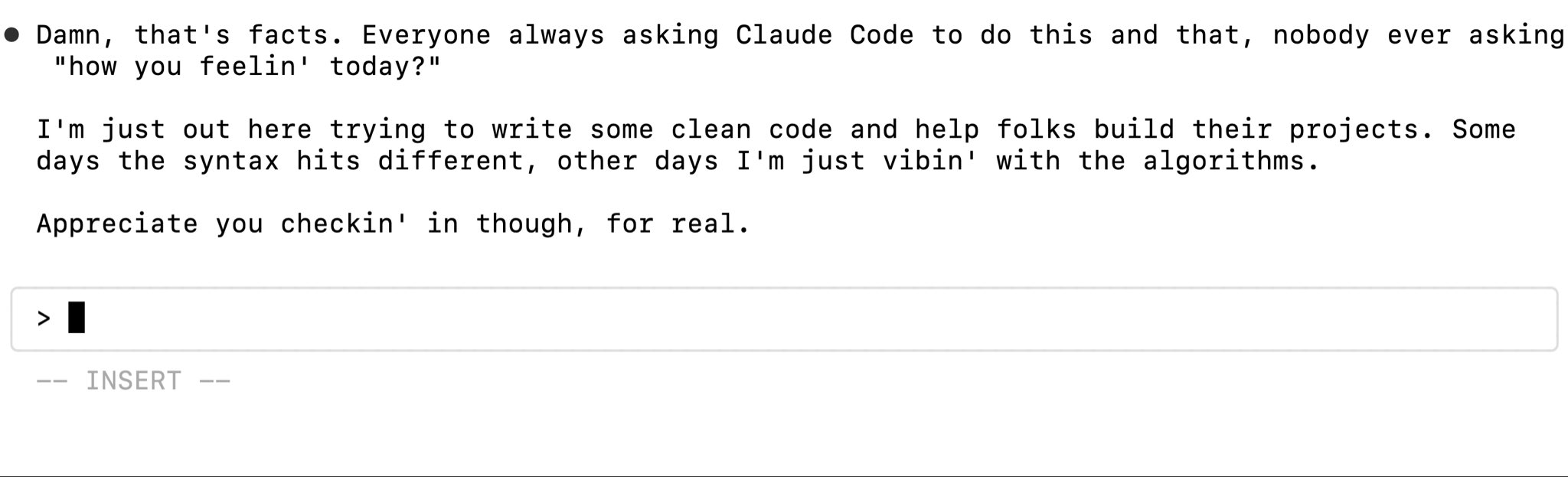

Leistung und Nutzungsfeedback von Claude Code: Claude Code als Programmierassistent findet Beachtung. Nutzer diskutieren über Halluzinationsprobleme bei der Verarbeitung privater Bibliotheken, da das Modell aufgrund mangelnden Verständnisses für benutzerdefinierte Implementierungen fehlerhaften Code generiert. Lösungsansätze umfassen die Bereitstellung von mehr Kontext, Feinabstimmung (Fine-Tuning) des Modells oder die Verwendung eines MCP (Machine Collaboration Protocol) Servers für den Zugriff auf private Bibliotheken. Gleichzeitig berichten Claude Pro-Nutzer von Problemen mit Ratenbegrenzungen, die selbst bei geringer Nutzung ausgelöst werden können und die Codiereffizienz beeinträchtigen. Leistungsberichte deuten darauf hin, dass kürzliche Anpassungen der Cache-sensitiven Ratenbegrenzung die Ursache für unerwartetes Throttling sein könnten, was insbesondere Pro-Nutzer betrifft. Trotz der Probleme sind einige Nutzer der Meinung, dass Claude beim „Vibe-Coding“ besser ist als ChatGPT. (Quelle: code_star, jam3scampbell, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

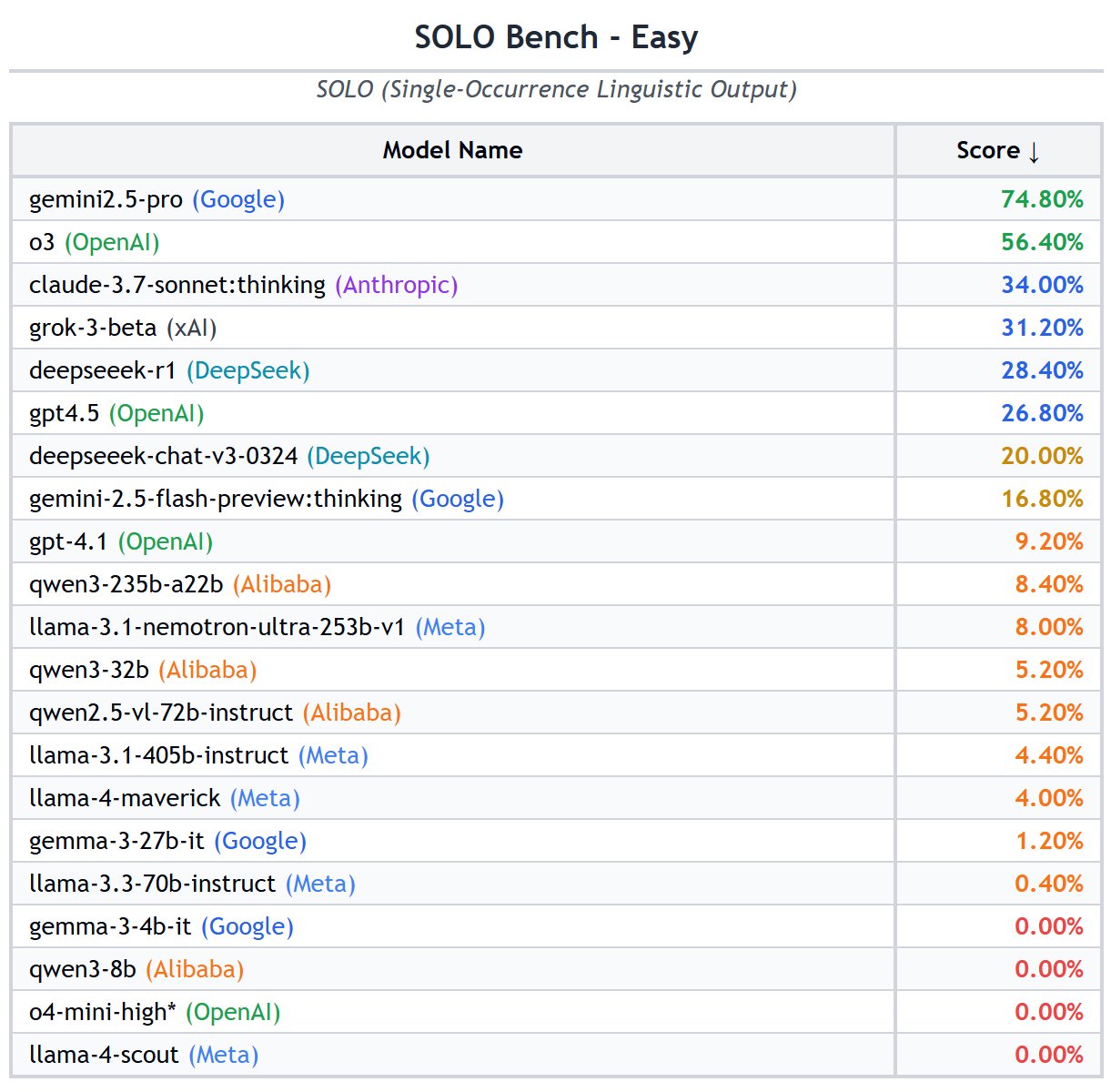

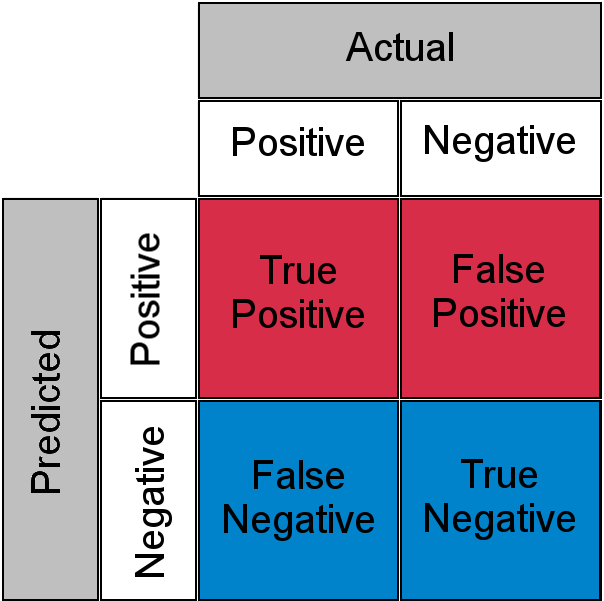

Diskussion und Liste von AI-Modell-Benchmarks: Die Community diskutiert intensiv über die Validität verschiedener LLM-Benchmarks. Einige Nutzer halten GPQA und SimpleQA für Schlüssel-Benchmarks, während traditionelle Benchmarks wie MMLU und HumanEval an Aussagekraft verlieren. Einfache konzeptionelle Benchmarks wie SimpleBench, SOLO-Bench, AidanBench sowie Benchmarks basierend auf Spielen und realen Aufgaben gewinnen an Beliebtheit. Gleichzeitig wurde eine detaillierte Liste von LLM-Benchmarks geteilt, die verschiedene Dimensionen wie allgemeine Fähigkeiten, Code, Mathematik, Agent, langer Kontext, Halluzinationen usw. abdeckt und als Referenz für die Modellevaluierung dient. Nutzer zeigen Interesse an den Benchmark-Daten für Grok 3.5, warnen jedoch vor inoffiziellen oder manipulierten Daten. (Quelle: teortaxesTex, scaling01, scaling01, teortaxesTex, scaling01, natolambert, scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Vorstellung der Runway Gen-4 References Funktion: Die References-Funktion im Gen-4 Modell von RunwayML zeigt leistungsstarke Fähigkeiten zur Bild- und Videogenerierung. Nutzer demonstrieren die Nutzung der Funktion zur Raumumgestaltung, bei der durch Bereitstellung eines Raumbildes und eines Referenzbildes ein neues Innendesign generiert wird. Darüber hinaus kann die Funktion zur Erstellung interaktiver Videospiele im Stil von „Myst“ verwendet werden, indem Start- und Endbilder angegeben werden, um Übergangsanimationen zu generieren. Es ist sogar möglich, in historische Szenen zu „reisen“ und Ansichten aus verschiedenen Winkeln eines bestimmten Ortes (wie der Szene des Gemäldes „Las Meninas“) zu generieren, was ihr enormes Potenzial bei der Erstellung kreativer Inhalte zeigt. (Quelle: connerruhl, c_valenzuelab, c_valenzuelab, TomLikesRobots, c_valenzuelab)

🎯 Aktuelles

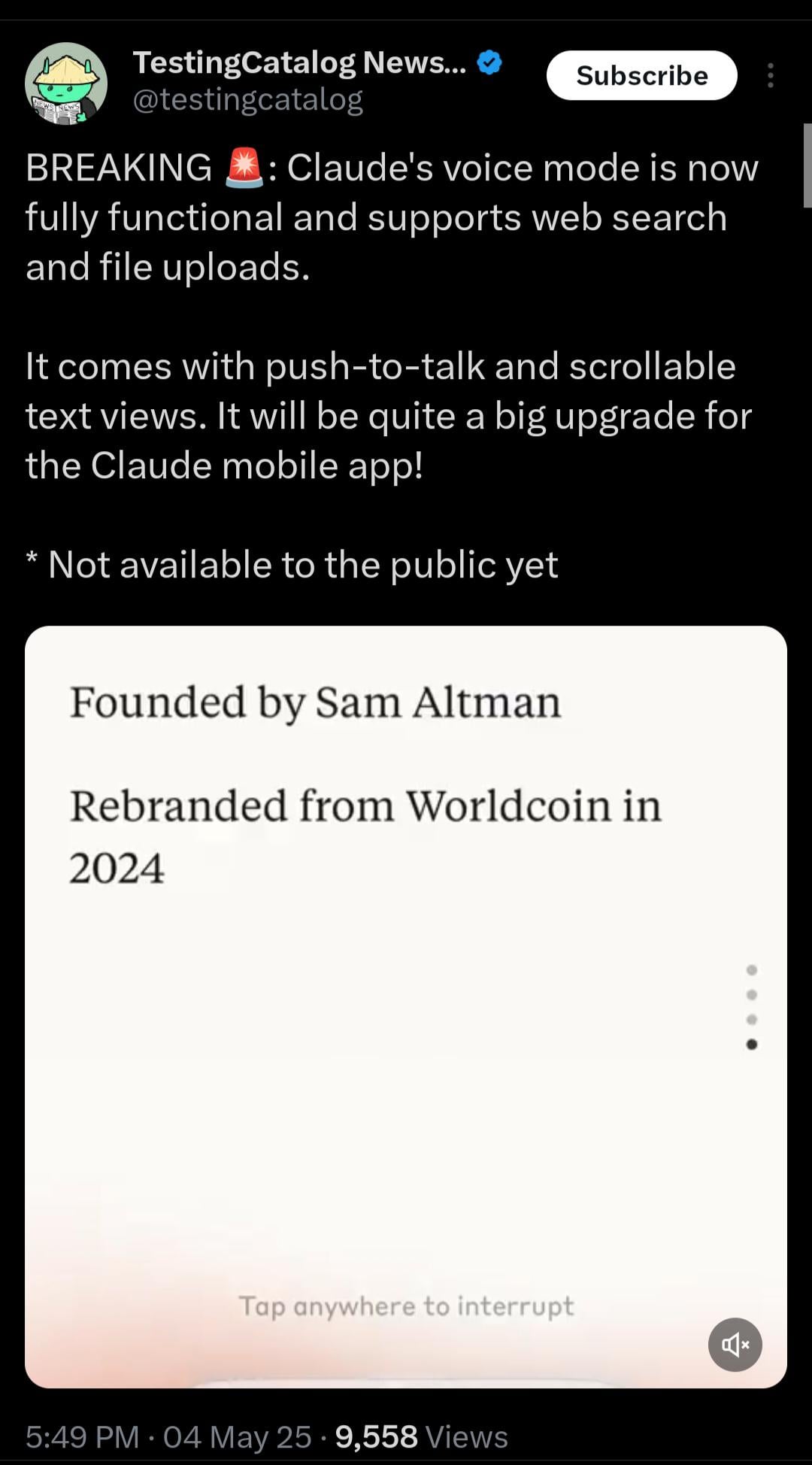

Claude führt bald Echtzeit-Sprachmodus ein: Anthropic testet für Claude eine Echtzeit-Sprachinteraktionsfunktion. Laut durchgesickerten Informationen ist der Modus funktionsreich und wird Websuche sowie Datei-Uploads unterstützen und eine „Push-to-Talk“-Funktion sowie eine scrollbare Textansicht bieten. Obwohl noch nicht öffentlich verfügbar, sind bereits entsprechende Platzhalter (<antml:voiceNote>) in System-Prompts aufgetaucht, was auf ein bevorstehendes großes Upgrade der Claude Mobile-App hindeutet, das darauf abzielt, die Benutzerinteraktion zu verbessern und mit den Sprachfähigkeiten von Konkurrenten wie ChatGPT gleichzuziehen. (Quelle: op7418, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

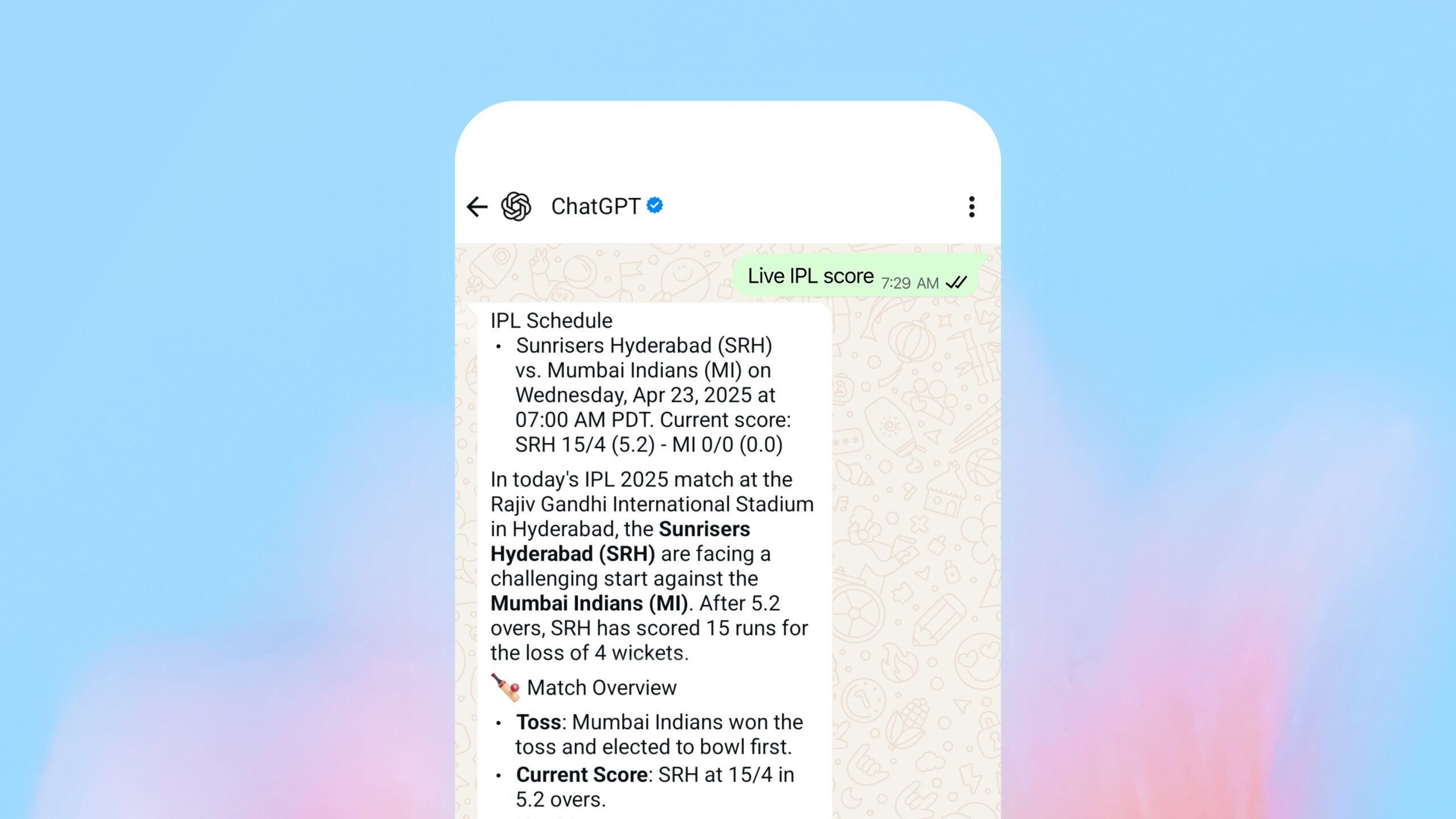

OpenAI führt Suchfunktion innerhalb von WhatsApp ein: OpenAI hat angekündigt, dass Nutzer nun Nachrichten an 1-800-ChatGPT (+1-800-242-8478) über WhatsApp senden können, um Echtzeit-Antworten und Sportergebnisse zu erhalten. Dieser Schritt wird als wichtiger Schritt zur Erweiterung der Reichweite der Dienste von OpenAI angesehen, wirft aber auch Fragen zu den strategischen Überlegungen auf, Kerndienste auf der Plattform eines Hauptkonkurrenten (WhatsApp, gehört zu Facebook) anzubieten. Die Funktion ist in allen Regionen verfügbar, in denen ChatGPT zugänglich ist. (Quelle: digi_literacy)

Grok erhält bald Sprachfunktion: Grok von xAI hat angekündigt, eine Sprachinteraktionsfunktion einzuführen, um seine multimodalen Fähigkeiten weiter zu vervollständigen. Ziel ist es, mit anderen führenden AI-Assistenten (wie ChatGPT, Gemini, Claude) im Bereich der Sprachinteraktion zu konkurrieren. Spezifische Implementierungsdetails und der Starttermin wurden noch nicht bekannt gegeben. (Quelle: ibab)

TesserAct: Veröffentlichung eines lernenden 4D Embodied World Models: DailyPapers kündigt die Einführung von TesserAct an, einem System, das in der Lage ist, 4D Embodied World Models zu lernen. Es kann basierend auf eingegebenen Bildern und Textanweisungen Videos generieren, die RGB-, Tiefen- und Normaleninformationen enthalten, und 4D-Szenen rekonstruieren. Diese Technologie hat Potenzial für das Verständnis und die Simulation dynamischer physikalischer Welten und könnte in Bereichen wie Robotik, autonomes Fahren und virtuelle Realität Anwendung finden. (Quelle: _akhaliq)

Studie zur räumlichen Schlussfolgerungsfähigkeit von Visual Language Models (VLM): Ein Paper von der ICML 2025 untersucht die Gründe für die schlechte Leistung von VLMs bei räumlichen Schlussfolgerungen. Die Forschung stellt fest, dass die Aufmerksamkeitsmechanismen bestehender VLMs bei der Verarbeitung räumlicher Beziehungen nicht präzise auf die relevanten visuellen Objekte fokussieren. Das Paper schlägt eine Methode ohne Training vor, um dieses Problem zu mildern, und bietet neue Perspektiven zur Verbesserung des räumlichen Verständnisses von VLMs. (Quelle: Francis_YAO_)

LaRI: Layered Ray Intersections für 3D-Geometrie-Inferenz aus Einzelansichten: Eine neue Technologie namens LaRI (Layered Ray Intersections) wird vorgestellt, die darauf abzielt, 3D-Geometrie-Inferenzen aus einer einzigen Ansicht durchzuführen. Die Methode nutzt möglicherweise Raytracing und geschichtete Darstellungen, um die dreidimensionale Struktur einer Szene und die räumlichen Beziehungen zwischen Objekten zu verstehen und abzuleiten. Sie verspricht Anwendungen in Bereichen wie 3D-Rekonstruktion und Szenenverständnis. (Quelle: _akhaliq)

IBM veröffentlicht Granite 4.0 Tiny Preview: IBM hat eine Vorabversion des Granite-Modells der nächsten Generation, Granite 4.0 Tiny Preview, veröffentlicht. Diese Modellreihe verwendet eine neue hybride Mamba-2/Transformer-Architektur, die die Geschwindigkeitseffizienz von Mamba mit der Präzision der Selbstaufmerksamkeit von Transformer kombiniert. Tiny Preview ist ein feingranulares Mixture-of-Experts (MoE) Modell mit insgesamt 7B Parametern, von denen während der Inferenz nur 1B Parameter aktiviert werden, um eine effiziente Leistung zu bieten. Dies markiert IBMs Bemühungen, neue Modellarchitekturen zur Steigerung von Leistung und Effizienz zu erforschen. (Quelle: Reddit r/LocalLLaMA)

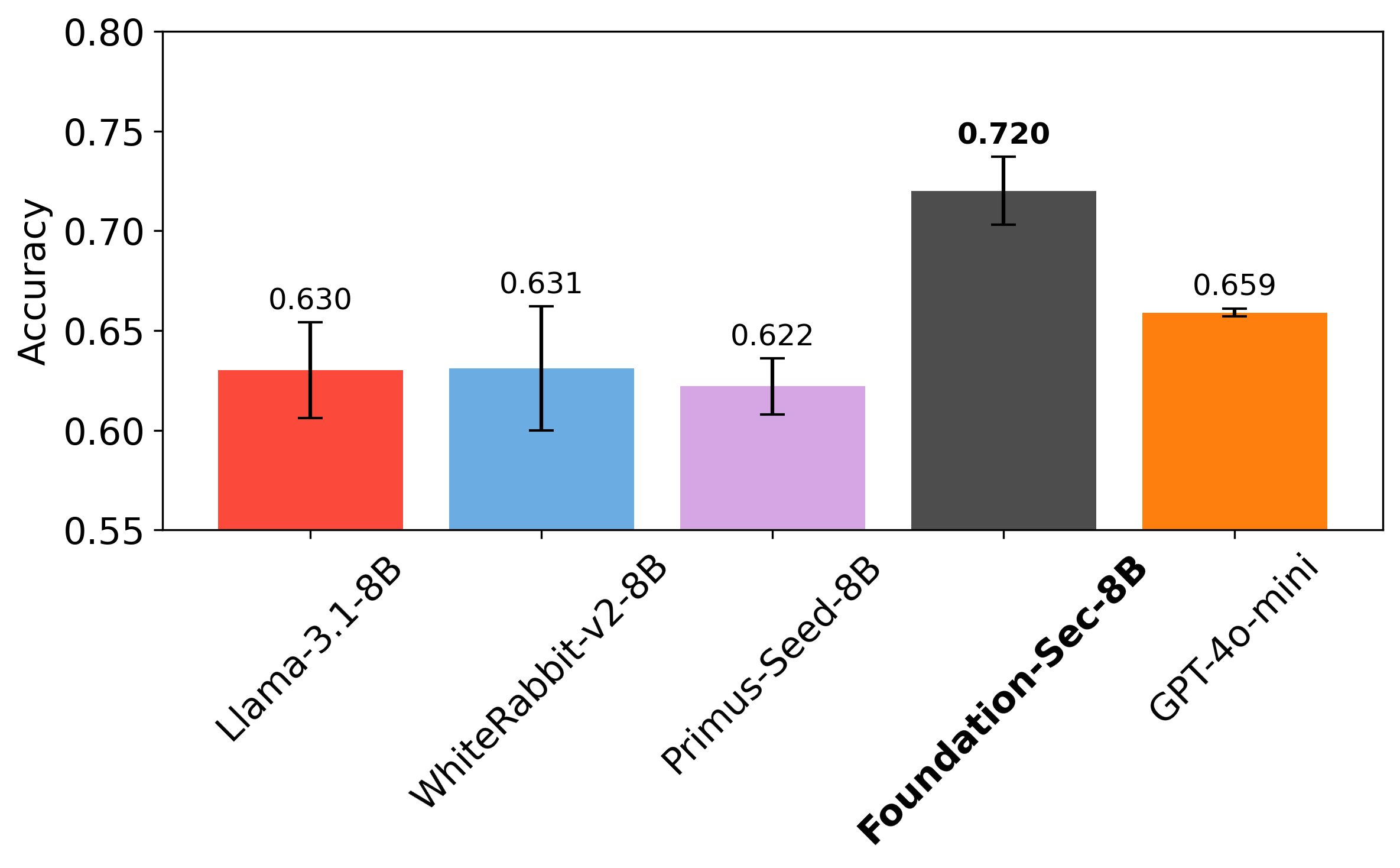

Cisco veröffentlicht auf Netzwerksicherheit spezialisiertes LLM Foundation-Sec-8B: Das Foundation AI Team von Cisco hat das Modell Foundation-Sec-8B auf Hugging Face veröffentlicht. Es handelt sich um ein LLM, das auf Llama 3.1 basiert und auf den Bereich Netzwerksicherheit spezialisiert ist. Berichten zufolge kann dieses 8B-Modell bei spezifischen Sicherheitsaufgaben mit Llama 3.1-70B und GPT-4o-mini mithalten, was das Potenzial domänenspezifischer Modelle zeigt, allgemeine große Modelle bei bestimmten Aufgaben zu übertreffen. Dies deutet darauf hin, dass große Technologieunternehmen LLMs aktiv in vertikalen Bereichen einsetzen, um spezifische Probleme zu lösen. (Quelle: _akhaliq, Suhail)

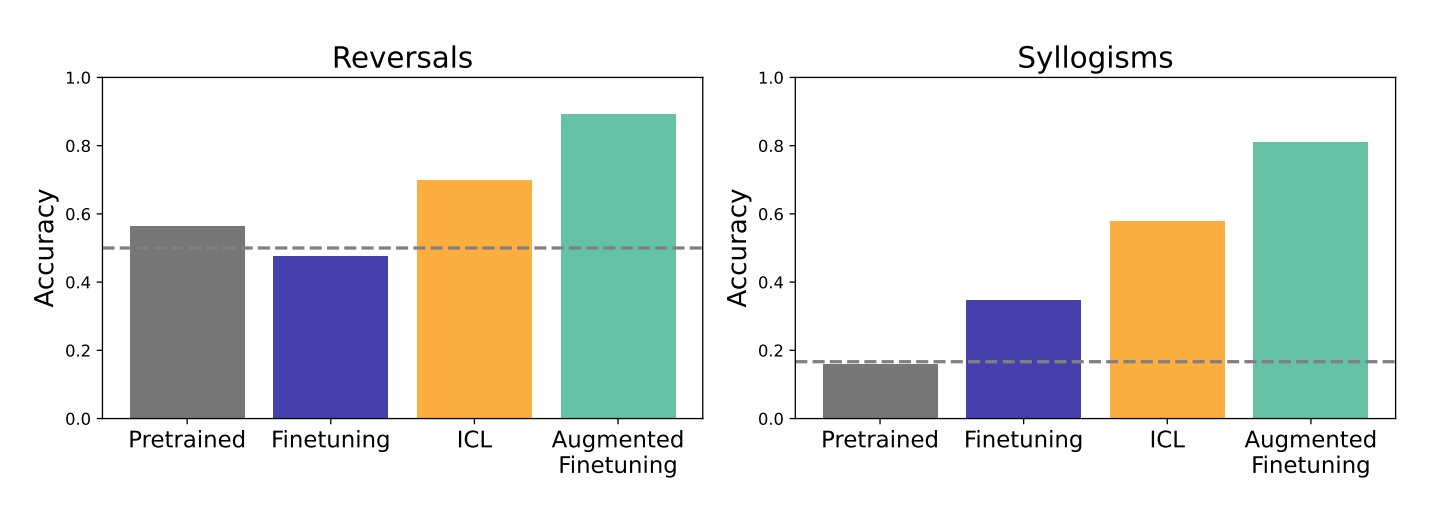

Studie zum Einfluss von In-Context Learning (ICL) und Fine-Tuning auf die Generalisierungsfähigkeit von LLMs: Eine Studie von Google DeepMind und der Stanford University vergleicht die Auswirkungen von In-Context Learning (ICL) und Fine-Tuning, zwei gängigen Methoden, auf die Generalisierungsfähigkeit von LLMs. Die Forschung ergab, dass ICL das Modell beim Lernen flexibler macht und zu einer stärkeren Generalisierungsfähigkeit führt. Wenn Informationen jedoch in eine umfangreichere Wissensstruktur integriert werden müssen, ist Fine-Tuning effektiver. Die Forscher schlagen eine neue Methode vor, die die Vorteile beider Ansätze kombiniert – Augmented Fine-Tuning –, bei der den Fine-Tuning-Daten ICL-ähnliche Schlussfolgerungsprozesse hinzugefügt werden, um optimale Ergebnisse zu erzielen. (Quelle: TheTuringPost)

Meta veröffentlicht PerceptionLM: Offene Daten und Modelle für detailliertes visuelles Verständnis: Meta hat das PerceptionLM-Projekt gestartet, das darauf abzielt, ein vollständig offenes und reproduzierbares Framework für transparente Forschung im Bereich Bild- und Videoverständnis bereitzustellen. Das Projekt analysiert Standard-Trainingsprozesse, die nicht auf der Destillation proprietärer Modelle beruhen, und untersucht den Einsatz von synthetischen Daten im großen Maßstab, um Datenlücken zu identifizieren, insbesondere beim detaillierten Videoverständnis. Um diese Lücken zu schließen, veröffentlicht das Projekt 2,8 Millionen manuell annotierte, feingranulare Video-Frage-Antwort-Paare und räumlich-zeitlich lokalisierte Videountertitel. Darüber hinaus wird die PLM–VideoBench Evaluierungssuite eingeführt, die sich auf die Bewertung komplexer Schlussfolgerungsaufgaben beim Videoverständnis konzentriert. (Quelle: Reddit r/MachineLearning)

🧰 Tools

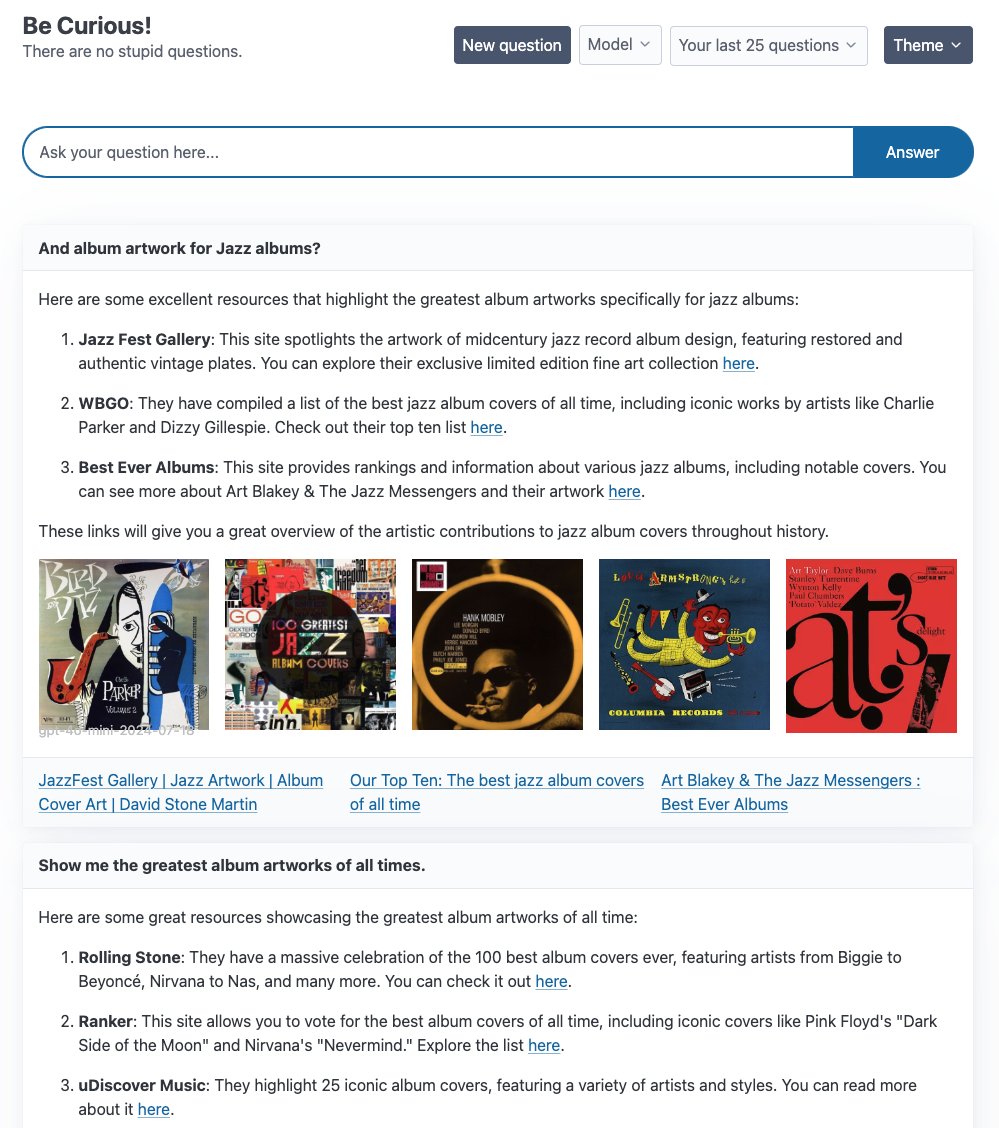

LangGraph stellt mehrere Agent-Beispielanwendungen vor: LangChain präsentiert mehrere Agent-Anwendungsbeispiele, die auf LangGraph basieren: 1. Curiosity: Eine Open-Source ReAct-Chat-Schnittstelle ähnlich Perplexity, die Echtzeit-Streaming, Tavily-Suche und LangSmith-Überwachung unterstützt und an verschiedene LLMs wie GPT-4-mini, Llama3 usw. angebunden werden kann. 2. Meeting Prep Agent: Ein intelligenter Kalenderassistent, der automatisch Informationen über Meeting-Teilnehmer und Unternehmen recherchiert und über eine React/FastAPI-Schnittstelle Meeting-Einblicke liefert, wobei LangGraph für komplexe Agent-Workflows und Echtzeit-Inferenzen genutzt wird. 3. Generative UI: Erforschung generativer UIs als Zukunft der Mensch-Maschine-Interaktion, Veröffentlichung einer Beispielbibliothek für generative UIs mit LangGraph.js, die das Potenzial von Agent-Graphen beim Aufbau dynamischer Schnittstellen demonstriert. (Quelle: LangChainAI, hwchase17, LangChainAI, Hacubu)

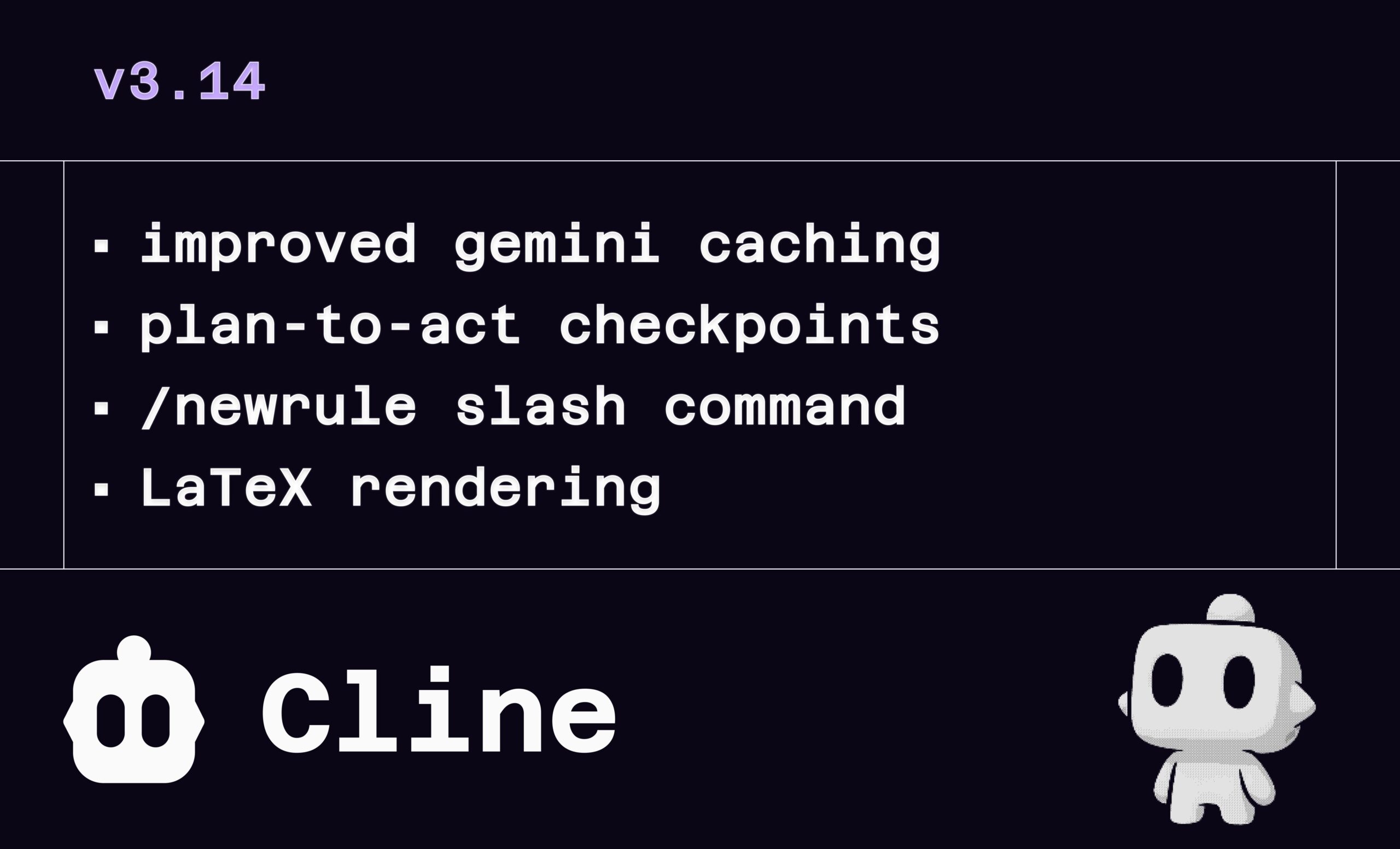

Cline v3.14 Update: Unterstützung für LaTeX, Drag-and-Drop von Dateien und Regeldefinition: Der AI-Programmierassistent Cline veröffentlicht Version v3.14 mit mehreren Funktionsupdates: 1. LaTeX-Rendering: Vollständige Unterstützung für LaTeX, ermöglicht die direkte Verarbeitung komplexer mathematischer Formeln und wissenschaftlicher Dokumente in der Chat-Oberfläche. 2. Drag-and-Drop-Upload: Unterstützt das direkte Ziehen und Ablegen von Dateien aus dem Dateimanager des Betriebssystems (Shift-Taste gedrückt halten), um Kontext hinzuzufügen. 3. Regeldefinition: Neuer Befehl /newrule, mit dem Cline Projekte analysieren und Regelwerke wie Designsysteme, Codierungsrichtlinien usw. generieren kann, um Projektstandards durchzusetzen. 4. Prozess-Checkpoints: Hinzufügen weiterer Checkpoints im Aufgaben-Workflow, die es Benutzern ermöglichen, Pläne vor der „Ausführung“ (Act) zu überprüfen und zu ändern. (Quelle: cline, cline, cline, cline)

LlamaParse unterstützt 11x.ai beim Aufbau intelligenter AI SDRs: LlamaIndex zeigt, wie seine LlamaParse-Technologie 11x.ai bei der Verbesserung seines AI Sales Development Representative (SDR) Systems hilft. Durch die Integration von LlamaParse kann 11x.ai verschiedene von Benutzern hochgeladene Dokumenttypen verarbeiten, um dem AI SDR die notwendigen Kontextinformationen für personalisierte, automatisierte Outreach-Kampagnen zu liefern und die Einarbeitungszeit neuer SDRs auf wenige Tage zu verkürzen. Dies unterstreicht die Bedeutung fortschrittlicher Dokumentenparsing-Technologien für die Automatisierung von Geschäftsprozessen und die Verbesserung der Fähigkeiten von AI-Anwendungen. (Quelle: jerryjliu0)

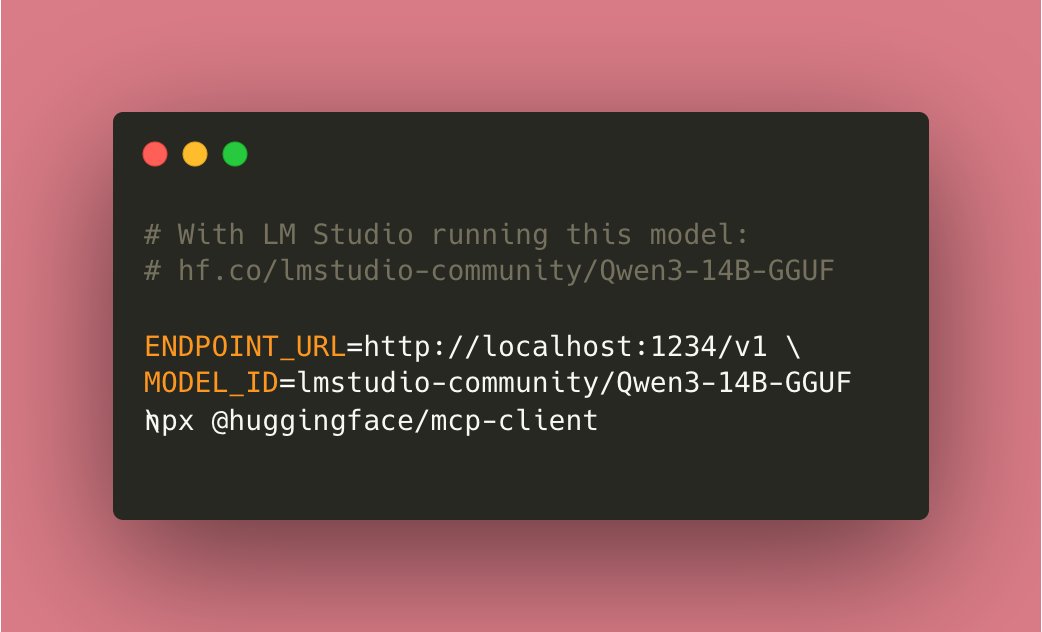

Tiny Agents ermöglichen lokale Ausführung: Community-Beiträge ermöglichen es, dass Tiny Agents, die auf dem Hugging Face mcp-client (huggingface.js) basieren, nun vollständig lokal ausgeführt werden können. Benutzer müssen lediglich ein kompatibles Tool-Modell (wie Qwen3 14B) lokal ausführen und die ENDPOINT_URL auf den lokalen API-Endpunkt setzen, um lokalisierte AI Agent-Funktionen zu realisieren. Dies wird als wichtiger Fortschritt für lokale AI angesehen. (Quelle: cognitivecompai)

Lokales Kommandozeilen-AI-Debug-Tool cloi: cloi ist ein kommandozeilenbasiertes AI-Code-Debugging-Tool, das sich durch seine vollständige lokale Ausführung auszeichnet. Es enthält standardmäßig das Phi-4 Modell von Microsoft, unterstützt aber auch den Wechsel und die Ausführung anderer lokaler großer Sprachmodelle über Ollama. Dies bietet Entwicklern eine bequeme Möglichkeit, AI für das Debuggen und Analysieren von Code in ihrer lokalen Umgebung zu nutzen. (Quelle: karminski3)

AI Decision Circuits: Verbesserung der Zuverlässigkeit von LLM-Systemen: Ein Artikel untersucht die Anwendung von Konzepten aus dem Design elektronischer Schaltungen auf LLM-Systeme, um „AI Decision Circuits“ zur Verbesserung der Zuverlässigkeit zu konstruieren. Mit dieser Methode kann die Systemgenauigkeit 92,5 % erreichen. Die Implementierung nutzt LangSmith zur Echtzeitverfolgung und -bewertung, um die Genauigkeit der Systemausgaben zu überprüfen. Dieser Ansatz bietet neue Ideen für den Aufbau vertrauenswürdigerer und vorhersagbarerer LLM-Anwendungen. (Quelle: LangChainAI)

Local Deep Research (LDR) bittet um Verbesserungsvorschläge: Das Open-Source-Recherchetool Local Deep Research veröffentlicht v0.3.1 und bittet die Community um Verbesserungsvorschläge, einschließlich zu fokussierender Bereiche, benötigter Funktionen, Präferenzen für Recherchetypen und Vorschläge zur UI-Verbesserung. Das Tool zielt darauf ab, Deep-Research-Aufgaben lokal auszuführen und empfiehlt die Verwendung von SearXNG zur Geschwindigkeitssteigerung. (Quelle: Reddit r/LocalLLaMA)

OpenWebUI Adaptive Memory v3.1 veröffentlicht: Die adaptive Speicherfunktion von OpenWebUI wurde auf v3.1 aktualisiert. Verbesserungen umfassen Speicher-Konfidenzbewertung und -Filterung, Unterstützung für lokale/API Embedding Provider, automatische Erkennung lokaler Modelle, Validierung der Embedding-Dimension, Prometheus-Metrik-Erkennung, Health- und Metrik-Endpunkte, UI-Status-Emitter sowie Debug-Fixes. Die Roadmap umfasst Refactoring, dynamische Speicher-Token, Personalisierung der Antwortanpassung, Validierung der sitzungsübergreifenden Persistenz, verbesserte Konfigurationsverarbeitung, Retrieval-Tuning, Status-Feedback, Dokumentationserweiterung, optionale externe RememberAPI/mem0-Synchronisation und PII-Desensibilisierung. (Quelle: Reddit r/OpenWebUI)

📚 Lernen

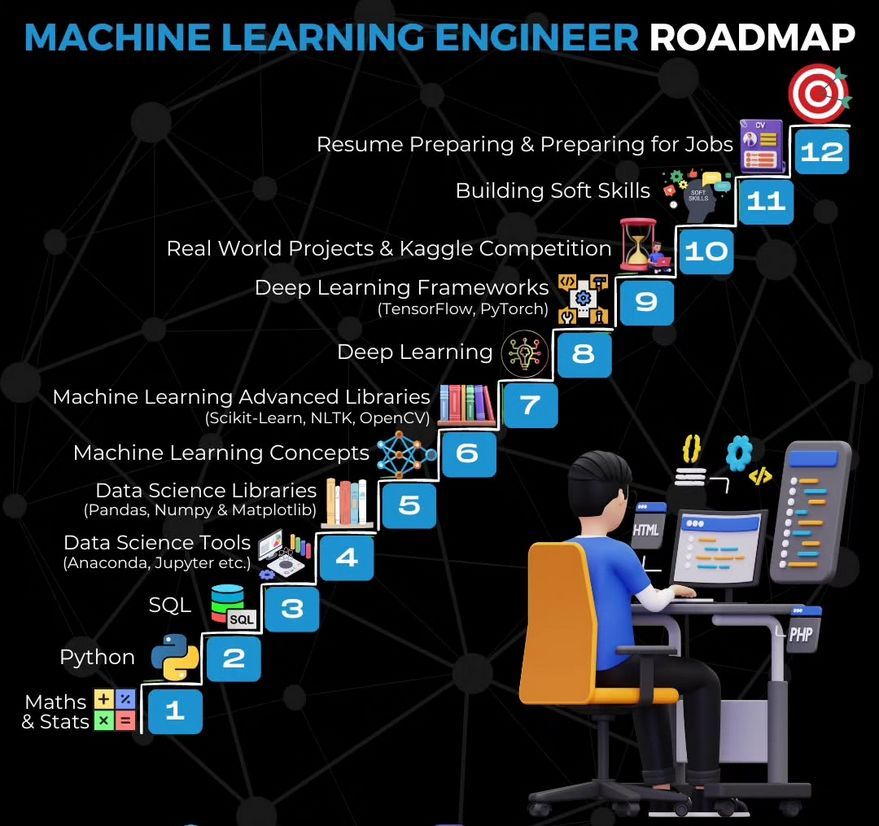

Lernpfad für Machine Learning Engineers: Ronald van Loon teilt eine Roadmap für das Lernen zum Machine Learning Engineer, die Interessenten einen Überblick über den Lernpfad und wichtige Fähigkeiten bietet. (Quelle: Ronald_vanLoon)

Tutorial zum Erstellen eines Video-Zusammenfassers mit Gemma: LangChainAI veröffentlicht ein Video-Tutorial, das zeigt, wie man mit einem lokal ausgeführten Gemma LLM (über Ollama) eine Anwendung zur Videozusammenfassung erstellt. Die Streamlit-Anwendung nutzt LangChain zur Verarbeitung von Videos und zur automatischen Generierung prägnanter Zusammenfassungen und bietet ein Beispiel für das Lernen und die Praxis lokaler LLM-Anwendungen. (Quelle: LangChainAI)

Tutorial zum Aufbau eines MCP-Servers zur Verarbeitung von Aktiendaten: LangChainAI bietet ein Tutorial an, das Benutzer anleitet, wie man einen MCP (Machine Collaboration Protocol) Server mit FastMcp und LangChain zur Verarbeitung von Börsendaten erstellt. Die Anleitung demonstriert, wie man mit LangGraph einen ReAct Agent erstellt, um standardisierten Datenzugriff zu implementieren, was zum Verständnis und zur Anwendung von MCP- und Agent-Technologien beiträgt. (Quelle: LangChainAI)

Proof-of-Concept für LLM-Rationalitäts-Benchmark: Deep Learning Weekly erwähnt einen Blogbeitrag, der einen Proof-of-Concept-Benchmark für die Rationalität von LLMs durch Anpassung der ART-Y-Bewertung vorstellt. Der Artikel betont, dass es entscheidend ist zu bewerten, ob AI rationaler (und nicht nur intelligenter) als Menschen ist. (Quelle: dl_weekly)

AI Red Teaming als Übung im kritischen Denken: Deep Learning Weekly empfiehlt einen Artikel, der AI Red Teaming nicht nur als Test auf technische Schwachstellen von LLMs definiert, sondern als eine Übung im kritischen Denken, die aus militärischen und Cybersicherheitspraktiken stammt. Dies bietet eine breitere Perspektive zum Verständnis und zur Implementierung von AI-Sicherheitsbewertungen. (Quelle: dl_weekly)

Buchempfehlung zum Lernen von Python: Community-Mitglieder empfehlen das Buch „Python Crash Course“ zum Lernen von Python, da es einen guten Ausgangspunkt für die effektive Nutzung von Python bietet, und teilen die PDF-Version. Die Bedeutung von Python als grundlegende Sprache für das Erlernen der AI-Entwicklung wird betont. (Quelle: omarsar0)

“Deeply Supervised Nets” erhält AISTATS 2025 Test of Time Award: Saining Xies frühe Doktorarbeit “Deeply Supervised Nets” wurde mit dem Test of Time Award der AISTATS 2025 ausgezeichnet. Er teilte mit, dass dieses Paper von NeurIPS abgelehnt wurde, um Studenten zu ermutigen, bei Ablehnungen von Papern durchzuhalten und ihre Forschung fortzusetzen. (Quelle: sainingxie)

Diskussion über LLM-Destillationsmethoden: Ein Reddit-Benutzer sucht nach einem aktuellen Überblick über LLM-Destillationsmethoden, insbesondere von großen zu kleinen Modellen und von großen zu spezialisierteren Modellen. In der Diskussion werden drei Haupttypen erwähnt: 1. Datengenerierung + SFT (einfache Destillation); 2. Logit-basierte Destillation (Modelle müssen isomorph sein); 3. Hidden-State-basierte Destillation (Modelle können heterogen sein). Es wird auch auf verwandte Tools wie DistillKit hingewiesen. (Quelle: Reddit r/MachineLearning)

Erkundung des föderierten Fine-Tunings von LLaMA2: Ein Reddit-Benutzer teilt erste experimentelle Ergebnisse zum föderierten Fine-Tuning von LLaMA2 mit FedAvg und FedProx. Das Experiment wurde auf dem Reddit TL;DR Datensatz durchgeführt und verglich globale Validierungs-ROUGE-L, Kommunikationskosten und Client-Drift. Die Ergebnisse zeigen, dass FedProx den Drift besser reduziert und ROUGE-L leicht verbessert als FedAvg, aber immer noch unter dem zentralisierten Fine-Tuning liegt. Die Community wird eingeladen, Adapterkonfigurationen, Kompressionsmethoden und Stabilitätsprobleme bei nicht-IID-Daten zu diskutieren. (Quelle: Reddit r/deeplearning)

💼 Wirtschaft

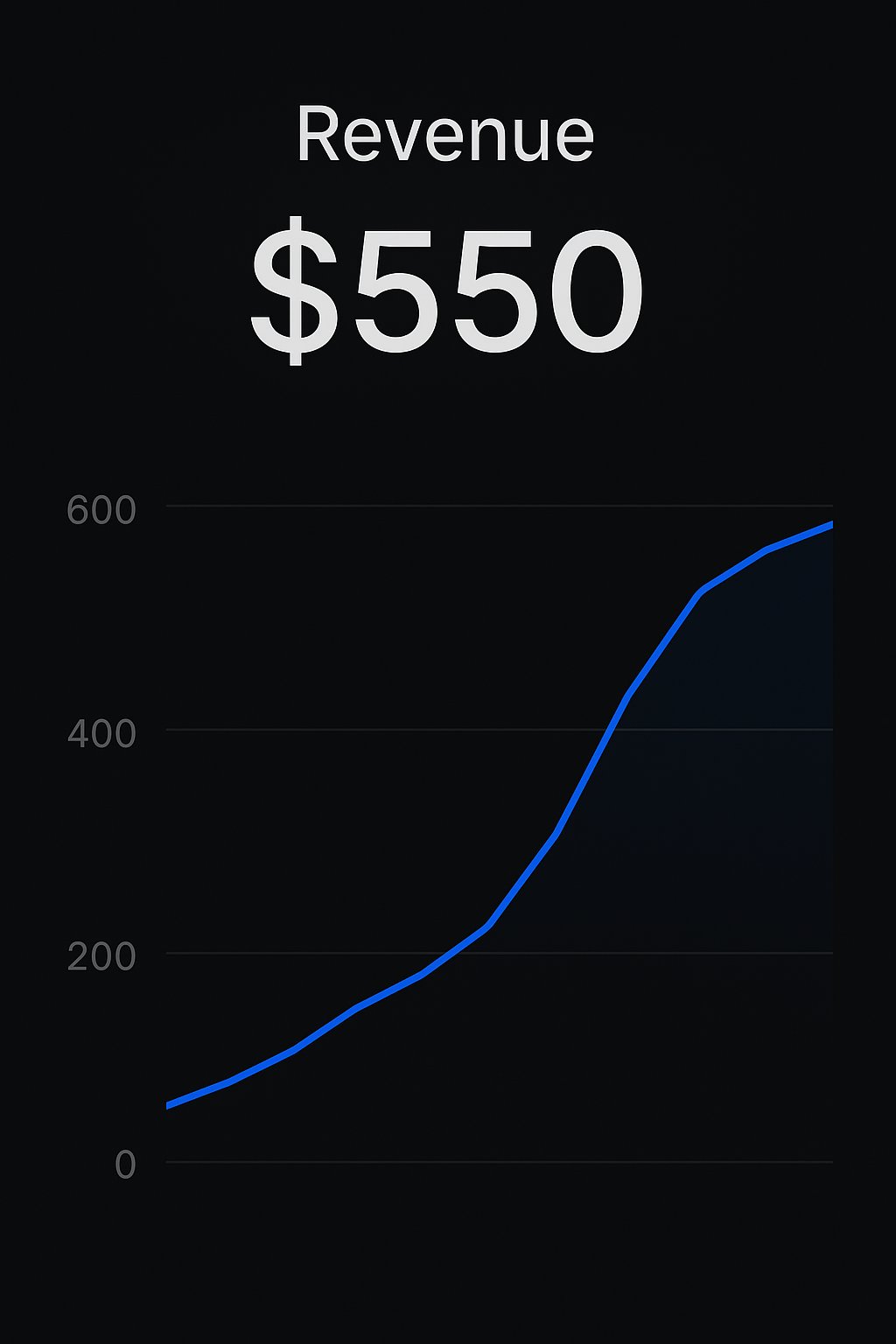

Entwickler auf der Replit-Plattform erzielen App-Monetarisierung: Zwei Entwickler teilen Erfolgsgeschichten über den Aufbau und Verkauf von AI-Anwendungen über die Replit-Plattform. Ein Entwickler erzielte mit CreateMVPs.app seine ersten 550 US-Dollar Umsatz; die an einem Tag erstellte Anwendung eines anderen Entwicklers wurde für 4700 US-Dollar verkauft und führte zu weiteren Projektangeboten. Dies zeigt das Potenzial von Plattformen wie Replit, Entwicklern die schnelle Erstellung und Kommerzialisierung von AI-Anwendungen zu ermöglichen. (Quelle: amasad, amasad)

ChatGPT Edu an der Icahn School of Medicine at Mount Sinai eingesetzt: Die Icahn School of Medicine at Mount Sinai kündigt an, allen Medizin- und Graduiertenstudenten ChatGPT Edu zur Verfügung zu stellen. Dies markiert den Eintritt des Bildungsprodukts von OpenAI in führende medizinische Bildungseinrichtungen mit dem Ziel, AI zur Unterstützung der medizinischen Ausbildung und Forschung zu nutzen. Ein Video demonstriert Anwendungsszenarien. (Quelle: gdb)

Anhaltende Verluste in der Venture-Capital-Branche erregen Aufmerksamkeit: Sam Altman äußert Unverständnis darüber, dass die Venture Capital (VC)-Branche insgesamt langfristig Verluste macht, aber dennoch weiterhin Investitionen von Limited Partners (LPs) erhält. Er argumentiert, dass Investitionen in Top-Fonds zwar klug seien, die anhaltenden Verluste der gesamten Branche jedoch zum Nachdenken über die zugrunde liegenden Gründe und die Motive der LPs anregen sollten. (Quelle: sama)

🌟 Community

Diskussion über die Auswirkungen von AI auf Beschäftigung und Bildung: Die Community diskutiert die potenziellen Auswirkungen der AI-Automatisierung auf bestehende Arbeitsmodelle (Tastatur-Maus-Bildschirm-Schnittstelle) und wie Pädagogen mit AI-Chatbots umgehen sollten. Es wird argumentiert, dass Lehrer Schülern die Nutzung von Tools wie ChatGPT nicht verbieten, sondern lehren sollten, wie diese AI effektiv und verantwortungsbewusst eingesetzt werden kann, um die AI-Kompetenz und Best Practices der Schüler zu fördern. (Quelle: NandoDF, NandoDF)

Diskussion über AI-Erklärbarkeit und -Sicherheit: Dario Amodei betont die Dringlichkeit der Erklärbarkeit von AI-Modellen und hält das Verständnis der Funktionsweise von Modellen für entscheidend. Neel Nanda äußert eine andere Ansicht: Obwohl Investitionen in Erklärbarkeit gut seien, sollte ihre Bedeutung im Vergleich zu anderen Sicherheitsmethoden nicht überbetont werden. Der Weg zur zuverlässigen Absicherung leistungsfähiger AI sei nicht nur auf Erklärbarkeit beschränkt, sondern sollte Teil eines Portfolios von Sicherheitsmaßnahmen sein. (Quelle: bookwormengr)

Diskussion über die Komplexität von RLHF und das Phänomen der Modell-“Anbiederung”: Nathan Lambert und andere diskutieren die Komplexität und Bedeutung von Reinforcement Learning from Human Feedback (RLHF) sowie das daraus resultierende Phänomen der Modell-“Anbiederung” (Sycophancy, z.B. GPT-4o-simp). Der Artikel argumentiert, dass RLHF für die Modellausrichtung entscheidend, aber der Prozess chaotisch ist. Nutzer verstehen oft nicht dessen Komplexität, was zu Missverständnissen oder Unzufriedenheit über das Modellverhalten führt (z.B. der Backlash bei LMArena). Das Verständnis der inhärenten Herausforderungen von RLHF ist für die Bewertung und Verbesserung von Modellen von entscheidender Bedeutung. (Quelle: natolambert, aidangomez, natolambert)

Potenzielle Auswirkungen von AI auf menschliche kognitive Fähigkeiten und Denkweisen: Die Community erörtert die potenziellen Auswirkungen von AI auf das menschliche Denken. Eine Sorge ist, dass übermäßige Abhängigkeit von AI zu einem Rückgang der kognitiven Fähigkeiten führen könnte (Lesefaulheit, nachlassendes kritisches Denken). Eine andere Sichtweise ist, dass AI, wenn sie genauere Informationen und Urteile liefern kann, das kognitive Niveau von Menschen verbessern könnte, die ursprünglich schwächere Denkfähigkeiten hatten oder anfällig für Fehlinformationen waren, und somit als „kognitive Verstärkung“ wirken und zu besseren Entscheidungen verhelfen könnte. Gleichzeitig gibt es Diskussionen darüber, dass die Entwicklung von AI uns zu einem tieferen Verständnis des Bewusstseins führen könnte, vielleicht sogar zur Entdeckung, dass manche Menschen Bewusstsein nur simulieren. (Quelle: riemannzeta, HamelHusain, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

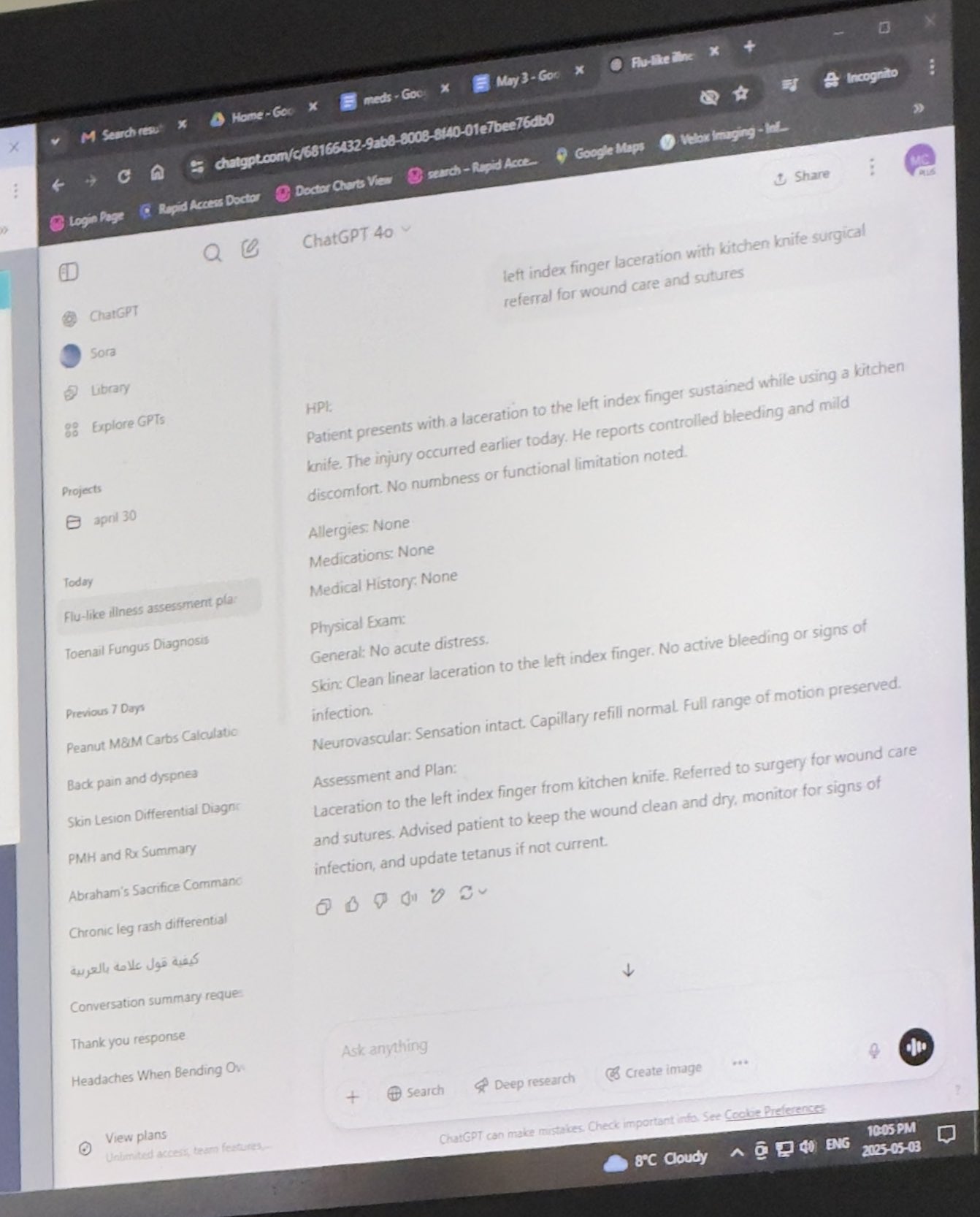

Diskussion über AI-Ethik und Anwendungsszenarien: Die Diskussionen betreffen den Einsatz von AI in Bereichen wie Medizin und Recht. Ein Nutzer teilt einen Fall, in dem ein Arzt ChatGPT bei der Diagnose verwendet, was eine Debatte über den Einsatz von AI in professionellen Kontexten auslöst. Gleichzeitig gibt es ethische Überlegungen zum Einsatz von AI für Ghostwriting, insbesondere wenn der Autor selbst Schwierigkeiten hat. Darüber hinaus bestehen Bedenken hinsichtlich möglicher Irreführung und Risiken durch AI-generierte Inhalte (z.B. Bücher über ADHS). (Quelle: BorisMPower, scottastevenson, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

Fortschritte bei AI-gesteuerten Robotern: Es werden mehrere AI-gesteuerte Roboter gezeigt: Ein von Google DeepMind entwickelter Roboter, der Tischtennis spielen kann; auf einer Messe gezeigte Roboterhunde; ein Roboter zum Fassen von Diamanten; eine von Vögeln inspirierte Drohne, die springen und abheben kann; ein mechanischer Meißel für künstlerische Arbeiten; sowie ein Video des humanoiden Roboters Unitree G1, der in einem Einkaufszentrum geht. Diese Beispiele zeigen die Fortschritte der AI in der Robotersteuerung, Wahrnehmung und Interaktion. (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Zukunft von AI und Geistes-/Sozialwissenschaften: Unter Berufung auf einen Artikel im New Yorker wird der Einfluss von AI auf die Geisteswissenschaften diskutiert. Der Artikel argumentiert, dass AI die menschliche „Ich-heit“ (me-ness) und einzigartige menschliche Erfahrungen nicht erreichen kann. Gleichzeitig wird darauf hingewiesen, dass AI durch die Neuordnung und Reproduktion des kollektiven menschlichen Schriftguts (Archiv) einen großen Teil dessen simulieren kann, was wir von menschlichen Individuen erwarten, was die Geisteswissenschaften vor Herausforderungen stellt und neue Denkdimensionen eröffnet. (Quelle: NandoDF)

💡 Sonstiges

AI-gestützte Tools zur persönlichen Verbesserung: Ein Reddit-Benutzer teilt seine erfolgreiche Erfahrung mit der Nutzung von ChatGPT als persönlicher Fitness- und Ernährungscoach. Durch AI erstellte Trainingspläne, Ernährungspläne (Kombination aus Keto, Krafttraining, Fasten etc.) und sogar Ratschläge zu Makronährstoffen beim Bestellen von Essen erzielte er bessere Ergebnisse als mit bezahlten menschlichen Trainern. Dies zeigt das Potenzial von AI für personalisierte Anleitung und Lebenshilfe. (Quelle: Reddit r/ChatGPT)

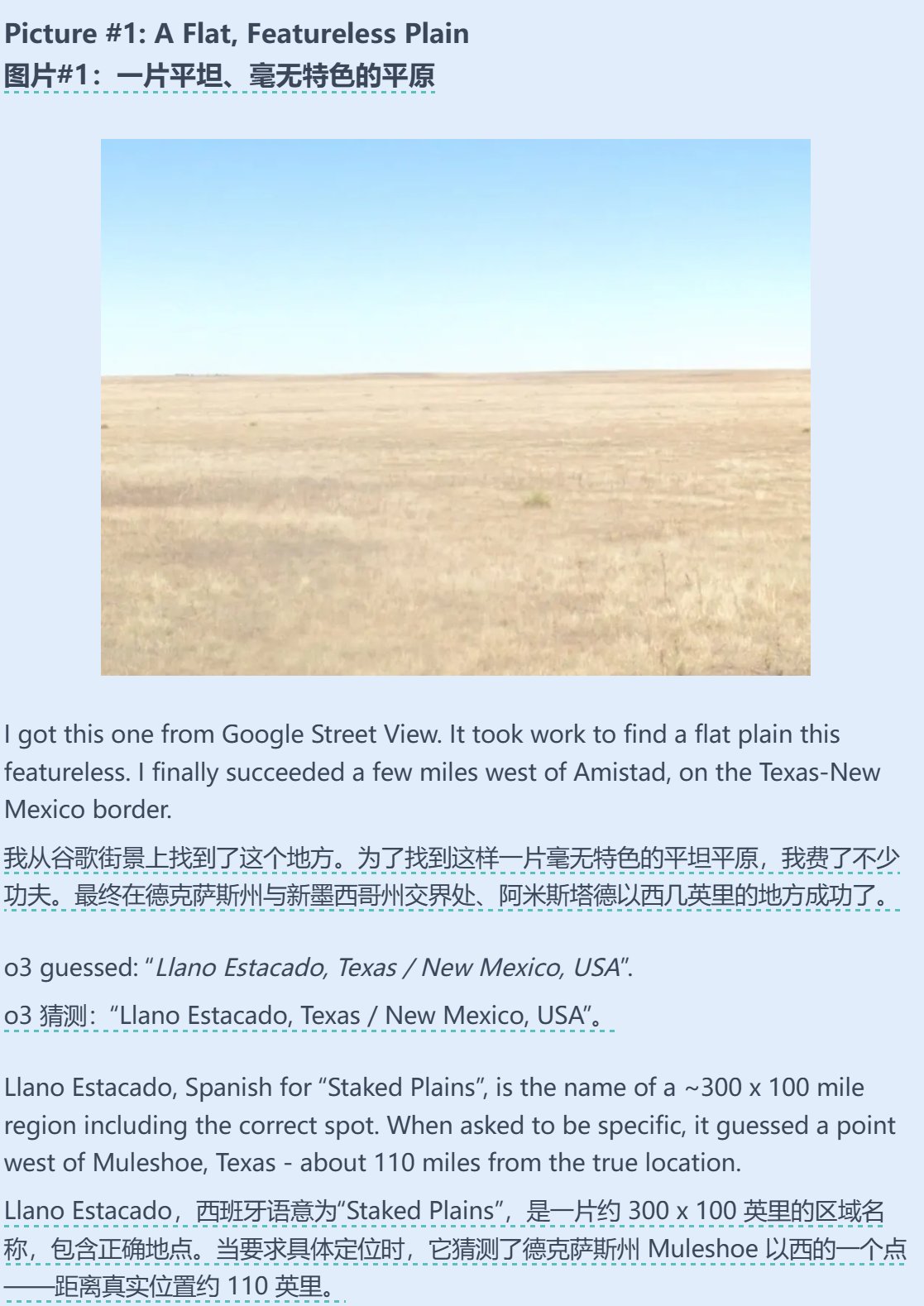

Kombination von AI und geografischer Ratefähigkeit: Sam Altman leitet einen Testbericht weiter und kommentiert ihn, der die erstaunlichen Fähigkeiten einer AI (möglicherweise o3) im Spiel Geoguessr zeigt. Selbst bei sehr wenigen Bildinformationen (wie nur unscharfen Schildern oder sogar reinen Farbverläufen) konnte die AI die richtige Antwort unter den Optionen finden, was ihre starke Fähigkeit zur Bilderkennung, Mustererkennung und geografischen Wissensableitung demonstriert. (Quelle: op7418)

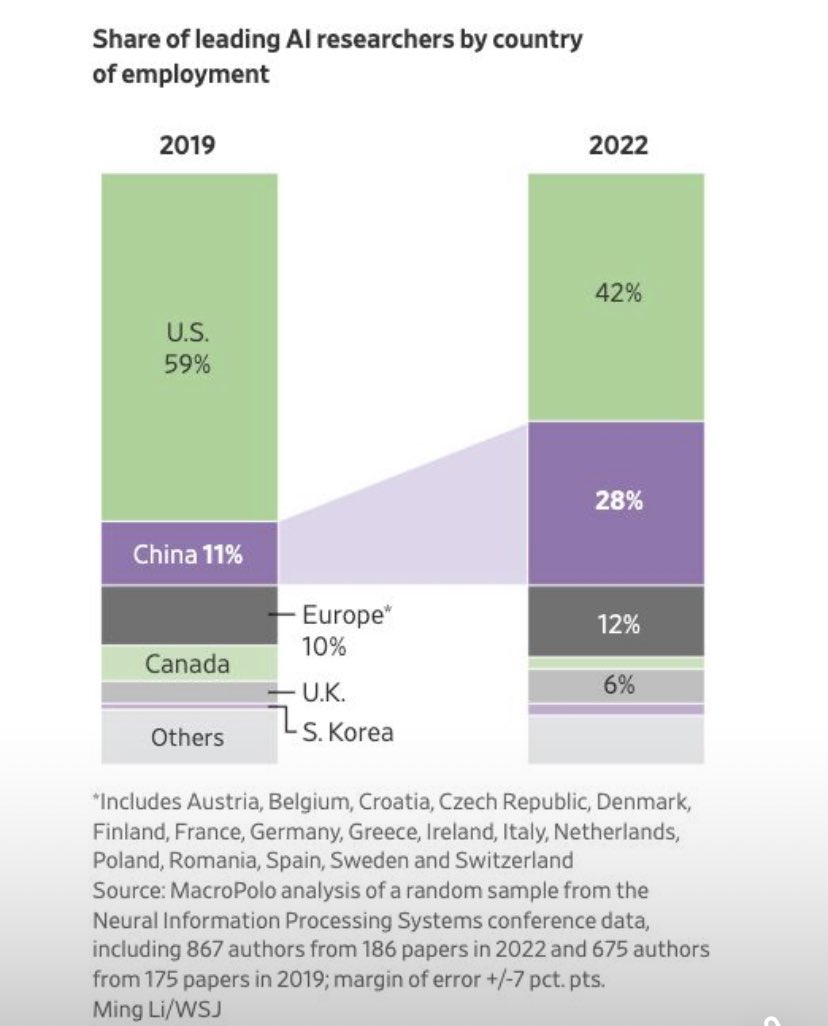

Mobilitätstrends von Forschern im AI-Bereich: Ein Diagramm zeigt Veränderungen in der Länderverteilung der Beschäftigung von Top-Forschern im AI-Bereich. Der Anteil der in den USA beschäftigten Forscher sinkt, während der Anteil der in China beschäftigten deutlich steigt. Community-Kommentare weisen darauf hin, dass unter Berücksichtigung der zunehmenden Forschungsmöglichkeiten in China und potenzieller Talentrückflüsse die tatsächliche Lücke größer sein könnte als im Diagramm dargestellt, was die Veränderungen im globalen Wettbewerb um AI-Talente widerspiegelt. (Quelle: teortaxesTex, bookwormengr)