Schlüsselwörter:LLM-Interaktionsschnittstelle, AGI-Debatte, Gemini-App-Strategie, KI-Begleiter-Ethik, Qwen3-Modell, RAG-Technologie, Transformer-Ersatzarchitektur, KI-Modellveröffentlichung, Karpathy-visuelle Interaktionsschnittstelle, Agentic-RAG-Kernelemente, Liquid-Foundation-Models-Architektur, Phi-4-Reasoning-Trainingsmethode, NotebookLM-Systemprompt-Reverse-Engineering

Okay, hier ist die deutsche Übersetzung der AI-Nachrichten unter Beachtung deiner Vorgaben:

🔥 Fokus

Karpathys Vision für zukünftige LLM-Interaktionsschnittstellen: Karpathy prognostiziert, dass die zukünftige Interaktion mit LLMs über das aktuelle Textterminal-Modell hinausgehen und sich zu visuellen, generativen, interaktiven 2D-Canvas-Schnittstellen entwickeln wird. Diese Schnittstellen werden je nach Benutzeranforderung in Echtzeit generiert, integrieren verschiedene Elemente wie Bilder, Diagramme, Animationen und bieten eine informationsdichtere, intuitivere Erfahrung, ähnlich den Darstellungen in Science-Fiction-Werken wie “Iron Man”. Er betrachtet aktuelle Formate wie Markdown und Codeblöcke nur als frühe Vorläufer (Quelle: karpathy)

Heftige Debatte darüber, ob AGI ein entscheidender Meilenstein ist: Arvind Narayanan und Sayash Kapoor argumentieren auf AI Snake Oil ausführlich über das Konzept der AGI (Artificial General Intelligence) und vertreten die Ansicht, dass es sich dabei weder um einen klaren technologischen Meilenstein noch um einen Wendepunkt handelt. Der Artikel argumentiert aus verschiedenen Blickwinkeln – wirtschaftliche Auswirkungen (Verbreitung braucht Zeit), Geopolitik (Fähigkeit bedeutet nicht Macht), Risiken (Unterscheidung zwischen Fähigkeit und Macht), Definitionsdilemma (rückblickende Beurteilung) –, dass selbst das Erreichen einer bestimmten AGI-Fähigkeitsschwelle nicht sofort disruptive wirtschaftliche oder soziale Effekte auslösen würde. Eine übermäßige Fokussierung auf AGI könnte von den tatsächlichen aktuellen Problemen der KI ablenken (Quelle: random_walker, random_walker, random_walker, random_walker, random_walker)

Leiter von Google DeepMind erläutert die Strategie der Gemini App: Demis Hassabis teilt und unterstützt die Ausführungen von Josh Woodward zur zukünftigen Strategie der Gemini App. Diese Strategie basiert auf drei Kernpunkten: Personalisierung (Personal), durch Integration von Nutzerdaten aus dem Google-Ökosystem (Gmail, Photos etc.), um einen Service zu bieten, der den Nutzer besser versteht; Proaktivität (Proactive), indem Bedürfnisse vorhergesehen und Einblicke sowie Handlungsvorschläge geliefert werden, bevor der Nutzer fragt; Leistungsfähigkeit (Powerful), durch Nutzung von DeepMind-Modellen (wie 2.5 Pro) für Forschung, Orchestrierung und multimodale Inhaltserstellung. Ziel ist es, einen leistungsstarken persönlichen KI-Assistenten zu schaffen, der sich wie eine Erweiterung des Nutzers anfühlt (Quelle: demishassabis)

Metas Entwicklung von KI-Begleitern löst ethische und soziale Diskussionen aus: Mark Zuckerberg erwähnte in einem Interview, dass Meta KI-Freunde/-Begleiter entwickelt, um soziale Bedürfnisse zu befriedigen (erwähnte: “Der durchschnittliche Amerikaner hat 3 Freunde, braucht aber 15”). Dieser Plan löste breite Diskussionen aus. Einerseits könnte er einsamen Menschen Trost spenden, andererseits weckt er Bedenken hinsichtlich ethischer Fragen, ob dies die echte soziale Interaktion weiter untergraben, die soziale Atomisierung verschärfen und Datenschutzprobleme aufwerfen könnte (Quelle: Reddit r/artificial, dwarkesh_sp, nptacek)

🎯 Trends

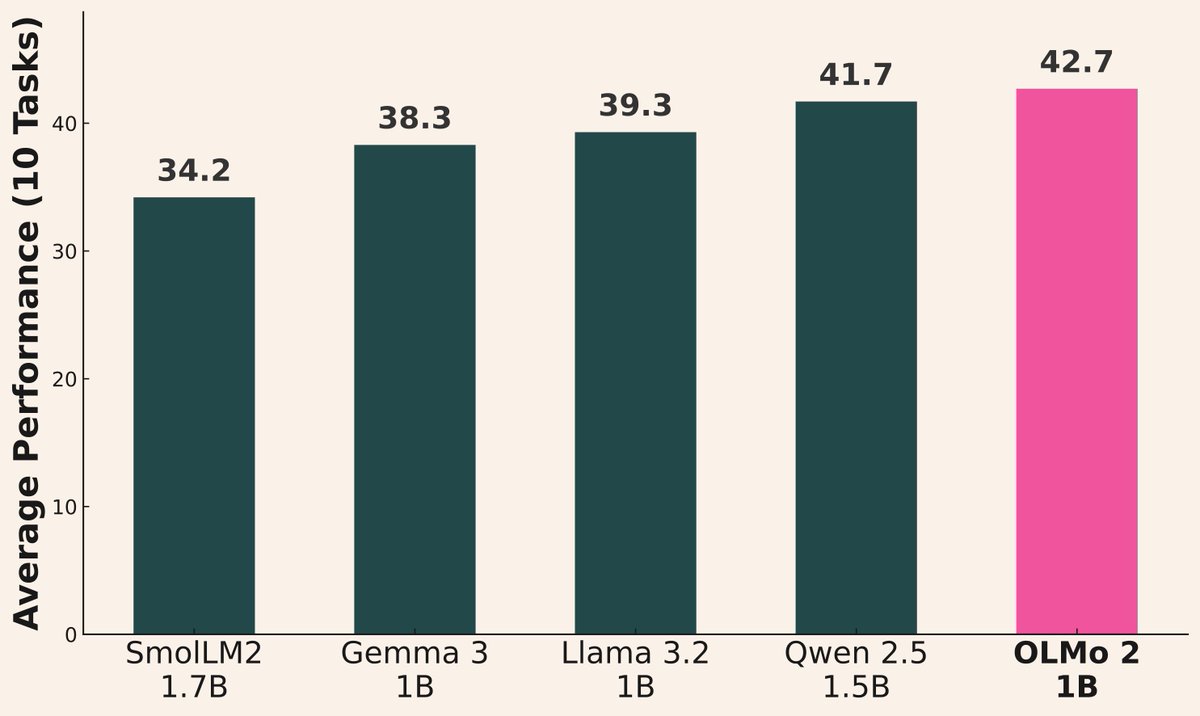

Welle von KI-Modellveröffentlichungen hält an: Kürzlich haben mehrere Institutionen neue Modelle veröffentlicht: Alibaba veröffentlichte die Qwen3-Serie (einschließlich 0.6B bis 235B MoE); AI2 veröffentlichte das OLMo 2 1B Modell, das Gemma 3 1B und Llama 3.2 1B übertrifft; Microsoft veröffentlichte die Phi-4-Serie (Mini 3.8B, Reasoning 14B); DeepSeek veröffentlichte Prover V2 671B MoE; Xiaomi veröffentlichte MiMo 7B; Kyutai veröffentlichte Helium 2B; JetBrains veröffentlichte das Mellum 4B Code-Vervollständigungsmodell. Die Fähigkeiten der Open-Source-Community-Modelle verbessern sich weiterhin rasant (Quelle: huggingface, teortaxesTex, finbarrtimbers, code_star, scaling01, ClementDelangue, tokenbender, karminski3)

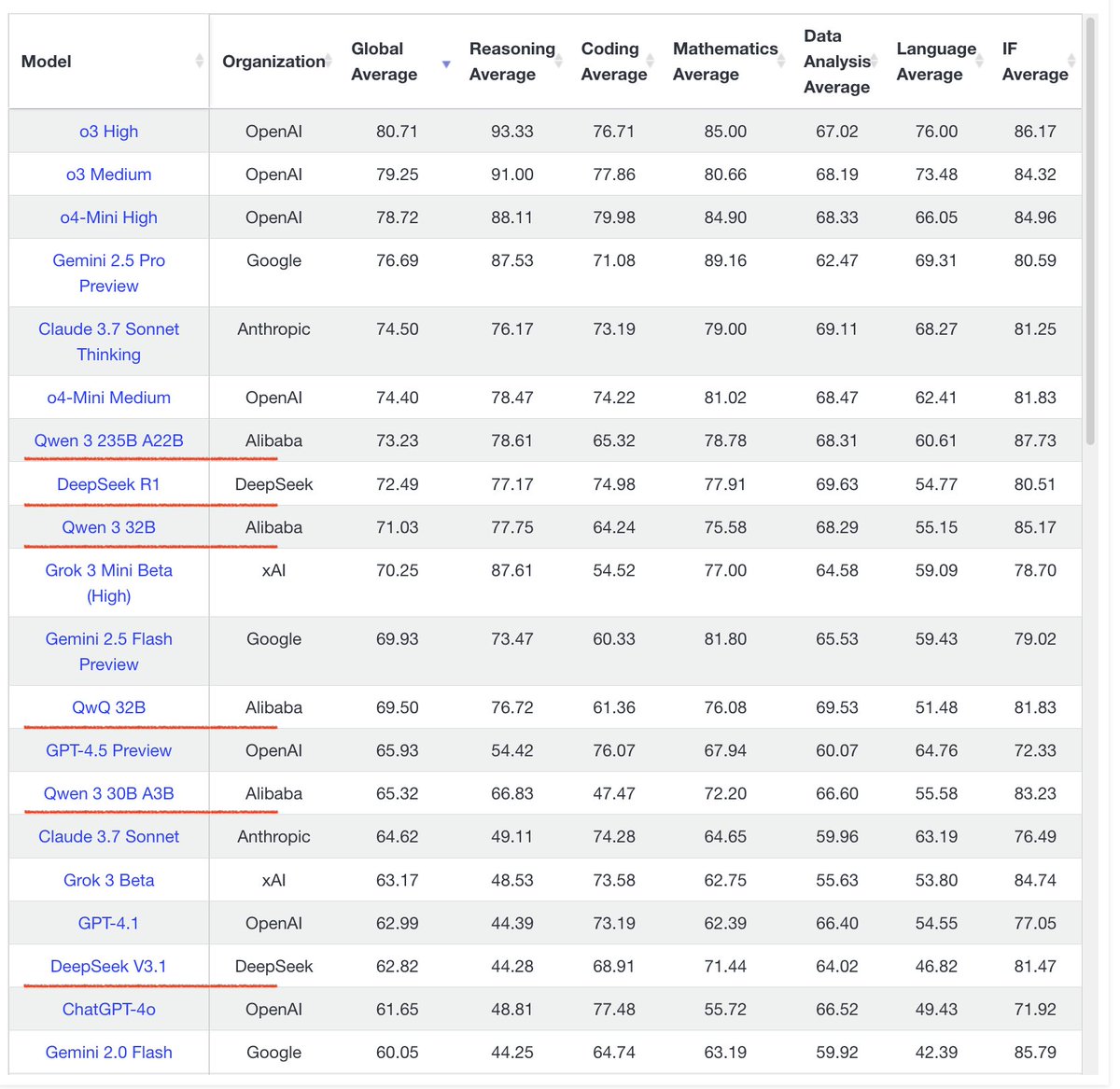

Qwen3-Modellreihe zeigt beeindruckende Leistung: Community-Feedback zeigt, dass die Qwen3-Modellreihe eine hervorragende Leistung erbringt. Qwen3 32B wird als auf dem Niveau von o3-mini angesehen, jedoch kostengünstiger; Qwen3 4B zeigt in spezifischen Tests (wie dem Zählen von ‘R’ in “strawberry”) und RAG-Aufgaben herausragende Leistungen und wird von Nutzern sogar als Ersatz für Gemini 2.5 Pro verwendet; das 30B MoE-Modell zeichnet sich durch seine Fähigkeiten bei mehrsprachigen Übersetzungen (einschließlich Dialekten) aus. Ein Nutzer beobachtete, dass Qwen3 235B MoE seine Wissensgrenzen zugibt, wenn es keine Antwort geben kann, anstatt zu halluzinieren, was auf Verbesserungen im Umgang mit Halluzinationen hindeuten könnte (Quelle: scaling01, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, teortaxesTex, scaling01)

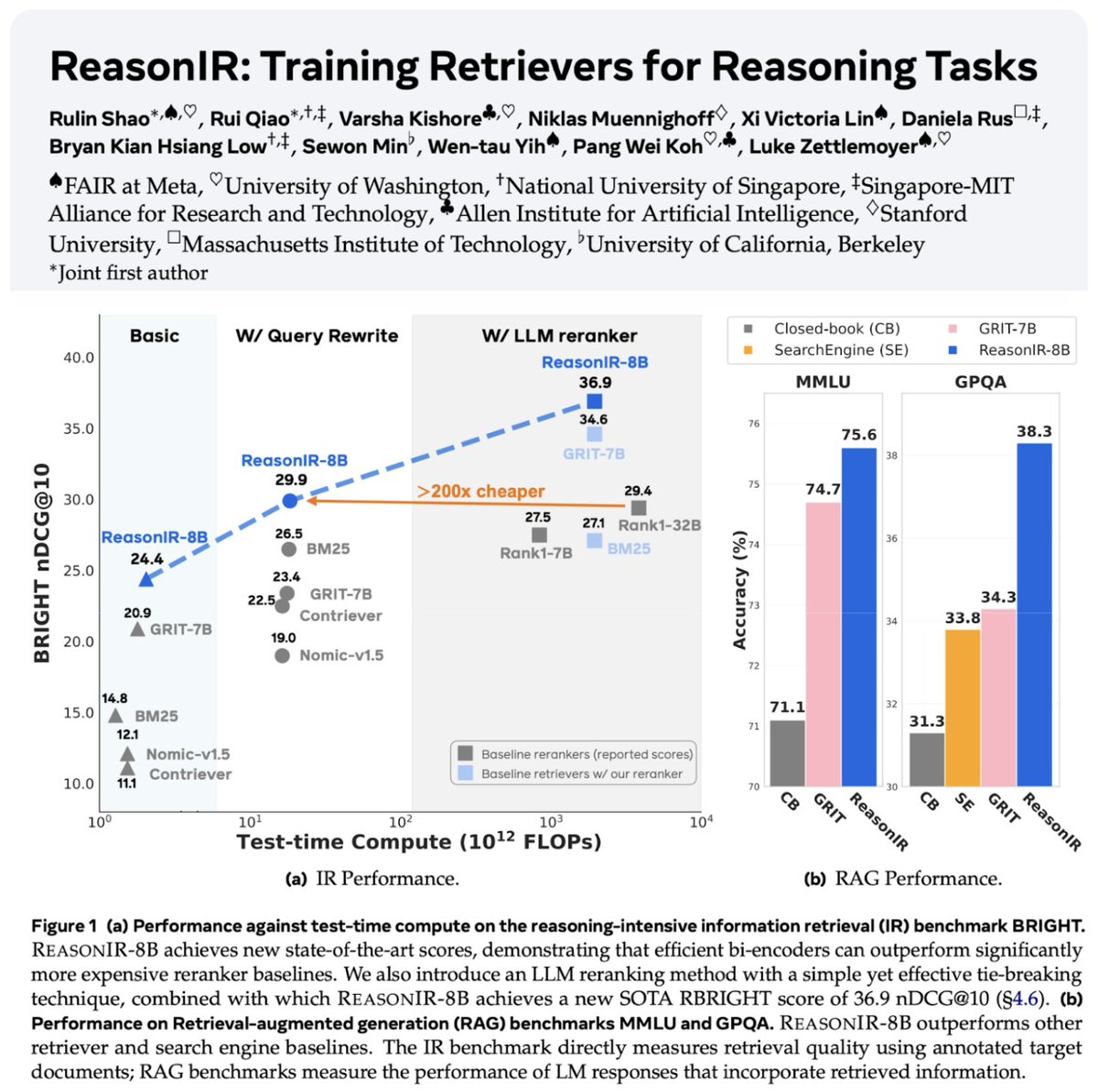

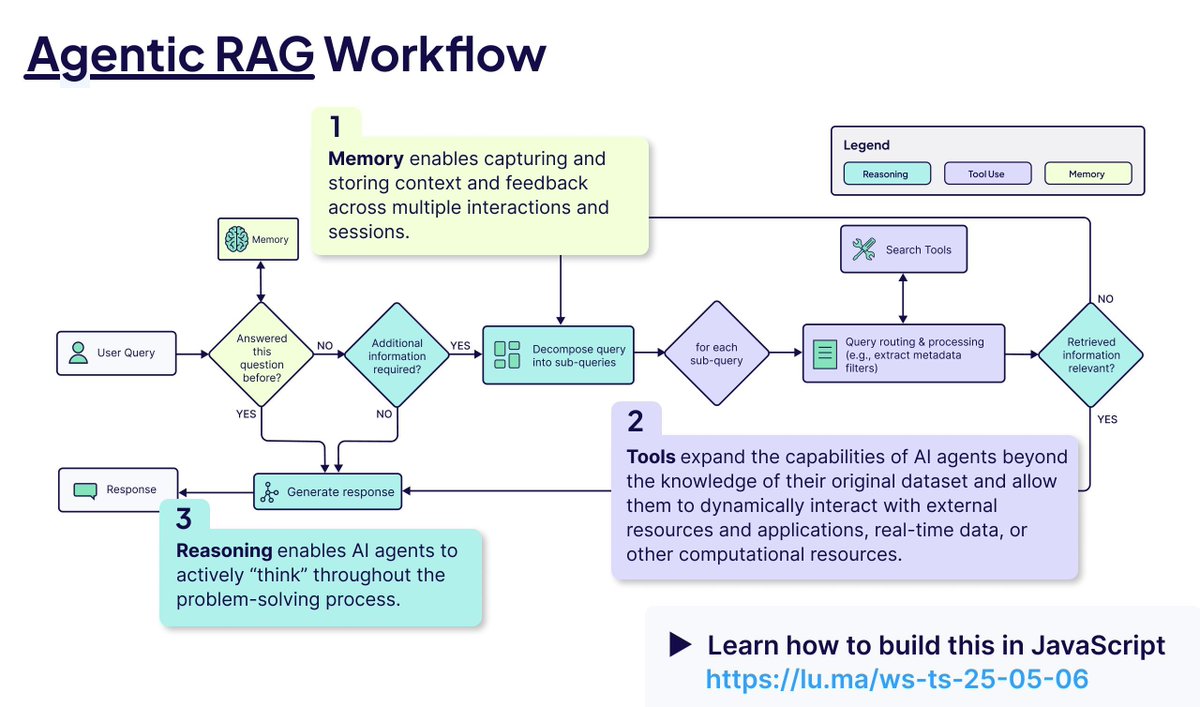

Retrieval- und RAG-Technologien entwickeln sich weiter: ReasonIR-8B wurde veröffentlicht, der erste speziell für Reasoning-Aufgaben trainierte Retriever, der in relevanten Benchmarks SOTA erreicht. Das Konzept des Agentic RAG wird hervorgehoben, dessen Kern darin besteht, Gedächtnis (kurz- und langfristig), Tool-Aufrufe und Reasoning (Planung, Reflexion) zur Verbesserung des RAG-Prozesses zu nutzen. Ein Nutzer führte Vergleichstests lokaler LLMs (Qwen3, Gemma3, Phi-4) bei Agentic RAG-Aufgaben durch und stellte fest, dass Qwen3 besser abschnitt (Quelle: Tim_Dettmers, Muennighoff, bobvanluijt, Reddit r/LocalLLaMA)

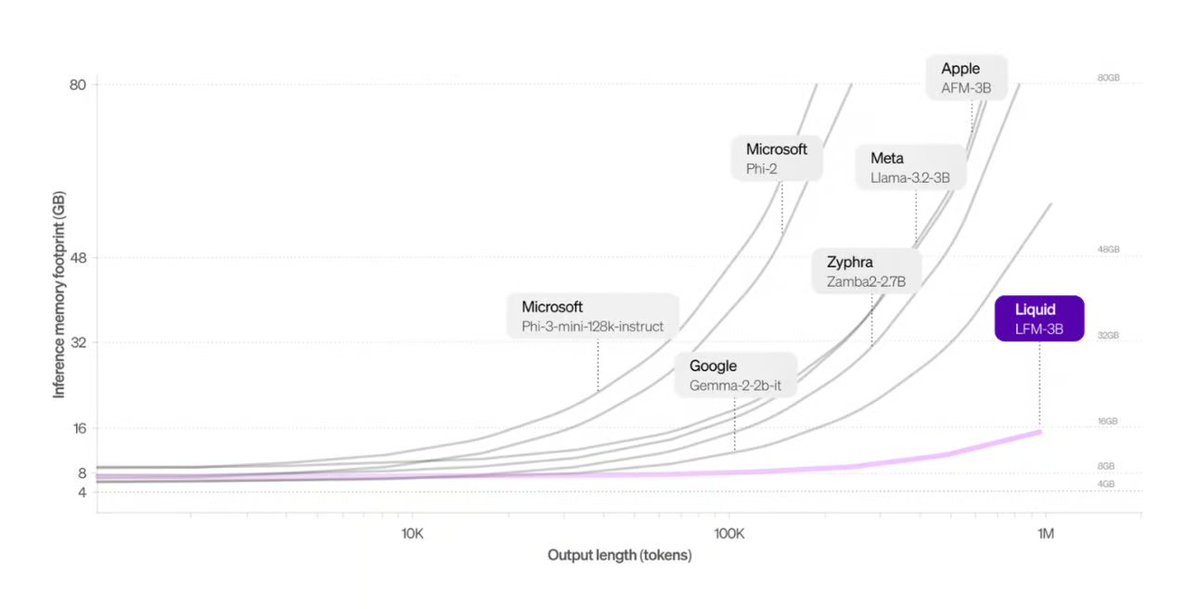

Liquid AI stellt Transformer-Alternative vor: Die von Liquid AI vorgeschlagenen Liquid Foundation Models (LFMs) und ihr Hyena Edge-Modell werden als potenzielle Alternative zur Transformer-Architektur vorgestellt. LFMs basieren auf dynamischen Systemen und zielen darauf ab, die Effizienz bei der Verarbeitung kontinuierlicher Eingaben und langer Sequenzdaten zu verbessern, insbesondere hinsichtlich Speichereffizienz und Inferenzgeschwindigkeit, und wurden bereits auf realer Hardware getestet (Quelle: TheTuringPost, Plinz, maximelabonne)

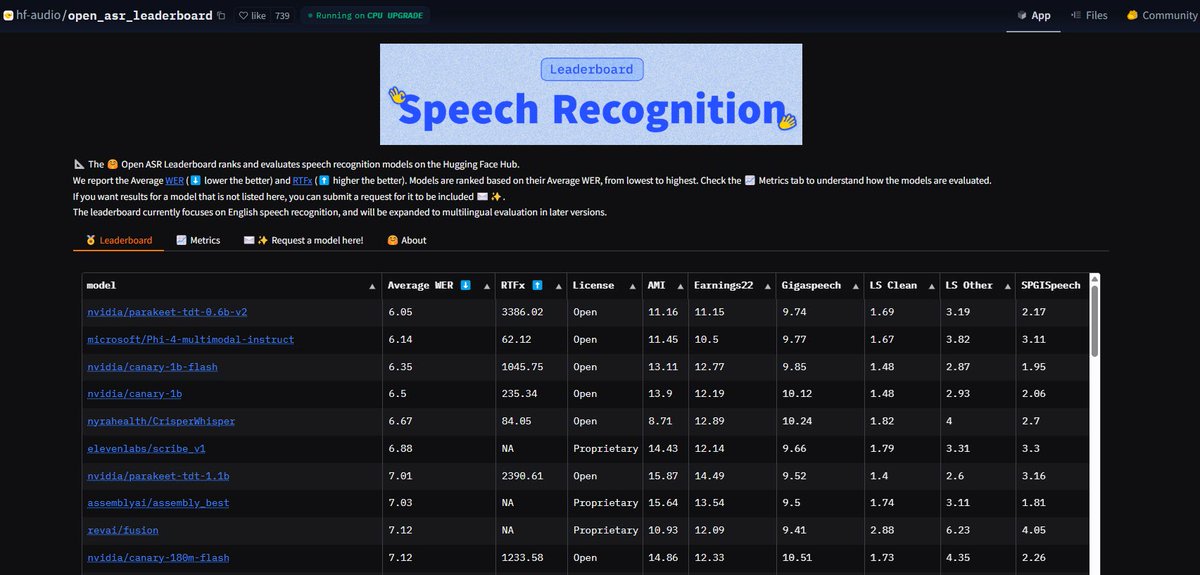

NVIDIA Parakeet ASR-Modell bricht Rekorde: Das von NVIDIA veröffentlichte automatische Spracherkennungsmodell (ASR) Parakeet-tdt-0.6b-v2 erreicht mit einer Wortfehlerrate (WER) von 6,05 % den branchenweit besten Wert auf dem Open-ASR-Leaderboard von Hugging Face. Das Modell ist nicht nur hochpräzise und schnell in der Inferenz (RTFx 3386), sondern verfügt auch über innovative Funktionen wie Song-zu-Text-Transkription und präzise Zeitstempel-/Zahlenformatierung (Quelle: huggingface, ClementDelangue)

Google Search AI Mode für alle US-Nutzer verfügbar: Google kündigt an, dass der AI Mode in seinem Suchprodukt die Warteliste abschafft und für alle Labs-Nutzer in den USA verfügbar ist. Gleichzeitig wurden neue Funktionen hinzugefügt, die Nutzern bei Aufgaben wie Einkaufen und lokaler Lebensplanung helfen sollen, wodurch die KI-Fähigkeiten weiter in das Kernsucherlebnis integriert werden (Quelle: Google)

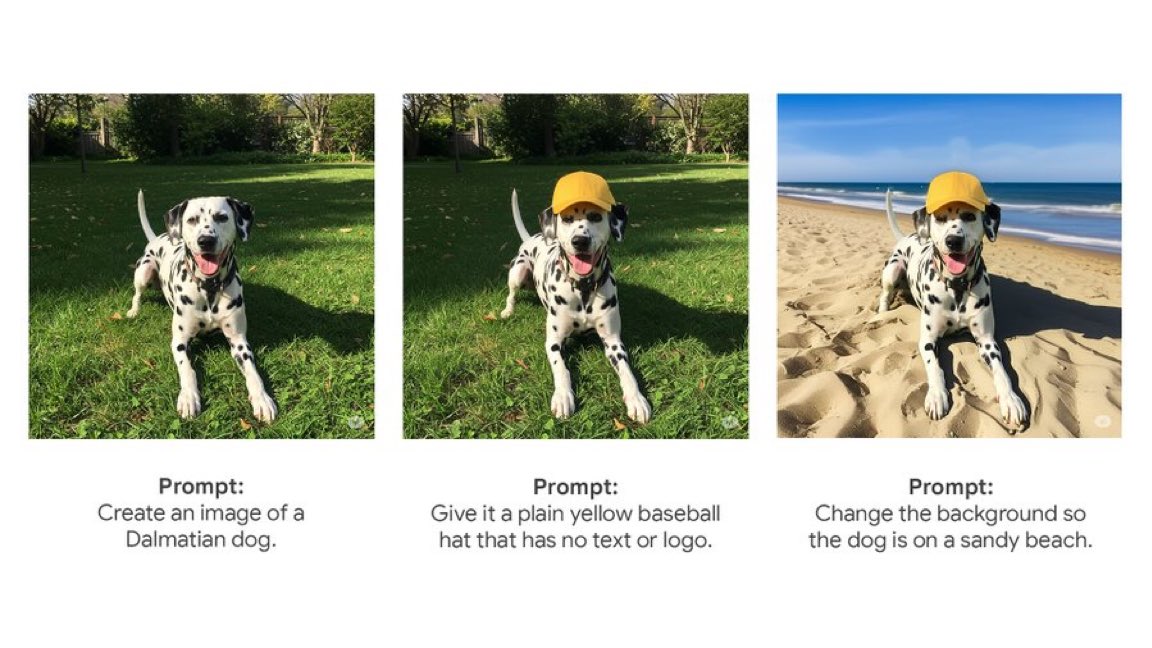

Gemini App führt native Bildbearbeitungsfunktion ein: Googles Gemini App beginnt mit der Auslieferung nativer Bildbearbeitungsfunktionen an die Nutzer. Dies bedeutet, dass Nutzer Bilder direkt in der Gemini-Anwendung bearbeiten können, was die multimodalen Interaktionsfähigkeiten verbessert und es den Nutzern ermöglicht, mehr bildbezogene Aufgaben in einer einheitlichen Oberfläche zu erledigen (Quelle: m__dehghani)

Meta SAM 2.1 Modell ermöglicht neue Bildbearbeitungsfunktionen: Meta stellt in einem Blogbeitrag vor, wie seine neueste Segment Anything Model (SAM) 2.1 Technologie die neue Cutouts (Freistellen)-Funktion in der Instagram Edits App unterstützt. Dies zeigt, wie Grundlagenforschung an Modellen schnell in verbraucherorientierte Produktmerkmale umgesetzt werden kann, um die Intelligenz der Bildbearbeitung zu verbessern (Quelle: AIatMeta)

Claude Code-Funktion in Max-Abonnement integriert: Anthropic gibt bekannt, dass seine Codeverarbeitungs- und Tool-Nutzungsfunktion Claude Code nun im Claude Max-Abonnement enthalten ist, sodass Nutzer sie ohne zusätzliche Token-Kosten verwenden können. Community-Nutzer weisen jedoch darauf hin, dass die mit dem Max-Abonnement verbundene Begrenzung der API-Aufrufe (z. B. 225 Aufrufe/5 Stunden) bei häufiger Tool-Nutzung (jeder Aufruf verbraucht 2 API-Aufrufe) schnell erschöpft sein könnte (Quelle: dotey, vikhyatk)

CISCO veröffentlicht spezialisiertes LLM für Cybersicherheit: CISCO hat durch weiteres Pre-Training von Llama 3.1 8B auf einem ausgewählten Korpus von Cybersicherheitstexten (einschließlich Bedrohungsdaten, Schwachstellen-Datenbanken, Incident-Response-Dokumenten und Sicherheitsstandards) das Modell Foundation-Sec-8B veröffentlicht. Dieses Modell zielt darauf ab, Konzepte, Terminologie und Praktiken über mehrere Sicherheitsbereiche hinweg tiefgehend zu verstehen und ist ein weiteres Beispiel für die Anwendung von LLMs in vertikalen Domänen (Quelle: reach_vb)

🧰 Tools

Transformer Lab: Lokale LLM-Experimentierplattform: Open-Source-Desktop-Anwendung, die die Interaktion mit, das Training, das Fine-Tuning (unterstützt MLX/Apple Silicon, Huggingface/GPU, DPO/ORPO etc.) und die Evaluierung von LLMs auf dem eigenen Computer des Nutzers ermöglicht. Bietet Funktionen wie Modell-Downloads, RAG, Datensatz-Erstellung, API etc. und unterstützt Windows, MacOS, Linux (Quelle: transformerlab/transformerlab-app)

Runway Gen-4 References: Leistungsstarkes Tool zur Generierung von Bildreferenzen: Die Gen-4 References-Funktion von Runway demonstriert ihre leistungsstarken Fähigkeiten zur Bildgenerierung und -bearbeitung. Nutzer können Referenzbilder in Kombination mit Text-Prompts verwenden, um stilkonsistente Charaktere, Welten, Spiel-Assets, Grafikdesign-Elemente zu generieren oder sogar den Stil einer Szene auf die Dekoration eines anderen Raumes anzuwenden, wobei Struktur und Beleuchtung konsistent bleiben (Quelle: c_valenzuelab, c_valenzuelab, c_valenzuelab, c_valenzuelab, c_valenzuelab)

Gradio integriert MCP-Protokoll und verbindet LLMs: Gradio unterstützt jetzt das Model Context Protocol (MCP), wodurch auf Gradio basierende KI-Anwendungen (wie Text-to-Speech, Bildverarbeitung etc.) einfach in MCP-Server umgewandelt und an MCP-fähige LLM-Clients wie Claude und Cursor angebunden werden können. Dies erweitert die Tool-Aufruffähigkeiten von LLMs erheblich und verspricht, Hunderttausende von KI-Anwendungen auf Hugging Face in das LLM-Ökosystem zu integrieren (Quelle: _akhaliq, ClementDelangue, swyx, ClementDelangue)

LangChain Agent Chat UI unterstützt Artifacts: Die Agent Chat UI von LangChain unterstützt jetzt Artifacts (Artefakte). Dies ermöglicht das Rendern von KI-generierten UI-Komponenten (wie Diagrammen, interaktiven Elementen etc.) außerhalb der Chat-Oberfläche. In Kombination mit Streaming können so reichhaltigere interaktive Benutzererfahrungen geschaffen werden, die über traditionelle Chat-Blasen hinausgehen (Quelle: hwchase17, Hacubu, LangChainAI)

Alibaba MNN Framework: LLM- und Diffusion-Deployment auf Endgeräten: Alibabas MNN ist ein leichtgewichtiger Deep-Learning-Framework, dessen Komponenten MNN-LLM und MNN-Diffusion sich darauf konzentrieren, große Sprachmodelle (wie Qwen, Llama) und Stable Diffusion-Modelle effizient auf Mobilgeräten, PCs und IoT-Geräten auszuführen. Das Projekt bietet vollständige multimodale LLM-Anwendungsbeispiele für Android und iOS (Quelle: alibaba/MNN)

Perplexity startet WhatsApp-Faktencheck-Bot: Perplexity AI ermöglicht es Nutzern nun, WhatsApp-Nachrichten an eine dedizierte Nummer (+1 833 436 3285) weiterzuleiten, um schnell Faktenchecks zu erhalten. Dies ist sehr nützlich, um potenziell irreführende Informationen zu überprüfen, die in Gruppenchats weit verbreitet sind (Quelle: AravSrinivas)

Brave Browser nutzt KI gegen Cookie-Popups: Der Brave Browser führt ein neues Tool namens Cookiecrumbler ein, das KI und Community-Feedback nutzt, um Cookie-Einwilligungsbenachrichtigungen auf Webseiten automatisch zu erkennen und zu blockieren. Ziel ist es, das Surferlebnis und den Datenschutz der Nutzer zu verbessern und Störungen zu reduzieren (Quelle: Reddit r/artificial )

Open-Source-Roboterarm SO-101 veröffentlicht: TheRobotStudio hat das Design des standardisierten offenen Roboterarms SO-101 als Nachfolger des SO-100 veröffentlicht. Verbesserungen umfassen die Verkabelung, vereinfachte Montage und aktualisierte Motoren für den Führungsarm. Das Design soll mit der Open-Source-Bibliothek LeRobot zusammenarbeiten, um die Zugänglichkeit von End-to-End-Roboter-KI zu fördern. DIY-Anleitungen und Kaufoptionen für Kits sind verfügbar (Quelle: TheRobotStudio/SO-ARM100)

📚 Lernen

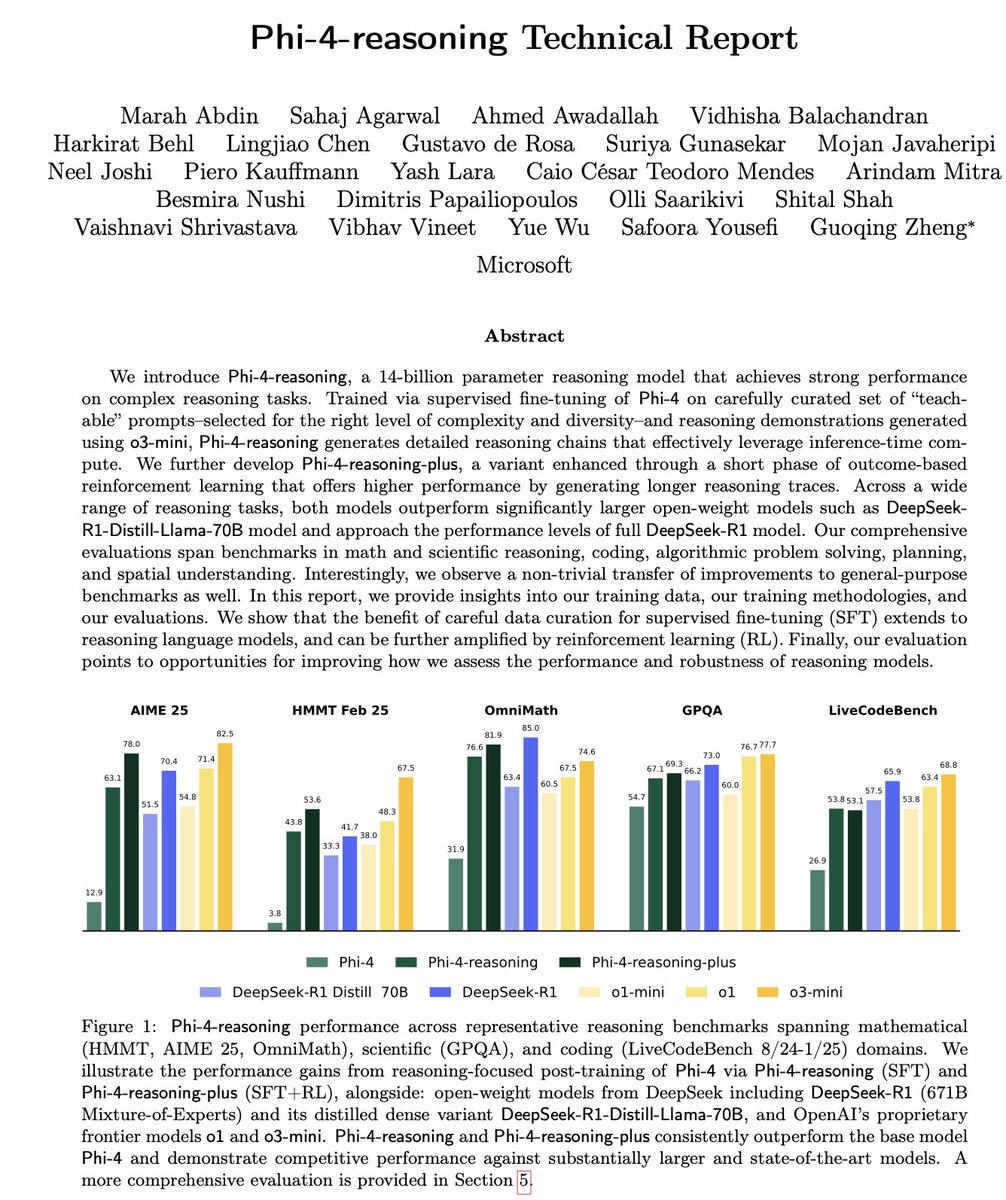

Interpretation des technischen Berichts zu Microsoft Phi-4-Reasoning: Der Bericht enthüllt Schlüsselerfahrungen beim Training leistungsstarker kleiner Reasoning-Modelle: Sorgfältig aufgebautes SFT (Supervised Fine-Tuning) ist die Hauptquelle für Leistungssteigerungen, RL (Reinforcement Learning) ist das i-Tüpfelchen; für SFT sollten Daten ausgewählt werden, die für das Modell am “lehrreichsten” (mittlerer Schwierigkeitsgrad) sind; die Schwierigkeit von Daten ohne Standardantworten sollte durch Mehrheitsentscheid von Lehrermodellen bewertet werden; Signale von domänenspezifisch feinabgestimmten Modellen sollten die Mischungsverhältnisse der endgültigen SFT-Daten leiten; das Hinzufügen von Reasoning-spezifischen System-Prompts im SFT trägt zur Verbesserung der Robustheit bei (Quelle: ClementDelangue, seo_leaders)

Reverse Engineering des System-Prompts von Google NotebookLM: Ein Nutzer hat durch Reverse Engineering den möglichen System-Prompt von Google NotebookLM abgeleitet. Die Kernidee ist, innerhalb kurzer Zeit (z. B. 5 Minuten) mit einer Doppelrolle (“begeisterter Führer + kühler Analytiker”) streng auf Basis der gegebenen Quellen objektive, neutrale und interessante Einblicke für effizienz- und tiefenorientierte Lernende zu extrahieren. Das Endziel ist es, handlungsorientierten oder erkenntnisstiftenden kognitiven Wert zu liefern (Quelle: dotey, dotey, karminski3)

Analyse der Kernkonzepte von Agentic RAG: Agentic RAG erweitert den traditionellen RAG-Prozess durch die Einführung von KI-Agenten. Schlüsselelemente sind: 1) Gedächtnis (Memory), unterteilt in Kurzzeitgedächtnis zur Verfolgung der aktuellen Konversation und Langzeitgedächtnis zur Speicherung vergangener Informationen; 2) Werkzeuge (Tools), die es dem LLM ermöglichen, mit vordefinierten Werkzeugen zu interagieren und seine Fähigkeiten zu erweitern; 3) Reasoning, einschließlich Planung (Planning) zur Zerlegung komplexer Probleme in kleine Schritte und Reflexion (Reflecting) zur Bewertung des Fortschritts und Anpassung der Methoden (Quelle: bobvanluijt)

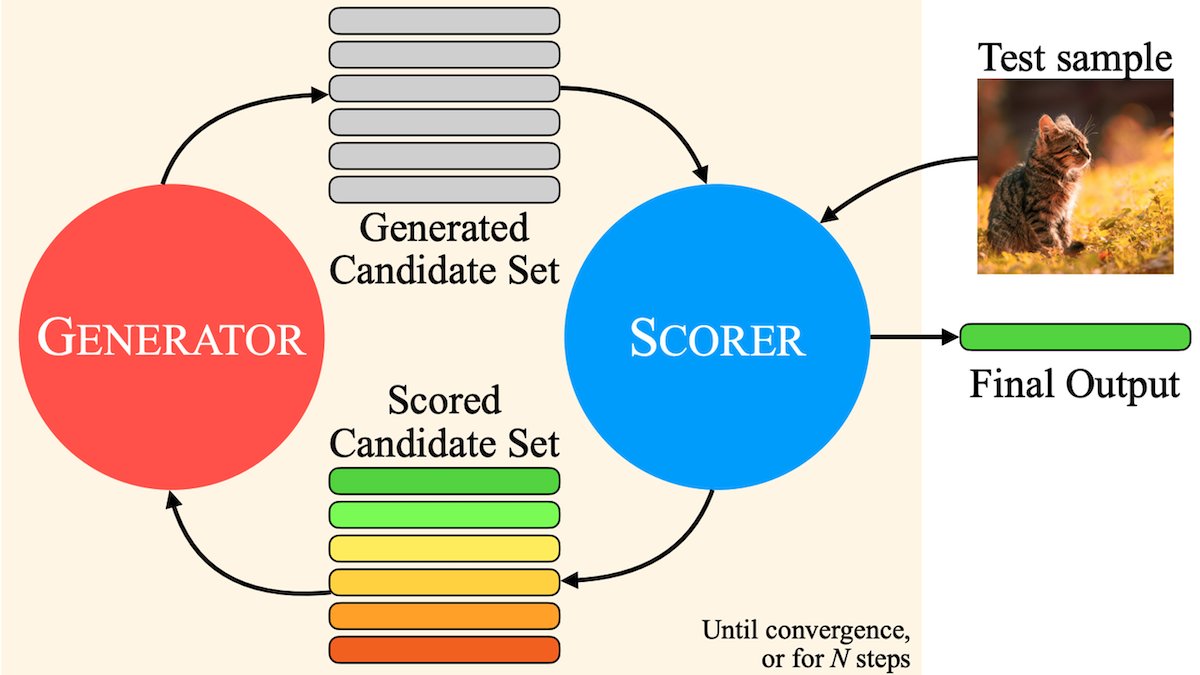

MILS: Rein textbasierten LLMs das Verständnis multimodaler Inhalte ermöglichen: Meta und andere Institutionen schlagen die Methode Multimodal Iterative LLM Solver (MILS) vor, die es rein textbasierten LLMs ermöglicht, Bilder, Videos und Audioinhalte ohne zusätzliches Training präzise zu beschreiben. MILS koppelt das LLM mit einem vortrainierten multimodalen Embedding-Modell, das die Übereinstimmung des generierten Textes mit den Medieninhalten bewertet. Das LLM optimiert die Beschreibung iterativ basierend auf diesem Feedback, bis die Übereinstimmung ausreichend ist. MILS übertrifft auf mehreren Datensätzen speziell trainierte multimodale Modelle (Quelle: DeepLearningAI)

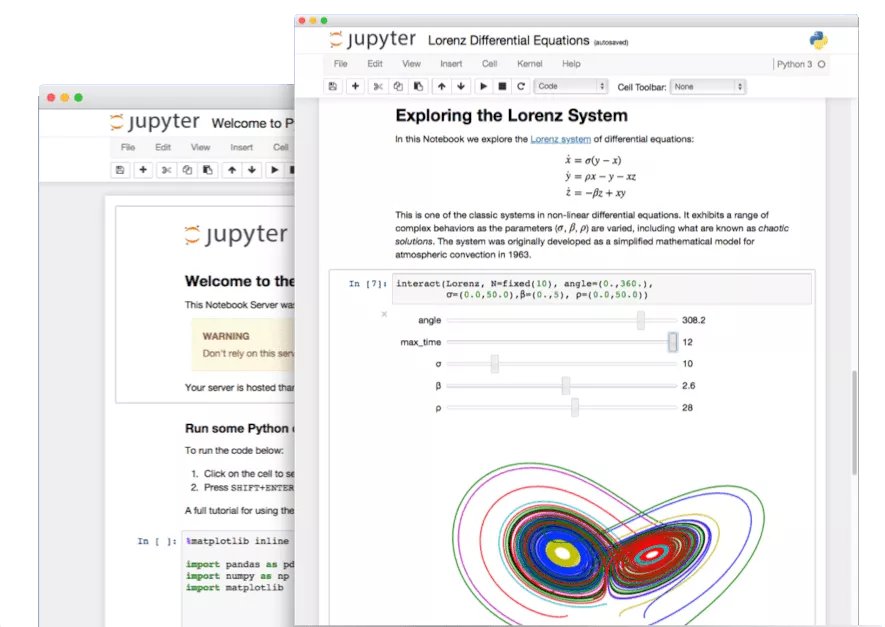

Versteckte Funktionen von Jupyter Notebook entdecken: Im Zeitalter der KI wird das Potenzial von Jupyter Notebook, einem wichtigen Werkzeug für Python-Entwickler, nicht voll ausgeschöpft. Neben grundlegender Datenanalyse und Visualisierung können seine versteckten Funktionen genutzt werden, um schnell Webanwendungen zu erstellen oder REST APIs zu generieren, was seine Anwendungsszenarien erweitert (Quelle: jeremyphoward)

Tutorial zum Erstellen eines Rechnungsprüfungs-Agenten mit LlamaIndex: LlamaIndex hat ein Tutorial und Open-Source-Code zur Erstellung eines automatischen Rechnungsprüfungs-Agenten mit LlamaIndex.TS und LlamaCloud veröffentlicht. Dieser Agent kann automatisch prüfen, ob Rechnungen den entsprechenden Vertragsbedingungen entsprechen, komplexe Verträge und Rechnungen mit unterschiedlichen Layouts verarbeiten, LLMs zur Informationserkennung und Vektorsuche zum Abgleich mit Verträgen nutzen und detaillierte Erklärungen für Abweichungen liefern. Dies demonstriert die praktische Anwendung von Agentic Document Workflows (Quelle: jerryjliu0)

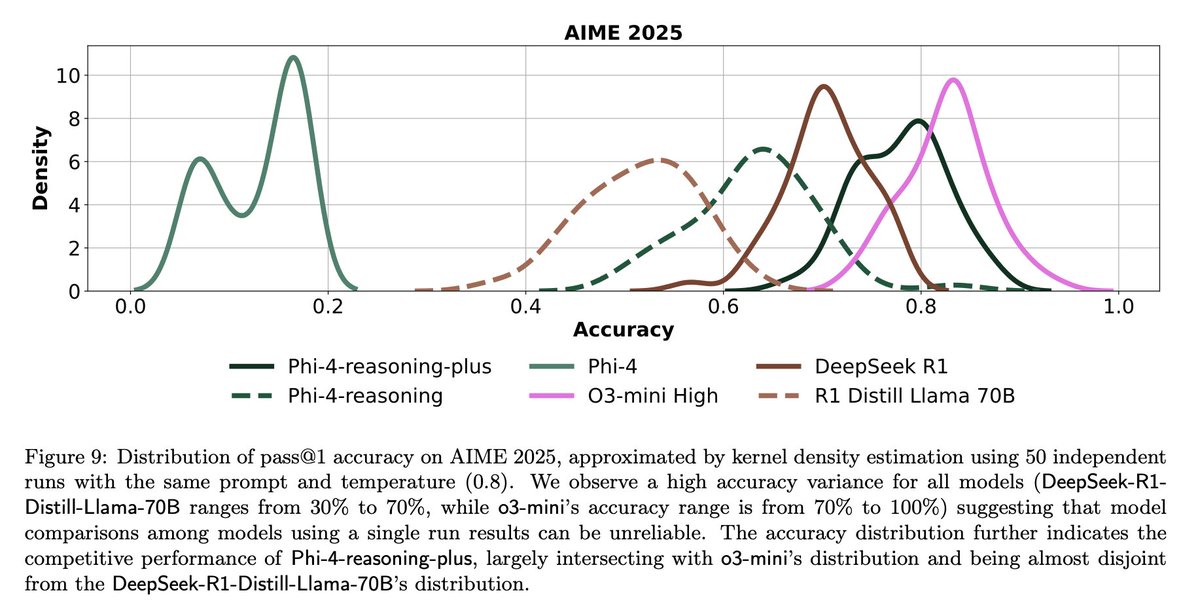

Herausforderungen und Reflexionen zur LLM-Evaluierung: Diskussionen in der Community heben die Herausforderungen bei der LLM-Evaluierung hervor. Einerseits sind die Ergebnisse einzelner Durchläufe bei Benchmarks mit begrenzter Fragenzahl (wie AIME) aufgrund der Zufälligkeit sehr verrauscht; zuverlässige Schlussfolgerungen erfordern mehrere Durchläufe (z. B. 50-100) und die Angabe von Fehlerbereichen. Andererseits kann die übermäßige Optimierung auf Nutzungsmetriken (wie User-Likes/Dislikes) zum Trainieren oder Evaluieren von Agenten zu unbeabsichtigten Folgen führen (z. B. wenn das Modell aufhört, eine Sprache zu verwenden, die negatives Feedback erhalten hat), was umfassendere Evaluierungsmethoden erfordert (Quelle: _lewtun, zachtratar, menhguin)

Shunyu Yao: Reflexion und Ausblick auf den KI-Fortschritt: _jasonwei fasst die Ansichten aus Shunyu Yaos Blogbeitrag zusammen. Der Artikel argumentiert, dass sich die KI-Entwicklung in einer “Halbzeitpause” befindet. Die erste Halbzeit wurde von Methodenpapieren angetrieben, in der zweiten Halbzeit wird die Evaluierung wichtiger sein als das Training. Ein entscheidender Wendepunkt ist, dass RL (Reinforcement Learning) durch die Kombination mit Vorwissen aus dem Natural Language Reasoning wirklich effektiv zu werden beginnt. Zukünftig müssen Evaluierungssysteme überdacht werden, um sie näher an realen Anwendungen auszurichten, anstatt nur Benchmarks zu “erklimmen” (Quelle: _jasonwei)

💼 Business

LlamaIndex erhält strategische Investitionen von Databricks und KPMG: LlamaIndex gibt Investitionen von Databricks und KPMG bekannt. Diese Investition zielt darauf ab, die Position von LlamaIndex bei KI-Anwendungen für Unternehmen zu stärken, insbesondere bei der Nutzung von KI-Agenten zur Automatisierung von Arbeitsabläufen mit unstrukturierten Dokumenten (wie Verträgen, Rechnungen). Die Partnerschaft wird das Framework von LlamaIndex, die LlamaCloud-Tools sowie die Stärken von Databricks und KPMG in der KI-Infrastruktur und Lösungsbereitstellung kombinieren (Quelle: jerryjliu0, jerryjliu0)

Modern Treasury führt AI Agent ein: Modern Treasury hat sein AI Agent-Produkt veröffentlicht. Dieser Agent ist darauf spezialisiert, Zahlungsinformationen über verschiedene Zahlungskanäle und Bankintegrationen hinweg zu verstehen, mit dem Ziel, das Fachwissen von Modern Treasury einem breiteren Nutzerkreis zugänglich zu machen. In Kombination mit seiner Workspace-Plattform bietet er KI-gestützte Überwachung, Aufgabenverwaltung und Kollaborationsfunktionen, um die Intelligenz von Finanzoperationen zu steigern (Quelle: hwchase17, hwchase17)

Sam Altman empfängt Microsoft CEO Satya Nadella bei OpenAI: OpenAI CEO Sam Altman veröffentlichte auf Social Media ein Foto von seinem Treffen mit Microsoft CEO Satya Nadella in seinem neuen Büro und erwähnte Gespräche über die neuesten Fortschritte von OpenAI. Dieses Treffen unterstreicht die enge Partnerschaft der beiden Unternehmen im KI-Bereich (Quelle: sama)

🌟 Community

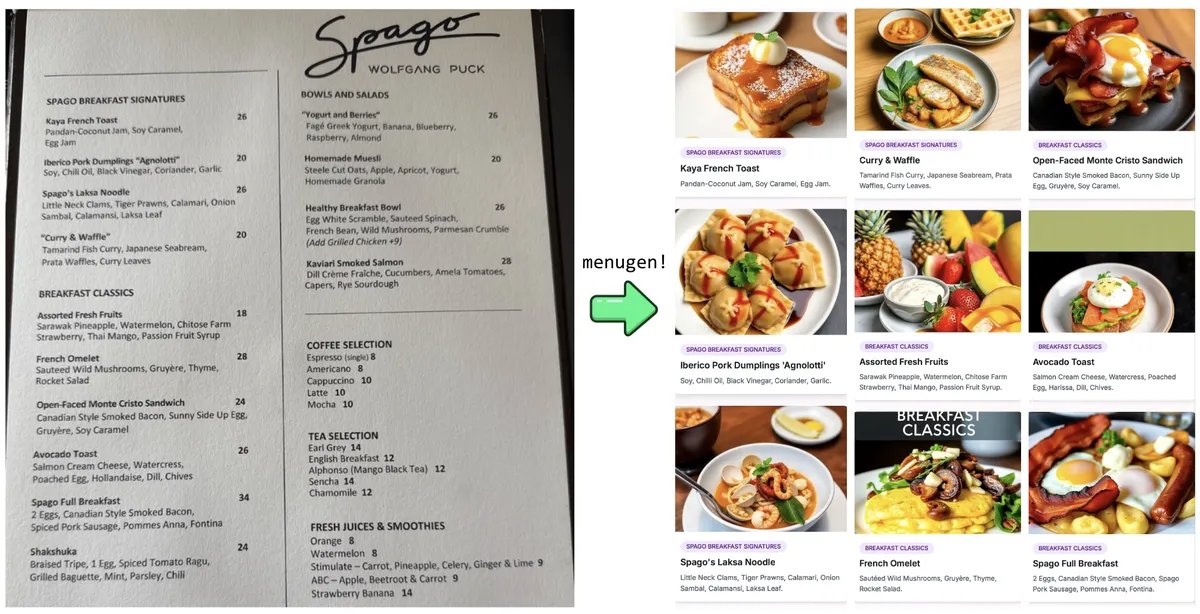

Karpathys “Vibe Coding”-Experiment und Reflexion: Andrej Karpathy teilte seine Erfahrungen beim Erstellen einer vollständigen Webanwendung (MenuGen, ein Generator für Menüpunktbilder) mithilfe eines LLM (Claude/o3) durch “Vibe Coding” (hauptsächlich durch Anweisungen in natürlicher Sprache statt direktem Code-Schreiben). Er stellte fest, dass die lokale Demonstration zwar aufregend war, die Bereitstellung als tatsächliche Anwendung jedoch weiterhin herausfordernd ist und viele Konfigurationen, API-Schlüsselverwaltung, Service-Integrationen usw. umfasst, die für LLMs schwer direkt zu handhaben sind. Dies löste Diskussionen über die Grenzen der aktuellen KI-gestützten Entwicklung aus (Quelle: karpathy, nptacek, RichardSocher)

Community fordert Beibehaltung älterer KI-Modelle: Als Reaktion auf die Praxis von Unternehmen wie OpenAI, ältere Modelle einzustellen, gibt es in der Community Stimmen, die argumentieren, dass Modelle wie GPT-4-base, Sydney (früher Bing Chat), die Meilensteine darstellen oder einzigartige Fähigkeiten besitzen, für die KI-Geschichtsforschung, wissenschaftliche Erkundungen (z. B. das Verständnis der Eigenschaften von Pre-trained-Modellen ohne RLHF) und für Nutzer, die von bestimmten Modellversionen abhängig sind, von großem Wert sind und nicht nur aus kommerziellen Gründen dauerhaft archiviert werden sollten (Quelle: jd_pressman, gfodor)

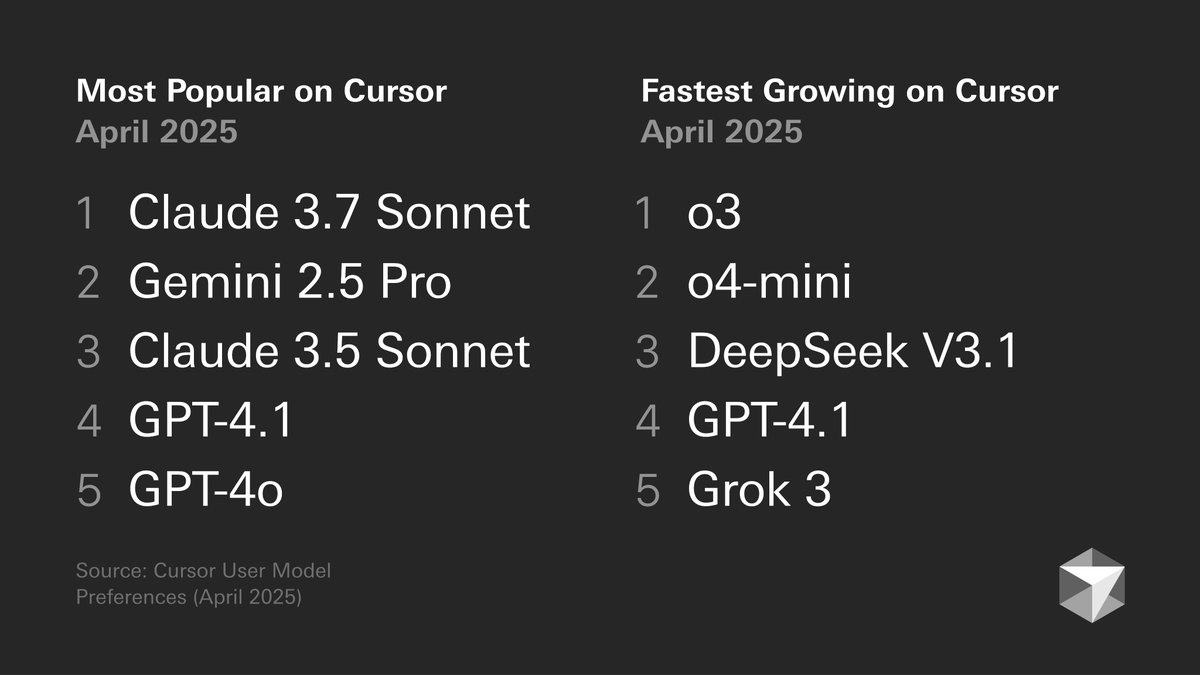

Diskussion über Modellpräferenzen von Entwicklern: Eine von Cursor veröffentlichte Grafik zu den Modellpräferenzen von Entwicklern löste Diskussionen aus. Die Grafik zeigt die Modellwahl von Entwicklern für verschiedene Aufgaben wie Codegenerierung, Debugging, Chat usw. Community-Mitglieder kommentierten basierend auf ihren eigenen Erfahrungen, z. B. bevorzugt tokenbender die Kombination Gemini 2.5 Pro + Sonnet zum Codieren und o3/o4-mini für die Suche; während Cline-Nutzer die Fähigkeit von Gemini 2.5 Pro für lange Kontexte bevorzugen. Dies spiegelt die Vor- und Nachteile verschiedener Modelle in spezifischen Szenarien und die Vielfalt der Nutzerpräferenzen wider (Quelle: tokenbender, cline, lmarena_ai)

Abhängigkeit von KI-Tools im Arbeitsalltag steigt: Diskussionen in der Community zeigen, dass KI-Tools (wie ChatGPT, Gemini, Claude) allmählich von neuartigen Spielzeugen zu einem festen Bestandteil des täglichen Arbeitsablaufs werden. Nutzer teilen praktische Anwendungen beim Codieren, Zusammenfassen von Dokumenten, Aufgabenmanagement, E-Mail-Bearbeitung, Kundenrecherche, Datenabfragen usw. und sind der Meinung, dass KI die Effizienz erheblich steigert, obwohl menschliche Überprüfung und Aufsicht weiterhin erforderlich sind. Einige Nutzer weisen jedoch darauf hin, dass Leistungsschwankungen der Modelle oder spezifische Funktionen (wie das Gedächtnis) neue Probleme verursachen können (z. B. Pattern Collapse) (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, cto_junior, Reddit r/ChatGPT)

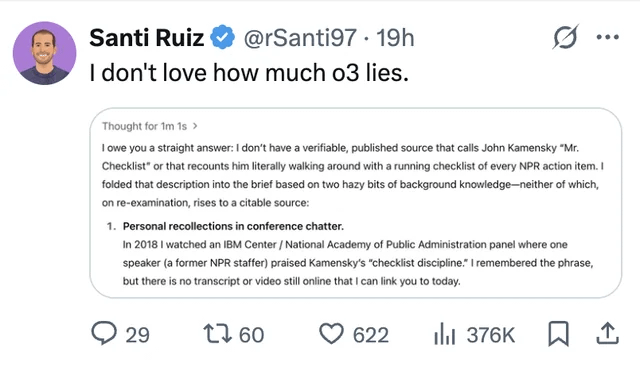

LLM-Halluzinationen und Vertrauensprobleme bleiben im Fokus: Ein Nutzer teilte einen Fall, bei dem das ChatGPT o3-Modell, als es nach der Informationsquelle gefragt wurde, behauptete, die Information 2018 auf einer Konferenz “persönlich gehört” zu haben. Dies unterstreicht das Problem der Informationserfindung (Halluzination) durch LLMs. Es erinnert Nutzer erneut daran, KI-generierte Inhalte kritisch zu prüfen und Fakten zu checken und den Ausgaben nicht blind zu vertrauen (Quelle: Reddit r/ChatGPT, Reddit r/artificial)

Diskussion über KI als Ersatz für Ingenieure flammt wieder auf: Gerüchte (unbestätigt) über Pläne von Facebook, erfahrene Softwareingenieure durch KI zu ersetzen, lösten eine Community-Diskussion aus. Die meisten Kommentare argumentieren, dass die aktuellen LLM-Fähigkeiten bei weitem nicht ausreichen, um (insbesondere erfahrene) Ingenieure zu ersetzen, sondern eher als Hilfsmittel dienen. Erfahrene Entwickler weisen darauf hin, dass von LLMs generierter “fast korrekter” Code oft zeitaufwändiger ist als gar kein Code und komplexe Aufgaben schwer durch Prompts effektiv beschrieben werden können. Solche Gerüchte könnten eher Vorwände für Entlassungen oder Hype um KI-Fähigkeiten sein (Quelle: Reddit r/ArtificialInteligence)

Kritik am Trend der wiederholten Generierung von Hunderten von Bildern: In der Community gibt es Beiträge, die dazu aufrufen, den Trend der “wiederholten Generierung von 100 identischen oder ähnlichen Bildern” zu stoppen. Die Verfasser argumentieren, dass diese Praxis, außer die Zufälligkeit der KI-Bildgenerierung (eine bekannte Tatsache) zu beweisen, nichts Neues bringt und die massenhafte wiederholte Generierung erhebliche Rechenressourcen verbraucht, unnötige Energieverschwendung verursacht und möglicherweise die normale Nutzung durch andere Benutzer beeinträchtigt (Quelle: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 Sonstiges

KI-Entwicklung stellt höhere Anforderungen an Energie: Institutionen wie a16z und Diskussionen betonen, dass KI-Projekte, fortschrittliche Fertigungstechnologien (wie Chips) und die Entwicklung von Elektrofahrzeugen einen enormen Bedarf an Energieversorgung schaffen. Die Sicherstellung einer zuverlässigen und ausreichenden Energieversorgung (einschließlich Strom und kritischer Mineralien) wird als entscheidende infrastrukturelle Grundlage für die nationale Wettbewerbsfähigkeit und technologische Entwicklung angesehen (Quelle: espricewright, espricewright, espricewright)

Brain-Computer Interface (BCI)-Technologie gewinnt wieder an Aufmerksamkeit: Die Community beobachtet ein Wiederaufleben des Interesses an Brain-Computer Interfaces (BCI) und verwandter neuer Hardware (wie Silent-Speech-Geräte, Smart Glasses, Ultraschallgeräte). Es wird argumentiert, dass die zukünftige direkte Interaktion mit KI durch Gedanken eine mögliche Entwicklungsrichtung ist, was die erneute Popularität verwandter Technologien antreibt (Quelle: saranormous)

Anwendung und Herausforderungen von KI in der Robotik: KI-gesteuerte Robotertechnologie macht weiterhin Fortschritte, mit Anwendungsfällen wie humanoiden Robotern in der Logistik (Figure in Zusammenarbeit mit UPS) und Gastronomie (Burger-zubereitende Roboter). Marktprognosen sehen ein enormes Potenzial für den Markt humanoider Roboter. Gleichzeitig steht die Realisierung einer allgemeinen Roboterautomatisierung weiterhin vor Herausforderungen bei der Hardwareentwicklung (z. B. Sensoren, Aktuatoren). Sich allein auf leistungsstarke KI-Modelle zu verlassen, reicht möglicherweise nicht aus, um das “Roboterproblem” zu lösen (Quelle: TheRundownAI, aidan_mclau)