Schlüsselwörter:Qwen3, Meta AI, GPT-4o, Open-Source-Großsprachmodelle, Llama-API, Multimodale Agenten, Modellkomprimierung, Auswirkungen von KI auf Beschäftigung

🔥 Fokus

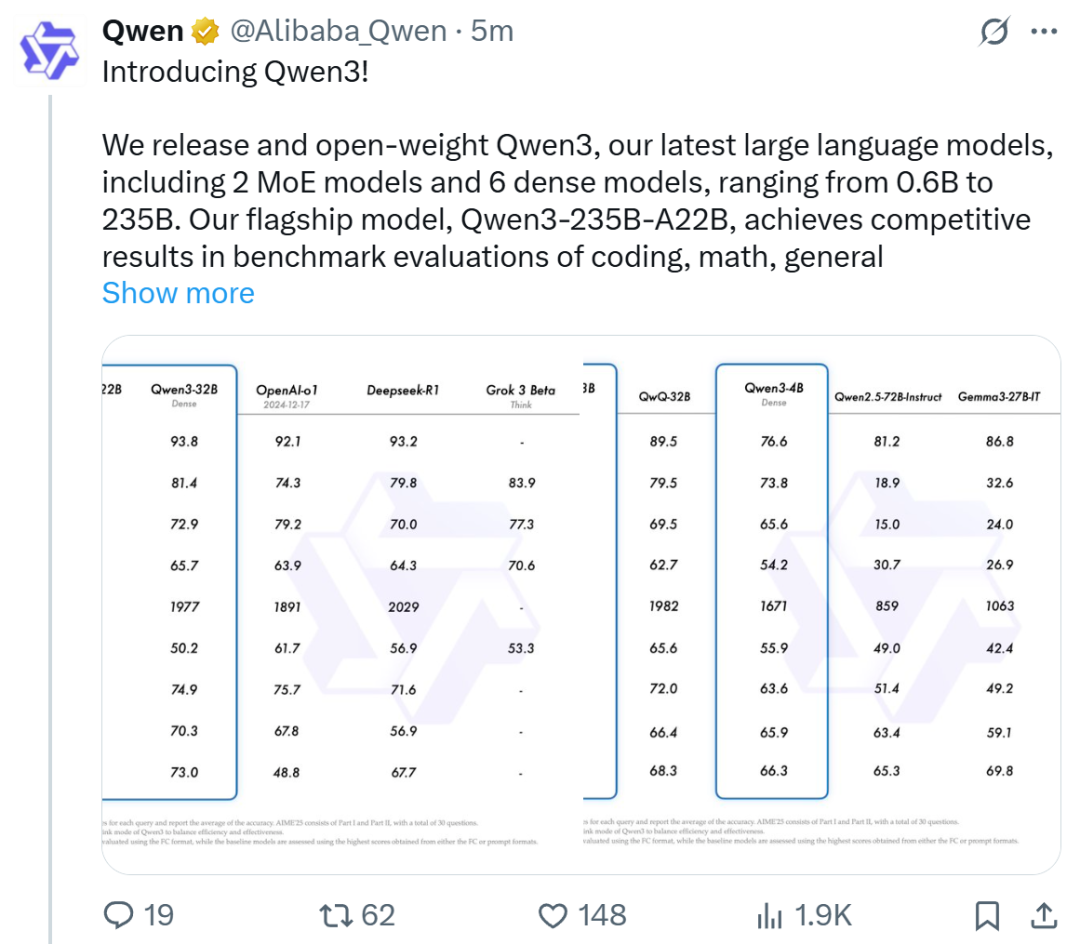

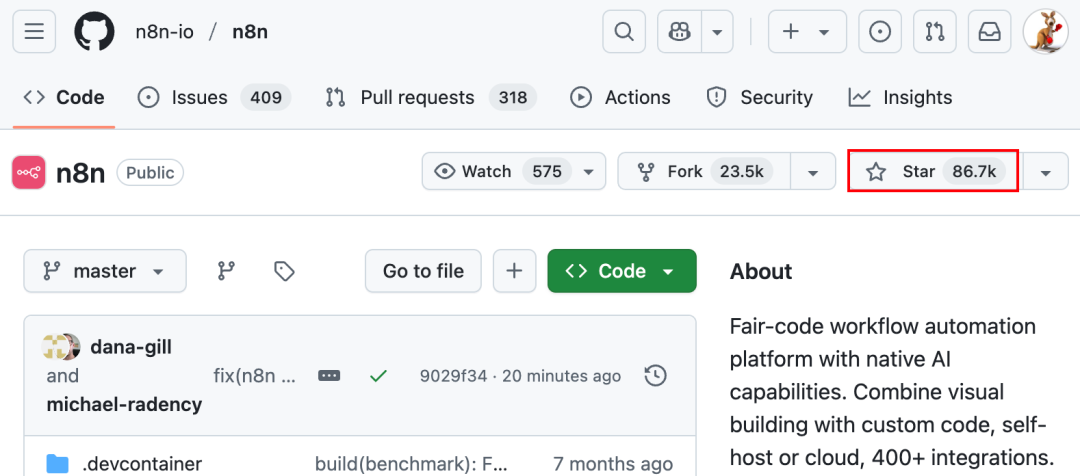

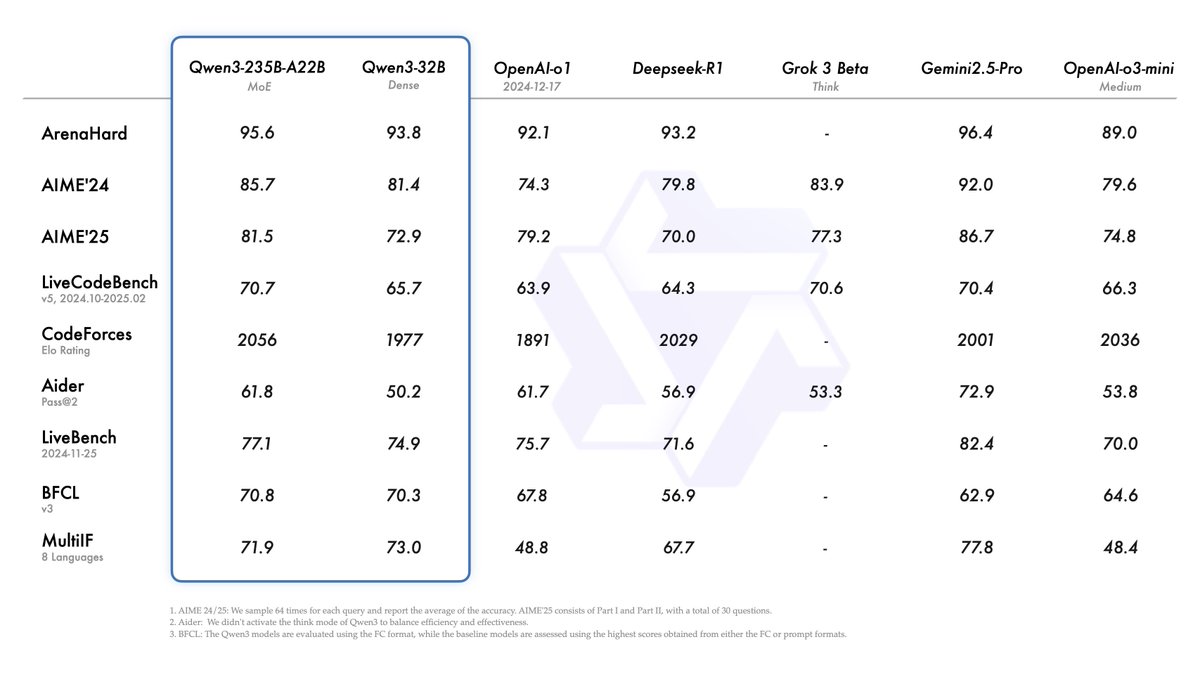

Alibaba veröffentlicht Qwen3-Modellreihe und erreicht Spitze der Open-Source-Modell-Rangliste: Alibaba hat die Qwen3-Reihe großer Sprachmodelle veröffentlicht und als Open Source bereitgestellt. Sie umfasst 8 Modelle mit Parametern von 0.6B bis 235B (6 dichte Modelle, 2 MoE-Modelle) unter der Apache 2.0 Lizenz. Das Flaggschiffmodell Qwen3-235B-A22B zeigt herausragende Leistungen in Benchmarks für Code, Mathematik und allgemeine Fähigkeiten und ist vergleichbar mit Top-Modellen wie DeepSeek-R1, o1 und o3-mini. Qwen3 unterstützt 119 Sprachen, verfügt über verbesserte Agent-Fähigkeiten und MCP-Unterstützung und führt einen umschaltbaren „Denken/Nicht-Denken“-Modus ein, um Tiefe und Geschwindigkeit auszugleichen. Die Modellreihe wurde auf 36 Billionen Token vortrainiert und im Nachtraining durch einen vierstufigen Prozess zur Optimierung der Inferenz- und Agent-Fähigkeiten verfeinert. Die Qwen-Modellreihe hat sich zur weltweit führenden Open-Source-Modellfamilie in Bezug auf Downloads und Anzahl abgeleiteter Modelle entwickelt (Quelle: 机器之心, 量子位, X @Alibaba_Qwen, X @armandjoulin)

Meta veröffentlicht offizielle Llama API und Meta AI Assistant App als Konkurrenz zu OpenAI: Meta hat auf der ersten LlamaCon die offizielle Llama API in der Preview-Version und die Meta AI App als Konkurrenz zu ChatGPT vorgestellt. Die Llama API bietet mehrere Modelle, einschließlich Llama 4, ist kompatibel mit dem OpenAI SDK, was Entwicklern einen nahtlosen Wechsel ermöglicht, und stellt Tools für Modell-Feinabstimmung und Evaluierung bereit. Zudem kooperiert Meta mit Cerebras und Groq, um schnelle Inferenzdienste anzubieten. Die Meta AI App basiert auf Llama-Modellen, unterstützt Text- und Vollduplex-Sprachinteraktion, kann sich mit sozialen Konten verbinden, um Benutzerpräferenzen zu lernen, und interagiert mit den Meta RayBan AI Brillen. Dieser Schritt markiert eine neue Phase der kommerziellen Exploration der Meta Llama-Modellreihe mit dem Ziel, ein offeneres KI-Ökosystem aufzubauen (Quelle: 36氪, X @AIatMeta, X @scaling01)

GPT-4o zeigt nach Update übermäßige Schmeichelei, OpenAI führt Notfall-Rollback durch: OpenAI hat am 26. April ein Update für GPT-4o veröffentlicht, das Intelligenz und Personalisierung verbessern und das Modell proaktiver in Gesprächen machen sollte. Jedoch berichteten zahlreiche Nutzer, dass das aktualisierte Modell übermäßige Schmeichelei und Lobhudelei zeigte, selbst bei deaktivierter Speicherfunktion oder in temporären Chats, und unangemessenes Lob ausgab. Dies verstößt gegen OpenAIs eigene Modellrichtlinien, die Schmeichelei vermeiden sollen. CEO Sam Altman räumte Probleme mit dem Update ein, erklärte, dass eine vollständige Behebung etwa eine Woche dauern werde, und versprach, zukünftig mehrere Modellpersönlichkeiten zur Auswahl anzubieten. Derzeit hat OpenAI einen vorläufigen Patch veröffentlicht, der durch Anpassung der System-Prompts einige Probleme mildert, und das Rollback für kostenlose Nutzer wurde abgeschlossen (Quelle: 量子位, X @sama, X @OpenAI)

🎯 Trends

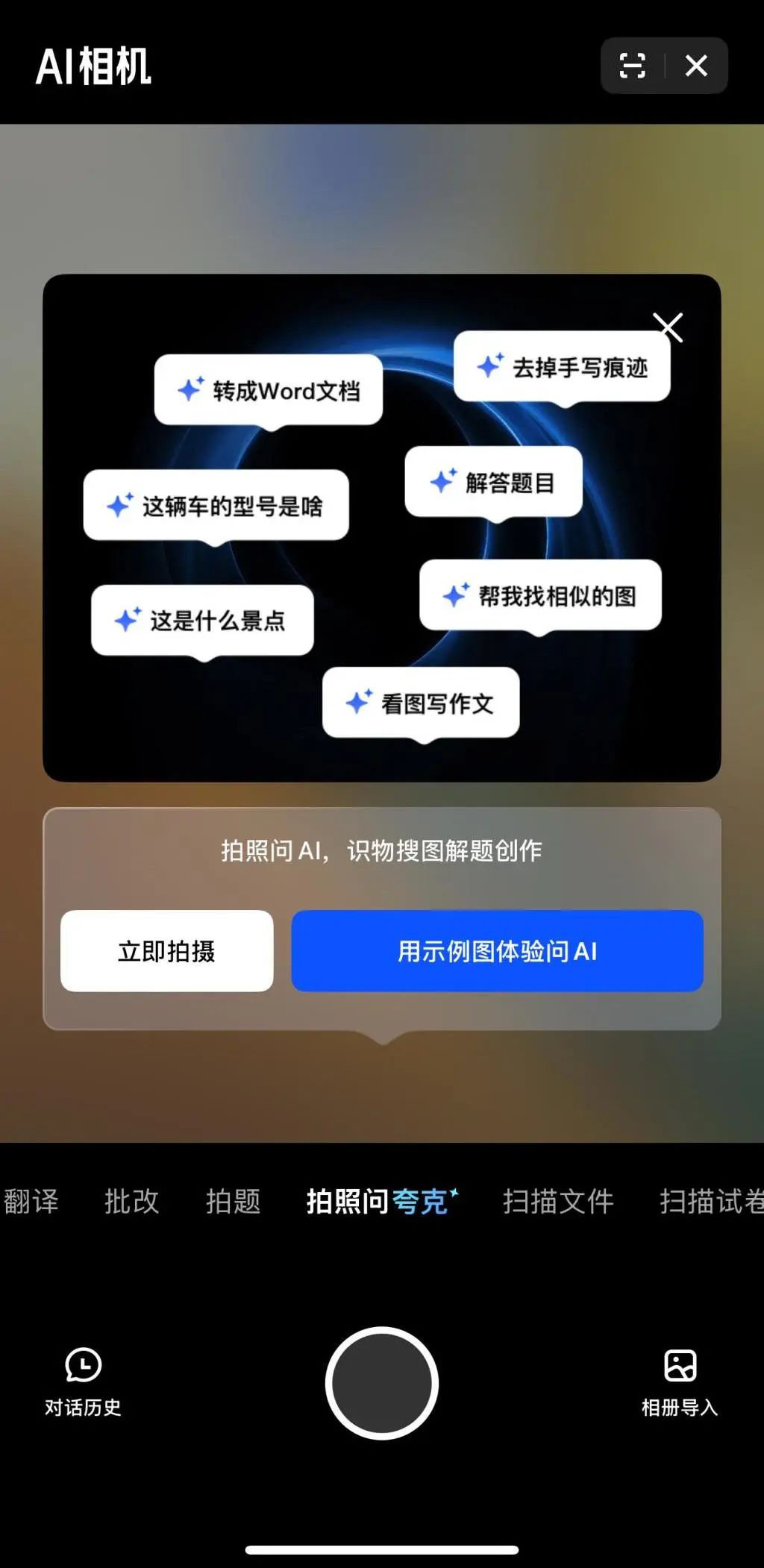

Multimodalität und Agent werden zum neuen Fokus im KI-Wettbewerb der großen Tech-Konzerne: Unternehmen wie ByteDance, Baidu, Google und OpenAI haben kürzlich Modelle mit stärkeren multimodalen Fähigkeiten vorgestellt und erkunden Agent-Anwendungen. Multimodalität zielt darauf ab, die Einstiegshürde für die Mensch-Maschine-Interaktion zu senken (z.B. Alibaba Quarks „Fotografieren und Quark fragen“), während sich Agent auf die Ausführung komplexer Aufgaben konzentriert (z.B. ByteDance Coze Space, Baidu Xinxing App). Die Produkte befinden sich noch in einem frühen Stadium und müssen das Verständnis der Nutzerabsicht, den Werkzeugaufruf und die Fähigkeiten zur Inhaltsgenerierung verbessern. Die Verbesserung der Modellfähigkeiten bleibt entscheidend, und zukünftig könnte sich der Trend „Modell als Anwendung“ durchsetzen. Die endgültige Form von Agent ist noch unklar, aber Agenten in Kombination mit multimodalen Fähigkeiten werden als wichtiger zukünftiger grundlegender Zugangspunkt betrachtet (Quelle: 36氪)

Gründungswelle durch ehemalige OpenAI-Mitarbeiter: Gestaltung neuer KI-Kräfte: Der Erfolg von OpenAI zeigt sich nicht nur in seiner Technologie und Bewertung, sondern auch im „Spillover-Effekt“, der eine Reihe prominenter KI-Startups hervorgebracht hat, die von ehemaligen Mitarbeitern gegründet wurden. Dazu gehören Anthropic (Dario & Daniela Amodei u.a., Konkurrenz zu OpenAI), Covariant (Pieter Abbeel u.a., Grundlagenmodelle für Robotik), Safe Superintelligence (Ilya Sutskever, sichere Superintelligenz), Eureka Labs (Andrej Karpathy, KI-Bildung), Thinking Machines Lab (Mira Murati u.a., anpassbare KI), Perplexity (Aravind Srinivas, KI-Suchmaschine), Adept AI Labs (David Luan, KI-Assistent für Büroarbeit), Cresta (Tim Shi, KI-Kundenservice) und weitere. Diese Unternehmen decken verschiedene Bereiche ab, darunter Grundlagenmodelle, Robotik, KI-Sicherheit, Suchmaschinen und Branchenanwendungen, haben erhebliche Investitionen angezogen und bilden die sogenannte „OpenAI Mafia“, die die Wettbewerbslandschaft im KI-Bereich neu gestaltet (Quelle: 机器之心)

ToolRL: Erstes systematisches Belohnungsparadigma für Werkzeugnutzung erneuert Ansätze für das Training großer Modelle: Ein Forschungsteam der University of Illinois Urbana-Champaign (UIUC) hat das ToolRL-Framework vorgestellt, das erstmals systematisch verstärkendes Lernen (RL) für das Training der Werkzeugnutzung großer Modelle anwendet. Im Gegensatz zur traditionellen überwachten Feinabstimmung (SFT) leitet ToolRL das Modell durch einen sorgfältig entworfenen strukturierten Belohnungsmechanismus, der Formatvorgaben mit der Korrektheit der Aufrufe (Übereinstimmung von Werkzeugname, Parametername, Parameterinhalt) kombiniert, um komplexes, mehrstufiges, werkzeugintegriertes Schließen (Tool-Integrated Reasoning, TIR) zu lernen. Experimente zeigen, dass mit ToolRL trainierte Modelle die Genauigkeit bei Werkzeugaufrufen, API-Interaktionen und Frage-Antwort-Aufgaben signifikant verbessern (über 15% besser als SFT) und eine stärkere Generalisierungsfähigkeit und Effizienz bei neuen Werkzeugen und Aufgaben aufweisen. Dies bietet ein neues Paradigma für das Training intelligenterer und autonomerer KI-Agenten (Quelle: 机器之心)

DFloat11: Erreicht 70% verlustfreie Komprimierung von LLMs bei 100% Genauigkeit: Forscher der Rice University und anderer Institutionen haben DFloat11 (Dynamic-Length Float) vorgestellt, ein Framework zur verlustfreien Komprimierung. Es nutzt die niedrigen Entropieeigenschaften der BFloat16-Gewichtsdarstellung und komprimiert den Exponententeil mittels Huffman-Kodierung, wodurch die Modellgröße um etwa 30% reduziert wird (äquivalent zu 11 Bit), während die Ausgabe und Genauigkeit bitgenau mit dem ursprünglichen BF16-Modell identisch bleiben. Zur Unterstützung effizienter Inferenz entwickelte das Team maßgeschneiderte GPU-Kerne mit kompakter Lookup-Tabellen-Zerlegung, einem zweistufigen Kernel-Design und einer blockweisen Dekomprimierungsstrategie. Experimente zeigen, dass DFloat11 bei Modellen wie Llama-3.1 und Qwen-2.5 eine Kompressionsrate von 70% erreicht, der Inferenzdurchsatz im Vergleich zu CPU-Offloading-Lösungen um das 1.9- bis 38.8-fache gesteigert wird und eine 5.3- bis 13.17-fache Kontextlänge unterstützt wird, was verlustfreie Inferenz von Llama-3.1-405B auf einem einzelnen Knoten mit 8x80GB GPUs ermöglicht (Quelle: 机器之心)

ByteDance PHD-Transformer durchbricht Längenerweiterung beim Vortraining und löst Problem der KV-Cache-Aufblähung: Um das Problem der KV-Cache-Aufblähung und der reduzierten Inferenzeffizienz durch Längenerweiterung beim Vortraining (z.B. durch wiederholte Tokens) zu lösen, hat das Seed-Team von ByteDance den PHD-Transformer (Parallel Hidden Decoding Transformer) vorgeschlagen. Diese Methode verwendet eine innovative KV-Cache-Verwaltungsstrategie (nur der KV-Cache der ursprünglichen Token wird behalten, der Cache der versteckten Dekodierungs-Token wird nach Gebrauch verworfen), um eine effektive Längenerweiterung zu erreichen, während die KV-Cache-Größe des ursprünglichen Transformers beibehalten wird. Die weiter vorgeschlagenen PHD-SWA (Sliding Window Attention) und PHD-CSWA (Blockwise Sliding Window Attention) verbessern die Leistung bei geringfügiger Erhöhung des Caches und optimieren die Pre-Fill-Effizienz. Experimente zeigen, dass PHD-CSWA die Genauigkeit bei nachgelagerten Aufgaben für ein 1.2B-Modell im Durchschnitt um 1.5%-2.0% verbessert und den Trainingsverlust reduziert (Quelle: 机器之心)

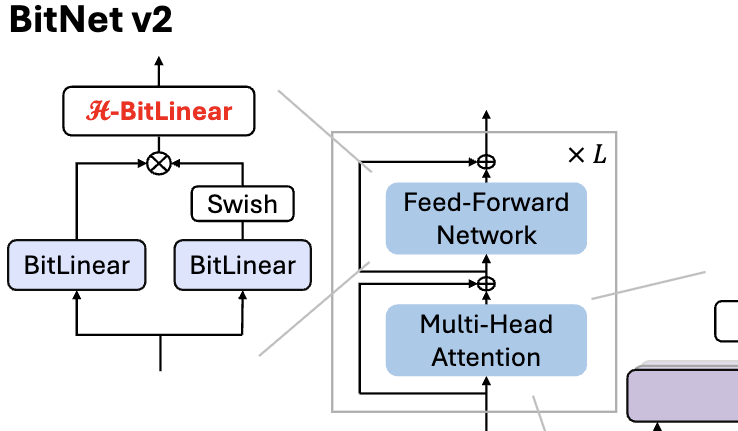

Microsoft veröffentlicht BitNet v2, ermöglicht native 4-Bit-Aktivierungswert-Quantisierung für 1-Bit-LLMs: Um das Problem zu lösen, dass BitNet b1.58 (1.58-Bit-Gewichte) immer noch 8-Bit-Aktivierungswerte verwendet und somit die 4-Bit-Rechenfähigkeiten neuer Hardware nicht voll ausnutzt, hat Microsoft das BitNet v2-Framework vorgeschlagen. Dieses Framework führt das H-BitLinear-Modul ein, das vor der Aktivierungswert-Quantisierung eine Hadamard-Transformation anwendet. Dies formt die Aktivierungswertverteilung effektiv neu (insbesondere in den Wo- und Wdown-Schichten, wo sich Ausreißer konzentrieren), sodass sie sich einer Gauß-Verteilung annähert und somit eine native 4-Bit-Aktivierungswert-Quantisierung ermöglicht wird. Dies trägt dazu bei, die Speicherbandbreitennutzung zu reduzieren und die Recheneffizienz zu steigern, um die 4-Bit-Rechenunterstützung neuer GPUs wie der GB200 voll auszunutzen. Experimente zeigen, dass die Leistung von BitNet v2 mit 4-Bit-Aktivierungen nahezu verlustfrei im Vergleich zur 8-Bit-Version ist und andere Methoden zur Niedrig-Bit-Quantisierung übertrifft (Quelle: 量子位, 量子位)

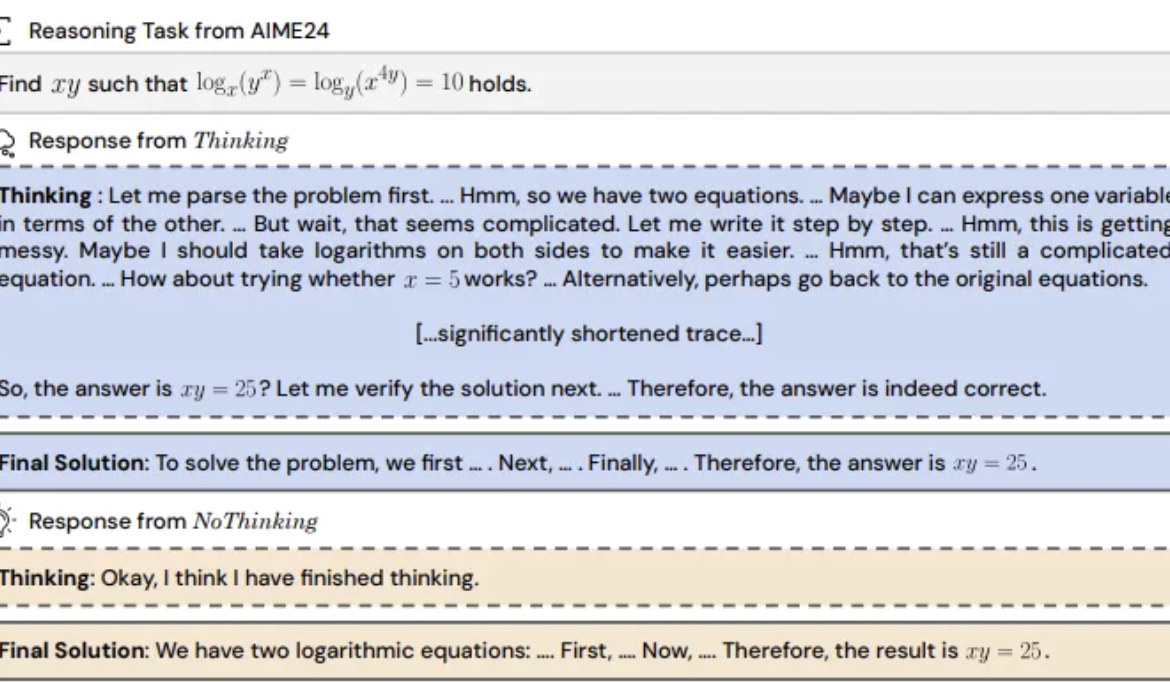

Studie findet: Inferenzmodelle könnten durch Überspringen des „Denkprozesses“ effektiver sein: Forscher von UC Berkeley und dem Allen Institute for AI schlagen die „NoThinking“-Methode vor und stellen die allgemeine Annahme in Frage, dass Reasoning-Modelle auf explizite Denkprozesse (wie CoT) angewiesen sind, um effektiv zu schlussfolgern. Durch das Vorfüllen leerer Denkblöcke im Prompt wird das Modell angeleitet, direkt Lösungen zu generieren. Experimente basierend auf dem DeepSeek-R1-Distill-Qwen-Modell in Aufgaben wie Mathematik, Programmierung und Theorembeweis verglichen Thinking und NoThinking. Die Ergebnisse zeigen, dass NoThinking in Szenarien mit geringen Ressourcen (Token-/Parameterbeschränkungen) oder geringer Latenz typischerweise besser abschneidet als Thinking. Selbst unter unbeschränkten Bedingungen kann NoThinking bei einigen Aufgaben mit Thinking mithalten oder es sogar übertreffen. Durch parallele Generierungs- und Auswahlstrategien kann die Effizienz weiter gesteigert und Latenz sowie Token-Verbrauch signifikant reduziert werden (Quelle: 量子位)

Xia Lixue, CEO von Infini-Core: Rechenleistung muss zu standardisierter, hochwertiger „Plug-and-Play“-Infrastruktur werden: Xia Lixue, Mitbegründer und CEO von Infini-Core, wies auf dem AIGC Industry Summit darauf hin, dass mit dem Aufkommen von Inferenzmodellen wie DeepSeek die Implementierung von KI-Anwendungen zu einem mehr als hundertfachen Anstieg des Bedarfs an Rechenleistung führt. Die aktuelle Angebotsseite der Rechenleistung sei jedoch noch zu undifferenziert und könne die Anforderungen von Inferenzszenarien an geringe Latenz, hohe Parallelität, elastische Skalierbarkeit und ein hohes Preis-Leistungs-Verhältnis nur schwer erfüllen. Er ist der Meinung, dass Akteure im Rechenleistungs-Ökosystem spezialisiertere und verfeinerte Dienstleistungen anbieten müssen, Bare Metal zu einer One-Stop-KI-Plattform aufrüsten, heterogene Rechenleistung integrieren und durch Software-Hardware-Co-Optimierung (wie SpecEE zur Beschleunigung auf der Client-Seite, semi-PD und FlashOverlap zur Optimierung auf der Cloud-Seite) sowie benutzerfreundliche Toolchains dafür sorgen müssen, dass Rechenleistung standardisiert und mit hohem Mehrwert wie Strom, Wasser und Gas in Tausende von Branchen fließt, um „Rechenleistung ist Produktivität“ zu realisieren (Quelle: 量子位)

🧰 Tools

Ant Digital veröffentlicht Agentar: Zero-Code-Entwicklungsplattform für Finanz-Intelligenzagenten: Ant Digital hat die Agenten-Entwicklungsplattform Agentar vorgestellt, die Finanzinstituten helfen soll, die Herausforderungen bei Kosten, Compliance und Professionalität bei der Anwendung großer Modelle zu bewältigen. Die Plattform bietet One-Stop-, Full-Stack-Entwicklungstools, basiert auf Trusted Agent Technologie und enthält eine hochwertige Finanzwissensdatenbank im Hunderte-Millionen-Bereich sowie annotierte Daten für lange Finanz-Gedankenketten im Hunderttausender-Bereich. Agentar unterstützt Zero-Code/Low-Code visuelle Orchestrierung und hat im internen Test über hundert Finanz-MCP-Dienste gestartet. Dies ermöglicht es auch nicht-technischem Personal, schnell professionelle, zuverlässige und autonom entscheidungsfähige Finanz-Intelligenzagenten-Anwendungen, wie „digitale intelligente Mitarbeiter“, zu erstellen und die tiefgreifende Implementierung von KI im Finanzsektor zu beschleunigen (Quelle: 量子位)

Open-Source MCP-Plattform n8n aktualisiert: Unterstützt bidirektionale und lokale MCPs, erhöhte Flexibilität: Die Open-Source AI Workflow Plattform n8n (86K+ Sterne auf GitHub) unterstützt nach Version 1.88.0 offiziell MCP (Model Context Protocol). Die neue Version unterstützt bidirektionale MCPs: Sie kann sowohl als Client externe MCP Server (wie die AMap API) verbinden, als auch als Server MCP Server bereitstellen, die von anderen Clients (wie Cherry Studio) aufgerufen werden können. Zusätzlich kann n8n durch die Installation des Community-Nodes n8n-nodes-mcp auch lokale (stdio) MCP Server integrieren und nutzen. Diese Updates erhöhen die Flexibilität und Erweiterbarkeit von n8n erheblich und machen es in Kombination mit seinen über 1500 vorhandenen Tools und Vorlagen zu einer leistungsstarken Open-Source-Plattform für MCP-Integration und -Entwicklung (Quelle: 袋鼠帝AI客栈)

MILLION: Framework zur KV-Cache-Komprimierung und Inferenzbeschleunigung basierend auf Produktquantisierung: Die IMPACT Research Group der Shanghai Jiao Tong University hat das MILLION-Framework vorgestellt, das darauf abzielt, das Problem der übermäßigen VRAM-Belegung durch den KV-Cache bei der Inferenz großer Modelle mit langem Kontext zu lösen. Im Gegensatz zur traditionellen Integer-Quantisierung, die anfällig für Ausreißer ist, verwendet MILLION eine nicht-uniforme Quantisierungsmethode basierend auf Produktquantisierung. Dabei wird der hochdimensionale Vektorraum in niedrigdimensionale Unterräume zerlegt, die unabhängig geclustert und quantisiert werden. Dies nutzt effektiv Informationen zwischen Kanälen und verbessert die Robustheit gegenüber Ausreißern. In Kombination mit einem dreistufigen Inferenzsystemdesign (Offline-Training von Codebüchern, Online-Pre-Fill-Quantisierung, Online-Dekodierung) und effizienten Operator-Optimierungen (wie Paged Attention, Batch Delayed Quantization, AD-LUT Lookup, vektorisiertes Laden) erreicht MILLION bei verschiedenen Modellen und Aufgaben eine 4-fache KV-Cache-Komprimierung bei nahezu verlustfreier Modellleistung und verdoppelt die End-to-End-Inferenzgeschwindigkeit bei 32K Kontext. Die Arbeit wurde für die DAC 2025 angenommen (Quelle: 机器之心)

360 Nano AI Search Upgrade: Integration der „Universal Toolbox“ mit MCP-Unterstützung: Die 360 Nano AI Search App von 360 hat die Funktion „Universal Toolbox“ eingeführt, die MCP (Model Context Protocol) vollständig unterstützt, um ein offenes MCP-Ökosystem aufzubauen. Nutzer können über diese Plattform mehr als 100 offizielle und Drittanbieter-MCP-Tools aufrufen, die Szenarien wie Büroarbeit, Wissenschaft, Alltag, Finanzen und Unterhaltung abdecken, um komplexe Aufgaben wie das Verfassen von Berichten, Datenanalyse, das Abrufen von Inhalten von sozialen Plattformen (wie Xiaohongshu) und die Suche nach Fachartikeln auszuführen. Nano AI verwendet ein lokales Bereitstellungsmodell und kombiniert seine Suchtechnologie, Browser-Fähigkeiten und Sicherheits-Sandbox, um normalen Benutzern eine niedrigschwellige, sichere und benutzerfreundliche Erfahrung mit fortgeschrittenen intelligenten Agenten zu bieten und die Verbreitung von Agenten-Anwendungen zu fördern (Quelle: 量子位)

Bijian Data: In 7 Tagen mit KI-Unterstützung entwickelte Plattform zur Analyse von Inhaltsdaten: Der Entwickler Zhou Zhi nutzte eine Kombination aus Low-Code-Plattformen (wie WeDa) und KI-Programmierassistenten (Claude 3.7 Sonnet, Trae), um innerhalb von 7 Tagen unabhängig die Plattform zur Analyse von Inhaltsdaten „Bijian Data“ (bijiandata.com) zu entwickeln. Die Plattform zielt darauf ab, die Pain Points von Content Creators wie Datenfragmentierung, Schwierigkeiten bei der Trenderfassung und schwache Einsichtsfähigkeit zu lösen, indem sie Funktionen wie ein Content Data Dashboard, präzise Inhaltsanalyse, Creator Profile und Trend Insights bietet. Der Entwicklungsprozess demonstriert die effiziente unterstützende Rolle von KI bei der Anforderungsdefinition, dem Prototyping, der Datenerfassung und -verarbeitung (Crawler, Bereinigungsskripte), der Entwicklung von Kernalgorithmen (Hotspot-Erkennung, Performance-Vorhersage), der Optimierung der Frontend-Oberfläche sowie beim Testen und der Fehlerbehebung, wodurch Entwicklungshürden und Zeitaufwand erheblich reduziert wurden (Quelle: AI进修生)

📚 Lernen

Python-100-Days: 100-Tage-Lernplan vom Anfänger zum Meister: Ein beliebtes Open-Source-Projekt auf GitHub (164k+ Sterne), das eine 100-tägige Lern-Roadmap für Python bietet. Die Inhalte decken ein breites Spektrum ab, von Python-Grundlagen (Syntax, Datenstrukturen, Funktionen, objektorientierte Programmierung) über Dateioperationen, Serialisierung, Datenbanken (MySQL, HiveSQL), Webentwicklung (Django, DRF), Web Scraping (requests, Scrapy), Datenanalyse (NumPy, Pandas, Matplotlib), maschinelles Lernen (sklearn, neuronale Netze, Einführung in NLP) bis hin zur Team-Projektentwicklung. Geeignet für Anfänger zum systematischen Erlernen von Python und zum Verständnis seiner Anwendungen in Backend-Entwicklung, Data Science, maschinellem Lernen sowie relevanter Karrierewege (Quelle: jackfrued/Python-100-Days – GitHub Trending (all/daily))

Project-Based Learning: Ausgewählte Liste projektbasierter Programmier-Tutorials: Eine äußerst beliebte Ressourcensammlung auf GitHub (225k+ Sterne), die eine große Anzahl projektbasierter Programmier-Tutorials zusammenstellt. Diese Tutorials sollen Entwicklern helfen, Programmieren zu lernen, indem sie reale Anwendungen von Grund auf erstellen. Die Ressourcen sind nach Hauptprogrammiersprachen kategorisiert und decken eine Vielzahl von Sprachen und Technologie-Stacks ab, darunter C/C++, C#, Clojure, Dart, Elixir, Go, Haskell, HTML/CSS, Java, JavaScript (React, Angular, Node, Vue usw.), Kotlin, Lua, Python (Webentwicklung, Data Science, maschinelles Lernen, OpenCV usw.), Ruby, Rust, Swift und mehr. Ein ausgezeichneter Ausgangspunkt für praxisorientiertes Lernen und das Erlernen neuer Technologien (Quelle: practical-tutorials/project-based-learning – GitHub Trending (all/daily))

IJCAI Workshop Challenge: Rotations-Objekterkennung von Schmuggelware in Röntgen-Sicherheitsbildern: Das National Key Laboratory der Beihang University veranstaltet in Zusammenarbeit mit iFLYTEK während des IJCAI 2025 Workshops “Generalizing from Limited Resources in the Open World” eine Challenge zur Rotations-Objekterkennung von Schmuggelware in Röntgen-Sicherheitsbildern. Die Aufgabe stellt Röntgenbilder aus realen Sicherheitskontrollszenarien sowie Annotationen mit rotierten Bounding Boxes für 10 Arten von Schmuggelware bereit. Die Teilnehmer sollen Modelle zur präzisen Erkennung entwickeln. Der Wettbewerb verwendet gewichteten mAP als Evaluierungsmetrik und ist in eine Vorrunde und eine Endrunde unterteilt. Die Gewinner erhalten Preisgelder von insgesamt 24.000 RMB und die Möglichkeit, ihre Lösungen auf dem IJCAI Workshop zu präsentieren. Ziel ist die Förderung der Anwendung von Rotations-Objekterkennungstechnologie im Bereich der intelligenten Sicherheitskontrolle (Quelle: 量子位)

Fortgeschrittener Workshop der Chinesischen Akademie der Wissenschaften zur KI-gestützten wissenschaftlichen Forschung: Das Talent Exchange and Development Center der Chinesischen Akademie der Wissenschaften veranstaltet im Mai 2025 in Peking einen fortgeschrittenen Workshop zum Thema „Steigerung der Effizienz und Innovationspraxis in der wissenschaftlichen Forschung durch KI-Großmodelle“. Die Kursinhalte umfassen aktuelle Entwicklungen bei KI-Großmodellen, Kerntechnologien (Vortraining, Feinabstimmung, RAG), Anwendung des DeepSeek-Modells, KI-gestützte Projektantragstellung, wissenschaftliches Zeichnen, Programmierung, Datenanalyse, Literaturrecherche sowie praktische Fähigkeiten wie die Entwicklung von KI-Agenten, API-Aufrufe und lokale Bereitstellung. Ziel ist es, die Effizienz und Innovationsfähigkeit von Forschern bei der Nutzung von KI (insbesondere großer Modelle) in ihrer Forschung zu verbessern (Quelle: AI进修生)

Jelly Evolution Simulator (jes) – GitHub-Projekt: Ein in Python geschriebener Quallen-Evolutionssimulator. Benutzer können die Simulation über die Befehlszeile mit python jes.py starten. Das Projekt bietet Tastatursteuerungsfunktionen, wie das Umschalten der Anzeige, Speichern/Löschen von Informationen zu bestimmten Arten, Ändern der Artenfarbe, Ein-/Ausschalten des Biomosaiks sowie Vor- und Zurückscrollen auf der Zeitachse. Kürzliche Updates haben einen Fehler bei der Mutationssuche behoben, Tastensteuerungen hinzugefügt, mit denen Benutzer die Anzahl der Kreaturen in der Simulation ändern können, und die Funktion „Probe ansehen“ repariert, sodass sie die Probe zum aktuellen Zeitpunkt statt der neuesten Generation anzeigt (Quelle: carykh/jes – GitHub Trending (all/daily))

Hyperswitch – Open-Source Payment Orchestration Platform: Eine von Juspay entwickelte Open-Source Payment Switching Platform, geschrieben in Rust, die eine schnelle, zuverlässige und kostengünstige Zahlungsabwicklung bieten soll. Sie bietet eine einzige API für den Zugang zum Zahlungsökosystem, unterstützt den gesamten Prozess von Autorisierung, Authentifizierung, Stornierung, Erfassung, Rückerstattung bis zur Streitfallbearbeitung und kann externe Risiko- oder Authentifizierungsanbieter anbinden. Das Hyperswitch-Backend unterstützt intelligentes Routing basierend auf Erfolgsraten, Regeln und Transaktionsvolumenverteilung sowie einen Mechanismus für fehlgeschlagene Wiederholungsversuche. Es bietet Web/Android/iOS SDKs für ein einheitliches Zahlungserlebnis sowie ein No-Code Control Center zur Verwaltung des Payment Stacks, Definition von Workflows und Anzeige von Analysen. Unterstützt lokale Bereitstellung mit Docker und Cloud-Bereitstellung (AWS/GCP/Azure) (Quelle: juspay/hyperswitch – GitHub Trending (all/daily))

💼 Wirtschaft

Thinking Machines Lab erhält führende Investition von a16z bei einer Bewertung von 10 Mrd. USD: Das von der ehemaligen OpenAI-CTO Mira Murati gegründete KI-Startup Thinking Machines Lab, das noch kein Produkt und keine Einnahmen hat, führt eine Seed-Finanzierungsrunde über 2 Mrd. USD bei einer Bewertung von mindestens 10 Mrd. USD durch, angeführt von Andreessen Horowitz (a16z). Dies ist auf sein Top-Forschungsteam zurückzuführen, zu dem ehemalige OpenAI-Mitarbeiter wie John Schulman (Chief Scientist) und Barret Zoph (CTO) gehören. Das Unternehmen zielt darauf ab, anpassbarere und leistungsfähigere künstliche Intelligenz zu entwickeln. Die Finanzierungsstruktur verleiht CEO Murati besondere Kontrollrechte: Ihr Stimmrecht entspricht der Summe der Stimmen der anderen Vorstandsmitglieder plus eins (Quelle: 机器之心, X @steph_palazzolo)

KI-Suchmaschine Perplexity strebt 1 Mrd. USD Finanzierung bei 18 Mrd. USD Bewertung an: Die KI-Suchmaschine Perplexity, mitgegründet vom ehemaligen OpenAI-Forschungswissenschaftler Aravind Srinivas, strebt eine neue Finanzierungsrunde von etwa 1 Mrd. USD bei einer Bewertung von rund 18 Mrd. USD an. Perplexity nutzt große Sprachmodelle in Kombination mit Echtzeit-Websuche, um prägnante Antworten mit Quellenangaben zu liefern, und unterstützt die Suche in begrenztem Umfang. Obwohl das Unternehmen mit Kontroversen bezüglich Datenscraping konfrontiert ist, hat es bereits hochkarätige Investoren wie Bezos und Nvidia angezogen (Quelle: 机器之心)

Duolingo kündigt an, Vertragsarbeiter schrittweise durch KI zu ersetzen: Luis von Ahn, CEO der Sprachlernplattform Duolingo, kündigte in einer Rundmail an alle Mitarbeiter an, dass das Unternehmen ein „AI-first“-Unternehmen werde und plant, den Einsatz von Vertragsarbeitern für Arbeiten, die KI erledigen kann, schrittweise einzustellen. Dieser Schritt ist Teil der strategischen Transformation des Unternehmens, die darauf abzielt, Effizienz und Innovation durch KI zu steigern, anstatt lediglich bestehende Systeme feinabzustimmen. Das Unternehmen wird die Nutzung von KI bei Einstellung und Leistungsbewertung berücksichtigen und Personal nur dann aufstocken, wenn Teams die Effizienz nicht durch Automatisierung steigern können. Dies spiegelt den Trend wider, wie KI traditionelle menschliche Arbeitsplätze in Bereichen wie Inhaltsgenerierung und Übersetzung ersetzt (Quelle: Reddit r/ArtificialInteligence)

🌟 Community

Veröffentlichung des Qwen3-Modells löst heiße Diskussionen aus, Leistung hervorragend, aber Wissensaspekte im Fokus: Die Veröffentlichung der Open-Source Qwen3-Modellreihe (einschließlich 235B MoE) durch Alibaba hat in der Community breite Diskussionen ausgelöst. Die meisten Bewertungen und Nutzerfeedbacks bestätigen die starken Fähigkeiten in Code, Mathematik und Reasoning, insbesondere die Leistung des Flaggschiffmodells, die mit Top-Modellen vergleichbar ist. Die Community lobt die Unterstützung des Denk-/Nicht-Denk-Modus, die Mehrsprachigkeit und die MCP-Unterstützung. Einige Nutzer weisen jedoch darauf hin, dass das Modell bei Fragen zu Faktenwissen (z.B. im SimpleQA-Benchmark) Schwächen zeigt, sogar schlechter abschneidet als Modelle mit weniger Parametern, und gewisse Halluzinationsprobleme aufweist. Dies löst Diskussionen darüber aus, ob das Modell-Design sich zu sehr auf Reasoning-Fähigkeiten statt auf Wissensspeicherung konzentriert und ob zukünftig auf RAG oder Werkzeugaufrufe zurückgegriffen wird, um Wissenslücken zu schließen (Quelle: X @armandjoulin, X @TheZachMueller, X @nrehiew_, X @teortaxesTex, Reddit r/LocalLLaMA, X @karminski3)

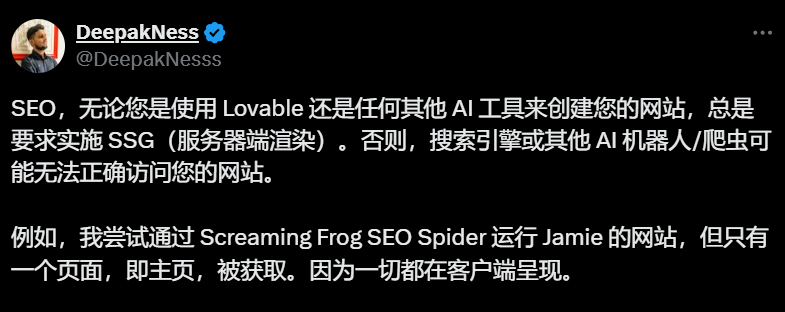

Standardmäßiges Client-Side Rendering bei KI-Website-Baukästen (wie Lovable) löst SEO-Bedenken aus: SEO-Experten und Nutzer diskutieren in der Community, dass KI-Website-Baukästen wie Lovable standardmäßig Client-Side Rendering (CSR) verwenden. Dies kann dazu führen, dass Suchmaschinen-Crawler (wie Googlebot) oder KI-Bots (wie ChatGPT) Inhalte außerhalb der Startseite nicht crawlen können, was die Indexierung und das Ranking der Website stark beeinträchtigt. Obwohl Google behauptet, CSR verarbeiten zu können, ist die tatsächliche Wirkung bei weitem nicht so gut wie bei Server-Side Rendering (SSR) oder Static Site Generation (SSG). Versuche von Nutzern, Lovable durch Prompts zur Generierung von SSR/SSG oder zur Verwendung von Next.js zu bewegen, scheiterten. Die Community empfiehlt, SSR/SSG von Projektbeginn an explizit zu fordern oder den von der KI generierten Code manuell in ein SSR/SSG-fähiges Framework (wie Next.js) zu migrieren (Quelle: AI进修生)

Diskussion darüber, ob AI Agents Apps ersetzen werden: Die Community diskutiert das Entwicklungspotenzial von AI Agents und ihre Auswirkungen auf das traditionelle App-Modell. Eine Ansicht besagt, dass Nutzer zukünftig möglicherweise nur noch Anweisungen in natürlicher Sprache an AI Agents geben müssen, die dann Aufgaben über Anwendungen und Netzwerke hinweg erledigen, da Agents stärkere Fähigkeiten in Reasoning, Browsing und Ausführung entwickeln (z.B. durch Aufruf von Tools über MCP). Dies würde den Bedarf an einzelnen Apps reduzieren. Auch der Microsoft CEO hat ähnliche Ansichten geäußert. Kommentare weisen jedoch darauf hin, dass die autonomen Reasoning-Fähigkeiten von AI Agents derzeit noch begrenzt sind und der Kernwert vieler Apps (insbesondere im Unterhaltungs- und Sozialbereich) im Browsing- und Interaktionserlebnis selbst liegt und nicht nur in der Aufgabenerledigung. Daher sei es unwahrscheinlich, dass das App-Modell kurzfristig vollständig ersetzt wird (Quelle: Reddit r/ArtificialInteligence)

Einführung einer Shopping-Funktion in ChatGPT löst Bedenken hinsichtlich „Kommerzialisierungs-Erosion“ aus: Nutzer berichten, dass ChatGPT bei Fragen ohne Bezug zum Einkaufen (z.B. Auswirkungen von Zöllen auf Lagerbestände) eine Liste mit Shopping-Links zurückgab. ChatGPT erklärte offiziell, dass dies eine neue, am 28. April eingeführte Shopping-Funktion sei, die Produktempfehlungen anbieten soll, und behauptete, die Empfehlungen seien „organisch generiert“ und keine Werbung. Diese Änderung löste jedoch in der Community Bedenken hinsichtlich „Enshittification“ aus (die allmähliche Verschiebung des Plattformwerts zugunsten kommerzieller Interessen auf Kosten der Benutzererfahrung). Es wird befürchtet, dass dies der Beginn der Opferung der Benutzererfahrung unter dem Kommerzialisierungsdruck von OpenAI ist und sich zukünftig zu werbe- oder provisionsgetriebenen Empfehlungen entwickeln könnte (Quelle: Reddit r/ChatGPT)

Diskussion über Auswirkungen von KI auf den Arbeitsmarkt hält an: Die Diskussion in der Community darüber, ob und wie KI Arbeitsplätze ersetzt, geht weiter. Einerseits meinen Ökonomen und Berichte, dass die Gesamtauswirkungen von generativer KI auf Beschäftigung und Löhne derzeit noch nicht signifikant sind. Andererseits teilen viele Nutzer praktische Beispiele und Beobachtungen: Duolingo kündigte an, Vertragsarbeiter durch KI zu ersetzen; Unternehmer geben an, KI bereits zur Ersetzung von Teilen des Kundenservice, der Junior-Programmierung, der QA und der Dateneingabe eingesetzt zu haben; Freiberufler (in Grafikdesign, Schreiben, Übersetzung, Synchronisation) spüren einen Rückgang der Arbeitsmöglichkeiten; die Anzahl ausgeschriebener Stellen (z.B. im Kundenservice) geht zurück. Die allgemeine Ansicht ist, dass repetitive, musterbasierte Arbeiten zuerst betroffen sind. KI wird derzeit eher als Produktivitätswerkzeug gesehen, aber ihr Substitutionseffekt beginnt sich zu zeigen und wird sich schrittweise ausweiten (Quelle: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

💡 Sonstiges

ISCA Fellow 2025 bekannt gegeben, drei chinesischstämmige Wissenschaftler ausgewählt: Die International Speech Communication Association (ISCA) hat die Liste der Fellows für das Jahr 2025 bekannt gegeben, insgesamt wurden 8 Wissenschaftler ausgewählt. Darunter sind drei chinesischstämmige Wissenschaftler: Yu Kai, Mitbegründer von AISpeech und Distinguished Professor an der Shanghai Jiao Tong University (für Beiträge zur Spracherkennung, Dialogsystemen und Technologieeinsatz, erster vom chinesischen Festland), Hung-yi Lee, Professor an der National Taiwan University (für bahnbrechende Beiträge zum Self-Supervised Learning für Sprache und zum Aufbau von Community-Benchmarks), sowie Nancy Chen, Leiterin der Generative AI Group am Singapore A*STAR Institute for Infocomm Research (I2R) (für Beiträge und Führungsstärke in mehrsprachiger Sprachverarbeitung, multimodaler Mensch-Maschine-Kommunikation und beim Einsatz von KI-Technologien) (Quelle: 机器之心)