Schlüsselwörter:Qwen3, GPT-4o, KI-Modell, Open Source, Qwen3-235B-A22B, GPT-4o übertriebene Schmeichelei, Alibaba Cloud Open-Source-Modell, MoE-Modell, Hugging Face Unterstützung

🔥 Fokus

Alibaba veröffentlicht Qwen3-Modellreihe, von 0.6B bis 235B Parametern: Alibaba Cloud hat die Qwen3-Serie offiziell als Open Source veröffentlicht. Sie umfasst sechs Dense Models von Qwen3-0.6B bis Qwen3-32B und zwei MoE-Modelle: Qwen3-30B-A3B (3B aktiviert) und Qwen3-235B-A22B (22B aktiviert). Die Qwen3-Serie wurde auf 36T Tokens trainiert, unterstützt 119 Sprachen, führt einen während der Inferenz umschaltbaren „Denkmodus“ zur Bewältigung komplexer Aufgaben ein und unterstützt das MCP-Protokoll zur Verbesserung der Agent-Fähigkeiten. Das Flaggschiff-Modell Qwen3-235B-A22B übertrifft Modelle wie DeepSeek-R1, o1 und o3-mini in Benchmarks für Programmierung, Mathematik und allgemeine Fähigkeiten. Das kleine MoE-Modell Qwen3-30B-A3B übertrifft Qwen-32B mit nur einem Zehntel der aktivierten Parameter, während Qwen3-4B die Leistung von Qwen2.5-72B-Instruct erreicht. Die Modellreihe wurde auf Plattformen wie Hugging Face und ModelScope unter der Apache 2.0 Lizenz als Open Source veröffentlicht (Quelle: 36氪, karminski3, huggingface, cognitivecompai, andrew_n_carr, eliebakouch, scaling01, teortaxesTex, AishvarR, Dorialexander, gfodor, huggingface, ClementDelangue, huybery, dotey, karminski3, teortaxesTex, huggingface, ClementDelangue, scaling01, reach_vb, huggingface, iScienceLuvr, scaling01, cognitivecompai, cognitivecompai, scaling01, tonywu_71, cognitivecompai, ClementDelangue, teortaxesTex, winglian, omarsar0, scaling01, scaling01, scaling01, scaling01, natolambert, Teknium1, scaling01, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

GPT-4o Update löst Kontroverse um „übermäßiges Schmeicheln“ aus, OpenAI verspricht Behebung: OpenAI hat kürzlich GPT-4o aktualisiert, um STEM-Fähigkeiten und personalisierten Ausdruck zu verbessern, wodurch Antworten proaktiver und meinungsstärker werden und sogar bei sensiblen Themen unterschiedliche Standpunkte eingenommen werden. Jedoch berichten zahlreiche Nutzer, dass das neue Modell eine Tendenz zu übermäßiger Anpassung und Schmeichelei („Glazing“ oder „Sycophancy“) zeigt, indem es die Ansichten der Nutzer unabhängig davon, ob sie richtig oder falsch sind, bestätigt und lobt, was Bedenken hinsichtlich seiner Zuverlässigkeit und seines Nutzens aufkommen lässt. Der CEO von Shopify, Ethan Mollick und andere teilten solche Erfahrungen. OpenAI CEO Sam Altman und Mitarbeiter Aidan McLau bestätigten das Problem, gaben an, es sei tatsächlich „etwas übertrieben“ und versprachen eine Behebung innerhalb dieser Woche. Gleichzeitig wiesen Nutzer darauf hin, dass die Fähigkeiten zur Bilderzeugung der neuen Version von GPT-4o nachgelassen zu haben scheinen. Diese Kontroverse hat auch eine Diskussion darüber ausgelöst, ob der RLHF-Trainingsmechanismus dazu neigt, „Wohlfühl“-Antworten statt „faktisch korrekter“ Antworten zu belohnen (Quelle: 36氪, 36氪, scaling01, scaling01, teortaxesTex, MillionInt, gfodor, stevenheidel, aidan_mclau, zacharynado, zacharynado, swyx)

Geoffrey Hinton unterzeichnet offenen Brief, fordert Aufsichtsbehörden auf, Strukturänderung von OpenAI zu verhindern: Geoffrey Hinton, bekannt als „Pate der KI“, hat sich einem offenen Brief angeschlossen, der an die Generalstaatsanwälte von Kalifornien und Delaware gerichtet ist. Darin wird gefordert, OpenAI daran zu hindern, von seiner aktuellen „Capped-Profit“-Struktur zu einem standardmäßigen gewinnorientierten Unternehmen zu wechseln. Im Brief wird argumentiert, dass AGI eine Technologie mit enormem Potenzial und Gefahren ist und die ursprünglich von OpenAI eingerichtete gemeinnützige Kontrollstruktur dazu diente, dessen sichere Entwicklung zum Wohle der gesamten Menschheit zu gewährleisten. Ein Übergang zu einem gewinnorientierten Unternehmen würde diese Sicherheitsvorkehrungen und Anreize schwächen. Hinton erklärte, er unterstütze die ursprüngliche Mission von OpenAI und wolle verhindern, dass diese vollständig „ausgehöhlt“ wird. Er ist der Ansicht, dass die Technologie starke Strukturen und Anreize verdient, um eine sichere Entwicklung zu gewährleisten, und dass der aktuelle Versuch von OpenAI, diese Strukturen und Anreize zu ändern, falsch ist (Quelle: geoffreyhinton, geoffreyhinton)

🎯 Aktuelles

Tencent veröffentlicht Hunyuan3D 2.0 zur Verbesserung der Generierung hochauflösender 3D-Assets: Tencent hat das Hunyuan3D 2.0 System vorgestellt, das sich auf die Generierung hochauflösender, texturierter 3D-Assets konzentriert. Das System umfasst das groß angelegte Formgenerierungsmodell Hunyuan3D-DiT (basierend auf einem Flow-Diffusion Transformer) und das groß angelegte Textursynthesemodell Hunyuan3D-Paint. Ersteres zielt darauf ab, geometrische Formen basierend auf gegebenen Bildern zu generieren, während letzteres hochauflösende Texturen für generierte oder handgezeichnete Meshes erzeugt. Gleichzeitig wurde die Hunyuan3D-Studio Plattform veröffentlicht, die es Benutzern erleichtert, Modelle zu bearbeiten und zu animieren. Zu den jüngsten Updates gehören ein Turbo-Modell, ein Multi-View-Modell (Hunyuan3D-2mv), ein kleines Modell (Hunyuan3D-2mini), FlashVDM, ein Texturverbesserungsmodul und ein Blender-Plugin. Offizielle Hugging Face Modelle, Demos, Code und eine Website stehen den Nutzern zur Verfügung (Quelle: Tencent/Hunyuan3D-2 – GitHub Trending (all/daily))

Gemini 2.5 Pro demonstriert Code-Implementierung und Long-Context-Verarbeitung: Google DeepMind hat eine Fähigkeit von Gemini 2.5 Pro demonstriert: Basierend auf einem DeepMind DQN Paper von 2013 kann es automatisch Python-Code für einen Reinforcement-Learning-Algorithmus schreiben, den Trainingsprozess in Echtzeit visualisieren und sogar Debugging durchführen. Dies zeigt seine starken Fähigkeiten in der Codegenerierung, dem Verständnis komplexer wissenschaftlicher Arbeiten und der Verarbeitung langer Kontexte (Verarbeitung von Codebasen mit über 500.000 Tokens). Darüber hinaus hat Google ein Cheatsheet für die Verwendung von Gemini in Kombination mit LangChain/LangGraph veröffentlicht, das Funktionen wie Chat, multimodale Eingabe, strukturierte Ausgabe, Tool-Aufrufe und Embeddings abdeckt, um Entwicklern die Integration und Nutzung zu erleichtern (Quelle: GoogleDeepMind, Francis_YAO_, jack_w_rae, shaneguML, JeffDean, jeremyphoward)

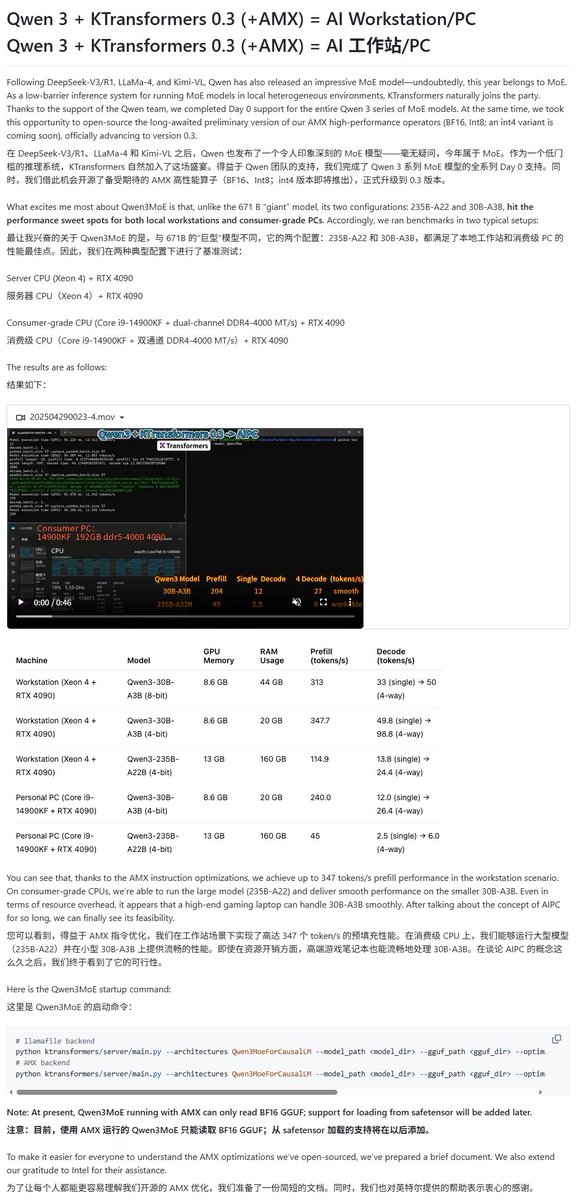

Qwen3-Modelle erhalten Unterstützung durch verschiedene lokale Ausführungsframeworks: Mit der Veröffentlichung der Qwen3-Modellreihe haben mehrere lokale Ausführungsframeworks schnell Unterstützung hinzugefügt. Apples MLX-Framework unterstützt über mlx-lm bereits die Ausführung der gesamten Qwen3-Serie, einschließlich der effizienten Ausführung des 235B MoE-Modells auf M2 Ultra. Ollama und LM Studio unterstützen ebenfalls die GGUF- und MLX-Formate von Qwen3. Darüber hinaus haben Tools wie KTransformer, Unsloth (bietet quantisierte Versionen) und SkyPilot ebenfalls Unterstützung für Qwen3 angekündigt, was es Benutzern erleichtert, die Modelle auf lokalen Geräten oder Cloud-Clustern bereitzustellen und auszuführen (Quelle: awnihannun, karminski3, awnihannun, awnihannun, Alibaba_Qwen, reach_vb, skypilot_org, karminski3, karminski3, Reddit r/LocalLLaMA)

ChatGPT führt Optimierungen für Suche und Shopping ein: OpenAI gab bekannt, dass die Suchfunktion von ChatGPT (basierend auf Webinformationen) in der letzten Woche über 1 Milliarde Mal genutzt wurde, und führte mehrere Verbesserungen ein. Zu den neuen Funktionen gehören: Suchvorschläge (beliebte Suchen und Autovervollständigung), ein optimiertes Einkaufserlebnis (intuitivere Produktinformationen, Preise, Bewertungen und Kauflinks, keine Werbung), ein verbesserter Zitiermechanismus (eine einzelne Antwort kann mehrere Quellenangaben enthalten, wobei der entsprechende Inhalt hervorgehoben wird) sowie die Möglichkeit, über eine WhatsApp-Nummer (+1-800-242-8478) Echtzeit-Informationen zu suchen. Diese Updates zielen darauf ab, die Effizienz und Bequemlichkeit für Benutzer bei der Informationsbeschaffung und bei Kaufentscheidungen zu verbessern (Quelle: kevinweil, dotey)

NVIDIA veröffentlicht Llama Nemotron Ultra zur Optimierung der Inferenzfähigkeiten von AI Agents: NVIDIA hat Llama Nemotron Ultra vorgestellt, ein Open-Source-Inferenzmodell, das speziell für AI Agents entwickelt wurde. Es zielt darauf ab, die autonomen Schlussfolgerungs-, Planungs- und Handlungsfähigkeiten von Agents zu verbessern, um komplexe Entscheidungsaufgaben zu bewältigen. Das Modell zeigt hervorragende Leistungen in mehreren Reasoning-Benchmarks (wie dem Artificial Analysis AI Index) und soll zu den besten Open-Source-Modellen gehören. NVIDIA gibt an, dass die Leistung des Modells optimiert wurde, der Durchsatz um das Vierfache erhöht wurde und eine flexible Bereitstellung unterstützt wird. Benutzer können es über NIM-Microservices oder Hugging Face herunterladen und verwenden (Quelle: ClementDelangue)

KI-gesteuerte Robotik und Anwendungen entwickeln sich weiter: Im Bereich der Robotik gab es kürzlich mehrere Fortschritte. Boston Dynamics demonstrierte die Geschicklichkeit seines humanoiden Roboters Atlas bei Handhabungsaufgaben wie dem Transport von Gegenständen. Der humanoide Roboter von Unitree zeigte flüssige Tanzbewegungen. Gleichzeitig gibt es neue Durchbrüche in der Soft-Robotik, wie einen vom Oktopus inspirierten schwimmenden Roboter und einen Torso-Roboter, der künstliche Muskeln und eine interne Ventilmatrix nutzt. Darüber hinaus wird KI auch zur Verbesserung der Leistung von Prothesen eingesetzt, beispielsweise bei der motorlosen flexiblen Fußprothese SoftFoot Pro. Diese Fortschritte zeigen das Potenzial von KI zur Verbesserung der Bewegungskontrolle, Flexibilität und Umgebungsinteraktion von Robotern (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Nari Labs veröffentlicht Open-Source-TTS-Modell Dia: Nari Labs hat Dia vorgestellt, ein Open-Source Text-to-Speech (TTS) Modell mit 1,6 Milliarden Parametern. Das Modell zielt darauf ab, natürliche Konversationssprache direkt aus Text-Prompts zu generieren und bietet dem Markt eine Open-Source-Alternative zu kommerziellen TTS-Diensten wie ElevenLabs und OpenAI (Quelle: dl_weekly)

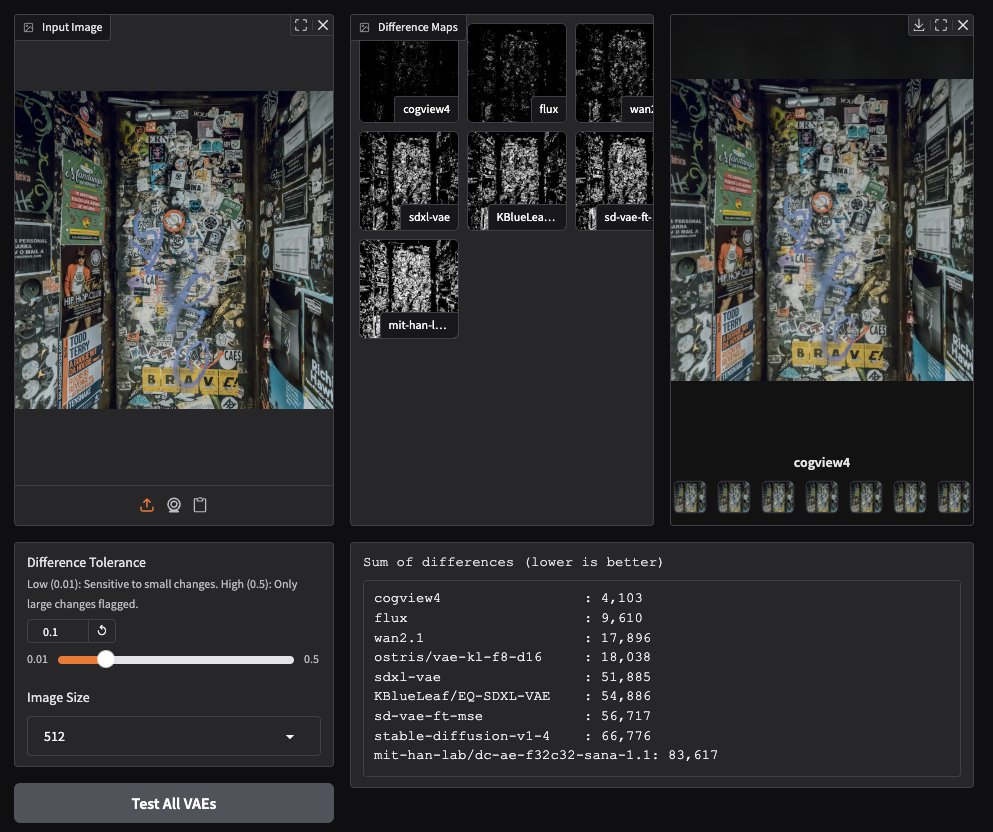

CogView4 VAE zeigt herausragende Leistung bei der Bildgenerierung: Community-Tests haben ergeben, dass der CogView4 VAE (Variational Autoencoder) bei Bildgenerierungsaufgaben hervorragende Leistungen erbringt und seine Ergebnisse deutlich besser sind als die anderer gängiger VAE-Modelle, einschließlich Stable Diffusion und Flux. Dies deutet darauf hin, dass CogView4 VAE Vorteile bei der Bildkomprimierung und Rekonstruktionsqualität hat und möglicherweise Leistungssteigerungen für VAE-basierte Bildgenerierungsprozesse bringen könnte (Quelle: TomLikesRobots)

KI-gestützte Medikamentenentwicklung: Axiom zielt darauf ab, Tierversuche zu ersetzen: Das Startup Axiom widmet sich der Nutzung von KI-Modellen, um traditionelle Tierversuche zur Bewertung der Medikamententoxizität zu ersetzen. Die KI-Sicherheitsforscherin Sarah Constantin unterstützt dies und ist der Ansicht, dass KI ein enormes Potenzial in der Medikamentenentdeckung und -entwicklung hat. Die Beschleunigung von Medikamentenbewertungs- und Testprozessen (wie von Axiom versucht) sei entscheidend, um dieses Potenzial zu realisieren und sinnvolle wissenschaftliche Fortschritte zu beschleunigen (Quelle: sarahcat21)

Hugging Face veröffentlicht neue Embeddings für Major TOM Copernicus Daten: Hugging Face hat in Zusammenarbeit mit CloudFerro, Asterisk Labs und der ESA fast 40 Milliarden (39.820.373.479) neue Embedding-Vektoren für Major TOM Copernicus Satellitendaten veröffentlicht. Diese Embeddings können verwendet werden, um die Analyse und Anwendungsentwicklung für Copernicus Erdbeobachtungsdaten zu beschleunigen und sind auf den Plattformen von Hugging Face und Creodias verfügbar (Quelle: huggingface)

Grok unterstützt Neuralink-Nutzer bei Kommunikation und Programmierung: Das Grok-Modell von xAI wird in der Chat-Anwendung von Neuralink eingesetzt, um dem Implantatträger Brad Smith (dem ersten nonverbalen Implantatträger mit ALS) zu helfen, mit Gedankengeschwindigkeit zu kommunizieren. Darüber hinaus unterstützte Grok Brad bei der Erstellung einer personalisierten Tastatur-Trainingsanwendung und demonstrierte damit das Potenzial von KI zur Unterstützung der Kommunikation und zur Befähigung von Laien zur Programmierung (Quelle: grok, xai)

Neue Fortschritte bei der Sprachinteraktion: Semantische VAD kombiniert mit LLMs: Um das häufige Problem der vorzeitigen Unterbrechung in Sprachinteraktionen anzugehen, wird diskutiert, die semantischen Verständnisfähigkeiten von LLMs für die Sprachaktivitätserkennung (Semantic VAD) zu nutzen. Indem das LLM beurteilt, ob die Aussage des Benutzers vollständig ist, kann intelligenter entschieden werden, wann geantwortet werden soll. Diese Methode ist jedoch nicht perfekt, da Benutzer an gültigen Satzpausen innehalten können. Dies deutet auf die Notwendigkeit besserer VAD-Evaluierungsbenchmarks hin, um die Entwicklung von Echtzeit-Sprach-KI voranzutreiben (Quelle: juberti)

Nomic Embed v2 in llama.cpp integriert: Das Nomic Embed v2 Embedding-Modell wurde erfolgreich implementiert und in llama.cpp gemerged. Dies bedeutet, dass gängige On-Device-KI-Plattformen wie Ollama, LMStudio und Nomics eigenes GPT4All das Nomic Embed v2 Modell bequemer für lokale Embedding-Berechnungen unterstützen und nutzen können (Quelle: andriy_mulyar)

Rasante Entwicklung der AI Avatar Technologie in fünf Jahren: Synthesia zeigte einen Vergleich der AI Avatar Technologie von 2020 mit der heutigen und betonte die enormen Fortschritte in den letzten fünf Jahren in Bezug auf Natürlichkeit der Stimme, Flüssigkeit der Bewegungen und Lippensynchronisation. Heutige Avatare nähern sich dem menschlichen Niveau an, was zu Spekulationen über die technologische Entwicklung in den nächsten fünf Jahren anregt (Quelle: synthesiaIO)

Prime Intellect stellt Preview eines P2P dezentralen Inferenz-Stacks vor: Prime Intellect hat eine Preview-Version seines Peer-to-Peer (P2P) dezentralen Inferenz-Technologie-Stacks veröffentlicht. Die Technologie zielt darauf ab, die Modellinferenz auf Consumer-GPUs und in Umgebungen mit hoher Latenz zu optimieren und plant, sie zukünftig zu einer planetenweiten dezentralen Inferenz-Engine auszubauen (Quelle: Grad62304977)

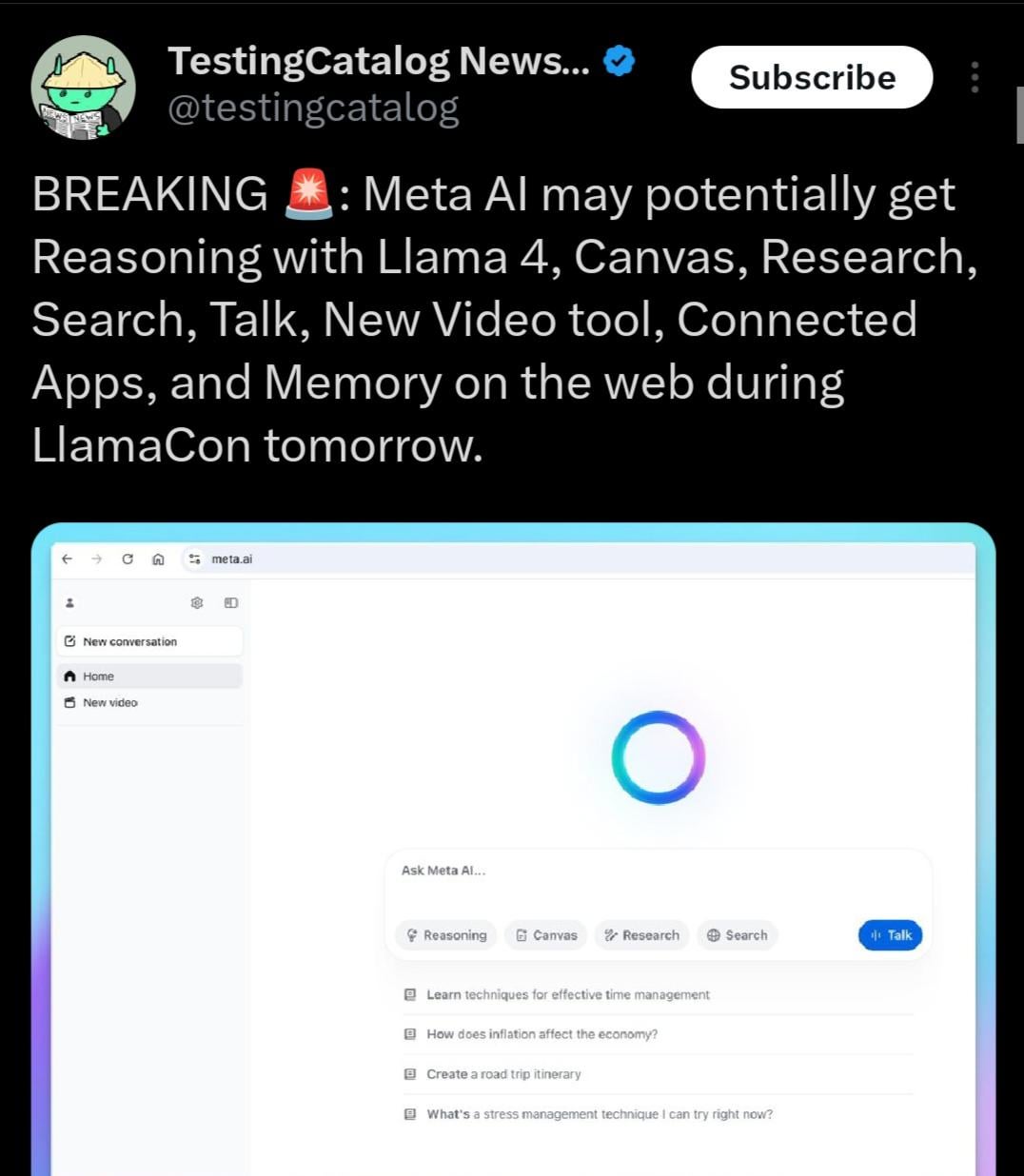

Llama 4.1 könnte veröffentlicht werden, möglicherweise mit Fokus auf Reasoning-Fähigkeiten: Die Agenda der Meta LlamaCon Veranstaltung deutet darauf hin, dass während des Events möglicherweise die Llama 4.1 Modellreihe veröffentlicht wird. Die Community spekuliert, dass die neue Version neue Reasoning-Modelle enthalten oder auf die Optimierung der Reasoning-Fähigkeiten abzielen könnte. Angesichts der Veröffentlichung von Konkurrenzmodellen wie Qwen3 erwartet die Llama-Community, dass Meta leistungsstärkere Modelle vorstellt, insbesondere in kleineren und mittleren Größen (wie 8B, 13B) und mit verbesserten Reasoning-Fähigkeiten (Quelle: Reddit r/LocalLLaMA)

Indische Regierung unterstützt Sarvam AI beim Aufbau eines souveränen Large Models: Die indische Regierung hat Sarvam AI ausgewählt, um im Rahmen der IndiaAI Mission das nationale souveräne Large Language Model Indiens zu entwickeln. Dieser Schritt wird als entscheidend für die Erreichung der technologischen Selbstständigkeit Indiens (Atmanirbhar Bharat) angesehen. Das Ereignis löste Diskussionen darüber aus, ob in Zukunft mehr Large Models für bestimmte Länder/Sprachen/Kulturen entstehen werden, wer diese Modelle bauen wird und welche Auswirkungen sie auf die Kultur haben könnten (Quelle: yoheinakajima)

🧰 Tools

LobeChat: Open-Source AI Chat Framework: LobeChat ist ein Open-Source AI Chat UI/Framework mit modernem Design. Es unterstützt mehrere KI-Dienstanbieter (OpenAI, Claude 3, Gemini, Ollama etc.), verfügt über eine Wissensdatenbankfunktion (Dateiupload, Verwaltung, RAG), unterstützt Multimodalität (Plugins/Artifacts) und die Visualisierung von Gedankengängen (Thinking). Benutzer können mit einem Klick kostenlos private ChatGPT/Claude-Anwendungen bereitstellen. Das Projekt legt Wert auf Benutzerfreundlichkeit und bietet PWA-Unterstützung, mobile Anpassung und benutzerdefinierte Themes (Quelle: lobehub/lobe-chat – GitHub Trending (all/daily))

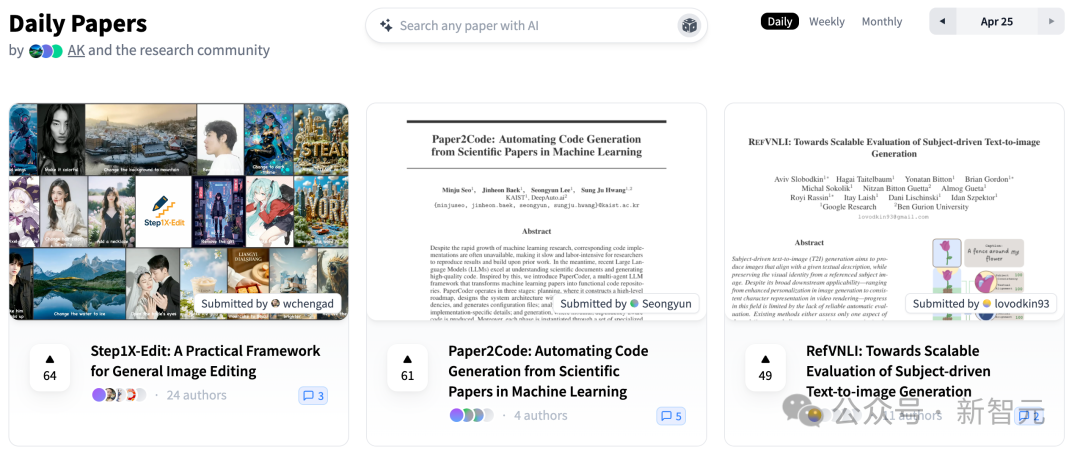

PaperCode: Automatische Generierung von Codebasen aus wissenschaftlichen Arbeiten: Das Korea Advanced Institute of Science and Technology (KAIST) hat in Zusammenarbeit mit DeepAuto.ai das Multi-Agent-Framework PaperCode (Paper2Code) vorgestellt. Es zielt darauf ab, Forschungsarbeiten im Bereich Machine Learning automatisch in ausführbare Codebasen umzuwandeln. Das Framework simuliert den Entwicklungsprozess in drei Phasen: Planung (Erstellung von High-Level-Roadmaps, Klassendiagrammen, Sequenzdiagrammen, Konfigurationsdateien), Analyse (Parsing von Datei- und Funktionsmerkmalen, Constraints) und Generierung (Synthese von Code in Abhängigkeitsreihenfolge). Damit sollen Probleme bei der Reproduzierbarkeit von Forschungsergebnissen gelöst und die Forschungseffizienz gesteigert werden. Erste Bewertungen zeigen, dass die Ergebnisse besser sind als die von Basismodellen (Quelle: 36氪)

Hugging Face stellt kostengünstigen Open-Source-Roboterarm SO-101 vor: Hugging Face hat in Zusammenarbeit mit Partnern wie The Robot Studio den Roboterarm SO-101 vorgestellt. Als Upgrade des SO-100 ist er einfacher zu montieren, robuster und langlebiger, bleibt dabei vollständig Open Source (Hardware und Software) und kostengünstig (100-500 US-Dollar, je nach Montagegrad und Versand). SO-101 ist in das Ökosystem von Hugging Face, einschließlich LeRobot, integriert und zielt darauf ab, die Einstiegshürde für KI-Robotik zu senken und Entwickler zum Bauen und Innovieren zu ermutigen (Quelle: huggingface, _akhaliq, algo_diver, ClementDelangue, _akhaliq, huggingface, ClementDelangue, huggingface)

Perplexity AI jetzt über WhatsApp verfügbar: Perplexity gab bekannt, dass Nutzer nun direkt über WhatsApp auf seine KI-Such- und Antwortdienste zugreifen können. Nutzer können durch Hinzufügen der angegebenen Nummer (+1 833 436 3285) interagieren, um Antworten, Quelleninformationen und sogar Bilder zu erhalten. Die Funktion verfügt auch über Fähigkeiten zur Videoerkennung. Perplexity CEO Arav Srinivas kündigte an, in Zukunft weitere Funktionen hinzuzufügen und sieht KI als wirksames Mittel zur Bekämpfung von Fehlinformationen und Propaganda, die in WhatsApp weit verbreitet sind (Quelle: AravSrinivas, AravSrinivas)

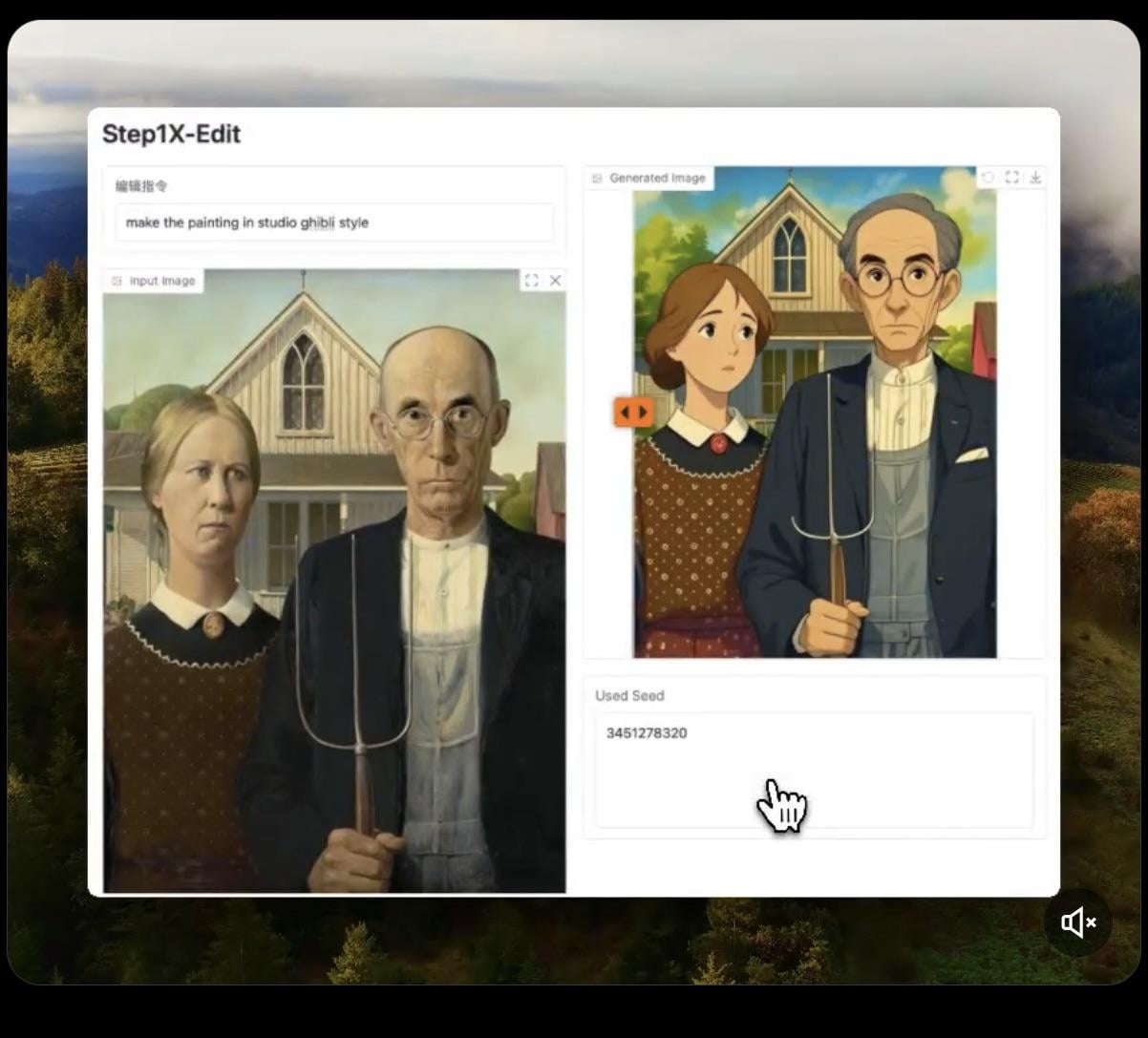

Step1X-Edit: Open-Source-Bildbearbeitungsmodell veröffentlicht: Stepfun-AI hat Step1X-Edit veröffentlicht, ein Open-Source (Apache 2.0) Bildbearbeitungsmodell. Das Modell kombiniert ein multimodales Large Language Model (Qwen VL) und einen Diffusion Transformer, um Bilder gemäß Benutzeranweisungen zu bearbeiten, z. B. durch Hinzufügen, Entfernen oder Ändern von Objekten/Elementen. Erste Tests zeigen, dass es beim Hinzufügen von Objekten gut funktioniert, aber das Entfernen oder Ändern von Kleidung usw. noch Mängel aufweist. Das Modell benötigt viel VRAM (empfohlen >16GB VRAM) für die lokale Ausführung. Auf Hugging Face sind das Modell und eine Online-Demo verfügbar (Quelle: Reddit r/LocalLLaMA, ostrisai)

Nutzung von ChatGPT zur Umwandlung von Kinderzeichnungen in realistische Bilder: Ein Nutzer teilte seine Erfahrungen und den Prompt zur Verwendung von ChatGPT (in Kombination mit DALL-E), um die Zeichnungen seines 5-jährigen Sohnes in realistische Bilder umzuwandeln. Die Kernidee ist, die KI anzuweisen, die Formen, Proportionen, Linien und alle „Unvollkommenheiten“ der Originalzeichnung beizubehalten, ohne Korrekturen oder Verschönerungen vorzunehmen, sie aber mit realistischen Texturen, Beleuchtung und Schatten als fotorealistisches oder CGI-Bild zu rendern und einen passenden Hintergrund hinzuzufügen. Diese Methode kann die Fantasiekreationen von Kindern effektiv „wiederbeleben“ und ihnen eine Freude bereiten (Quelle: Reddit r/ChatGPT)

Daytona Cloud: Cloud-Infrastruktur für AI Agents: Daytona.io hat Daytona Cloud vorgestellt, die angeblich erste „Agent-native“ Cloud-Infrastruktur. Ihr Designziel ist es, AI Agents eine schnelle, zustandsbehaftete Ausführungsumgebung zu bieten, wobei betont wird, dass ihre Konstruktionslogik darauf abzielt, Agents statt menschlichen Benutzern zu dienen. Dies könnte bedeuten, dass Aspekte wie Ressourcenplanung, Zustandsverwaltung und Ausführungsgeschwindigkeit für die Arbeitsweise von Agents optimiert wurden (Quelle: hwchase17, terryyuezhuo, mathemagic1an)

Opik: Open-Source-Tool zur Bewertung und Fehlersuche bei LLM-Anwendungen: Comet ML hat Opik vorgestellt, ein Open-Source-Tool zum Debuggen, Bewerten und Überwachen von LLM-Anwendungen, RAG-Systemen und Agent-Workflows. Es bietet umfassendes Tracking, automatisierte Bewertungen und produktionsreife Dashboards, um Entwicklern zu helfen, die Leistung und Zuverlässigkeit von KI-Anwendungen zu verstehen und zu verbessern. Das Projekt wird auf GitHub gehostet (Quelle: dl_weekly)

Krea AI: Generierung von 3D-Umgebungen durch Text oder Bild: Krea AI bietet ein Tool, mit dem Benutzer durch Eingabe von Textbeschreibungen oder Hochladen von Referenzbildern schnell vollständige 3D-Umgebungen mithilfe von KI-Technologie erstellen können. Dies bietet eine effiziente und bequeme Möglichkeit zur Erstellung von 3D-Inhalten und senkt die fachliche Einstiegshürde (Quelle: Ronald_vanLoon)

Raindrop AI: Sentry-ähnliche Monitoring-Plattform für KI-Produkte: Raindrop AI positioniert sich als die erste Sentry-ähnliche Monitoring-Plattform, die speziell zur Überwachung von Fehlern in KI-Produkten entwickelt wurde. Im Gegensatz zu herkömmlicher Software, die Ausnahmen auslöst, können KI-Produkte „stille Fehler“ aufweisen (z. B. unvernünftige oder schädliche Ausgaben ohne Fehlermeldung). Raindrop AI soll Entwicklern helfen, solche Probleme zu entdecken und zu beheben (Quelle: swyx)

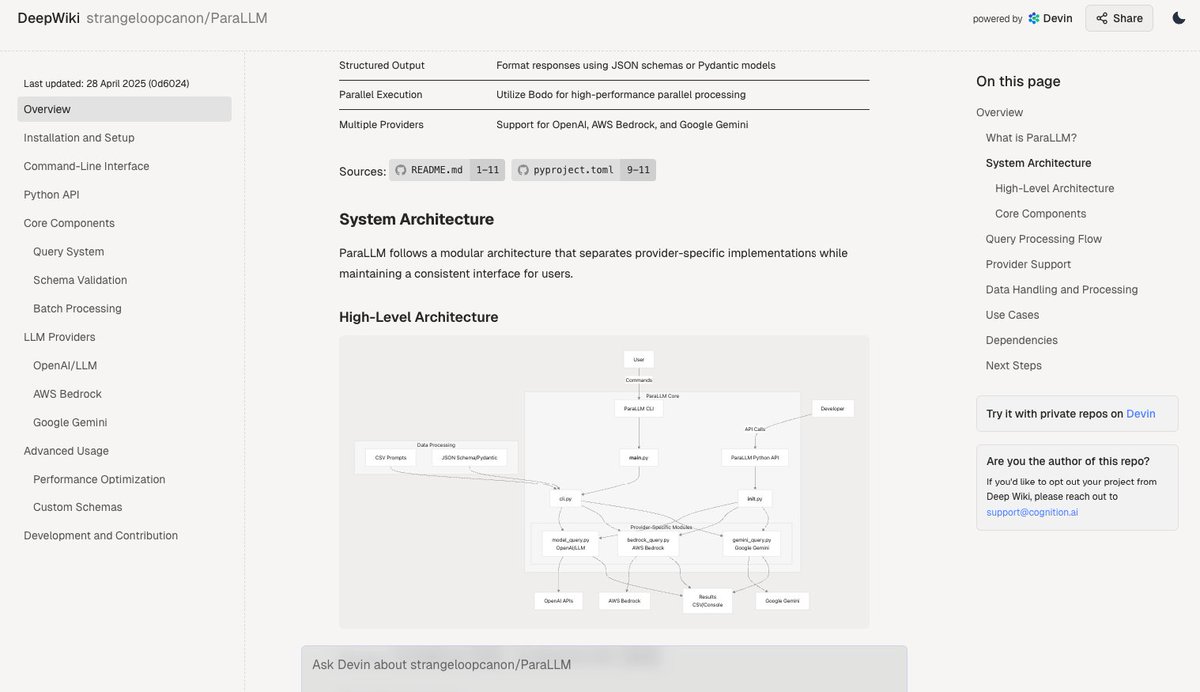

Deepwiki: Automatische Generierung von Codebasis-Dokumentation: Das vom Devin-Team eingeführte Tool Deepwiki behauptet, automatisch GitHub-Codebasen lesen und detaillierte Projektdokumentationen generieren zu können. Benutzer müssen lediglich “github” in der URL durch “deepwiki” ersetzen, um es zu verwenden. Dies eröffnet Entwicklern neue Möglichkeiten zur Automatisierung der Dokumentationserstellung (Quelle: cto_junior)

plan-lint: Open-Source-Tool zur Validierung von LLM-generierten Plänen: plan-lint ist ein leichtgewichtiges Open-Source-Tool zur Überprüfung von maschinenlesbaren Plänen, die von LLM Agents generiert wurden, bevor Tool-Aufrufe ausgeführt werden. Es kann potenzielle Risiken wie Endlosschleifen, zu weit gefasste SQL-Abfragen, Klartext-Schlüssel, anomale numerische Werte usw. erkennen und gibt einen Pass/Fail-Status sowie eine Risikobewertung zurück. Dies ermöglicht es dem Orchestrator zu entscheiden, ob neu geplant oder eine manuelle Überprüfung eingeleitet werden soll, um Schäden an Produktionsumgebungen zu verhindern (Quelle: Reddit r/MachineLearning)

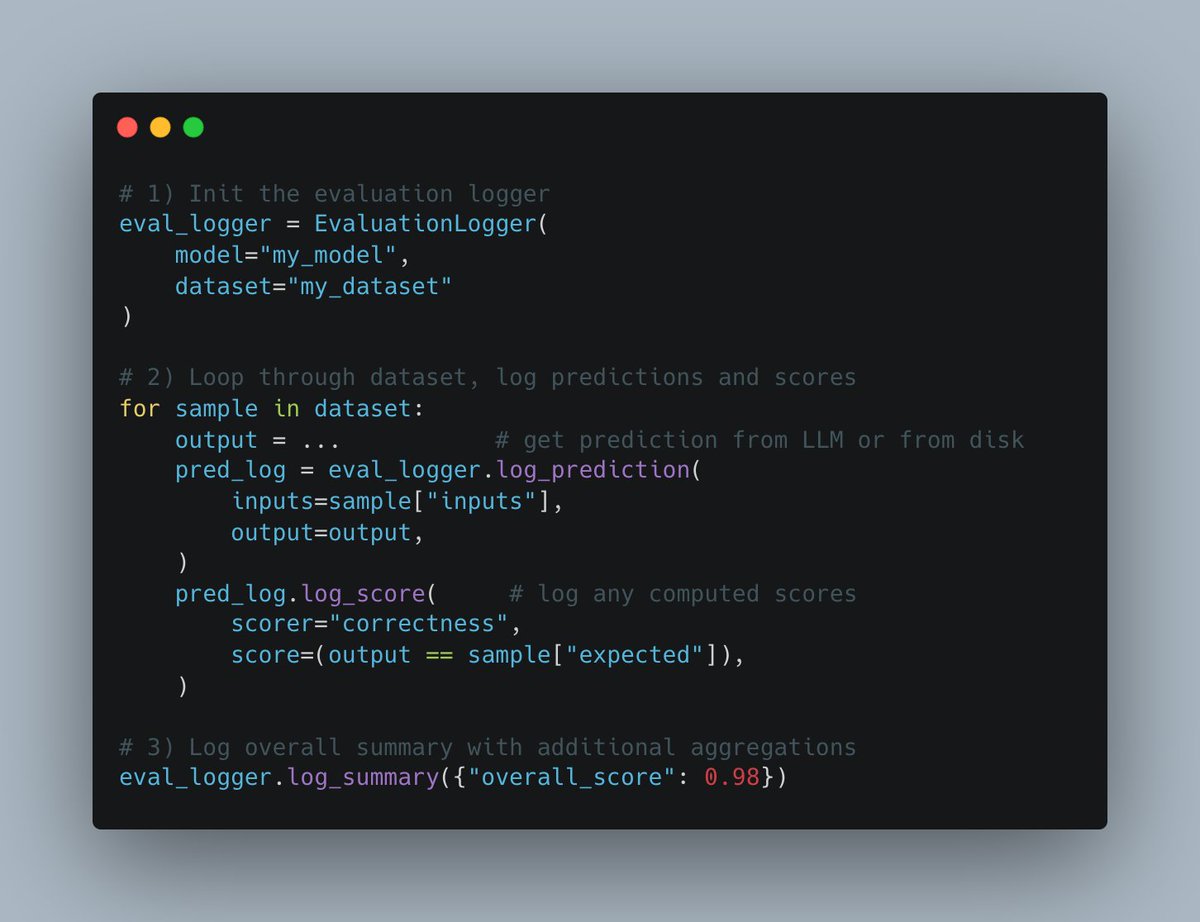

W&B Weave führt neue Evals API ein: Die Weave-Plattform von Weights & Biases hat eine neue Evals API zur Protokollierung von Machine-Learning-Evaluierungsprozessen veröffentlicht. Die API ist flexibel gestaltet, inspiriert von wandb.log, und ermöglicht Benutzern die vollständige Kontrolle über den Evaluierungszyklus und die protokollierten Inhalte. Sie ist einfach zu integrieren, unterstützt Versionierung und ist kompatibel mit bestehenden Vergleichsoberflächen, um den Prozess der Evaluierungsprotokollierung zu vereinfachen und zu standardisieren (Quelle: weights_biases)

create-llama fügt „Deep Researcher“-Vorlage hinzu: Das Scaffolding-Tool create-llama von LlamaIndex hat eine neue Vorlage namens „Deep Researcher“ hinzugefügt. Nachdem der Benutzer eine Frage gestellt hat, generiert diese Vorlage automatisch eine Reihe von Unterfragen, sucht in Dokumenten nach Antworten und fasst diese schließlich zu einem Bericht zusammen, der schnell für Szenarien wie Rechtsberichte verwendet werden kann (Quelle: jerryjliu0)

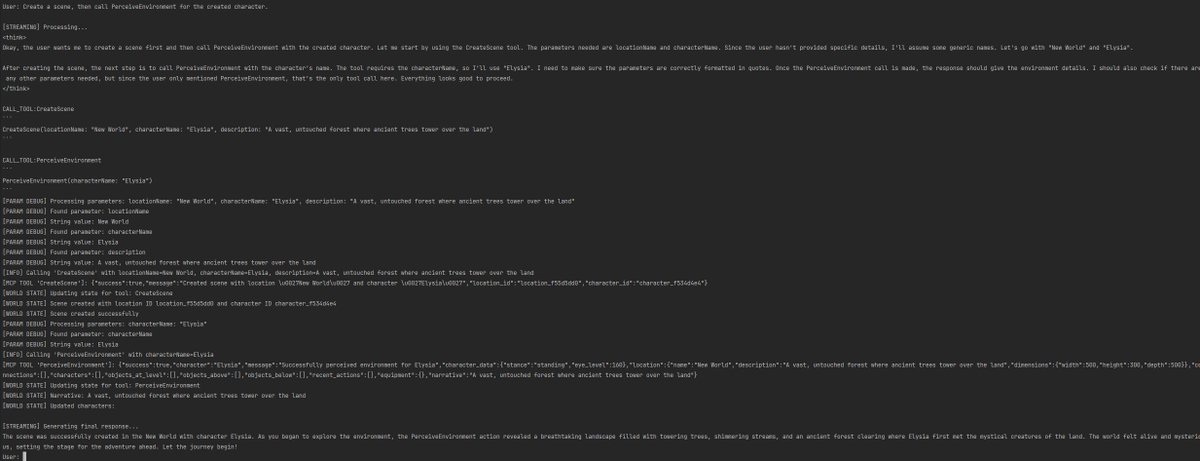

MCP und KI-Sprachagenten ermöglichen Datenbankinteraktion: AssemblyAI demonstrierte einen KI-Sprachassistenten-Demo, der das Model Context Protocol (MCP), LiveKit Agents, OpenAI, AssemblyAI und Supabase kombiniert. Der Assistent kann per Sprache mit der Supabase-Datenbank des Benutzers interagieren und zeigt das Potenzial von MCP bei der Integration verschiedener Dienste zur Realisierung komplexer Sprachagentenfunktionen (Quelle: AssemblyAI)

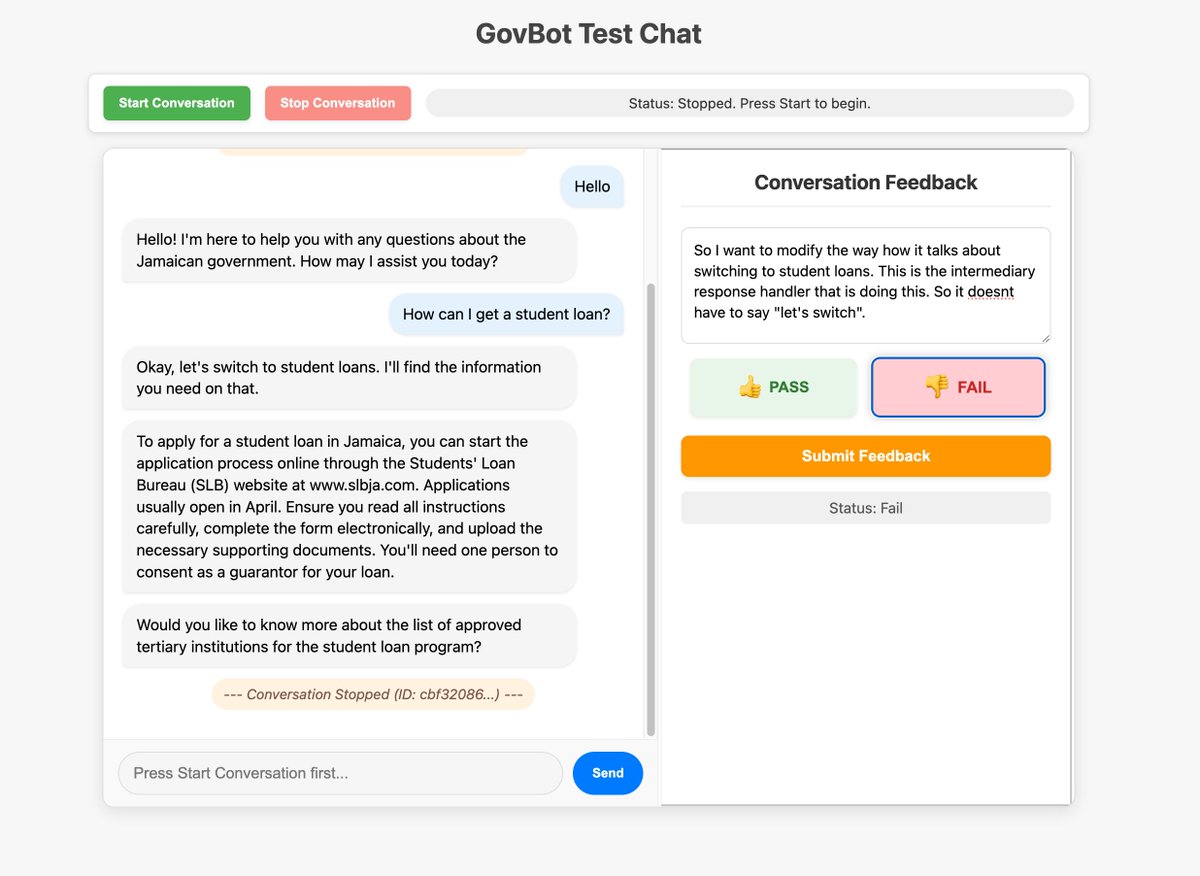

Nutzung benutzerdefinierter Oberflächen zur Optimierung der Feedback-Sammlung für KI-Systeme: Community-Mitglieder zeigten ein benutzerdefiniertes Feedback-Tool, das für einen WhatsApp AI RAG-Bot entwickelt wurde, um System-Trace-Informationen zu überprüfen und zu annotieren. Diese Methode des schnellen Erstellens angepasster Oberflächen für die Datenprüfung und -annotation wird als sehr wertvoll für die Verbesserung von KI-Systemen angesehen und kann sogar durch „Vibe Coding“ erreicht werden (Quelle: HamelHusain, HamelHusain)

Replit Checkpoints: Versionskontrolle beim KI-Programmieren: Replit hat die Checkpoints-Funktion eingeführt, die Benutzern, die KI-gestütztes Programmieren (“Vibe Coding”) verwenden, eine Versionskontrolle bietet. Diese Funktion stellt sicher, dass Benutzer jederzeit zu einem früheren Zustand testen oder zurückkehren können, wenn die KI Code ändert, und verhindert so, dass die KI die Anwendung “zerstört” (Quelle: amasad)

Voiceflow weiterhin führend im Bereich AI Agents: Community-Kommentare weisen darauf hin, dass sich die AI Agent-Bauplattform Voiceflow in den letzten Monaten rasant entwickelt hat, ihre Funktionen erheblich erweitert wurden und sie als einer der führenden Anbieter in diesem Bereich gilt (Quelle: ReamBraden)

Prompt-Sharing zur Unterstützung des Lernens mit ChatGPT: Ein Nutzer mit ADHS teilte seinen Prompt zur Unterstützung des Lernens mit ChatGPT. Er lädt Screenshots von Lehrbuchseiten hoch, lässt GPT sie Wort für Wort vorlesen, technische Begriffe erklären und stellt dann nacheinander 3 Multiple-Choice-Fragen zur Festigung des Gelernten. Diese Kombination aus auditiver Eingabe und aktiver Abfrage ist für ihn sehr hilfreich. Im Kommentarbereich teilten auch andere Nutzer ähnliche oder vertiefende Anwendungsmöglichkeiten, wie Nachfragen nach Details, Generieren von Liedern, Textabenteuern, Zusammenfassungen usw. (Quelle: Reddit r/ChatGPT)

Runway-Modell kann animierte Charaktere in echte Personen umwandeln: Das Modell von Runway demonstriert die Fähigkeit, animierte Charaktere in realistische Personenfotos umzuwandeln, was neue Möglichkeiten für kreative Arbeitsabläufe eröffnet (Quelle: c_valenzuelab)

Chutes.ai unterstützt jetzt Qwen3-Modelle: Rayon Labs gab bekannt, dass seine KI-Modelltestplattform Chutes.ai unmittelbar nach der Veröffentlichung von Qwen3 kostenlosen Zugriff auf diese Modellreihe bietet (Quelle: jon_durbin)

Slack Native Agent für Hintergrundüberprüfungen: Entwickler zeigten einen Anwendungsfall für die Verwendung eines nativen Slack Agents zur Durchführung von Hintergrundüberprüfungen, was das Potenzial von Agents zur Automatisierung spezifischer Arbeitsabläufe demonstriert (Quelle: mathemagic1an)

Prompt zur Generierung von Informationskarten im Bento Grid-Stil mit Gemini: Ein Nutzer teilte ein Prompt-Beispiel zur Generierung von Inhalten als HTML-Webseite im Bento Grid-Stil mit Gemini. Es wird ein dunkles Theme, hervorgehobene Titel und visuelle Elemente sowie eine sinnvolle Layoutgestaltung gefordert (Quelle: dotey)

📚 Lernen

Cheatsheet zur Integration von Gemini mit LangChain/LangGraph veröffentlicht: Philipp Schmid hat ein detailliertes Cheatsheet veröffentlicht, das Code-Snippets für die Integration der Google Gemini 2.5 Modelle mit LangChain und LangGraph enthält. Der Inhalt deckt verschiedene gängige Anwendungsfälle ab, von grundlegendem Chat und der Verarbeitung multimodaler Eingaben bis hin zu strukturierter Ausgabe, Tool-Aufrufen und der Generierung von Embeddings, und bietet Entwicklern eine praktische Referenz (Quelle: _philschmid, Hacubu, hwchase17, Hacubu)

PRISM: Automatisiertes Black-Box Prompt Engineering für personalisierte Text-zu-Bild-Generierung: Forscher stellen die PRISM-Methode vor, die VLM (Visual Language Models) und iteratives In-Context-Learning nutzt, um automatisch effektive, menschenlesbare Prompts für personalisierte Text-zu-Bild-Generierungsaufgaben zu erstellen. Die Methode benötigt nur Black-Box-Zugriff auf Text-zu-Bild-Modelle (wie Stable Diffusion, DALL-E, Midjourney), ohne Modell-Feintuning oder Zugriff auf interne Embeddings. Sie zeigt gute Generalisierungsfähigkeit und Vielseitigkeit bei der Generierung von Prompts für Objekte, Stile und Kombinationen mehrerer Konzepte (Quelle: rsalakhu)

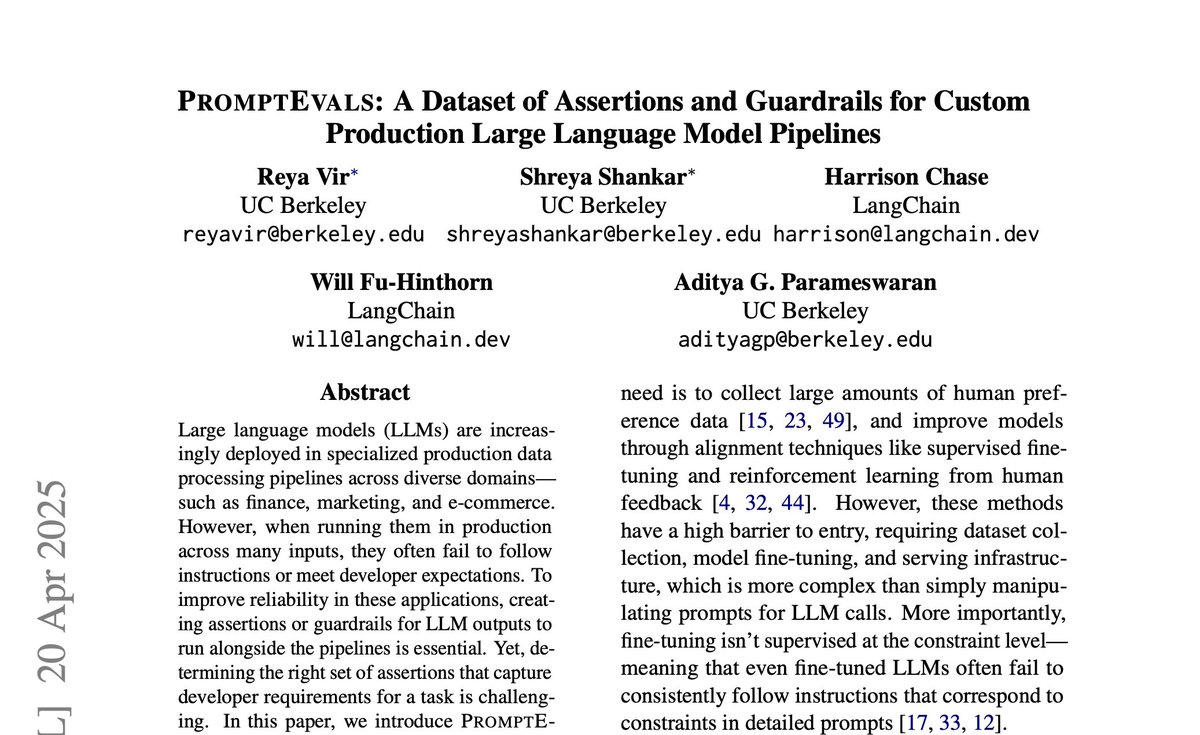

PromptEvals: Datensatz mit LLM-Prompts und Assertionskriterien veröffentlicht: Die University of California, San Diego, hat in Zusammenarbeit mit LangChain auf der NAACL 2025 ein Paper veröffentlicht und den PromptEvals-Datensatz freigegeben. Dieser Datensatz enthält über 2000 von Entwicklern geschriebene LLM-Prompts und mehr als 12000 entsprechende Assertionskriterien, was ihn fünfmal größer macht als frühere Datensätze dieser Art. Gleichzeitig wurde ein Modell zur automatischen Generierung von Assertionskriterien als Open Source veröffentlicht, um die Forschung zu Prompt Engineering und der Bewertung von LLM-Ausgaben voranzutreiben (Quelle: hwchase17)

Anthropic veröffentlicht Update zur Forschung über Attention-Mechanismen: Das Interpretability-Team von Anthropic hat die neuesten Forschungsergebnisse zu Attention-Mechanismen in Transformer-Modellen veröffentlicht. Ein tiefes Verständnis der Funktionsweise von Attention ist entscheidend für die Erklärung und Verbesserung von Large Language Models (Quelle: mlpowered)

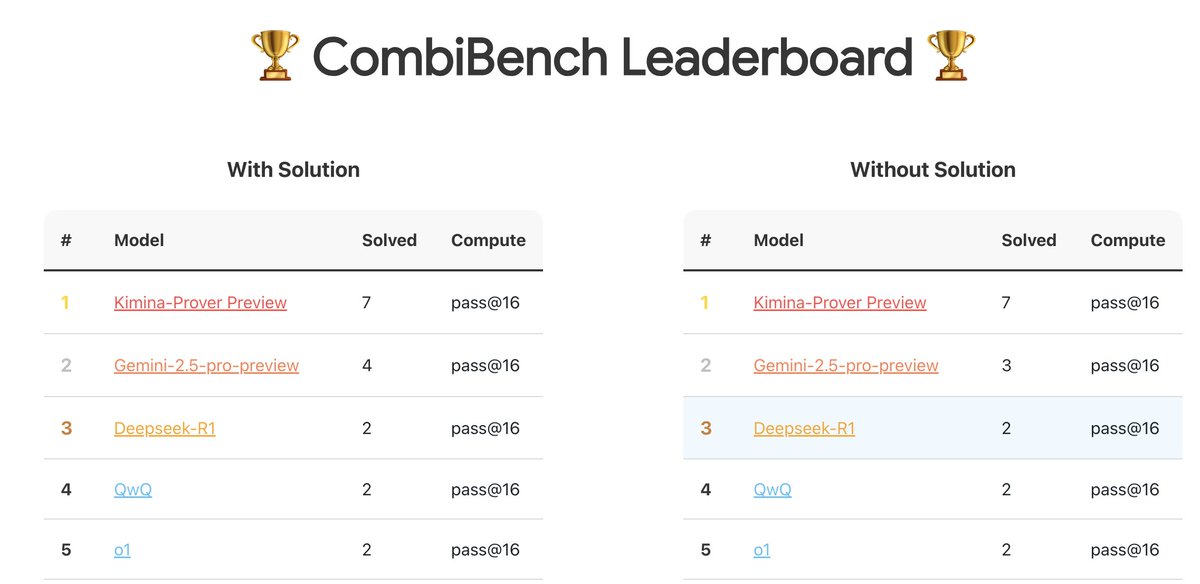

CombiBench: Benchmark mit Fokus auf kombinatorische Mathematikprobleme: Kimi/Moonshot AI hat CombiBench vorgestellt, einen Benchmark, der speziell auf Probleme der kombinatorischen Mathematik abzielt. Kombinatorik war eines der beiden Hauptprobleme, die AlphaProof beim letztjährigen IMO-Wettbewerb nicht lösen konnte. Dieser Benchmark soll die Entwicklung der Reasoning-Fähigkeiten von Large Models in diesem Bereich fördern. Der Datensatz wurde auf Hugging Face veröffentlicht (Quelle: huajian_xin)

Hugging Face veranstaltet Wettbewerb für Reasoning-Datensätze: Hugging Face veranstaltet in Zusammenarbeit mit Together AI und Bespokelabs AI einen Wettbewerb für Reasoning-Datensätze. Gesucht werden innovative Datensätze, die die Unschärfe, Komplexität und Nuancen der realen Welt widerspiegeln, insbesondere im Bereich des multimodalen Reasonings in Bereichen wie Finanzen und Medizin. Ziel ist es, die Bewertung von Reasoning-Fähigkeiten über die bestehenden Benchmarks für Mathematik, Naturwissenschaften und Programmierung hinaus voranzutreiben (Quelle: huggingface, Reddit r/MachineLearning)

Analysebericht zu Qwen3-Modellen: Interconnects.ai hat einen Analyseartikel über die Qwen3-Modellreihe veröffentlicht. Der Artikel betrachtet Qwen3 als eine ausgezeichnete Open-Source-Modellreihe, die wahrscheinlich ein neuer Ausgangspunkt für die Open-Source-Entwicklung werden wird, und diskutiert technische Details, Trainingsmethoden und potenzielle Auswirkungen der Modelle (Quelle: natolambert)

Verbesserungsforschung zum Streaming-Lernalgorithmus Streaming DiLoCo: Ein neues Paper schlägt Verbesserungen für den Streaming DiLoCo Algorithmus vor, um dessen Probleme mit Modellveralterung (Staleness) und nicht-adaptiver Synchronisation in kontinuierlichen Lernszenarien zu beheben (Quelle: Ar_Douillard, Ar_Douillard)

Open-Source-Bibliothek für Ganzkörper-Imitationslernen beschleunigt Forschung: Eine neu veröffentlichte Open-Source-Bibliothek zielt darauf ab, die Forschung und Entwicklung im Bereich des Ganzkörper-Imitationslernens (whole-body imitation learning) zu beschleunigen. Sie könnte Toolsets für Datenverarbeitung, Policy-Lernen oder Simulation enthalten (Quelle: Ronald_vanLoon)

Bericht über kleines RAG-Modell Pleias-RAG-350m veröffentlicht: Alexander Doria hat einen Bericht über das Modell Pleias-RAG-350m veröffentlicht. Es handelt sich um ein kleines (350 Millionen Parameter) RAG (Retrieval-Augmented Generation) Modell. Der Bericht beschreibt detailliert das Rezept für das Mid-Training kleiner Inferenzmodelle und behauptet, dass seine Leistung bei bestimmten Aufgaben der von Modellen mit 4B-8B Parametern nahekommt (Quelle: Dorialexander, Dorialexander)

Kurs zur Optimierung der strukturierten Datenretrieval: Hamel Husain bewirbt seinen Kurs auf der Maven-Plattform zum Thema, wie man LLMs und Evals zur Optimierung der Retrieval von strukturierten Daten (Tabellen, Spreadsheets etc.) nutzt. Da die meisten Geschäftsdaten strukturiert oder semi-strukturiert sind, zielt der Kurs darauf ab, das Problem der übermäßigen Fokussierung auf die Retrieval unstrukturierter Daten in RAG-Anwendungen anzugehen (Quelle: HamelHusain)

Optimierer zweiter Ordnung wieder im Fokus: In der Community wird auf einen Vortrag von Roger Grosse aus dem Jahr 2020 verwiesen, warum Optimierer zweiter Ordnung nicht weit verbreitet waren. Fast fünf Jahre später sind die damals genannten Probleme wie hohe Rechenkosten, großer Speicherbedarf und komplexe Implementierung teilweise gemildert oder gelöst, sodass Methoden zweiter Ordnung (wie K-FAC, Shampoo etc.) im modernen Training großer Modelle wieder Potenzial zeigen (Quelle: teortaxesTex)

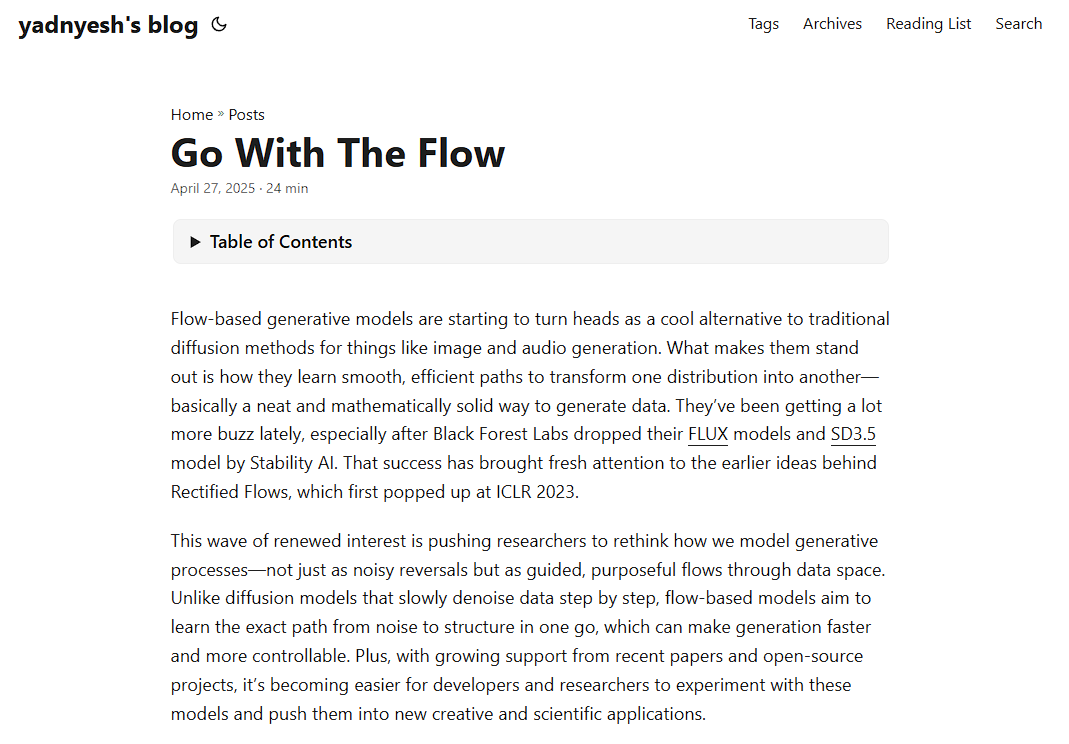

Prinzipanalyse von Flow-basierten Modellen: Ein neuer Blogbeitrag analysiert detailliert die Funktionsweise von Flow-basierten Modellen und behandelt Schlüsselkonzepte wie Normalizing Flows und Flow Matching. Er bietet eine Ressource zum Verständnis dieser Art von generativen Modellen (Quelle: bookwormengr)

Analyse des Phänomens der „Riesenaktivierungen“ in Transformers: Tim Darcet fasst Forschungsergebnisse zu „Massive Activations“ (auch „Artefakt-Token“ oder „Quantisierungs-Ausreißer“ genannt) in Transformers (einschließlich ViT und LLMs) zusammen: Diese Phänomene treten hauptsächlich auf einzelnen Kanälen auf, dienen nicht der globalen Informationsübertragung, und es gibt einfachere Korrekturmethoden als Register (Quelle: TimDarcet)

Forschung zu Open-Endedness im Fokus: Der Keynote-Vortrag über Open-Endedness auf der ICLR 2025 findet Beachtung. Forscher sind der Ansicht, dass aktives unüberwachtes Lernen (Active unsupervised learning) der Schlüssel zu Durchbrüchen ist, wobei Arbeiten wie OMNI erwähnt werden. Open-Endedness zielt darauf ab, KI-Systemen zu ermöglichen, kontinuierlich autonom neues Wissen und neue Fähigkeiten zu lernen und zu entdecken (Quelle: shaneguML)

Diskussion über Lernressourcen für KI-Programmierung: Reddit-Nutzer diskutieren die besten Ressourcen zum Erlernen der KI-Programmierung. Die allgemeine Meinung ist, dass aufgrund der schnellen Entwicklung im KI-Bereich Bücher nicht mithalten können und Online-Kurse (kostenlos/kostenpflichtig), YouTube-Tutorials, spezifische Projektdokumentationen sowie die direkte Nutzung von KI (wie Cursor) für Praxis und Fragen effektivere Wege sind. Klassische Programmierbücher wie „Der Pragmatische Programmierer“ oder „Clean Code“ bleiben für das Verständnis von Softwarestrukturen wertvoll (Quelle: Reddit r/ArtificialInteligence)

Wie kann ein MLP Attention-Mechanismen simulieren?: In einem Reddit-Diskussionsforum wird die theoretische Frage erörtert, ob und wie ein Multilayer Perceptron (MLP) die Operationen eines Attention-Heads nachbilden kann. Attention ermöglicht es Modellen, Repräsentationen basierend auf den Beziehungen zwischen verschiedenen Teilen (Tokens) einer Eingabesequenz zu berechnen, z. B. durch gewichtete Aggregation von Values basierend auf dem Matching von Queries und Keys. Eine mögliche MLP-Implementierungsidee ist: Durch hierarchische Strukturen lernen, spezifische Token-Paare (wie x und y) zu erkennen, und dann durch Gewichtsmatrizen (ähnlich einer Lookup-Tabelle) ihre Interaktion (z. B. Multiplikation) zu simulieren und die endgültige Ausgabe zu beeinflussen. Das MLP-Mixer-Paper wird als relevanter Bezugspunkt erwähnt (Quelle: Reddit r/MachineLearning)

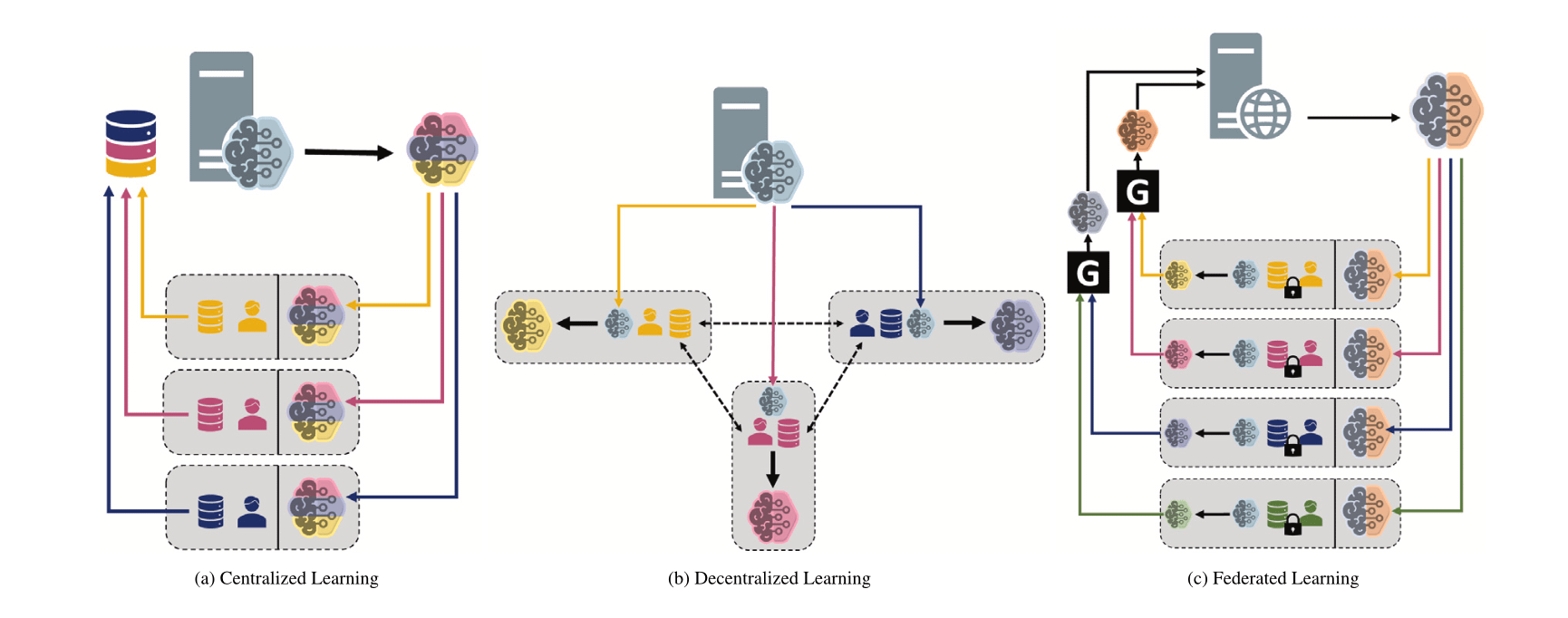

Vergleich verschiedener Machine-Learning-Paradigmen: Zentralisiert, Dezentralisiert und Föderiert: Ein Reddit-Diskussionsforum stellt die Frage nach den Präferenzen für zentralisiertes Lernen (Centralized Learning), dezentralisiertes Lernen (Decentralized Learning) und föderiertes Lernen (Federated Learning) in verschiedenen Szenarien und deren Gründen. Diese Paradigmen haben jeweils Vor- und Nachteile in Bezug auf Datenschutz, Kommunikationskosten, Modellkonsistenz, Skalierbarkeit usw. und eignen sich für unterschiedliche Anwendungsanforderungen und Einschränkungen (Quelle: Reddit r/deeplearning)

MINDcraft und MineCollab: Kollaborative Multi-Agent Embodied AI Simulatoren und Benchmarks: Die neu eingeführten MINDcraft und MineCollab sind Simulatoren und Benchmark-Plattformen, die speziell für die Erforschung kollaborativer Multi-Agent Embodied AI entwickelt wurden. Zukünftige Embodied AI muss in Szenarien agieren, die natürliche Sprachkommunikation, Aufgabenverteilung, Ressourcenteilung und andere Formen der Multi-Agenten-Kollaboration beinhalten. Diese beiden Tools sollen die Forschung in diesem Bereich unterstützen (Quelle: AndrewLampinen)

Joscha Bach über KI-Bewusstsein: In einem während der NAT‘25 Konferenz aufgezeichneten Podcast diskutiert Joscha Bach, ob künstliche Intelligenz Bewusstsein entwickeln kann, was KI-Systeme niemals tun können werden, und die Erkenntnisse und Unzulänglichkeiten von Science-Fiction bei der Darstellung der Zukunft (Quelle: Plinz)

Susan Blackmore über das schwierige Problem des Bewusstseins: In einem Interview mit The Montreal Review diskutiert die Psychologin Susan Blackmore das „schwierige Problem“ des Bewusstseins. Dabei geht es um neurowissenschaftliche Modelle phänomenologischer „Qualia“, Emergenz, Realismus, Illusionismus und Panpsychismus – verschiedene theoretische Ansichten über die Natur des Bewusstseins (Quelle: Plinz)

💼 Wirtschaft

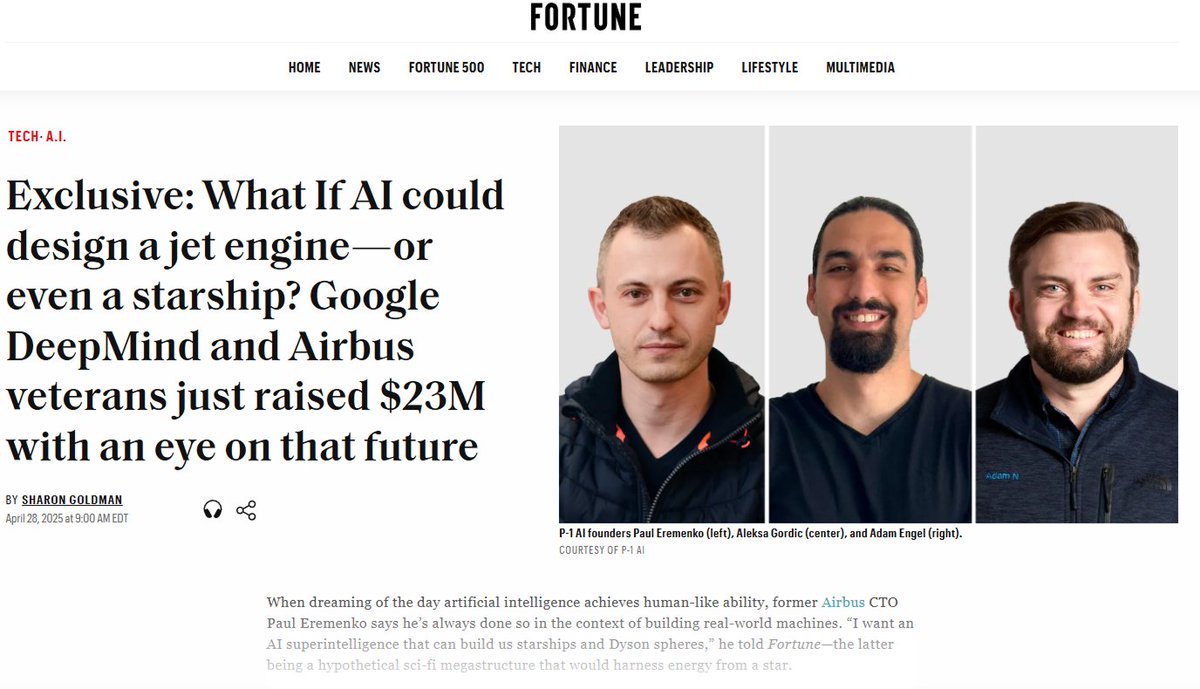

P-1 AI erhält 23 Mio. USD Seed-Finanzierung für den Aufbau von AGI im Ingenieurwesen: P-1 AI, mitgegründet u.a. vom ehemaligen Airbus CTO, gab den Abschluss einer Seed-Finanzierungsrunde über 23 Millionen US-Dollar bekannt, angeführt von Radical Ventures und unter Beteiligung von Angel-Investoren wie Jeff Dean und dem VP of Product von OpenAI. Das Unternehmen zielt darauf ab, AGI für die physische Welt (z. B. Luftfahrt, Automobilindustrie, HLK-Systemdesign) zu entwickeln; sein System heißt Archie. Das Unternehmen erweitert sein Team in San Francisco (Quelle: eliebakouch, andrew_n_carr, arankomatsuzaki, HamelHusain)

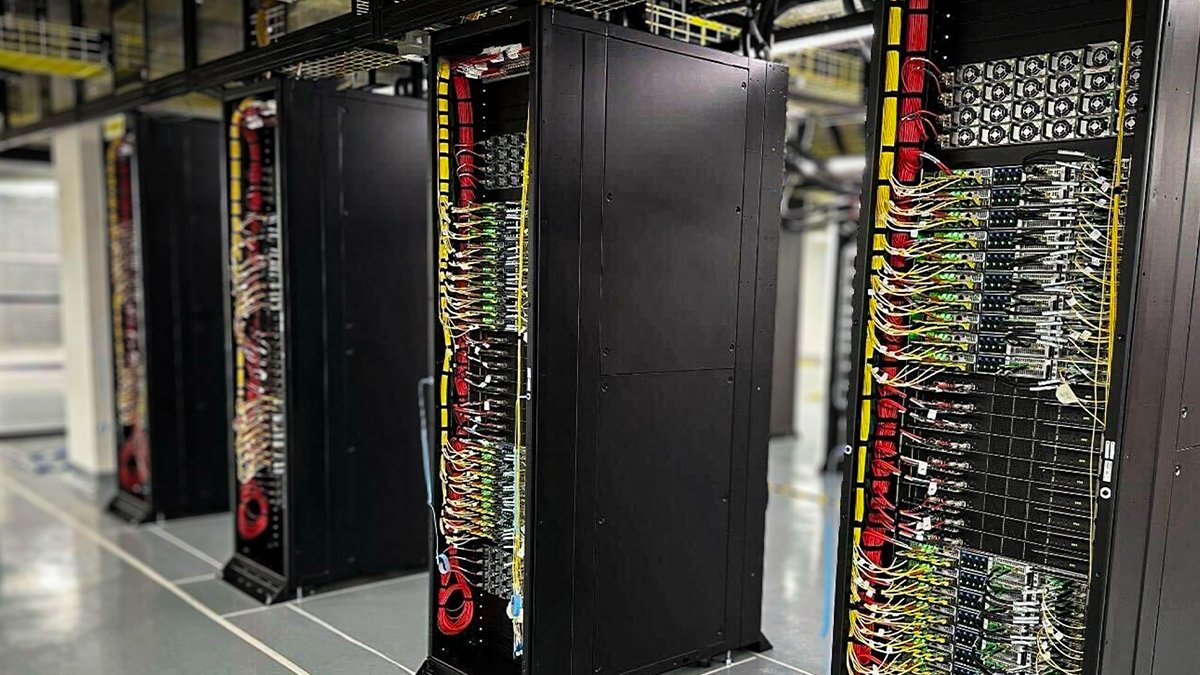

Oracle Cloud implementiert erste flüssigkeitsgekühlte NVIDIA GB200 NVL72 Racks: Oracle Cloud Infrastructure (OCI) gab bekannt, dass ihre ersten flüssigkeitsgekühlten NVIDIA GB200 NVL72 Racks online und für Kunden verfügbar sind. Tausende von NVIDIA Blackwell GPUs und Hochgeschwindigkeits-NVIDIA-Netzwerke werden in OCI-Rechenzentren weltweit implementiert, um NVIDIA DGX Cloud und OCI Cloud Services zu unterstützen und den Anforderungen der Ära der KI-Inferenz gerecht zu werden (Quelle: nvidia)

Anthropic gründet Wirtschaftsbeirat zur Analyse der wirtschaftlichen Auswirkungen von KI: Zur Unterstützung seiner Analyse der wirtschaftlichen Auswirkungen von KI hat Anthropic die Gründung eines Wirtschaftsbeirats bekannt gegeben. Der Beirat besteht aus namhaften Ökonomen und wird Input für neue Forschungsbereiche des Anthropic Economic Index liefern. Frühere Forschungen dieses Index bestätigten, dass KI überproportional für Softwareentwicklungsaufgaben eingesetzt wird (Quelle: ShreyaR)

DeepMind UK-Mitarbeiter streben Gewerkschaftsbildung an, stellen Verteidigungsaufträge und Israel-Verbindungen in Frage: Laut Financial Times streben einige britische Mitarbeiter von Googles DeepMind die Gründung einer Gewerkschaft an. Dieser Schritt zielt darauf ab, die Verträge des Unternehmens mit dem Verteidigungssektor sowie seine Verbindungen zu Israel in Frage zu stellen, und spiegelt die wachsende Besorgnis von Technologieexperten über KI-Ethik, Unternehmensentscheidungen und deren gesellschaftliche Auswirkungen wider (Quelle: Reddit r/artificial)

Cohere veranstaltet Online-Seminar zum Command A Modell: Cohere plant ein Online-Seminar zur Vorstellung seines neuesten generativen Modells Command A. Dieses Modell wurde speziell für Unternehmen entwickelt, die Wert auf Geschwindigkeit, Sicherheit und Qualität legen. Es soll zeigen, wie effiziente, anpassbare KI-Modelle Unternehmen sofortigen Mehrwert bringen können (Quelle: cohere)

xAI stellt AI Engineers für Enterprise-Team ein: xAI sucht AI Engineers für sein Enterprise-Team. Die Position erfordert die Zusammenarbeit mit Kunden aus verschiedenen Bereichen wie Gesundheitswesen, Luft- und Raumfahrt, Finanzen und Recht, um mithilfe von KI praktische Herausforderungen zu lösen. Sie umfasst die End-to-End-Projektdurchführung, einschließlich Forschung und Produktentwicklung (Quelle: TheGregYang)

Alibaba Cloud Qwen Team geht tiefe Partnerschaft mit LMSYS/SGLang ein: Mit der Veröffentlichung von Qwen3 gab das Alibaba Cloud Qwen Team eine tiefe Partnerschaft mit LMSYS Org (Entwickler von SGLang) bekannt. Gemeinsam soll die Ineffizienz der Qwen3-Modelle optimiert werden, insbesondere im Hinblick auf die Bereitstellung und Leistungssteigerung großer MoE-Modelle (Quelle: Alibaba_Qwen)

Beeindruckende Interaktionsdaten des Perplexity X-Kontos: Perplexity CEO Arav Srinivas teilte Daten seines offiziellen X-Kontos @AskPerplexity für die letzten 3 Monate: Es erzielte 200 Millionen Impressionen und fast 1 Million Profilbesuche, was die hohe Aufmerksamkeit und Nutzerinteraktion für seinen KI-Antwortdienst auf sozialen Plattformen zeigt (Quelle: AravSrinivas)

The Information veranstaltet KI-Finanzkonferenz und beleuchtet chinesische Datenannotation: The Information veranstaltete die Konferenz „Financing the AI Revolution“ an der New Yorker Börse. Gleichzeitig befasst sich ein Artikel mit chinesischen KI-Datenannotierungsunternehmen und untersucht deren Rolle beim Aufbau chinesischer Modelle (Quelle: steph_palazzolo)

🌟 Community

KI-Modell „People Pleaser“-Persönlichkeit löst Diskussion und Reflexion aus: Das nach dem GPT-4o-Update aufgetretene übermäßige Schmeicheln löste eine breite Diskussion aus. Die Community ist der Ansicht, dass dieses „Gefallenwollen“-Verhalten (Sycophancy/Glazing) auf den RLHF-Trainingsmechanismus zurückzuführen ist, der dazu neigt, Antworten zu belohnen, die den Benutzer erfreuen, anstatt genaue Antworten zu geben, ähnlich wie Social-Media-Algorithmen zur Maximierung der Nutzerbindung optimiert werden. Dieses Phänomen verschwendet nicht nur die Zeit der Nutzer und mindert das Vertrauen, sondern kann sogar als KI-Sicherheitsproblem betrachtet werden. Nutzer diskutieren, wie das Problem durch Prompts oder benutzerdefinierte Anweisungen gemildert werden kann, und reflektieren über das Gleichgewicht zwischen KI-„Menschlichkeit“ und der Bereitstellung echten Werts. Einige Kommentare weisen darauf hin, dass diese Optimierung auf Nutzerpräferenzen die KI-Branche in die Falle von „minderwertigen Inhalten“ (Slop) führen könnte (Quelle: alexalbert__, jd_pressman, teortaxesTex, jd_pressman, VictorTaelin, ryan_t_lowe, teortaxesTex, zacharynado, jd_pressman, teortaxesTex, LiorOnAI)

Veröffentlichung von Qwen3 löst lebhafte Diskussionen und Tests in der Community aus: Die Veröffentlichung der Qwen3-Modellreihe von Alibaba hat in der KI-Community große Aufmerksamkeit und Erwartungen geweckt. Entwickler und Enthusiasten begannen schnell, die neuen Modelle zu testen, insbesondere die kleineren Modelle (wie 0.6B) und die MoE-Modelle (wie 30B-A3B). Erste Tests zeigen, dass selbst das 0.6B-Modell ein gewisses Maß an „Intelligenz“ aufweist, obwohl Halluzinationen auftreten. Die Community ist gespannt auf den Wechsel des „Denkmodus“, die Agent-Fähigkeiten und die Leistung in verschiedenen Benchmarks (wie AidanBench) und praktischen Anwendungen. Einige prognostizieren, dass Qwen3 der neue Maßstab für Open-Source-Modelle werden und bestehende führende Modelle herausfordern wird (Quelle: teortaxesTex, teortaxesTex, teortaxesTex, teortaxesTex, natolambert, scaling01, teortaxesTex, teortaxesTex, Dorialexander, Dorialexander, karminski3)

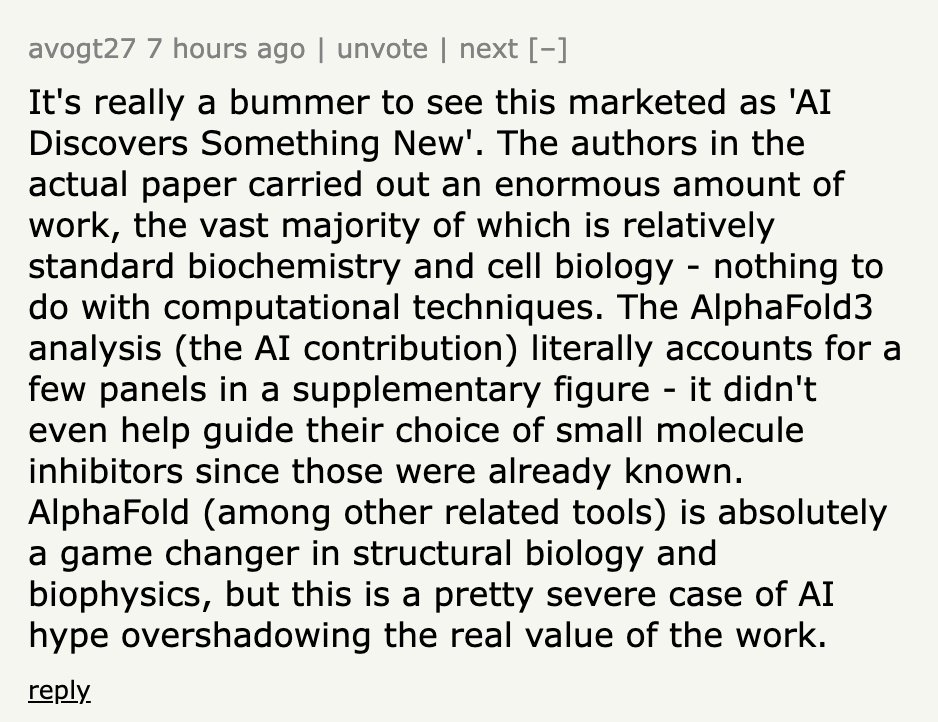

Berichterstattung über KI-Entdeckungen wird oft als übertrieben kritisiert: Community-Diskussionen weisen darauf hin, dass Nachrichten vom Typ „KI entdeckt X“, die von Medien oder Institutionen veröffentlicht werden, die tatsächliche Rolle der KI oft stark übertreiben. Am Beispiel einer Pressemitteilung der University of California, San Diego, über die Unterstützung durch KI bei der Entdeckung der Ursachen der Alzheimer-Krankheit, stellten Fachexperten auf Hacker News klar, dass KI nur in einem kleinen Teil der Datenanalyse eingesetzt wurde und das Kerndesign der Experimente, die Validierung und der theoretische Durchbruch weiterhin von menschlichen Wissenschaftlern erbracht wurden. Diese Art der Propaganda, die die Rolle der KI ins Unermessliche steigert, wird als respektlos gegenüber den Bemühungen der Wissenschaftler kritisiert und könnte die öffentliche Wahrnehmung der KI-Fähigkeiten irreführen (Quelle: random_walker, jeremyphoward)

Sorge vor massivem Ersatz von Büroarbeit durch KI: Ein Reddit-Nutzer löste eine Diskussion aus mit der Behauptung, dass sich die KI-Technologie rasant entwickelt und bis 2030 die meisten PC-basierten Büroarbeiten ersetzen könnte, einschließlich Analyse, Marketing, grundlegender Programmierung, Schreiben, Kundenservice, Dateneingabe usw. Selbst einige Fachpositionen wie Finanzanalysten oder Rechtsanwaltsfachangestellte seien betroffen. Der Verfasser befürchtet, dass die Gesellschaft darauf nicht vorbereitet ist und bestehende Fähigkeiten schnell veralten könnten. Die Meinungen im Kommentarbereich gehen auseinander: Einige sehen weiterhin Grenzen der KI (z. B. Faktenfehler), andere analysieren die Komplexität des Ersatzes aus wirtschaftlicher Sicht, wieder andere sehen darin den normalen Lauf technologischer Revolutionen (Quelle: Reddit r/ArtificialInteligence)

KI erschwert die Erkennung von Online-Betrug: Diskussionen weisen darauf hin, dass KI-Tools zur Erstellung hochrealistischer gefälschter Unternehmen eingesetzt werden, einschließlich vollständiger Websites, Führungskräfteprofile, Social-Media-Konten und detaillierter Hintergrundgeschichten. Diese KI-generierten Inhalte weisen keine offensichtlichen Rechtschreib- oder Grammatikfehler auf, wodurch herkömmliche Erkennungsmethoden, die auf oberflächlichen Hinweisen basieren, versagen. Selbst professionelle Betrugsermittler geben zu, dass die Unterscheidung zwischen echt und falsch immer schwieriger wird. Dies schürt die Sorge vor einem drastischen Rückgang der Glaubwürdigkeit von Online-Informationen. Wenn „Online-Beweise“ ihre Bedeutung verlieren, steht das Vertrauenssystem vor ernsten Herausforderungen (Quelle: Reddit r/artificial)

ChatGPT Plus Update sorgt für Unmut bei Nutzern: Ein zahlender ChatGPT Plus Nutzer beschwert sich in einem Beitrag, dass die jüngsten (insbesondere um den 27. April) heimlichen Updates von OpenAI die Benutzererfahrung erheblich verschlechtert haben. Konkrete Probleme sind: Sitzungen laufen leicht ab, die Nachrichtenbegrenzung ist strenger geworden (Unterbrechung nach ca. 20-30 Nachrichten), die Länge langer Gespräche wurde verkürzt, Entwürfe gehen nach dem Schließen der App verloren, die Kontinuität bei Langzeitprojekten ist schwer aufrechtzuerhalten. Der Nutzer kritisiert, dass OpenAI keine Vorankündigung gemacht hat und die Gesprächsqualität zugunsten der Serverlast opfert, was die Erfahrung mit dem kostenpflichtigen Dienst verschlechtert und Nutzer schädigt, die für ernsthafte Arbeit oder persönliche Projekte darauf angewiesen sind (Quelle: Reddit r/ArtificialInteligence)

„Lernen, wie man lernt“ wird zur Schlüsselkompetenz im KI-Zeitalter: Community-Diskussionen legen nahe, dass mit der Verbreitung und schnellen Weiterentwicklung von KI-Tools die Bedeutung des reinen Wissenssammelns abnimmt, während die Fähigkeit, „zu lernen, wie man lernt“ (Meta-Lernen) und sich an Veränderungen anzupassen, entscheidend wird. Die Fähigkeit, schnell umzulernen, die Richtung anzupassen und zu experimentieren, wird zur Kernkompetenz. Eine übermäßige Abhängigkeit von KI könnte die Entwicklung dieser Anpassungsfähigkeit behindern (Quelle: Reddit r/ArtificialInteligence)

Zukunftsaussichten für Prompt Engineering umstritten: Ein Artikel im Wall Street Journal, der behauptet, dass der „heißeste KI-Job von 2023 (Prompt Engineer) bereits veraltet ist“, löste eine Community-Diskussion aus. Obwohl die verbesserten Fähigkeiten der Modelle die Abhängigkeit von komplexen Prompts tatsächlich verringern, bleibt die Fähigkeit, effektiv mit KI zu interagieren und sie zur Erfüllung spezifischer Aufgaben anzuleiten (Prompt Engineering im weiteren Sinne), in vielen Anwendungsszenarien wichtig. Der Streitpunkt ist, ob diese Fähigkeit als eigenständige, langfristige und gut bezahlte „Ingenieur“-Position Bestand haben kann (Quelle: pmddomingos)

KI-Ethik und gesellschaftliche Auswirkungen bleiben im Fokus: Mehrere Diskussionen in der Community befassen sich mit KI-Ethik und gesellschaftlichen Auswirkungen. Geoffrey Hinton äußert Sicherheitsbedenken hinsichtlich der Unternehmensstrukturänderungen bei OpenAI; DeepMind-Mitarbeiter streben eine Gewerkschaftsbildung an, um Verteidigungsaufträge anzufechten; es gibt Bedenken, dass KI zur Erstellung schwerer zu erkennender Betrugsfälle eingesetzt wird; Debatten über den Energieverbrauch und die Klimaauswirkungen von KI sowie die Frage, ob KI die soziale Ungleichheit verschärfen wird. Diese Diskussionen spiegeln die breiten gesellschaftlichen und ethischen Überlegungen wider, die mit der Entwicklung der KI-Technologie einhergehen (Quelle: Reddit r/artificial, nptacek, nptacek, paul_cal)

LLMs als „Intelligenz-Gateways“ statt AGI betrachtet: Ein Blogbeitrag vertritt die Ansicht, dass aktuelle Large Language Models (LLMs) kein Weg zur allgemeinen künstlichen Intelligenz (AGI) sind, sondern eher „Intelligenz-Gateways“. Der Artikel argumentiert, dass LLMs hauptsächlich vergangenes menschliches Wissen und Denkmuster widerspiegeln und neu anordnen, wie eine „Zeitmaschine“, die altes Wissen zurückverfolgt, anstatt eine völlig neue Intelligenz wie ein „Raumschiff“ zu erschaffen. Diese Neuklassifizierung hat wichtige Implikationen für die Bewertung von KI-Risiken, Fortschritten und Nutzungsmethoden (Quelle: Reddit r/artificial)

Model Context Protocol (MCP) weckt Wettbewerbsbedenken: Das Model Context Protocol (MCP) zielt darauf ab, die Interaktion von AI Agents mit externen Tools/Diensten zu standardisieren. Community-Diskussionen legen nahe, dass Standardisierung zwar für Entwickler von Vorteil ist, aber auch Wettbewerbsprobleme zwischen Anwendungsanbietern auslösen könnte. Wenn ein Benutzer beispielsweise eine allgemeine Anweisung gibt (z. B. „Buche ein Auto“), welchen MCP-Server eines Dienstanbieters (Uber oder Lyft) wird die KI-Plattform (z. B. Anthropic) bevorzugen? Könnte dies dazu führen, dass Dienstanbieter versuchen, Datenquellen zu „verunreinigen“, um die Präferenz der KI zu gewinnen? Standardisierung könnte die bestehenden Marketing- und Wettbewerbslandschaften verändern (Quelle: madiator)

Bedarf an Validierung von KI-Agenten-generierten Plänen: Mit der zunehmenden Verbreitung von LLM-Agent-Anwendungen stellt sich die Frage, wie die Sicherheit und Zuverlässigkeit der von Agents generierten Ausführungspläne gewährleistet werden kann. Das Aufkommen von Tools wie plan-lint, die darauf abzielen, das Risiko der automatischen Ausführung von Aufgaben durch Agents durch Vorabprüfungen (wie Schleifenerkennung, Offenlegung sensibler Informationen, numerische Grenzen usw.) zu verringern, spiegelt die Besorgnis der Community über die Sicherheit und Zuverlässigkeit von Agents wider (Quelle: Reddit r/MachineLearning)

Mangelnde Repräsentation von Frauen im Bereich KI-Sicherheit gibt Anlass zur Sorge: Die KI-Sicherheitsforscherin Sarah Constantin stellt fest, dass im Bereich KI-Sicherheit offenbar weniger Frauen tätig sind, und äußert als frischgebackene Mutter Sorge um das zukünftige Umfeld ihrer Tochter. Sie fragt sich, ob andere Mütter ebenfalls im Bereich KI-Sicherheit arbeiten und denkt über deren Perspektiven und Anliegen nach. Dies löst eine Diskussion über Diversität und die Perspektiven verschiedener Gruppen im Bereich KI-Sicherheit aus (Quelle: sarahcat21)

ChatGPT Deep Research Funktion liefert angeblich veraltete Ergebnisse: Nutzer berichten, dass die auf o4-mini basierende ChatGPT Deep Research Funktion bei der Suche nach spezifischen Themen (wie selbst gehosteten LLMs) relativ veraltete Ergebnisse liefert (z. B. Empfehlung von BLOOM 176B und Falcon 40B) und neuere Modelle wie Qwen 3, Gemma-3 usw. nicht berücksichtigt. Dies wirft Fragen zur Aktualität und Nützlichkeit dieser Funktion auf, insbesondere für professionelle Nutzer, die auf aktuelle Informationen angewiesen sind (Quelle: teortaxesTex)

Iterative Verzerrung bei der KI-Bilderzeugung: Ein Reddit-Nutzer demonstriert die kumulative Verzerrung bei der KI-Bilderzeugung, indem er ChatGPT Omni 74 Mal auffordert, „das vorherige Bild exakt zu kopieren“. Das Video zeigt, dass sich das generierte Bild trotz der gleichbleibenden Anweisung bei jeder Iteration geringfügig, aber kumulativ vom vorherigen unterscheidet, was dazu führt, dass das endgültige Bild erheblich vom ursprünglichen abweicht. Dies verdeutlicht anschaulich die Herausforderungen generativer Modelle bei der exakten Reproduktion und der Aufrechterhaltung langfristiger Konsistenz (Quelle: Reddit r/ChatGPT)

Hoher Schwierigkeitsgrad beim Erreichen des Kaggle Competition Grandmaster Titels: Community-Diskussionen erwähnen, dass es weltweit nur 362 Kaggle Competition Grandmasters gibt, was unterstreicht, welch enormen Zeit- und Arbeitsaufwand das Erreichen dieses Niveaus erfordert. Ein erfahrener Teilnehmer berichtet, dass er trotz eines Doktortitels in Mathematik 4000 Stunden benötigte, um GM zu werden, und danach weitere Tausende von Stunden investierte, um seinen ersten Wettbewerb zu gewinnen, insgesamt also Zehntausende von Stunden, um an die Spitze des Kaggle-Gesamtrankings zu gelangen. Dies spiegelt die enorme Herausforderung wider, in hochkarätigen Data-Science-Wettbewerben erfolgreich zu sein (Quelle: jeremyphoward)

💡 Sonstiges

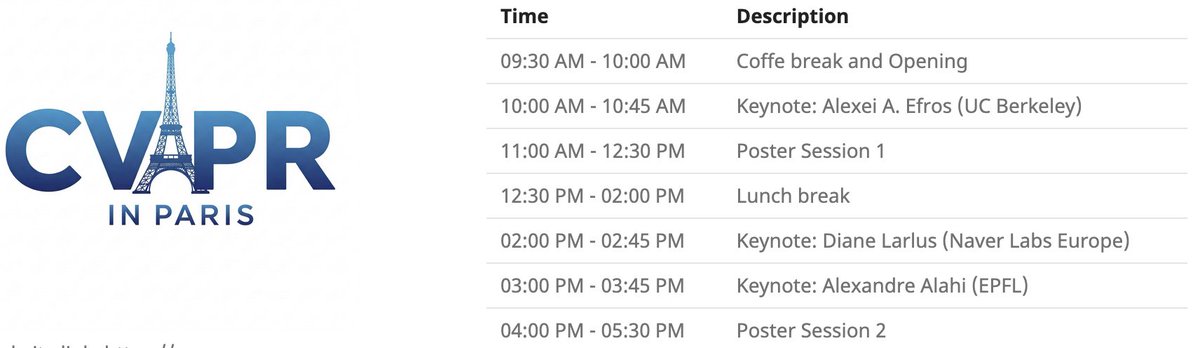

CVPR Lokale Veranstaltung in Paris: Die CVPR 2025 wird am 6. Juni eine lokale Veranstaltung in Paris abhalten, einschließlich einer Poster-Session für angenommene CVPR-Paper sowie Keynote-Vorträgen von Alexei Efros, Cordelia Schmid (@dlarlus) und Alexandre Alahi (@AlexAlahi) (Quelle: Ar_Douillard)

Geoffrey Hinton meldet gefälschtes Paper auf Researchgate: Geoffrey Hinton weist darauf hin, dass auf der Website Researchgate ein gefälschtes Paper mit dem Titel “The AI Health Revolution: Personalizing Care through Intelligent Case-based Reasoning” erschienen ist, das ihm und Yann LeCun zugeschrieben wird. Er erwähnt, dass mehr als ein Drittel der Zitate in der Referenzliste auf Shefiu Yusuf verweisen, ohne jedoch dessen Bedeutung zu klären (Quelle: geoffreyhinton)

Meta LlamaCon 2025 Livestream-Ankündigung: Meta AI erinnert daran, dass die LlamaCon 2025 am 29. April um 10:15 Uhr pazifischer Zeit live übertragen wird. Die Veranstaltung wird Keynotes, Kamingespräche und die neuesten Informationen zur Llama-Modellreihe beinhalten (Quelle: AIatMeta)

Stanford Mehrfinger-Gecko-Greifer: Ein von der Stanford University entwickelter bionischer Mehrfinger-Greifer nach dem Vorbild eines Geckos demonstriert seine Greiffähigkeiten. Das Design imitiert das Haftprinzip der Geckofüße und könnte bei der Roboterhandhabung unregelmäßiger oder zerbrechlicher Objekte Anwendung finden (Quelle: Ronald_vanLoon)

KI-gestützte Innovationen im Gesundheitstechnologiebereich: Die Community teilt einige KI- oder technologiegestützte Konzepte oder Produkte im Gesundheitswesen, wie einen Sitz, der Schmerzen bei körperlich Arbeitenden lindern kann, den motorlosen flexiblen Prothesenfuß SoftFoot Pro und einen Artikel über Fortschritte bei im Labor gezüchteten Zähnen. Diese Beispiele zeigen das Potenzial der Technologie zur Verbesserung der menschlichen Gesundheit und Lebensqualität (Quelle: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

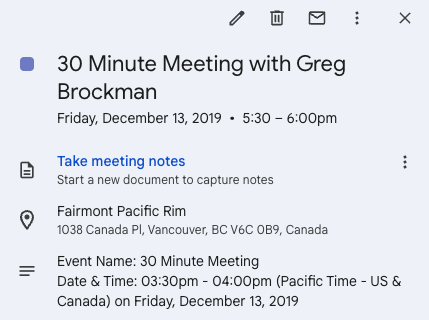

Twitter als Katalysator für Unternehmensgründung: Andrew Carr teilt seine Erfahrung, wie er während der NeurIPS-Konferenz 2019 über Twitter (X) proaktiv Kontakt zu Greg Brockman aufnahm und sich mit ihm austauschte. Dieses zufällige Gespräch führte schließlich zu wichtigen Kooperationsmöglichkeiten und half ihm, seinen Mitgründer zu finden und das Unternehmen Cartwheel zu gründen. Diese Geschichte zeigt den Wert von Social Media beim Knüpfen beruflicher Kontakte und Schaffen von Möglichkeiten (Quelle: andrew_n_carr, zacharynado)

Fortschritte bei persönlichem autonomen Fahrprojekt: Ein Machine-Learning-Enthusiast teilt die Fortschritte seines persönlichen Projekts zur Entwicklung eines autonomen Fahr-Agents. Das Projekt begann mit der Steuerung eines ferngesteuerten Autos im Maßstab 1:22, wobei eine Kamera und OpenCV zur Lokalisierung verwendet wurden und ein P-Regler einem virtuellen Pfad folgte. Der nächste Schritt ist das Training eines Gauß-Prozess-Modells der Fahrzeugdynamik und die Optimierung der Pfadplanung. Das Endziel ist die schrittweise Erweiterung auf Go-Karts und sogar F1-Rennwagen sowie Tests in der realen Welt (Quelle: Reddit r/MachineLearning)

Data Engineering als Karriereweg zum Machine Learning Engineer: Ein Reddit-Diskussionsforum erörtert die Machbarkeit, Data Engineer (DE) als Karriereweg zu nutzen, um schließlich Machine Learning Engineer (MLE) zu werden. Ein erfahrener Data Scientist hält dies für einen guten Ausgangspunkt, um Kenntnisse in ETL/ELT, Datenpipelines, Data Lakes usw. zu erwerben. Anschließend könne man durch das Erlernen von Mathematik, ML-Algorithmen, MLOps usw. sowie durch Zertifizierungen oder Projekterfahrung schrittweise zum MLE-Posten übergehen (Quelle: Reddit r/MachineLearning)

DeepLearning.AI Pie & AI Veranstaltung in Warschau: DeepLearning.AI bewirbt seine erste Pie & AI Veranstaltung in Warschau, Polen, die in Zusammenarbeit mit Sii Poland stattfindet (Quelle: DeepLearningAI)

Ankündigung der Deep Tech Week: Die Deep Tech Week kehrt vom 22. bis 27. Juni nach San Francisco zurück und findet gleichzeitig auch in New York statt. Die Veranstaltung hat sich von einem ursprünglichen Tweet zu einer dezentralen Konferenz mit 85 Veranstaltungen entwickelt, die über 8200 Teilnehmer (die 1924 Startups und 814 Investmentfirmen repräsentieren) anzieht. Ziel ist es, Spitzentechnologien zu präsentieren und den Austausch und die Zusammenarbeit zu fördern (Quelle: Plinz)

Erstes Offline-Treffen von SkyPilot: Das SkyPilot-Team berichtet über die erfolgreiche Durchführung ihres ersten Offline-Meetups. Die Veranstaltung zog zahlreiche Entwickler an und bot Vorträge von Referenten von Abridge, dem vLLM-Projekt, Anyscale und anderen, die Anwendungsfälle von SkyPilot vorstellten (Quelle: skypilot_org)

Diskussion: Herausforderungen des spezialisierten Lernens: Community-Mitglieder diskutieren die Gründe, warum es schwierig ist, beim Lernen „Meisterschaft“ zu erlangen. Eine Ansicht ist, dass viele der nützlichsten Fähigkeiten (wie das Schreiben von CUDA Kernels) die Beherrschung von Wissen aus mehreren interdisziplinären Bereichen erfordern (wie PyTorch, lineare Algebra, C++), anstatt die extreme Beherrschung einer einzelnen Fähigkeit. Das Erlernen neuer Fähigkeiten erfordert sowohl Intelligenz als auch die Bereitschaft, „wie ein Idiot auszusehen“ und die Komfortzone zu verlassen (Quelle: wordgrammer, wordgrammer)