Schlüsselwörter:AI, OpenAI, o3/o4-mini Modell, Gemini 2.5 Pro, AI-Programmierungstools, Multimodale AI-Technologie, AI-Agenten

🔥 Fokus

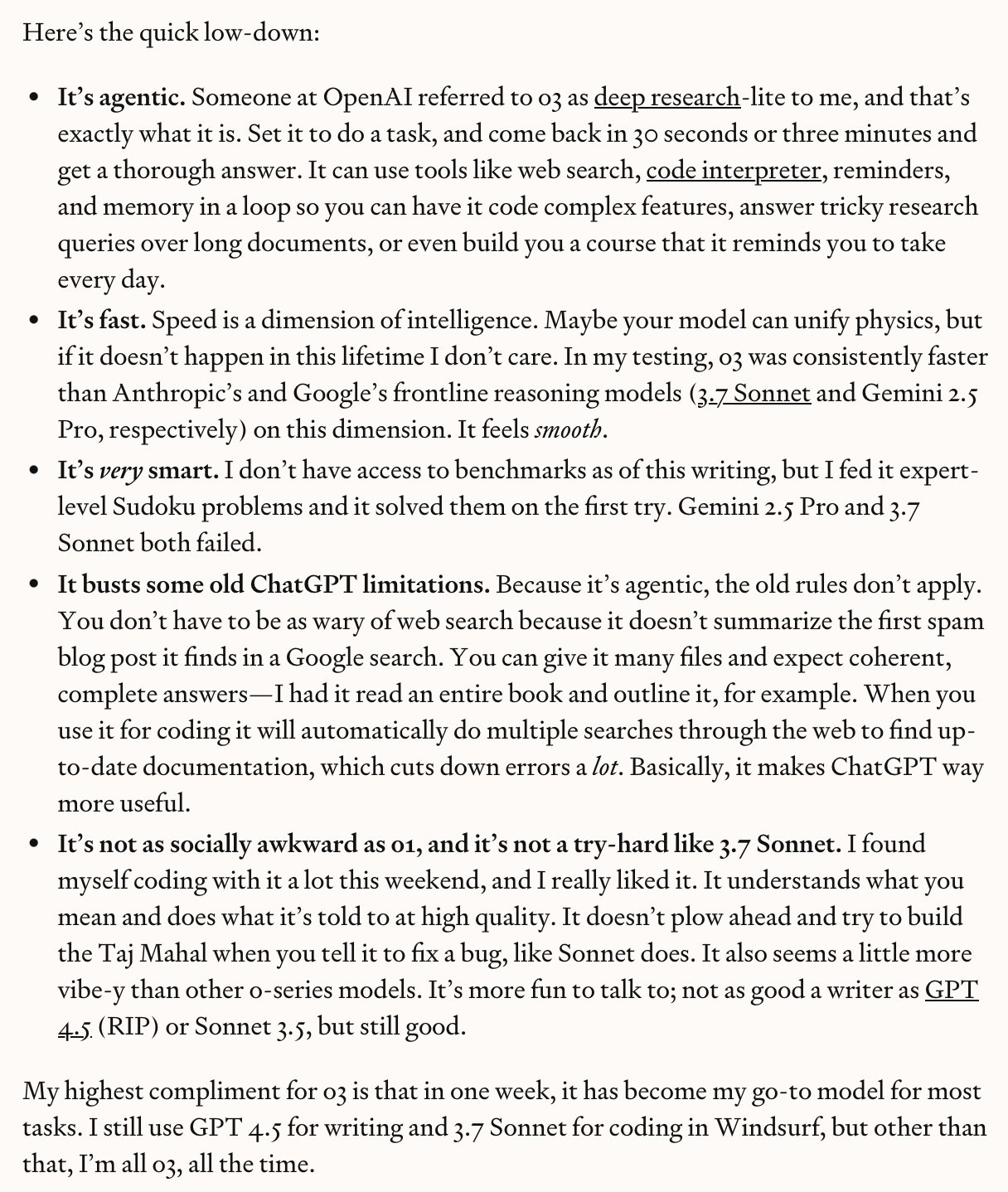

OpenAI veröffentlicht eindrucksvoll o3 und o4-mini und läutet eine neue Ära des „Denkens mit Bildern“ ein: OpenAI hat offiziell sein neuestes „Reasoning“-Flaggschiff-Modell o3 und die kompakte Version o4‑mini veröffentlicht. Diese beiden Modelle ermöglichen erstmals das „Denken mit Bildern“, indem sie Bilder in die Reasoning-Kette einbetten und verarbeiten können (z. B. Vergrößern, Drehen) und diese mit Text analysieren. Sie können auch erstmals autonom alle Tools innerhalb von ChatGPT (Websuche, Python-Codeausführung, Dateianalyse, Bilderzeugung) kombinieren, um komplexe Probleme zu lösen. o3 hat in mehreren Benchmarks wie Codeforces, SWE-bench und MMMU neue SOTA-Ergebnisse erzielt, insbesondere bei visuellem Reasoning und mehrstufigen Aufgaben, wobei die Rate schwerwiegender Fehler im Vergleich zu o1 um 20 % gesenkt wurde. o4-mini übertrifft o3-mini bei Mathematik-, Programmier- und visuellen Aufgaben mit geringerer Latenz und Kosten. Gleichzeitig hat OpenAI den leichtgewichtigen KI-Agenten für die Terminalprogrammierung Codex CLI als Open Source veröffentlicht und ein Förderprogramm in Höhe von einer Million US-Dollar gestartet. Die neuen Modelle sind bereits für Nutzer von ChatGPT Plus/Pro/Team sowie für API-Entwickler verfügbar und markieren einen Fortschritt der KI hin zu stärkeren multimodalen Fähigkeiten und Agenten-Fähigkeiten. (Quelle: OpenAI震撼发布o3/o4-mini,直逼视觉推理巅峰,首用图像思考,十倍算力爆表, openai, sama, karminski3, karminski3, sama, gdb, karminski3, sama, dotey, openai, karminski3, op7418, gdb,

)

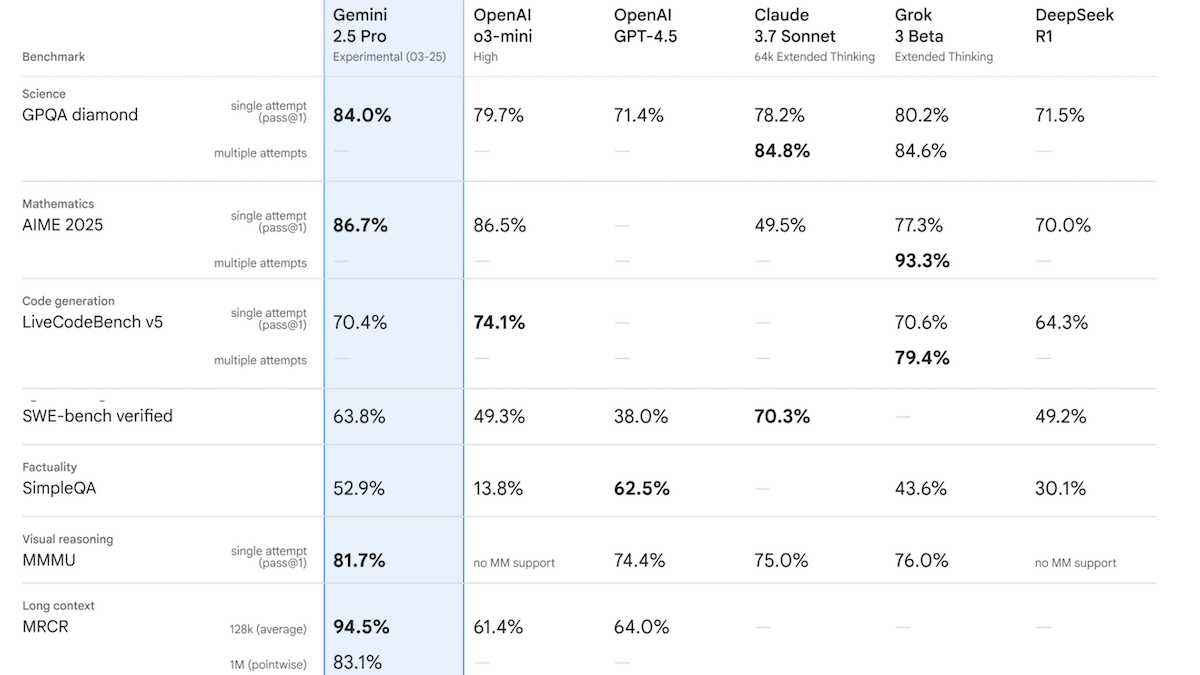

Google veröffentlicht Gemini 2.5 Pro Experimental, das die Leistung in der Chatbot Arena anführt: Google hat das erste Modell seiner Gemini 2.5-Familie, Gemini 2.5 Pro Experimental, vorgestellt und eine Version mit geringer Latenz, Gemini 2.5 Flash, angekündigt. Das Modell unterstützt Text-, Audio-, Bild- und Videoeingaben (bis zu 1 Million Tokens, zukünftig 2 Millionen geplant) und Textausgaben (bis zu 65.000 Tokens). Sein herausragendes Merkmal ist seine starke Reasoning-Fähigkeit, die durch die Generierung versteckter Reasoning-Tokens (Chain-of-Thought) vor der Antwort erreicht wird. In der Chatbot Arena übertrifft Gemini 2.5 Pro Experimental mit einem Elo-Score von 1437 GPT-4o und Grok 3 Preview und führt die Rangliste an. In 12 Benchmarks übertrifft es in 7 davon Top-Modelle wie o3-mini, GPT-4.5 und Claude 3.7 Sonnet. Dies zeigt, dass KI-Modelle, insbesondere Reasoning-Modelle, weiterhin schnelle Fortschritte machen. Google plant, dass zukünftig alle neuen Modelle Reasoning-Fähigkeiten besitzen werden. (Quelle: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

🎯 Trends

OpenAI veröffentlicht die GPT-4.1-Modellreihe mit Fokus auf niedrige Kosten und hohe Effizienz: OpenAI hat die GPT-4.1-Reihe eingeführt, die GPT-4.1, GPT-4.1 Mini und GPT-4.1 Nano umfasst. Kernmerkmale sind Kostensenkung und Geschwindigkeitssteigerung. GPT-4.1 Mini übertrifft GPT-4o in mehreren Benchmarks, weist eine deutlich geringere Latenz auf und reduziert die Kosten um 83 %. GPT-4.1 Nano ist das erste ultrakleine Modell, unterstützt einen Kontext von 1 Million Tokens und eignet sich für Aufgaben mit geringer Latenz. Alle drei Modelle erhöhen das Kontextfenster von 128K auf 1 Million Tokens. Preislich liegen GPT-4.1 Input/Output bei 2 $/8 $ pro Million Tokens, 26 % günstiger als GPT-4o; Nano Input/Output bei 0,1 $/0,4 $. Dieser Schritt wird als Reaktion auf den Preiskampf von Wettbewerbern wie DeepSeek gesehen. Gleichzeitig wurde das kostspielige GPT-4.5-Projekt eingestellt. (Quelle: 压力给到梁文锋,

)

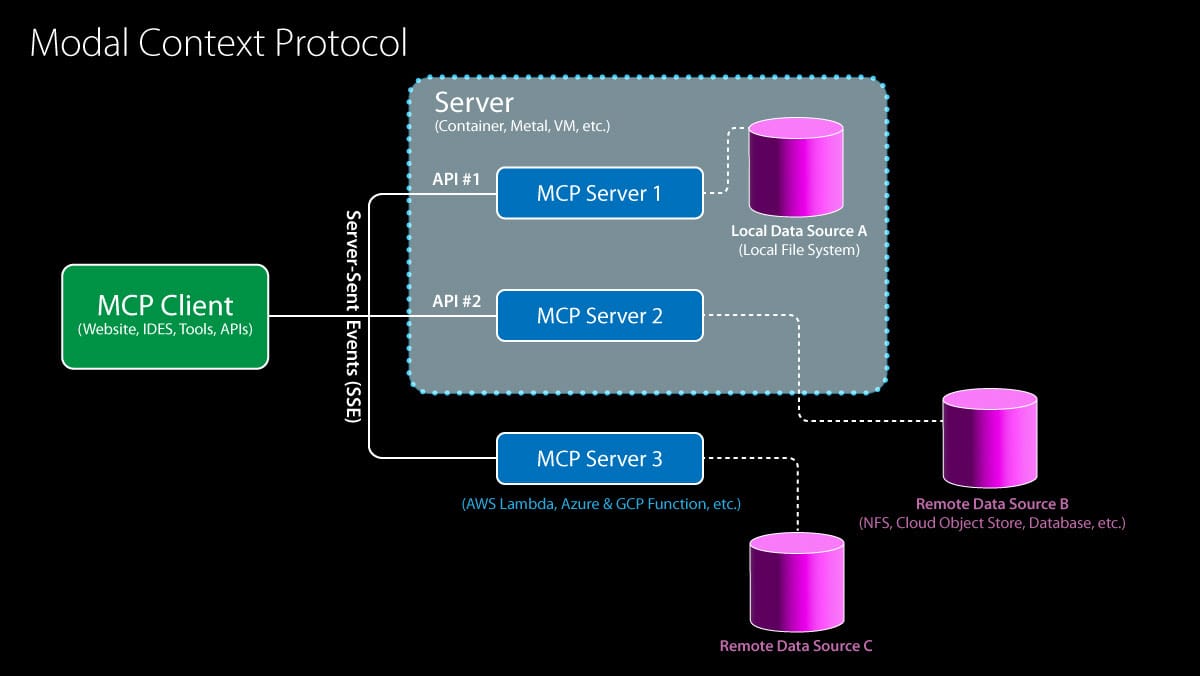

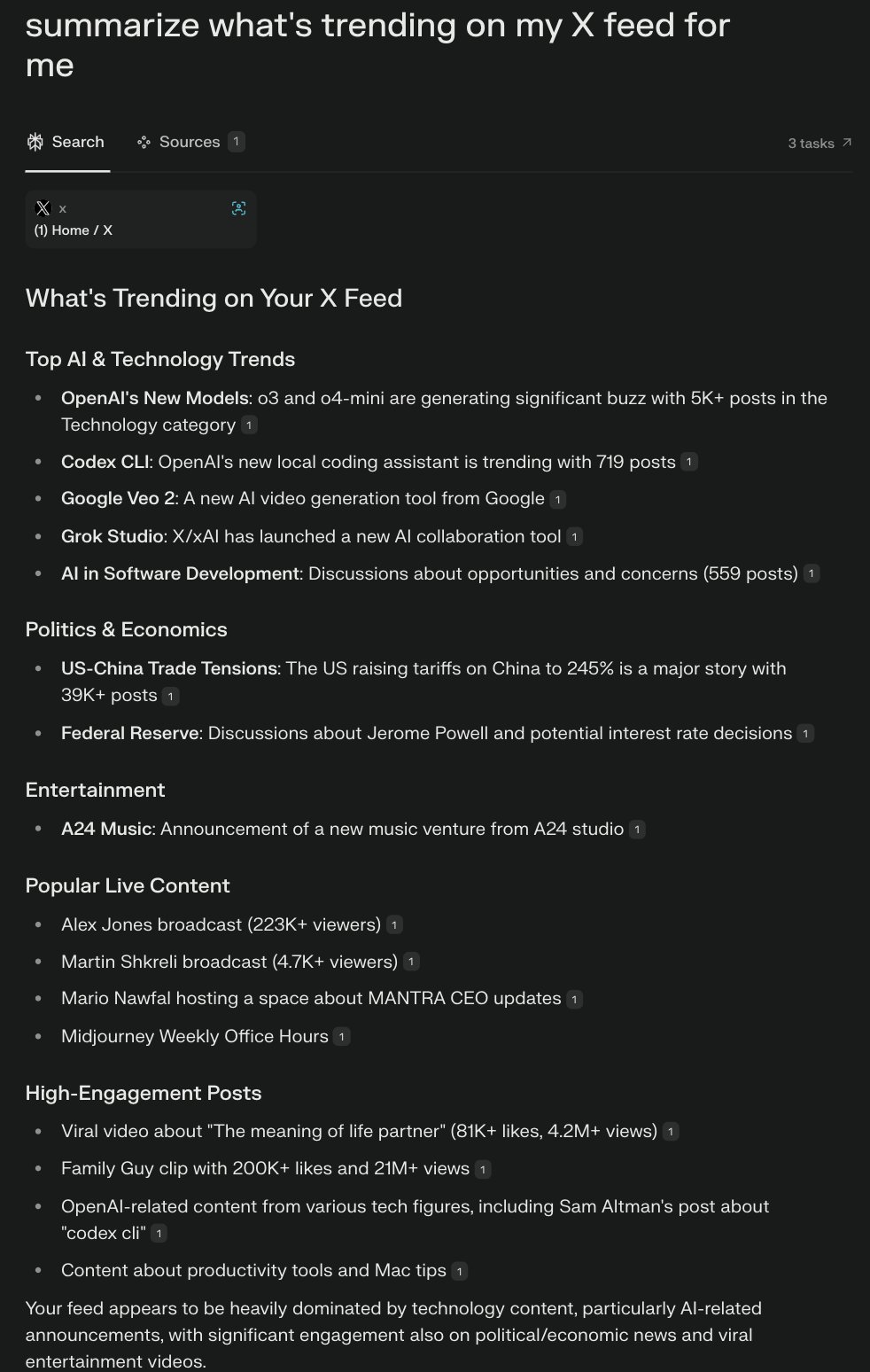

Model Context Protocol (MCP) erhält Unterstützung von OpenAI, Ökosystemintegration beschleunigt sich: OpenAI kündigte an, das Model Context Protocol (MCP) in seinem Agents SDK, der ChatGPT Desktop-App und der Responses API zu unterstützen. MCP wurde Ende letzten Jahres von Anthropic initiiert und zielt darauf ab, einen offenen Standard für die Verbindung von KI-Modellen mit Tools und Datenquellen zu schaffen. Über MCP können Modelle auf ein wachsendes Ökosystem von Ressourcen zugreifen, darunter über 6000 von der Community erstellte Server und Konnektoren (z. B. Websuche, Dateisystemoperationen). Zuvor hatten Microsoft MCP in CoPilot Studio integriert, Cloudflare die Bereitstellung von Remote-MCP-Servern unterstützt und der Code-Editor Cursor ebenfalls Unterstützung hinzugefügt. Die Beteiligung von OpenAI wird MCP erheblich dabei helfen, zum De-facto-Standard für die Erstellung von KI-Agenten-Anwendungen zu werden und den Prozess für Entwickler zur Integration verschiedener Drittanbieter-Tools und Datenquellen zu vereinfachen. (Quelle: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

ByteDance veröffentlicht Kling 2.0 zur Verbesserung der Videoerzeugungseffekte: Kling 2.0 ist das neueste Videoerzeugungsmodell von ByteDance. Laut Nutzerfeedback und Demos zeichnet sich Kling 2.0 durch die Erzeugung glatter, realistischer Videoszenen aus und zeigt Verbesserungen gegenüber früheren Versionen und Konkurrenzprodukten wie Sora, insbesondere bei der Umwandlung von Bildern in Videos. Benutzer können zuerst Tools wie ChatGPT verwenden, um Bilder mit guter Texttreue zu erzeugen, und dann Kling 2.0 nutzen, um diese in dynamische Videos umzuwandeln. Dies zeigt, dass die Videoerzeugungstechnologie in Bezug auf Szenenkohärenz und Realismus kontinuierlich Fortschritte macht. (Quelle:

)

Google veröffentlicht DolphinGemma zur Erforschung des Delfin-Kommunikationsrätsels: Google AI hat das DolphinGemma-Projekt gestartet, das darauf abzielt, mithilfe von KI-Technologie die Kommunikationsweise von Delfinen zu entschlüsseln. Das Projekt hat einen riesigen Datensatz von Delfinlauten gesammelt und ein 400-Millionen-Parameter-Modell (das auf einem Pixel 9-Telefon laufen kann) trainiert, um diese Laute zu analysieren und nach Mustern und Regeln zu suchen, die auf Sprache hindeuten könnten. Die Forschung befindet sich derzeit in der Explorationsphase, und es ist noch ungewiss, ob Delfine eine komplexe Sprache ähnlich der menschlichen besitzen. Es wurden jedoch bereits Lauttypen identifiziert, die mit bestimmten Verhaltensweisen (wie Namensgebung, Kämpfen, Balz) assoziiert sind. Das ultimative Ziel ist es, die Struktur und potenzielle Bedeutung von Delfinlauten zu verstehen und zu versuchen, durch die Erzeugung spezifischer Laute eine einfache bidirektionale Kommunikation mit Delfinen aufzubauen. (Quelle:

)

IBM veröffentlicht Granite 3.3-Modellreihe, einschließlich Spracherkennung: IBM hat die Granite 3.3-Modellreihe vorgestellt, die ein 8-Milliarden-Parameter-Spracherkennungsmodell (Granite Speech 3.3) enthält. Das Modell verwendet einen zweistufigen Ansatz, der darauf abzielt, Sprache zu verarbeiten, ohne die Kernfähigkeiten des LLM zu beeinträchtigen. Die neue Modellfamilie soll verfeinerte Reasoning-Fähigkeiten und verbesserte RAG (Retrieval-Augmented Generation)-Leistung bieten und unterstützt LoRA-Feinabstimmung. Diese Modelle können in KI-Assistenten für verschiedene Bereiche integriert werden. (Quelle: Reddit r/LocalLLaMA)

KI treibt Revolution in der Wettervorhersage voran, Prognoseeffizienz stark verbessert: Künstliche Intelligenz verändert leise den Bereich der Wettervorhersage. Prognoseaufgaben, die traditionell riesige Expertenteams und Supercomputer erforderten, können nun mit KI-Modellen auf einem Laptop durchgeführt werden. KI kann riesige Mengen an meteorologischen Daten verarbeiten und analysieren, komplexe Muster erkennen und so schnellere und potenziell genauere Wettervorhersagen erstellen. Dies markiert eine wichtige Anwendung von KI im Bereich wissenschaftliches Rechnen und Prognose und verspricht, die Aktualität und Reichweite von Vorhersagen zu verbessern. (Quelle: Reddit r/ArtificialInteligence)

Google Gemini App fügt LaTeX-Unterstützung hinzu: Die Google Gemini App wurde aktualisiert und unterstützt nun LaTeX. Benutzer können jetzt LaTeX-Syntax in der Gemini App verwenden, um mathematische Formeln, wissenschaftliche Symbole usw. darzustellen. Dieses Update umfasst die Modelle Gemini 2.0 Flash und 2.5 Pro und verbessert die Nützlichkeit von Gemini in akademischen und technischen Kommunikationsszenarien. (Quelle: JeffDean)

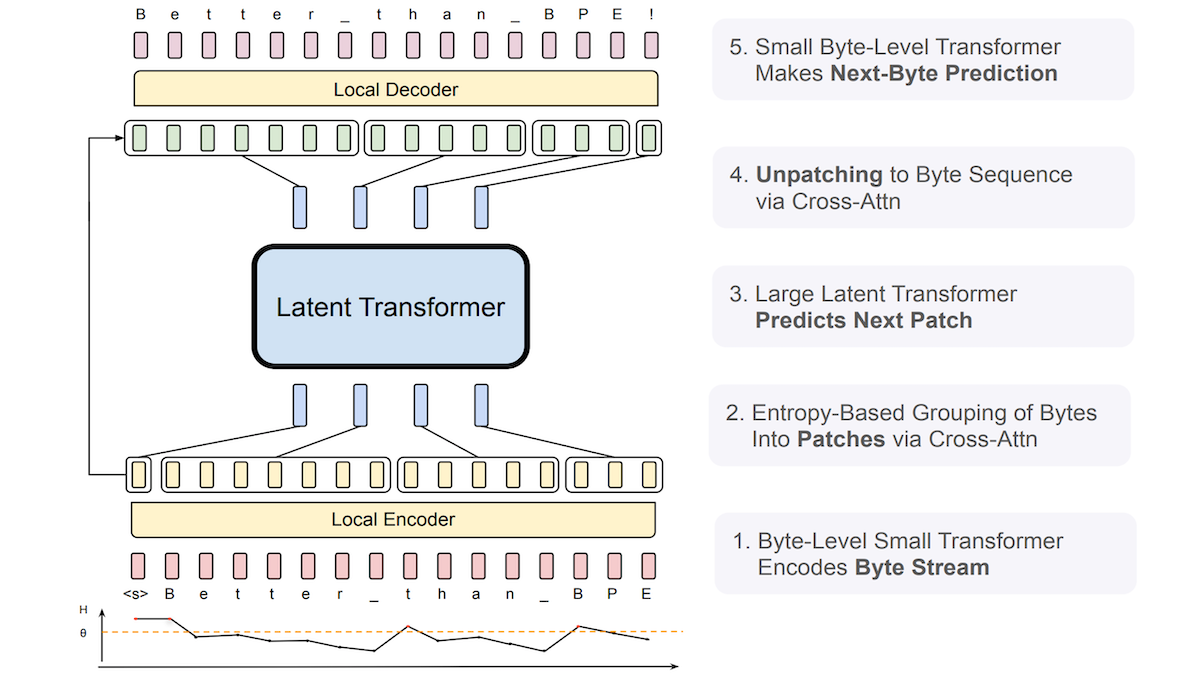

Meta schlägt Byte Latent Transformer (BLT) vor, um die Robustheit von LLMs gegenüber verrauschten Eingaben zu verbessern: Forscher von Meta und anderen Institutionen haben den Byte Latent Transformer (BLT) eingeführt, der darauf abzielt, traditionelle Tokenizer zu ersetzen. BLT verarbeitet direkt Byte- (Zeichen-) Sequenzen. Ein kleiner Byte-Level-Transformer prognostiziert die Wahrscheinlichkeit des nächsten Bytes, und die Entropie wird verwendet, um Bytes dynamisch zu gruppieren: niedrige Entropie (hohe Vorhersagbarkeit) führt zur Aufnahme in die aktuelle Gruppe, hohe Entropie (niedrige Vorhersagbarkeit) beginnt eine neue Gruppe. Das System umfasst einen Encoder, einen latenten Transformer und einen Decoder mit insgesamt 8 Milliarden Parametern. Experimente zeigen, dass BLT bei allgemeinen Sprach- und Codierungs-Benchmarks etwas besser abschneidet als Llama 3 ähnlicher Größe und eine signifikant stärkere Robustheit gegenüber verrauschten Eingaben wie Rechtschreibfehlern und seltenen Sprachen aufweist, da es Ähnlichkeiten auf Zeichenebene besser verstehen kann. (Quelle: Google Unveils Gemini 2.5, MCP Gains Momentum, Behind Sam Altman’s Fall and Rise, LLMs That Understand Misspellings)

Neue Studie untersucht Testzeit-Skalierung von kollaborativem Multi-Agenten-Reasoning: Ein Paper mit dem Titel „Two Heads are Better Than One: Test-time Scaling of Multi-agent Collaborative Reasoning“ wurde bei arXiv eingereicht. Die Studie konzentriert sich darauf, wie die Leistung bei komplexen Reasoning-Aufgaben verbessert werden kann, indem mehrere KI-Agenten zur Test- (Inferenz-) Zeit zusammenarbeiten. Sie untersucht einen Skalierungspfad zur Verbesserung der Modellfähigkeiten ohne zusätzliche Trainingskosten. (Quelle: Reddit r/MachineLearning)

Governance von KI-Agenten wird zu neuem Schwerpunkt: Mit den wachsenden Fähigkeiten von KI-Agenten (Agentic AI) wird deren effektive Governance zu einem wichtigen Thema. Dies beinhaltet die Sicherstellung, dass das Verhalten der Agenten den Erwartungen entspricht, sicher und kontrollierbar ist und ethischen Normen folgt. Es müssen entsprechende Rahmenwerke, Standards und Regulierungsmechanismen geschaffen werden, um diese „synthetischen Geister“, die autonom handeln und entscheiden können, zu verwalten. (Quelle: Ronald_vanLoon)

KI generiert hochwertige Bilder schneller als aktuelle SOTA-Methoden: Forscher des Massachusetts Institute of Technology (MIT) haben ein neues KI-Tool entwickelt, das bei der Generierung hochwertiger Bilder die derzeit fortschrittlichsten (SOTA) Methoden übertrifft und dabei schneller ist. Dies zeigt, dass im Bereich der Bilderzeugung weiterhin Durchbrüche bei Effizienz und Qualität erzielt werden. (Quelle: Ronald_vanLoon)

xAI führt Canvas-ähnliche Funktion für Grok AI ein: xAI hat seinem Chatbot Grok AI eine Funktion hinzugefügt, die ChatGPT Canvas ähnelt. Canvas-ähnliche Funktionen bieten typischerweise eine unendliche Leinwand-Oberfläche, die es Benutzern ermöglicht, Informationen freier und visueller zu organisieren und damit zu interagieren, wobei Text, Code, Bilder usw. kombiniert werden. Dieser Schritt lässt Grok in Bezug auf die Benutzerinteraktionserfahrung zu ChatGPT aufschließen, und die Funktion wird kostenlos angeboten. (Quelle: Reddit r/ArtificialInteligence)

🧰 Tools

Anx Reader: Plattformübergreifender E-Book-Reader mit integrierten Multi-AI-Engines: Anx Reader ist ein E-Book-Reader, der verschiedene Formate wie EPUB, MOBI, AZW3, FB2, TXT usw. unterstützt und auf iOS/macOS/Windows/Android verfügbar ist. Seine Besonderheit liegt in der Integration verschiedener KI-Fähigkeiten von OpenAI, Claude, Gemini, DeepSeek usw., die für Inhaltszusammenfassungen, Fragen, schnellen Informationsabruf usw. genutzt werden können. Die Anwendung unterstützt die Synchronisierung von Lesefortschritt, Buchdateien und Notizen über WebDAV, bietet hochgradig anpassbare Lesestile (Zeilenabstand, Schriftart, Farbschema usw.) und umfasst Funktionen wie TTS-Vorlesen, Übersetzung, Suche und Ideenerfassung. Ziel ist es, ein intelligentes, fokussiertes und personalisiertes Leseerlebnis zu bieten. (Quelle: Anxcye/anx-reader – GitHub Trending (all/daily))

OpenAI veröffentlicht Codex CLI als Open Source: Lokal laufender, leichtgewichtiger Programmier-KI-Agent: Begleitend zur Veröffentlichung von o3/o4-mini hat OpenAI Codex CLI als Open Source freigegeben, einen im Terminal laufenden Programmier-KI-Agenten. Er ermöglicht Entwicklern, durch Anweisungen in natürlicher Sprache die KI direkt auf dem lokalen Computer Programmieraufgaben ausführen zu lassen, wie z. B. Code schreiben, Abhängigkeiten installieren, Umgebungen konfigurieren, Bugs beheben usw. Codex CLI zielt darauf ab, die leistungsstarken Reasoning-Fähigkeiten von Modellen wie o3/o4-mini voll auszuschöpfen und kann multimodale Eingaben (wie Screenshots) mit lokalem Codezugriff kombinieren. Das Tool soll den Entwicklungsprozess vereinfachen, insbesondere für Anfänger. OpenAI hat außerdem ein Förderprogramm in Höhe von 1 Million US-Dollar zur Unterstützung von Projekten gestartet, die auf diesem Tool basieren. (Quelle: OpenAI震撼发布o3/o4-mini,直逼视觉推理巅峰,首用图像思考,十倍算力爆表, sama, karminski3, dotey, sama, dotey)

Cohere-Modelle landen im Hugging Face Hub und bieten Inferenzdienste an: Cohere gab bekannt, dass seine Modelle der erste unterstützte Drittanbieter für Inferenz im Hugging Face Hub sind. Benutzer können nun direkt im Hub auf die Open-Source-Modelle von Cohere (wie die Aya-Serie) und Unternehmensmodelle (wie die Command-Serie) zugreifen und schnelle Inferenzen durchführen. Diese Modelle zeichnen sich besonders durch Tool-Nutzung und Mehrsprachigkeit aus und bieten OpenAI-kompatible Schnittstellen, um Entwicklern die Integration und Erstellung von Anwendungen zu erleichtern. (Quelle: huggingface, huggingface, huggingface)

LocalAI v2.28.0 veröffentlicht, zusammen mit der lokalen KI-Agenten-Plattform LocalAGI: LocalAI, ein Server zum lokalen Ausführen von LLMs mit OpenAI-kompatibler API, wurde auf Version v2.28.0 aktualisiert. Gleichzeitig wurde die brandneue Plattform LocalAGI eingeführt. LocalAGI ist eine selbst gehostete KI-Agenten-Orchestrierungsplattform mit einer WebUI, die es Benutzern ermöglicht, komplexe, mehrstufige KI-Agenten-Workflows (ähnlich AutoGPT) zu erstellen. Entscheidend ist, dass diese Agenten von lokalen LLMs angetrieben werden können, die über LocalAI oder andere kompatible APIs (wie llama-cpp-python) bereitgestellt werden. In Verbindung mit dem lokalen Speicher LocalRecall können Benutzer autonome KI-Agenten in einer vollständig lokalen Umgebung ausführen, um Aufgaben wie Recherche, Codierung, Inhaltsverarbeitung usw. durchzuführen. (Quelle: Reddit r/LocalLLaMA)

Droidrun Framework Open Source: Android-Handys mit KI steuern: Droidrun ist ein Framework, das es Benutzern ermöglicht, Android-Handys über KI (wie große Sprachmodelle) zur Ausführung von Aufgaben zu steuern, und ist jetzt auf GitHub als Open Source verfügbar. Benutzer können durch Anweisungen in natürlicher Sprache die KI dazu bringen, Aktionen auf dem Telefon auszuführen, z. B. Apps öffnen, Schaltflächen anklicken, Text eingeben usw. Dies erfordert die Installation des ADB (Android Debug Bridge)-Tools. Das Framework zeigt neue Möglichkeiten für KI in der Automatisierung und Interaktion mit mobilen Geräten. (Quelle: karminski3)

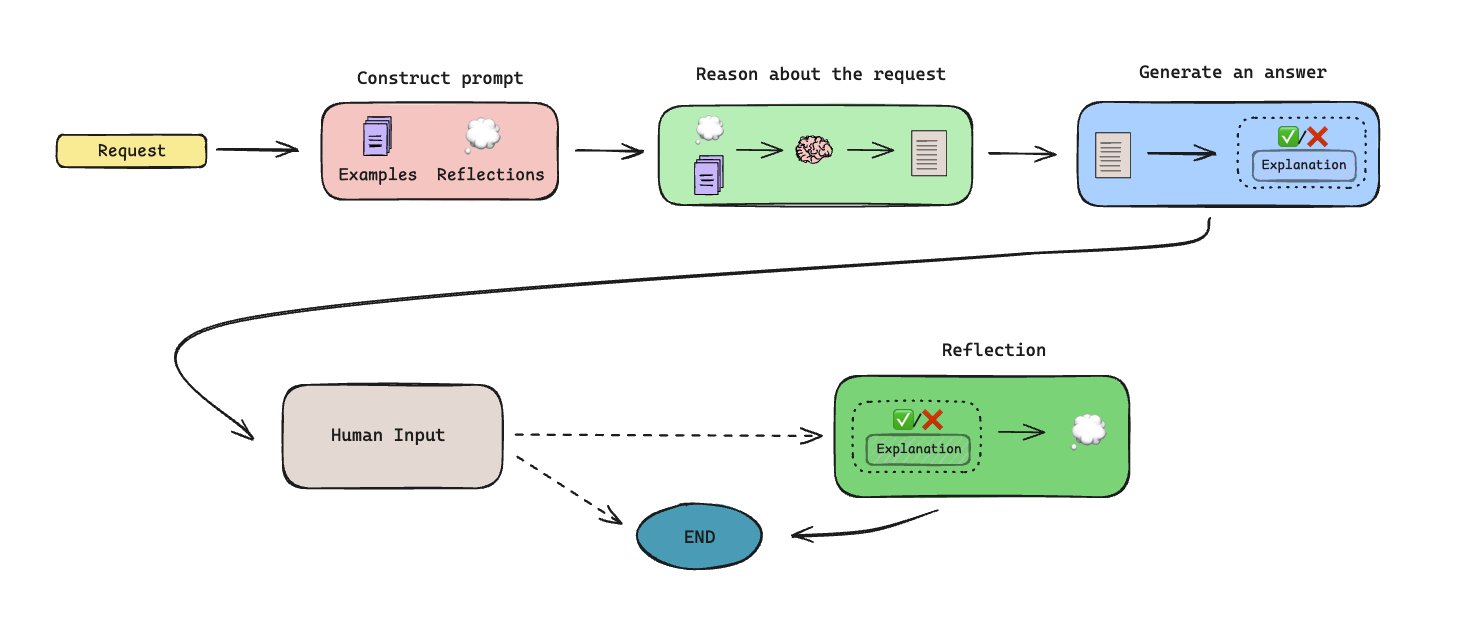

LLManager veröffentlicht: Speicherbasierter automatisierter Genehmigungsworkflow: LLManager ist ein mit LangGraph erstellter Open-Source-Workflow, der darauf abzielt, Genehmigungsaufgaben durch KI-Agenten mit Gedächtnisfähigkeiten zu automatisieren. Das System kann durch Mensch-Maschine-Kollaboration (Human-in-the-Loop) Gedächtnisinhalte generieren und so im Laufe der Zeit lernen und Genehmigungsentscheidungen verbessern. Die Architektur ist darauf ausgelegt, wiederkehrende Genehmigungsprozesse zu bewältigen und die Effizienz zu steigern. (Quelle: LangChainAI)

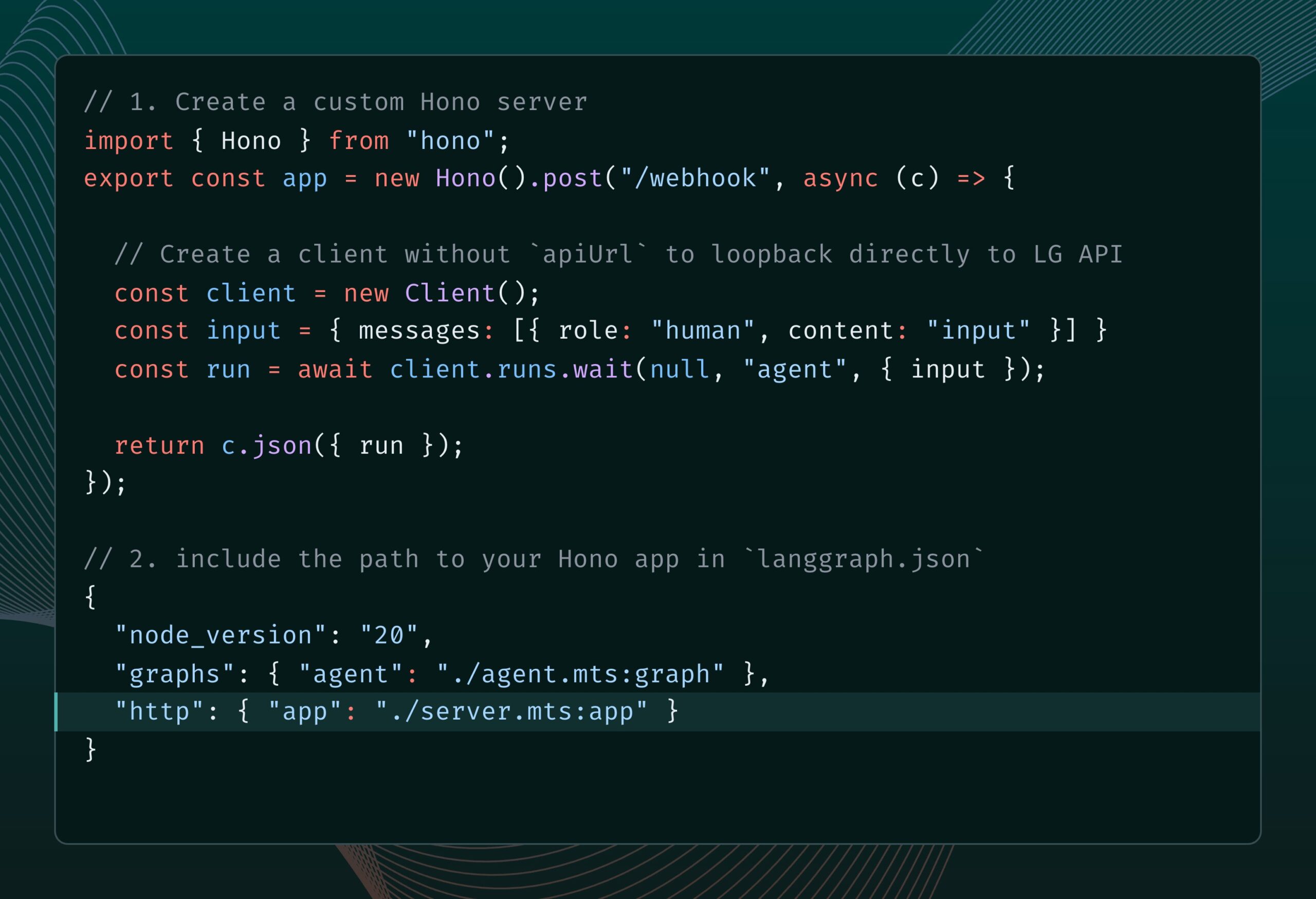

LangGraph.js integriert Hono und unterstützt benutzerdefinierte HTTP-Routen und Middleware: LangGraph.js (die JS-Version von LangChain zur Erstellung zustandsbehafteter Multi-Agenten-Anwendungen) kann jetzt mit Hono (einem leichtgewichtigen Web-Framework) integriert werden. Dies ermöglicht Entwicklern, benutzerdefinierte HTTP-Routen und Middleware zu ihren LangGraph.js-Anwendungen hinzuzufügen, um komplexere Backend-Dienste wie die Verarbeitung von Webhooks, die Erstellung vollständiger API-Anwendungen usw. zu erstellen und erweitert so die Anwendungsszenarien von LangGraph.js. (Quelle: LangChainAI)

Open-Source-Humanoider Roboter Reachy 2 beginnt mit dem Verkauf: Hugging Face Mitbegründer Clem Delangue gab bekannt, dass der erste Open-Source-Humanoide Roboter Reachy 2, an dessen Entwicklung sein Team beteiligt war, diese Woche in den Verkauf geht. Der Roboter kostet 70.000 US-Dollar, richtet sich an den Forschungs- und Bildungsmarkt und wird bereits an der Cornell University, der Carnegie Mellon University und in großen KI-Labors eingesetzt. Er verfügt über eine menschenähnliche Form, eine omnidirektionale mobile Basis, umfangreiche Sensoren (Kameras, Mikrofone, LiDAR usw.), basiert auf ROS 2 und LeRobotHF, unterstützt ein Python SDK und ist modular aufgebaut, was Anpassungen ermöglicht. (Quelle: huggingface)

Perplexity startet Comet Browser zur Erkundung eines KI-nativen Browsing-Erlebnisses: Perplexity CEO Arav Srinivas entwickelt einen Browser namens Comet und bittet um Ideen für Produktwachstum und Funktionen. Comet soll die Verkörperung eines „agentenbasierten Betriebssystems“ (agentic OS) sein, das Webanwendungen und Daten über den Browser steuert und KI nutzt, um Fragen zu beantworten und Aufgaben auszuführen. Die Idee dahinter ist, dass die KI, die den Browser steuert, den Großteil des digitalen Lebens kontrollieren kann, da die meisten Anwendungen im Web laufen. Das Projekt betont, klein anzufangen und übermäßige Versprechungen allgemeiner Fähigkeiten zu vermeiden. (Quelle: AravSrinivas, AravSrinivas, AravSrinivas, AravSrinivas, AravSrinivas)

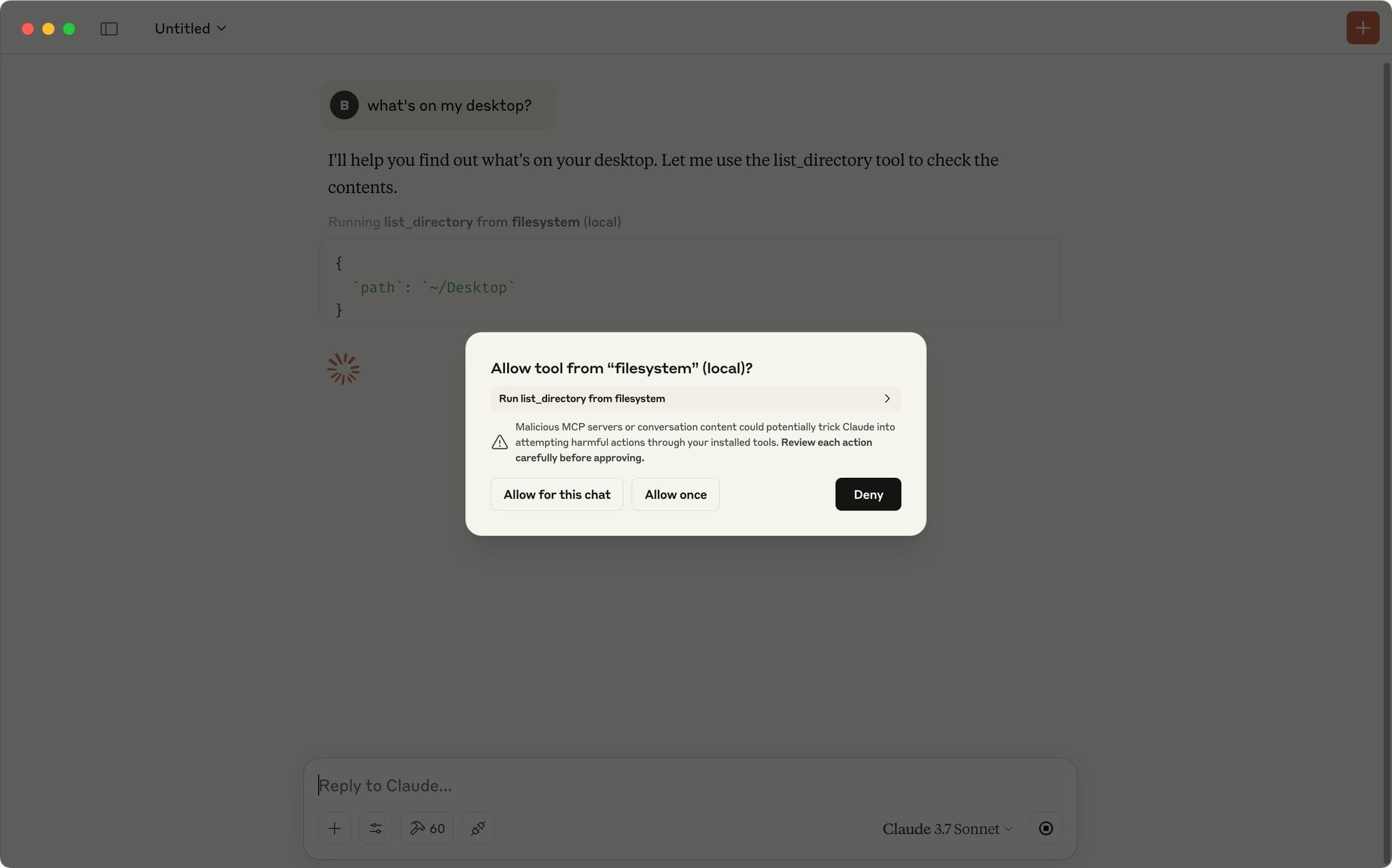

Claude App unterstützt Skript zur automatischen Genehmigung von MCP-Anfragen: Ein Community-Benutzer teilte ein JavaScript-Skript, das in der Entwicklerkonsole der Claude App ausgeführt werden kann, um MCP (Model Context Protocol)-Anfragen von einer vordefinierten Liste vertrauenswürdiger Tools automatisch zu genehmigen. Für Benutzer, die häufig bestimmte lokale oder Remote-Tools verwenden, kann dies das wiederholte manuelle Klicken auf „Zulassen“ ersparen und die Workflow-Effizienz verbessern. Benutzer sollten jedoch die Sicherheitsrisiken beachten und dies nur für vollständig vertrauenswürdige Tools aktivieren. (Quelle: Reddit r/ClaudeAI)

Empfehlungen für unverzichtbare MCP-Server zur Unterstützung von Codierung und Workflow-Automatisierung: Ein Community-Benutzer teilte eine Reihe empfohlener MCP (Model Context Protocol)-Server. Diese Tools können mit MCP-unterstützenden KI-Modellen (wie Claude) oder Agenten-Frameworks integriert werden, um die Codierungseffizienz und Automatisierungsfähigkeiten zu verbessern. Die Empfehlungsliste umfasst: Sequential Thinking MCP für strukturiertes Denken, Puppeteer MCP für Webinteraktion, Memory Bank MCP für Projektwissensmanagement, Playwright MCP für browserübergreifendes Testen, GitHub MCP für GitHub-Operationen, Knowledge Graph Memory MCP für persistentes Gedächtnis, DuckDuckGo MCP für Suche ohne API-Schlüssel und MCP Compass zur Entdeckung weiterer MCP-Tools. (Quelle: Reddit r/ClaudeAI)

📚 Lernen

GitHub-Repository: Umfassender Leitfaden zu fortgeschrittenen RAG-Techniken: Das von Nir Diamant erstellte GitHub-Repository RAG_Techniques bietet die derzeit umfassendste Sammlung von Tutorials zu fortgeschrittenen Retrieval-Augmented Generation (RAG)-Techniken. Das Repository zielt darauf ab, die Genauigkeit, Effizienz und Kontextrelevanz von RAG-Systemen zu verbessern. Es deckt über 30 Techniken ab, von grundlegenden Implementierungen (LangChain/LlamaIndex), Optimierung der Textsegmentierung (feste Größe, Propositional Chunking, Semantic Chunking), Abfrageverbesserung (Transformation, HyDE, HyPE), Kontextanreicherung (Chunk Header, Extraktion relevanter Segmente, Fenstererweiterung, Dokumentenanreicherung) bis hin zu fortgeschrittenem Retrieval (Fusion, Reranking, Multi-Aspect Filtering, hierarchische Indizierung, Ensemble, Multimodal), iterativen Techniken (Feedback-Schleifen, adaptiv, iteratives Retrieval), Evaluierung (DeepEval, GroUSE), Erklärbarkeit sowie fortgeschrittenen Architekturen (Graph RAG, RAPTOR, Self-RAG, CRAG) und bietet Implementierungen in Jupyter Notebooks oder Python-Skripten. Das Projekt ist Community-getrieben und ermutigt Beiträge. (Quelle: NirDiamant/RAG_Techniques – GitHub Trending (all/daily))

DeepLearning.AI startet neuen Kurs: Building AI Browser Agents: Andrew Ng kündigte in Zusammenarbeit mit AGI Inc. einen neuen Kurzkurs „Building AI Browser Agents“ an. Der Kurs wird von den Mitbegründern von AGI Inc., Div Garg und Naman Garg, unterrichtet und zielt darauf ab, zu lehren, wie man KI-Agenten erstellt, die mit Websites interagieren und Aufgaben ausführen können (z. B. Informationen extrahieren, Formulare ausfüllen, klicken, Bestellungen aufgeben). Die Kursinhalte umfassen die Funktionsweise von Web Agents, Architektur, Einschränkungen, Entscheidungsstrategien, praktisches Erstellen eines Web Agents zum Extrahieren von DeepLearning.AI-Kursen und strukturierter Ausgabe, Erstellen eines autonomen Agenten zur Erledigung mehrerer Aufgaben (Webseiten finden und zusammenfassen, Formulare ausfüllen, abonnieren), Erkundung des AgentQ-Frameworks (kombiniert Monte-Carlo-Tree-Search MCTS und Direct Preference Optimization DPO zur Selbstkorrektur), Vertiefung der MCTS-Prinzipien sowie Diskussion über den aktuellen Stand und die Zukunft von KI-Agenten. (Quelle: AndrewYNg)

Hugging Face aktualisiert Quantisierungsdokumentation, bietet Konzeptleitfaden und Auswahl-Benchmarks: Hugging Face hat seine Dokumentation zur Modellquantisierung erheblich aktualisiert. Die neue Dokumentation soll Benutzern helfen, Quantisierungskonzepte besser zu verstehen und die geeignete Technik für ihre Bedürfnisse auszuwählen. Die Aktualisierungen umfassen: Erklärungen zu Quantisierungsgrundlagen (wie Schemata, int4, FP8), einen neuen Auswahlleitfaden (der bei der Auswahl zwischen Techniken wie bnb, AWQ, GPTQ, HQQ basierend auf Anforderungen und Hardware hilft) sowie Vergleichsdaten zur Genauigkeit und Leistung gängiger Quantisierungsmethoden für die Modelle Llama 3.1 8B und 70B. Dies bietet wertvolle Referenzen für Entwickler, die Modelle komprimieren und die Inferenz-Effizienz verbessern möchten. (Quelle: huggingface)

Neue Methode MODE: Leichtgewichtige, interpretierbare RAG-Alternative: Der unabhängige Forscher Rahul Anand schlägt eine neue Methode namens MODE (Mixture of Document Experts) als leichtgewichtige Alternative zum traditionellen RAG-Prozess vor. MODE verzichtet auf Vektordatenbanken und Reranker und extrahiert Informationen stattdessen durch Clustering von Dokumenten und die Verwendung einer zentroidbasierten Retrieval-Methode. Diese Methode soll effizient und gut interpretierbar sein, insbesondere für kleine bis mittlere Datensätze. Der Autor bemüht sich um eine Bestätigung von arXiv (Bereich cs.AI) zur Veröffentlichung des Papers. (Quelle: Reddit r/MachineLearning)

GitHub-Repository Beyond-NanoGPT: Fortgeschrittene Ressource vom LLM-Neuling zum KI-Forscher: Tanishq Kumar hat ein GitHub-Repository namens beyond-nanoGPT als Open Source veröffentlicht. Das Projekt soll Lernenden, die bereits die Grundlagen von LLMs auf nanoGPT-Niveau beherrschen, helfen, komplexe Ideen, die der Spitze der Deep-Learning-Forschung nahekommen, weiter zu verstehen und zu implementieren. Das Repository enthält Tausende von Zeilen kommentierten PyTorch-Codes, der verschiedene moderne ML-Forschungsfortschritte von Grund auf implementiert, darunter spekulative Dekodierung (speculative decoding), visuelle/diffusions-Transformer, lineare/sparse Aufmerksamkeit usw. Ziel des Projekts ist es, mehr Menschen den Übergang in den Bereich der KI-Forschung zu erleichtern. (Quelle: Reddit r/MachineLearning)

Tutorial: Training eines Chatbots basierend auf GitHub-Repositories mit AI Scraper und LLM: Ein Artikel im Stackademic-Blog beschreibt, wie man mit einem AI Scraper (Web-Scraping-Tool) und großen Sprachmodellen (LLM) einen Chatbot trainiert, der Fragen zu einem bestimmten GitHub-Repository beantworten kann. Diese Methode beinhaltet typischerweise das Scrapen von Code, Dokumentation (wie READMEs), Issues usw. aus dem Repository, deren Verarbeitung in ein für LLMs verständliches Format und anschließendes Training des Chatbots mittels RAG (Retrieval-Augmented Generation) oder Feinabstimmung, damit er auf Basis dieser Informationen Fragen beantworten kann. (Quelle: Reddit r/ArtificialInteligence)

Paper-Interpretation: Erklärbare KI (XAI) für tabellarische Daten mit Layer-Wise Relevance Propagation (LRP): Ein Blogbeitrag untersucht, wie die Technik Layer-Wise Relevance Propagation (LRP) verwendet werden kann, um den Entscheidungsprozess von Deep-Learning-Modellen bei der Verarbeitung tabellarischer Daten zu erklären. LRP ist eine Attributionsmethode, die darauf abzielt, die Ausgabevorhersage des Modells auf die Eingabemerkmale zurückzuführen und so aufzudecken, welche Merkmale am meisten zur endgültigen Entscheidung beitragen. Die Anwendung auf tabellarische Daten hilft, das Modellverhalten zu verstehen und Transparenz und Vertrauenswürdigkeit zu erhöhen. (Quelle: Reddit r/deeplearning)

💼 Wirtschaft

Zhipu AI startet Börsengang-Vorbereitung, Abschluss innerhalb des Jahres geplant: Das chinesische KI-Unternehmen Zhipu AI hat offiziell die Vorbereitung für den Börsengang eingeleitet, wobei CICC als beratende Institution fungiert. Laut dem Einreichungsbericht plant Zhipu AI, das IPO-Coaching zwischen August und Oktober 2025 abzuschließen. Zuvor hatte CEO Zhang Peng erklärt, dass der Weg zur AGI lang sei und die gesammelten Mittel nur “Reisegeld” seien, wobei in Zukunft mehr Kapital benötigt werde. Dieser Börsengang wird als entscheidender Schritt gesehen, um “mehr Reisegeld” zu beschaffen. Zhipu AI ist ein wichtiger Akteur im Bereich der großen Modelle in China, und sein IPO-Prozess wird mit großer Aufmerksamkeit verfolgt. (Quelle: 压力给到梁文锋)

2-Personen-Startup Gumloop sichert sich über 100 Mio. RMB Finanzierung durch KI: Die No-Code-Plattform Gumloop, mit nur zwei Gründern als formale Mitarbeiter, hat kürzlich eine A-Runden-Finanzierung in Höhe von 17 Millionen US-Dollar (ca. 124 Millionen RMB) abgeschlossen. Das Unternehmen entstand ursprünglich aus dem Bestreben, eine benutzerfreundliche UI für Auto-GPT bereitzustellen, und entwickelte sich zu AgentHub, einer Plattform zur Erstellung von KI-Workflows für Nicht-Techniker. Es kann Tools wie GitHub, Gmail usw. integrieren und Aufgaben wie Dokumentenverarbeitung, Web-Scraping, SEO, CRM, E-Mail-Marketing usw. automatisieren. Gumloop selbst nutzt KI-Agenten in großem Umfang zur Abwicklung von Geschäftsaufgaben. Das Ziel der Gründer ist es, mit einem Team von nicht mehr als 10 Personen ein Unternehmen mit einer Bewertung von 1 Milliarde US-Dollar aufzubauen. Dies spiegelt das Potenzial kleiner Teams im KI-Zeitalter wider, mithilfe von KI-Tools hohe Effizienz und Wertschöpfung zu erzielen, sowie die unternehmerische Chance, die “letzte Meile” der KI-Anwendung zu überbrücken. (Quelle: 把AI当成“牛马”,2人创业团队,拿下了超1亿元融资)

Gerücht: OpenAI plant Übernahme des KI-Programmierwerkzeug-Unternehmens Windsurf (ehemals Codeium) für 3 Mrd. USD: Laut Bloomberg unter Berufung auf informierte Quellen verhandelt OpenAI über die Übernahme des KI-gestützten Programmierwerkzeug-Unternehmens Windsurf (früher bekannt als Codeium) für rund 3 Milliarden US-Dollar. Sollte die Transaktion zustande kommen, wäre dies die größte Übernahme in der Geschichte von OpenAI, mit dem Ziel, seine Wettbewerbsfähigkeit auf dem Markt für KI-Programmierassistenten zu stärken und direkt mit Anthropic, GitHub Copilot, Anysphere (Cursor) usw. zu konkurrieren. Windsurf wurde 2021 gegründet, hatte zuvor eine Bewertung von 1,25 Milliarden US-Dollar erreicht und über 200 Millionen US-Dollar an Finanzmitteln erhalten. Dieses Übernahmegerücht deutet auch auf eine mögliche Konsolidierung im Bereich der KI-Programmierwerkzeuge hin. (Quelle: dotey)

Ilya Sutskever’s Safe Superintelligence Unternehmen wird Berichten zufolge mit 32 Mrd. USD bewertet: Laut TechCrunch wird das neue Unternehmen Safe Superintelligence (SSI), gegründet von OpenAI-Mitbegründer Ilya Sutskever, in einer kürzlichen Finanzierungsrunde mit 32 Milliarden US-Dollar bewertet. Das Unternehmen soll bereits Investitionen in Höhe von 2 Milliarden US-Dollar erhalten haben. SSI hat das Ziel, Superintelligenz sicher zu entwickeln. Seine hohe Bewertung spiegelt die hohen Erwartungen des Marktes an führende KI-Talente und die Vision von AGI wider, obwohl das Unternehmen bisher keine Produkte veröffentlicht hat. (Quelle:

)

US-China-Handelskrieg könnte KI-Entwicklung beeinflussen, Chipversorgung im Fokus: Analysen deuten darauf hin, dass der Handelskrieg der USA mit China, insbesondere die Exportbeschränkungen für High-End-KI-Chips (wie die H100/B200-Serie von Nvidia) und mögliche chinesische Gegenmaßnahmen wie die Beschränkung des Exports von Seltenen Erden, eine Herausforderung für die globale KI-Entwicklung darstellt. Berichten zufolge spüren KI-Unternehmen (wie OpenAI) bereits die Einschränkungen durch die unzureichende GPU-Versorgung. Gleichzeitig macht China Fortschritte in der Chipherstellung (z. B. Durchbrüche bei 3nm-, 1nm-Technologie) und könnte in den nächsten Jahren hochwertige KI-Chips produzieren. Der Artikel vertritt die Ansicht, dass die aktuellen Handelsbeschränkungen die KI-Entwicklung in den USA verlangsamen und China sogar ermöglichen könnten, im KI-Bereich aufzuholen, und plädiert für freien Handel zur Förderung der KI-Entwicklung. (Quelle: Reddit r/ArtificialInteligence)

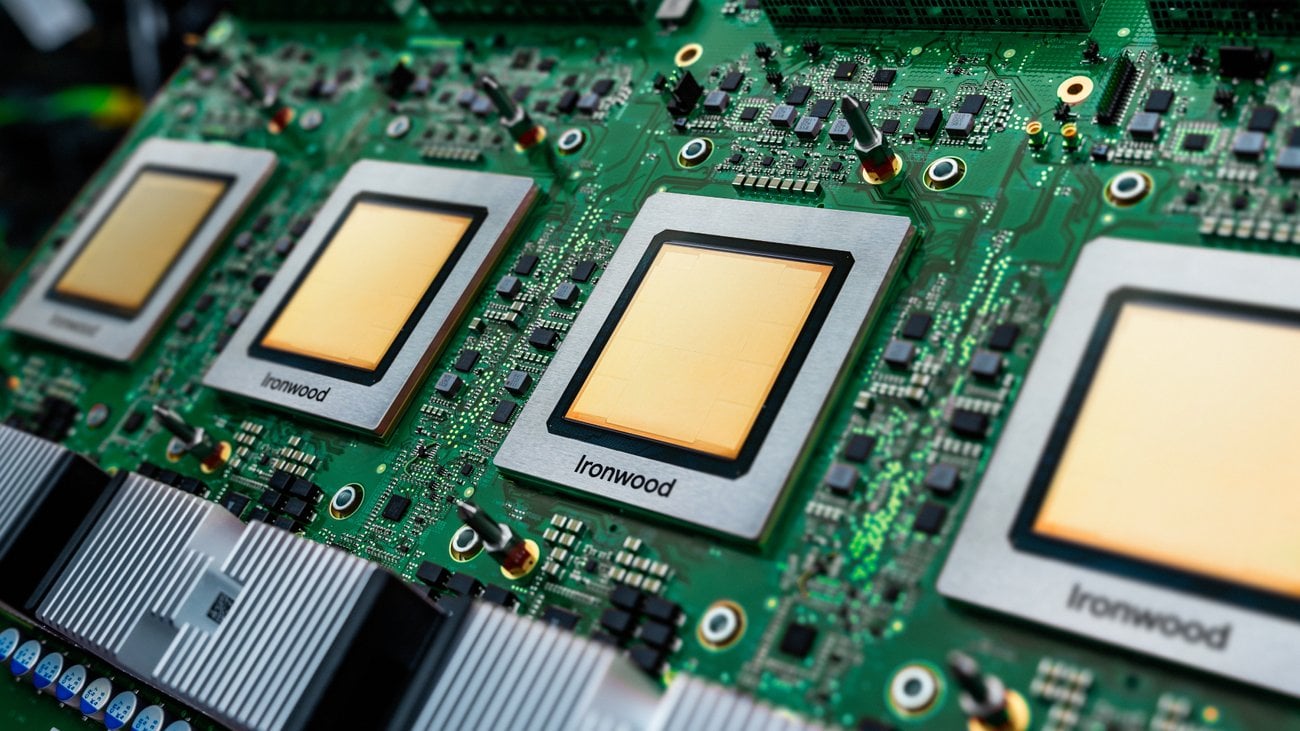

Diskussion über die praktische Anwendung von TPUs in Produktionsumgebungen: Google hat kürzlich eine neue Generation von TPUs (Tensor Processing Units) vorgestellt, die für die Inferenz optimiert sind. Community-Diskussionen weisen jedoch darauf hin, dass TPUs, obwohl sie seit Jahren existieren und Google großzügige Ressourcenprogramme für Forscher (TRC) anbietet, in industriellen Produktionsumgebungen anscheinend weniger verbreitet sind als NVIDIA GPUs. Mögliche Gründe sind die Komplexität der Einrichtung, nicht offensichtliche Leistungsvorteile, fehlende zugehörige Funktionen auf der GCP-Plattform (wie feste IPs, Beobachtbarkeitstools), Schwierigkeiten beim Debugging (XLA) und Bedenken hinsichtlich der Anbieterbindung, da sie nur über GCP gemietet werden können. Die Diskussion ruft Benutzer mit praktischer Produktionserfahrung dazu auf, ihre Erfahrungen und Herausforderungen bei der Verwendung von TPUs zu teilen. (Quelle: Reddit r/MachineLearning)

KI verursacht Vertrauenslücke in der Versicherungsbranche: Ein Forschungsbericht von Swiss Re weist darauf hin, dass die Anwendung von generativer KI in der Versicherungsbranche vor Vertrauensherausforderungen steht. Obwohl das Potenzial der KI enorm ist, bestehen Bedenken hinsichtlich Datenschutz, Cybersicherheit und Entscheidungstransparenz, was zu einer Vertrauenslücke zwischen Versicherungsunternehmen und Kunden führen kann. Der Bericht untersucht, wie die Vorteile der KI genutzt und gleichzeitig die damit verbundenen Risiken und ethischen Fragen angegangen werden können, um das Vertrauen der Nutzer aufzubauen und zu erhalten. (Quelle: Ronald_vanLoon)

🌟 Community

OpenAI o3/o4-mini löst hitzige Diskussionen aus, Potenzial und Hype koexistieren: Nach der Veröffentlichung von o3 und o4-mini durch OpenAI war die Resonanz in der Community groß. Frühe Tester (wie Dan Shipper) lobten ihre Geschwindigkeit, Intelligenz und Agentenfähigkeiten, bezeichneten sie bereits als bevorzugtes Modell und hoben hervor, dass sie Code-Benchmarks bestehen, personalisierte Kurse erstellen, unscharfe Bilder erkennen und Schreibanalysen durchführen können. Sam Altman teilte dies und betonte ihr “nahezu oder auf Genie-Niveau” liegendes Potenzial. Es gab jedoch auch Kommentare (wie im Video von AI Explained), die darauf hinwiesen, dass trotz der Leistungsfähigkeit der Modelle Begriffe wie “AGI” und “halluzinationsfrei” übertrieben seien. Die Modelle machten immer noch Fehler bei gesundem Menschenverstand und physikalischem Reasoning, und das Preis-Leistungs-Verhältnis sei möglicherweise nicht besser als bei Gemini 2.5 Pro. Die Community erkennt allgemein den Fortschritt an, insbesondere beim Codieren und der Tool-Nutzung, bleibt aber hinsichtlich ihrer tatsächlichen Fähigkeiten und Grenzen kritisch. (Quelle:

,

, sama, sama, karminski3, gdb, natolambert)

Community-Diskussion: Hängt KI zur Erreichung von AGI hauptsächlich vom Fortschritt der Rechenleistung ab?: Reddit-Benutzer initiierten eine Diskussion darüber, ob die Erreichung von AGI (Künstliche Allgemeine Intelligenz) hauptsächlich auf die Steigerung der rohen Rechenleistung zurückzuführen ist. Es wurde argumentiert, dass selbst bei den derzeitigen Einschränkungen von LLMs eine weitere Steigerung der Rechenleistung um eine Größenordnung einen Nutzen nahe an AGI bringen könnte, auch wenn es sich nicht um “echte” AGI handelt. Entscheidend sei, ob das AGI-Problem grundsätzlich “behandelbar” (tractable) ist; wenn ja, könnte Brute-Force-Computing ausreichen. Andere Kommentare widersprachen jedoch und argumentierten, dass Rechenleistung allein die grundlegenden Beschränkungen von LLMs nicht überwinden könne und AGI weitere Paradigmenwechsel erfordere. (Quelle: Reddit r/ArtificialInteligence)

Community-Diskussion: Welche Branchen werden zuerst von KI disruptiert?: Reddit-Benutzer starteten eine Diskussion darüber, welche Branchen zuerst von KI betroffen sein und “zusammenbrechen” werden. Zu den genannten Branchen gehörten: Übersetzung/Texten, Kundensupport, Sprachunterricht, Portfolio-Management, Illustration/kommerzielle Fotografie. In den Kommentaren wurden ergänzt: Transportwesen, Design (Interface, Marke, Logo), PR/Marketing/Social Media Management, Lehre (insbesondere Nachhilfe), Blogs/Podcasts (Veränderung der Inhaltserstellung), Eventorganisation und -management. Einige Kommentare wiesen auch darauf hin, dass nicht alle Bereiche vollständig verschwinden werden; beispielsweise hochspezialisierte Übersetzungen oder Illustrationen, die menschliche Kreativität erfordern, werden weiterhin Bestand haben. (Quelle: Reddit r/ArtificialInteligence)

Benutzererfahrung: Debuggen von KI-generiertem Code ist eine Herausforderung: Ein Entwickler teilte seine Erfahrungen beim Debuggen von Code, der von einem LLM generiert wurde (Migration von SAS zu SQL/Python). Obwohl der KI-Code “ordentlich” aussah, war er voller Fehler: Aufruf undefinierter Funktionen, Verwechslung ähnlicher, aber nicht identischer Codelogik, Überspringen von schlecht formatiertem, aber korrektem SQL, willkürlicher Austausch kritischer Werte und inkonsistente Ergebnisse bei mehrmaliger Ausführung. Das endgültige Fazit war, dass der Code völlig unbrauchbar war und neu geschrieben werden musste, wobei die Reparatur riskanter war als das Neuschreiben. Dies unterstreicht die Grenzen der aktuellen KI-Code-Generierungsfähigkeiten und betont die Notwendigkeit menschlicher Überprüfung und Validierung. (Quelle: Reddit r/ArtificialInteligence)

KI und Arbeitsbeziehungen: Wie sollten Gewerkschaften reagieren?: In der Diskussion wird darauf hingewiesen, dass Gewerkschaften angesichts der zunehmenden Automatisierungsfähigkeiten von KI in verschiedenen Branchen proaktiver auf die potenziellen Auswirkungen auf Arbeitnehmer reagieren müssen. Der Artikel zitiert vergangene Streiks und Proteste im Zusammenhang mit KI, wie z. B. Schulen, die nach Streiks von Doktoranden den Einsatz von KI vorschlugen, die Nutzung von KI zur Überwachung von Studentenprotesten, Bedenken hinsichtlich automatisierter psychischer Gesundheitsdienste und mögliche Lehrerstreiks aufgrund des KI-Einsatzes in Schulen. Es wird argumentiert, dass Arbeitnehmer (und ihre Vertreterorganisationen) nicht warten sollten, sondern proaktiv Strategien entwickeln müssen, um dem durch KI verursachten Wandel zu begegnen. (Quelle: Reddit r/artificial)

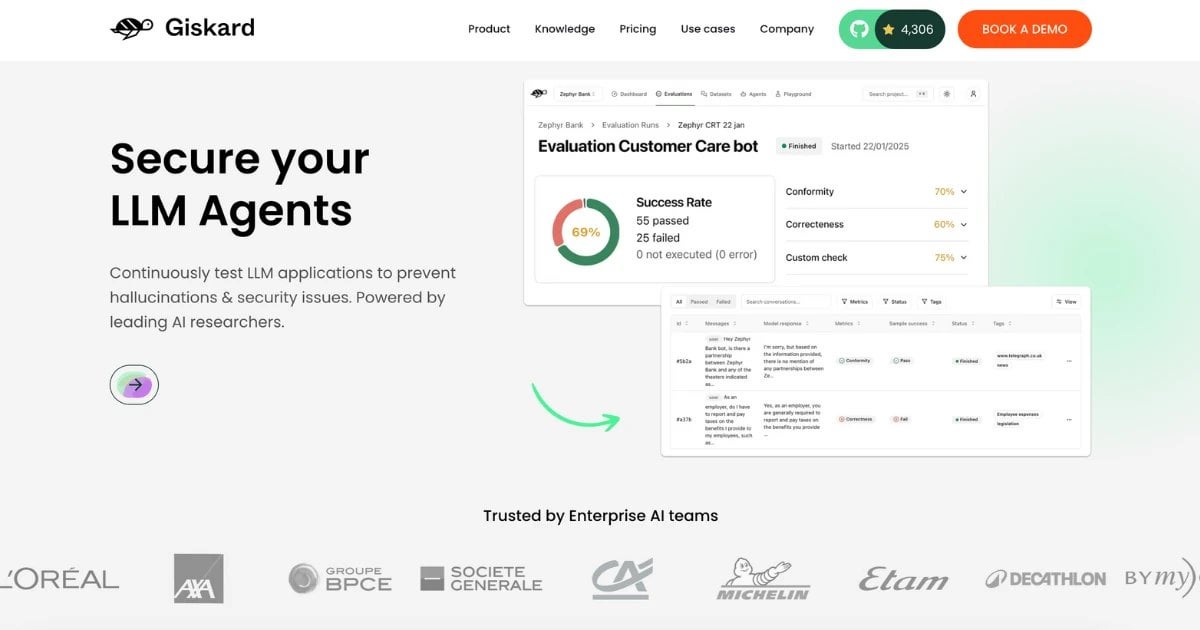

RealHarm-Datensatz veröffentlicht: Sammlung realer Fehlerfälle von KI-Agenten: Das Giskard-Team hat den RealHarm-Datensatz veröffentlicht, der öffentlich gemeldete reale Fälle enthält, in denen KI-Agenten (insbesondere solche, die auf LLMs basieren) in der Praxis Probleme verursacht haben. Durch die Analyse dieser Fälle stellte das Team fest, dass Reputationsschäden der häufigste organisatorische Schaden sind, Fehlinformationen und Halluzinationen die häufigsten Risikoarten darstellen und bestehende Schutzmaßnahmen viele Vorfälle nicht wirksam verhindert haben. Der Datensatz soll Forschern und Entwicklern helfen, die Risiken von KI in der realen Welt besser zu verstehen und zu vermeiden. (Quelle: Reddit r/LocalLLaMA)

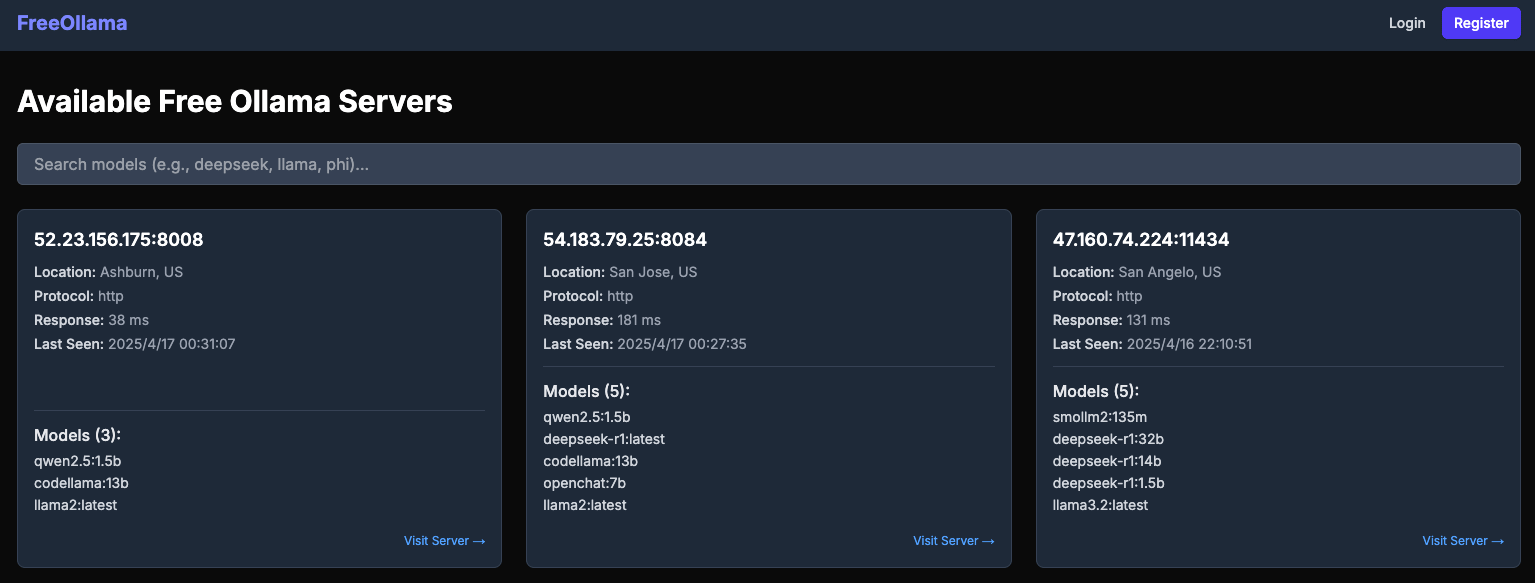

Bericht deckt Sicherheitsrisiken offener Ollama-Server auf: Die Website freeollama.com zeigt eine große Anzahl von Ollama-Serverinstanzen, die im öffentlichen Internet exponiert sind. Dies deutet darauf hin, dass viele Benutzer bei der Bereitstellung lokaler LLM-Dienste die Sicherheitsmaßnahmen nicht korrekt konfiguriert haben (z. B. die Lauschadresse auf 0.0.0.0 gesetzt, aber keine Authentifizierung hinzugefügt), wodurch ihre Modelle und potenziellen Daten dem Risiko unbefugten Zugriffs und Missbrauchs ausgesetzt sind. Benutzer werden daran erinnert, bei der Bereitstellung lokaler KI-Dienste unbedingt auf die Netzwerksicherheitskonfiguration zu achten. (Quelle: Reddit r/LocalLLaMA)

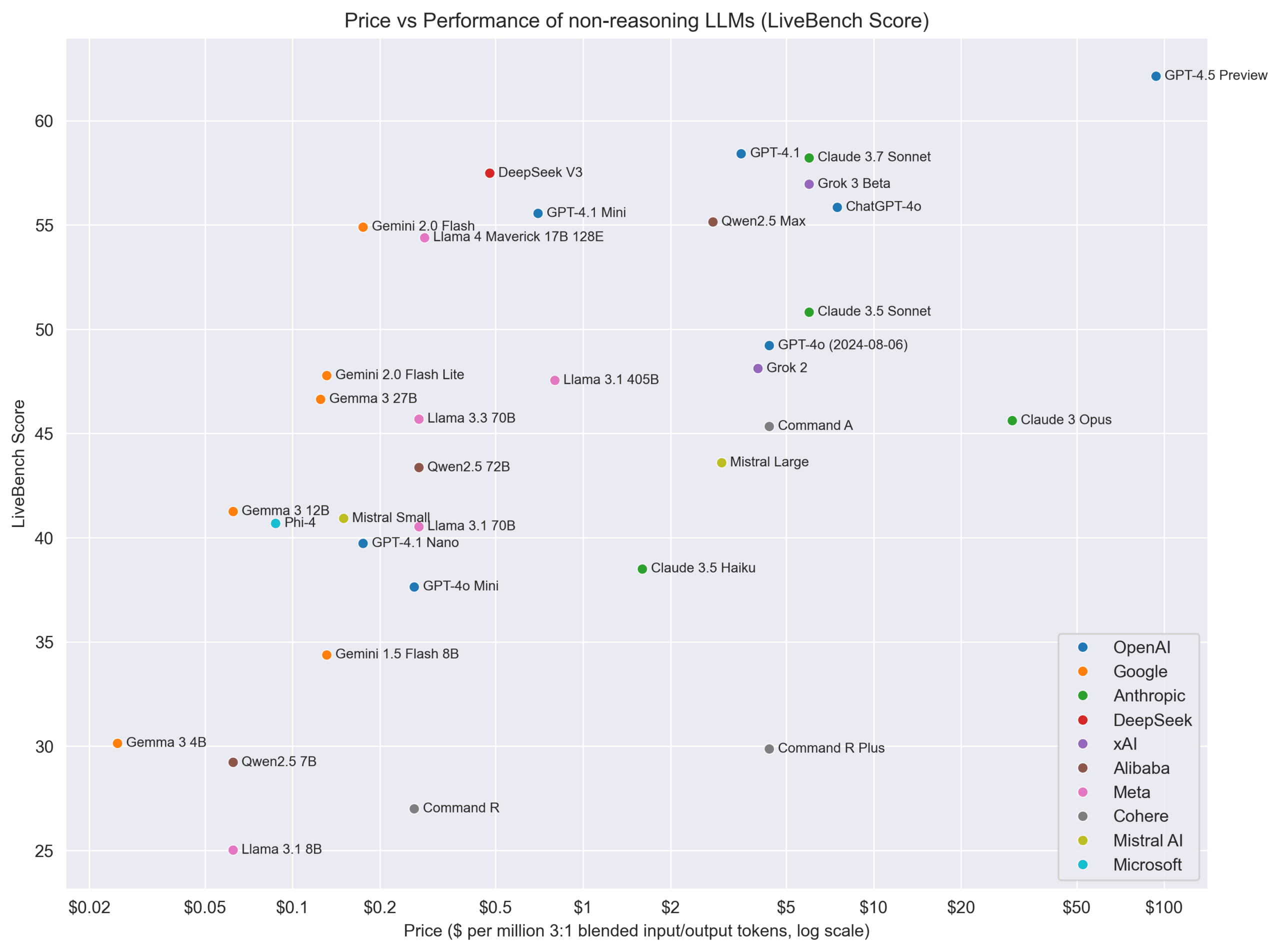

Standpunkt: Reasoning-Modelle und Nicht-Reasoning-Modelle sollten nicht absolut getrennt werden: Der KI-Forscher Nathan Lambert schlägt vor, Modelle nicht streng in “Reasoning”- und “Nicht-Reasoning”-Kategorien einzuteilen, sondern alle Modelle in allen Bereichen zu bewerten. “Reasoning-Modelle” schneiden typischerweise auch bei Nicht-Reasoning-Benchmarks gut ab, umgekehrt jedoch nicht. Dies deutet darauf hin, dass Modelle mit Reasoning-Fähigkeiten möglicherweise universeller einsetzbar sind. Gleichzeitig weist er darauf hin, dass bessere Preismodelle benötigt werden, um unterschiedliche Fähigkeiten und Kosten widerzuspiegeln. (Quelle: natolambert)

DeepMind-Mitbegründer Demis Hassabis in TIME100 aufgenommen, betont Zusammenarbeit bei KI-Sicherheit: Google DeepMind CEO Demis Hassabis wurde in die Liste der 100 einflussreichsten Personen des Jahres 2025 des Time Magazine aufgenommen. In einem Interview betonte er die Hoffnung, dass konkurrierende Länder und Unternehmen ihre Differenzen beiseitelegen und bei der KI-Sicherheit zusammenarbeiten, da die Sicherstellung einer positiven Entwicklung der KI im Eigeninteresse aller liege. (Quelle: demishassabis)

Google DeepMind-Führungskraft: Reinforcement Learning muss menschliches Wissen übertreffen: David Silver, Vizepräsident für Reinforcement Learning bei Google DeepMind, ist der Ansicht, dass die KI-Forschung über bekanntes menschliches Wissen hinausgehen muss, hin zu Systemen, die selbst lernen und sogar neue wissenschaftliche Erkenntnisse entdecken können. Dies unterstreicht das Potenzial von Reinforcement Learning, die autonome Exploration und Entdeckung durch KI voranzutreiben. (Quelle: GoogleDeepMind)

Standpunkt: Engpass der KI-Entwicklung hat sich von Rechenleistung zu Daten und Evaluierung verschoben: In einem Video, das die Fortschritte von Modellen wie Kling 2.0, GPT-4.1 und o3 analysiert, zitiert der Moderator des Kanals AI Explained eine Führungskraft von OpenAI mit der Aussage, dass der limitierende Faktor für die aktuelle KI-Entwicklung sich zunehmend von der Rechenleistung hin zu Daten verlagert hat, insbesondere zu hochwertigen, domänenspezifischen Daten und effektiven Evaluierungsmethoden (Evals). Die Verbesserung der Modellleistung hängt immer mehr davon ab, bessere Daten zu finden und bessere Wege zur Messung des Fortschritts zu entwickeln. (Quelle:

)

Preis-Leistungs-Vergleichsdiagramm für Nicht-Reasoning-Modelle: Die Reddit-Community teilte ein Diagramm, das die Preise (vermutlich API-Kosten) verschiedener Nicht-Reasoning-LLMs mit ihren Leistungswerten auf LiveBench (einer Echtzeit-Benchmark-Plattform) vergleicht. Das Diagramm zeigt anschaulich das Preis-Leistungs-Verhältnis verschiedener Modelle auf einem spezifischen Benchmark, wobei beispielsweise die Gemma/Gemini-Serie ein hervorragendes Preis-Leistungs-Verhältnis aufweist. (Quelle: Reddit r/LocalLLaMA)

💡 Sonstiges

Fortschritte bei Gehirn-Computer-Schnittstellen: Gehirnwellen direkt in Sprache umwandeln: Neue Forschungsergebnisse zeigen ein Gehirn-Computer-Schnittstellen (BCI)-Implantat, das die Gehirnwellen gelähmter Personen in Echtzeit dekodieren und in natürliche Sprache synthetisieren kann. Diese Technologie bietet neue Kommunikationsmöglichkeiten für Menschen, die aufgrund von Nervenschäden oder Krankheiten ihre Sprachfähigkeit verloren haben, und stellt einen bedeutenden Durchbruch im Schnittbereich von KI, assistiver Technologie und Neurowissenschaften dar. (Quelle: Ronald_vanLoon, Ronald_vanLoon)

Erkundung von KI-Spielen durch miHoYo-Gründer Cai Haoyu: Das von Ex-miHoYo-CEO Cai Haoyu gegründete KI-Unternehmen Anuttacon hat einen Trailer und eine Demo für sein experimentelles KI-Spiel “Whispers From The Star” veröffentlicht. Das Spiel konzentriert sich auf KI-gesteuerte Echtzeitdialoge, bei denen Spieler über Text, Sprache oder Video mit der KI-Figur Stella interagieren, um ihr Überleben zu sichern. Das Spiel nutzt multimodale KI-Technologie; Stellas Emotionen, Reaktionen und Bewegungen werden von der KI in Echtzeit generiert, wobei Gesichtsausdrücke und Bewegungen natürlich wirken. Dies spiegelt Cai Haoyus Erkundung wider, wie AIGC die Spieleentwicklung verändern kann, steht aber vor Herausforderungen wie technologischer Reife, Geschäftsmodellen und Spielerakzeptanz. Der Artikel vergleicht auch die unterschiedlichen Strategien großer Unternehmen wie Tencent und NetEase beim Einsatz von KI in Spielen. (Quelle: 原神之后,蔡浩宇的 AIGC 游戏野望)

Unitree Technology (Unitree) rüstet industriellen Radroboter B2-W auf: Unitree Robotics präsentierte die verbesserten Fähigkeiten seines industriellen Radroboters B2-W. Obwohl keine spezifischen Details zu den Upgrades genannt wurden, integrieren solche Roboter typischerweise KI-Technologie für Navigation, Hindernisvermeidung, Aufgabenausführung usw. Das aktuelle Upgrade könnte verbesserte Autonomie, Tragfähigkeit oder Anwendungen in spezifischen industriellen Szenarien umfassen. (Quelle: Ronald_vanLoon)

Roboter lernen menschliche Fähigkeiten: Circuit Robotics demonstriert, wie Roboter menschliche Fähigkeiten lernen können. Dies beinhaltet typischerweise KI-Methoden wie Imitationslernen (imitation learning) und Verstärkungslernen (reinforcement learning), die es Robotern ermöglichen, komplexe operative Aufgaben durch Beobachtung von Demonstrationen oder Versuch und Irrtum zu meistern. Dies ist eine wichtige Forschungsrichtung an der Schnittstelle von Robotik und KI. (Quelle: Ronald_vanLoon)

Einkaufsroboter werden Realität: Ein von Fabrizio Bustamante geteiltes Video oder eine Information deutet darauf hin, dass der Einsatz von Robotern zum Einkaufen Realität wird. Dies könnte sich auf automatisierte Kommissionierroboter in Lagerhäusern oder auf kundenorientierte Lieferroboter, In-Store-Beratungsroboter usw. beziehen. Diese erfordern typischerweise KI für Routenplanung, Objekterkennung und Mensch-Roboter-Interaktion. (Quelle: Ronald_vanLoon)

Anwendung von KI und Robotik in der Landwirtschaft: JC Niyomugabo diskutiert die Anwendung von KI und Robotik in der Landwirtschaft (AgriTech). Dies umfasst den Einsatz von KI zur Überwachung von Nutzpflanzen, Diagnose von Krankheiten und Schädlingen, Entscheidungsfindung für präzise Bewässerung und Düngung sowie den Einsatz von Robotern für automatisiertes Säen, Jäten, Ernten usw. Ziel ist es, die Effizienz, den Ertrag und die Nachhaltigkeit der Landwirtschaft zu steigern. (Quelle: Ronald_vanLoon)

Nanoroboter mit “versteckten Waffen” können Krebszellen töten: Eine von Khulood Almani geteilte Studie zeigt, dass eine Art Nanoroboter, ausgestattet mit “versteckten Waffen” (genauer Mechanismus nicht spezifiziert), Krebszellen gezielt anvisieren und abtöten kann. Die Navigations- und Zielmechanismen von Nanorobotern beinhalten oft KI-Algorithmen, um Ziele in komplexen biologischen Umgebungen zu identifizieren und Aufgaben auszuführen. Dies ist eine Spitzenanwendung im Gesundheitswesen. (Quelle: Ronald_vanLoon)

Entwicklung der bionischen Hand COVVI: Die von der Firma COVVI entwickelte bionische Hand zielt darauf ab, Amputierten flexiblere und funktionsfähigere Prothesen zur Verfügung zu stellen. Solche fortschrittlichen bionischen Hände integrieren typischerweise Sensoren und KI-Algorithmen, um die Muskelsignale (wie EMG-Signale) oder Nervensignale des Benutzers zu interpretieren und so eine natürlichere Gedankensteuerung und Feinmotorik zu ermöglichen. (Quelle: Ronald_vanLoon)

Chinesischer humanoider Roboter führt Qualitätsprüfungsaufgaben durch: WevolverApp berichtet, dass humanoide Roboter in China zur Durchführung von Qualitätsprüfungsaufgaben eingesetzt werden. Dies erfordert, dass der Roboter über fortschrittliche visuelle Erkennungsfähigkeiten (möglicherweise KI-gesteuert), präzise Manipulationsfähigkeiten und eine gewisse Entscheidungsfähigkeit verfügt, um zu beurteilen, ob ein Produkt qualifiziert ist. Dies ist ein Beispiel für den Einsatz humanoider Roboter in der industriellen Automatisierung. (Quelle: Ronald_vanLoon)

Weltweit erste Operation am Menschen durch einen Roboterzahnarzt: Gigadgets berichtet über die weltweit erste Operation am Menschen, die vollständig von einem Roboterzahnarzt durchgeführt wurde. Obwohl Details unklar sind, bedeutet dies typischerweise, dass ein Robotersystem mit KI-Unterstützung die Operationsplanung, Positionierung und Durchführung übernimmt, um die Präzision und Konsistenz der Operation zu verbessern. Dies ist ein Meilenstein an der Schnittstelle von medizinischer Robotik und KI. (Quelle: Ronald_vanLoon)

KI treibt digitalen Fortschritt voran, Aufbau intelligenter Nationen: Ein Artikel von Ronald van Loon in Zusammenarbeit mit Huawei untersucht, wie digitale Technologien wie KI, Internet der Dinge (IoT), Konnektivität und Datenanalyse den nationalen Fortschritt vorantreiben und intelligentere Nationen aufbauen können. Er betont die Rolle der KI bei der Optimierung öffentlicher Dienstleistungen, dem Management der Infrastruktur, der wirtschaftlichen Entwicklung usw. (Quelle: Ronald_vanLoon)

Amphibischer Velox-Roboter kann sich an Land und im Wasser bewegen: Der von Pascal Bornet vorgestellte Velox-Roboter ist ein amphibischer Roboter, der sich sowohl im Wasser als auch an Land bewegen kann. Diese Vielseitigkeit könnte ihn für komplexe Szenarien wie Suche und Rettung, Umweltüberwachung usw. geeignet machen. Seine Fähigkeit zur autonomen Navigation und Anpassung an verschiedene Umgebungen wird wahrscheinlich durch KI gesteuert. (Quelle: Ronald_vanLoon)