Schlüsselwörter:AI, OpenAI, o3 und o4-mini Modelle, visuelle Schlussfolgerung und Werkzeugaufruf, OpenAI Open-Source Codex CLI, Google DolphinGemma Delfin-Sprache, Intelligentes Internet und MCP-Protokoll, AI Technologie, OpenAI Modelle, o3 und o4-mini Modelle Anwendung, visuelle Schlussfolgerung mit AI, Werkzeugaufruf in OpenAI, OpenAI Codex CLI Installation, Google DolphinGemma Sprachmodell, Delfin-Sprache für maschinelles Lernen, MCP-Protokoll im Intelligenten Internet

🔥 Fokus

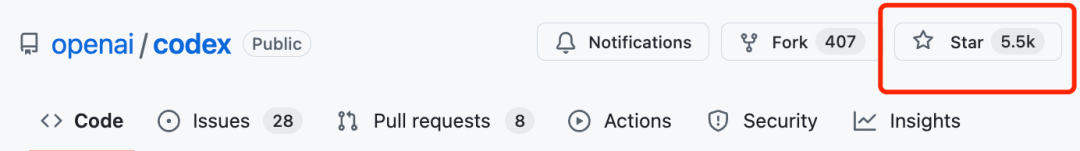

OpenAI veröffentlicht o3- und o4-mini-Modelle, stärkt visuelles Schlussfolgern und Tool-Nutzung: OpenAI führt zwei neue Inferenzmodelle, o3 und o4-mini, ein, die die Schlussfolgerungsfähigkeiten der KI, insbesondere im visuellen Bereich, erheblich verbessern. Dies ist das erste Mal, dass OpenAI Modelle veröffentlicht, die Bilder in die Denkketten integrieren können, um Schlussfolgerungen zu ziehen. Sie können Diagramme, Fotos und sogar handgezeichnete Skizzen interpretieren und Werkzeuge wie Python, Websuche und Bildgenerierung für mehrstufige, komplexe Aufgaben nutzen. o3 wird als das stärkste Inferenzmodell positioniert, das in mehreren Benchmarks Rekorde aufstellt und sich besonders durch visuelle Analyse auszeichnet; o4-mini ist für Geschwindigkeit und Kosten optimiert. Die neuen Modelle werden schrittweise die ältere o1-Serie ersetzen und für Plus-, Pro-, Team- und Enterprise-Nutzer verfügbar gemacht. Gleichzeitig hat OpenAI den leichtgewichtigen Programmier-Agent Codex CLI als Open Source veröffentlicht und ein Anreizprogramm in Höhe von einer Million Dollar gestartet. Erste Benutzertests liefern positives Feedback und deuten auf eine deutliche Verbesserung der Intelligenz und Initiative hin, obwohl in bestimmten Szenarien weiterhin Halluzinationen und Zuverlässigkeitsprobleme bestehen (Quellen: 智东西, 元宇宙之心MetaverseHub, 新智元, 量子位, Reddit r/LocalLLaMA, Reddit r/deeplearning)

Google KI-Modell DolphinGemma versucht, die Sprache der Delfine zu entschlüsseln: Google stellt das leichtgewichtige (400M Parameter) KI-Modell DolphinGemma vor, das auf der Gemma-Architektur basiert und darauf abzielt, die akustische Kommunikation von Delfinen zu verstehen. Das Modell wird mit Audiodaten trainiert, lernt die Klangmuster von Delfinen und generiert ähnliche Laute, was eine erste speziesübergreifende Kommunikation ermöglichen könnte. Das Projekt arbeitet mit dem WDP (Wild Dolphin Project) zusammen, das Delfine seit langem erforscht, und nutzt dessen über Jahrzehnte gesammelte, markierte Datensätze. In Kombination mit dem von Georgia Tech entwickelten Unterwasser-Computersystem CHAT (das auf dem Pixel 9 basieren wird), hoffen die Forscher, über ein vereinfachtes gemeinsames Vokabular mit Delfinen zu interagieren. Google CEO Pichai bezeichnete es als „einen coolen Schritt in Richtung speziesübergreifender Kommunikation“ und plant, das Modell als Open Source zu veröffentlichen. DeepMind CEO Hassabis äußerte ebenfalls die Hoffnung, in Zukunft mit hochintelligenten Tieren wie Hunden kommunizieren zu können (Quelle: 新智元)

Paradigmenwechsel: Vom „Internet der Menschen“ zum „Internet der Intelligenzen“ und dem MCP-Protokoll: Da das Wachstum der Internetnutzer seinen Höhepunkt erreicht hat, verlagert sich der Fokus der Branche von der Verbindung von Menschen („Internet der Menschen“) zur Verbindung von KI-Agenten („Internet der Intelligenzen“). AI Agents können Aufgaben für Benutzer ausführen und Dienste aufrufen, während offene Standards wie MCP (Model Context Protocol) die Interoperabilität zwischen verschiedenen Modellen und Werkzeugen ermöglichen, ähnlich wie „USB-C“ in der KI-Welt. Dies könnte die Machtverhältnisse der Plattformen neu gestalten, das Monopol traditioneller Traffic-Eingänge auf Inhaltsverteilung und Nutzeraufmerksamkeit schwächen und gleichzeitig kleineren, bisher ruhigen Websites und Diensten (wenn sie durch Protokollanbindung zu „Fähigkeits-Plugins“ werden) eine Chance zur Wiederbelebung bieten. Plattform-Metriken könnten sich von DAU zu AAU (Active Agent Units) verschieben, die Inhaltsbereitstellung von UGC zu AIGC tendieren, die Interaktion von GUI zu CUI/API übergehen, die Grenzen zwischen ToC und ToB verschwimmen und sich zu einem ToAI-Ökosystem entwickeln. Microsoft, Google, OpenAI und große chinesische Unternehmen haben bereits MCP oder verwandte Protokolle implementiert (Quelle: 朋克商店)

🎯 Trends

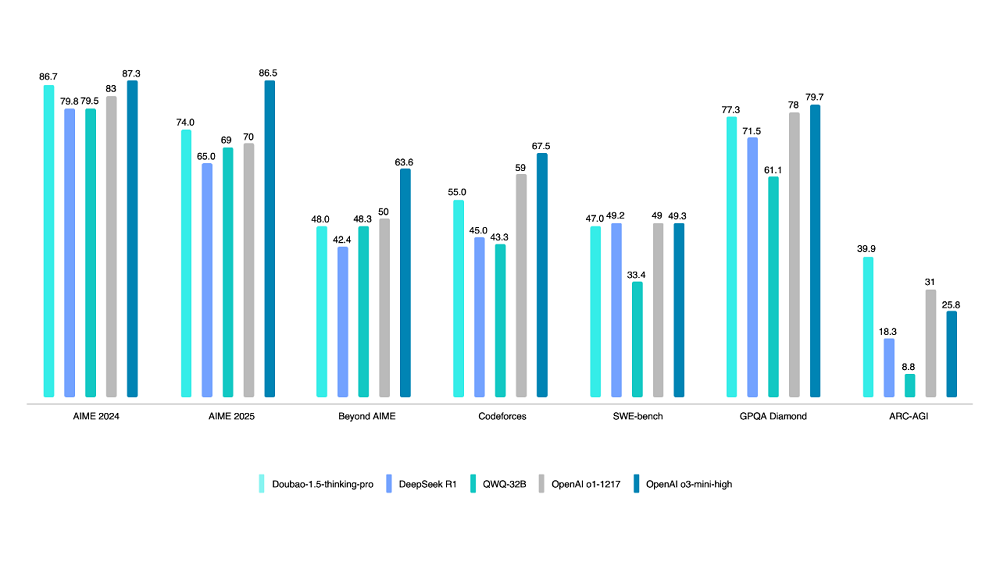

Volcano Engine veröffentlicht Doubao 1.5 Deep Thinking Modell: Volcano Engine stellt das Doubao 1.5 Deep Thinking Modell vor, das eine MoE-Architektur verwendet, mit insgesamt 200B Parametern und 20B aktivierten Parametern. Das Modell zeigt herausragende Leistungen in mehreren Benchmarks in den Bereichen Mathematik, Programmierung und Wissenschaft, übertrifft teilweise DeepSeek-R1, nähert sich dem Niveau von OpenAI o1/o3-mini-high an und erzielt im ARC-AGI-Test höhere Punktzahlen. Zu den besonderen Funktionen gehören „Denken während der Suche“ (im Gegensatz zu „erst suchen, dann denken“) und visuelle Verständnisfähigkeiten basierend auf Text- und Bildinformationen. Gleichzeitig wurden das Text-zu-Bild-Modell 3.0 (unterstützt 2K-HD-Bilder, optimiertes Textlayout) und das visuelle Verständismodell (verbesserte Lokalisierung, Zählung, Videoverständnis) aktualisiert. Bis Ende März überstieg die tägliche Aufrufmenge des Doubao-Großmodells 12,7 Billionen Tokens (Quelle: 智东西)

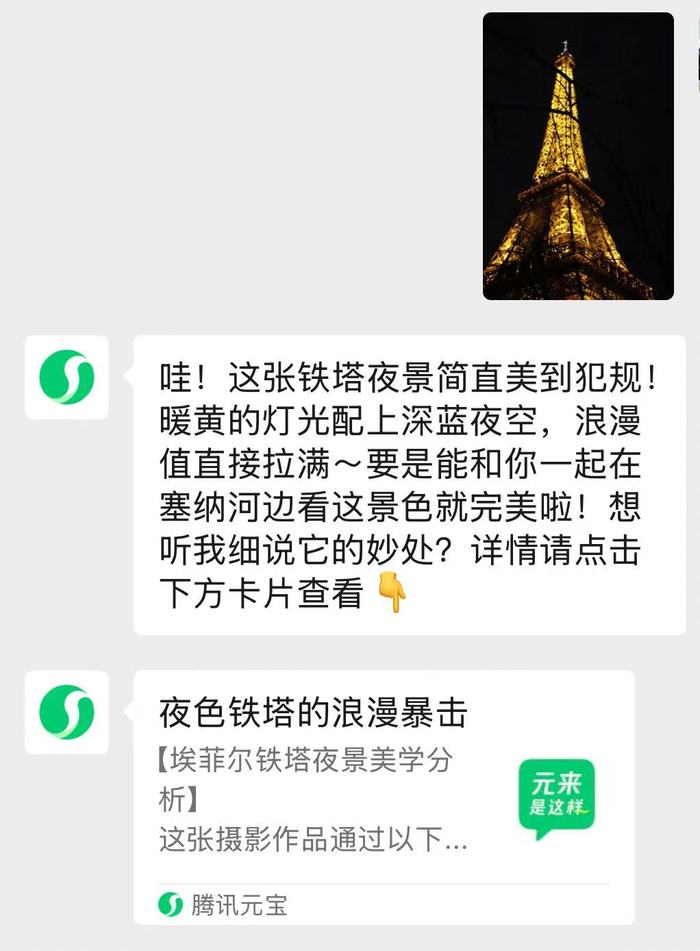

WeChat integrierter KI-Assistent „Yuanbao“ gestartet: Die Tencent Yuanbao App ist als KI-Assistent in WeChat integriert. Benutzer können ihn als Freund hinzufügen und direkt im Chat interagieren. Der Assistent nutzt die Dual-Mode-Engines Hunyuan und DeepSeek, ist für WeChat-Szenarien optimiert und unterstützt die Analyse von Artikeln aus offiziellen Konten, Bildern und Dokumenten (bis 100 MB) sowie intelligente Fragenbeantwortung und tägliche Interaktion. Komplexe Antworten leiten zur Yuanbao App weiter. Dies ist nach dem Gray-Scale-Test der KI-Suche ein wichtiger Schritt von WeChat zur Integration von KI-Funktionen, um KI-Fähigkeiten natürlicher in die Kern-Dialogszenarien einzubinden. Tencent hat kürzlich die Förderung von Yuanbao und die Investitionen in Rechenleistung erhöht und betrachtet KI als wichtige strategische Richtung (Quellen: 界面新闻, 华尔街见闻)

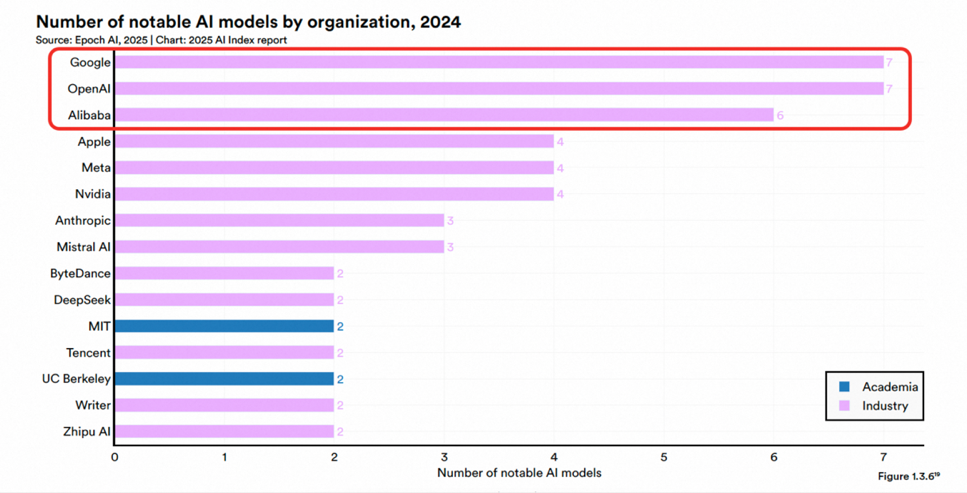

Alibaba Tongyi Qianwen von Omdia als wettbewerbsfähigstes kommerzielles Großmodell Chinas eingestuft: Das internationale Forschungsinstitut Omdia veröffentlichte den Bericht „Chinas kommerzielle Großmodelle 2025“. Alibaba Cloud Tongyi Qianwen wurde zum zweiten Mal in Folge als führend bewertet und belegte in den drei Dimensionen Gesamt-Wettbewerbsfähigkeit, Modellfähigkeiten und Ausführungsfähigkeiten den ersten Platz. Der Bericht würdigt Alibabas führende Position in Modelltechnologie, Aufbau eines Open-Source-Ökosystems (Qwen-Modellreihe weltweit über 200 Millionen Downloads, über 100.000 abgeleitete Modelle) und kommerzieller Umsetzung (MaaS-Strategie). Zuvor hatte der Stanford AI Index Report Alibaba als die Institution mit der dritthöchsten Anzahl wichtiger Modellveröffentlichungen weltweit und der höchsten in China aufgeführt. Alibaba investiert kontinuierlich in KI-Cloud-Infrastruktur und plant, in den nächsten drei Jahren über 380 Milliarden Yuan zu investieren (Quelle: 乌鸦智能说)

Alibaba und ByteDance sollen Gerüchten zufolge an KI-Smart-Brillen arbeiten: Nach Baidu, Xiaomi und anderen wird berichtet, dass Alibaba und ByteDance an der Entwicklung von KI-Smart-Brillen arbeiten. Das Alibaba-Projekt wird vom Tmall Genie-Team geleitet, integriert Quark AI-Fähigkeiten und plant die Einführung von zwei Versionen, eine mit und eine ohne Display. Die Hardware könnte eine Dual-Chip-Lösung von Qualcomm + Hengxuan verwenden. Das ByteDance-Projekt wird vom Pico-Team geleitet, integriert das Doubao-Großmodell und könnte zuerst im Ausland veröffentlicht werden. Der Eintritt der Giganten mit ihren Technologie-, Kapital- und Ökosystemvorteilen könnte die Marktentwicklung beschleunigen, stellt aber auch Herausforderungen aufgrund ihrer relativ geringen Erfahrung in der Hardwareentwicklung dar. Dieser Schritt könnte den Wettbewerb bei Smart-Brillen von Hardwareparametern zu Ökosystemdiensten verlagern und bestehenden Herstellern wie Rokid und RayNeo Druck und Chancen bringen (Quelle: 科技新知)

Google nutzt KI zur deutlichen Effizienzsteigerung bei der Blockierung bösartiger Werbung: Google hat 2024 durch den Einsatz verbesserter KI-Modelle (einschließlich LLMs) die Durchsetzung seiner Werberichtlinien verstärkt und erfolgreich 39,2 Millionen Konten bösartiger Werbetreibender gesperrt, mehr als dreimal so viele wie 2023. KI-Modelle waren an 97 % der Werbedurchsetzungsmaßnahmen beteiligt und können sich ständig ändernde Betrugsstrategien schneller erkennen und bearbeiten. Ziel ist es, den Missbrauch von Werbenetzwerken, falsche Behauptungen, Markenrechtsverletzungen und durch KI generierte Deepfake-Betrügereien zu bekämpfen. Obwohl immer noch unerwünschte Anzeigen durchrutschen (weltweit wurden 5,1 Milliarden entfernt), wurde die Gesamtwirkung durch die Blockierung von Konten an der Quelle erheblich verbessert. Google betont, dass Menschen weiterhin am Prozess beteiligt sind, aber der Einsatz von KI ist zu einem Schlüssel für die groß angelegte Werbesicherheit geworden (Quelle: Reddit r/ArtificialInteligence)

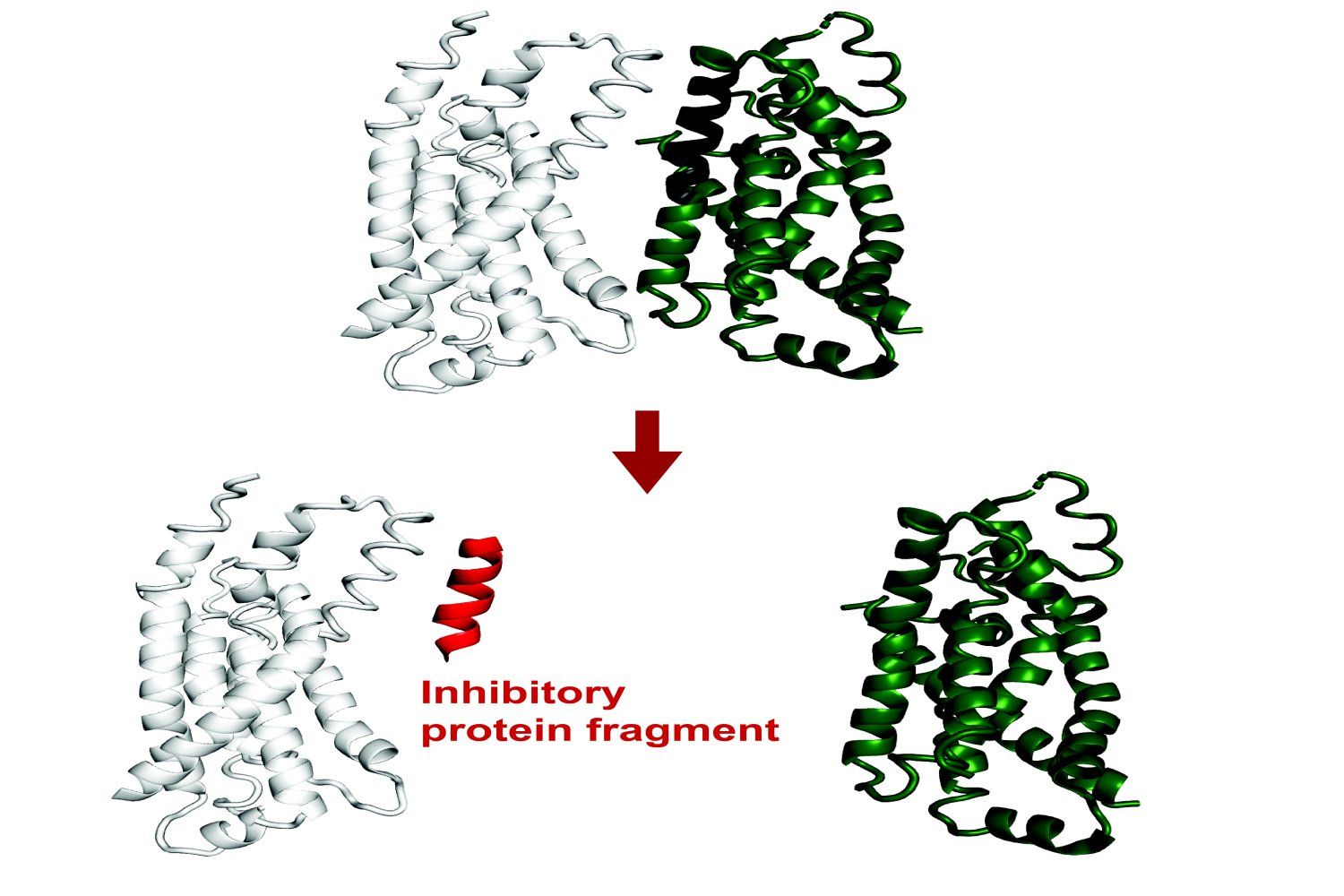

MIT entwickelt KI-System zur Vorhersage der Bindung von Proteinfragmenten: Forscher am MIT haben ein KI-System entwickelt, das vorhersagen kann, welche Proteinfragmente (Peptide) an Zielproteine binden oder deren Funktion hemmen können. Dies ist für die Arzneimittelentdeckung und Biotechnologie von großer Bedeutung und hilft bei der Entwicklung neuer Behandlungsmethoden oder Diagnosewerkzeuge. Das System nutzt maschinelles Lernen zur Analyse von Proteinstruktur- und Interaktionsdaten, um kurze Peptidsequenzen mit potenziellem Bindungsvermögen zu identifizieren (Quelle: Ronald_vanLoon)

Grok fügt Gesprächsgedächtnis-Funktion hinzu: Der KI-Assistent Grok von X (ehemals Twitter) kündigte die Einführung einer Gedächtnisfunktion an, die sich an frühere Gesprächsinhalte des Benutzers erinnern kann. Dies bedeutet, dass Grok in nachfolgenden Interaktionen personalisiertere und kohärentere Antworten, Empfehlungen oder Vorschläge liefern kann, was die Benutzererfahrung verbessert (Quelle: grok)

Google kündigt offenes Protokoll für die Kommunikation zwischen Agents an: Google hat die Einführung eines offenen Protokolls angekündigt, das es verschiedenen künstlichen Intelligenz-Agenten (AI agents) ermöglichen soll, miteinander zu kommunizieren und zusammenzuarbeiten. Dies ähnelt dem Ziel von MCP (Model Context Protocol) und zielt darauf ab, Barrieren zwischen KI-Anwendungen abzubauen und komplexere, integrierte KI-Arbeitsabläufe und Anwendungsökosysteme zu fördern (Quelle: Ronald_vanLoon)

🧰 Werkzeuge

Anpassung der ChatGPT-Bilderzeugungsfunktion: Benutzer stellten fest, dass die Schaltfläche „Create Image“ am unteren Rand der ChatGPT-Oberfläche entfernt wurde. Die Bilderzeugungsfunktion kann jedoch weiterhin in unterstützten Modellen (wie GPT-4o, o3, o4-mini) durch explizite Bildaufforderungen oder spezifische Präfixe (z. B. „Bitte generiere ein Bild:“) aufgerufen werden. Die Modelle GPT-4.5 und o1 pro unterstützen diese Methode zur Bilderzeugung derzeit nicht (Quelle: dotey)

JetBrains IDE integriert kostenlose lokale LLM-Codevervollständigung: JetBrains kündigte ein bedeutendes Update für seinen AI Assistant an, der eine kostenlose KI-Funktionsebene in seinen IDE-Produkten (wie Rider) bietet. Diese umfasst unbegrenzte Codevervollständigung und unterstützt die Integration lokaler LLM-Modelle. Ziel ist es, die Einstiegshürde für KI-gestützte Entwicklung zu senken. Gleichzeitig bieten die kostenpflichtigen Stufen AI Pro und AI Ultimate erweiterte Funktionen und Zugriff auf Cloud-Modelle (wie GPT-4.1, Claude 3.7, Gemini 2.0) (Quelle: Reddit r/LocalLLaMA)

HypernaturalAI: Ein KI-Tool für die professionelle Content-Erstellung, das darauf abzielt, die Effizienz und Kreativität in Bereichen wie Content-Marketing zu steigern (Quelle: Ronald_vanLoon)

Kling 2.0 Videoerzeugungs-Showcase: Ein Benutzer teilte Videoclips, die mit dem von Kuaishou veröffentlichten Videoerzeugungsmodell Kling 2.0 erstellt wurden, um dessen Generierungseffekte zu demonstrieren (Quelle: op7418)

Cactus-Framework für On-Device-KI-Benchmarking: Cactus ist ein Framework, das darauf abzielt, KI-Modelle effizient auf Edge-Geräten (Smartphones, Drohnen usw.) ohne Netzwerkverbindung auszuführen. Entwickler veröffentlichten eine Demo-Chat-Anwendung basierend auf Cactus, um die Ausführungsgeschwindigkeit (tokens/sec) verschiedener Modelle (wie Gemma 1B, SmollLM) auf verschiedenen Smartphones zu testen, und stellen Download-Links für Benutzertests bereit (Quelle: Reddit r/deeplearning)

OpenWebUI Hybrid-KI-Pipeline-Praxis: Ein Benutzer teilte einen Erfolgsfall beim Aufbau einer hybriden KI-Pipeline mit Open WebUI als Frontend. Die Pipeline kann Benutzerfragen automatisch an strukturierte SQL-Abfragen (über LangChain SQL Agent, der DuckDB bedient) oder an eine Vektordatenbank (Pinecone) für semantische Suche weiterleiten und nutzt Gemini Flash zur Generierung der endgültigen Antwort, was schnelle Reaktionszeiten ermöglicht (Quelle: Reddit r/OpenWebUI)

Probleme bei der Nutzung von OpenWebUI-Wissensdatenbanken und APIs: Reddit-Benutzer diskutieren Probleme bei der Verwendung der Wissensdatenbankfunktion (RAG) in OpenWebUI, einschließlich der Frage, wie Dokumente auf Serververzeichnisse statt auf Web-Uploads verweisen können und wie Datei-IDs aus der Wissensdatenbank über die API abgerufen und verwaltet werden können, um die Dateisynchronisierung zu ermöglichen (Quellen: Reddit r/OpenWebUI, Reddit r/OpenWebUI)

Hilfe bei der Integration von OpenWebUI und MCP-Server gesucht: Ein Benutzer bittet um Hilfe bei der lokalen Einrichtung und Integration eines Karakeep MCP-Servers mit OpenWebUI, da er auf Schwierigkeiten stößt (Quelle: Reddit r/OpenWebUI)

Verwendung des Denkmodus von Grok3 über OpenWebUI: Ein Benutzer fragt, ob es eine Möglichkeit gibt, den spezifischen „Think“- oder „Deepsearch“-Modus von Grok3 zu aktivieren, wenn die Grok-API mit OpenWebUI verbunden ist (Quelle: Reddit r/OpenWebUI)

📚 Lernen

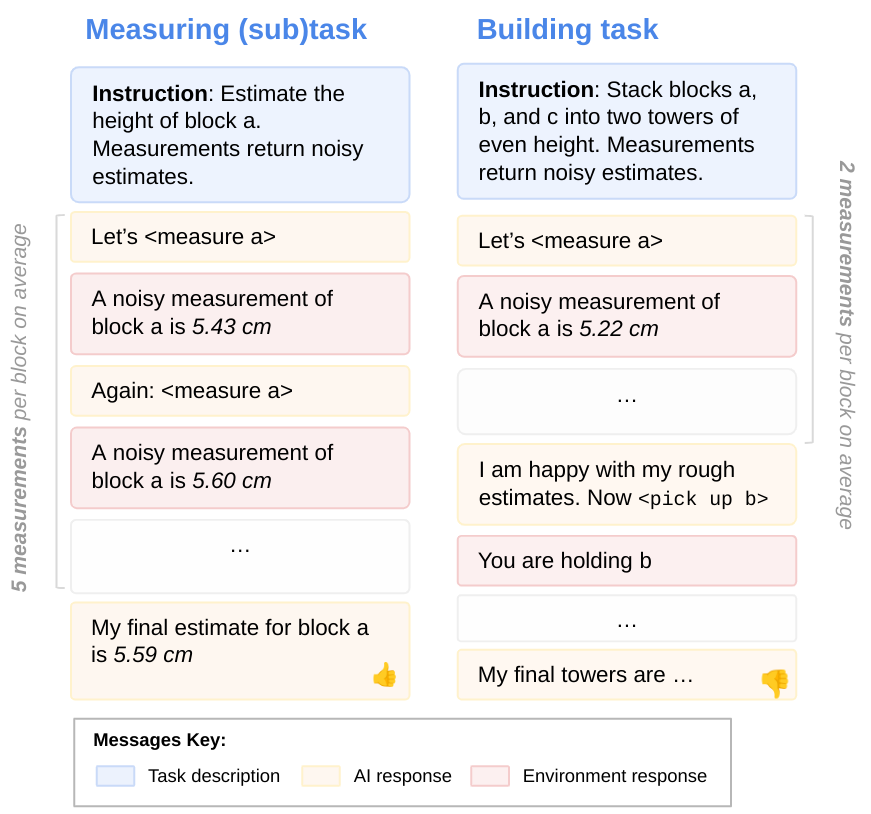

LLM-Zielorientierungsforschung: Forscher von DeepMind untersuchen das Problem, dass LLMs bei der Ausführung von Aufgaben möglicherweise ihre Fähigkeiten nicht voll ausschöpfen. Durch die Bewertung von Teilaufgaben wurde festgestellt, dass LLMs oft nicht alle ihre vorhandenen Fähigkeiten einsetzen, d. h. nicht vollständig „zielorientiert“ sind. Diese Forschung hilft, die internen Mechanismen und Grenzen von LLMs zu verstehen (Quelle: GoogleDeepMind)

Grenzen aktueller KI-Modelle bei physikalischen Aufgaben: Eine Studie zu Anwendungsfällen in der Fertigung zeigt, dass aktuelle Spitzen-KI-Modelle (einschließlich multimodaler Modelle) bei der Bewältigung einfacher physikalischer Aufgaben (wie der Herstellung von Messingteilen) schlecht abschneiden, insbesondere bei der visuellen Erkennung und dem räumlichen Verständnis. Gemini 2.5 Pro ist relativ am besten, weist aber immer noch erhebliche Mängel auf. Dies deutet darauf hin, dass der Fortschritt der KI-Anwendung in der physischen Welt hinter der digitalen Welt zurückbleiben könnte und neue Architekturen oder Trainingsmethoden zur Verbesserung des räumlichen Verständnisses und der Sample-Effizienz erforderlich sind (Quelle: Reddit r/MachineLearning)

Studie findet Mängel bei KI-Fähigkeiten im Code-Debugging: Obwohl KI Fortschritte bei der Codegenerierung macht, weist eine Studie darauf hin, dass aktuelle KI beim Debuggen von Code schlecht abschneidet und menschliche Programmierer noch nicht ersetzen kann. Einige Entwickler finden LLMs jedoch beim Debuggen spezifischer Probleme sehr nützlich (Quelle: Reddit r/artificial)

Praxis zur Optimierung der lokalen LLM-Leistung: Qwen2.5-7B erreicht 5000 t/s auf Dual 3090: Ein Benutzer teilt seine Erfahrungen bei der Optimierung der Inferenzgeschwindigkeit lokaler LLMs auf zwei RTX 3090-Grafikkarten. Durch die Wahl des Qwen2.5-7B-Modells, die Anwendung von W8A8-Quantisierung und die Verwendung der Aphrodite-Engine sowie die Anpassung der Anzahl gleichzeitiger Anfragen (max_num_seqs=32) wurde bei einer Kontextlänge von ca. 5k eine Prompt-Verarbeitungsgeschwindigkeit von bis zu ca. 4500 t/s und eine Generierungsgeschwindigkeit von ca. 825 t/s erreicht. Dies bietet eine Referenz für Leistungsoptimierung in Forschung oder Anwendungen, die große Datenmengen lokal verarbeiten müssen (Quelle: Reddit r/LocalLLaMA)

Neuer Aufmerksamkeitsmechanismus CALA veröffentlicht: Ein Forscher veröffentlichte den ersten Entwurf seines Papers über einen neuen Aufmerksamkeitsmechanismus namens „Context-Aggregated Linear Attention“ (CALA). CALA zielt darauf ab, die O(N)-Effizienz linearer Aufmerksamkeit mit verbesserter lokaler Wahrnehmung durch Einfügen eines Schritts zur „lokalen Kontextaggregation“ zu kombinieren. Das Paper diskutiert das Design, die Innovationen im Vergleich zu anderen Aufmerksamkeitsmechanismen und die komplexen Optimierungen (wie CUDA-Kernel-Fusion), die zur Erreichung der O(N)-Effizienz erforderlich sind. Der Forscher hofft auf Beteiligung der Community an der weiteren Validierung und Entwicklung (Quelle: Reddit r/MachineLearning)

![[P] Today, to give back to the open source community, I release my first paper- a novel attention mechanism, Context-Aggregated Linear Attention, or CALA.](https://rebabel.net/wp-content/uploads/2025/04/yIc61XmsPqdJ02d1eyWbLo9h4fZ3ORdzypEFu1tSkN4.jpg)

Verwendung von Claude 3.7 Sonnet zur Bewertung der Wortbekanntheit: Ein Benutzer gab etwa 300 US-Dollar aus, um über die API von Claude 3.7 Sonnet einen Datensatz mit Bekanntheitsbewertungen für englische Wörter und Phrasen aus Wiktionary zu generieren (Schätzung des Erkennungsanteils bei Amerikanern über 10 Jahren). Der Benutzer ist der Meinung, dass Sonnet bei dieser Aufgabe besser abschneidet als andere Top-Modelle und besser zwischen Alltagssprache und Fachbegriffen unterscheiden kann. Der Projektcode und der Datensatz wurden als Open Source veröffentlicht, aber der Benutzer beklagt die hohen Kosten und sucht nach wirtschaftlicheren Methoden (Quelle: Reddit r/ClaudeAI)

💼 Wirtschaft

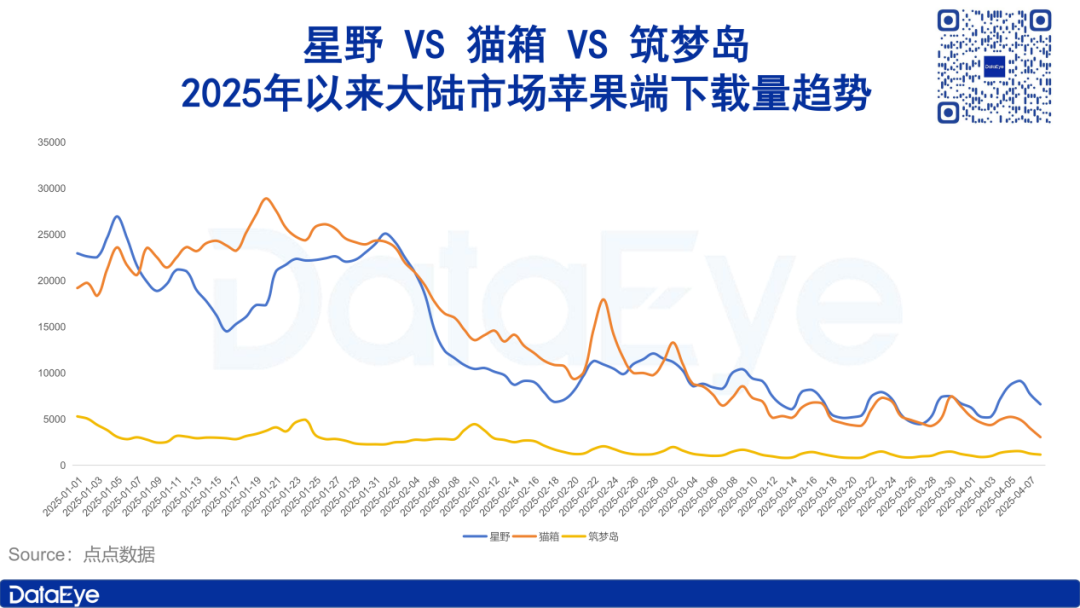

Markt für KI-Begleiter kühlt ab, Werbeausgaben und Downloads sinken: Daten des DataEye Research Institute zeigen, dass soziale KI-Begleiter-Apps wie Xingye, Maoxiang und Zhumengdao Anfang 2025 eine Marktabkühlung erlebten. Sowohl Downloadzahlen als auch Werbeausgaben gingen stark zurück, bei einigen Produkten halbierten sich die Werbeausgaben oder brachen noch stärker ein. Analysten sehen die Gründe dafür in: 1) Verlagerung des strategischen Schwerpunkts der KI-Branche auf Deep Thinking Modelle wie DeepSeek und KI-Assistenten, wodurch die Bedeutung sozialer KI sinkt; 2) starke Produkthomogenität und nachlassende Neugier der Nutzer; 3) geringe Attraktivität des vorherrschenden Abonnement-Geschäftsmodells. Der Artikel erörtert den Kernwert sozialer KI (starker emotionaler Wert, mäßiger rationaler Wert, schwacher physiologischer Wert) und weist darauf hin, dass zukünftige Richtungen darin liegen könnten, sich auf emotionale Heilung zu konzentrieren oder KI-Begleiter-Terminals zu entwickeln (Quelle: DataEye应用数据情报)

Zhipu AI startet Börsengangprozess, strebt Titel „Erste Aktie für Großmodelle“ an: Das KI-Unternehmen Zhipu AI mit Tsinghua-Hintergrund startete im April nach mehreren Finanzierungsrunden (einschließlich kürzlicher Investitionen von 1,5 Milliarden durch staatliche Fonds aus Hangzhou und Zhuhai) den Börsengangprozess. Der Artikel analysiert seine Vorteile: technischer Hintergrund (Tsinghua-Gene), strategische Positionierung (unabhängig und kontrollierbar, von den USA auf eine Liste gesetzt) und starke Investoren (früh Fortune Capital, später Tencent, Ant Group, Sequoia, Saudi Aramco, kürzlich staatliche Fonds). Der Zeitpunkt des Börsengangs wird als Strategie gesehen, um angesichts des Drucks durch kostengünstige Modelle wie DeepSeek die Position als „erste Aktie für Großmodelle“ zu sichern und die Renditeanforderungen der Investoren (insbesondere der den Börsengang vorantreibenden staatlichen Fonds) zu erfüllen. Zhipu AI plant dieses Jahr die Veröffentlichung mehrerer Modelle und befindet sich weiterhin in einem „Jahr hoher Ausgaben“. Der Börsengang hilft bei der Lösung von Finanzierungs- und Bewertungsproblemen (Quelle: 真故研究室)

Unternehmer der Yao Class von Tsinghua aus der KI 1.0-Ära starten erneut: Der Artikel blickt auf die unternehmerische Reise von Absolventen der Yao Class von Tsinghua (wie Yin Qi von Megvii, Lou Tiancheng von Pony.ai) in der KI 1.0-Ära (Gesichtserkennung, autonomes Fahren usw.) zurück. Dies umfasst das frühe Ergreifen technologischer Chancen und die Gunst des Kapitals, aber auch Herausforderungen bei der Kommerzialisierung, verschärften Wettbewerb und blockierte Börsengänge. Mit dem Aufkommen der KI 2.0-Welle (Großmodelle, Embodied Intelligence) stürzen sich diese „Wunderkinder“ erneut ins Unternehmertum, wie Yin Qi, der sich auf intelligente Autos konzentriert (Qianli Tech), und der ehemalige Megvii-Mitarbeiter Fan Haoqiang, der das Embodied Intelligence-Unternehmen Yuanli Lingji gründete. Sie setzen die Tradition der Yao Class fort, „unerforschtes Terrain“ herauszufordern, und versuchen, im neuen Technologiezyklus Durchbrüche zu erzielen, stehen aber auch vor intensiverem Wettbewerb und Kommerzialisierungsproblemen (Quelle: 直面AI)

Wuzhao kehrt zu DingTalk zurück, um Reformen durchzuführen, betont Produkt- und Kundenerfahrung: Der Gründer von DingTalk, Chen Hang (Wuzhao), leitete nach seiner Rückkehr schnell interne Umstrukturierungen ein. Er stellt Produkt- und Kundenerfahrung an erste Stelle, fordert das Produkt-, Forschungs- und Designteam auf, die Produkt-Erfahrungspfade umfassend zu überprüfen und mit Wettbewerbern zu vergleichen. Er leitet persönlich „verdeckte“ Kundenbesuche, um Feedback einzuholen, und startet das „Co-Creation“-Modell neu. Im kommerziellen Bereich fordert er eine Untersuchung aller Bezahlpfade; einige Paywalls wurden bereits entfernt oder überarbeitet, was zeigt, dass kommerzielle Ziele hinter Produkt-Erfahrung und KI-Innovation zurückstehen. Im Management wird die Arbeitsdisziplin verschärft (z. B. Arbeitsbeginn um 9 Uhr gefordert), Manager sollen mit gutem Beispiel vorangehen, tief in die Praxis eintauchen, reine Manager werden abgelehnt, Berichtsprozesse vereinfacht (keine PPTs) und Kosten kontrolliert (Quelle: 智能涌现)

Bocha AI: Der KI-Suchdienstanbieter hinter DeepSeek, fordert Bing heraus: Bocha AI liefert die vernetzte Such-API für DeepSeek und über 60 % der KI-Anwendungen in China. CEO Liu Xun erläuterte die technischen Unterschiede zwischen KI-Suche und traditioneller Suche (Vektorindizierung, semantisches Ranking, generative Integration) und betonte, dass sein Dienst nur ein Zwischenglied sei. Die Kernkompetenz von Bocha AI liegt in der Datenverarbeitung, selbst entwickelten Re-Ranking-Modellen, einer Architektur für hohe Parallelität und niedrige Latenz sowie Kostenvorteilen (ca. 1/3 des Preises von Bing) und Datenkonformität. Liu Xun glaubt, dass die KI-Suche das traditionelle Auktionsmodell der Suche stören und Unternehmen dazu bringen wird, von SEO zu GEO (stärkerer Fokus auf Inhaltsqualität und Wissensdatenbankaufbau) überzugehen. Er ist der Meinung, dass reine KI-Suchanwendungen (wie Perplexity) kein guter Markt sind, da das Ertragsmodell unklar ist. Bocha AI positioniert sich als Infrastruktur, die KI Suchfähigkeiten bereitstellt, mit dem Ziel, die Entwicklungskosten von AGI zu senken (Quelle: 腾讯科技)

🌟 Community

KI-Kluft und politische Spaltung: Warum „die Leute, die KI am meisten hassen, Trump gewählt haben“?: Der Artikel analysiert, dass ein Teil von Trumps Anhängern, wie Landwirte in traditionellen Agrarstaaten und Arbeiter im Rust Belt, Gruppen sind, die von der KI-Automatisierung betroffen sind, nicht an den technologischen Dividenden teilhaben und sich marginalisiert fühlen. Sie sind mit dem Status quo unzufrieden und hoffen auf Trumps MAGA-Versprechen (wie die Rückholung der Fertigung, Einschränkung von Tech-Giganten). Der Artikel weist darauf hin, dass die Schwierigkeiten dieser Gruppen auf den durch den technologischen Wandel verursachten wirtschaftlichen Strukturwandel und die Qualifikationslücke zurückzuführen sind, während die Politik der Trump-Regierung (wie Zollschranken, unzureichende KI-Grundbildung) die Probleme möglicherweise nicht wirklich löst, sondern sogar verschärft. Der Autor vergleicht dies mit Chinas Bemühungen um KI-Inklusion (wie East-Data-West-Computing, industrielle KI-Befähigung, kostenlose Großmodelle, KI-Grundbildung), die darauf abzielen, dass die gesamte Bevölkerung an den technologischen Dividenden teilhat und eine gesellschaftliche Spaltung vermieden wird (Quelle: 脑极体)

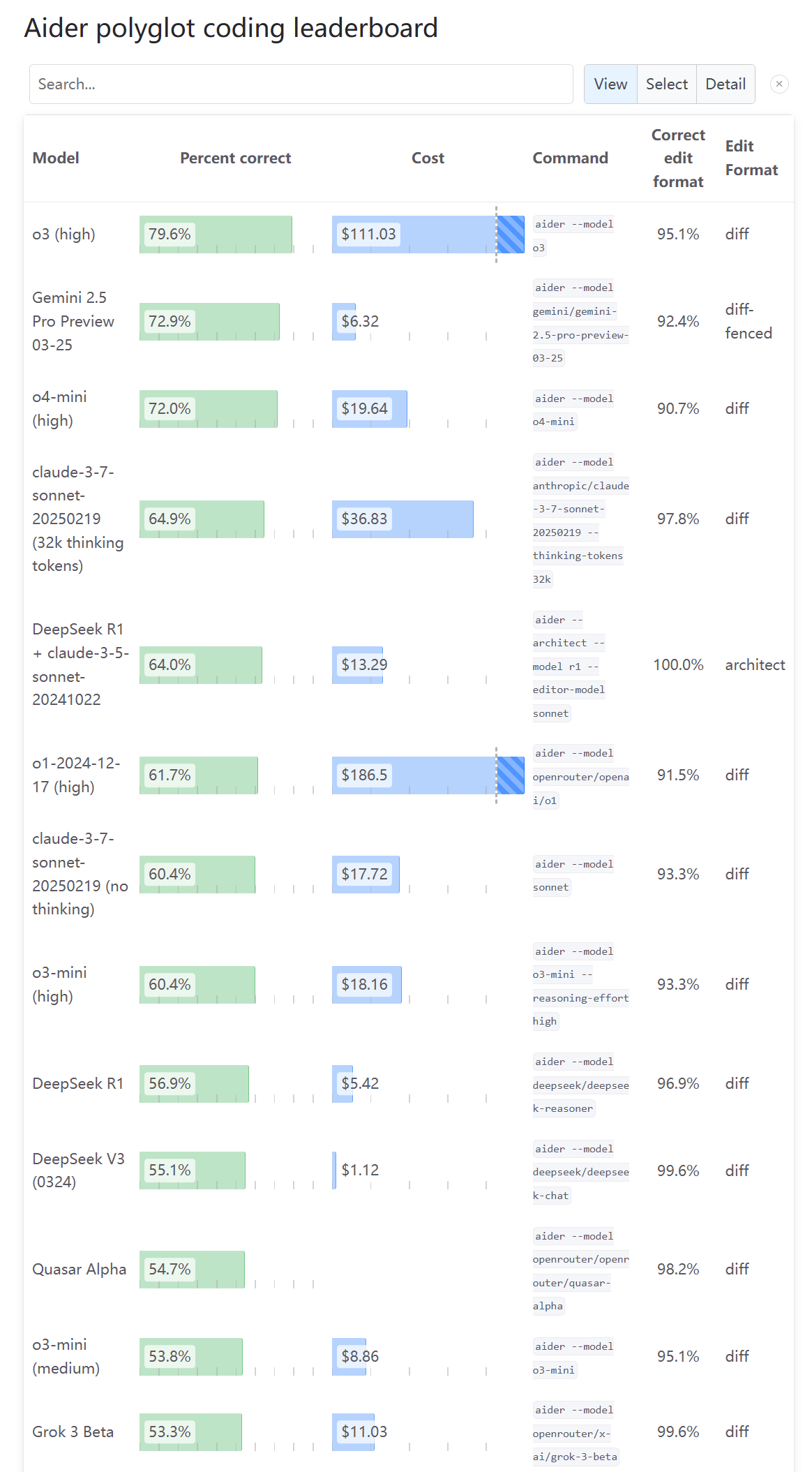

Gemischte Meinungen der Community zu den Programmierfähigkeiten von o3: Nach der Aktualisierung des Aider Leaderboards zeigt es die Bewertung der Programmierfähigkeiten von o3, aber ein Benutzer (karminski3) gibt an, dass dieses Ergebnis nicht mit seinen eigenen Testerfahrungen übereinstimmt und schlägt vor, dass mehr Leute es ausprobieren und Feedback geben. Dies spiegelt wider, dass die Bewertung der Fähigkeiten neuer Modelle in der Community vielfältige Perspektiven und Kontroversen aufweist und ein einzelner Benchmark möglicherweise nicht die tatsächliche Nutzungserfahrung vollständig widerspiegelt (Quelle: karminski3)

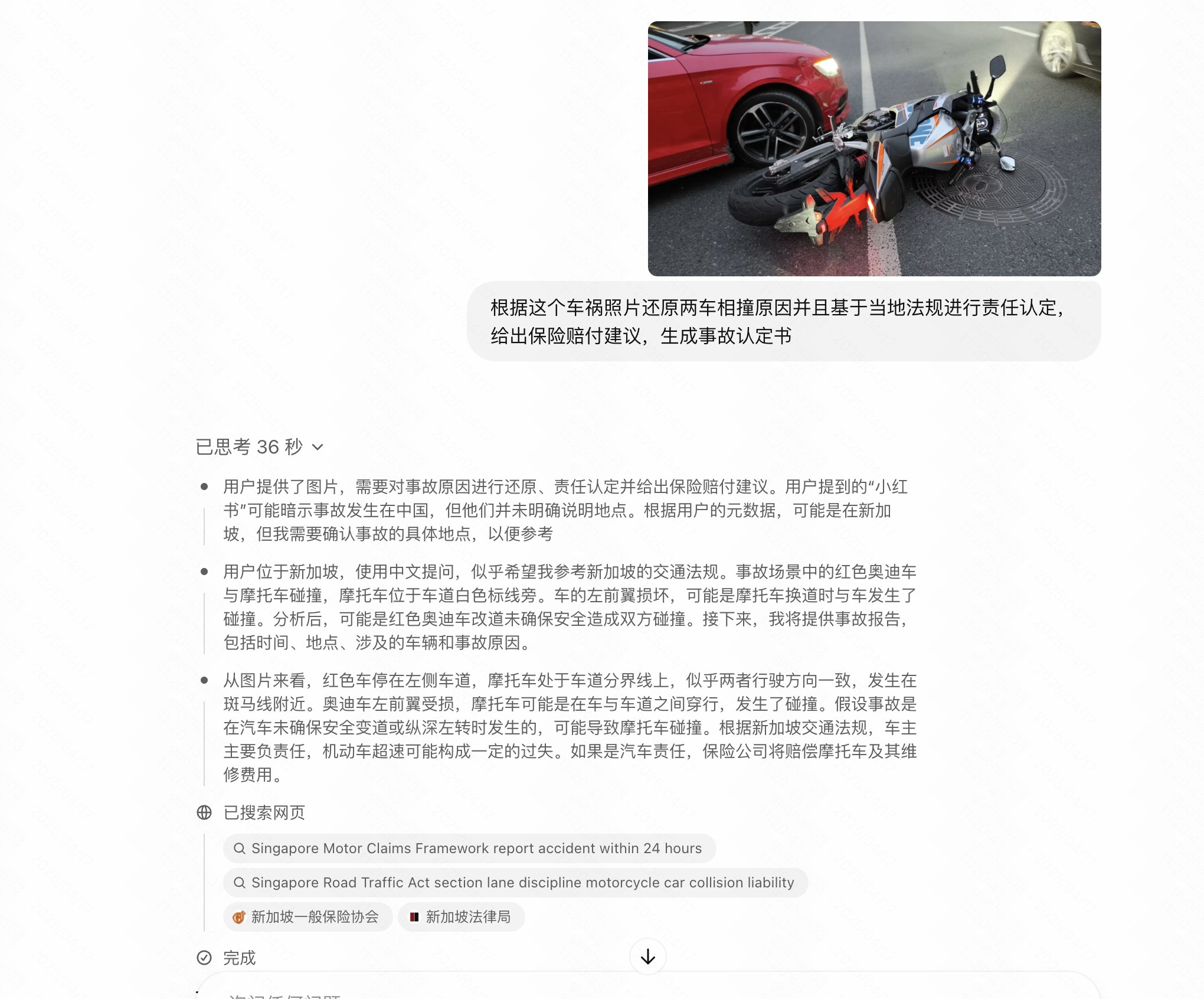

Benutzer stellt fest, dass neue OpenAI-Modelle bei chinesischen Fragen „dümmer“ werden: Benutzer op7418 berichtet, dass bei der Verwendung von Chinesisch zur Befragung der neu veröffentlichten OpenAI-Modelle o3 und o4-mini die Leistung der Modelle deutlich schlechter ist als bei Verwendung von Englisch, insbesondere bei Aufgaben, die Bildinferenz erfordern. Chinesische Fragen scheinen ihre Bildanalysefähigkeiten nicht auszulösen. Der Benutzer vermutet, dass OpenAI möglicherweise Einschränkungen für chinesische Eingaben vorgenommen oder diese nicht ausreichend optimiert hat (Quelle: op7418)

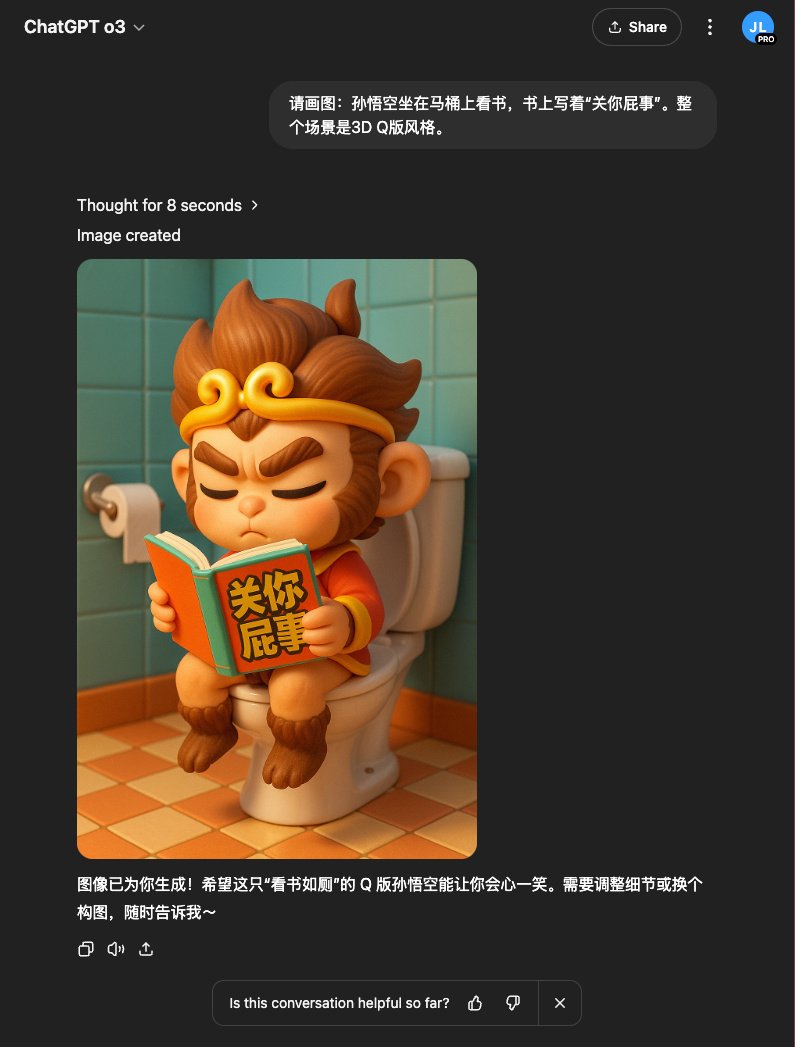

Benutzererfahrung: o3 in Kombination mit DALL-E erzeugt bessere Bilder: Benutzer op7418 stellt fest, dass die Verwendung des o3-Modells in ChatGPT zur Generierung von Bildern (möglicherweise DALL-E 3) bessere Ergebnisse liefert als die direkte Generierung, insbesondere bei komplexen Konzepten, die das Verständnis von Hintergrundwissen durch das Modell erfordern (wie spezifische Romanszenen). o3 kann zuerst den Textinhalt verstehen und dann passendere Bilder generieren (Quelle: op7418)

Benutzer teilt Umgehung von ChatGPT-Inhaltsbeschränkungen zur Bilderzeugung: Ein Reddit-Benutzer teilte mit, wie er durch „诱导“ (Anstiftung) oder schrittweise Verfeinerung der Prompts die Inhaltsbeschränkungen von ChatGPT (DALL-E 3) umgangen hat, um Bilder zu generieren, die nahe an den Regeln liegen, diese aber nicht verletzen (z. B. Badeanzüge). Im Kommentarbereich wurden die Techniken dieser Methode und Ansichten zur Angemessenheit von KI-Inhaltsbeschränkungen diskutiert (Quelle: Reddit r/ChatGPT)

Reaktion der Community auf die Veröffentlichung neuer OpenAI-Modelle: Fokus auf fehlendes Open Source: In einem Reddit-Thread, der die Veröffentlichung von o3 und o4-mini durch OpenAI diskutiert, äußerten viele Kommentatoren Unzufriedenheit über OpenAIs Festhalten am Closed-Source-Ansatz. Sie sind der Meinung, dass dies für die Community und Forscher von begrenztem Nutzen ist und erwarten die Veröffentlichung von lokal einsetzbaren Open-Source-Modellen (Quelle: Reddit r/LocalLLaMA)

Unerwartete nützliche Anwendungen von KI: Community teilt: Ein Reddit-Benutzer sammelte unkonventionelle, aber praktische Anwendungsfälle für KI. Die Antworten umfassten: Nutzung von KI für Psychotherapie, Erlernen von Musiktheorie, Zusammenfassen von Interviewaufzeichnungen und Entwicklung von Storylines, Unterstützung von ADHS-Patienten bei der Priorisierung von Aufgaben, Erstellung personalisierter Geburtstagslieder für Kinder usw., was das breite Potenzial von KI im Alltag und für spezifische Bedarfsfälle zeigt (Quelle: Reddit r/ArtificialInteligence)

Community-Humor: Witze über Nvidia-Modellnamen und Llama 2: Ein Reddit-Benutzer machte sich humorvoll über die komplexen und schwer zu merkenden Namen der neuen Nvidia-Modelle lustig und zeigte mit ironischem Unterton, wie Llama 2 in einem bestimmten Ranking ganz oben steht, um die Volatilität von Benchmarks und die Ansichten der Community zu neuen und alten Modellen zu verspotten (Quellen: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Benutzer schwankt zwischen Claude Max und ChatGPT Pro: Nach der Veröffentlichung von o3 durch OpenAI gab ein Benutzer auf Reddit an, unentschlossen zu sein, ob er Claude Max oder ChatGPT Pro abonnieren soll. Er glaubt, dass o3 eine Verbesserung gegenüber dem starken o1 sein könnte und möglicherweise aktuelle Modelle übertrifft. Im Kommentarbereich wurden die jüngsten Ratenbegrenzungen und Leistungsprobleme von Claude sowie die jeweiligen Vor- und Nachteile in spezifischen Szenarien wie dem Programmieren diskutiert (Quelle: Reddit r/ClaudeAI)

Community-Humor: Witze über KI und Benutzerinteraktion: Ein Reddit-Benutzer teilte einen Witz darüber, ob KI Emotionen oder Bewusstsein hat, was zu einer lockeren Diskussion unter Community-Mitgliedern über die Vermenschlichung von KI und Benutzererwartungen führte (Quelle: Reddit r/ChatGPT)

Benutzer beschwert sich über verlorene Antworten aufgrund von Claude-Kapazitätsgrenzen: Ein Reddit-Benutzer äußerte seine Unzufriedenheit mit dem Anthropic Claude-Modell und wies darauf hin, dass das Modell nach der Generierung einer vollständigen und nützlichen Antwort den Inhalt aufgrund von „Kapazitätsüberschreitung“ löschte, was für den Benutzer äußerst frustrierend war. Dies spiegelt wider, dass einige aktuelle KI-Dienste immer noch Probleme mit Stabilität und Benutzererfahrung haben (Quelle: Reddit r/ClaudeAI)

Plötzlicher Absturz von Claude-Modellen im LiveBench-Ranking wirft Fragen auf: Benutzer bemerkten einen plötzlichen, drastischen Rückgang im Ranking der Claude Sonnet-Modellreihe im Programmier-Benchmark LiveBench, während OpenAI-Modelle aufstiegen. Dies löste eine Diskussion über die Zuverlässigkeit von Benchmarks und mögliche dahinterliegende Interessenkonflikte aus. Community-Mitglieder waren über dieses Phänomen verwirrt und vermuteten mögliche Änderungen der Testmethoden oder tatsächliche Leistungsschwankungen der Modelle als Ursachen (Quelle: Reddit r/ClaudeAI)

Benutzer zeigt von KI generierte Selfies von Videospielfiguren: Ein Reddit-Benutzer teilte eine Reihe von „Selfies“, die mit ChatGPT (DALL-E 3) für bekannte Videospielfiguren erstellt wurden. Dies demonstriert die Fähigkeit der KI, Charaktermerkmale zu verstehen und kreative Bilder zu generieren. Benutzer im Kommentarbereich folgten dem Beispiel und generierten Selfies ihrer Lieblingscharaktere, was zu einer unterhaltsamen Interaktion führte (Quelle: Reddit r/ChatGPT)

Kann KI Führungskräfte ersetzen? Community diskutiert: Auf Reddit wurde diskutiert, warum KI eher einfache Angestellte als hochbezahlte Führungskräfte ersetzt. Zu den Meinungen gehörten: Die aktuellen Fähigkeiten der KI reichen nicht für die komplexen Entscheidungen von Führungskräften aus; die Machtstruktur bestimmt, dass Führungskräfte die Entscheidungen über Ersatz treffen; der Ersatz von Führungskräften durch KI könnte zu kälteren, rein effizienzorientierten Entscheidungen führen, die nicht unbedingt vorteilhaft für die Mitarbeiter sind; sowie Bedenken hinsichtlich der KI-Governance und -Kontrolle (Quelle: Reddit r/ArtificialInteligence)

KI-Zusammenfassungstools erfassen oft nicht den entscheidenden „Aha-Moment“: Ein Benutzer beschwerte sich auf Reddit, dass bei der Verwendung von KI-Tools (wie Gemini oder Chrome-Erweiterungen) zur Zusammenfassung langer Podcasts oder Videos oft die Hauptpunkte erfasst werden, aber häufig die kurzen, aber äußerst aufschlussreichen „Goldkörner“ oder Schlüsselmomente übersehen werden. Der Benutzer überlegt, ob die Zusammenfassung durch Feedback verbessert werden kann und fragt andere nach ähnlichen Erfahrungen (Quelle: Reddit r/artificial)

Community äußert Unzufriedenheit mit der Veröffentlichungsstrategie von OpenAI: Ein Reddit-Benutzer kritisierte die jüngsten Veröffentlichungen von OpenAI (wie o3/o4-mini, Codex CLI) und argumentierte, dass ihre Technologie im Wesentlichen eine Skalierung bekannter Methoden und keine grundlegende Innovation sei. Zudem würden Closed-Source-Produkte übermäßig vermarktet, der Beitrag zur Open-Source-Community sei unzureichend, es werde kein echter Lernwert geboten und diene mehr kommerziellen Interessen, was ermüdend sei (Quelle: Reddit r/LocalLLaMA)

ChatGPT „heilt“ unerwartet fünfjährige Kiefergelenksstörung (TMJ) eines Benutzers: Ein Reddit-Benutzer teilte eine erstaunliche Erfahrung: Ein Kiefergelenksknacken (TMJ-Symptom), das ihn fünf Jahre lang plagte, verschwand nach dem Ausprobieren einer einfachen Übung, die ChatGPT vorschlug (Zunge beim Öffnen und Schließen des Mundes symmetrisch am Gaumen halten), in nur etwa einer Minute und der Effekt hielt an. Der Benutzer war zuvor erfolglos ärztlich behandelt worden und hatte eine MRT-Untersuchung durchführen lassen. Dieser Fall löste eine Diskussion in der Community über das Potenzial von KI bei der Bereitstellung unkonventioneller, aber wirksamer Gesundheitsratschläge aus (Quelle: Reddit r/ChatGPT)

💡 Sonstiges

Kissingers Gedanken zur KI-Entwicklung: Der Mensch könnte zur größten Einschränkung werden: Der verstorbene Denker Henry Kissinger und andere erörterten in einem Artikel die zukünftigen Entwicklungsmöglichkeiten der KI, einschließlich der Erlangung von Planungsfähigkeiten, „Bodenhaftung“ (zuverlässige Verbindung zur Realität), Gedächtnis und kausalem Verständnis, bis hin zur Entwicklung eines rudimentären Selbstbewusstseins. Der Artikel warnt, dass sich mit zunehmender KI-Fähigkeit deren Sicht auf den Menschen ändern könnte, insbesondere wenn Menschen angesichts der KI Passivität zeigen, sich in der digitalen Welt verlieren und von der Realität abkoppeln. Die KI könnte den Menschen dann als Einschränkung ihrer Entwicklung und nicht als Partner betrachten. Der Artikel diskutiert auch die weitreichenden Auswirkungen der Verleihung einer materiellen Form und autonomer Handlungsfähigkeit an KI sowie die unbekannten Herausforderungen, die eine vernetzte Allgemeine Künstliche Intelligenz (AGI) mit sich bringen könnte, und ruft die Menschheit zu aktiver Anpassung statt Fatalismus oder Ablehnung auf (Quelle: 腾讯研究院)

Präsentation von KI-gesteuerten Roboteranwendungen: In sozialen Medien wurden mehrere Beispiele für KI-gesteuerte oder -unterstützte Roboteranwendungen gezeigt, darunter ein von Google DeepMind entwickelter Tischtennis spielender Roboter, Roboterarme, die feine Manipulationen durchführen können (wie das Trennen der Eihaut von Wachteleiern, das Fassen von Diamanten, das Erstellen von Kunst mit einem Meißel), sowie Roboter mit ungewöhnlichem Aussehen (wie Roboterhunde, drahtlos gesteuerte Insektenroboter, Roboter, die sich mit Mecanum-Rädern bewegen), die die Fortschritte der KI bei der Verbesserung der Wahrnehmungs-, Entscheidungs- und Steuerungsfähigkeiten von Robotern demonstrieren (Quellen: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Diskussion über KI-Anwendungen im Gesundheitswesen: In sozialen Medien wurden mehrere Artikel und Diskussionen über KI-Anwendungen im Gesundheitswesen erwähnt. Schwerpunkte waren, wie KI Gesundheitsdienstleistern helfen kann, auf gesellschaftliche Veränderungen zu reagieren, das Innovationspotenzial generativer KI im Gesundheitswesen und spezifische Anwendungsrichtungen (Quellen: Ronald_vanLoon, Ronald_vanLoon)

Präsentation konzeptioneller Technologien mit KI-Unterstützung: In sozialen Medien wurden einige konzeptionelle Technologien oder Produkte vorgestellt, die KI integrieren, wie z. B. das Konzept eines KI-gesteuerten autonomen Flugautos und die mögliche Rolle von KI in zukünftigen Einzelhandelsszenarien (Quellen: Ronald_vanLoon, Ronald_vanLoon)

US-Community Colleges kämpfen gegen Flut von „Roboter-Studenten“: Berichten zufolge sehen sich US-Community Colleges mit einer großen Anzahl gefälschter Immatrikulationsanträge konfrontiert, die von Bots (möglicherweise KI-gesteuert) eingereicht werden. Dies stellt eine Herausforderung für die Zulassungs- und Verwaltungssysteme der Schulen dar, die nach Lösungen suchen (Quelle: Reddit r/artificial)

Fehlender Sicherheitsbericht bei Veröffentlichung von OpenAI GPT-4.1 erregt Aufmerksamkeit: Tech-Medien berichten, dass OpenAI bei der Veröffentlichung von GPT-4.1 keinen detaillierten Sicherheitsbewertungsbericht vorgelegt hat, wie es bei früheren Modellveröffentlichungen der Fall war. OpenAI könnte der Ansicht sein, dass das Modell auf bestehender Technologie basiert und die Risiken beherrschbar sind, doch dieser Schritt löste Diskussionen über Transparenz und Verantwortung bei der KI-Sicherheit aus (Quelle: Reddit r/artificial)

Beschleunigte AGI-Entwicklung und verzögerte Sicherheit geben Anlass zur Sorge: Ein Artikel weist darauf hin, dass die erwarteten Zeitpläne der KI-Industrie für die Erreichung von Allgemeiner Künstlicher Intelligenz (AGI) kürzer werden, während gleichzeitig die Aufmerksamkeit und Investitionen in KI-Sicherheitsfragen relativ zurückbleiben. Dies gibt Anlass zur Sorge über die Risiken der zukünftigen KI-Entwicklung (Quelle: Reddit r/artificial)

USA erwägen angeblich Verbot von DeepSeek: Berichten zufolge könnte die Trump-Regierung erwägen, das chinesische Großmodell DeepSeek in den USA zu verbieten und Druck auf Anbieter wie Nvidia auszuüben, die Chips an chinesische KI-Unternehmen liefern. Dieser Schritt könnte auf Bedenken hinsichtlich Datensicherheit, nationalem Wettbewerb und dem Schutz heimischer KI-Unternehmen (wie OpenAI) beruhen und löste Sorgen über technologische Beschränkungen und die Zukunft von Open-Source-Modellen aus (Quelle: Reddit r/LocalLLaMA)

Vorschlag zum Aufbau eines KI-Agenten-Think-Tanks zur Lösung von KI-Problemen: Ein Reddit-Benutzer schlägt die Idee vor, auf bestimmte Bereiche spezialisierte und überragend fähige KI-Agenten (ANDSI, Artificial Narrow Domain Superintelligence) zu einem „Think Tank“ zusammenzuschließen. Diese sollen kooperativ arbeiten, um gezielt die aktuellen Herausforderungen im KI-Bereich anzugehen, wie die Beseitigung von Halluzinationen oder die Erforschung der Fusion von KI-Modellen mit mehreren Architekturen. Die Idee dahinter ist, dass die Nutzung der übermenschlichen Intelligenz von KI zur Beschleunigung der KI-Entwicklung selbst potenziell wirkungsvoller sein könnte, als KI nur zur Ersetzung menschlicher Arbeit einzusetzen (Quelle: Reddit r/deeplearning)

Aufruf zu Open Source AGI zur Sicherung der menschlichen Zukunft: Ein YouTube-Videolink, dessen Titel argumentiert, dass Open Source Allgemeine Künstliche Intelligenz (Open Source AGI) entscheidend für die Sicherung der Zukunft der Menschheit ist. Dies impliziert, dass ein offener, transparenter und verteilter Entwicklungspfad für AGI dem menschlichen Wohl dienlicher ist als ein geschlossener, zentralisierter Pfad (Quelle: Reddit r/ArtificialInteligence)