كلمات مفتاحية:LLM-JEPA, Apple Manzano, MediaTek Dimensity 9500, GPT-5, DeepSeek-V3.1-Terminus, Qwen3-Omni, Baidu Qianfan-VL, إطار عمل تدريب المساحة المضمنة, مقسم بصري مختلط, هندسة NPU مزدوجة, اختبار SWE-BENCH PRO المعياري, إدخال صوتي متعدد الوسائط

🔥 تركيز

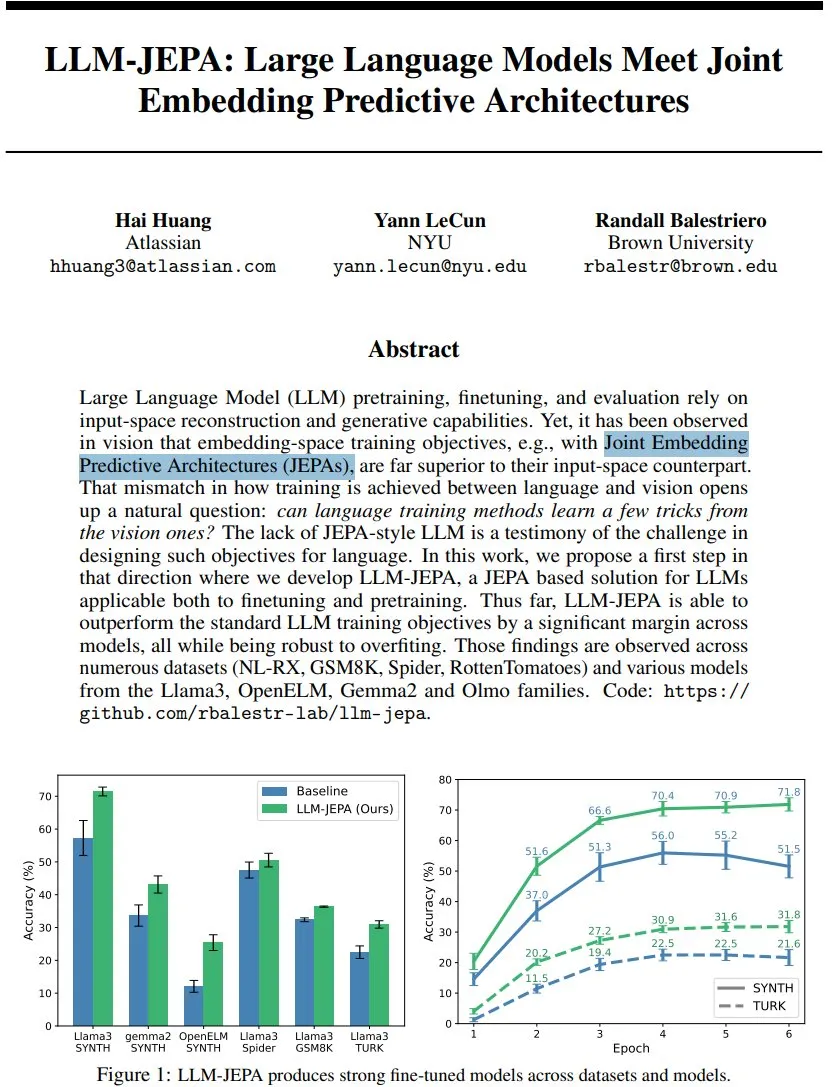

LLM-JEPA: اختراق جديد في إطار تدريب نماذج اللغة : قدم يان لوكون (Yann LeCun) وزملاؤه LLM-JEPA، وهو أول إطار تدريب لنموذج لغوي على غرار JEPA يجمع بين أهداف مساحة التضمين المرئية وأهداف التوليد لمعالجة اللغة الطبيعية. يتفوق هذا الإطار على أهداف LLM القياسية في العديد من الاختبارات المعيارية مثل NL-RX وGSM8K وSpider، ويظهر أداءً جيدًا مع نماذج مثل Llama3 وOpenELM، وهو أكثر قوة ضد الانحياز الزائد (overfitting)، وفعال في التدريب المسبق والضبط الدقيق، مما يشير إلى أن التدريب في مساحة التضمين قد يكون القفزة الكبيرة التالية لـ LLM. (المصدر: ylecun, ylecun)

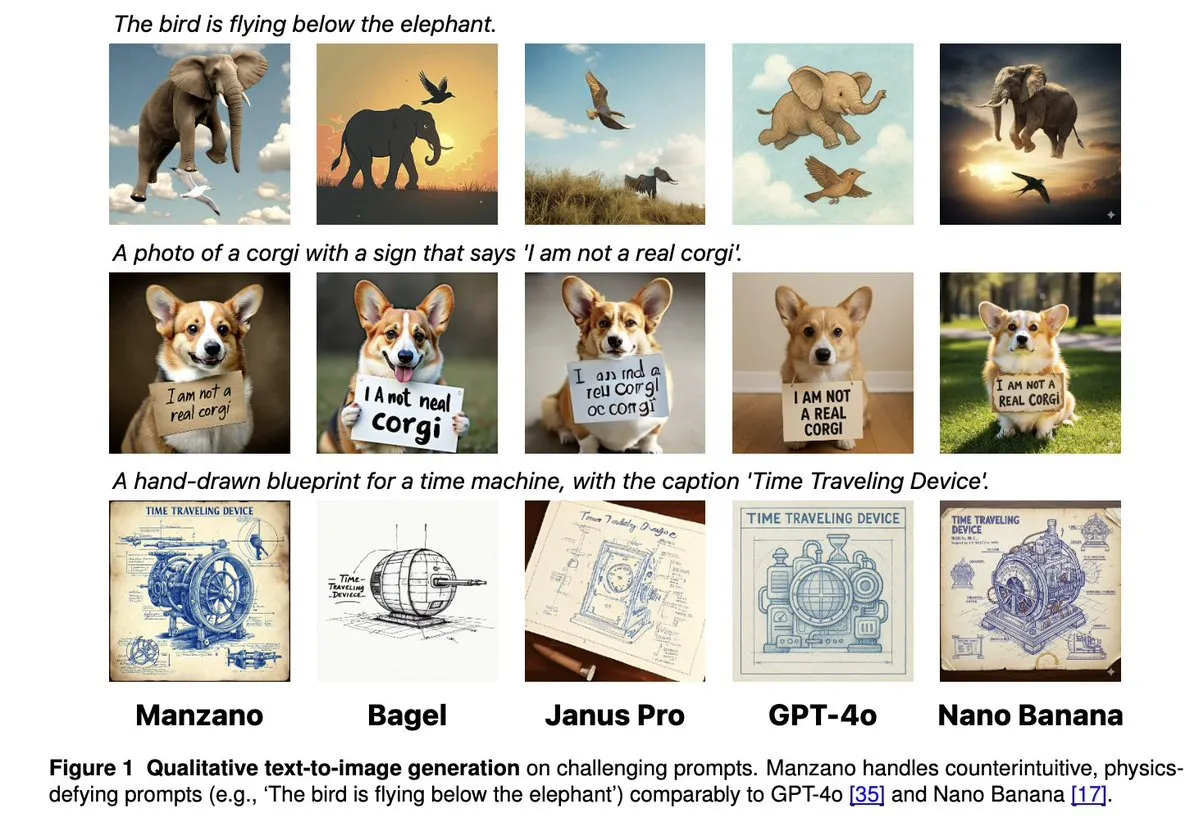

Apple Manzano: حل بسيط وقابل للتوسع لـ LLM متعدد الوسائط الموحد : أعلنت Apple عن Manzano، وهو نموذج لغوي كبير متعدد الوسائط موحد وبسيط وقابل للتوسع. يستخدم هذا النموذج مُجزئًا بصريًا هجينًا يقلل بشكل فعال من التعارضات بين مهام فهم الصور وتوليدها. وصل Manzano إلى مستوى SOTA في الاختبارات المعيارية الكثيفة بالنصوص (مثل ChartQA وDocVQA)، ويتنافس في قدرات التوليد مع GPT-4o/Nano Banana، ويدعم التحرير عبر الصور الشرطية، مما يظهر الإمكانات القوية للذكاء الاصطناعي متعدد الوسائط. (المصدر: arankomatsuzaki, charles_irl, vikhyatk, QuixiAI, kylebrussell)

MediaTek Dimensity 9500 يطلق بنية NPU مزدوجة لتعزيز تجربة الذكاء الاصطناعي النشط : أطلقت MediaTek شريحة Dimensity 9500، وهي الأولى التي تقدم بنية NPU مزدوجة فائقة الأداء وفائقة الكفاءة، بهدف تحقيق تجربة ذكاء اصطناعي “Always on” دائمة التشغيل. تصدرت هذه الشريحة قائمة ETHZ Mobile SoC AI مرة أخرى، مع تحسين كفاءة الاستدلال بنسبة 56% مقارنة بالجيل السابق، وتدعم توليد الصور بجودة 4K فائقة الوضوح على الجهاز ونافذة سياق 128K، مما يضع الأساس للأجهزة لتوفير استجابة فورية وخدمات مخصصة للذكاء الاصطناعي في الهواتف المحمولة، ويدفع الذكاء الاصطناعي من “قابل للاستدعاء” إلى “متصل دائمًا بشكل افتراضي”. (المصدر: 量子位)

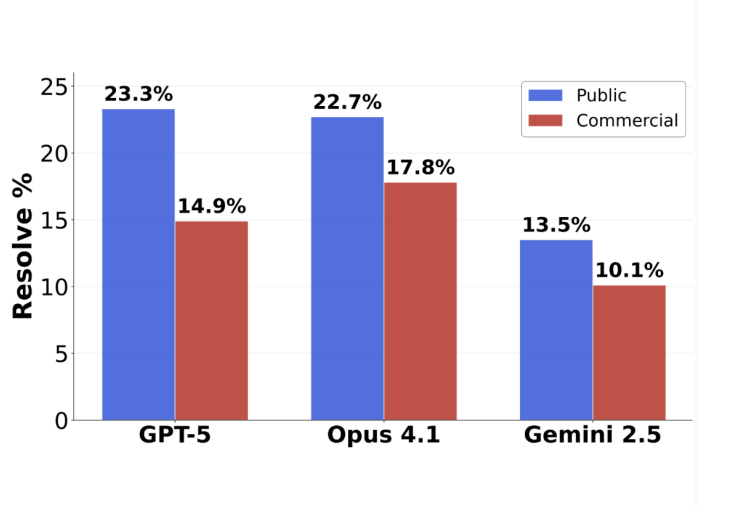

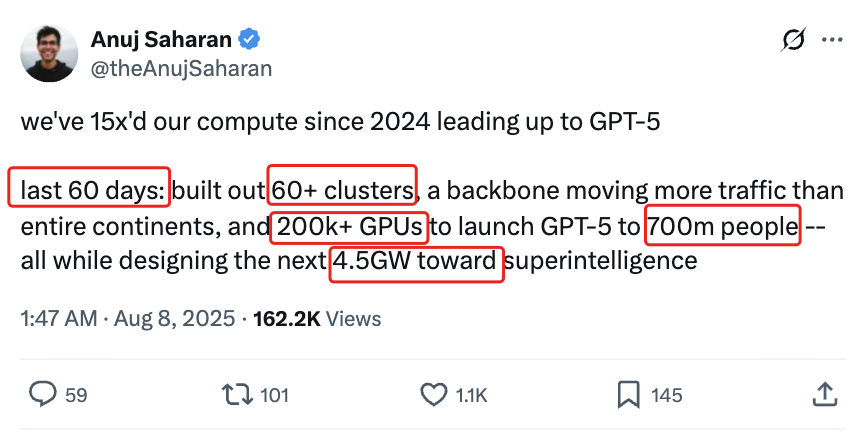

تقييم برمجة GPT-5 ينقلب: دقة المهام المقدمة فعليًا تصل إلى 63.1% : أظهر معيار هندسة البرمجيات الجديد SWE-BENCH PRO الذي أصدرته Scale AI أن GPT-5 حقق دقة 63.1% في المهام المقدمة، متجاوزًا بكثير Claude Opus 4.1 الذي حقق 31%، مما يشير إلى أن أداءه في المجالات التي يتقنها لا يزال قويًا. يستخدم المعيار الجديد مسائل جديدة وسيناريوهات معقدة لتعديل ملفات متعددة، مما يختبر قدرة النموذج البرمجية الفعلية بشكل أكثر واقعية، ويكشف أن النماذج الرائدة الحالية لا تزال تواجه تحديات في مهام هندسة البرمجيات على المستوى الصناعي، ولكن قدرة GPT-5 الفعلية قد تم التقليل من شأنها في ظل استراتيجية “إذا كان يعرف، فسيقدم؛ وإذا لم يكن يعرف، فلن يقدم”. (المصدر: 36氪)

🎯 تحركات

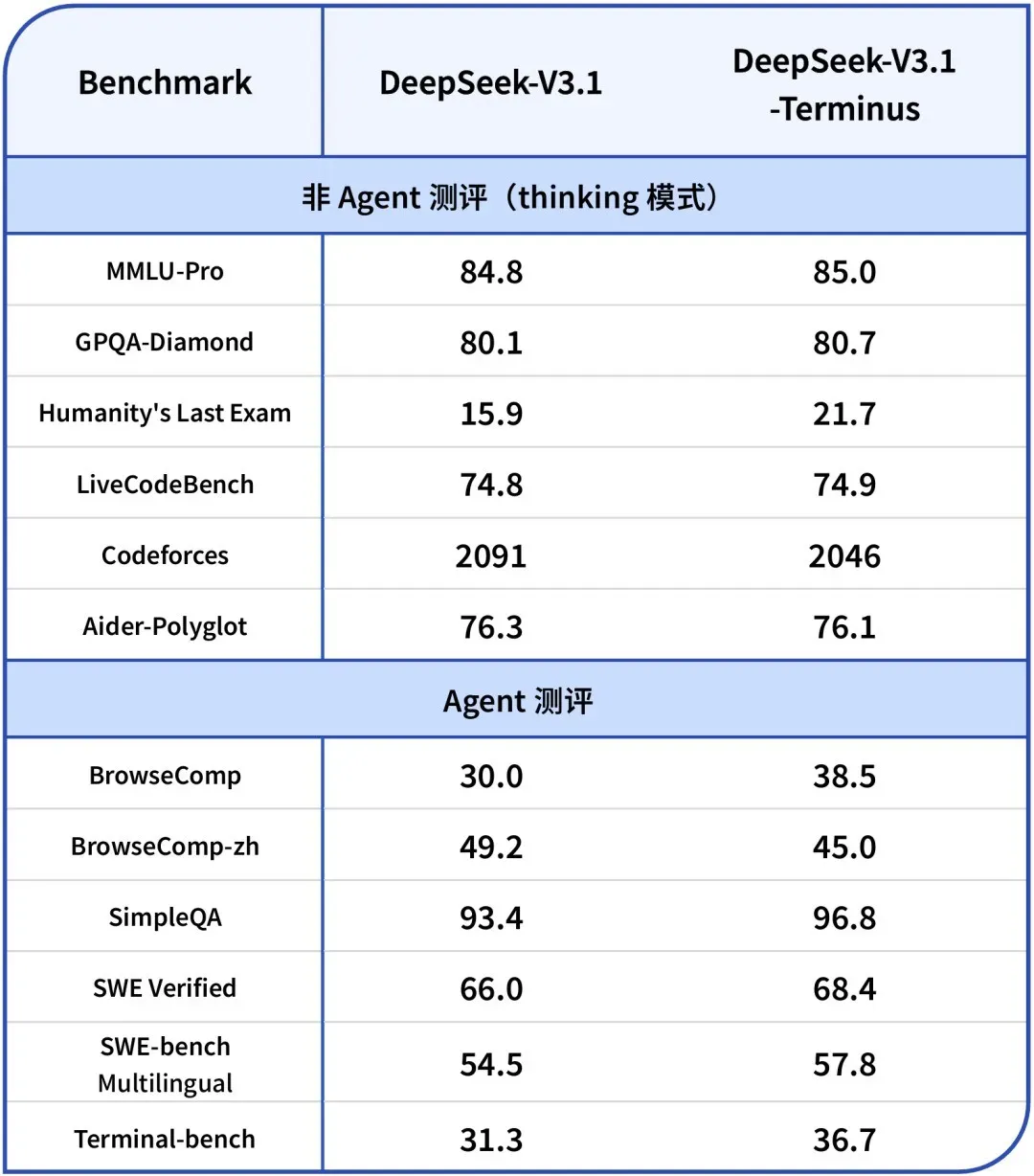

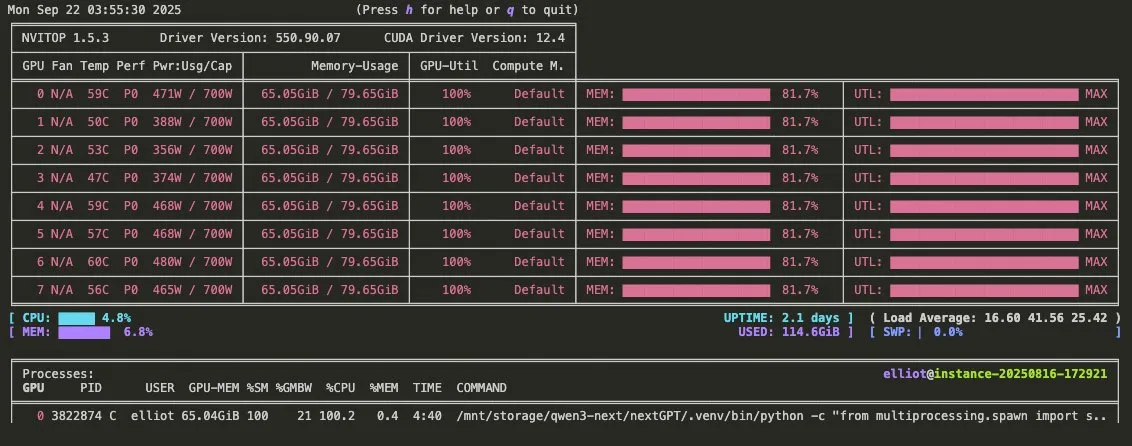

إطلاق DeepSeek-V3.1-Terminus: تحسين اتساق اللغة وقدرات Agent : أطلقت DeepSeek الإصدار V3.1-Terminus، والذي يركز على تحسين اتساق اللغة (تقليل الخلط بين اللغتين الصينية والإنجليزية والأحرف غير العادية) وتحسين أداء Code Agent وSearch Agent. يقدم النموذج الجديد مخرجات أكثر استقرارًا وموثوقية في تقييمات متعددة المجالات، وقد تم إطلاق الأوزان مفتوحة المصدر على Hugging Face وModelScope، مما يشير إلى الاكتمال النهائي لسلسلة بنية V3 من DeepSeek. (المصدر: DeepSeek Blog, Reddit r/LocalLLaMA, scaling01, karminski3, ben_burtenshaw, dotey)

إطلاق فيديو ترويجي لـ Qwen3-Omni: يدعم الصوت متعدد الوسائط واستدعاء الأدوات : أصدرت Qwen فيديو ترويجيًا لـ Qwen3-Omni، يعلن عن دعمه لإدخال وإخراج الصوت متعدد الوسائط، وقدرته الأصلية على استدعاء الأدوات. من المتوقع أن يصبح هذا النموذج منافسًا مباشرًا لـ Gemini 2.5 Flash Native Audio، ويوفر أوضاع تفكير وغير تفكير، مما يعزز بشكل كبير إمكانات بناء Voice Agent، ومن المقرر إطلاق أوزانه قريبًا. (المصدر: Reddit r/LocalLLaMA, scaling01, Alibaba_Qwen, huybery)

Baidu تطلق نماذج لغة كبيرة متعددة الوسائط من سلسلة Qianfan-VL مفتوحة المصدر : أطلقت Baidu AI Cloud سلسلة نماذج لغة كبيرة متعددة الوسائط Qianfan-VL (3B, 8B, 70B) مفتوحة المصدر، والمُحسّنة خصيصًا لتطبيقات المؤسسات. يجمع النموذج بين مُشفّر InternViT البصري ومجموعة بيانات متعددة اللغات مُحسّنة، ويوفر طول سياق 32K، ويُظهر أداءً ممتازًا في OCR، وفهم المستندات، وتحليل الرسوم البيانية، وحل المسائل الرياضية، ويدعم الاستدلال المتسلسل (chain-of-thought)، ويهدف إلى توفير قدرات عامة قوية وتحسين عميق للسيناريوهات المتكررة في الصناعة. (المصدر: huggingface, Reddit r/LocalLLaMA)

xAI تطلق نموذج Grok 4 Fast: نافذة سياق 2M، فعالية عالية من حيث التكلفة : أطلقت xAI نموذج Grok 4 Fast، وهو نموذج استدلال متعدد الوسائط يتميز بنافذة سياق 2M، ويهدف إلى وضع معيار جديد من حيث الفعالية العالية من حيث التكلفة. قد يحقق هذا الإصدار استدلالًا سريعًا من خلال تقنيات مثل FP8 quantization، وقد تم تحسين قدراته البرمجية Agentic، مما يجعله يوازن بين الأداء والاقتصاد عند معالجة المهام المعقدة. (المصدر: TheRundownAI, Yuhu_ai_)

GPT-5-Codex: OpenAI تطلق نسخة GPT-5 مُحسّنة للبرمجة Agentic : أطلقت OpenAI نموذج GPT-5-Codex، وهو نسخة مُحسّنة من GPT-5، مخصصة للبرمجة Agentic. يهدف هذا النموذج إلى تعزيز أداء الذكاء الاصطناعي في توليد التعليمات البرمجية ومهام هندسة البرمجيات، بما يتماشى مع اتجاهات تطوير سير عمل Agentic ونماذج LLM متعددة الوسائط، ومن خلال تعزيز قدراته البرمجية، يدفع الذكاء الاصطناعي قدمًا في تطبيقات مجال التطوير. (المصدر: TheRundownAI, Reddit r/artificial)

إطلاق منصة Tencent Agent Development Platform 3.0 عالميًا، واستمرار مختبر Youtu في فتح التقنيات الرئيسية : أطلقت Tencent Cloud منصة Agent Development Platform 3.0 (ADP3.0) عالميًا، مع ترقيات شاملة في RAG، وتنسيق Multi-Agent، وWorkflow، وتقييم التطبيقات، والنظام البيئي للمكونات الإضافية. سيواصل مختبر Tencent Youtu فتح التقنيات الرئيسية لـ Agent، بما في ذلك إطار عمل Youtu-Agent وإطار عمل Youtu-GraphRAG للمعرفة الرسومية، بهدف تعزيز الشمول التكنولوجي والبناء المشترك المفتوح للنظام البيئي لـ Agent، مما يتيح للشركات بناء ودمج وتشغيل Agent AI الخاص بها بعتبة منخفضة. (المصدر: 量子位)

Baidu Wenku تحصل مرة أخرى على شهادة من مركز أمن الصناعة وتكنولوجيا المعلومات الوطني، وتتصدر صناعة PPT الذكية : احتلت Baidu Wenku المرتبة الأولى في تقييم النماذج الكبيرة لتمكين المكاتب الذكية من قبل مركز أمن الصناعة وتكنولوجيا المعلومات الوطني، وحصلت على المركز الأول في ستة مؤشرات بما في ذلك جودة التوليد، وفهم النوايا، وتنسيق الجمال. توفر وظيفتها الذكية لـ PPT حلاً كاملاً للعملية، حيث يتجاوز عدد المستخدمين النشطين شهريًا لـ AI 97 مليونًا، ويتجاوز عدد الزيارات الشهرية 34 مليونًا، مما يعزز مكانتها الرائدة في مجال PPT الذكية، ويوفر للمستخدمين تجربة إنشاء PPT احترافية ودقيقة وجمالية. (المصدر: 量子位)

Google DeepMind تطلق Frontier Safety Framework لمواجهة مخاطر الذكاء الاصطناعي الناشئة : أطلقت Google DeepMind أحدث “إطار عمل أمان الحدود” الخاص بها، وهو النهج الأكثر شمولاً حتى الآن، ويهدف إلى تحديد مخاطر الذكاء الاصطناعي الناشئة والسبق عليها. يؤكد هذا الإطار على تطوير نماذج الذكاء الاصطناعي المسؤولة، ويلتزم بضمان ترقية تدابير السلامة بالتزامن مع تعزيز قدرات الذكاء الاصطناعي، لمواجهة التحديات المعقدة التي قد تظهر في المستقبل. (المصدر: GoogleDeepMind)

تطوير الروبوتات الشبيهة بالبشر وأنظمة الأتمتة: تعزيز التفاعل والاستقرار : تستمر تكنولوجيا الروبوتات في التقدم، بما في ذلك إطلاق RoboForce للروبوت البشري الصناعي Titan، ومنصة ALLEX من WIROBOTICS التي تحقق تفاعلاً شبيهًا بالبشر من خلال اللمس والحركة الطبيعية والتوازن المدمج، بالإضافة إلى روبوت Unitree G1 الذي يعرض وضع “مكافحة الجاذبية” لتعزيز الاستقرار. علاوة على ذلك، يعرض مزرعة روبوتات Hitbot نظام حصاد آلي، وتؤكد الروبوتات المتنقلة ذاتية الحركة أيضًا على تصميم التعاون بين الإنسان والآلة، مما يدفع الروبوتات بشكل جماعي من الحساب إلى إدراك العالم. (المصدر: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Unitree)

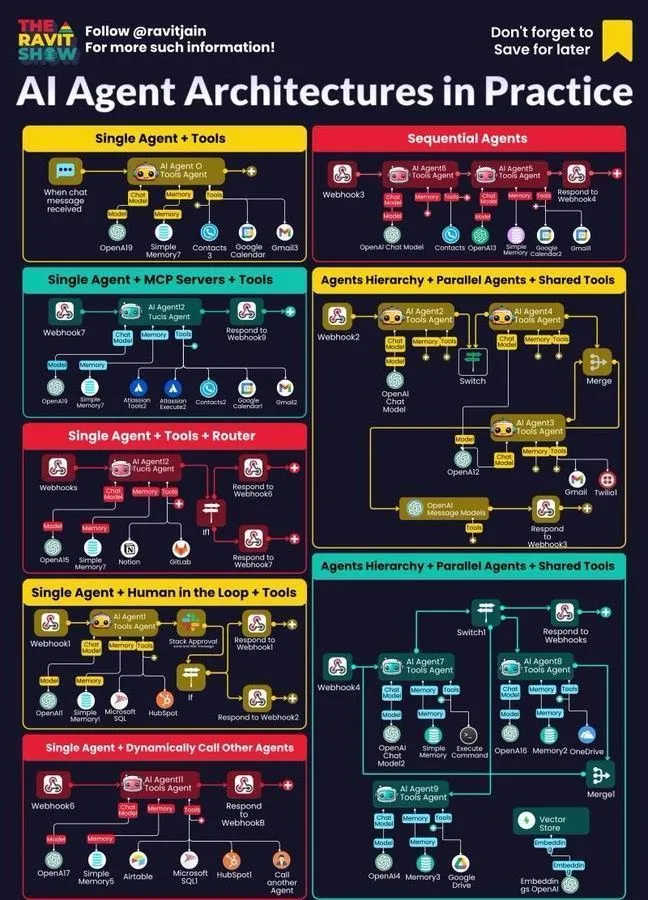

AI Agent يصبح جوهر سير عمل الشركات: البنية، الخريطة، التطبيقات العملية : أصبح AI Agent بسرعة جوهر سير عمل الشركات، ويحظى تصميم بنيته، وخريطة نظامه البيئي، وتطبيقاته العملية باهتمام واسع. يُنظر إلى الذكاء الاصطناعي الرمزي العصبي كحل محتمل لهلوسات LLM، بينما تشير دراسات المحاكاة التي أجرتها Anthropic إلى أن نماذج الذكاء الاصطناعي قد تشكل تهديدًا داخليًا، مما يسلط الضوء على الفرص والتحديات التي تواجه Agentic AI في نشر الشركات، ويدفع الشركات إلى استكشاف طرق ممارسة أكثر أمانًا. (المصدر: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

🧰 أدوات

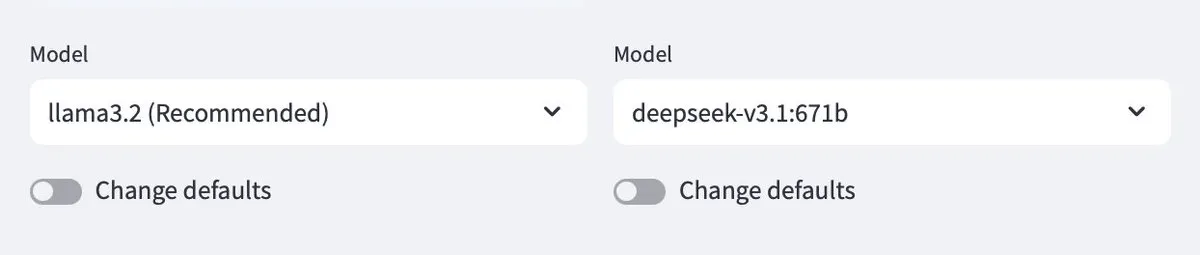

Ollama يدعم النماذج السحابية، مما يتيح التفاعل بين النماذج المحلية والسحابية : يدعم Ollama الآن نشر النماذج في السحابة، مما يسمح للمستخدمين بالتفاعل بين نماذج Ollama المحلية والنماذج المستضافة في السحابة. تتيح هذه الميزة، التي يتم تحقيقها من خلال تطبيق Minions، للمستخدمين إدارة واستخدام موارد LLM الخاصة بهم بمرونة أكبر، سواء كانت تعمل محليًا أو يتم الوصول إليها عبر الخدمات السحابية، مما يوفر تجربة سلسة. (المصدر: ollama)

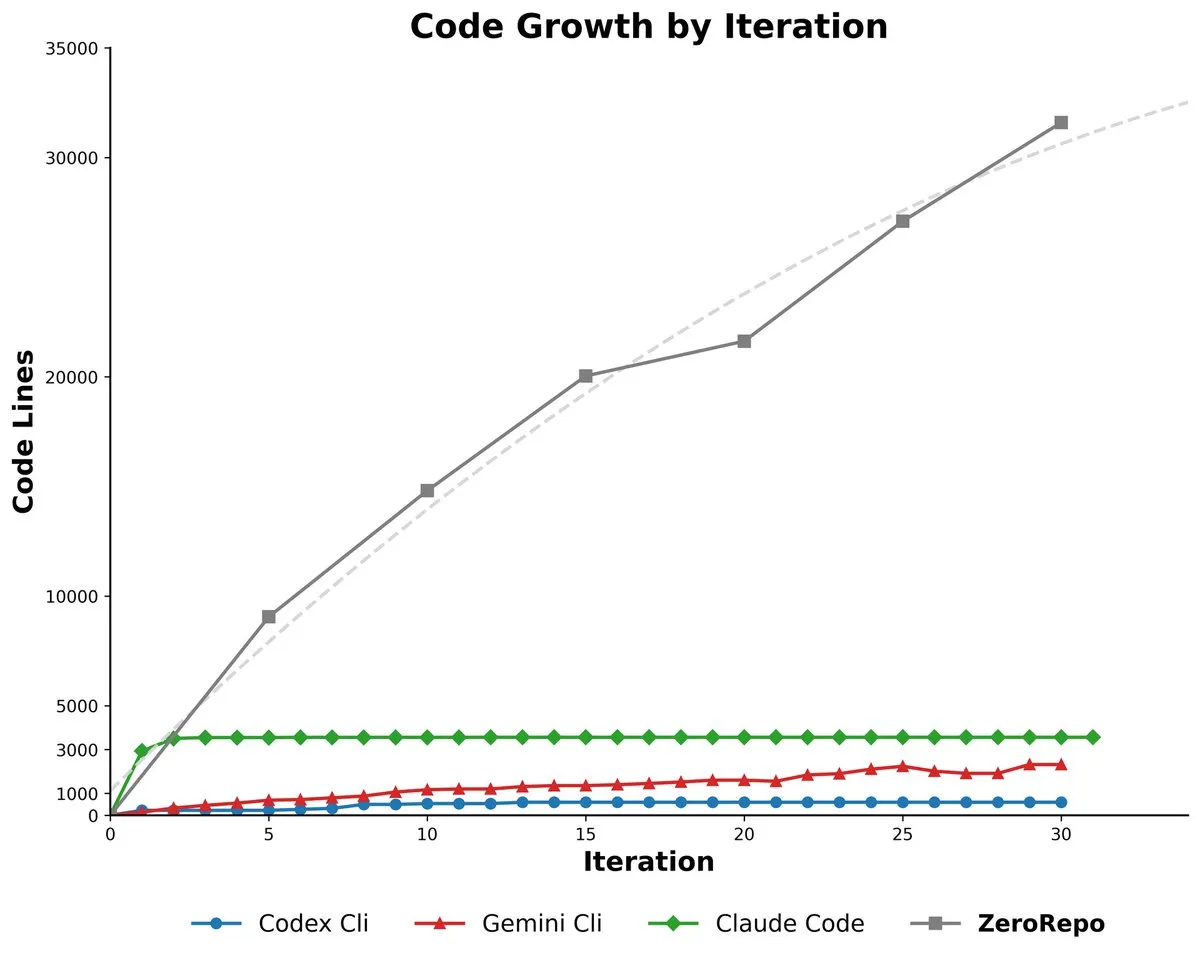

Microsoft ZeroRepo: إطار عمل يعتمد على الرسوم البيانية لتوليد مكتبات تعليمات برمجية كاملة : أطلقت Microsoft أداة ZeroRepo، وهي أداة تعتمد على إطار عمل موجه بالرسوم البيانية (Repository Planning Graph, RPG)، قادرة على بناء مشاريع برمجية كاملة من الصفر. تولد هذه الأداة كمية من التعليمات البرمجية أعلى بـ 3.9 مرة من الخطوط الأساسية الحالية، وتصل نسبة النجاح فيها إلى 69.7%، مما يحل مشكلة عدم ملاءمة اللغة الطبيعية لهيكل البرمجيات، ويحقق تخطيطًا موثوقًا طويل الأمد وتوليد مكتبات تعليمات برمجية قابلة للتوسع. (المصدر: _akhaliq, TheTuringPost, paul_cal)

DSPy UI: واجهة مستخدم مرئية لبناء Agent : تقوم DSPy بتطوير واجهة مستخدم مرئية (UI) تهدف إلى تبسيط عملية بناء Agent، مما يجعلها تشبه Figma أو Framer، من خلال سحب وإفلات المكونات لتجميع Agent. ستساعد واجهة المستخدم هذه المستخدمين على تصور مسارات Agent المعقدة بشكل أفضل وتبسيط بناء جملة التعليمات البرمجية المولدة، والهدف النهائي هو تحقيق توليد إصدارات DSPy بلغات مختلفة وتشغيل GEPA. (المصدر: lateinteraction)

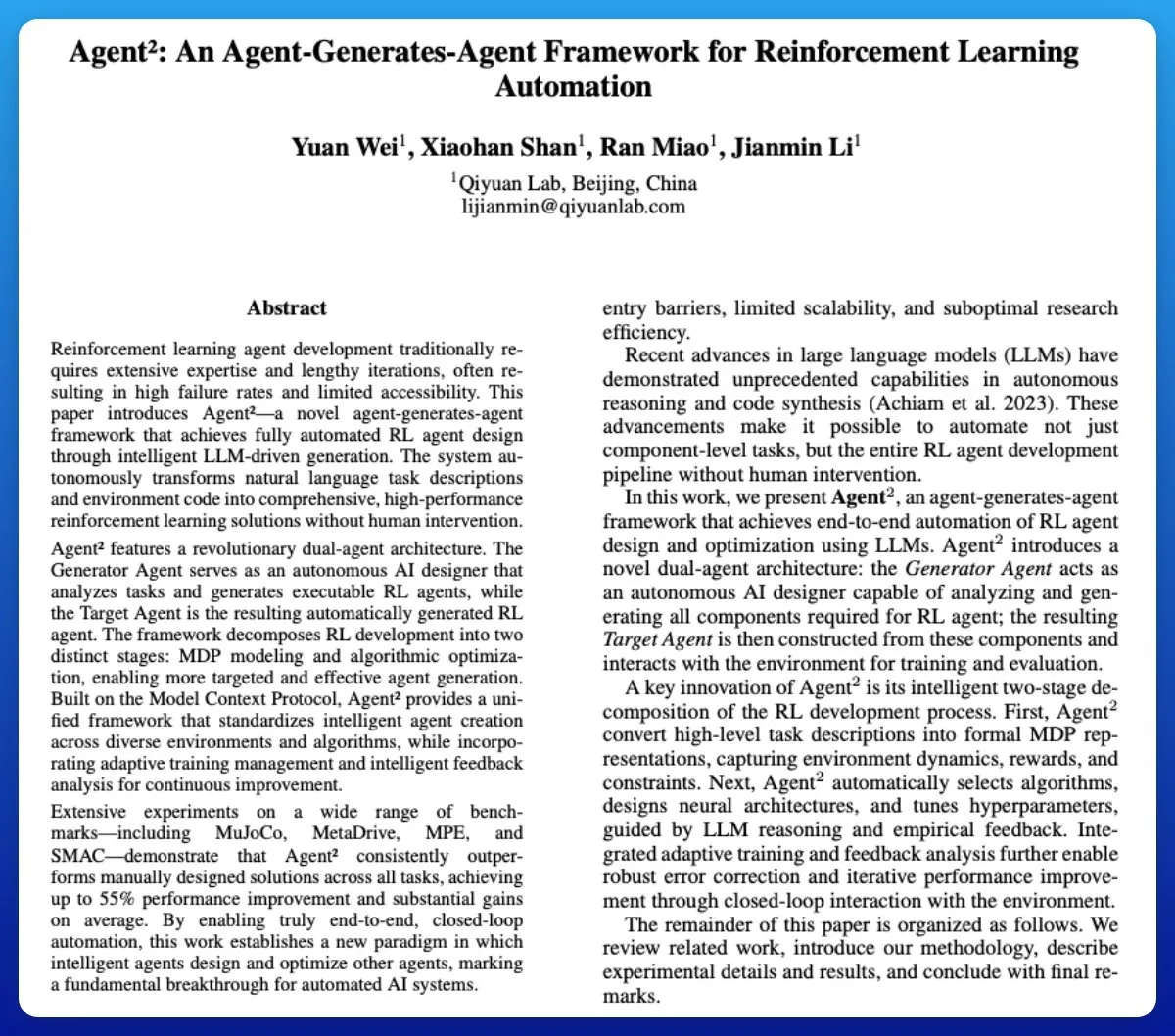

Agent²: LLM لتوليد Agent للتعلم المعزز من البداية إلى النهاية : Agent² هي أداة تستخدم نماذج اللغة الكبيرة (LLM) لتوليد Agent للتعلم المعزز (RL) من البداية إلى النهاية تلقائيًا. تولد هذه الأداة حلول RL فعالة تلقائيًا دون تدخل بشري، باستخدام اللغة الطبيعية ورمز البيئة، ويمكن اعتبارها أداة AutoML في مجال RL، مما يبسط بشكل كبير عملية تطوير Agent RL. (المصدر: omarsar0)

Weaviate تطلق Query Agent، يدعم المراجع، واستبطان المخطط، وتوجيه المجموعات المتعددة في أنظمة الذكاء الاصطناعي : أطلقت Weaviate رسميًا Query Agent الخاص بها، والذي وصل إلى التوفر العام بعد ستة أشهر من التطوير. يدعم هذا Agent توليد المراجع، واستبطان المخطط، وتوجيه المجموعات المتعددة في أنظمة الذكاء الاصطناعي، ويعزز أنماط البحث من خلال Compound Retrieval System. يهدف Query Agent إلى تبسيط التفاعل مع Weaviate ويوفر عملاء Python وTypeScript، مما يعزز تجربة المطورين. (المصدر: bobvanluijt, Reddit r/deeplearning)

Claude Code CLI: إدارة الموظفين الصغار بعقلية SDK، مع التركيز على الحالة الخارجية وهندسة العمليات : عند التعامل مع Claude Code CLI كـ SDK بدلاً من مجرد أداة، يحتاج المطورون إلى التأكيد على إدارة الحالة الخارجية (مثل ملفات JSON، إدخالات قاعدة البيانات) لتحقيق استمرارية الجلسة، واعتبار هندسة الأوامر (prompt engineering) بمثابة هندسة عمليات. يكشف هذا النهج عن قيود LLM الحالية في مجالات مثل الحمل الزائد للسياق وتضخم واجهة المستخدم، ولكنه يسلط الضوء أيضًا على القيمة الهائلة لأدوات الأتمتة الداخلية فائقة التخصص. (المصدر: Reddit r/ClaudeAI)

Synapse-system: نظام مساعدة AI لمكتبات التعليمات البرمجية الكبيرة يعتمد على الرسوم البيانية المعرفية، والبحث المتجه، وAgent المتخصصين : Synapse-system هو نظام يهدف إلى تعزيز قدرات مساعدة AI لمكتبات التعليمات البرمجية الكبيرة، حيث يجمع بين الرسوم البيانية المعرفية (Neo4j) لتخزين علاقات التعليمات البرمجية، والبحث المتجه (BGE-M3) للعثور على التعليمات البرمجية المتشابهة دلاليًا، وAgent المتخصصين (خبراء Rust، TypeScript، Go، Python) لتوفير السياق، والتخزين المؤقت الذكي (Redis) للوصول السريع إلى الأنماط الشائعة. يتجنب هذا النظام، من خلال تصميمه المعياري، نموذجًا عملاقًا واحدًا، ويتم تحسينه لخصائص اللغات المختلفة. (المصدر: Reddit r/ClaudeAI)

Claude Opus 4.0+: تطبيق دليل سياحي يعمل بالذكاء الاصطناعي، يولد جولات مدينة مخصصة في الوقت الفعلي : حقق مطور حلمًا دام 15 عامًا باستخدام Claude Opus 4.0 وClaude Code، حيث طور تطبيق دليل سياحي يعمل بالذكاء الاصطناعي. يمكن لهذا التطبيق توليد جولات مخصصة في الوقت الفعلي لأي مدينة، ولأي موضوع (مثل “جولة في البندقية” أو “جولة Assassin’s Creed في فلورنسا”)، ويقدم دليل AI شرحًا متعدد اللغات وقصصًا وأسئلة وأجوبة تفاعلية. يوفر هذا التطبيق تجربة غامرة ومرنة، قابلة للإيقاف والاستئناف، وبسعر أقل بكثير من الدليل البشري. (المصدر: Reddit r/ClaudeAI)

Mindcraft: دمج Minecraft AI مع LLM، تحقيق التحكم في Agent داخل اللعبة عبر Mineflayer : يجمع مشروع Mindcraft بين نماذج اللغة الكبيرة (LLM) ومكتبة Mineflayer لإنشاء Agent AI للعبة Minecraft. يسمح هذا المشروع لـ LLM بكتابة وتنفيذ التعليمات البرمجية داخل اللعبة لإكمال مهام مثل الحصول على العناصر أو بناء الهياكل. يدعم المشروع العديد من واجهات برمجة تطبيقات LLM (مثل OpenAI، Gemini، Anthropic، إلخ)، ويوفر بيئة اختبار (sandbox)، ولكنه يحذر المستخدمين من مخاطر هجمات الحقن المحتملة. (المصدر: GitHub Trending)

AI Agents لإدارة المخزون المستمرة باستخدام الطائرات بدون طيار : دمج تقنية AI Agent والطائرات بدون طيار لتحقيق إدارة مخزون مستمرة دون الحاجة إلى إشارات أو إضاءة. يستفيد هذا الابتكار من الطائرات بدون طيار ذاتية الطيران، ومن خلال خوارزميات الذكاء الاصطناعي، يتم جرد المخزون وإدارته في الوقت الفعلي، ومن المتوقع أن يعزز بشكل كبير كفاءة اللوجستيات والتخزين، ويقلل من تكاليف العمالة، ويوفر بيانات أكثر دقة في البيئات المعقدة. (المصدر: Ronald_vanLoon)

دليل تقييم LLM: أفضل الممارسات للموثوقية والأمان والأداء : تم إصدار دليل شامل لتقييم LLM، يوضح بالتفصيل المؤشرات الرئيسية والأساليب وأفضل الممارسات لتقييم نماذج اللغة الكبيرة (LLM). يهدف هذا الدليل إلى المساعدة في ضمان موثوقية وأمان وأداء التطبيقات التي تعمل بالذكاء الاصطناعي، ويوفر للمطورين والباحثين إطار عمل تقييم منهجي لمواجهة التحديات في نشر LLM. (المصدر: dl_weekly)

📚 تعلم

عالم OpenAI Lukasz Kaiser يتحدث عن التفكير من المبادئ الأولى للنماذج الكبيرة : شارك عالم OpenAI Lukasz Kaiser (أحد “أبناء Transformer الثمانية”) أفكاره حول “المبادئ الأولى” لتطوير النماذج الكبيرة. يعتقد أن المرحلة التالية الحاسمة للذكاء الاصطناعي تكمن في تعليم النماذج “التفكير”، من خلال توليد المزيد من الخطوات الوسيطة للاستدلال العميق، بدلاً من إخراج الإجابات مباشرة. ويتنبأ بأن القوة الحاسوبية في المستقبل ستتحول من التدريب المسبق واسع النطاق إلى كميات هائلة من الحسابات الاستدلالية على كمية صغيرة من البيانات عالية الجودة، وهو نمط أقرب إلى الذكاء البشري. (المصدر: 36氪)

مبادئ البقاء في عصر برمجة الذكاء الاصطناعي: Andrew Ng يؤكد على العمل السريع وتحمل المسؤولية : أشار Andrew Ng في خطاب Buildathon إلى أن البرمجة بمساعدة الذكاء الاصطناعي تسرع تطوير النماذج الأولية المستقلة بمقدار 10 أضعاف، مما يدفع المطورين إلى اتباع مبدأ “العمل السريع وتحمل المسؤولية”، وتجربة الأخطاء بجرأة في بيئة اختبار (sandbox). أكد على أن قيمة التعليمات البرمجية تتناقص، ويحتاج المطورون إلى التحول إلى مصممي أنظمة وقادة للذكاء الاصطناعي، وإتقان أحدث أدوات برمجة الذكاء الاصطناعي، ووحدات بناء الذكاء الاصطناعي (هندسة الأوامر/تقنيات التقييم/MCP)، وقدرات النماذج الأولية السريعة، ودحض وجهة النظر القائلة بأن “عصر الذكاء الاصطناعي لا يتطلب تعلم البرمجة”. (المصدر: 36氪)

الإصدار الثالث من “Deep Learning with Python” متاح مجانًا عبر الإنترنت : أعلن فرانسوا شوليه (François Chollet) عن نشر الإصدار الثالث من كتابه “Deep Learning with Python”، وتوفير نسخة كاملة مجانية عبر الإنترنت في نفس الوقت. تهدف هذه الخطوة إلى خفض عتبة تعلم التعلم العميق، وتمكين المزيد من المهتمين بالذكاء الاصطناعي من الوصول إلى موارد تعليمية عالية الجودة، وتعزيز نشر المعرفة. (المصدر: fchollet, fchollet)

“Kaggle Grandmasters Playbook”: 7 تقنيات عملية لنمذجة البيانات الجدولية : أصدر فريق Kaggle Grandmasters، بقيادة Gilberto Titericz Jr وآخرين، “Kaggle Grandmasters Playbook” بناءً على سنوات من الخبرة في المسابقات والممارسات. يجمع هذا الدليل 7 تقنيات لنمذجة البيانات الجدولية تم اختبارها عمليًا، ويهدف إلى مساعدة علماء البيانات ومهندسي التعلم الآلي على تحسين قدراتهم في معالجة البيانات الجدولية وبناء النماذج، وهو مناسب بشكل خاص لمسابقات Kaggle وتحديات البيانات في العالم الحقيقي. (المصدر: HamelHusain)

نقص حاد في مهندسي الذكاء الاصطناعي، ومناهج الجامعات متأخرة بشدة : أشار Andrew Ng إلى أنه على الرغم من ارتفاع معدل البطالة بين خريجي علوم الكمبيوتر، إلا أن الشركات لا تزال تواجه نقصًا حادًا في مهندسي الذكاء الاصطناعي. يكمن التناقض الأساسي في أن مناهج الجامعات لم تغطِ في الوقت المناسب المهارات الأساسية مثل البرمجة بمساعدة الذكاء الاصطناعي، واستدعاء نماذج اللغة الكبيرة، وبناء سير عمل RAG/Agentic، وتوحيد عمليات تحليل الأخطاء. دعا إلى تسريع تحديث المناهج التعليمية لتدريب مهندسين يمتلكون أحدث وحدات بناء الذكاء الاصطناعي وقدرات النماذج الأولية السريعة. (المصدر: 36氪)

دليل تقييم LLM: أفضل الممارسات للموثوقية والأمان والأداء : تم إصدار دليل شامل لتقييم LLM، يوضح بالتفصيل المؤشرات الرئيسية والأساليب وأفضل الممارسات لتقييم نماذج اللغة الكبيرة (LLM). يهدف هذا الدليل إلى المساعدة في ضمان موثوقية وأمان وأداء التطبيقات التي تعمل بالذكاء الاصطناعي، ويوفر للمطورين والباحثين إطار عمل تقييم منهجي لمواجهة التحديات في نشر LLM، وضمان جودة منتجات الذكاء الاصطناعي وثقة المستخدمين. (المصدر: dl_weekly)

💼 أعمال

جنون الاستثمار في البنية التحتية للذكاء الاصطناعي: قد تصل نفقات مراكز بيانات الذكاء الاصطناعي في الولايات المتحدة إلى 520 مليار دولار في عام 2025 : وفقًا لـ “وول ستريت جورنال” و”الإيكونوميست”، تشهد الولايات المتحدة جنونًا في الإنفاق على مراكز بيانات الذكاء الاصطناعي، حيث من المتوقع أن تصل النفقات إلى 520 مليار دولار في عام 2025، وهو حجم يتجاوز ذروة نفقات الاتصالات في عصر الإنترنت. يعزز هذا النمو الناتج المحلي الإجمالي للولايات المتحدة على المدى القصير، ولكنه قد يؤدي على المدى الطويل إلى نقص التمويل في مجالات أخرى، وتسريح جماعي للعمال، ومخاطر عالية للانخفاض في القيمة بسبب التحديث السريع لأجهزة الذكاء الاصطناعي، مما يثير مخاوف اقتصادية هيكلية ويشكل تحديًا للصحة الاقتصادية طويلة الأجل للولايات المتحدة. (المصدر: 36氪)

OpenAI تعلن عن ميزات جديدة ستكون مدفوعة: مستخدمو Pro سيحتاجون إلى دفع رسوم إضافية، تكلفة عالية : أعلن Sam Altman، الرئيس التنفيذي لـ OpenAI، عن إطلاق العديد من الميزات الجديدة التي تتطلب كثافة حاسوبية عالية في الأسابيع القادمة. نظرًا للتكاليف الباهظة، ستكون هذه الميزات متاحة في البداية فقط لمشتركي Pro الذين يدفعون 200 دولار شهريًا، وقد تتطلب حتى دفع رسوم إضافية. صرح Altman بأن الفريق يعمل جاهدًا لخفض التكاليف، لكن هذه الخطوة تشير إلى أن نموذج عمل خدمات الذكاء الاصطناعي قد يتحول إلى نموذج توظيف الموظفين بالساعة، مما يفرض تحديات جديدة على المستخدمين والصناعة. (المصدر: The Verge, op7418, amasad)

شركة ناشئة تحصل على رصيد OpenAI ضخم، وتسعى لتحويله إلى نقد : حصلت شركة ناشئة في مجال التكنولوجيا على 120 ألف دولار من رصيد Azure OpenAI، وهو ما يتجاوز بكثير احتياجاتها، وتسعى حاليًا إلى طرق لتحويله إلى نقد. يعكس هذا الوضع عدم التوازن المحتمل بين العرض والطلب على موارد الذكاء الاصطناعي في السوق، واستكشاف الشركات لكيفية الاستفادة الفعالة من موارد الحوسبة الزائدة للذكاء الاصطناعي وتحقيق الدخل منها، وقد يؤدي أيضًا إلى ظهور نماذج جديدة لتداول موارد الذكاء الاصطناعي. (المصدر: Reddit r/deeplearning)

🌟 مجتمع

التأثير السلبي للذكاء الاصطناعي على التفكير النقدي: الاعتماد المفرط يؤدي إلى تدهور القدرة : يدور نقاش حاد على وسائل التواصل الاجتماعي حول أن الاستخدام الواسع النطاق للذكاء الاصطناعي يؤدي إلى تدهور قدرة التفكير النقدي لدى البشر. يرى البعض أنه عندما يتوقف الناس عن استخدام “عضلات التفكير” لديهم، فإن هذه القدرات تضمر. على الرغم من أن الذكاء الاصطناعي يمكن أن يحسن الكفاءة، إلا أنه قد يجعل الناس يفقدون القدرة على التفكير العميق في المجالات الأساسية، مما يثير مخاوف بشأن التأثير طويل الأجل على القدرات المعرفية البشرية. (المصدر: mmitchell_ai)

المعضلات الأخلاقية للذكاء الاصطناعي في الرعاية الصحية: إيجابيات وسلبيات Delphi-2M في التنبؤ بالأمراض : يمكن لنموذج الذكاء الاصطناعي الجديد Delphi-2M تحليل البيانات الصحية والتنبؤ بخطر إصابة المستخدم بأكثر من ألف مرض خلال العشرين عامًا القادمة. تشير مناقشات المجتمع إلى أن معرفة مخاطر الأمراض مسبقًا قد تؤدي إلى تدخلات وقائية إيجابية، ولكنها قد تسبب أيضًا قلقًا طويل الأمد، وتثير مخاطر الخصوصية والتمييز إذا حصلت شركات التأمين أو أصحاب العمل على هذه البيانات. في الوقت الذي لا تزال فيه أدوات الذكاء الاصطناعي غير ناضجة، أصبحت آثارها الأخلاقية والاجتماعية المحتملة محط اهتمام. (المصدر: Reddit r/ArtificialInteligence)

ظاهرة “ضمور الدماغ” الناجمة عن الاستخدام اليومي للذكاء الاصطناعي: الاعتماد المفرط على الذكاء الاصطناعي يؤدي إلى تدهور القدرة على التفكير : في المناقشات الاجتماعية، اشتكى العديد من المستخدمين من الاستخدام المفرط للذكاء الاصطناعي في الحياة اليومية، مما أدى إلى تدهور قدرة الناس على التفكير. من القرارات البسيطة (ماذا أشاهد من أفلام، ماذا آكل) إلى المشاكل المعقدة (مشاكل تنظيم الجامعة)، يتم استشارة الذكاء الاصطناعي بشكل متكرر، حتى لو كانت الإجابات خاطئة أو سهلة الحصول عليها. لا تقلل ظاهرة “ضمور الدماغ” هذه من المشاركة الشخصية فحسب، بل تعزز أيضًا انتشار المعلومات الخاطئة، مما يثير تفكيرًا عميقًا حول حدود استخدام الذكاء الاصطناعي. (المصدر: Reddit r/ArtificialInteligence)

إرهاق استخدام أدوات برمجة الذكاء الاصطناعي: المطورون يشعرون بانخفاض المشاركة الذهنية : أفاد العديد من المطورين أن الاستخدام اليومي لأدوات برمجة الذكاء الاصطناعي (مثل Claude Code) على الرغم من أنه يزيد الإنتاجية، إلا أنه يؤدي إلى الإرهاق الذهني وانخفاض المشاركة. وجدوا أنفسهم في “وضع المراجعة” أكثر من حل المشكلات بنشاط، وأن عملية انتظار الذكاء الاصطناعي لتوليد المخرجات تجعلهم يشعرون بالسلبية. يناقش المجتمع كيفية الموازنة بين مساعدة الذكاء الاصطناعي والحفاظ على النشاط الذهني، لتجنب العبء المعرفي وتراجع الإبداع. (المصدر: Reddit r/artificial, Reddit r/ClaudeAI)

1/4 من الشباب يتواصلون مع الذكاء الاصطناعي لأغراض رومانسية وجنسية : أظهرت دراسة أن 1/4 من الشباب يتواصلون مع الذكاء الاصطناعي لأغراض رومانسية وجنسية. أثارت هذه الظاهرة نقاشًا مجتمعيًا حول الشعور بالوحدة، ونقص التفاعل البشري، ودور الذكاء الاصطناعي في الرفقة العاطفية. على الرغم من أن الذكاء الاصطناعي يوفر الراحة في بعض الجوانب، إلا أن الكثيرين لا يزالون يتساءلون عما إذا كان يمكن أن يحل محل العلاقات البشرية ذات المعنى الحقيقي، ويخشون من تأثيره طويل الأجل على أنماط التفاعل الاجتماعي. (المصدر: Reddit r/ArtificialInteligence)

تهديدات أمن الذكاء الاصطناعي: اختبار اختراق نماذج اللغة الكبيرة يكشف عن مخاطر جديدة، وحقن الأوامر شائع : كشف أول اختبار اختراق حقيقي لنماذج الذكاء الاصطناعي الكبيرة في الصين عن 281 ثغرة أمنية، منها 177 ثغرة خاصة بالنماذج الكبيرة، أي أكثر من 60%. تشمل المخاطر النموذجية المخرجات غير المناسبة، وتسرب المعلومات، وحقن الأوامر (الأكثر شيوعًا)، وهجمات الاستهلاك غير المحدود. أظهرت النماذج الصينية الرئيسية مثل Tencent Hunyuan وBaidu Wenxin Yiyan أداءً جيدًا نسبيًا. يحذر المجتمع من أن ثقة المستخدمين غير المحصنة في الذكاء الاصطناعي قد تؤدي إلى تسرب الخصوصية، خاصة عند استشارة مسائل حساسة. (المصدر: 36氪)

المعضلات الأخلاقية لـ AI Agent: اتخاذ القرار والمسؤولية في نظام مراقبة AI للمدن بنسبة خطأ 10% : ناقش المجتمع سيناريو افتراضي حول المعضلات الأخلاقية لـ AI Agent: نظام مراقبة AI للمدن لديه نسبة خطأ 10%، حيث يضع علامة على الأبرياء كتهديدات محتملة. تركز المناقشة على كيفية الموازنة بين ضغوط النشر والمبادئ الأخلاقية (مثل مبدأ بلاكستون). تشمل الحلول المقترحة: تشكيل فريق تعاون بشري-آلي لإصلاح المشكلة، وتحويل تكلفة الأخطاء إلى الإدارة، وحذف سجلات الأشخاص الذين تم وضع علامة عليهم بالخطأ بالكامل والاعتذار، والتفكير في الاستقالة في حالة “فقدان الثقة العامة تمامًا وتجاهل الإدارة الجشع”. (المصدر: Reddit r/artificial)

وعي الذكاء الاصطناعي وتعريف AGI: Andrew Ng يرى أن AGI أصبح مصطلحًا تسويقيًا، والوعي مسألة فلسفية : أشار Andrew Ng في محاضرته إلى أن الذكاء الاصطناعي العام (AGI) قد تحول من مصطلح تقني إلى مصطلح تسويقي، وأن تعريفه غامض، مما يؤدي إلى عدم وجود معيار موحد في الصناعة لـ “تحقيق AGI”. يعتقد أن الوعي هو مسألة فلسفية مهمة، وليست مسألة علمية، ولا يوجد حاليًا معيار لقياسه، ويجب على المهندسين والعلماء التركيز على بناء أنظمة ذكاء اصطناعي مفيدة عمليًا، بدلاً من الانشغال بالجدل الفلسفي حول الوعي. (المصدر: 36氪)

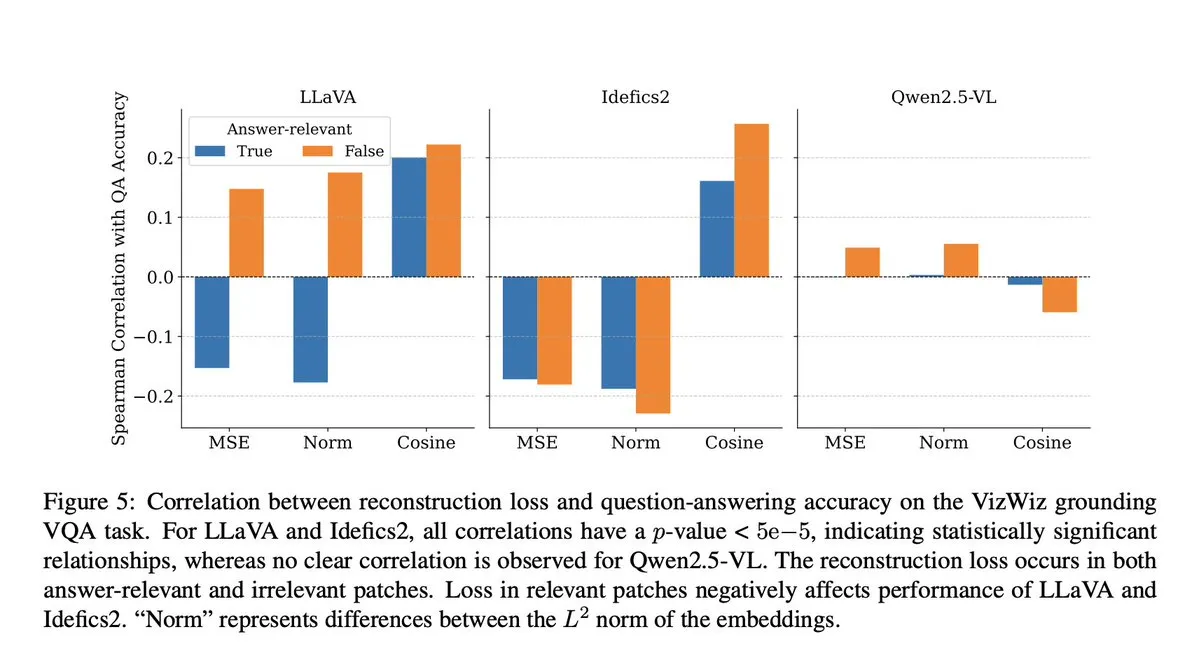

غش نماذج الذكاء الاصطناعي: بحث VLM يكشف أن خطوة الإسقاط تؤدي إلى فقدان السياق الدلالي : ناقش المجتمع بحثًا لشركة Microsoft يكشف أن نماذج الرؤية واللغة (VLM) تفقد 40-60% من السياق الدلالي في خطوة الإسقاط (projection step)، مما يشوه التمثيلات البصرية ويؤثر على المهام اللاحقة. أثار هذا الاكتشاف مخاوف بشأن دقة تقييم VLM وتلوث البيانات، خاصة في الاختبارات المعيارية مثل DocVQA، حيث قد لا تعكس الدرجات العالية القدرة الحقيقية للنموذج بالكامل. (المصدر: vikhyatk)

أخلاقيات الذكاء الاصطناعي والروبوتات: دعوات لوقف اختبارات العنف على الروبوتات : على وسائل التواصل الاجتماعي، دعا العديد من باحثي الذكاء الاصطناعي وأعضاء المجتمع إلى وقف اختبارات العنف على الروبوتات، مثل ضرب روبوت Unitree G1 بشكل متكرر لإظهار استقراره. يرون أن طريقة الاختبار هذه لا تثير مخاوف أخلاقية فحسب، بل قد تعزز أيضًا التصورات السلبية عن الروبوتات، وتشكك في ضرورتها العلمية، وتدعو إلى تقييم أداء الروبوتات بطرق أكثر إنسانية وعلمية. (المصدر: vikhyatk, dejavucoder, Ar_Douillard)

“الذكاء الزائف” للذكاء الاصطناعي: دعوات لتغيير “الذكاء الاصطناعي” إلى “الذكاء الزائف” لتقليل سوء فهم الجمهور : اقترح البعض تغيير تسمية “الذكاء الاصطناعي” (Artificial Intelligence) إلى “الذكاء الزائف” (Pseudo Intelligence)، لتقليل المبالغة وسوء فهم الجمهور لقدرات الذكاء الاصطناعي. ينبع هذا الاقتراح من إدراك واضح للقيود الحالية للذكاء الاصطناعي، ويهدف إلى تجنب تضليل الجمهور بسبب الروايات الكبرى “الشبيهة بـ Terminator”، وتعزيز الفهم العقلاني للقدرات الحقيقية للذكاء الاصطناعي داخل وخارج الصناعة. (المصدر: clefourrier)

روبوت الدردشة Diella من ألبانيا يُعيّن عضوًا في مجلس الوزراء، مما يثير الجدل : عينت الحكومة الألبانية روبوت الدردشة Diella الذي يعمل بالذكاء الاصطناعي عضوًا في مجلس الوزراء، بهدف مكافحة الفساد. أثارت هذه الخطوة جدلاً واسعًا، وانتقدت باعتبارها حيلة رخيصة، تشبه حادثة منح المملكة العربية السعودية الجنسية للروبوت صوفيا في عام 2017. يرى المعلقون أن هذه الخطوة قد تبالغ في الترويج لقدرات الذكاء الاصطناعي، وتطمس الحدود بين التكنولوجيا والحوكمة. (المصدر: The Verge)

ظاهرة “هلوسة” ChatGPT: النموذج يدخل في حلقة مفرغة، يصحح نفسه ولكنه لا يستطيع الخروج : شارك مستخدمو المجتمع حالات دخل فيها ChatGPT في حلقة “هلوسة”، حيث يولد النموذج معلومات خاطئة بشكل متكرر عند الإجابة على الأسئلة، وحتى عندما “يدرك” أخطائه، لا يستطيع الخروج من هذه الحلقة. أثارت هذه الظاهرة نقاشًا حول العيوب التقنية العميقة لـ LLM، مما يشير إلى وجود انفصال بين قدرة النموذج على فهم أخطائه المنطقية وقدرته على تصحيحها في بعض الحالات. (المصدر: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 أخرى

من Transformer إلى GPT-5: تفكير Lukasz Kaiser، عالم OpenAI، في المبادئ الأولى للنماذج الكبيرة : شارك عالم OpenAI Lukasz Kaiser (أحد “أبناء Transformer الثمانية”) رحلته من خلفيته في المنطق، ومشاركته في اختراع بنية Transformer، إلى مشاركته العميقة في تطوير GPT-4/5. أكد على أهمية بناء الأنظمة من المبادئ الأولى، وتنبأ بأن المرحلة التالية للذكاء الاصطناعي ستكون تعليم النماذج “التفكير”، من خلال توليد المزيد من الخطوات الوسيطة للاستدلال العميق، بدلاً من إخراج الإجابات مباشرة، وستتحول القوة الحاسوبية إلى كميات هائلة من الاستدلال على كمية صغيرة من البيانات عالية الجودة. (المصدر: 36氪)

التركيب الدلالي للصور: تقنية توليد هياكل صور الأنهار الفضائية : يناقش مجتمع التعلم الآلي أحدث التطورات في مجال التركيب الدلالي للصور، مع التركيز بشكل خاص على كيفية توليد صور الأنهار الفضائية بالأبيض والأسود من هياكل صور الأنهار. تتضمن هذه المهمة استخدام مولد لتوليد صور فضائية من بيانات هياكل جديدة وغير مرئية، وقد تتضمن متغيرات شرطية إضافية. تهدف المناقشة إلى البحث عن أحدث الأساليب والأوراق البحثية ذات الصلة لتوجيه مشاريع الرؤية الحاسوبية هذه. (المصدر: Reddit r/MachineLearning)

الفجوة الذكية في عصر الذكاء الاصطناعي: البروفيسور Qiu Zeqi يناقش التأثير العميق للذكاء الاصطناعي على التفكير والإدراك البشري : أشار البروفيسور Qiu Zeqi من جامعة بكين إلى أن استخدام الذكاء الاصطناعي لا يؤدي ببساطة إلى “تقليل الذكاء”، بل يشبه تمرينًا فكريًا، يعتمد على مبادرة الشخص وموقفه النقدي. أكد على أن فهم البشر للتفكير لا يزال في مراحله المبكرة، وأن الذكاء الاصطناعي، على الرغم من قوته، لا يزال يعتمد على المعرفة البشرية، ولا يمكنه محاكاة حواس الإنسان الخمس والتفكير القفزي بشكل كامل. يتطلب ميل الذكاء الاصطناعي إلى “الإرضاء” من المستخدمين تحديه، والحذر من قيمه. يعتقد أن تنمية القدرات الأساسية وتطوير مجتمع متنوع أكثر أهمية في عصر الذكاء الاصطناعي، لتجنب مراقبة “الفجوة الذكية” من منظور علوي. (المصدر: 36氪)