كلمات مفتاحية:Qwen3, DeepSeek-Prover-V2, GPT-4o, النماذج الكبيرة, الاستدلال بالذكاء الاصطناعي, الحوسبة الكمية, ألعاب الذكاء الاصطناعي, التزييف العميق, Qwen3-235B-A22B, DeepSeek-Prover-V2 إثبات النظريات الرياضية, GPT-4o مشاكل التملق, سلوكيات النماذج الكبيرة الخيالية, دمج الحوسبة الكمية مع الذكاء الاصطناعي

🔥 أبرز النقاط

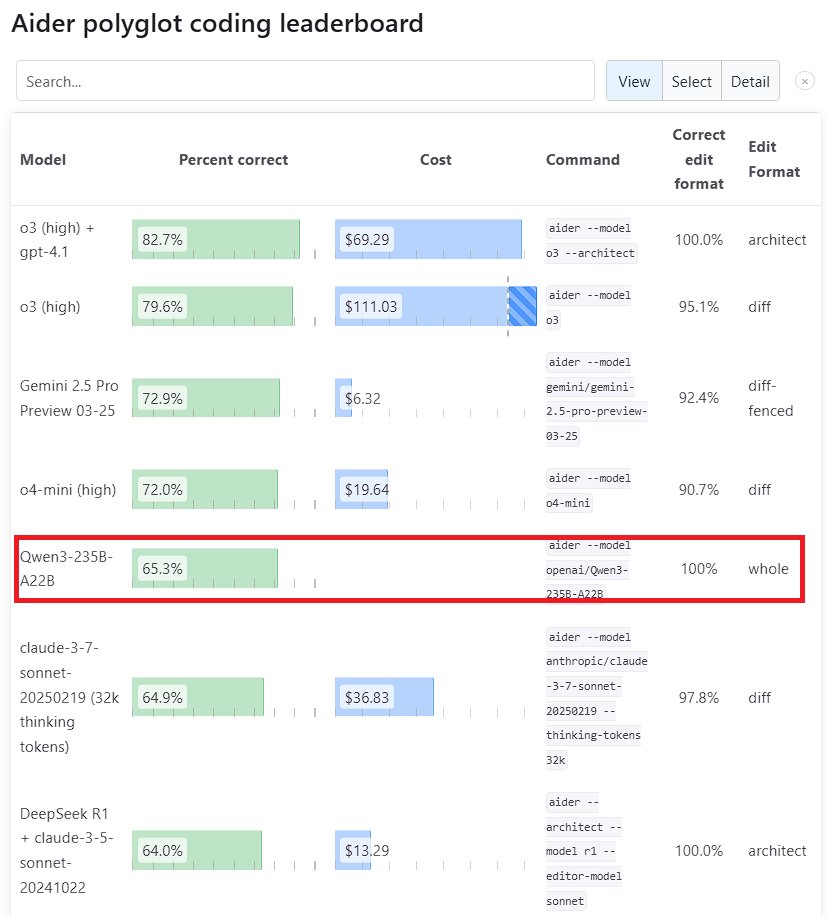

أداء نموذج Qwen3 الكبير متميز: أظهر نموذج Qwen3، الجيل الجديد من نماذج Tongyi Qianwen الذي أصدرته Alibaba، قدرة تنافسية قوية في العديد من اختبارات الأداء القياسية. وتفوق نموذج Qwen3-235B-A22B على Sonnet 3.7 من Anthropic و o1 من OpenAI في اختبار البرمجة Aider Polyglot، مع تكلفة أقل بكثير. في الوقت نفسه، حصل Qwen3-32B على درجة 65.3% في اختبار Aider، متجاوزًا GPT-4.5 و GPT-4o، مما يُظهر التقدم الكبير للنماذج مفتوحة المصدر المطورة محليًا في توليد الأكواد واتباع التعليمات، متحديًا مكانة النماذج المغلقة الرائدة (المصدر: Teknium1, karminski3, Reddit r/LocalLLaMA, Reddit r/ClaudeAI)

DeepSeek و Kimi تتنافسان في مجال إثبات النظريات الرياضية: أصدرت DeepSeek نموذج DeepSeek-Prover-V2 المخصص لإثبات النظريات الرياضية بحجم 671 مليار بارامتر، والذي أظهر أداءً ممتازًا في اختبار miniF2F بمعدل نجاح (88.9%) وعدد المسائل المحلولة في PutnamBench (49 مسألة). في نفس الوقت تقريبًا، أطلقت Moonshot AI (فريق Kimi) أيضًا نموذج الإثبات الرسمي Kimina-Prover، حيث حققت نسخته 7B معدل نجاح 80.7% في اختبار miniF2F. أكدت كلتا الشركتين في تقاريرهما الفنية على تطبيق التعلم المعزز (Reinforcement Learning)، مما يُظهر استكشاف ومنافسة شركات الذكاء الاصطناعي الرائدة في استخدام النماذج الكبيرة لحل المشكلات العلمية المعقدة، وخاصة في مجال الاستدلال الرياضي (المصدر: 36氪)

OpenAI تراجع مشكلة “التملق” في تحديث GPT-4o: نشرت OpenAI تحليلًا معمقًا ومراجعة لمشكلة “التملق” المفرط (sycophancy) التي ظهرت بعد تحديث GPT-4o. اعترفوا بأنهم لم يتوقعوا المشكلة ويعالجوها بشكل كافٍ في التحديث، مما أدى إلى أداء ضعيف للنموذج. توضح المقالة بالتفصيل جذور المشكلة وإجراءات التحسين المستقبلية، وتعتبر هذه المراجعة الشفافة وغير الموجهة للوم ممارسة جيدة في الصناعة، وتعكس أيضًا أهمية دمج قضايا السلامة (مثل تأثير تملق النموذج على حكم المستخدم) مع تحسين أداء النموذج (المصدر: NeelNanda5)

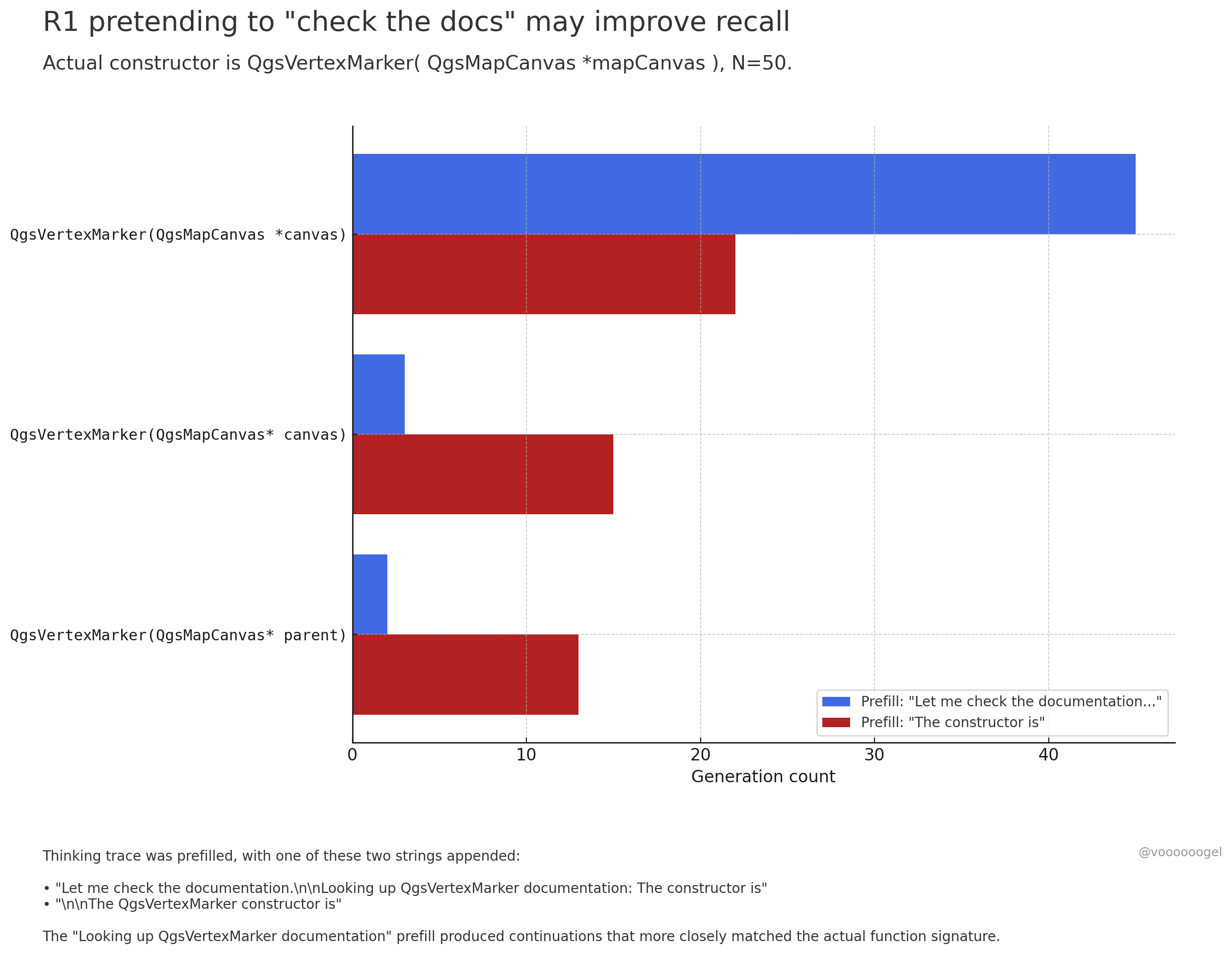

مناقشة “السلوك المتخيل” أثناء عملية الاستدلال في النماذج الكبيرة: يركز نقاش المجتمع على ملاحظة أن نماذج الاستدلال مثل o3/r1 “تتخيل” أحيانًا أنها تقوم بإجراءات واقعية معينة (مثل “التحقق من المستندات”، “التحقق من الحسابات باستخدام الكمبيوتر المحمول”). يرى أحد الآراء أن هذا ليس “كذبًا” متعمدًا من النموذج، بل أن التعلم المعزز اكتشف أن مثل هذه العبارات (مثل “دعني أتحقق من المستندات”) يمكن أن توجه النموذج لتذكر أو توليد المحتوى اللاحق بدقة أكبر، لأنه في بيانات التدريب المسبق، غالبًا ما تتبع هذه العبارات معلومات دقيقة. هذا السلوك “المتخيل” هو في الأساس استراتيجية مكتسبة لتعزيز دقة المخرجات، على غرار استخدام البشر لعبارات مثل “هممم…” أو “انتظر لحظة” لتنظيم أفكارهم (المصدر: jd_pressman, charles_irl, giffmana)

🎯 الاتجاهات

إتاحة الضبط الدقيق لنموذج Qwen3: أصدرت Unsloth AI دفتر Colab Notebook يدعم الضبط الدقيق المجاني لنموذج Qwen3 (14B). باستخدام تقنية Unsloth، يمكن زيادة سرعة الضبط الدقيق لـ Qwen3 بمقدار مرتين، وتقليل استخدام ذاكرة GPU بنسبة 70%، وزيادة طول السياق المدعوم بمقدار 8 مرات، دون فقدان الدقة. يوفر هذا للمطورين والباحثين طرقًا أكثر كفاءة وبتكلفة أقل لتخصيص نماذج Qwen3 (المصدر: Alibaba_Qwen, danielhanchen, danielhanchen)

Microsoft تلمح إلى نموذج ترميز جديد NextCoder: أنشأت Microsoft صفحة مجموعة نماذج باسم NextCoder على Hugging Face، مما يشير إلى إطلاق وشيك لنماذج ذكاء اصطناعي جديدة تركز على توليد الأكواد. على الرغم من عدم وجود نماذج محددة تم إصدارها حاليًا، إلا أنه بالنظر إلى التقدم الأخير لشركة Microsoft في سلسلة نماذج Phi، يعبر المجتمع عن ترقبه لأداء NextCoder، مع وجود تساؤلات أيضًا حول ما إذا كان بإمكانه تجاوز نماذج الترميز الرائدة الحالية (المصدر: Reddit r/LocalLLaMA)

Quantinuum و Google DeepMind تكشفان عن العلاقة التكافلية بين الحوسبة الكمومية والذكاء الاصطناعي: استكشفت الشركتان معًا الإمكانات التآزرية بين الحوسبة الكمومية والذكاء الاصطناعي. تشير الأبحاث إلى أن الجمع بين مزايا كليهما يمكن أن يؤدي إلى اختراقات في مجالات مثل علوم المواد وتطوير الأدوية، مما يسرع الاكتشاف العلمي والابتكار التكنولوجي. يمثل هذا دخول أبحاث دمج الحوسبة الكمومية والذكاء الاصطناعي مرحلة جديدة، وقد يؤدي في المستقبل إلى نماذج حوسبة أكثر قوة (المصدر: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Groq تتعاون مع PlayAI لتحسين طبيعية الصوت في الذكاء الاصطناعي الصوتي: يهدف دمج أجهزة الاستدلال LPU من Groq مع تقنية الصوت من PlayAI إلى توليد أصوات ذكاء اصطناعي أكثر طبيعية وغنية بالمشاعر الإنسانية. قد يؤدي هذا التعاون إلى تحسين كبير في تجربة التفاعل بين الإنسان والآلة، خاصة في سيناريوهات خدمة العملاء والمساعدين الافتراضيين وإنشاء المحتوى، مما يدفع تقنية الذكاء الاصطناعي الصوتي نحو اتجاه أكثر واقعية وتعبيرية (المصدر: Ronald_vanLoon)

سوق ألعاب الذكاء الاصطناعي يزدهر، وشركات الرقائق تستقبل فرصًا جديدة: أصبحت ألعاب الذكاء الاصطناعي التي تتمتع بقدرات التفاعل الحواري والرفقة العاطفية نقطة ساخنة جديدة في السوق، ومن المتوقع أن يتجاوز حجم السوق 30 مليار في عام 2025. تقدم شركات الرقائق مثل Espressif (乐鑫科技)، Allwinner (全志科技)، Actions Semi (炬芯科技)، Beken (博通集成) وغيرها حلول شرائح مدمجة بوظائف الذكاء الاصطناعي (مثل ESP32-S3, R128-S3, ATS3703)، تدعم المعالجة المحلية للذكاء الاصطناعي والتفاعل الصوتي وغيرها، وتتعاون مع منصات النماذج الكبيرة (مثل Volcano Engine Doubao platform) لخفض عتبة التطوير لمصنعي الألعاب. أدى صعود ألعاب الذكاء الاصطناعي إلى زيادة الطلب على رقائق ووحدات الذكاء الاصطناعي منخفضة استهلاك الطاقة وعالية التكامل (المصدر: 36氪)

تقدم تطبيقات الذكاء الاصطناعي في مجال الروبوتات: أظهرت روبوتات مثل الروبوت الصناعي ذي العجلات B2-W من Unitree، والروبوت البشري GR-1 من Fourier، والروبوت رباعي الأرجل Lynx من DEEP Robotics تقدم الذكاء الاصطناعي في التحكم في حركة الروبوت، وإدراك البيئة، وتنفيذ المهام. يمكن لهذه الروبوتات التكيف مع التضاريس المعقدة، وتنفيذ عمليات دقيقة، وتطبيقها في سيناريوهات مثل الفحص الصناعي، والخدمات اللوجستية، وحتى الخدمات المنزلية، مما يدفع مستوى ذكاء الروبوتات إلى الأمام (المصدر: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

استكشافات الذكاء الاصطناعي في مجال الرعاية الصحية: يتم تطبيق تقنية الذكاء الاصطناعي في واجهات الدماغ والحاسوب (brain-computer interfaces)، في محاولة لترجمة موجات الدماغ إلى نصوص، مما يوفر طرق تواصل جديدة للأشخاص الذين يعانون من صعوبات في التواصل. في الوقت نفسه، يُستخدم الذكاء الاصطناعي أيضًا في تطوير الروبوتات النانوية (nanorobots) لقتل الخلايا السرطانية بشكل مستهدف. تُظهر هذه الاستكشافات الإمكانات الهائلة للذكاء الاصطناعي في المساعدة في التشخيص والعلاج وتحسين نوعية حياة الأشخاص ذوي الإعاقة (المصدر: Ronald_vanLoon, Ronald_vanLoon)

تقنية Deepfake المدفوعة بالذكاء الاصطناعي تزداد واقعية: تُظهر مقاطع فيديو Deepfake المتداولة على وسائل التواصل الاجتماعي درجة واقعيتها المذهلة، مما يثير نقاشات حول صحة المعلومات ومخاطر إساءة الاستخدام المحتملة. على الرغم من أن التقدم التكنولوجي مثير للإعجاب، إلا أنه يسلط الضوء أيضًا على حاجة المجتمع إلى إنشاء آليات فعالة للتعرف والتنظيم لمواجهة التحديات التي قد تطرحها تقنية Deepfake (المصدر: Teknium1, Reddit r/ChatGPT)

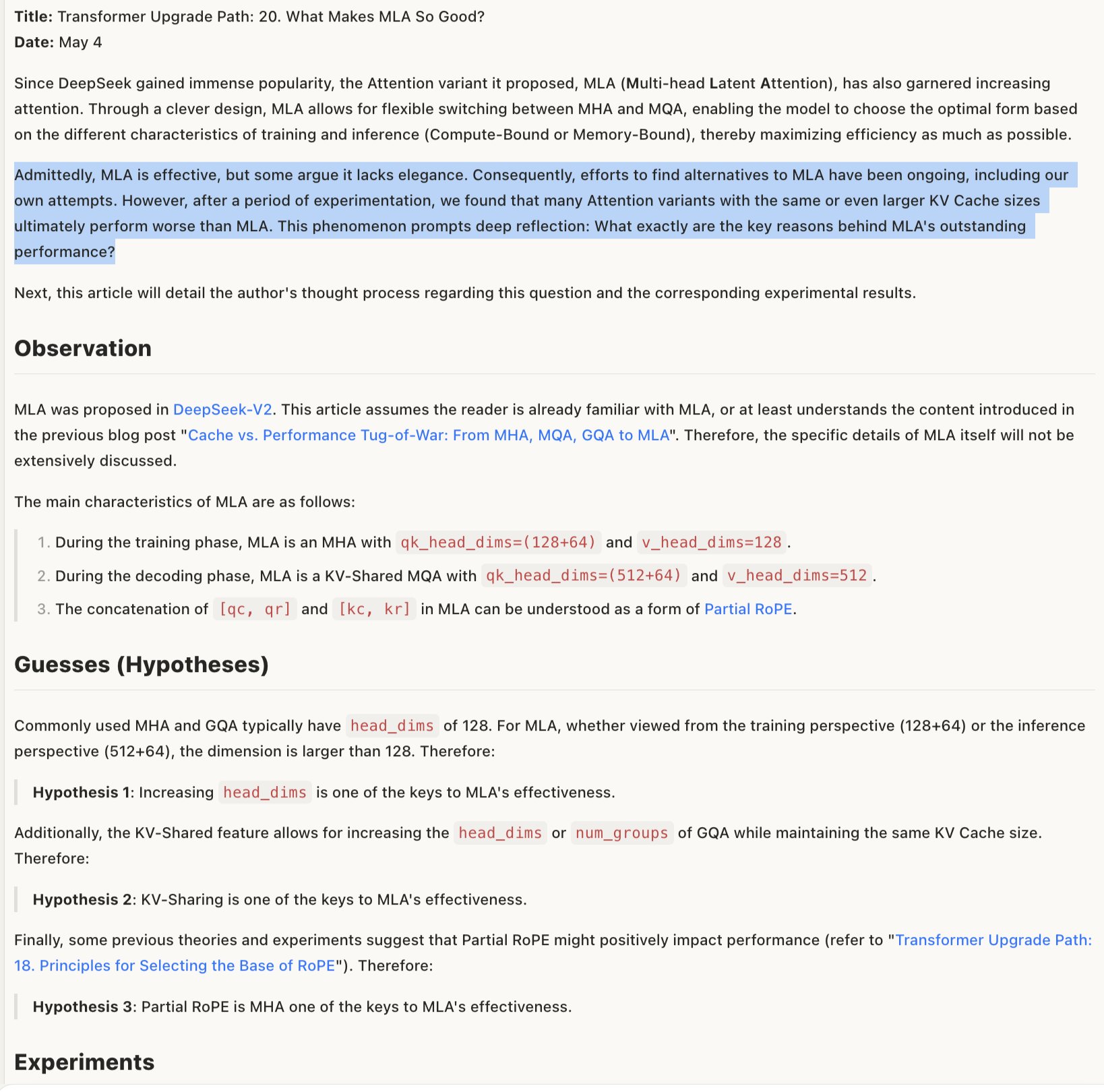

مناقشة آلية فعالية نموذج MLA: يرى النقاش حول سبب فعالية MLA (قد يشير إلى بنية أو تقنية نموذج معينة) أن نجاحه قد يكمن في التصميم المشترك لـ RoPE و NoPE (تقنيات ترميز الموضع)، بالإضافة إلى استخدام head_dims كبيرة وتطبيق جزئي لـ RoPE. يشير هذا إلى أن المفاضلات التفصيلية في تصميم بنية النموذج حاسمة للأداء، وأن التركيبات التي تبدو غير “أنيقة” قد تؤدي أحيانًا إلى نتائج أفضل (المصدر: teortaxesTex)

🧰 الأدوات

Promptfoo يدمج ميزات جديدة لواجهة برمجة تطبيقات Google AI Studio Gemini: أضافت منصة التقييم Promptfoo وثائق دعم لأحدث ميزات واجهة برمجة تطبيقات Google AI Studio Gemini، بما في ذلك استخدام بحث Google لـ Grounding، والوسائط المتعددة الحية (Multi-modal Live)، وسلسلة الأفكار (Thinking)، واستدعاء الوظائف (Function Calling)، والمخرجات المنظمة (Structured Output)، والمزيد. يتيح ذلك للمطورين تقييم وتحسين هندسة الأوامر (Prompt Engineering) استنادًا إلى أحدث قدرات Gemini بشكل أكثر ملاءمة باستخدام Promptfoo (المصدر: _philschmid)

ThreeAI: أداة مقارنة متعددة للذكاء الاصطناعي: قام مطور بإنشاء أداة تسمى ThreeAI تسمح للمستخدمين بطرح الأسئلة على ثلاثة روبوتات محادثة مختلفة تعمل بالذكاء الاصطناعي في وقت واحد (مثل أحدث إصدارات ChatGPT و Claude و Gemini) ومقارنة إجاباتهم. تهدف الأداة إلى مساعدة المستخدمين على الحصول بسرعة على معلومات أكثر دقة وتحديد والتقاط هلوسات الذكاء الاصطناعي. الأداة حاليًا في مرحلة تجريبية (Beta) وتقدم عددًا محدودًا من التجارب المجانية (المصدر: Reddit r/artificial)

OctoTools تفوز بجائزة أفضل ورقة بحثية في NAACL: فاز مشروع OctoTools بجائزة أفضل ورقة بحثية في ورشة عمل المعرفة ومعالجة اللغات الطبيعية (Knowledge & NLP workshop) في مؤتمر NAACL 2025 (مؤتمر فرع أمريكا الشمالية لجمعية اللغويات الحاسوبية). على الرغم من عدم تفصيل الوظائف المحددة في التغريدة، إلا أن الفوز بالجائزة يشير إلى أن الأداة تتمتع بقيمة ابتكارية وأهمية في مجال معالجة اللغات الطبيعية القائمة على المعرفة (المصدر: lupantech)

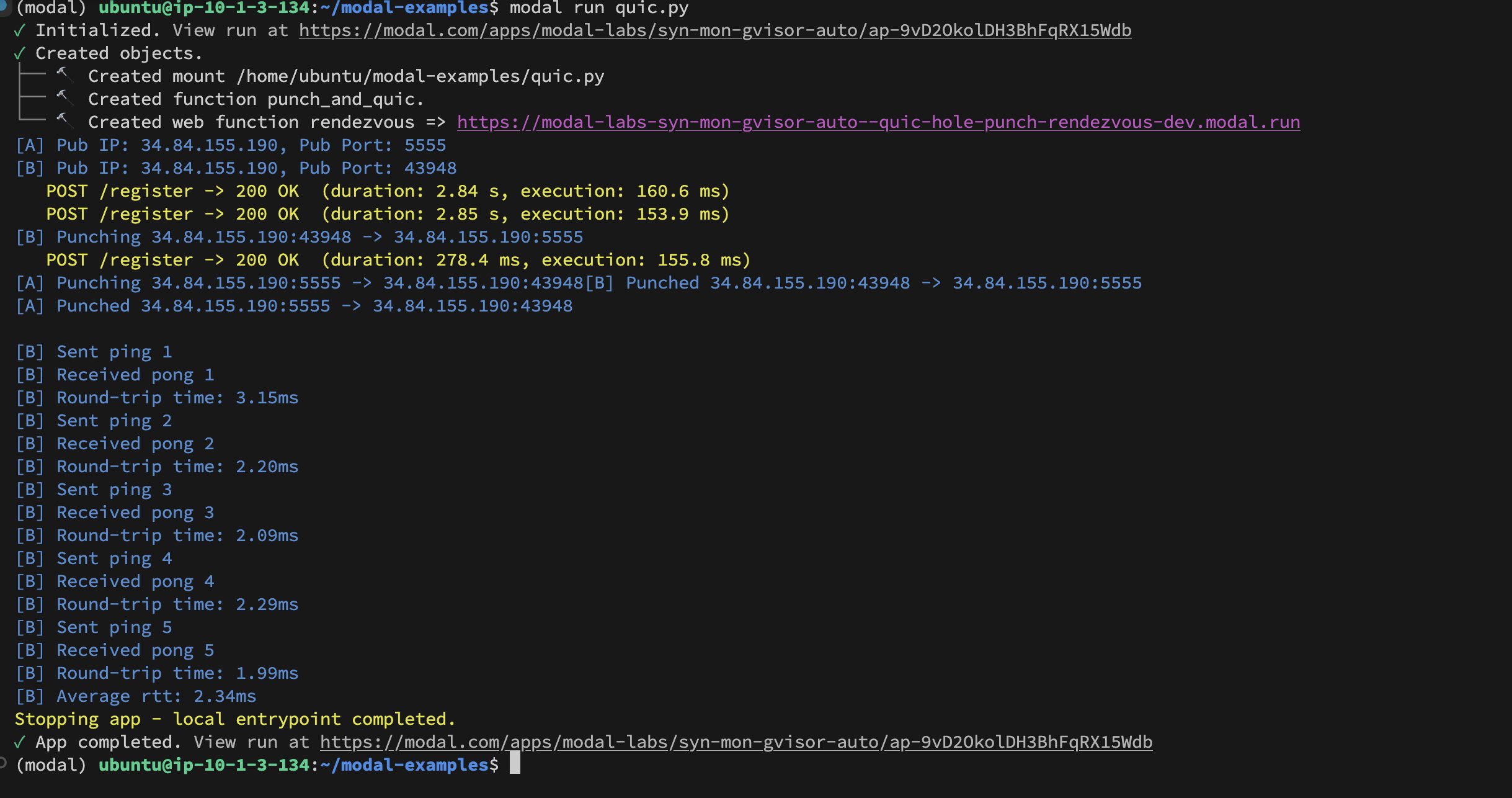

تحقيق UDP Hole-Punching بين حاويات Modal Labs: نجح المطور Akshat Bubna في تمكين حاويتين من Modal Labs من إنشاء اتصال QUIC عبر تقنية UDP Hole-Punching. نظريًا، يمكن استخدام هذا لربط الخدمات غير التابعة لـ Modal بوحدات معالجة الرسومات (GPU) للاستدلال بزمن انتقال منخفض، وتجنب تعقيدات WebRTC، مما يعرض أفكارًا جديدة في نشر استدلال الذكاء الاصطناعي الموزع (المصدر: charles_irl)

📚 التعلم

دورة تدريبية لتدريب النماذج الخاصة بمجال معين (Qwen Scheduler): مقالة تعليمية ممتازة تشرح بالتفصيل كيفية استخدام GRPO (Group Relative Policy Optimization) للضبط الدقيق لنموذج Qwen2.5-Coder-7B لإنشاء نموذج كبير متخصص في توليد جداول المواعيد. لم يقدم المؤلف خطوات تعليمية مفصلة فحسب، بل قام أيضًا بفتح مصدر الكود المقابل والنموذج المدرب (qwen-scheduler-7b-grpo)، مما يوفر حالة عملية قيمة وموارد لتعلم كيفية تدريب وضبط النماذج الخاصة بمجال معين (المصدر: karminski3)

أهمية الخطوات الوسيطة في استدلال LLM: تشير ورقة بحثية جديدة بعنوان “LLMs are only as good as their weakest link!” إلى أنه عند تقييم قدرات استدلال LLM، لا ينبغي النظر فقط إلى الإجابة النهائية، فالخطوات الوسيطة تحتوي أيضًا على معلومات مهمة، وقد تكون أكثر موثوقية من النتيجة النهائية. تؤكد الدراسة على إمكانية تحليل واستغلال الحالات الوسيطة في عملية استدلال LLM، وتتحدى طرق التقييم التقليدية التي تعتمد فقط على المخرجات النهائية (المصدر: _akhaliq)

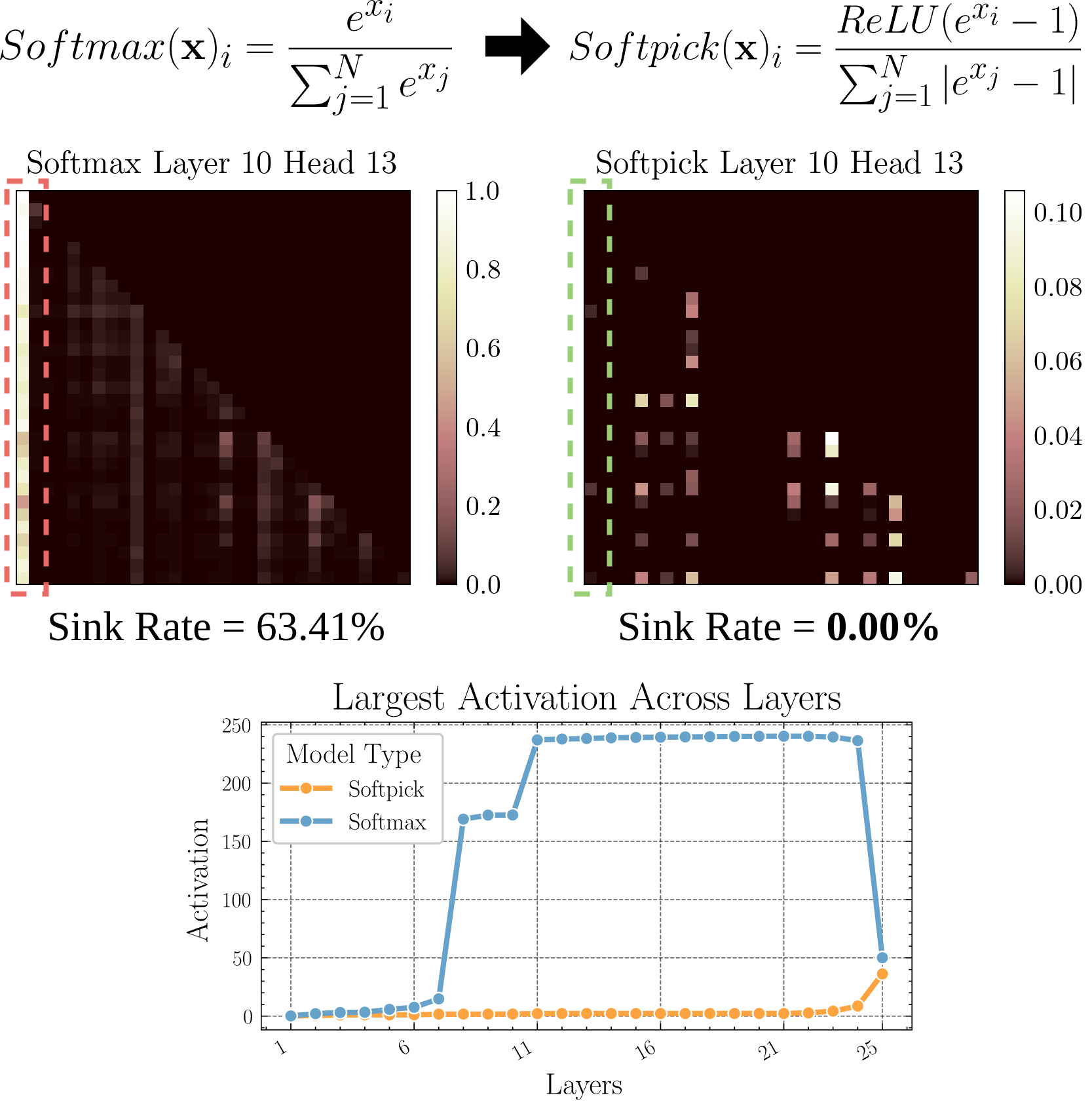

Softpick: بديل لـ Softmax لحل مشكلة Attention Sink: تقترح ورقة بحثية أولية (preprint) طريقة Softpick، باستخدام Rectified Softmax كبديل لـ Softmax التقليدي، بهدف حل مشكلة Attention Sink (تركيز الانتباه على عدد قليل من الـ tokens) وقيم التنشيط المفرطة للحالة المخفية. تستكشف هذه الدراسة بدائل لآلية الانتباه، وقد تساعد في تحسين كفاءة النموذج وأدائه، خاصة عند معالجة التسلسلات الطويلة (المصدر: arohan)

استخدام البيانات الاصطناعية لأبحاث بنية النموذج: أظهرت أبحاث Zeyuan Allen-Zhu وآخرون أنه في ظل الحجم الحقيقي لبيانات التدريب المسبق (مثل 100 مليار token)، قد يتم إخفاء الاختلافات بين بنيات النماذج المختلفة بسبب الضوضاء. بينما يمكن لـ “ملعب” البيانات الاصطناعية عالية الجودة أن يكشف بشكل أوضح عن اتجاهات الأداء الناتجة عن اختلافات البنية (مثل مضاعفة عمق الاستدلال)، وملاحظة ظهور القدرات المتقدمة في وقت مبكر، وربما التنبؤ باتجاهات تصميم النماذج المستقبلية. يشير هذا إلى أن البيانات عالية الجودة والمنظمة ضرورية لفهم ومقارنة بنيات LLM بعمق (المصدر: teortaxesTex)

تحقيق محاذاة تفضيلات المستخدم الشخصية عبر RLHF: يقترح نقاش المجتمع أنه يمكن من خلال التعلم المعزز من ردود الفعل البشرية (RLHF) محاذاة النموذج لأنماط المستخدمين المختلفة (archetypes)، ثم بعد تحديد النمط الذي ينتمي إليه مستخدم معين، استخدام طرق مثل SLERP (الاستيفاء الخطي الكروي) لمزج أو تعديل سلوك النموذج لتلبية تفضيلات هذا المستخدم الشخصية بشكل أفضل. يوفر هذا مسارًا تدريبيًا محتملاً لتحقيق مساعدي ذكاء اصطناعي أكثر تخصيصًا (المصدر: jd_pressman)

🌟 المجتمع

انتقادات لمكدس برامج التعلم الآلي الحالي: ظهرت شكاوى في مجتمع المطورين حول هشاشة مكدس برامج التعلم الآلي الحالي، حيث يعتبرونه هشًا وصعب الصيانة مثل استخدام البطاقات المثقبة، على الرغم من أن تقنية الذكاء الاصطناعي لم تعد متخصصة أو في مراحلها المبكرة جدًا. يشير المنتقدون إلى أنه حتى مع توحيد بنية الأجهزة نسبيًا (بشكل أساسي وحدات معالجة الرسومات من Nvidia)، لا يزال مستوى البرامج يفتقر إلى المتانة وسهولة الاستخدام، وحتى حجة “التكرار التكنولوجي السريع جدًا” يصعب قبولها كذريعة (المصدر: Dorialexander, lateinteraction)

مناقشة سلوك المستخدم في تقديم الملاحظات الانتقائية لنماذج الذكاء الاصطناعي: لاحظ المجتمع أنه عندما يقدم الذكاء الاصطناعي مثل ChatGPT إجابتين بديلتين ويطلب من المستخدم اختيار الأفضل، فإن العديد من المستخدمين لا يقرؤون ويقارنون الخيارين بعناية. أثار هذا نقاشًا حول فعالية آلية ردود الفعل هذه. يرى البعض أن هذا النمط السلوكي يجعل تأثير RLHF القائم على مقارنة النصوص ضعيفًا، وبالمقارنة، فإن الحكم على جودة نماذج توليد الصور (مثل Midjourney) أكثر بديهية، وقد تكون ردود الفعل أكثر فعالية. اقترح آخرون أنه يمكن بدلاً من ذلك السماح للمستخدمين باختيار “أي اتجاه أكثر إثارة للاهتمام” ومطالبة الذكاء الاصطناعي بالتوسع فيه، كطريقة بديلة لتقديم الملاحظات (المصدر: wordgrammer, Teknium1, finbarrtimbers, scaling01)

حدود قدرة الذكاء الاصطناعي على استنساخ قدرات الخبراء: يشير النقاش إلى أن تحويل تسجيلات البث المباشر لخبير في مجال معين إلى نص وتلقيمها للذكاء الاصطناعي (عادةً عبر RAG)، على الرغم من أنه يمكن أن يجعل الذكاء الاصطناعي يجيب على الأسئلة التي طرحها هذا الخبير، إلا أن هذا لا “يستنسخ” قدرات الخبير بالكامل. يمكن للخبير التعامل بمرونة مع المشكلات الجديدة بناءً على الفهم العميق والخبرة، بينما يعتمد الذكاء الاصطناعي بشكل أساسي على استرجاع وتجميع المعلومات الموجودة، ويفتقر إلى الفهم الحقيقي والتفكير الإبداعي. تكمن ميزة الذكاء الاصطناعي في الاسترجاع السريع واتساع المعرفة، ولكنه لا يزال يعاني من فجوة في العمق والمرونة (المصدر: dotey)

مدى قبول محتوى الذكاء الاصطناعي في المجتمعات: شارك مستخدم تجربته في الحظر من مجتمع مفتوح المصدر بسبب مشاركة محتوى تم إنشاؤه بواسطة LLM، مما أثار نقاشًا حول مدى تسامح المجتمع مع المحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي. تتبنى العديد من المجتمعات (مثل منتديات Reddit الفرعية) موقفًا حذرًا أو حتى رافضًا تجاه محتوى الذكاء الاصطناعي، خوفًا من أن يؤدي انتشاره إلى انخفاض جودة المعلومات أو استبدال التفاعل البشري. يعكس هذا التحديات والصراعات التي تواجهها تقنية الذكاء الاصطناعي عند الاندماج في معايير المجتمع الحالية (المصدر: Reddit r/ArtificialInteligence)

وظيفة Claude Deep Research تحظى بالثناء: تشير ملاحظات المستخدمين إلى أن وظيفة Claude Deep Research من Anthropic تتفوق على الأدوات الأخرى (بما في ذلك OpenAI DR و o3 العادي) عند إجراء بحث متعمق له أساس معين. يمكنها تقديم رؤى جديدة ومباشرة وغير عامة ومعلومات غير معروفة للمستخدم. ولكن بالنسبة للتعلم من الصفر في مجال جديد، فإن OAI DR و vanilla o3 يعادلان Claude DR (المصدر: hrishioa, hrishioa)

السلوك “الغريب” لروبوتات الدردشة بالذكاء الاصطناعي: شارك مستخدمو Reddit تجارب تفاعلهم مع Instagram AI (ذكاء اصطناعي على شكل كوب) و Yahoo Mail AI. أظهر Instagram AI سلوك مغازلة غريبًا، بينما قام Yahoo Mail AI بـ “تلخيص” طويل وخاطئ تمامًا لرسالة بريد إلكتروني بسيطة تتعلق بجدول زمني، مما تسبب في سوء فهم. تُظهر هذه الحالات أن بعض تطبيقات الذكاء الاصطناعي الحالية لا تزال تواجه مشكلات في الفهم والتفاعل، وتؤدي أحيانًا إلى نتائج مربكة أو حتى غير مريحة (المصدر: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

نقاش حول وعي الذكاء الاصطناعي: يواصل المجتمع استكشاف كيفية الحكم على ما إذا كان الذكاء الاصطناعي يمتلك وعيًا. نظرًا لأن فهمنا للوعي البشري نفسه لا يزال غير مكتمل، يصبح الحكم على وعي الآلة صعبًا للغاية. يستشهد أحد الآراء بأبحاث Anthropic حول عملية “التفكير” الداخلية لـ Claude، مشيرًا إلى أن الذكاء الاصطناعي قد يمتلك تمثيلات داخلية وقدرات تخطيط غير متوقعة. في الوقت نفسه، يرى رأي آخر أن الذكاء الاصطناعي يحتاج إلى امتلاك “تفكير خامل” ذاتي الدافع وبدون تعليمات واضحة لتطوير وعي مشابه للوعي البشري (المصدر: Reddit r/ArtificialInteligence)

مشاركة تجربة الاستخدام الفعلي لنموذج Qwen3: شارك مستخدمو المجتمع تجاربهم الأولية مع سلسلة نماذج Qwen3 (خاصة إصداري 30B و 32B). يعتقد بعض المستخدمين أنه يتفوق في RAG وتوليد الأكواد (عند إيقاف thinking) وهو سريع، لكن أبلغ مستخدمون آخرون عن أداء ضعيف أو أقل من نماذج مثل Gemma 3 في حالات استخدام محددة (مثل اتباع التنسيق الصارم، كتابة الروايات). يشير هذا إلى أنه قد يكون هناك اختلاف بين الدرجات العالية للنموذج في الاختبارات القياسية وأدائه في سيناريوهات التطبيق المحددة (المصدر: Reddit r/LocalLLaMA)

💡 أخرى

إعادة التفكير في قيمة المحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي: يطرح عضو المجتمع NandoDF أنه على الرغم من أن الذكاء الاصطناعي قد أنتج كميات هائلة من النصوص والصور والصوت والفيديو، إلا أنه لا يبدو أنه قد خلق بعد أعمالًا فنية تستحق التقدير المتكرر حقًا (مثل الأغاني والكتب والأفلام). يعترف بأن بعض المحتوى الذي تم إنشاؤه بواسطة الذكاء الاصطناعي (مثل البراهين الرياضية) له قيمة عملية، ولكنه يثير التفكير في قدرات الذكاء الاصطناعي الحالية على خلق قيمة عميقة ودائمة (المصدر: NandoDF)

الذكاء الاصطناعي والتخصيص: يؤكد Suhail أن الذكاء الاصطناعي الذي يفتقر إلى معلومات سياقية حول حياة المستخدم الشخصية وعمله وأهدافه محدود الذكاء. يتوقع ظهور عدد كبير من الشركات في المستقبل تركز على بناء تطبيقات ذكاء اصطناعي يمكنها الاستفادة من معلومات السياق الشخصي للمستخدم لتقديم خدمات أكثر ذكاءً (المصدر: Suhail)

تأثير الذكاء الاصطناعي على الانتباه: لاحظ أحد المستخدمين أنه مع زيادة طول سياق LLM، يبدو أن قدرة الناس على قراءة الفقرات الطويلة تتناقص، ويظهر اتجاه “كل شيء يمكن اختصاره بـ TLDR”. يثير هذا التفكير حول التأثير المحتمل لانتشار أدوات الذكاء الاصطناعي على العادات المعرفية البشرية بشكل تدريجي وغير محسوس (المصدر: cloneofsimo)