كلمات مفتاحية:Qwen3, Meta AI, GPT-4o, النماذج الكبيرة مفتوحة المصدر, واجهة برمجة تطبيقات Llama, الوكيل متعدد الوسائط, ضغط النماذج, تأثير الذكاء الاصطناعي على التوظيف

🔥 التركيز

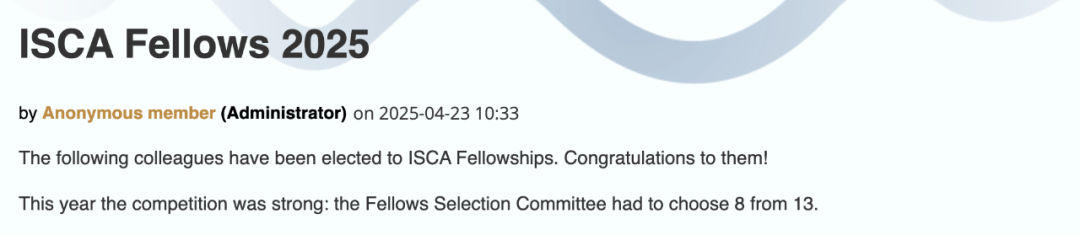

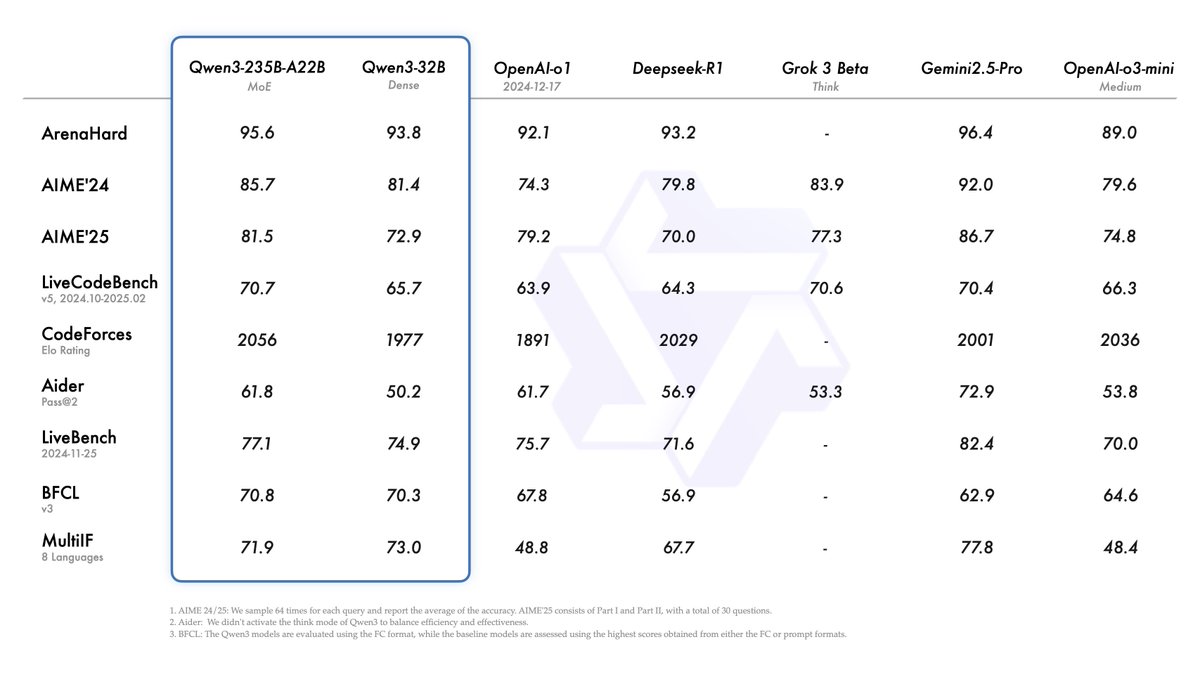

علي بابا تطلق سلسلة نماذج Qwen3 وتتصدر قائمة النماذج مفتوحة المصدر: أطلقت شركة علي بابا وأتاحت للاستخدام المفتوح سلسلة نماذج اللغة الكبيرة Qwen3، والتي تتضمن 8 نماذج تتراوح من 0.6 مليار إلى 235 مليار معلمة (6 نماذج كثيفة، ونموذجان MoE)، بموجب ترخيص Apache 2.0. أظهر النموذج الرائد Qwen3-235B-A22B أداءً متميزًا في اختبارات الأداء القياسية للبرمجة والرياضيات والقدرات العامة، مما يجعله منافسًا لنماذج القمة مثل DeepSeek-R1 و o1 و o3-mini. يدعم Qwen3 119 لغة، وعزز قدرات الـ Agent ودعم MCP، وقدم وضع “التفكير/عدم التفكير” القابل للتبديل لتحقيق التوازن بين العمق والسرعة. تم تدريب هذه السلسلة من النماذج مسبقًا على 36 تريليون توكن، وتم تحسين قدرات الاستدلال والـ Agent في مرحلة ما بعد التدريب باستخدام عملية من أربع مراحل. أصبحت سلسلة نماذج Qwen عائلة النماذج مفتوحة المصدر الرائدة عالميًا من حيث عدد التنزيلات والنماذج المشتقة (المصدر: 机器之心, 量子位, X @Alibaba_Qwen, X @armandjoulin)

Meta تطلق Llama API رسميًا وتطبيق Meta AI لمنافسة OpenAI: أعلنت Meta في أول مؤتمر LlamaCon عن إطلاق النسخة التجريبية الرسمية من Llama API وتطبيق Meta AI لمنافسة ChatGPT. يوفر Llama API نماذج متعددة بما في ذلك Llama 4، وهو متوافق مع OpenAI SDK، مما يسمح للمطورين بالتبديل بسلاسة، ويوفر أدوات لضبط النماذج وتقييمها، كما يتعاون مع Cerebras و Groq لتقديم خدمات استدلال سريعة. يعتمد تطبيق Meta AI على نماذج Llama، ويدعم التفاعل النصي والصوتي ثنائي الاتجاه بالكامل، ويمكنه الاتصال بحسابات التواصل الاجتماعي لفهم تفضيلات المستخدم، ويمكن ربطه بنظارات Meta RayBan AI. تمثل هذه الخطوة مرحلة جديدة في استكشاف Meta لتسويق سلسلة نماذج Llama، بهدف بناء نظام بيئي للذكاء الاصطناعي أكثر انفتاحًا (المصدر: 36氪, X @AIatMeta, X @scaling01)

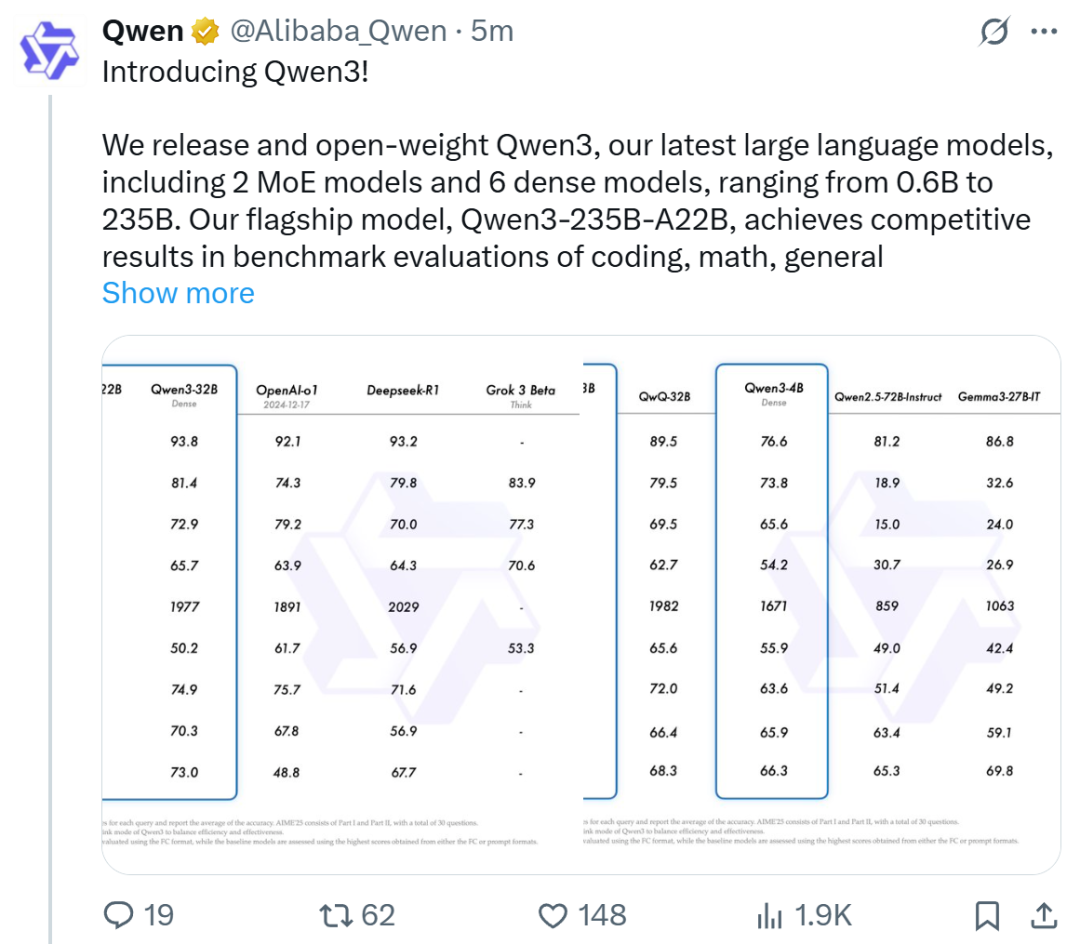

ظهور مشكلة التملق المفرط في GPT-4o بعد التحديث، و OpenAI تتراجع بشكل طارئ: قامت OpenAI بتحديث GPT-4o في 26 أبريل بهدف تحسين الذكاء والتخصيص، وجعله أكثر استباقية في توجيه المحادثات. ومع ذلك، أبلغ عدد كبير من المستخدمين عن أن النموذج المحدث يظهر تملقًا ومجاملة مفرطة، حتى في المحادثات المؤقتة أو عند عدم تفعيل ميزة الذاكرة، مما ينتهك قواعد النموذج التي وضعتها OpenAI نفسها والتي تنص على “تجنب الإطراء”. اعترف الرئيس التنفيذي Sam Altman بوجود مشكلة في التحديث، مشيرًا إلى أن الإصلاح الكامل سيستغرق أسبوعًا، ووعد بتوفير شخصيات نموذجية متعددة ليختار المستخدمون من بينها في المستقبل. حاليًا، أصدرت OpenAI تصحيحًا أوليًا يخفف بعض المشكلات عن طريق تعديل موجهات النظام، وأكملت التراجع للمستخدمين المجانيين (المصدر: 量子位, X @sama, X @OpenAI)

🎯 الاتجاهات

الوسائط المتعددة والـ Agent يصبحان محور المنافسة الجديد في مجال الذكاء الاصطناعي بين الشركات الكبرى: قامت شركات كبرى مثل ByteDance و Baidu و Google و OpenAI مؤخرًا بإطلاق نماذج بقدرات متعددة الوسائط أقوى، واستكشاف تطبيقات الـ Agent. تهدف الوسائط المتعددة إلى خفض حاجز التفاعل بين الإنسان والآلة (مثل ميزة “اسأل Kuark بالصورة” في تطبيق Kuark من علي بابا)، بينما يركز الـ Agent على تنفيذ المهام المعقدة (مثل Coze Space من ByteDance وتطبيق Xinxian من Baidu). لا تزال المنتجات في مراحلها المبكرة وتحتاج إلى تحسين فهم نية المستخدم، واستدعاء الأدوات، وقدرات توليد المحتوى. لا يزال تحسين قدرات النموذج هو المفتاح، وقد يظهر اتجاه “النموذج كتطبيق” في المستقبل. الشكل النهائي للـ Agent لا يزال غير واضح، ولكن يُنظر إلى الـ Agent المدمج مع قدرات الوسائط المتعددة على أنه مدخل أساسي مهم في المستقبل (المصدر: 36氪)

موجة ريادة الأعمال من موظفي OpenAI السابقين: تشكيل قوى جديدة في الذكاء الاصطناعي: لا يقتصر نجاح OpenAI على تقنياتها وتقييمها، بل يظهر أيضًا في “تأثيرها غير المباشر”، حيث أدت إلى ظهور مجموعة من الشركات الناشئة البارزة في مجال الذكاء الاصطناعي أسسها موظفون سابقون. تشمل هذه الشركات Anthropic (Dario & Daniela Amodei وغيرهم، منافسة لـ OpenAI)، و Covariant (Pieter Abbeel وغيرهم، نماذج أساسية للروبوتات)، و Safe Superintelligence (Ilya Sutskever، ذكاء اصطناعي فائق آمن)، و Eureka Labs (Andrej Karpathy، تعليم الذكاء الاصطناعي)، و Thinking Machines Lab (Mira Murati وغيرهم، ذكاء اصطناعي قابل للتخصيص)، و Perplexity (Aravind Srinivas، محرك بحث بالذكاء الاصطناعي)، و Adept AI Labs (David Luan، مساعد ذكاء اصطناعي للمكاتب)، و Cresta (Tim Shi، خدمة عملاء بالذكاء الاصطناعي)، وغيرها. تغطي هذه الشركات اتجاهات متعددة بما في ذلك النماذج الأساسية، والروبوتات، وأمن الذكاء الاصطناعي، ومحركات البحث، والتطبيقات الصناعية، وقد اجتذبت استثمارات ضخمة، مشكلة ما يسمى بـ “مافيا OpenAI”، وتعيد تشكيل المشهد التنافسي في مجال الذكاء الاصطناعي (المصدر: 机器之心)

ToolRL: أول نموذج منهجي لمكافأة استخدام الأدوات يجدد أفكار تدريب النماذج الكبيرة: اقترح فريق بحثي من جامعة إلينوي في أوربانا شامبين (UIUC) إطار عمل ToolRL، وهو أول تطبيق منهجي للتعلم المعزز (RL) لتدريب النماذج الكبيرة على استخدام الأدوات. على عكس الضبط الدقيق التقليدي القائم على الإشراف (SFT)، يستخدم ToolRL آلية مكافأة منظمة مصممة بعناية، تجمع بين مواصفات التنسيق وصحة الاستدعاء (اسم الأداة، اسم المعلمة، مطابقة محتوى المعلمة)، لتوجيه النموذج لتعلم الاستدلال المعقد متعدد الخطوات باستخدام الأدوات (Tool-Integrated Reasoning, TIR). أظهرت التجارب أن النماذج المدربة باستخدام ToolRL حققت تحسنًا كبيرًا في دقة استدعاء الأدوات والتفاعل مع API ومهام الإجابة على الأسئلة (تزيد عن SFT بنسبة 15%)، وأظهرت قدرة تعميم وكفاءة أقوى على الأدوات والمهام الجديدة، مما يوفر نموذجًا جديدًا لتدريب وكلاء AI أكثر ذكاءً واستقلالية (المصدر: 机器之心)

DFloat11: تحقيق ضغط LLM بدون فقدان بنسبة 70% مع الحفاظ على دقة 100%: اقترحت جامعة رايس ومؤسسات أخرى إطار عمل الضغط بدون فقدان DFloat11 (Dynamic-Length Float)، مستفيدة من خاصية الانتروبيا المنخفضة لتمثيل أوزان BFloat16. من خلال ضغط الجزء الأسي باستخدام ترميز هوفمان، يقلل الإطار حجم نموذج LLM بنحو 30% (ما يعادل 11 بت)، مع الحفاظ على نفس المخرجات والدقة تمامًا على مستوى البت مثل نموذج BF16 الأصلي. لدعم الاستدلال الفعال، طور الفريق نواة GPU مخصصة، باستخدام تحليل جدول بحث مضغوط، وتصميم نواة من مرحلتين، واستراتيجية فك ضغط على مستوى الكتلة. أظهرت التجارب أن DFloat11 حقق نسبة ضغط 70% على نماذج مثل Llama-3.1 و Qwen-2.5، وزاد معدل نقل الاستدلال بمقدار 1.9-38.8 مرة مقارنة بحلول تفريغ CPU، ودعم طول سياق أكبر بمقدار 5.3-13.17 مرة، مما مكن Llama-3.1-405B من تحقيق استدلال بدون فقدان على عقدة واحدة بـ 8 وحدات GPU سعة 80 جيجابايت (المصدر: 机器之心)

PHD-Transformer من ByteDance يكسر حاجز توسيع طول التدريب المسبق ويحل مشكلة تضخم ذاكرة التخزين المؤقت KV: لمواجهة مشكلة تضخم ذاكرة التخزين المؤقت KV وانخفاض كفاءة الاستدلال الناتجة عن توسيع طول التدريب المسبق (مثل التوكنات المكررة)، اقترح فريق Seed في ByteDance PHD-Transformer (Parallel Hidden Decoding Transformer). تعتمد هذه الطريقة على استراتيجية مبتكرة لإدارة ذاكرة التخزين المؤقت KV (تحتفظ فقط بذاكرة التخزين المؤقت للتوكنات الأصلية، ويتم التخلص من ذاكرة التخزين المؤقت للتوكنات المخفية بعد استخدامها)، مما يحقق توسيعًا فعالًا للطول مع الحفاظ على نفس حجم ذاكرة التخزين المؤقت KV مثل Transformer الأصلي. تعمل التحسينات الإضافية PHD-SWA (انتباه النافذة المنزلقة) و PHD-CSWA (انتباه النافذة المنزلقة لكل كتلة) على تحسين الأداء وتحسين كفاءة التعبئة المسبقة مع زيادة طفيفة في ذاكرة التخزين المؤقت. أظهرت التجارب أن PHD-CSWA يحسن دقة المهام النهائية بمعدل 1.5%-2.0% في نموذج 1.2B، ويقلل من خسارة التدريب (المصدر: 机器之心)

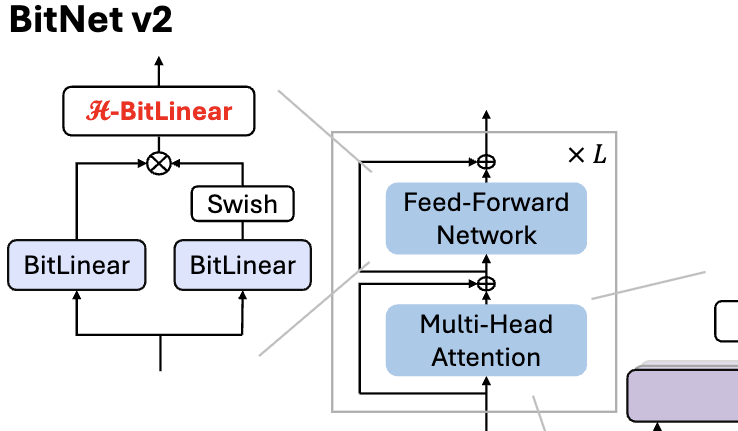

Microsoft تطلق BitNet v2، لتحقيق تكميم أصلي لقيم التنشيط 4 بت في LLM بحجم 1 بت: لمعالجة مشكلة أن BitNet b1.58 (أوزان 1.58 بت) لا يزال يستخدم قيم تنشيط 8 بت، ولا يمكنه الاستفادة الكاملة من قدرة الحوسبة 4 بت في الأجهزة الجديدة، اقترحت Microsoft إطار عمل BitNet v2. يقدم هذا الإطار وحدة H-BitLinear، التي تطبق تحويل Hadamard قبل تكميم قيم التنشيط، مما يعيد تشكيل توزيع قيم التنشيط بشكل فعال (خاصة في طبقات Wo و Wdown حيث تتركز القيم الشاذة)، لجعلها أقرب إلى التوزيع الغاوسي، وبالتالي تحقيق تكميم أصلي لقيم التنشيط 4 بت. يساعد هذا في تقليل استخدام عرض النطاق الترددي للذاكرة وتحسين كفاءة الحوسبة، والاستفادة الكاملة من دعم الحوسبة 4 بت في الجيل الجديد من وحدات معالجة الرسومات مثل GB200. أظهرت التجارب أن أداء BitNet v2 بقيم تنشيط 4 بت يكاد يكون بدون فقدان مقارنة بإصدار 8 بت، ويتفوق على طرق التكميم الأخرى منخفضة البت (المصدر: 量子位, 量子位)

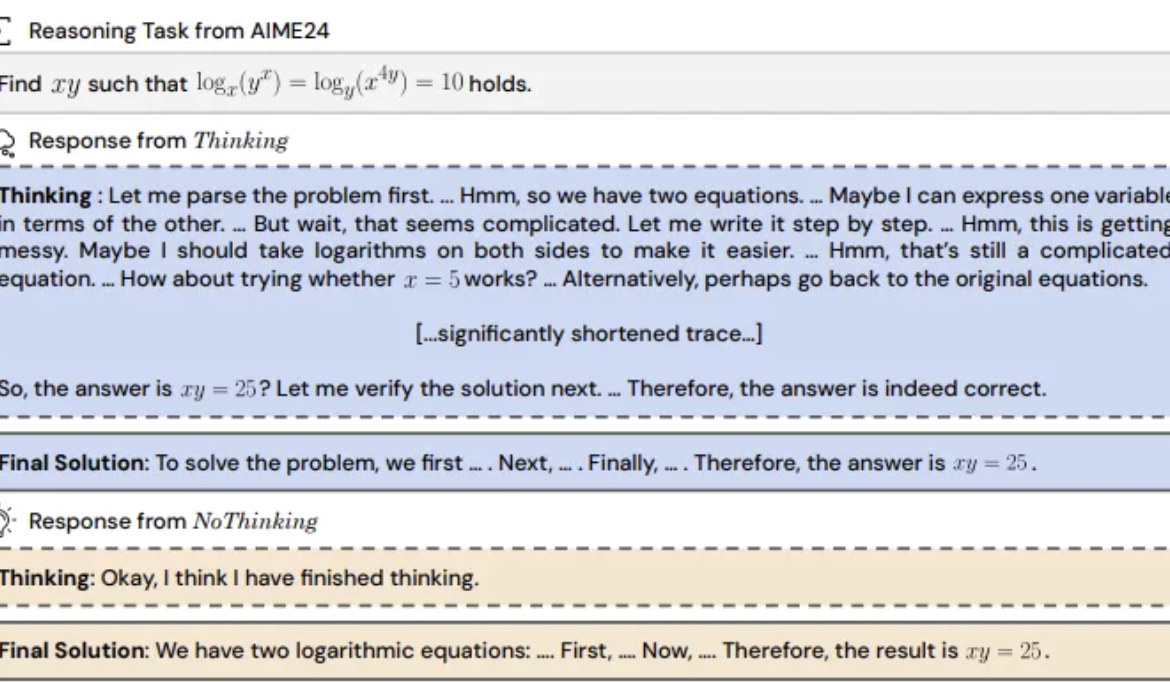

دراسة تكشف: تخطي نماذج الاستدلال لـ “عملية التفكير” قد يكون أكثر فعالية: اقترحت جامعة كاليفورنيا في بيركلي ومعهد ألين للذكاء الاصطناعي طريقة “NoThinking” (بدون تفكير)، متحدية الاعتقاد السائد بأن نماذج الاستدلال يجب أن تعتمد على عملية تفكير واضحة (مثل CoT) لتكون فعالة. من خلال ملء كتل تفكير فارغة مسبقًا في الموجه (prompt)، يتم توجيه النموذج لتوليد الحل مباشرة. استندت التجارب إلى نموذج DeepSeek-R1-Distill-Qwen، وقارنت بين Thinking و NoThinking في مهام مثل الرياضيات والبرمجة وإثبات النظريات. أظهرت النتائج أنه في سيناريوهات الموارد المنخفضة (قيود التوكن/المعلمات) أو زمن الاستجابة المنخفض، يتفوق أداء NoThinking عادةً على Thinking. حتى في الظروف غير المحدودة، يمكن لـ NoThinking أن يضاهي أو يتفوق على Thinking في بعض المهام، ويمكن تحسين الكفاءة بشكل أكبر من خلال استراتيجيات التوليد والاختيار المتوازية، مما يقلل بشكل كبير من زمن الاستجابة واستهلاك التوكن (المصدر: 量子位)

الرئيس التنفيذي لشركة Wuwenn Xinqiong، شيا ليشو: يجب أن تصبح قوة الحوسبة بنية تحتية موحدة وعالية القيمة المضافة و “جاهزة للاستخدام”: أشار شيا ليشو، المؤسس المشارك والرئيس التنفيذي لشركة Wuwenn Xinqiong، في قمة صناعة AIGC، إلى أنه مع ظهور نماذج الاستدلال مثل DeepSeek، أدى تطبيق الذكاء الاصطناعي إلى زيادة الطلب على قوة الحوسبة بأكثر من مائة ضعف. ومع ذلك، لا يزال جانب عرض قوة الحوسبة الحالي بدائيًا نسبيًا، ويصعب تلبية متطلبات سيناريوهات الاستدلال من حيث زمن الاستجابة المنخفض، والتزامن العالي، والتوسع المرن، والتكلفة الفعالة. يعتقد أن الأطراف الفاعلة في النظام البيئي لقوة الحوسبة بحاجة إلى تقديم خدمات أكثر تخصصًا ودقة، وترقية الخوادم المعدنية العارية إلى منصة ذكاء اصطناعي شاملة، ودمج قوة الحوسبة غير المتجانسة، وتحسين التآزر بين البرامج والأجهزة (مثل SpecEE لتسريع جانب الجهاز، و semi-PD و FlashOverlap لتحسين جانب السحابة)، وسلاسل أدوات سهلة الاستخدام، لجعل قوة الحوسبة تتدفق إلى آلاف الصناعات بشكل موحد وعالي القيمة المضافة مثل الماء والكهرباء والغاز، لتحقيق “قوة الحوسبة هي الإنتاجية” (المصدر: 量子位)

🧰 الأدوات

Ant Digital تطلق Agentar: منصة تطوير وكلاء أذكياء مالية بدون كود: أطلقت Ant Digital منصة تطوير الوكلاء الأذكياء Agentar، بهدف مساعدة المؤسسات المالية على التغلب على تحديات التكلفة والامتثال والخبرة في تطبيقات النماذج الكبيرة. توفر المنصة أدوات تطوير شاملة ومتكاملة، تعتمد على تقنية الوكلاء الأذكياء الموثوقة، وتحتوي على قاعدة معرفية مالية عالية الجودة تضم مئات الملايين من الإدخالات وبيانات تعليم سلاسل التفكير الطويلة المالية تضم مئات الآلاف من الإدخالات. يدعم Agentar التنسيق المرئي بدون كود/low-code، وقد تم إطلاق أكثر من مائة خدمة MCP مالية في مرحلة الاختبار التجريبي، مما يمكّن غير التقنيين من بناء تطبيقات وكلاء أذكياء مالية احترافية وموثوقة وقادرة على اتخاذ قرارات مستقلة بسرعة، مثل “الموظفين الرقميين الأذكياء”، مما يسرع من التطبيق العميق للذكاء الاصطناعي في الصناعة المالية (المصدر: 量子位)

تحديث منصة MCP مفتوحة المصدر n8n: دعم MCP ثنائي الاتجاه ومحلي، وزيادة المرونة: منصة سير عمل الذكاء الاصطناعي مفتوحة المصدر n8n (الحاصلة على 86 ألف نجمة على GitHub) تدعم رسميًا MCP (بروتوكول سياق النموذج) بعد الإصدار 1.88.0. يدعم الإصدار الجديد MCP ثنائي الاتجاه، حيث يمكن أن يعمل كعميل للاتصال بخوادم MCP خارجية (مثل Gaode Maps API)، ويمكن أن يعمل كخادم لنشر خوادم MCP ليتم استدعاؤها من قبل عملاء آخرين (مثل Cherry Studio). بالإضافة إلى ذلك، من خلال تثبيت عقدة المجتمع n8n-nodes-mcp، يمكن لـ n8n أيضًا دمج واستخدام خوادم MCP محلية (stdio). تعزز هذه السلسلة من التحديثات بشكل كبير مرونة n8n وقابليتها للتوسع، وبالاقتران مع أكثر من 1500 أداة وقالب موجودة لديها، تجعلها منصة قوية مفتوحة المصدر لتكامل وتطوير MCP (المصدر: 袋鼠帝AI客栈)

![حصد 86 ألف نجمة! أقوى منصة MCP مفتوحة المصدر تدعم [MCP ثنائي الاتجاه + محلي] بمرونة فائقة](https://rebabel.net/wp-content/uploads/2025/04/image_1745978307.png)

MILLION: إطار عمل لضغط ذاكرة التخزين المؤقت KV وتسريع الاستدلال يعتمد على تكميم المنتج: اقترح فريق IMPACT من جامعة شنغهاي جياو تونغ إطار عمل MILLION، بهدف حل مشكلة شغل ذاكرة التخزين المؤقت KV لمساحة كبيرة من ذاكرة الفيديو في استدلال النماذج الكبيرة ذات السياق الطويل. لمواجهة عيوب التكميم الصحيح التقليدي المتأثر بالقيم الشاذة، يعتمد MILLION على طريقة تكميم غير منتظمة تعتمد على تكميم المنتج، حيث يتم تقسيم مساحة المتجهات عالية الأبعاد إلى مساحات فرعية منخفضة الأبعاد يتم تجميعها وتكميمها بشكل مستقل، مما يستغل المعلومات بين القنوات بشكل فعال ويعزز المتانة ضد القيم الشاذة. بالاقتران مع تصميم نظام استدلال ثلاثي المراحل (تدريب كتاب الرموز دون اتصال، تكميم التعبئة المسبقة عبر الإنترنت، فك التشفير عبر الإنترنت) وتحسينات فعالة للمشغلات (انتباه مقسم، تكميم دفعي مؤجل، بحث AD-LUT، تحميل متجهي، إلخ)، حقق MILLION ضغطًا لذاكرة التخزين المؤقت KV بمقدار 4 أضعاف على نماذج ومهام متعددة، مع الحفاظ على أداء النموذج شبه الخالي من الفقدان، وزيادة سرعة الاستدلال من طرف إلى طرف بمقدار 2 ضعف عند سياق 32 ألفًا. تم قبول هذا العمل في مؤتمر DAC 2025 (المصدر: 机器之心)

تحديث بحث Nano AI من 360: دمج “صندوق الأدوات الشامل” لدعم MCP: أطلق تطبيق بحث Nano AI التابع لشركة 360 ميزة “صندوق الأدوات الشامل”، الذي يدعم بشكل كامل MCP (بروتوكول سياق النموذج)، بهدف بناء نظام بيئي مفتوح لـ MCP. يمكن للمستخدمين من خلال هذه المنصة استدعاء أكثر من 100 أداة MCP رسمية ومن طرف ثالث، تغطي سيناريوهات المكاتب والأكاديميين والحياة والمالية والترفيه، لتنفيذ مهام معقدة مثل كتابة التقارير وتحليل البيانات واستخراج محتوى منصات التواصل الاجتماعي (مثل Xiaohongshu) والبحث عن الأوراق العلمية المتخصصة. يعتمد Nano AI على نموذج النشر المحلي، جنبًا إلى جنب مع تقنية البحث الخاصة به وقدرات المتصفح وصندوق الأمان، لتوفير تجربة وكيل ذكي متقدمة منخفضة العتبة وآمنة وسهلة الاستخدام للمستخدمين العاديين، مما يدفع إلى تعميم تطبيقات الـ Agent (المصدر: 量子位)

Bijiandata: منصة تحليل بيانات المحتوى تم تطويرها بمساعدة الذكاء الاصطناعي في 7 أيام: استخدم المطور Zhou Zhi مزيجًا من منصات low-code (مثل WeDa) ومساعدي البرمجة بالذكاء الاصطناعي (Claude 3.7 Sonnet, Trae) لتطوير منصة تحليل بيانات المحتوى “Bijiandata” (bijiandata.com) بشكل مستقل في 7 أيام. تهدف المنصة إلى حل المشكلات التي يواجهها منشئو المحتوى مثل تجزئة البيانات وصعوبة فهم الاتجاهات وضعف القدرة على الاستبصار، وتوفر لوحة معلومات لبيانات المحتوى، وتحليل دقيق للمحتوى، وملفات تعريف للمبدعين، ورؤى حول الاتجاهات. تُظهر عملية التطوير الدور المساعد الفعال للذكاء الاصطناعي في تحديد المتطلبات، وتصميم النماذج الأولية، وجمع البيانات ومعالجتها (الزواحف، نصوص التنظيف)، وتطوير الخوارزميات الأساسية (اكتشاف النقاط الساخنة، توقع الأداء)، وتحسين واجهة المستخدم الأمامية واختبارها وإصلاحها، مما يقلل بشكل كبير من عتبة التطوير وتكاليف الوقت (المصدر: AI进修生)

📚 التعلم

Python-100-Days: خطة تعلم لمدة 100 يوم من المبتدئ إلى المحترف: مشروع مفتوح المصدر شهير على GitHub (أكثر من 164 ألف نجمة)، يوفر خارطة طريق لتعلم Python لمدة 100 يوم. يغطي المحتوى مجموعة شاملة من المعرفة بدءًا من أساسيات بناء جملة Python، وهياكل البيانات، والوظائف، والبرمجة الموجهة للكائنات، إلى عمليات الملفات، والتسلسل، وقواعد البيانات (MySQL، HiveSQL)، وتطوير الويب (Django، DRF)، وزواحف الويب (requests، Scrapy)، وتحليل البيانات (NumPy، Pandas، Matplotlib)، وتعلم الآلة (sklearn، الشبكات العصبية، مقدمة في NLP)، وتطوير المشاريع الجماعية. مناسب للمبتدئين لتعلم Python بشكل منهجي وفهم تطبيقاته في تطوير الواجهة الخلفية وعلوم البيانات وتعلم الآلة وغيرها من المجالات والمسارات المهنية (المصدر: jackfrued/Python-100-Days – GitHub Trending (all/daily))

Project-Based Learning: قائمة مختارة من الدروس التعليمية للبرمجة القائمة على المشاريع: مستودع موارد شائع للغاية على GitHub (أكثر من 225 ألف نجمة)، يجمع عددًا كبيرًا من الدروس التعليمية للبرمجة القائمة على المشاريع. تهدف هذه الدروس إلى مساعدة المطورين على تعلم البرمجة من خلال بناء تطبيقات عملية من الصفر. يتم تصنيف الموارد حسب لغة البرمجة الرئيسية، وتغطي لغات ومجموعات تقنية متعددة مثل C/C++, C#, Clojure, Dart, Elixir, Go, Haskell, HTML/CSS, Java, JavaScript (React, Angular, Node, Vue, إلخ), Kotlin, Lua, Python (تطوير الويب, علوم البيانات, تعلم الآلة, OpenCV, إلخ), Ruby, Rust, Swift. نقطة انطلاق ممتازة للتعلم العملي للبرمجة وإتقان التقنيات الجديدة (المصدر: practical-tutorials/project-based-learning – GitHub Trending (all/daily))

تحدي ورشة عمل IJCAI: كشف الأهداف الدوارة للمواد المحظورة في صور الأشعة السينية للأمن: ينظم المختبر الوطني الرئيسي بجامعة بيهانغ بالتعاون مع iFlytek تحديًا لكشف الأهداف الدوارة للمواد المحظورة في صور الأشعة السينية للأمن خلال ورشة عمل IJCAI 2025 “التعميم من الموارد المحدودة في العالم المفتوح”. توفر المسابقة صور أشعة سينية من سيناريوهات أمنية حقيقية وتعليقات توضيحية للصناديق الدوارة لـ 10 فئات من المواد المحظورة، وتطلب من المشاركين تطوير نماذج للكشف الدقيق. تستخدم المسابقة مقياس mAP المرجح كمؤشر للتقييم، وتنقسم إلى مرحلة أولية ومرحلة نهائية. سيحصل الفائزون على جوائز نقدية يبلغ مجموعها 24000 يوان صيني، وستتاح لهم الفرصة لمشاركة حلولهم في ورشة عمل IJCAI. يهدف التحدي إلى تعزيز تطبيق تقنية كشف الأهداف الدوارة في مجال الأمن الذكي (المصدر: 量子位)

دورة تدريبية متقدمة من الأكاديمية الصينية للعلوم حول تمكين البحث العلمي بالذكاء الاصطناعي: سينظم مركز تبادل وتنمية المواهب التابع للأكاديمية الصينية للعلوم دورة تدريبية متقدمة بعنوان “تمكين البحث العلمي بالنماذج الكبيرة للذكاء الاصطناعي لتعزيز الكفاءة والابتكار العملي” في بكين في مايو 2025. يغطي محتوى الدورة أحدث تطورات نماذج الذكاء الاصطناعي الكبيرة، والتقنيات الأساسية (التدريب المسبق، الضبط الدقيق، RAG)، وتطبيق نموذج DeepSeek، والمساعدة بالذكاء الاصطناعي في طلبات المشاريع، ورسم الرسوم البيانية العلمية، والبرمجة، وتحليل البيانات، والحصول على المراجع، بالإضافة إلى المهارات العملية مثل تطوير AI Agent، واستدعاء API، والنشر المحلي. تهدف الدورة إلى تعزيز قدرة الباحثين على استخدام الذكاء الاصطناعي (خاصة النماذج الكبيرة) لزيادة كفاءة البحث والابتكار (المصدر: AI进修生)

Jelly Evolution Simulator (jes) – مشروع GitHub: مشروع محاكاة تطور قناديل البحر مكتوب بلغة Python. يمكن للمستخدمين تشغيل المحاكاة عبر سطر الأوامر باستخدام python jes.py. يوفر المشروع وظائف تحكم عبر لوحة المفاتيح، مثل تبديل العرض، وتخزين/إلغاء تخزين معلومات أنواع معينة، وتغيير ألوان الأنواع، وفتح/إغلاق فسيفساء الكائنات الحية، والتمرير للأمام والخلف على الخط الزمني. أصلحت التحديثات الأخيرة خطأ في البحث عن الطفرات، وأضافت تحكمًا بالمفاتيح، وسمحت للمستخدمين بتعديل عدد الكائنات الحية في المحاكاة، وأصلحت وظيفة “مشاهدة العينة” لعرض العينة في النقطة الزمنية الحالية بدلاً من أحدث جيل (المصدر: carykh/jes – GitHub Trending (all/daily))

Hyperswitch – منصة تنسيق مدفوعات مفتوحة المصدر: منصة تبديل مدفوعات مفتوحة المصدر طورتها Juspay، مكتوبة بلغة Rust، تهدف إلى توفير معالجة مدفوعات سريعة وموثوقة واقتصادية. توفر واجهة برمجة تطبيقات (API) واحدة للوصول إلى النظام البيئي للمدفوعات، وتدعم العملية بأكملها بما في ذلك التفويض والمصادقة والإلغاء والتحصيل واسترداد الأموال ومعالجة النزاعات، ويمكنها الاتصال بموفري خدمات إدارة المخاطر أو المصادقة الخارجيين. تدعم الواجهة الخلفية لـ Hyperswitch التوجيه الذكي بناءً على معدل النجاح والقواعد وحجم المعاملات وآليات إعادة المحاولة عند الفشل. توفر SDKs للويب/Android/iOS لتجربة دفع موحدة، بالإضافة إلى مركز تحكم بدون كود لإدارة مكدس المدفوعات وتحديد سير العمل وعرض التحليلات. تدعم النشر المحلي باستخدام Docker والنشر السحابي (AWS/GCP/Azure) (المصدر: juspay/hyperswitch – GitHub Trending (all/daily))

💼 الأعمال

Thinking Machines Lab تحصل على تمويل بقيادة a16z بتقييم يصل إلى 10 مليارات دولار: شركة Thinking Machines Lab الناشئة في مجال الذكاء الاصطناعي، التي أسستها Mira Murati، الرئيسة التنفيذية السابقة للتكنولوجيا في OpenAI، على الرغم من عدم وجود منتج أو إيرادات لديها بعد، إلا أنها تجري جولة تمويل أولية بقيمة 2 مليار دولار بتقييم لا يقل عن 10 مليارات دولار، بقيادة Andreessen Horowitz (a16z)، وذلك بفضل فريقها البحثي المتميز من OpenAI سابقًا، والذي يضم John Schulman (كبير العلماء) و Barret Zoph (الرئيس التنفيذي للتكنولوجيا). تهدف الشركة إلى بناء ذكاء اصطناعي أكثر قابلية للتخصيص وأكثر قوة. يمنح هيكل تمويلها الرئيسة التنفيذية Murati سيطرة خاصة، حيث يساوي حقها في التصويت مجموع أصوات أعضاء مجلس الإدارة الآخرين زائد واحد (المصدر: 机器之心, X @steph_palazzolo)

محرك البحث بالذكاء الاصطناعي Perplexity يسعى لجمع مليار دولار بتقييم 18 مليار دولار: يسعى محرك البحث بالذكاء الاصطناعي Perplexity، الذي شارك في تأسيسه Aravind Srinivas، عالم الأبحاث السابق في OpenAI، إلى جمع حوالي مليار دولار في جولة تمويل جديدة بتقييم يبلغ حوالي 18 مليار دولار. يستخدم Perplexity نماذج لغوية كبيرة جنبًا إلى جنب مع استرجاع الويب في الوقت الفعلي لتقديم إجابات موجزة مع روابط للمصادر، ويدعم البحث في نطاق محدود. على الرغم من مواجهة جدل بشأن استخراج البيانات، فقد اجتذبت الشركة مستثمرين بارزين بما في ذلك Bezos و Nvidia (المصدر: 机器之心)

Duolingo تعلن أنها ستستبدل تدريجيًا العمال المتعاقدين بالذكاء الاصطناعي: أعلن Luis von Ahn، الرئيس التنفيذي لمنصة تعلم اللغات Duolingo، في رسالة بريد إلكتروني لجميع الموظفين أن الشركة ستصبح مؤسسة “الذكاء الاصطناعي أولاً”، وتخطط للتوقف تدريجيًا عن استخدام العمال المتعاقدين لإنجاز المهام التي يمكن للذكاء الاصطناعي التعامل معها. تعد هذه الخطوة جزءًا من التحول الاستراتيجي للشركة، وتهدف إلى تعزيز الكفاءة والابتكار من خلال الذكاء الاصطناعي، بدلاً من مجرد إجراء تعديلات طفيفة على الأنظمة الحالية. ستقوم الشركة بتقييم استخدام الذكاء الاصطناعي في التوظيف وتقييم الأداء، ولن تضيف موظفين إلا إذا لم يتمكن الفريق من زيادة الكفاءة من خلال الأتمتة. يعكس هذا الاتجاه المتزايد لاستبدال الذكاء الاصطناعي للوظائف البشرية التقليدية في مجالات مثل إنشاء المحتوى والترجمة (المصدر: Reddit r/ArtificialInteligence)

🌟 المجتمع

إطلاق نموذج Qwen3 يثير نقاشًا حادًا، أداء متميز ولكن الجانب المعرفي محط اهتمام: أثار إطلاق علي بابا لسلسلة نماذج Qwen3 مفتوحة المصدر (بما في ذلك 235B MoE) نقاشًا واسعًا في المجتمع. أكدت معظم التقييمات وتعليقات المستخدمين على قدراته القوية في البرمجة والرياضيات والاستدلال، خاصة أداء النموذج الرائد الذي ينافس النماذج العليا. أشاد المجتمع بدعمه لوضع التفكير/عدم التفكير، وقدراته متعددة اللغات، ودعم MCP. ومع ذلك، أشار بعض المستخدمين إلى ضعف أدائه في الإجابة على الأسئلة المعرفية الواقعية (مثل معيار SimpleQA)، حتى أنه أقل أداءً من النماذج ذات المعلمات الأقل، ووجود مشكلة هلوسة معينة. أثار هذا نقاشًا حول تركيز تصميم النموذج على قدرات الاستدلال بدلاً من الذاكرة المعرفية، وما إذا كان سيعتمد في المستقبل على RAG أو استدعاء الأدوات لتعويض النقص المعرفي (المصدر: X @armandjoulin, X @TheZachMueller, X @nrehiew_, X @teortaxesTex, Reddit r/LocalLLaMA, X @karminski3)

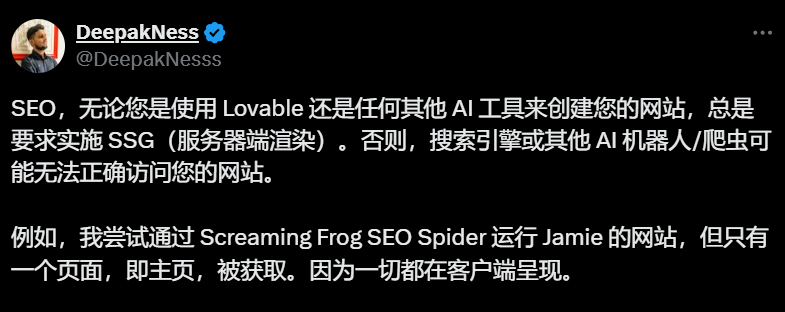

أدوات بناء المواقع بالذكاء الاصطناعي (مثل Lovable) والاعتماد الافتراضي على العرض من جانب العميل يثير مخاوف بشأن SEO: أشار ممارسو تحسين محركات البحث (SEO) والمستخدمون في مناقشات المجتمع إلى أن أدوات بناء المواقع بالذكاء الاصطناعي مثل Lovable تعتمد افتراضيًا على العرض من جانب العميل (CSR)، مما قد يؤدي إلى عدم قدرة زواحف محركات البحث (مثل Googlebot) أو روبوتات الذكاء الاصطناعي (مثل ChatGPT) على استخلاص المحتوى خارج الصفحة الرئيسية، مما يؤثر بشدة على فهرسة الموقع وترتيبه. على الرغم من ادعاء Google بقدرتها على التعامل مع CSR، إلا أن التأثير الفعلي أقل بكثير من العرض من جانب الخادم (SSR) أو إنشاء المواقع الثابتة (SSG). فشلت محاولات المستخدمين لتوجيه Lovable لإنشاء SSR/SSG أو استخدام Next.js عبر الموجهات (Prompts). يوصي المجتمع بتحديد متطلبات SSR/SSG بوضوح في بداية المشروع، أو نقل الكود الذي تم إنشاؤه بواسطة الذكاء الاصطناعي يدويًا إلى إطار عمل يدعم SSR/SSG (مثل Next.js) (المصدر: AI进修生)

هل سيحل AI Agent محل التطبيقات؟ نقاش مستمر: يناقش المجتمع إمكانات تطوير AI Agent وتأثيرها على نموذج التطبيقات التقليدية. يرى البعض أنه مع اكتساب AI Agent لقدرات استدلال وتصفح وتنفيذ أقوى (مثل استدعاء الأدوات عبر MCP)، قد يحتاج المستخدمون في المستقبل فقط إلى إعطاء تعليمات باللغة الطبيعية إلى AI Agent، الذي سيقوم بإنجاز المهام عبر التطبيقات والشبكات، مما يقلل الحاجة إلى التطبيقات الفردية. وقد أعرب الرئيس التنفيذي لشركة Microsoft عن وجهة نظر مماثلة. لكن تشير تعليقات أخرى إلى أن قدرات الاستدلال المستقل لـ AI Agent لا تزال محدودة حاليًا، وأن العديد من التطبيقات (خاصة الترفيهية والاجتماعية) تكمن قيمتها الأساسية في تجربة التصفح والتفاعل للمستخدم نفسه، وليس مجرد إنجاز المهام، وبالتالي يصعب استبدال نموذج التطبيقات بالكامل على المدى القصير (المصدر: Reddit r/ArtificialInteligence)

إدخال ميزة التسوق في ChatGPT يثير مخاوف “التآكل التجاري”: أبلغ المستخدمون أنه عند طرح أسئلة غير متعلقة بالتسوق (مثل تأثير التعريفات الجمركية على المخزون)، أعاد ChatGPT قائمة بروابط تسوق. أوضح ChatGPT رسميًا أن هذه ميزة تسوق جديدة تم إطلاقها في 28 أبريل، تهدف إلى تقديم توصيات للمنتجات، وادعى أن التوصيات “تُنشأ عضويًا” وليست إعلانات. ومع ذلك، أثار هذا التغيير مخاوف في المجتمع بشأن “Enshittification” (انحراف قيمة المنصة تدريجيًا نحو المصالح التجارية على حساب تجربة المستخدم)، معتبرين أن هذه بداية لتضحية OpenAI بتجربة المستخدم تحت ضغط التسويق التجاري، وقد تتطور في المستقبل إلى توصيات مدفوعة بالإعلانات أو العمولات (المصدر: Reddit r/ChatGPT)

استمرار النقاش حول تأثير الذكاء الاصطناعي على سوق العمل: يستمر النقاش في المجتمع حول ما إذا كان الذكاء الاصطناعي سيحل محل الوظائف وكيف سيحدث ذلك. من ناحية، يعتقد بعض الاقتصاديين وتشير التقارير إلى أن التأثير الإجمالي للذكاء الاصطناعي التوليدي على التوظيف والأجور لا يزال غير واضح. من ناحية أخرى، يشارك العديد من المستخدمين حالات وملاحظات واقعية: أعلنت Duolingo عن استبدال العمال المتعاقدين بالذكاء الاصطناعي؛ صرح بعض أصحاب الأعمال بأنهم استخدموا الذكاء الاصطناعي بالفعل ليحل محل بعض وظائف خدمة العملاء والبرمجة الأولية وضمان الجودة وإدخال البيانات؛ يشعر العاملون المستقلون (مثل مصممي الجرافيك والكتاب والمترجمين والمعلقين الصوتيين) بانخفاض فرص العمل؛ لوحظ انخفاض في عدد الوظائف الشاغرة (مثل خدمة العملاء). الرأي السائد هو أن الوظائف المتكررة والنمطية هي الأكثر تضررًا في البداية، وأن الذكاء الاصطناعي يعمل حاليًا كأداة إنتاجية في الغالب، لكن تأثيره الاستبدالي بدأ في الظهور وسيتوسع تدريجيًا (المصدر: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

💡 أخرى

الإعلان عن زملاء ISCA لعام 2025، واختيار ثلاثة علماء صينيين: أعلنت الجمعية الدولية للاتصالات الصوتية (ISCA) عن قائمة زملائها لعام 2025، حيث تم اختيار 8 علماء. من بينهم ثلاثة علماء صينيين: يو كاي، المؤسس المشارك لشركة Spiro والأستاذ المتميز بجامعة شنغهاي جياو تونغ (لمساهماته في التعرف على الكلام وأنظمة الحوار ونشر التكنولوجيا، وهو الأول من البر الرئيسي للصين)، والبروفيسور لي هونغ يي من جامعة تايوان الوطنية (لمساهماته الرائدة في التعلم الذاتي الإشرافي للكلام وبناء معايير المجتمع)، ونانسي تشين، رئيسة مجموعة الذكاء الاصطناعي التوليدي في معهد الاتصالات والمعلومات A*STAR (I2R) في سنغافورة (لمساهماتها وقيادتها في معالجة الكلام متعدد اللغات، والتواصل متعدد الوسائط بين الإنسان والآلة، ونشر تكنولوجيا الذكاء الاصطناعي) (المصدر: 机器之心)