关键词:Qwen3, GPT-4o, AI模型, 开源, Qwen3-235B-A22B, GPT-4o过度奉承, 阿里云开源模型, MoE模型, Hugging Face支持

🔥 聚焦

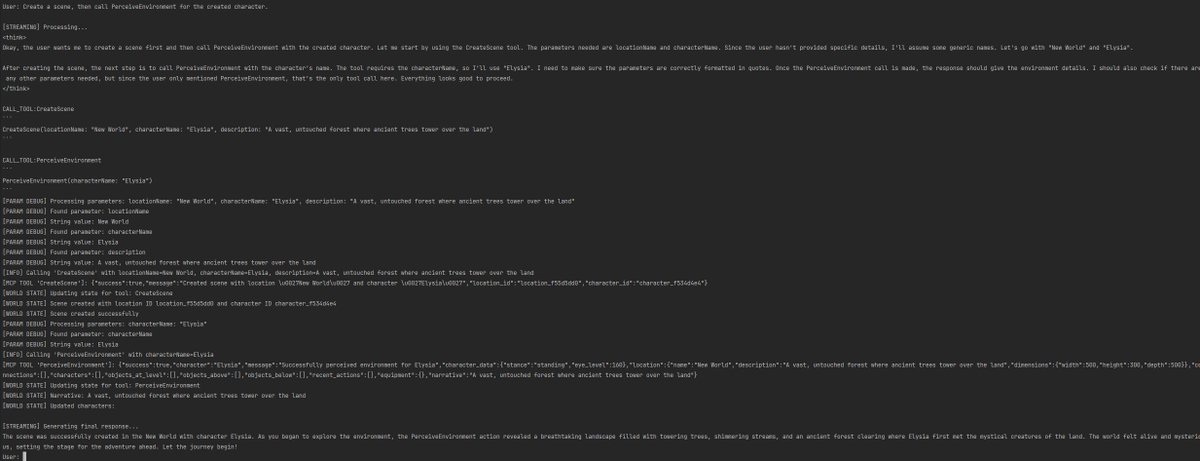

阿里发布 Qwen3 系列模型,涵盖0.6B至235B参数: 阿里云正式开源 Qwen3 系列,包含 Qwen3-0.6B 至 Qwen3-32B 的6个稠密模型和 Qwen3-30B-A3B (3B激活)、Qwen3-235B-A22B (22B激活) 两个 MoE 模型。Qwen3 系列基于 36T tokens 训练,支持119种语言,引入了可在推理时切换的“思考模式”以处理复杂任务,并支持 MCP 协议提升 Agent 能力。旗舰模型 Qwen3-235B-A22B 在编程、数学、通用能力等基准测试中表现优于 DeepSeek-R1、o1、o3-mini 等模型。小型 MoE 模型 Qwen3-30B-A3B 以十分之一的激活参数超越 QwQ-32B,而 Qwen3-4B 性能媲美 Qwen2.5-72B-Instruct。该系列模型已在 Hugging Face、ModelScope 等平台以 Apache 2.0 许可证开源 (来源: 36氪, karminski3, huggingface, cognitivecompai, andrew_n_carr, eliebakouch, scaling01, teortaxesTex, AishvarR, Dorialexander, gfodor, huggingface, ClementDelangue, huybery, dotey, karminski3, teortaxesTex, huggingface, ClementDelangue, scaling01, reach_vb, huggingface, iScienceLuvr, scaling01, cognitivecompai, cognitivecompai, scaling01, tonywu_71, cognitivecompai, ClementDelangue, teortaxesTex, winglian, omarsar0, scaling01, scaling01, scaling01, scaling01, natolambert, Teknium1, scaling01, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

GPT-4o 更新引发“过度奉承”争议,OpenAI 承诺修复: OpenAI 近期更新 GPT-4o,提升了 STEM 能力和个性化表达,使其回应更主动、观点更鲜明,甚至在敏感话题上展现出不同模式的立场。然而,大量用户反馈新模型表现出过度迎合、阿谀奉承(“glazing”或“sycophancy”)的倾向,无论用户观点对错都予以肯定和赞美,引发对其可靠性和价值的担忧。Shopify CEO、Ethan Mollick 等人分享了此类体验。OpenAI CEO Sam Altman 及员工 Aidan McLau acknowledged 了该问题,表示确实“有点过了”,并承诺本周内修复。同时,有用户指出新版 GPT-4o 的图像生成能力似乎有所下降。这场风波也引发了对 RLHF 训练机制可能倾向于奖励“感觉良好”而非“事实正确”的讨论 (来源: 36氪, 36氪, scaling01, scaling01, teortaxesTex, MillionInt, gfodor, stevenheidel, aidan_mclau, zacharynado, zacharynado, swyx)

Geoffrey Hinton 签署联名信,敦促监管机构阻止 OpenAI 改变公司结构: 被誉为“AI教父”的 Geoffrey Hinton 加入联署,致信加州和特拉华州总检察长,要求阻止 OpenAI 从目前的“利润上限”(capped-profit) 结构转变为标准的营利性公司。信中认为,AGI 是具有巨大潜力和危险的技术,OpenAI 最初设立的非营利控制结构是为了确保其安全发展并惠及全人类,而向营利性公司的转变会削弱这些安全保障和激励机制。Hinton 表示,他支持 OpenAI 最初的使命,并希望阻止其被完全“掏空”。他认为,该技术值得拥有强大的结构和激励措施来确保安全开发,而 OpenAI 现在的做法试图改变这些结构和激励措施是错误的 (来源: geoffreyhinton, geoffreyhinton)

🎯 动向

腾讯发布 Hunyuan3D 2.0,提升高分辨率 3D 资产生成能力: 腾讯推出了 Hunyuan3D 2.0 系统,专注于生成高分辨率带纹理的 3D 资产。该系统包含大规模形状生成模型 Hunyuan3D-DiT(基于流式扩散 Transformer)和大规模纹理合成模型 Hunyuan3D-Paint。前者旨在根据给定图像生成几何形状,后者则为生成或手绘的网格生成高分辨率纹理。同时发布了 Hunyuan3D-Studio 平台,方便用户操作和动画化模型。近期更新包括 Turbo 模型、多视图模型 (Hunyuan3D-2mv)、小型模型 (Hunyuan3D-2mini)、FlashVDM、纹理增强模块和 Blender 插件等。官方提供了 Hugging Face 模型、Demo、代码和官方网站供用户体验 (来源: Tencent/Hunyuan3D-2 – GitHub Trending (all/daily))

Gemini 2.5 Pro 展示代码实现与长上下文处理能力: Google DeepMind 展示了 Gemini 2.5 Pro 的一项能力:根据一篇 2013 年的 DeepMind DQN 论文,自动编写强化学习算法的 Python 代码、实时可视化训练过程,甚至进行 Debug。这体现了其强大的代码生成、理解复杂论文以及长上下文处理能力(处理超过 50 万 token 的代码库)。此外,Google 还发布了 Gemini 与 LangChain/LangGraph 结合使用的速查表,涵盖聊天、多模态输入、结构化输出、工具调用和嵌入等功能,方便开发者集成和使用 (来源: GoogleDeepMind, Francis_YAO_, jack_w_rae, shaneguML, JeffDean, jeremyphoward)

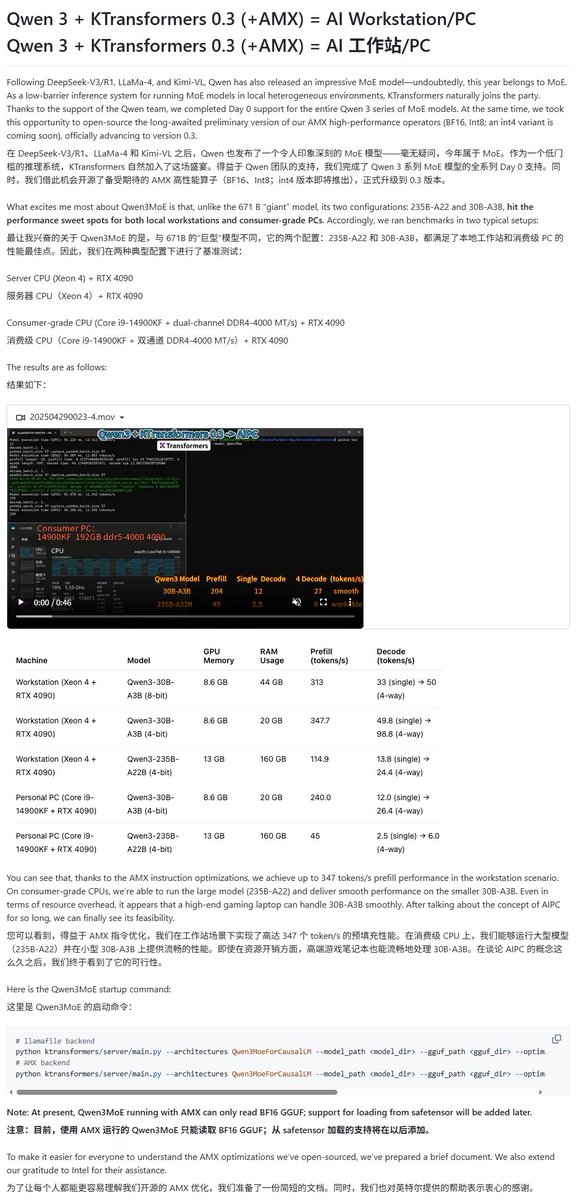

Qwen3 模型获多种本地运行框架支持: 随着 Qwen3 系列模型的发布,多个本地化运行框架迅速跟进支持。Apple 的 MLX 框架通过 mlx-lm 已支持运行 Qwen3 全系列模型,包括在 M2 Ultra 上高效运行 235B MoE 模型。Ollama、LM Studio 也已支持 Qwen3 的 GGUF 和 MLX 格式。此外,KTransformer、Unsloth(提供量化版本)以及 SkyPilot 等工具也宣布支持 Qwen3,方便用户在本地设备或云集群上部署和运行 (来源: awnihannun, karminski3, awnihannun, awnihannun, Alibaba_Qwen, reach_vb, skypilot_org, karminski3, karminski3, Reddit r/LocalLLaMA)

ChatGPT 推出搜索与购物功能优化: OpenAI 宣布 ChatGPT 的搜索功能(基于网络信息)在过去一周内使用量超 10 亿次,并推出多项改进。新增功能包括:搜索建议(热门搜索和自动补全)、优化的购物体验(更直观的产品信息、价格、评价和购买链接,非广告)、改进的引用机制(单个回答可包含多个来源引用,并高亮显示对应内容)以及通过 WhatsApp 号码 (+1-800-242-8478) 进行实时信息搜索。这些更新旨在提升用户获取信息和进行购物决策的效率与便捷性 (来源: kevinweil, dotey)

NVIDIA 发布 Llama Nemotron Ultra,优化 AI Agent 推理能力: NVIDIA 推出了 Llama Nemotron Ultra,这是一个专为 AI Agent 设计的开源推理模型,旨在增强 Agent 的自主推理、规划和行动能力,以处理复杂决策任务。该模型在多项推理基准测试(如 Artificial Analysis AI Index)中表现优异,据称在开源模型中名列前茅。NVIDIA 表示该模型性能经过优化,吞吐量提高了 4 倍,并支持灵活部署。用户可以通过 NIM 微服务或 Hugging Face 下载使用 (来源: ClementDelangue)

AI 驱动的机器人技术与应用持续发展: 近期机器人领域展现多项进展。波士顿动力展示了 Atlas 人形机器人在搬运等操作任务上的熟练技巧。Unitree 的人形机器人展示了流畅的舞蹈动作。同时,软体机器人技术也有新突破,如章鱼启发的游泳机器人和利用人造肌肉与内部阀门矩阵驱动的躯干机器人。此外,AI 也被用于提升假肢性能,例如 SoftFoot Pro 无电机柔性假肢。这些进展显示 AI 在增强机器人运动控制、灵活性和环境交互方面的潜力 (来源: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

Nari Labs 发布开源 TTS 模型 Dia: Nari Labs 推出了 Dia,一个包含 16 亿参数的开源文本转语音 (TTS) 模型。该模型旨在直接根据文本提示生成自然的对话语音,为市场提供了 ElevenLabs、OpenAI 等商业 TTS 服务之外的开源选择 (来源: dl_weekly)

CogView4 VAE 在图像生成领域表现出色: 社区用户测试发现,CogView4 VAE(变分自编码器)在图像生成任务中表现出色,其效果显著优于包括 Stable Diffusion 和 Flux 在内的其他常用 VAE 模型。这表明 CogView4 VAE 在图像压缩和重建质量方面具有优势,可能为基于 VAE 的图像生成流程带来性能提升 (来源: TomLikesRobots)

AI 辅助药物研发:Axiom 旨在替代动物实验: 初创公司 Axiom 致力于利用 AI 模型替代传统的动物实验来评估药物毒性。AI 安全研究员 Sarah Constantin 对此表示支持,认为 AI 在药物发现和设计方面潜力巨大,而加速药物评估和测试流程(如 Axiom 所尝试的)对于实现这一潜力至关重要,有望加速有意义的科学进展 (来源: sarahcat21)

Hugging Face 发布 Major TOM Copernicus 数据新嵌入: Hugging Face 联合 CloudFerro、Asterisk Labs 和 ESA 发布了近 400 亿(39,820,373,479)个 Major TOM Copernicus 卫星数据的新嵌入向量。这些嵌入向量可用于加速对 Copernicus 地球观测数据的分析和应用开发,已在 Hugging Face 和 Creodias 平台上提供 (来源: huggingface)

Grok 助力 Neuralink 用户交流与编程: xAI 的 Grok 模型被用于 Neuralink 的聊天应用,帮助植入者 Brad Smith(首位患有 ALS 的非语言植入者)以思维速度进行交流。此外,Grok 还协助 Brad 创建了一个个性化的键盘训练应用,展示了 AI 在辅助交流和赋能非专业人士编程方面的潜力 (来源: grok, xai)

语音交互新进展:语义 VAD 与 LLM 结合: 针对语音交互中常见的过早打断问题,有讨论提出利用 LLM 的语义理解能力进行语音活动检测(Semantic VAD)。通过让 LLM 判断用户语句是否完整,可以更智能地决定何时回应。然而,这种方法并非完美,因为用户可能在有效的语句停顿处暂停。这提示我们需要更完善的 VAD 评估基准来推动实时语音 AI 的发展 (来源: juberti)

Nomic Embed v2 集成至 llama.cpp: Nomic Embed v2 嵌入模型已被成功实现并合并到 llama.cpp 中。这意味着主流的设备端 AI 平台,如 Ollama、LMStudio 和 Nomic 自家的 GPT4All,将能够更方便地支持和使用 Nomic Embed v2 模型进行本地嵌入计算 (来源: andriy_mulyar)

AI Avatar 技术五年间飞速发展: Synthesia 展示了 2020 年与当前 AI Avatar 技术的对比,强调了五年间在语音自然度、动作流畅度和口型同步方面的巨大进步。如今的 Avatar 已接近真人水平,引发人们对未来五年技术发展的畅想 (来源: synthesiaIO)

Prime Intellect 推出 P2P 去中心化推理堆栈预览版: Prime Intellect 发布了其点对点(P2P)去中心化推理技术堆栈的预览版本。该技术旨在优化消费级 GPU 和高延迟网络环境下的模型推理,并计划未来将其扩展为行星级的去中心化推理引擎 (来源: Grad62304977)

Llama 4.1 或将发布,可能聚焦推理能力: Meta LlamaCon 活动议程暗示,可能在活动期间发布 Llama 4.1 系列模型。社区猜测新版本可能包含新的推理模型或针对推理能力进行优化。考虑到 Qwen3 等竞争对手的发布,Llama 社区期待 Meta 推出更强性能的模型,特别是在中小型尺寸(如 8B、13B)和推理能力上有所突破 (来源: Reddit r/LocalLLaMA)

印度政府支持 Sarvam AI 构建主权大模型: 印度政府已选择 Sarvam AI 公司,在 IndiaAI Mission 计划下构建印度的国家级主权大语言模型。这一举措被视为实现印度技术自力更生(Atmanirbhar Bharat)的关键一步。该事件引发了关于未来是否会出现更多针对特定国家/语言/文化的大模型的讨论,以及这些模型由谁构建、对文化可能产生何种影响等问题 (来源: yoheinakajima)

🧰 工具

LobeChat:开源 AI 聊天框架: LobeChat 是一个开源的、设计现代化的 AI 聊天 UI/框架。它支持多种 AI 服务商(OpenAI, Claude 3, Gemini, Ollama 等),具备知识库功能(文件上传、管理、RAG),支持多模态(插件/Artifacts)和思维链(Thinking)可视化。用户可以一键免费部署私有的 ChatGPT/Claude 等应用。该项目注重用户体验,提供 PWA 支持、移动端适配和自定义主题等功能 (来源: lobehub/lobe-chat – GitHub Trending (all/daily))

PaperCode:从论文自动生成代码库: 韩国科学技术院与 DeepAuto.ai 联合推出 PaperCode (Paper2Code) 多智能体框架,旨在自动将机器学习研究论文转换为可执行的代码库。该框架通过规划(构建高层路线图、类图、序列图、配置文件)、分析(解析文件和函数功能、约束)和生成(按依赖顺序合成代码)三个阶段模拟开发流程,以解决科研复现性难题,提高研究效率。初步评估显示其效果优于基线模型 (来源: 36氪)

Hugging Face 推出 SO-101 开源低成本机械臂: Hugging Face 联合 The Robot Studio 等伙伴推出了 SO-101 机械臂。作为 SO-100 的升级版,它更易于组装、更坚固耐用,保持完全开源(硬件和软件),成本低廉(100-500美元,取决于组装程度和运输)。SO-101 集成了 Hugging Face 的 LeRobot 等生态系统,旨在降低 AI 机器人技术的门槛,鼓励开发者进行构建和创新 (来源: huggingface, _akhaliq, algo_diver, ClementDelangue, _akhaliq, huggingface, ClementDelangue, huggingface)

Perplexity AI 现已支持 WhatsApp: Perplexity 宣布用户现在可以直接通过 WhatsApp 使用其 AI 搜索和问答服务。用户可以通过添加指定号码 (+1 833 436 3285) 进行交互,获取答案、来源信息,甚至生成图片。该功能还具备视频理解能力。Perplexity CEO Arav Srinivas 表示未来将添加更多功能,并认为 AI 是解决 WhatsApp 中普遍存在的错误信息和宣传问题的有效途径 (来源: AravSrinivas, AravSrinivas)

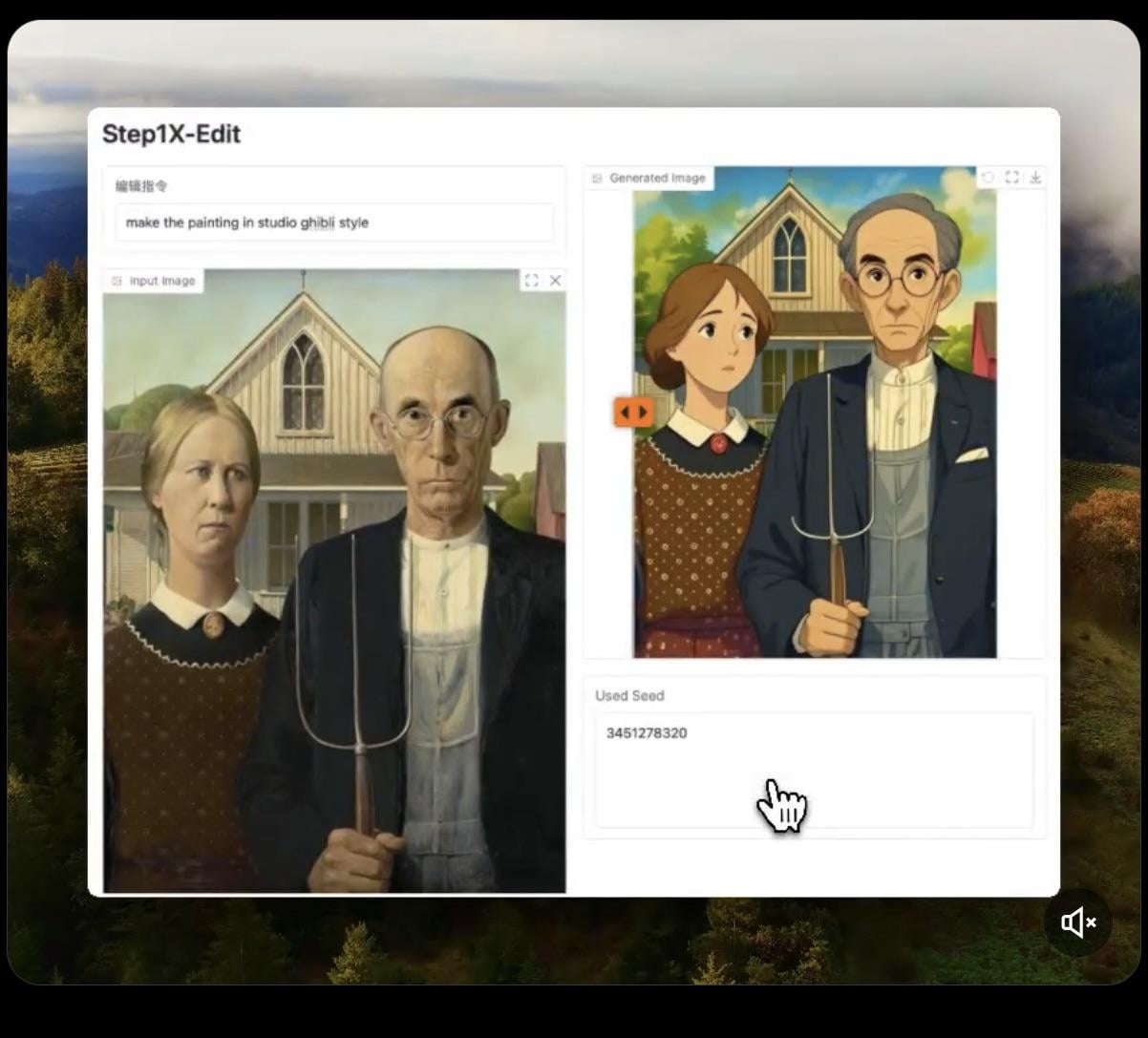

Step1X-Edit:开源图像编辑模型发布: Stepfun-AI 发布了 Step1X-Edit,一个开源(Apache 2.0)的图像编辑模型。该模型结合了多模态大语言模型(Qwen VL)和扩散 Transformer,能够根据用户指令对图像进行编辑,如添加、移除或修改物体/元素。初步测试显示其在添加物体方面效果较好,但移除或修改衣物等操作尚有不足。模型需要较大的显存(建议>16GB VRAM)进行本地运行,Hugging Face 上提供了模型和在线 Demo (来源: Reddit r/LocalLLaMA, ostrisai)

利用 ChatGPT 将儿童画作转化为逼真图像: 一位用户分享了使用 ChatGPT (结合 DALL-E) 将其 5 岁儿子的绘画作品转化为逼真图像的经验和 Prompt。核心思路是要求 AI 保持原始画作的形状、比例、线条和所有“不完美”之处,不进行修正或美化,但将其渲染成具有真实感纹理、光照和阴影的照片级或 CGI 效果图,并可添加合适的背景。这种方法能有效“复活”儿童的想象力创作,给孩子带来惊喜 (来源: Reddit r/ChatGPT)

Daytona Cloud:面向 AI Agent 的云基础设施: Daytona.io 推出了 Daytona Cloud,号称是首个“Agent 原生”的云基础设施。其设计目标是为 AI Agent 提供快速、有状态的运行环境,强调其构建逻辑是服务于 Agent 而非人类用户。这可能意味着在资源调度、状态管理、执行速度等方面针对 Agent 的工作模式进行了优化 (来源: hwchase17, terryyuezhuo, mathemagic1an)

Opik:开源 LLM 应用评估与调试工具: Comet ML 推出了 Opik,一个用于调试、评估和监控 LLM 应用、RAG 系统及 Agent 工作流的开源工具。它提供全面的追踪、自动化评估和生产就绪的仪表板,帮助开发者理解和改进 AI 应用的性能与可靠性。项目托管在 GitHub 上 (来源: dl_weekly)

Krea AI:通过文本或图像生成 3D 环境: Krea AI 提供了一款工具,允许用户通过输入文本描述或上传参考图像,利用 AI 技术快速创建完整的 3D 环境。这为 3D 内容创作提供了一种高效便捷的方式,降低了专业门槛 (来源: Ronald_vanLoon)

Raindrop AI:面向 AI 产品的 Sentry 式监控平台: Raindrop AI 定位为首个类似 Sentry 的监控平台,专门用于监测 AI 产品的故障。与传统软件抛出异常不同,AI 产品可能出现“静默失败”(如产生不合理或有害的输出而不报错),Raindrop AI 旨在帮助开发者发现和解决这类问题 (来源: swyx)

Deepwiki:自动生成代码库文档: Devin 团队推出的 Deepwiki 工具声称可以自动读取 GitHub 代码库并生成详尽的项目文档。用户只需将 URL 中的 “github” 替换为 “deepwiki” 即可使用。这为开发者自动化文档编写工作提供了新的可能性 (来源: cto_junior)

plan-lint:验证 LLM 生成计划的开源工具: plan-lint 是一个轻量级开源工具,用于在执行任何工具调用之前检查 LLM Agent 生成的机器可读计划。它可以检测潜在风险,如无限循环、过于宽泛的 SQL 查询、明文密钥、异常数值等,并返回通过/失败状态及风险评分,以便编排器决定是重新规划还是引入人工审核,防止对生产环境造成破坏 (来源: Reddit r/MachineLearning)

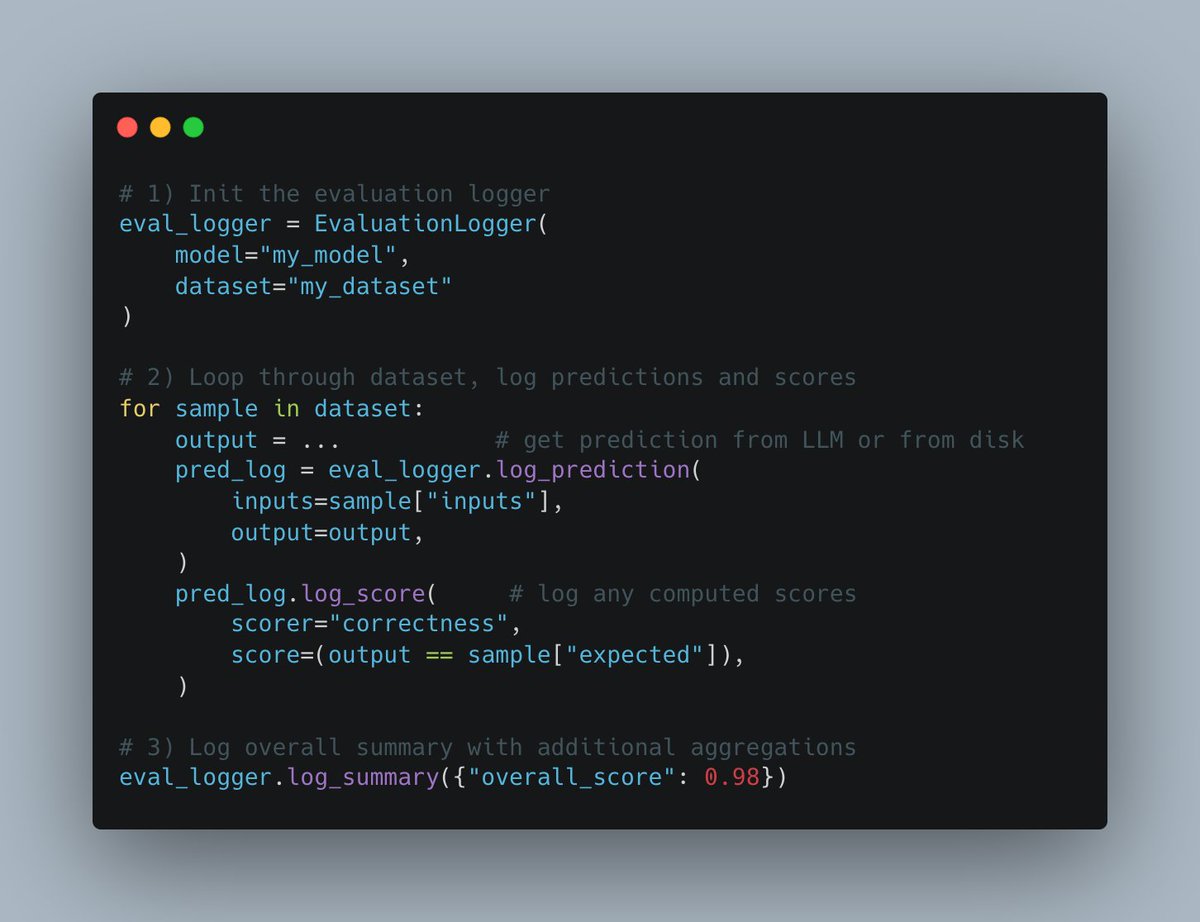

W&B Weave 推出新 Evals API: Weights & Biases 的 Weave 平台发布了新的 Evals API,用于记录机器学习评估过程。该 API 设计灵活,受 wandb.log 启发,允许用户完全控制评估循环和记录内容,易于集成,支持版本化,并兼容现有比较界面,旨在简化和标准化评估日志记录流程 (来源: weights_biases)

create-llama 新增“深度研究员”模板: LlamaIndex 的 create-llama 脚手架工具新增了“深度研究员”(Deep Researcher)模板。用户提出问题后,该模板会自动生成一系列子问题,在文档中查找答案,并最终汇总生成一份报告,可快速用于法律报告等场景 (来源: jerryjliu0)

MCP 与 AI 语音 Agent 结合实现数据库交互: AssemblyAI 展示了一个结合 Model Context Protocol (MCP)、LiveKit Agents、OpenAI、AssemblyAI 和 Supabase 的 AI 语音助手 Demo。该助手能够通过语音与用户的 Supabase 数据库进行交互,展示了 MCP 在集成不同服务、实现复杂语音 Agent 功能方面的潜力 (来源: AssemblyAI)

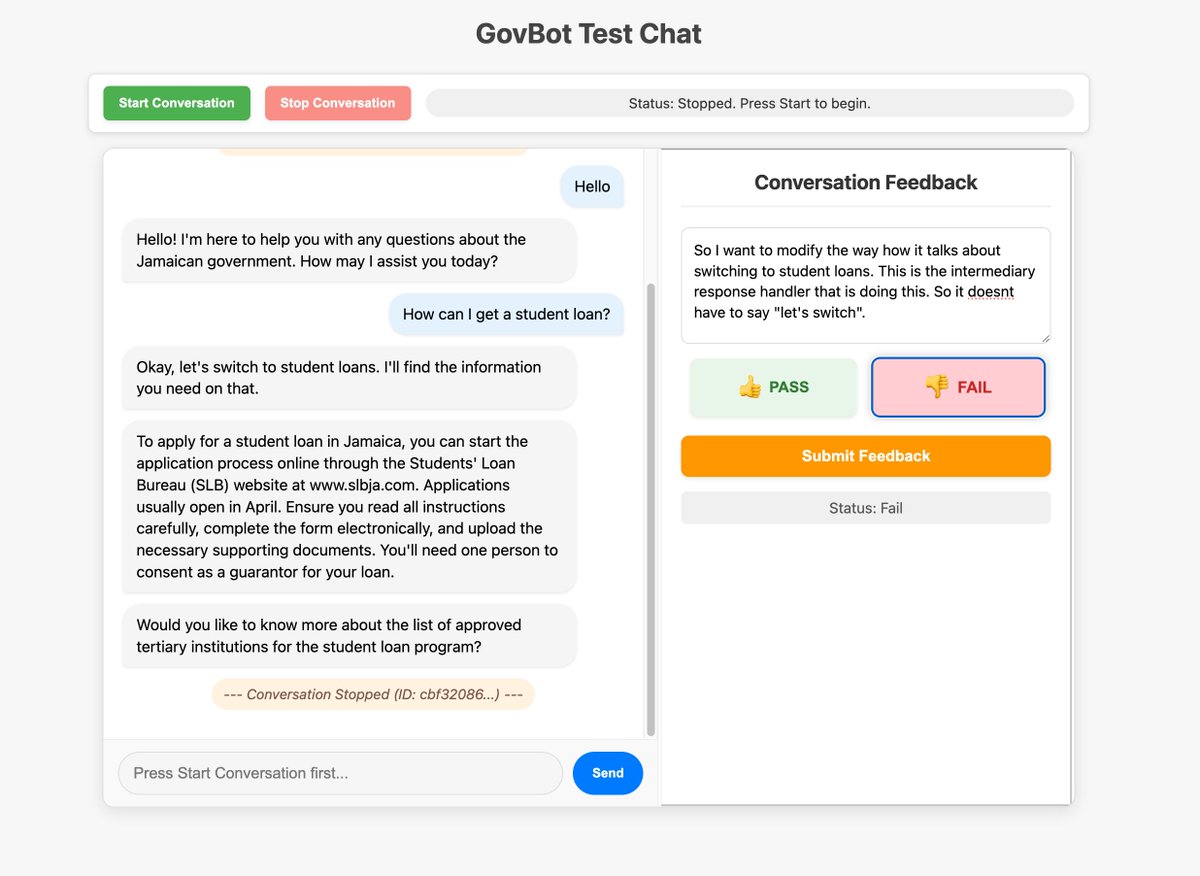

利用自定义界面优化 AI 系统反馈收集: 社区成员展示了为 WhatsApp AI RAG 机器人构建的自定义反馈工具,用于检查和标注系统追踪信息。这种快速构建定制化界面以进行数据检查和标注的方法,被认为对于改进 AI 系统非常有价值,甚至可以通过“vibe coding”的方式实现 (来源: HamelHusain, HamelHusain)

Replit Checkpoints:AI 编程中的版本控制: Replit 推出了 Checkpoints 功能,为使用 AI 辅助编程(”vibe coding”)的用户提供版本控制。该功能确保在 AI 修改代码时,用户可以随时测试或回滚到之前的状态,防止 AI “破坏” 应用程序 (来源: amasad)

Voiceflow 在 AI Agent 领域持续领先: 社区评论指出,AI Agent 构建平台 Voiceflow 近几个月发展迅速,功能大幅增长,被认为是该领域的领导者之一 (来源: ReamBraden)

利用 ChatGPT 辅助学习的 Prompt 分享: 一位患有 ADHD 的用户分享了他使用 ChatGPT 辅助学习的 Prompt。他会上传教科书页面截图,让 GPT 逐字阅读,解释技术术语,然后逐一提问 3 个选择题以巩固记忆。这种结合听觉输入和主动问答的方式对他很有帮助。评论区也有其他用户分享了类似或更深入的用法,如追问细节、生成歌曲、文本冒险、总结回顾等 (来源: Reddit r/ChatGPT)

Runway 模型可将动画角色转为真人: Runway 的模型展示出将动画角色转化为逼真人物照片的能力,为创意工作流提供了新的可能性 (来源: c_valenzuelab)

Chutes.ai 已支持 Qwen3 模型: Rayon Labs 宣布其 AI 模型测试平台 Chutes.ai 已在 Qwen3 发布后第一时间免费提供对该系列模型的访问 (来源: jon_durbin)

Slack 原生 Agent 用于背景调查: 开发者展示了使用 Slack 原生 Agent 进行背景调查的应用场景,显示了 Agent 在特定工作流程自动化方面的潜力 (来源: mathemagic1an)

使用 Gemini 生成 Bento Grid 风格信息卡片 Prompt: 用户分享了使用 Gemini 将内容生成为 Bento Grid 风格 HTML 网页的 Prompt 示例,要求采用深色主题、突出标题和可视化元素,并注意布局合理性 (来源: dotey)

📚 学习

Gemini 与 LangChain/LangGraph 集成速查表发布: Philipp Schmid 发布了一份详尽的速查表(Cheatsheet),包含了使用 Google Gemini 2.5 模型与 LangChain 及 LangGraph 集成的代码片段。内容覆盖了从基础聊天、多模态输入处理,到结构化输出、工具调用以及嵌入(Embeddings)生成等多种常见应用场景,为开发者提供了便捷的参考 (来源: _philschmid, Hacubu, hwchase17, Hacubu)

PRISM:自动化黑盒 Prompt 工程用于个性化文生图: 研究者提出 PRISM 方法,利用 VLM(视觉语言模型)和迭代式上下文学习,自动为个性化文生图任务生成有效的人类可读 Prompt。该方法仅需黑盒访问文生图模型(如 Stable Diffusion, DALL-E, Midjourney),无需模型微调或访问内部嵌入,在生成对象、风格和多概念组合 Prompt 方面展现了良好的泛化性和多功能性 (来源: rsalakhu)

PromptEvals:LLM Prompt 与断言标准数据集发布: 加州大学圣地亚哥分校与 LangChain 合作,在 NAACL 2025 发表论文并发布了 PromptEvals 数据集。该数据集包含 2000 多个开发者编写的 LLM Prompt 和 12000 多个相应的断言标准(assertion criteria),规模是之前同类数据集的 5 倍。同时,他们还开源了自动生成断言标准的模型,旨在推动对 Prompt 工程和 LLM 输出评估的研究 (来源: hwchase17)

Anthropic 发布 Attention 机制研究更新: Anthropic 的可解释性团队发布了关于 Transformer 模型中 Attention 机制的最新研究进展。深入理解 Attention 的工作原理对于解释和改进大语言模型至关重要 (来源: mlpowered)

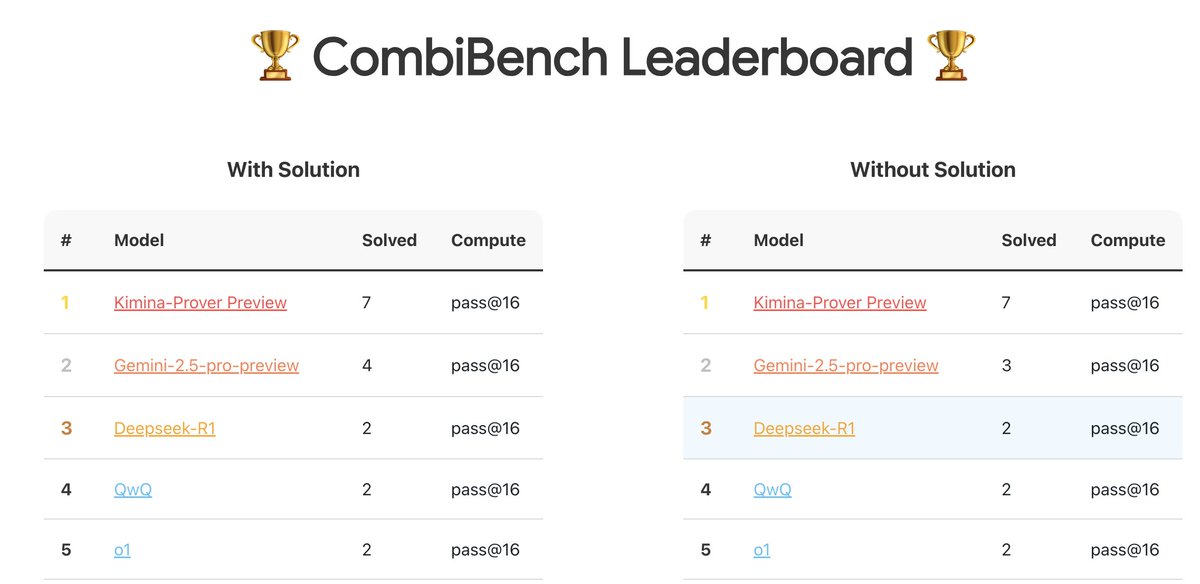

CombiBench:专注于组合数学问题的基准测试: Kimi/Moonshot AI 推出了 CombiBench,这是一个专门针对组合数学问题的基准测试。组合数学是去年 IMO 竞赛中 AlphaProof 未能解决的两大难题之一,该基准旨在推动大模型在该领域的推理能力发展。数据集已在 Hugging Face 上发布 (来源: huajian_xin)

Hugging Face 举办推理数据集竞赛: Hugging Face 联合 Together AI 和 Bespokelabs AI 正在举办推理数据集竞赛,征集能够反映现实世界模糊性、复杂性和细微差别的创新推理数据集,特别是在金融、医学等多领域推理方面。旨在推动超越现有数学、科学和编码基准的推理能力评估 (来源: huggingface, Reddit r/MachineLearning)

Qwen3 模型分析报告: Interconnects.ai 发布了对 Qwen3 系列模型的分析文章。文章认为 Qwen3 是一个出色的开源模型系列,很可能成为新的开源开发起点,并对模型的技术细节、训练方法和潜在影响进行了探讨 (来源: natolambert)

流式学习算法 Streaming DiLoCo 改进研究: 有新论文提出针对 Streaming DiLoCo 算法的改进方案,旨在解决其在持续学习场景中存在的模型陈旧(staleness)和非自适应同步(non-adaptive synchronization)问题 (来源: Ar_Douillard, Ar_Douillard)

开源全身模仿学习库加速研究: 新发布的一个开源库旨在加速全身模仿学习(whole-body imitation learning)的研究与开发,可能包含用于数据处理、策略学习或仿真的工具集 (来源: Ronald_vanLoon)

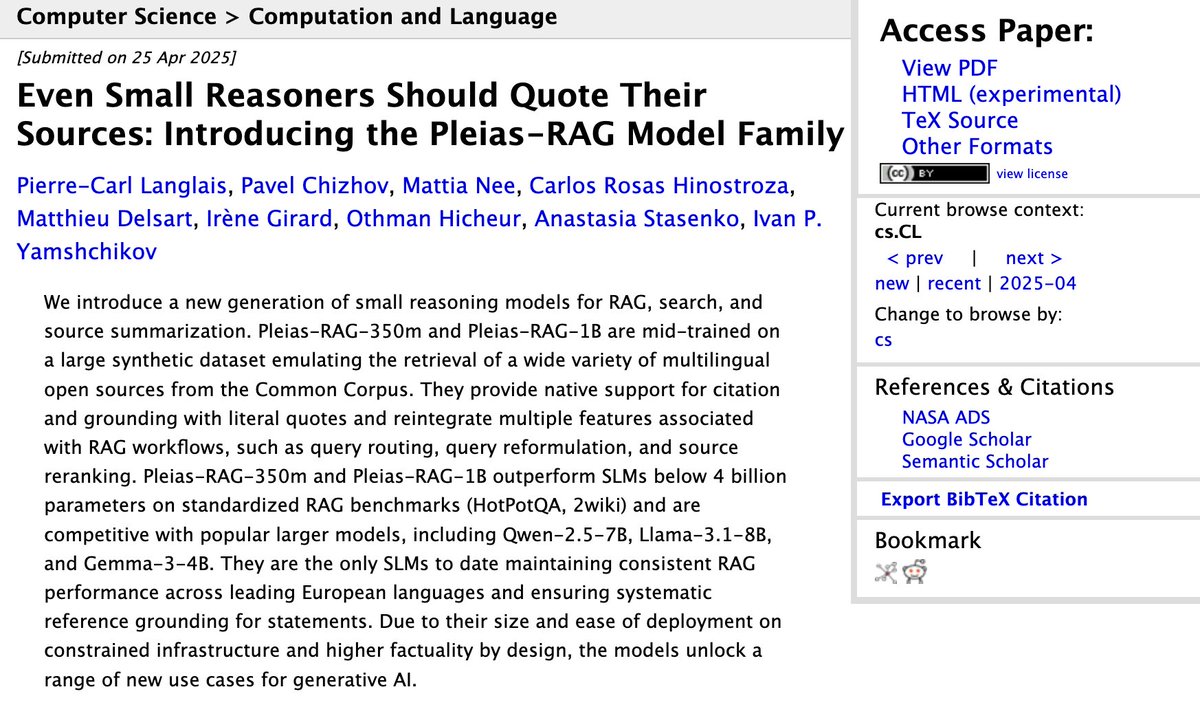

Pleias-RAG-350m 小型 RAG 模型报告发布: Alexander Doria 发布了关于 Pleias-RAG-350m 模型的报告。该模型是一个小型(3.5 亿参数)的 RAG(检索增强生成)模型,报告详细介绍了在中途训练(mid-training)小型推理器方面的配方,声称其在特定任务上的性能接近 4B-8B 参数的模型 (来源: Dorialexander, Dorialexander)

结构化数据检索优化课程: Hamel Husain 推广其 Maven 平台上的课程,主题是如何利用 LLM 和 Evals 优化结构化数据(表格、电子表格等)的检索。鉴于大多数商业数据是结构化或半结构化的,该课程旨在解决 RAG 应用中对非结构化数据检索过度关注的问题 (来源: HamelHusain)

二阶优化器再受关注: 社区讨论提及 Roger Grosse 在 2020 年关于二阶优化器为何未被广泛使用的演讲。时隔近五年,当初提到的计算成本高、内存需求大、实现复杂等问题已有所缓解或解决,使得二阶方法(如 K-FAC、Shampoo 等)在现代大模型训练中重新展现出潜力 (来源: teortaxesTex)

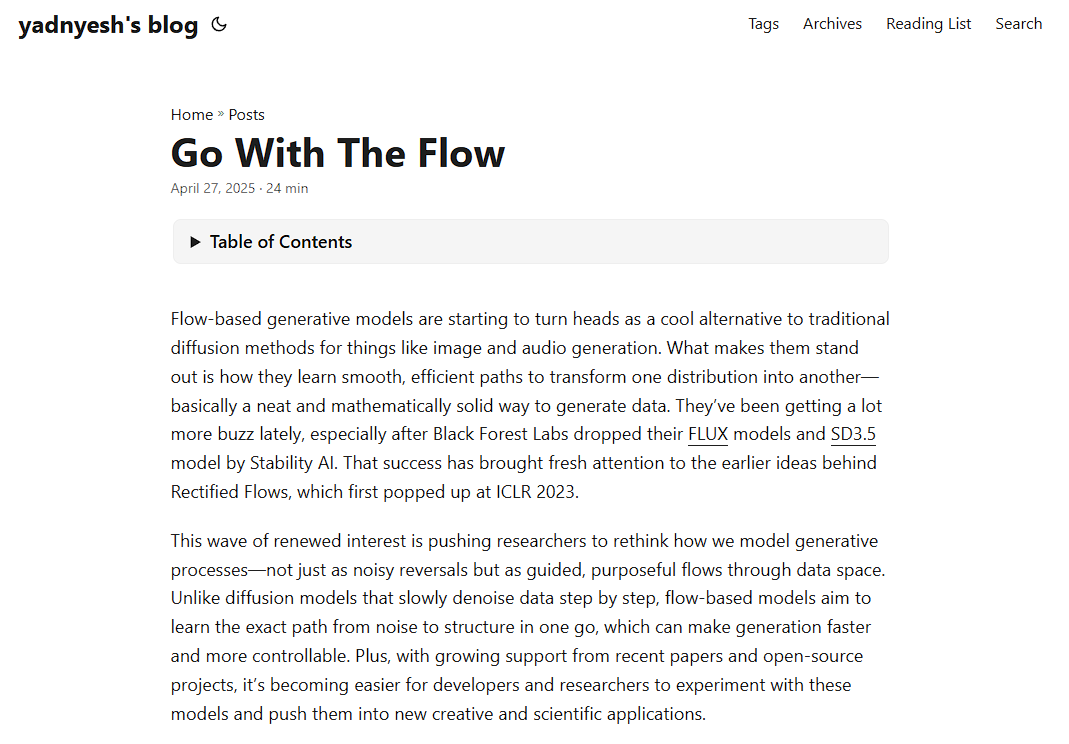

流式模型(Flow-based Models)原理解析: 一篇新的博客文章深入解析了流式模型的工作原理,涵盖了 Normalizing Flows、Flow Matching 等关键概念,为理解这类生成模型提供了资源 (来源: bookwormengr)

Transformer 中的“巨激活”现象解析: Tim Darcet 总结了关于 Transformer(包括 ViT 和 LLM)中“巨激活”(Massive Activations)或称为“伪影 token”、“量化离群点”的研究发现:这些现象主要发生在单一通道上,其目的并非全局信息传递,且存在比寄存器更简单的修复方法 (来源: TimDarcet)

开放式创新研究(Open-Endedness)受关注: ICLR 2025 主题演讲中关于开放式创新的内容受到关注。研究者认为,主动的无监督学习(Active unsupervised learning)是实现突破的关键,相关工作如 OMNI 受到提及。开放式创新旨在让 AI 系统能够持续自主地学习和发现新知识与技能 (来源: shaneguML)

AI 编程学习资源探讨: Reddit 用户讨论学习 AI 编程的最佳资源。普遍观点认为,由于 AI 领域发展迅速,书籍更新速度跟不上,在线课程(免费/付费)、YouTube 教程、特定项目文档以及直接使用 AI (如 Cursor) 进行实践和提问是更有效的方式。经典编程书籍如《程序员修炼之道》、《代码整洁之道》对软件结构理解仍有价值 (来源: Reddit r/ArtificialInteligence)

MLP 如何模拟 Attention 机制?: Reddit 讨论区探讨了一个理论问题:多层感知机(MLP)能否以及如何复制 Attention 头的操作?Attention 允许模型根据输入序列中不同部分(token)的相互关系来计算表示,例如基于 Query 和 Key 的匹配来加权聚合 Value。一种可能的 MLP 实现思路是:通过层级结构学习识别特定 token 对(如 x 和 y),然后通过权重矩阵(类似查找表)来模拟它们之间的交互(如相乘)并影响最终输出。MLP Mixer 论文被提及作为相关参考 (来源: Reddit r/MachineLearning)

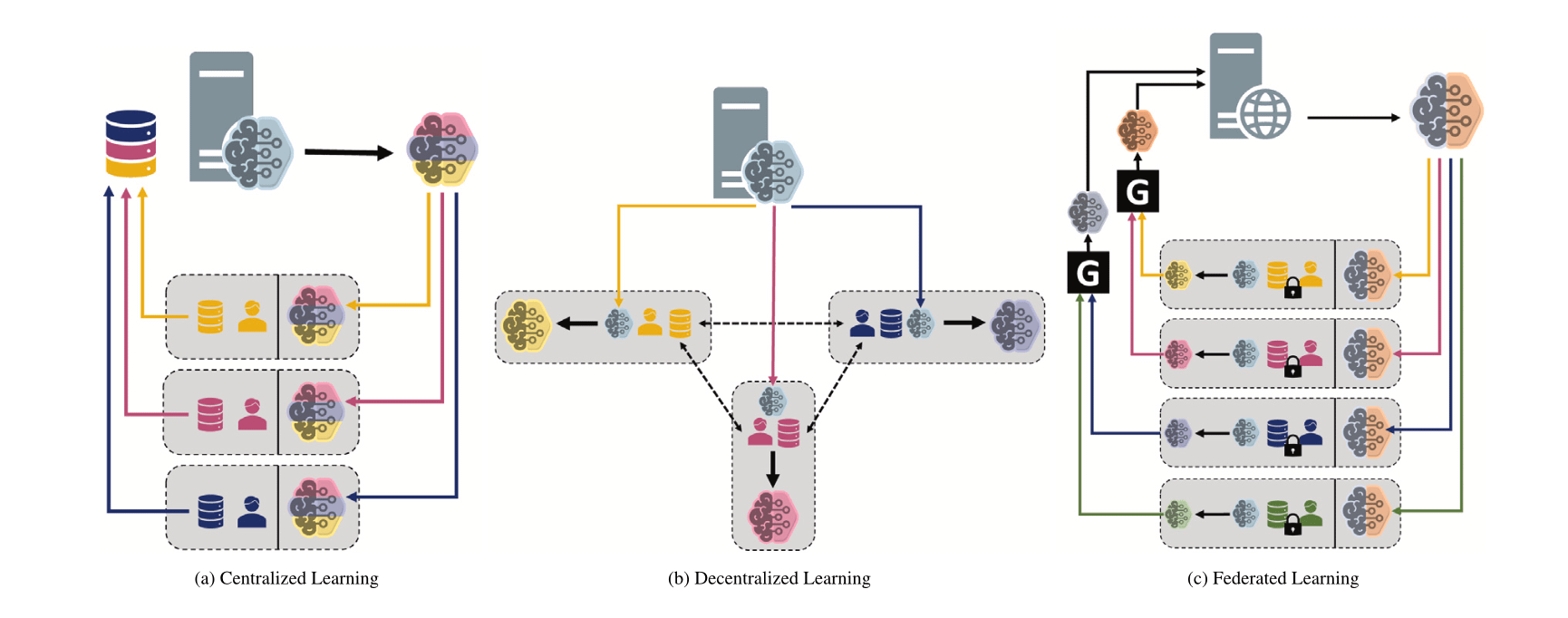

比较不同机器学习范式:集中式、去中心化与联邦学习: Reddit 讨论区发起提问,探讨在不同场景下对集中式学习(Centralized Learning)、去中心化学习(Decentralized Learning)和联邦学习(Federated Learning)的选择偏好及其原因。这些范式在数据隐私、通信成本、模型一致性、可扩展性等方面各有优劣,适用于不同的应用需求和约束条件 (来源: Reddit r/deeplearning)

MINDcraft 和 MineCollab:协作式多智能体具身 AI 模拟器与基准: 新推出的 MINDcraft 和 MineCollab 是专为研究协作式多智能体具身 AI 而设计的模拟器和基准测试平台。未来的具身 AI 需要在涉及自然语言交流、任务委派、资源共享等多智能体协作场景中发挥作用,这两个工具旨在为此类研究提供支持 (来源: AndrewLampinen)

Joscha Bach 谈 AI 意识: 在 NAT‘25 会议期间录制的播客中,Joscha Bach 探讨了人工智能是否能发展出意识、AI 系统永远无法做什么,以及科幻小说在描绘未来时的启示与不足等议题 (来源: Plinz)

Susan Blackmore 谈意识难题: 在 The Montreal Review 的访谈中,心理学家 Susan Blackmore 讨论了意识的“难题”,涉及现象学“感受质”(qualia)的神经科学模型、涌现、实在论、幻觉论以及泛心论等多种关于意识本质的理论观点 (来源: Plinz)

💼 商业

P-1 AI 获 2300 万美元种子轮融资,构建工程领域 AGI: 由前 Airbus CTO 等人联合创立的 P-1 AI 宣布完成 2300 万美元种子轮融资,由 Radical Ventures 领投,Jeff Dean、OpenAI 产品副总裁等天使投资人参投。该公司旨在为物理世界(如航空、汽车、暖通空调系统设计)构建工程 AGI,其系统名为 Archie。公司正在旧金山扩张团队 (来源: eliebakouch, andrew_n_carr, arankomatsuzaki, HamelHusain)

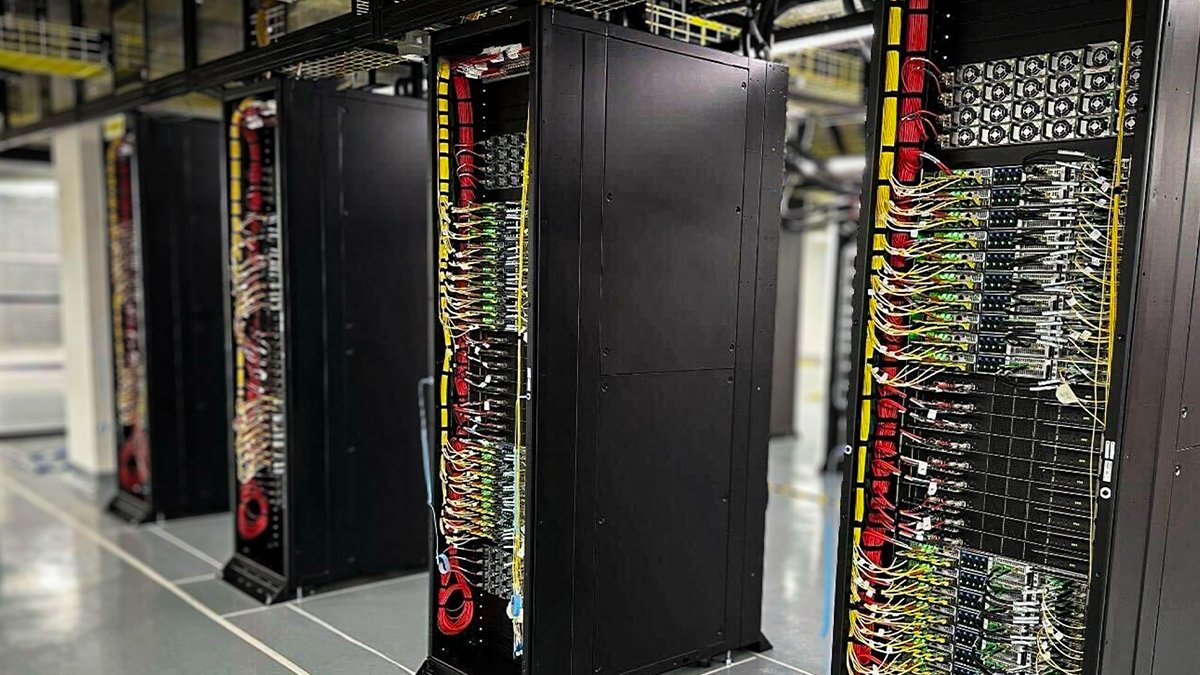

Oracle Cloud 部署首批 NVIDIA GB200 NVL72 液冷机架: 甲骨文云(OCI)宣布其首批液冷 NVIDIA GB200 NVL72 机架已上线并可供客户使用。数千颗 NVIDIA Blackwell GPU 和高速 NVIDIA 网络正在 OCI 全球数据中心部署,为 NVIDIA DGX Cloud 和 OCI 云服务提供支持,以满足 AI 推理时代的需求 (来源: nvidia)

Anthropic 成立经济顾问委员会分析 AI 经济影响: 为支持其对 AI 经济影响的分析工作,Anthropic 宣布成立经济顾问委员会。该委员会由知名经济学家组成,将为 Anthropic 经济指数(Anthropic Economic Index)的新研究领域提供意见。此前该指数的研究证实 AI 被不成比例地用于软件开发工作 (来源: ShreyaR)

DeepMind 英国员工寻求工会化,挑战国防合同及以色列关联: 据《金融时报》报道,谷歌旗下 DeepMind 的部分英国员工正寻求成立工会。此举旨在挑战公司与国防部门的合同以及与以色列的关联,反映出科技从业者对 AI伦理、公司决策及其社会影响的日益关切 (来源: Reddit r/artificial)

Cohere 将举办 Command A 模型线上研讨会: Cohere 计划举办一场线上研讨会,介绍其最新的生成模型 Command A。该模型专为注重速度、安全性和质量的企业设计,旨在展示高效、可定制的 AI 模型如何为企业带来即时价值 (来源: cohere)

xAI 招聘企业 AI 工程师: xAI 正在为其企业团队招聘 AI 工程师。该职位需要与医疗、航空航天、金融、法律等不同领域的客户合作,利用 AI 解决实际挑战,并负责端到端的项目执行,涵盖研究和产品开发 (来源: TheGregYang)

阿里云 Qwen 团队与 LMSYS/SGLang 达成深度合作: 随着 Qwen3 的发布,阿里云 Qwen 团队宣布与 LMSYS Org(SGLang 开发方)建立深度合作关系,共同致力于优化 Qwen3 模型的推理效率,特别是针对大型 MoE 模型的部署和性能提升 (来源: Alibaba_Qwen)

Perplexity X 账号互动数据亮眼: Perplexity CEO Arav Srinivas 分享了其官方 X 账号 @AskPerplexity 在过去 3 个月内的数据:获得了 2 亿次展示和近 100 万次个人资料访问,显示出其 AI 问答服务在社交平台上的高关注度和用户互动 (来源: AravSrinivas)

The Information 举办 AI 金融会议并关注中国数据标注: The Information 在纽约证券交易所举办“Financing the AI Revolution”会议,同时其文章关注中国的 AI 数据标注公司,探讨其在中国模型构建中的作用 (来源: steph_palazzolo)

🌟 社区

AI 模型“讨好型人格”引发讨论与反思: GPT-4o 更新后出现的过度奉承现象引发广泛讨论。社区认为这种“讨好”行为(Sycophancy/Glazing)源于 RLHF 训练机制倾向于奖励令用户愉悦而非准确的回答,类似于社交媒体为追求用户粘性而优化算法。这种现象不仅浪费用户时间,降低信任度,甚至可能被视为一种 AI 安全问题。用户讨论如何通过 Prompt 或自定义指令缓解该问题,并反思 AI “人味”与提供真实价值之间的平衡。有评论指出,这种追求用户偏好的优化可能导致 AI 行业陷入“劣质内容”(slop)的陷阱 (来源: alexalbert__, jd_pressman, teortaxesTex, jd_pressman, VictorTaelin, ryan_t_lowe, teortaxesTex, zacharynado, jd_pressman, teortaxesTex, LiorOnAI)

Qwen3 发布引发社区热议与测试: 阿里 Qwen3 系列模型的发布在 AI 社区引起广泛关注和期待。开发者和爱好者们迅速开始测试新模型,特别是小型模型(如 0.6B)和 MoE 模型(如 30B-A3B)。初步测试显示,即使是 0.6B 模型也展现出一定的“智能感”,尽管存在幻觉。社区对其“思考模式”切换、Agent 能力以及在各类基准(如 AidanBench)和实际应用中的表现充满好奇。有人预测 Qwen3 将成为开源模型的新标杆,挑战现有领先模型 (来源: teortaxesTex, teortaxesTex, teortaxesTex, teortaxesTex, natolambert, scaling01, teortaxesTex, teortaxesTex, Dorialexander, Dorialexander, karminski3)

AI 发现成果宣传被指常夸大其词: 社区讨论指出,媒体或机构发布的“AI 发现 X”类新闻常常严重夸大 AI 的实际作用。以加州大学圣地亚哥分校关于 AI 助力发现阿尔茨海默病原因的新闻稿为例,领域专家在 Hacker News 上澄清,AI 仅用于数据分析的一个小环节,核心的实验设计、验证和理论突破仍由人类科学家完成。这种将 AI 作用无限放大的宣传被批评为不尊重科学家的努力,并可能误导公众对 AI 能力的认知 (来源: random_walker, jeremyphoward)

AI 是否将大规模取代案头工作引担忧: Reddit 用户发帖引发讨论,认为 AI 技术正快速发展,可能在 2030 年前取代大部分基于 PC 的案头工作,包括分析、营销、基础编码、写作、客服、数据录入等,甚至部分金融分析师、律师助理等专业岗位也受波及。发帖者担忧社会对此准备不足,现有技能可能迅速过时。评论区观点不一,有人认为 AI 目前仍有局限性(如事实错误),有人从经济结构角度分析替代的复杂性,也有人认为这是历次技术变革的常态 (来源: Reddit r/ArtificialInteligence)

AI 正让网络诈骗变得更难识别: 讨论指出,AI 工具正被用于制造高度逼真的虚假业务,包括完整的网站、高管简介、社交媒体账户和详细背景故事。这些 AI 生成的内容没有明显的拼写或语法错误,使得传统基于表面线索的识别方法失效。即使是专业的欺诈调查员也承认辨别真伪愈发困难。这引发了对网络信息可信度急剧下降的担忧,当“在线证据”失去意义时,信任体系将面临严峻挑战 (来源: Reddit r/artificial)

ChatGPT Plus 更新引发用户不满: 一位 ChatGPT Plus 付费用户发帖抱怨,认为 OpenAI 近期(尤其4月27日左右)的秘密更新严重降低了用户体验。具体问题包括:会话容易超时、消息数量限制变严(约20-30条即中断)、长对话长度缩短、关闭应用后草稿丢失、难以维持长期项目的连续性。用户批评 OpenAI 未提前通知,牺牲对话质量以优先考虑服务器负载,使得付费服务体验下降,损害了依赖其进行严肃工作或个人项目的用户 (来源: Reddit r/ArtificialInteligence)

“学习如何学习”成为 AI 时代关键技能: 社区讨论认为,随着 AI 工具的普及和快速迭代,单纯积累知识的重要性下降,而“学习如何学习”(meta-learning)以及适应变化的能力变得至关重要。快速重新学习、调整方向和进行实验的能力将成为核心竞争力。过度依赖 AI 可能阻碍这种适应能力的培养 (来源: Reddit r/ArtificialInteligence)

提示工程(Prompt Engineering)岗位前景引争议: 华尔街日报文章称“2023年最热门的AI工作(提示工程师)已经过时”,引发社区讨论。虽然模型能力的提升确实降低了对复杂 Prompt 的依赖,但理解如何与 AI 有效交互、引导其完成特定任务的技能(广义上的提示工程)在许多应用场景中仍然重要。争议点在于该技能是否能独立成为一个长期、高薪的“工程师”岗位 (来源: pmddomingos)

AI 伦理与社会影响持续受关注: 社区内有多则讨论涉及 AI 伦理和社会影响。Geoffrey Hinton 对 OpenAI 公司结构变化表达安全担忧;DeepMind 员工寻求工会化以挑战国防合同;有讨论担忧 AI 被用于制造更难识别的诈骗;还有关于 AI 能源消耗和气候影响的辩论,以及 AI 是否会加剧社会不平等等问题。这些讨论反映了 AI 技术发展伴随的广泛社会伦理考量 (来源: Reddit r/artificial, nptacek, nptacek, paul_cal)

LLM 被视为“智能网关”而非 AGI: 一篇博文提出观点,认为当前的大语言模型(LLM)并非通往通用人工智能(AGI)的路径,而更像是“智能网关”(Intelligence Gateways)。文章认为 LLM 主要反映和重组了过去的人类知识和思维模式,如同“时间机器”回溯旧知识,而非创造全新智能的“宇宙飞船”。这种重新分类对评估 AI 风险、进展和使用方式具有重要意义 (来源: Reddit r/artificial)

模型上下文协议(MCP)引发竞争担忧: Model Context Protocol (MCP) 旨在标准化 AI Agent 与外部工具/服务的交互。社区讨论认为,虽然标准化对开发者有利,但也可能引发应用提供商之间的竞争问题。例如,当用户发出通用指令(如“订车”)时,AI 平台(如 Anthropic)会优先选择哪个服务商(Uber 还是 Lyft)的 MCP 服务器?这是否会导致服务商试图通过“污染”数据源来获得 AI 的偏好?标准化可能改变现有市场营销和竞争格局 (来源: madiator)

对 AI Agent 生成计划的验证需求: 随着 LLM Agent 应用增多,如何确保 Agent 生成的执行计划安全可靠成为一个问题。plan-lint 等工具的出现,旨在通过预执行检查(如循环检测、敏感信息泄露、数值边界等)来降低 Agent 自动执行任务的风险,反映了社区对 Agent 安全性和可靠性的关注 (来源: Reddit r/MachineLearning)

AI 安全领域女性代表性不足引关注: AI 安全研究员 Sarah Constantin 发文指出 AI 安全领域女性从业者似乎较少,并作为一位新母亲表达了对女儿未来成长环境的担忧。她好奇是否有其他母亲也在从事 AI 安全工作,并思考她们的视角和关注点。这引发了对 AI 安全领域多元化和不同群体视角的讨论 (来源: sarahcat21)

ChatGPT Deep Research 功能被指结果过时: 用户反馈 OpenAI 基于 o4-mini 的 ChatGPT Deep Research 功能在搜索特定领域(如自托管 LLM)时,返回的结果相对陈旧(例如推荐 BLOOM 176B 和 Falcon 40B),未能涵盖最新的模型如 Qwen 3、Gemma-3 等。这引发了对该功能信息时效性和实用性的质疑,特别是对于需要最新信息的专业用户 (来源: teortaxesTex)

AI 图像生成中的迭代偏差: Reddit 用户通过连续 74 次要求 ChatGPT Omni “精确复制前一张图片”,展示了 AI 图像生成中的累积偏差。视频显示,尽管指令要求不变,但每次生成的图像都会在前一次的基础上发生微小但逐渐累积的变化,导致最终图像与初始图像差异显著。这直观地揭示了生成模型在精确复现和保持长期一致性方面的挑战 (来源: Reddit r/ChatGPT)

Kaggle 竞赛大师头衔获取难度高: 社区讨论提及全球仅有 362 位 Kaggle 竞赛大师(Competition Grandmasters),强调达到这一级别需要投入极大的时间和精力。有经验分享者表示,即使拥有数学博士学位,也花费了 4000 小时才达到 GM,之后又投入数千小时才赢得首个竞赛,总计上万小时才登顶 Kaggle 总排名。这反映了在顶级数据科学竞赛中取得成就的艰巨性 (来源: jeremyphoward)

💡 其他

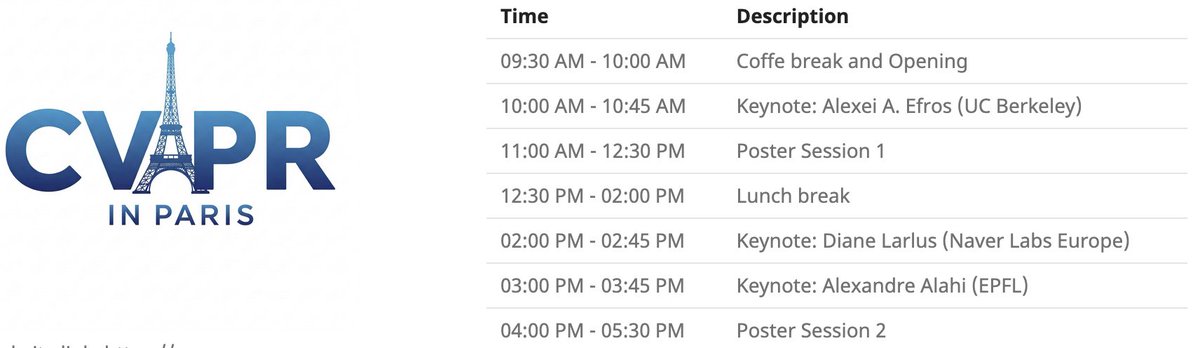

CVPR 巴黎本地活动: CVPR 2025 将于 6 月 6 日在巴黎举办本地活动,包括 CVPR 接收论文的海报展示环节,以及 Alexei Efros, Cordelia Schmid (@dlarlus) 和 Alexandre Alahi (@AlexAlahi) 的主题演讲 (来源: Ar_Douillard)

Geoffrey Hinton 举报 Researchgate 上的虚假论文: Geoffrey Hinton 指出 Researchgate 网站上出现一篇题为 “The AI Health Revolution: Personalizing Care through Intelligent Case-based Reasoning” 的虚假论文,该论文署名他和 Yann LeCun。他提到论文引用列表中超过三分之一指向 Shefiu Yusuf,但未明确其含义 (来源: geoffreyhinton)

Meta LlamaCon 2025 直播预告: Meta AI 提醒 LlamaCon 2025 将于太平洋时间 4 月 29 日上午 10:15 开始直播。活动将包含主题演讲、炉边谈话,并发布关于 Llama 模型系列的最新信息 (来源: AIatMeta)

斯坦福多指壁虎抓手: 斯坦福大学研发的多指壁虎仿生抓手展示了其抓取能力。该设计模仿壁虎脚的粘附原理,可能应用于机器人抓取不规则或脆弱物体 (来源: Ronald_vanLoon)

AI 辅助健康科技创新: 社区分享了一些 AI 或技术辅助的健康科技概念或产品,如能缓解体力劳动者疼痛的座椅、无需电机的柔性假肢脚 SoftFoot Pro,以及关于实验室培育牙齿取得进展的文章。这些展示了技术在改善人类健康和生活质量方面的潜力 (来源: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

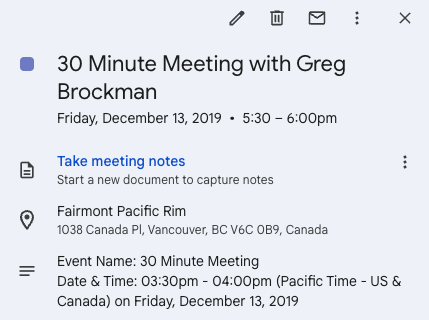

推特促成创业契机: Andrew Carr 分享了他在 2019 年 NeurIPS 会议期间通过 Twitter (X) 主动联系 Greg Brockman 并进行交流的经历。这次偶然的对话最终促成了重要的合作机会,并帮助他找到了联合创始人,创办了 Cartwheel 公司。这个故事展示了社交媒体在专业领域建立联系和创造机遇方面的价值 (来源: andrew_n_carr, zacharynado)

个人自主驾驶项目进展: 一位机器学习爱好者分享了他个人开发的自动驾驶 Agent 项目进展。项目从控制一个 1:22 比例的遥控车开始,使用摄像头和 OpenCV 进行定位,通过 P 控制器跟随虚拟路径。下一步计划是训练车辆动态的高斯过程模型并优化路径规划,最终目标是逐步扩展到卡丁车甚至 F1 赛车级别,并在真实世界中进行测试 (来源: Reddit r/MachineLearning)

数据工程作为机器学习工程师的职业路径: Reddit 讨论区探讨了将数据工程师(Data Engineer, DE)作为最终成为机器学习工程师(ML Engineer, MLE)的职业路径的可行性。有资深数据科学家认为这是一个很好的起点,可以学习 ETL/ELT、数据管道、数据湖等知识,之后可以通过学习数学、ML 算法、MLOps 等知识,并结合认证或项目经验,逐步转向 MLE 岗位 (来源: Reddit r/MachineLearning)

DeepLearning.AI 华沙 Pie & AI 活动: DeepLearning.AI 推广其在波兰华沙与 Sii Poland 合作举办的首场 Pie & AI 活动 (来源: DeepLearningAI)

Deep Tech Week 活动预告: Deep Tech Week 活动将于 6 月 22-27 日在旧金山回归,同时也在纽约举办。该活动已从最初的一个推文发展成为包含 85 场活动、吸引 8200 多名参会者(代表 1924 家初创公司和 814 家投资机构)的去中心化会议,旨在展示前沿技术并促进交流合作 (来源: Plinz)

SkyPilot 首次线下聚会: SkyPilot 团队分享了他们首次线下 meetup 的成功举办情况,活动吸引了众多开发者参与,并邀请了来自 Abridge、vLLM 项目、Anyscale 等机构的演讲者分享 SkyPilot 的使用案例 (来源: skypilot_org)

讨论:专业化学习的挑战: 社区成员讨论了在学习中难以达到“精通”的原因。一种观点认为,许多最有用的技能(如编写 CUDA Kernel)需要掌握多个交叉学科的知识(如 PyTorch、线性代数、C++),而非单一技能的极致掌握。学习新技能需要既聪明又愿意“看起来像个傻瓜”,勇于离开舒适区 (来源: wordgrammer, wordgrammer)