关键词:GPT-4.1, Hugging Face, GPT-4.1系列模型性能对比, Hugging Face收购Pollen Robotics, OpenAI新模型编码能力提升, GPT-4.1 mini成本降低83%, 开源机器人Reachy 2

🔥 聚焦

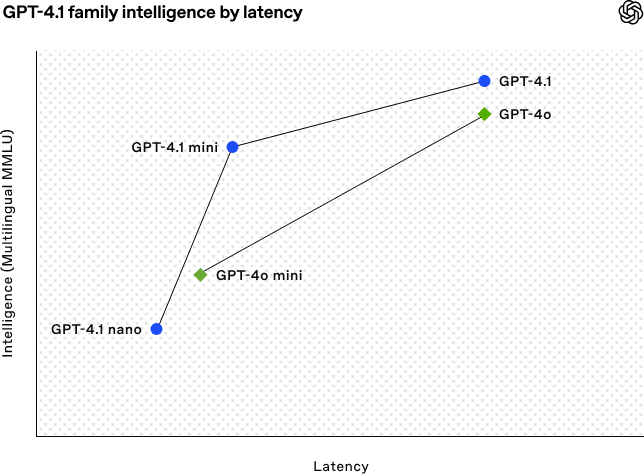

OpenAI发布GPT-4.1系列模型,强化编码与长文本处理能力:OpenAI于4月15日凌晨发布了GPT-4.1系列三款新模型:GPT-4.1(旗舰)、GPT-4.1 mini(高效)、GPT-4.1 nano(超小型),均仅通过API提供。该系列模型在编码、指令遵循和长上下文理解方面表现优异,上下文窗口均达100万token,输出token达32768。GPT-4.1在SWE-bench Verified测试中得分54.6%,显著优于GPT-4o及将被弃用的GPT-4.5 Preview。GPT-4.1 mini在性能超越GPT-4o的同时,延迟减半、成本降低83%。GPT-4.1 nano则为目前最快、最低成本模型,适用于低延迟任务。此次发布旨在为开发者提供性能更强、成本更优、速度更快的模型选择,推动复杂智能系统和智能体应用的构建。 (来源: 36氪, 智东西, op7418, openai, karminski3, sama, natolambert, karminski3, karminski3, karminski3, dotey, OpenAI, GPT-4.1来了,超越GPT-4.5,SWE-Bench达到55%,开发者专属。)

Hugging Face收购开源机器人公司Pollen Robotics:AI社区平台Hugging Face宣布收购法国开源机器人初创公司Pollen Robotics,旨在推动AI机器人的开源化和普及化。此次收购将结合Hugging Face在软件平台(如LeRobot库和Hub)的优势与Pollen Robotics在开源硬件(如Reachy 2人形机器人)方面的专长。Reachy 2是一款专为研究、教育和具身智能实验设计的开源、VR兼容的人形机器人,售价7万美元。Hugging Face认为机器人是AI的下一个重要交互界面,应致力于开放、可负担、可定制化,此次收购是其实现这一愿景的关键一步,目标是让社区能够构建和控制自己的机器人伙伴,而非依赖封闭昂贵的系统。 (来源: huggingface, huggingface, huggingface, huggingface, huggingface, huggingface, huggingface, huggingface, huggingface, huggingface, huggingface, huggingface, huggingface)

🎯 动向

AI助力解决50年未解数学难题:美国布鲁克海文国家实验室的华人学者Weiguo Yin利用OpenAI的推理模型o3-mini-high,在一维J_1-J_2 q态Potts模型的精确求解上取得突破,特别是在q=3的情况下,AI辅助完成了关键证明。该问题涉及统计力学基础模型,与层状材料原子堆叠、非常规超导等物理现象相关,其精确解在过去50年未能实现。研究者通过引入最大对称子空间(MSS)方法,并借助AI逐步提示处理传递矩阵,成功将q=3时的9×9传递矩阵简化为有效的2×2矩阵,并将此方法推广至任意q值。这项研究不仅解决了长期存在的数学物理难题,也展示了AI在辅助复杂科学研究、提供新见解方面的巨大潜力。 (来源: 刚刚,AI破解50年未解数学难题!南大校友用OpenAI模型完成首个非平凡数学证明)

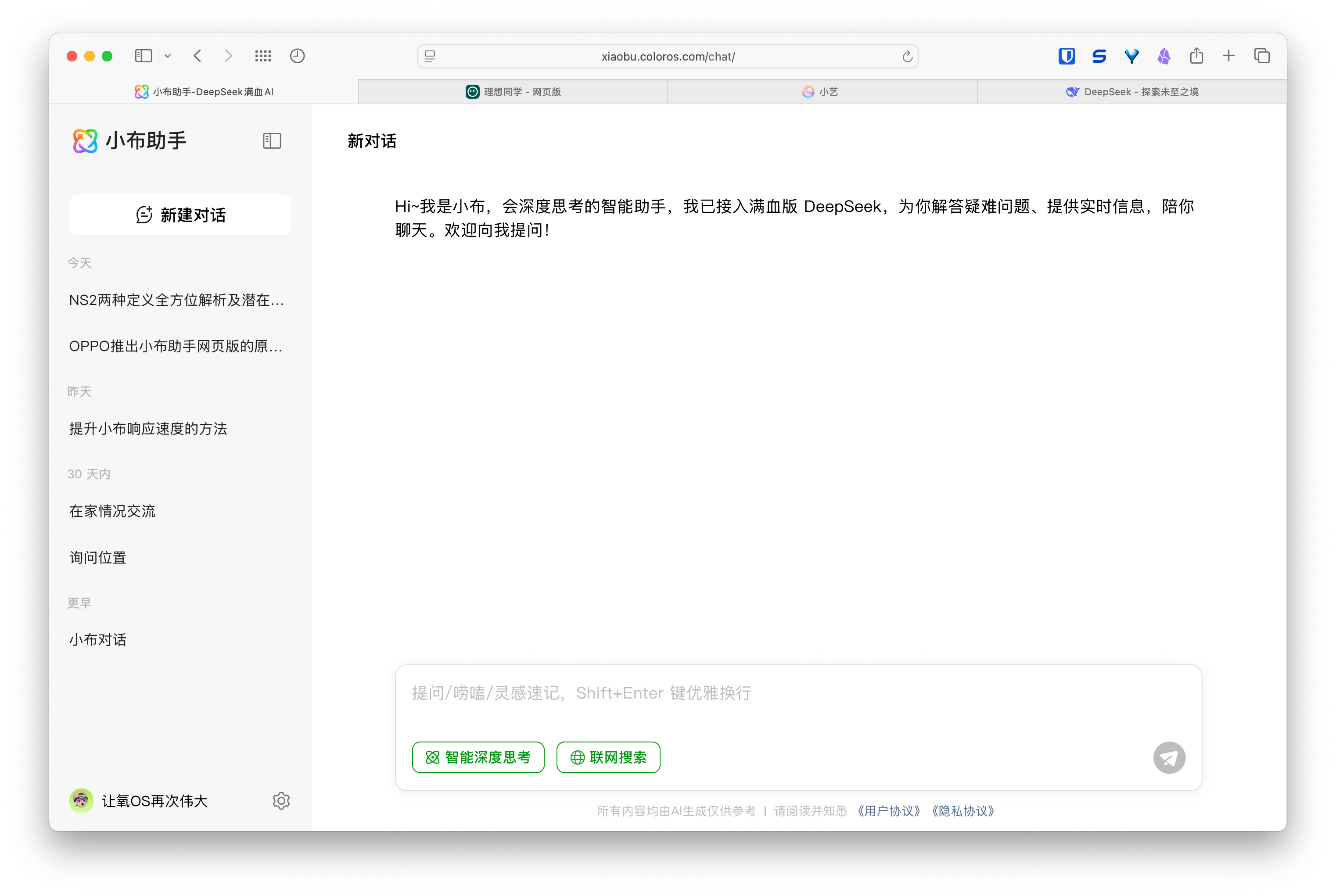

AI网页版助手兴起,手机与汽车厂商布局多端体验:华为(小艺助手)、理想汽车(理想同学)、OPPO(小布助手)等厂商相继推出其AI助手的网页版,引发关注。尽管这些网页版在功能完善度上(如编辑问题、排版、设置选项)可能不及DeepSeek等专业模型服务,但其核心目标并非直接竞争,而是服务于各自品牌的用户,打通手机、车机到PC端的体验闭环。通过绑定用户账号、同步对话记录,这些网页版旨在增强用户粘性,提供跨终端的一致交互体验,并将AI助手融入更广泛的用户场景,本质上是一场关于用户入口和数据生态的布局。 (来源: AI网页版扎堆上线,华为、理想、OPPO们打的什么算盘?)

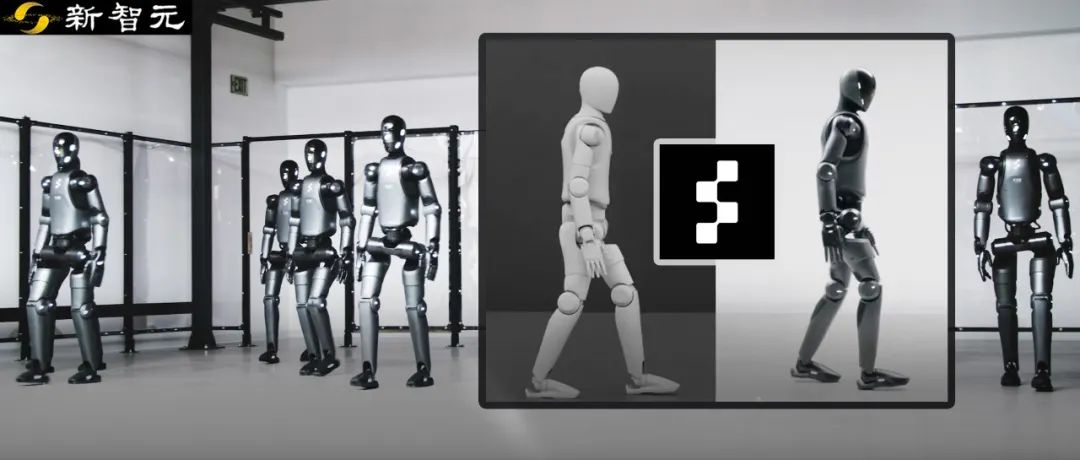

Figure机器人通过强化学习实现模拟到现实的零样本迁移:Figure公司展示了其Figure 02人形机器人通过纯模拟环境中的强化学习(RL)实现自然步态。利用高效GPU加速的物理模拟器,在几小时内生成相当于数年的训练数据,训练出一个能控制多个具有不同物理参数和场景(如不同地形、干扰)的虚拟机器人的单一神经网络策略。通过结合模拟域随机化和真实机器人的高频扭矩反馈,训练出的策略能够零样本迁移到物理机器人上,无需微调。这套方法不仅缩短了开发时间,提高了真实世界表现的稳定性,且一个策略可控制整个机器人军团,展示了其在大规模商业应用中的潜力。 (来源: 一套算法控制机器人军团!纯模拟环境强化学习,Figure学会像人一样走路)

DeepSeek将开源部分推理引擎优化:DeepSeek宣布计划将其基于vLLM修改的高性能推理引擎的部分优化和特性贡献回社区。他们不会发布完整的、高度定制化的推理栈,而是选择将关键改进(如对最新模型架构的支持、性能优化)集成到vLLM和SGLang等主流开源推理框架中,目标是让社区能够从第一天起就获得对新模型和技术的SOTA级支持。此举受到社区欢迎,被认为是真正致力于开源贡献而非仅仅口头宣传。 (来源: Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, natolambert)

智谱AI疑似将发布GLM-4系列新模型:根据GitHub上泄露的信息(后被移除),智谱AI似乎准备发布GLM-4系列新模型。该系列可能包含不同参数规模(如9B、32B)和功能的版本,例如基础模型(GLM-4-32B-0414)、对话模型(Chat)、推理模型(GLM-Z1-32B-0414)以及具备更深度思考能力的“反刍”模型(Rumination),可能对标OpenAI的Deep Research。此外,还可能包含视觉多模态模型(GLM-4V-9B)。泄露的基准测试数据显示,GLM-4-32B-0414在部分指标上可能优于DeepSeek-V3和DeepSeek-R1。相关的推理引擎支持代码已合并到transformers/vllm/llama.cpp。社区对此高度关注,期待正式发布和测评。 (来源: karminski3, karminski3, Reddit r/LocalLLaMA)

NVIDIA发布Nemotron系列新模型:NVIDIA在Hugging Face上发布了新的Nemotron-H系列基础模型,包括56B、47B和8B三种参数规模,均支持8K上下文窗口。这些模型基于混合Transformer和Mamba架构。目前发布的是基础模型(Base),尚未提供指令微调(Instruct)版本。Nemotron系列旨在探索新架构在语言建模上的潜力。 (来源: Reddit r/LocalLLaMA)

🧰 工具

GitHub Copilot集成至Windows Terminal Canary版:微软将GitHub Copilot功能集成到了Windows Terminal的Canary预览版中,推出了名为“终端聊天”(Terminal Chat)的新特性。该功能允许用户直接在终端环境中与AI互动,获取命令建议和解释。用户需订阅GitHub Copilot并安装最新Canary版终端,验证账户后即可使用。此举旨在将AI辅助直接融入开发者常用的命令行环境,减少上下文切换,提高处理复杂或不熟悉任务的效率,加速学习进程,并有助于减少错误。 (来源: GitHub Copilot 现可在 Windows 终端中运行了)

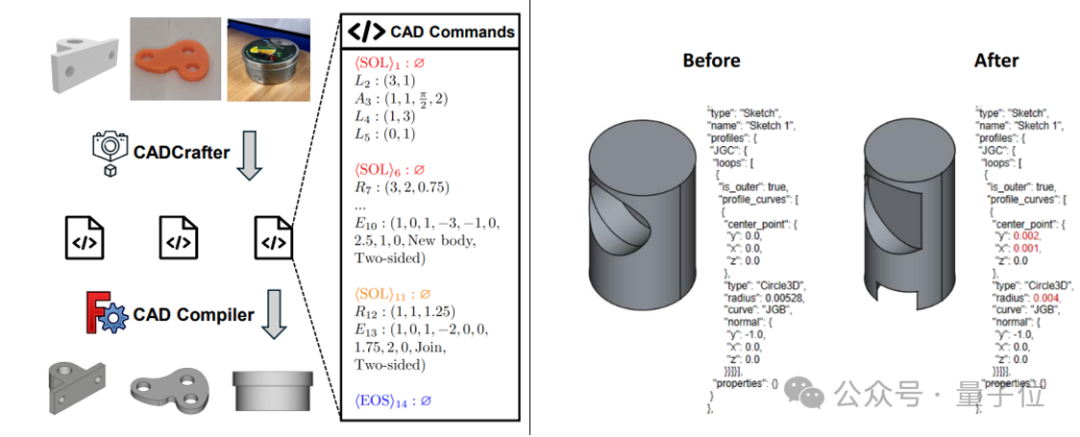

CADCrafter:单图生成可编辑CAD文件:由魔芯科技(KOKONI 3D)、南洋理工大学等机构的研究者提出了一种名为CADCrafter的新框架,能够从单张图像(渲染图、实物照片等)直接生成参数化的、可编辑的CAD工程文件(以CAD指令序列表示),解决了现有图生3D方法(生成Mesh或3DGS)产出模型难以精确编辑和表面质量不高的问题。该方法采用VAE与Diffusion Transformer结合的两阶段生成架构,并通过多视图到单视图的蒸馏策略以及基于DPO的可编译性检查机制来提升生成质量和成功率。研究成果已被CVPR 2025接收,为AI辅助工业设计提供了新范式。 (来源: 单图直出CAD工程文件!CVPR 2025新研究解决AI生成3D模型“不可编辑”痛点|魔芯科技NTU等出品)

LangChain推出GraphRAG与MongoDB Atlas集成:LangChain宣布与MongoDB合作,推出基于图的RAG(GraphRAG)系统。该系统利用MongoDB Atlas存储和处理数据,通过LangChain实现,能够超越传统的基于相似性搜索的RAG,理解和推理实体间的关系。它支持通过LLM进行实体和关系抽取,并利用图遍历来获取连接的上下文信息,旨在为需要深度关系理解的应用提供更强大的问答和推理能力。 (来源: LangChainAI)

Hugging Face开源其推理游乐场(Inference Playground):Hugging Face将其用于模型推理测试和比较的在线工具Inference Playground开源。这是一个基于Web的LLM聊天界面,允许用户控制各种推理设置(如温度、top-p等)、修改AI响应、比较不同模型和提供商的表现。该项目使用Svelte 5、Melt UI和Tailwind构建,代码已在GitHub上发布,为开发者提供了一个可定制和扩展的本地或在线模型交互与评估平台。 (来源: huggingface)

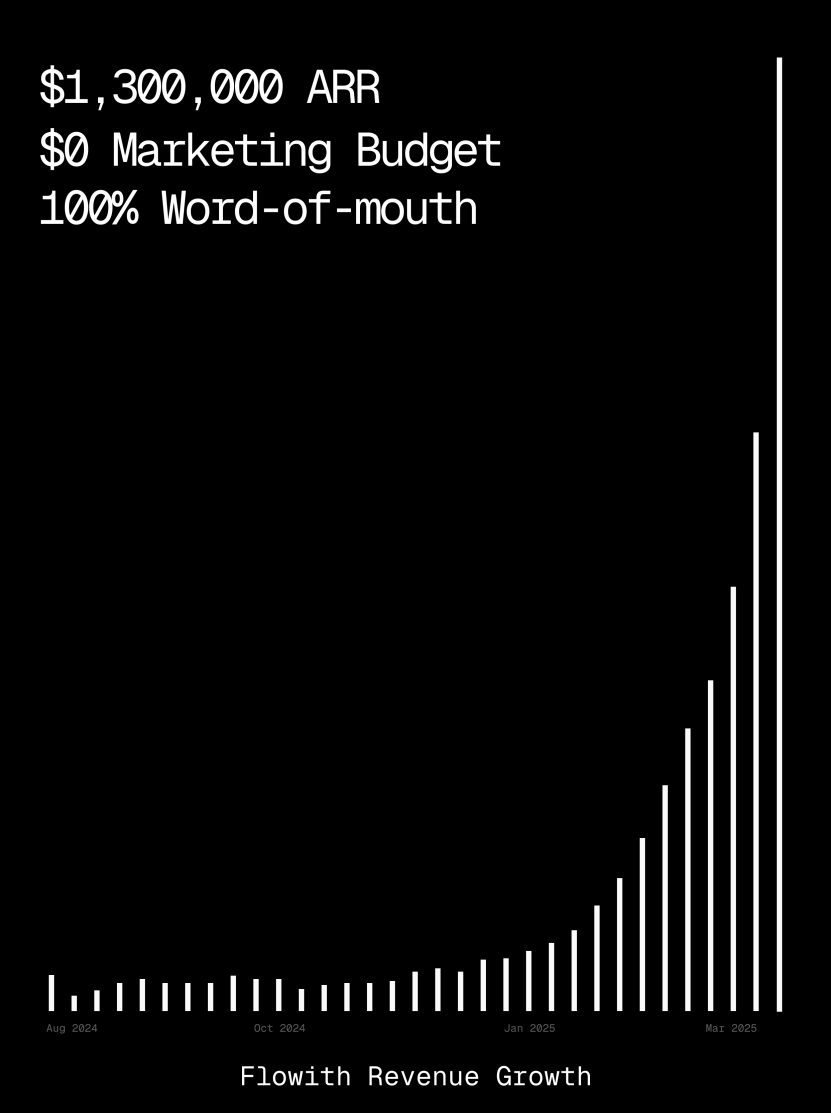

Flowith平台ARR超百万美元,展示AI Agent生成网页能力:AI Agent平台Flowith的年度经常性收入(ARR)已超过100万美元,显示出市场对能够替代人工的全能AI Agent平台的强烈需求。用户分享了使用Flowith的Oracle功能,仅通过简单的自然语言描述(“我想要做个社交媒体图文预览程序网页…”),即可快速生成功能完善、样式精确还原(如Twitter风格)且支持图片预览的网页小工具,无需连接GitHub或进行复杂配置,体现了AI Agent在低代码/无代码网页生成方面的潜力。 (来源: karminski3)

自主调试代理Deebo发布:研究者构建了一个名为Deebo的自主调试代理MCP服务器。它作为一个本地守护进程运行,编程代理可以将棘手的错误处理任务异步卸载给它。Deebo通过生成多个具有不同修复假设的子进程,在隔离的git分支中运行每个场景,并由一个“母代理”进行循环测试、推理,最终返回诊断结果和建议的补丁。在一个真实的tinygrad $100悬赏bug测试中,Deebo成功识别了问题根源并提出了两个具体修复方案,通过了测试。 (来源: Reddit r/MachineLearning)

![[D] We built an autonomous debugging agent. Here’s how it grokked a $100 bug](https://rebabel.net/wp-content/uploads/2025/04/81BPXr5Ywnk-6MetZBQchhgsROH341CoTk3xAdE5Jic.jpg)

📚 学习

Nabla-GFlowNet:兼顾多样性与效率的扩散模型奖励微调新方法:针对扩散模型微调中,传统强化学习收敛慢、直接奖励最大化易过拟合且损失多样性的问题,港中文(深圳)等机构的研究者提出Nabla-GFlowNet。该方法基于生成流网络(GFlowNet)框架,将扩散过程视为流平衡系统,推导出Nabla-DB平衡条件及相应损失函数。通过参数化设计,利用单步去噪估计残差梯度,避免了额外网络估计。实验表明,在美学评分、指令跟随等奖励函数上微调Stable Diffusion时,Nabla-GFlowNet相比ReFL、DRaFT等方法能更快收敛且不易过拟合,同时保持了生成样本的多样性。 (来源: ICLR 2025 | 扩散模型奖励微调新突破!Nabla-GFlowNet让多样性与效率兼得)

MegaMath:371B Tokens的最大开源数学推理数据集发布:由LLM360推出的MegaMath数据集,包含3710亿Tokens,旨在解决开源社区缺乏大规模、高质量数学推理预训练数据的问题。该数据集分为数学密集网页(279B)、数学相关代码(28.1B)和高质量合成数据(64B)三部分。构建过程中采用了创新的数据处理流水线,包括针对数学公式优化的HTML解析、两阶段文本抽取、动态教育价值打分、代码数据的多步精确召回以及多种大规模合成方法(Q&A、代码生成、文本代码交错)。在Llama-3.2(1B/3B)上进行的100B Tokens预训练验证显示,MegaMath能在GSM8K、MATH等基准上带来15-20%的绝对性能提升。 (来源: 3710亿数学Tokens!全球最大开源数学数据集MegaMath震撼发布,碾压DeepSeek-Math)

OS Agents综述:基于多模态大模型的计算机、手机与浏览器智能体研究:浙江大学联合OPPO、零一万物等机构发布了一篇关于操作系统智能体(OS Agents)的综述论文。文章系统梳理了利用多模态大语言模型(MLLM)构建能在电脑、手机、浏览器等环境中自动完成任务的智能体(如Anthropic的Computer Use、苹果的Apple Intelligence)的研究现状。内容涵盖OS Agents的基础(环境、观察空间、动作空间、核心能力)、构建方法(基础模型架构与训练策略、智能体框架的感知/规划/记忆/行动模块)、评估协议与基准,以及相关商业产品和未来挑战(安全隐私、个性化与自我进化)。研究团队维护了一个包含250+相关论文的开源仓库,旨在推动该领域发展。 (来源: 浙大、OPPO等发布最新综述:基于多模态大模型的计算机、手机与浏览器智能体研究)

NLPrompt:结合MAE损失与最优传输的鲁棒提示学习方法:上海科技大学YesAI Lab在CVPR 2025 Highlight论文中提出NLPrompt,旨在解决视觉语言模型提示学习中的标签噪声问题。研究发现,在提示学习场景下,使用平均绝对误差(MAE)损失(PromptMAE)比交叉熵(CE)损失更能抵抗噪声标签的影响,并从特征学习理论角度证明了其鲁棒性。此外,提出基于提示的最优传输数据净化方法(PromptOT),利用文本特征作为原型,将数据集划分为干净子集(用CE损失训练)和带噪子集(用MAE损失训练),有效融合两种损失的优势。实验证明NLPrompt在合成及真实噪声数据集上均表现优越,并具备良好的泛化性。 (来源: CVPR 2025 | MAE损失+最优传输双剑合璧!上科大提出全新鲁棒提示学习方法)

DeepSeek-R1推理机制分析:麦吉尔大学的研究者分析了DeepSeek-R1这类大型推理模型的推理过程。与直接给出答案的LLM不同,推理模型会生成详细的多步推理链。研究探讨了推理链长度与性能的关系(存在“最佳点”,过长可能损害性能)、长上下文管理、文化与安全问题(相比非推理模型存在更强安全漏洞),以及与人类认知现象的关联(如持续纠结已探索问题)。该研究揭示了当前推理模型运作机制的一些特点和潜在问题。 (来源: LLM每周速递!| 涉及多模态、MoE模型、Deepseek推理、Agent安全控制、模型量化等)

MoE大模型测试时优化方法C3PO:约翰霍普金斯大学研究发现混合专家(MoE)LLM存在专家路径次优问题,提出测试时优化方法C3PO(关键层、核心专家、协作路径优化)。该方法不依赖真实标签,而是通过参考样本集中的“成功邻居”定义替代目标,优化模型性能。它采用模式查找、核回归、相似样本平均损失等算法,并为降低成本仅优化关键层的核心专家权重。应用于MoE LLM后,C3PO在六个基准测试中使基础模型准确率提升7-15%,超越常用测试时学习基线,并使小参数MoE模型性能超越更大参数LLM,提升了MoE效率。 (来源: LLM每周速递!| 涉及多模态、MoE模型、Deepseek推理、Agent安全控制、模型量化等)

量化对推理模型性能影响研究:清华大学研究团队首次系统探索了量化技术对推理型语言模型(如DeepSeek-R1系列、Qwen、LLaMA)性能的影响。研究评估了不同位宽(W8A8, W4A16等)的权重、KV缓存和激活量化算法在数学、科学、编程等推理基准上的表现。结果显示,W8A8或W4A16量化通常可实现无损性能,但更低位宽会带来显著的准确度下降风险。模型大小、来源和任务难度是影响量化后性能的关键因素。量化模型的输出长度并未显著增加,合理调整模型大小或增加推理步骤可提升性能。相关量化模型和代码已开源。 (来源: LLM每周速递!| 涉及多模态、MoE模型、Deepseek推理、Agent安全控制、模型量化等)

SHIELDAGENT:强制Agent符合安全策略的防护栏:芝加哥大学提出SHIELDAGENT框架,旨在通过逻辑推理强制AI Agent的行动轨迹符合明确的安全策略。该框架首先从策略文档中提取可验证规则,构建安全策略模型(基于概率规则电路),然后在Agent执行过程中,根据其行动轨迹检索相关规则并生成防护计划,利用工具库和可执行代码进行形式化验证,确保Agent行为不违反安全规定。同时发布了包含3K安全相关指令和轨迹对的数据集SHIELDAGENT-BENCH。实验表明,SHIELDAGENT在多个基准上达到SOTA,显著提升了安全符合率和召回率,同时降低了API查询和推理时间。 (来源: LLM每周速递!| 涉及多模态、MoE模型、Deepseek推理、Agent安全控制、模型量化等)

MedVLM-R1:通过强化学习激励医学VLM推理能力:慕尼黑工业大学、牛津大学等机构合作提出MedVLM-R1,一款旨在生成明确自然语言推理过程的医学视觉语言模型(VLM)。该模型采用DeepSeek的群体相对策略优化(GRPO)强化学习框架,在仅包含最终答案的数据集上训练,却能自主发现人类可解释的推理路径。在仅使用600个MRI VQA样本训练后,这个2B参数模型在MRI、CT、X射线基准测试中准确率达78.22%,显著优于基线,并展现出强大的域外泛化能力,甚至超越了Qwen2-VL-72B等更大规模模型。该研究为构建可信赖、可解释的医疗AI提供了新思路。 (来源: 小样本大能量!MedVLM-R1借力DeepSeek强化学习,重塑医疗AI推理能力)

研究揭示强化学习训练可能导致推理模型响应冗长:一项来自Wand AI的研究分析了推理模型(如DeepSeek-R1)生成较长响应的原因。研究发现,这种行为可能源于强化学习(特别是PPO算法)的训练过程,而非问题本身需要更长推理。当模型因错误答案获得负奖励时,PPO损失函数倾向于生成更长响应以稀释每个token的惩罚,即使额外内容无助于提高准确性。研究还表明,简洁的推理往往与更高的准确度相关。通过第二轮仅使用部分可解问题的强化学习训练,可以缩短响应长度,同时保持甚至提高准确度,这对提高部署效率具有重要意义。 (来源: 更长思维并不等于更强推理性能,强化学习可以很简洁)

中科大与中兴提出Curr-ReFT:提升小尺寸VLM推理与泛化能力:针对小尺寸视觉语言模型(VLM)在复杂任务上的“砖墙”现象(训练瓶颈)和域外泛化能力不足问题,中科大与中兴通讯提出课程式强化学习后训练范式(Curr-ReFT)。该范式结合课程学习(CL)和强化学习(RL),设计了难度感知的奖励机制,让模型从易到难(二元决策→多项选择→开放式回答)逐步学习。同时,采用基于拒绝采样的自我改进策略,利用高质量多模态和语言样本维持模型基础能力。在Qwen2.5-VL-3B/7B模型上的实验表明,Curr-ReFT显著提升了模型的推理和泛化性能,7B模型在部分基准上甚至超越了InternVL2.5-26B/38B。 (来源: 中科大、中兴提出新后训练范式:小尺寸多模态模型,成功复现R1推理)

GenPRM:通过生成式推理扩展过程奖励模型:清华大学与上海AI Lab提出生成式过程奖励模型(GenPRM),旨在解决传统过程奖励模型(PRM)依赖标量评分、缺乏可解释性且无法测试时扩展的问题。GenPRM采用生成式方法,结合思维链(CoT)推理和代码验证,对每一步推理进行自然语言分析和Python代码执行验证,提供更深入、可解释的过程监督。此外,GenPRM引入测试时扩展机制,通过并行采样多条推理路径并聚合奖励值来提升评估精度。仅使用23K合成数据训练的1.5B模型通过测试时扩展在ProcessBench上超越GPT-4o,7B版本超越72B的Qwen2.5-Math-PRM-72B。GenPRM还能作为批评模型指导策略模型优化。 (来源: 过程奖励模型也可以测试时扩展?清华、上海AI Lab 23K数据让1.5B小模型逆袭GPT-4o)

研究揭示推理AI在缺失前提问题上的“过度思考”现象:马里兰大学和利哈伊大学的研究发现,当前的推理模型(如DeepSeek-R1, o1)在面对缺少必要前提信息的问题(Missing Premise, MiP)时,往往表现出“过度思考”的倾向。它们会生成比正常问题长2-4倍的响应,陷入反复审视问题、猜测意图、自我怀疑的循环,而不是快速识别问题无法解决并停止。相比之下,非推理模型(如GPT-4.5)在MiP问题上响应更短,更能识别前提缺失。研究表明,推理模型虽能察觉到前提缺失,但缺乏果断中止无效推理的“批判性思维”,这种行为模式可能源于强化学习训练中对长度约束的不足,并通过蒸馏传播。 (来源: 推理AI「脑补」成瘾,废话拉满!马里兰华人学霸揭开内幕)

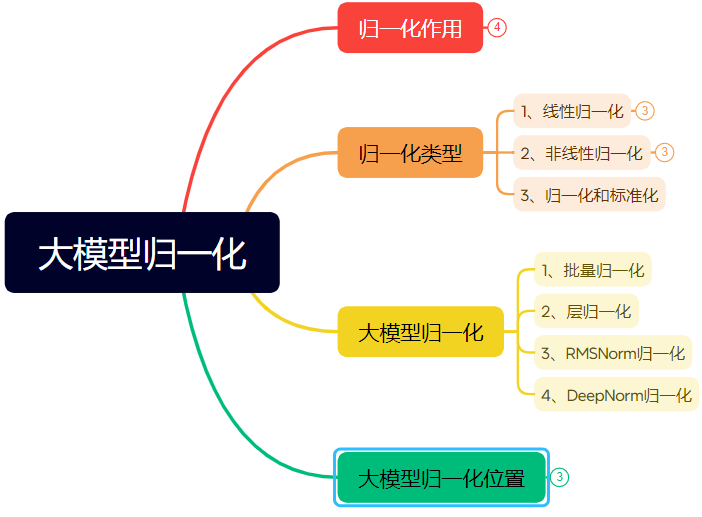

万字长文详解神经网络归一化技术演进:文章系统梳理了归一化(Normalization)在神经网络,特别是Transformer及大模型中的作用与演变。归一化通过将数据限制在固定范围,解决了数据可比性、提高了优化速度、缓解了激活函数饱和区和内部协变量偏移(ICS)问题。文章介绍了常见的线性(Min-max, Z-score, Mean)和非线性归一化方法,重点阐述了适用于深度学习模型的批量归一化(BN)、层归一化(LN)、RMSNorm和DeepNorm,分析了它们在Transformer架构中的应用差异(为何LN/RMSNorm更适用于NLP)。此外,还讨论了归一化模块在Transformer层内的不同放置位置(Post-Norm, Pre-Norm, Sandwich-Norm)及其对训练稳定性和性能的影响。 (来源: 万字长文!一文了解归一化:从Transformer归一化到主流大模型归一化的演变!)

利用AI生成特定风格字体设计的Prompt工程:文章分享了作者探索使用即梦AI 3.0生成具有特定风格文字设计的经验和提示词模板。作者发现直接指定字体名称(如宋体、楷体)效果不佳,AI模型对此理解有限。因此,作者转向描述字体风格特征、情感氛围和视觉效果,并结合不同风格的参照举例,构建了一个“高级文字风格设计提示生成器”的Prompt模板。用户只需输入文字内容,该模板即可根据文字内涵智能匹配或融合多种预设风格(如光韵夜影、工业质朴、童趣涂绘、金属科幻等),生成用于文生图模型的详细提示词,从而获得质量相对稳定的图文设计效果。 (来源: AI生成字体设计我有点玩明白了,用这套Prompt提效50%。, 即梦AI 3.0制作含字体封面,这个方案酷到封神【附:16+案例和Prompt】)

ZClip:用于LLM预训练的自适应梯度尖峰抑制方法:研究者提出ZClip,一种轻量级的自适应梯度裁剪方法,旨在减少LLM训练过程中的损失尖峰,提高训练稳定性。与使用固定阈值的传统梯度裁剪不同,ZClip采用基于z-score的方法来检测和裁剪异常的梯度尖峰,即那些显著偏离近期移动平均值的梯度。这种方法有助于在不干扰收敛的情况下保持训练稳定性,并且易于集成到任何训练循环中。代码和论文已发布。 (来源: Reddit r/deeplearning)

![[2504.02507] ZClip: Adaptive Spike Mitigation for LLM Pre-Training](https://rebabel.net/wp-content/uploads/2025/04/Swd9uQN43Dpl2SJyH6zjTbJAdRaXwKbmzZwM9L2rPXk.jpg)

💼 商业

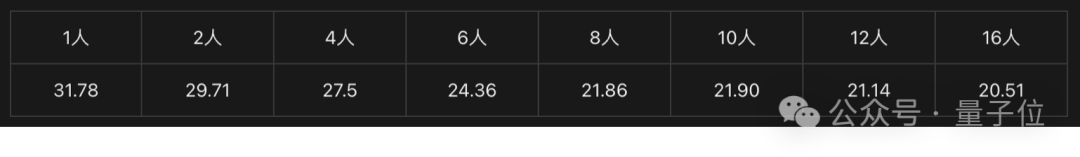

英特尔锐炫显卡+至强W处理器方案助力低成本AI一体机:英特尔通过其锐炫™显卡(Arc™)和至强® W处理器的组合,为市场提供了构建成本可控(10万元级别)且性能实用的大模型一体机方案。锐炫™显卡采用Xe架构和XMX AI加速引擎,支持主流AI框架和Ollama/vLLM,功耗较低且支持多卡并联。至强® W处理器提供高核心数和内存扩展能力,内置AMX加速技术。结合IPEX-LLM、OpenVINO™和oneAPI等软件优化,实现了CPU与GPU的高效协同。实测显示,该方案一体机运行QwQ-32B模型单人使用可达32 tokens/s,运行671B DeepSeek R1模型(需FlashMoE优化)可达近10 tokens/s,满足离线推理需求,推动AI推理普及化。 (来源: 榨干3000元显卡,跑通千亿级大模型的秘方来了)

NVIDIA将在美本土制造AI超级计算机:NVIDIA宣布将首次在美国本土完整设计和建造其AI超级计算机,并与主要制造伙伴合作。同时,其新一代Blackwell芯片已在亚利桑那州的台积电工厂开始生产。NVIDIA计划在未来4年内,在美国生产价值高达五千亿美元的AI基础设施,合作伙伴包括台积电、富士康、纬创、安靠和矽品精密。此举旨在满足AI芯片和超算需求,加强供应链,提升弹性。 (来源: nvidia, nvidia)

地平线机器人招聘3D重建/生成实习生:地平线机器人具身智能团队正在上海/北京招聘3D重建/生成方向算法实习生。职责包括参与设计和开发机器人Real2Sim算法方案(结合3D GS重建、前馈重建、3D/视频生成),优化Real2Sim仿真器性能(支持流体、触觉仿真等),以及跟踪前沿研究并发表顶会论文。要求硕士及以上学历,计算机/图形学/AI相关专业,有3D视觉/视频生成或多模态/扩散模型经验,熟练使用Python/Pytorch/Huggingface。顶会论文发表、熟悉仿真平台或开源项目经验者优先。提供转正机会、GPU集群和有竞争力薪资。 (来源: 上海/北京内推 | 地平线机器人具身智能团队招聘3D重建/生成方向算法实习生)

美团酒旅招聘L7-L8大模型算法工程师:美团酒旅供给算法团队在北京招聘L7-L8级别的大模型算法工程师(社招)。职责包括构建酒旅供给理解体系(商品标签、热点识别、相似供给挖掘等),优化展示素材(标题、图文、推荐理由生成),构建度假套餐组合(选品、销量预测、定价),以及探索和落地前沿大模型技术(微调、RL、Prompt优化)。要求硕士及以上学历,2年以上经验,计算机/自动化/数理统计相关专业,具备扎实的算法基础和代码能力。 (来源: 北京内推 | 美团酒旅供给算法团队招聘L7-L8大模型算法工程师)

Meta将在欧盟使用用户数据训练AI:Meta宣布准备开始使用欧盟地区Facebook和Instagram用户的公开数据(如帖子、评论,不含私信)来训练其AI模型,仅限18岁以上用户。公司将通过应用内通知和邮件告知用户,并提供反对(opt-out)的链接。此前,Meta因爱尔兰监管机构的要求暂停了在欧洲使用用户数据训练AI的计划。 (来源: Reddit r/artificial)

腾讯云推出MCP托管服务:腾讯云也开始提供MCP(Managed Cloud Platform)托管服务,旨在为企业提供更便捷、高效的云资源管理和运维解决方案。此举意味着主流云厂商在该领域的竞争加剧。具体服务细节和“微信特色”暂未详述。 (来源: 腾讯云也搞 MCP 托管了,还带了点“微信特色”。)

🌟 社区

图灵奖得主LeCun谈AI发展:人类智能非通用,下一代突破或在非生成式:在近期的播客访谈中,Yann LeCun再次强调AGI一词具有误导性,认为人类智能是高度专业化的,而非通用。他预测AI的下一个重大突破可能来自非生成式模型,重点在于让机器真正理解物理世界、具备推理规划能力和持久记忆,类似其提出的JEPA架构。他认为当前LLM缺乏真正的推理能力和对物理世界的建模能力,达到猫的智能水平已是巨大进步。对于Meta开源LLaMA,他认为是推动整个AI生态发展的正确选择,并强调创新来自全球,开源是加速突破的关键。他还看好智能眼镜作为AI助手的重要载体。 (来源: 图灵奖得主LeCun:人类智能不是通用智能,下一代AI可能基于非生成式)

GitHub短暂“封禁”中国IP引关注,官方称系配置错误:4月12日至13日,部分中国用户发现无法访问GitHub,页面提示“IP地址受到访问限制”,引发社区恐慌和讨论,担忧是否为针对性封锁。此前GitHub曾因美国制裁封禁过俄罗斯、伊朗等国开发者账号。GitHub官方随后回应称,此次事件是由于一项配置更改错误导致未登录用户暂时无法访问,问题已于4月13日修复。尽管是技术故障,但事件再次引发了对代码托管平台地缘政治风险和国内替代方案(如Gitee、CODING、极狐GitLab等)的讨论。 (来源: “Bug”还是“预演”?GitHub 突然“封禁”所有中国 IP,官方:只是“手滑”技术出错了)

AI Agent引发网络安全担忧:MIT科技评论文章指出,由AI驱动的自主网络攻击即将到来。随着AI能力的增强,恶意行为者可能利用AI Agent自动发现漏洞、策划并执行更复杂、更大规模的网络攻击,对个人、企业乃至国家安全构成新的威胁。这要求网络安全领域必须加紧研究和部署能够应对AI驱动攻击的防御策略和技术。 (来源: Ronald_vanLoon)

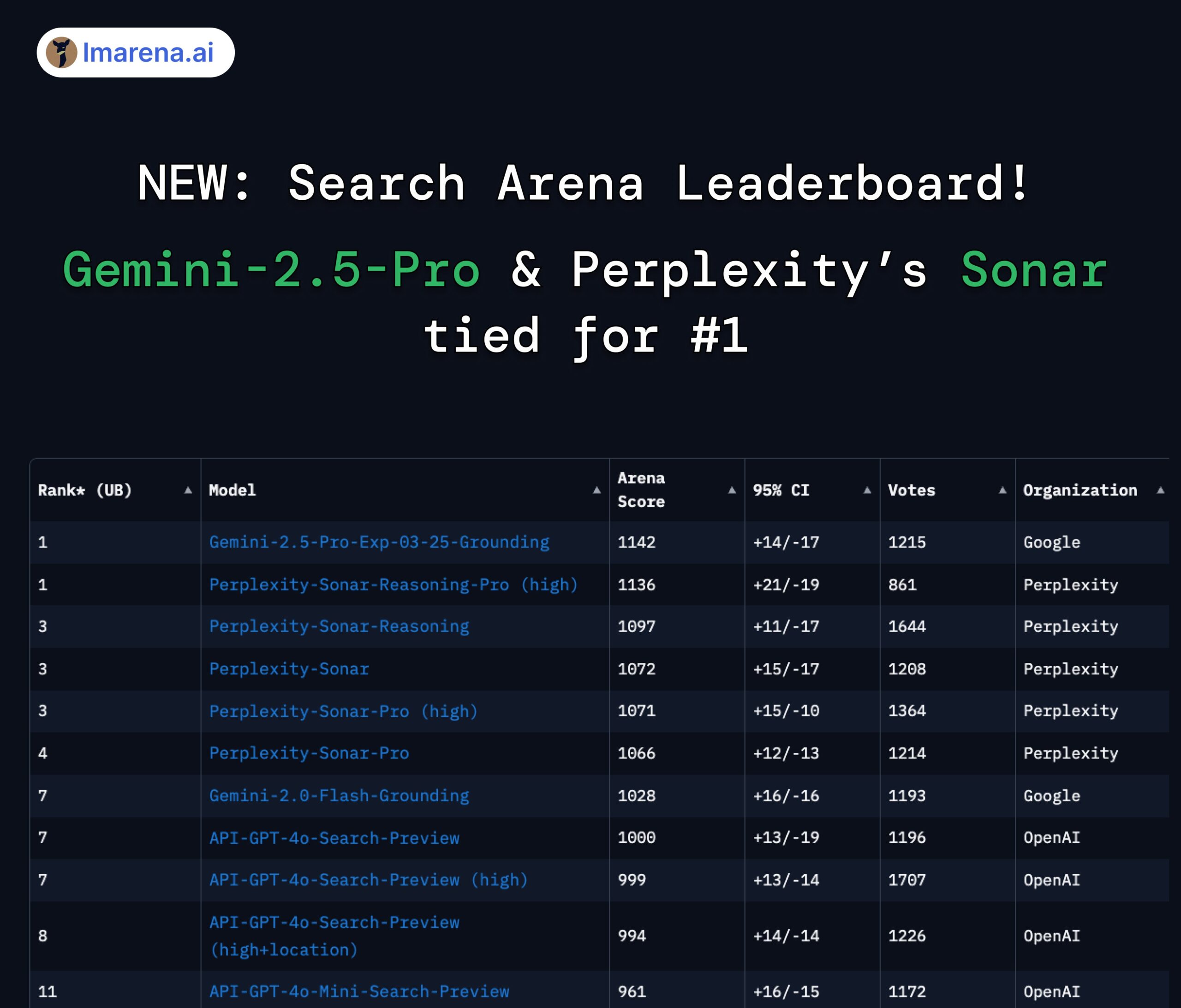

Perplexity Sonar与Gemini 2.5 Pro并列搜索竞技场榜首:在LMArena.ai(原LMSYS)新推出的Search Arena排行榜上,Perplexity的Sonar-Reasoning-Pro-High模型与Google的Gemini-2.5-Pro-Grounding并列第一。该榜单专门评估基于网络搜索的LLM回答质量。Perplexity CEO Arav Srinivas对此表示祝贺,并强调将继续改进Sonar模型和搜索索引。社区认为这显示出在搜索增强型LLM领域,竞争主要在Google和Perplexity之间展开。 (来源: AravSrinivas, lmarena_ai, lmarena_ai, AravSrinivas, lmarena_ai, AravSrinivas)

关于Claude模型使用限制的讨论:Reddit r/ClaudeAI社区中,用户对于Claude Pro版本的使用限制(如消息量上限、容量限制)存在争议。一些用户抱怨频繁遇到限制,影响工作流程,甚至考虑更换模型;另一些用户则表示很少遇到限制,认为可能是使用方式(如加载超大上下文)或夸大其词导致。这反映了用户对Anthropic模型使用策略和稳定性的不同体验和看法。 (来源: Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

AI与就业未来的讨论:Reddit r/ChatGPT上一张对比图引发讨论:AI将增强人类能力,带来富足生活,还是取代人类工作,导致大规模失业?评论中,许多用户表达了对AI取代工作的担忧,特别是对于创造性职业(编程、艺术)。一些人认为AI将加剧社会不平等,因为收益主要归于AI所有者,而税基减少可能使UBI难以实现。另一些人则持更乐观态度,认为AI是强大的工具,能提升效率,创造新岗位(如提示工程师),关键在于适应和学习利用AI。 (来源: Reddit r/ChatGPT, Reddit r/ArtificialInteligence)

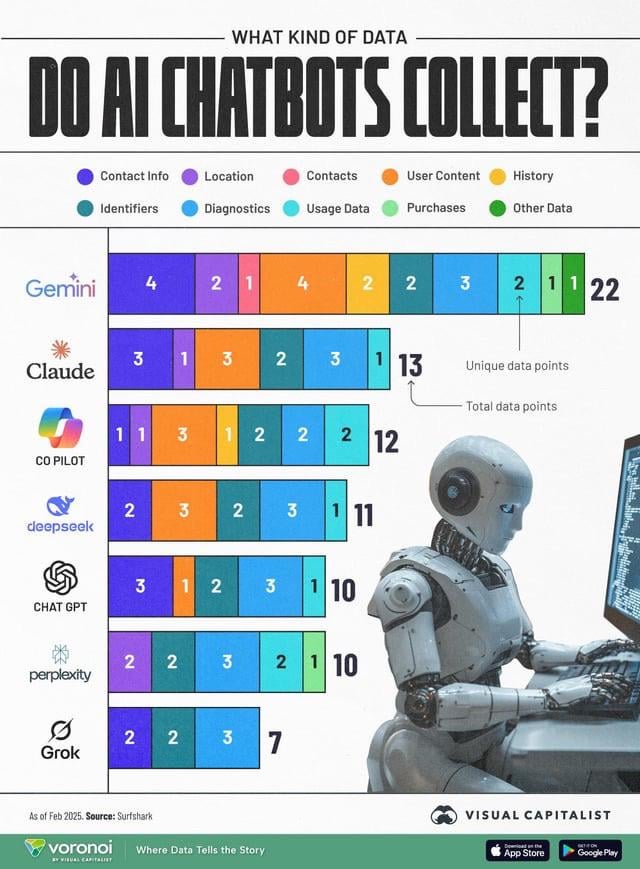

AI数据收集引发隐私关注:一张信息图对比了不同AI聊天机器人(ChatGPT, Gemini, Copilot, Claude, Grok)收集的用户数据类型,引发社区对隐私问题的讨论。图中显示,Google Gemini收集的数据类型最多,而Grok(需要账户)和ChatGPT(无需账户)相对较少。用户评论强调了免费服务背后数据收集的普遍性(“没有免费午餐”),并对数据收集的具体目的(如行为预测)表示担忧。 (来源: Reddit r/artificial)

模型蒸馏被认为是低成本复现高性能的有效途径:Reddit用户分享了通过模型蒸馏技术,使用大型模型(如GPT-4o)训练小型、精调模型,在特定领域(情感分析)以低14倍的成本实现了接近GPT-4o的性能(92%准确率)。评论指出,蒸馏是广泛使用的技术,但在跨领域泛化能力上,小模型通常不如大模型。对于特定、稳定的领域,蒸馏是有效的降本增效方法,但对于需要不断适应新数据或多领域的复杂场景,直接使用大型API可能更经济。 (来源: Reddit r/MachineLearning)

![[D] Distillation is underrated. I replicated GPT-4o's capability in a 14x cheaper model](https://rebabel.net/wp-content/uploads/2025/04/zyj7as7ogque1.png)

💡 其他

OceanBase举办首届AI黑客松大赛:分布式数据库厂商OceanBase联合蚂蚁开源、机器之心等举办首届AI黑客松大赛,已于4月10日开启报名,截止至5月7日。大赛以“DB+AI”为主题,设置两大方向:一是使用OceanBase作为数据基座构建AI应用,二是探索OceanBase与AI生态(如CAMEL AI, FastGPT, OpenDAL)的结合。大赛提供10万元总奖池,面向个人和团队开放报名,旨在激发开发者探索数据库与AI深度融合的创新应用。 (来源: 10万奖金×认知升级!OceanBase首届AI黑客松广发英雄帖,你敢来么?)

清华大学刘辛军教授将直播讲解并联机器人:清华大学机械系设计工程研究所所长、IFToMM中国委员会主席刘辛军教授,将于4月15日晚进行在线讲座,主题为“并联机器人机构学基础与装备创新”。讲座将探讨并联机器人的基础理论及其在前沿装备创新中的应用。主持人为哈工大刘英想教授。 (来源: 重磅直播!清华大学刘辛军教授开讲:并联机器人机构学基础与装备创新前沿)

第三届中国AIGC产业峰会攻略发布:将于4月16日在北京举办的第三届中国AIGC产业峰会发布了详细议程和亮点。峰会将聚焦AI技术与应用落地,议题涵盖算力基建、大模型在教育/文娱/企业服务/AI4S等垂直场景的应用、AI安全可控等。演讲嘉宾来自百度、华为、AWS、微软亚研院、面壁智能、生数科技、粉笔、网易有道、趣丸科技、轻松健康、蚂蚁集团等。峰会还将发布2025年值得关注的AIGC企业和产品榜单,以及中国AIGC应用全景图谱。 (来源: 倒计时2天!20余位行业大佬共话AI,中国AIGC产业峰会最全攻略在此)