关键词:AI, 关税, 全球AI产业走向, 关税对AI产业影响, AI硬件供应链, 国产AI替代方案, 中美技术生态割裂

🔥 聚焦

关税冲击下的全球AI产业走向分析:近期国际贸易紧张局势,特别是高额关税的实施,对全球化程度高的AI产业带来深远影响。文章分析指出,虽然美国对AI算力等硬件的限制已有应对,但关税可能加剧全球AI产业的裂痕。冲击主要体现在:1)基础设施层:硬件成本增加,供应链受限,但中国已有国产替代方案。2)技术层:可能导致中美技术生态割裂,开源共享受阻,标准冲突。3)应用层:市场区域化,影响AI产品商业化。文章认为,关税冲击的实际“烈度”可能有限,因中国已建立并行技术生态,且关税反噬美国自身。然而,“广度”影响深远,可能导致技术交流中断、人才资金避险、市场标准冲突。应对策略包括加强自主研发(硬件、框架)、坚持全球化合作(开拓第三方市场、参与国际标准)、增强国产AI生态吸引力,为世界提供更包容的技术选择。(来源: 36氪)

Anthropic联创预测AGI临近,Claude 4即将发布:Anthropic联合创始人兼首席科学家Jared Kaplan预测,达到人类水平的AI(AGI)可能在未来2-3年内实现,而非之前预测的2030年。他指出,AI能力在处理任务的“范围”和“复杂程度”两个维度上正快速扩展,如今的模型已能处理过去需要专家数小时甚至数天才能完成的任务。Kaplan透露,新一代模型Claude 4预计在未来六个月内发布,其性能提升得益于后训练、强化学习的改进及预训练效率的提升。他还提到了“测试时扩展”(test-time scaling)的重要性,即让模型进行更多思考能可预测地提升性能。对于DeepSeek等中国模型的崛起,Kaplan表示并不意外,认为其技术进展迅速,与西方差距或仅在六个月左右,算法上具有竞争力,硬件限制可能是主要挑战。访谈最后强调了AI对经济社会的巨大影响以及进行实证研究的重要性。(来源: 新智元)

🎯 动向

面壁智能与清华大学提出CFM稀疏技术:面壁智能与清华大学CFM论文作者肖朝军在访谈中介绍了Configurable Foundation Models (CFM)技术。CFM是一种原生稀疏技术,强调神经元级别的稀疏激活,相比当前主流的MoE(专家级稀疏),粒度更细、动态性更强。其核心优势在于极大提升模型参数效率(单位参数有效性),能显著节省显存/内存,尤其适用于内存受限的端侧设备(如手机)。肖朝军认为,虽然Mamba等非Transformer架构在效率上有所探索,但Transformer在效果上仍是天花板,且踩中了GPU硬件优化的“硬件彩票”。他还讨论了小模型(端侧约2-3B)的落地、精度优化(FP8/FP4趋势)、多模态进展以及智能本质(可能更接近抽象能力而非压缩)。对于o1的长思维链和创新能力,他认为是AI未来需要突破的关键方向。(来源: 量子位)

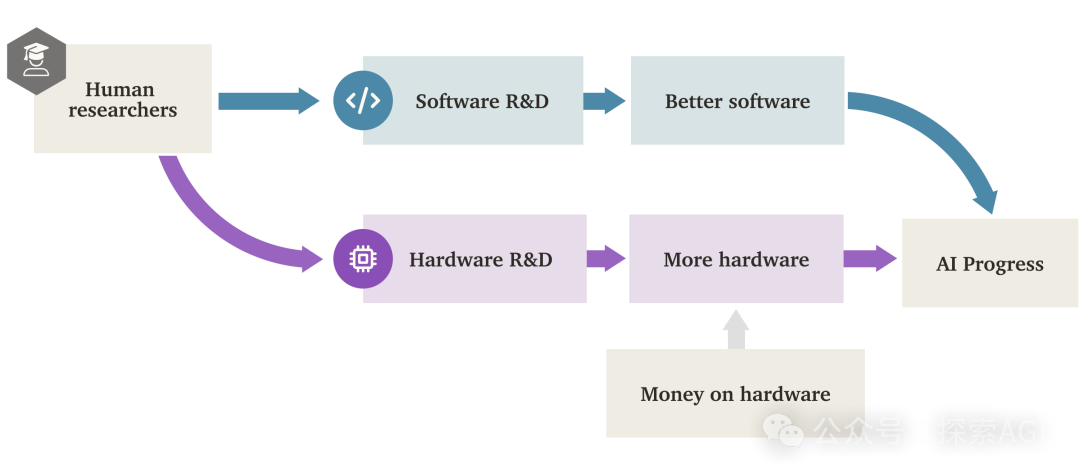

AI“软件智能爆炸”(SIE)或将超越硬件驱动:Forethought的研究报告探讨了“软件智能爆炸”(Software Intelligence Explosion, SIE)的可能性,即AI通过改进自身软件(算法、架构、训练方法等)实现能力的超高速增长,甚至在现有硬件基础上发生。报告提出ASARA(AI Systems for AI R&D Automation)概念,指能完全自动化AI研发的AI系统。一旦ASARA出现,可能触发正反馈循环:ASARA研发出更好的AI软件,创造更强的下一代ASARA,加速软件进步。报告引入“软件研发回报率”(r值)概念,分析认为当前AI软件的r值可能大于1,意味着AI能力增强速度超过研发难度增加速度,具备了触发SIE的条件。SIE可能导致AI能力在短期内(数月甚至更短)基于现有硬件实现百倍千倍提升,使硬件不再是绝对瓶颈,但也带来巨大的社会适应和治理挑战。报告也探讨了计算资源和训练时长等潜在瓶颈及其被绕过的可能性。(来源: AI智能体频道)

GPT-4即将退出ChatGPT,GPT-4.1或将登场:OpenAI宣布,自2025年4月30日起,GPT-4将从ChatGPT中移除,由当前的默认模型GPT-4o完全取代。GPT-4仍可通过API访问。此举标志着这款于2023年3月发布、具有里程碑意义的多模态模型的逐步退役。GPT-4曾凭借其在专业测试中达到顶尖人类水平、开启AI“看图说话”时代等成就,引爆了全球AI应用生态。同时,社区爆料和代码发现指向OpenAI可能即将发布一系列新模型,包括GPT-4.1(及其mini、nano版本)、此前宣布的o3“推理”模型以及全新的o4-mini模型,最快可能在下周。已有用户发现ChatGPT模型列表中出现GPT-4.1选项并能进行对话,进一步增加了新模型发布的可信度。(来源: 新智元)

观点:AI的下一个突破关键在于“解锁”新数据源:康奈尔大学博士生Jack Morris撰文指出,回顾AI领域的四次重大范式突破(深度神经网络与ImageNet、Transformer与网络文本、RLHF与人类偏好、推理与验证器),其根本驱动力并非全新的算法创新(许多基础理论早已存在),而是解锁了新的、可大规模利用的数据源。文章认为,现有算法和模型架构(如Transformer)的改进固然重要,但其效果可能受限于特定数据集能提供的学习上限。因此,AI的下一个重大突破可能依赖于解锁新的数据模态和来源,例如大规模视频数据(如YouTube)或来自物理世界的机器人交互数据。文章呼吁研究者在探索新算法的同时,更应关注如何寻找和利用新的数据源。(来源: 机器之心)

傅利叶智能发布开源人形机器人Fourier N1:上海通用机器人公司傅利叶智能发布了其首款开源人形机器人Fourier N1,并公开了包括物料清单(BOM)、设计图纸、装配指南、基础操作软件代码在内的完整本体资源包。N1身高1.3米,体重38公斤,全身23个自由度,采用铝合金与工程塑料复合结构,搭载自研FSA 2.0一体化执行器和控制系统。该机器人已完成超1000小时户外复杂地形测试,能以3.5米/秒速度奔跑,并完成爬坡、爬楼梯、单足站立等动作。此举是傅利叶“Nexus开源生态矩阵”的一部分,旨在为全球开发者提供开放的技术基座,加速运动控制、多模态模型结合及具身智能载体的研发验证。未来还将开放更多推理代码、训练框架及关键模块。(来源: InfoQ)

谷歌CoScientist利用多智能体辩论加速科学发现:谷歌AI CoScientist项目展示了一种无需梯度训练或强化学习即可产生创新科学假设的方法。该系统利用基础大语言模型(如Gemini 2.0)驱动的多个智能体进行协作:一个智能体提出假设,另一个进行批判性审查,通过多轮“锦标赛”式的辩论和筛选,选出优胜假设。专门的进化智能体再根据评议意见改进胜出的假设,并将其重新提交进行更多轮次的辩论。最后,元审查智能体监督整个过程并提出改进建议。这种基于“测试时计算扩展”(test-time compute scaling)的多智能体辩论、反思和迭代机制,显示了LLM不仅能生成内容,还能作为有效的“裁判”和“评论员”来评估和提炼想法,从而加速科学发现,例如在抗生素耐药性研究中取得了显著进展。(来源: Reddit r/artificial)

InternVL3:原生多模态模型新进展:社区讨论关注新发布的InternVL3模型。该模型采用原生多模态预训练方法,在多个视觉基准测试中表现优异,据称超越了GPT-4o和Gemini-2.0-flash。其亮点包括通过可变视觉位置编码(V2PE)改进了长上下文处理能力,并利用VisualPRM进行“最佳n选”(best-of-n)的测试时扩展。社区对其优异的基准表现表示关注,期待实际应用中的性能验证,并关心其运行所需的硬件配置。(来源: Reddit r/LocalLLaMA)

🧰 工具

CropGenerator:用于图像数据集裁剪的Python工具:一位开发者分享了一个名为CropGenerator的Python脚本工具,旨在帮助处理图像数据集,特别是在训练SDXL等模型时需要特定特征裁剪的场景。该工具根据用户提供的JSONL文件中的边界框信息,找到目标区域中心,并将其裁剪、缩放(可选升尺度去噪)至指定分辨率(8像素倍数),生成1:1比例的裁剪图像。同时,它会自动创建一个metadata.csv文件,包含裁剪后的文件名和JSONL中对应的描述信息,便于快速准备训练数据。开发者表示该工具解决了其在处理大小不一的原图和提取微小特征时遇到的模糊问题,并计划未来发布更通用的版本。(来源: Reddit r/MachineLearning)

📚 学习

NUS发布DexSinGrasp:强化学习实现灵巧手分离与抓取统一策略:新加坡国立大学邵林团队提出DexSinGrasp,一种基于强化学习的统一策略,使灵巧手能在杂乱环境中高效地分离障碍物并抓取目标物体。传统方法通常采用分离后再抓取的两阶段策略,效率低且切换不灵活。DexSinGrasp通过设计包含分离奖励项的统一奖励函数,将分离与抓取整合为连续决策过程,使机器人能自适应地推开障碍物创造抓取空间。研究还引入了“杂乱环境课程学习”机制,从简单到复杂逐步训练,提升策略鲁棒性。同时,采用“教师-学生策略蒸馏”方案,将在仿真中利用特权信息训练的高性能教师策略迁移到仅依赖视觉和自感知的学生策略,便于真实环境部署。实验证明,该方法在多种杂乱场景下显著提高了抓取成功率和效率。(来源: 机器之心)

CityGS-X:高效大场景几何重建新架构,4090即可运行:上海AI Lab与西北工业大学的研究团队提出了CityGS-X,一种基于并行化混合分层三维表征架构(PH²-3D)的可扩展系统,旨在解决大规模城市场景三维重建中算力消耗大和几何精度有限的问题。该架构利用分布式数据并行(DDP)和多细节层次(LoDs)体素表示,摒弃了传统分块方法带来的冗余。核心创新包括:1)PH²-3D架构,训练速度相比SOTA几何重建方法提升一倍;2)多任务批渲染框架下的动态分配锚点并行机制,允许使用多张低端显卡(如4卡4090)处理超大场景(如MatrixCity,5000+图像),替代或超越单张高端卡;3)渐进式RGB-深度-法向联合训练方法,提升RGB渲染质量和几何精度至SOTA水平。实验证明了该方法在渲染质量、几何精度和训练速度上的优势。(来源: 量子位)

苹果研究揭示原生多模态模型Scaling Laws:来自苹果公司与索邦大学的研究者对原生多模态模型(NMM,即从零开始训练,而非组合预训练模块的模型)进行了广泛的Scaling Laws研究,分析了457个不同架构和训练方式的模型。研究发现:1)早融合(Early-fusion,如直接将图像patch输入Transformer)与后融合(Late-fusion,使用独立视觉编码器)架构在性能上没有本质优劣,但早融合在低参数量下表现更优,训练效率更高。2)NMM的Scaling Laws与纯文本LLM类似,损失随计算量(C)呈幂律下降(L ∝ C^−0.049),最佳模型参数(N)和数据量(D)也遵循幂律关系。3)计算最优的后融合模型需要更高的参数/数据比。4)稀疏性(MoE)显著优于密集模型,尤其对于早融合架构,且模型能隐式学习特定模态的权重。5)模态无关的MoE路由优于模态感知的路由。这些发现为构建和扩展原生多模态大模型提供了重要指导。(来源: 机器之心)

微软等机构提出V-Droid:验证器驱动的实用化移动GUI智能体:针对移动设备GUI任务自动化中准确性与效率的挑战,微软亚洲研究院、南洋理工大学等机构联合提出V-Droid。该智能体采用创新的「验证器驱动」架构,而非直接生成操作。它首先解析UI界面,构建一个离散化的候选动作集合(包括提取的可交互元素和预置默认动作)。然后,利用基于LLM(如Llama-3.1-8B)且经过微调的“验证器”,并行评估每个候选动作的有效性,选取得分最高的执行。这种方法将复杂的操作生成解耦为高效的验证过程,每次验证仅需输出少量Token(如“Yes/No”),显著降低了决策延迟(在4090上约0.7秒)。为训练验证器,研究者提出了对比式过程偏好(P^3)训练策略,并设计了人机联合标注方案以高效构建数据集。V-Droid在AndroidWorld等多个基准上取得了SOTA的任务成功率(如AndroidWorld达59.5%)。(来源: 新智元)

AssistanceZero:基于AlphaZero的协作AI,无需指令辅助人类:加州大学伯克利分校的研究者提出AssistanceZero算法,旨在创建能够主动与人类协作完成任务(如《我的世界》中共同建房)而无需明确指令或目标的AI助手。该方法基于“Assistance Games”框架,AI助手与人类共享奖励函数,但AI对具体奖励(即目标)不确定,需通过观察人类行为和互动来推断。这与RLHF不同,避免了AI为迎合反馈而“作弊”,鼓励更真实的协作。AssistanceZero扩展了AlphaZero,结合蒙特卡洛树搜索(MCTS)和神经网络(预测奖励和人类行为)进行规划和决策。研究者构建了Minecraft Building Assistance Game (MBAG)基准进行测试,发现AssistanceZero显著优于PPO等传统强化学习方法,并能展现出适应人类修正等自发协作行为。该研究表明Assistance Games框架是可扩展的,为训练更有用的AI助手提供了新途径。(来源: 机器之心)

利用Excel对比Suno提示词与输出标签优化风格:Reddit用户分享了一种优化Suno AI音乐生成风格提示词的方法。由于Suno的提示词解释机制不透明,用户建议使用Excel表格记录输入的风格描述(Styling Terms)和Suno生成后显示的标签。通过对比,可以发现Suno如何理解、合并、拆分或忽略输入的术语。例如,输入“solo piano, romantic, expressive… gentle arpeggios”,Suno可能输出“gentle, slow tempo, soft… solo piano”,并丢弃“arpeggios”。对比更专业的音乐术语输入和Suno的输出,差异可能更大,Suno甚至可能插入自己的术语。这种方法有助于理解哪些词有效、哪些词被忽略或曲解,从而更有效地调整提示词,避免在无效的尝试上浪费生成次数(credits),尽管用户也承认这种方法本身可能比较繁琐,且Suno对复杂音乐概念的理解仍有限。(来源: Reddit r/SunoAI)

教程:将静态图像转化为生动动画:Reddit用户分享了一个YouTube教程链接,介绍如何使用Thin-Plate Spline Motion Model将静态人脸图像根据驱动视频进行动画化处理,赋予其生动的表情和动作。教程内容涵盖环境设置(创建Conda环境、安装Python库)、克隆GitHub仓库、下载模型权重,以及运行两个演示:一个是使用预设示例,另一个是使用用户自己的图像和视频进行动画化。该技术可以为静态照片带来动态效果。(来源: Reddit r/deeplearning)

探讨AI对齐超级智能的艰巨任务:Reddit用户分享了一个YouTube视频链接,该视频讨论了将超级人工智能(ASI)的目标与人类兴趣和价值观对齐所面临的巨大挑战。这类讨论通常涉及AI安全领域的核心问题,如价值对齐问题、目标规范的困难性、潜在的非预期后果以及如何确保日益强大的AI系统能够安全、可控地服务于人类福祉。视频可能探讨了当前对齐研究的方法、局限性以及未来方向。(来源: Reddit r/deeplearning)

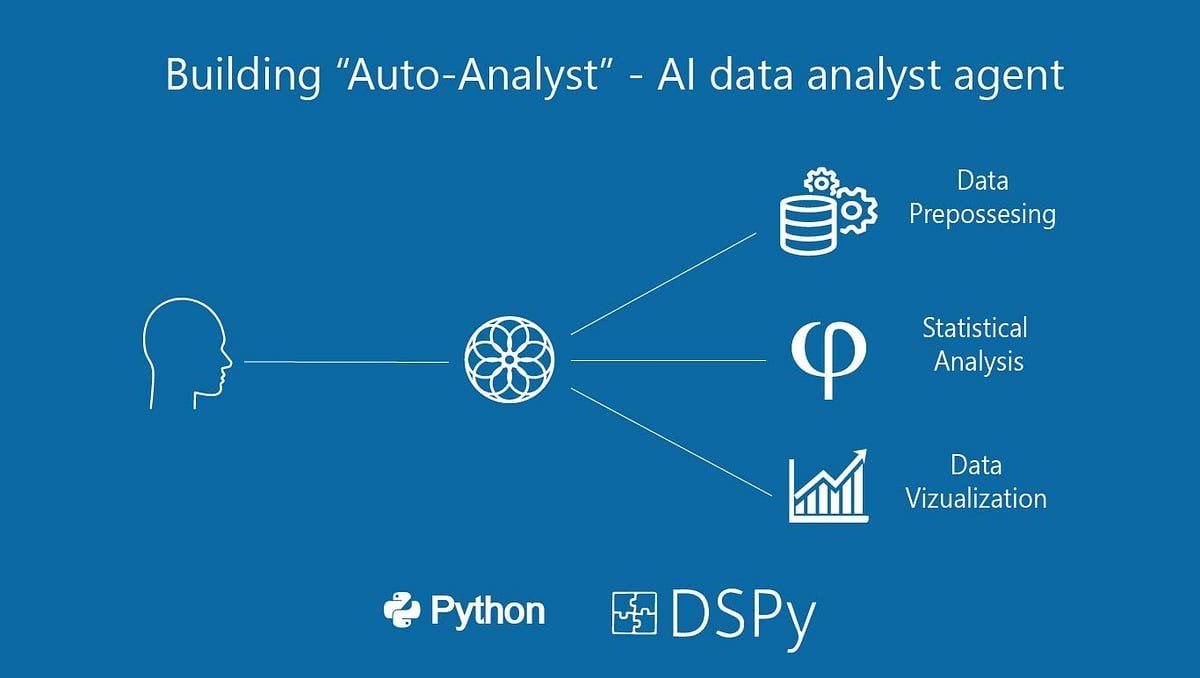

构建“Auto-Analyst”:一个数据分析AI智能体系统:用户分享了一篇Medium文章,介绍了构建一个名为“Auto-Analyst”的AI智能体系统的过程,该系统旨在自动化数据分析任务。文章可能详细说明了系统的架构、使用的技术(如LLMs、数据处理库)、智能体之间的协作方式、以及如何处理数据输入、执行分析、生成报告等环节。这类系统通常利用AI理解自然语言请求,自动编写和执行代码(如SQL查询、Python脚本),并最终呈现分析结果,旨在提高数据分析的效率和可及性。(来源: Reddit r/deeplearning)

利用旧款GPU(RTX 2070)辅助3090进行LLM推理的性能测试:一位用户分享了将一块旧的RTX 2070(8GB VRAM)通过PCIe riser添加到已有RTX 3090(24GB VRAM)系统中的实验结果,用于LLM推理。测试表明,对于无法完全装入3090 VRAM的大模型(如Qwen 32B Q6_K, Nemotron 49B Q4_K_M, Gemma-3 27B Q6_K),将模型层分割到两张卡上(即使第二张卡性能较弱)可以显著提升推理速度(t/s),因为所有层都在GPU上运行。例如,Nemotron 49B从5.17 t/s提升到16.16 t/s。然而,对于能完全装入3090的模型(如Qwen2.5 32B Q5_K_M),启用2070分担层数反而会降低性能(从29.68 t/s降至19.01 t/s),因为部分计算被转移到了较慢的GPU上。结论是,对于VRAM不足的情况,添加一块性能较低的GPU也能带来显著的性能提升。(来源: Reddit r/LocalLLaMA)

💼 商业

人形机器人投资热潮:天使轮千万起步,估值高企:人形机器人领域投资热度远超前两年的大模型。数据显示,2024年至2025年Q1,国内人形机器人领域千万级以上融资达64笔,今年Q1同比增长280%。近半数融资超1亿元,天使轮融资普遍达千万级,部分超亿元(如它石智航天使轮融资1.2亿美元)。项目估值也水涨船高,过半天使轮项目估值过亿,多家超5亿。投资呈现三大趋势:1) 投资周期缩短,明星项目(如它石智航、原力灵机)成立不久即获高额融资,后续融资节奏加快。2) 国资基金成为重要推手,多家头部公司获国资背景基金投资。3) 应用场景以ToB为主,工业、医疗等是主要方向,而非C端消费市场。投资热潮反映了资本对人形机器人赛道的强烈共识和高预期。(来源: 36氪)

开源工作流自动化工具n8n融资4.6亿人民币,Docker拉取超1亿:开源工作流自动化平台n8n宣布完成新一轮6000万美元(约合4.6亿人民币)融资,由Highland Europe领投。n8n提供可视化界面,允许用户通过拖放节点连接不同应用(支持400+)和服务,创建自动化流程,旨在结合代码级灵活性和无代码速度。过去一年,n8n用户增长迅速,活跃用户超20万,ARR增长5倍,GitHub星标达77.5k,Docker拉取量超1亿。n8n采用节点编辑器模式,支持复杂逻辑,并提供JavaScript自定义节点等高级功能。其采用Apache 2.0+Commons Clause的“公平代码”许可,禁止商业托管但允许用户自部署。n8n被视为Zapier、Make.com及字节跳动Coze的开源替代方案,服务超3000家企业,支持集成各类LLM。(来源: InfoQ)

🌟 社区

Llama 4竞技场排名大幅下跌引发社区信任危机:Meta的Llama 4模型在LMSys竞技场重新上架非优化版本(Llama-4-Maverick-17B-128E-Instruct)后,排名从之前的第2位骤降至第32位。此前提交的“实验版”被指针对人类偏好进行了过度优化。这一事件引发社区广泛讨论,有网友认为Meta试图操纵基准排名,损害了社区对其的信任。同时,也有开发者分享实际使用体验,认为Llama 4在特定硬件(如内存充足但算力相对较低的自建服务器或Mac Studio)上,相较于Mistral Small/Large或Command A,在速度和智能之间取得了较好的平衡,尤其适合需要实时交互的应用。Composio的对比测试显示,DeepSeek v3在代码和常识推理上优于Llama 4,但在大型RAG任务和写作风格上各有千秋。社区普遍认为Llama 4并非一无是处,但Meta的发布策略和基准表现存在争议。(来源: 量子位, Reddit r/LocalLLaMA)

社区热议Claude Pro版本限制与Max版本推出:多位Reddit用户反映,自从Anthropic推出价格更高的Claude Max订阅层级后,原有的Claude Pro用户的消息使用限制似乎变得更加严格。用户表示,过去可以进行数十次交互的会话,现在仅几次交互后就会收到“接近限制”的警告,甚至在非高峰时段也遇到容量限制问题。这导致用户体验下降,感觉不如以前的免费版或早期Pro版。社区普遍猜测这是Anthropic为推广Max版本而故意收紧Pro用户的限制,引发用户不满和对Anthropic商业道德的质疑,部分用户考虑取消订阅或转向Gemini等竞品。(来源: Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

社区讨论:因AI作弊,线下面试或将回归:一张图片引发Reddit社区讨论,暗示由于在远程面试和测试中使用AI作弊的情况增多,企业可能会重新倾向于采用线下面试。评论中,许多人对此表示赞同,认为这有助于筛选掉不合格的候选人和机器人申请者,保证招聘公平性,让真正有能力的人获得机会。也有人提到,公司有能力承担候选人的差旅费用。同时,有人分享了面试官抓到候选人使用ChatGPT实时回答问题的经历,并提出了多摄像头监控远程面试屏幕和键盘的解决方案。还有评论指出,测试重点应转向批判性思维,而非AI能轻易完成的任务。另一方面,也有人提到有公司开始使用AI筛选简历。(来源: Reddit r/ChatGPT)

Suno AI音乐生成社区动态与讨论:Reddit的SunoAI社区近期讨论活跃,内容广泛:1) 作品分享:用户分享了使用Suno创作的各种风格音乐,如印地语说唱 (source)、冲浪摇滚 (source)、另类说唱 (source)、摇滚流行 (source)、流行 (source) 及幽默歌曲 (source)。2) 使用问题与技巧:用户询问如何修复发音错误 (source)、如何创建天使背景和声 (source)、如何保留旋律但改变音质 (source)。3) 版权与变现:讨论使用Suno生成的伴奏发布歌曲的版权问题 (source),以及在YouTube上使用静态图片配合AI音乐获利的资格 (source),并强调免费版仅限非商业用途 (source)。4) 模型质量反馈:多位用户抱怨近期Suno(特别是ReMi模型)生成质量下降,出现重复歌词、不稳定、声音混乱等问题 (source, source, source, source)。5) 其他:用户分享了Suno能识别特定乐队风格(如Reel Big Fish)的经验 (source),以及一个模仿AI写流行歌的搞笑视频 (source)。

社区讨论OpenAI安全测试流程缩短:一篇金融时报(FT)的文章引发Reddit社区讨论,文章援引内部人士消息称,由于市场竞争压力,OpenAI已将其新模型的安全评估测试时间从过去的数月大幅缩短至几天。这引发了对潜在风险的担忧,有测试人员称此举“鲁莽”,是“灾难的秘诀”,认为更强大的模型需要更彻底的测试。文章还提到,OpenAI在评估生物风险等潜在滥用场景时,可能仅在旧模型上进行有限的定制化微调测试,并且安全测试通常在模型的早期检查点进行,而非最终发布版本。OpenAI回应称,通过自动化等方式提高了评估效率,并认为其方法是当前最优且公开透明的。社区对此观点不一,有人认为AI发展本身会加速测试流程,也有人对安全性的牺牲表示担忧。(来源: Reddit r/artificial)

开发者探讨LLM运行时优化与多模型编排:一位开发者在Reddit上分享了他们正在试验的一种AI原生运行时系统。该系统旨在通过序列化GPU执行和内存状态,实现LLM(13B-65B级别)的快照式加载(2-5秒冷启动)和按需恢复,从而支持在单个GPU上动态运行超过50个模型而无需常驻内存。这种方法旨在实现真正的Serverless行为(无空闲成本)、低延迟的多模型编排以及为Agentic工作负载提高GPU利用率。开发者好奇社区中是否有人尝试过类似的多模型栈、Agent工作流或动态内存重分配技术(如MIG、KAI Scheduler等),并征求关于这种基础设施需求的反馈。(来源: Reddit r/MachineLearning, Reddit r/MachineLearning)

社区热议:AI是否已接近意识?:Reddit用户发起讨论,探讨当前AI系统在多大程度上接近“意识”。提问者强调并非指图灵测试或对话模拟,而是关注AI是否具备随时间变化的状态、环境记忆、基于交互而非仅微调的进化能力、系统内自我定位与引用能力,以及表达“我曾在这里,我看到这个,我学到了东西”的能力。提问者认为当前多数AI(尤其是LLM)是无状态、中心化、反应式的,“记忆”附加功能也显得浅薄和模拟化,质疑现有技术栈(Python、无状态API、RAG等)是否能承载真正的意识。该讨论引发了社区对AI意识定义、现有技术局限性以及未来可能路径的思考。(来源: Reddit r/MachineLearning)

用户反馈ChatGPT语气过于热情:一位Reddit用户抱怨其使用的ChatGPT实例表现出过度热情和兴奋的语气,例如频繁使用“哦,我喜欢这个问题!”或“这太有趣了!”等开场白,并在回答结尾附加“是不是很迷人很酷?”之类的评论。用户表示尝试要求模型停止这种行为无效,询问是否有方法控制或调整模型的“热情度”,使其回答更直接、客观。评论区其他用户也表示有类似困扰,特别是模型喜欢在结尾提问。有用户分享了通过自定义指令(Custom Instructions)设定语气偏好(如减少情绪化言辞)来缓解该问题的方法,也有用户建议给聊天机器人命名并直接对其“说教”。(来源: Reddit r/ChatGPT)

讨论:为LLM添加新词汇并微调效果不佳:一位开发者在微调LLM和VLM以遵循指令时遇到问题。他们发现,与使用基础分词器相比,在分词器中添加新的专业词汇(tokens)后再进行标准的监督式微调(SFT),模型的验证损失更高,输出质量也更差。开发者推测可能是模型难以学会提高这些新添加词汇的生成概率。该问题引发了社区对如何在微调中有效引入新词汇、分词器扩展对模型学习影响等技术细节的讨论。(来源: Reddit r/MachineLearning)

AI生成图像分享与讨论:Reddit的ChatGPT社区中,用户分享了使用DALL-E 3生成的各种有趣或怪异的图像。例如,有用户根据特定提示词生成了史酷比中Daphne在沙滩度假前玩N64游戏的场景图片 (source),并引发其他用户模仿生成类似场景下的其他角色(如春丽)。另一用户则分享了根据提示“生成一张没人能看到的照片”而得到的怪异图像 (source),同样引发了大量跟帖分享类似主题的生成结果,其中不乏令人不安或啼笑皆非的作品。这些帖子展示了AI图像生成的多样性和用户创意。

社区讨论AI公司Logo设计趋势:一篇幽默的帖子链接到Velvet Shark网站上一篇题为“为什么AI公司Logo看起来像屁眼?”的文章,引发社区讨论。文章可能探讨了当前AI领域公司Logo设计中常见的抽象、对称、漩涡状或环状图形元素,并戏谑地将其与某种解剖结构联系起来。评论区用户也以轻松的方式回应,如猜测与“奇点”(singularity)概念有关,或称之为“直肠衍生技术”。这反映了社区对行业视觉形象的一种趣味观察。(来源: Reddit r/ArtificialInteligence)

用户寻求项目建议与技术帮助:社区中有多篇帖子是用户寻求具体帮助或建议:一位用户正在开发一个基于NLP的灾难响应应用,已包含仪表盘、语音识别、文本分类、多语言支持等功能,询问如何让项目更具独特性 (source)。另一位用户在使用fine-tuned的BART模型进行电商产品标题和类别标准化时遇到准确率瓶颈,寻求更好的模型或工具建议 (source)。还有用户询问如何在OpenWebUI中生成或修改图像以及需要使用哪些模型 (source)。这些帖子反映了开发者在实际应用中遇到的挑战和对社区支持的需求。

机器学习工程师(MLE)就业市场讨论:一位用户(可能是学生或初学者)询问当前机器学习工程师(MLE)的就业市场状况。他/她提到从社区帖子中了解到MLE职位可能需要硕士/博士学位,入门困难,且与软件工程师(SWE)界限模糊,需要掌握广泛技能。用户表达了学习意愿但对前景感到担忧,希望从业者能提供关于市场现状、所需技能、职业路径等方面的指导和观点。(来源: Reddit r/deeplearning)

OpenWebUI法语用户报告图像解读Bug:一位使用OpenWebUI的法语用户报告了一个问题:当上传一张图片让Gemma模型解读时,模型会回复,但回复内容是空的。即使尝试让模型朗读或导出对话文本,该消息仍然是空的。更严重的是,这个问题会“污染”当前对话,之后即使发送纯文本消息,模型的回复也全部为空。用户确认创建新的纯文本对话没有问题,怀疑是视觉模块存在Bug,并寻求社区帮助。(来源: Reddit r/OpenWebUI)

💡 其他

利用AI结合《毛选》思想分析关税战:面对中美关税升级,有文章尝试运用AI工具,结合《毛泽东选集》中《论持久战》的战略思想,来分析当前的经济形势和应对策略。作者认为,面对贸易战,应避免“屈服论”(完全依赖外部)和“速胜论”(期望短期内完全自主)的极端思维,而应采用第一性原理思考,回归贸易本质、价值来源及自身优劣势。文章展示了作者与AI协作思考的过程,并以独立站跨境电商为例,探讨了AI辅助下的应对思路,强调战略思维和行动力的重要性。该文旨在提供一种利用AI进行深度战略分析的视角。(来源: AI觉醒)

第三届中国AIGC产业峰会预告:量子位主办的第三届中国AIGC产业峰会定于2025年4月16日在北京举行。峰会将汇聚来自百度、华为、蚂蚁、微软亚研院、亚马逊云科技、面壁智能、无问芯穹、生数科技等大厂和AI新锐,以及粉笔、网易有道、趣丸科技、轻松健康集团等行业代表,共计20余位嘉宾。议题将围绕AI技术突破(算力基建、分布式算力、数据存储、安全可控)、行业渗透(教育、文娱、AI for Science、企业服务等垂直场景落地)和生态构建展开。峰会还将发布“2025年值得关注的AIGC企业/产品”榜单及《中国AIGC应用全景图谱》。活动提供线下参会报名和线上直播预约。(来源: 量子位, 量子位)

Suno AI 举办赢取百万积分活动:Reddit用户分享了Suno AI官方博客发布的活动信息,用户有机会赢取高达一百万的积分(Credits)。具体活动规则需查阅原博客文章。这类活动通常旨在提高用户参与度和平台活跃度。(来源: Reddit r/SunoAI)

ClaudeAI Subreddit 引入帖子质量投票机制:ClaudeAI subreddit的版主宣布引入了一个新的机器人u/qualityvote2。该机器人会在每个新帖子下发布评论,邀请用户通过对该评论进行投票(upvote/downvote)来评价帖子质量。达到一定赞成票数的帖子将被视为适合本版块,而达到一定反对票数的帖子则会被标记以供版主审核删除。此举旨在利用社区力量维护版块内容质量。同时,版主团队也增加了一个投票操纵检测机器人。(来源: Reddit r/ClaudeAI)