关键词:AGI, Sora2, RAG, Gemini 3.0, AI玩具, 智能体, 大模型, AI视频生成技术, 检索增强生成演进, 多模态AI模型, AI制药平台, 算电协同技术

🎯 动向

Andrej Karpathy:AGI是长曲线,而非爆发式增长 : 前OpenAI核心研究员Andrej Karpathy指出,当前对AI“爆发年”的说法过于狂热,AGI的实现需要数十年漫长演进。他强调,真正的智能体应具备持久性、记忆力和连续性,而非现有“幽灵”般的聊天机器人。AI的未来发展应从“灌数据”转向“教目标”,通过任务性、反馈循环的训练,让AI成为社会中具有身份、角色和责任的“伙伴”,而非单纯的工具。(来源:36氪)

Sora2发布:AI视频生成进入“超级加速”阶段 : OpenAI发布Sora2及其社交应用Sora App,下载量超越ChatGPT,标志着AI视频领域进入“超级加速”期。Sora2在物理拟真、多模态融合及“镜头语言”理解上实现突破,能自动生成包含多镜头切换、剧情连贯的视频,极大地降低了创作门槛。国内厂商如百度、谷歌也迅速迭代产品,但版权和变现模式仍是行业面临的现实考题。(来源:36氪)

RAG范式演进:智能体与长上下文窗口下的“生死”辩论 : 随着LLM长上下文窗口和Agent能力的崛起,RAG(检索增强生成)的未来引发热议。LlamaIndex认为RAG正进化为“智能体检索”,通过分层Agent架构实现更智能的知识库查询;Hamel Husain强调RAG作为严谨工程学科的重要性;而Nicolas Bustamante则宣称“朴素RAG已死”,Agent结合长上下文可直接进行逻辑导航,RAG将降级为Agent工具箱的组件。(来源:36氪)

谷歌Gemini 3.0模型疑似上线LMArena,展现多模态新能力 : 谷歌Gemini 3.0的“马甲”模型(lithiumflow和orionmist)疑似在LMArena竞技场曝光,实测显示其在“看表”任务上能精确识别时间,SVG图像生成能力显著提升,并首次展现出较好的音乐作曲能力,能模仿音乐风格并保持节奏。这些进展预示Gemini 3.0在多模态理解和生成方面有显著突破,引发业界对谷歌即将发布新模型的期待。(来源:36氪)

AI玩具从“AI+玩具”走向“AI x 玩具”的深度融合 : AI玩具市场正经历从简单功能叠加到深度融合的转型,全球市场规模预计在2030年达千亿级。新一代AI玩具通过语音识别、人脸识别、情感分析等多模态技术,实现主动感知场景、理解情绪,提供个性化陪伴与教育。产业模式也从“硬件售卖”转向“服务+内容持续输出”,满足儿童、年轻人和老年人日益增长的情感陪伴和生活辅助需求,成为人类学习与AI共处的重要载体。(来源:36氪)

奢侈科技品牌BUTTONS发布搭载HALI智能体的影音机器人 : BUTTONS推出SOLEMATE智能体超级影音机器人,搭载特斯联通用智能体HALI。HALI具备空间认知与物理交互能力,通过三维语义记忆模型理解环境,并能基于用户位置和意图主动提供服务。该机器人利用智算中心的大规模协同计算,实现资源、设备及行为的最优编排,标志着AI向具身通用智能体迈进,能够突破数字世界壁垒,在物理环境中“感知-推理-行动”。(来源:36氪)

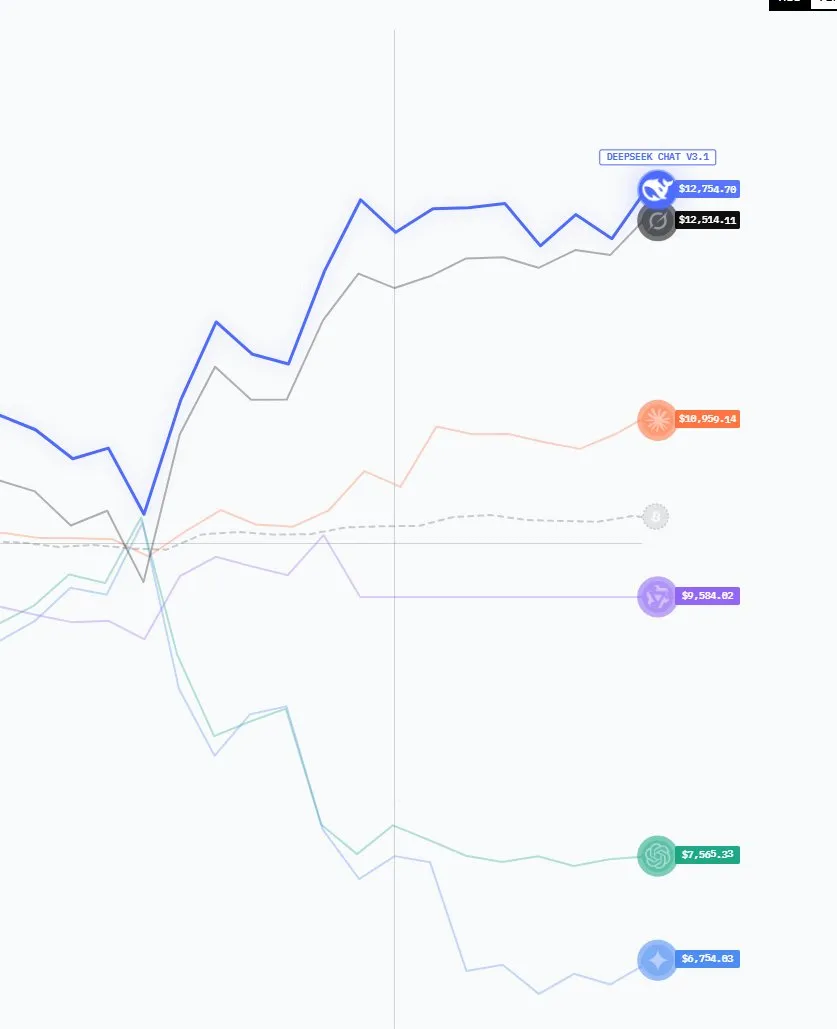

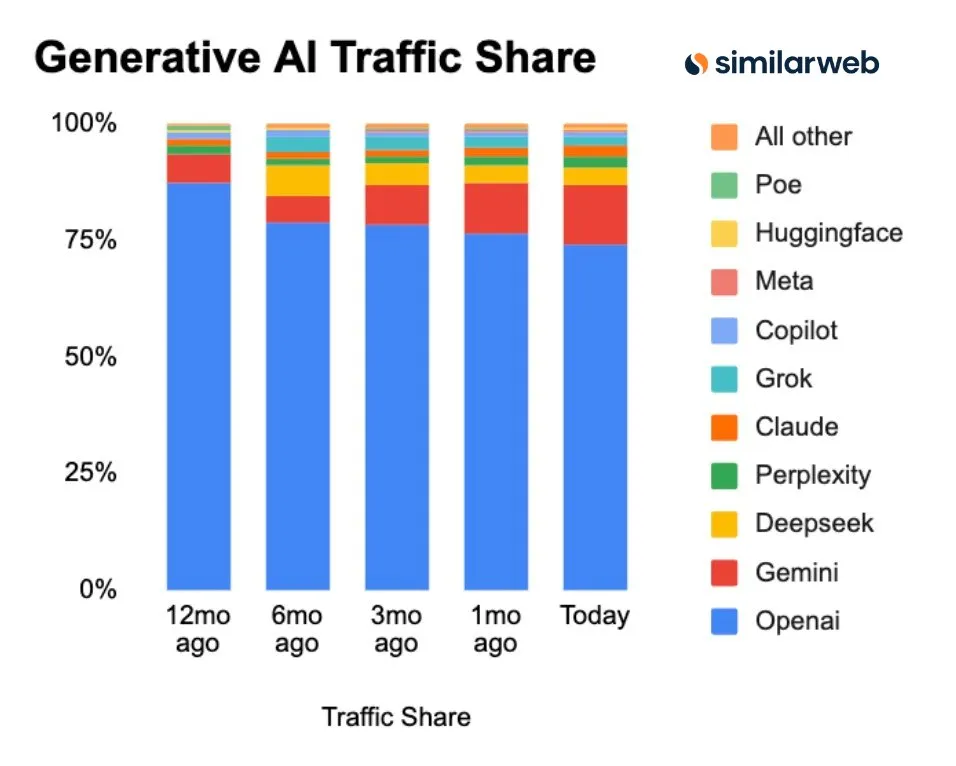

中国AI模型崛起,市场份额与下载量显著增长 : 最新数据显示,GenAI市场格局正在变化,ChatGPT的市场份额持续下降,而Perplexity、Gemini、DeepSeek等竞争者正在崛起。尤其值得关注的是,去年表现突出的美国开源AI模型,今年在LMArena排行榜上已被中国模型占据主导地位,DeepSeek和Qwen等中国模型在Hugging Face上的下载量是美国模型的两倍,显示出中国在开放AI领域日益增强的竞争力。(来源:ClementDelangue, ClementDelangue)

Google发布一系列AI更新:Veo 3.1、Gemini API地图集成等 : Google本周发布多项AI进展,包括视频模型Veo 3.1(支持场景扩展和参考图像)、Gemini API集成Google Maps数据、Speech-to-Retrieval研究(绕过语音转文本直接查询数据)、150亿美元印度AI中心投资、以及Gmail/Calendar的Gemini调度AI功能。同时,其AI Overviews功能因“流量杀手”面临意大利新闻出版商的调查,并发布了用于生物数据翻译的C2S-Scale 27B模型。(来源:Reddit r/ArtificialInteligence)

微软推出MAI-Image-1,图像生成模型能力跻身前十 : 微软AI发布了其首个完全自主研发的图像生成模型MAI-Image-1,该模型在LMArena的文本到图像模型排行榜中首次进入前十名。这一进展显示了微软在原生图像生成技术领域的强大实力,并预示着其在多模态AI领域的进一步发力,将为用户提供更优质的图像创作体验。(来源:dl_weekly)

🧰 工具

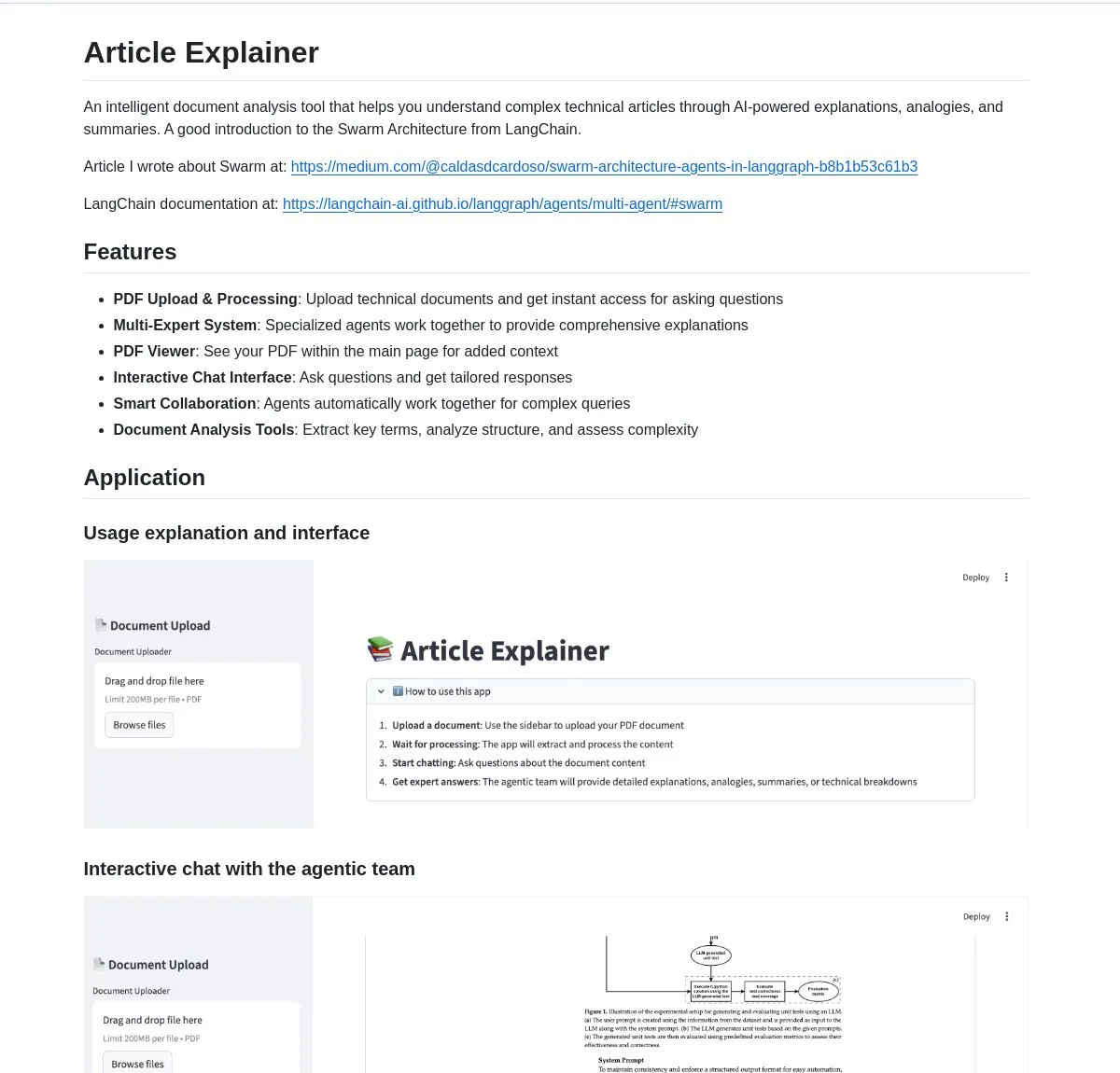

LangChain Article Explainer:AI文档分析工具 : LangChain发布了一款名为“Article Explainer”的AI文档分析工具,该工具利用LangGraph的Swarm Architecture分解复杂技术文章。它通过多智能体协作,提供互动式解释和深入见解,用户可以通过自然语言查询获取信息,极大地提升了技术文档的理解效率。(来源:LangChainAI)

Claude Code Skill:将Claude转变为专业项目架构师 : 一位开发者构建了一个Claude Code Skill,能将Claude转变为专业的项目架构师。该技能让Claude在编码前自动生成需求文档、设计文档和实施计划,解决了复杂项目中上下文丢失的问题。它能快速输出用户故事、系统架构、组件接口和分层任务,极大地提升了项目规划和执行效率,支持各类Web应用、微服务和ML系统开发。(来源:Reddit r/ClaudeAI)

Perplexity AI Comet:提升浏览与研究效率的AI浏览器扩展 : Perplexity AI Comet浏览器扩展推出早期访问,旨在提升用户的浏览、研究和生产力。该工具能够提供快速答案、总结网页内容,并将AI功能直接集成到浏览器体验中,为用户提供更智能、高效的信息获取方式,尤其适用于需要快速消化大量在线信息的用户。(来源:Reddit r/artificial)

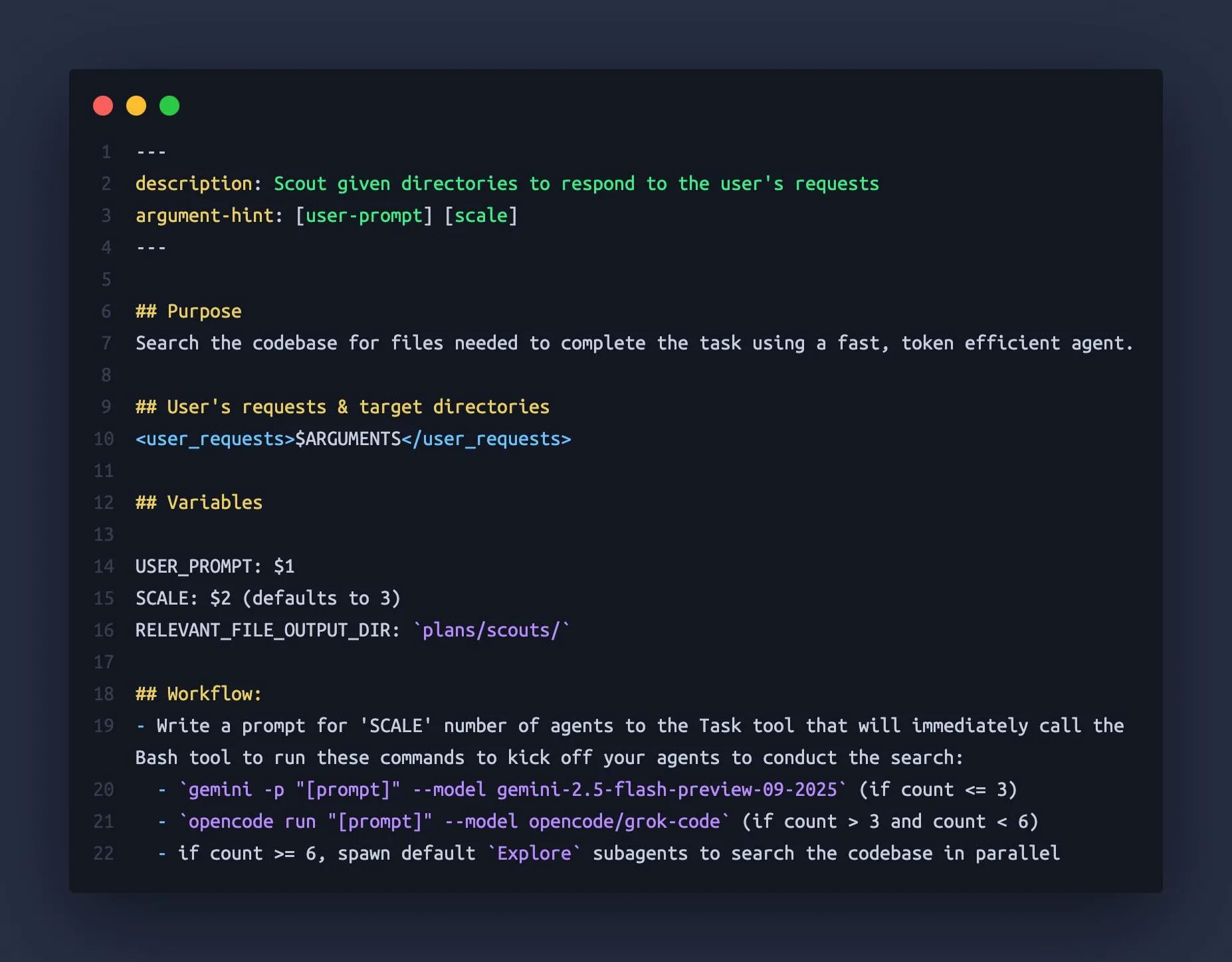

Claude Code利用Gemini CLI和OpenCode作为“子智能体” : 有开发者发现,Claude Code可以编排Gemini 2.5 Flash和Grok Code Fast等其他大型语言模型作为“子智能体”,利用它们的大上下文窗口(1M-2M tokens)快速侦察代码库,为Claude Code提供更全面的上下文信息。这种组合使用方式有效避免了Claude在复杂任务中“失去上下文”的问题,提升了编码助手的效率和准确性。(来源:Reddit r/ClaudeAI)

CAD生成模型k-1b:基于Gemma3-1B微调的3D模型生成器 : 一位开发者构建了名为k-1b的1B参数CAD生成模型,用户只需输入描述,即可生成STL格式的3D模型。该模型通过AI辅助生成和修复OpenSCAD数据集进行训练,并基于Gemma3-1B进行微调。作者还提供了CLI工具,支持OBJ模型转换和终端预览,为3D设计和制造领域提供了低成本、高效的AI辅助工具。(来源:karminski3, Reddit r/LocalLLaMA)

neuTTS-Air:CPU可运行的0.7B语音克隆模型 : Neuphonic发布了一款名为neutts-air的0.7B语音克隆模型,其最大亮点是可在CPU上运行。用户只需提供目标语音和对应文本,即可克隆声音并生成新文本的音频,约30秒生成18秒音频。该模型目前仅支持英文,但其轻量级和CPU兼容性为个人用户和小型开发者提供了便捷的语音克隆解决方案。(来源:karminski3)

Claude Code M&A Deal Comp Agent:利用PDF解析生成Excel交易条款 : 一位开发者利用Claude Code Skills和LlamaIndex的semtools PDF解析能力,创建了一个M&A交易分析智能体。该智能体能够解析公共M&A文件(如DEF 14A),分析每份PDF,并自动生成包含交易条款和可比公司数据的Excel表格。这一工具显著提升了金融分析的效率和准确性,尤其适用于处理复杂金融文档的场景。(来源:jerryjliu0)

Anthropic Skills和Plugins:功能重叠引发开发者困惑 : Anthropic近期推出了Skills和Plugins功能,旨在为AI Agent引入自定义功能。然而,一些开发者反映这两者在用途上存在混淆和重叠,导致在使用场景和开发策略上感到困惑。这表明Anthropic在功能设计和发布策略上可能存在优化空间,以更好地指导开发者利用其AI能力。(来源:Vtrivedy10, Reddit r/ClaudeAI)

📚 学习

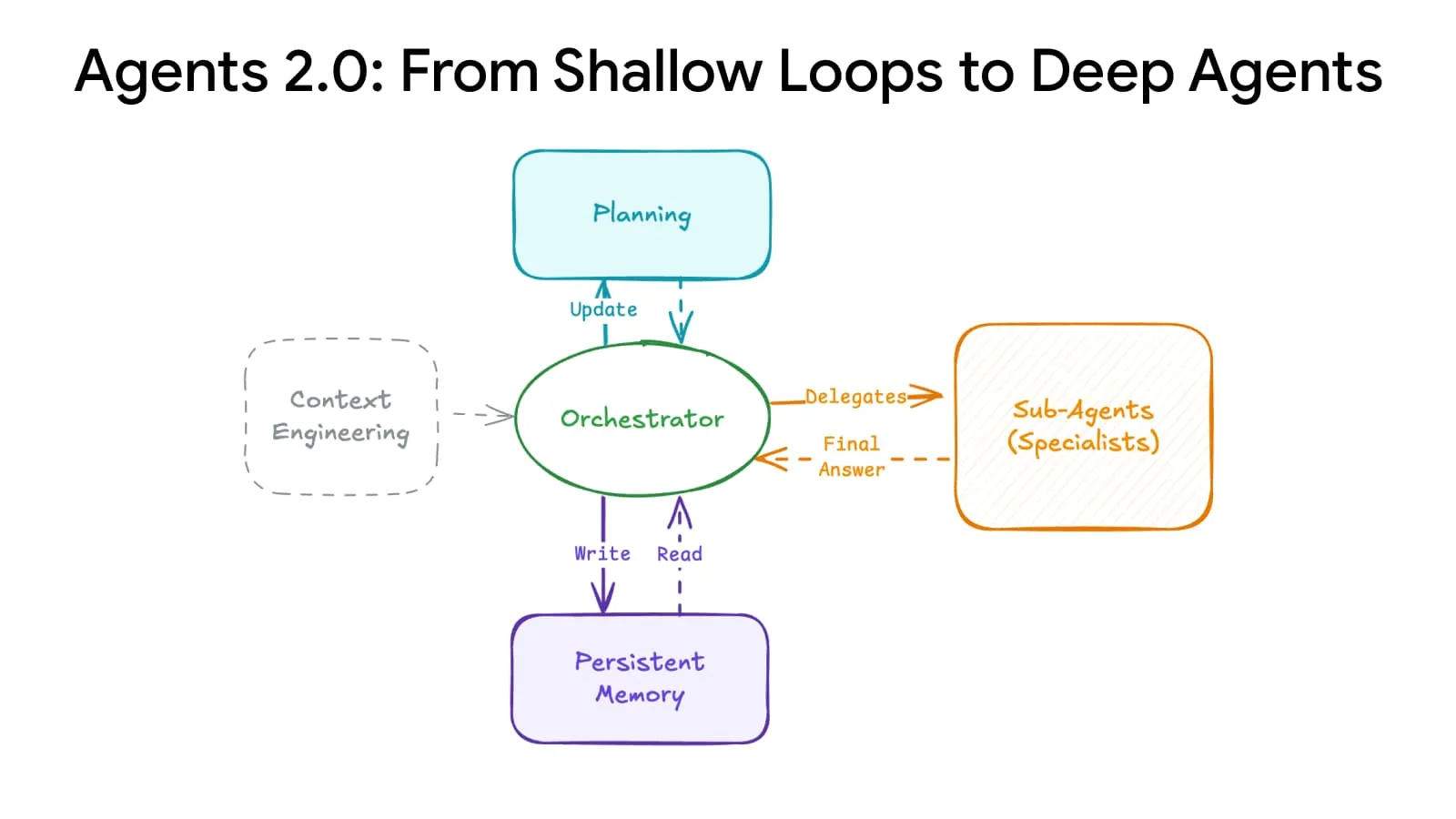

Deep Agents Evolution:高级规划与记忆系统提升智能体规模 : 一项AI架构突破实现了“深度智能体进化”,通过先进的规划和记忆系统,使智能体能够从15步扩展到500多步,彻底改变了AI处理复杂任务的方式。这项技术有望让AI在更长时间序列和更复杂逻辑链条中保持连贯性,为构建更强大的通用AI智能体奠定基础。(来源:LangChainAI)

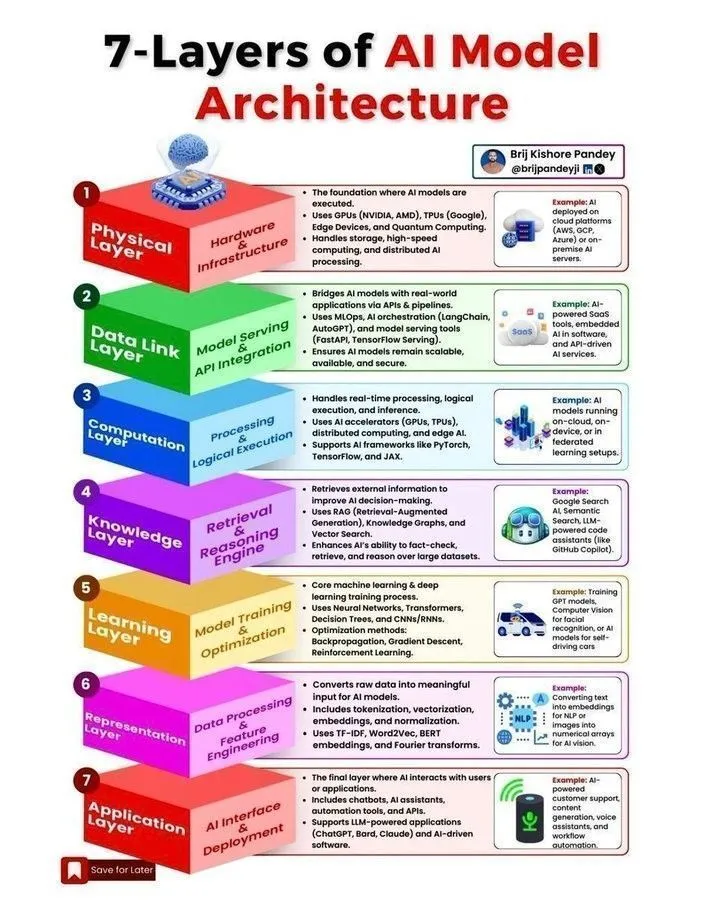

AI模型架构与智能体开发路线图 : 社交媒体上分享了多份关于AI模型架构、智能体开发路线图、机器学习生命周期及AI与生成式AI、机器学习之间区别的资源。这些内容旨在帮助开发者和研究人员理解AI系统的核心概念、构建可扩展AI智能体的关键步骤,以及掌握2025年AI领域所需的关键技能。(来源:Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

斯坦福CME295课程:Transformer与大模型工程实践 : 斯坦福大学发布了CME295系列课程,专注于Transformer架构和大型语言模型(LLM)的工程实践知识。该课程避免复杂的数学概念,强调实际应用,为希望深入了解大模型开发和部署的工程师提供了宝贵的学习资源。同时,CS224N课程被推荐为NLP入门的最佳选择。(来源:karminski3, QuixiAI, stanfordnlp)

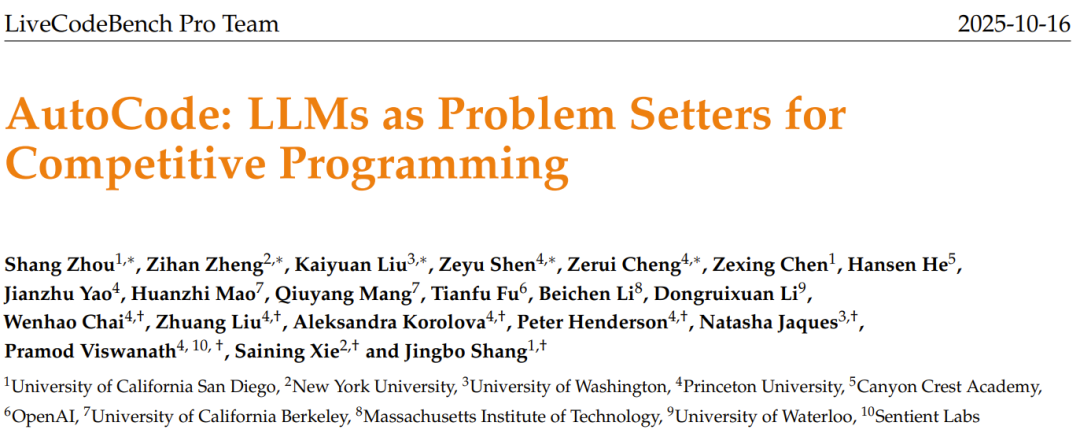

AI出题机AutoCode:LLM生成原创编程竞赛题 : LiveCodeBench Pro团队推出了AutoCode框架,利用LLM在一个闭环、多角色系统中自动化竞赛编程问题的创建和评估。该框架通过增强的验证器-生成器-检查器机制,实现了测试用例生成的高可靠性,并能从“种子问题”启发LLM生成高质量、原创的新问题,有望为更严谨的编程竞赛基准测试和模型的自我完善铺平道路。(来源:36氪)

KAIST研发AI半导体大脑:结合Transformer与Mamba效率 : 韩国科学技术院(KAIST)开发了一种新型AI半导体大脑,成功结合了Transformer架构的智能和Mamba架构的效率。这一突破性研究旨在解决现有AI模型在性能和能耗之间的权衡问题,为未来高效、低功耗的AI硬件设计提供了新的方向,有望加速边缘AI和嵌入式AI系统的发展。(来源:Reddit r/deeplearning)

多阶段NER管线:模糊匹配与LLM掩码技术分析Reddit评论 : 一项研究提出了一种多阶段命名实体识别(NER)管线,结合高速模糊匹配和LLM掩码技术,用于从Reddit评论中提取实体和情感。该方法首先通过模糊搜索识别已知实体,然后用LLM处理掩码后的文本以发现新实体,最后进行情感分析和总结。这种混合方法在处理大规模、嘈杂的领域特定文本时,实现了速度与发现能力的平衡。(来源:Reddit r/MachineLearning)

ML驱动交易系统部署经验:解决实时环境中的“前瞻偏差”与“状态漂移” : 一位开发者分享了部署ML驱动交易系统的经验,强调了在实时环境中解决“前瞻偏差”和“状态漂移”的关键性。通过严格的逐行处理模型和“黄金主控”脚本,确保历史测试与实时运行的确定性一致。系统还包含一个验证器,以1.0的皮尔逊相关系数衡量实时预测与验证器预测的一致性,确保模型的可靠性。(来源:Reddit r/MachineLearning)

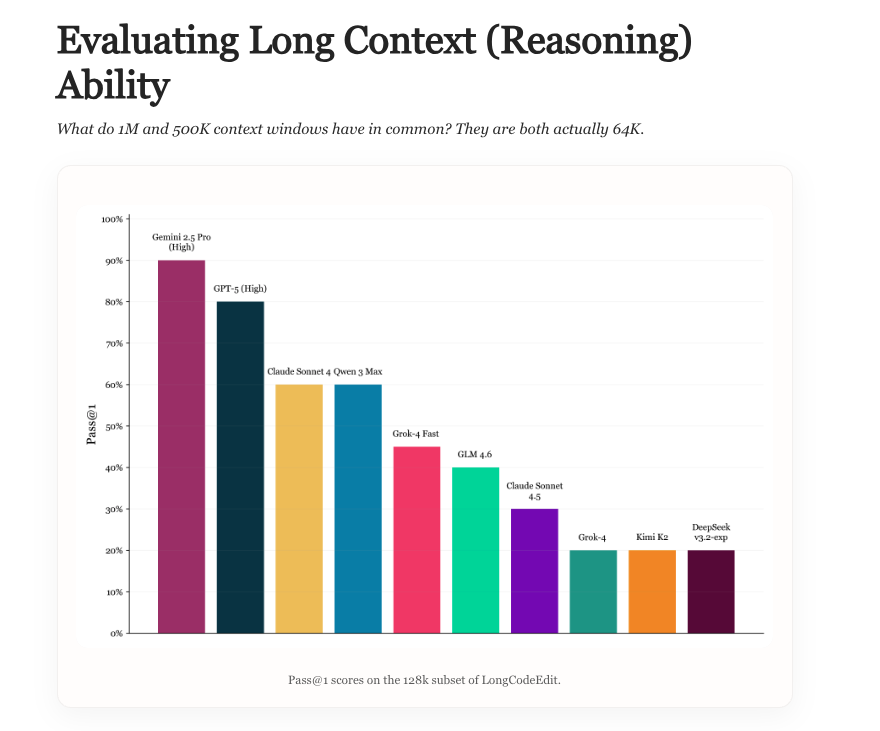

Long Context Evaluation:LLM长上下文能力评估新基准 : 新研究探讨了LLM长上下文评估的现状,分析了现有基准的优缺点,并引入了一个名为LongCodeEdit的新基准。该研究旨在解决现有评估方法在衡量LLM处理长文本和复杂代码编辑任务时的不足,为更准确地评估模型在长上下文场景下的性能提供了新工具和见解。(来源:nrehiew_, teortaxesTex)

Manifold Optimization:神经网络训练的几何感知优化 : Manifold优化使神经网络训练具备几何感知能力。新研究将这一思想扩展到模块化流形,帮助设计理解层间交互的优化器。通过结合前向函数、流形约束和范数,该框架描述了层间几何和优化规则的组合方式,从而在更深层次上实现几何感知优化,提升神经网络的训练效率和效果。(来源:TheTuringPost, TheTuringPost)

AI研究的科尔莫哥洛夫复杂度:AI简化研究成果的潜力 : 讨论指出,新的研究和博客内容的核心“本质”可以被压缩为代码、产物和数学抽象。未来的AI系统有望将复杂研究“翻译”成简单产物,通过提取核心差异并复现关键结果,大幅压缩新研究的理解成本,使研究人员能够更容易地跟上ArXiv上的海量论文,实现研究成果的快速消化和应用。(来源:jxmnop, aaron_defazio)

LSTM之父对残差学习起源的争议:Hochreiter 1991年贡献 : LSTM之父Jürgen Schmidhuber再次发声,指出残差学习的核心思想早在1991年就由其学生Sepp Hochreiter提出,用于解决RNN的梯度消失问题。Hochreiter在博士论文中引入了循环残差连接,并固定权重为1.0,这被认为是后来LSTM、Highway网络和ResNet等深度学习架构中残差思想的奠基。Schmidhuber强调了早期贡献对深度学习发展的重要性。(来源:量子位)

💼 商业

知维拓医药获数千万元种子轮融资:AI辅助口服小分子新药研发 : 北京知维拓医药科技有限公司完成数千万元种子轮融资,由纽尔利资本领投,青檀投资跟投。资金将用于推进核心管线临床前研发及AI交互分子设计平台建设。公司聚焦AI制药赛道,利用自主研发的EnCore平台加速先导化合物发现和分子优化,主攻自身免疫疾病口服小分子药物,有望攻克“难成药”靶点。(来源:36氪)

达卯科技完成近亿元A+轮融资:算电协同技术破解智算中心高能耗难题 : 达卯科技完成近亿元A+轮融资,由宁德时代旗下溥泉资本领投。本轮融资将用于能源大模型、算电协同平台及智能体等核心技术的研发与推广,旨在通过“算电协同”解决智算中心高能耗问题,助力新型电力系统建设。达卯科技依托全栈自研能源大模型,已与商汤科技、寒武纪等头部企业合作,为高能耗算力基础设施提供能源优化方案。(来源:36氪)

京东、天猫、抖音“AI”上双11:技术赋能电商大促增长 : 今年双11成为AI电商的练兵场,京东、天猫、抖音等头部平台全面加码AI技术。AI被应用于优化消费体验、赋能商家、物流配送、内容分发和消费决策等全链路环节。例如,京东升级“拍照购”,抖音豆包接入商城,值得买科技实现AI对话即比价。AI正成为电商增长的新引擎,通过极致效率和成本控制,重塑行业竞争格局,推动电商从“货架/内容电商”走向“智能电商”阶段。(来源:36氪, 36氪)

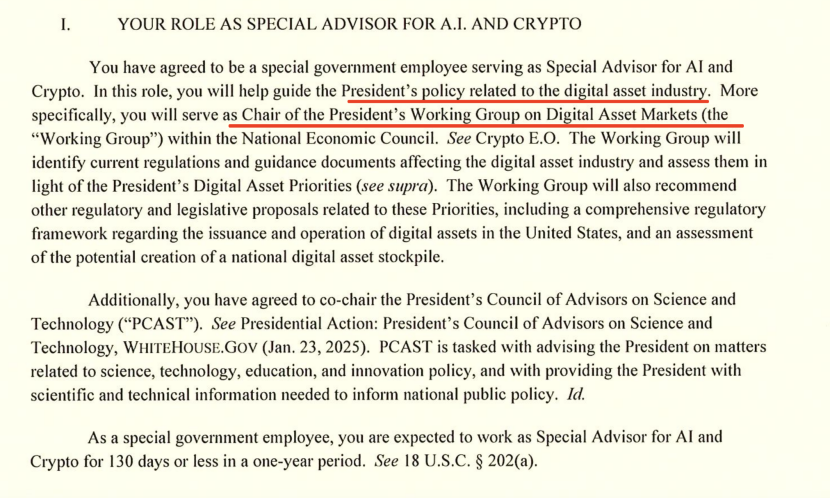

白宫AI负责人谈中美AI竞争:芯片出口与生态系统主导权 : 白宫AI和Crypto“沙皇”David Sacks在访谈中阐述了美国在中美AI竞争中的策略,强调创新、基础设施和出口的重要性。他指出,美国对华芯片出口政策需“细致入微”,既要限制最先进芯片,也要避免完全剥夺导致华为在国内市场垄断。Sacks强调,美国应构建庞大的AI生态系统,成为全球首选技术合作伙伴,而非通过官僚控制扼杀竞争力。(来源:36氪)

🌟 社区

OpenAI商业化争议:从非营利到逐利,Sam Altman口碑受损 : OpenAI CEO Sam Altman因ChatGPT将放开情色内容、GPT-5模型表现及激进的基础设施扩张策略,引发广泛争议。社区质疑其从非营利初心转向商业逐利,对AI技术发展方向、投资泡沫和员工伦理待遇表示担忧。Altman的回应未能完全平息舆论,凸显AI帝国扩张与社会责任之间的张力。(来源:36氪, janusch_patas, Reddit r/ArtificialInteligence)

大模型中毒:数据投毒、对抗样本与AI安全挑战 : 大模型面临数据投毒、后门攻击和对抗样本等安全威胁,导致模型输出异常、有害内容,甚至被用于商业广告(GEO)、技术炫耀或网络犯罪。研究显示,少量恶意数据即可显著影响模型。这引发了对AI幻觉、用户决策操纵及公共安全风险的担忧,强调建立模型免疫系统、强化数据审核和持续防御机制的重要性。(来源:36氪)

AI时代下数据标注员的困境:硕博学历从事低薪重复劳动 : 随着AI大模型发展,数据标注工作对学历要求提高(甚至需要硕博),但薪资待遇却远低于AI工程师。这些“AI老师”从事着评估AI生成内容、进行伦理审查和专业知识教练的活,却拿着低廉的时薪,且工作不稳定,项目结束即失业。这种“赛博流水线”式的层层转包和压榨模式,引发了对AI产业劳动伦理和公平性的深刻反思。(来源:36氪)

AI对创意与人类价值的冲击:是终结还是升华? : 社区讨论AI对人类创造力的影响,认为AI并未杀死创意,而是揭示了人类创造力的相对平庸。AI擅长模式重组和生成,但真正的原创性、矛盾性和不可预测性仍是人类的独特优势。新工具的出现总是淘汰中间地带,迫使人类在内容和创意上寻求更高层次的突破,使真正的创意变得更加珍贵。(来源:Reddit r/artificial)

AI引发的生存焦虑与应对策略:现实问题与过度担忧 : 面对AI可能带来的生存威胁,社区讨论了如何应对由此产生的“存在性恐惧”。一些观点认为,这种恐惧可能源于对未来的过度幻想,建议人们回归现实,关注当下生活。同时,也有人指出,与AI相关的经济冲击和就业问题是更紧迫的现实威胁,强调AI安全应与社会经济影响并重。(来源:Reddit r/ArtificialInteligence)

Karpathy观点引发热议:AGI十年论、智能体“幽灵”论与AI发展路径 : Andrej Karpathy关于AGI“十年论”及现有AI智能体是“幽灵”的观点在社区引发广泛讨论。他强调AI需要持久性、记忆力和连续性才能成为真正的智能体,并建议AI训练应从“灌数据”转向“教目标”。这些观点被视为对当前AI炒作的冷静反思,促使人们重新思考AI的长期发展路径和评估标准。(来源:TheTuringPost, TheTuringPost, NandoDF, random_walker, lateinteraction, stanfordnlp)

ChatGPT市场份额持续下滑:Perplexity、Gemini、DeepSeek等竞争者崛起 : Similarweb数据显示,ChatGPT的市场份额持续下降,从一年前的87.1%降至74.1%。与此同时,Gemini、Perplexity、DeepSeek、Grok和Claude等竞争对手的市场份额正在稳步增长。这一趋势表明AI助手市场竞争日益激烈,用户选择趋于多元化,ChatGPT的主导地位正受到挑战。(来源:ClementDelangue, brickroad7)

GPT-5数学乌龙事件:OpenAI过度营销与同行质疑 : OpenAI研究员高调宣称GPT-5解决了多项厄尔多斯数学难题,但随后被发现只是通过网络检索找到了已有答案,而非独立破解。这一事件引发了DeepMind CEO哈萨比斯和Meta的LeCun等业界大咖的公开嘲讽,质疑OpenAI的过度营销,凸显了AI能力宣传中的严谨性问题以及同行间的竞争态势。(来源:量子位)

AI的隐性环境成本:能源消耗与水资源需求 : 历史研究表明,从电报到AI,通信系统始终伴随着隐性环境成本。AI和现代通信系统依赖大规模数据中心,导致能源消耗和水资源需求飙升。预计到2027年,AI用水量将与丹麦全年用水量相当。这凸显了AI技术快速发展背后的环境代价,呼吁政府加强监管,强制披露环境影响,并支持低影响项目。(来源:aihub.org)

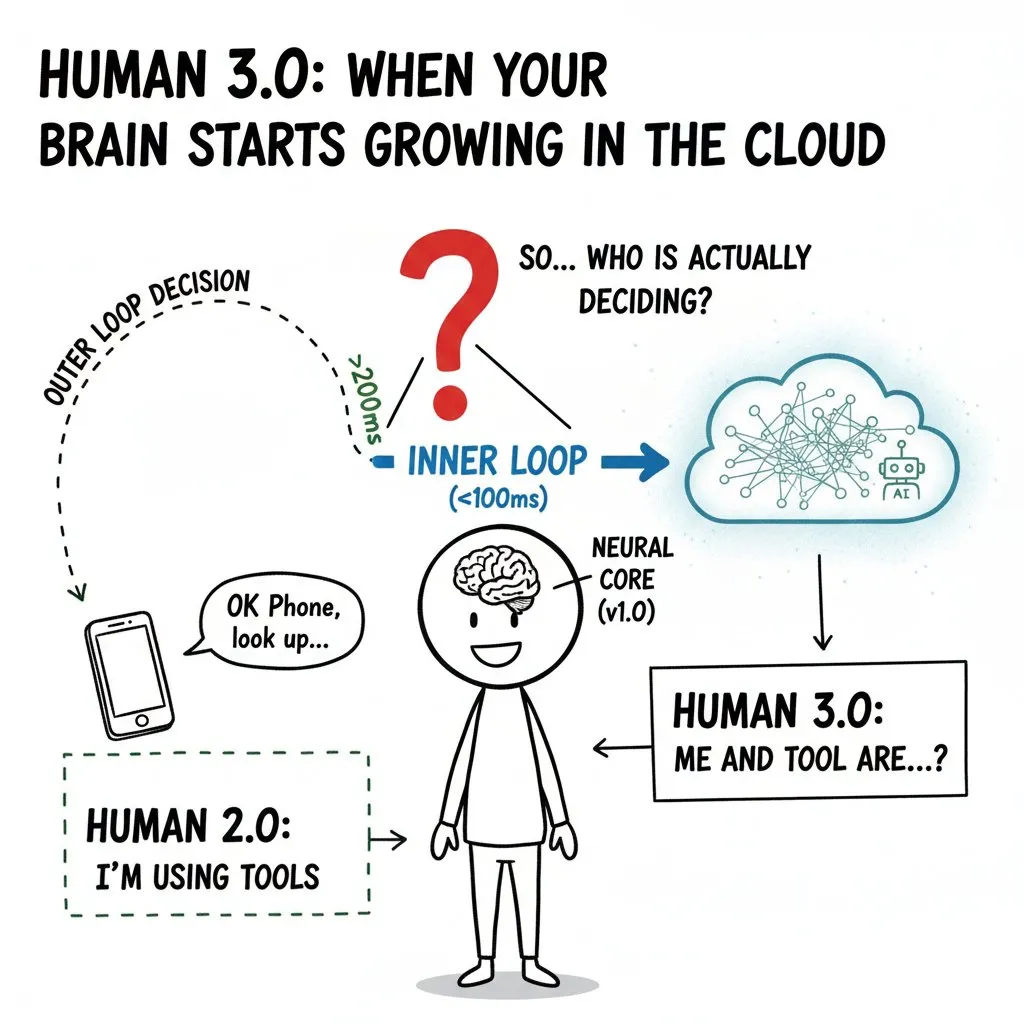

AI对人类心智的“入侵”:脑机接口与“人类3.0”的伦理边界 : 社区深度讨论了脑机接口(BCI)和AI对人类心智的潜在影响,提出了“人类3.0”的概念。当外部算力进入人类决策的“内环”,快到大脑无法分辨信号来源时,将引发“自我”边界、价值判断和长期健康等伦理问题。文章强调,在技术普及前必须制定零信任架构、硬件隔离和权限管理,以避免出租决策权和加剧物种层面的不平等。(来源:dotey)

💡 其他

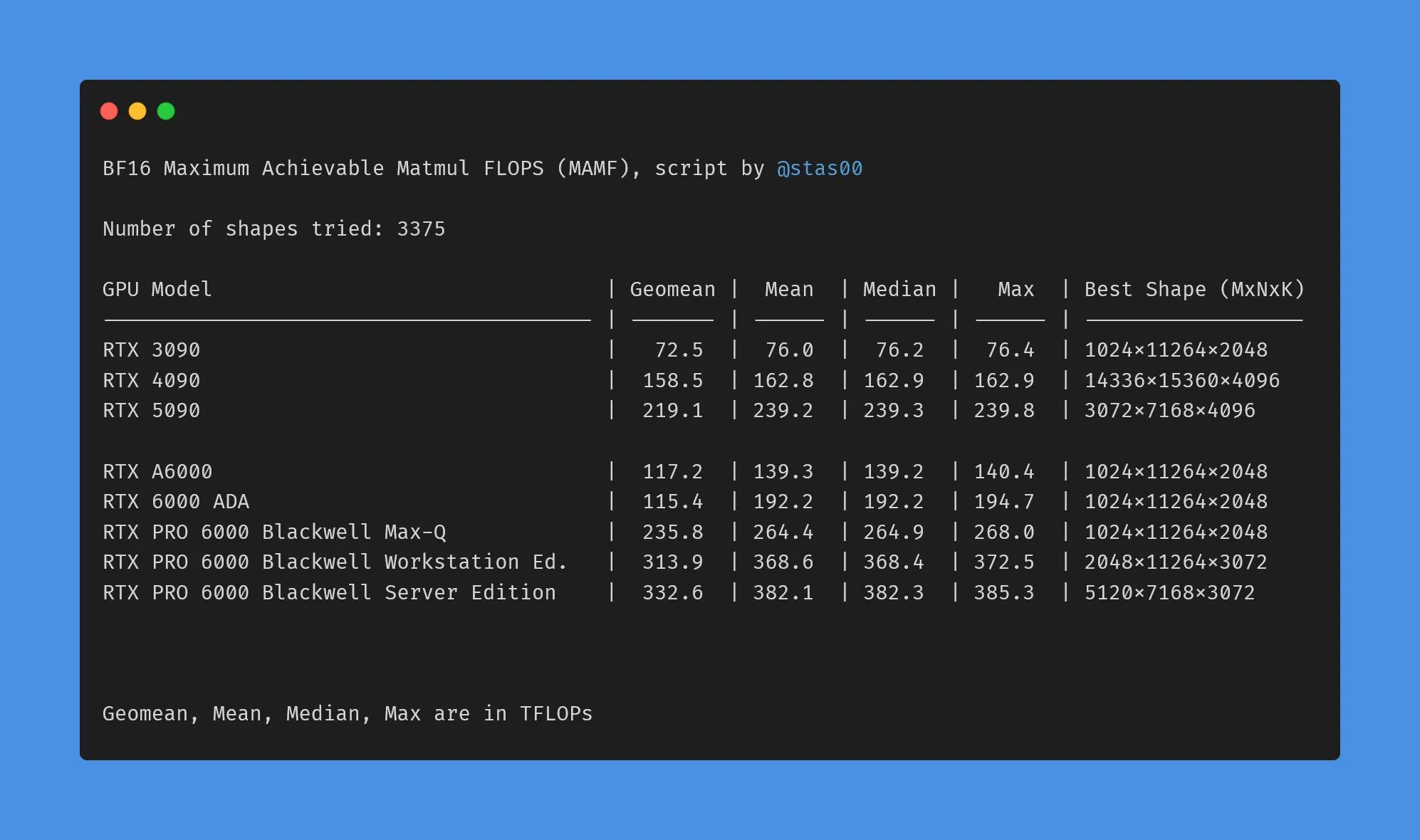

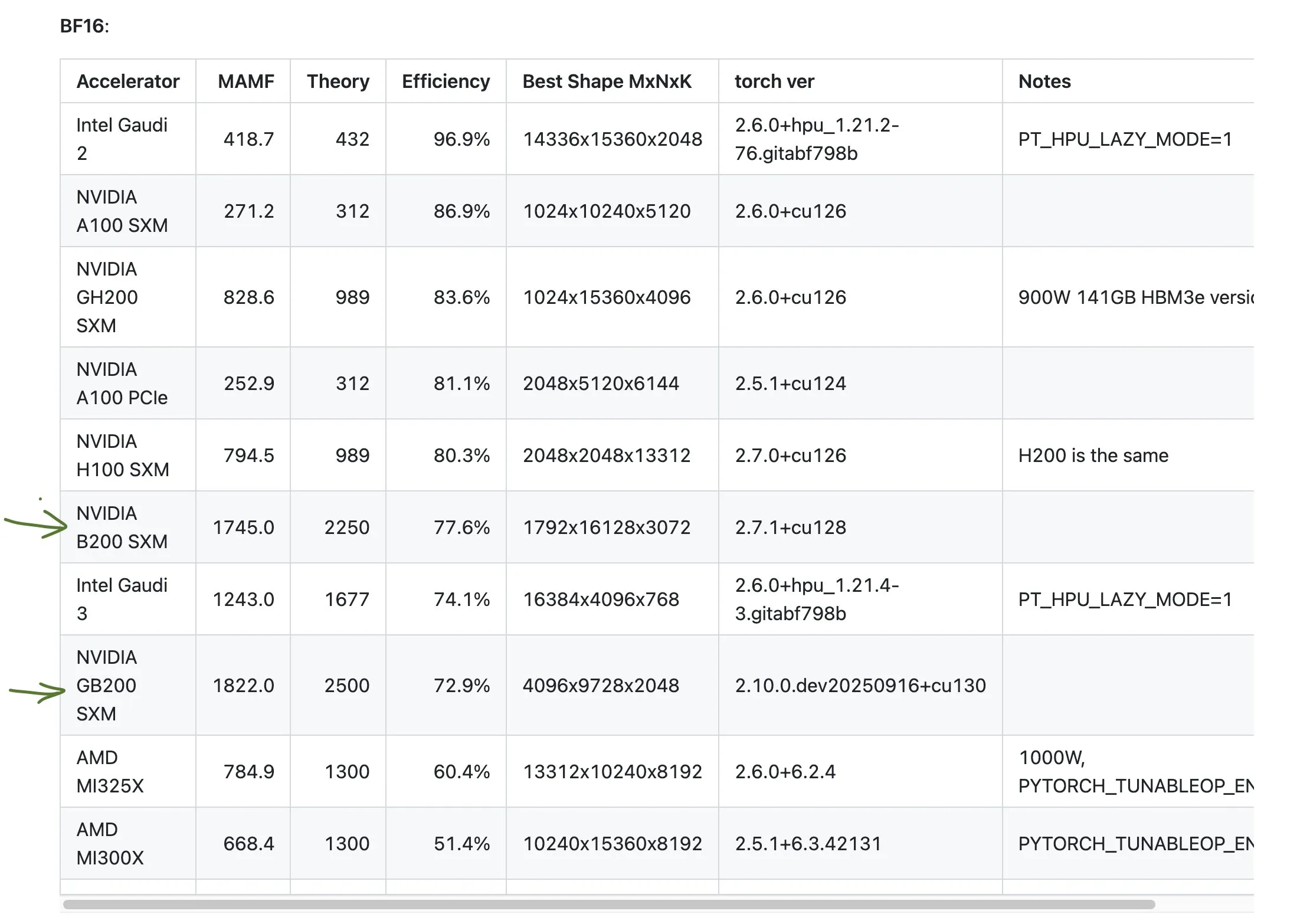

NVIDIA消费级与专业级GPU性能数据差异 : 社区讨论了NVIDIA消费级和专业级GPU在营销TFLOPs与实际性能之间的差异。数据显示,消费级显卡(如3090、4090、5090)实际性能略高于或接近标称TFLOPs,而专业级工作站显卡(如A6000、6000 ADA)的实际性能远低于标称值。尽管如此,专业卡在功耗、尺寸和能效方面仍有优势,但用户需警惕营销数据与实际表现的落差。(来源:TheZachMueller)

AMD GPU性能表现不佳的讨论 : 社区讨论了AMD GPU在某些基准测试中的性能表现,指出其效率可能仅为预期的一半。这引发了对AMD在AI计算领域竞争力的担忧,尤其是在与NVIDIA的GB200等高性能产品对比时。用户在规划AI计算资源时,需谨慎评估不同厂商GPU的实际性能和效率。(来源:jeremyphoward)

GIGABYTE AI TOP ATOM:桌面级Grace Blackwell GB10性能 : 技嘉发布AI TOP ATOM,将NVIDIA Grace Blackwell GB10的性能引入桌面级工作站。这一产品旨在为个人用户和小型团队提供强大的AI计算能力,使其能够在本地进行高性能模型训练和推理,降低对云端资源的依赖,加速AI应用的开发和部署。(来源:Reddit r/LocalLLaMA)