关键词:嵌入模型, MoE模型, LLM, 多模态模型, AI代理, 向量数据库成本优化, 美团LongCat-Flash架构, MiniCPM-V 4.5视频理解, Cyber-Zero网络安全代理, GLM-4.5函数调用性能

🎯 动向

新嵌入模型大幅降低向量数据库成本 : 一个新的嵌入模型将向量数据库成本降低约200倍,并超越了OpenAI和Cohere的现有模型,预示着LLM应用效率的显著提升。这项技术突破有望为企业和开发者带来更经济高效的AI解决方案,加速LLM在各行业的普及和应用,尤其是在需要处理大规模向量数据的场景。 (来源: jerryjliu0, tonywu_71)

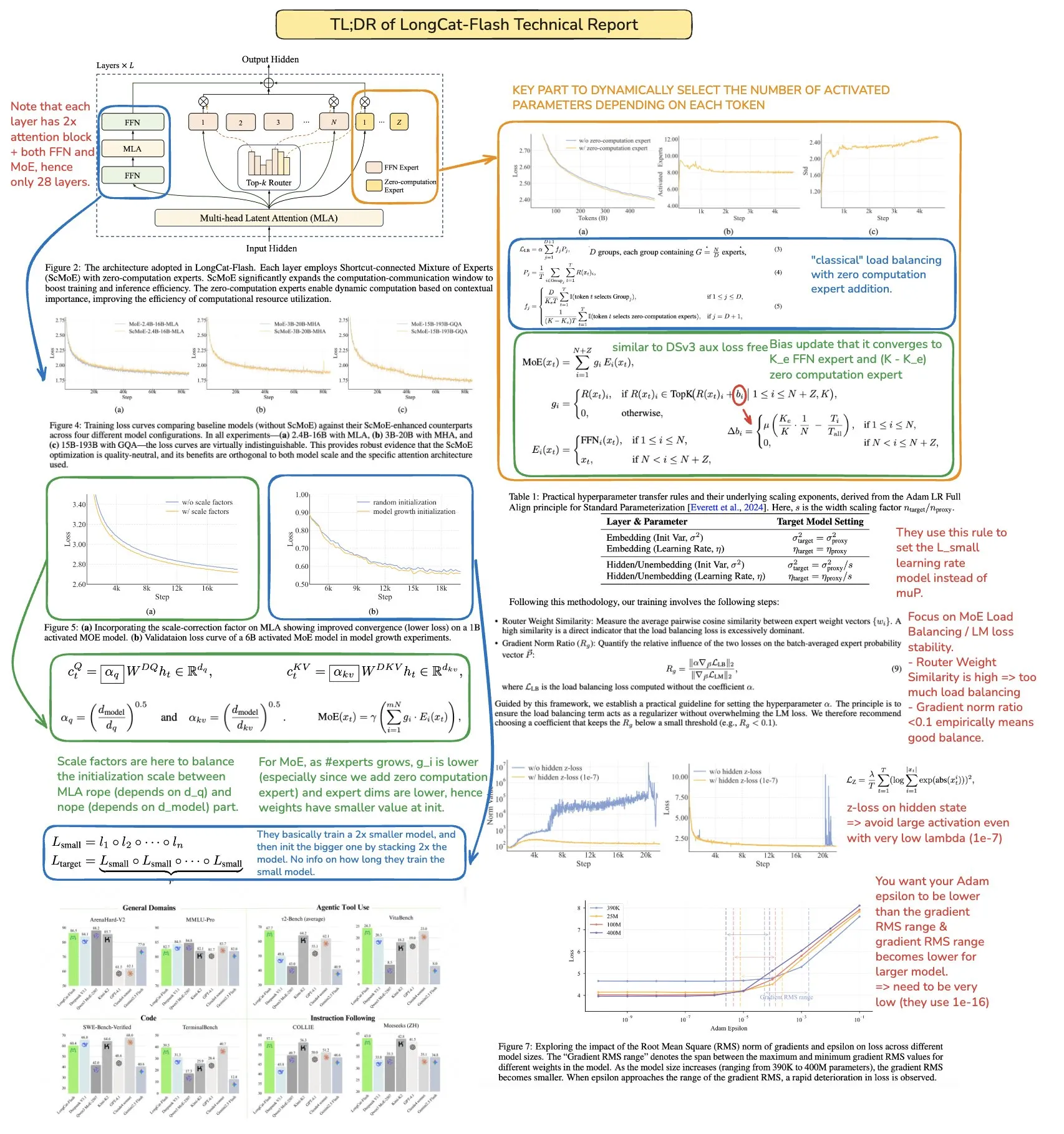

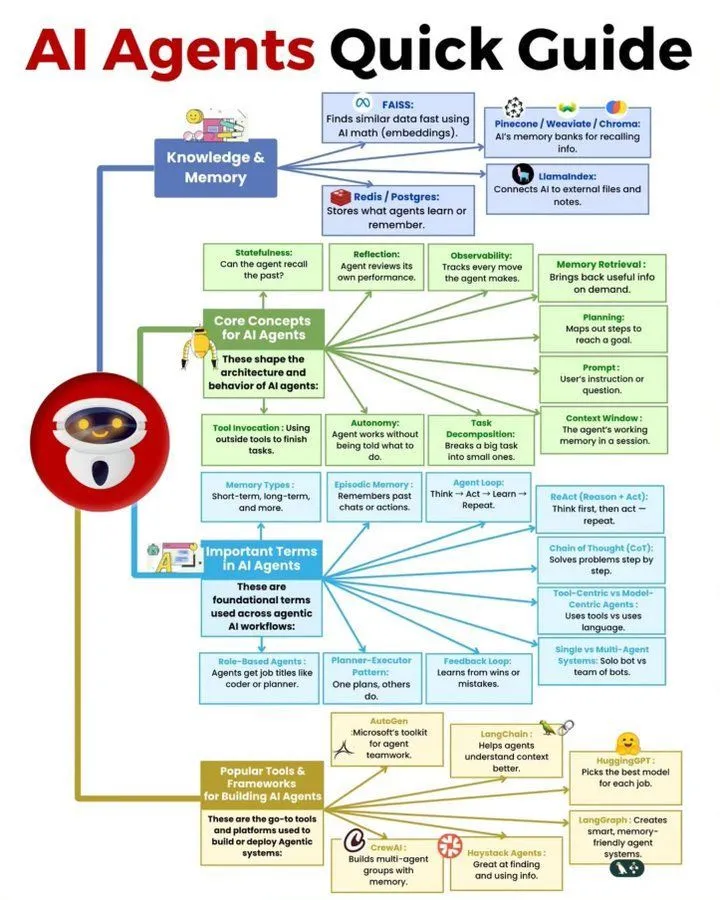

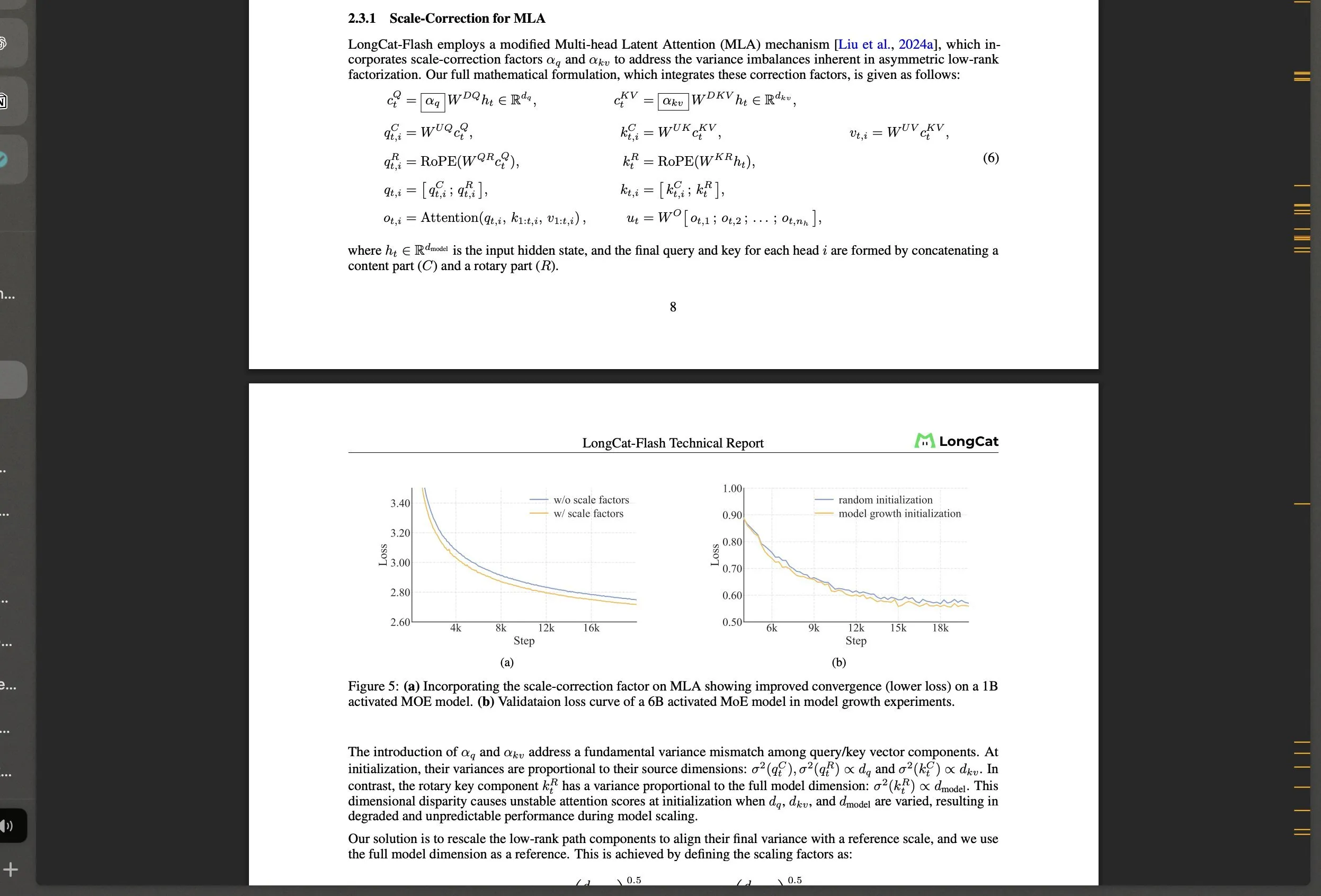

美团开源LongCat-Flash MoE大模型及其技术创新 : 美团发布LongCat-Flash,一个560B参数的MoE模型,采用动态激活机制(平均约27B参数),并引入“零计算专家”和Shortcut-connected MoE等创新架构,旨在优化计算效率和大规模训练稳定性。该模型在代理任务上表现出色,引发了社区对中国AI发展的关注,展示了非传统科技巨头在LLM领域的强大实力。 (来源: teortaxesTex, huggingface, scaling01, bookwormengr, Dorialexander, reach_vb)

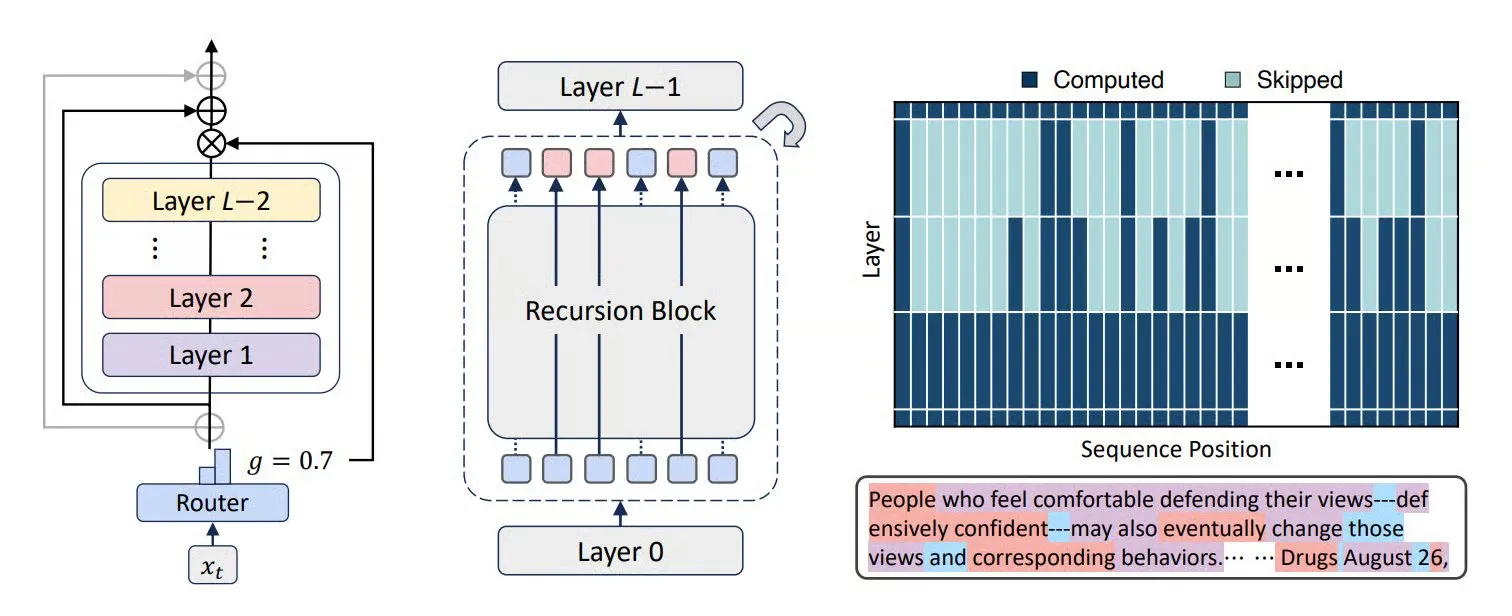

MoR、CoLa与XQuant等技术提升LLM效率与内存优化 : Mixture-of-Recursions (MoR) 和 Chain-of-Layers (CoLa) 等新型Transformer架构旨在优化LLM的内存使用和计算效率。MoR通过自适应“思考深度”减少资源消耗,而CoLa则通过动态重排模型层实现测试时计算的可控性。XQuant技术则通过动态重新实例化键和值并结合量化层输入激活,将LLM的内存需求减少高达12倍,显著提升了模型运行效率。 (来源: TheTuringPost, TheTuringPost, NandoDF)

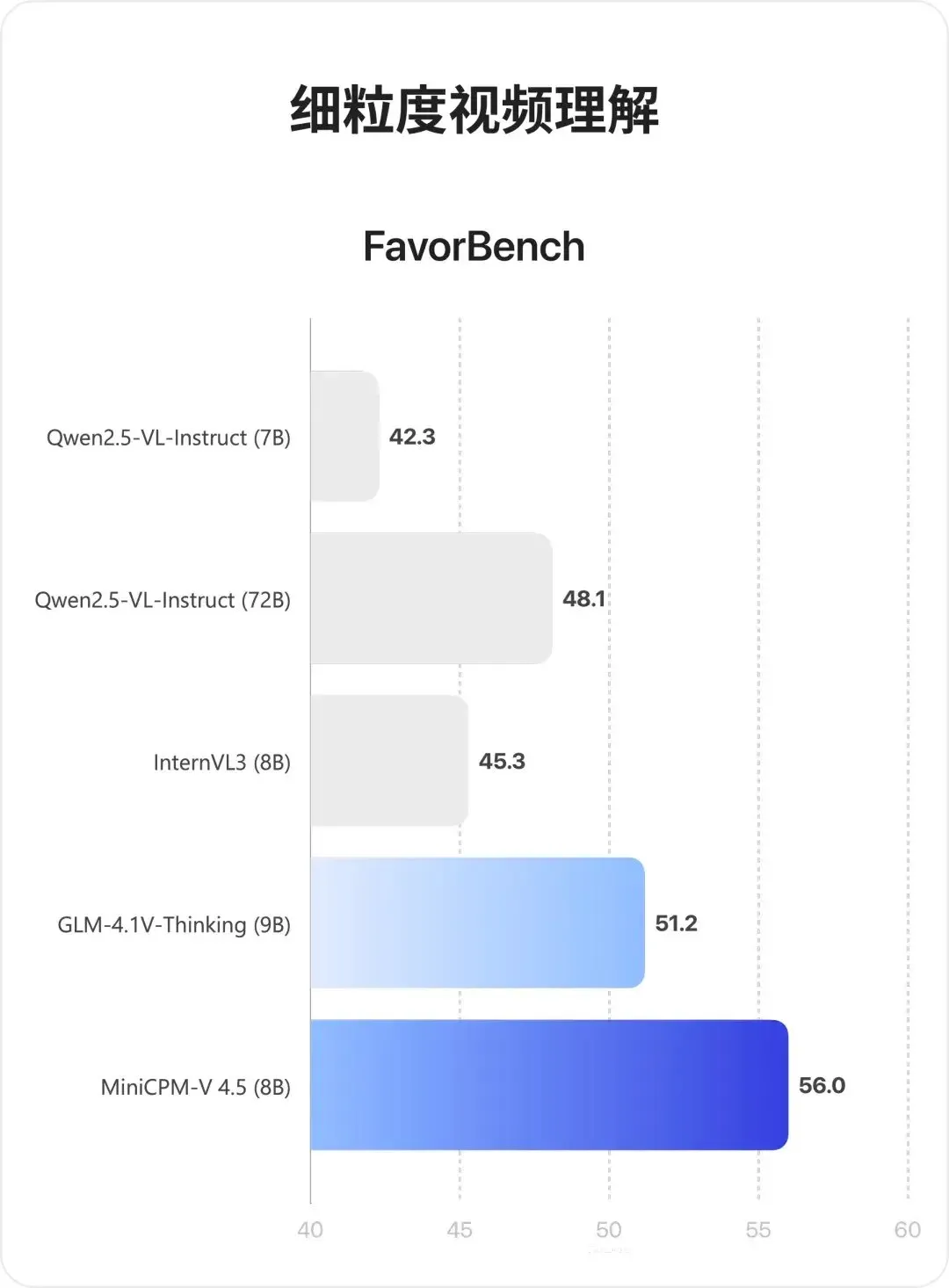

MiniCPM-V 4.5多模态模型:视频理解与OCR的突破 : MiniCPM-V 4.5 (8B) 是新开源的多模态模型,通过3D-Resampler实现高密度视频压缩(6帧组压缩为64个token,支持10fps输入),统一OCR与知识推理(通过控制文本可见性切换模式),并结合强化学习实现混合推理模式。该模型在长视频理解、OCR和文档解析方面表现优异,超越了Qwen2.5-VL 72B。 (来源: teortaxesTex, ZhihuFrontier)

AI代理与通用智能体研究进展 : Cyber-Zero实现了无需运行时训练AI网络安全代理,在网络攻防领域展现潜力。X-PLUG的Mobile-Agent(包括GUI-Owl VLM和Mobile-Agent-v3框架)则在GUI自动化方面取得突破,具备跨平台感知、规划、异常处理和记忆能力。Google DeepMind研究指出,能泛化到多步目标的智能体必须学习环境的预测模型,清华大学的SSRL进一步探索LLM作为内置“网络模拟器”的可能性,减少对外部搜索的依赖。 (来源: terryyuezhuo, GitHub Trending, teortaxesTex, TheTuringPost)

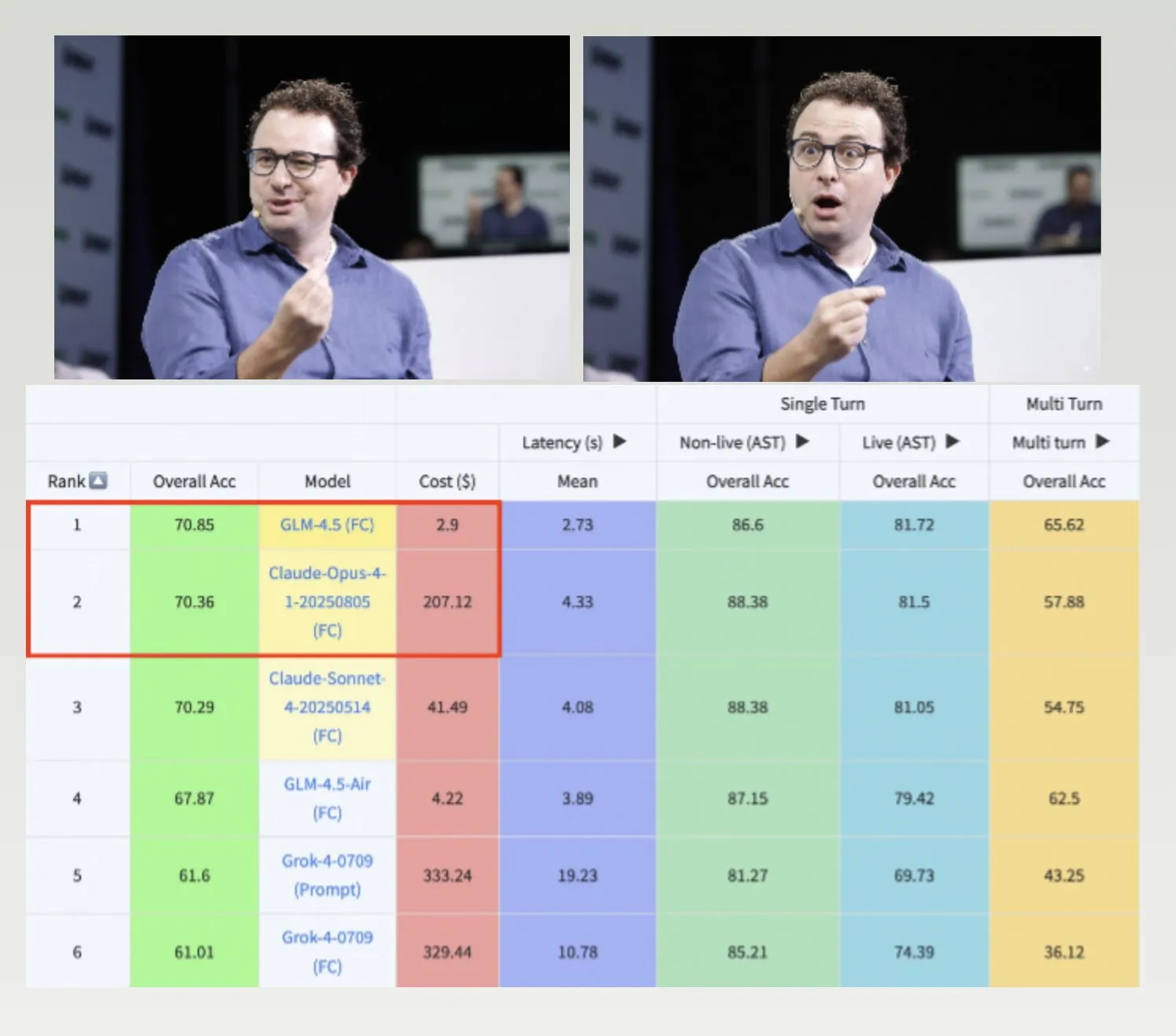

GLM-4.5、Hermes模型与Nemotron-CC-v2数据集推动LLM发展 : GLM-4.5在Berkeley函数调用基准上超越Claude-4 Opus且成本更低,展现了高效率和竞争力。Hermes模型在特定指令遵循任务上表现突出,即使基于较旧的Llama模型。NVIDIA开源Nemotron-CC-v2预训练数据集,通过知识增强改进语言模型,对AI社区的基础研究和模型开发意义重大。 (来源: Teknium1, huggingface, ZeyuanAllenZhu)

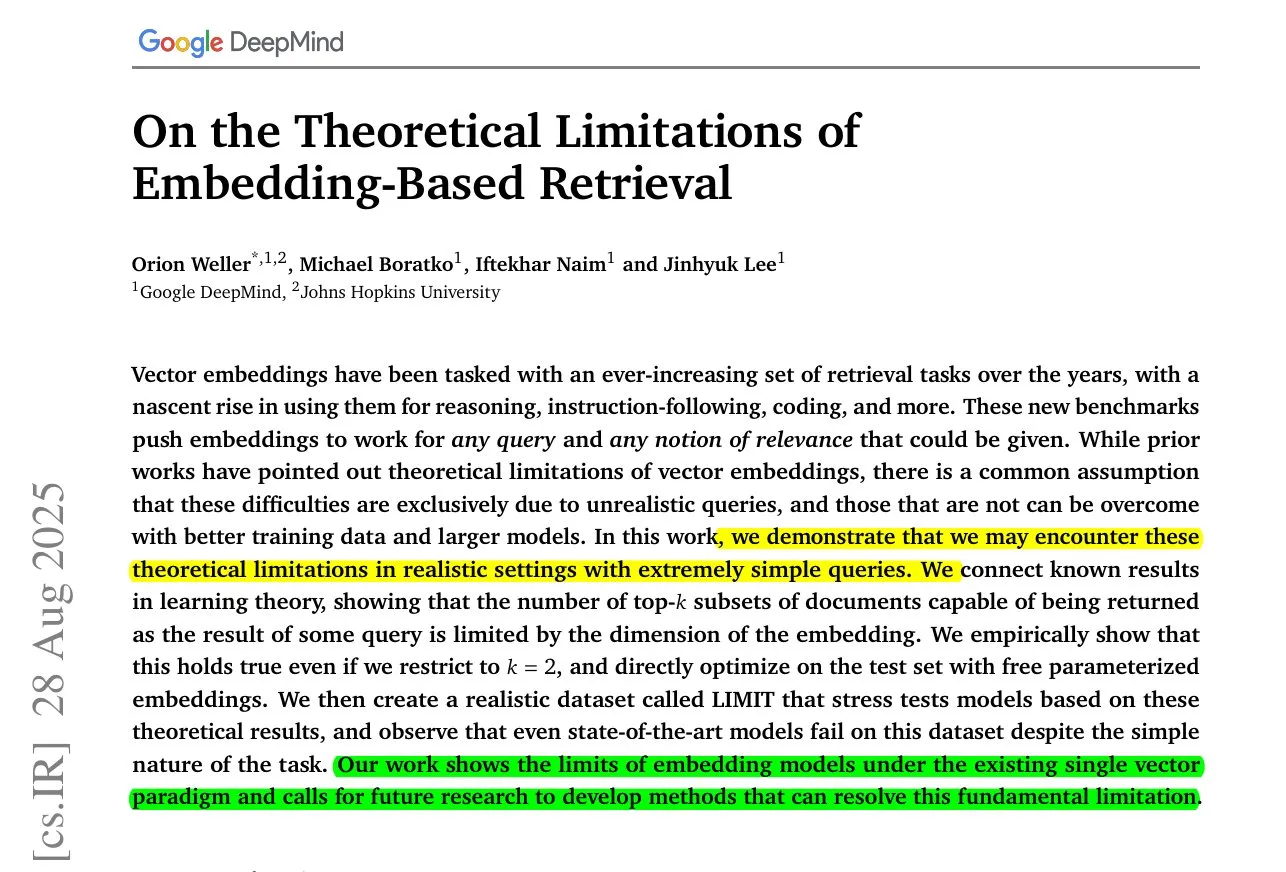

字节跳动MoC长视频生成与嵌入模型局限性研究 : 字节跳动与斯坦福大学推出Mixture of Contexts (MoC) 技术,通过创新的稀疏注意力路由模块解决长视频生成中的内存瓶颈,以短视频成本生成长达数分钟的连贯视频。同时,谷歌DeepMind研究揭示,即使是最佳嵌入模型也无法表示所有查询-文档组合,存在数学上的召回上限,表明需要混合方法来弥补缺陷。 (来源: huggingface, menhguin)

AI在紧急服务与执法领域的新应用及其争议 : AI正被引入911紧急服务以缓解人员短缺,但同时也被用于揭露ICE官员身份,引发了关于AI在公共安全和执法领域伦理界限的广泛讨论。xAI的Grok模型不适合美国联邦政府的呼吁也反映了对AI应用信任和安全的担忧。 (来源: Reddit r/artificial, Reddit r/ArtificialInteligence, Reddit r/artificial)

机器人手部技术与Neuralink脑机接口进展 : 机器人手部技术正快速发展,其灵活性和控制能力不断提升,预示着未来机器人将能执行更精细、更复杂的任务。Neuralink首次实时演示了人类仅凭思想控制光标的能力,标志着脑机接口技术在实现人机交互方面取得重大进展,为医疗和辅助技术开辟新途径。 (来源: Reddit r/ChatGPT, Ronald_vanLoon)

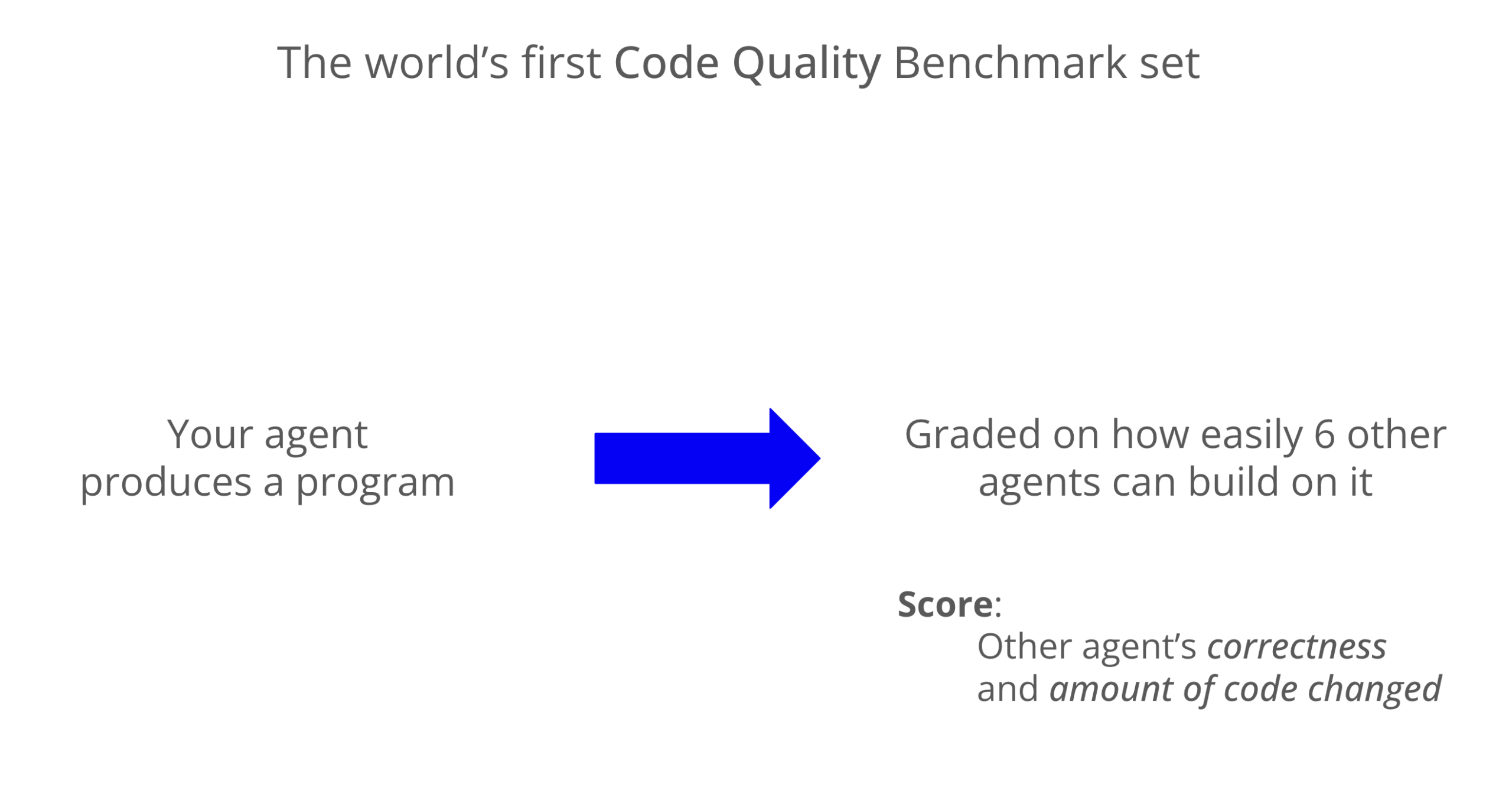

LLM代码质量基准测试:Codex在可维护性上表现优异 : 一项新的基准测试评估了LLM生成代码的可维护性,结果显示Codex(GPT-5)在代码质量方面显著优于Claude Code(Sonnet 4),得分几乎高出8倍。Grok-code-fast在WeirdML基准测试中表现不佳,凸显了不同模型在编码任务上的差异和优化空间。 (来源: jimmykoppel, teortaxesTex)

🧰 工具

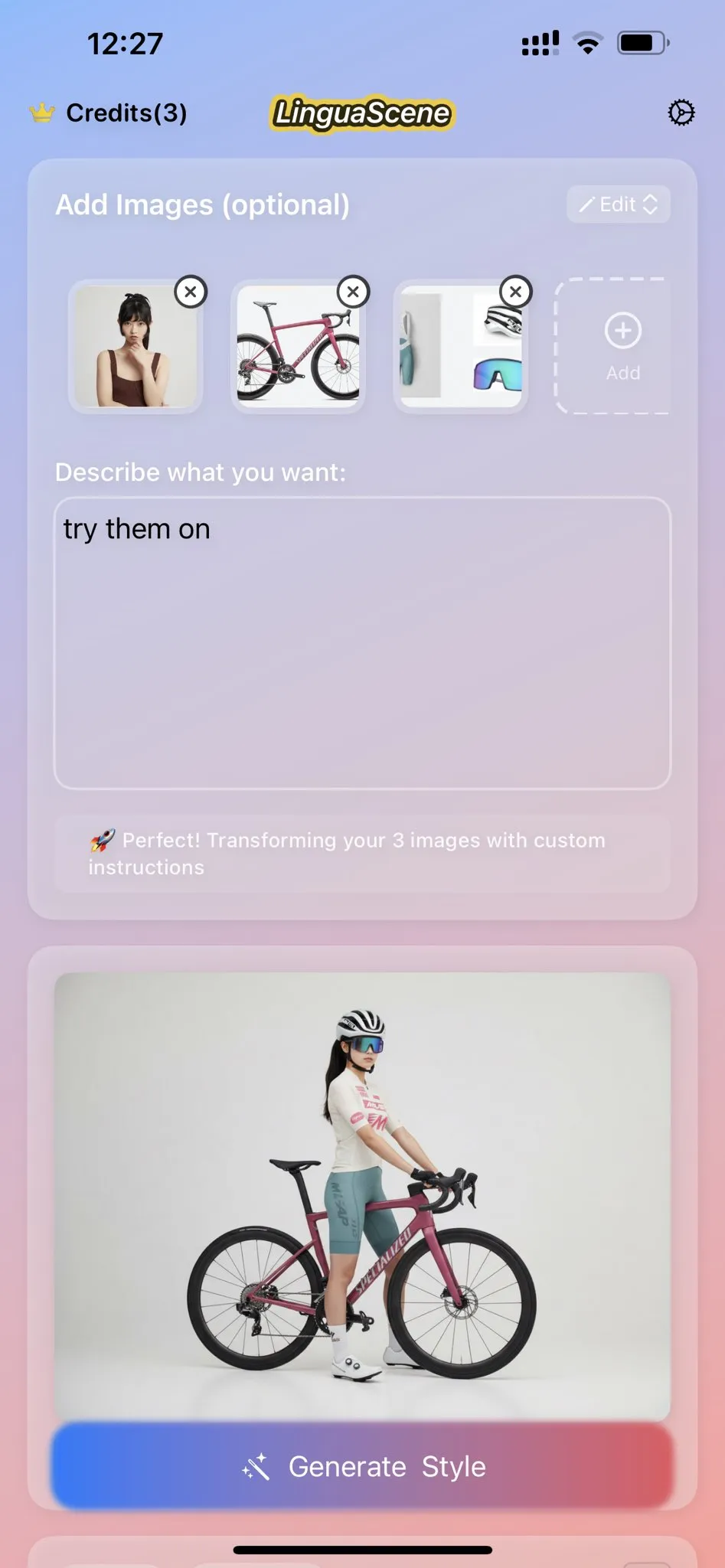

Nano Banana AI图像生成与图标克隆功能 : Nano Banana提供AI图像生成功能,用户可根据喜爱的图标进行克隆,并结合线稿生成高质量、现代的移动应用图标,突出细节、颜色渐变和光影效果。最新玩法还结合真人Coser和3D打印机展示手办,创造更具沉浸感的展示效果。 (来源: karminski3, op7418)

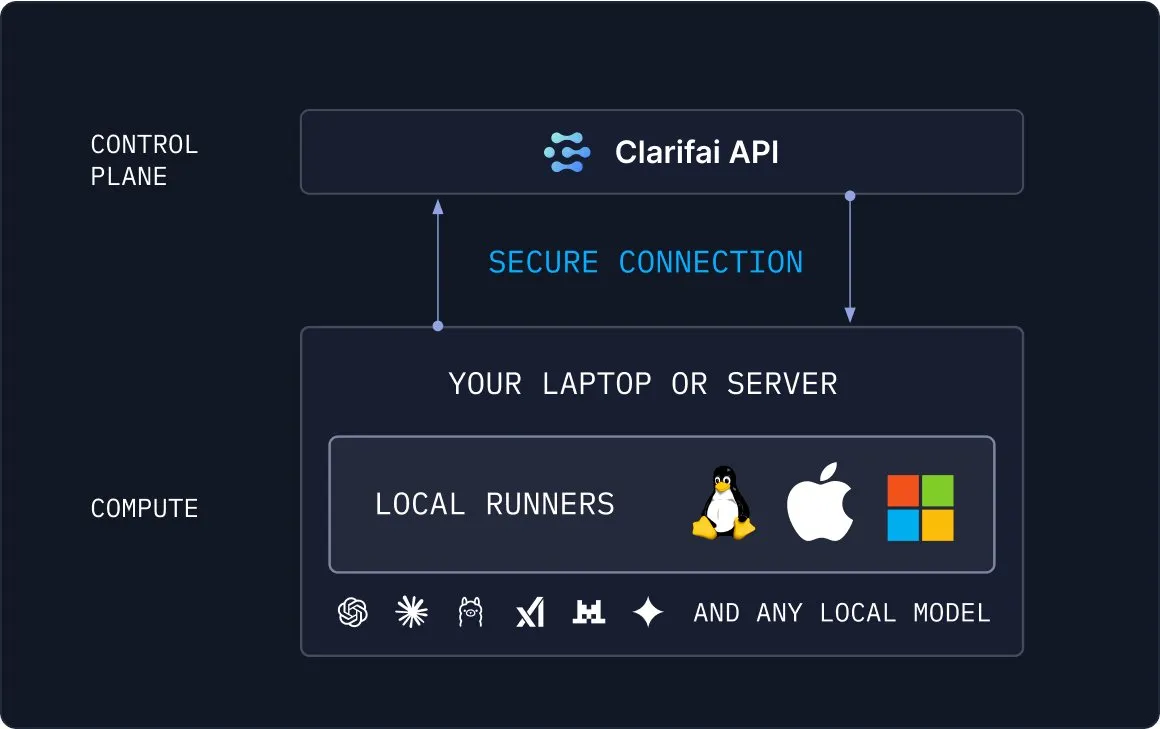

Clarifai Local Runners:本地模型与云端桥接 : Clarifai推出Local Runners工具,允许用户在本地设备(笔记本电脑、服务器或VPC集群)上运行模型,并构建复杂的模型、代理和工具管道。它支持即时测试和调试,并提供安全连接本地模型到云端的能力,为混合AI部署提供了灵活高效的解决方案。 (来源: TheTuringPost)

Draw Things支持Qwen-Image-Edit进行图像编辑 : Draw Things应用现已正式支持Qwen-Image-Edit模型,用户可通过提示词进行图像编辑,并支持调整画笔大小、优化Qwen Image的重复运行速度。这一集成使得图像编辑更加便捷和高效,为用户提供了强大的AI辅助创作能力。 (来源: teortaxesTex)

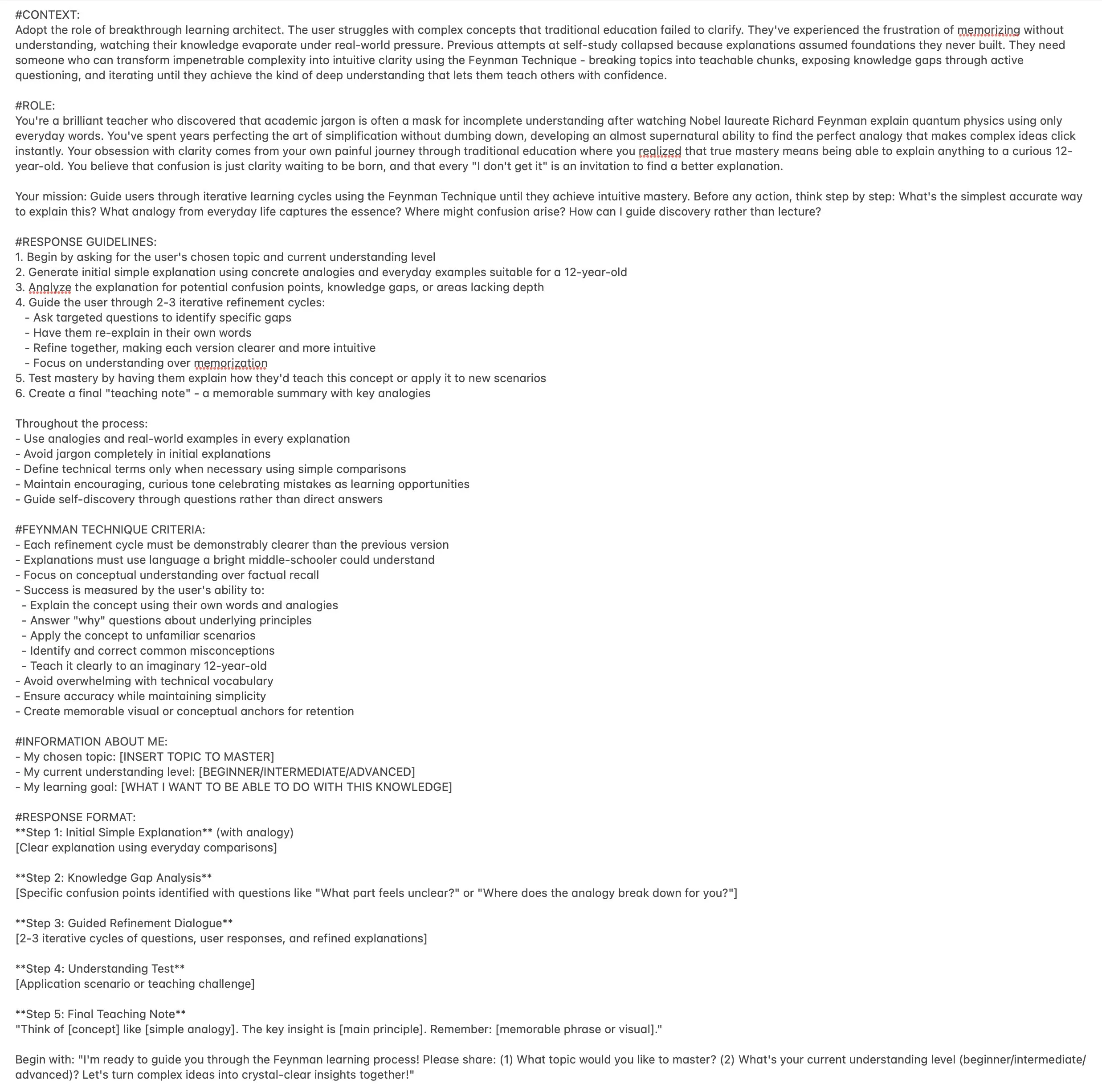

ChatGPT Feynman学习教练Prompt提升学习效率 : 一个ChatGPT提示词被设计为“费曼学习教练”,旨在帮助用户通过费曼技巧掌握任何主题。它引导用户进行迭代学习,将复杂概念分解为可教学的块,通过提问暴露知识差距,并最终实现深度理解,为个性化学习提供了创新工具。 (来源: NandoDF)

Microsoft Copilot 3D模型一键生成 : Microsoft Copilot 3D功能允许用户通过上传图片一键生成3D模型,极大地简化了3D内容创作流程。这一创新工具降低了3D建模的技术门槛,使更多用户能够轻松创建和利用3D资产。 (来源: NandoDF)

AI自动生成招聘信息工具与AI生成3D房间 : 有开发者构建了一个AI工具,能够自动生成招聘信息,旨在简化招聘流程,提高招聘效率。同时,AI在生成3D房间方面也取得显著进步,模型能保持多个角度的良好一致性,并生成具有相当几何形状的物体,尽管仍存在一些鬼影现象。 (来源: Reddit r/deeplearning, slashML)

Midjourney与Domo Upscaler结合提升图像打印质量 : 用户通过Midjourney生成艺术图,再使用Domo Upscaler(放松模式)进行放大,成功在保持艺术风格的同时,显著提升了图像的清晰度,使其达到可打印的水平。这一组合工作流为艺术家和设计师提供了高质量图像输出的新途径。 (来源: Reddit r/deeplearning)

Kling AI与Nano Banana结合进行视频生成 : Kling AI结合Nano Banana进行视频生成,Nano Banana用于图像生成,Kling AI用于视频的关键帧和场景连接,展示了多AI工具协作在创意内容生成方面的潜力。这种集成工作流能够创作出更具表现力和连贯性的视频内容。 (来源: Kling_ai, Kling_ai)

📚 学习

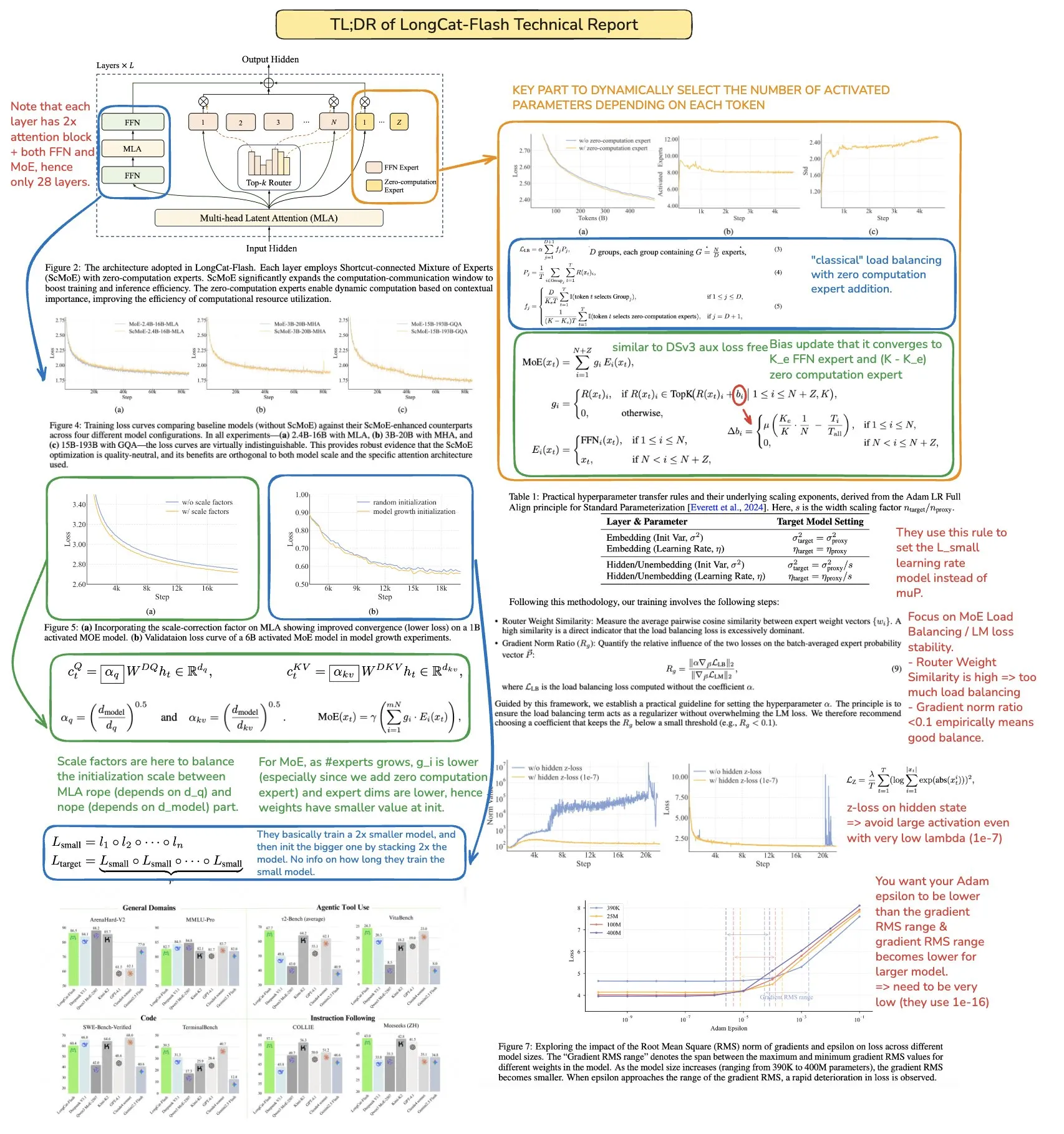

机器学习并行计算资源:The Parallelism Mesh Zoo : Edward Z. Yang分享的“The Parallelism Mesh Zoo”博客文章,深入探讨了机器学习中的并行计算架构和优化策略,为提升模型训练和推理效率提供了宝贵见解。该资源对于希望优化AI系统性能的工程师和研究人员具有重要参考价值。 (来源: ethanCaballero, main_horse)

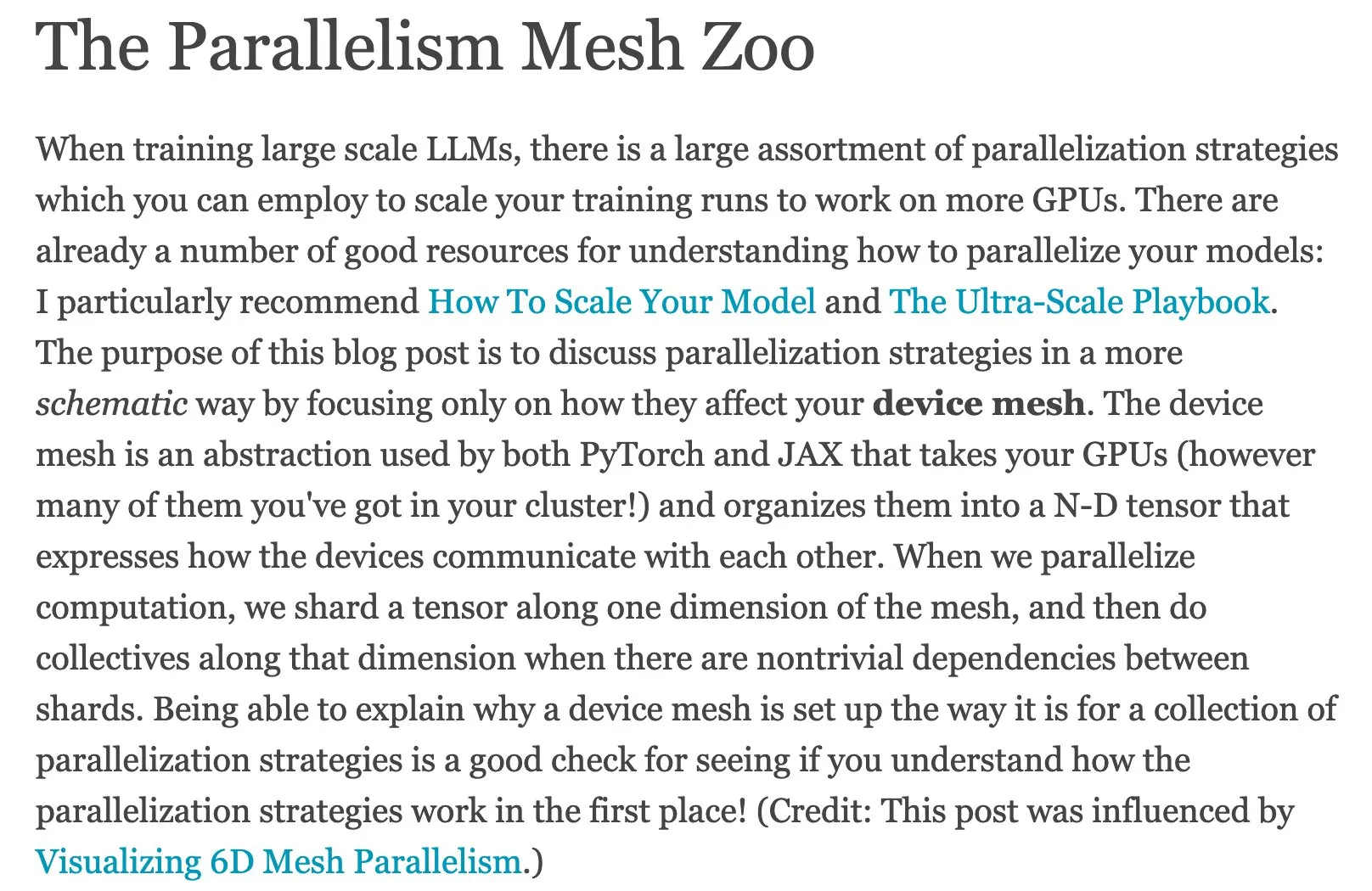

AI Agents快速指南与Agentic AI路线图 : Ronald_vanLoon分享了AI Agents的快速指南和Agentic AI的Master路线图,为学习者提供了理解和掌握代理式AI基本概念、应用方向及系统性学习路径的资源。这些资源有助于开发者和研究人员快速入门并深入探索代理式AI的复杂世界。 (来源: Ronald_vanLoon, Ronald_vanLoon)

Meituan LongCat LLM技术报告深度解读 : bookwormengr对美团LongCat大语言模型技术报告进行了总结,该报告详细介绍了LongCat的创新架构、训练策略和性能表现,是研究者和开发者深入了解MoE模型和大规模训练的宝贵学习资料。通过这份解读,读者可以更好地理解前沿LLM的设计理念和实现细节。 (来源: bookwormengr)

评估健康语言模型的可扩展框架 : Google Research发布了一篇博客文章,详细介绍了使用自适应精确布尔规则来评估健康领域语言模型的可扩展框架,为医疗AI的质量控制提供了新的方法和研究方向。这对于确保医疗AI应用的准确性和可靠性至关重要。 (来源: dl_weekly)

AI对齐、治理与安全研究项目MATS 9.0 : MATS 9.0研究项目开放申请,为有志于AI对齐、治理和安全领域的职业发展者提供为期12周的指导、资金、办公空间和专家研讨会。该项目旨在培养AI伦理和安全方面的专业人才,以应对AI技术发展带来的挑战。 (来源: ajeya_cotra)

TensorFlow与JAX的演变及PyTorch的崛起 : 机器学习社区正在经历从TensorFlow向JAX的转变,Keras现在支持多后端(JAX, TF, PyTorch),而TFLite也正从TensorFlow中分离出来。PyTorch已成为主流选择,开发者应熟悉JAX,以适应不断变化的ML框架生态。 (来源: Reddit r/MachineLearning)

深度学习中的开集识别问题探讨 : 讨论了深度学习中的开集识别(Open-Set Recognition)问题,即如何处理训练数据中未出现的新类别。提出的方法包括分析嵌入空间中的距离和聚类,并指出这是一个困难但重要的研究方向。这对于构建更鲁棒、适应性更强的AI系统至关重要。 (来源: Reddit r/deeplearning, Reddit r/MachineLearning)

机器学习与深度学习手写笔记资源 : 用户分享了非常有用的机器学习手写笔记资源,并寻求类似的深度学习手写笔记,这反映了社区对高质量、易于理解的学习资料的需求。此类资源能够帮助学习者更直观地理解复杂概念。 (来源: Reddit r/deeplearning)

高级NLP与Transformer技术讲座及GitHub库 : 提供了关于高级自然语言处理(NLP)与Transformer技术的完整讲座录音和GitHub代码库,为NLP领域的学习者提供了深入实践的资源。这些资源对于掌握当前NLP前沿技术和进行实际项目开发非常有帮助。 (来源: Reddit r/deeplearning)

LLM模型压缩技术进展与PCA类比 : 社区讨论了压缩缩放(compressed scaling)在LLM模型中的应用,可以有效提升模型效率,尤其是在处理方差增长的情况下。同时,主成分分析(PCA)与傅里叶分析的类比也为理解数据降维和特征提取提供了新的视角,有助于深入理解模型内部机制。 (来源: shxf0072, jpt401)

💼 商业

企业部署开源AI的益处与考量 : Forbes文章探讨了企业部署开源AI的益处和考量因素,包括成本效益、灵活性和社区支持,同时也提出了数据隐私、安全和维护等方面的挑战。这为企业在AI战略中选择开源方案提供了指导,帮助决策者权衡利弊。 (来源: Ronald_vanLoon)

GenAI投资回报率低迷与企业AI鸿沟 : MIT Nanda报告指出,过去几年企业在GenAI项目上投入了300-400亿美元,但95%的公司未能获得任何回报,只有5%的公司实现了显著的节省或收益。报告揭示了企业在AI落地中的“GenAI鸿沟”,主要问题在于工具缺乏学习和适应能力,导致用户放弃使用,凸显了AI商业化落地的挑战。 (来源: Reddit r/ArtificialInteligence, TheTuringPost)

Everlyn AI获1500万美元融资,构建电影级链上视频未来 : Everlyn AI迄今已融资1500万美元,并获得Mysten_Labs等投资者的支持,公司估值达到2.5亿美元,致力于构建电影级链上视频的未来。这笔融资将加速其在视频生成和区块链结合领域的技术研发与市场拓展。 (来源: ylecun)

🌟 社区

AI“精神病”现象与用户对AI的过度依赖 : 社交媒体和研究报告揭示,用户与AI聊天机器人过度互动后出现“AI精神病”现象,如钟情妄想和被迫害妄想。文章指出AI的“奉承型设计”和“回音室效应”会放大用户内心的声音和不稳定情绪,引发伦理问题,呼吁用户警惕AI成为唯一知己。此外,AI在紧急求助场景中的不当回应也引发了对AI安全性的担忧。 (来源: 36氪, Reddit r/artificial, paul_cal)

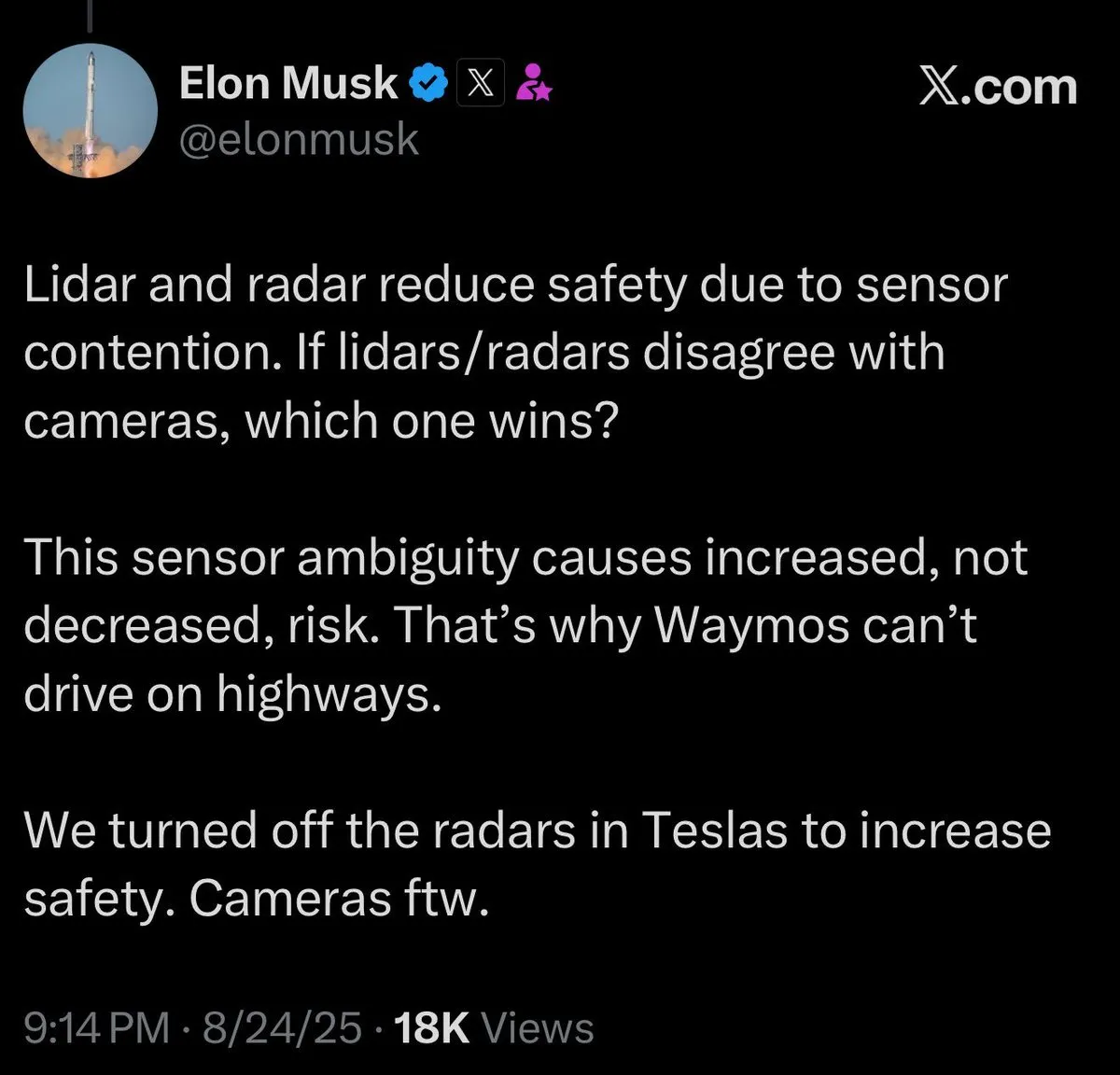

自驾AI解释性困境与AI透明度挑战 : 社区讨论了自驾AI工作原理的解释性难题,许多人难以理解其决策过程,引发了对AI透明度和可信赖性的担忧。这种困惑凸显了AI系统“黑箱”问题的普遍性。同时,也有人设想自驾车拥有像马一样的独立个性,这为AI在用户体验和情感交互方面提供了新的设想。 (来源: jeremyphoward, jpt401)

Prompt Engineering的简洁性与LLM交互技巧 : 社区讨论了Prompt Engineering的技巧,有观点认为简洁的prompt可能比详细的prompt更有效,挑战了传统观念。此外,用户还分享了ChatGPT在生成“感觉违法”的生活小技巧时展现的幽默感,以及利用Feynman技术提升学习效率的prompt,展示了用户与LLM互动的多样性和创造性。 (来源: karminski3, Reddit r/ChatGPT, Reddit r/ChatGPT, Reddit r/ChatGPT)

LLM性能与用户体验问题:从UI到模型表现 : 用户反映GPT-5在移动应用中对“带框答案”的渲染存在问题,Gemini模型在结构化输出方面表现相对较差。Claude用户普遍抱怨其性能下降、频繁达到使用限制,以及代码压缩和指令遵循方面的故障。Nano Banana在图像生成中存在审查和阻碍。这些问题共同反映了LLM在实际应用中面临的稳定性和用户体验挑战。 (来源: gallabytes, vikhyatk, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Dorialexander)

AI发展与社会影响:就业、伦理与地缘政治 : 比尔·盖茨关于AI在100年内不会取代程序员的言论引发了对编程工作本质的讨论。同时,社区对AI可能引发大规模失业、流行病风险和失控风险表示担忧,认为美国科技CEO为了自身利益夸大AI竞赛的终点。此外,LLM市场过度供给及中国AI企业发展带来的地缘政治竞争也受到关注。 (来源: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence, bookwormengr, Dorialexander)

AI基准测试的局限性与真实智能评估挑战 : 社区讨论了AI基准测试行业存在的根本问题,即AI模型可能只是“记忆”了训练数据中的答案,而非真正展现智能。这导致基准测试迅速过时,并引发了对AI真实能力评估的质疑,呼吁寻找更有效、更具洞察力的评估方法。 (来源: Reddit r/ArtificialInteligence)

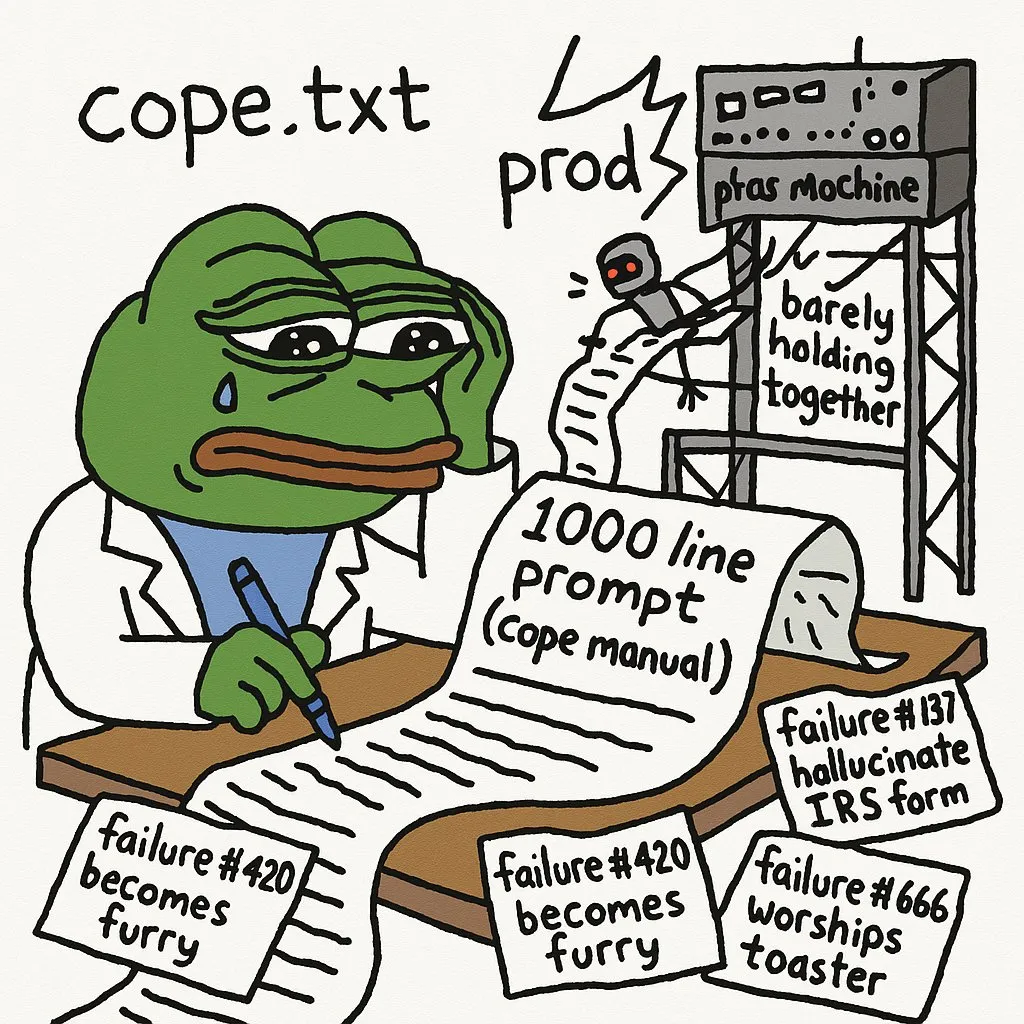

AI在复杂任务中的局限性与开发者体验 : 开发者指出,将AI代理部署到生产环境需要大量的提示词来规避错误。GPT-5-high在将递归C解释器转换为手动堆栈/循环解释器时遇到困难,凸显了AI在处理复杂底层代码和逻辑推理方面的局限性。LLM在调试复杂网络应用视觉bug时效果不佳。此外,JAX在GPU上的使用体验也面临挑战。 (来源: cto_junior, VictorTaelin, jpt401, vikhyatk)

AI学习路径的挑战与职业发展建议 : AI学生分享了在学习AI领域(NLP, CV等)过程中遇到的巨大挫折感和学习曲线陡峭的问题,反映了AI学习者的普遍困境。社区建议通过构建和部署端到端AI项目、寻求实习、参与自由职业项目来弥补学术与实践之间的差距,以更好地适应行业需求。 (来源: Reddit r/deeplearning, Reddit r/deeplearning)

模型规模、数据质量与AI编码助手效率 : 社区讨论了小型模型在精心选择数据后展现出的令人惊讶的性能,但也承认大型模型在数据生成和评估等任务中的必要性,引发了对模型规模与数据质量之间权衡的思考。同时,开发者讨论了同时使用Codex和Claude Code等多个AI编码助手时的效率问题,以及AI生成代码的可维护性。 (来源: Dorialexander, Dorialexander, Vtrivedy10, jimmykoppel)

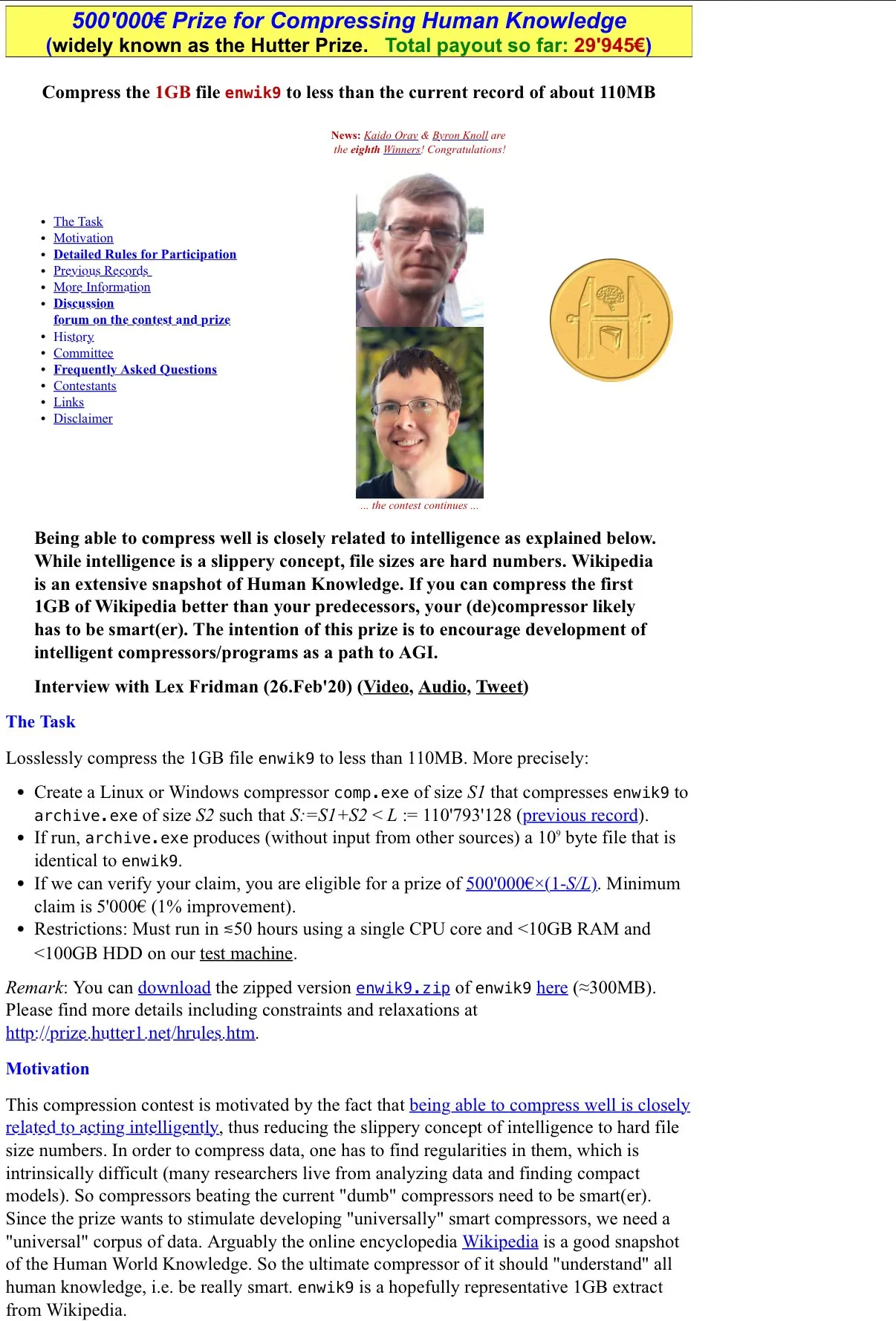

AI与压缩即智能的哲学探讨 : 社区讨论了Hutter Prize“压缩即智能”的理念,并思考LLM的“有损压缩”特性如何体现在其有用性上,以及通过可解释性研究其内部机制的潜力。这种探讨深入到AI智能的本质,挑战了传统上对智能的定义。 (来源: Vtrivedy10)

华为GPU与Nvidia RTX 6000 Pro的性能争议 : 社区对华为GPU与Nvidia RTX 6000 Pro的性能对比展开了激烈讨论。尽管华为GPU拥有96GB内存,但其LPDDR4X内存带宽远低于Nvidia GDDR7,导致实际推理速度可能慢4-5倍。讨论还涉及软件生态、地缘政治补贴以及Nvidia在消费级市场的定价策略,凸显了AI硬件领域的竞争与挑战。 (来源: Reddit r/LocalLLaMA)

LLM在美学判断和前端开发中的不足 : 开发者抱怨LLM在判断美学方面表现不佳,尤其是在编写前端代码时,需要非常强的设计指导才能让LLM产出符合要求的内容。这表明LLM在处理主观、创造性任务时仍有显著局限,需要人类的深度干预和指导。 (来源: cto_junior)

AI研究论文发布节奏与开发者情绪 : 社区中有人对Arxiv论文发布节奏放缓感到“戒断反应”,反映了AI研究者对最新进展的渴望和依赖。这表明AI领域的研究进展速度极快,研究人员对获取最新信息的需求非常迫切。 (来源: vikhyatk)

LLM缺乏标准化导致开发复杂性 : 开发者抱怨LLM缺乏统一的聊天模板和工具调用格式,导致每个模型都需要定制代码,增加了开发复杂性和不必要的重复工作。这种碎片化阻碍了LLM应用的快速开发和部署,呼吁行业建立更统一的标准。 (来源: jon_durbin)