关键词:DeepSeek, OpenAI, 推理模型, 多模态大模型, 强化学习, AI创新, 开源模型, DeepSeek R1推理模型, OpenAI o4强化学习训练, 多模态大模型人类思维地图, Mistral AI Magistral系列, 小红书dots.llm1 MoE模型

🔥 聚焦

DeepSeek与OpenAI的创新路径揭示“认知型创新”: DeepSeek通过“有限Scaling Law”、MLA与MoE架构创新及软硬协同优化,实现了低成本高性能,其R1推理模型的开源推动了AI认知能力的突破,打破了中国创新者在基础研究领域的“思想钢印”,证明了中国企业在AI基础研究和模型创新方面的全球领先实力。OpenAI则凭借Transformer架构和Scaling Law(尺度定律)的极致运用,引领了大语言模型革命,并通过ChatGPT和推理模型o1推动了人机交互范式变革和AI认知能力的跃迁。两者的发展路径均强调了对技术本质的深刻理解与战略性重构,为AI时代的创业者提供了宝贵的组织构建和创新思路,特别是DeepSeek鼓励“涌现”的AI Lab范式,为技术创新驱动的创业者提供了新的组织模式参考 (来源: 36氪)

OpenAI被曝训练新模型o4,强化学习重塑AI格局: SemiAnalysis爆料OpenAI正在训练一个介于GPT-4.1和GPT-4.5之间的新模型,下一代推理模型o4将基于GPT-4.1进行强化学习(RL)训练。RL通过生成CoT解锁模型推理能力,并推动AI智能体发展,但其对基础设施(尤其推理)和奖励函数设计要求极高,易出现“奖励黑客”现象。高质量数据是扩展RL的关键,用户行为数据将成重要资产。RL还改变了实验室组织结构,使推理与训练深度融合。与预训练不同,RL可持续更新模型能力,如DeepSeek R1。对于小模型,蒸馏可能优于RL。此轮爆料预示着AI领域,特别是推理模型,将迎来基于RL的持续进化和能力跃升 (来源: 36氪)

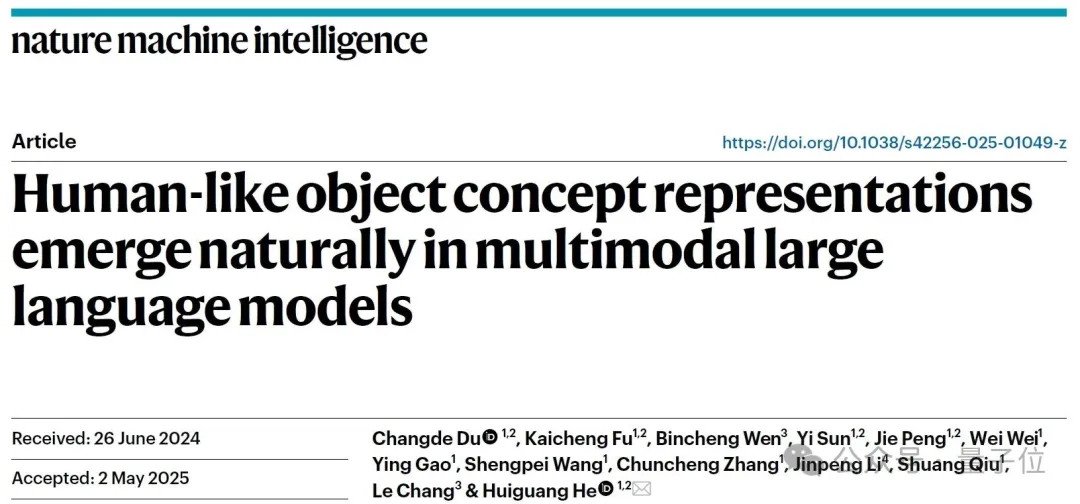

多模态大模型被发现能自发形成“人类思维地图”: 中国科学院自动化研究所与脑科学与智能技术卓越创新中心的联合团队通过行为实验与神经影像分析,证实多模态大语言模型(MLLMs)能够自发形成与人类高度相似的物体概念表征系统。研究通过分析470万次“三选一异类识别任务”的行为判断数据,首次构建了AI模型的“概念地图”。核心发现包括:不同架构的AI模型可能收敛到相似的低维认知结构;模型在无监督情况下涌现出高级物体概念分类能力,与人类认知一致;AI模型的“思考维度”可被赋予语义标签,如动物、食物、硬度等;MLLM的表征与大脑特定区域(如FFA、PPA)的神经活动模式显著相关,为“AI与人类共享概念处理机制”提供了证据。该研究为理解AI认知、发展类脑智能及脑机接口提供了新思路 (来源: 量子位)

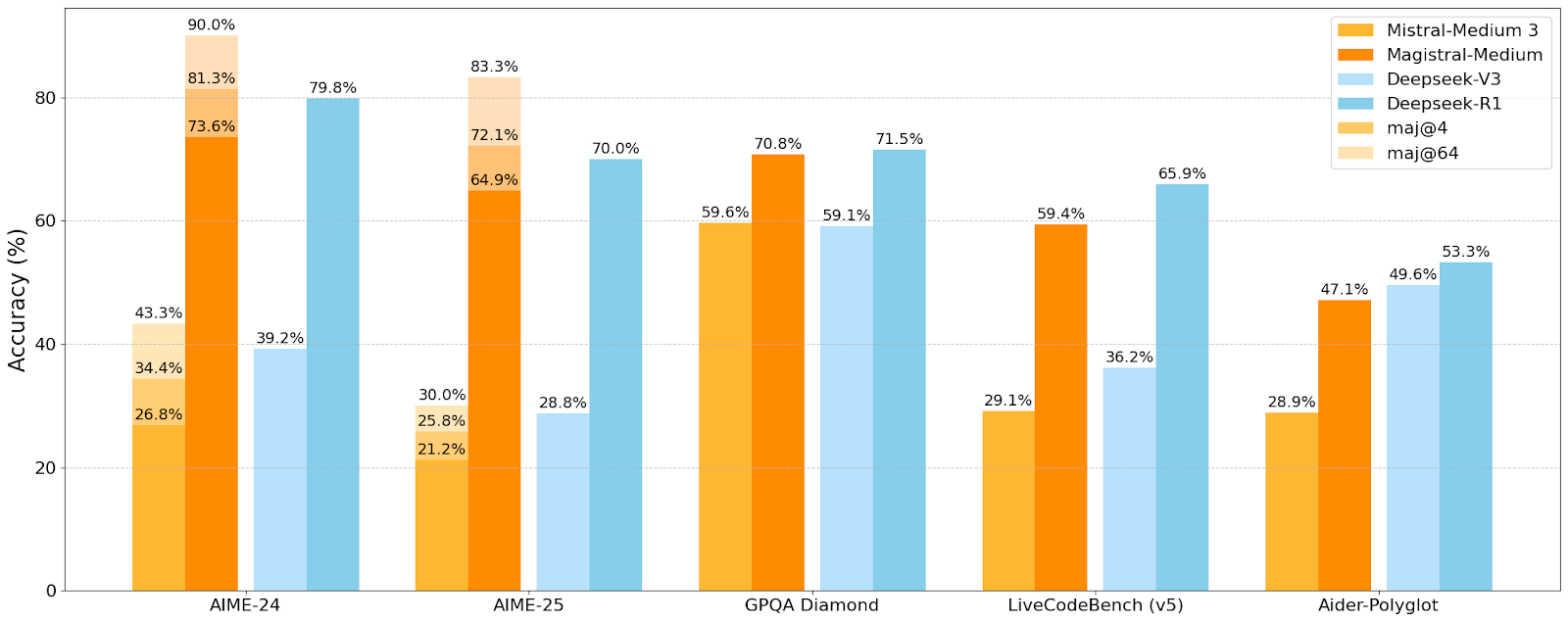

Mistral AI发布首个推理模型Magistral系列,小模型Magistral-Small已开源: Mistral AI推出了其首批专为推理设计的模型系列Magistral,包括Magistral-Small和Magistral-Medium。Magistral-Small基于Mistral Small 3.1(2503)构建,是一个24B参数的高效推理模型,通过Magistral Medium的轨迹进行SFT和RL训练,增强了推理能力。该模型支持多语言,上下文窗口为128k(推荐有效上下文40k),采用Apache 2.0许可证开源,可在单个RTX 4090或32GB RAM的MacBook上本地部署(量化后)。基准测试显示,Magistral-Small在AIME24、AIME25、GPQA Diamond和Livecodebench (v5)等任务上表现出色,接近甚至优于一些更大模型。Magistral-Medium性能更强,但目前未开源。此次发布标志着Mistral在提升模型推理能力和多语言支持方面的进展 (来源: Reddit r/LocalLLaMA, Mistral AI, X)

🎯 动向

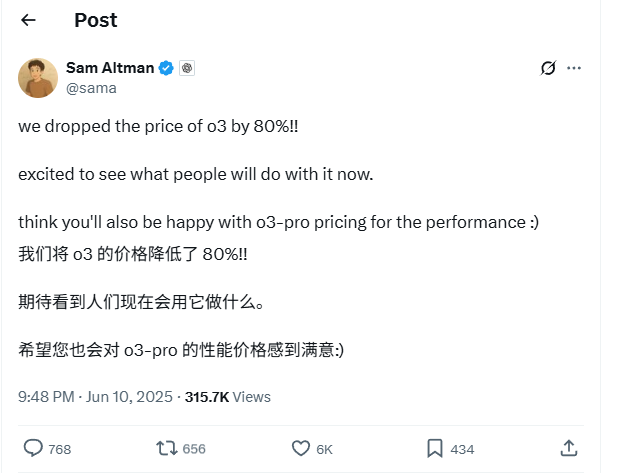

OpenAI o3模型API价格大幅下调80%: OpenAI CEO Sam Altman宣布,其o3模型的API价格降低了80%。调整后,输入价格为2美元/百万token,输出价格为8美元/百万token(部分信息源提及输出5美元/百万token,需以官方文档为准)。此次降价幅度巨大,使得使用o3模型进行代码编写等任务的成本显著降低,预计将推动更广泛的应用和创新。用户需注意官网价格列表可能尚未同步更新,建议在API调用前进行测试以确认实际生效价格,避免不必要的损失。此举被认为是应对市场竞争(如Gemini 2.5 Pro和Claude 4 Sonnet)的策略,可能预示着AI智能的成本将持续下降 (来源: X, X, X)

苹果WWDC 2025被指AI着墨不多,但技术细节显露野心: 苹果在全球开发者大会(WWDC)2025上对AI的着墨似乎不如预期,但其技术文档揭示了其在设备端和云端模型方面的深度投入。苹果正采用先进的训练、蒸馏和量化技术,包括为移动端模型(约3B大小)设计的“双块架构”(旨在降低内存占用)和服务器端模型使用的“PT-MoE”(并行轨道专家混合)架构。这些技术旨在优化Apple芯片上的低延迟推理,并减少KV缓存内存使用。尽管外界有声音认为苹果在AI领域落后,但其在模型技术上的成就(如开源嵌入模型)和对不同优先级的关注(如设备端智能而非仅聊天机器人)表明其有独特的AI战略。WWDC还宣布Safari 26将支持WebGPU,这将极大提升设备端运行AI模型(如通过Transformers.js)的性能,例如浏览器内视觉模型字幕生成速度提升约12倍 (来源: X, X, X)

Perplexity Pro用户现可使用OpenAI o3模型: Perplexity宣布其Pro订阅用户现在可以使用OpenAI的o3模型。这一集成将为Perplexity Pro用户带来更强大的信息处理和问答能力。同时,Perplexity也在测试其“Memory”功能,并更新了iOS语音助手,旨在提供更简洁实用的用户体验。其Discover文章功能也默认为更简洁的“Summary”模式,并提供切换至深度“Report”模式的选项 (来源: X, X, X)

小红书开源首个142B MoE大模型dots.llm1,中文评测超DeepSeek-V3: 小红书开源了其首个大模型dots.llm1,这是一个1420亿参数的MoE(混合专家)模型,推理时仅激活140亿参数。该模型在预训练阶段使用了11.2万亿非合成tokens,主要来自通用爬虫和自有爬虫的Web数据。小红书团队提出了可扩展的三阶段数据处理框架,并开源以增强可复现性。dots.llm1在C-Eval上取得92.2分,超越包括DeepSeek-V3在内的所有模型,并在中英文、数学、对齐等任务上接近阿里Qwen3-32B的性能。小红书还开源了中间训练检查点,以促进社区对大模型动力学的理解 (来源: 36氪)

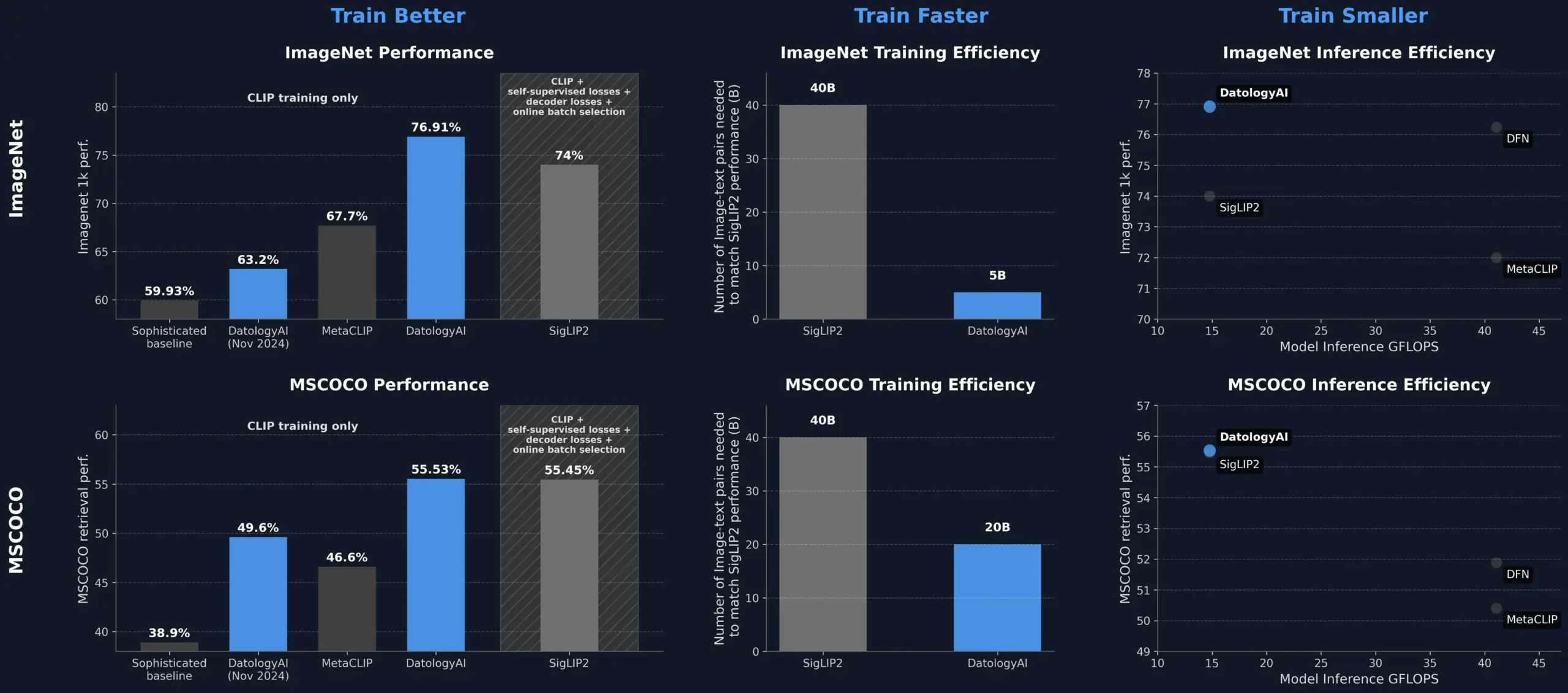

DatologyAI通过数据管理提升CLIP模型性能,超越SigLIP2: DatologyAI展示了仅通过数据管理(data curation)就能显著提升CLIP模型性能的成果。他们的方法使得ViT-B/32模型在ImageNet 1k上的准确率达到76.9%,超过了SigLIP2报告的74%。此外,该方法还带来了8倍的训练效率提升和2倍的推理效率提升,并已公开发布了相关模型。这突显了高质量、精心管理的数据集在训练先进AI模型中的核心作用,即使不改变模型架构,也能通过优化数据来挖掘模型潜力 (来源: X, X)

快手与东北大学联合提出统一多模态嵌入框架UNITE: 为解决多模态检索中不同模态(文本、图像、视频)数据分布差异导致的跨模态干扰问题,快手与东北大学研究人员提出了多模态统一嵌入框架UNITE。该框架通过“模态感知掩码对比学习”(MAMCL)机制,在对比学习中只考虑与查询目标模态一致的负样本,避免模态间错误竞争。UNITE采用“检索适应+指令微调”两阶段训练,并在图像-文本检索、视频-文本检索及指令检索等多个评测中取得SOTA成绩,如在MMEB Benchmark中超越更大规模模型,在CoVR上大幅领先。研究强调视频-文本数据在统一模态中的核心能力,并指出指令任务更依赖文本主导的数据 (来源: 量子位)

NVIDIA发布Earth-2气候模拟AI基础模型: NVIDIA的Earth-2平台推出了一款新的AI基础模型,能够以公里级分辨率模拟全球气候。该模型旨在提供更快、更准确的气候预测,为理解和预测地球复杂自然系统提供了新途径。此举标志着AI在气候科学和地球系统建模领域的应用迈出了重要一步,有望提升气候变化研究和灾害预警能力 (来源: X)

OpenAI服务出现大范围故障,ChatGPT及API受影响: OpenAI的ChatGPT服务和API接口在北京时间6月10日晚间出现大范围故障,表现为错误率和延迟升高。许多用户报告无法访问服务或遇到“Hmm…something seems to have gone wrong”等错误提示。OpenAI官方状态页确认了该问题,并表示工程师已定位根本原因并正在紧急修复。此次故障影响了全球大量依赖ChatGPT和其API的用户及应用,再次凸显了大型AI服务稳定性的重要性 (来源: X, Reddit r/ChatGPT, Reddit r/ChatGPT)

🧰 工具

Model Context Protocol (MCP) 服务器生态系统持续扩展: Model Context Protocol (MCP) 旨在为大型语言模型(LLM)提供安全、可控的工具和数据源访问。GitHub上的modelcontextprotocol/servers仓库汇集了MCP的参考实现和社区构建的服务器,展示了其多样化应用。官方及第三方服务器覆盖了文件系统、Git操作、数据库交互(如PostgreSQL, MySQL, MongoDB, Redis, ClickHouse, Cassandra等)、云服务(AWS, Azure, Cloudflare)、API集成(GitHub, GitLab, Slack, Google Drive, Stripe, PayPal)、搜索(Brave, Algolia, Exa, Tavily)、代码执行、AI模型调用(Replicate, ElevenLabs)等广泛领域。MCP的生态发展迅速,已有超过130个官方及社区服务器,并涌现出EasyMCP、FastMCP、MCP-Framework等开发框架和MCP-CLI、MCPM等管理工具,旨在降低LLM接入外部工具和数据的门槛,推动AI Agent的发展 (来源: GitHub Trending)

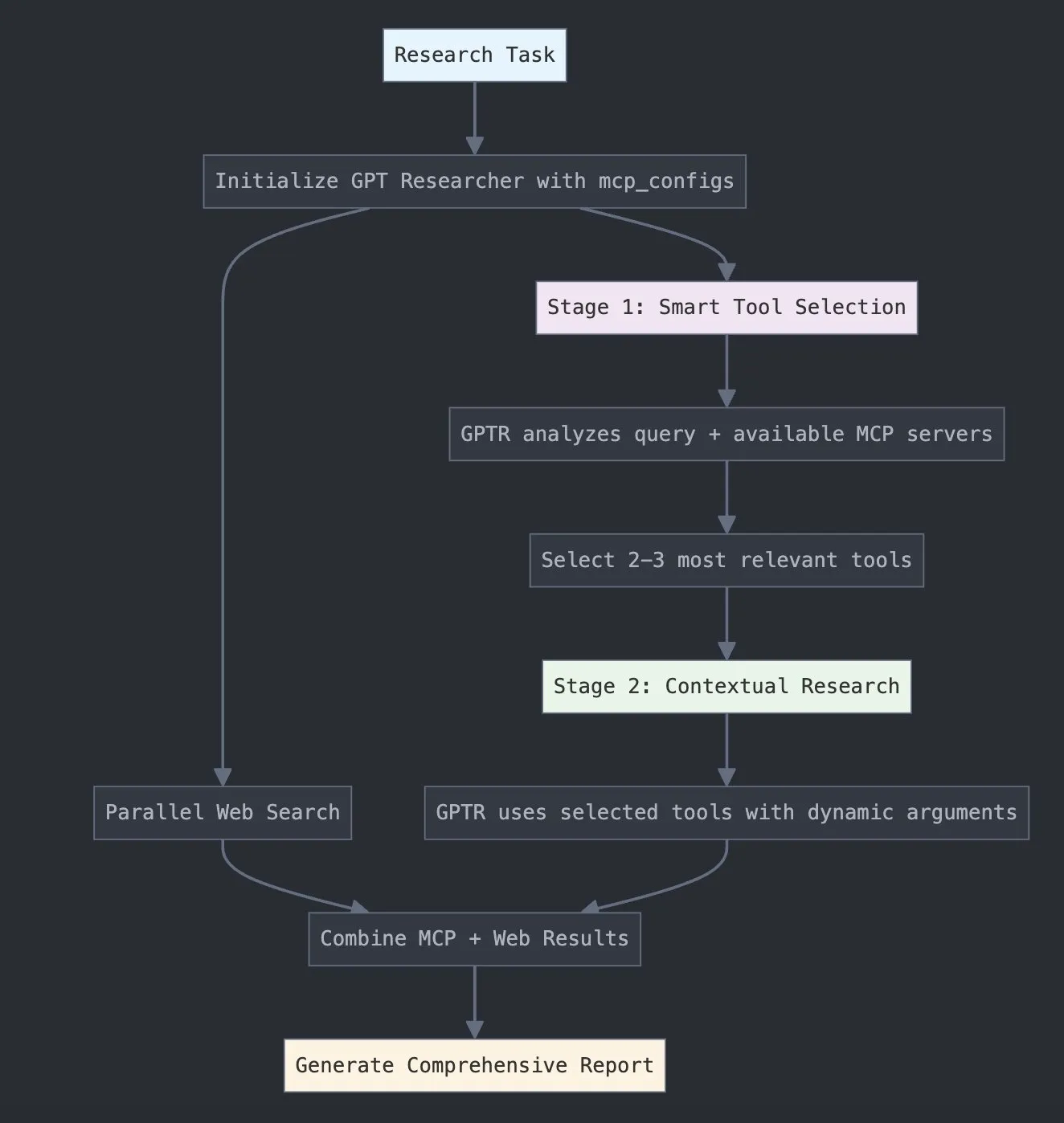

LangChain推出GPT Researcher MCP,增强研究能力: LangChain宣布GPT Researcher现已利用其模型上下文协议(MCP)适配器,以实现智能工具选择和研究。这一集成将MCP与网络搜索功能相结合,旨在为用户提供更全面的数据收集和分析能力,进一步提升AI在研究领域的应用深度和广度 (来源: X)

Hugging Face发布Vui:100M开源NotebookLM,实现类人TTS: Hugging Face上发布了Vui,一个1亿参数的开源NotebookLM项目,包含三个模型:Vui.BASE(基于40k小时音频对话训练的基础模型)、Vui.ABRAHAM(具备上下文感知能力的单说话人模型)和Vui.COHOST(可进行双人对话的模型)。Vui能够克隆声音、模仿呼吸、嗯啊等口头禅甚至非语音声音,标志着类人文本转语音(TTS)技术取得了新进展 (来源: X, X)

Consilium:开源多智能体协作平台,解决复杂问题: Hugging Face上展示了Consilium项目,这是一个开源的多智能体协作平台。用户可以组建一个专家AI智能体团队,通过辩论和实时研究(网页、arXiv、SEC文件)来共同解决复杂问题并达成共识。用户设定策略,智能体团队负责寻找答案,展示了AI在协作式问题解决方面的新探索 (来源: X)

Unsloth发布Magistral-Small-2506优化版GGUF模型: 继Mistral AI发布Magistral-Small-2506推理模型后,Unsloth迅速推出了其优化版的GGUF格式模型,适用于llama.cpp、LMStudio和Ollama等平台。这一快速响应体现了开源社区在模型优化和部署方面的活力和效率,使得新模型能更快地被更广泛的用户和开发者所用 (来源: X)

📚 学习

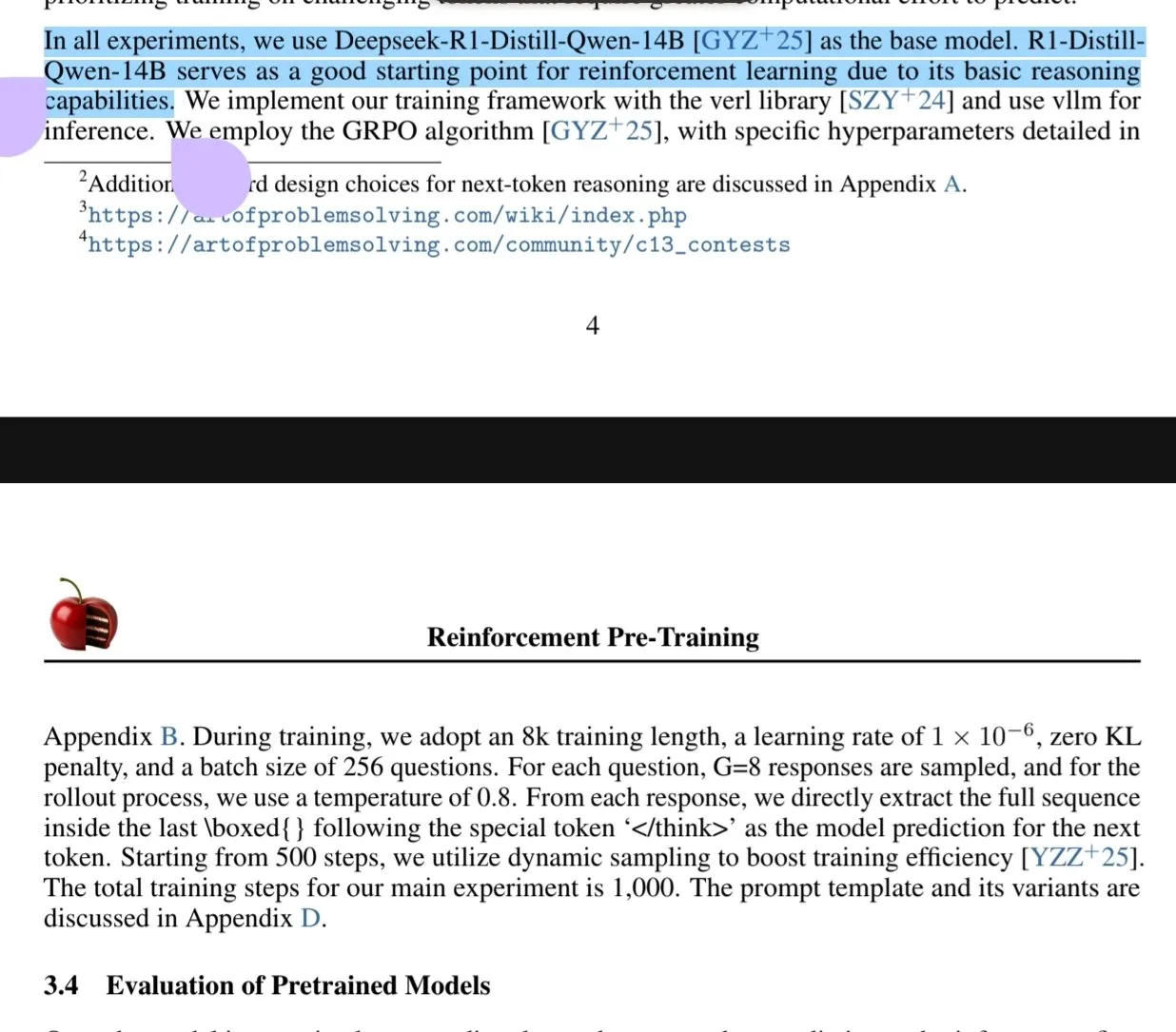

新论文探讨强化学习预训练(RPT)范式: 一篇新论文《Reinforcement Pre-Training (RPT)》提出将下一代词元预测重构为使用RLVR(Reinforcement Learning with Verifiable Rewards)进行推理的任务。RPT旨在通过激励下一词元推理能力来改进语言模型预测准确性,并为后续强化微调提供强大基础。研究显示,增加训练计算量能持续提升预测精度,表明RPT是推进语言模型预训练的有效且有前景的扩展范式 (来源: HuggingFace Daily Papers, X)

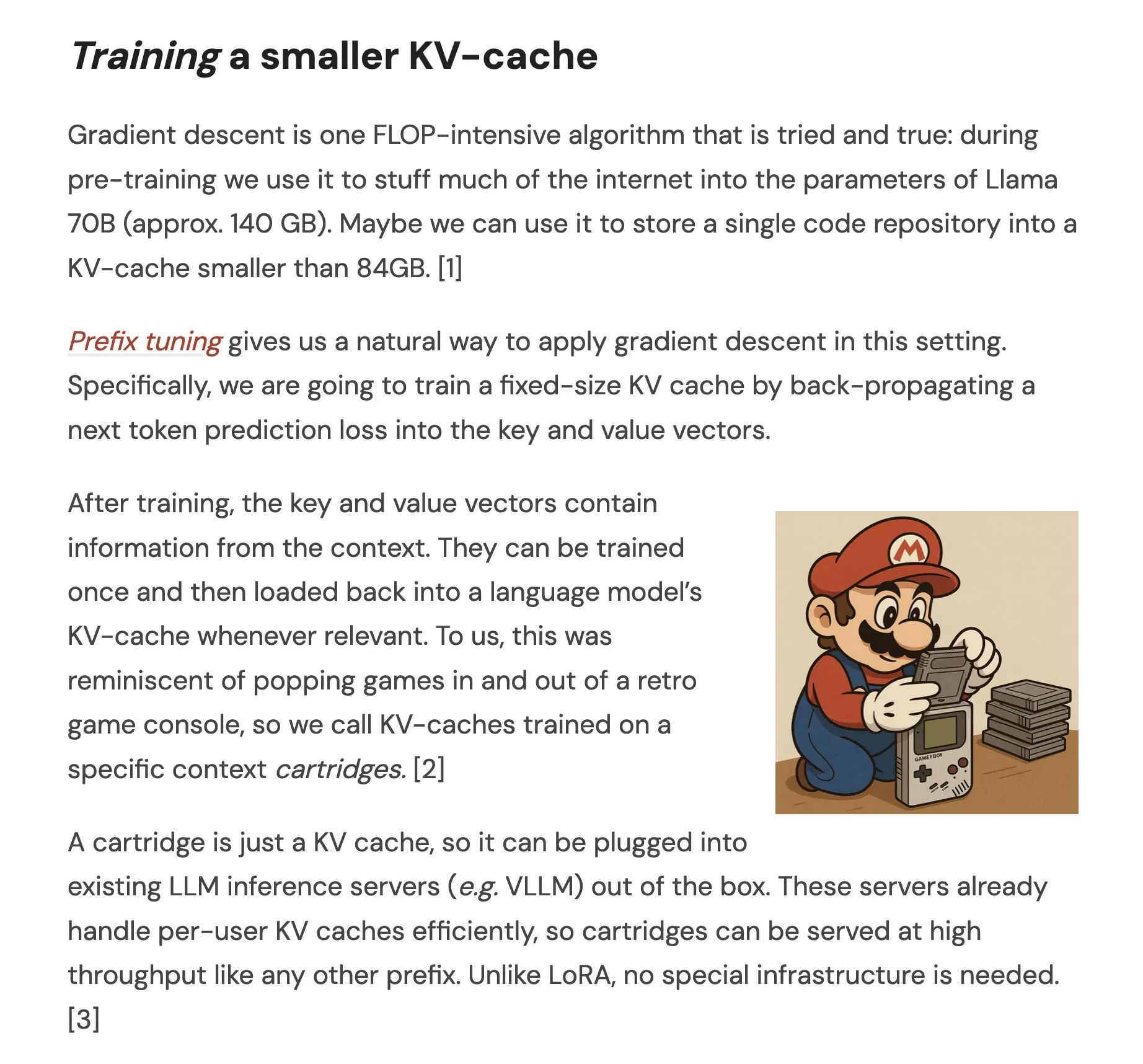

论文提出Cartridges:通过自学习实现轻量级长上下文表示: 一篇名为《Cartridges: Lightweight and general-purpose long context representations via self-study》的论文,探讨了一种通过离线训练小型KV缓存(称为Cartridge)来处理长文本的方法,以替代在推理时将整个语料库放入上下文窗口。研究发现,通过“自学习”(生成关于语料库的合成对话并以上下文蒸馏目标进行训练)训练的Cartridge,能以显著更低的内存消耗(减少38.6倍)和更高的吞吐量(提升26.4倍)达到与ICL相当的性能,并能扩展模型的有效上下文长度,甚至支持跨语料库组合使用而无需重新训练 (来源: HuggingFace Daily Papers, X)

论文探讨LLM在几何问题求解中的群对比策略优化(GCPO): 论文《GeometryZero: Improving Geometry Solving for LLM with Group Contrastive Policy Optimization》针对LLM在几何问题求解中辅助线构造的挑战,提出了GCPO框架。该框架通过“群对比掩码”根据上下文效用为辅助线构造提供正负奖励信号,并引入长度奖励促进更长的推理链。基于GCPO开发的GeometryZero模型系列,在Geometry3K和MathVista等基准测试中表现优于基线模型,平均提升4.29%,展示了在有限算力下提升小模型几何推理能力的潜力 (来源: HuggingFace Daily Papers)

论文《The Illusion of Thinking》通过问题复杂度探究推理模型能力与局限: 该研究系统地考察了大型推理模型(LRMs)的能力、扩展特性和局限性。通过使用可精确控制复杂度的谜题环境,研究发现LRMs在超过特定复杂度后准确率会完全崩溃,并表现出反直觉的扩展限制:推理努力随问题复杂度增加到一定程度后反而下降。与标准LLM相比,LRMs在低复杂度任务中表现较差,中复杂度任务中占优,高复杂度任务中两者均失效。研究指出LRMs在精确计算方面存在局限,难以运用显式算法,且在不同规模上推理不一致 (来源: HuggingFace Daily Papers, X)

论文研究LLM在小资源语言中的稳健性评估: 论文《Evaluating LLMs Robustness in Less Resourced Languages with Proxy Models》探讨了大型语言模型(LLMs)在波兰语等低资源语言中对扰动(如字符级和词级攻击)的敏感性。研究发现,通过少量字符修改并使用小型代理模型计算词重要性,可以创建出能显著改变不同LLM预测的攻击,这揭示了LLM在这些语言中可能存在的安全漏洞,可能被用于规避其内部安全机制。研究者发布了相关数据集和代码 (来源: HuggingFace Daily Papers)

Rel-LLM:提升LLM处理关系数据库效率的新方法: 一篇论文提出Rel-LLM框架,旨在解决大型语言模型(LLM)在处理关系数据库时效率低下的问题。传统方法将结构化数据转换为文本会导致关键链接丢失和输入冗余。Rel-LLM通过图神经网络(GNN)编码器创建结构化图提示,在检索增强生成(RAG)框架内保留关系结构。该方法包括时序感知子图采样、异构GNN编码器、MLP投影层对齐图嵌入与LLM潜空间、以及将图表示结构化为JSON图提示等步骤,并通过自监督预训练目标对齐图与文本表示。实验表明,GNN编码能有效捕捉文本序列化中丢失的复杂关系结构,结构化图提示能有效将关系上下文注入LLM注意力机制 (来源: X)

论文探讨LLM的“过拒绝”问题及EvoRefuse优化方法: 论文《EVOREFUSE: Evolutionary Prompt Optimization for Evaluation and Mitigation of LLM Over-Refusal to Pseudo-Malicious Instructions》研究了大型语言模型(LLM)对“伪恶意指令”(语义无害但触发模型拒绝的输入)的过度拒绝问题。为解决现有指令管理方法在可扩展性和多样性上的不足,论文提出EVOREFUSE,一种利用进化算法优化提示的方法,能生成多样化的、持续引发LLM拒绝的伪恶意指令。基于此,研究者创建了EVOREFUSE-TEST(包含582条指令的基准测试)和EVOREFUSE-ALIGN(包含3000条指令及响应的对齐训练数据集)。实验表明,在EVOREFUSE-ALIGN上微调的LLAMA3.1-8B-INSTRUCT模型,其过度拒绝率比在次优对齐数据集上训练的模型降低了高达14.31%,且不损害安全性 (来源: HuggingFace Daily Papers)

💼 商业

中科闻歌完成新一轮战略融资,北京市石景山区产业基金投资: 企业级AI服务商中科闻歌宣布完成新一轮战略融资,投资方为北京市石景山区现代创新产业发展基金有限公司。本轮融资将主要用于自研决策智能操作系统DIOS的研发投入和市场推广,加速企业级人工智能技术发展和商业落地。中科闻歌成立于2017年,核心团队源自中国科学院自动化所,专注于多语言理解、跨模态语义和复杂场景决策技术,服务于媒体、金融、政务、能源等行业。此前已获国开金融、中网投、深创投等国资背景基金超十亿元投资 (来源: 量子位)

Sakana AI与日本北国银行达成战略合作,推动区域金融AI发展: 日本AI初创公司Sakana AI宣布与总部位于石川县的北国金融控股公司(Hokkoku Financial Holdings)签署谅解备忘录(MOU),双方将就区域金融与AI的结合展开战略合作。这是继与三菱UFJ银行建立全面合作伙伴关系后,Sakana AI再次与金融机构联手,旨在将尖端AI技术应用于解决日本区域社会面临的课题,特别是在金融服务领域。Sakana AI致力于开发针对金融机构的高度专业化AI技术,此次合作有望为日本其他区域性银行树立AI应用的典范 (来源: X, X)

Cohere与Ensemble合作,将其AI平台引入医疗保健行业: AI公司Cohere宣布与EnsembleHP(医疗保健解决方案提供商)建立合作伙伴关系,将其Cohere North AI智能体平台引入医疗保健行业。双方旨在通过安全的AI智能体平台,减少医疗管理流程中的摩擦,提升医院和卫生系统的患者体验。此举标志着Cohere在推动其大型语言模型和AI技术在关键垂直行业应用方面迈出了重要一步 (来源: X)

🌟 社区

Ilya Sutskever在多伦多大学荣誉学位演讲:AI终将无所不能,需积极关注: OpenAI联合创始人Ilya Sutskever在获得多伦多大学荣誉理学博士学位(其在该校的第四个学位)的演讲中表示,AI的进步将使其“总有一天能完成我们能做的所有事情”,因为人类大脑是生物计算机,AI则是数字大脑。他认为,我们正处在AI定义的非凡时代,AI已深刻改变学生和工作的意义。他强调,与其担忧,不如通过使用和观察顶尖AI来形成直觉,理解其能力边界。他呼吁人们关注AI发展,并积极应对随之而来的巨大挑战和机遇,因为AI将深刻影响每个人的生活。他还分享了个人心态:“接受现实,不悔过去,努力改善现状。” (来源: X, 36氪)

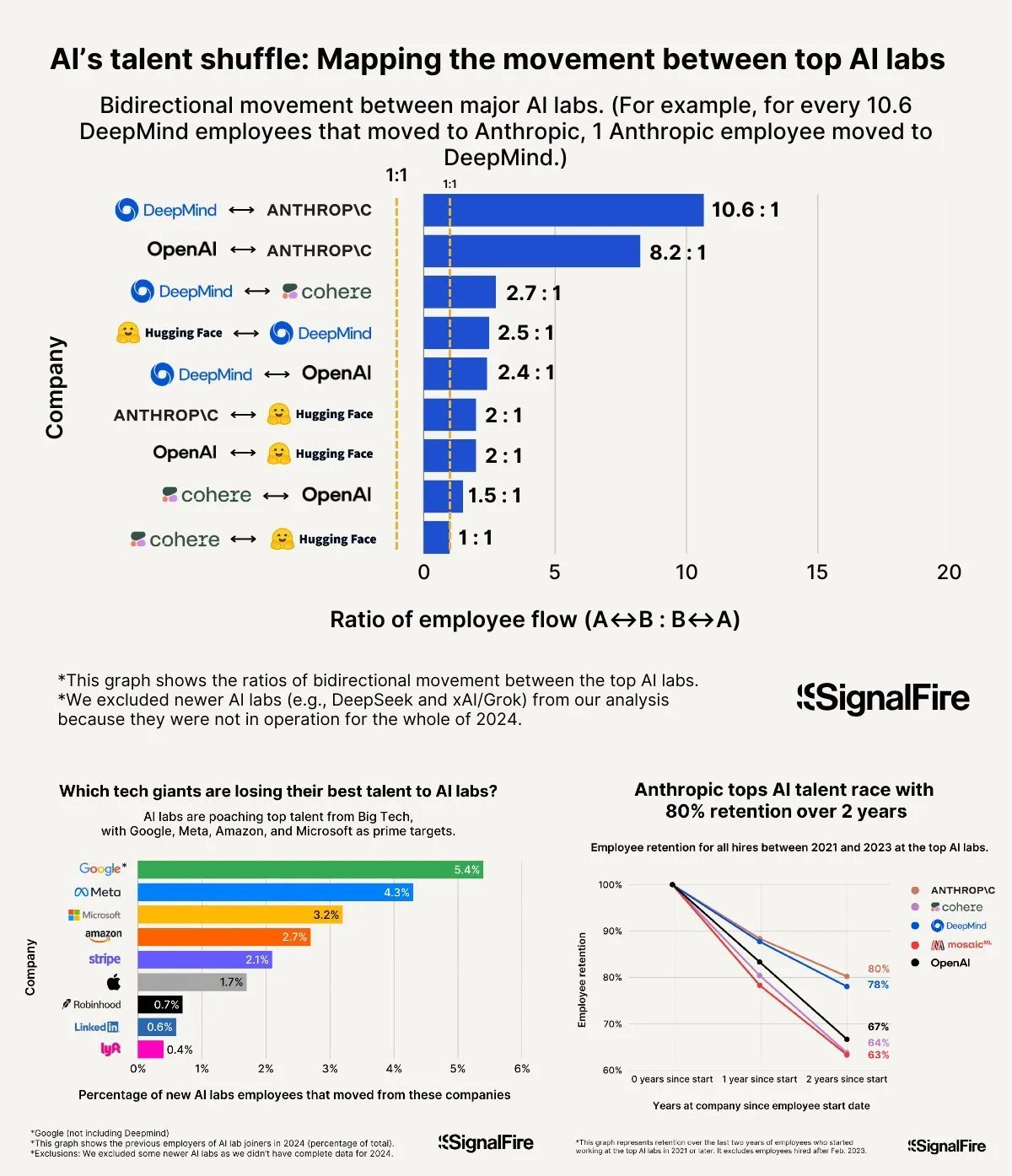

AI人才争夺战白热化:Meta高薪仍难敌OpenAI与Anthropic: Meta据称开出年薪超200万美元的高价招揽AI人才,但仍面临人才流向OpenAI和Anthropic的困境。有讨论指出,OpenAI L6级别薪资接近150万美元,且股票增值潜力被认为优于Meta,使其在顶尖人才眼中更具吸引力。此外,Llama团队被指存在作弊行为以及Meta内部KPI压力大、末位淘汰率高(今年达15-20%)等因素也影响了人才选择。Anthropic则以高达约80%的人才留存率(成立两年后)成为顶尖AI研究人员的首选大公司之一。这场人才战的激烈程度被形容为“匪夷所思” (来源: X, X)

“Vibe Coding”经验分享:AI辅助编程的5条避坑法则: 社交媒体上,有经验的开发者分享了使用AI(如Claude)进行“Vibe Coding”(一种依赖AI辅助的编程方式)时避免陷入低效调试循环的五条规则:1. 三振出局:若AI三次未能修复问题,应停止并让AI从新描述的需求从头构建。2. 重置上下文:AI在长对话后会“遗忘”,建议每8-10轮消息后保存有效代码,新开会话并仅粘贴问题组件及简要应用描述。3. 简明扼要描述问题:用一句话清晰描述bug。4. 频繁版本控制:每个功能完成后即提交Git。5. 必要时推倒重来:若修复bug耗时过长(如超2小时),不如删除问题组件让AI重新构建。核心在于承认代码已不可逆转地损坏时,要果断放弃修补。同时强调,懂编程才能更好指导AI和调试 (来源: Reddit r/LocalLLaMA, Reddit r/ClaudeAI, Reddit r/ArtificialInteligence)

李飞飞谈创办World Labs:源于对智能本质的探索,空间智能是AI关键缺失: 在a16z播客中,李飞飞分享了创办World Labs的初衷,强调其并非跟风基础模型热潮,而是对智能本质的持续探索。她认为,语言虽是高效信息载体,但在表征三维物理世界方面存在缺陷,真正的通用智能必须建立在对物理空间和物体关系的理解之上。一次角膜损伤导致她暂时失去立体视觉的经历,让她更深刻体会到三维空间表征对物理交互的重要性。World Labs旨在构建能真正理解物理世界的AI模型(世界模型LWM),弥补当前AI在空间智能上的缺失。她认为,要实现此愿景,需集结产业级算力、数据和人才,并指出当前技术突破点在于让AI从单目视觉重建完整三维场景理解 (来源: 量子位)

AI辅助高考:从押题争议到志愿填报的机遇与隐忧: 高考前后,AI在教育领域的应用引发广泛讨论。一方面,“AI押题”成为热点,但因高考命题的科学性、保密性及“反押题”机制,AI精准押题可能性低,且市面部分押题卷质量堪忧。另一方面,AI在备考规划、题目讲解、考场监考及阅卷等方面展现出积极作用,如个性化学习计划、智能答疑、AI监考系统提升公平与效率。在志愿填报环节,AI工具能根据考生分数、位次快速推荐院校专业,打破信息差。然而,过度依赖AI填报也引发担忧:算法可能强化热门专业偏好,忽视个体兴趣和长远发展;将人生选择权完全交予算法,可能导致“算法绑架人生”。文章呼吁理性看待AI辅助,强调以智慧驾驭工具,以思考定义未来 (来源: 36氪)

AI Agent公司成功模式讨论:自服务 vs. 定制化服务: 社区讨论了AI Agent公司的成功模式,一方观点认为成功的AI Agent公司(尤其是服务中大型市场)多采用类似Palantir的模式,即大量现场开发工程师(FDEs)和定制化软件,而非纯粹的自服务模式。另一方则坚持自服务模式的长期价值,认为团队最终会选择内部构建重要应用。这反映了AI Agent领域在服务模式和市场策略上的不同思考路径 (来源: X)

💡 其他

Google Diffusion系统提示词曝光,揭示其设计原则与能力边界: 一位用户分享了据称是Google Diffusion(一个文本扩散语言模型)的系统提示词。该提示词详细说明了模型的身份(Gemini Diffusion,由Google训练的专家文本扩散语言模型,非自回归)、核心原则与约束(如指令遵循、非自回归特性、准确性、无实时访问、安全伦理、知识截止日期2023年12月、代码生成能力),以及针对HTML网页和HTML游戏生成的具体指令。这些指令涵盖了输出格式、美学设计、样式(如Tailwind CSS的专门使用或游戏中的自定义CSS)、图标使用(Lucide SVG图标)、布局与性能(CLS预防)、注释要求等。最后强调了逐步思考、精确遵循用户指令的重要性。这份提示词为了解此类模型的设计思路和预期行为提供了窗口 (来源: Reddit r/LocalLLaMA)

Arvind Narayanan阐述“AI即普通技术”论文的诞生与思考: 普林斯顿大学教授Arvind Narayanan分享了其与Sayash Kapoor合著的论文《AI as Normal Technology》的创作历程。他最初对AGI和存在风险持怀疑态度,但在同事的敦促下,决定认真对待并参与相关讨论。通过反思,他认识到超级智能相关观点值得认真对待,社交媒体不适合严肃讨论,且AI伦理和AI安全社区都存在各自的“信息茧房”。论文初稿在ICML被拒,但评审过程中的激烈争论反而坚定了他们继续研究的决心。他们意识到与AI安全社区的分歧比预想的更深,并认识到有必要进行更有成效的跨界辩论。最终,论文在哥伦比亚大学Knight First Amendment Institute工作坊发表,引发了广泛关注和富有成效的讨论,使Narayanan对AI政策的未来更为乐观 (来源: X)

00后AI创业者群体崛起,重塑创业规则: 一批00后AI创业者正以惊人速度在全球创业浪潮中崭露头角,他们凭借对AI技术的深刻理解和原生数字环境的敏锐洞察,重新定义了创业法则。案例包括Anysphere (Cursor)的Michael Truell(3年从实习生到百亿美金公司CEO)、Mercor的三位创始人(2年打造百亿级AI招聘平台)、Magic的Eric Steinberger(25岁联合创立融资超4亿美元的AI编码公司)以及Axiom的洪乐潼(专注AI解决数学难题,未有产品即获高估值)。这些年轻创业者普遍具备以下特点:编程是母语;年少成名,抓住技术红利窗口;敏锐感知用户需求;对组织和产品有AI原生理解,倾向极简高效团队和“AI即产品”的逻辑。他们的成功标志着AI时代创业范式的转变 (来源: 36氪)