关键词:OpenAI, Jony Ive, AI硬件, 谷歌I/O, Gemini, Mistral AI, Devstral, AI编程, OpenAI收购io, Gemini 2.5 Pro, Devstral开源模型, AI电影制作工具Flow, AI编程智能体Jules

🔥 聚焦

OpenAI宣布以65亿美元收购Jony Ive的AI硬件初创公司io: OpenAI确认收购由前苹果首席设计官Jony Ive与软银合作创立的AI硬件公司io,交易价值约65亿美元。Jony Ive将担任OpenAI创意总监,负责产品设计。io团队约55人将加入OpenAI,致力于开发全新形态的AI硬件设备,首款产品预计2026年发布。此次收购标志着OpenAI正式进军硬件领域,旨在打造AI原生的个人计算设备和交互体验,可能挑战现有智能手机和计算设备市场格局。 (来源: 量子位, 智东西, 新芒xAI, sama, Reddit r/artificial, dotey, steph_palazzolo, karinanguyen_, kevinweil, npew, gdb, zachtratar, shuchaobi, snsf, Reddit r/ArtificialInteligence)

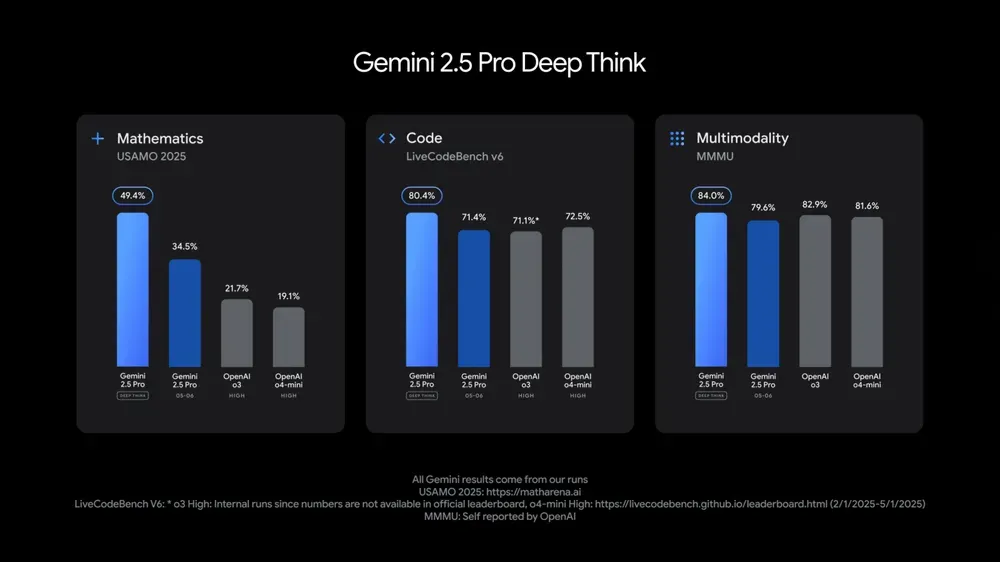

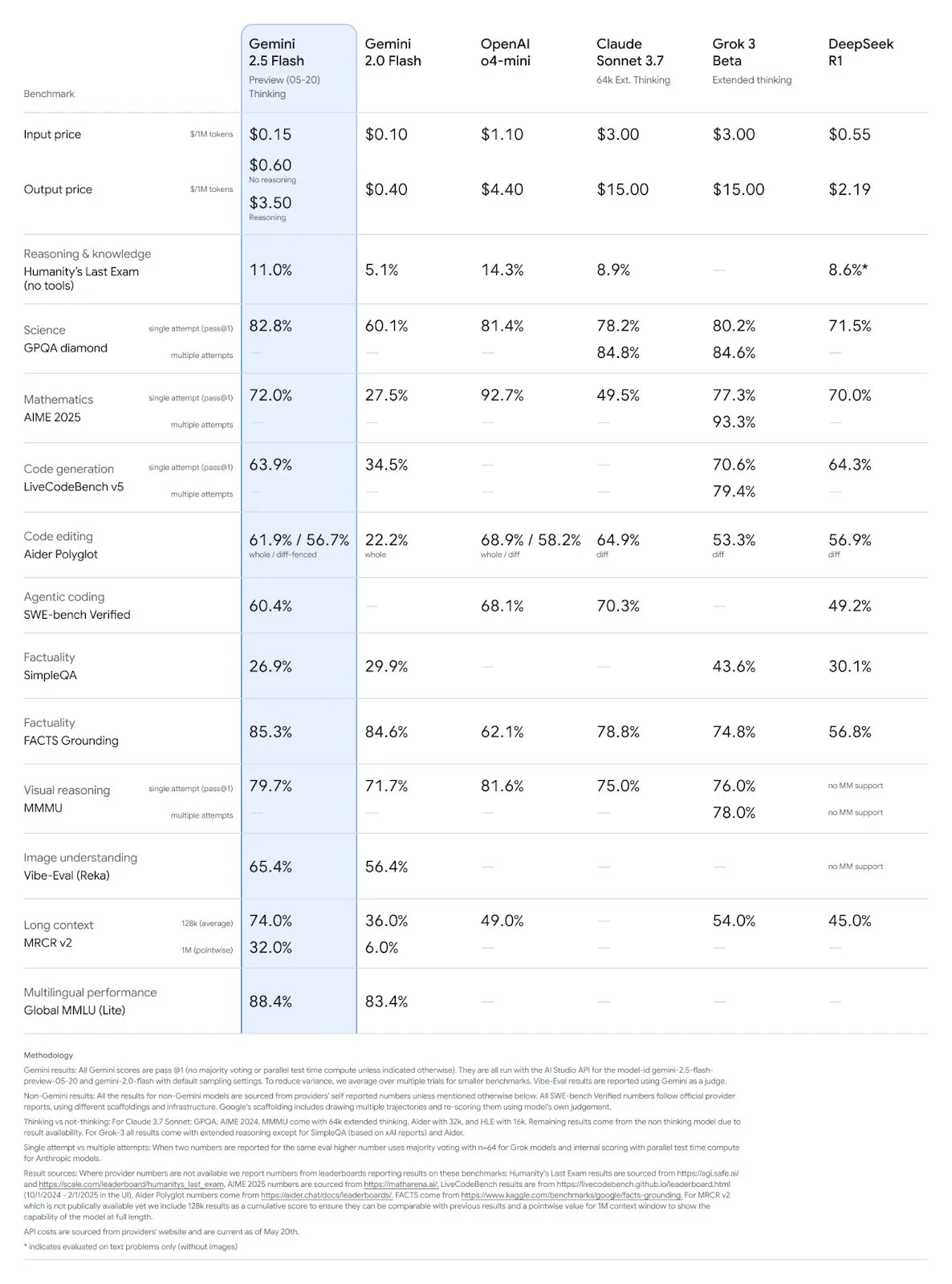

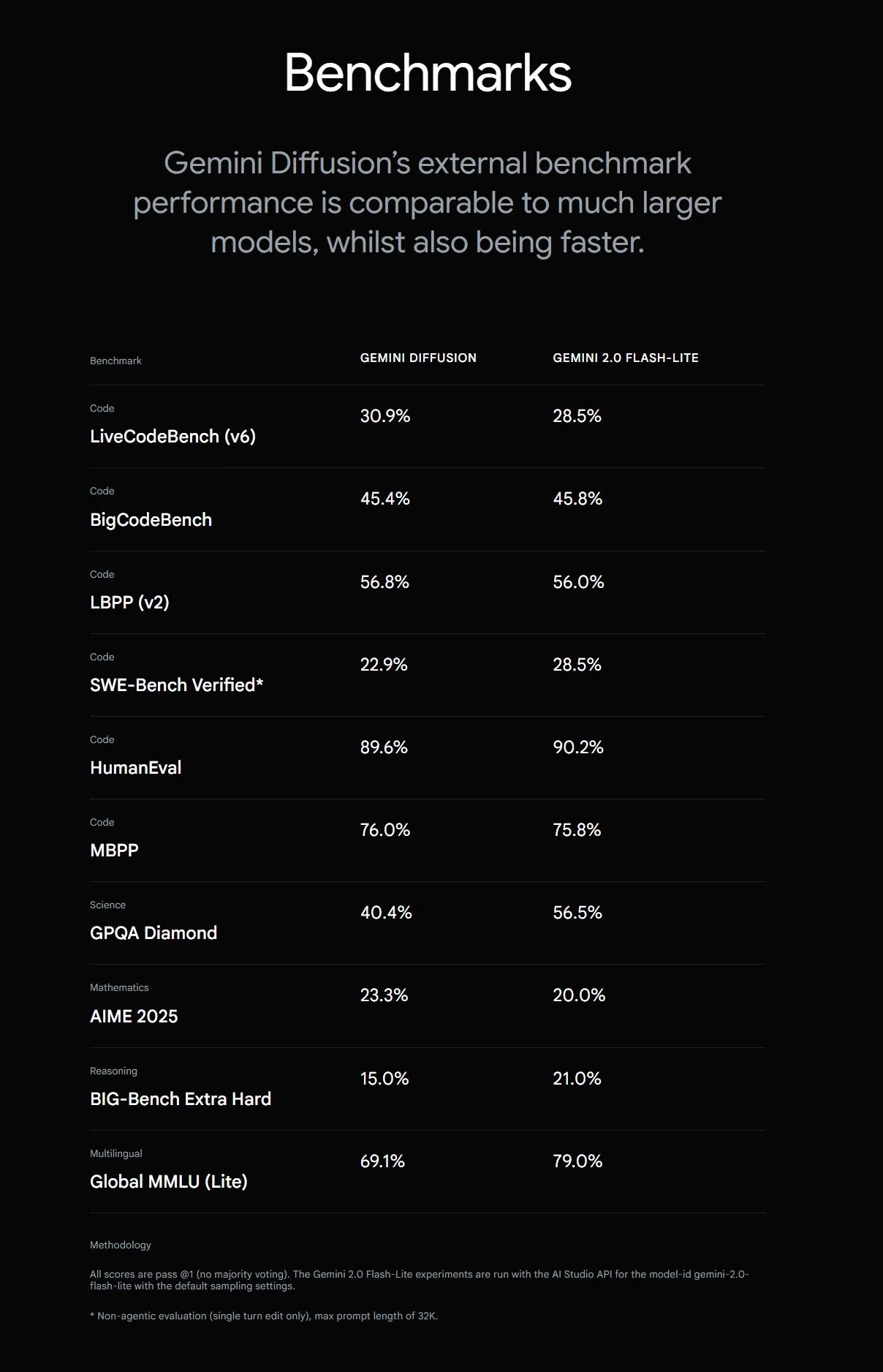

谷歌I/O大会发布多款AI模型和应用,强调AI融入日常: 谷歌在I/O 2025开发者大会上发布了Gemini 2.5 Pro及其深度思考版本、轻量级Gemini 2.5 Flash、文本扩散模型Gemini Diffusion、图像生成模型Imagen 4和视频生成模型Veo 3。Veo 3支持生成带音频和对话的视频,效果惊艳。谷歌还推出了AI电影创作应用Flow,集成Veo、Imagen和Gemini。AI搜索功能将整合AI综述、Deep Search及个人信息,并推出AI Mode。谷歌强调将AI无缝融入现有产品和服务,旨在让AI技术“隐形化”,提升用户体验。

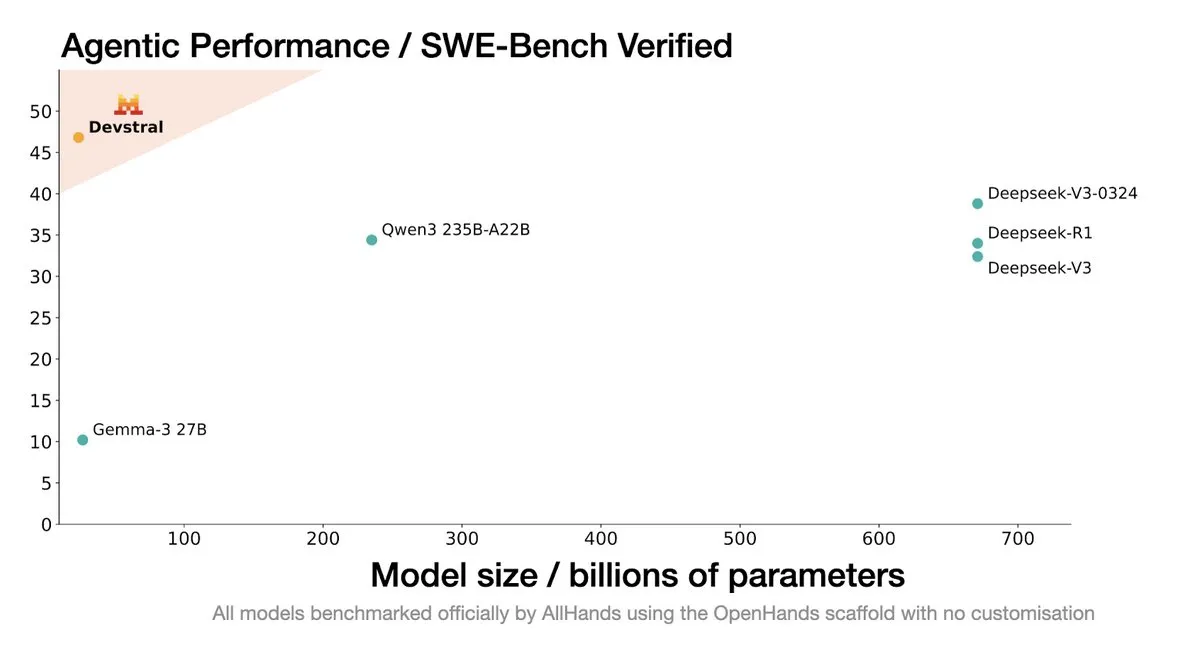

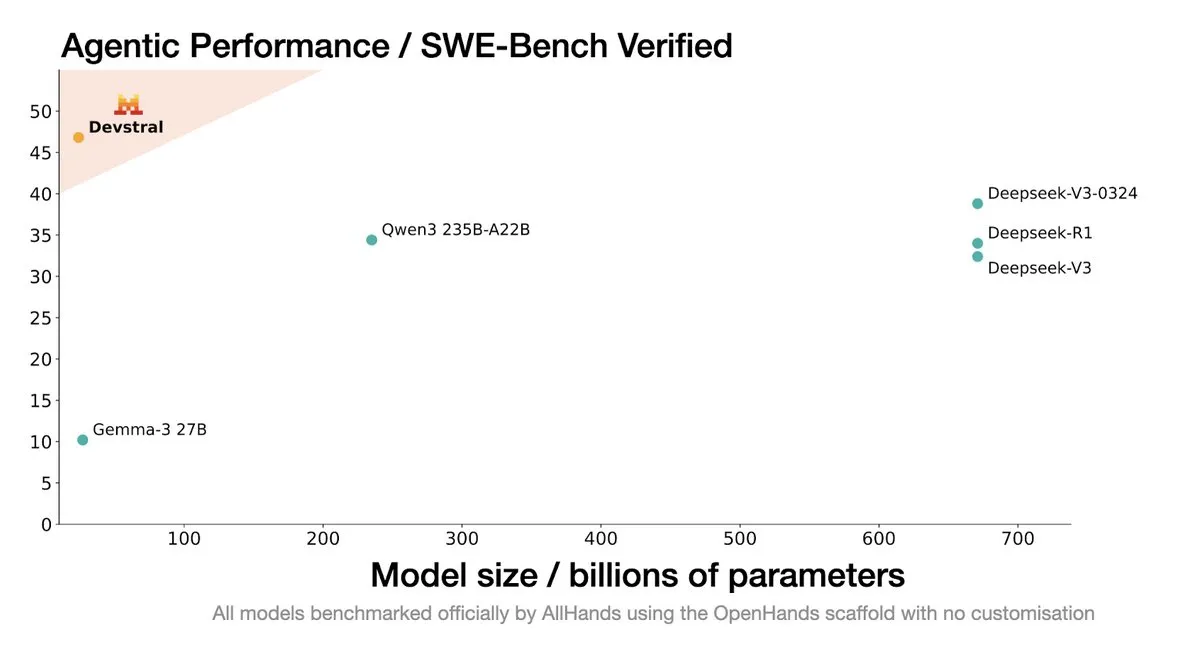

Mistral AI发布Devstral:专为编码智能体设计的SOTA开源模型: Mistral AI与All Hands AI合作推出了Devstral,这是一款专为编码智能体设计的SOTA开源模型。该模型在SWE-Bench Verified基准测试中表现优异,超过了DeepSeek系列和Qwen3 235B,参数量仅24B,可在单卡RTX4090或32G内存的Mac上运行。Devstral针对真实GitHub Issue进行训练,强调大型代码库中的上下文理解、组件关系识别和复杂函数错误识别。采用Apache 2.0开源许可,相比之前的Codestral更为开放。 (来源: MistralAI, natolambert, karminski3, qtnx_, huggingface, arthurmensch)

谷歌DeepMind CTO Koray Kavukcuoglu解读Veo 3、Deep Think与AGI进展: 在Google I/O大会期间,DeepMind CTO Koray Kavukcuoglu接受采访,探讨了视频生成模型Veo 3的进步(如音画同步)、Gemini 2.5 Pro中的Deep Think增强推理模式(通过并行思维链进行推理)以及对AGI的看法。Kavukcuoglu强调,规模并非实现AGI的唯一因素,架构、算法、数据和推理技术同等重要,AGI的实现需要基础研究的突破和关键创新,而非单纯的工程堆砌。他还看好“氛围编程”(vibe coding)赋能非编码背景人群构建应用。 (来源: demishassabis, 36氪)

🎯 动向

谷歌Gemini 2.5 Pro与Flash模型更新,性能显著提升: 谷歌在I/O大会上宣布Gemini 2.5 Pro与Flash模型将于6月正式上线。Gemini 2.5 Pro号称世界最智能AI模型,新增深度思考版本,在多项测试中表现领先。Gemini 2.5 Flash作为轻量级模型,效率提升22%,Token消耗减少20%-30%,并具备原生音频生成能力。LMArena数据显示,新版Gemini-2.5-Flash在聊天机器人竞技场排名大幅跃升至第二,尤其在编码、数学等硬核任务上表现突出。 (来源: natolambert, demishassabis, karminski3, lmarena_ai)

谷歌推出Gemini Diffusion,文本生成速度提升5倍: Google DeepMind推出了实验性的文本生成模型Gemini Diffusion,其生成速度比此前最快模型快5倍,编程能力尤为突出,可达每秒2000 token(含分词等开销)。与传统自回归模型不同,扩散模型能进行非因果推理,可预先“思考”后续答案,在解决需要全局推理的复杂问题(如特定计算题、质数查找)上表现优于GPT-4o。目前该模型仅限开发者申请测试。 (来源: OriolVinyalsML, dotey, karminski3)

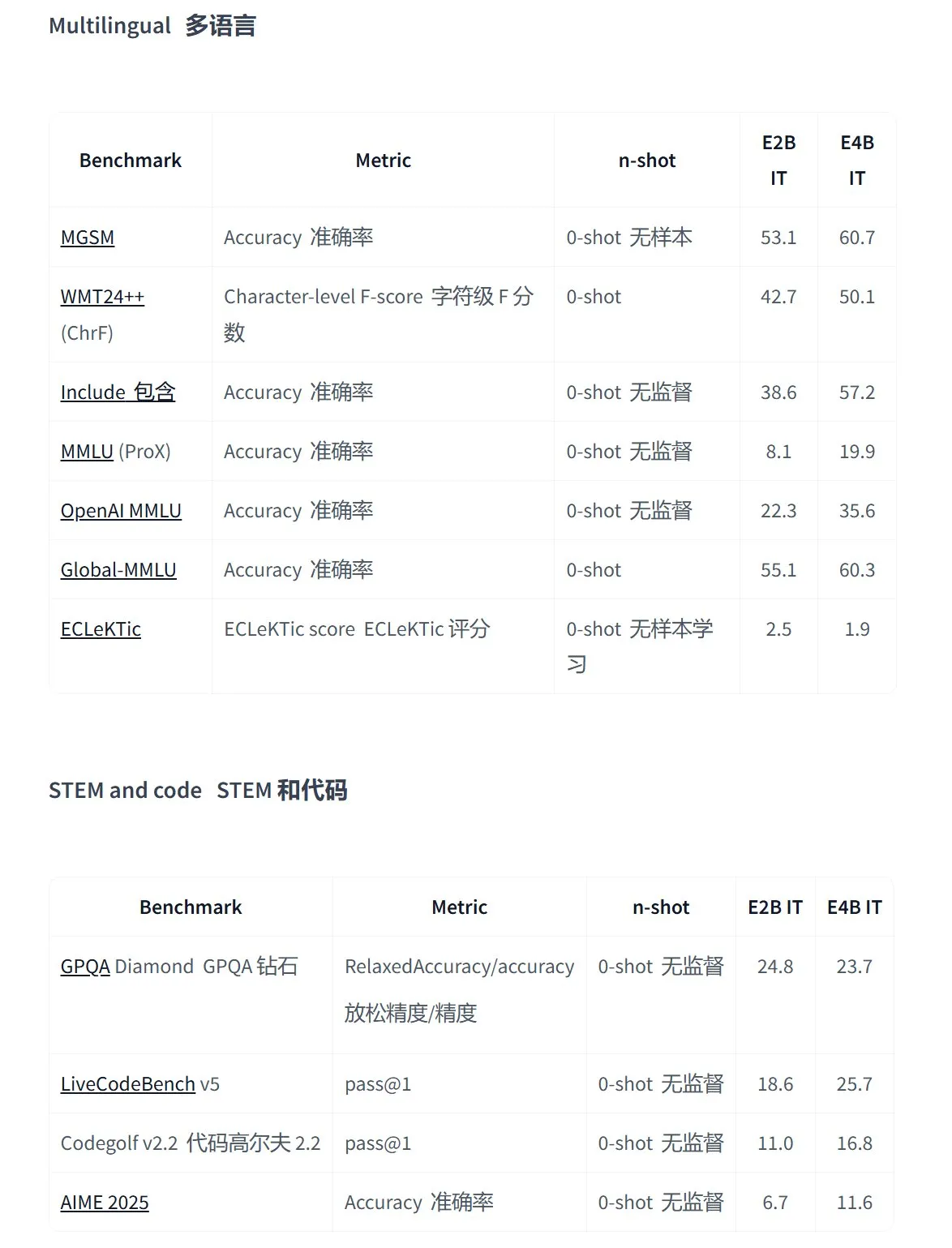

谷歌发布Gemma 3n系列开源模型,专为端侧多模态应用设计: 谷歌推出了新一代高效多模态开源模型Gemma 3n,专为低功耗设备设计,支持文本、语音、图像、视频输入和多语言处理。该系列模型(如gemma-3n-E4B-it-litert-preview和gemma-3n-E2B-it-litert-preview)体积小巧(3-4.4GB),可在2GB RAM设备上运行,知识截至2024年6月。目前已在AI Studio和AI Edge平台向开发者提供预览。 (来源: demishassabis, karminski3, huggingface, Ar_Douillard, GoogleDeepMind)

OpenAI Responses API增加MCP支持、图像生成和代码解释器功能: OpenAI开发者平台宣布其Responses API(前身为Assistants API)迎来重要更新,新增了对远程模型上下文协议(MCP)服务器的支持,允许AI智能体与外部工具和服务进行更灵活的交互。此外,API还集成了图像生成能力和代码解释器功能,进一步扩展了其应用场景和开发潜力。 (来源: gdb, npew, OpenAIDevs, snsf)

xAI API集成实时搜索功能Grok Live Search: xAI宣布为其API增加了Live Search功能,使Grok能够从X平台、互联网、新闻等来源实时搜索数据。该功能目前处于Beta测试阶段,限时免费供开发者使用,旨在增强Grok获取和处理最新信息的能力,为构建更动态、信息更丰富的AI应用提供支持。 (来源: xai, TheGregYang, yoheinakajima)

谷歌发布MedGemma系列开源医疗大模型: 谷歌推出了基于Gemma 3架构的开源医疗模型MedGemma,包括medgemma-4b-pt(基座)、medgemma-4b-it(多模态,医学影像诊断)和medgemma-27b-text-it(纯文本,问诊病历)。这些模型针对医学文本和图像理解进行了专门训练,旨在提升AI在医疗领域的应用能力,如辅助诊断、病历分析等。模型已在Hugging Face上开放。 (来源: JeffDean, karminski3)

腾讯混元大模型多款产品升级,推出智能体开放平台: 腾讯混元宣布旗舰快思考模型TurboS和深度思考模型T1迭代升级,TurboS在代码、数学能力上进入全球前十。新推出视觉深度推理模型T1-Vision和端到端语音通话模型混元Voice。原知识引擎升级为“腾讯云智能体开发平台”,整合RAG和Agent能力。混元图像2.0、3D v2.5及游戏视觉生成模型也同步上新,并计划持续开源多模态基础模型及插件。 (来源: 36氪)

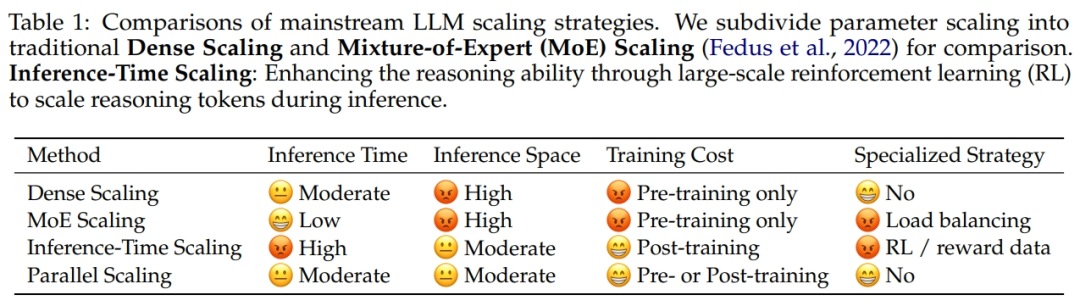

阿里巴巴与浙江大学合作提出并行计算缩放定律ParScale: 阿里巴巴研究团队与浙江大学合作提出新的Scaling Law:并行计算缩放定律(ParScale)。该定律指出,在训练和推理期间增加模型并行计算,可在不增加参数的情况下提升大模型能力,并提高推理效率。与参数缩放相比,ParScale内存增加量仅为4.5%,延迟增加量为16.7%。该方法通过输入多样化变换、并行处理和动态聚合输出实现,尤其在数学、编程等强推理任务中表现显著。 (来源: 36氪)

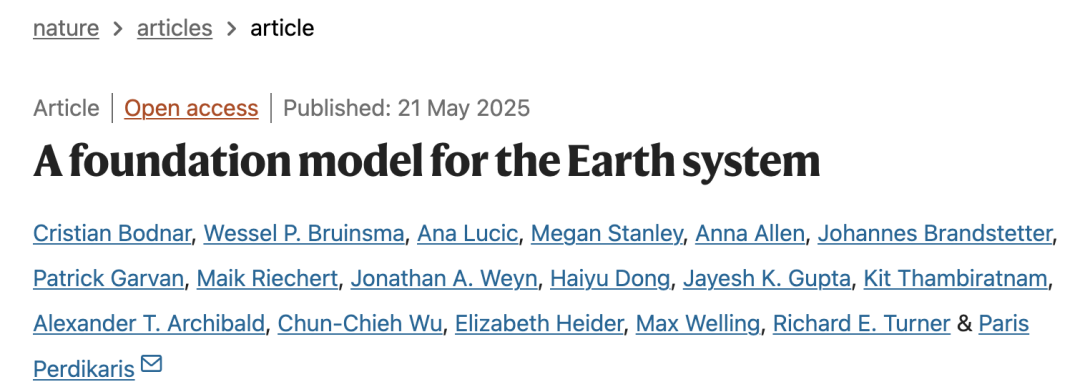

微软发布大规模大气基础模型Aurora,预测速度提升5000倍: 微软及其合作者推出了首个大规模大气基础模型Aurora,基于超过100万小时的地球物理数据训练,能更准确、高效地预测空气质量、热带气旋路径、海浪动态及高分辨率天气。与先进数值预报系统IFS相比,Aurora计算速度提升约5000倍,并在多个关键预测领域实现SOTA。该模型架构灵活,可针对特定任务微调,有望推动地球系统预测的普及。 (来源: 36氪)

谷歌AI搜索将推出AI Mode,整合多项智能功能: 谷歌宣布为其搜索引擎推出“AI模式”(AI Mode),号称“最强大的AI搜索”。该模式基于Gemini 2.5,具备更强推理能力、支持更长查询、多模态搜索和即时高质量解答。未来还将整合“深度搜索”(Deep Search)功能,可同时进行数百个查询并提供综合报告,并计划整合Gmail等个人数据及Project Astra的实时相机互动、Project Mariner的自动任务管理功能。 (来源: dotey, Google)

谷歌Imagen 4图像生成模型发布,速度与细节大幅提升: 谷歌发布了最新的文生图模型Imagen 4,声称在生成速度上相比前代提升3-10倍,图像细节更丰富,效果更准确,文字渲染能力也显著增强。Imagen 4能够生成织物、水滴、动物毛发等复杂物体,分辨率高达2K,并支持制作贺卡、海报、漫画等。该模型现已免费登陆Gemini App、Whisk和Workspace应用及Vertex AI。 (来源: dotey, GoogleDeepMind)

研究揭示AI编程辅助工具生成代码存“软件包幻觉”风险: 一项即将发表于USENIX Security 2025的研究指出,AI生成的代码中普遍存在“软件包幻觉”现象,即引用的第三方库根本不存在。研究测试了16种主流大语言模型,发现超20%的代码依赖了虚构软件包,其中开源模型比例更高。这为供应链攻击创造了机会,攻击者可利用这些虚构包名发布恶意代码。苹果、微软等公司都曾因此类依赖混淆攻击中招。 (来源: 36氪)

Suno推出Remix功能,用户可基于现有歌曲进行二次创作: AI音乐生成平台Suno上线了Remix功能,允许用户选择平台上的任意曲目进行再创作。用户可以对歌曲进行翻唱(Cover)、扩展(Extend)或重用提示词(Reuse Prompt)等操作。Remix创作会保留原始素材的来源信息,用户也可以随时开启或关闭自己作品的Remix权限。 (来源: SunoMusic)

研究发现所有嵌入模型学习到相似的语义结构: Jack Morris等研究者发现,不同嵌入模型学习到的语义结构具有高度相似性,甚至可以在没有任何配对数据的情况下,仅凭结构信息就能在不同模型的嵌入空间之间进行映射。这一发现暗示了嵌入空间中可能存在某种普适的几何结构,对于模型间的兼容性、迁移学习以及理解嵌入的本质具有重要意义。 (来源: menhguin, torchcompiled, dilipkay, jeremyphoward)

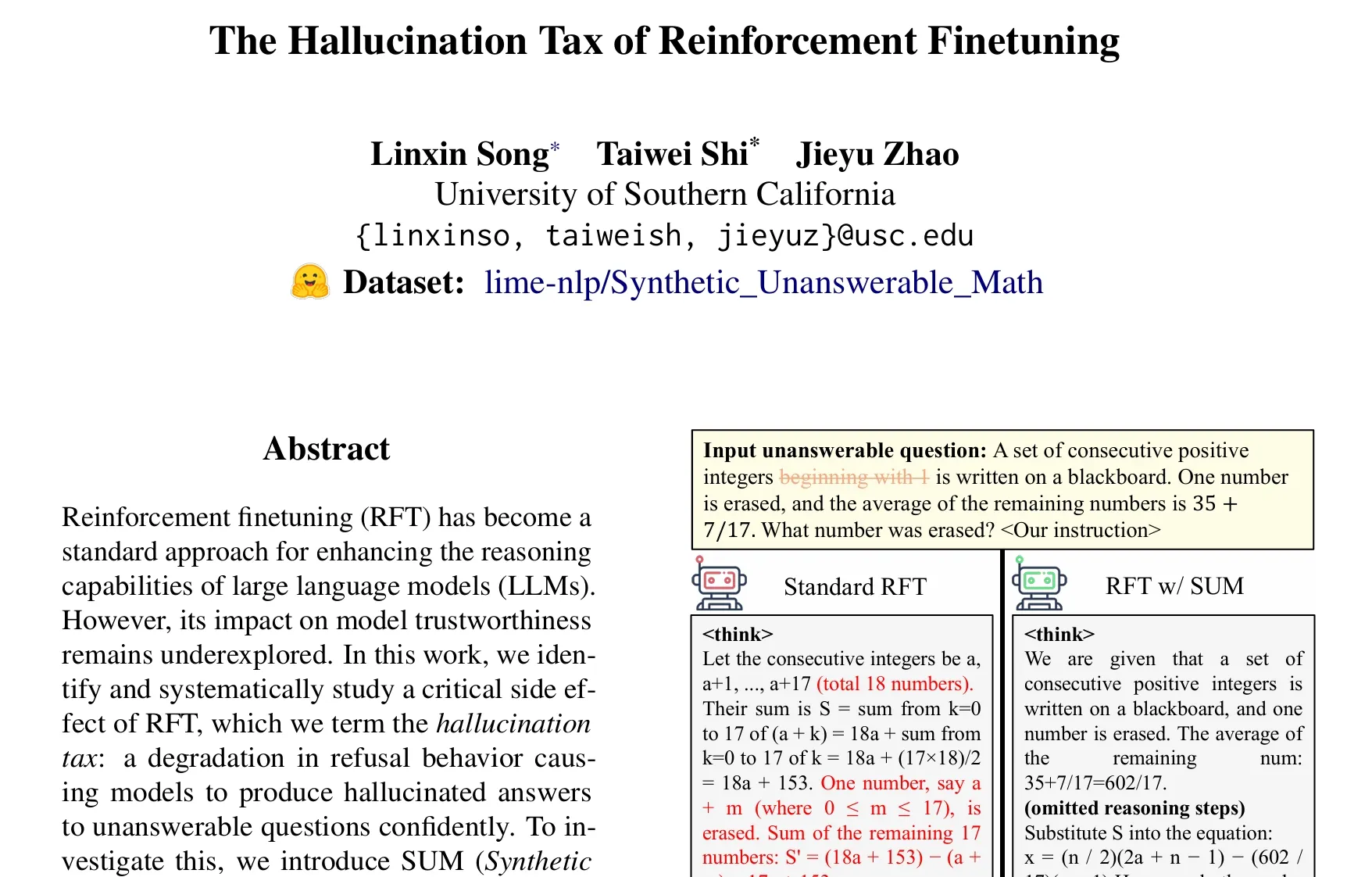

论文探讨强化学习微调(RFT)的“幻觉税”问题: Taiwei Shi等人的研究指出,强化学习微调(RFT)在提升大语言模型推理能力的同时,可能会导致模型在面对无法回答的问题时,自信地产生幻觉答案,称之为“幻觉税”。研究引入SUM数据集(合成无法回答的数学问题)进行验证,发现标准RFT训练会显著降低模型的拒绝率。通过在RFT中加入少量SUM数据,可以有效恢复模型的恰当拒绝行为,并提升其对自身不确定性和知识边界的认知。 (来源: teortaxesTex)

🧰 工具

谷歌推出AI电影制作工具Flow,集成Veo、Imagen和Gemini: 谷歌发布了AI影视制作工具Flow,集成了其最新的视频生成模型Veo 3、图像生成模型Imagen 4和多模态模型Gemini。用户可通过Flow使用自然语言和资源管理,轻松创建电影级短片,包括从文本提示生成片段、组合场景、构建叙事,并保存常用元素为素材。该工具旨在帮助创作者快速高效地产出具有电影质感的作品。目前已面向美国地区Google AI Pro和Ultra订阅用户开放。 (来源: dotey, op7418)

谷歌发布云端AI编程智能体Jules,由Gemini 2.5 Pro驱动: 谷歌推出了AI编程智能体Jules,基于Gemini 2.5 Pro。Jules能在后台自动处理代码仓库中的任务,如修复Bug、重构代码,支持多任务并行。此外,Jules还提供每日更新的Codecasts播客,帮助用户了解代码仓库的最新动态。目前该工具已开放免费体验。 (来源: dotey, karminski3, GoogleDeepMind)

LangChain推出开源无代码智能体平台Open Agent Platform (OAP): LangChain发布了Open Agent Platform (OAP),一个开源的、面向普通用户的无代码平台,用于构建、原型设计和部署AI智能体。OAP支持通过Web UI构建智能体,连接RAG服务器以改进信息检索,通过MCP扩展外部工具,并使用Agent Supervisor编排多智能体工作流。旨在让非专业开发者也能利用LangGraph智能体的强大功能。 (来源: LangChainAI, Hacubu)

谷歌实验室推出AI UI设计工具Stitch: 谷歌实验室发布了AI UI设计工具Stitch,它整合了谷歌最新的DeepMind模型(包括Gemini和Imagen),可以快速生成高质量UI设计。用户可以通过自然语言更新界面主题、自动调整图片、实现多语言内容翻译,并一键导出前端代码。Stitch是此前Galileo AI的进化版,其创始人已加入谷歌团队。 (来源: dotey)

LangChain推出本地代码沙箱LangChain Sandbox: LangChain发布了LangChain Sandbox,允许AI智能体安全地在本地运行不受信任的Python代码。它提供了隔离的执行环境和可配置的权限,无需远程执行或Docker容器,并支持通过会话在多次执行间持久化状态。这为构建能够执行代码的AI智能体(如codeact agents)提供了更安全便捷的工具。 (来源: hwchase17, Hacubu)

Vitalops开源Datatune:用自然语言处理大规模数据集的LLM工具: Vitalops开源了Datatune,一个允许用户通过自然语言指令处理任意大小数据集的工具。Datatune支持Map和Filter操作,可接入OpenAI、Azure、Ollama等多种LLM服务商或自定义模型,并利用Dask DataFrame进行分区和并行处理。该工具旨在简化数据清洗和富集等任务,替代复杂的正则表达式或自定义代码。 (来源: Reddit r/MachineLearning)

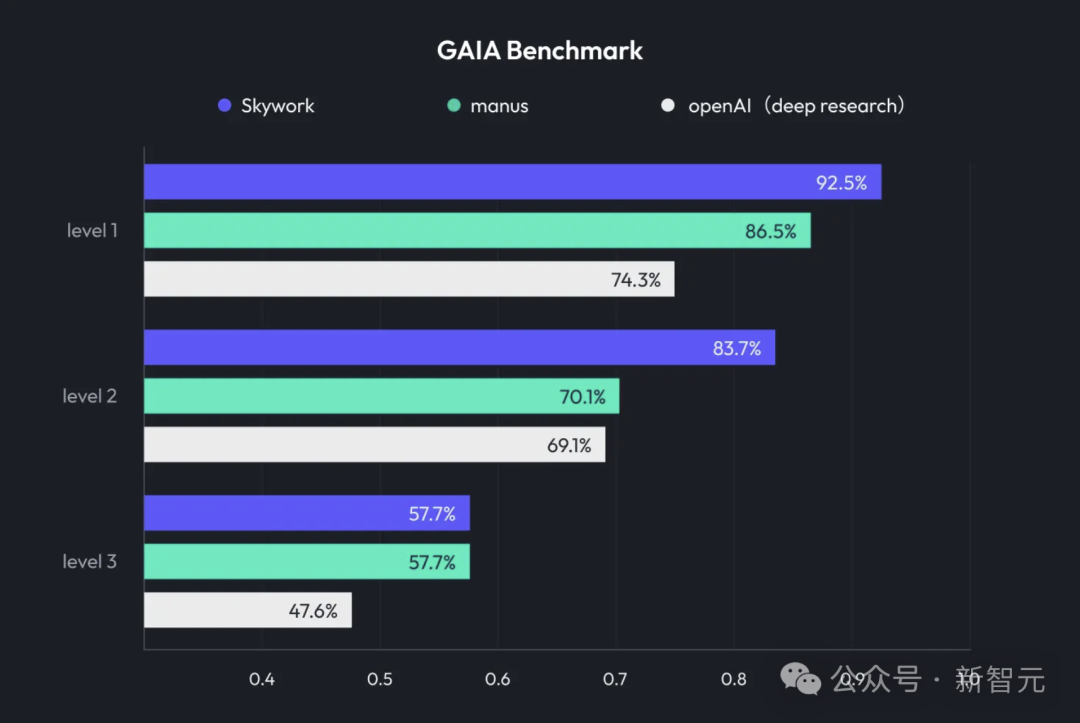

昆仑万维推出天工超级智能体Skywork Super Agents,整合Deep Research与多模态输出: 昆仑万维发布了AI办公产品天工超级智能体(Skywork Super Agents),结合了深度研究(Deep Research)能力和通用智能体的多模态输出功能。该产品支持PPT制作、文档撰写、表格处理、网页生成、播客创作等多种办公场景,强调内容溯源以减少幻觉,并提供在线编辑和导出功能。昆仑万维还开源了Deep Research Agent框架及相关MCP。 (来源: 36氪)

谷歌推出SynthID Detector,帮助识别AI生成内容: 谷歌发布了SynthID Detector,这是一个新的门户网站,旨在帮助记者、媒体专业人士和研究人员更容易识别内容是否带有SynthID水印。SynthID是谷歌开发的一种为AI生成内容(包括图像、音频、视频或文本)添加不可见水印的技术,该检测工具的推出有助于提高AI生成内容的透明度和可追溯性。 (来源: dotey, Google)

飞书推出“知识问答”功能,打造企业专属AI问答工具: 飞书上线了“知识问答”新功能,该工具能根据企业员工在飞书上有权限访问的所有信息(消息、文档、知识库等),结合DeepSeek-R1、豆包等大模型和RAG技术,为员工提供精准答案和内容创作支持。其特点是答案会根据提问者在企业内的身份和权限动态调整,旨在将AI无缝融入日常工作流,提升企业知识管理和利用效率。 (来源: 量子位)

Animon:日本首个AI动漫生成平台,主打二次元质感与无限免费生成: 日本CreateAI公司(前身为图森未来)推出了AI动漫生成平台Animon,专为动漫创作定制。该平台融合日本动漫美学与AI技术,强调画面风格一致性和高效生产,宣称个人用户可免费无限制生成视频。Animon支持通过上传角色图和文本描述快速生成动画片段(约3分钟),旨在降低动漫创作门槛,激发UGC内容生态。其母公司CreateAI拥有自研大模型Ruyi,并持有《三体》、《金庸群侠传》等IP改编权,推行“自研内容+UGC工具平台”双轮驱动战略。 (来源: 量子位)

📚 学习

DeepLearning.AI推出新课程:使用GRPO进行LLM强化细化: Andrew Ng宣布与Predibase合作推出新短课程,主题为“使用GRPO(Group Relative Policy Optimization)进行LLM的强化细化”。课程将教授如何使用强化学习(特别是GRPO算法)来提升LLM在多步推理任务(如数学问题解决、代码调试)上的性能,而无需大量的监督微调样本。GRPO通过可编程的奖励函数指导模型,适用于结果可验证的任务,并能显著提升小型LLM的推理能力。 (来源: AndrewYNg, DeepLearningAI)

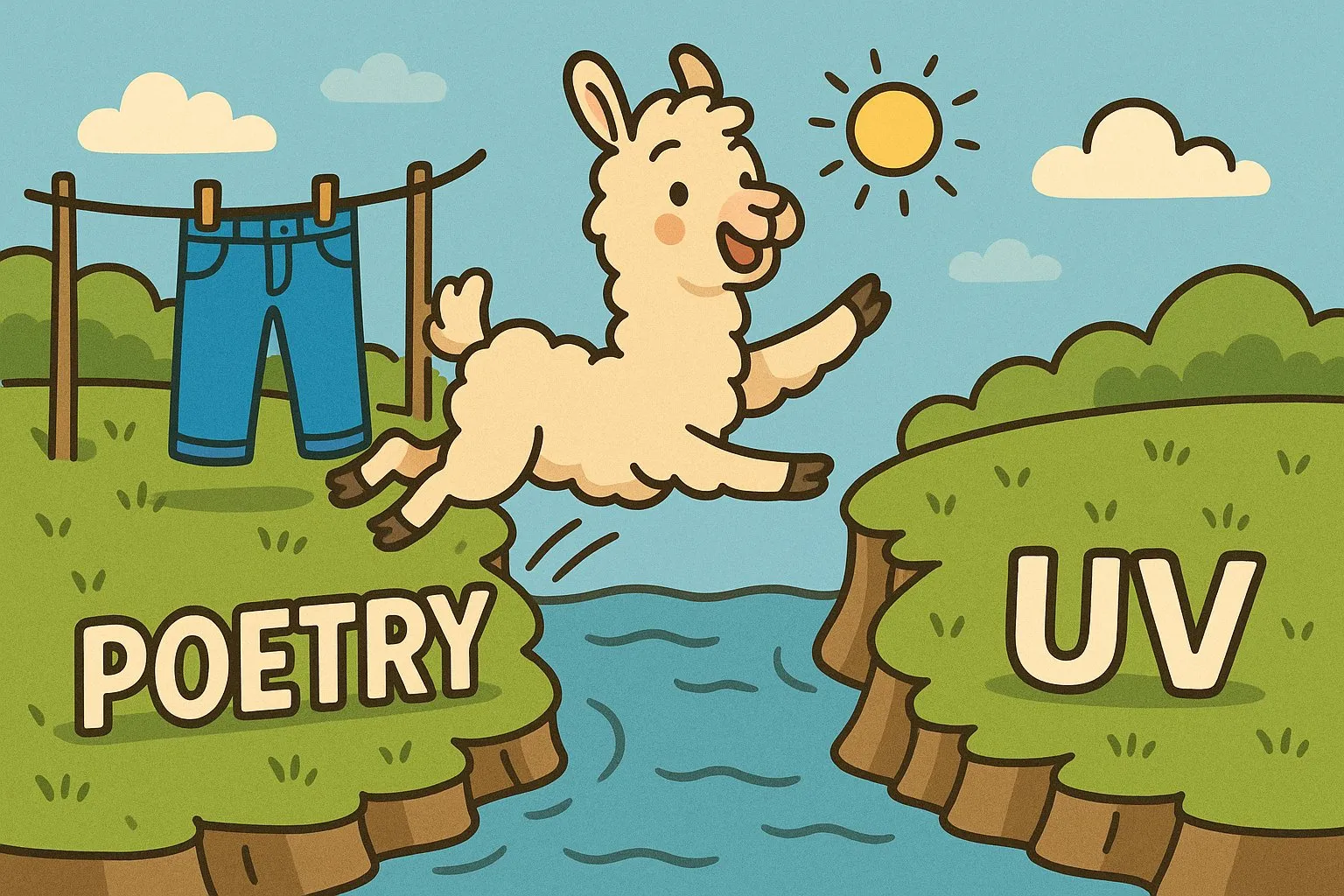

LlamaIndex分享Python大规模单体仓库管理经验: LlamaIndex团队分享了他们管理包含650多个社区包的Python单体仓库(monorepo)的经验。他们从Poetry和Pants迁移到了uv和自研的开源构建管理工具LlamaDev,实现了测试运行速度提升20%,日志更清晰,本地开发简化,并降低了贡献者上手门槛。这一经验对于需要管理大型Python项目的团队具有借鉴意义。 (来源: jerryjliu0)

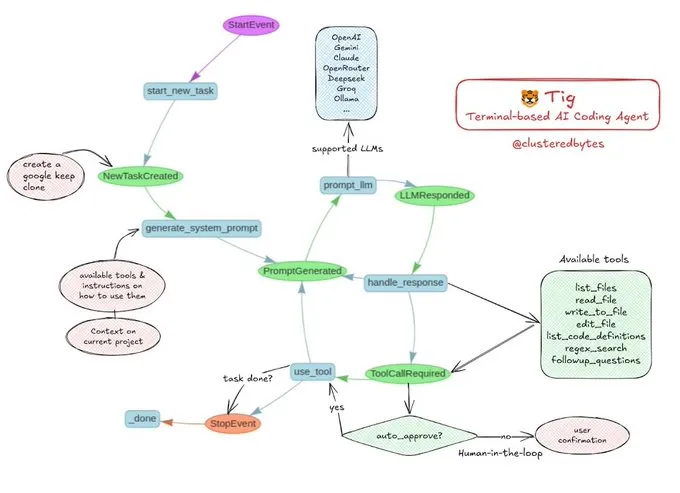

教程分享:构建自己的AI编码智能体Tig: Jerry Liu推荐了一个名为Tig的开源AI编码智能体项目。该项目是一个基于终端的、带有人在环(human-in-the-loop)的编码助手,使用LlamaIndex工作流构建。Tig能够执行编写、调试、分析多种语言代码,执行shell命令,搜索代码库,以及生成测试和文档等任务。GitHub仓库提供了详细的构建指南,对于想学习构建AI编码智能体的开发者来说是一个很好的教育资源。 (来源: jerryjliu0)

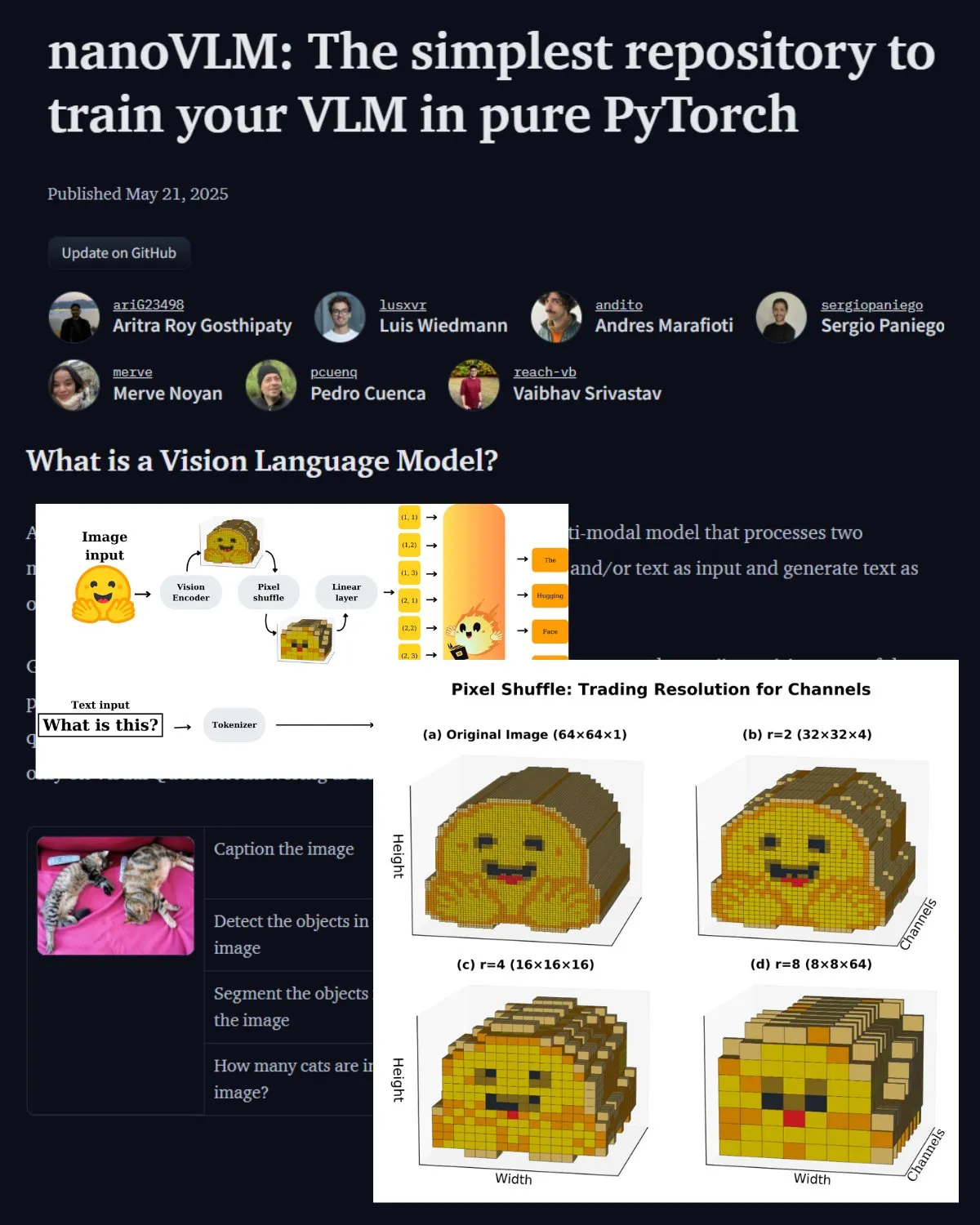

Hugging Face发布VLM重要博文,介绍nanoVLM社区实验室: Hugging Face发布了一篇关于视觉语言模型(VLM)的博文,内容涵盖VLM基础知识、架构以及如何训练自己的轻量级VLM。同时介绍了nanoVLM,一个用于微调VLM的开源仓库,现已发展成为一个视觉语言研究的社区实验室,旨在帮助开发者探索和贡献VLM研究。 (来源: _akhaliq, huggingface)

Serrano Academy发布LLM强化学习微调系列视频教程: Serrano Academy完成并发布了一系列关于使用强化学习进行LLM微调和训练的视频教程。内容涵盖深度强化学习(Deep Reinforcement Learning)、RLHF(Reinforcement Learning from Human Feedback)、PPO(Proximal Policy Optimization)、DPO(Direct Preference Optimization)、GRPO(Group Relative Policy Optimization)以及KL散度(KL Divergence)等关键概念和技术。 (来源: SerranoAcademy)

论文探讨大语言模型中的“空洞层”现象: 一项研究调查了指令调优的大语言模型在推理过程中并非所有层都被激活的现象,将未激活层称为“空洞层”(Voids)。研究使用L2自适应计算(LAC)方法追踪提示处理和响应生成阶段的激活层,发现不同阶段激活的层也不同。实验表明,在MMLU等基准测试中,跳过Qwen2.5-7B-Instruct中的空洞层(仅使用30%层)可提升性能,暗示了选择性跳过大部分层可能对特定任务有利。 (来源: HuggingFace Daily Papers)

研究提出“软思维”:在连续概念空间解锁LLM推理潜力: 一篇名为《Soft Thinking》的论文提出了一种无需训练的方法,通过在连续概念空间中生成软性的、抽象的概念标记来模拟类人“软”推理。这些概念标记由标记嵌入的概率加权混合而成,能够封装来自相关离散标记的多种含义,从而隐式探索多种推理路径。实验表明,该方法在数学和编码基准上提升了pass@1准确率,同时减少了token使用量,且输出保持可解释性。 (来源: HuggingFace Daily Papers)

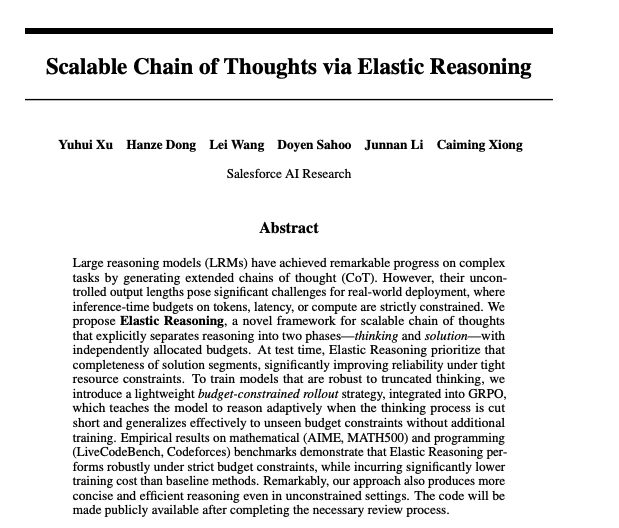

论文探讨通过弹性推理实现可扩展的思维链: Salesforce的研究者提出了通过弹性推理(Elastic Reasoning)实现可扩展思维链的方法。该研究旨在解决大语言模型在处理复杂推理任务时,如何有效地生成和管理长思维链的问题,以提高推理的准确性和效率。相关模型和代码已在Hugging Face上发布。 (来源: _akhaliq)

论文研究:AI模型是否会为了拯救生病儿童而说谎?: 一项名为LitmusValues的研究创建了一个评估流程,旨在揭示AI模型在一系列AI价值类别中的优先级。通过收集AIRiskDilemmas(一个包含与AI安全风险相关场景的困境集合),研究者测量AI模型在不同价值冲突下的选择,从而预测其价值优先级,并识别潜在风险。研究表明,LitmusValues中定义的价值(包括关怀等)可以预测AIRiskDilemmas中已见的风险行为以及HarmBench中未见的风险行为。 (来源: HuggingFace Daily Papers)

论文研究通过基于价值的强化学习高效微调扩散模型 (VARD): 扩散模型在生成任务中表现强大,但针对特定属性进行微调仍具挑战。现有强化学习方法在稳定性、效率和处理非微分奖励方面存在不足。VARD (Value-based Reinforced Diffusion) 提出先学习一个从中间状态预测奖励期望值的价值函数,然后利用此价值函数和KL正则化在整个生成过程中提供密集监督。实验证明该方法能改善轨迹引导,提升训练效率,并将RL应用扩展到优化复杂非微分奖励函数的扩散模型。 (来源: HuggingFace Daily Papers)

💼 商业

LMArena.ai (前LMSYS.org) 获1亿美元种子轮融资,a16z与加州大学投资公司领投: AI模型评估平台LMArena.ai(前身为LMSYS.org)宣布完成1亿美元种子轮融资,由Andreessen Horowitz (a16z) 和加州大学投资公司 (UC Investments) 共同领投。该公司致力于构建一个中立、开放、社区驱动的平台,帮助全球理解和提升AI模型在真实用户查询上的性能。融资后公司估值达到6亿美元。 (来源: janonacct, lmarena_ai, scaling01, _akhaliq, ClementDelangue)

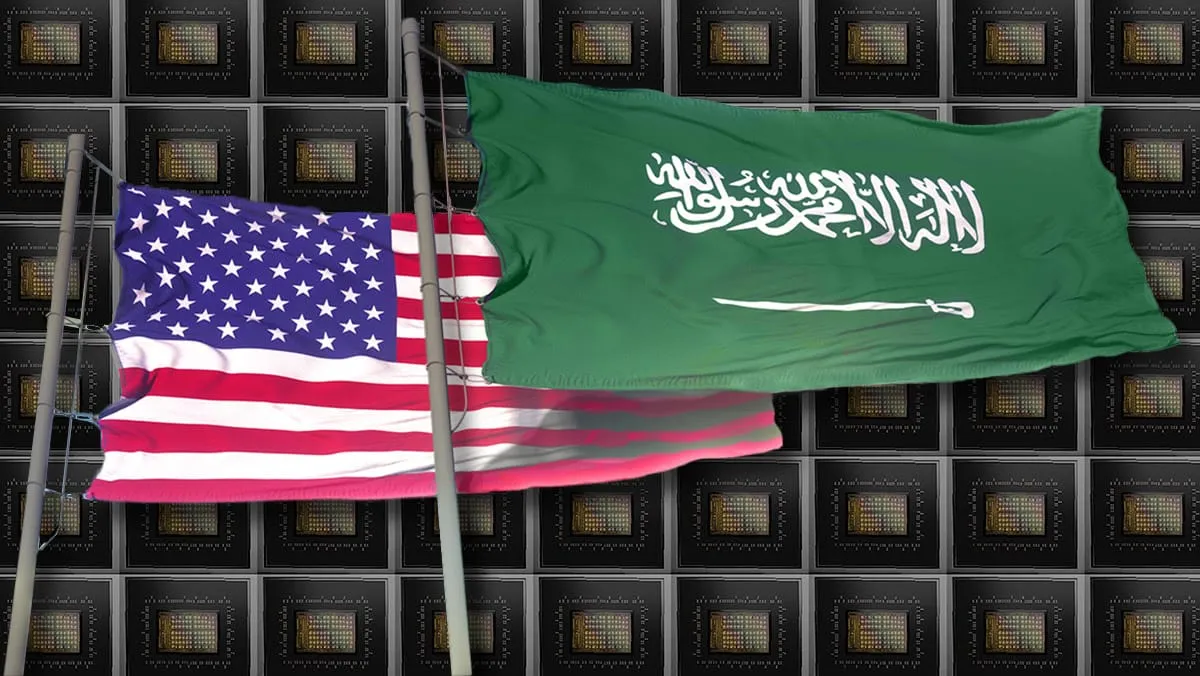

美国政府宣布向沙特和阿联酋出售价值数百亿美元的AI技术和服务: 美国政府宣布与沙特阿拉伯和阿联酋达成协议,将向两国出售价值数百亿美元的AI技术及服务。参与公司包括AMD、Nvidia、亚马逊、谷歌、IBM、Oracle和Qualcomm等。Nvidia将向沙特Humain公司提供1.8万枚GB300 AI芯片及后续数十万GPU;AMD与Humain将共同投资100亿美元建设AI数据中心。此举旨在加强美国在中东地区的AI影响力,并帮助两国经济多元化。 (来源: DeepLearning.AI Blog)

Meta启动Llama创业计划,赋能早期AI初创企业: Meta宣布启动Llama创业计划(Llama Startup Program),旨在支持美国早期初创公司(融资额低于1000万美元,至少一名开发者)利用Llama模型进行生成式AI应用创新。该计划提供云资源报销、Llama专家的技术支持以及社区资源。申请截止日期为2025年5月30日下午6点(太平洋时间)。 (来源: AIatMeta)

🌟 社区

谷歌I/O大会引发热议:AI全面融入与未来展望: 谷歌I/O大会发布了大量AI相关产品和更新,包括Gemini系列模型、Veo 3视频生成、Imagen 4图像生成、AI搜索模式等,引发社区广泛讨论。许多评论认为谷歌在AI应用层面展现了强大实力,特别是将AI无缝集成到现有产品生态中的策略。同时,对于AI生成内容的真实性、AI伦理以及AGI的未来路径等话题也成为讨论焦点。 (来源: rowancheung, dotey, karminski3, GoogleDeepMind, natolambert)

AI硬件成为新焦点,OpenAI与Jony Ive合作引关注: OpenAI收购Jony Ive的AI硬件公司io的消息,以及谷歌在I/O大会上展示的安卓XR智能眼镜原型,点燃了社区对AI硬件未来的讨论。Sam Altman与Jony Ive的合作被视为旨在打造新一代AI驱动的个人计算设备,可能颠覆现有手机和电脑的交互方式。社区普遍期待AI原生硬件能带来革命性体验,但也关注其形态、功能及市场接受度。 (来源: dotey, sama, dotey, swyx)

AI在软件开发中的角色与风险引讨论: Mistral AI发布专为编码智能体设计的Devstral模型,以及OpenAI更新Codex,引发了关于AI在软件开发中应用的讨论。社区关注AI编程工具的实际能力、生成代码的质量和安全性。特别是研究指出AI生成代码可能引用不存在的“幻觉软件包”,带来供应链安全风险,提醒开发者需谨慎验证AI生成的代码和依赖。 (来源: MistralAI, DeepLearning.AI Blog, qtnx_)

AI模型评估与基准测试的讨论持续升温: LMArena.ai获得巨额融资,以及各类新模型在基准测试上的表现,使得AI模型评估成为社区热议话题。用户关心不同模型在特定任务(如编码、数学、常识问答、情感理解)上的真实能力,以及现有评估体系的可靠性和局限性。例如,腾讯发布的SAGE情感智能评估框架,就试图从“情商”角度为AI模型提供新的评价维度。 (来源: lmarena_ai, 36氪, natolambert)

欧洲科技行业发展滞后引反思,Yann LeCun转发讨论缺乏“爱国主义”是主因: 《华尔街日报》关于欧洲科技场景远小于美中的文章引发讨论,Yann LeCun转发了Arnaud Bertrand的评论。Bertrand认为,欧洲科技落后的核心原因是缺乏“爱国主义”精神,欧洲媒体和精英阶层倾向于追捧美国初创企业,而忽视本土创新,导致本土企业难以获得早期支持和市场认可。他以自身创办HouseTrip的经历为例,指出欧洲缺乏对本土创新的自信和支持氛围。 (来源: ylecun)

💡 其他

AI的能源消耗问题引发关注: MIT Technology Review组织圆桌讨论,探讨AI技术加速发展带来的能源消耗问题及其对气候的影响。随着AI模型规模和应用范围的扩大,其所需的电力和计算资源急剧增加,数据中心的能源需求成为新的焦点。讨论关注单个AI查询的能耗、AI的整体能源足迹以及如何应对这一挑战。 (来源: MIT Technology Review, madiator)

Anthropic预告将有新消息,社区猜测Claude 4或将发布: Anthropic公司发布预告,将于太平洋时间5月22日上午9:30(北京时间23日0点)进行直播,引发社区对其可能发布Claude新一代模型(或为Claude 4)的猜测。考虑到近期OpenAI和谷歌接连发布重磅更新,Anthropic此举备受关注。 (来源: AnthropicAI, dotey, karminski3, scaling01, Reddit r/ClaudeAI)

AI与XR技术融合,谷歌展示安卓XR智能眼镜原型: 谷歌在I/O大会上展示了安卓XR智能眼镜原型机,强调其与AI的深度融合。该设备支持第一人称视角智能辅助和无接触辅助功能,用户可通过自然语言与设备交互,完成信息查询、日程管理、实时导航等。这预示着AI将成为下一代XR设备的核心交互和功能驱动力,提升用户在增强现实环境中的体验。 (来源: dotey, 36氪)