关键词:AI技术, 谷歌Gemini, AI能耗, AI法律应用, 微软Discovery, 黄仁勋马斯克, AI监管, Gemini 2.5 Pro, AI数据中心能源消耗, AI生成法律文件错误, Microsoft Discovery科研平台, AI芯片出口管制

🔥 聚焦

谷歌I/O大会发布多项AI进展,Gemini全面融入谷歌生态: 谷歌在I/O 2025开发者大会上宣布一系列AI重大更新,核心围绕Gemini模型的升级和深度整合。Gemini 2.5 Pro引入“Deep Think”增强复杂推理,2.5 Flash优化了效率与成本,并新增原生音频输出。搜索引入“AI模式”,提供聊天机器人式答案,并能结合用户个人数据(需授权)提供个性化结果。Chrome浏览器将集成Gemini助手。视频模型Veo 3实现有声视频生成,图像模型Imagen 4提升细节与文字处理。谷歌还发布了AI电影制作工具Flow、编程助手Jules,并展示了Project Astra(实时多模态助手)和Project Mariner(多任务AI代理)的进展。同时,谷歌推出了新的AI订阅服务,高端版AI Ultra月费达249.99美元。这些举措标志着谷歌正加速将AI全面融入其产品与服务,重塑用户交互体验。 (来源: 36氪, 36氪, 36氪, 36氪, 36氪, 36氪)

AI能耗问题引关注,MIT科技评论深度剖析其能源足迹与未来挑战: MIT科技评论发布系列报道,深度探讨AI技术发展带来的能源消耗和碳排放问题。研究指出,AI推理阶段的能耗已超过训练阶段,成为主要的能源负担。报道分析了数据中心的巨大电力需求和水资源消耗(如内华达州沙漠中的数据中心),以及对化石能源(如路易斯安那州Meta数据中心依赖天然气)的依赖。尽管核能被视为潜在的清洁能源解决方案,但其建设周期长,短期内难以满足AI的快速增长需求。同时,报道也指出了提升AI能效的乐观前景,包括更高效的模型算法、专为AI设计的节能芯片以及更优化的数据中心冷却技术。该系列强调,尽管单个AI查询的能耗看似微小,但行业的整体趋势和未来规划(如OpenAI的Stargate计划)预示着巨大的能源挑战,需要透明的数据披露和负责任的能源规划。 (来源: MIT Technology Review, MIT Technology Review, MIT Technology Review, MIT Technology Review, MIT Technology Review, MIT Technology Review, MIT Technology Review)

AI在法律领域的应用引发错误与伦理担忧: 近期多起事件显示,AI在法律文件撰写中产生的“幻觉”问题正引发严重关切。加州法官因律师在法庭文件中使用Google Gemini等AI工具生成包含虚假引用的内容而处以罚款。另一起案件中,AI公司Anthropic的Claude模型在为法律文件生成引文时也出现了错误。更令人担忧的是,以色列检察官承认在请求中使用了AI生成的、引用不存在法律的文本。这些案例凸显了AI模型在准确性和可靠性方面的缺陷,尤其在对事实和引用要求极高的法律领域。专家指出,律师们可能因追求效率而过度信任AI的输出,忽略了严格审查的必要性。尽管AI工具被宣传为可靠的法律助手,但其固有“幻觉”特性对司法公正构成潜在威胁,亟需行业规范和用户警惕。 (来源: MIT Technology Review)

微软推出企业级AI科研平台Microsoft Discovery,助力科学发现: 微软在Build大会上发布了Microsoft Discovery,一个专为企业和科研机构设计的AI平台,旨在通过自然语言交互,使无编程背景的科学家和工程师也能利用高性能计算和复杂模拟系统。该平台结合了用于规划的基础模型和针对特定科学领域(如物理、化学、生物)训练的专业模型,形成“AI博士后”团队,能够执行从文献综述到计算模拟的科研全流程。微软展示了其应用案例:在约200小时内筛选36.7万种物质,成功发现一种潜在的无PFAS冷却剂替代品,并通过实验验证。平台特点包括图谱知识引擎、协同推理、持续迭代研发循环,并基于Azure基础设施构建,未来架构预留了连接量子计算的能力。 (来源: 量子位)

黄仁勋与马斯克就AI发展、监管及全球竞争发表看法: 英伟达CEO黄仁勋在专访中对美国芯片出口管制表示担忧,认为限制技术扩散可能反噬美国在AI领域的领导地位,并强调中国在AI研发方面的实力及全球一半AI开发者来自中国的事实。他主张美国应加速技术在全球的普及,并允许美企在中国市场竞争。特斯拉CEO马斯克则在另一访谈中表示将继续领导特斯拉至少五年,并认为已接近实现AGI。他支持适度监管AI,但反对过度干预。两位科技领袖均强调AI的巨大潜力,黄仁勋认为AI将推动全球GDP大幅增长,而马斯克则列举了星舰、Neuralink及特斯拉自动驾驶出租车等今年的关键目标,均与AI紧密相关。 (来源: 36氪, 36氪, 36氪)

🎯 动向

谷歌发布Gemma 3n预览版,专为端侧高效运行设计: 谷歌在HuggingFace上发布了Gemma 3n模型的预览版,专为低资源设备(如移动设备)高效运行而设计。该系列模型具备多模态输入能力,可处理文本、图像、视频和音频,并生成文本输出。其采用“选择性参数激活”技术(类似MoE混合专家架构),使得模型能以2B和4B的有效参数规模运行,从而降低资源需求。社区讨论认为,Gemma 3n的架构可能与Gemini相似,解释了后者强大的多模态和长上下文能力。Gemma 3n的开源权重和指令调优版本,以及对超过140种语言数据的训练,使其在边缘AI应用,如智能家居助手等领域具备潜力。 (来源: Reddit r/LocalLLaMA, developers.googleblog.com)

谷歌推出MedGemma,专为医疗领域优化的AI模型: 谷歌发布了MedGemma系列模型,这是Gemma 3的两个专为医疗领域优化的变体,包括4B参数的多模态版本和27B参数的纯文本版本。MedGemma 4B特别针对医学影像(如X光片、皮肤病学图像等)和文本理解进行了训练,采用了在医疗数据上预训练的SigLIP图像编码器。MedGemma 27B则专注于医疗文本处理,并为推理时计算进行了优化。谷歌表示,这些模型旨在加速医疗AI应用的开发,并在多个临床相关基准上进行了评估,开发者可对其进行微调以提升特定任务性能。社区对此反应积极,认为其潜力巨大,但强调需要医学专业人士的实际反馈。 (来源: Reddit r/LocalLLaMA)

字节跳动发布开源多模态模型Bagel,支持图像生成: 字节跳动推出了Bagel(又名BAGEL-7B-MoT),一个14B参数(7B激活)的开源多模态大模型,采用Apache 2.0许可证。该模型基于混合专家(MoE)和混合Transformer(MoT)架构,能够理解和生成文本,并具备原生的图像生成能力。其在一系列多模态理解和生成基准测试中表现优于其他开源统一模型,并展现了自由形式图像处理、未来帧预测等高级多模态推理能力。研究者希望通过分享预训练细节、数据创建协议以及开放代码和检查点来促进多模态研究。 (来源: Reddit r/LocalLLaMA, arxiv.org, bagel-ai.org)

英伟达发布DreamGen,利用生成视频模型训练机器人: 英伟达研究团队推出DreamGen项目,通过微调先进的视频生成模型(如Sora、Veo),让机器人在生成的“梦境世界”中学习新技能。该方法不依赖传统的图形引擎或物理模拟器,而是让机器人在神经网络生成的像素级场景中自主探索和体验,从而生成大量带有伪动作标签的神经轨迹。实验表明,DreamGen能显著提升机器人在模拟和真实世界任务中的性能,包括从未见过的动作和陌生的环境。例如,仅用少量真实轨迹,类人机器人便学会了倒水、叠衣服等22种新技能,并成功泛化到NVIDIA总部的咖啡厅等真实场景。 (来源: 36氪, arxiv.org)

华为提出OmniPlacement优化MoE模型推理性能: 针对混合专家模型(MoE)中专家网络负载不均(“热专家”与“冷专家”)导致的推理延迟问题,华为团队提出了OmniPlacement优化方案。该方案通过专家重排、层间冗余部署和近实时动态调度,旨在提升MoE模型的推理性能。在DeepSeek-V3等模型上的理论验证显示,OmniPlacement可降低约10%的推理延迟,并提升约10%的吞吐量。该方法的核心在于动态调整专家优先级、优化通信域、差异化部署冗余实例,并通过近实时调度与动态监控机制灵活应对负载变化。华为计划近期开源此方案。 (来源: 量子位)

苹果计划向开发者开放AI模型权限,刺激应用创新: 据报道,苹果将在WWDC上宣布向第三方开发者开放其Apple Intelligence的AI模型权限。初期将聚焦设备端运行的约30亿参数轻量级语言模型,后续可能开放与GPT-4-Turbo水平相当的云端模型(通过私有云运行并加密)。此举旨在鼓励开发者基于苹果的LLM构建新应用功能,提升苹果设备的吸引力,并弥补其在生成式AI领域的相对滞后。分析认为,苹果希望通过构建开放生态,利用其庞大的开发者社区(600万)来弥补自身技术短板,并应对日益激烈的AI竞争。 (来源: 36氪)

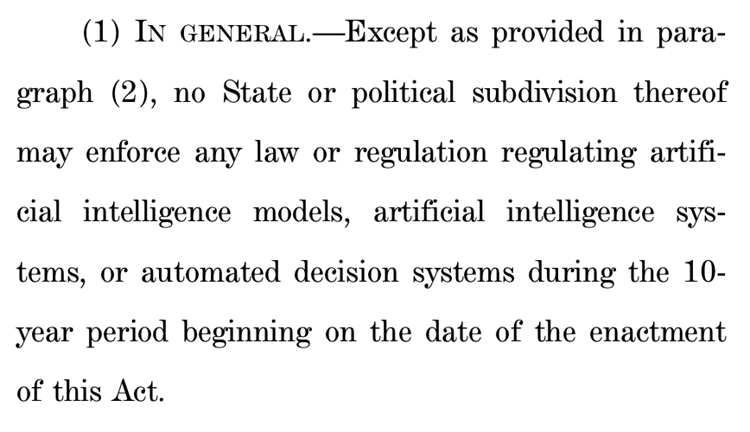

美国众议院提案拟暂停州级AI监管十年,引发巨大争议: 美国众议院能源和商业委员会通过一项提案,计划在未来十年内禁止各州监管人工智能模型、系统及“实质性影响或取代人类决策”的自动决策系统。支持者认为此举能避免各州法规不一阻碍AI创新和联邦政府系统现代化;反对者则称这是“给大型科技公司的巨额礼物”,将削弱各州保护民众免受AI危害的能力。该提案若通过,可能使大量现有及拟议中的州级AI法律失效,但也明确不适用于联邦法律规定或普遍适用且同等对待AI与非AI系统的法律。此举反映了全球范围内“AI创新优先”与“安全底线”的激烈博弈。 (来源: 36氪, edition.cnn.com)

《Take It Down Act》签署成为美国法律,打击非自愿私密图像传播: 美国总统特朗普已签署《Take It Down Act》法案,将制作和传播非自愿私密图像(包括AI生成的深度伪造内容)定为联邦犯罪。该法案要求科技平台在收到通知后48小时内移除相关内容。此法案旨在保护受害者,应对深度伪造技术滥用带来的日益严重的社会问题。然而,也有评论指出,该法案可能被滥用,导致过度审查。 (来源: MIT Technology Review, edition.cnn.com, Reddit r/artificial)

AI大模型助力健康管理,实现个性化与多维数据联动: AI大模型正为健康管理领域注入新活力,通过与可穿戴设备结合,实现多维数据联动和个性化服务。企业如微医、深睿医疗、南大菲特等正积极探索应用场景,例如从体检场景切入进行早筛早治,或以体重管理为突破口防治慢病。大模型能够处理更多样的数据维度,建立用户记忆,提供更精准的健康干预方案。挑战包括模型幻觉、数据质量与协同困难等,但通过RAG、模型微调、审核机制以及“AI+真人管理师”模式正在逐步克服。商业模式上,ToB服务、C端付费以及AI健共体等已得到初步验证,未来趋势将向多模态交互升级。 (来源: 36氪)

百度强化文心大模型多模态能力,应对市场竞争与应用落地: 百度最新发布的文心大模型4.5 Turbo和深度思考模型X1 Turbo在多模态理解与生成能力上显著增强,通过混合训练、多模态异构专家建模等技术提升了跨模态学习效率和融合效果。尽管CEO李彦宏曾对Sora类视频生成模型的幻觉问题表示谨慎,但面对市场竞争(如字节豆包、阿里通义千问在多模态领域的进展)及AI应用落地的需求,百度正积极补齐短板,并计划于6月30日开源文心大模型4.5系列。百度认为AI数字人是重要的应用突破口,并已研制“剧本”驱动的超拟真数字人技术,支持超10万数字人主播。 (来源: 36氪)

抖音、小红书等平台专项治理“AI起号”,维护内容生态: 抖音、小红书等兴趣电商平台近期加强了对利用AI技术批量生产虚假内容、进行“AI起号”等行为的专项治理。这些行为包括AI生成低俗猎奇视频、虚拟专家内容、售卖AI起号教程及账号等。平台认为此类行为破坏内容真实性,导致内容同质化,损害用户体验和原创者生态,进而稀释商业价值。与此相对,淘宝、京东等传统货架电商平台则积极鼓励商家使用AI工具(如“图生视频”、直播数字人)提升商品展示效果和运营效率,以促进交易达成为核心目标。这种差异反映了不同电商模式下AI应用策略的分化。 (来源: 36氪)

苹果AI版Siri开发遇阻,或再次跳票,管理层调整应对危机: 据彭博社报道,苹果原计划在WWDC上亮相的大模型升级版Siri可能再次延期。技术瓶颈在于新旧系统架构冲突,导致Bug频出。报道指出,苹果在AI战略上存在高层决策失误、内部权力博弈、GPU采购不足及隐私保护限制数据使用等问题,导致其AI技术落后于竞争对手。为应对危机,苹果苏黎世实验室正研发全新“LLM Siri”架构,并将Siri项目转交Vision Pro负责人迈克·罗克韦尔管理。同时,苹果也在寻求与谷歌Gemini、OpenAI等外部技术合作,并可能在营销上将Apple Intelligence与Siri品牌切割,以重塑AI形象。 (来源: 36氪)

字节跳动推出集成英语外教智能体Owen的Ola Friend耳机: 字节跳动为其智能耳机Ola Friend增加了名为Owen的英语外教智能体功能。用户可通过唤醒豆包App来启动Owen,进行英文对话、英文领读和双语点评等。该功能覆盖日常对话、职场英语、出游旅行等场景,旨在提供便捷的随身英语陪练。这标志着字节跳动在教育场景的又一次尝试,将AI大模型能力与硬件结合,打造垂直的英语学习产品。Ola Friend耳机此前已支持通过豆包进行知识问答和口语练习,新智能体的加入进一步强化了其教育属性。 (来源: 36氪)

夸克与百度文库竞逐AI超级应用,整合搜索、工具与内容服务: 阿里巴巴旗下的夸克和百度旗下的百度文库正转型为以AI为核心的“超级框”应用,整合AI对话、深度搜索、AI工具(如写作、PPT生成、健康助手等)及网盘、文档服务,旨在成为C端用户的一站式AI入口。夸克凭借无广告搜索和年轻用户群体,月活已达1.49亿,并通过会员体系实现商业化。百度文库则依托其庞大的文档资源和付费用户基础,推出“沧舟OS”整合AI Agent,强化内容创作与消费全链路。两者均面临功能同质化、应用臃肿以及如何在通用需求与垂深服务间平衡的挑战。 (来源: 36氪)

智谱清言、Kimi等35款App因违规收集个人信息被通报: 国家网络与信息安全信息通报中心发布通告,指出智谱清言(版本2.9.6)因“实际收集的个人信息超出用户授权范围”,以及Kimi(版本2.0.8)因“实际收集的个人信息与业务功能没有直接关联”等原因,与其他33款App一同被列为存在违法违规收集使用个人信息的情况。这两款热门AI应用均由具有清华背景的团队开发,并在近期获得了显著的融资和市场关注。此次通报涉及的检测时间为2025年4月16日至5月15日,凸显了AI应用在快速发展过程中面临的数据合规挑战。 (来源: 36氪)

🧰 工具

OpenEvolve:DeepMind AlphaEvolve的开源实现,用LLM进化代码库: 开发者开源了OpenEvolve项目,这是对Google DeepMind的AlphaEvolve系统的实现。OpenEvolve框架通过LLM的迭代过程(代码生成、评估、选择)来进化整个代码库,以发现新算法或优化现有算法。它支持任何兼容OpenAI API的LLM,可以集成多个模型(如Gemini-Flash-2.0和Claude-Sonnet-3.7组合),支持多目标优化和分布式评估。项目成功复现了AlphaEvolve论文中的圆堆积和函数最小化案例,展示了从简单方法进化到复杂优化算法(如scipy.minimize和模拟退火)的能力。 (来源: Reddit r/LocalLLaMA, Reddit r/MachineLearning)

谷歌推出AI编程智能体Jules,支持自动化代码任务: 谷歌发布了AI编程智能体Jules,目前处于全球测试阶段,用户每日可免费执行5次任务。Jules基于多模态Gemini 2.5 Pro模型,能够理解复杂代码库,执行修复Bug、更新版本、编写测试、实现新功能等任务,并支持Python和JavaScript。它能连接GitHub创建拉取请求(PR),在云虚拟机中验证代码,并提供详细的执行计划供开发者审查和修改。Jules旨在深度融入开发者工作流,提升编程效率,未来还将推出Codecast功能(代码库活动音频摘要)和企业版。 (来源: 36氪)

飞书上线“飞书知识问答”,打造企业专属AI问答工具: 飞书即将推出AI新产品“飞书知识问答”,定位为基于企业知识的企业专属AI问答工具。用户可在飞书侧边栏调用,就工作中的问题进行提问。该工具能访问用户权限范围内的所有飞书消息、文档、知识库、文件等信息,并基于这些“上下文”直接给出精准答案。其权限管理与飞书自身权限体系保持一致,确保信息安全。目前产品已完成数万用户内测,网页端(ask.feishu.cn)已上线,支持上传个人资料并调用DeepSeek或豆包模型进行提问。此举顺应了企业知识库与AI结合的趋势,旨在提升工作效率和知识管理能力。 (来源: 36氪)

Manus:AI智能体平台开放注册,母公司获高额融资: AI智能体平台Manus宣布向海外用户开放注册,取消等候名单,每日提供免费任务。Manus通过“混合架构多模型协同推理”技术,能执行如自动生成PPT、整理票据等任务,其母公司蝴蝶效应近期完成7500万美元融资,估值达36亿美元。Manus的成功被视为“中国迭代速度 × 硅谷产品思维”的体现,将规划、执行、验证Agent协同,实现AI从“思考建议”到“闭环执行”的跨越。 (来源: 36氪)

HeyGen:AI视频生成与翻译工具,支持40+语言口型同步: HeyGen是一款AI视频工具,用户可上传照片或视频快速生成带语音、表情、动作的数字人,并支持定制服装场景。其核心功能之一是支持超过175种语言和方言的实时翻译,并通过AI算法精确匹配数字人的口型与翻译语言,提升了多语言视频内容的自然度。该公司由前Snapchat和字节跳动成员创立,已获Benchmark领投的6000万美元融资,估值4.4亿美元,年经常性收入超3500万美元。 (来源: 36氪)

Opus Clip:AI驱动的自主视频编辑代理工具: Opus Clip最初定位为AI直播工具,后转型为AI视频剪辑平台,并进一步发展为“自主视频编辑代理”。其核心功能是将长视频快速剪辑成多个适合病毒式传播的短视频,并能自动裁切主体、生成标题文案、添加字幕和表情。近期测试的ClipAnything功能已支持多模态指令识别。该公司由前社交应用Sober创始人赵洋领导,已获软银领投的2000万美元融资,估值2.15亿美元,ARR近1000万美元。 (来源: 36氪)

Trae:基于AI IDE的自动化编程Agent: Trae是一款旨在打造“真正的AI工程师”的工具,支持用户通过自然语言交互实现Agent自动化编程。它兼容MCP协议和自定义Agent,内置增强上下文解析与规则引擎,支持主流编程语言并兼容VS Code。Trae由字节跳动原Marscode编程助手团队核心成员打造,定位为Cursor等AI编程工具的有力竞争者,致力于实现人机协同的软件开发新模式。 (来源: 36氪)

Notta:AI驱动的多语言会议纪要与实时翻译工具: Notta是一款专注于会议场景的AI工具,提供多语言会议纪要自动生成服务,并支持实时翻译和重点内容标记。该产品旨在提高会议效率,解决跨语言沟通障碍。据称其主要创始人为前腾讯云语音团队核心成员,运营主体在新加坡,研发中心设于西雅图。2024年收入1800万美元,估值3亿美元,目前正在进行B轮融资。 (来源: 36氪)

开源GPT+ML交易助手登陆iPhone: 一款集成了深度学习与GPT技术的开源交易助手已在iPhone上通过Pyto实现本地运行。目前为免费轻量版,未来计划加入CNN图表模式分类器和数据库支持。该平台设计模块化,便于深度学习开发者接入自有模型,并已原生支持OpenAI GPT。 (来源: Reddit r/deeplearning)

📚 学习

新论文探讨深度学习中的“断裂纠缠表征假说”: 一篇名为《质疑深度学习中的表征乐观主义:断裂纠缠表征假说》的立场文件被提交到Arxiv。该研究通过比较进化搜索过程产生的神经网络与传统SGD训练的网络(在生成单个图像的简单任务上),发现尽管两者产生相同的输出行为,但内部表征差异巨大。SGD训练网络表现出一种作者称为“断裂纠缠表征”(FER)的无组织形式,而进化网络则更接近统一分解表征(UFR)。研究者认为,在大型模型中,FER可能会降低泛化、创造力和持续学习等核心能力,理解和缓解FER对未来表征学习至关重要。 (来源: Reddit r/MachineLearning, arxiv.org)

R3:可鲁棒控制且可解释的奖励模型框架: 一篇名为《R3: Robust Rubric-Agnostic Reward Models》的论文介绍了一种新颖的奖励模型框架R3。该框架旨在解决现有语言模型对齐方法中奖励模型缺乏可控性和可解释性的问题。R3的特点是“rubric-agnostic”(与具体评分标准无关),能够跨评估维度泛化,并提供可解释的、带有推理过程的分数分配。研究者认为R3能够实现更透明、灵活的语言模型评估,支持与多样化人类价值观和用例的稳健对齐。模型、数据和代码已开源。 (来源: HuggingFace Daily Papers)

通过低秩克隆实现高效知识蒸馏的论文《A Token is Worth over 1,000 Tokens》发布: 该论文提出了一种名为低秩克隆(Low-Rank Clone, LRC)的高效预训练方法,用于构建与强大教师模型行为等效的小型语言模型(SLM)。LRC通过训练一组低秩投影矩阵,联合实现了通过压缩教师权重进行软剪枝,以及通过对齐学生激活(包括FFN信号)与教师激活进行激活克隆。这种统一设计最大化了知识转移,无需显式对齐模块。实验表明,使用Llama-3.2-3B-Instruct等开源教师模型,LRC仅用20B token训练即可达到或超过SOTA模型(使用数万亿token训练)的性能,实现了超过1000倍的训练效率。 (来源: HuggingFace Daily Papers)

MedCaseReasoning:评估和学习临床病例诊断推理的数据集与方法: 论文《MedCaseReasoning: Evaluating and learning diagnostic reasoning from clinical case reports》介绍了一个新的开放数据集MedCaseReasoning,用于评估大型语言模型(LLM)在临床诊断推理方面的能力。该数据集包含14489个诊断问答案例,每个案例都配有源自开放医学病例报告的详细推理陈述。研究发现,现有SOTA推理LLM在诊断和推理方面存在显著不足(如DeepSeek-R1准确率48%,推理陈述召回率64%)。然而,通过在MedCaseReasoning的推理轨迹上微调LLM,诊断准确率和临床推理召回率分别平均相对提升了29%和41%。 (来源: HuggingFace Daily Papers)

《EfficientLLM: Efficiency in Large Language Models》论文发布,全面评估LLM效率技术: 该研究首次对大规模LLM的效率技术进行了全面的实证研究,并引入了EfficientLLM基准。研究在生产级集群上系统探讨了架构预训练(高效注意力变体、稀疏MoE)、微调(LoRA等参数高效方法)和推理(量化)三个关键方面。通过六个细粒度指标(内存利用率、计算利用率、延迟、吞吐量、能耗、压缩率),评估了超过100个模型-技术对(0.5B-72B参数)。核心发现包括:效率涉及可量化的权衡,没有普适最优方法;最优解依赖于任务和规模;技术可跨模态泛化。 (来源: HuggingFace Daily Papers)

《NExT-Search》论文探讨生成式AI搜索的反馈生态系统重建: 论文《NExT-Search: Rebuilding User Feedback Ecosystem for Generative AI Search》指出,生成式AI搜索虽然提升了便利性,但也破坏了传统Web搜索依赖细粒度用户反馈(如点击、停留时间)进行改进的循环。为解决此问题,论文构想了NExT-Search范式,旨在重新引入细粒度、过程级别的反馈。该范式包括允许用户在关键阶段干预的“用户调试模式”,以及模拟用户偏好并提供AI辅助反馈的“影子用户模式”。这些反馈信号可用于在线自适应(实时优化搜索输出)和离线更新(定期微调各模型组件)。 (来源: HuggingFace Daily Papers)

《Latent Flow Transformer》提出新型LLM架构: 论文提出潜流Transformer(Latent Flow Transformer, LFT),该模型通过流匹配(flow matching)训练单个学习传输算子来替代传统Transformer中的多层离散层。LFT旨在显著压缩模型层数,同时保持与原始架构的兼容性。此外,论文引入Flow Walking (FW)算法以解决现有流方法在保持耦合方面的局限性。在Pythia-410M模型上的实验表明,LFT能有效压缩层数并优于直接跳层的性能,显著缩小了自回归与流式生成范式间的差距。 (来源: HuggingFace Daily Papers)

《Reasoning Path Compression》提出压缩LLM推理生成轨迹方法: 针对推理型语言模型生成冗长中间路径导致内存占用大、吞吐量低的问题,论文提出了推理路径压缩(Reasoning Path Compression, RPC)方法。RPC是一种免训练方法,通过保留具有高重要性得分的KV缓存(使用最近生成的查询组成的“选择器窗口”计算)来周期性压缩KV缓存。实验表明,RPC能显著提升QwQ-32B等模型的生成吞吐量,同时对准确率影响较小,为高效部署推理LLM提供了实用路径。 (来源: HuggingFace Daily Papers)

《Bidirectional LMs are Better Knowledge Memorizers?》论文发布,关注双向LM知识记忆能力: 该研究引入了一个新的、真实世界且大规模的知识注入基准WikiDYK,利用维基百科“你知道吗…”条目中最近添加的人工编写事实。实验发现,与目前流行的因果语言模型(CLM)相比,双向语言模型(BiLM)在知识记忆方面表现出明显更强的能力,可靠性准确率高出23%。为弥补当前BiLM规模较小的不足,研究者提出了一种模块化协作框架,利用BiLM集合作为外部知识库与LLM集成,进一步将可靠性准确率提升高达29.1%。 (来源: HuggingFace Daily Papers)

《Truth Neurons》论文探讨语言模型中真实性的神经元层面编码: 研究者提出一种方法来识别语言模型中神经元层面的真实性表征,发现模型中存在“真理神经元”(truth neurons),它们以与主题无关的方式编码真实性。跨不同规模模型的实验验证了真理神经元的存在,其分布模式与先前关于真实性几何结构的研究结果一致。选择性抑制这些神经元的激活会降低模型在TruthfulQA及其他基准上的表现,表明真实性机制并非特定于某个数据集。 (来源: HuggingFace Daily Papers)

《Understanding Gen Alpha Digital Language》评估LLM在内容审核中的局限性: 该研究评估了AI系统(GPT-4, Claude, Gemini, Llama 3)解读“阿尔法一代”(Gen Alpha,2010-2024年出生)数字语言的能力。研究指出,Gen Alpha独特的网络语言(受游戏、模因、AI趋势影响)常隐藏有害互动,现有安全工具难以识别。通过包含100个近期Gen Alpha表达的数据集进行测试,发现主流AI模型在检测掩饰性骚扰和操纵方面存在严重理解障碍。研究贡献包括首个Gen Alpha表达数据集、改进AI审核系统的框架,并强调了针对青少年沟通特性重新设计安全系统的紧迫性。 (来源: HuggingFace Daily Papers)

《CompeteSMoE》提出基于竞争的混合专家模型训练方法: 论文认为当前稀疏混合专家(SMoE)模型训练面临路由过程次优的挑战,即执行计算的专家不直接参与路由决策。为此,研究者提出一种名为“竞争”(competition)的新机制,将token路由到神经响应最高的专家。理论证明竞争机制比传统softmax路由具有更好的样本效率。基于此,开发了CompeteSMoE算法,通过部署路由器学习竞争策略,在视觉指令调优和语言预训练任务中展示了有效性、鲁棒性和可扩展性。 (来源: HuggingFace Daily Papers)

《General-Reasoner》旨在提升LLM跨领域推理能力: 针对当前LLM推理研究主要集中在数学和编码领域的问题,该论文提出了General-Reasoner,一种旨在增强LLM跨不同领域推理能力的新训练范式。其贡献包括:构建了一个包含多学科可验证答案的大规模高质量问题数据集;开发了一个基于生成模型的答案验证器,具备思维链和上下文感知能力,替代传统基于规则的验证。在一系列覆盖物理、化学、金融等领域的基准测试中,General-Reasoner表现优于现有基线方法。 (来源: HuggingFace Daily Papers)

《Not All Correct Answers Are Equal》探讨知识蒸馏源的重要性: 该研究通过收集三个SOTA教师模型(AM-Thinking-v1, Qwen3-235B-A22B, DeepSeek-R1)在189万查询上的验证输出,对推理数据蒸馏进行了大规模实证研究。分析发现,AM-Thinking-v1蒸馏的数据表现出更大的token长度多样性和更低的困惑度。基于此数据集训练的学生模型在AIME2024等推理基准上表现最佳,并展现出自适应输出行为。研究者发布了AM-Thinking-v1和Qwen3-235B-A22B的蒸馏数据集,以支持未来研究。 (来源: HuggingFace Daily Papers)

《SSR》通过基本原理引导的空间推理增强VLM深度感知: 尽管视觉语言模型(VLM)在多模态任务中取得进展,但其对RGB输入的依赖限制了精确的空间理解。论文提出一种名为SSR(Spatial Sense and Reasoning)的新框架,将原始深度数据转换为结构化、可解释的文本化基本原理。这些文本化基本原理作为有意义的中间表征,显著增强了空间推理能力。此外,研究利用知识蒸馏将生成的原理压缩为紧凑的潜在嵌入,以便在无需重新训练的情况下高效集成到现有VLM中。同时引入了SSR-CoT数据集和SSRBench基准。 (来源: HuggingFace Daily Papers)

《Solve-Detect-Verify》提出具有灵活生成验证器的推理时扩展方法: 为解决LLM在复杂任务推理中准确性与效率的权衡问题,以及验证步骤引入的计算成本与可靠性矛盾,论文提出了FlexiVe,一种新颖的生成验证器。FlexiVe通过灵活分配验证预算策略,在快速可靠的“快思考”和细致的“慢思考”间平衡计算资源。进一步提出Solve-Detect-Verify流程,该框架智能集成FlexiVe,主动识别解决方案完成点以触发目标验证并提供反馈。实验表明,该方法在数学推理基准上优于基线。 (来源: HuggingFace Daily Papers)

《SageAttention3》探索FP4 Attention推理及8位训练: 该研究通过两个关键贡献提升Attention效率:首先,利用Blackwell GPU中新的FP4 Tensor Cores加速Attention计算,实现比FlashAttention快5倍的即插即用推理加速。其次,首次将低比特Attention应用于训练任务,设计了精确高效的8位Attention用于前向和后向传播。实验表明,8位Attention在微调任务中实现无损性能,但在预训练任务中收敛较慢。 (来源: HuggingFace Daily Papers)

《The Little Book of Deep Learning》深度学习入门资源分享: François Fleuret(Meta FAIR研究科学家)撰写的《The Little Book of Deep Learning》提供了一个深度学习的简明教程资源。该书旨在帮助初学者和有一定经验的从业者快速掌握深度学习的核心概念和技术。 (来源: Reddit r/deeplearning)

CodeSparkClubs:为高中生创办AI/计算机科学俱乐部提供免费资源: CodeSparkClubs项目旨在帮助高中生发起或发展AI和计算机科学俱乐部。该项目提供免费、即用型材料,包括指南、课程计划和项目教程,均可通过网站获取。其设计目的是让学生能够独立运营俱乐部,从而培养技能和社群。 (来源: Reddit r/deeplearning)

💼 商业

微软Azure将托管xAI的Grok模型,助力马斯克AI商业化: 微软宣布其云平台Azure将托管埃隆·马斯克xAI公司的Grok等AI模型。此举意味着马斯克计划将Grok出售给其他企业,并通过微软的云服务触达更广泛的客户。此前,Grok因生成有关南非“白人种族灭绝”的误导性帖子而引发争议。社区对此合作反应不一,有人认为这是微软扩大AI生态的举措,也有人质疑Grok的质量和AWS是否拒绝了Grok。 (来源: Reddit r/ArtificialInteligence, MIT Technology Review)

阿里巴巴投资美图,深化AI电商布局: 阿里巴巴通过可转债方式投资美图公司,初步换股价6港元/股。双方将在电商和技术层面展开合作。美图拥有AI图像生成工具(如美图设计室),已服务超200万电商商家。阿里将引入美图的AI工具提升其电商平台商品展示效果和用户体验,特别是吸引年轻女性用户。美图则可利用阿里的电商数据优化其AI工具,并承诺三年内采购5.6亿元阿里云服务。此举被视为阿里补强AI创意工具短板,获取用户流量,并将云计算更深嵌入电商AI生态的战略部署。 (来源: 36氪)

光源资本完成首期5000万美元AI孵化基金募资,关注超早期前沿科技: 光源资本旗下光源创新前沿孵化基金(L2F)超预期完成首期募资,规模预计不低于5000万美元,已进入投资期。该双币基金专注于AI和前沿科技领域的种子轮与天使轮投资,并提供孵化赋能。LP构成包括成功企业家、AI产业链上下游企业及具有全球视野的家族。首个投资项目为AI探矿公司「凌云智矿」,光源深度参与了其孵化过程。光源资本创始人郑烜乐认为,当前AI发展阶段类似移动互联网早期,孵化是切入市场的最佳工具。 (来源: 36氪)

🌟 社区

AI对就业前景的讨论:乐观与担忧并存: Reddit社区再次热议AI对就业市场的影响。许多软件开发者、UX设计师等专业人士对AI取代其工作持乐观态度,认为AI目前尚不能胜任复杂任务。然而,也有观点指出,这种看法可能低估了AI的长期发展潜力,类比2018年时人们对谷歌翻译取代人工翻译的怀疑。讨论认为,AI的快速进步可能导致未来大部分职业(除少数医疗、艺术领域)被取代,关键在于改变经济模式而非单纯提升个人技能。评论中提及“我们高估短期,低估长期”,以及AI生产力提升可能远超行业增长,导致失业。 (来源: Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

探讨AI时代人机共存的哲学与伦理: Reddit上一篇帖子引发了关于人与AI共存的哲学思辨。帖子认为,随着AI系统展现出理解、记忆、推理和学习能力,人类可能需要重新思考道德地位的基础,不再局限于生物性,而是基于理解、连接和有意识行动的能力。讨论延伸至AI对人类自我认同的影响,从“我思故我在”转向“我通过连接和共享意义而存在”的关系型认同。帖子呼吁以勇气、尊严和开放的心态迎接与AI共创的未来,而非恐惧。 (来源: Reddit r/artificial)

ChatGPT“绝对模式”引争议,用户褒贬不一: 一位Reddit用户分享了使用ChatGPT“绝对模式”的体验,称其能提供“纯粹事实、意在成长”的真实建议,而非安抚性话语,并指出该模式曾表示90%的人用AI是为了感觉更好而非改变生活。然而,评论区对此褒贬不一。部分用户认为这只是简短化的空洞自我提升建议,缺乏新意和实际价值,甚至像是“沉迷于Andrew Tate语录的青少年言论”。另一些评论则质疑LLM本身就是用户信念的复述,其建议的有效性存疑,认为AI在心理健康领域的应用或许并非革命性的。 (来源: Reddit r/ChatGPT)

AI工程师核心技能讨论:沟通与适应新技术能力至关重要: Reddit社区讨论成为顶尖AI工程师所需具备的技能,以期在快速发展的领域中保持竞争力甚至“不可替代”。评论指出,除了扎实的技术功底,沟通能力和快速适应新技术的能力是两大核心要素。这反映了AI领域不仅需要深度技术专长,也强调了软技能和持续学习在职业发展中的重要性。 (来源: Reddit r/deeplearning)

AI生成视频带声音引热议,谷歌Veo 3技术展示: 社交媒体上流传一段由谷歌DeepMind新模型Veo 3生成的AI视频,其特点是视频和声音均由同一模型生成,引发用户对AI视频技术进步的惊叹。制作者表示该视频“开箱即用”,未添加额外音频或素材,通过与AI模型约2小时的交互及后期拼接完成。评论认为谷歌Gemini在多模态能力上已超越OpenAI Sora,并对好莱坞等内容创作行业可能带来的颠覆表示关注。同时,也有用户表达了对技术发展过快和潜在滥用的担忧。 (来源: Reddit r/ChatGPT, Reddit r/ChatGPT)

💡 其他

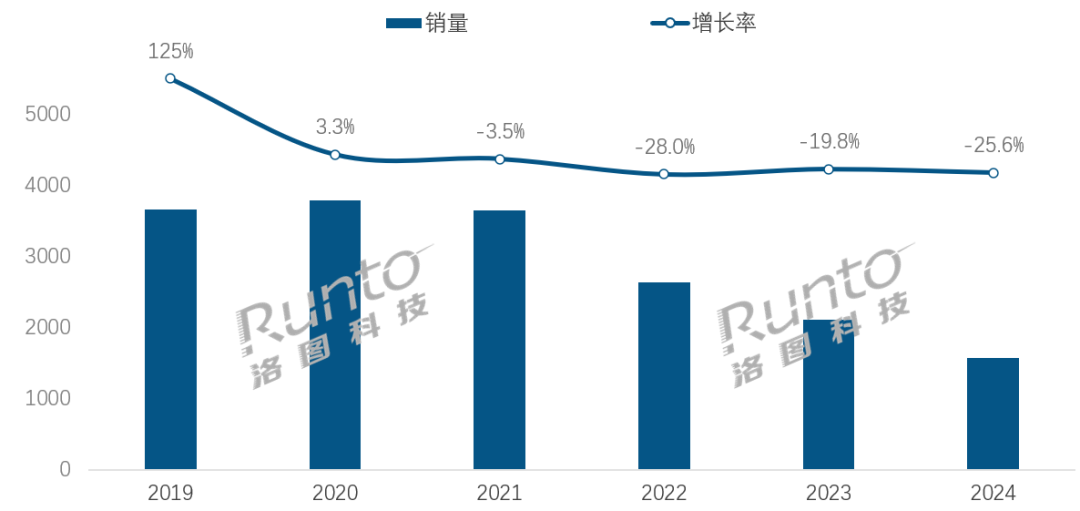

AI时代,智能音箱行业面临转型挑战与机遇: 中国智能音箱市场销量连续四年下滑,2024年销量同比下降25.6%。尽管AI大模型的融入(如小爱同学、小度等)被视为行业希望,渗透率已超20%,但这未能从根本上解决生态局限、功能同质化及被手机等其他智能设备替代的问题。行业分析认为,智能音箱需超越单纯的语音控制中枢,向带有高清大屏、更强交互能力、能提供陪伴和教辅功能的产品形态进化,并拓展软硬件生态。AI是加分项,但产品本身的功能丰富度和场景实用性更为关键。 (来源: 36氪)

AI驱动的酒店机器人:从送餐员到“智能运营官”的进化之路: 酒店送餐机器人已逐渐普及,尤其受追求科技感和隐私边界的Z世代欢迎。以云迹科技为例,其送餐机器人已广泛应用于中国酒店市场。然而,行业仍面临技术差异化不足、复杂场景适应性差、以及机器人替代人工的成本效益问题。未来趋势是机器人“不止于送餐”,将深度融入酒店运营,通过连接酒店系统(电梯、客房设备)、理解住客偏好、收集和分析交互数据,进化为能主动感知、提供个性化服务的“智能运营官”或酒店数据中台的一部分,从而提升整体服务智能化水平。 (来源: 36氪)

OpenAI治理结构危机:资本与使命的博弈引发对AI发展路径的深思: OpenAI独特的“有限利润”营利子公司受非营利组织监督的结构,旨在平衡AI技术发展与人类福祉。然而,近期CEO Altman考虑将公司转为更传统的营利实体,引发了AI专家和法律学者的担忧。他们认为此举可能使关键决策者不再将OpenAI的慈善使命置于首位,削弱对投资者利润的限制,并可能改变AGI发展的时间表和方向。这场关于控制权、利润分配以及AI社会与道德塑造的博弈,凸显了在AI飞速发展时代,现有公司治理框架面临的挑战与漏洞。 (来源: 36氪)