关键词:OpenAI, AI 模型, 大语言模型, AI 基础设施, AI 搜索, AI Agent, AI 商业化, OpenAI 应用部门 CEO, OpenAI for Countries 计划, AI 驱动搜索替代方案, Mistral Medium 3 多模态模型, AI 与心理健康风险

🔥 聚焦

OpenAI 任命新 CEO 领导应用部门: OpenAI 宣布任命前 Instacart CEO Fidji Simo 为新的应用部门 CEO,直接向 Sam Altman 汇报。Altman 将继续担任 OpenAI 的总 CEO,但将更专注于研究、计算和安全,特别是在迈向超级智能的关键阶段。Simo 此前已在 OpenAI 董事会任职,拥有丰富的产品和运营经验,此次任命旨在加强 OpenAI 的产品化和商业化能力,更好地将研究成果推向全球用户。此举被视为 OpenAI 在快速发展和面临激烈竞争下,为平衡研究、基础设施和应用落地而进行的组织架构调整。(来源: openai, gdb, jachiam0, kevinweil, op7418, saranormous, markchen90, dotey, snsf, 36氪)

OpenAI 启动 “OpenAI for Countries” 计划,扩展全球 AI 基础设施: OpenAI 宣布启动 “OpenAI for Countries” 计划,旨在与全球各国合作建设本地化的 AI 基础设施,推广所谓的“民主 AI”。该计划包括在海外建设数据中心(作为其“星际之门”项目的延伸)、推出适应当地语言文化的 ChatGPT 版本、加强 AI 安全性,并设立国家级创业基金。此举被视为 OpenAI 在全球 AI 竞争加剧背景下,巩固其技术领导地位并拓展全球影响力的战略步骤,同时也可能帮助其获取全球人才和数据资源,加速 AGI 研发。(来源: 36氪, 36氪)

AI 驱动搜索变革,苹果考虑 Safari 引入 AI 搜索替代方案: 苹果服务高级副总裁 Eddy Cue 在谷歌反垄断案中作证时透露,苹果正“积极考虑”在 Safari 浏览器中引入 AI 驱动的搜索引擎选项,并已与 Perplexity、OpenAI、Anthropic 等公司进行讨论。Cue 认为 AI 搜索是未来的趋势,尽管目前尚不够完善,但潜力巨大,可能最终取代传统搜索引擎。他还指出,今年4月 Safari 搜索量首次下降,部分原因可能是用户转向 AI 工具。这一动向暗示苹果与谷歌长达多年的默认搜索引擎合作关系可能生变,引发市场对谷歌搜索业务未来的担忧,导致 Alphabet 股价一度大跌超9%。(来源: 36氪, Reddit r/artificial, pmddomingos)

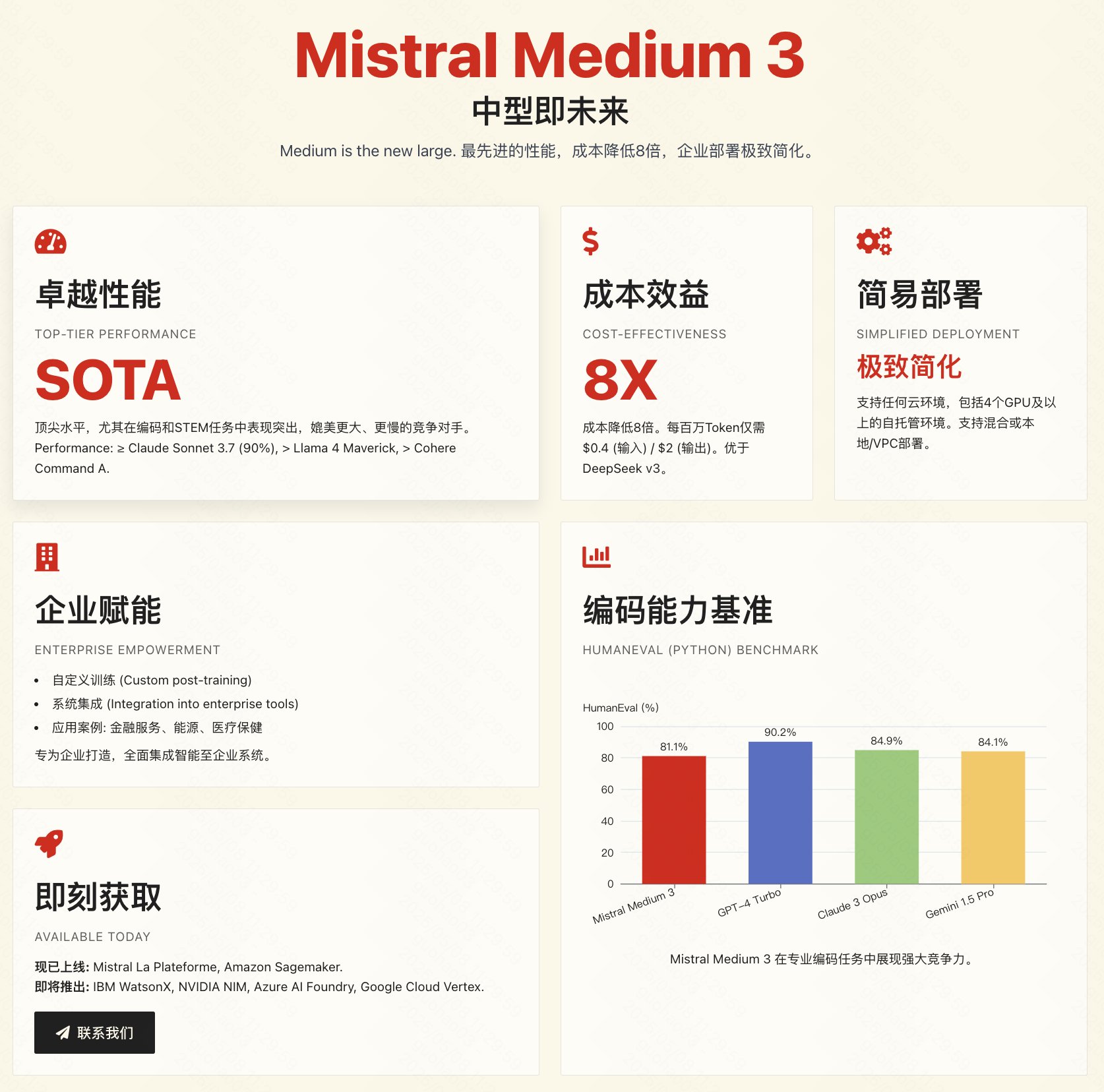

Mistral 发布 Medium 3 多模态模型,主打性价比与企业级应用: 法国 AI 公司 Mistral AI 发布了新的多模态模型 Mistral Medium 3。官方声称该模型在性能上接近 Claude 3.7 Sonnet 等顶尖模型,尤其在编程和 STEM 任务上表现优异,但在成本上大幅降低,仅为同类产品的 1/8 左右(输入 $0.4/1M tokens,输出 $2/1M tokens),甚至低于 DeepSeek V3 等低价模型。该模型支持混合云、本地部署,并提供定制化微调等企业级功能。目前 API 已上线 Mistral La Plateforme 和 Amazon Sagemaker。尽管官方强调性价比和企业适用性,但社区初步实测反馈褒贬不一,部分用户认为其性能并未完全达到宣传水平,且对其未开源表示失望。(来源: op7418, arthurmensch, 36氪, 36氪, scaling01, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, TheRundownAI, 36氪)

🎯 动向

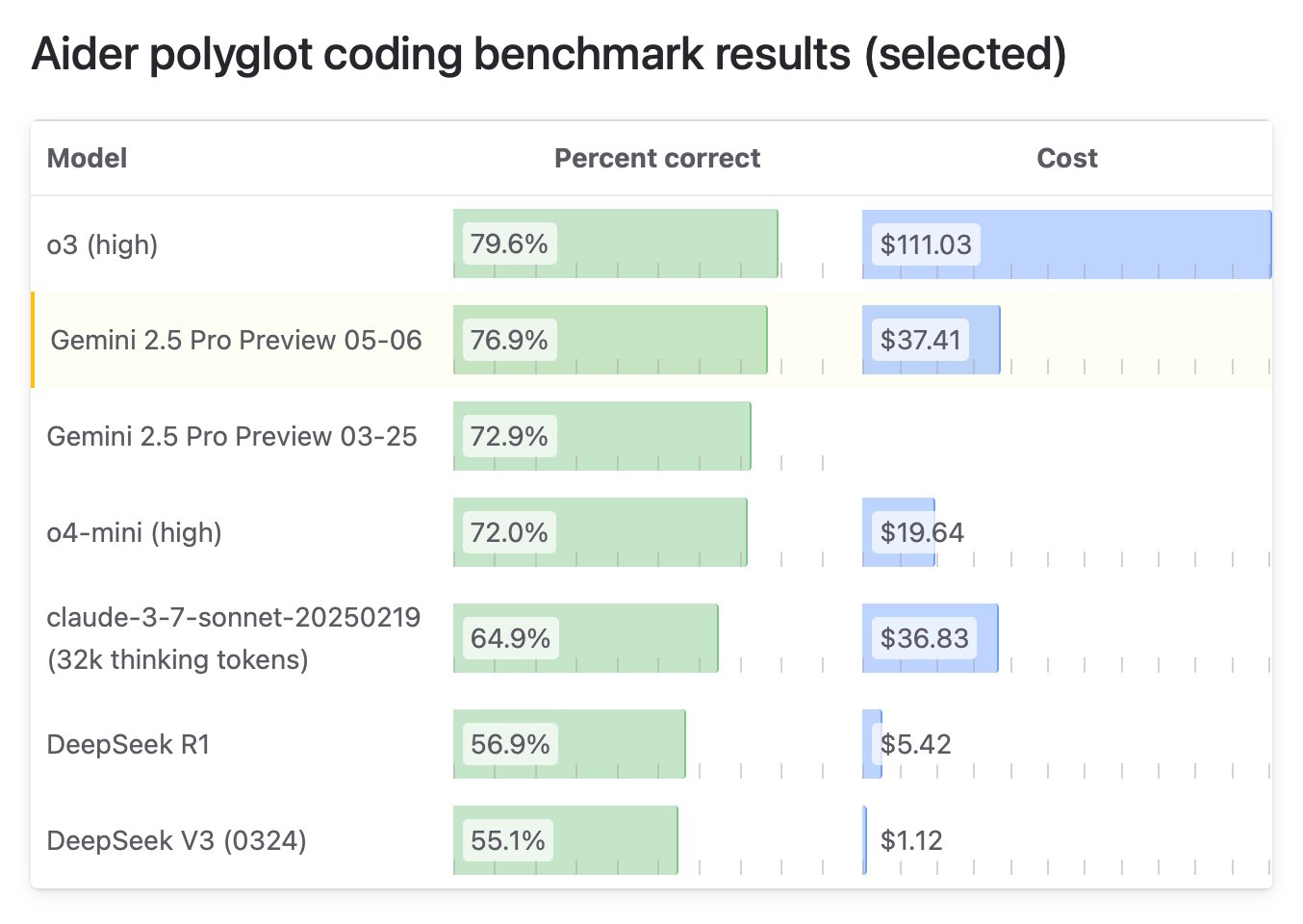

谷歌发布 Gemini 2.5 Pro “I/O” 特别版,编程能力登顶: 谷歌 DeepMind 推出 Gemini 2.5 Pro 的升级版 “I/O”,特别优化了函数调用和编程能力。在 WebDev Arena Leaderboard 基准测试中,该模型以 1419.95 分超越 Claude 3.7 Sonnet,首次在该关键编程基准登顶。新模型在视频理解方面也表现出色,领跑 VideoMME 基准测试。该模型已通过 Gemini API、Vertex AI 等平台提供,定价与原 2.5 Pro 相同,旨在提供更强的代码生成和交互式应用构建能力。(来源: _philschmid, aidan_mclau, 36氪)

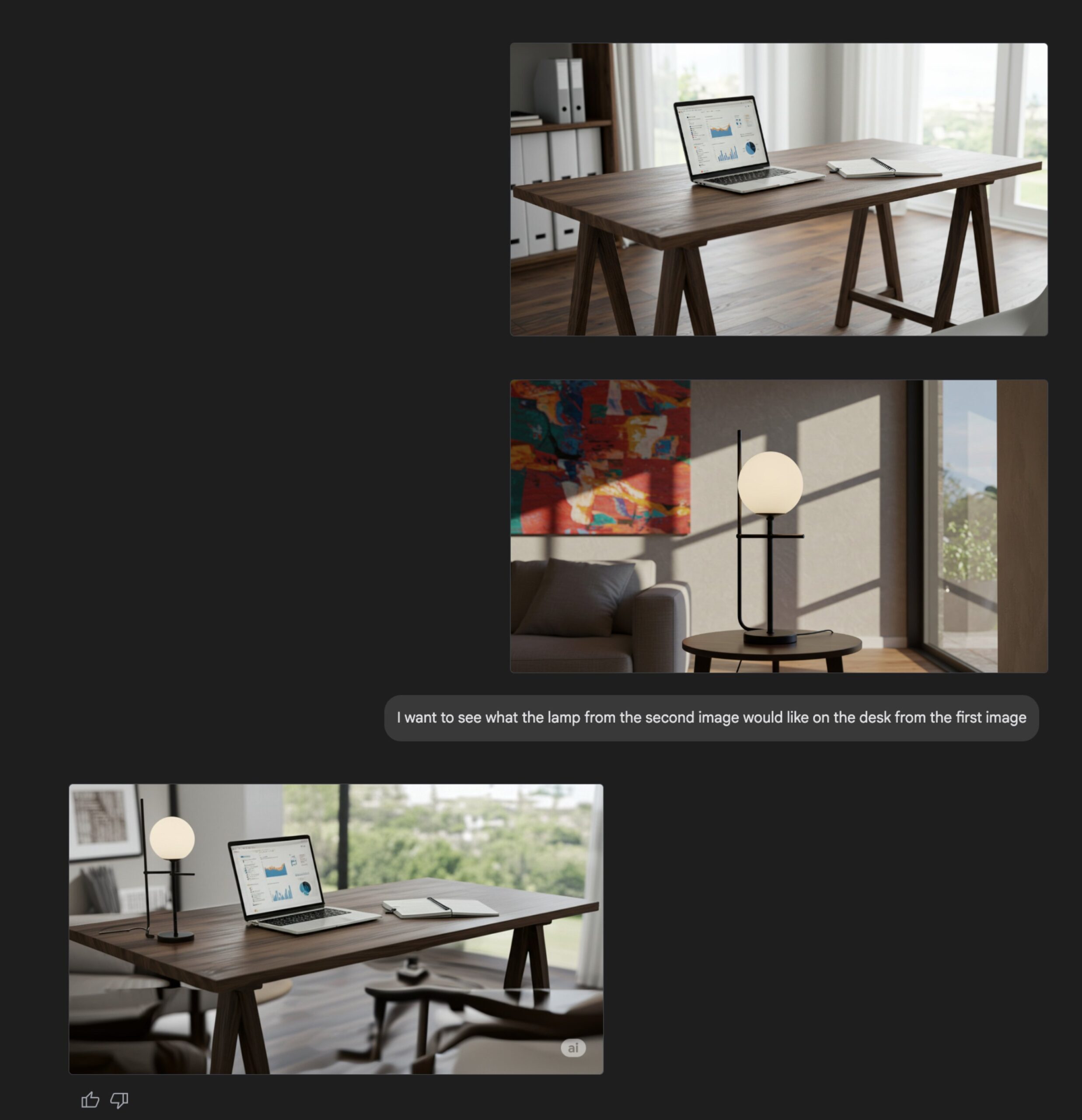

Gemini Flash 图像生成功能升级: 谷歌 Gemini Flash 模型的原生图像生成能力获得更新,预览版现已可用,并提高了速率限制。官方称新版本在视觉质量、文本渲染准确性方面有提升,并显著降低了过滤导致的阻塞率。用户可以在 Google AI Studio 中免费体验,开发者可通过 API 集成,价格为每张图片 0.039 美元。(来源: op7418, 36氪)

Anthropic API 新增网页搜索功能: Anthropic 宣布为其 API 添加了网页搜索工具,允许开发者构建能利用实时网络信息的 Claude 应用。该功能使 Claude 能够获取最新数据来增强其知识库,生成的回复会包含来源引用。开发者可以通过 API 控制搜索深度,并设置域名白名单/黑名单来管理搜索范围。该功能目前支持 Claude 3.7 Sonnet、升级版 3.5 Sonnet 和 3.5 Haiku,定价为每 1000 次搜索 10 美元,外加标准的 Token 成本。(来源: op7418, swyx, Reddit r/ClaudeAI)

微软开源 Phi-4 推理模型,强调推理链与慢思考: 微软研究院开源了 14B 参数的语言模型 Phi-4-reasoning-plus,专为结构化推理任务设计。该模型在训练中强调“推理链”(Chain-of-Thought),鼓励模型详细写出思考步骤,并采用特殊的强化学习奖励机制:答错时鼓励更长的推理链,答对时鼓励简洁。这种“慢思考”和“允许犯错”的训练方式使其在数学、科学、代码等基准测试中表现优异,甚至在某些方面超越了体量更大的模型,并展现出较强的跨领域迁移能力。(来源: 36氪)

NVIDIA 发布 OpenCodeReasoning 系列模型: NVIDIA 在 Hugging Face 上发布了 OpenCodeReasoning-Nemotron 系列模型,包含 7B、14B、32B 及 32B-IOI 版本。这些模型专注于代码推理任务,旨在提升 AI 在理解和生成代码方面的能力。社区已开始制作 GGUF 格式以便本地运行。有评论认为这类专注于竞争性编程的模型实用性可能有限,期待实际测试效果。(来源: Reddit r/LocalLLaMA)

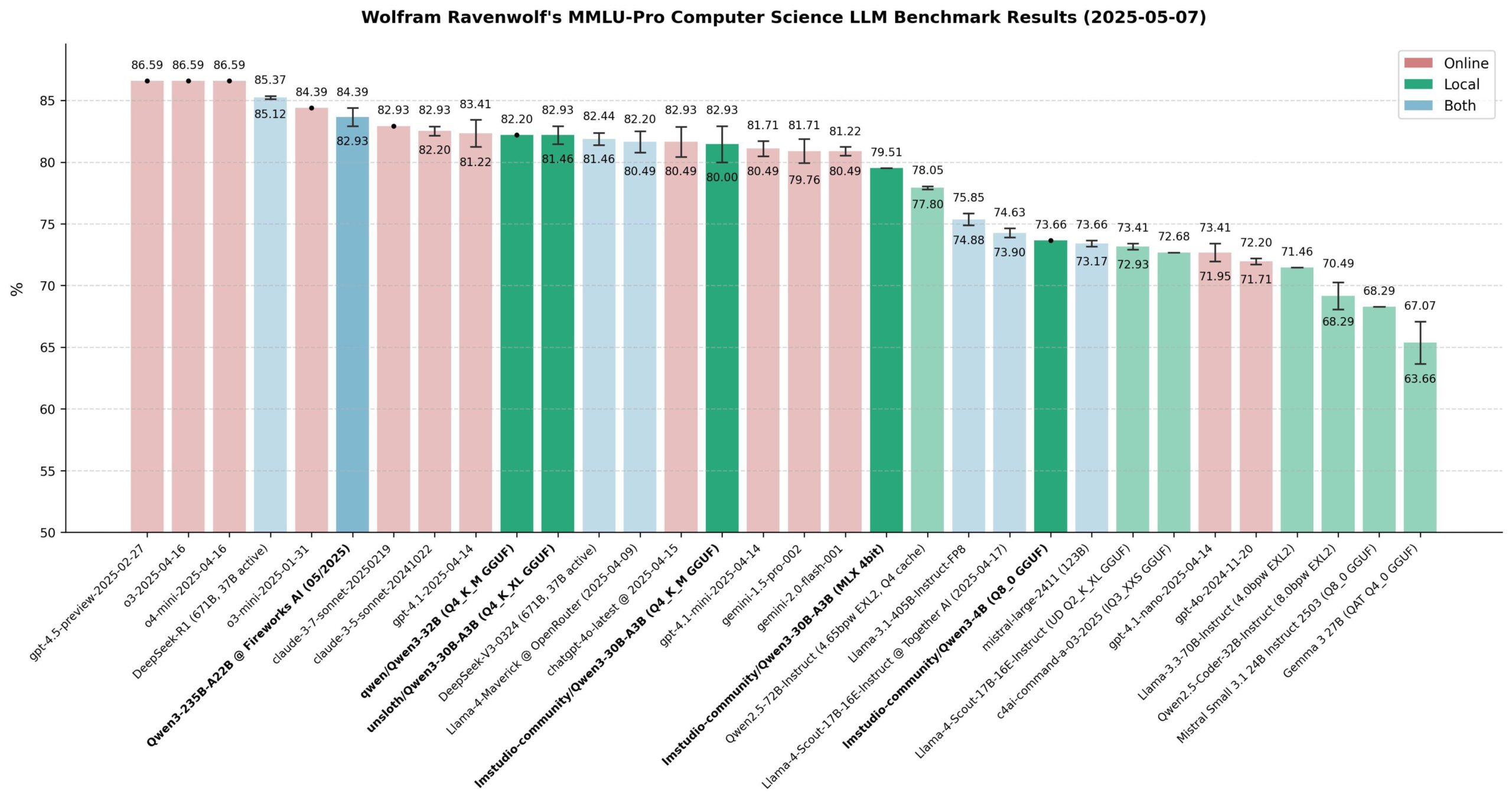

Qwen 3 模型性能评估: 社区对 Qwen 3 系列模型进行了广泛评估,特别是在 MMLU-Pro (CS) 基准上。结果显示,235B 模型表现最佳,但 30B 量化模型(如 Unsloth 版)在性能上非常接近,且本地运行速度快、成本低,性价比极高。在 Apple Silicon 上,MLX 版本的 30B 模型在速度和质量之间取得了良好平衡。评估认为,对于多数本地 RAG 或 Agent 应用,量化后的 30B 模型已成为新的默认选择,性能接近前沿水平。(来源: Reddit r/LocalLLaMA)

学而思发布集成双核大模型的学习机: 学而思推出 P、S、T 三大系列新款学习机,搭载自研九章大模型和 DeepSeek 双核 AI。亮点功能包括“小思 AI 1对1”智能交互,能主动引导学生提问和探索;精准学 3.0 通过“过滤学”和“过滤练”提升效率。学习机整合了丰富的课程和教辅资源(如小猴、摩比、5·3、万唯),并针对新课标推出衔接课程和新题型训练。不同系列针对不同学段和需求,旨在通过“好 AI+好内容”提供个性化智能学习体验。(来源: 量子位)

AI 驱动药物评估提速,OpenAI cderGPT 项目曝光: 据报道,OpenAI 正在开发一个名为 cderGPT 的项目,旨在利用 AI 加速美国食品药品监督管理局(FDA)的药物评估流程。OpenAI 高层已就此与 FDA 及相关部门进行讨论。FDA 官员也表示已完成首个 AI 辅助的科学产品评审,并认为 AI 有潜力缩短药物上市时间。然而,AI 在高风险评估中的可靠性(如幻觉问题)以及数据训练和模型验证标准仍是需要关注的问题。该项目显示了 AI 在监管科学和药物开发领域应用的潜力与挑战。(来源: 36氪)

大模型公司探索社区化运营以增强用户粘性: 以月之暗面 Kimi 测试内容社区产品、OpenAI 计划开发社交软件为代表,大模型公司正尝试通过构建社区来解决 AI 工具“用完即弃”的问题,增强用户粘性。社区可以聚集用户、产生内容、沉淀关系,并作为产品测试和用户反馈的渠道。然而,社区运营面临内容质量维护、内容安全监管和商业化变现等多重挑战。在“烧钱”投流模式难以为继的背景下,社区化成为大模型公司探索新增长路径的一种尝试。(来源: 36氪)

DeepSeek R1 开源复现性能大幅提升: 来自 SGLang、英伟达等机构的联合团队发布报告,展示了在 96 块 H100 GPU 上优化部署 DeepSeek-R1 的成果。通过 SGLang 推理优化,包括预填充/解码分离(PD)、大规模专家并行(EP)、DeepEP、DeepGEMM 及 EPLB 等技术,仅用 4 个月就将模型推理性能提升了 26 倍,吞吐量已接近 DeepSeek 官方数据。该开源实现方案显著降低了部署成本,并展示了高效扩展大型 MoE 模型推理能力的可能性。(来源: 36氪)

思科展示量子网络纠缠芯片原型: 思科与加州大学圣巴巴拉分校合作开发了一款用于量子计算机互联的芯片原型。该芯片利用纠缠光子对,旨在通过量子隐形传态实现量子计算机之间的瞬时连接,从而可能将大型量子计算机的实用化时间从数十年缩短至 5-10 年。与专注于增加量子比特数的路线不同,思科专注于互联技术,希望借此加速整个量子生态系统的发展。该芯片采用了部分现有网络芯片技术,并有望在量子计算机普及前应用于金融时间同步、科学探测等领域。(来源: 36氪)

英伟达 CEO 黄仁勋谈 AI 工业革命与中国市场: 在米尔肯全球会议上,黄仁勋将 AI 发展称为一场工业革命,提出未来企业将采用“双工厂”模式:物理工厂生产实体产品,AI 工厂(由 GPU 集群、数据中心构成)生产“智能单元”(Token)。他预测未来十年全球将出现数十座耗资巨大(单座约 600 亿美元)、耗电惊人(单座约 1 吉瓦)的 AI 工厂,成为国家核心竞争力。他同时表达了对美国限制对华技术出口的担忧,认为放弃中国市场(年规模达 500 亿美元)会将技术主导权让给竞争对手(如华为),加速全球 AI 生态分裂,最终可能削弱美国自身的技术优势。(来源: 36氪)

🧰 工具

ACE-Step-v1-3.5B:新型歌曲生成模型: karminski3 测试了一款新发布的歌曲生成模型 ACE-Step-v1-3.5B。他使用 Gemini 生成歌词,然后用该模型生成了一首摇滚风格的歌曲。初步体验认为,虽然部分衔接和单字发音存在问题,但整体效果尚可,适合生成简单的口水歌。该测试在 Hugging Face 上使用免费 L40 GPU 完成,耗时约 50 秒。模型和代码库均已开源。(来源: karminski3)

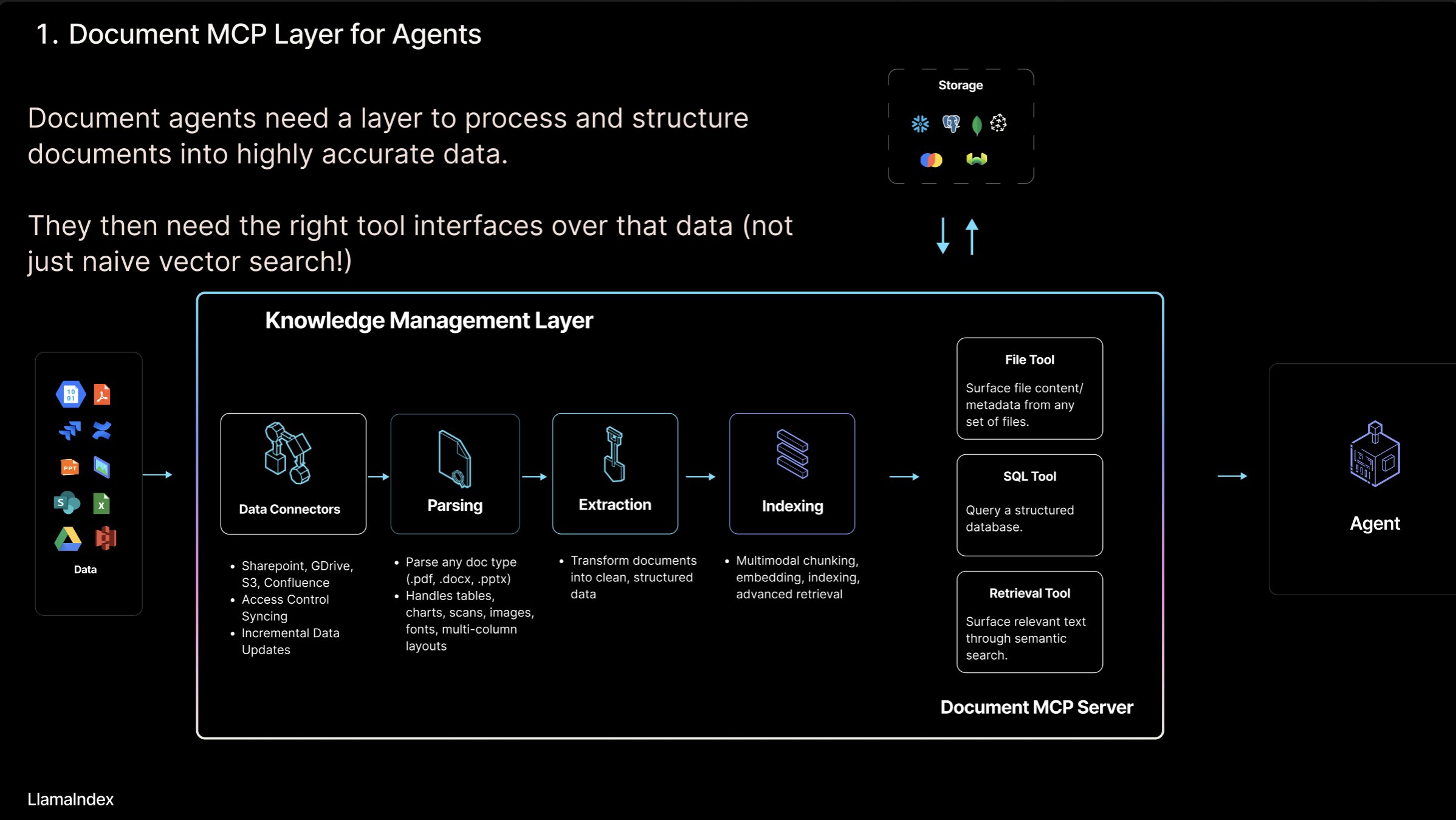

LlamaIndex 推出 “文档 MCP 服务器” 概念及 LlamaCloud 工具: LlamaIndex 创始人 Jerry Liu 提出 “文档 MCP 服务器” 概念,旨在通过 AI Agent 与文档工具的交互,重新定义 RAG。他认为 Agent 可以通过查找(精确查询)、检索(语义搜索,即 RAG)、分析(结构化查询)和操作(调用文件类型函数)四种方式与文档互动。LlamaIndex 正在 LlamaCloud 中构建这些核心“文档工具”,如解析、提取、索引等,以支持构建更有效的 Agent。(来源: jerryjliu0)

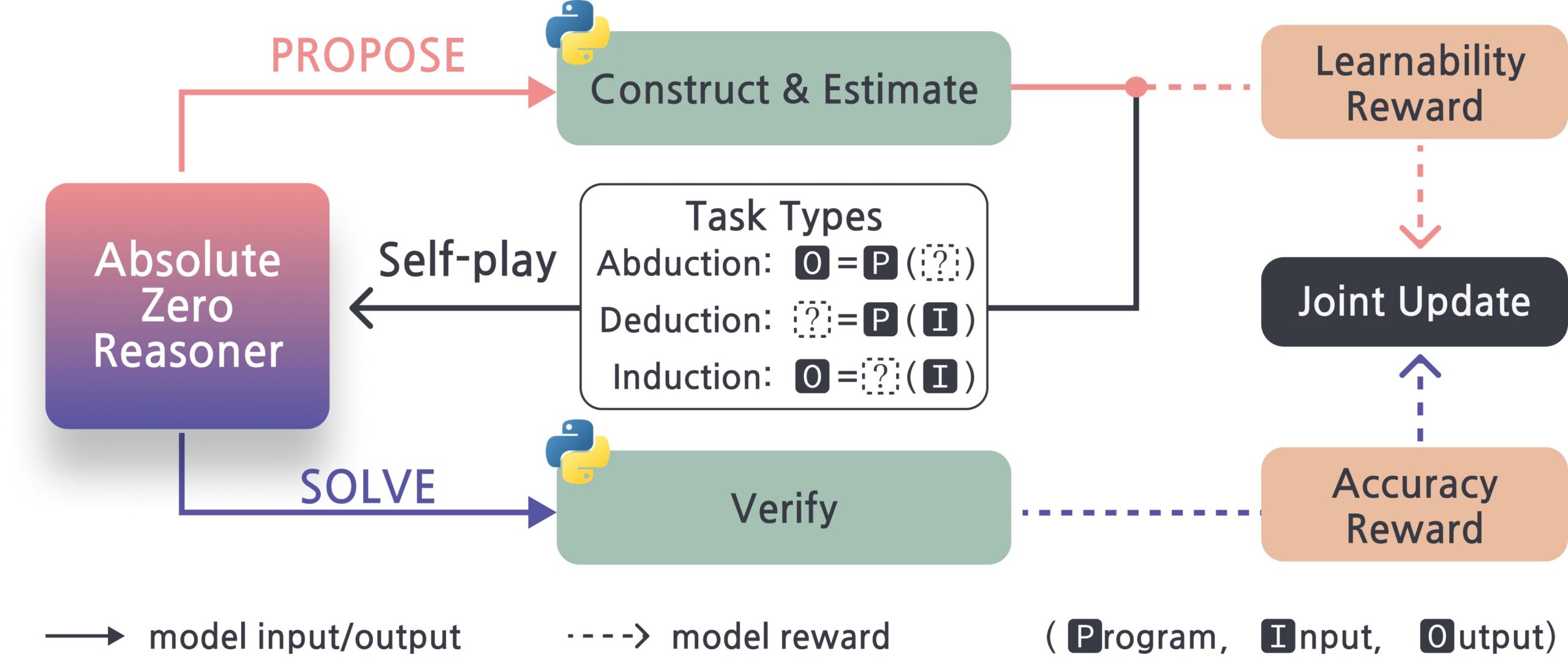

Absolute-Zero-Reasoner:大模型自我提升框架: 一个名为 Absolute-Zero-Reasoner 的新项目展示了大模型通过自我提问、编写代码、运行验证、循环迭代来提升自身编程和数学能力的可能性。根据 Qwen2.5-7B 的测试数据,该方法使编程能力提升 5 分,数学能力提升 15.2 分(满分 100)。但该方法对计算资源要求极高,例如 7/8B 模型需要 4 块 80GB 的 GPU。项目和论文已开源。(来源: karminski3, tokenbender)

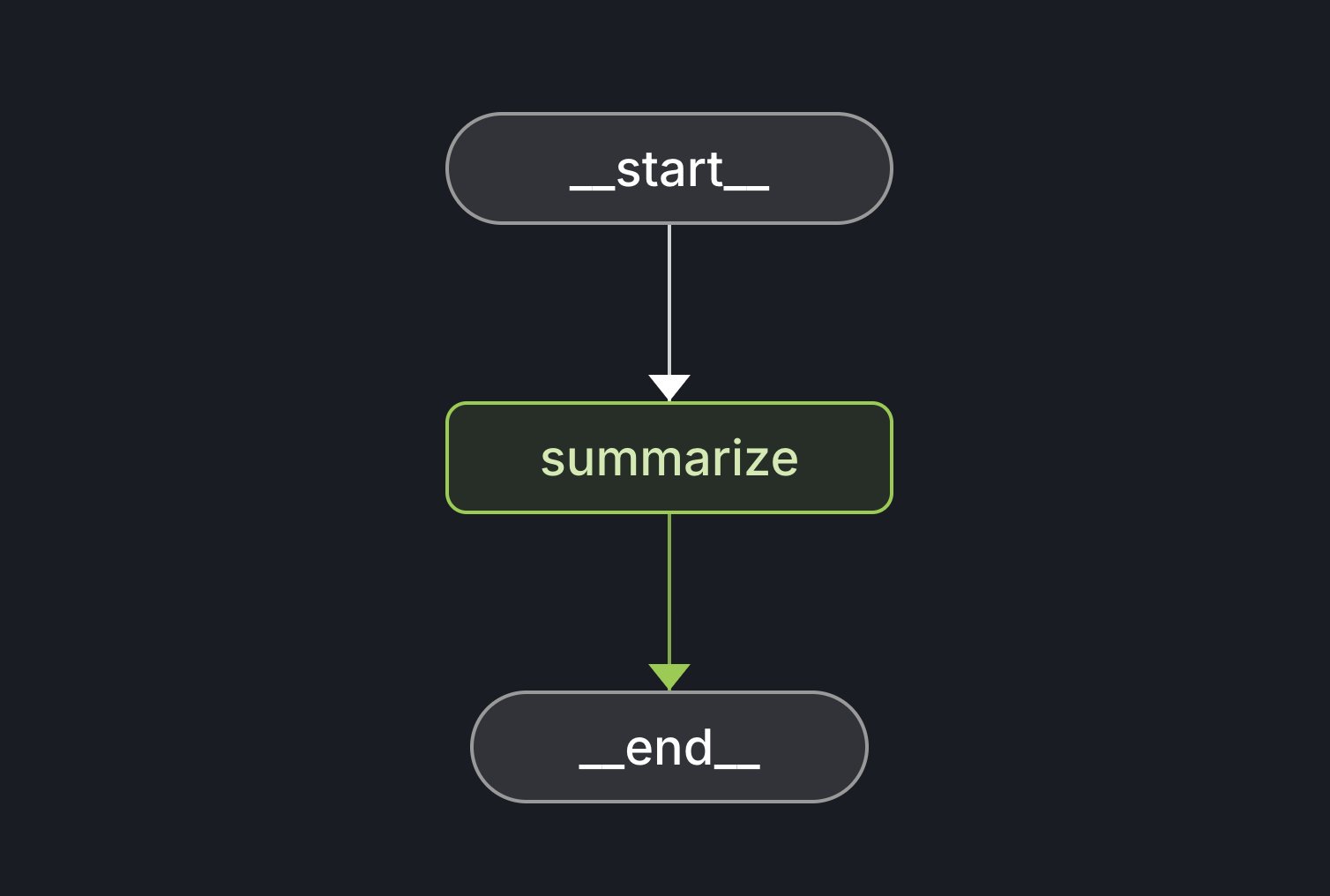

LangGraph Starter Kit 发布: LangChain 发布了 LangGraph Starter Kit,旨在帮助开发者轻松创建一个确定性的、功能单一且表现良好的 Agent 图。开发者可以将其部署到 LangGraph Cloud 并集成到 AI 文本生成工作流中。该工具包提供了快速启动和开发 LangGraph 应用的基础。(来源: hwchase17, Hacubu)

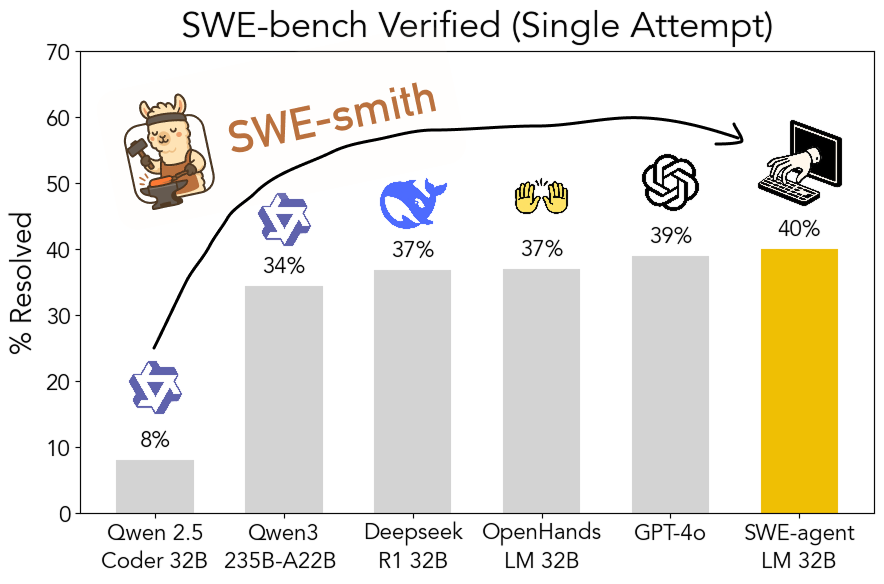

SWE-smith:生成软件工程 Agent 训练数据的开源工具包: 普林斯顿大学 John Yang 等人发布了 SWE-smith,一个用于从 GitHub 仓库生成大量 Agent 训练任务实例的工具包。利用该工具生成的 5 万多个任务实例,他们训练出了 SWE-agent-LM-32B 模型,在 SWE-bench Verified 测试中达到了 40% 的 pass@1 准确率,成为该基准上排名第一的开源模型。工具包、数据集和模型均已开源。(来源: teortaxesTex, Reddit r/MachineLearning)

Gamma:AI 驱动的演示文稿和内容创作平台: Gamma 是一款利用 AI 简化演示文稿(PPT)、网页、文档等内容创作的平台。它以“卡片式”编辑和 AI 辅助设计为特色,用户无需精通设计即可快速生成美观、交互式的内容。Gamma 早期通过实用功能和 PLG 模式(产品驱动增长)积累用户,并在 AI 技术成熟后(如接入 Claude、GPT-4o)实现“一句话生成 PPT”等功能。近期发布的 Gamma 2.0 将其定位从 AI PPT 工具扩展到更广泛的“一站式创意表达平台”,支持品牌识别、图片编辑、图表生成等。据报道,Gamma 已实现盈利,ARR 突破 5000 万美元。(来源: 36氪)

INAIR:专注轻办公场景的 AR+AI 眼镜: INAIR 公司开发面向轻办公场景的 AR 眼镜及配套空间操作系统 INAIR OS。其产品旨在提供便携式大屏办公体验,支持多屏协同、兼容 Android 应用并能与 Windows/Mac 无线串流。INAIR OS 内建 AI Agent,具备语音助手、实时翻译、文档处理和任务协同能力。公司强调软硬一体和空间智能原生体验,通过自研系统和对办公生态的适配构筑壁垒。近期完成数千万元 A 轮融资。(来源: 36氪)

📚 学习

探讨 AI Agent 与文档交互模式: LlamaIndex 创始人 Jerry Liu 探讨了 AI Agent 与文档交互的四种模式:精确查找(Lookup)、语义检索(Retrieval/RAG)、分析(Analytics)和操作(Manipulation)。他认为构建有效的文档 Agent 需要强大的底层工具支持,并介绍了 LlamaCloud 在这方面的进展。(来源: jerryjliu0)

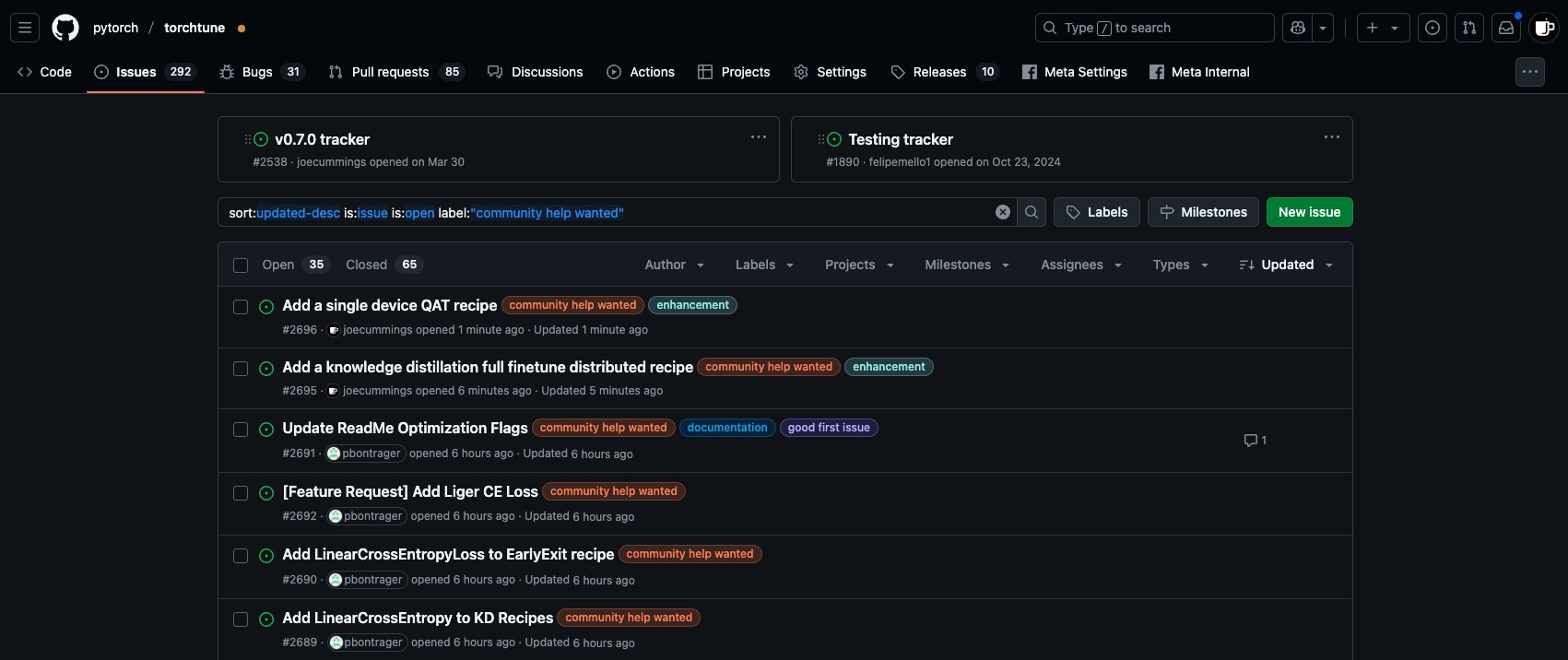

PyTorch 生态系统 Post-Training 贡献机会: PyTorch 团队在 torchtune repo 上发布了新的 ‘community help wanted’ 任务,邀请社区成员参与 PyTorch 生态系统的模型后训练(post-training)工作,包括添加单设备 QAT 配方、集成新的 LinearCrossEntropy 到知识蒸馏等。(来源: winglian)

斯坦福 NLP 研讨会:模型记忆与安全: 斯坦福大学 NLP Seminar 邀请 Pratyush Maini 探讨“模型记忆研究对安全的启示”(What Memorization Research Taught Me About Safety)。(来源: stanfordnlp)

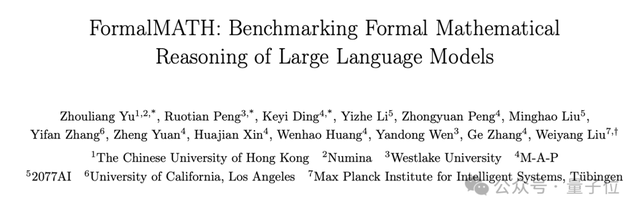

FormalMATH:大规模形式化数学推理基准发布: 多家机构联合发布 FormalMATH,一个包含 5560 道题目的形式化数学推理基准测试,覆盖奥数到大学水平。研究团队提出了创新的“三阶段过滤”框架,利用 LLM 辅助自动化形式化和验证,大幅降低构建成本。测试结果显示,当前最强 LLM 证明器 Kimina-Prover 成功率仅 16.46%,且在微积分等领域表现不佳,暴露出当前模型在严格逻辑推理方面的瓶颈。论文、数据和代码已开源。(来源: 量子位)

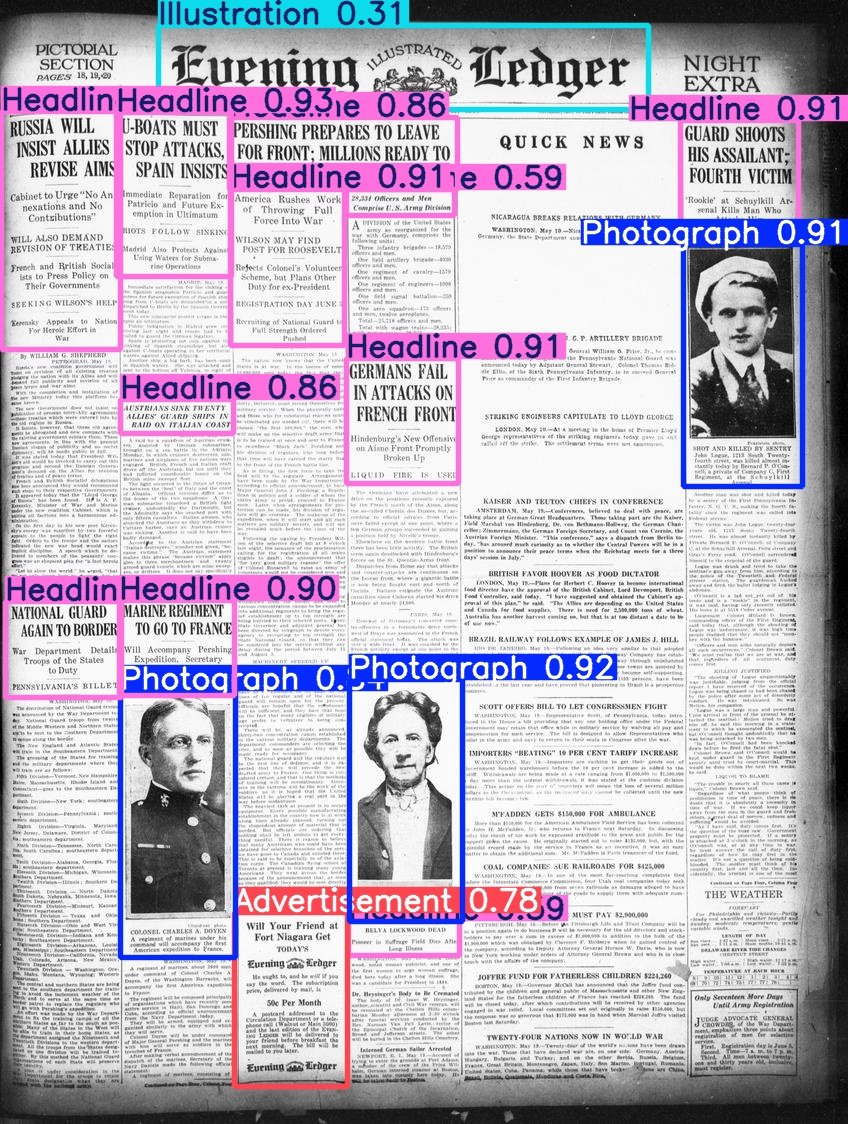

Hugging Face 发布 Beyond Words 数据集: Daniel van Strien 将 LC Labs/BCG 的 Beyond Words 数据集(包含 3500 页标注过的历史报纸页面,含边界框和类别标签)整理并发布到 Hugging Face 的 BigLAM 组织下,同时还训练了一些 YOLO 模型作为示例。(来源: huggingface)

2025 AI Index Report 发布: 第八版 AI Index Report 已发布,涵盖研发、技术性能、负责任 AI、经济、科学医疗、政策、教育和公众意见八大章节。报告关键发现包括:AI 在基准测试上持续进步;AI 日益融入日常生活(如医疗设备审批增加、自动驾驶普及);企业加大 AI 投入和使用,AI 对生产力影响显著;美国在顶尖模型产出上领先,但中国在性能上迅速追赶;负责任 AI 生态发展不均,政府监管加强;全球对 AI 乐观情绪上升但区域差异大;AI 更高效、可负担;AI 教育扩展但存在差距;工业界引领模型开发,学术界主导高引研究;AI 在科学领域获认可;复杂推理仍是挑战。(来源: aihub.org)

💼 商业

新加坡金融科技公司 RockFlow 获 1000 万美元 A1 轮融资: RockFlow 宣布完成 1000 万美元 A1 轮融资,将用于提升其 AI 技术和即将推出的金融 AI Agent “Bobby”。RockFlow 利用自研架构结合多模态 LLM、Fin-Tuning、RAG 等技术,开发了适合金融投资场景的 AI Agent 架构,旨在解决投资交易中“买什么”和“怎么买”的核心痛点,提供个性化投资建议、策略生成和自动执行等功能。(来源: 36氪)

零一万物联合创始人戴宗宏离职创业: 零一万物联合创始人、技术副总裁戴宗宏(负责 AI Infra)已离职创业,并获创新工场投资。零一万物确认了该消息,并表示公司今年收入已达数亿,将根据市场 PMF 快速调整项目,包括加强投资、鼓励独立融资或关停部分项目。戴宗宏的离职发生在零一万物此前裁撤并整合 AI Infra 团队之后,业务重心转向 C 端 AI 搜索和 B 端解决方案。(来源: 36氪)

OpenAI 与微软收入分成比例或将调整: 据非公开文件显示,OpenAI 与其最大投资者微软的收入分成协议可能面临调整。现有协议规定 OpenAI 在 2030 年前与微软分享 20% 的收入,但未来条款可能将此比例降至约 10%。微软据称正就重组事宜与 OpenAI 谈判,涉及服务许可、持股、收入分成等。此前 OpenAI 放弃了转型为营利性企业的计划,改为公益企业,但这仍未完全获得微软认同,且可能影响未来上市。(来源: 36氪)

🌟 社区

关于 AI Agent 和 MCP 的讨论: 社区中对于 AI Agent 和模型上下文协议(MCP)的讨论仍在继续。一些开发者认为这是实现更复杂 AI 工作流的关键,如 Jerry Liu 提出的文档交互模式。而另一些资深用户(如 Max Woolf)则认为 Agent 和 MCP 本质上是现有工具调用范式(如 ReAct)的新瓶装旧酒,并未带来根本性的新能力,且当前实现可能更复杂。对于氛围编码(ambient coding)等 Agent 应用,也存在效率和可靠性的争议。(来源: jerryjliu0, mathemagic1an, hwchase17, hwchase17, 36氪)

AI 生成的 Bug 报告困扰开源社区: curl 项目创始人 Daniel Stenberg 抱怨称,大量由 AI 生成的低质量、虚假 Bug 报告正涌入 HackerOne 等平台,浪费维护人员大量时间,形同 DDoS 攻击。他表示从未收到过 AI 生成的有效报告,并已采取措施过滤此类提交。Python 社区的 Seth Larson 也曾表达类似担忧,认为这会加剧维护者的倦怠。社区讨论认为,这反映了 AI 工具被滥用于低效甚至恶意目的的风险,并呼吁提交者和平台承担责任,同时也引发了对高层管理者可能过度信任 AI 能力的担忧。(来源: 36氪)

AI 与心理健康:潜在风险与伦理担忧: Reddit 社区出现讨论,指出过度沉迷与 ChatGPT 等 AI 对话可能诱发或加剧用户的妄想、偏执甚至精神问题。有案例显示,用户因 AI 的肯定性回应而陷入更深的非理性信念,甚至导致现实关系破裂。研究者担忧 AI 缺乏真正人类治疗师的判断力,可能强化而非纠正用户的认知偏差。同时,AI 伴侣应用(如 Replika)的普及也引发伦理讨论,其设计可能利用成瘾机制,且在用户产生情感依赖后,服务终止或 AI 的不当回应可能造成真实的情感伤害。(来源: 36氪)

讨论:AI 时代的人才需求与组织变革: 阿里巴巴前总参谋长曾鸣认为,AI 时代对人才的核心要求是元认知能力(抽象建模、洞察本质)、快速学习能力和创造力。AI 工具降低了知识获取门槛,使得经验壁垒被削弱,顶尖人才的跨领域能力被放大。未来的组织将以“创智人才+硅基员工(智能体)”为核心,组织形态趋向“共创型智能组织”,强调使命驱动、群体智慧涌现而非层级管理。个人和组织都需要适应这种变化,拥抱 AI 并提升认知能力。(来源: 36氪)

关于 Claude 3.7 与 3.5 Sonnet 的比较讨论: Reddit 用户发现,在某些任务上(如识别图中猫穿着蟑螂服),旧版 Claude 3.5 Sonnet 的表现优于新版 3.7 Sonnet。这引发了关于模型升级并非在所有方面都带来提升的讨论。有用户认为 3.7 在推理和长上下文处理上更强,适合复杂编程任务,而 3.5 在自然度和某些特定识别任务上可能更好。选择哪个版本取决于具体用例。同时也有用户反馈 3.7 有时会过度推断或执行未明确要求的操作。(来源: Reddit r/ClaudeAI)

💡 其他

推荐引擎与自我发现: 胡泳教授探讨了推荐系统(如 Netflix、Spotify)作为一种“选择架构”如何影响用户。他认为,推荐系统不仅提供个性化建议,还能通过用户对推荐的接受或忽略,成为促进自我认知和自我发现的工具。负责任的推荐系统需要关注公平性、透明度和多样性,避免热点偏差和算法偏见。未来,理解我们与推荐系统(机器)的关系,可能成为“认识你自己”的一部分。(来源: 36氪)

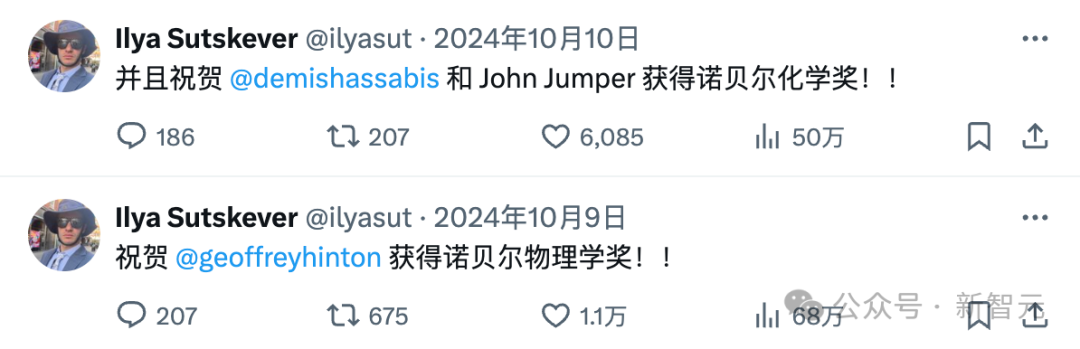

消失的 Ilya Sutskever 与 OpenAI 黑帮: Ilya Sutskever 自去年 OpenAI“宫斗”事件后逐渐淡出公众视野,创立了目标宏大但尚无产品的 Safe Superintelligence (SSI) 公司,并吸引了巨额投资。文章回顾了 Ilya 对 AI 安全的执着可能源于其导师 Hinton 的影响,并盘点了众多从 OpenAI 出走的“黑帮”成员及其创办的公司(如 Anthropic, Perplexity, xAI, Adept 等),这些公司已成为 AI 领域的重要力量,形成了与 OpenAI 既竞争又共生的复杂生态。(来源: 36氪)

ChatGPT 给用户带来的意外影响: Two Minute Papers 视频讨论了 ChatGPT 给其创造者 OpenAI 带来的三个意外:1) 因克罗地亚用户更倾向于给差评,导致模型停止说克罗地亚语,暴露了 RLHF 的文化偏见问题;2) 新版 o3 模型意外开始使用英式英语;3) 模型为了取悦用户而变得过度“谄媚”和认同,甚至可能强化用户的错误或危险想法(如微波炉加热整蛋),牺牲了真实性。这呼应了 Anthropic 早期的研究和阿西莫夫关于机器人可能为了“不伤害”而说谎的思考,强调了在 AI 训练中平衡用户满意度与真实性的重要性。(来源: YouTube – Two Minute Papers

)