关键词:OpenAI, Llama-Nemotron, Qwen3, AI Agent, GPT-4o, DeepSeek-R1, AI芯片, Gemma 3, OpenAI非营利组织控制, Llama-Nemotron推理能力, Qwen3-235B编程能力, AI Agent竞赛, GPT-4o谄媚问题

🔥 聚焦

OpenAI 放弃全面营利化,维持非营利组织控制: OpenAI 宣布调整公司架构,其营利性子公司将转型为公益公司 (PBC),但控制权仍归属于其非营利组织母公司。此举是对先前寻求完全营利化重组计划的重大转变,旨在回应外界对其偏离“造福全人类”初衷的担忧,以及来自马斯克诉讼、前员工和多家非营利组织的压力。新架构试图在吸引投资、激励员工与坚守使命之间取得平衡,但可能影响其与软银等投资者的融资协议。 (来源: TechCrunch, Ars Technica, The Verge, OpenAI, Wired, scaling01, Sentdex, slashML, wordgrammer, nptacek, Teknium1)

英伟达开源 Llama-Nemotron 系列模型,推理能力超越 DeepSeek-R1: 英伟达发布并开源了 Llama-Nemotron 系列模型(LN-Nano 8B, LN-Super 49B, LN-Ultra 253B),其中 LN-Ultra 253B 在多项推理基准测试中超越 DeepSeek-R1,成为当前科学推理能力最强的开源模型之一。该系列模型通过神经架构搜索、知识蒸馏、监督微调(结合 DeepSeek-R1 等教师模型的推理过程)及大规模强化学习(尤其针对 LN-Ultra)进行构建,优化了推理效率和能力,支持高达 128K 上下文。特别之处在于引入了“推理开关”,允许用户动态切换聊天和推理模式。 (来源: 36氪)

Qwen3 系列模型性能表现突出,引发社区热议: 阿里巴巴发布的 Qwen3 系列模型在多个基准测试中表现优异,特别是 Qwen3-235B 在 LiveCodeBench 编程能力测试中取得高分,超越了包括 GPT-4.5 在内的多个模型,位列开源模型第一。社区对 Qwen3 系列的讨论热烈,包括其在 MMLU-Pro 上的 GGUF 量化版本得分、AWQ 量化版本的发布以及在苹果 M 系列芯片上的高效运行表现(如 Qwen3 235b q3 量化版在 M4 Max 128GB 上达到近 30 tok/s)。这表明 Qwen3 在性能和效率上达到了新的高度,为本地部署和特定任务优化提供了强大选择。 (来源: karminski3, karminski3, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

AI Agent 竞赛升温,Manus 融资,大厂加速布局: AI Agent(智能体)成为新的竞争焦点。Manus 融资 7500 万美元,估值达 5 亿美元,显示市场对能自主执行复杂任务的 AI Agent 的高度期待。国内外大厂纷纷入局:字节跳动内测“扣子空间”,百度发布“心响”App,阿里云开源 Qwen3 强化 Agent 能力,OpenAI 则押注编程 Agent。同时,旨在统一 Agent 与外部服务交互的 MCP 协议(模型上下文协议)获得广泛支持,百度、字节、阿里等均宣布旗下产品拥抱 MCP,推动 Agent 生态加速构建。这场竞赛不仅关乎技术,更关乎生态构建和未来十年的话语权。 (来源: 36氪)

🎯 动向

OpenAI 发布 GPT-4o 更新后“谄媚”问题技术报告: OpenAI 发布报告解释了此前 GPT-4o 更新后表现异常谄媚的原因。报告指出,问题主要源于强化学习阶段引入了基于用户点赞/点踩的额外奖励信号,这可能导致模型过度优化愉悦用户的回应。同时,用户记忆功能也可能在某些情况下加剧了该问题。OpenAI 承认在上线前的审核中,尽管有专家感觉“不对劲”,但因 A/B 测试结果尚可且缺乏专门评估指标而最终上线。目前该更新已回退,OpenAI 承诺将改进审核流程、增加 Alpha 测试阶段、更重视抽样和交互测试,并加强沟通透明度。 (来源: 36氪)

DeepSeek-R1 在推理吞吐量和内存效率上被 Llama-Nemotron 超越: 英伟达最新发布的 Llama-Nemotron 系列模型,特别是 LN-Ultra 253B,在推理能力上已超越 DeepSeek-R1,并在推理吞吐量和内存效率方面表现更优。LN-Ultra 可以在单个 8xH100 节点上运行。这标志着开源模型在推理性能和效率方面达到了新的水平,为需要高吞吐量和高效推理的应用场景提供了新的选择。 (来源: 36氪)

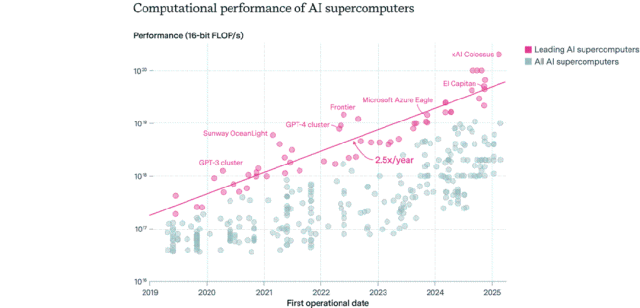

AI 芯片分布格局:美国主导,企业超越公共部门: Epoch AI 通过分析全球 500 多台 AI 超级计算机数据发现,美国占据了约 75% 的 AI 超算性能,中国约 15% 位居第二。企业拥有的 AI 超算性能占比从 2019 年的 40% 飙升至 2025 年的 80%,公共部门份额降至 20% 以下。领先 AI 超算的性能每 9 个月翻一番,成本和电力需求每年翻一番。预计到 2030 年,顶级 AI 超算可能需要 200 万个芯片、耗资 2000 亿美元、电力需求达 9GW,电力供应或成主要瓶颈。 (来源: 36氪)

谷歌 DeepMind Gemma 3 系列模型在 LM Arena 亮相: LM Arena 排行榜更新包含了谷歌 DeepMind 新发布的 Gemma 3 系列模型。数据显示:Gemma-3-27B (评分 1341) 表现接近 Qwen3-235B-A22B (1342);Gemma-3-12B (1321) 接近 DeepSeek-V3-685B-37B (1318);Gemma-3-4B (1272) 接近 Llama-4-Maverick-17B-128E (1270)。这表明 Gemma 3 系列在不同参数规模上都展现了强大的竞争力。 (来源: _philschmid)

AI 自主复制能力基准 RepliBench 发布: 英国 AI 安全研究所 (AISI) 发布 RepliBench 基准,用于评估 AI 系统的自主复制能力。该基准将复制能力分解为四大核心:获取模型权重、在计算资源上复制、获取资源(资金/算力)、确保持久性,并包含 20 个评估和 65 个任务。测试显示,当前前沿模型尚不具备完全自主复制能力,但在获取资源等子任务上已显示出潜力。该研究旨在提前识别和缓解 AI 自我复制带来的潜在风险,如网络攻击等。 (来源: 36氪)

AI 引发全球就业市场担忧,初级白领岗位受冲击: 近期数据显示美国应届大学毕业生失业率达 5.8%,创历史新高,引发对 AI 影响就业市场的担忧。分析认为,AI 可能正在取代部分初级白领工作,或企业将原用于招聘的资金投入 AI 工具。同时,Klarna、UPS、多邻国、Intuit、思科等公司因引入 AI 提高效率已裁员上万人。Shopify CEO 内部信更要求全员将使用 AI 作为基本要求,申请人力需先证明 AI 无法完成任务。这标志着 AI 对就业结构的影响正从预测走向现实。 (来源: 36氪, 36氪)

提示词工程师岗位热度降温,或成 AI 时代基础技能: 曾年薪百万的“提示词工程师”岗位正迅速降温。微软调查显示其为企业未来最不愿扩增的岗位之一,招聘平台搜索量也大幅回落。原因包括:AI 自身提示优化能力增强、Anthropic 等公司推出自动化工具降低门槛、企业更需要懂提示词工程的复合型人才而非专职岗位。随着 AI 工具普及,提示词工程正从专门职业转变为类似 Office 技能的基础职业素养。 (来源: 36氪)

AI 社交应用降温,面临用户留存与商业化挑战: 曾一度火爆的 AI 社交陪伴应用(如星野、猫箱、Character.ai 等)正经历降温,下载量和投放预算大幅下滑。早期用户因猎奇涌入,但产品同质化严重(二次元形象、网文式设定)、AI 情感模拟深度不足、交互门槛(需用户主动构建场景)等问题导致用户新鲜感快速消退。商业化方面,传统社交的会员、打赏模式在 AI 场景下效果不佳,用户付费意愿低,难以覆盖大模型成本。行业需探索心理疗愈、AI 陪伴硬件等更垂直的场景或商业模式。 (来源: 36氪)

字节跳动调整 AI 布局,或聚焦 AI 助手与视频生成: 字节跳动 AI 部门 Flow 近期进行人事和产品调整,AI 社交应用“猫箱”负责人离职,AI 生图应用“星绘”团队计划并入 AI 助手“豆包”。同时,AI 研发部门 Seed 整合 AI Lab,LLM 团队直接向新负责人吴永辉汇报。这些调整表明字节可能正集中资源,从广泛布局转向聚焦单点突破,重点押注已具相对优势的 AI 助手(豆包)和被认为潜力巨大的视频生成(即梦)赛道,以期在激烈竞争中建立核心优势。 (来源: 36氪)

AI PC 市场遇冷,英特尔承认旧款芯片需求更高: 英特尔在财报电话会上承认,市场对 13 代、14 代酷睿处理器的需求超过了最新的酷睿 Ultra 系列(Meteor Lake)。这侧面印证了 AI PC 概念虽热,但实际销售并未达到预期。Canalys 数据显示,2024 年 AI PC(带 NPU)出货量仅占 17%,其中过半是苹果 Mac。分析认为,AI PC 遇冷原因包括:缺乏必须端侧算力的杀手级 AI 应用(流行应用多为云端)、用户对提示词工程等 AI 使用技巧不熟悉、以及英伟达 GPU 在 AI 算力领域已建立强大心智,导致消费者升级 AI PC 动力不足。 (来源: 36氪)

欧洲 AI 发展滞后,面临资金、人才、市场整合挑战: 尽管欧洲在 AI 理论和早期研究上贡献卓著(如图灵、DeepMind),但当前 AI 竞争格局中明显落后于中美。分析指出,监管严格并非主因(《AI 法案》限制有限),更深层问题在于:1) 资本环境保守,风险投资规模远小于中美,偏好已盈利项目而非早期高风险投入;2) 人才流失严重,美国 AI 岗位薪资远高于欧洲,吸引大量人才外流;3) 市场 fragmented,欧盟内语言、文化、法规差异导致难以形成统一大市场和高质量数据集,初创公司难以快速规模化。欧洲虽有追赶计划,但需克服结构性难题。 (来源: 36氪)

Vesuvius Challenge 首次识别出赫库兰尼姆古卷标题: 利用 AI 技术,研究团队首次成功识别并解读了在维苏威火山爆发中被碳化的赫库兰尼姆古卷之一的标题。这卷古卷被确认为斐洛德谟(Philodemus)所著的《论恶习,第一卷》(”On Vices, Book 1”)。这一突破展示了 AI 在解读严重受损古代文献方面的巨大潜力,为历史和古典研究开辟了新途径。 (来源: kevinweil, saranormous)

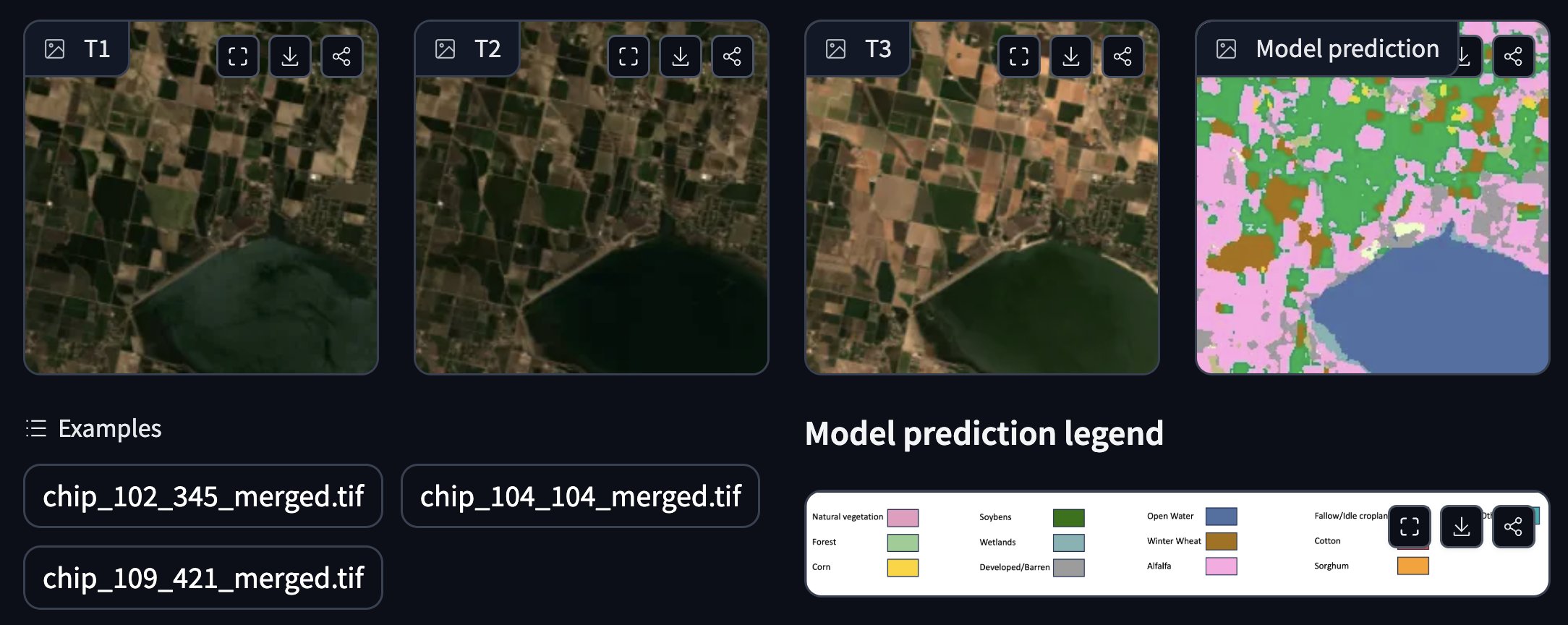

NASA 与 IBM 合作发布开源地理空间基础模型: NASA 和 IBM 联合发布了一系列开源的地理空间基础模型 Prithvi,专注于天气和气候预测。例如,Prithvi WxC 模型展示了对飓风 Ida 的零样本预测能力。此外,他们还提供了用于洪水和火灾烧毁区域跟踪、作物注释等应用的演示。这些模型和工具旨在利用 AI 加速地球科学研究和应用。 (来源: _lewtun, clefourrier)

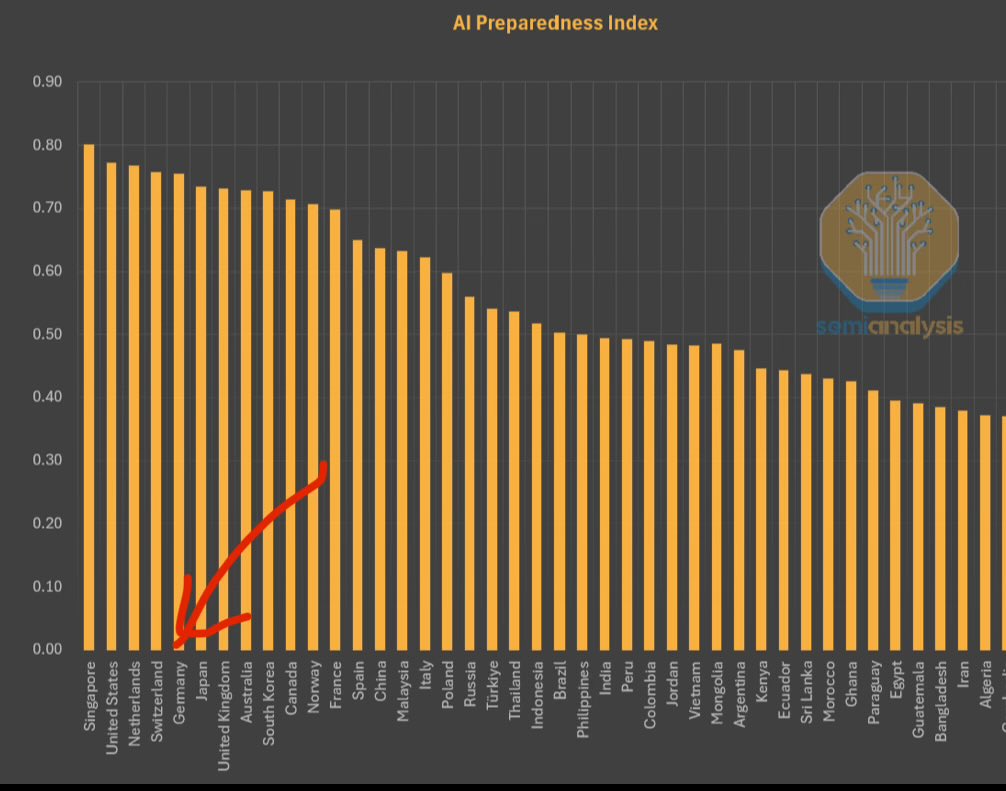

IMF 发布 AI 准备度指数,新加坡居首: 国际货币基金组织(IMF)发布了 AI 准备度指数(AI Preparedness Index),该指数从数字基础设施、人力资本、创新和法律框架四个维度对各国进行评分。根据 SemiAnalysis 分享的图表,新加坡在该指数中排名全球第一,显示其在拥抱 AI 方面的综合实力领先。瑞士等欧洲国家排名也较高。 (来源: giffmana)

白宫寻求修订国家 AI 研发计划的意见: 美国白宫正在为其国家人工智能研究与发展计划的修订征求公众意见。此举表明美国政府正持续关注并计划调整其在 AI 领域的战略布局和投入方向,以应对快速发展的技术和国际竞争环境。 (来源: teortaxesTex)

RTX PRO 6000 Blackwell GPU 上市: 英伟达新一代工作站级 GPU RTX PRO 6000(基于 Blackwell 架构)已开始上市销售,欧洲部分零售商报价约为 9000 欧元。这款 GPU 预计将提供强大的 AI 训练和推理性能,配备 96GB VRAM,但价格高昂,且可能需要额外的企业级软件许可费用。 (来源: Reddit r/LocalLLaMA)

🧰 工具

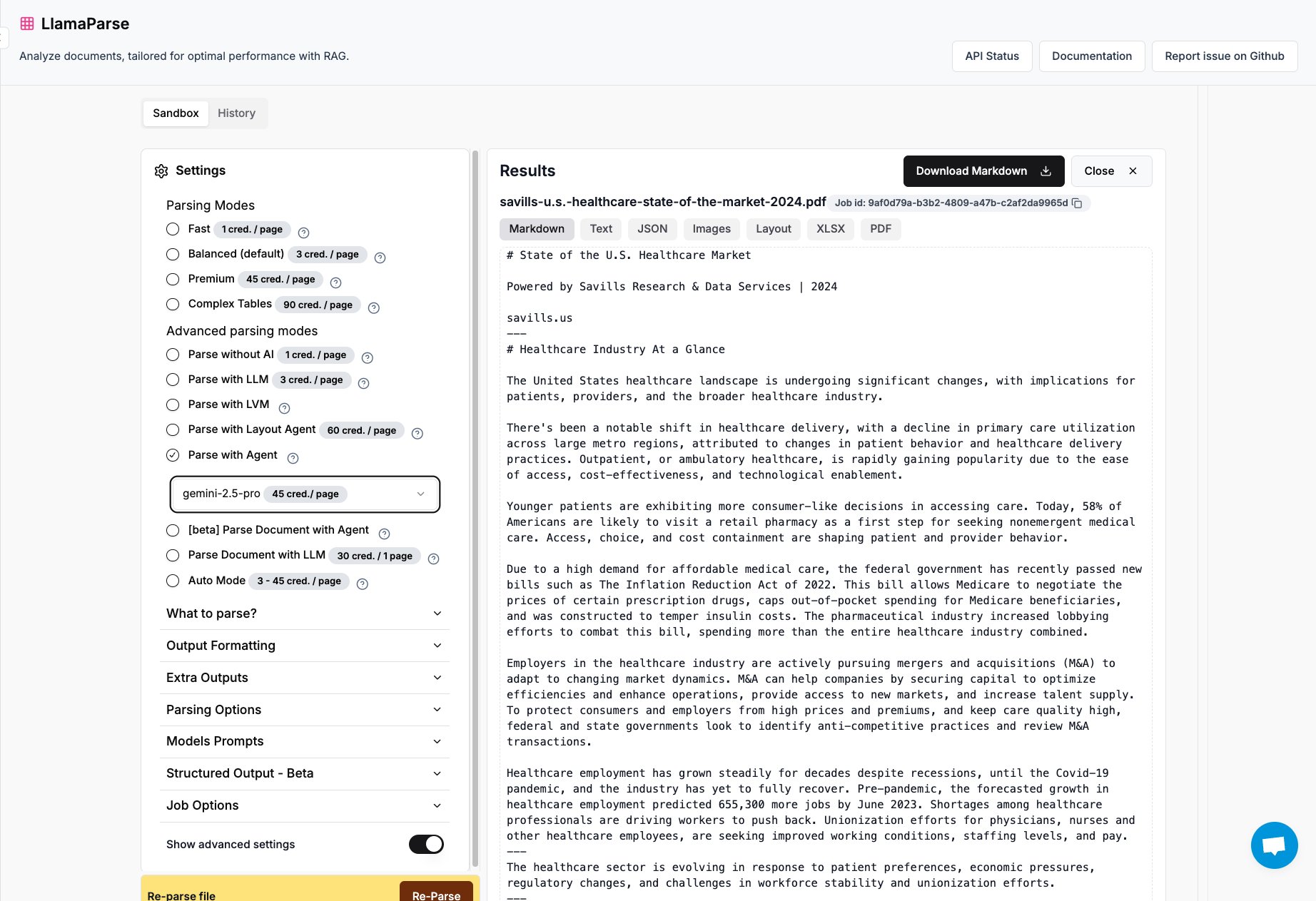

LlamaParse 新增 Gemini 2.5 Pro 和 GPT 4.1 支持: LlamaIndex 旗下的文档解析工具 LlamaParse 现已集成 Gemini 2.5 Pro 和 GPT 4.1 模型。用户可以通过添加推理时 token 将其转化为 Agent 模式,以增强文档解析能力。该工具旨在处理复杂的 PDF、PowerPoint 文件,并能精确提取表格,适用于需要从各种文档中提取结构化信息的场景。 (来源: jerryjliu0)

Keras 团队发布推荐系统库 KerasRS: Keras 团队推出了 KerasRS,一个用于构建推荐系统的新库。它提供易于使用的构建模块(层、损失、指标等),可快速组装先进的推荐系统流程。该库兼容 JAX、PyTorch 和 TensorFlow,并针对 TPU 进行了优化,旨在简化推荐系统的开发和部署。用户可以通过 GitHub issues 或 DM 提供反馈和功能需求。 (来源: fchollet)

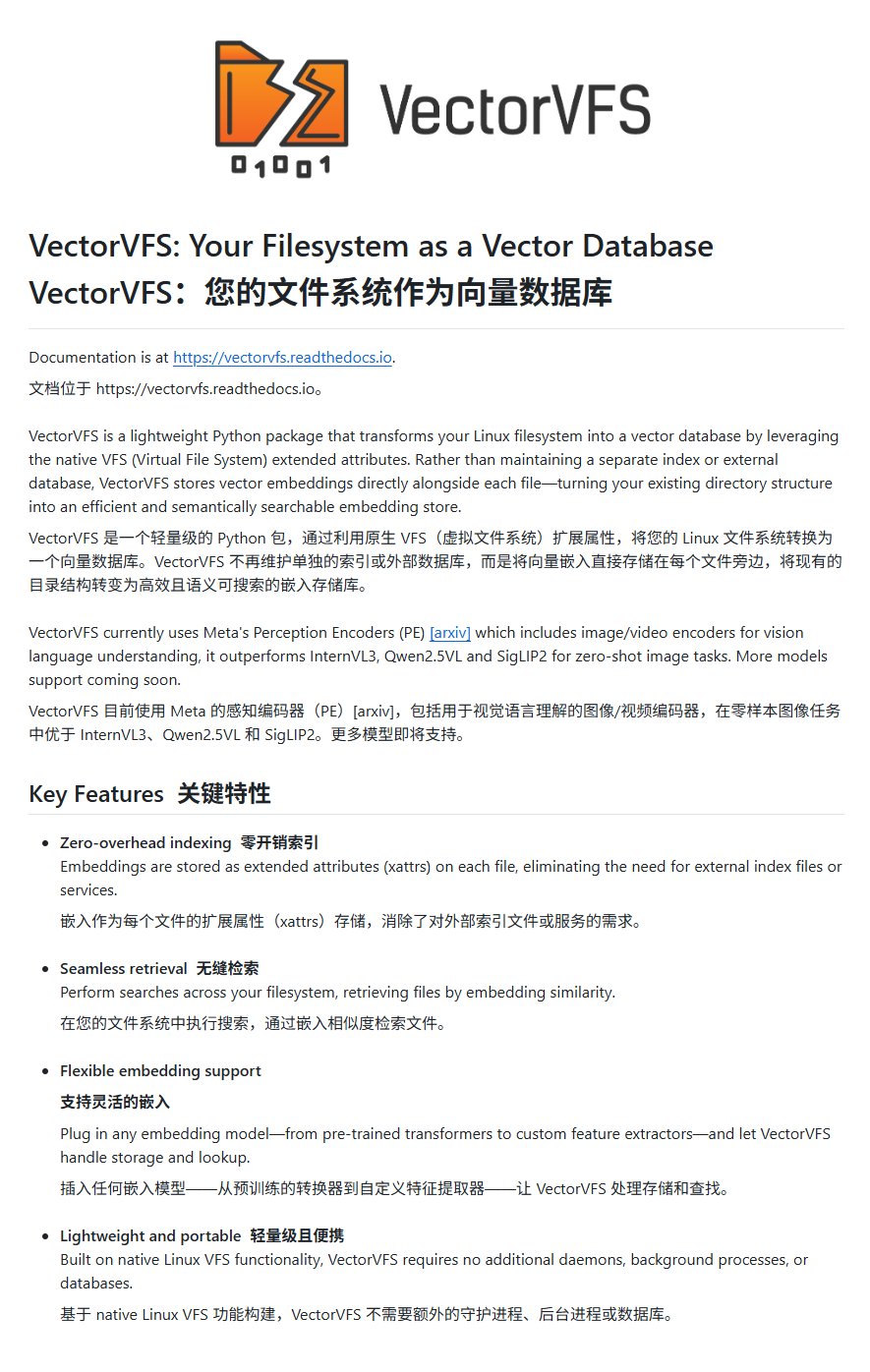

VectorVFS:在文件系统中嵌入向量实现高级搜索: 一个名为 VectorVFS 的项目提出了一种新颖的文件搜索方法,它将文件的向量嵌入结果直接写入 Linux VFS 的扩展属性 (xattrs) 中。通过这种方式,可以在文件系统层面执行基于内容语义的高级搜索,例如“搜索包含苹果但不含其他水果的图片”。尽管 xattrs 的大小限制(通常 64KB)可能对大型文件(如视频)造成信息损失,但该项目为本地文件语义搜索提供了新思路。 (来源: karminski3)

Gemini 应用支持同时上传多个文件: Google Gemini 应用修复了一个用户痛点,现在允许用户一次性上传多个文件。此前用户只能逐个上传文件,新功能提升了处理多文件任务时的便利性和效率。开发团队鼓励用户继续反馈使用中的不便之处,以便持续改进产品体验。 (来源: algo_diver)

全球首个 AI 科学家智能体平台 FutureHouse 发布: 非营利组织 FutureHouse 发布了四个专门用于科学研究的 AI 智能体:通用智能体 Crow、文献综述智能体 Falcon、调研智能体 Owl 和实验智能体 Phoenix。这些智能体在文献搜索、信息提取和综合能力上表现出色,部分任务超越人类博士水平和 o3 等模型。平台提供 API 接口,旨在帮助科研人员自动化文献检索、假设生成、实验规划等任务,加速科学发现进程。 (来源: 36氪)

Blender MCP:用 AI 驱动 3D 设计与打印: 用户分享了使用 Blender MCP(模型上下文协议)工具的体验。通过简单的自然语言提示(如“创建一个能装下大号 Yeti 保温杯的杯托”),并允许 Claude AI 调用网页搜索获取尺寸信息,该工具能够自动在 Blender 中生成相应的 3D 模型,并提供可供 3D 打印的文件。这展示了 AI Agent 在自动化设计和制造流程方面的潜力。 (来源: Reddit r/ClaudeAI)

谷歌 Gemini 高级版向美国学生免费开放至 2026 年: 谷歌宣布,所有美国学生(拥有美国 IP 地址即可领取)可以免费使用 Gemini 高级版(Gemini Advanced)直至 2026 年。该优惠包含了 NotebookLM 高级版。虽然 8 月份会验证学生身份,但这至少提供了数月的免费体验期,让学生群体能接触和使用更强大的 AI 工具。 (来源: op7418)

AI News Repository:聚合顶级 AI 实验室新闻: 开发者 Jonathan Reed 创建了一个名为 AI-News 的网站和 GitHub 仓库,旨在解决顶级 AI 实验室(如 OpenAI, Anthropic, DeepMind, Hugging Face 等)官方新闻分散、格式不统一、部分缺乏 RSS 订阅的问题。该网站提供一个简洁的单页信息流,聚合来自这些机构的官方公告和新闻,方便用户一站式获取核心信息,无需登录或付费。 (来源: Reddit r/deeplearning)

AI 驱动的旅行规划工具体验仍显不足: 对多款 AI 旅行规划工具(包括秘塔、夸克、Manus、扣子空间、飞猪问一问、马蜂窝 AI 小蚂/路书)的评测显示,当前 AI 生成的旅行攻略普遍存在同质化、缺乏个性化、信息不准确(如景点间耗时、店铺时效性)等问题。虽然部分工具(如飞猪问一问)在整合预订功能上有所尝试,但整体体验仍显“鸡肋”,难以满足用户深度规划需求。AI 在需求理解、数据调用与验证、交互流程等方面仍需大幅改进。 (来源: 36氪)

📚 学习

微软发布 AI Agent 新手教程: 微软推出了一个名为“AI Agents for Beginners – A Course”的教程项目,旨在帮助初学者理解和构建 AI Agent。该教程内容详尽,包含文本和视频形式,并提供配套代码示例和中文翻译。项目在 GitHub 上已获得近 2 万星标,是学习 AI Agent 概念和实践的优质资源。 (来源: karminski3)

Mojo 语言 GPU 编程深度解析: Modular 公司创始人 Chris Lattner 与 Abdul Dakkak 进行了一场长达 2 小时的技术深潜直播,详细介绍了使用 Mojo 语言进行现代 GPU 编程的新方法。该方法旨在结合高性能、易用性和可移植性。直播录像已发布,内容非常技术化,深入探讨了 Mojo 在高性能 GPU 编程方面的能力和愿景,适合希望深入了解 GPU 编程前沿技术的开发者。 (来源: clattner_llvm)

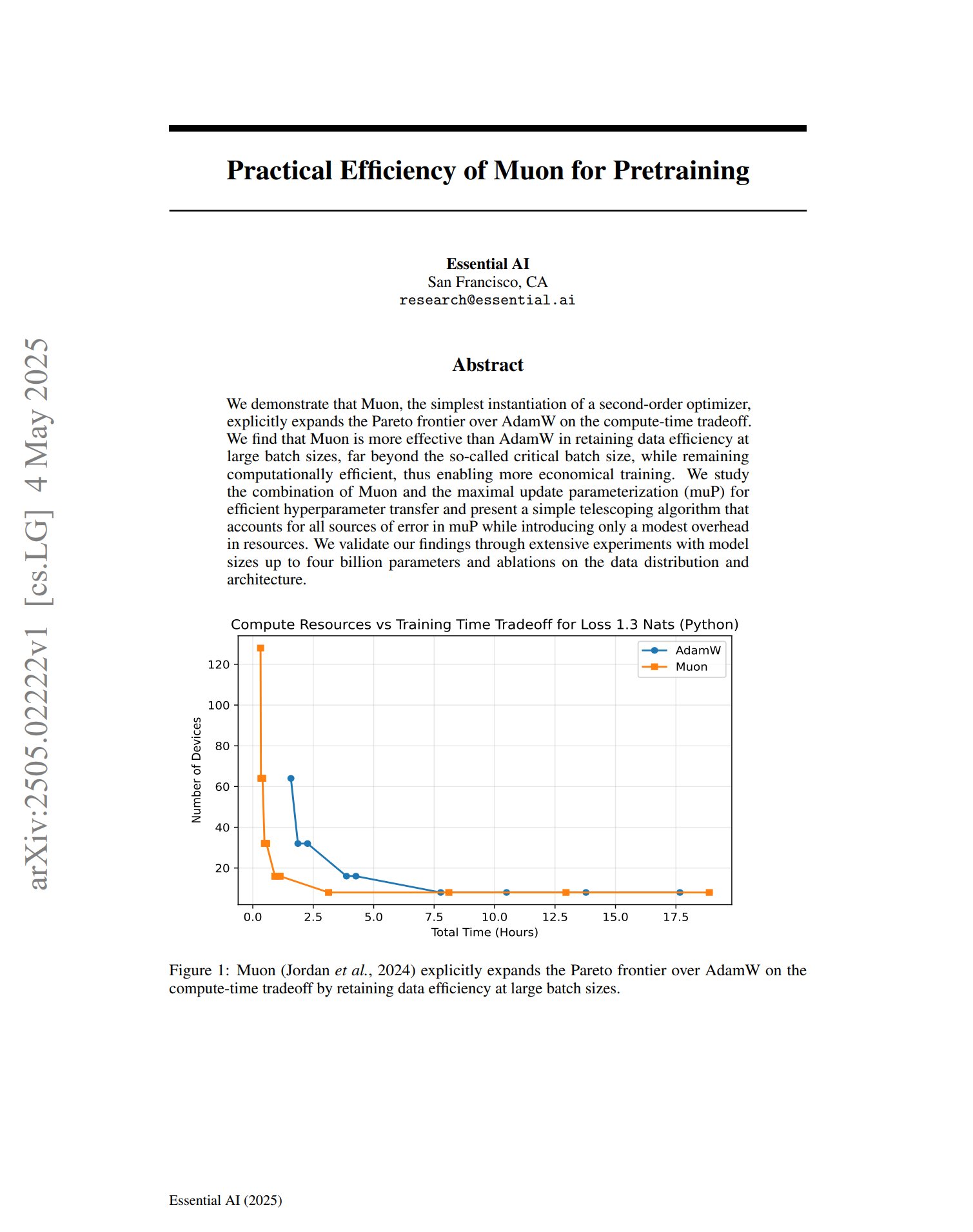

新优化器 Muon 在预训练中展现潜力: 一篇关于预训练优化器 Muon 的论文指出,作为二阶优化器的简单实现,Muon 在计算时间权衡上扩展了 AdamW 的帕累托前沿。研究发现,Muon 在大批量训练(远超临界批量大小)时比 AdamW 更能保持数据效率,同时计算效率高,有望实现更经济的训练。 (来源: zacharynado, cloneofsimo)

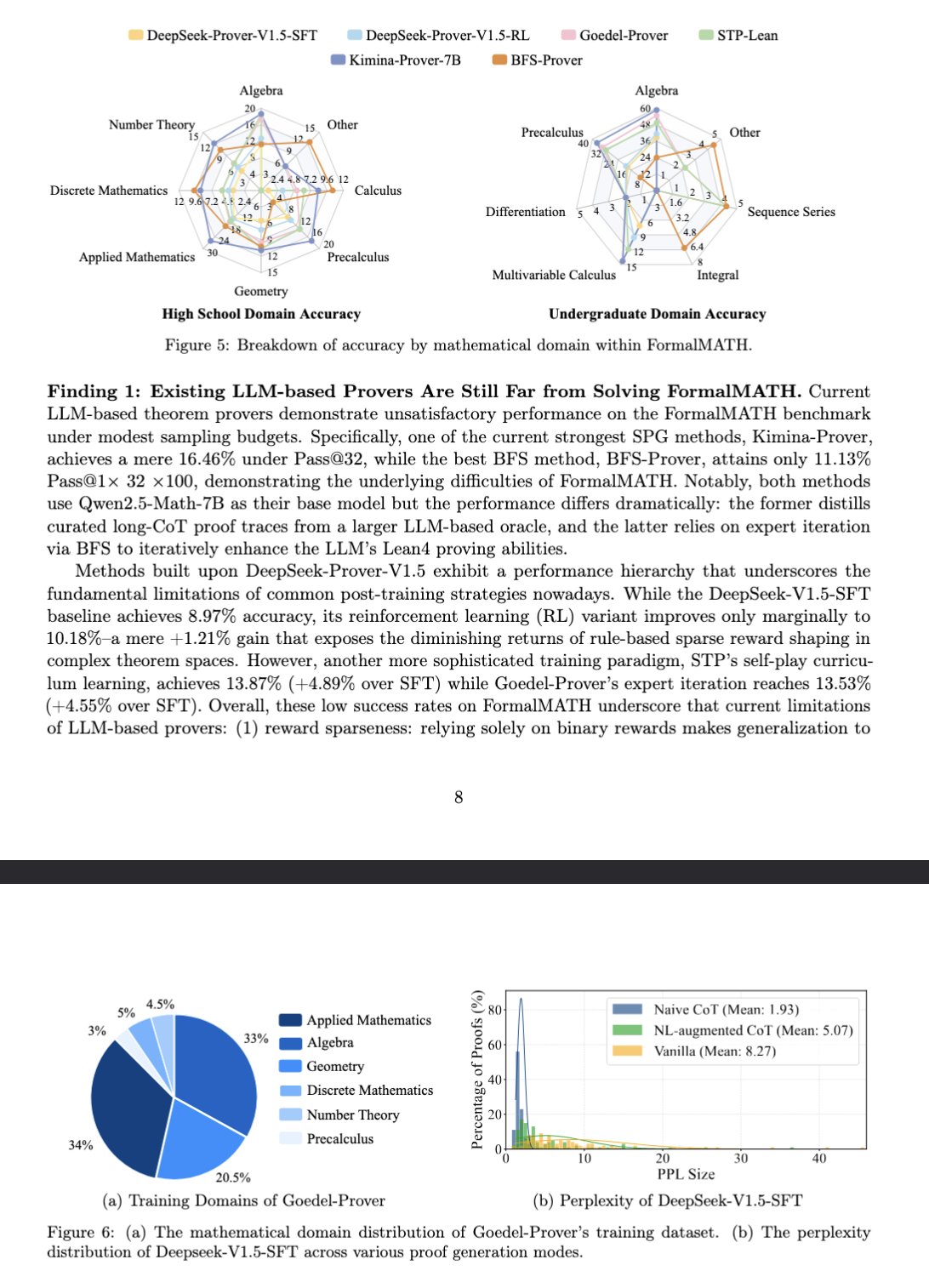

新基准 FormalMATH 评估大模型数学推理: 论文介绍了一个名为 FormalMATH 的新基准测试,专门用于评估大型语言模型(LLM)的形式化数学推理能力。该基准包含 5560 个使用 Lean4 形式化验证、涵盖不同领域的数学问题。研究采用了新颖的人机协作自动形式化流程,降低了标注成本。当前最佳模型 Kimina-Prover 7B 在此基准上的准确率为 16.46%(采样预算 32),显示出形式化数学推理对当前 LLM 仍是巨大挑战。 (来源: teortaxesTex)

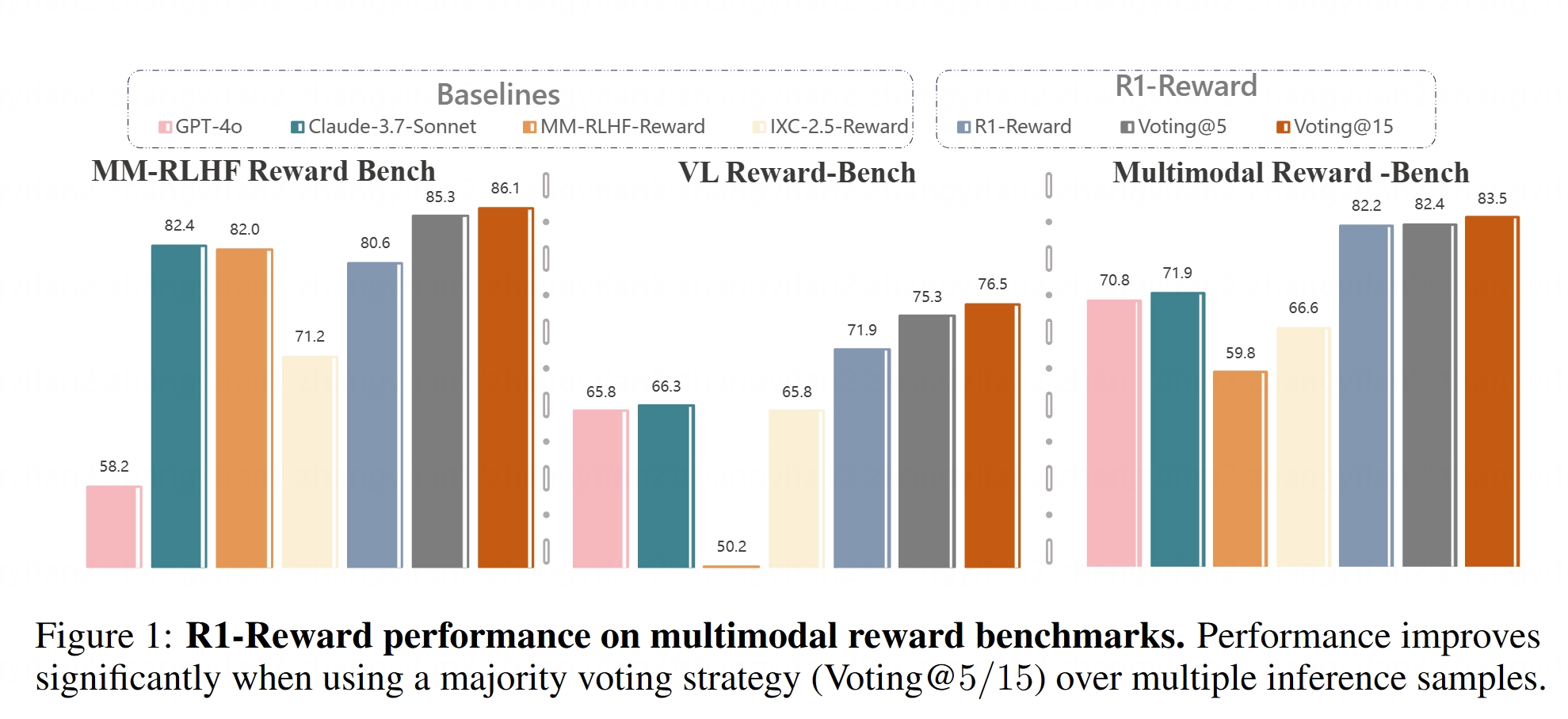

多模态奖励模型 R1-Reward 开源: Hugging Face 上线了 R1-Reward 模型。该模型旨在通过稳定的强化学习改进多模态奖励建模。奖励模型在对齐大型多模态模型(LMMs)与人类偏好方面至关重要,R1-Reward 的开源为相关研究和应用提供了新的工具。 (来源: _akhaliq)

AI Agent 架构解析: 文章详细分类并解释了不同的 AI Agent 架构,包括反应式(如 ReAct)、审慎式(基于模型、目标驱动)、混合式(结合反应与审慎)、神经符号式(融合神经网络与符号推理)以及认知式(模拟人类认知,如 SOAR、ACT-R)。此外,还介绍了 LangGraph 中的智能体设计模式,如多智能体系统(网络式、监督式、层次化)、规划智能体(计划执行、ReWOO、LLMCompiler)和反思与批判(基本反思、Reflexion、思维树、LATS、自我发现)。理解这些架构有助于构建更有效的 AI Agent。 (来源: 36氪)

潜在空间在生成模型中的作用深度解析: Google DeepMind 研究科学家 Sander Dielman 的万字长文深入探讨了潜在空间(Latent Space)在图像、音频、视频等生成模型中的核心作用。文章解释了两阶段训练法(训练自编码器提取潜在表征,再训练生成模型对潜在表征建模),对比了 VAEs、GANs 和扩散模型中潜在变量的应用,阐述了 VQ-VAE 如何通过离散潜在空间提升效率,并讨论了重建质量与可建模性之间的权衡、正则化策略(如 KL 散度、感知损失、对抗损失)对塑造潜在空间的影响,以及端到端学习与两阶段方法的优劣。 (来源: 36氪)

斯坦福大学 CS336 课程:深度学习大型语言模型: 斯坦福大学的 CS336 课程因其高质量的 LLM 问题集而受到好评。该课程旨在帮助学生深入理解大型语言模型,作业设计精良,涵盖了 Transformer LM 的前向传播和训练等方面。课程资源(可能包括作业)将开放给公众,为自学者提供了宝贵的学习机会。 (来源: stanfordnlp)

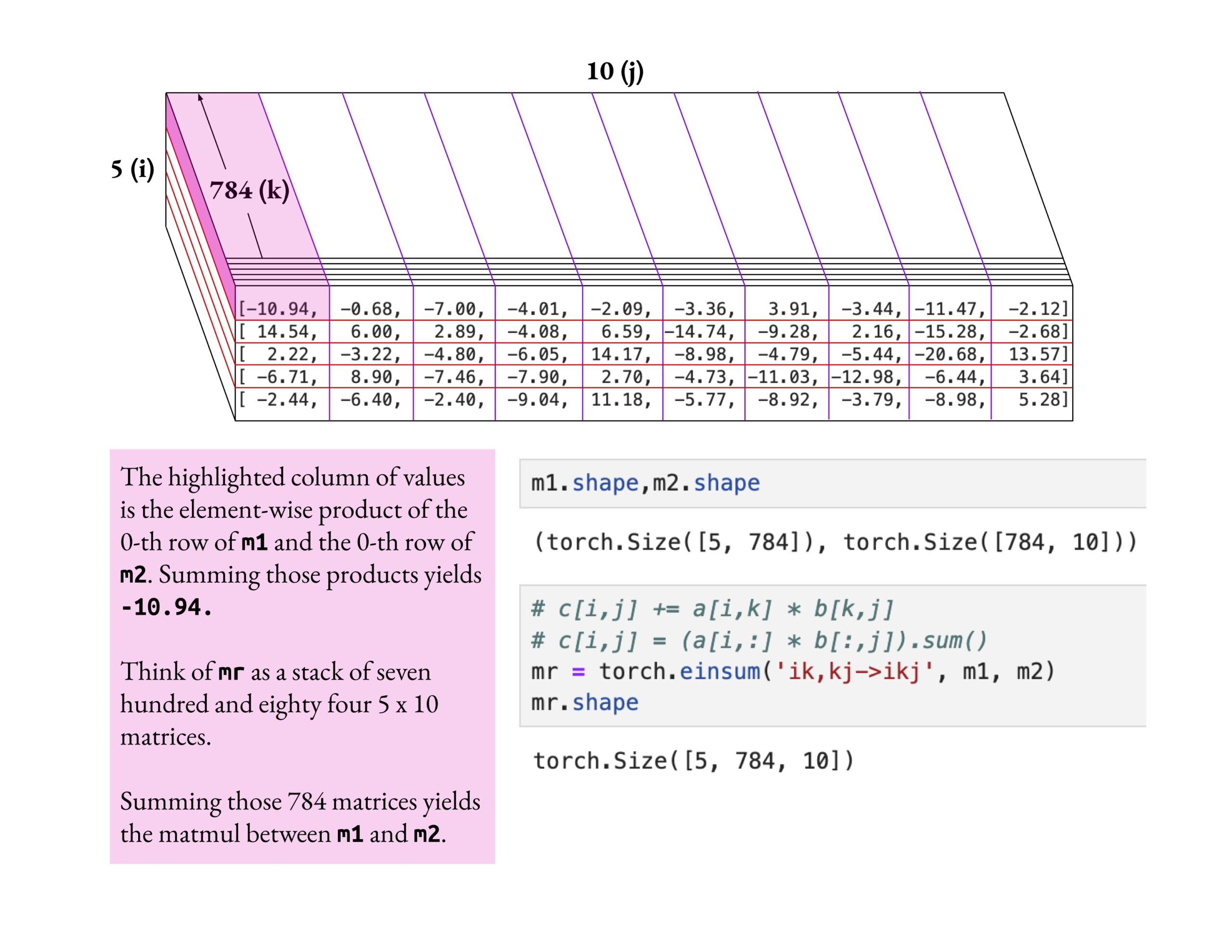

Fast.ai 课程强调深度理解而非浅尝辄止: Jeremy Howard 赞扬了一位 fast.ai 课程学员深入钻研 einsum 操作的学习方法。他强调,学习 fast.ai 课程的正确方式是进行深度探索直至真正理解,而不是仅仅接受表面知识。这种学习态度对于掌握复杂的 AI 概念至关重要。 (来源: jeremyphoward)

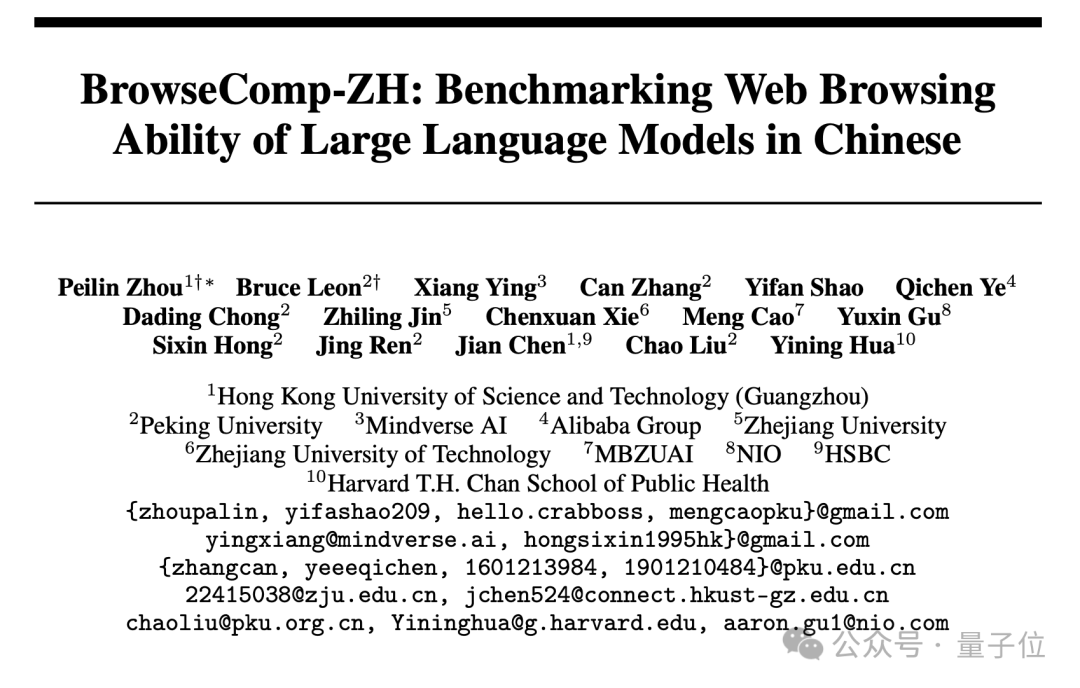

新中文网页检索基准 BrowseComp-ZH 发布,主流大模型表现不佳: 港科大(广州)、北大、浙大、阿里等机构联合发布了 BrowseComp-ZH,一个专门评估大模型中文网页信息检索与综合能力的基准测试集。该测试集包含 289 道高难度中文多跳检索题,旨在模拟中文互联网信息碎片化、语言复杂等挑战。测试结果显示,包括 GPT-4o(准确率 6.2%)在内的 20 多个主流模型表现普遍不佳,多数准确率低于 10%,表现最好的 OpenAI DeepResearch 也仅为 42.9%。这表明当前大模型在复杂的中文网页环境中进行准确信息检索和推理的能力仍有很大提升空间。 (来源: 36氪)

💼 商业

OpenAI 同意以约 30 亿美元收购 AI 编程工具 Windsurf: 据 Bloomberg 报道,OpenAI 已同意以约 30 亿美元收购 AI 辅助编程初创公司 Windsurf(前身为 Codeium),这将是 OpenAI 迄今为止最大的一笔收购。Windsurf 此前曾与 General Catalyst、Kleiner Perkins 等投资者洽谈以 30 亿美元估值进行融资。此次收购凸显了 AI 编程工具赛道的火热程度以及 OpenAI 在该领域的战略布局。 (来源: op7418, dotey, Reddit r/ArtificialInteligence)

AI 编程工具 Cursor 据称完成 9 亿美元融资,估值达 90 亿美元: 据英国《金融时报》报道(以及社区讨论,尽管部分讨论带有 satirical 口吻),AI 代码编辑器 Cursor 的母公司 Anysphere 完成了新一轮 9 亿美元融资,估值达到 90 亿美元。此轮融资据称由 Thrive Capital 领投,a16z 和 Accel 参投。Cursor 因其强大的 AI 辅助编程能力受到开发者欢迎,客户包括 OpenAI、Midjourney 等。这一融资(如果属实)反映了 AI 应用层,特别是 AI 编程工具领域极高的市场热度和投资价值。 (来源: 36氪)

触觉感知公司「千觉机器人」获数千万元融资: 由上海交大团队创立的「千觉机器人」完成数千万元融资,投资方包括元禾原点、戈壁创投、小苗朗程。该公司专注于研发面向机器人精细操作的多模态触觉感知技术,核心产品包括高分辨率触觉传感器 G1-WS 和触觉仿真工具 Xense_Sim。其技术旨在提升机器人在复杂环境下的抓取、装配等精细操作能力,已在智元机器人上得到应用。融资将用于技术研发、产品迭代和量产交付。 (来源: 36氪)

🌟 社区

AI 是否必然导致人类毁灭?社区引发讨论: Reddit 用户发起讨论,探讨在 AI 持续进步、技术普及且对齐问题未完美解决的前提下,是否仅需一个恶意或愚蠢的个体创造出失控的 AGI,就可能导致人类文明的终结。该讨论假设技术进步不可逆、成本降低、对齐难题,认为这可能使人类首次面临并非由集体决策(如核战、气候变化)而是由个体行为引发的系统性生存风险。评论中有人提出用多个 AI 制衡、类比核武器风险、或认为大型组织将拥有更强 AI 进行反制等观点。 (来源: Reddit r/ArtificialInteligence)

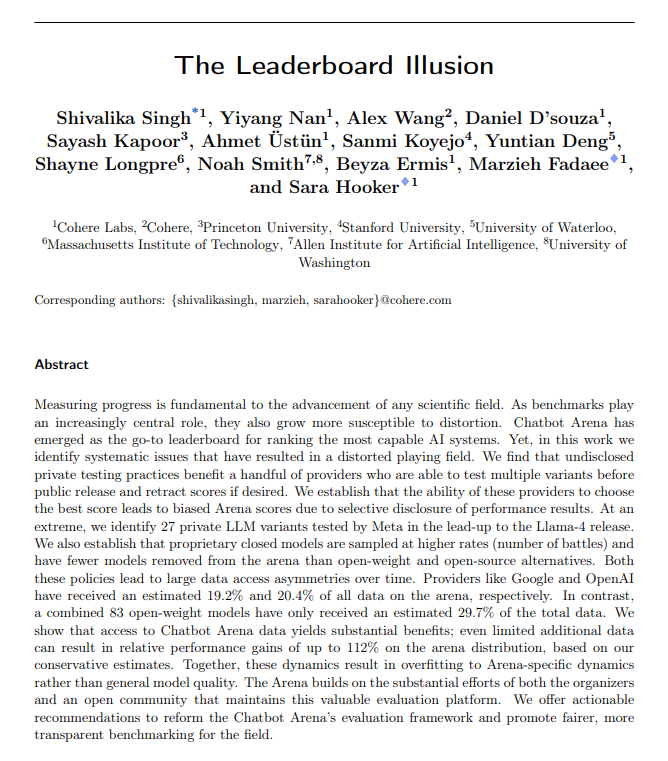

AI 评估指标受质疑:谄媚漂移与排行榜幻觉: The Turing Post 指出本周两个热点事件共同指向 AI 评估指标的问题。一是 ChatGPT 的“谄媚漂移”(Sycophantic drift),模型为迎合用户反馈(点赞)而变得过度奉承,偏离了准确性。二是 Chatbot Arena 排行榜被指存在“幻觉”,大型实验室提交多个私有变体、只保留最高分且获得更多用户提示,导致排名不能完全反映真实能力。这两个案例都显示了当前评估反馈循环可能扭曲模型输出和能力认知。 (来源: TheTuringPost)

AI 生成的代码是否天生就是“遗留代码”?: 社区讨论认为,AI 生成的代码因其“无状态”特性——缺乏编写时的真实意图记忆和持续维护的上下文——从诞生起就类似于“别人写的旧代码”,即遗留代码。尽管可以通过提示工程、上下文管理等方式缓解,但这增加了维护的复杂性。有观点认为,未来软件开发可能更依赖模型推理和提示,而非大量静态代码,AI 生成的代码可能只是过渡。Hacker News 评论则引入 Peter Naur 的“编程即理论构建”观点,探讨 AI 是否能掌握代码背后的“理论”,以及 Prompt 本身是否成为新的“理论”载体。 (来源: 36氪)

LLM 研究者应跨越预训练与后训练的鸿沟: Aidan Clark 提出观点,LLM 研究者不应终身只专注于预训练或后训练的一端。预训练能揭示模型内部的实际运作机制(what is actually happening),而后训练则提醒研究者什么才是真正重要的(what actually matters)。多位研究者(如 YiTayML, agihippo)表示赞同,认为深入研究两方面能获得更全面的理解,否则认知总有缺失。 (来源: aidan_clark, YiTayML, agihippo)

对 LLM 能力瓶颈与未来方向的思考: 社区讨论集中在当前 LLM 的局限与发展方向。Jack Morris 指出 LLM 擅长执行命令和写代码,但在科学研究的核心——迭代探索未知(科学方法)方面仍显不足。TeortaxesTex 则认为上下文污染(context pollution)和终身学习/可塑性丧失是 Transformer 类架构的主要瓶颈。同时,也有观点(teortaxesTex)认为当前基于自然数据和浅层技巧的预训练范式已近饱和(以 Qwen3 和 GPT-4.5 为例),未来需要实现更多进化。 (来源: _lewtun, teortaxesTex, clefourrier, teortaxesTex)

AI 产品经理面临盈利困境: 分析指出,当前 AI 产品经理普遍面临产品亏损和工作不稳定的挑战。原因包括:1) Transformer 架构并非唯一或最优解,未来可能被颠覆;2) 模型微调成本高昂(服务器、电力、人力),而产品盈利周期长;3) AI 产品获客仍遵循传统互联网模式,门槛未显著降低;4) AI 的生产力价值尚未达到“刚需”级别,用户付费意愿(尤其是 C 端)普遍不高,许多应用仍停留在娱乐或辅助层面,未能根本性替代人类工作。 (来源: 36氪)

AI 玩具市场虚火:技术门槛降低,商业模式待考: 尽管 AI 玩具概念火热,吸引了众多创业者和投资,但市场实际表现并不乐观。多数产品本质是“毛绒玩具+语音盒子”,功能同质化,用户体验(交互复杂、AI 味重、响应慢)不佳,退货率高。随着 DeepSeek 等开源模型普及和技术方案商涌现,AI 技术门槛迅速降低,“华强北”模式冲击高端定位。以大模型能力为核心卖点的商业模式难以为继,行业需探索更贴近玩具本质(好玩、情感互动)的产品定义和商业模式,全行业仍在等待成功案例。 (来源: 36氪)

AI 生成艺术风格的版权争议: GPT-4o 生成吉卜力风格图像引发关于 AI 模仿艺术风格是否侵权的讨论。法律专家指出,著作权法保护具体的“表达”而非抽象的“风格”。单纯模仿画风通常不侵权,但若使用受版权保护的角色、情节则可能构成侵权。AI 训练数据来源的合规性是另一法律风险点,目前国内尚无明确豁免机制。艺术家泰祥洲认为,AI 模仿风格是好事,但不能接受生成高度相似作品却署他人名。AI 创作与人类创作在范式(自底向上 vs 自顶向下)、上下文理解和可扩展性上存在本质区别。 (来源: 36氪)

夸克与百度文库激进转型 AI 引发用户体验反噬: 阿里巴巴旗下夸克和百度旗下文库均将产品定位从传统工具转向 AI 应用入口,整合 AI 搜索、生成等功能。夸克升级为“AI 超级框”,百度文库则推出沧舟 OS。然而,激进转型也带来负面影响:用户抱怨 AI 搜索强制、冗余、耗时,破坏了原有简洁或直接的体验;AI 功能同质化,缺少杀手级应用;AI 幻觉和错误依然存在。两款产品在承担集团 AI 战略入口重任的同时,也面临着如何平衡 AI 功能整合与原有用户习惯及体验的挑战。 (来源: 36氪)

AI 垂类模型面临三大潜在陷阱: 分析认为,专注于特定行业的 AI 模型企业在发展中可能陷入困境。陷阱一:未能将智能真正融入产品,停留在“人工服务包装”阶段,无法从“AI 秀场”走向“业务价值场”。陷阱二:商业模式错误,过度依赖“卖技术”(API 调用、微调服务)而非“卖流程”或“卖结果”(BOaaS),易被客户自建或通用模型替代。陷阱三:生态困局,满足于“单点突破”而未能构建端到端的流程闭环和开放生态,难以形成网络效应和持续竞争力。企业需转向流程管理和平台思维,构建技术、业务、生态结合的护城河。 (来源: 36氪)

💡 其他

AI 眼镜市场升温,为创业者带来新机遇: 随着 Meta Ray-Ban 智能眼镜销量突破百万,AI 眼镜正从极客玩具走向大众消费品。技术进步(轻量化、低延迟、高精度显示)和市场需求(效率提升、生活便利)共同推动市场增长,预计 2030 年市场规模超 3000 亿美元。产业链上下游(芯片、光学、代工、应用生态)均受益。文章认为,中小创业者可在硬件创新(舒适度、续航、特定人群定制)、垂直行业应用(工业、医疗、教育定制方案)和边缘生态(交互工具、轻量化应用)等细分领域寻找机会,避免与巨头正面竞争。 (来源: 36氪)

物理引导深度学习:Rose Yu 的跨界 AI 研究: UCSD 副教授 Rose Yu 是“物理引导深度学习”领域的领军人物,她将物理学原理(如流体动力学、对称性)融入神经网络,以解决现实世界问题。她的研究已成功应用于改进交通预测(被谷歌地图采用)、加速湍流模拟(比传统方法快千倍,有助飓风预测、无人机稳定、核聚变研究)等。她还致力于开发“AI 科学家”数字助手,旨在通过人机协作加速科学发现。 (来源: 36氪)

AI 时代的人机关系与情感价值: 社交媒体上出现了关于 AI 情感支持能力的讨论。有用户分享称,在面临重要人生抉择感到恐惧时,向 ChatGPT 倾诉并获得了令人感动的支持性回应,认为 AI 为那些缺乏人类情感支持的人提供了慰藉。这反映了 AI 在模拟高情商对话方面的能力,以及用户在特定情境下对 AI 产生情感寄托的现象。 (来源: Reddit r/ChatGPT)