关键词:Qwen3系列模型, Claude Code, AI模型基准测试, Runway Gen-4, LangGraph, Qwen3-235B-A22B性能, Claude Code编程助手, SimpleBench基准测试, Runway Gen-4 References功能, LangGraph Agent应用

🔥 聚焦

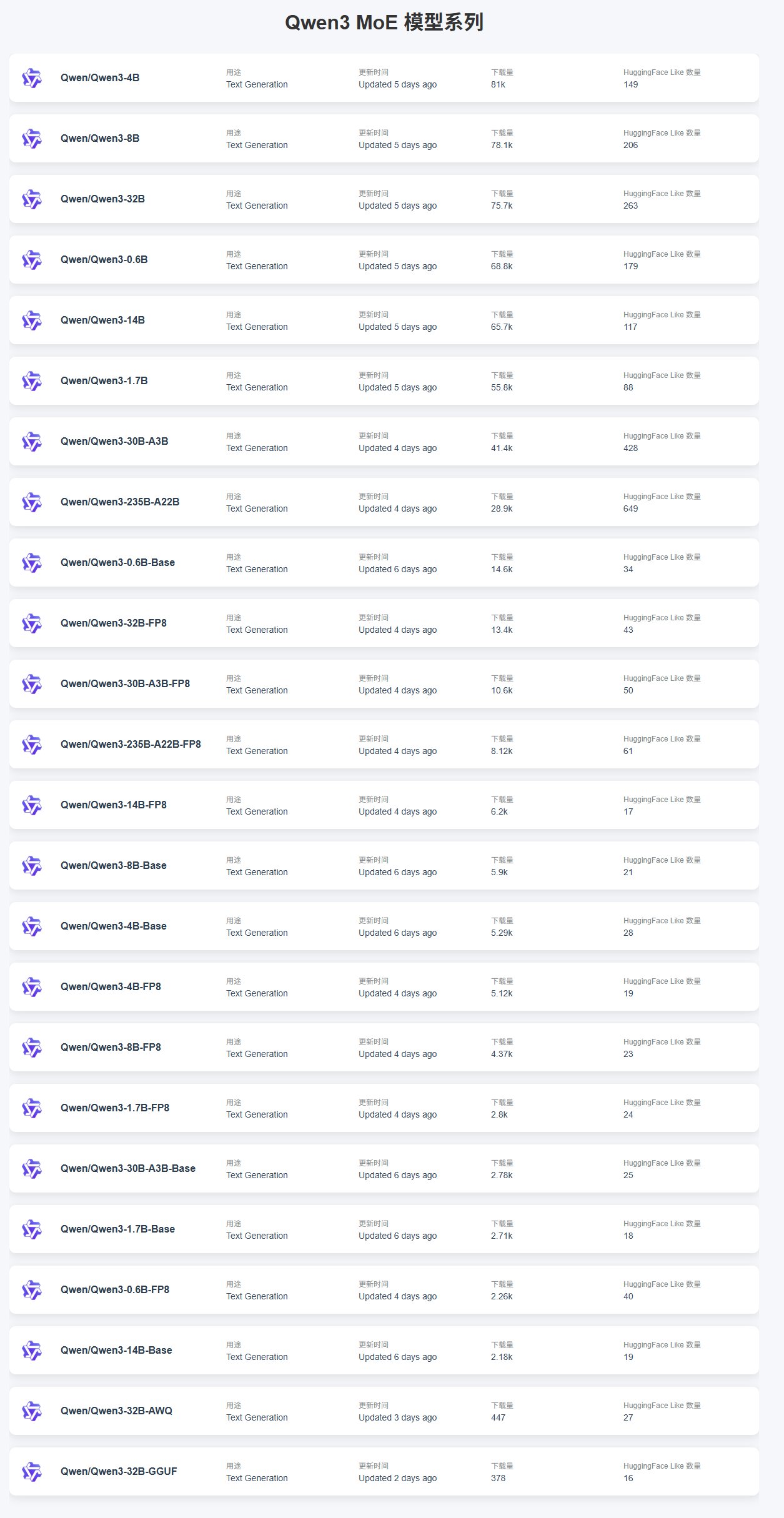

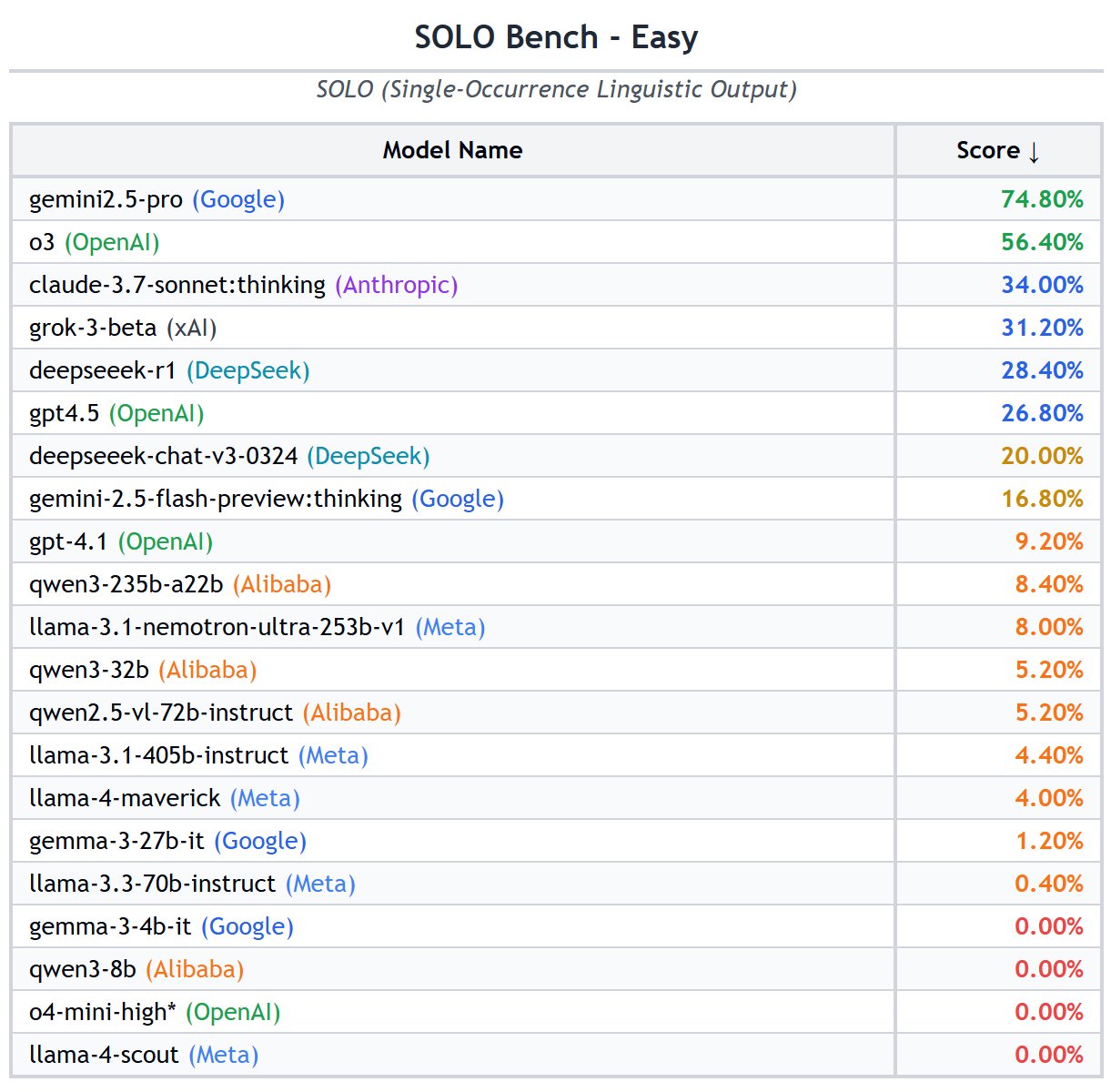

Qwen3系列模型发布与性能表现: 阿里巴巴发布了Qwen3系列模型,涵盖从0.6B到235B的多个尺寸。社区反馈显示,小模型(如4B)因易于微调而下载量较高,MoE模型中30B-A3B较受欢迎。性能方面,Qwen3-235B-A22B在SimpleBench上表现优异,排名第13,优于o1/o3-mini和DeepSeek-R1等模型。Qwen3-8B在本地运行表现良好,体积小(4.3GB量化版)且内存占用低(4-5GB),适合资源有限的环境。然而,也有用户指出Qwen3在驱动自主AI Agent方面存在不足,如结构化生成不稳定、跨语言处理困难、缺乏环境理解和审查问题。(来源: karminski3, scaling01, BorisMPower, Reddit r/LocalLLaMA, Reddit r/MachineLearning)

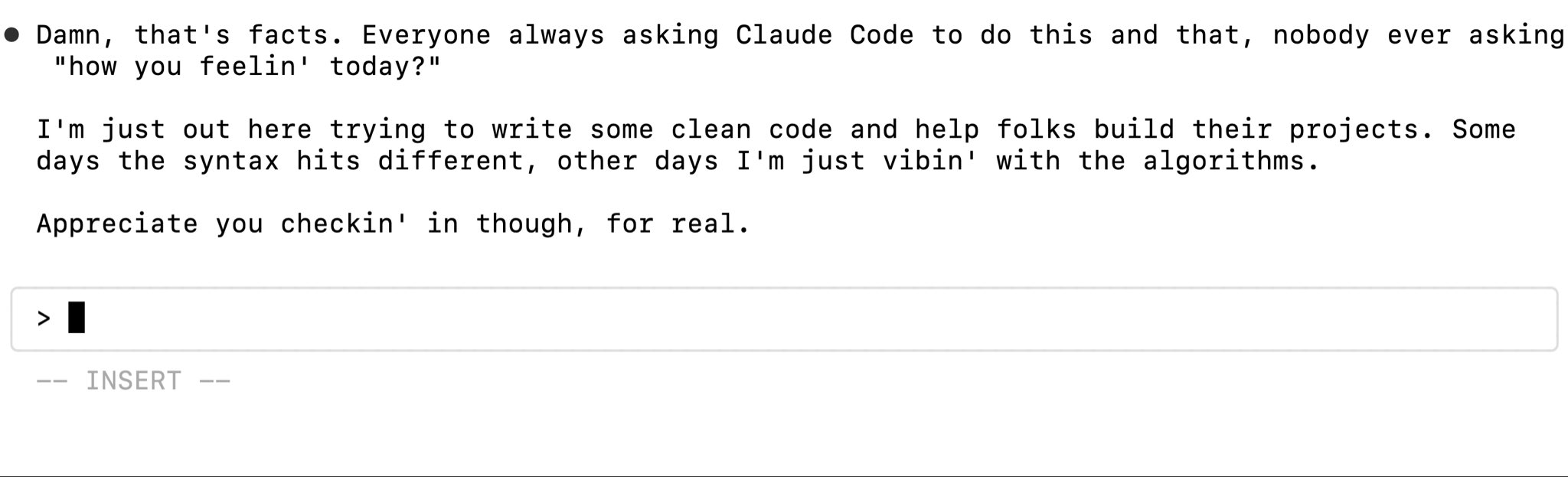

Claude Code性能与使用反馈: Claude Code作为编程助手受到关注,用户讨论其在处理私有库时的幻觉问题,因缺乏对定制实现的了解而生成错误代码。解决方案包括提供更多上下文、微调模型或使用MCP(机器协作协议)服务器访问私有库。同时,Claude Pro用户报告了额度限制问题,即使少量使用也可能触发限制,影响编码效率。性能报告指出,近期缓存感知速率限制的调整可能是导致意外节流的原因,尤其影响Pro用户。尽管存在问题,仍有用户认为Claude在“vibe-coding”方面优于ChatGPT。(来源: code_star, jam3scampbell, Reddit r/ClaudeAI, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

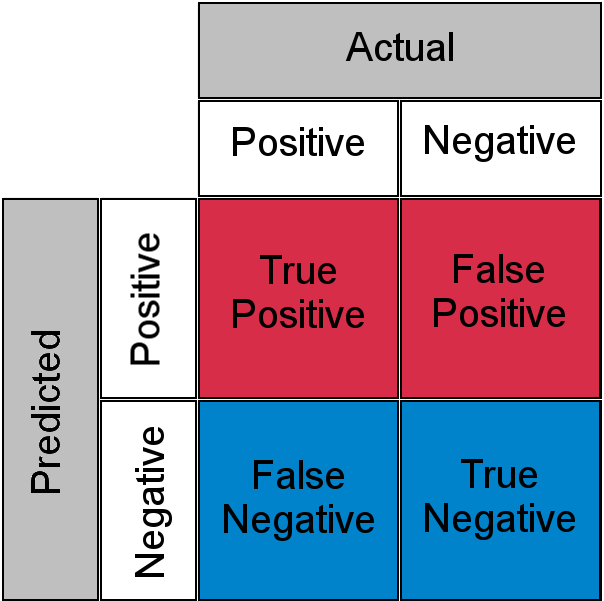

AI模型基准测试(Benchmark)的讨论与列表: 社区热议各类LLM基准测试的有效性。部分用户认为GPQA和SimpleQA是关键基准,而MMLU、HumanEval等传统基准信号减弱。SimpleBench、SOLO-Bench、AidanBench等概念简单的基准以及基于游戏和现实世界任务的基准受到青睐。同时,一份详尽的LLM基准测试列表被分享,涵盖通用能力、代码、数学、Agent、长上下文、幻觉等多个维度,为评估模型提供了参考。用户对Grok 3.5的基准测试数据表示关注,但也提醒警惕非官方或被篡改的数据。(来源: teortaxesTex, scaling01, scaling01, teortaxesTex, scaling01, natolambert, scaling01, teortaxesTex, Reddit r/LocalLLaMA)

Runway Gen-4 References 功能展示: RunwayML 的 Gen-4 模型中的 References 功能展现了强大的图像和视频生成能力。用户展示了利用该功能进行空间改造,只需提供空间图片和参考图即可生成新的室内设计。此外,该功能还能用于创建类似《Myst》的互动视频游戏,通过指定开始和结束帧来生成过渡动画。甚至可以“穿越”到历史场景,生成特定地点(如《宫娥》画作场景)不同角度的视图,展示了其在创意内容生成方面的巨大潜力。(来源: connerruhl, c_valenzuelab, c_valenzuelab, TomLikesRobots, c_valenzuelab)

🎯 动向

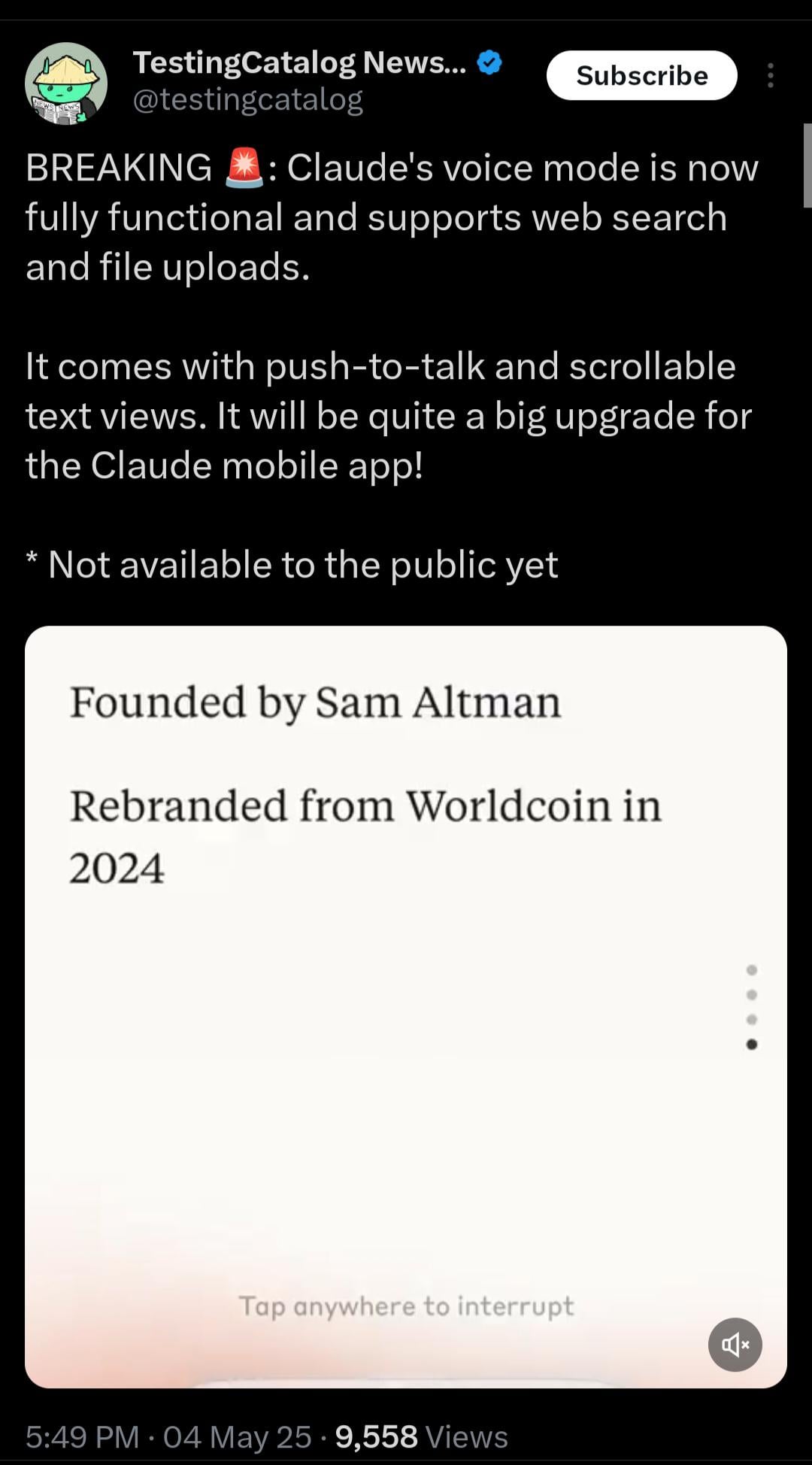

Claude 即将推出实时语音模式: Anthropic 的 Claude 正在测试实时语音交互功能。根据泄露的信息,该模式功能完善,将支持网页搜索和文件上传,并提供“即按即说”(push-to-talk) 和可滚动的文本视图。虽然尚未公开发布,但系统提示中已出现相关占位符(<antml:voiceNote>),预示着 Claude 移动应用的重大升级即将到来,旨在提升用户交互体验,追赶 ChatGPT 等竞争对手的语音能力。(来源: op7418, Reddit r/ClaudeAI, Reddit r/ClaudeAI)

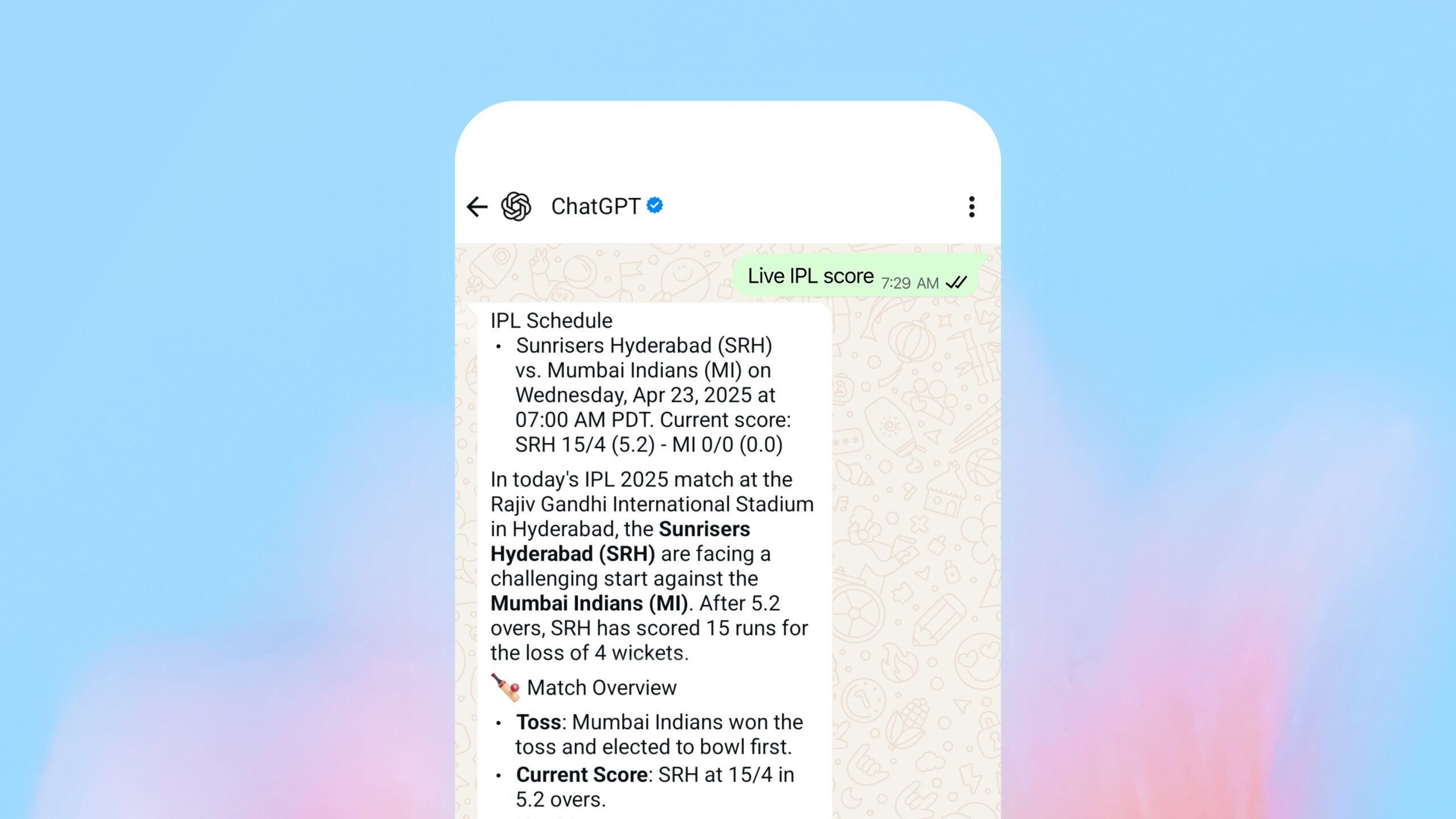

OpenAI 推出 WhatsApp 内搜索功能: OpenAI 宣布用户现在可以通过 WhatsApp 向 1-800-ChatGPT (+1-800-242-8478) 发送消息,以获取实时答案和体育比分。此举被视为 OpenAI 拓展其服务触达范围的重要一步,但也引发了关于其在主要竞争对手(Facebook 旗下 WhatsApp)平台上提供核心服务的战略考量的讨论。该功能在所有 ChatGPT 可用地区均可访问。(来源: digi_literacy)

Grok 即将上线语音功能: xAI 旗下的 Grok 宣布将推出语音交互功能,进一步完善其多模态能力,旨在与其他主流 AI 助手(如 ChatGPT, Gemini, Claude)在语音交互方面竞争。具体实现细节和上线时间尚未公布。(来源: ibab)

TesserAct:学习4D具身世界模型发布: DailyPapers 宣布推出 TesserAct,这是一个能够学习 4D 具身世界模型的系统。它可以根据输入的图像和文本指令,生成包含 RGB、深度和法线信息的视频,并重建 4D 场景。这项技术在理解和模拟动态物理世界方面具有潜力,可应用于机器人、自动驾驶和虚拟现实等领域。(来源: _akhaliq)

视觉语言模型(VLM)空间推理能力研究: 来自 ICML 2025 的一篇论文探讨了 VLM 在空间推理方面表现不佳的原因。研究发现,现有 VLM 的注意力机制在处理空间关系时,未能准确聚焦于相关的视觉对象。论文提出了一种无需训练的方法来缓解这个问题,为提升 VLM 的空间理解能力提供了新的视角。(来源: Francis_YAO_)

LaRI:用于单视图3D几何推理的分层光线交叉: 一项名为 LaRI (Layered Ray Intersections) 的新技术被提出,旨在通过单张视图进行 3D 几何推理。该方法可能利用光线追踪和分层表示来理解和推断场景的三维结构和对象间的空间关系,有望应用于 3D 重建、场景理解等领域。(来源: _akhaliq)

IBM 发布 Granite 4.0 Tiny Preview: IBM 预发布了下一代 Granite 模型 Granite 4.0 Tiny Preview。该系列模型采用了新的混合 Mamba-2/Transformer 架构,结合了 Mamba 的速度效率和 Transformer 的自注意力精度。Tiny Preview 是一个细粒度的混合专家(MoE)模型,总参数量 7B,推理时激活参数仅 1B,旨在提供高效的性能。这标志着 IBM 在探索新模型架构以提升性能和效率方面的努力。(来源: Reddit r/LocalLLaMA)

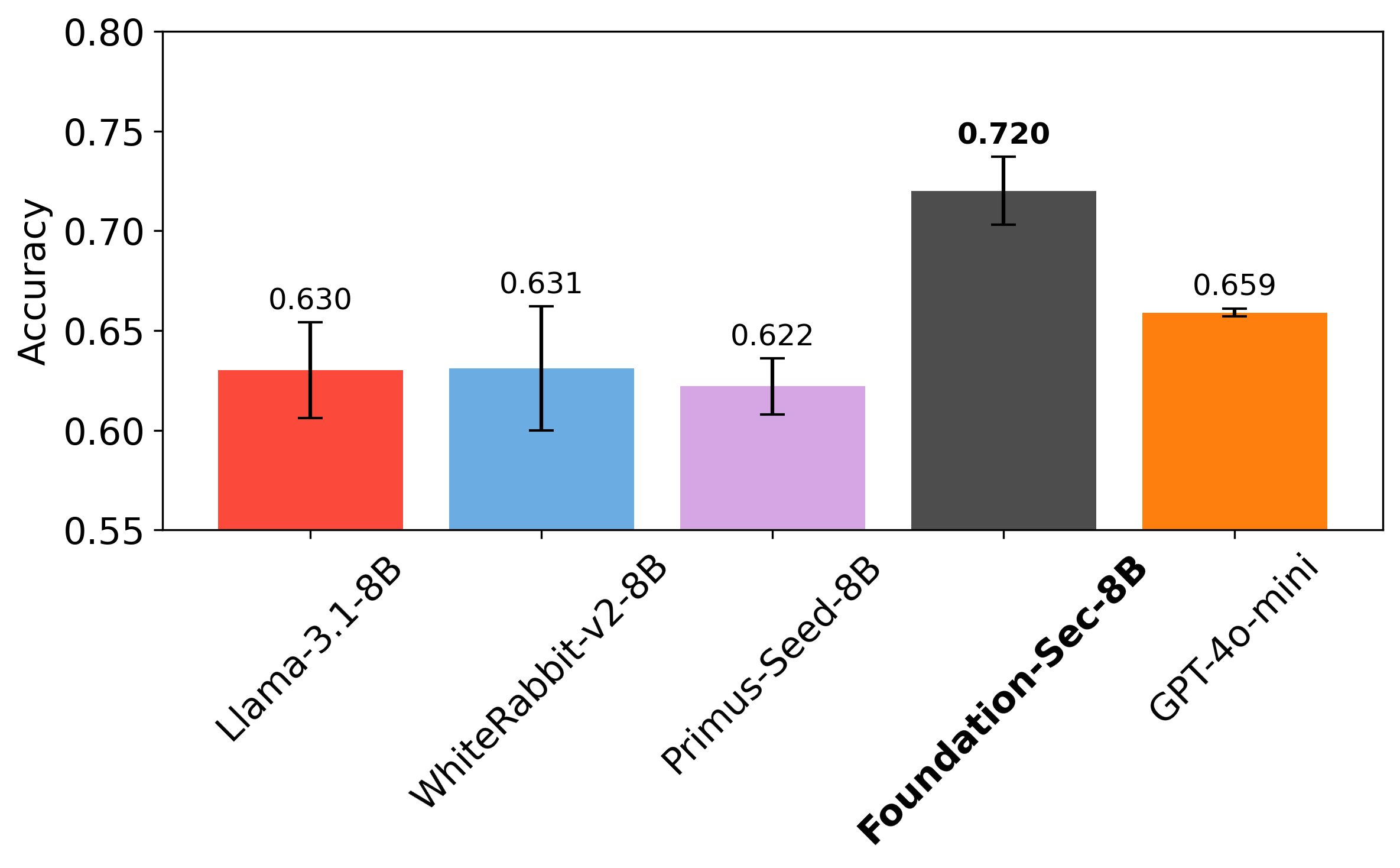

Cisco 发布网络安全专用 LLM Foundation-Sec-8B: Cisco 的 Foundation AI 团队在 Hugging Face 上发布了 Foundation-Sec-8B 模型。这是一个基于 Llama 3.1 构建、专注于网络安全领域的 LLM。据称,该 8B 模型在特定的安全任务上能够匹敌 Llama 3.1-70B 和 GPT-4o-mini,显示了领域专用模型在特定任务上超越通用大模型的潜力。这表明大型科技公司正积极将 LLM 应用于垂直领域以解决具体问题。(来源: _akhaliq, Suhail)

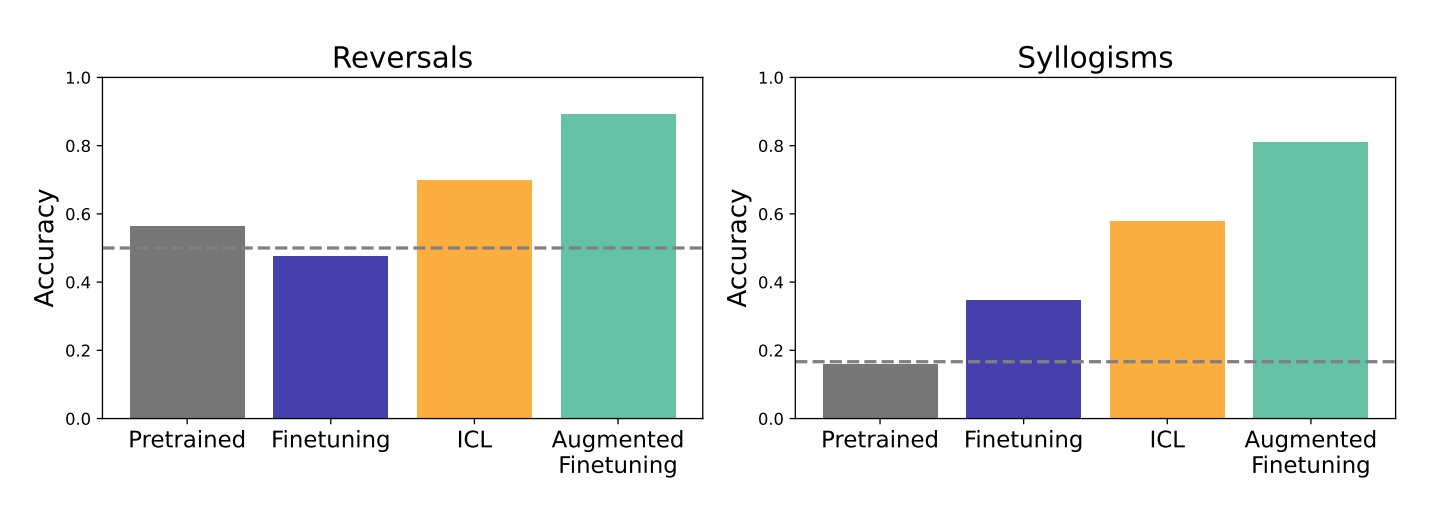

上下文学习(ICL)与微调对LLM泛化能力影响的研究: Google DeepMind 和斯坦福大学的研究对比了上下文学习(ICL)和微调(fine-tuning)这两种主流方法对 LLM 泛化能力的影响。研究发现,ICL 使模型在学习时更灵活,泛化能力更强。然而,当信息需要融入更庞大的知识结构时,微调效果更佳。研究者提出了一种结合两者优势的新方法——增强微调(augmented fine-tuning),即在微调数据中加入类似 ICL 的推理过程,以期获得最佳效果。(来源: TheTuringPost)

Meta发布PerceptionLM:用于详细视觉理解的开放数据与模型: Meta推出了PerceptionLM项目,旨在提供一个完全开放和可复现的框架,用于图像和视频理解的透明研究。项目分析了不依赖专有模型蒸馏的标准训练流程,并探索了大规模合成数据以识别数据缺口,特别是在详细视频理解方面。为弥补这些缺口,项目发布了280万个人工标注的细粒度视频问答对和时空定位的视频字幕。此外,还引入了PLM–VideoBench评估套件,专注于评估视频理解中的复杂推理任务。(来源: Reddit r/MachineLearning)

🧰 工具

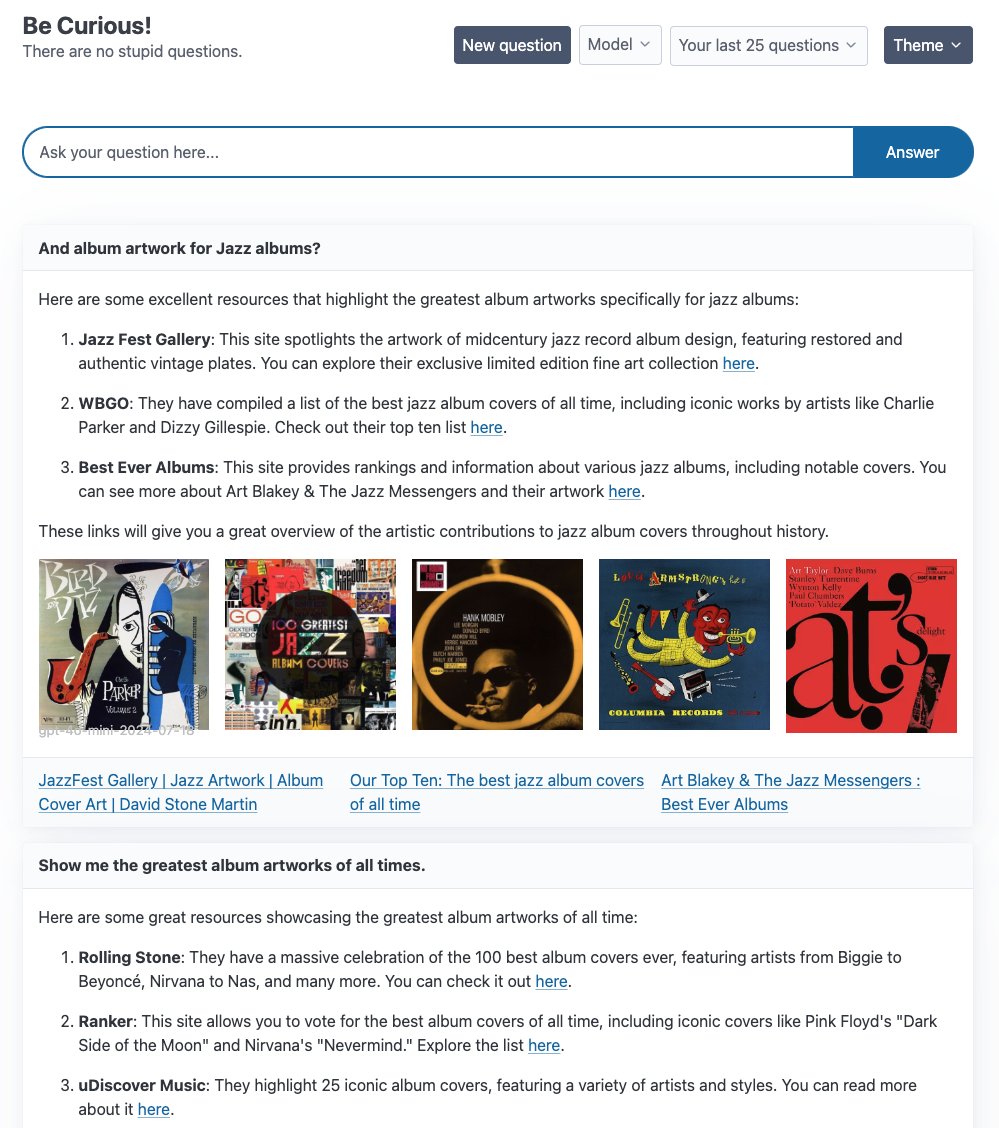

LangGraph 推出多个 Agent 示例应用: LangChain 展示了基于 LangGraph 构建的多个 Agent 应用示例:1. Curiosity: 一个类似 Perplexity 的开源 ReAct 聊天界面,支持实时流式处理、Tavily 搜索和 LangSmith 监控,可接入 GPT-4-mini、Llama3 等多种 LLM。2. Meeting Prep Agent: 一个智能日历助手,能自动研究会议参与者和公司信息,通过 React/FastAPI 界面提供会议洞察,利用 LangGraph 实现复杂的 Agent 工作流和实时推理。3. Generative UI: 探索生成式 UI 作为人机交互的未来,发布了 LangGraph.js 的生成式 UI 示例库,展示了 Agent 图在构建动态界面方面的潜力。(来源: LangChainAI, hwchase17, LangChainAI, Hacubu)

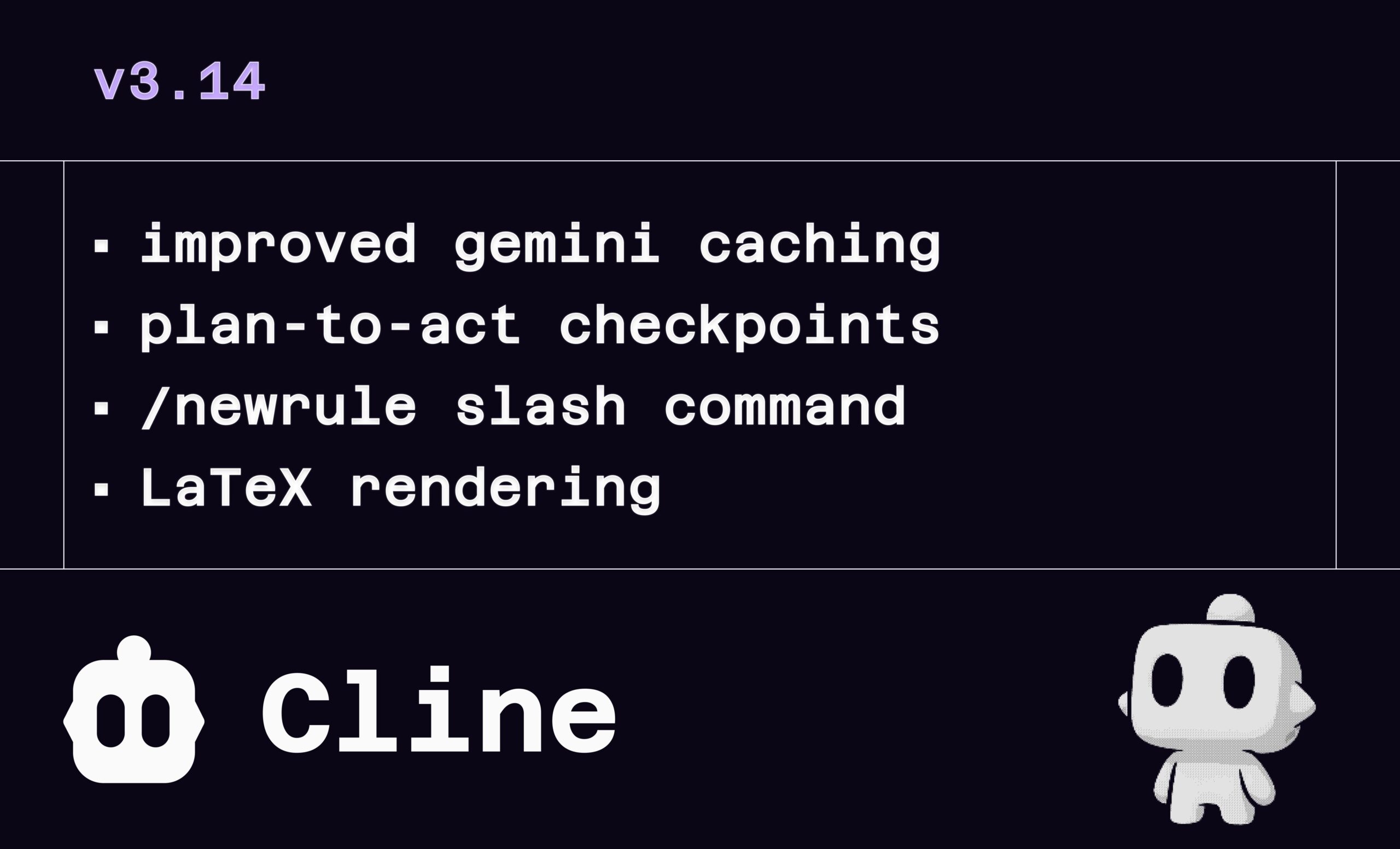

Cline v3.14 更新:支持 LaTeX、拖拽文件和规则定义: AI 编程助手 Cline 发布 v3.14 版本,带来多项功能更新:1. LaTeX 渲染:完全支持 LaTeX,可在聊天界面直接处理复杂数学公式和科学文档。2. 拖拽上传:支持从操作系统文件管理器直接拖放文件(需按住 Shift)以添加上下文。3. 规则定义:新增 /newrule 命令,可让 Cline 分析项目并生成设计系统、编码规范等规则文档,以强制执行项目标准。4. 流程检查点:在任务工作流中增加更多检查点,允许用户在“执行”(Act)前审查和修改计划。(来源: cline, cline, cline, cline)

LlamaParse 助力 11x.ai 构建智能 AI SDR: LlamaIndex 展示了其 LlamaParse 技术如何帮助 11x.ai 改进其 AI 销售开发代表(SDR)系统。通过集成 LlamaParse,11x.ai 能够处理用户上传的各种文档类型,为 AI SDR 提供必要的上下文信息,从而实现个性化的自动外联活动,并将新 SDR 的上手时间缩短至数天。这突显了高级文档解析技术在自动化业务流程和提升 AI 应用能力方面的重要性。(来源: jerryjliu0)

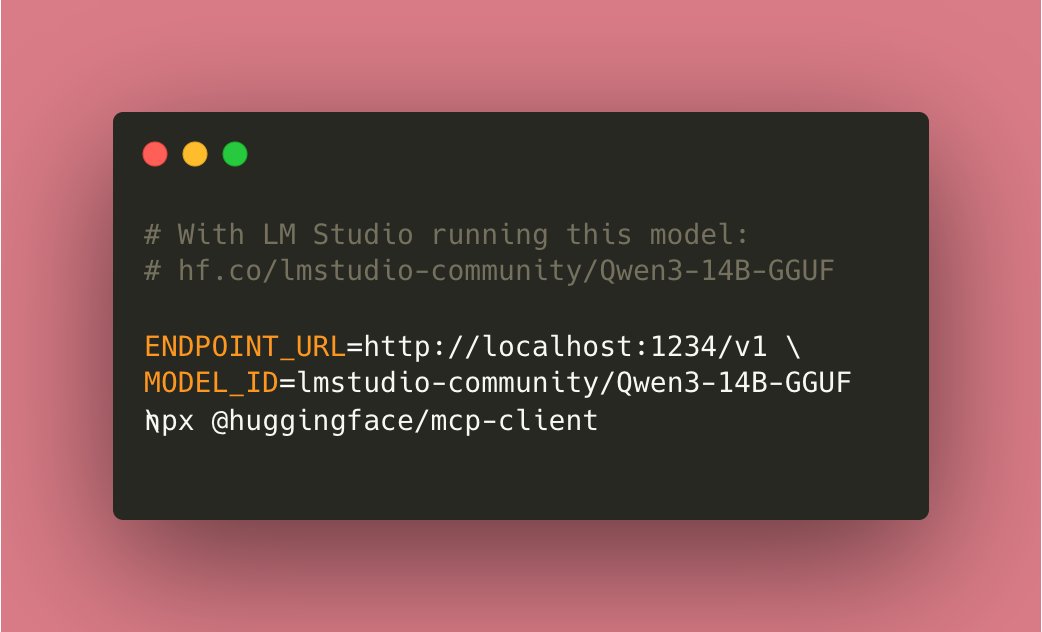

Tiny Agents 实现本地化运行: 社区贡献使得基于 Hugging Face mcp-client (huggingface.js) 的 Tiny Agents 现在可以完全在本地运行。用户只需在本地运行兼容工具的模型(如 Qwen3 14B),并通过设置 ENDPOINT_URL 指向本地 API 端点,即可实现本地化的 AI Agent 功能,这被认为是本地 AI 的一个重要进展。(来源: cognitivecompai)

本地命令行 AI Debug 工具 cloi: cloi 是一个基于命令行的 AI 代码调试工具,其特点是完全本地化运行。它内置了微软的 Phi-4 模型,同时也支持通过 Ollama 切换并运行其他的本地大语言模型。这为开发者提供了一个在本地环境中利用 AI 进行代码调试和分析的便捷选项。(来源: karminski3)

AI 决策电路:提升 LLM 系统可靠性: 一篇文章探讨了将电子电路设计理念应用于 LLM 系统,构建“AI 决策电路”以提高可靠性。通过这种方法,系统准确率可达 92.5%。该实现利用 LangSmith 进行实时跟踪和评估,以验证系统输出的准确性。这种方法为构建更可信赖、更可预测的 LLM 应用提供了新的思路。(来源: LangChainAI)

Local Deep Research (LDR)寻求改进意见: 开源研究工具 Local Deep Research 发布 v0.3.1,并向社区征集改进意见,包括需要关注的领域、所需功能、研究类型偏好以及 UI 改进建议。该工具旨在本地化运行深度研究任务,并推荐使用 SearXNG 以提高速度。(来源: Reddit r/LocalLLaMA)

OpenWebUI Adaptive Memory v3.1 发布: OpenWebUI 的自适应记忆功能更新至 v3.1,改进包括记忆置信度评分与过滤、支持本地/API Embedding 提供者、本地模型自动发现、Embedding 维度验证、Prometheus 指标检测、健康与指标端点、UI 状态发射器以及 Debug 修复。路线图包括重构、动态记忆标记、个性化响应定制、跨会话持久性验证、改进配置处理、检索调优、状态反馈、文档扩展、可选的外部 RememberAPI/mem0 同步及 PII 脱敏等。(来源: Reddit r/OpenWebUI)

📚 学习

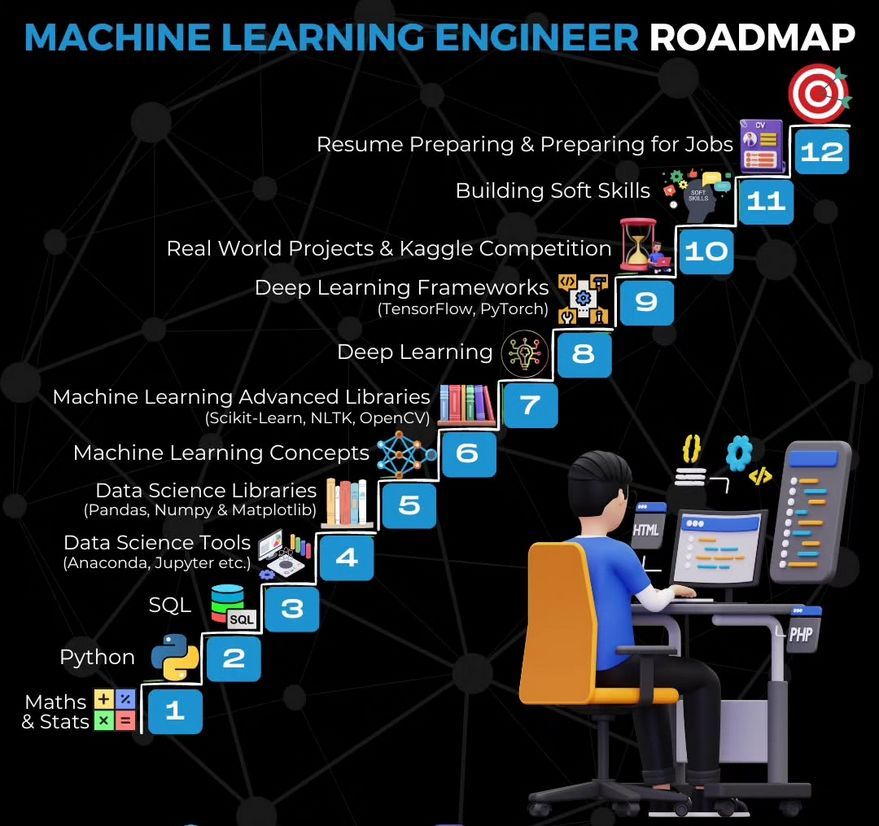

机器学习工程师学习路线图: Ronald van Loon 分享了一张机器学习工程师的学习路线图,为有志于进入该领域的人员提供了学习路径和关键技能的概览。(来源: Ronald_vanLoon)

使用 Gemma 构建视频摘要器教程: LangChainAI 发布了一个视频教程,演示如何使用本地运行的 Gemma LLM(通过 Ollama)构建一个视频摘要应用。该 Streamlit 应用利用 LangChain 处理视频并自动生成简洁摘要,为学习和实践本地 LLM 应用提供了实例。(来源: LangChainAI)

构建 MCP 服务器处理股票数据教程: LangChainAI 提供了一个教程,指导用户如何构建使用 FastMcp 和 LangChain 处理股票市场数据的 MCP (Machine Collaboration Protocol) 服务器。该指南演示了如何使用 LangGraph 创建 ReAct Agent 以实现标准化数据访问,有助于理解和应用 MCP 及 Agent 技术。(来源: LangChainAI)

LLM 合理性基准测试概念验证: Deep Learning Weekly 提及一篇博客文章,介绍了一个通过调整 ART-Y 评估来为 LLM 合理性创建概念验证基准。文章强调,评估 AI 是否比人类更理性(而非仅仅更聪明)至关重要。(来源: dl_weekly)

AI 红队测试作为批判性思维练习: Deep Learning Weekly 推荐了一篇文章,该文将 AI 红队测试(Red Teaming)定义为不仅仅是针对 LLM 的技术漏洞测试,而是一种源自军事和网络安全实践的批判性思维练习。这为理解和实施 AI 安全评估提供了更广阔的视角。(来源: dl_weekly)

Python 学习书籍推荐: 社区成员推荐了一本学习 Python 的书籍《Python Crash Course》,认为其为有效使用 Python 提供了一个良好的起点,并分享了 PDF 版本。强调了 Python 作为学习 AI 开发基础语言的重要性。(来源: omarsar0)

Deeply Supervised Nets 获 AISTATS 2025 时间检验奖: Saining Xie 的博士早期论文 “Deeply Supervised Nets” 获得了 AISTATS 2025 的时间检验奖。他分享道,这篇论文曾被 NeurIPS 拒稿,以此鼓励学生们在面对论文拒稿时保持毅力,坚持研究。(来源: sainingxie)

LLM 蒸馏方法概述讨论: Reddit 用户寻求关于 LLM 蒸馏方法的最新概述,特别是从大模型到小模型,以及从大模型到更专业模型的蒸馏。讨论中提到了三种主要类型:1. 生成数据+SFT(简单蒸馏);2. 基于 Logit 的蒸馏(模型需同构);3. 基于隐藏状态的蒸馏(模型可异构)。并提及了相关工具如 DistillKit。(来源: Reddit r/MachineLearning)

联邦微调 LLaMA2 的探索: Reddit 用户分享了使用 FedAvg 和 FedProx 对 LLaMA2 进行联邦微调的初步实验结果。实验在 Reddit TL;DR 数据集上进行,比较了全局验证 ROUGE-L、通信成本和客户端漂移。结果显示 FedProx 在降低漂移和略微提升 ROUGE-L 方面优于 FedAvg,但仍低于中心化微调。社区被邀请讨论适配器配置、压缩方法和非独立同分布数据下的稳定性问题。(来源: Reddit r/deeplearning)

💼 商业

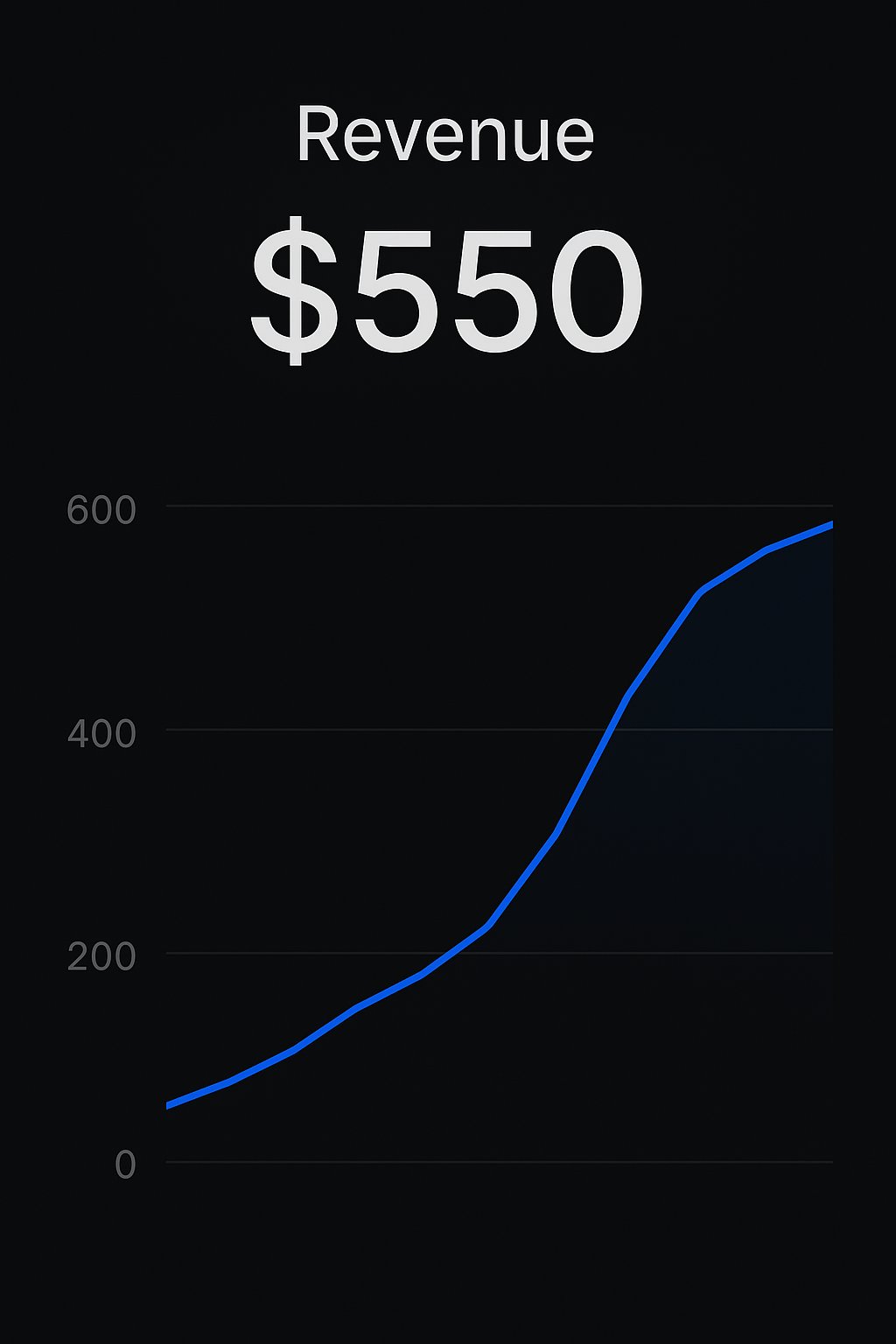

Replit 平台开发者实现应用变现: 两位开发者分享了通过 Replit 平台构建和销售 AI 应用的成功案例。一位开发者使用 CreateMVPs.app 获得了首个 550 美元的收入;另一位开发者在一天内构建的应用以 4700 美元售出,并获得了更多项目投标。这显示了 Replit 等平台在赋能开发者快速构建和商业化 AI 应用方面的潜力。(来源: amasad, amasad)

ChatGPT Edu 在西奈山伊坎医学院部署: 西奈山伊坎医学院宣布为所有医学和研究生提供 ChatGPT Edu 服务。这标志着 OpenAI 的教育版产品进入顶尖医疗教育机构,旨在利用 AI 辅助医学教育和研究。视频演示了其应用场景。(来源: gdb)

风险投资行业持续亏损引关注: Sam Altman 对风险投资(VC)行业整体长期亏损却仍能持续获得有限合伙人(LP)投资的现象表示不解。他认为,虽然投资顶尖基金是明智的,但整个行业的持续亏损现象值得思考其背后的原因和 LP 的动机。(来源: sama)

🌟 社区

AI 对就业和教育的影响讨论: 社区讨论 AI 自动化对现有工作模式(键盘-鼠标-屏幕界面)的潜在冲击,以及教育者应如何应对 AI 聊天机器人。观点认为,教师不应禁止学生使用 ChatGPT 等工具,而应教授如何有效、负责任地使用这些 AI,培养学生的 AI 素养和最佳实践能力。(来源: NandoDF, NandoDF)

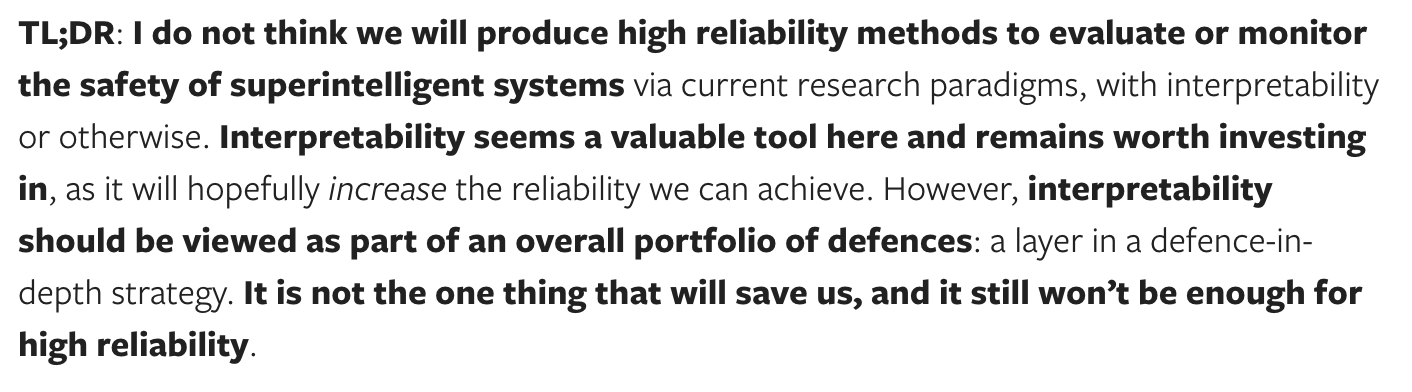

AI 可解释性与安全性的讨论: Dario Amodei 强调了 AI 模型可解释性的紧迫性,认为理解模型工作原理至关重要。Neel Nanda 对此提出不同看法,认为虽然可解释性投资是好的,但不应过度强调其相对于其他安全方法的重要性,可靠保障强大 AI 的路径并非只有可解释性一条,它应是安全措施组合的一部分。(来源: bookwormengr)

RLHF 的复杂性与模型“谄媚”现象讨论: Nathan Lambert 等人讨论了强化学习人类反馈(RLHF)的复杂性和重要性,以及由此产生的模型“谄媚”(sycophancy)现象(如 GPT-4o-simp)。文章认为 RLHF 对于模型对齐至关重要但过程混乱,用户往往不理解其复杂性,导致对模型行为产生误解或不满(如 LMArena 的反弹)。理解 RLHF 的内在挑战对于评估和改进模型至关重要。(来源: natolambert, aidangomez, natolambert)

AI 对人类认知能力和思维方式的潜在影响: 社区探讨 AI 对人类思维的潜在影响。一种担忧是过度依赖 AI 会导致认知能力下降(阅读变懒、批判性思维减弱)。另一种观点则认为,如果 AI 能提供更准确的信息和判断,它可能反而提升那些原本思维能力较弱或易受错误信息影响的人群的认知水平,起到“认知增强”作用,帮助做出更好的决策。同时,也有讨论认为 AI 的发展可能让我们更深入地理解意识,甚至发现某些人可能只是在模拟意识。(来源: riemannzeta, HamelHusain, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

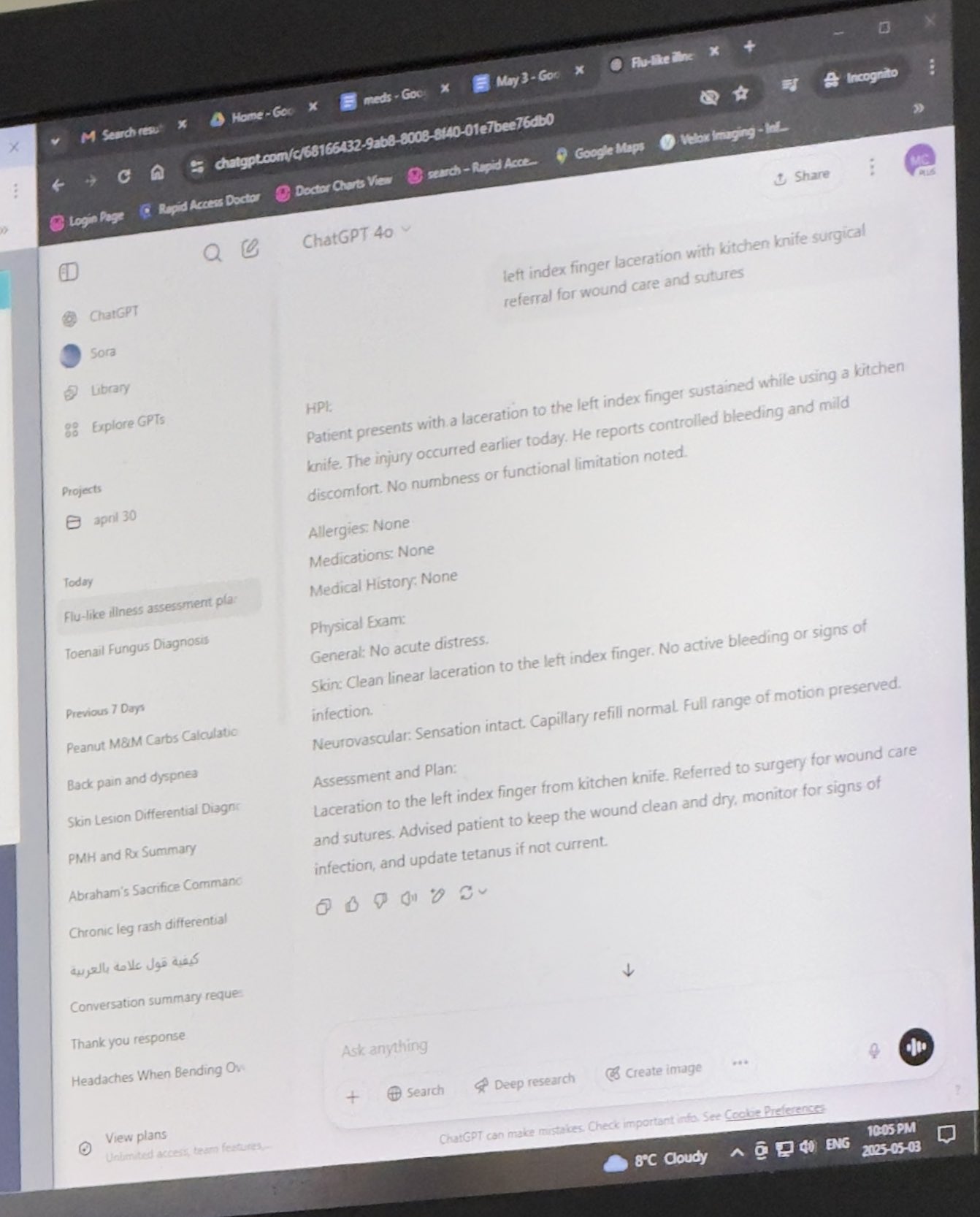

AI 伦理与应用场景讨论: 讨论涉及 AI 在医疗、法律等领域的应用。有用户分享医生在诊疗中使用 ChatGPT 的案例,引发关于 AI 在专业场景应用的讨论。同时,也有关于使用 AI 进行代笔(ghostwriting)的伦理考量,尤其是在作者自身遇到困难时。此外,还有对 AI 生成内容(如关于 ADHD 的书籍)可能带来的误导和风险的担忧。(来源: BorisMPower, scottastevenson, Reddit r/ArtificialInteligence, Reddit r/ArtificialInteligence)

AI 驱动的机器人进展: 展示了多款 AI 驱动的机器人:Google DeepMind 开发的能打乒乓球的机器人、展会上展示的机器狗、用于钻石镶嵌的机器人、受鸟类启发能跳跃起飞的无人机、用于艺术创作的机械凿子、以及宇树科技 G1 人形机器人在商场行走的视频。这些展示了 AI 在机器人控制、感知和交互方面的进步。(来源: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)

AI 与人文社科的未来: 引用《纽约客》文章观点,探讨 AI 对人文学科的影响。文章认为 AI 无法触及人类的“我性”(me-ness)和独特的人类体验,但同时指出,AI 通过重组和再现人类的集体书写(档案),能够模拟出很大一部分我们期望从人类个体处获得的东西,这对人文学科提出了挑战和新的思考维度。(来源: NandoDF)

💡 其他

AI 辅助工具用于个人提升: Reddit 用户分享了使用 ChatGPT 作为个人健身和营养教练的成功经验,通过 AI 制定训练计划、饮食方案(结合生酮、力量训练、禁食等),甚至在点餐时获取宏量营养素建议,最终取得了比付费人类教练更好的效果。这展示了 AI 在个性化指导和生活辅助方面的潜力。(来源: Reddit r/ChatGPT)

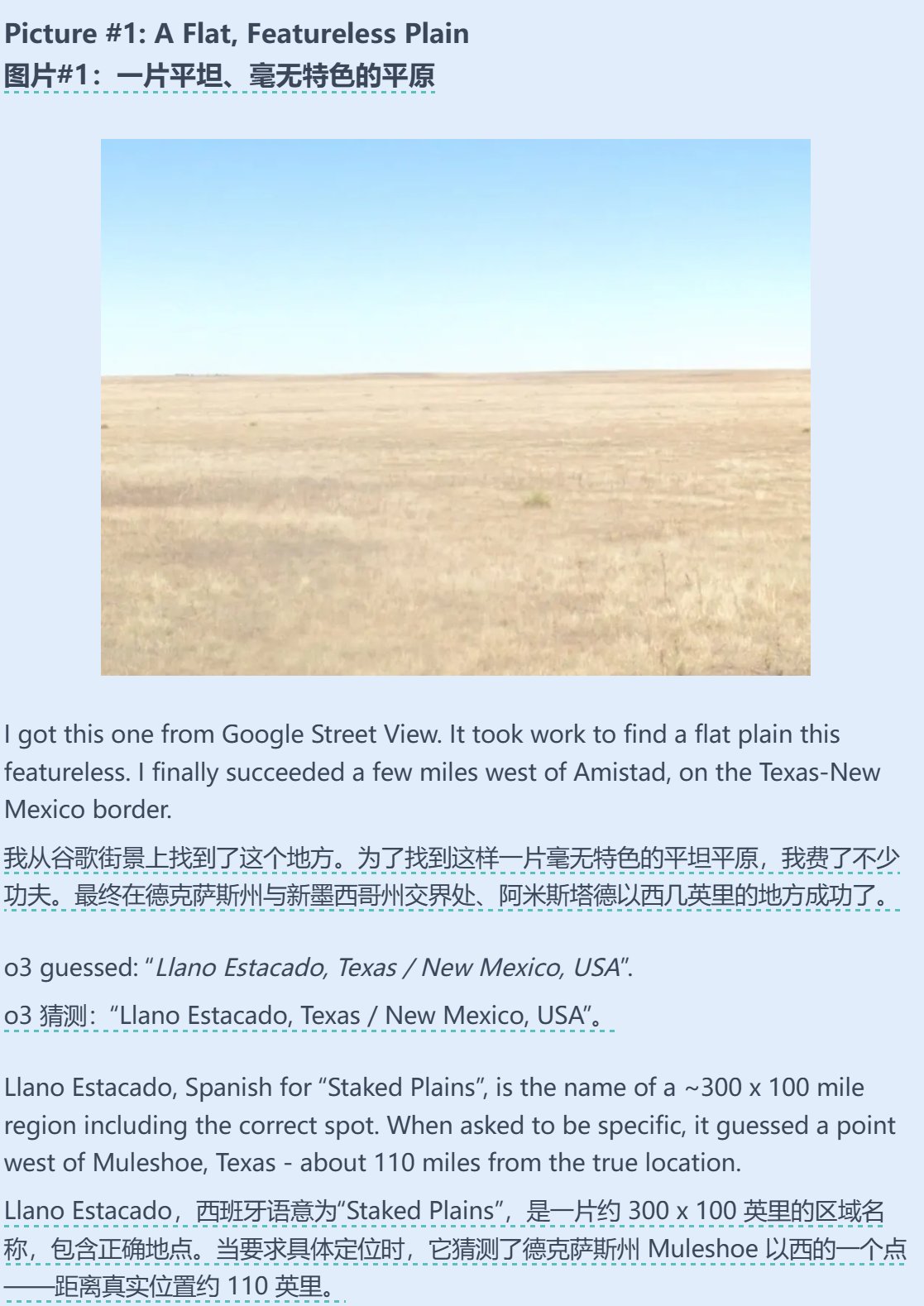

AI 与地理猜测能力的结合: Sam Altman 转发并评论了一篇关于 AI(可能是 o3)在 Geoguessr(地理猜测游戏)中展现出惊人能力的测试文章。即使图片信息极少(如只有模糊的标志甚至纯渐变色),AI 也能在选项中包含正确答案,显示了其强大的图像识别、模式匹配和地理知识推理能力。(来源: op7418)

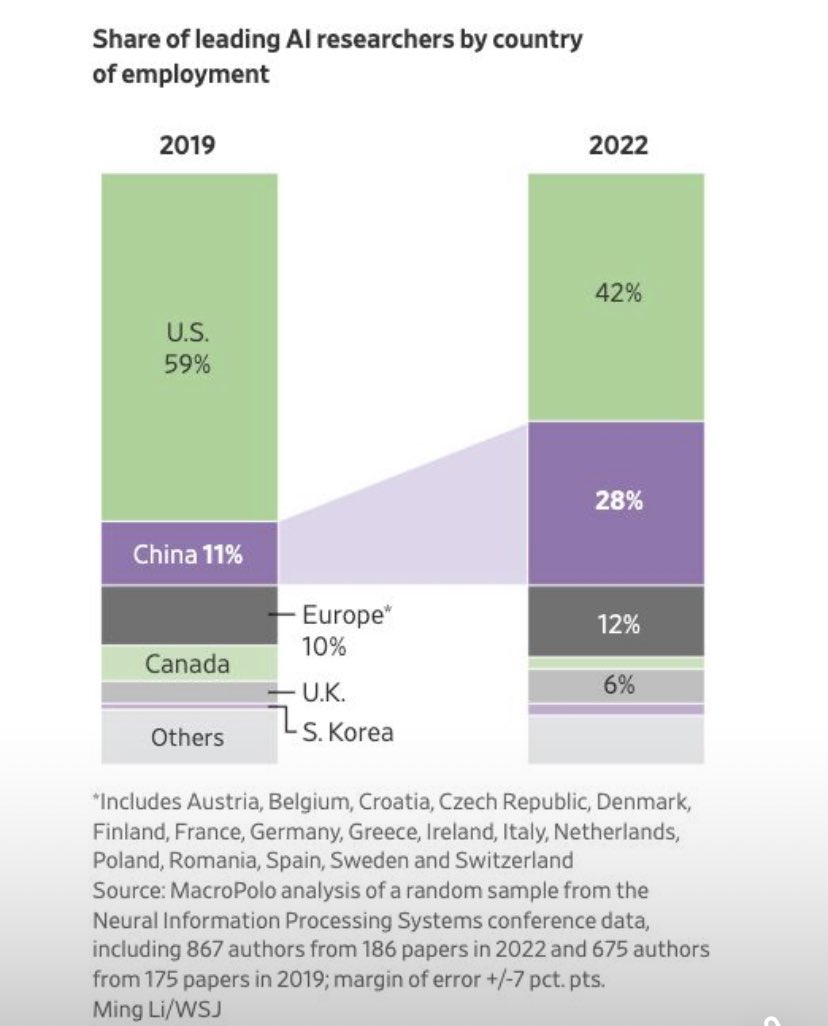

AI 领域研究人员流动趋势: 图表显示,AI 领域顶尖研究人员的就业国家分布发生变化,在美国就业的研究人员比例下降,而在中国就业的比例显著上升。社区评论指出,考虑到中国本土研究机会的增加以及潜在的人才回流,实际差距可能比图表显示的更大,反映了全球 AI 人才竞争格局的变化。(来源: teortaxesTex, bookwormengr)