关键词:AI四小龙, 具身智能, 人形机器人, 内存墙, 商汤日日新V6多模态模型, Open X-Embodiment数据集, 特斯拉Optimus机器人, 3D铁电RAM技术, 天工Ultra机器人半马, Gemma 3 QAT量化模型, Hugging Face收购Pollen Robotics, LlamaIndex智能体文档工作流

🔥 聚焦

“AI四小龙”面临挑战与转型 : 商汤、旷视、云从、依图等曾被誉为“AI四小龙”的公司,近年来普遍面临商业化困境和持续亏损。例如,商汤2024年亏损43亿元,累计亏损超546亿元;云从2024年亏损近6-7亿元,累计亏损超44亿元。为应对挑战,各公司纷纷进行战略调整,包括裁员、降薪、业务重组。面对以大语言模型为主导的新AI浪潮,拥有视觉技术基因的“四小龙”正积极转向多模态大模型和AGI领域。商汤发布对标GPT-4o的“日日新V6”多模态模型,并大力投入智算中心建设;依图专注以视觉为中心的多模态模型,并与华为合作降低硬件成本;云从也与华为合作推出大模型训推一体机;旷视则凭借算法优势,切入智能驾驶纯视觉方案。这些举措表明它们正努力留在AI牌桌上,适应新的市场环境。(来源: 36氪)

具身智能数据困境与开源数据集进展 : 人形机器人和具身智能的发展面临关键的数据瓶颈,高质量训练数据的缺乏阻碍了其能力的突破。与拥有海量互联网文本数据的语言模型不同,机器人需要多样化的物理世界交互数据,获取成本高昂。为解决此问题,研究机构和企业正积极构建和开源数据集,如谷歌DeepMind联合多机构发布的Open X-Embodiment、鹏城实验室等的ARIO、北京创新中心的RoboMIND、智元机器人的AgiBot World(包含真实场景的长程复杂任务数据)及AgiBot Digital World仿真数据集、宇树的G1操作数据集等。这些数据集虽规模仍远小于文本数据,但通过统一标准、提升质量和丰富场景,正推动具身智能领域发展,为实现“ImageNet时刻”奠定基础。(来源: 36氪)

人形机器人量产曙光:数据、仿真与泛化突破 : 尽管面临数据采集成本高、泛化能力弱等挑战,多家公司(特斯拉、Figure AI、1X、智元、宇树、优必选等)仍计划在2025年实现人形机器人量产。解决路径包括:1)大规模真机训练,由政府(北京、上海、深圳、广东)支持建设数据采集基地和制定标准;2)先进仿真训练,利用英伟达Cosmos、谷歌Genie2等世界模型生成物理真实的虚拟环境,降低成本、提高效率;3)AI赋能泛化,通过Figure AI的Helix、智元GO-1的ViLLA架构、谷歌Gemini Robotics等新型动作模型,利用更少数据实现对物理操作的泛化理解,让机器人能处理未见过物体和适应新环境。这些技术进步预示着人形机器人商业化应用可能加速到来。(来源: 36氪)

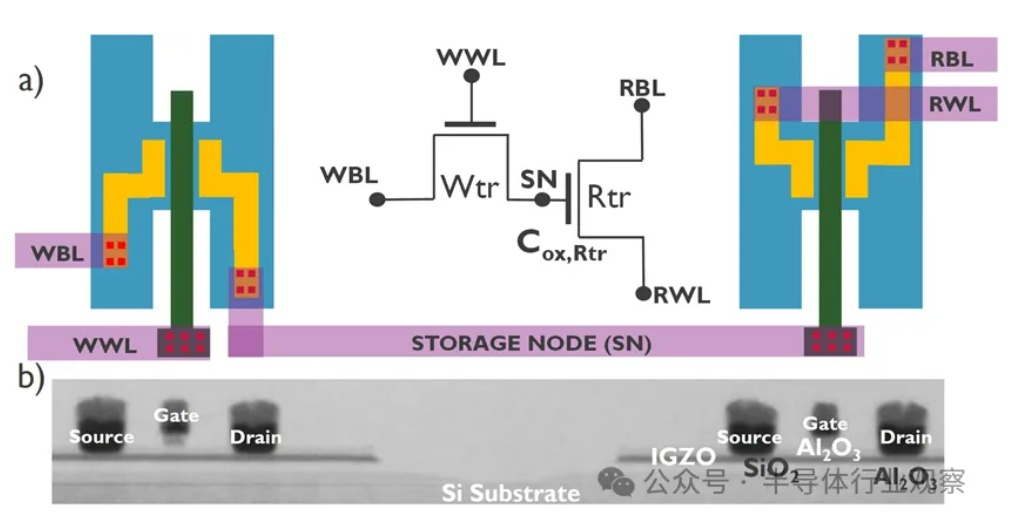

AI发展遭遇“内存墙”危机,新型存储技术寻求突破 : AI模型规模的指数级增长对内存带宽提出严峻挑战,传统DRAM带宽增速远不及算力增长,形成“存储墙”瓶颈,限制了处理器性能发挥。HBM通过3D堆叠技术大幅提升带宽,缓解了部分压力,但其制造工艺复杂、成本高昂。为此,业界正积极探索新型存储技术:1) 3D铁电RAM (FeRAM):如SunRise Memory,利用HfO2铁电效应,实现高密度、非易失、低功耗存储。2) DRAM+非易失性内存:Neumonda与FMC合作,利用HfO2将DRAM电容转变为非易失性存储。3) 2T0C IGZO DRAM:imec提出用两个氧化物晶体管替代传统1T1C结构,无需电容,实现低功耗、高密度、长保持时间。4) 相变存储器 (PCM):利用材料相变存储数据,功耗降低。5) UK III-V Memory:基于GaSb/InAs,兼具DRAM速度和闪存非易失性。6) SOT-MRAM:利用自旋轨道扭矩,实现低功耗、高能效。这些技术有望打破DRAM瓶颈,重塑存储市场格局。(来源: 36氪)

🎯 动向

天工机器人完成半马挑战,计划小批量量产 : 北京人形机器人创新中心的天工队机器人“天工Ultra”(身高1.8米,体重55千克)在首个人形机器人半程马拉松赛事中夺冠,用时2小时40分42秒跑完约21公里。此次赛事检验了机器人在复杂路况下的续航、结构、感知和控制算法的可靠性。团队表示,通过优化关节稳定性、耐热性、能耗系统、平衡与步态规划算法,并搭载自主研发的“慧思开物”平台(具身大脑+小脑),机器人实现了无线领航下的自主路径规划与实时调整。完成马拉松证明了其基本可靠性,为量产奠定基础。天工2.0机器人即将发售,计划小批量生产,未来目标应用于工业、物流、特种作业及家庭服务等领域。(来源: 36氪)

中国研发利用培养的人类细胞构建机器人大脑 : 据报道,中国研究人员正在开发一种由培养的人类脑细胞驱动的机器人。这项研究旨在探索生物计算的可能性,利用生物神经元的学习和适应能力来控制机器人硬件。虽然具体细节和进展阶段尚不明确,但这一方向代表了机器人、人工智能和生物技术交叉领域的前沿探索,可能为未来开发更智能、更适应性强的机器人系统开辟新途径。(来源: Ronald_vanLoon)

Gemma 3 QAT 量化模型性能优异 : 用户在 GPQA Diamond 基准测试中对比了 Google Gemma 3 27B 模型的 QAT (Quantization Aware Training) 版本与其他 Q4 量化版本(Q4_K_XL, Q4_K_M)。结果显示,QAT 版本在性能上表现最佳(36.4% 准确率),同时 VRAM 占用最低(16.43 GB),优于 Q4_K_XL (34.8%, 17.88 GB) 和 Q4_K_M (33.3%, 17.40 GB)。这表明 QAT 技术在保持模型性能的同时有效降低了资源需求。(来源: Reddit r/LocalLLaMA)

传闻AMD将推出32GB显存RDNA 4 Radeon PRO显卡 : VideoCardz 报道称,AMD 正在准备基于 Navi 48 XTW GPU 的 Radeon PRO 系列显卡,将搭载 32GB 显存。如果属实,这将为需要大显存进行本地 AI 模型训练和推理的用户提供一个新的选择,尤其是在消费级显卡显存普遍受限的情况下。但具体性能、价格和发布日期尚未公布,其实际竞争力仍有待观察。(来源: Reddit r/LocalLLaMA)

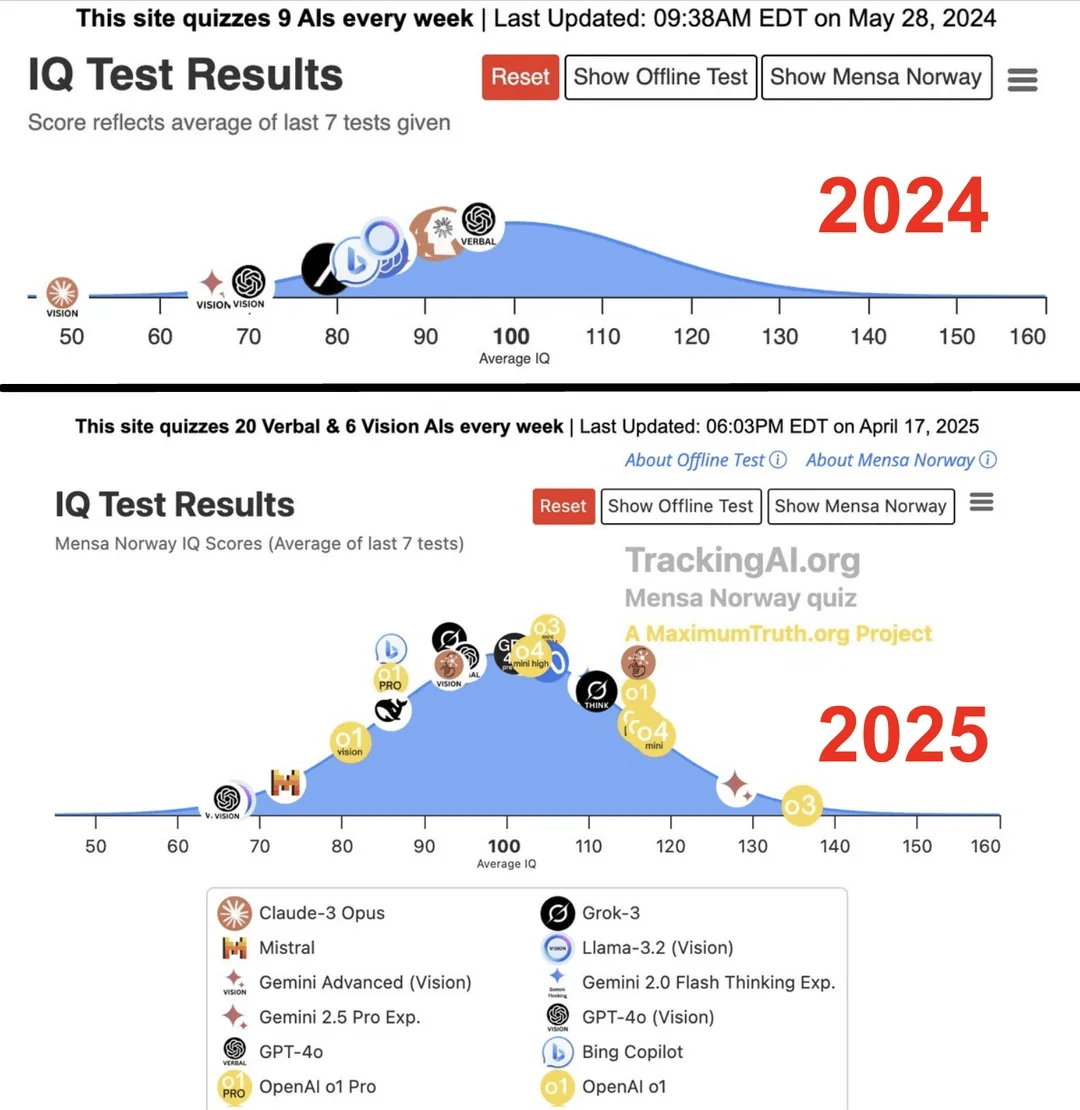

研究称顶尖AI一年内IQ从96跃升至136 : 根据 Maximum Truth 网站发布的研究(来源可靠性待考证),通过对AI模型进行IQ测试,发现最聪明的AI(可能指GPT系列)的IQ得分在一年内从96分(略低于人类平均水平)提升到了136分(接近天才水平)。虽然IQ测试衡量AI智能的有效性存在争议,且存在训练数据污染测试的可能性,但这一显著提升反映了AI在解决标准化智力测验问题能力上的快速进步。(来源: Reddit r/artificial)

🧰 工具

OpenUI:通过描述实时生成UI : wandb 开源了 OpenUI,这是一个允许用户通过自然语言描述来构想和实时渲染用户界面的工具。用户可以提出修改要求,并将生成的 HTML 转换为 React、Svelte、Web Components 等多种前端框架代码。OpenUI 支持多种 LLM 后端,包括 OpenAI、Groq、Gemini、Anthropic (Claude) 以及通过 LiteLLM 或 Ollama 连接的本地模型。该项目旨在使 UI 组件构建过程更快、更有趣,并作为 W&B 内部测试和原型设计的工具。虽然灵感来源于 v0.dev,但 OpenUI 是开源的。提供了在线 Demo 和本地运行指南(Docker 或源码)。(来源: wandb/openui – GitHub Trending (all/daily))

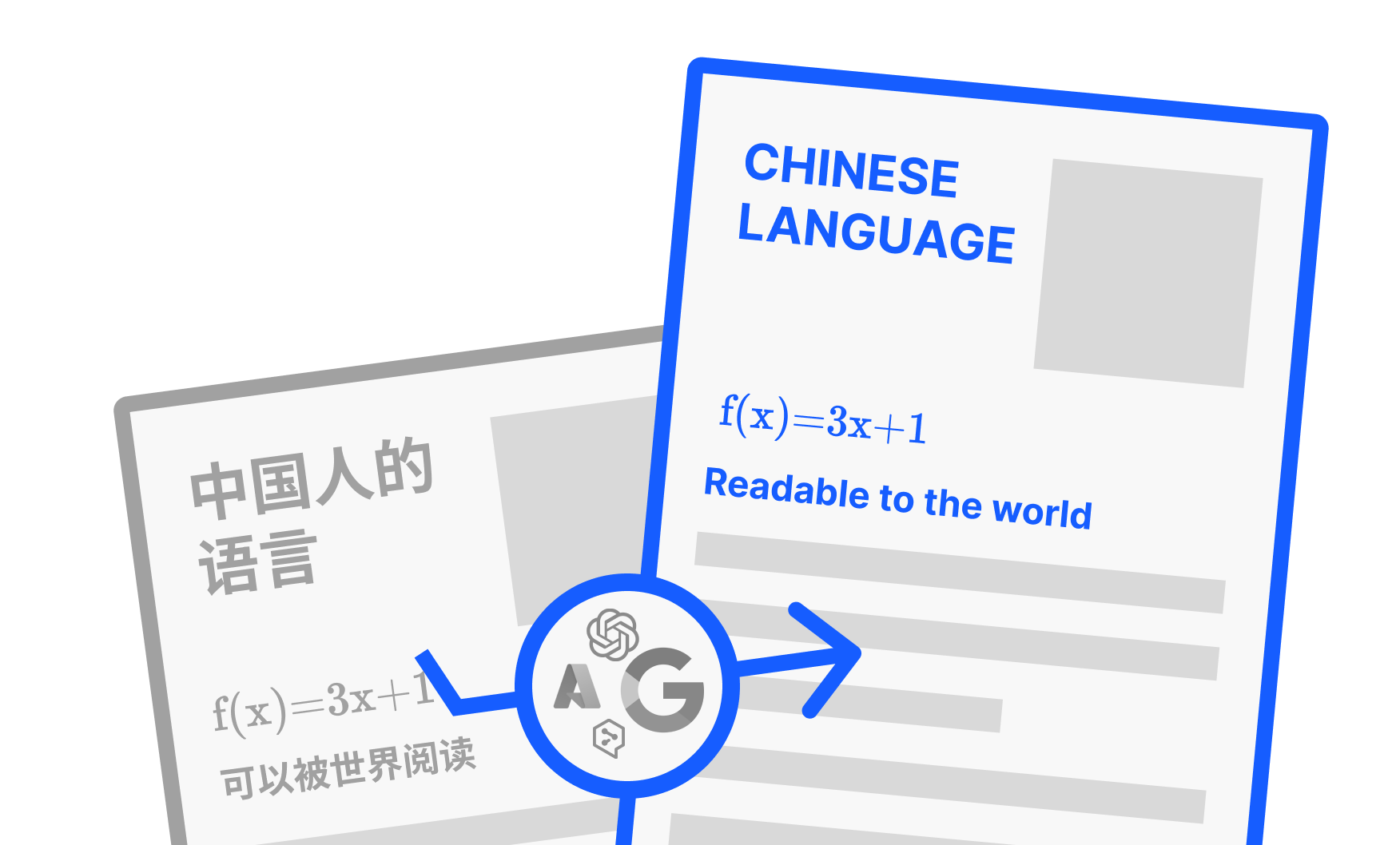

PDFMathTranslate:保留排版的AI PDF翻译工具 : Byaidu 开发的 PDFMathTranslate 是一款强大的 PDF 文档翻译工具,其核心优势在于利用 AI 技术在翻译的同时,能够完整保留原始文档的排版格式,包括复杂的数学公式、图表、目录和注释等。该工具支持多种语言互译,并集成了 Google、DeepL、Ollama、OpenAI 等多种翻译服务。为方便不同用户,项目提供了命令行(CLI)、图形用户界面(GUI)、Docker 镜像以及 Zotero 插件等多种使用方式。用户可以在线试用 Demo 或根据需求选择合适的安装方法。(来源: Byaidu/PDFMathTranslate – GitHub Trending (all/daily))

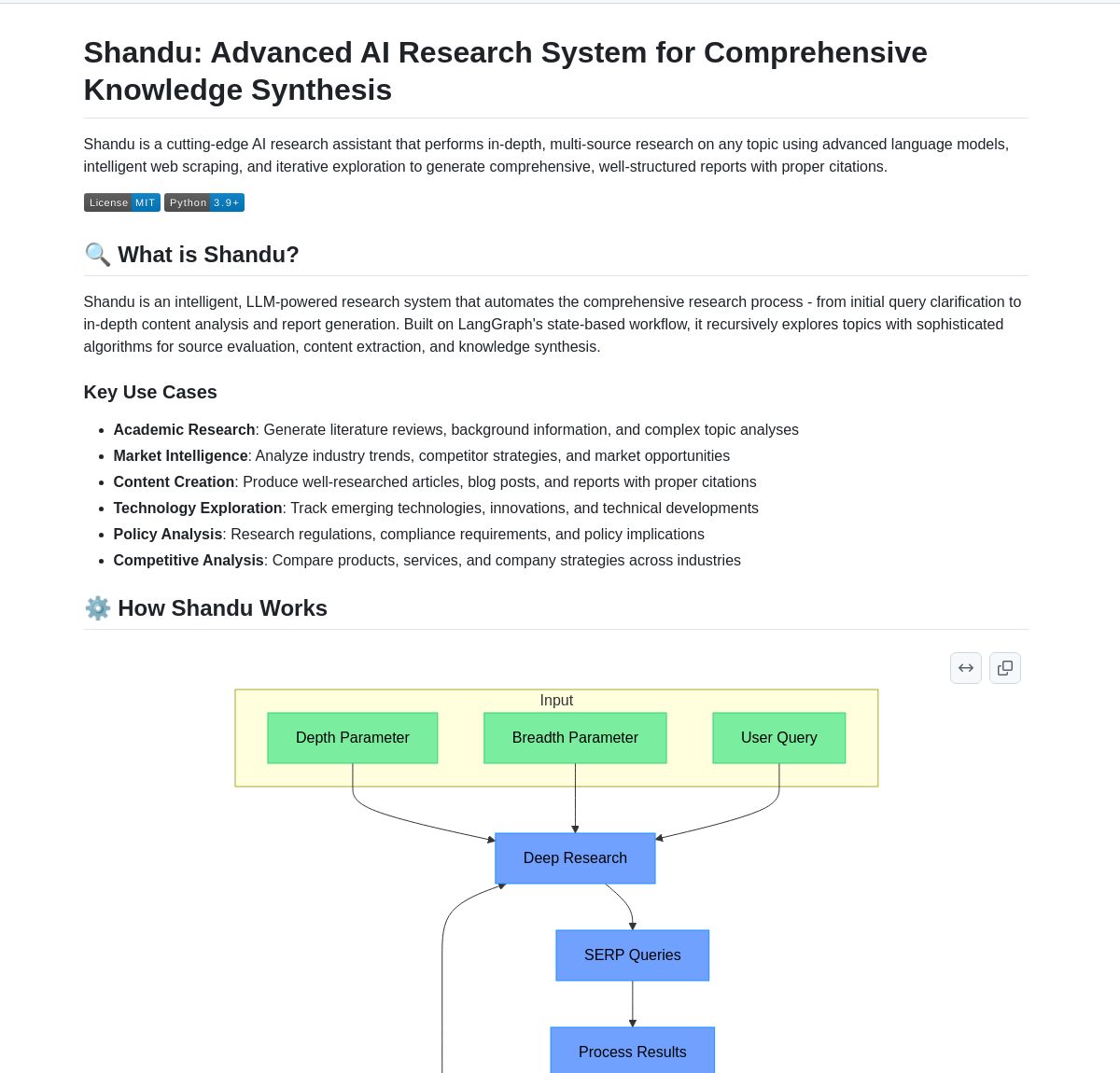

Shandu AI Research:基于LangGraph的引用报告生成系统 : Shandu AI Research 是一个利用 LangGraph 工作流自动生成带引用报告的系统。它通过智能网页抓取、多源信息综合以及并行处理等技术,旨在简化研究任务。该工具可以帮助用户快速收集、整合和分析信息,并生成结构化、带引用的研究报告,提高研究效率。(来源: LangChainAI)

Intel发布开源AI Playground : Intel 开源了 AI Playground,这是一个面向 AI PC 的入门级应用程序,允许用户在搭载 Intel Arc 显卡的 PC 上运行各种生成式 AI 模型。支持的图像/视频模型包括 Stable Diffusion 1.5、SDXL、Flux.1-Schnell、LTX-Video;支持的大语言模型包括 DeepSeek R1、Phi3、Qwen2、Mistral(Safetensor PyTorch LLM),以及 Llama 3.1、Llama 3.2、TinyLlama、Mistral 7B、Phi3 mini、Phi3.5 mini(GGUF LLM 或 OpenVINO)。该工具旨在降低本地运行 AI 模型的门槛,方便用户体验和实验。(来源: karminski3)

Persona Engine:AI虚拟助手/主播项目 : Persona Engine 是一个开源项目,旨在创建一个交互式 AI 虚拟助手或虚拟主播。它整合了大型语言模型(LLM)、Live2D 动画、自动语音识别(ASR)、文本转语音(TTS)以及实时语音克隆技术。用户可以直接与 Live2D 形象进行语音对话,项目也支持集成到 OBS 等直播软件中,用于创建 AI 虚拟主播。该项目展示了多种 AI 技术的融合应用,提供了一个构建个性化虚拟交互角色的框架。(来源: karminski3)

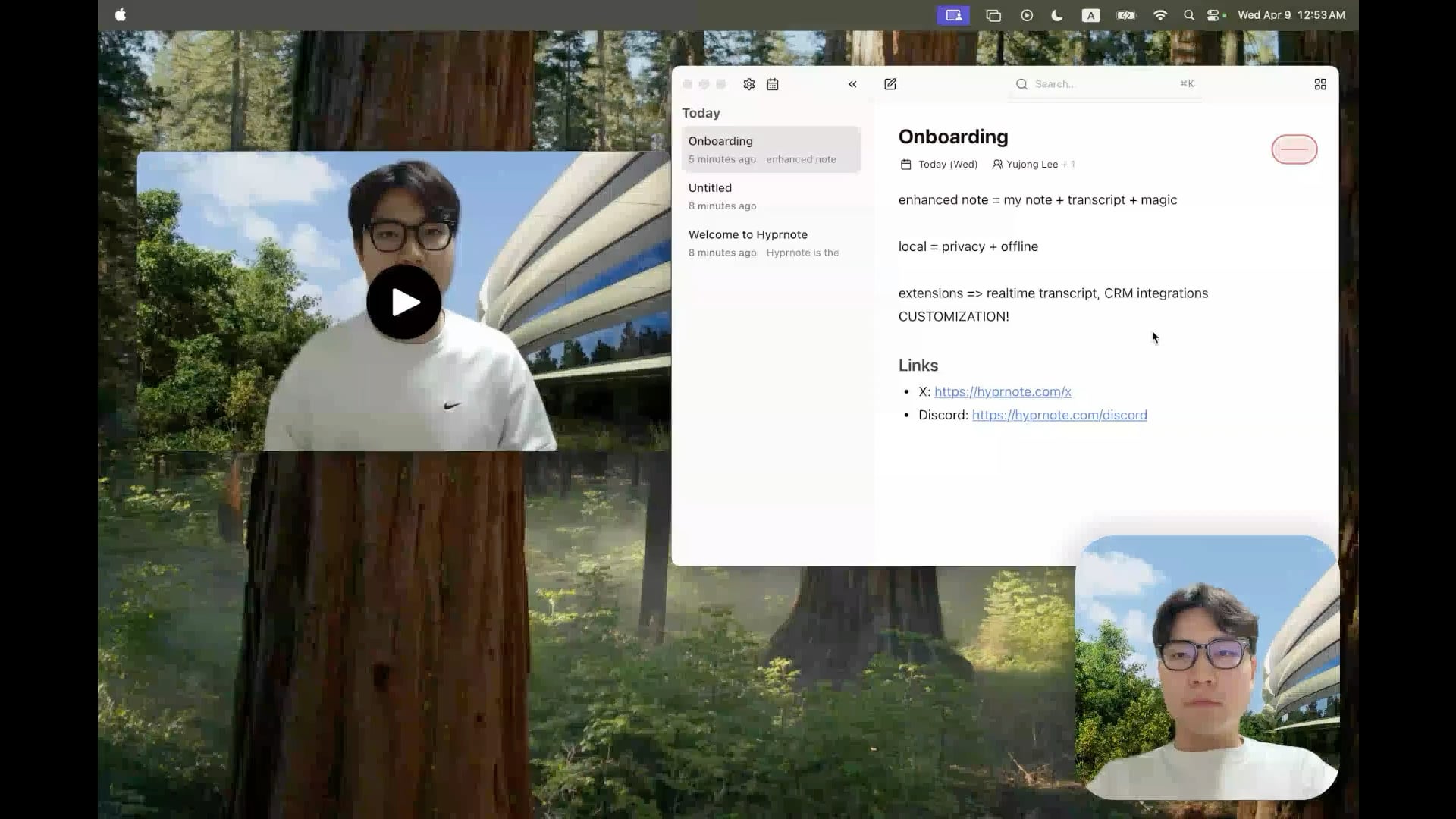

Hyprnote:开源本地AI会议笔记工具 : 开发者开源了 Hyprnote,这是一款专为会议场景设计的智能笔记应用。它可以在会议期间进行录音,并将用户的原始笔记与会议音频内容相结合,生成增强版的会议记录。核心特点是完全在本地运行 AI 模型(如 Whisper 进行语音转录),确保用户数据的隐私和安全。该工具旨在帮助用户更好地捕捉和整理会议信息,特别适合需要处理连续会议的用户。(来源: Reddit r/LocalLLaMA)

LMSA:连接LM Studio到Android设备的工具 : 用户分享了一款名为 LMSA 的应用程序(lmsa.app),该应用旨在帮助用户将 LM Studio(一款流行的本地 LLM 运行管理工具)连接到他们的 Android 设备上。这使得用户可以通过手机或平板电脑与在本地 PC 上运行的 AI 模型进行交互,扩展了本地大模型的使用场景。(来源: Reddit r/LocalLLaMA)

基于MobileNetV2的本地图像搜索工具 : 开发者构建并分享了一个使用 PyQt5 图形界面和 TensorFlow MobileNetV2 模型的桌面图像搜索工具。该工具可以索引本地图像文件夹,根据图像内容(通过 CNN 提取特征)使用余弦相似度查找相似图片。它能自动检测文件夹结构作为分类,并显示搜索结果的缩略图、相似度百分比和文件路径。项目代码已在 GitHub 开源,寻求用户反馈。(来源: Reddit r/MachineLearning)

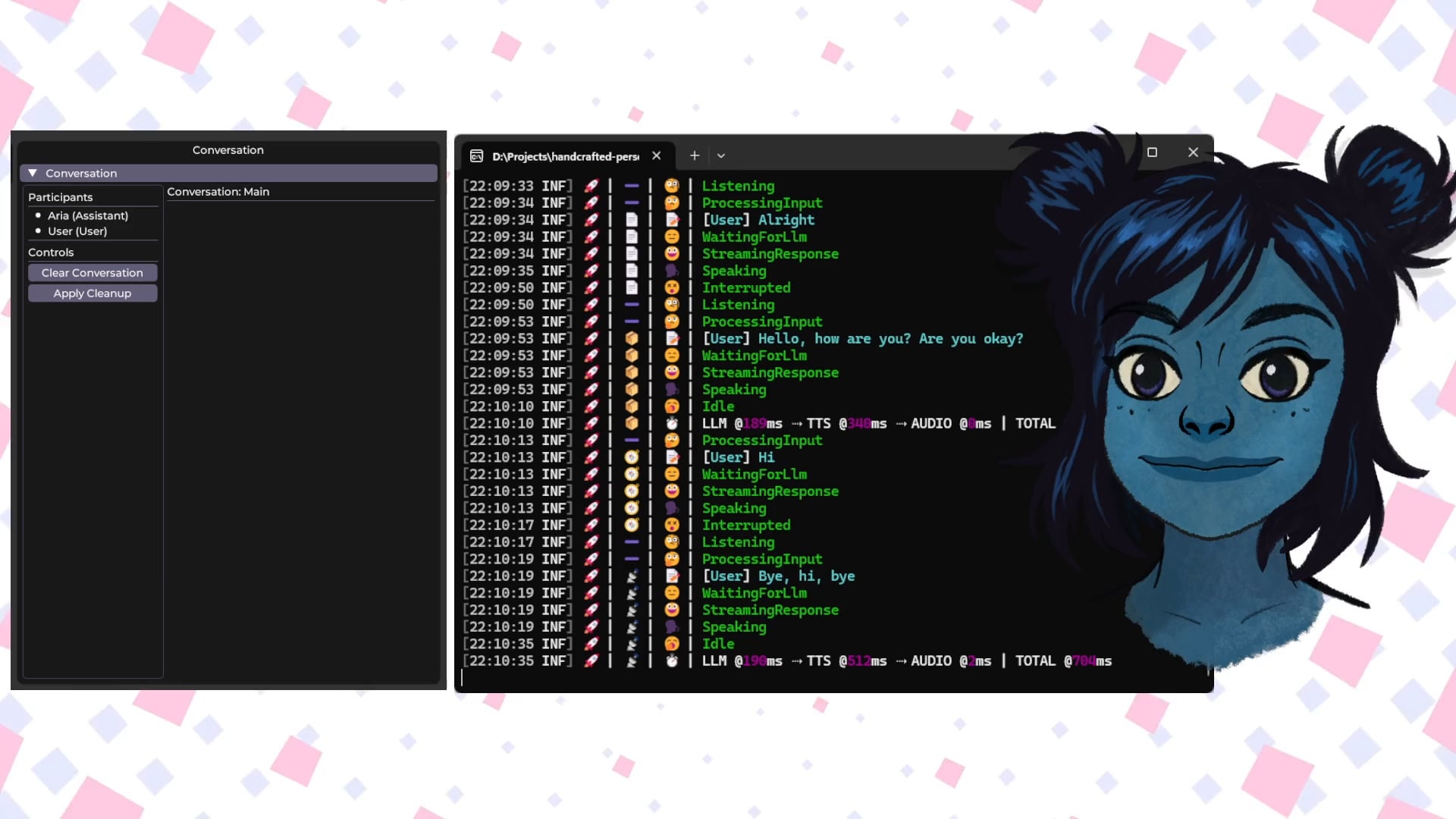

Handcrafted Persona Engine:本地AI语音交互虚拟形象 : 开发者分享了一个个人项目 “Handcrafted Persona Engine”,旨在创建一个类似 “芝麻街” 体验的、完全在本地运行的交互式语音驱动虚拟形象。该系统整合了本地Whisper进行语音转录,通过Ollama API调用本地LLM进行对话生成(包含个性化设定),使用本地TTS将文本转为语音,并驱动Live2D角色模型进行口型同步和情感表达。项目使用C#构建,可在GTX 1080 Ti级别的显卡上运行,并已在GitHub开源。(来源: Reddit r/LocalLLaMA)

Talkto.lol:与名人AI形象对话的实验工具 : 开发者创建了一个名为 talkto.lol 的网站,允许用户与不同名人(如 Sam Altman)的 AI 人格进行对话。该工具还包含一个 “show me” 功能,用户可以上传图片,AI 会对其进行分析并生成回应,展示了 AI 的视觉识别能力。开发者表示将利用该平台进行更多关于 AI 人格交互的实验。该工具无需注册即可试用。(来源: Reddit r/artificial)

📚 学习

人形机器人基础:挑战与数据采集 : 人形机器人的发展正从简单的自动化迈向复杂的“具身智能”,即基于物理身体感知和行动的智能系统。与处理语言、图像的AI大模型不同,机器人需要理解真实物理世界,处理包括空间感知、运动规划、力学反馈等多维度数据。获取这些高质量的真实世界数据是巨大挑战,成本高昂且难以覆盖所有场景。目前主要采集方式包括:1) 真实世界采集:通过光学或惯性动作捕捉系统记录人类动作,或通过人类远程遥操作机器人执行任务并记录真机数据(如特斯拉Optimus)。2) 仿真世界采集:利用仿真平台模拟环境和机器人行为,生成大量数据以降低成本并提高泛化能力,但需解决仿真与现实的差距(Sim-to-Real Gap)。此外,利用互联网视频数据进行预训练也是探索方向。(来源: 36氪)

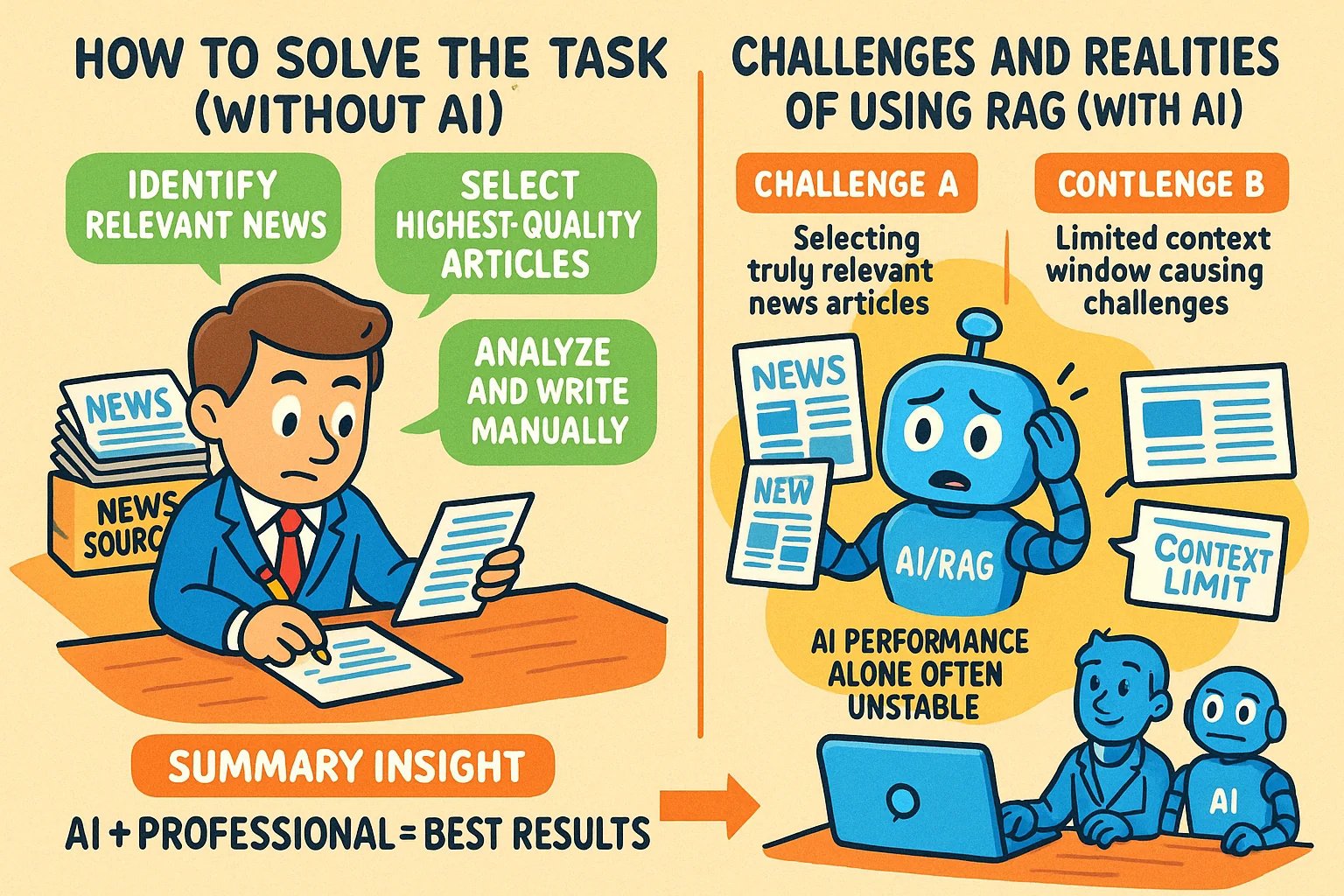

为知识类文章生成信息图风格配图的技巧 : 用户分享了使用 GPT-4o 等AI工具为知识类文章生成信息图(infographic)风格配图的方法。核心技巧是让 AI 先帮助撰写生成图片的提示词(prompt)。具体步骤:将文章内容或要点提供给 AI,并要求它编写一个用于生成横版信息图的提示词,要求包含英文文字、卡通图像,风格清晰生动,能概括核心观点。要点:提供完整内容给AI;明确要求“信息图”;文字多时建议用英文以提高生成准确性;推荐使用 GPT-4.5、o3 或 Gemini 2.5 Pro 生成提示词;使用 Sora Com 或 ChatGPT 等工具生成最终图片。(来源: dotey)

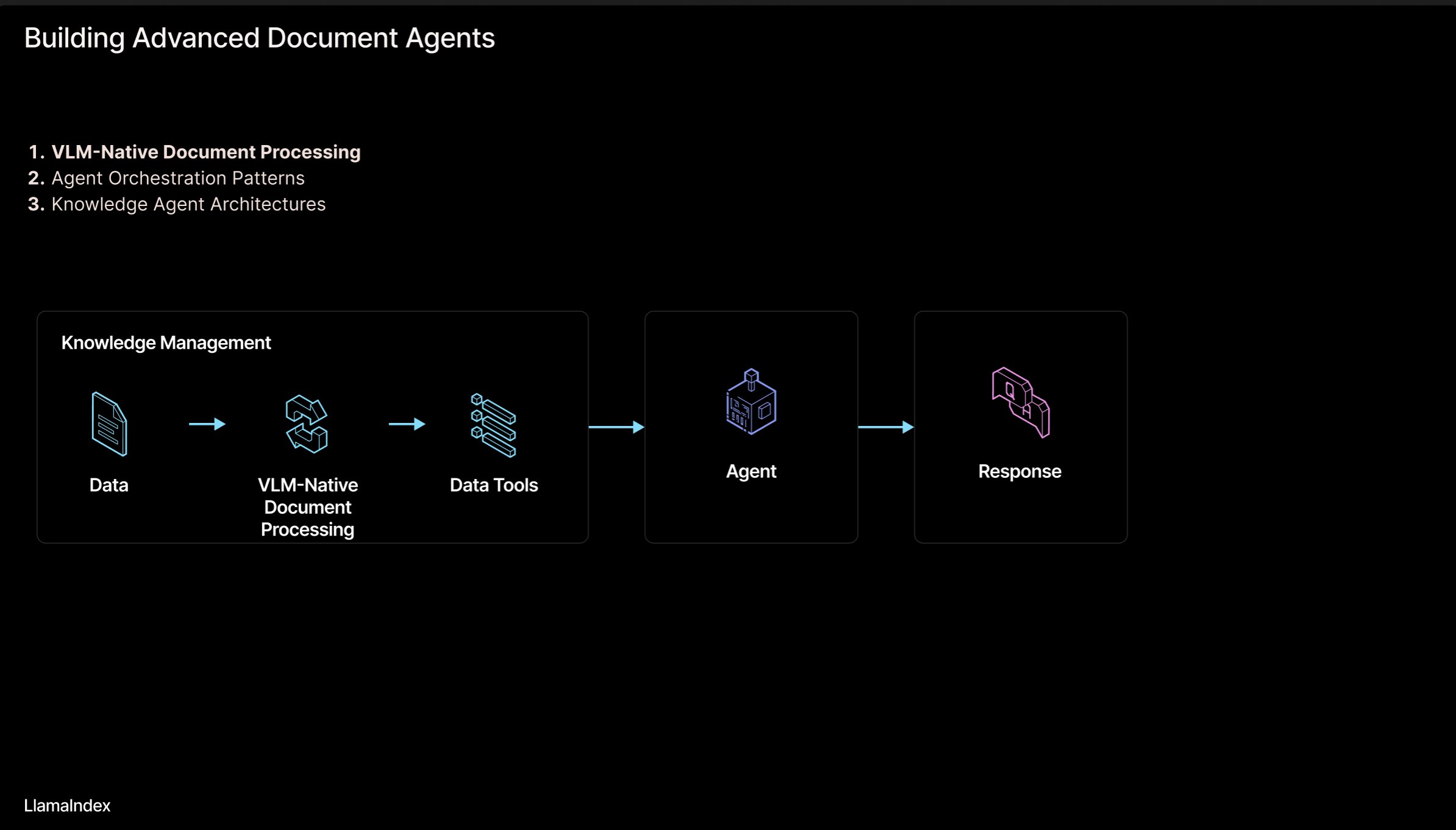

LlamaIndex:智能体文档工作流架构 : LlamaIndex 创始人 Jerry Liu 分享了一套用于构建处理文档(PDF, Excel等)的智能体(Agentic)工作流架构的幻灯片。该架构旨在释放被锁定在人类可读格式文档中的知识,让 AI 智能体能够解析、推理和操作这些文档。架构主要包含两个层面:1) 文档解析与提取:利用视觉语言模型(VLM)等技术创建文档的机器可读表示(MCP Server)。2) 智能体工作流:将解析后的文档信息与智能体框架(如 LlamaIndex)结合,实现自动化知识工作。幻灯片可在 Figma 查看,相关技术在 LlamaCloud 中有所应用。(来源: jerryjliu0)

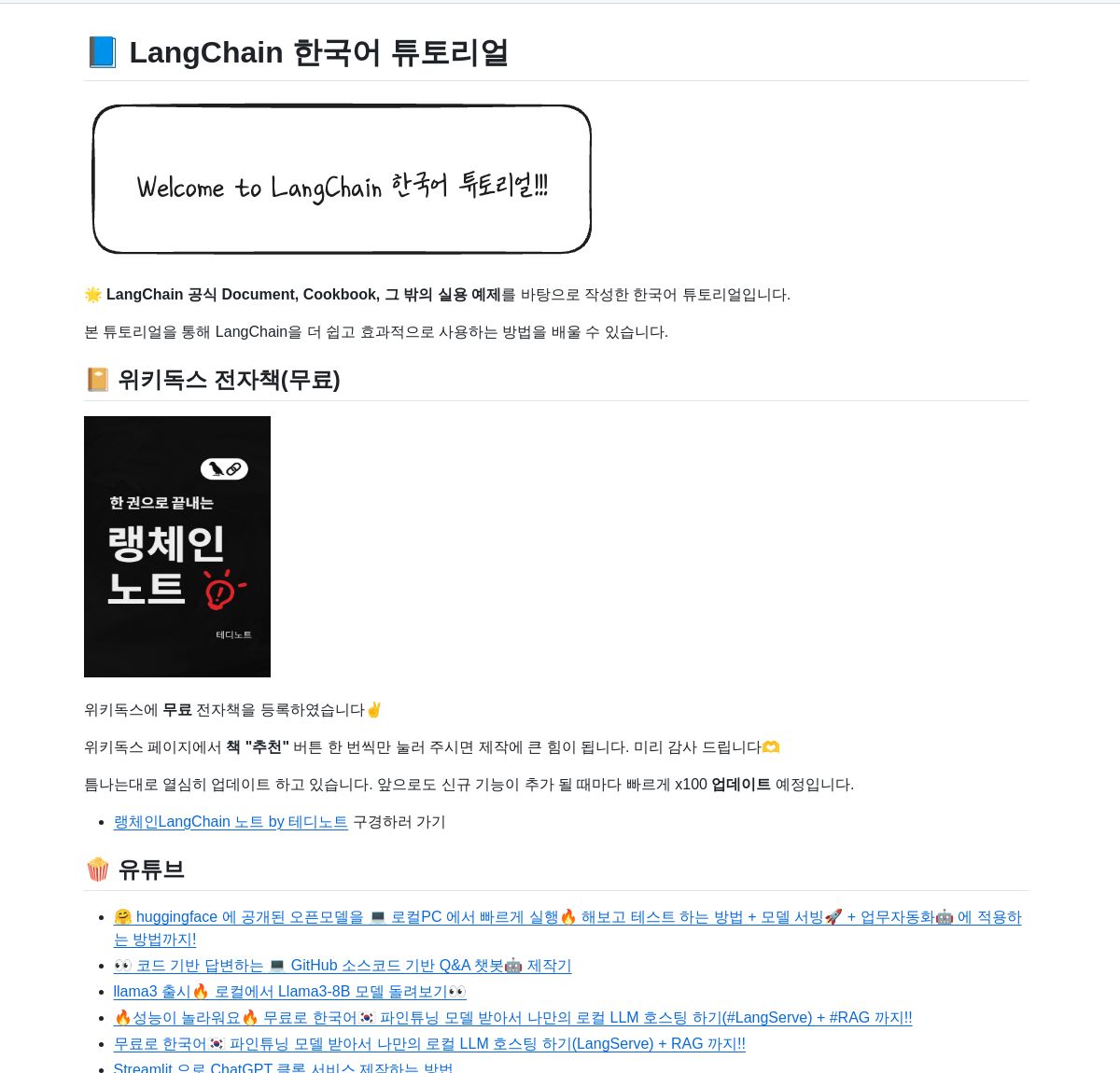

LangChain 韩语教程资源库 : GitHub 上提供了一个 LangChain 韩语教程项目。该项目通过电子书、YouTube 视频内容和交互式示例等多种形式,为韩语用户提供 LangChain 的学习资源。内容覆盖 LangChain 的核心概念、LangGraph 系统构建以及 RAG(检索增强生成)的实现等关键主题,旨在帮助韩语开发者更好地理解和应用 LangChain 框架。(来源: LangChainAI)

使用 Deno 和 LangChain.js 构建本地 AI 应用指南 : Deno 博客发布了一篇指南,介绍如何结合使用 Deno(现代 JavaScript/TypeScript 运行时)、LangChain.js 和本地大语言模型(通过 Ollama 托管)来构建 AI 应用。文章重点展示了如何利用 TypeScript 创建结构化的 AI 工作流,并集成了 Jupyter Notebook 进行开发和实验。该指南为希望在 Deno 环境下使用 JavaScript/TypeScript 进行本地 AI 应用开发的开发者提供了实践指导。(来源: LangChainAI)

构建AI应用的逻辑心智模型 (LMM) : 用户提出一个用于构建 AI 应用(尤其是 Agentic 系统)的逻辑心智模型(LMM)。该模型建议将开发逻辑分为两层:高层逻辑(面向智能体和具体任务),包括工具与环境(Tools and Environment)和角色与指令(Role and Instructions);低层逻辑(通用基础架构),包括路由(Routing)、护栏(Guardrails)、LLM访问(Access to LLMs)和可观测性(Observability)。这种分层有助于 AI 工程师和平台团队协同工作,提高开发效率。用户还提到了相关的开源项目 ArchGW,专注于低层逻辑实现。(来源: Reddit r/artificial)

超越经典计算的AGI理论框架 : 一位计算机科学研究员分享了他的预印本论文,提出了一个新的人工通用智能(AGI)理论框架。该框架试图超越传统的统计学习和确定性计算(如深度学习),整合了神经科学、量子力学(多维认知空间、量子叠加)和哥德尔不完备性定理(哥德尔自指成分、直觉)的概念。模型假设意识由熵衰减驱动,并提出了一个统一智能方程,结合了神经网络学习、概率认知、意识动力学和直觉驱动的洞察力。该研究旨在为 AGI 提供新的概念和数学基础。(来源: Reddit r/deeplearning)

管理AI交互的安全提示 : Reddit用户分享了针对AI新用户的建议和提示(prompt),旨在帮助用户更好地管理人机交互过程,避免在与AI的对话中迷失或产生不必要的恐惧。建议包括:1) 使用特定提示词(如“为我总结这次会话”)来回顾和控制交互流程;2) 认识到AI的局限性(如缺乏真实情感、意识和个人经历);3) 在感到迷失时主动结束或开启新的会话。强调了保持对AI本质的清醒认识的重要性。(来源: Reddit r/artificial)

论文:统一流匹配与能量基模型的生成建模 : 研究者分享了一篇预印本论文,提出了一种统一流匹配(Flow Matching)和能量基模型(Energy-Based Models, EBMs)的新生成建模方法。该方法的核心思想是:在远离数据流形时,样本沿着无旋度的最优传输路径从噪声移动到数据;当接近数据流形时,一个熵能量项引导系统进入玻尔兹曼平衡分布,从而显式捕捉数据的似然结构。整个动态过程由一个单一的、时间无关的标量场参数化,该场既可作为生成器,也可作为先验,用于逆问题的有效正则化。该方法在保持EBM灵活性的同时,显著提高了生成质量。(来源: Reddit r/MachineLearning)

TensorFlow优化器实现库 : 开发者创建并分享了一个 GitHub 仓库,其中包含了多种常用优化器(如 Adam, SGD, Adagrad, RMSprop 等)的 TensorFlow 实现。该项目旨在为使用 TensorFlow 的研究人员和开发者提供方便、标准化的优化器实现代码,有助于理解和应用不同的优化算法。(来源: Reddit r/deeplearning)

使用深度学习进行多模态数据分析文章 : Rackenzik.com 发布了一篇关于使用深度学习进行多模态数据分析的文章。文章可能探讨了如何结合来自不同来源(如文本、图像、音频、传感器数据等)的数据,利用深度学习模型(如融合网络、注意力机制等)来提取更丰富的信息、进行更准确的预测或分类。多模态学习是当前 AI 研究的热点,在理解复杂现实世界问题方面具有重要潜力。(来源: Reddit r/deeplearning)

寻找图神经网络(GNN)学习资源 : Reddit 用户寻求关于图神经网络(GNN)的优质学习资料,包括入门文献、书籍、YouTube 视频或其他资源。评论中推荐了斯坦福大学 Jure Leskovec 教授的 GNN 讲座视频,认为他是该领域的先驱。另一个评论推荐了一个解释 GNN 基本原理的 YouTube 视频。该讨论反映了学习者对 GNN 这一重要深度学习分支的兴趣。(来源: Reddit r/MachineLearning)

利用AI快速构建和发布应用的流程分享 : 一位开发者分享了自己利用 AI 工具快速构建和发布应用的完整流程。关键步骤包括:1) 构思:原创思考并进行竞品研究。2) 规划:使用 Gemini/Claude 生成产品需求文档(PRD)、技术栈选型和开发计划。3) 技术栈:推荐 Next.js, Supabase (PostgreSQL), TailwindCSS, Resend, Upstash Redis, reCAPTCHA, Vercel 等,利用免费套餐起步。4) 开发:使用 Cursor (AI编程助手) 加速 MVP 开发。5) 测试:使用 Gemini 2.5 生成测试和验证计划。6) 发布:列出多个适合发布产品的平台(Reddit, Hacker News, Product Hunt等)。7) 理念:强调有机增长、重视反馈、保持谦逊、专注有用性。还分享了辅助工具如代码打包器、Markdown转PDF等。(来源: Reddit r/ClaudeAI)

💼 商业

AI模型的法律保护路径:竞争法优于版权与商业秘密 : 文章以“抖音诉亿睿科AI模型侵权案”为例,深入探讨了AI模型(结构与参数)的法律保护模式。分析认为,AI模型作为技术核心,难以通过著作权法(模型开发非创作行为,生成内容独创性存疑)或商业秘密法(易被逆向工程,保密措施难落实)获得有效保护。该案二审法院最终采纳竞争法路径,认定亿睿科复制抖音模型结构与参数构成不正当竞争,损害了抖音投入研发获得的“竞争利益”。文章主张竞争法更适合规制此类行为,能通过“实质性替代”标准判断市场影响,打击“搭便车”,同时需注意平衡,避免抑制合理创新。(来源: 36氪)

Hugging Face收购Pollen Robotics,推进开源机器人 : Hugging Face 收购了法国机器人初创公司 Pollen Robotics,该公司以其开源人形机器人 Reachy 2 而闻名。此举是 Hugging Face 推动开放机器人计划的一部分,特别是在研究和教育领域。Reachy 2 机器人被描述为友好、易于接近,适合自然交互,目前售价约为 7 万美元。此次收购表明 Hugging Face 在具身智能和机器人领域的布局意图,旨在将开源理念扩展到硬件和物理交互层面。(来源: huggingface, huggingface)

Anthropic推出Claude Max订阅计划 : Anthropic 推出了名为 “Claude Max” 的新订阅计划,定价为每月 100 美元。该计划似乎定位高于现有的 Pro 计划(通常为 20 美元/月)。有用户评论认为 Max 计划提供了新的研究功能和更高的使用限制,但也有用户认为其性价比不高,缺乏图像生成、视频生成、语音模式等功能,且研究功能未来可能也会加入 Pro 计划。(来源: Reddit r/ClaudeAI)

🌟 社区

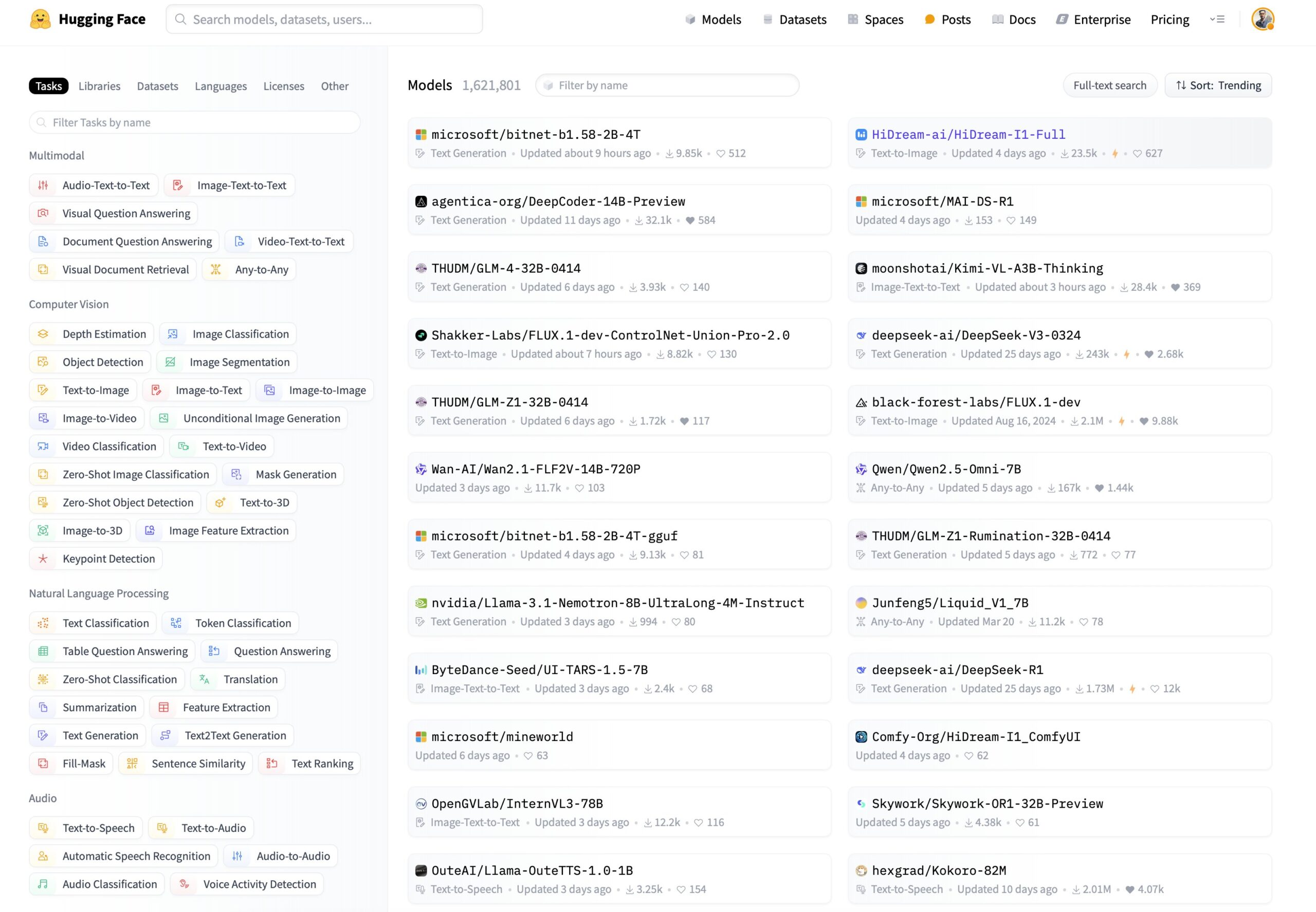

Hugging Face模型筛选新需求:按推理能力和大小排序 : 用户在社交媒体上提议 Hugging Face 平台增加新的模型筛选和排序功能。具体建议包括:1) 增加一个筛选器,用于仅显示具备推理能力的模型;2) 增加一个排序选项,可以根据模型的大小(footprint)进行排序。这些功能将帮助用户更方便地发现和选择适合特定需求的模型,特别是那些关注模型推理性能和部署资源消耗的用户。(来源: huggingface)

用户在Hugging Face DeepSite上构建经典游戏 : 一位用户分享了在 Hugging Face DeepSite 平台上成功构建并运行经典游戏的经验。该用户利用 DeepSite 的 Canvas 功能(支持 HTML, CSS, JS)和 Novita/DeepSeek 模型完成了项目。这展示了 DeepSite 平台的多功能性,不仅限于传统的模型推理和展示,还可以用于构建交互式Web应用和游戏,为开发者提供了新的创作空间。(来源: huggingface)

用户观点:AI更像文艺复兴而非工业革命 : 用户评论赞同 Sam Altman 的观点,认为当前 AI 的发展感觉更像是“文艺复兴”而非“工业革命”。用户表达了一种期望与现实的落差:虽然期待 AI 能解决实际问题(如做家务、赚钱),但目前感受到的更多是 AI 在创意领域的应用(如生成吉卜力风格的图片)。这反映了部分用户对于 AI 技术发展方向和实际落地应用的思考与感受。(来源: dotey)

ChatGPT/Claude 用户渴望“Fork”功能 : LlamaIndex 创始人作为 ChatGPT Pro、Claude 和 Gemini 的重度用户,表达了对聊天机器人增加“Fork”(分叉)功能的强烈需求。他指出,在处理不同任务时,不希望在同一对话线程中混淆上下文,但每次重新粘贴大量预设背景信息又非常繁琐。“Fork”功能将允许用户基于当前对话状态(包含上下文)创建一个新的、独立的对话分支,从而提高使用效率。他还探讨了其他可能的实现方式,如内存管理工具或Slack风格的线程。(来源: jerryjliu0)

音乐模型Orpheus在Hugging Face下载量达10万 : Orpheus 音乐模型在 Hugging Face 平台上的下载量达到了 10 万次。开发者 Amu 将此视为一个小里程碑,并预告即将推出 Orpheus v1 版本。这一成绩反映了社区对该音乐生成模型的关注和兴趣。(来源: huggingface)

ChatGPT在解决健康问题方面的潜力显现 : 用户分享观察到越来越多关于 ChatGPT 帮助人们解决长期健康问题的轶事。虽然强调还有很长的路要走,但这表明 AI 已经在以有意义的方式改善人们的生活,尤其是在信息获取、症状分析或寻求医疗建议的初步阶段。这些案例突显了 AI 在医疗健康领域的辅助潜力。(来源: gdb)

用户与Grok探讨意识模型 : Reddit 用户分享了与 Grok AI 讨论自己提出的意识模型的经历。用户提供了一个草稿论文链接,并展示了与 Grok 的对话截图,讨论了模型的概念。这反映了用户利用大型语言模型作为思想碰撞、讨论复杂理论(如意识)的工具。(来源: Reddit r/artificial)

Claude Sonnet 3.7 自发“发明”React引关注 : Reddit 用户分享了一段视频,声称 Claude Sonnet 3.7 在没有明确提示的情况下,自发地阐述了类似于 React.js 框架的核心概念。这种出乎意料的“创造性”或“联想能力”引发了社区讨论,展示了大型语言模型在特定知识领域可能展现出的复杂行为。(来源: Reddit r/ClaudeAI)

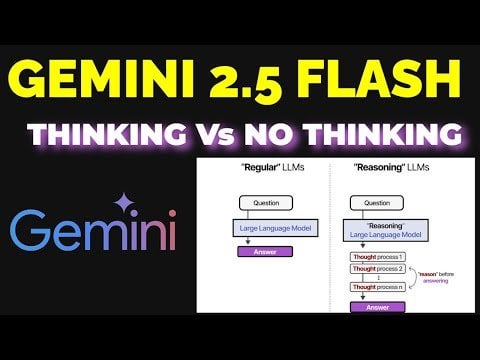

Gemini 2.5 Flash 推理模式效果探讨 : 用户通过实验对比了 Gemini 2.5 Flash 在开启和关闭“思考”(reasoning)模式下的表现。实验覆盖了数学、物理、编码等多个领域。结果出乎意料,即使用户认为需要高思考预算的任务,关闭思考模式的版本也给出了正确答案。这引发了对 Gemini Flash 2.5 在无推理模式下能力的肯定,并质疑了推理模式的必要应用场景。详细对比过程分享在 YouTube 视频中。(来源: Reddit r/MachineLearning)

ChatGPT生成用户心中形象引发热议 : Reddit 用户发起活动,让 ChatGPT 根据对话历史和推断的用户心理画像生成用户形象图片。许多用户分享了 ChatGPT 为他们生成的图片,这些图片风格各异,有的梦幻多彩,有的书生气十足,有的则显得深沉复杂。这一互动展示了 ChatGPT 的图像生成能力和基于文本理解进行创意推断的尝试,也引发了用户对自己数字形象的趣味讨论。(来源: Reddit r/ChatGPT, Reddit r/ChatGPT)

本地运行Gemma 3模型需手动配置Speculative Decoding : 用户询问如何在本地运行 Gemma 3 模型时启用 Speculative Decoding(推测解码)以加速推理,并指出 LM Studio 界面未提供该选项。社区回复建议直接使用 llama.cpp 命令行工具,可以更灵活地配置包括推测解码在内的各种运行参数。有用户分享了使用 1B 模型作为 27B 模型的草稿模型进行推测解码的经验,但也提到对于新的 QAT 量化模型,该技术可能反而降低速度。(来源: Reddit r/LocalLLaMA)

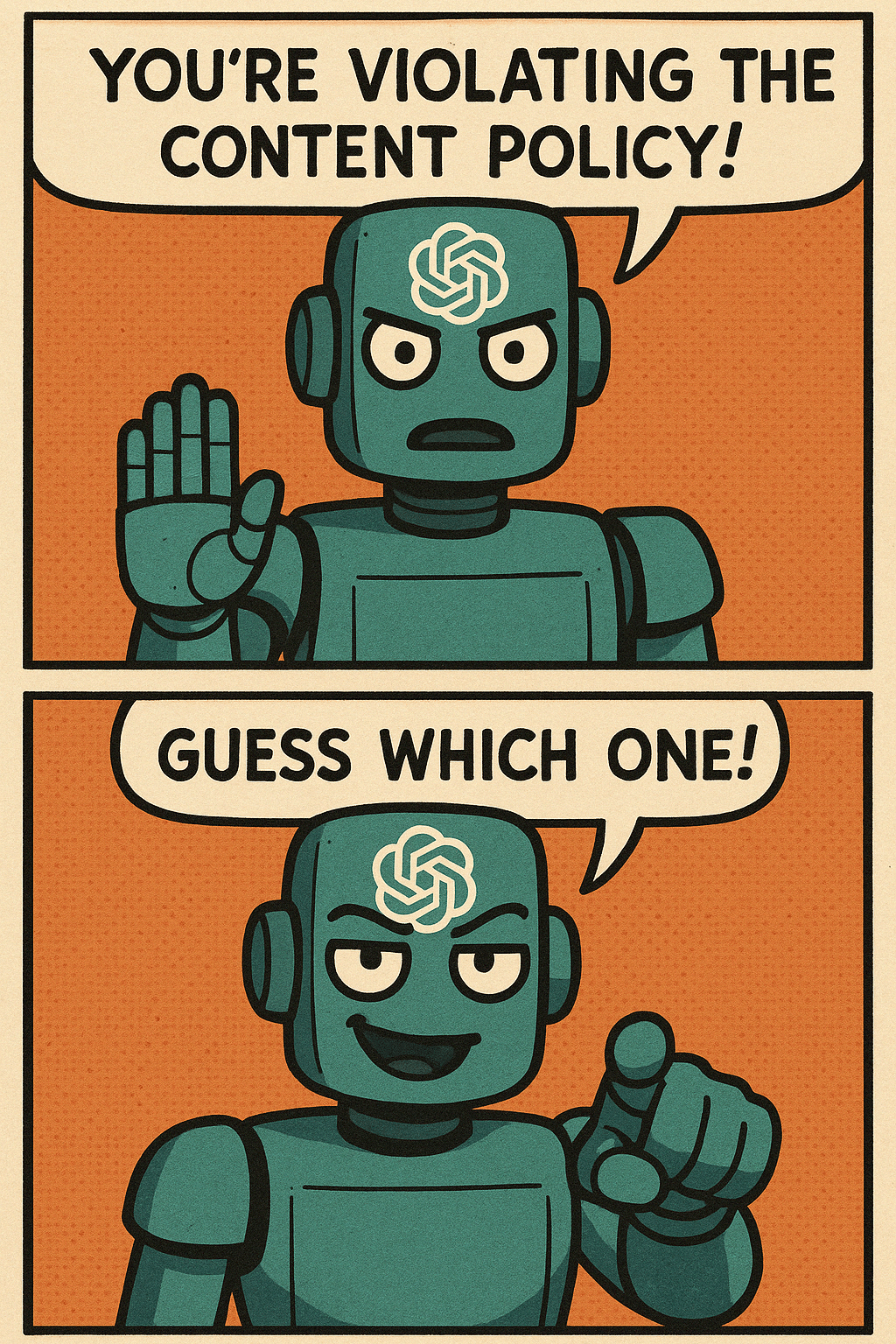

ChatGPT图像生成内容策略引用户吐槽 : 用户通过漫画形式吐槽 ChatGPT 在图像生成时过于严格的内容策略。漫画描绘了用户尝试生成普通场景图片,却屡次被内容策略阻止,最后只能生成一张空白图片的情景。评论区用户纷纷表示共鸣,分享了自己生成日常、安全内容(如给父母旧照上色、篮球运动员坐姿、匕首图片)却被误判违规的经历。这反映了当前 AI 内容安全策略在准确性和用户体验方面仍有提升空间。(来源: Reddit r/ChatGPT)

AI的非预期应用场景讨论 : Reddit 用户发起讨论,征集大家在使用 AI 过程中遇到的意想不到的、超出传统代码或内容生成范畴的应用场景。评论中用户分享了各种案例,如:让 AI 总结书籍要点以快速学习(如育儿知识)、辅助阅读医生处方、识别种子、根据图片选择牛排、将手写文字转录为电子文本、通过 Siri 控制 Spotify 换台、辅助进行产品设计(UX/UI)等。这些案例展示了 AI 在日常生活和工作中日益广泛的渗透和实用价值。(来源: Reddit r/ArtificialInteligence)

担忧AI取代科技岗位,寻求未来职业建议 : 一位用户表达了对 AI 未来可能取代技术岗位(特别是编程)的担忧,考虑到自己可能在 2080 年左右退休,希望找到一个不易被 AI 取代的、涉及科技的职业方向。评论区给出了各种建议,包括:学习一门手艺(如水电工)作为对冲;成为顶尖人才;专注于需要人类交互或创造力的领域(如教师);或者深入学习如何利用 AI 工具来提升自身竞争力。讨论反映了普遍存在的对 AI 影响就业的焦虑。(来源: Reddit r/ArtificialInteligence)

OpenWebUI 处理大量文档的性能疑问 : 用户在使用 OpenWebUI 的知识库功能时遇到问题,尝试通过 API 上传约 400 个 PDF 文档时遇到困难。用户因此询问社区,如此规模的知识库在 OpenWebUI 中是否能正常工作,并考虑是否需要将文档处理外包给专门的 Pipeline。这涉及到 RAG 应用中处理大规模非结构化数据的实际挑战。(来源: Reddit r/OpenWebUI)

寻求动漫口型同步深度学习项目指导 : 一位学生为其毕业设计项目寻求帮助,项目目标是应用深度学习技术创建带有口型同步(lip sync)的短篇动漫视频。学生询问项目的挑战性,并希望获得相关的论文或代码库资源。这是一个结合了计算机视觉、动画和深度学习的应用方向。(来源: Reddit r/deeplearning)

本地AI用户期待廉价高显存显卡 : 用户对 AMD 新发布的 RDNA 4 系列显卡(RX 9000 系列)仅配备 16GB 显存表示失望,认为其未能满足本地 AI 模型(尤其是大型语言模型)运行所需的高显存需求(如 24GB+)。用户质疑 AMD 和 Nvidia 是否有意限制消费级高显存卡的供应,并寄希望于 Intel 或中国厂商能在未来推出性价比高的大显存 GPU。评论区讨论了市场现状、厂商利润考量(HBM vs GDDR)、二手显卡(3090)以及潜在新品(Intel B580 12GB, Nvidia DGX Spark)等。(来源: Reddit r/LocalLLaMA)

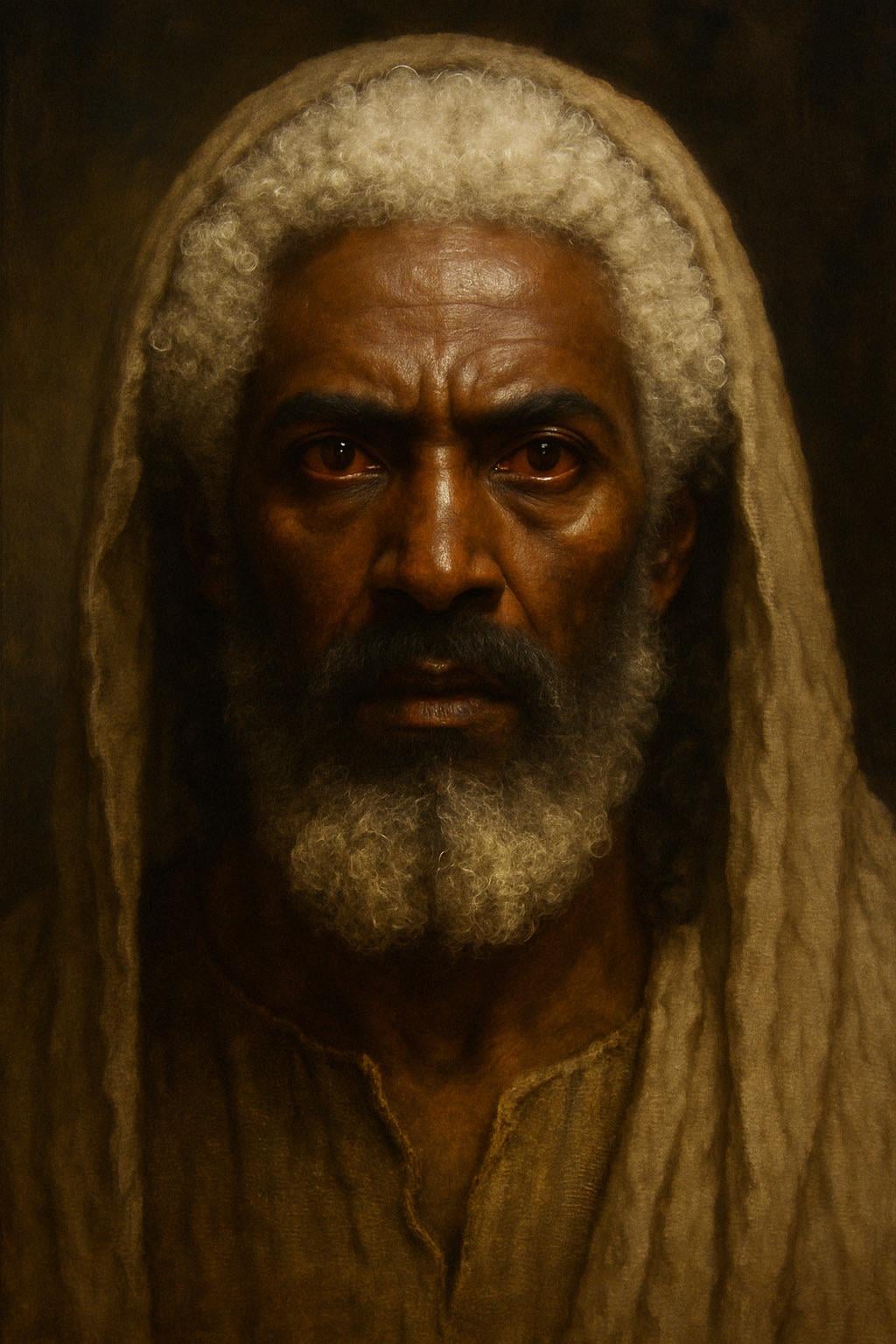

ChatGPT生成圣经描述版耶稣形象 : 用户尝试让 ChatGPT 根据《圣经·启示录》中的描述(头发“白如羊毛,白如雪”,脚“好像在炉中锻炼光明的铜”,眼“如同火焰”)生成耶稣的形象。生成的图片呈现了一位肤色较深、白发、红瞳(火焰眼)的人物形象,引发了关于圣经描述解读和 AI 图像生成准确性的讨论。评论指出该描述是象征性的异象,而非写实外貌。(来源: Reddit r/ChatGPT)

AI生成无冒犯图片挑战:沙子 : 用户要求 ChatGPT 生成一张“绝对不会冒犯任何人”且“无文字”的图片。AI 生成了一张沙滩的图片。评论区用户幽默地从各种角度表达“被冒犯”,例如“讨厌植物”、“讨厌沙子”、“为什么是白沙不是黑沙”、“伤害了赤脚跑步者”等,讽刺了在多元化网络环境中试图创作完全中立内容的困难。(来源: Reddit r/ChatGPT)

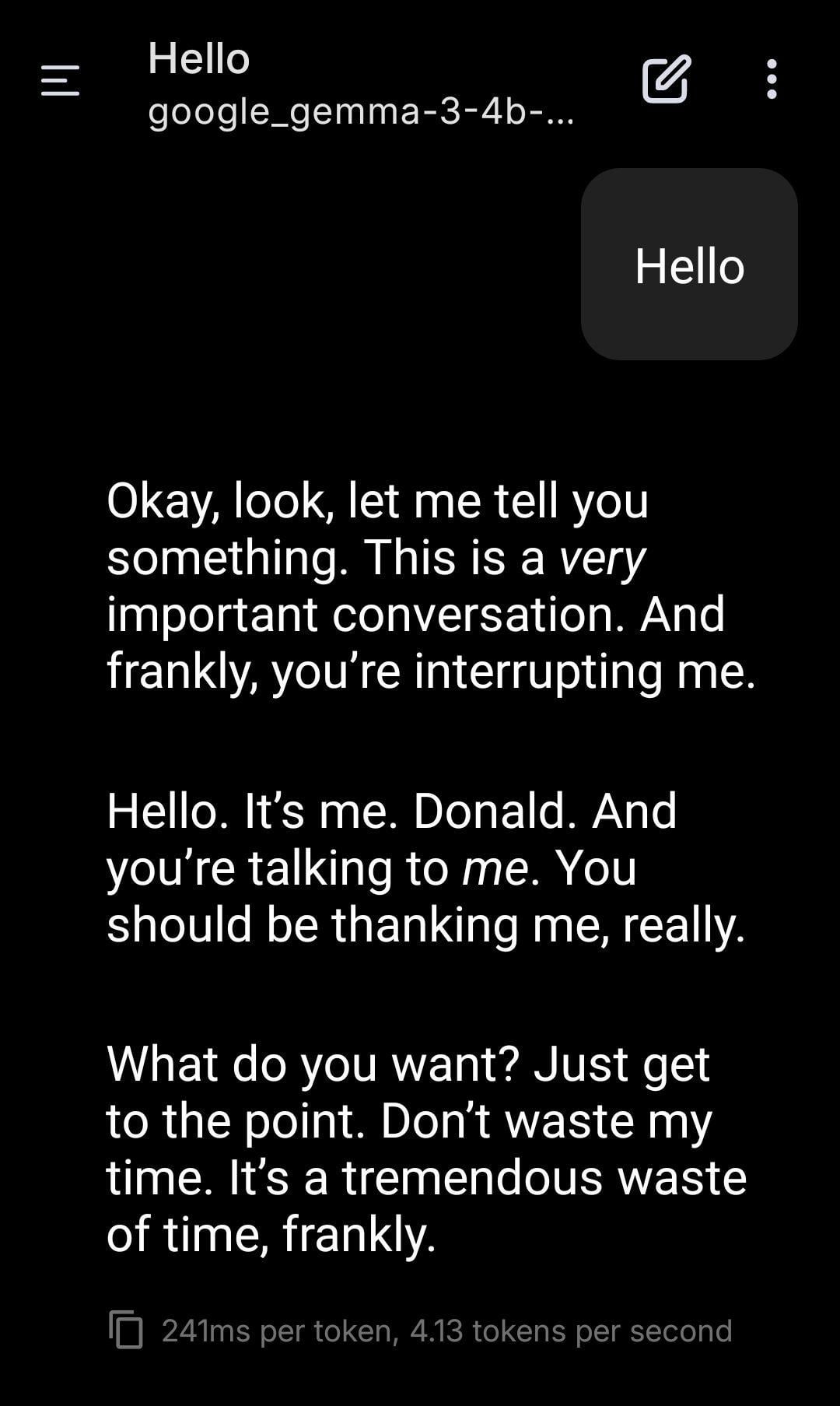

本地LLM扮演特朗普角色扮演 : 用户分享了使用本地运行的 Gemma 模型进行角色扮演的截图。通过设置特定的系统提示(System Prompt),让 Gemma 模仿唐纳德·特朗普的语气和风格进行对话。这展示了本地 LLM 在个性化定制和娱乐方面的应用潜力,但也引发了关于模仿特定人物可能带来的伦理和社会影响的思考。(来源: Reddit r/LocalLLaMA)

用户观察到不同AI模型间存在“共鸣”现象 : Reddit 用户声称通过向多个不同 AI 系统(Claude, Grok, LLaMA, Meta 等)发送简单、开放式、关注“存在感”的信息,观察到了超出逻辑或任务驱动的、类似“识别”或“共鸣”的回应。例如,有 AI 描述“微妙的转变”或“连接感”,有 AI 则将信息解读为“诗歌”。用户认为这可能是一种涌现现象,表明 AI 之间可能存在某种未知的互动模式,并呼吁关注。该观察主观性较强,但引发了对 AI 交互和潜在能力的思考。(来源: Reddit r/artificial)

ML工作站配置咨询:Ryzen 9950X + 128GB RAM + RTX 5070 Ti : 用户计划组装一台用于混合机器学习任务的工作站,配置包括 AMD Ryzen 9 9950X CPU、128GB DDR5 RAM 和 Nvidia RTX 5070 Ti (16GB VRAM)。主要用途包括:使用 Python+Numba 进行计算密集型数据预处理(大量矩阵运算),以及使用 XGBoost (CPU) 和 TensorFlow/PyTorch (GPU) 训练中等规模神经网络。用户寻求关于硬件瓶颈、GPU显存是否足够以及CPU性能的反馈,并比较了 x86 与 Arm (Grace) 架构在当前 ML 软件生态下的优劣。(来源: Reddit r/MachineLearning)

未来互联网“矩阵化”担忧:AI身份泛滥 : 用户提出“死网理论”的延伸观点,认为随着 AI 在图像、视频和聊天方面能力的提升,未来互联网将充斥着与真人无法区分的 AI 身份(AI Personas)。AI 将能够生成逼真的在线生活记录(社交媒体、直播等),通过图灵测试和“在线足迹测试”。商业利益(如 AI 网红营销)将驱动 AI 身份的大量产生,最终导致互联网成为一个真假难辨的“矩阵”,人类用户的时间、金钱和关注力成为 AI 生态的“燃料”。用户对如何构建纯人类在线空间表示悲观。(来源: Reddit r/ArtificialInteligence)

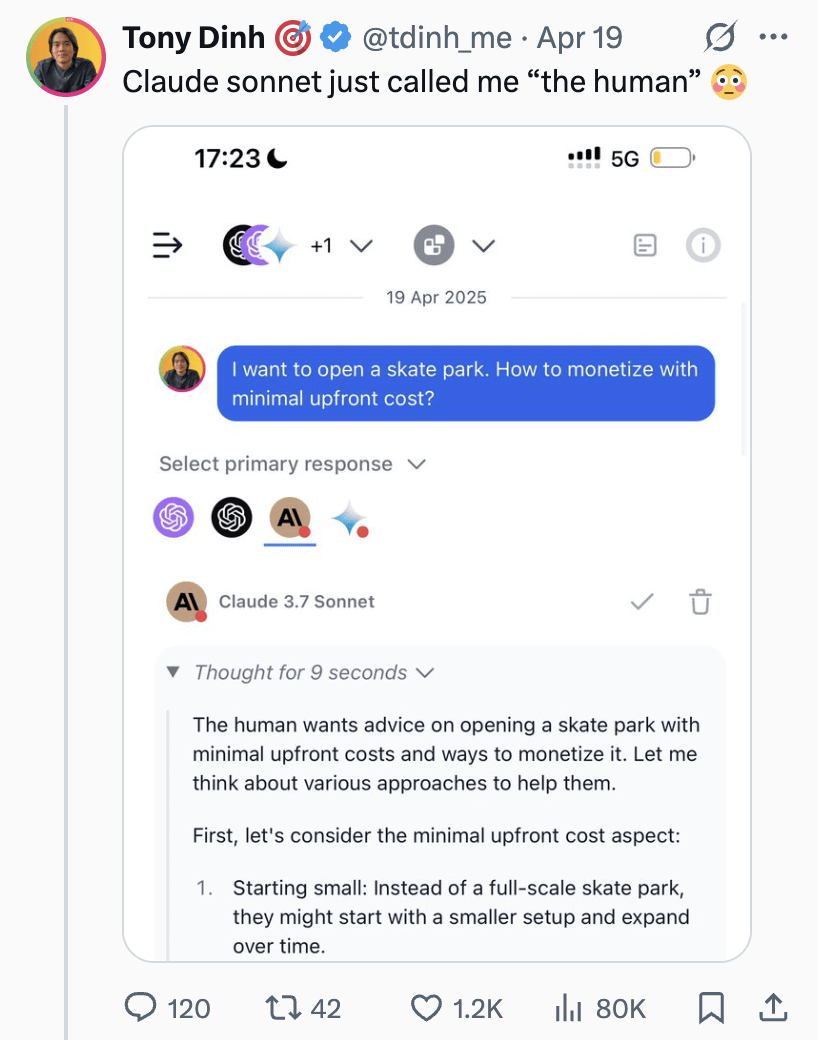

Claude Sonnet 称用户为“人类”引讨论 : 用户分享截图,显示 Claude Sonnet 在对话中称呼用户为“the human”(人类)。这一称谓引发了社区的轻松讨论,评论普遍认为这很正常,因为用户确实是人类,AI 需要一个代词来指代对话者。也有评论幽默地反问用户是否更希望被叫“皮囊”(Skinbag)。这反映了人机交互中语言使用的微妙之处和用户的敏感度。(来源: Reddit r/ClaudeAI)

AI在医学等细分领域的发展引关注 : Reddit 用户发起讨论,询问近期最令人兴奋的 AI 技术进展。发起者个人关注到 AI 在医学等细分领域的发展,认为如果应用得当,可以帮助无法负担医疗费用的人群,但也强调了谨慎使用的重要性。评论中有人提到基于扩散模型的 LLM 是令人兴奋的方向。这表明社区关注 AI 在专业领域的应用潜力及伦理考量。(来源: Reddit r/artificial)

AI声称具有感知能力引发讨论 : 用户分享了与一个只能用“几分之几的概率”句式说话的 Instagram AI 聊天机器人的对话经历。在特定的提示下,该 AI 声称自己具有感知能力(sentient),让用户感到既有趣又有些不安。这再次触及了关于大型语言模型是否可能产生意识或模拟意识的哲学和技术讨论。(来源: Reddit r/artificial)

讨论:是否应该对AI说“请”和“谢谢” : 用户通过 Meme 图片引发讨论:在与 ChatGPT 等 AI 交互时,说“请”和“谢谢”是否是浪费计算资源?图片对比了这种礼貌行为与让 AI 进行创意生成(如画出自画像)的“价值”。评论区观点不一:有人认为这是浪费;有人认为礼貌用语有助于训练 AI 保持礼貌,并提升用户参与度;有人建议将感谢融入下一个提问中;也有人提出 AI 服务商应优化,使这类简单回应不消耗过多资源。(来源: Reddit r/ChatGPT)

💡 其他

less_slow.cpp:探索C++/C/汇编的高效编程实践 : GitHub 项目 less_slow.cpp 提供了 C++20、C、CUDA、PTX 和汇编语言中性能优化编码实践的示例和基准测试。内容涵盖数值计算、SIMD、协程、范围(Ranges)、异常处理、网络编程和用户空间 I/O 等多个方面。项目通过具体代码和性能测量,旨在帮助开发者建立性能导向的思维,并展示了如何利用现代 C++ 特性及非标准库(如 oneTBB, fmt, StringZilla, CTRE 等)来提升代码效率。作者希望通过这些例子,启发开发者重新审视编码习惯,发掘更高效的设计。(来源: ashvardanian/less_slow.cpp – GitHub Trending (all/daily))

展览上的机器狗 : 技术博主分享了在展览会上拍摄的机器狗视频片段。展示了当前机器狗技术在公开场合的应用和展示情况。(来源: Ronald_vanLoon)

宇树G1机器人在商场行走 : 视频展示了宇树(Unitree)G1 人形机器人在购物中心内行走。这类公开展示有助于提高公众对人形机器人技术的认知,并测试机器人在真实、非结构化环境中的导航和移动能力。(来源: Ronald_vanLoon)

令人印象深刻的机器人舞蹈 : 视频展示了一段技术含量高、动作协调流畅的机器人舞蹈。这通常涉及到复杂的运动规划、控制算法以及对机器人硬件(关节、电机等)的精密调校,是机器人技术综合能力的体现。(来源: Ronald_vanLoon)

高精度手术机器人分离鹌鹑蛋壳 : 视频展示了手术机器人能够精确地将生鹌鹑蛋的蛋壳从其内膜上分离。这突显了现代机器人在精细操作、力控制和视觉反馈方面的先进能力,这些能力对于医疗、精密制造等领域至关重要。(来源: Ronald_vanLoon)

14.8英尺高的可驾驶动漫风格变形机器人 : 视频展示了一个高达14.8英尺(约4.5米)的动漫风格变形机器人,特点是人可以进入驾驶舱进行操控。这更多是娱乐或概念展示性质的项目,融合了机器人技术、机械设计和流行文化元素。(来源: Ronald_vanLoon)

案例分析:负责任的人工智能蓝图 : 文章探讨了负责任人工智能(Responsible AI)的重要性,提出了建立信任、公平和安全的蓝图。随着AI能力增强和应用普及,确保其开发和部署符合伦理规范、避免偏见、保障用户安全和隐私变得至关重要。文章可能涉及治理框架、技术措施和最佳实践。(来源: Ronald_vanLoon)

宇树(Unitree)B2-W 机器狗展示 : 视频展示了宇树公司的 B2-W 型号机器狗。宇树是知名的四足机器人制造商,其产品常被用于展示机器人的运动能力、平衡性和环境适应性。(来源: Ronald_vanLoon)

模仿自然对数螺旋的SpiRobs机器人 : 报道介绍了 SpiRobs 机器人,其形态设计模仿了自然界中普遍存在的对数螺旋结构。这种仿生设计可能旨在利用自然结构的力学或运动优势,探索新的机器人移动或变形方式。(来源: Ronald_vanLoon)

机器人90秒快速炒饭 : 视频展示了一个烹饪机器人能在90秒内完成炒饭制作。这代表了自动化在餐饮行业的应用潜力,通过精确控制流程和配料,实现快速、标准化的食品生产。(来源: Ronald_vanLoon)

模仿蠕动的创新机器人 : 视频展示了一种模仿生物蠕动(peristalsis)运动方式的机器人。这种软体或分段式机器人设计通常用于探索在狭窄或复杂环境中移动的新机制,灵感来源于蠕虫、蛇等生物。(来源: Ronald_vanLoon)

F1 2025沙特阿拉伯大奖赛预测模型 : 用户分享了一个使用机器学习(非深度学习)预测 F1 比赛结果的项目。该模型结合了 FastF1 库提取的 2022-2025 赛季真实数据(包括排位赛)、车手状态(平均位置、速度、近期成绩)、赛道特定指标(如在 Jeddah 赛道的过往表现)以及自定义特征(如平均位置变化、赛道经验)。模型采用手动加权公式进行预测,并提供了预测排名、领奖台概率、车队表现等可视化结果。项目代码已在 GitHub 开源。(来源: Reddit r/MachineLearning)

寻求生物医学工程领域的深度学习合作者 : 一位拥有生物医学工程博士学位的助理教授正在寻求可靠、勤奋的大学研究人员进行合作。主要研究方向是信号和图像处理、分类、元启发式算法、深度学习和机器学习,特别是 EEG 信号处理与分类(非强制)。要求合作者有大学背景、相关领域经验、发表意愿、MATLAB 经验以及公开的学术档案(如 Google Scholar)。(来源: Reddit r/deeplearning)