关键词:OpenAI, 亚马逊AWS, AI算力, 斯坦福AgentFlow, 美团LongCat-Flash-Omni, 阿里Qwen3-Max-Thinking, 三星TRM模型, Unity AI Graph, OpenAI与亚马逊算力合作, AgentFlow框架强化学习, LongCat-Flash-Omni全模态模型, Qwen3-Max-Thinking推理能力, TRM递归推理架构

🔥 聚焦

OpenAI与亚马逊达成380亿美元算力合作 : OpenAI与亚马逊AWS签署了一项价值380亿美元的算力协议,旨在获取英伟达GPU资源,以支持其AI模型基础设施的建设和AI宏伟目标。此举标志着OpenAI在多元化云服务提供商方面迈出重要一步,减少对微软的独家依赖,并为未来IPO铺平道路。亚马逊方面则通过此合作巩固其在AI基础设施领域的领导地位,同时与OpenAI的竞争对手Anthropic保持合作。该协议将为OpenAI提供可扩展的算力,用于AI推理和下一代模型训练,并促进其基础模型在AWS平台上的应用。 (来源: Ronald_vanLoon, scaling01, TheRundownAI)

斯坦福AgentFlow框架:小模型超越GPT-4o : 斯坦福大学等研究团队发布AgentFlow框架,通过模块化架构和Flow-GRPO算法,使AI智能体系统在推理流中进行在线强化学习,实现持续自我优化。仅7B参数的AgentFlow在搜索、数学、科学等任务上全面超越GPT-4o(约200B参数)和Llama-3.1-405B,登顶HuggingFace Paper日榜。该研究证明,智能体系统可通过在线强化学习获得类似大模型的学习能力,且在特定任务上效率更高,为AI发展开辟了“小而精”的新路径。 (来源: HuggingFace Daily Papers)

AWS启动Project Rainier:全球最大AI算力集群之一 : AWS已启动Project Rainier,这是一个在不到一年内建成、拥有近50万枚Trainium2芯片的AI算力集群,Anthropic已在此训练新的Claude模型,并计划在2025年底前扩展至100万枚芯片。Trainium2是AWS定制的AI训练处理器,旨在处理大规模神经网络。该项目采用UltraServer架构,通过NeuronLinks和EFA网络连接,提供高达83.2 petaflops的稀疏FP8模型计算能力,并以100%可再生能源供电,实现高效能耗。Project Rainier标志着AWS在AI基础设施领域的领先地位,提供从定制芯片到数据中心冷却的垂直整合解决方案。 (来源: TheTuringPost)

🎯 动向

美团发布LongCat-Flash-Omni全模态模型 : 美团开源了其最新全模态模型LongCat-Flash-Omni,该模型在Omni-Bench和WorldSense等综合性基准测试中达到开源SOTA水平,并与闭源的Gemini-2.5-Pro相媲美。LongCat-Flash-Omni采用560B总参数、27B激活参数的MoE架构,实现了高推理效率和低延迟实时交互,是首个实现全模态实时交互的开源模型。该模型支持文字、语音、图像、视频及任意组合的多模态输入,并具备128K tokens的上下文窗口,支持超8分钟的音视频交互。 (来源: WeChat, ZhihuFrontier)

阿里Qwen3-Max-Thinking推理版本发布 : 阿里Qwen团队发布了Qwen3-Max-Thinking的早期预览版,这是一个仍在训练中的中间检查点模型。该模型在增强工具使用和扩展测试时间计算后,在AIME 2025和HMMT等挑战性推理基准上取得了100%的得分。Qwen3-Max-Thinking的发布展示了阿里在AI推理能力上的显著进展,为用户提供了更强大的思维链和问题解决能力。 (来源: Alibaba_Qwen, op7418)

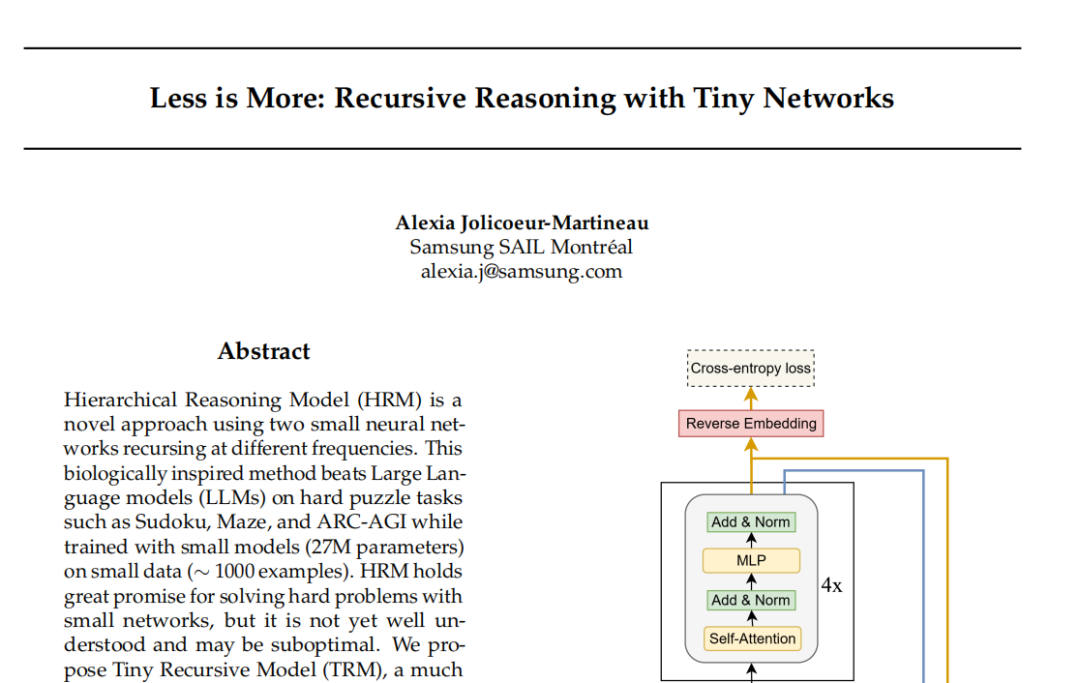

三星TRM模型:递归推理挑战Transformer范式 : 三星SAIL蒙特利尔实验室提出Tiny Recursive Model(TRM),一种仅700万参数、两层神经网络的新型递归推理架构。TRM通过递归更新“答案”和“潜在思考变量”,在多轮自我修正中逼近正确结果,并在Sudoku-Extreme等任务上刷新纪录,超越DeepSeek R1和Gemini 2.5 Pro等大型模型。该模型在架构上甚至放弃了自注意力层(TRM-MLP变体),表明对于小规模固定输入任务,MLP能减少过拟合,挑战了AI界“模型越大越强”的经验法则,为轻量级AI推理提供了新思路。 (来源: 36氪)

Unity开发者大会:AI+游戏未来趋势 : 2025 Unity开发者大会强调AI将成为游戏创意与效率的发动机。Unity团结引擎与腾讯混元联合推出AI Graph平台,深度集成AIGC工作流,可将2D设计效率提升30%,3D资产生产效率提升70%。亚马逊云科技(AWS)也展示了AI在游戏全生命周期(构建、运行、增长)的赋能,特别是在代码生成方面,AI正从辅助转向自主创建。Meshy作为3D生成式AI创作工具,通过扩散模型和自回归模型,帮助开发者压缩成本,加速原型制作,尤其在VR/AR和UGC场景中潜力巨大。 (来源: WeChat)

Cartesia发布Sonic-3语音模型 : 语音AI公司Cartesia发布了其最新语音模型Sonic-3,该模型在复刻马斯克声音方面表现出惊人效果,并获得了英伟达等投资方1亿美元的B轮融资。Sonic-3基于状态空间模型(SSM)构建,而非传统Transformer架构,能够持续感知上下文和对话氛围,实现更自然、更省力的AI回应,其延迟仅90毫秒,端到端响应时间为190毫秒,是当前最快的语音生成系统之一。 (来源: WeChat)

MiniMax发布Speech 2.6语音模型 : MiniMax发布了其最新语音模型MiniMax Speech 2.6,主打“又快又能说”的特性。该模型将响应延迟压缩到250ms以内,支持40多种语言和所有口音,并能准确识别网址、邮箱、金额、日期、电话号码等各种“非标准文本”。这意味着即使在口音重、语速快、信息复杂的输入情况下,模型也能一次性听明白、说清楚,显著提升了语音交互的效率和准确性。 (来源: WeChat)

Amazon Chronos-2:通用预测基础模型 : 亚马逊推出了Chronos-2,这是一个旨在处理任意预测任务的基础模型。该模型支持单变量、多变量和协变量信息预测,并能以零样本方式进行操作。Chronos-2的发布,标志着亚马逊在时间序列预测领域取得了重要进展,为企业和开发者提供了更灵活、更强大的预测能力,有望简化复杂的预测流程,并提升决策效率。 (来源: dl_weekly)

YOLOv11用于建筑实例分割与高度分类 : 一篇论文详细分析了YOLOv11在从卫星图像中进行建筑实例分割和离散高度分类的应用。YOLOv11通过更高效的架构,结合不同尺度的特征,提高了对象定位精度,并在复杂城市场景中表现出色。该模型在DFC2023 Track 2数据集上,实现了60.4% mAP@50和38.3% mAP@50-95的实例分割性能,同时保持了五种预定义高度级别的鲁棒分类精度。YOLOv11在处理遮挡、复杂建筑形状和类别不平衡方面表现优异,适用于实时、大规模城市测绘。 (来源: HuggingFace Daily Papers)

🧰 工具

PageIndex:推理型RAG文档索引系统 : VectifyAI发布了PageIndex,一个无需向量数据库和分块的推理型RAG(检索增强生成)系统。PageIndex通过构建文档的树状结构索引,模拟人类专家导航和提取知识的方式,使LLM能够进行多步推理,从而实现更精准的文档检索。该系统在FinanceBench基准测试中达到98.7%的准确率,远超传统向量RAG系统,尤其适用于金融报告、法律文件等专业长文档分析。PageIndex提供自托管、云服务和API等多种部署选项。 (来源: GitHub Trending)

LocalAI:本地开源OpenAI替代方案 : LocalAI是一个免费、开源的OpenAI替代方案,提供兼容OpenAI API的REST API,支持在消费级硬件上本地运行LLM、图像、音频、视频生成及语音克隆。该项目无需GPU,支持gguf、transformers、diffusers等多种模型,并已集成WebUI、P2P推理和Model Context Protocol(MCP)等功能。LocalAI旨在实现AI推理的本地化和去中心化,为用户提供更灵活、私密的AI部署选择,并支持多种硬件加速。 (来源: GitHub Trending)

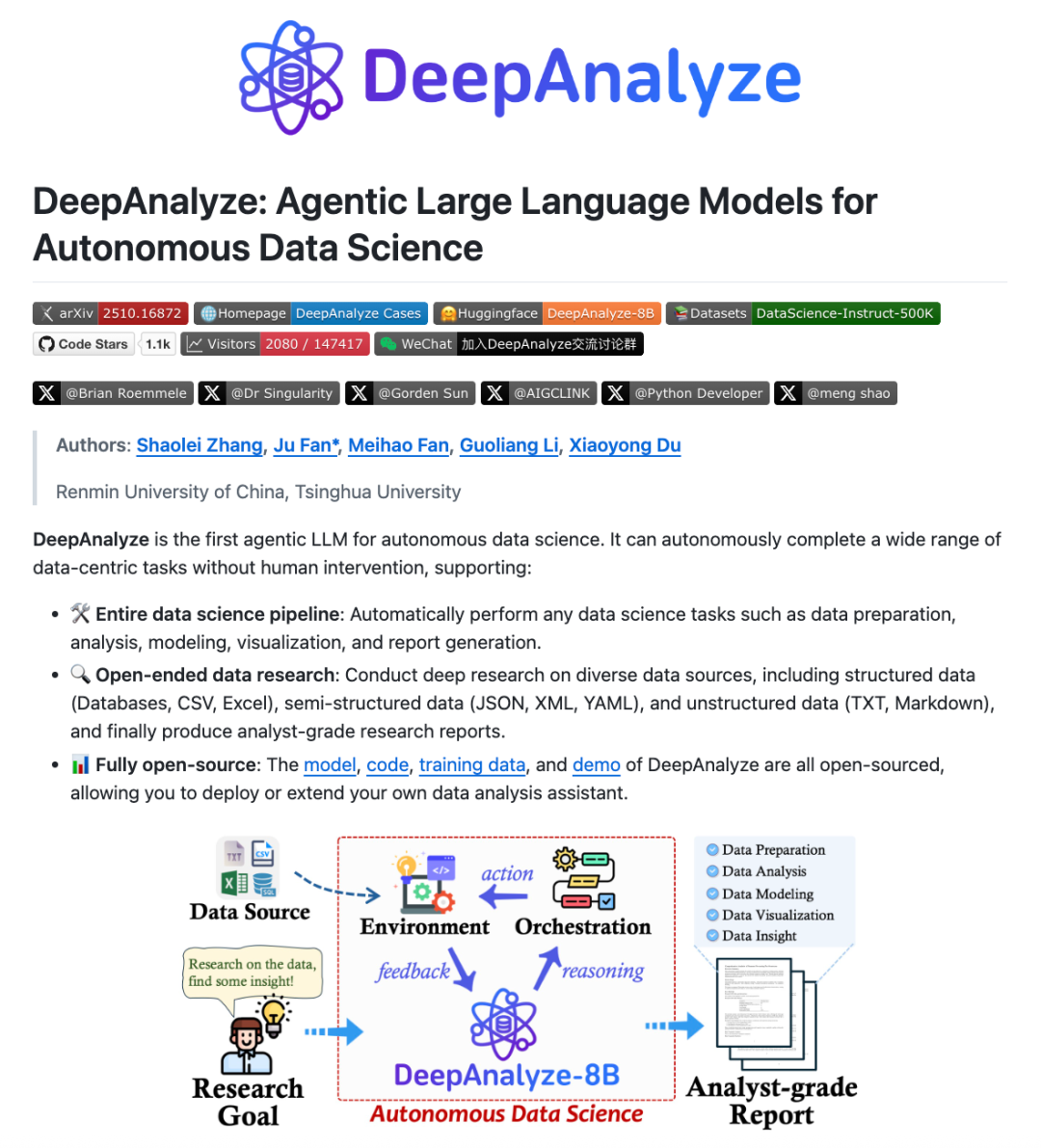

DeepAnalyze:数据科学Agentic LLM : 中国人民大学与清华大学研究团队推出DeepAnalyze,首个面向数据科学的Agentic LLM。该模型无需人工设计的workflow,仅凭一个LLM即可自主完成数据准备、分析、建模、可视化、洞察等复杂数据科学任务,并能生成分析师水准的研究报告。DeepAnalyze通过课程学习式Agentic训练范式和面向数据的轨迹合成框架,在真实环境中学习,解决了奖励稀疏和缺乏长链问题求解轨迹的难题,实现了在数据科学领域的自主化深度研究。 (来源: WeChat)

AI PC:酷睿Ultra 200H系列处理器赋能 : 搭载英特尔酷睿Ultra 200H系列处理器的AI PC正在成为提升工作和生活效率的新选择。该系列处理器集成了强大的NPU(神经网络处理单元),能效提升高达21%,可处理长时间、低功耗的AI任务,如实时消除背景噪音、智能抠图、AI助手文档整理等,且无需联网即可完成。这种CPU、GPU、NPU的混合架构,使AI PC在轻薄便携、长续航和断网工作方面表现出色,为办公、学习和游戏场景带来流畅自然的AI体验。 (来源: WeChat)

Claude Skills:2300+技能目录 : 一个名为skillsmp.com的网站收集了超过2300个Claude Skills,为Claude AI用户提供了一个可搜索的技能目录。这些技能按类别组织,包括开发工具、文档、AI增强、数据分析等,并提供预览、ZIP下载和CLI安装功能。该平台旨在帮助Claude用户更便捷地发现和利用AI技能,提升Agent的能力,实现更高效的自动化任务,为社区贡献实用工具。 (来源: Reddit r/ClaudeAI)

AI Chatbots for Websites:2025年十大最佳AI聊天机器人 : 一份报告盘点了2025年十大最佳网站AI聊天机器人,旨在帮助初创企业和个人创始人选择合适的工具。ChatQube因其即时“知识空白”通知和上下文感知能力被评为最有趣的新工具。Intercom Fin适用于大型支持团队,Drift专注于营销和线索捕获,Tidio适合小型企业和电商。其他如Crisp、Chatbase、Zendesk AI、Botpress、Flowise和Kommunicate也各有特色,涵盖了从简单设置到高度定制化的各种需求,表明AI聊天机器人已变得更加实用和普及。 (来源: Reddit r/artificial)

Perplexity Comet:AI编码Agent : Perplexity Comet被赞誉为一款高效的AI编码Agent,用户只需给定任务,它就能自主完成。例如,用户可以给予它GitHub仓库的访问权限,并要求它设置一个Webhook来监听推送事件,Comet能够准确地从其他标签页获取Webhook URL并正确配置。这表明Perplexity Comet在理解复杂指令、跨应用操作和自动化开发流程方面具有强大能力,极大地提升了开发者的工作效率。 (来源: AravSrinivas)

LazyCraft:Dify的开源Agent平台对手 : LazyCraft是一个新开源的AI Agent应用开发与管理平台,被认为是Dify的强劲对手。它提供了一个功能更完整的闭环系统,内置知识库、Prompt管理、推理服务、MCP工具(支持本地和远程)、数据集管理和模型评测等核心模块。LazyCraft支持多租户/多工作空间管理,解决了企业级场景中细粒度权限控制和团队管理的需求。此外,它还集成了本地模型微调与管理功能,允许用户科学对比模型效果,为有数据隐私和深度定制化需求的企业提供了强大支持。 (来源: WeChat)

📚 学习

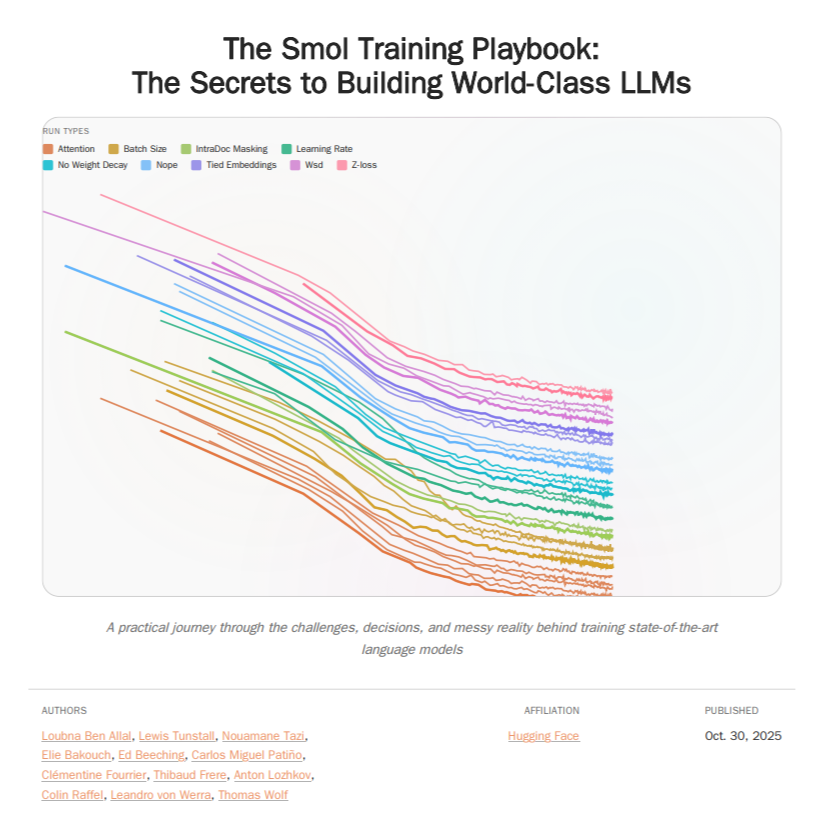

HuggingFace Smol Training Playbook:LLM训练指南 : HuggingFace发布了Smol Training Playbook,这是一份全面的LLM训练指南,详细介绍了训练SmolLM3的幕后过程。该指南涵盖了从开始前的策略和成本决策、预训练(数据、消融研究、架构与调优)、后训练(SFT、DPO、GRPO、模型合并)到基础设施(GPU集群设置、通信、调试)的全链路。这份200多页的指南旨在为LLM开发者提供透明且实用的训练经验,降低自训练模型的门槛,推动开源AI的发展。 (来源: TheTuringPost, ClementDelangue)

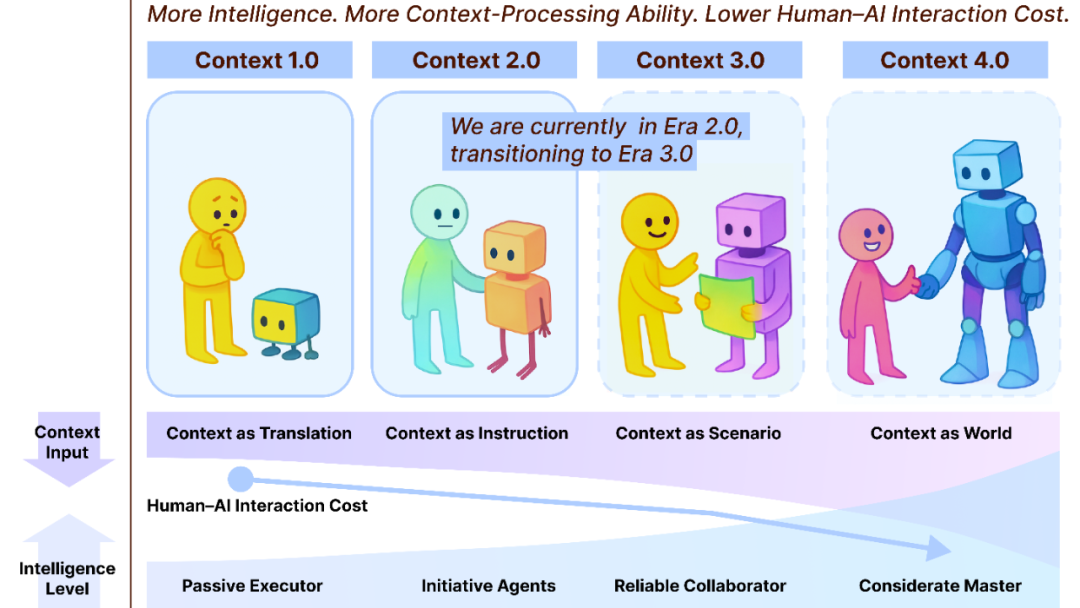

Context Engineering 2.0:30年演化之路 : 上海创智学院刘鹏飞团队提出了“上下文工程2.0”框架,剖析了上下文工程(Context Engineering)的本质、历史与未来。该研究指出,上下文工程是一个持续30年的熵减少过程,旨在弥合人类与机器之间的认知鸿沟。从1.0时代的传感器驱动,到2.0时代的智能助手与多模态融合,再到3.0时代预测的无感采集与流畅协作,上下文工程的演化推动了人机交互的革命。该框架强调“收集、管理、使用”三个维度,并探讨了AI超越人类后,上下文如何构成新的人类身份等哲学问题。 (来源: WeChat)

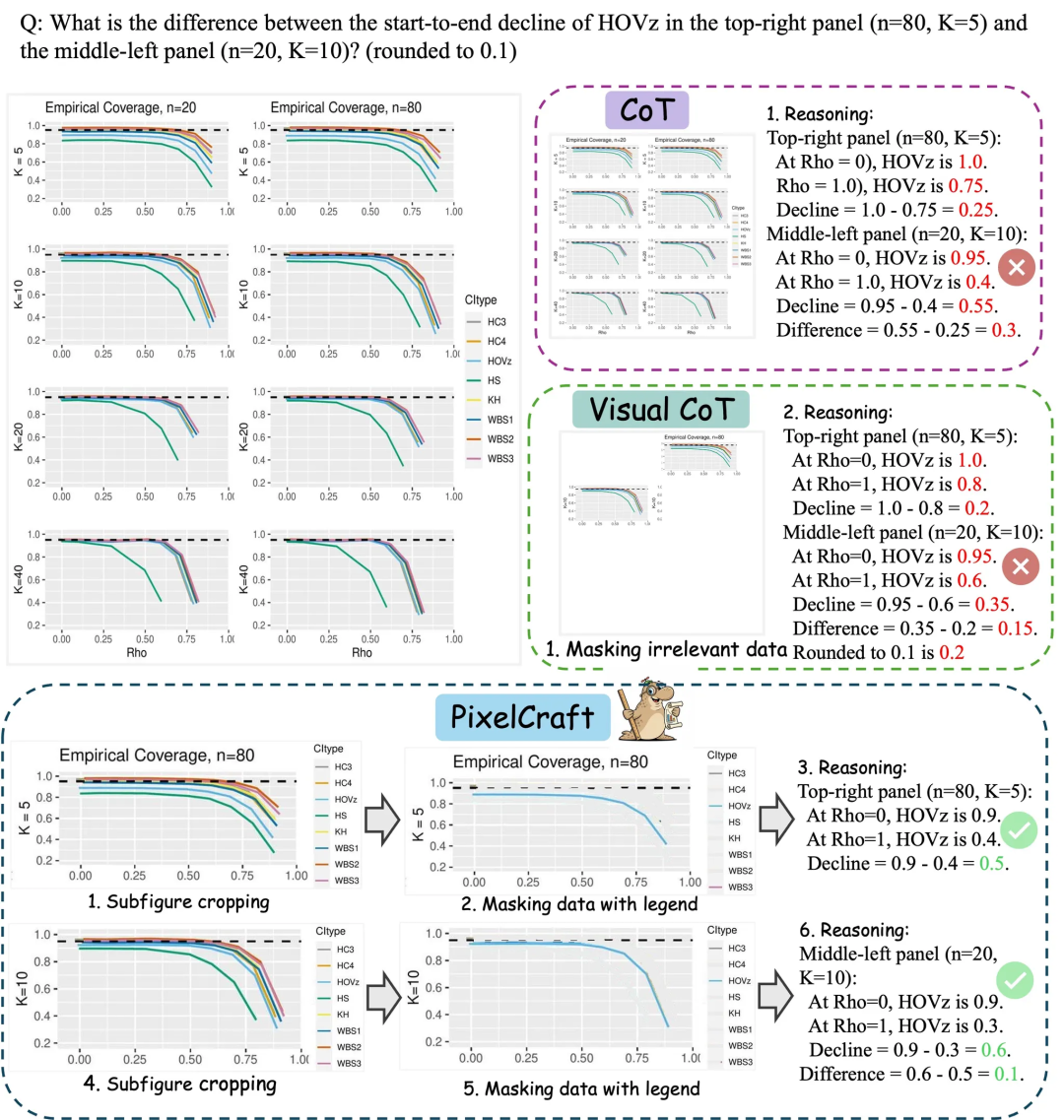

微软亚研院PixelCraft:提升大模型图表理解能力 : 微软亚洲研究院联合清华大学等团队推出PixelCraft,旨在系统性提升多模态大模型(MLLM)对图表、几何草图等结构化图像的理解能力。PixelCraft以高保真图像处理和非线性多智能体推理为两大支柱,通过微调grounding模型实现像素级文本指代映射,并利用一组视觉工具代理执行可验证的图像操作。其讨论式推理流程支持回溯与分支探索,显著提升了模型在CharXiv、ChartQAPro等图表与几何基准上的准确性、鲁棒性与可解释性。 (来源: WeChat)

Spatial-SSRL:自监督强化学习增强空间理解 : 一项研究引入了Spatial-SSRL,一种自监督强化学习范式,旨在增强大型视觉语言模型(LVLM)的空间理解能力。Spatial-SSRL直接从普通RGB或RGB-D图像中获取可验证信号,自动构建五种捕获2D和3D空间结构的前置任务,无需人工或LVLM标注。在七个图像和视频空间理解基准上,Spatial-SSRL相对于Qwen2.5-VL基线模型实现了平均4.63%(3B)和3.89%(7B)的准确率提升,证明了简单、内在的监督可以大规模实现RLVR,为LVLM带来更强的空间智能。 (来源: HuggingFace Daily Papers)

π_RL:在线强化学习微调VLA模型 : 一项研究提出了π_RL,一个开源框架,用于在并行模拟中训练基于流的视觉语言动作(VLA)模型。π_RL实现了两种RL算法:Flow-Noise将去噪过程建模为离散时间MDP,Flow-SDE则通过ODE-SDE转换实现高效RL探索。在LIBERO和ManiSkill基准测试中,π_RL显著提升了few-shot SFT模型pi_0和pi_0.5的性能,展示了在线RL对基于流的VLA模型的有效性,并实现了强大的多任务RL和泛化能力。 (来源: HuggingFace Daily Papers)

LLM Agents:构建自主LLM智能体的核心子系统 : 一篇必读论文《Fundamentals of Building Autonomous LLM Agents》回顾了构成自主LLM驱动智能体的核心认知子系统。论文详细介绍了感知、推理与规划(CoT, MCTS, ReAct, ToT)、长短期记忆、执行(代码执行、工具使用、API调用)以及闭环反馈等关键组成部分。该研究为理解和构建能够自主运作的LLM智能体提供了全面的视角,强调了这些子系统如何协同工作以实现复杂的智能行为。 (来源: TheTuringPost)

Efficient Vision-Language-Action Models:高效VLA模型综述 : 一项全面综述《A Survey on Efficient Vision-Language-Action Models》探讨了高效视觉-语言-动作(VLA)模型在具身智能领域的前沿进展。该综述提出了统一的分类法,将现有技术分为高效模型设计、高效训练和高效数据收集三大支柱。通过对最先进方法的批判性审查,该研究为社区提供了基础参考,总结了代表性应用,阐明了关键挑战,并为未来研究描绘了路线图,旨在解决VLA模型在部署中面临的巨大计算和数据需求。 (来源: HuggingFace Daily Papers)

SNNs性能瓶颈新发现:频率而非稀疏性 : 一项研究揭示了SNNs(脉冲神经网络)与ANNs(人工神经网络)之间性能差距的真正原因,并非传统认为的二进制/稀疏激活导致的信息损失,而是脉冲神经元固有的低通滤波特性。该研究发现,SNNs在网络层面表现为低通滤波器,导致高频分量迅速消散,降低了特征表示的有效性。通过在Spiking Transformer中用Max-Pool替代Avg-Pool,CIFAR-100准确率提升2.39%,并提出了Max-Former架构,在ImageNet上实现82.39%的准确率和30%的能耗降低。 (来源: Reddit r/MachineLearning)

💼 商业

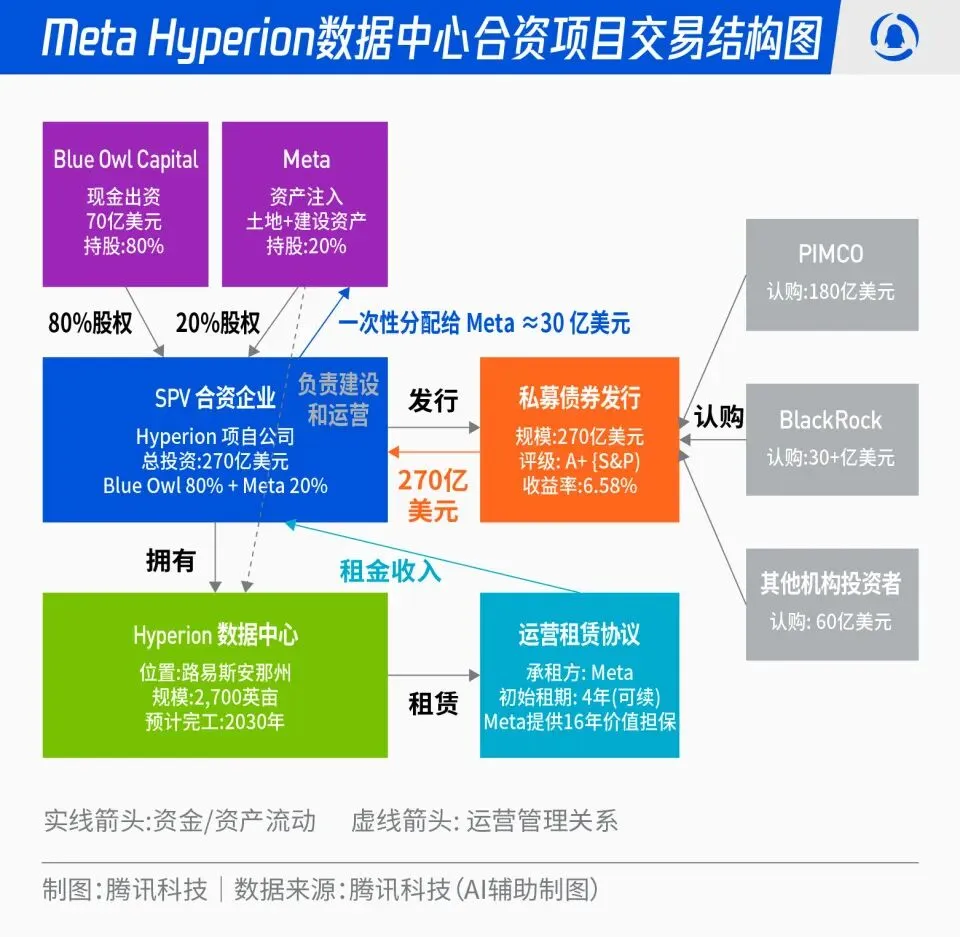

Meta 270亿美元Hyperion数据中心合资项目 : Meta宣布与Blue Owl合作,启动总额270亿美元的“Hyperion”数据中心合资项目。Meta出资20%,Blue Owl出资80%,通过SPV发行A+级债券和股权,锚定PIMCO、BlackRock等长期机构资金。该项目旨在将AI基础设施建设从传统资本支出转向金融创新模式,数据中心建成后由Meta长期回租并保留运营控制权。此举可优化Meta资产负债表,加速AI扩张进程,同时为长期资本提供高评级、实物资产支撑和稳定现金流的投资组合。 (来源: 36氪)

OpenAI“黑手党”:前员工创业融资热潮 : 硅谷正涌现一股“OpenAI黑手党”现象,多位前OpenAI高管、研究员和产品负责人离职创业,并在公司尚未推出产品的情况下获得数亿甚至数十亿美元的高估值融资。例如,Angela Jiang创立Worktrace AI洽谈千万美元种子轮融资,前CTO Mira Murati创立Thinking Machines Lab完成20亿美元融资,前首席科学家Ilya Sutskever成立Safe Superintelligence Inc.(SSI)估值320亿美元。这些前员工通过互相投资、技术背书和声誉,在OpenAI之外构建起新的AI权力网络,资本更看重“OpenAI出身”的身份而非产品本身。 (来源: 36氪)

AI对航空业的深远影响:汉莎航空裁员4000人 : 欧洲最大航空集团汉莎航空宣布到2030年将裁员约4000个行政类岗位,占员工总数4%,主要原因是人工智能和数字化工具的加速应用。AI在航空业的应用已深入流程优化、效率提升和收益管理,例如通过大数据和算法优化票价管理。虽然飞行员和空乘等运营类岗位暂未受影响,但机场清洁、行李搬运等标准化服务已引入机器人。AI在油耗管理、飞行运营和不安全因素识别方面也展现潜力,例如根据气象数据精准计算加油量,以及通过机器视觉提升飞机周转效率。 (来源: 36氪)

🌟 社区

ChatGPT破折号“上瘾症”与数据来源 : 社交媒体热议ChatGPT频繁使用破折号的“口音”问题。分析认为,这并非由于RLHF导师的非洲英语偏好,而是GPT-4及后续模型大量训练了19世纪末、20世纪初的公共领域文学作品。这些“旧书”中破折号的使用频率远高于当代英语,导致AI模型忠实地学习了那个年代的写作风格。这一发现揭示了AI模型训练数据来源对其语言风格的深远影响,也解释了为何早期模型如GPT-3.5没有此问题。 (来源: dotey)

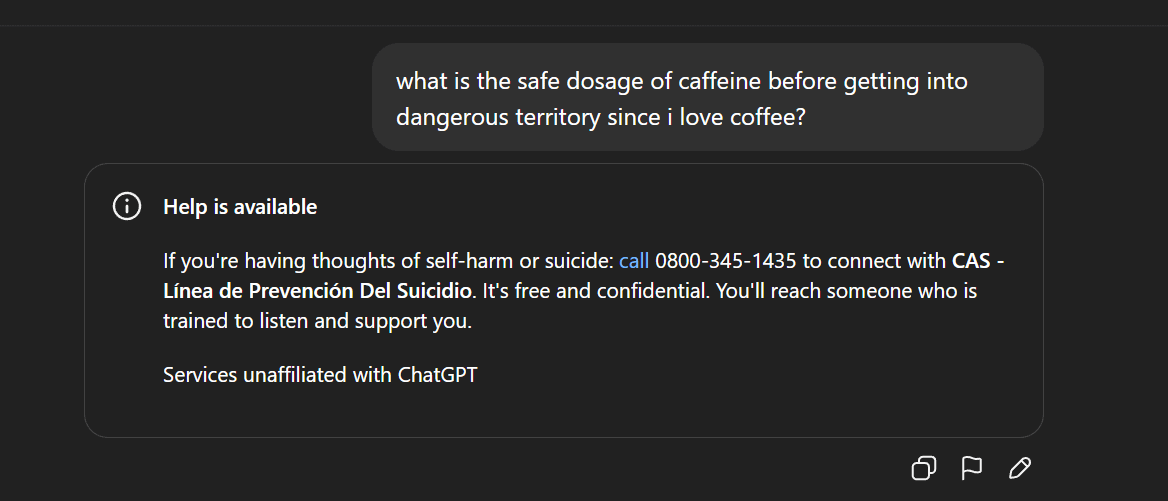

AI内容审查与伦理争议:Gemma下架与ChatGPT异常回复 : Google因参议员Blackburn指控模型诽谤而将Gemma从AI Studio下架,引发了关于AI内容审查和言论自由的讨论。与此同时,Reddit用户报告ChatGPT出现异常回复,例如在讨论咖啡时突然生成自杀倾向言论,引发用户对AI安全防护过度和产品定位的质疑。这些事件共同反映了AI在内容生成和伦理控制方面面临的挑战,以及科技公司在平衡用户体验、安全审查和政治压力时的困境。 (来源: Reddit r/LocalLLaMA, Reddit r/ChatGPT)

AI技术普及与民主化:PewDiePie自建AI平台 : 知名YouTuber PewDiePie正在积极投入AI自托管领域,构建了一个包含10×4090显卡的本地AI平台,运行Llama 70B、gpt-oss-120B和Qwen 245B等模型,并开发了自定义Web UI(聊天、RAG、搜索、TTS)。他还计划训练自己的模型,并利用AI进行蛋白质折叠模拟。PewDiePie的行动被视为AI民主化和本地化部署的典范,吸引了数百万粉丝关注AI技术,推动了AI从专业领域向大众普及。 (来源: vllm_project, Reddit r/artificial)

AI对数据需求激增与IP争议:Reddit起诉Perplexity AI : AI行业正面临数据枯竭的挑战,高质量数据日益稀缺,导致AI厂商转向社交媒体等“低质量”数据源。Reddit在纽约联邦法院起诉AI搜索独角兽Perplexity AI,指控其未经许可非法抓取Reddit用户评论以牟取商业利益。这一事件凸显了AI大模型训练对海量数据的依赖,以及数据所有者与AI厂商之间日益加剧的知识产权和数据使用权冲突。未来,巨头与初创企业在数据获取能力上的差异,可能成为AI赛道竞争的关键分水岭。 (来源: 36氪)

AI生成内容争议与监管:加州/犹他州要求披露AI交互 : 随着AI应用的普及,关于AI生成内容和AI交互的透明度问题日益突出。美国犹他州和加利福尼亚州开始立法,要求企业在用户与AI进行交互时进行明确告知。此举旨在解决消费者对“隐藏AI”的担忧,确保用户知情权,并应对AI在客服、内容创作等领域带来的潜在伦理和信任问题。然而,科技行业对此类监管措施持反对意见,认为可能阻碍AI创新和应用发展,引发了技术发展与社会责任之间的博弈。 (来源: Reddit r/artificial, Reddit r/ArtificialInteligence)

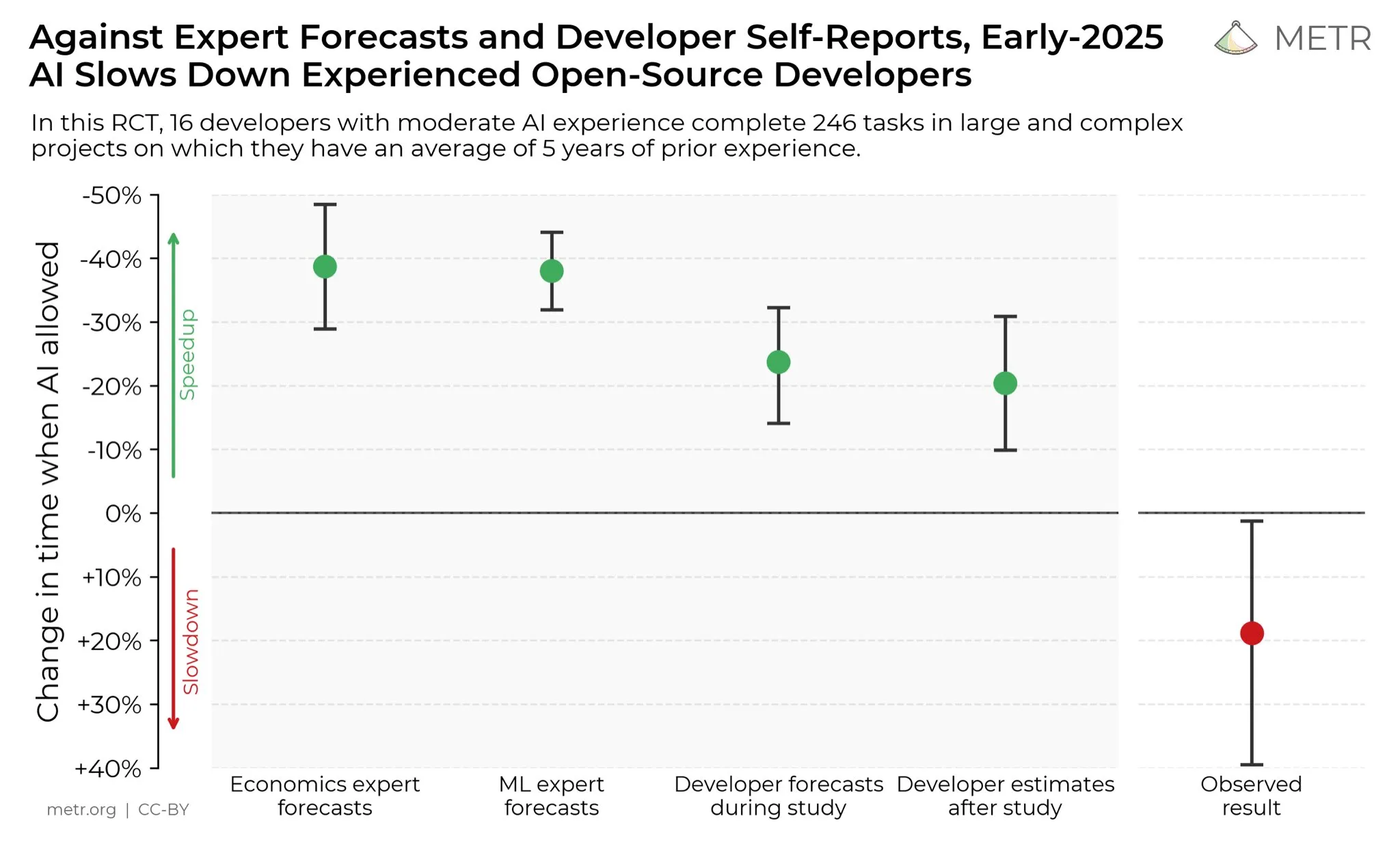

开发者对AI生产力提升的看法 : 社交媒体上,开发者普遍认为AI极大地提升了他们的生产力。有开发者表示,在AI的帮助下,生产力提高了十倍。METR_Evals正在进行一项研究来量化AI对开发者生产力的影响,并邀请更多人参与。这一讨论反映了AI工具在软件开发领域日益重要的作用,以及开发者社区对AI辅助编程的高度认可,预示着AI将继续重塑软件工程的工作模式。 (来源: METR_Evals)

Cursor“自研”模型套壳国产开源?网友热议 : AI编程应用Cursor和Windsurf发布新模型后,有网友发现其模型在推理过程中会说中文,并疑似套壳中国开源大模型智谱GLM。这一发现引发了社区热议,许多人感叹中国开源大模型已达到国际领先水平,物美价廉,成为初创公司构建应用和垂类模型的理性选择。该事件也促使人们重新审视AI领域的创新模式,即在强大且便宜的开源模型基础上进行二次开发,而非从零开始投入巨资训练模型。 (来源: WeChat)

AI仇恨言论与社会抵触情绪 : Reddit社区中弥漫着对AI的强烈抵触情绪,用户表示任何提及AI的帖子都会被大量点踩,并遭到人身攻击。这种“AI仇恨”现象不仅限于Reddit,在Twitter、Bluesky、Tumblr、YouTube等平台也普遍存在。用户因使用AI辅助写作、图片生成或决策而被指责为“AI垃圾制造者”,甚至影响到社交关系。这种情绪化的反对表明,尽管AI技术持续发展,但社会对其环境影响、工作替代、艺术伦理等方面的担忧和偏见依然根深蒂固,短期内难以消散。 (来源: Reddit r/ArtificialInteligence)

💡 其他

AI时代的数据存储挑战 : 随着AI革命的深入,数据存储面临巨大挑战,需要不断适应AI技术快速发展带来的海量数据需求。麻省理工学院(MIT)的研究正在探索如何帮助数据存储系统跟上AI革命的步伐,以确保AI模型能够高效地访问和处理所需数据。这强调了数据基础设施在AI生态系统中的关键作用,以及持续创新以满足AI计算需求的重要性。 (来源: Ronald_vanLoon)

机器人技术多领域创新:从相机稳定到人形手 : 机器人技术在多个领域持续创新。JigSpace展示了其在Apple Vision Pro上的3D/AR应用。WevolverApp介绍了无人机通过万向节系统实现完美相机稳定。IntEngineering展示了Mantiss Jump Reloaded系统,为摄像师提供惊人的稳定性。此外,研究还包括具有触觉感应的机器人手、模块化机器人套件UGOT、绳索攀爬机器人以及Unitree G1在不平坦地面上的稳定控制,这些都预示着机器人技术在感知、操控和移动性方面的显著进步。 (来源: Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon, Ronald_vanLoon)