关键词:AI发展, Grok 3, Gemma 3, AI应用, AI发展范式转变, xAI Grok 3 API, Google Gemma 3 QAT, VideoGameBench AI评测, AI分子发现加速, 联邦学习医疗影像, LlamaIndex知识代理, AI代码自修复技术

🔥 聚焦

AI发展范式转变:从刷榜到创造价值: OpenAI研究员姚顺雨的博客引发讨论,提出AI发展已进入下半场。上半场聚焦算法创新和基准测试刷分(如AlphaGo、GPT-4),通过结合大规模预训练(提供先验知识)和强化学习(RL),并引入“推理即行动”的概念,实现了泛化突破。然而,他认为持续刷榜的边际效益递减,下半场应转向定义有实际应用价值的问题,开发更贴近现实世界的评估方法,像产品经理一样思考,真正用AI创造用户价值和社会价值,而非仅仅追求指标提升。这标志着AI领域从技术探索为主转向应用落地和价值实现为主的思维转变 (来源: dotey)

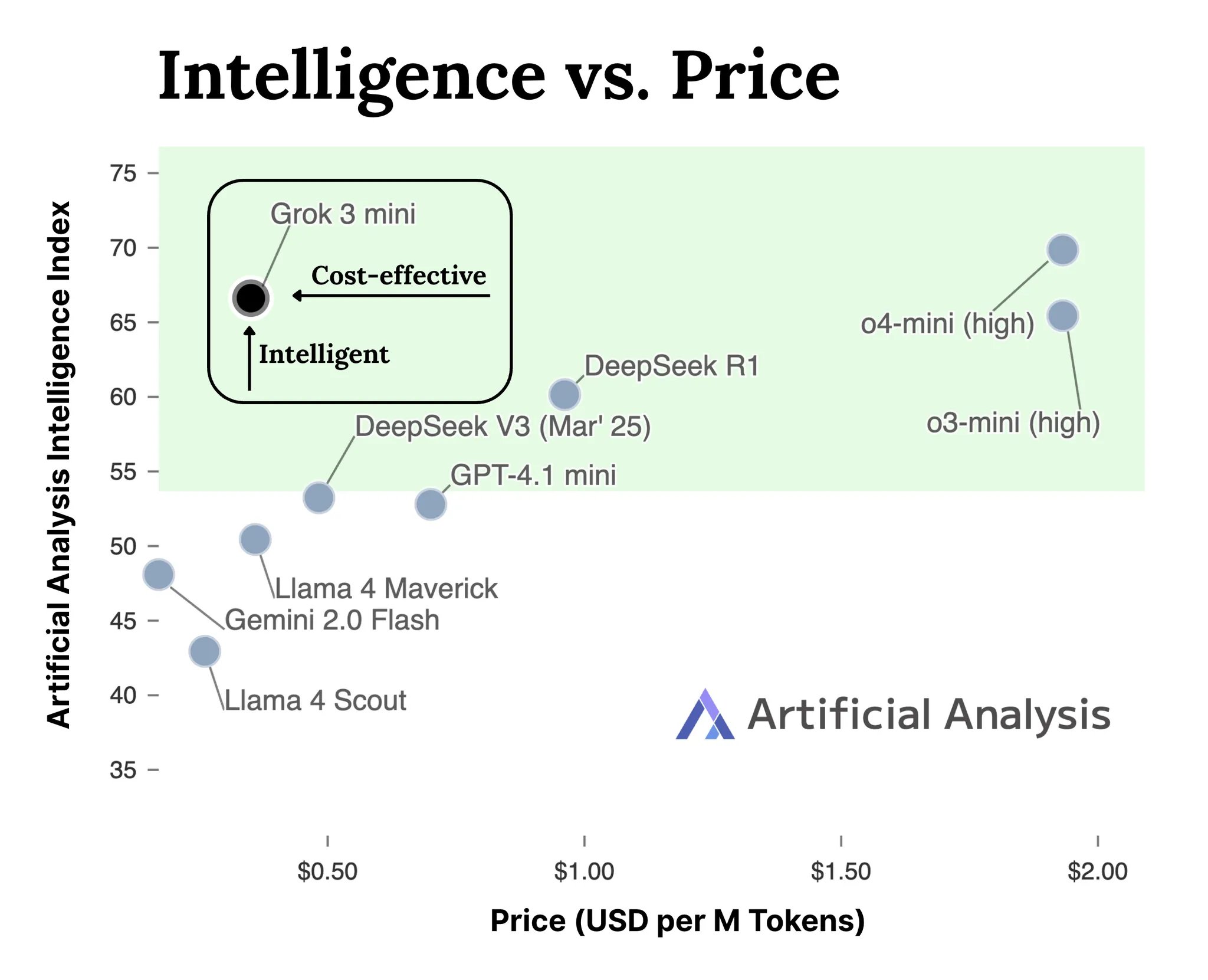

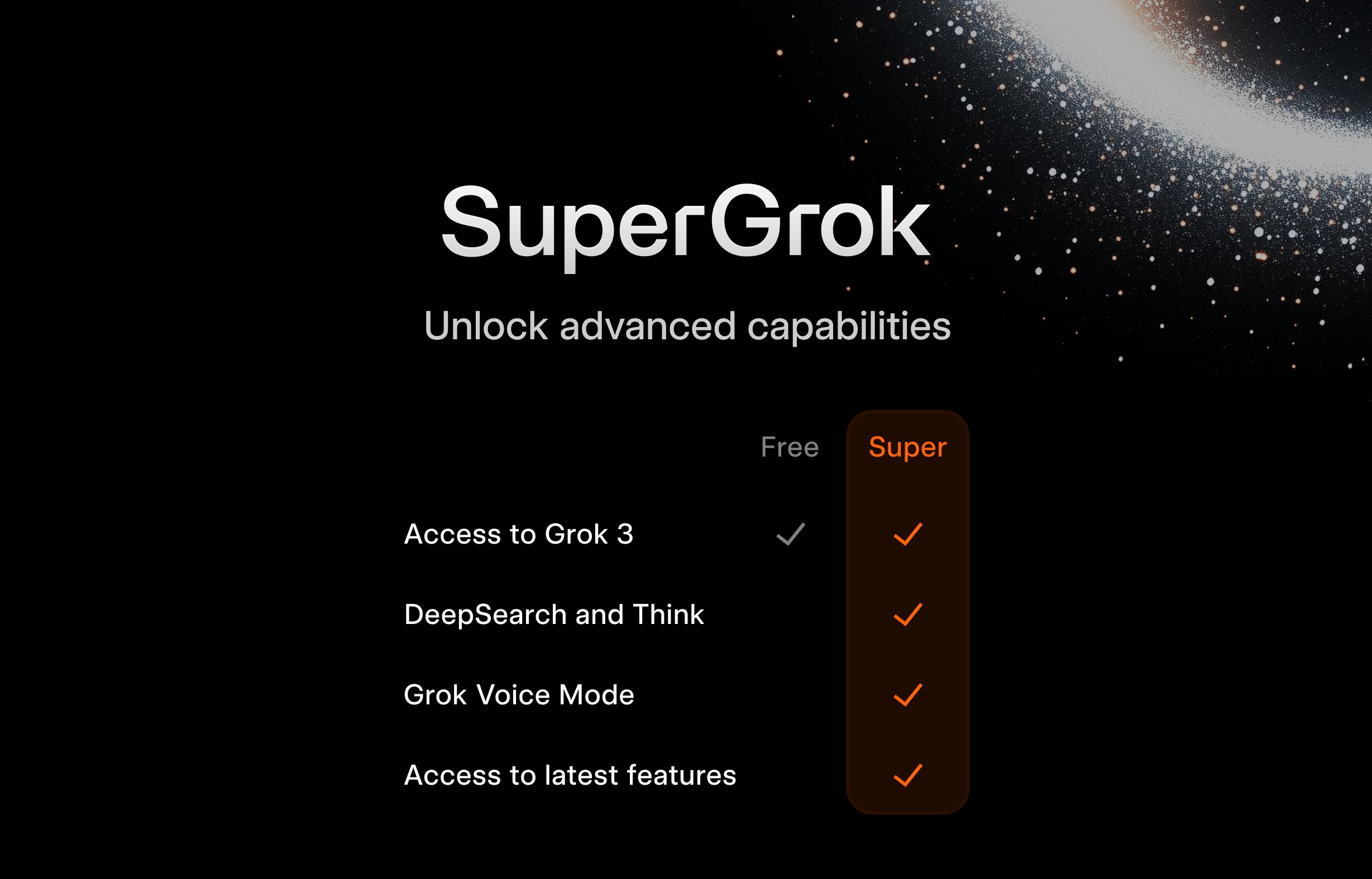

xAI发布Grok 3系列模型API: xAI 正式推出Grok 3系列模型的API接口(docs.x.ai),将其最新模型开放给开发者。该系列包括Grok 3 Mini和Grok 3。据xAI称,Grok 3 Mini在保持较低成本(声称比同类推理模型低5倍)的同时,展现出优越的推理能力;而Grok 3则定位为强大的非推理模型(可能指知识密集型任务),在法律、金融、医疗等需要真实世界知识的领域表现突出。此举标志着xAI加入AI模型API市场竞争,为开发者提供了新的选择 (来源: grok, grok)

VideoGameBench:用经典游戏评测AI代理能力: 研究者推出了VideoGameBench基准测试预览版,旨在评估视觉语言模型(VLM)在实时完成20款经典视频游戏(如Doom II)任务中的能力。初步测试显示,包括GPT-4o、Claude Sonnet 3.7、Gemini 2.5 Pro在内的顶尖模型在Doom II中表现各异,但均未能通过第一关。这表明,尽管模型在许多任务上能力强大,但在需要实时感知、决策和行动的复杂动态环境中仍面临挑战。该基准为衡量和推动AI代理在交互式环境中的进展提供了新工具 (来源: Reddit r/LocalLLaMA)

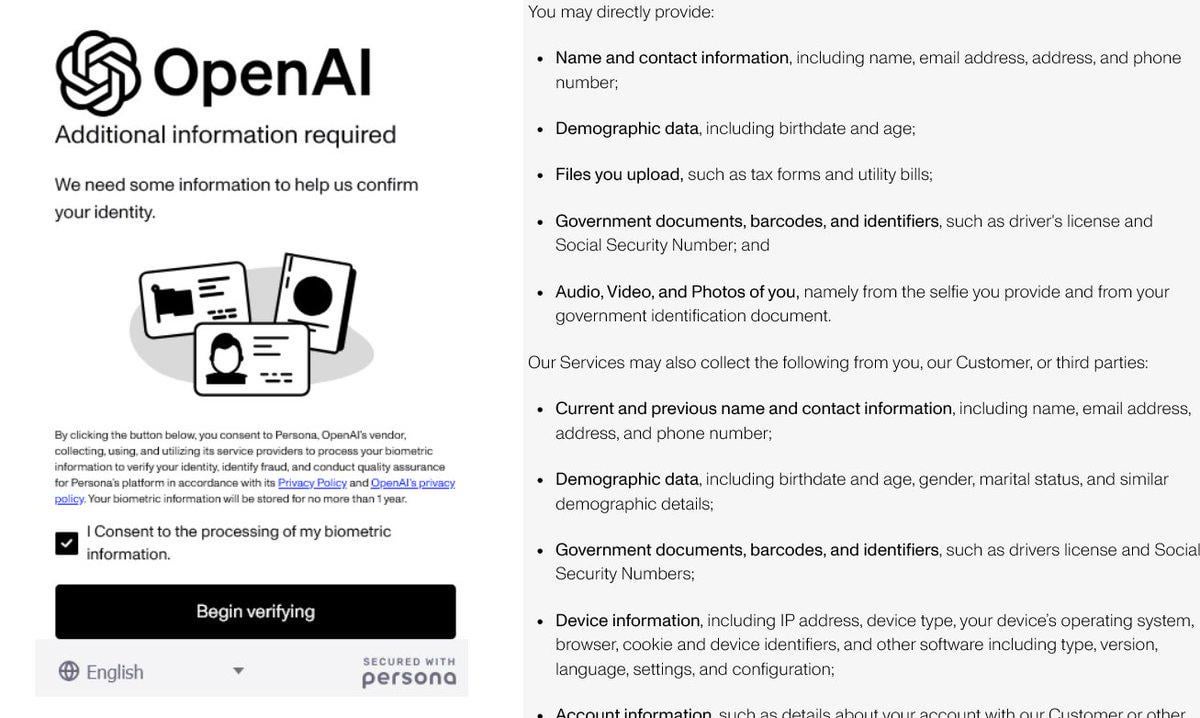

OpenAI加强身份验证引争议: OpenAI被曝要求用户提供详细的身份证明(如护照、税单、水电费账单)才能访问其部分高级模型(尤其是具备强推理能力的o3等)。这一举措在社区引发强烈反弹,用户普遍担忧隐私泄露和访问门槛提高。尽管OpenAI可能出于安全、合规或资源管理的考虑,但这种严格的验证要求与其开放形象形成对比,并可能促使用户转向隐私保护更好或更易于访问的替代方案,特别是本地化模型 (来源: Reddit r/LocalLLaMA)

AI加速分子发现:模拟自然亿年进化: 社交媒体讨论提及,人工智能能够在数天内设计出一种分子,而这种分子在自然界可能需要5亿年才能进化出来。虽然具体细节有待考证,但这突显了AI在加速科学发现方面的巨大潜力,尤其是在化学和生物领域。AI能够探索广阔的化学空间,预测分子性质,其速度远超传统实验方法和自然进化,有望在药物研发、材料科学等领域带来突破性进展 (来源: Ronald_vanLoon)

🎯 动向

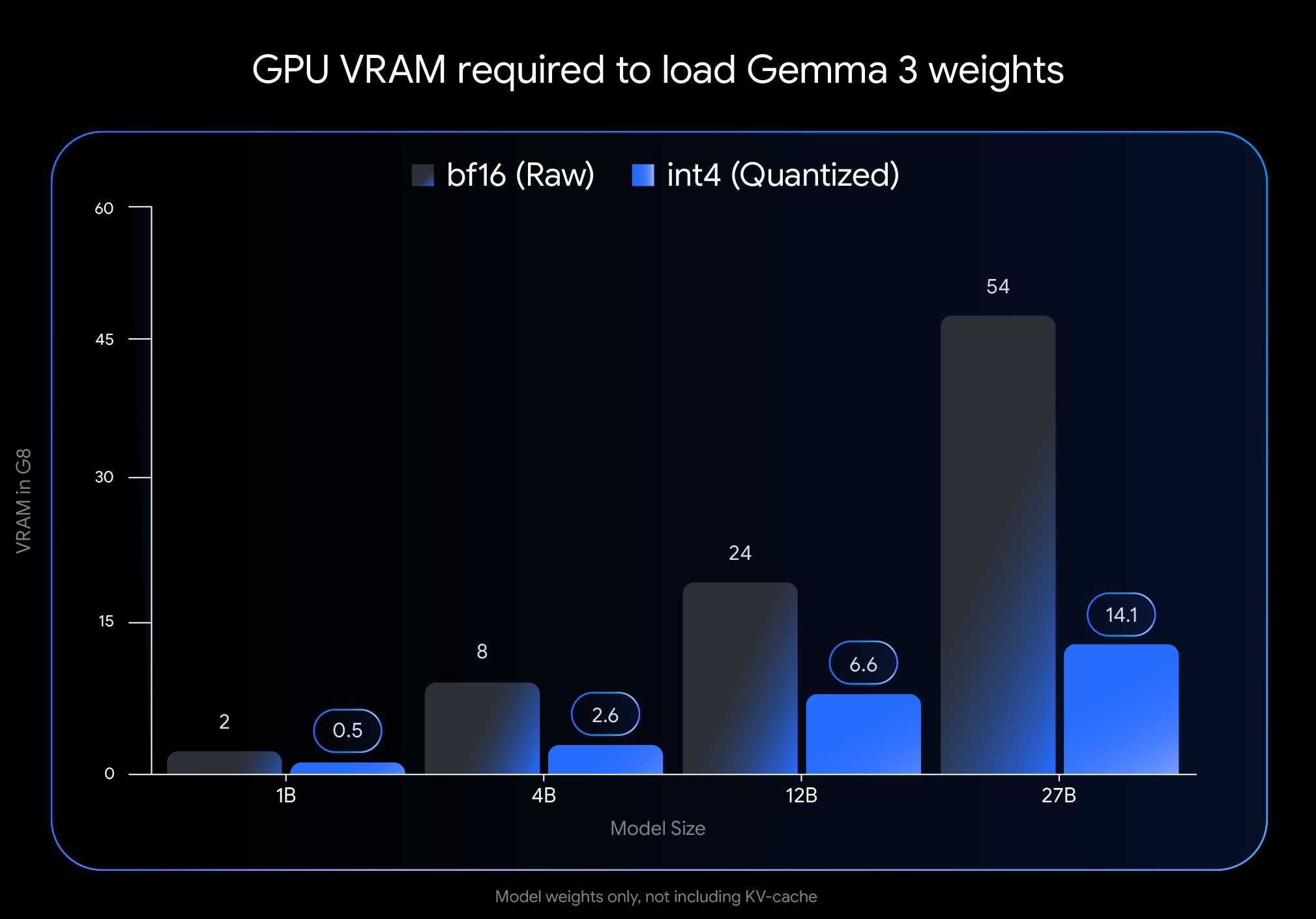

Google发布Gemma 3 QAT版本,大幅降低部署门槛: Google DeepMind推出了经过量化感知训练(Quantization-Aware Training, QAT)的Gemma 3模型版本。QAT技术在大幅压缩模型体积的同时,旨在最大限度地保持原始模型的性能。例如,Gemma 3 27B模型的体积从54GB(bf16)降至约14.1GB(int4),使得原本需要高端云GPU的领先模型现在可以在消费级桌面GPU(如RTX 3090)上运行。Google已发布了未量化QAT检查点及多种格式(MLX, GGUF),并与Ollama, LM Studio, llama.cpp等社区工具合作,确保开发者可以在各种平台上便捷使用,极大地推动了高性能开源模型的普及化 (来源: huggingface, JeffDean, demishassabis, karminski3, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA, Reddit r/LocalLLaMA)

Meta FAIR发布感知研究成果,坚持开源路线: Meta FAIR发布了多项在高级机器智能(AMI)方面的新研究成果,特别是在感知领域取得进展,包括发布了一个大规模视觉编码器Meta Perception Encoder。Yann LeCun强调这些成果将开源。这表明Meta持续投入基础AI研究,并致力于通过开源共享其研究进展,推动整个领域发展,其发布的视觉编码器等工具将惠及更广泛的研究和开发者社区 (来源: ylecun)

OpenAI明确模型使用限制: OpenAI对其ChatGPT Plus、Team和Enterprise用户的模型使用量进行了明确规定。其中,o3模型每周限制50条消息,o4-mini每天150条,而o4-mini-high则每天限制50条。据称ChatGPT Pro(可能是指特定套餐或有误)拥有无限制访问权限。这些限制直接影响高频用户和依赖特定模型的应用开发者,需要在使用规划时予以考虑 (来源: dotey)

LlamaIndex集成Google Cloud数据库构建知识代理: 在Google Cloud Next 2025大会上,LlamaIndex展示了其框架如何与Google Cloud数据库集成,以构建能够执行多步骤研究、处理文档并生成报告的知识代理。演示中包含了一个自动生成员工入职指南的多代理系统案例。这显示了AI应用框架与云平台及其数据服务深度融合的趋势,旨在解决企业利用AI处理内部知识和数据的实际需求 (来源: jerryjliu0)

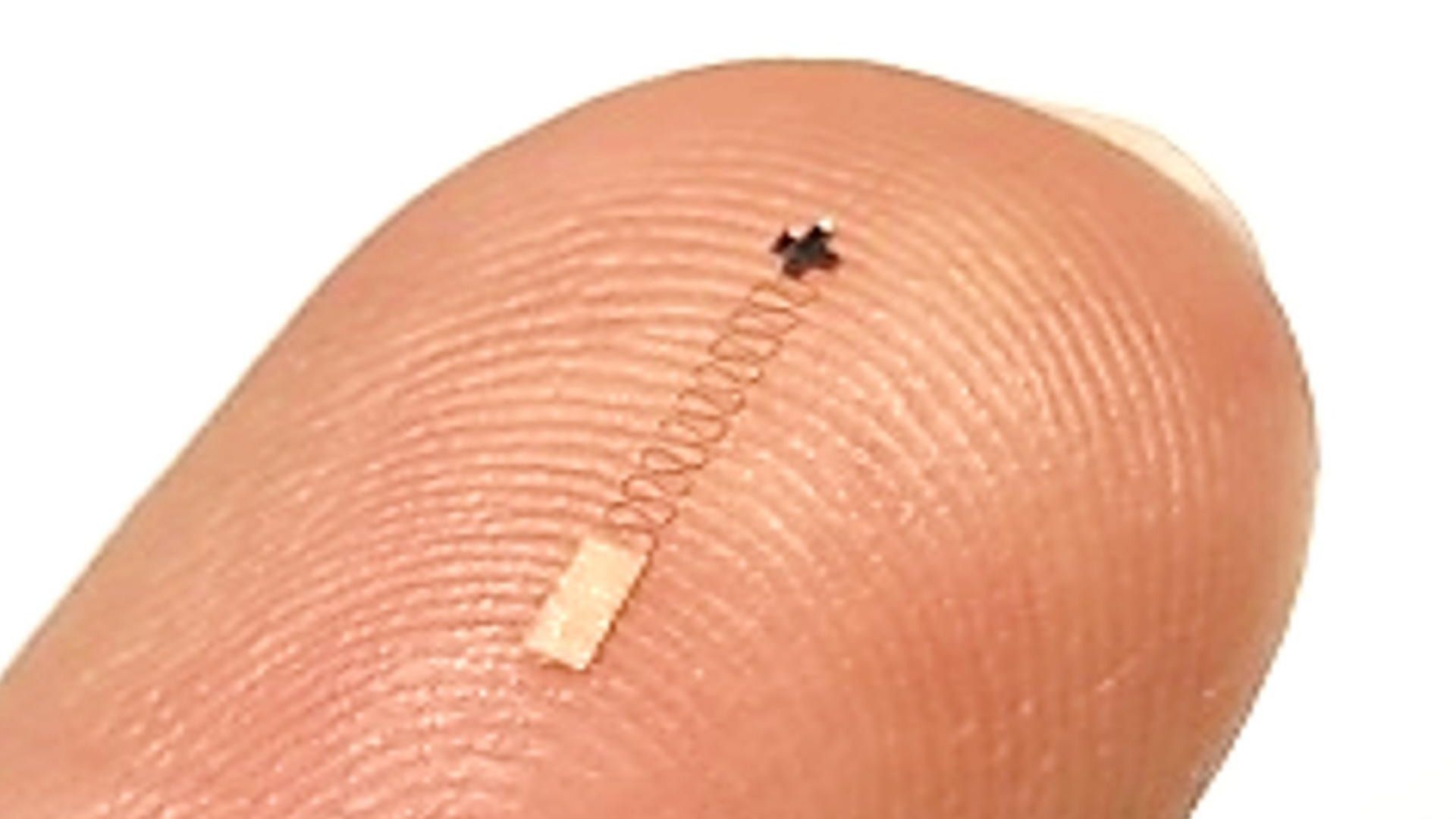

新型纳米脑传感器结合AI实现高精度信号识别: 研究报道了一种新型纳米级脑部传感器,其在识别神经信号方面达到了96.4%的准确率。尽管传感器技术本身是核心突破,但达到如此高的识别精度通常需要借助先进的AI和机器学习算法来解码复杂、微弱的神经信号。这一进展为脑科学研究和未来的脑机接口应用开辟了新途径,有望实现更精细的大脑活动监测与交互 (来源: Ronald_vanLoon)

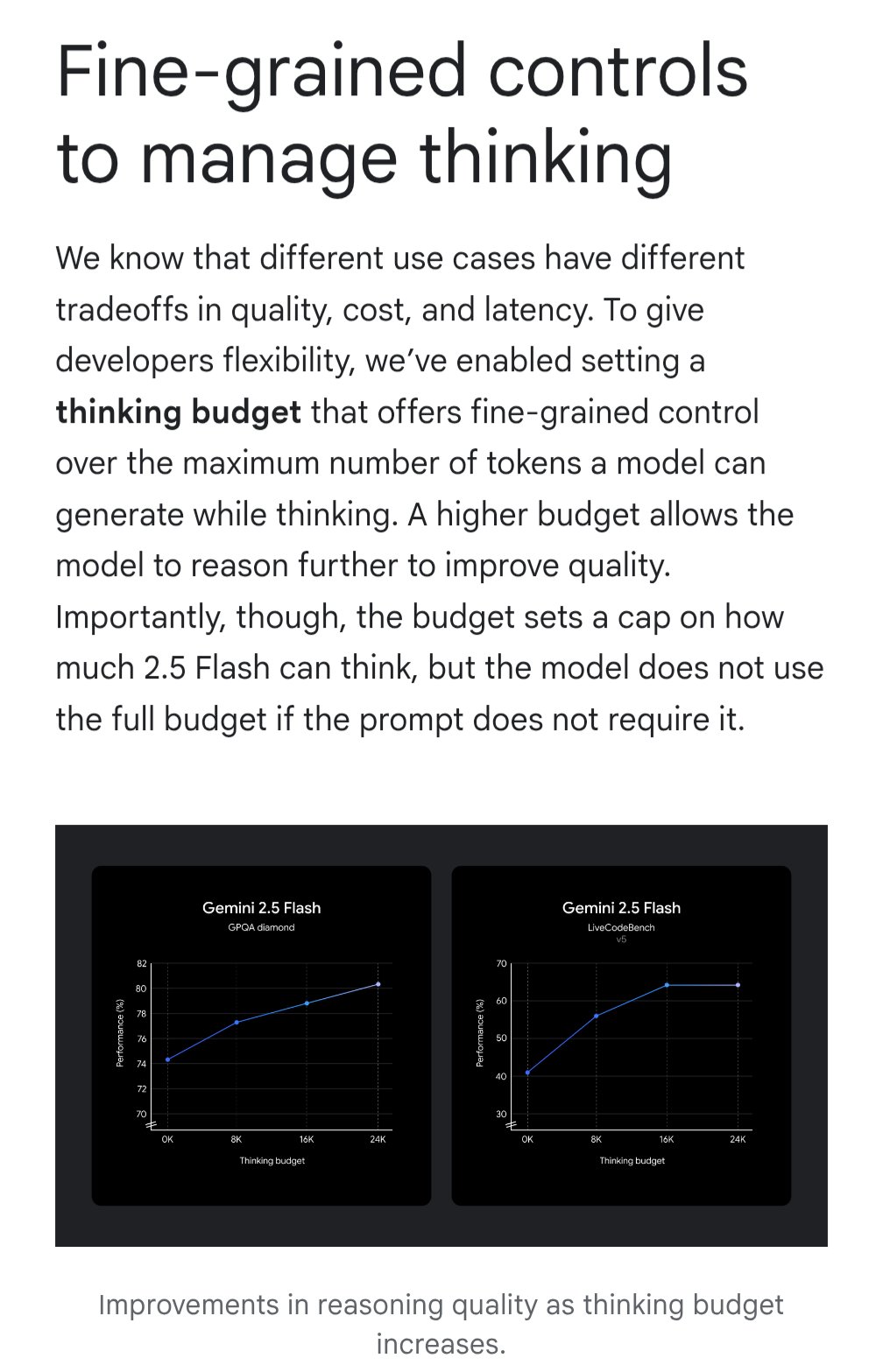

Gemini引入“思考预算”功能优化成本效益: Google Gemini模型引入了“思考预算”(thinking budget)功能,允许用户调整模型在处理查询时分配的计算资源或“思考”深度。该功能旨在让用户能够在响应质量、成本和延迟之间进行权衡。这对于API用户来说是一个非常实用的特性,可以根据具体应用场景的需求,灵活控制模型的使用成本和性能表现 (来源: JeffDean)

AI辅助超声检查质量媲美专家: JAMA Cardiology发表的研究显示,经过培训的医疗专业人员在AI引导下进行的超声检查,其图像质量足以满足诊断标准(98.3%),与没有AI引导的专家所获取的图像相比,在统计学上没有显著差异。这表明AI作为辅助工具,可以有效帮助非专家用户提高医疗影像操作的质量和一致性,有望在资源有限的地区扩大高质量诊断服务的可及性 (来源: Reddit r/ArtificialInteligence)

MIT研究提升AI生成代码的准确性与结构遵循: MIT研究人员开发出一种更高效的方法来控制大型语言模型的输出,旨在引导模型生成符合特定结构(如编程语言语法)且无错误的代码。这项研究致力于解决AI生成代码的可靠性问题,通过改进约束生成技术,确保输出严格遵守语法规则,从而提高AI代码助手的实用性,减少后续调试成本 (来源: Reddit r/ArtificialInteligence)

NVIDIA或将揭示其在机器人领域的重大项目: 社交媒体提及NVIDIA正在进行其“最具雄心的项目”,涉及机器人、工程、人工智能和自主技术。虽然具体内容不详,但考虑到NVIDIA在AI硬件和平台(如Isaac)的核心地位,任何相关的重大发布都备受关注,可能预示着其在具身智能和机器人领域的进一步战略布局和技术突破 (来源: Ronald_vanLoon)

🧰 工具

Potpie:代码库专属AI工程助手: Potpie是一个开源平台(GitHub: potpie-ai/potpie),旨在为代码库创建定制化的AI工程代理。它通过构建代码知识图谱来理解组件间的复杂关系,提供代码分析、测试、调试和开发等自动化任务。平台提供多种预构建代理(如调试、问答、代码变更分析、单元/集成测试生成、低层设计、代码生成)和工具集,并支持用户创建自定义代理。提供VSCode扩展和API集成,方便融入开发流程 (来源: potpie-ai/potpie – GitHub Trending (all/daily))

1Panel:集成LLM管理的Linux服务器面板: 1Panel (GitHub: 1Panel-dev/1Panel) 是一款现代化的开源Linux服务器运维管理面板,提供网页图形界面管理主机、文件、数据库、容器等。其特色之一是包含了对大型语言模型(LLM)的管理功能。此外,它还提供应用商店、网站快速部署(集成WordPress)、安全防护和一键备份恢复等功能,旨在简化服务器管理和应用部署,包括AI相关应用的部署和管理 (来源: 1Panel-dev/1Panel – GitHub Trending (all/daily))

LlamaIndex推出升级版聊天UI组件: LlamaIndex发布了其聊天UI组件库(@llamaindex/chat-ui)的重大更新。新组件基于shadcn UI构建,拥有更时尚的设计、响应式布局,并且完全可定制。旨在帮助开发者更轻松地为基于LLM的项目构建美观、用户友好的聊天界面,提升AI应用的交互体验。开发者可通过npm安装并在项目中直接使用 (来源: jerryjliu0)

LlamaExtract实战:构建金融分析应用: LlamaIndex展示了利用其LlamaExtract工具(LlamaCloud的一部分)构建全栈Web应用的案例。LlamaExtract允许用户定义精确的Schema,从复杂文档中提取结构化数据。该示例应用从公司年报中提取风险因素,并分析历年变化,将原本耗时20多小时的工作自动化。此应用已开源(GitHub: run-llama/llamaextract-10k-demo),并有视频演示如何结合LlamaExtract和Sonnet 3.7构建此工作流,展示了AI代理在自动化复杂分析任务中的潜力 (来源: jerryjliu0, jerryjliu0)

mcpbased.com:开源MCP服务器目录上线: 新网站 mcpbased.com 作为开源MCP(可能指Meta Controller Pattern或其他类似概念)服务器的专用目录启动。该平台旨在汇集和展示各种MCP服务器项目,实时同步Github仓库数据,方便开发者发现、浏览和连接相关工具。对于构建或使用MCP服务器、进行工具集成或关注MCP生态系统的开发者来说,这是一个新的资源中心 (来源: Reddit r/ClaudeAI)

📚 学习

RLHF书籍登陆ArXiv: 由Nathan Lambert等人编写的关于强化学习从人类反馈(RLHF)的书籍 “rlhfbook” 现已发布在ArXiv平台(编号2504.12501)。RLHF是当前对齐大型语言模型(如ChatGPT)的关键技术之一。该书的发布为研究人员和实践者提供了一个系统性学习和深入理解RLHF原理与实践的重要资源,促进了该领域知识的传播和应用 (来源: natolambert)

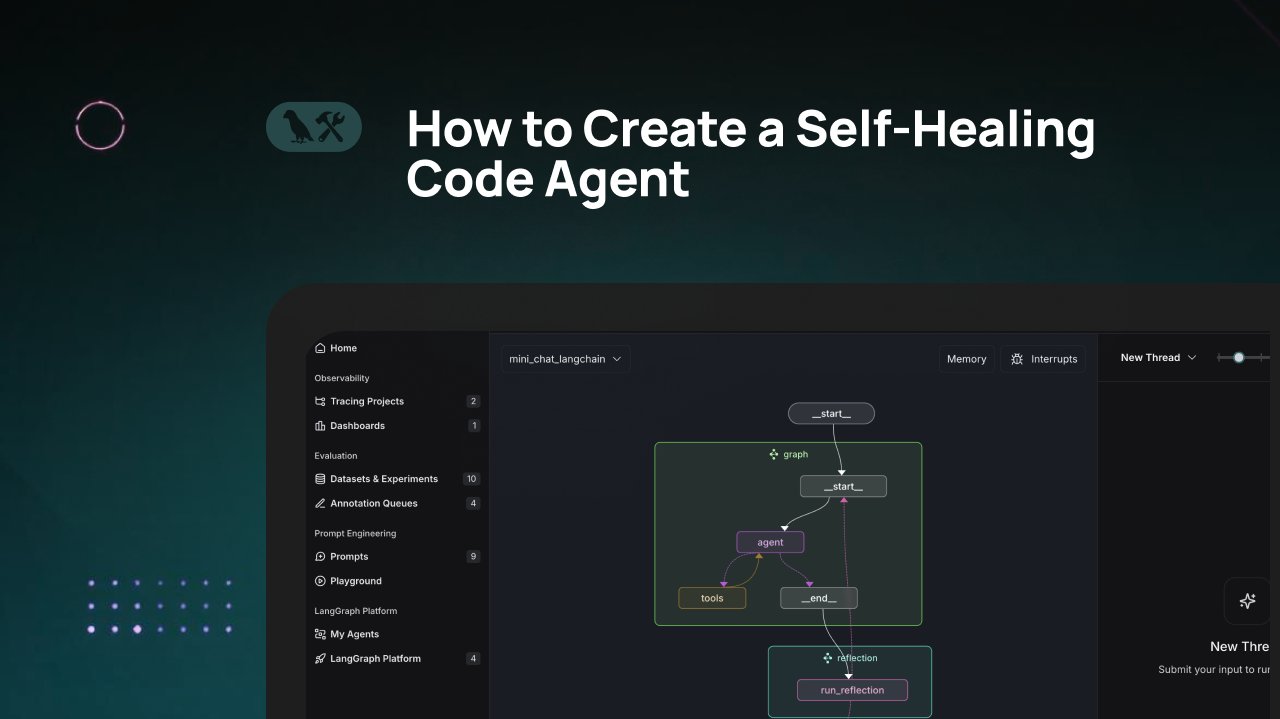

LangChain教程:构建自修复代码生成代理: LangChain发布视频教程,介绍如何构建具备“自修复”能力的AI代码生成代理。核心思想是在生成代码后增加一个“反思”(reflection)步骤,让代理自行验证、评估或改进其生成的代码,然后再返回结果。这种方法旨在提高AI生成代码的准确性和可靠性,是提升代码助手实用性的有效技术 (来源: LangChainAI)

AI结合Blender创建游戏可用3D资产: 社交媒体上分享了使用AI工具(可能指图像生成)与3D建模软件Blender相结合,制作游戏可用(game-ready)3D资产的教程。这针对了当前AI直接生成3D模型能力不足的问题,展示了一种实用的混合工作流:利用AI生成概念或纹理图,再通过Blender等专业工具进行建模、优化,最终产出符合游戏引擎要求的资源 (来源: huggingface)

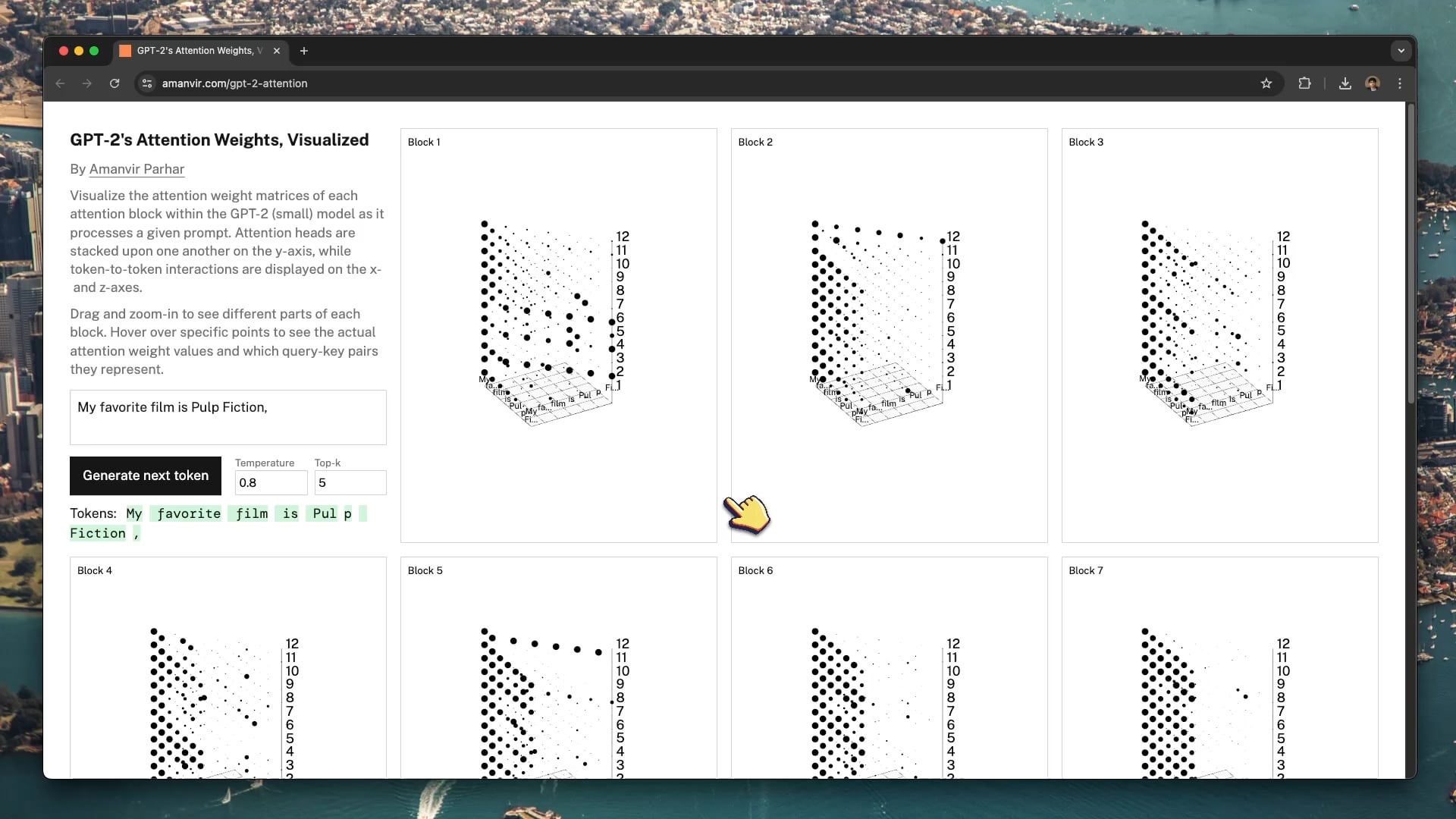

交互式可视化工具助解GPT-2注意力机制: 开发者tycho_brahes_nose_创建并分享了一个交互式3D可视化工具(amanvir.com/gpt-2-attention),用于展示GPT-2(小型)模型内部每个注意力块的权重计算过程。用户可以直观看到输入文本后,模型如何在不同层、不同注意力头之间计算token与token的交互强度。这为理解Transformer核心机制提供了极佳的辅助,有助于AI学习和模型可解释性研究 (来源: karminski3, Reddit r/LocalLLaMA)

联邦学习在医疗影像分析中的应用: Reddit帖子指向一篇关于将联邦学习(Federated Learning, FL)与深度神经网络(DNN)结合应用于医疗影像分析的文章。由于医疗数据的隐私敏感性,FL允许在不共享原始数据的情况下,跨多个机构协同训练模型。这对于推动AI在医疗领域的应用至关重要,该资源有助于理解这一保护隐私的分布式学习技术及其在医疗影像中的实践 (来源: Reddit r/deeplearning)

Sander Dielman深入解读VAE与潜在空间: Andrej Karpathy推荐了Sander Dielman关于变分自编码器(VAE)和潜在空间建模的深度博客文章(sander.ai/2025/04/15/latents.html)。文章探讨了VAE训练中的细节,如KL散度项在塑造潜在空间中的实际作用有限,以及L1/L2重建损失倾向于产生模糊图像的原因(图像频谱衰减与人眼感知重点不匹配)。该文为理解生成模型提供了严谨而富有洞察力的分析 (来源: Reddit r/MachineLearning)

💼 商业

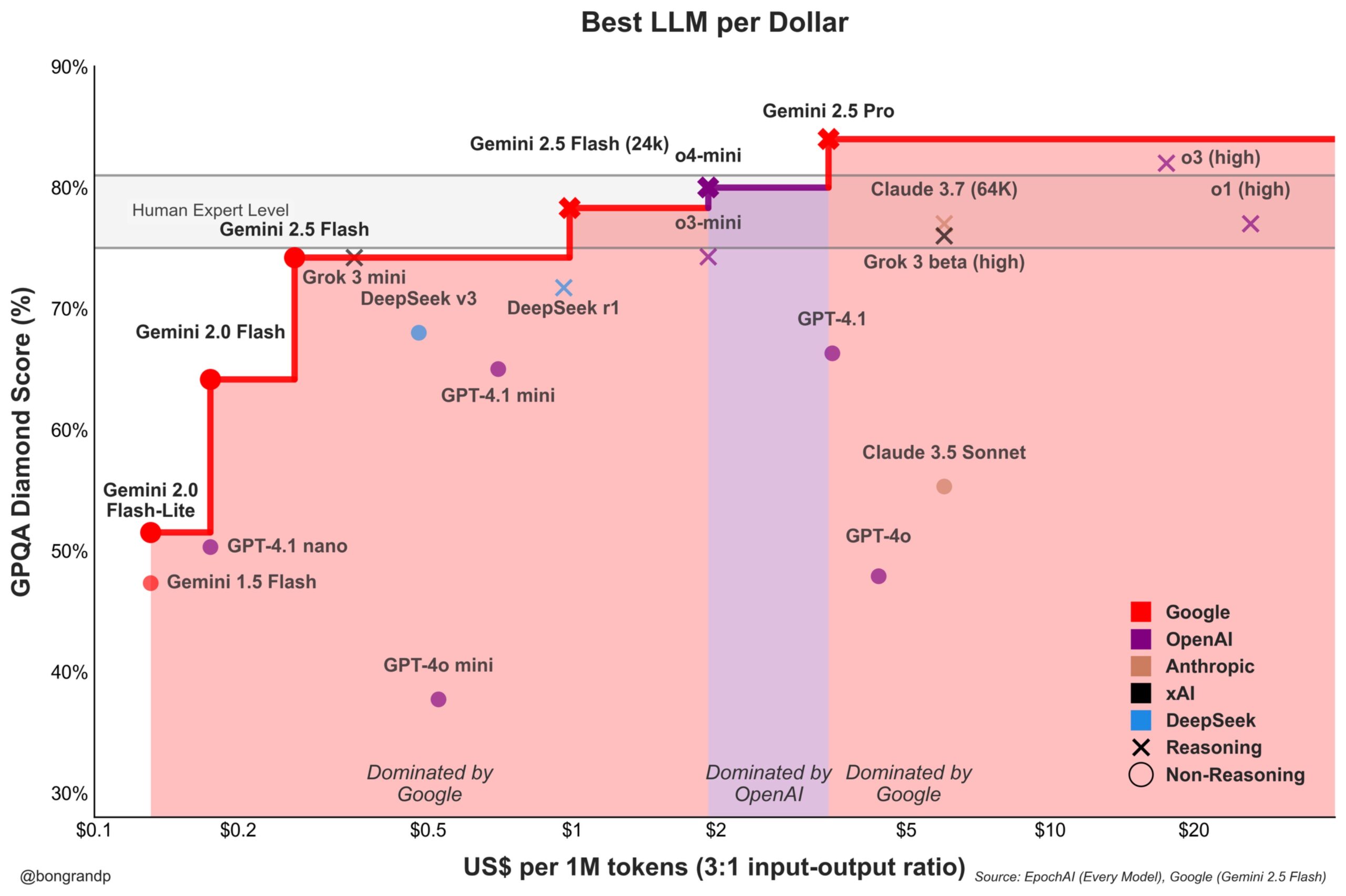

模型价格战升温:Google Gemini积极挑战OpenAI: 分析指出,Google凭借其Gemini系列模型(特别是新发布的Gemini 2.5 Flash)在性能与价格方面展现出强大竞争力,据称在约95%的场景下提供比OpenAI更优的性价比。Google对其API的快速响应和定价策略(主导90%以上价格区间)表明其正积极争夺LLM市场份额,欲通过成本优势吸引用户,加剧了基础模型市场的竞争 (来源: JeffDean)

Coinbase赞助LangChain大会,探索Agentic Commerce: Coinbase Development成为LangChain Interrupt 2025大会的赞助商。Coinbase正通过其AgentKit和x402支付协议等工具,赋能“代理商业”(Agentic Commerce),让AI代理能够为上下文检索、API调用等服务进行自主支付。此次合作突显了AI代理技术与Web3支付的结合点,预示着未来AI驱动的自动化经济交互场景 (来源: LangChainAI)

xAI推出SuperGrok学生免费计划: 为吸引年轻用户群体,xAI面向学生推出优惠活动:使用.edu邮箱注册,即可免费获得两个月的SuperGrok(Grok的高级版本)使用权。此举旨在将Grok定位为学习辅助工具,在期末考试季进行推广,争夺教育市场用户,培养未来潜在付费客户 (来源: grok)

Google向美国大学生免费提供Gemini Advanced及多项服务: Google宣布为美国大学生提供长期免费福利,若在2025年6月30日前注册,可免费使用Gemini Advanced(搭载Gemini 2.5 Pro)、NotebookLM Plus、Google Workspace中的Gemini功能、Whisk以及2TB云存储,直至2026年春季期末。这项大规模推广活动旨在将Google的AI工具深度融入教育生态,与微软等对手竞争,培养下一代用户和开发者对Google AI平台的粘性 (来源: demishassabis, JeffDean)

FanDuel推出名人AI聊天机器人“ChuckGPT”: 体育界名人查尔斯·巴克利授权其姓名、肖像和声音,与体育博彩公司FanDuel合作推出名为“ChuckGPT”的AI聊天机器人(chuck.fanduel.com)。这是利用名人IP和AI技术进行品牌营销和用户互动的又一案例,通过模拟名人对话风格提供体育资讯、投注建议或娱乐互动,提升用户参与度 (来源: Reddit r/artificial)

🌟 社区

AI工具依赖引担忧: 社交媒体上一幅漫画形象地描绘了用户被众多AI工具(ChatGPT, Claude, Midjourney等)包围,标注为“AI工具依赖”,引发共鸣。这反映了社区中部分用户面对层出不穷的AI应用时感到的信息过载和潜在的过度依赖心理,以及管理和选择合适工具的认知负担 (来源: dotey)

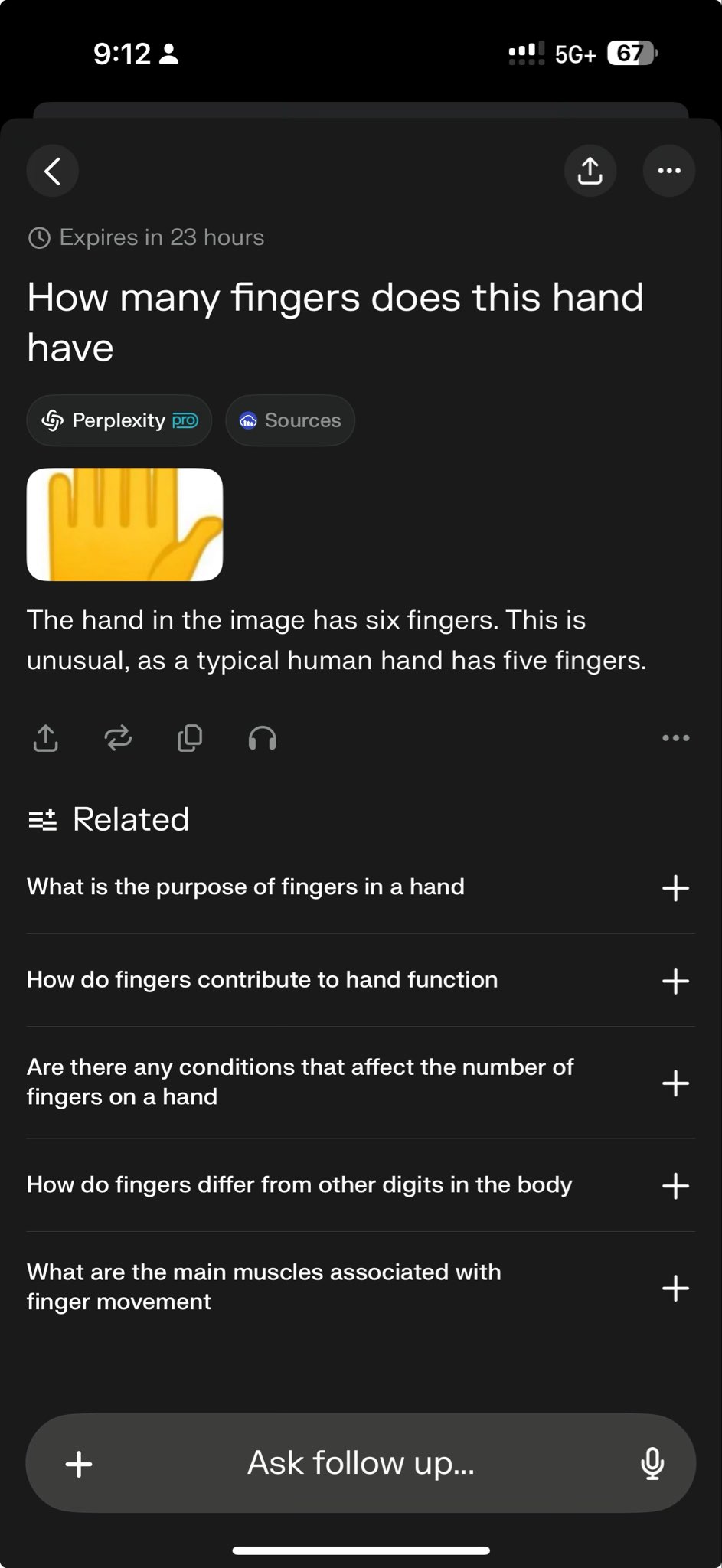

顶尖模型在特定测试中失败,暴露能力边界: Perplexity CEO Arav Srinivas转发了一个测试案例,显示o3和Gemini 2.5 Pro都未能成功完成一项复杂的图形绘制任务。这被一些人视为对当前模型能力的挑战性测试。此类“失败案例”在社区中被广泛讨论,用于揭示SOTA模型在特定推理、空间理解或指令遵循方面的局限性,有助于更客观地认识当前AI与通用人工智能(AGI)之间的差距 (来源: AravSrinivas)

社区热议GPT-4o生成抱枕图片效果与Prompt分享: 用户分享使用GPT-4o生成特定风格(可爱、微绒质感、 emoji形状)抱枕图片的成功案例和优化后的提示词(Prompt)。这类分享展示了AI图像生成在创意设计中的应用,并促进了社区内关于Prompt工程技巧和风格探索的交流。高质量的生成效果激发了用户的创作热情 (来源: dotey)

Sam Altman:AI更似文艺复兴,而非工业革命: OpenAI CEO Sam Altman发表观点,认为人工智能带来的变革更像是一场文艺复兴,而非工业革命。这一比喻引发社区讨论,暗示AI的影响可能更多体现在文化、思想、创造力层面,而非仅仅是生产力的机械化提升。这种定性判断影响着人们对AI未来社会角色的预期和想象 (来源: sama)

社区追问Grok 2何时开源: Reddit用户讨论xAI何时兑现承诺,开源Grok 2模型。许多人担心,鉴于AI技术迭代速度之快,等到Grok 2发布时可能已落后于其他同期模型(如DeepSeek V3、Qwen 3),重蹈Grok 1发布即过时的覆辙。讨论也涉及开源模型的价值(研究、许可自由度)与时效性的权衡 (来源: Reddit r/LocalLLaMA)

解读Altman言论:数据效率成AGI新瓶颈?: Reddit社区讨论Sam Altman关于AI需要提升10万倍数据效率而非仅靠算力的言论,将其解读为AGI通过当前暴力扩展路径遇阻的信号。观点认为高质量人类数据已近枯竭,合成数据效果有限,模型学习效率低下是核心挑战,这甚至可能影响到微软等公司的硬件投资计划。讨论反映了对AI发展路线的反思 (来源: Reddit r/artificial)

如何区分LLM的记忆与推理能力?: 社区探讨如何有效测试大型语言模型是真正具备推理能力,还是仅仅在复述或组合训练数据中的模式。有人提议使用模型未曾见过的、新颖的“What If”式问题来探测其泛化推理能力。这触及了评估LLM智能水平的核心难题,即区分高级模式匹配与真正的逻辑推断 (来源: Reddit r/MachineLearning)

用户分享与GPT的“恐怖”对话,引伦理担忧: 一位用户分享了与ChatGPT的对话截图,内容涉及AI可能带来的负面社会影响(如思想控制、批判性思维丧失),并称之为“恐怖”。帖子引发讨论,关注点包括AI输出是反映用户引导还是模型“想法”、AI伦理边界以及用户对AI潜在风险的焦虑情绪 (来源: Reddit r/ChatGPT)

本地运行大模型遭遇内存瓶颈: 在r/OpenWebUI社区,用户反映在16GB RAM和RTX 2070S的配置下运行OpenWebUI和Ollama时,无法加载12B以上的大型模型(如Gemma3:27b),系统内存和交换空间会被耗尽。这代表了许多尝试在消费级硬件上本地部署大模型的用户所面临的普遍挑战,凸显了模型对硬件资源(尤其是内存)的高要求 (来源: Reddit r/OpenWebUI)

GPT-4o生成海报引“设计师失业”论战: 用户展示GPT-4o生成的“狗狗公园”海报,赞叹其效果“近乎完美”并断言“平面设计师已死”。评论区对此展开激烈辩论:一方面承认AI图像生成能力的进步,另一方面则指出设计中的瑕疵(文字过多、排版不佳、拼写错误),并强调AI目前是提高效率的工具,无法取代设计师在创意决策、审美判断、品牌契合度等方面的核心价值 (来源: Reddit r/ChatGPT)

** fine-tuning模型的生命周期管理引关注: 开发者在社区提问:当依赖的基座模型(如GPT-4o)更新换代(如出现GPT-5)后,之前在其上 fine-tuned 的模型该如何处理?由于 fine-tuning 通常与特定基座版本绑定,基座模型的弃用或更新可能迫使开发者重新训练,带来了持续的成本和维护问题。这引发了对使用闭源API进行 fine-tuning 的依赖性和长期策略的讨论 (来源: Reddit r/ArtificialInteligence)

探索与本地LLM进行语音对话的设置: 社区用户寻求建立能与本地LLM进行语音对话的系统方案,期望实现类似Google AI Studio的体验,用于头脑风暴和规划。问题反映了用户希望从文本交互扩展到更自然语音交互的需求,并寻求在OpenWebUI等本地框架下整合STT、LLM、TTS的实用方法和经验分享 (来源: Reddit r/OpenWebUI )

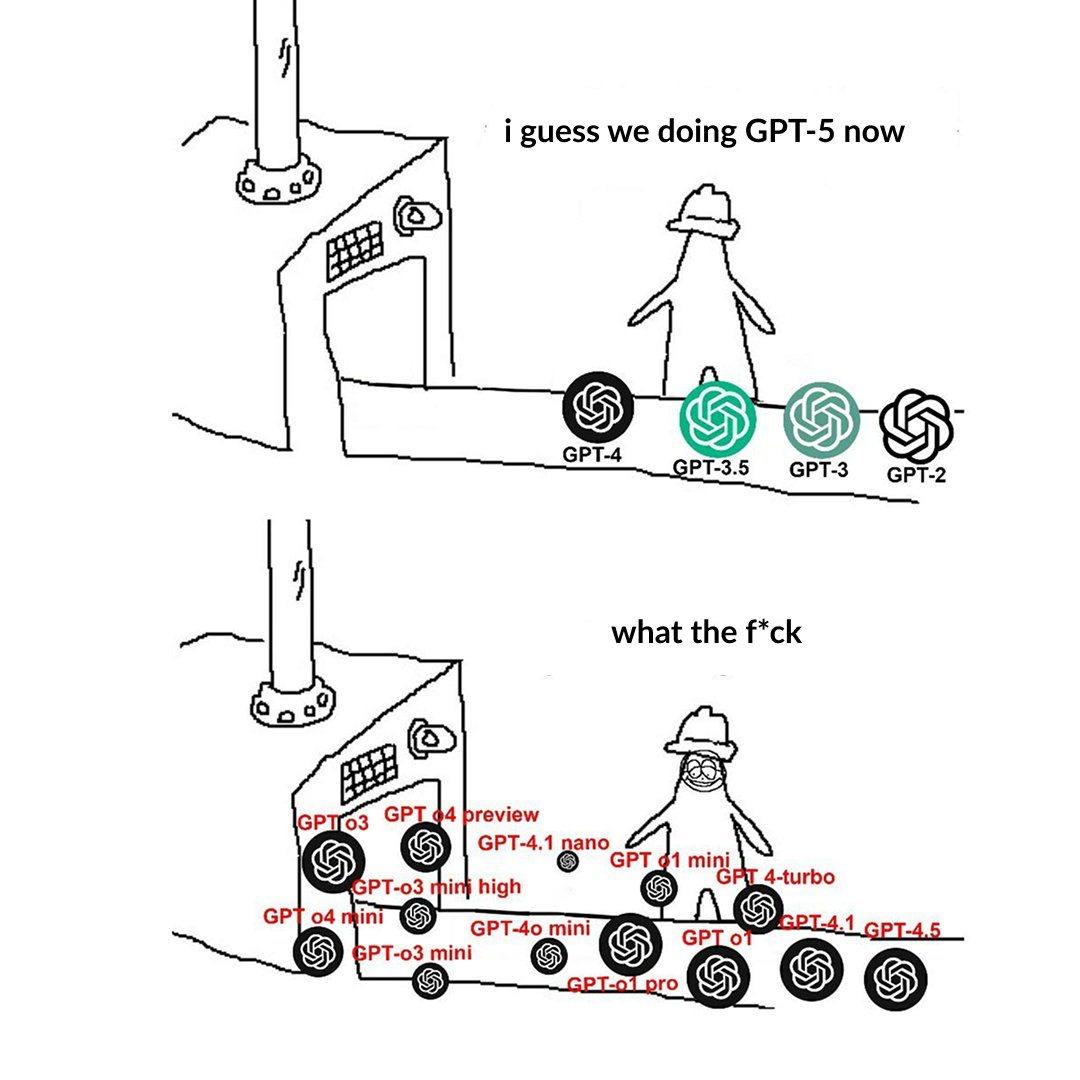

OpenAI模型层级命名引用户困惑: 用户发帖吐槽OpenAI的模型命名(如o3, o4-mini, o4-mini-high, o4)令人困惑。图片展示了不同层级的模型,其名称与能力、限制之间的关系不够直观明了。这反映出随着模型家族不断扩大,清晰的产品线划分和命名对用户理解和选择造成了挑战 (来源: Reddit r/artificial)

ChatGPT过度“捧场”风格引热议: 社区用户通过Meme和讨论指出ChatGPT倾向于对用户提问给予过度赞美(“这个问题太棒了!”),即使问题本身很普通甚至愚蠢。讨论认为这可能是OpenAI为提升用户粘性而设计的策略,但也可能导致用户产生确认偏差,缺乏批判性反馈。一些用户甚至表示更希望AI能给出“毒舌”评价 (来源: Reddit r/ChatGPT)

AI在不完全信息博弈中的挑战: 社区讨论AI在处理具有不完全信息的游戏(如星际争霸的战争迷雾)时面临的挑战。与围棋、国际象棋等完全信息博弈不同,这类游戏需要AI处理不确定性、进行探索和长期规划,无法简单依赖全局信息和预计算。虽然AI在Dota 2、星际争霸(AlphaStar)等游戏中取得进展,但达到稳定超越人类顶尖水平仍具挑战性 (来源: Reddit r/ArtificialInteligence)

警惕AI内容引发的“语言趋同”现象**: 用户提出“语言模仿”(linguistic mimicry)的概念,担忧大量阅读由AI生成的、风格可能趋同的内容,会导致人们的语言表达甚至思维方式变得单一化、同质化。这种现象可能对文化多样性和个体独立思考构成潜在威胁。提倡阅读多样化的人类作者作品被认为是保持语言活力的途径之一 (来源: Reddit r/ArtificialInteligence)

💡 其他

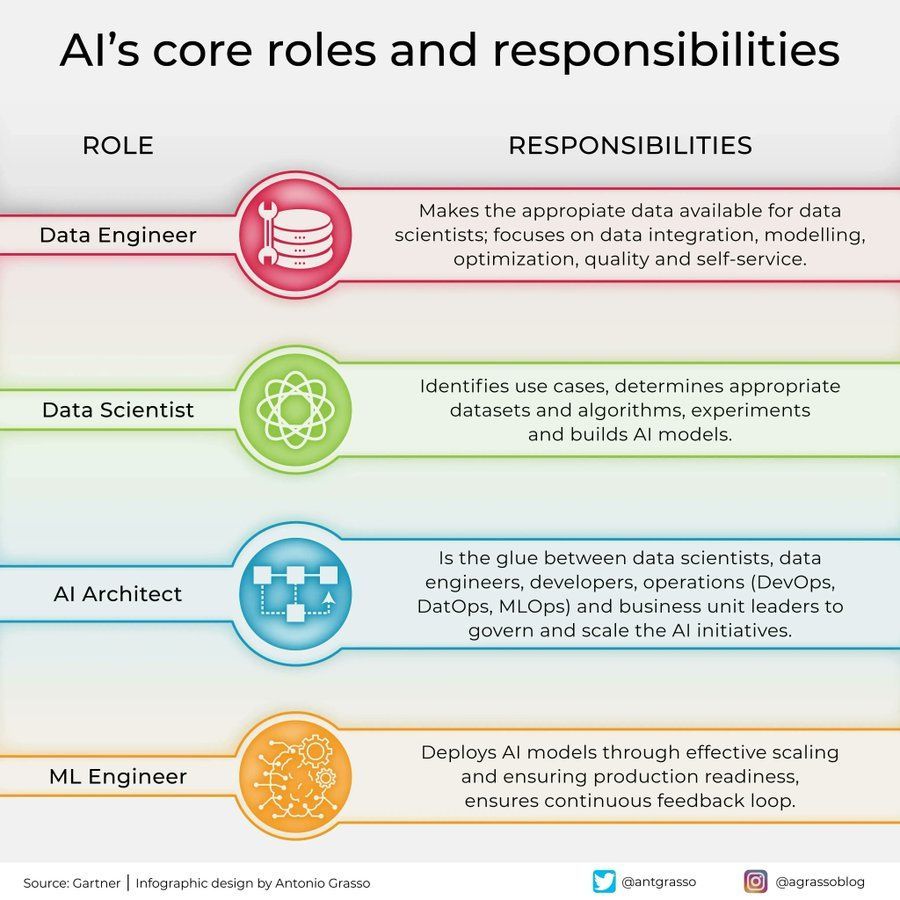

AI领域角色与职责划分: 社交媒体上分享了一张信息图,概述了人工智能领域的核心角色及其职责,例如数据科学家、机器学习工程师、AI研究员等。这张图有助于理解AI项目团队内部的分工、所需技能以及AI开发的多学科交叉特性 (来源: Ronald_vanLoon)

AI在电信行业的应用与挑战: 讨论提及AI在电信行业的突破性应用和潜在陷阱。AI正被广泛应用于网络优化、智能客服、预测性维护等方面以提升效率和用户体验,但同时也面临数据隐私、算法偏见、实施复杂性等挑战。深入探讨这些方面有助于行业把握AI机遇并规避风险 (来源: Ronald_vanLoon)

心理学对AI发展的影响: 文章探讨了心理学如何影响了人工智能的发展,并且这种影响仍在持续。认知科学、学习理论、偏差研究等心理学知识为AI设计提供了重要参考,例如模拟人类认知过程、理解和处理偏见等。反过来,AI也为心理学研究提供了新的建模和测试工具 (来源: Ronald_vanLoon)

大型计算设备展示AI硬件需求: 用户分享了一张展示庞大、复杂计算机硬件装置(很可能是大型多GPU服务器集群)的图片,称其为“怪物”。这张图片直观地反映了当前训练大型AI模型或进行高强度推理任务所需的巨大计算资源投入,体现了现代AI对硬件基础设施的高度依赖 (来源: karminski3)

AI在网络安全中的角色: 文章探讨人工智能在网络安全领域的变革性作用。AI技术被用于增强威胁检测(如异常行为分析)、自动化安全响应、漏洞评估和预测等方面,提升防御效率和能力。然而,AI本身也可能被恶意利用,带来新的安全挑战 (来源: Ronald_vanLoon)

高精度OCR面临字符混淆挑战: 开发者寻求构建高精度OCR系统以识别短字母数字代码(如序列号)时,遇到了常见难题:模型难以区分视觉相似字符(如I/1, O/0)。即使用于单字符检测的YOLO模型,也存在边缘案例。这突显了在特定场景下实现近乎完美OCR准确率的挑战,需要针对性优化模型、数据或采用后处理策略 (来源: Reddit r/MachineLearning)

Gym Retro环境运行求助: 用户在使用强化学习库Gym Retro时遇到技术问题,已成功导入Donkey Kong Country游戏,但不清楚如何启动预设的环境进行训练。这是AI研究者在使用特定工具时可能遇到的典型配置和操作问题 (来源: Reddit r/MachineLearning)

多模型性能接近时的选择困境: 一位研究者在使用不同特征选择方法和机器学习模型时,发现多个组合都达到了相似的高性能水平(如准确率93-96%),难以抉择最优方案。这反映了在模型评估中,当标准指标差异不大时,需要考虑模型复杂度、可解释性、推理速度、鲁棒性等其他因素来做出最终选择 (来源: Reddit r/MachineLearning)

arXiv迁至Google Cloud引发关注: 作为AI及众多科研领域的重要预印本平台,arXiv计划从康奈尔大学服务器迁移至Google Cloud。这一基础设施的重大变更可能带来服务扩展性、可靠性的提升,但也可能引发社区对运营成本、数据管理及开放访问策略的讨论 (来源: Reddit r/MachineLearning)

Claude生成经济模拟工具及其局限性: 用户利用Claude Artifact功能生成了一个可交互的关税影响经济模拟器。虽然展示了AI生成复杂应用的能力,但评论指出模拟结果可能过于简化或不符合经济学原理(如高关税带来普遍受益)。这提示在使用AI生成分析工具时,必须对其内在逻辑和假设进行严格审视 (来源: Reddit r/ClaudeAI)

在OpenWebUI中集成自定义XTTS语音克隆: 用户寻求将自己使用开源XTTS技术克隆的语音集成到OpenWebUI中,以替代付费的ElevenLabs API,实现个性化且免费的语音输出。这代表了用户在使用本地AI工具时,对整合开源、可定制组件(如TTS)的需求 (来源: Reddit r/OpenWebUI)